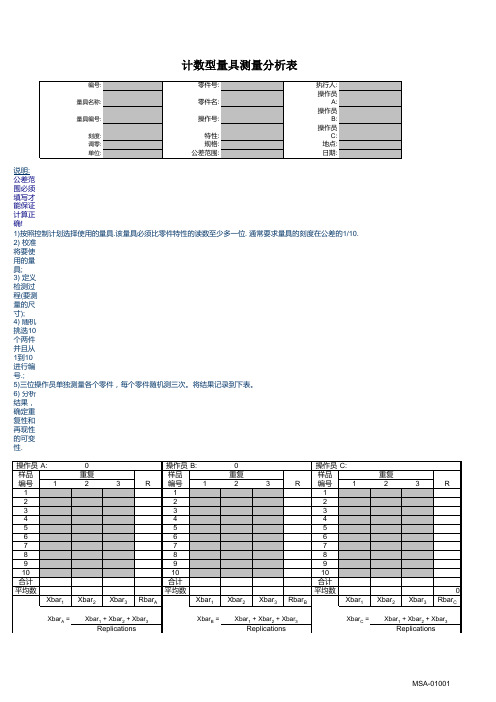

计数型MSA表格(Kappa模型)-公式可见-可编辑-无锁定

- 格式:xls

- 大小:90.50 KB

- 文档页数:2

计数型MSA:Kappa分析中“期望计数”的计算方法我们仍用MSA手册中的例子来做说明。

两评价人A和B分别对随机抽取的50个零件进行测量,对每个零件的测量随机地重复了3次。

设定1表示可接受的决定(即评为1类),0表示不可接受的决定(即评为0类)。

测量结果用以下交叉表列出。

科恩(Cohen)给出的Kappa计算公式为:MSA手册中定义P0为对角栏框中(观测)计数占总计数的比例,Pe为对角栏框中期望计数占总计数的比例。

(第三版中文MSA手册中翻译有误,这里是按英文版翻译过来的)(观测)计数容易理解,如对角栏框中的44表示A和B都评为0类的测量次数,97表示A 和B都评为1类的测量次数,而6则表示A评为0类但B评为1类的测量次数,3则表示A评为1类但B评为0类的测量次数。

因此,,P0也就是评价人A和B在测量中实际一致性的比率。

那期望计数是指什么呢?假如这两位评价人都是任意地(猜测)将50 个零件判定为可接受或不可接受,其结果也会达到一定程度的一致,不过这里的一致是偶然达到的,这种偶然达到的一致性比率称为偶然一致性比率,也就是Kappa计算中的Pe。

当评价人A 与B 随机地作评价时,此两人行动一定是独立的,互不影响,从而两人同评为0 类的概率为P0+×P+0,两人同评为1 类的概率为P1+×P+1。

(这里P0+表示A评价人评为0类的测量次数占总测量次数的比率,P1+表示A评价人评为1类的测量次数占总测量次数的比率;同理P+0、P+1分别表示B评价人评为0类的测量次数占总测量次数的比率,和B评价人评为1类的测量次数占总测量次数的比率。

这时偶然一致性比率Pe = P0+×P+0+ P1+×P+1。

因此,这里15.7和68.7分别就是两评价人同时评为0类和1类的期望计数,分别为对应单元格行总计数乘以列总计数除以总计数(即总测量次数)所得。

同样31.3和34.3这两个期望计数也是按同样方式得出的。

6.136.13 计数型测量系统分析计数型测量系统分析——————假设试验分析法假设试验分析法假设试验分析法((Kappa Kappa))说明:参照张智勇所著《ISO/TS16949五大工具最新版一本通》(机械工业出版社)编写。

计数型测量系统的分析是为了确定不同班次,不同生产线的检查人员是否能正确地区分合格品和不合格品,分析出测量结果与标准值的符合程度,以及他们自身和相互之间重复检查的一致程度。

假设试验分析—交叉表法是一种常用的计数型测量系统分析方法。

交叉表法可以在基准值(分析用样品称为基准,用计量型测量系统对样品进行测量,测量值称为基准值)已知的情况下进行,也可以在基准值未知的情况下进行。

在基准值未知的情况下进行,可以评价测量人之间的一致性,但不能评价测量系统区分好与不好的能力。

在基准值已知的情况下,即可评价测量人之间的一致性,又能评价测量人员与基准值的一致性,以及测量的有效性、漏判率和误判率,从而判断出测量人区分合格和不合格零件的能力。

6.136.13.1 .1 .1 未知基准值的一致性分析未知基准值的一致性分析1)随机选取g=50(一般选取g=30~50个样本)个能够覆盖过程范围的零件,对这些零件进行编号。

零件的编号不要让测量人知道,但分析人应该知道。

2)由3名评价人以随机盲测的方式测量所有零件各m=3次,每人测量次数为n=g×m=50×3=150次。

“接受”记为“1”,“拒绝”记为“0”,将三人所测150×3=450个数据记录于表6-21中。

测量时应按这样的规则进行:先让A 测量人以随机顺序对50个零件进行第1轮测量,然后让B 测量人、C 测量人以随机顺序进行第1轮测量,再让A 测量人进行第2轮测量,以此类推,完成测量工作。

表6-21 计数型测量系统分析数据表零件测量人A 测量人B 测量人C基准基准值代码A-1 A-2 A-3 B-1 B-2 B-3 C-1 C-2 C-31 1 1 1 1 1 1 1 1 1 1 0.476 901 +2 1 1 1 1 1 1 1 1 1 1 0.509015 +3 0 0 0 0 0 0 0 0 0 0 0.576459 -4 0 0 0 0 0 0 0 0 0 0 0.566152 -5 0 0 0 0 0 0 0 0 0 0 0.57036 -6 1 1 0 1 1 0 1 0 0 1 0.544 951 ×7 1 1 1 1 1 1 1 0 1 1 0.465454 ×8 1 1 1 1 1 1 1 1 1 1 0.502295 +9 0 0 0 0 0 0 0 0 0 0 0.437817 -10 1 1 1 1 1 1 1 1 1 1 0.515573 +11 1 1 1 1 1 1 1 1 1 1 0.488905 +12 0 0 0 0 0 0 0 10 0 0.559918 ×13 1 1 1 1 1 1 1 1 1 1 0.542704 +14 1 1 0 1 1 1 1 0 0 1 0.454518 ×15 1 1 1 1 1 1 1 1 1 1 0.517377 +16 1 1 1 1 1 1 1 1 1 1 0.531939 +17 1 1 1 1 1 1 1 1 1 1 0.519694 +18 1 1 1 1 1 1 1 1 1 1 0.484167 +19 1 1 1 1 1 1 1 1 1 1 0.520496 +20 1 1 1 1 1 1 1 1 1 1 0.477236 +21 1 1 0 1 0 1 0 1 0 1 0.452310 ×22 0 0 1 0 1 0 1 10 0 0.545604 ×23 1 1 1 1 1 1 1 1 1 1 0.529065 +24 1 1 1 1 1 1 1 1 1 1 0.514192 +25 0 0 0 0 0 0 0 0 0 0 0.599581 -26 0 1 0 0 0 0 0 0 1 0 0.547204 ×27 1 1 1 1 1 1 1 1 1 1 0.502436 +28 1 1 1 1 1 1 1 1 1 1 0.521642 +29 1 1 1 1 1 1 1 1 1 1 0.523754 +30 0 0 0 0 0 1 0 0 0 0 0.561457 ×31 1 1 1 1 1 1 1 1 1 1 0.503091 +32 1 1 1 1 1 1 1 1 1 1 0.505850 +33 1 1 1 1 1 1 1 1 1 1 0.487613 +34 0 0 1 0 0 1 0 1 1 0 0.449696 ×35 1 1 1 1 1 1 1 1 1 1 0.498698 +36 1 1 0 1 1 1 1 0 1 1 0.543077 ×37 0 0 0 0 0 0 0 0 0 0 0.409238 -38 1 1 1 1 1 1 1 1 1 1 0.488184 +39 0 0 0 0 0 0 0 0 0 0 0.427687 -40 1 1 1 1 1 1 1 1 1 1 0.501132 +41 1 1 1 1 1 1 1 1 1 1 0.513779 +42 0 0 0 0 0 0 0 0 0 0 0.566575 -43 1 0 1 1 1 1 1 1 0 1 0.462410 ×44 1 1 1 1 1 1 1 1 1 1 0.470832 +45 0 0 0 0 0 0 0 0 0 0 0.412453 -46 1 1 1 1 1 1 1 1 1 1 0.493441 +47 1 1 1 1 1 1 1 1 1 1 0.486379 +48 0 0 0 0 0 0 0 0 0 0 0.587893 -49 1 1 1 1 1 1 1 1 1 1 0.483803 +50 0 0 0 0 0 0 0 0 0 0 0.446697 -3)根据表6-21中的0和l 数据的结果将评价人A 和B、B 和C、A 和C 利用交叉表方法进行统计(见表6-22),A*B 栏中“0*0”代表A、B 两人均判拒绝的次数,统计有44个;“0*1”代表A 判拒绝而B 判接受的次数,统计有6个;“1*0”代表A 判接受而B 判拒绝的次数,统计有3个;“1*1”代表AB 两人同时判为接受的次数,统计有97个,将统计结果依次填入表6-22中。

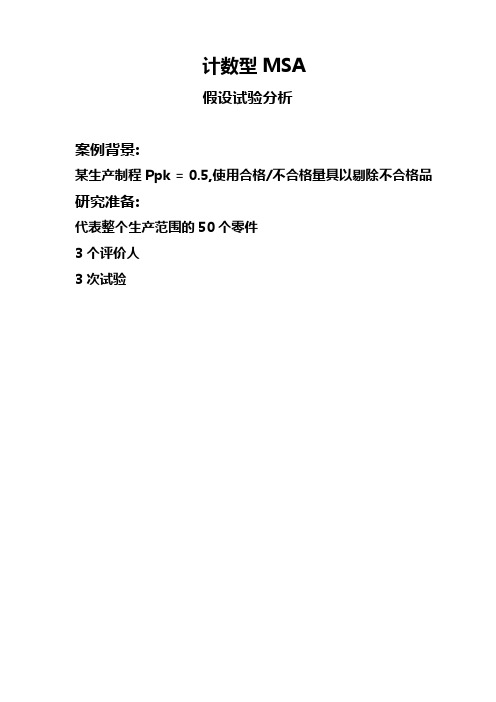

计数型MSA

假设试验分析

案例背景:

某生产制程Ppk = 0.5,使用合格/不合格量具以剔除不合格品研究准备:

代表整个生产范围的50个零件

3个评价人

3次试验

计数型数据收集表

评价人相互之间的比较A*B交叉表

B*C交叉表

A*C交叉表

Kappa - 评价人相互之间的一致性程度指标

Kappa = (Po-Pe)/(1-Pe)

Po = 对角单元观察比例之和

Pe = 对角单元期望比例之和

Kappa >= 0.75 显示良好的一致性

Kappa < 0.40 显示一致性程度不好

A*B交叉表

例如, 计算Kappa(A*B)

Po = (44+97)/150=0.940

Pe = (15.7+68.7)/150=0.563

Kappa(A*B) =(0.940 - 0.563) /(1 - 0.563)=0.86

但此Kappa并没有告知测量系统分辨合格/不合格能力比较评价人与基准的一致性

A*基准交叉表

B*基准交叉表

C*基准交叉表

以上数据显示每个评价人与基准之间有很好的一致性

有效性

正确判定件数/总判定件数

错误率

不拒收不合格品的次数/(正确判定不合格品次数+不拒收不合格品的次数)

错误警报率

拒收合格品的次数/(正确判定合格品次数+拒收合格品的次数)

以评价人A为例

有效性 = 42/50 = 0.84 = 84%

错误率 = 3/48 = 0.063 = 6.3%

错误警报率 = 5/102 = 0.049 = 4.9%

正确判定件数从数据收集表统计

测量系统接受指南。

1、2、3、4、5、线性GRR计数型Kappa分析MSA测量系统分析全套表格模板稳定性偏倚Excel原件可在本文档左侧回形针处取出再现性Kappa=(Po-Pe)/(1-Pe)A*参考 交叉表A01总计Po:0.95Pe:0.51B*参考 交叉表B01总计Po:0.97Pe:0.51C*参考 交叉表C01总计Po:0.96Pe:0.5130期望的数量26.4636.5463数量38487期望的数量数量60363一致性好6666Kappa 一致性好判定误发期望的数量638728 4.76%可接受2.30%可接受 4.76%可接受3.45%可接受可接受5.75%可接受01参考总计62063871501C0.90有效性判定重复性检查总数匹配数漏发A A B 评价人评价人%B 93.33%可接受判 定判定0.9383.33%2530 3.17%36.5450.4687数量638715090.00%可接受0.92A C 一致性好150期望的数量B 期望的数量36.9651.0488数量6387150期望的数量26.0435.9662数量38588期望的数量6387数量60248.7284150数量6387150期望的数量35.28数量28284总计01Kappa 判 定A*B 0.89一致性好C 3027A*C 0.93一致性好参考B*C 参考总计可接受期望的数量27.7238.280.90一致性好数量615Page 11 of 11。

假设试验一.基本资料1.产品代号/品名:2.测定器:3.测定数注:1表示合格, 0表示不合格.) 4.操作者之间交叉表A*B交叉表0,B-1为0的次数)+ (A-2为0,B-2为0的次数) + (A-3为0,B-3为0的次数)6=(A-1为0,B-1为1的次数) + (A-2为0,B-2为1的次数) + (A-3为0,B-3为1的次数)3=(A-1为1,B-1为0的次数) + (A-2为1,B-2为0的次数) + (A-3为1,B-3为0的次数)1,B-1为1的次数)+ (A-2为1,B-2为1的次数)+ (A-3为1,B-3为1的次数)期望的数量15.7 =150 *(47/150*50/150)期望的数量34.3 =150 *(103/150 *50/150)期望的数量31.3 =150 *(47/150 *100/150)期望的数量68.7 =150 *(103/150 *100/150)二.一致性评估1.一致性评估标准 标准: Kappa≥0.75 合格,表示一致性好;标准: Kappa≤0.4不合格,表示一致性差;标准: 0.75<Kappa<0.4,有条件合格, 表示一致性较好.注: Kappa最大值等于1.三.有效性评做.1.有效性评估标准评价者可接收:需要改进2.计算公式2.1.有效性=作出正确决定的次数/总决定次数有效性评价者不可接收:需要改进≥90%评价者可接收决定测量系统≥80%<80%员A:(A1/A2/A3与参考值84%完全一致的次数42)/50=84%员B:(B1/B2/B3与参考值90%完全一致的次数45)/50=90%员C:(C1/C2/C3与参考值80%完全一致的次数40)/50=80%。