信源的信息熵是概率分布Px

- 格式:ppt

- 大小:1.10 MB

- 文档页数:14

信源熵的名词解释信源熵(Source Entropy)是信息论中一个重要的概念,用于衡量信息源的不确定性和信息的平均编码长度。

在信息论中,信息可以被看作是从一个信源中获取的,而信源熵用来描述这个信源的不确定性大小。

信源熵的计算方法是根据信源可能产生的符号的概率分布来进行的。

具体来说,如果一个信源有n个可能取值(符号)S1,S2,...,Sn,并且每个符号出现的概率分别为P1,P2,...,Pn,那么信源的熵H(S)可以通过下面的公式计算得出:H(S) = -P1log(P1) - P2log(P2) - ... - Pnlog(Pn)其中,log是以2为底的对数,P1,P2,...,Pn是概率分布。

信源熵的含义是,对于一个不确定性较大的信源,需要更长的编码长度来表示每一个符号,所以熵值越大,说明信息的平均编码长度越长。

相反,当一个信源的不确定性较小,即各个符号出现的概率分布较平均时,信息的平均编码长度较短,熵值较小。

以一个简单的例子来说明信源熵的概念。

假设有一个只有两个符号的信源,分别记为S1和S2,它们出现的概率分别为P1和P2。

如果这两个符号的概率分布相等(即P1 = P2 = 0.5),那么信源的熵就是最大的,因为这两个符号的不确定性相同,需要同样长度的编码来表示它们。

而如果其中一个符号的概率接近于1,另一个符号的概率接近于0,那么信源的熵就是最小的,因为其中一个符号的信息是确定的,只需要很短的编码来表示它。

这个例子可以帮助我们理解信源熵与不确定性之间的关系。

除了信源熵,信息论中还有一个重要的概念是条件熵(Conditional Entropy)。

条件熵是在已知一定的背景条件下,信源的不确定性大小,即在给定前提条件下的平均编码长度。

条件熵可以通过信源和条件之间的联合概率分布来计算,其公式为:H(S|T) = -ΣΣP(s, t)log(P(s|t))其中,P(s, t)表示符号s和条件t联合发生的概率。

信息论与编码期末考试题信息论与编码期末考试题(一)一、判断题.1.当随机变量和相互独立时,条件熵等于信源熵.()2.由于构成同一空间的基底不是唯一的,所以不同的基底或生成矩阵有可能生成同一码集.()3.一般情况下,用变长编码得到的平均码长比定长编码大得多.()4.只要信息传输率大于信道容量,总存在一种信道编译码,可以以所要求的任意小的误差概率实现可靠的通信.()5.各码字的长度符合克拉夫特不等式,是唯一可译码存在的充分和必要条件.()6.连续信源和离散信源的熵都具有非负性.()7.信源的消息通过信道传输后的误差或失真越大,信宿收到消息后对信源存在的不确定性就越小,获得的信息量就越小.8.汉明码是一种线性分组码.()9.率失真函数的最小值是.()10.必然事件和不可能事件的自信息量都是.()二、填空题1、码的检、纠错能力取决于.2、信源编码的目的是;信道编码的目的是.3、把信息组原封不动地搬到码字前位的码就叫做.4、香农信息论中的三大极限定理是、、.5、设信道的输入与输出随机序列分别为和,则成立的条件..6、对于香农-费诺编码、原始香农-费诺编码和哈夫曼编码,编码方法惟一的是.7、某二元信源,其失真矩阵,则该信源的= .三、计算题.1、某信源发送端有2种符号,;接收端有3种符号,转移概率矩阵为.(1)计算接收端的平均不确定度;(2)计算由于噪声产生的不确定度;(3)计算信道容量以及最佳入口分布.2、一阶马尔可夫信源的状态转移图如右图所示,信源的符号集为.(1)求信源平稳后的概率分布;(2)求此信源的熵;(3)近似地认为此信源为无记忆时,符号的概率分布为平稳分布.求近似信源的熵并与进行比较.3、设码符号为,信源空间为试构造一种三元紧致码.4、设二元线性分组码的生成矩阵为.(1)给出该码的一致校验矩阵,写出所有的陪集首和与之相对应的伴随式;(2)若接收矢量,试计算出其对应的伴随式并按照最小距离译码准则试着对其译码.(二)一、填空题1、信源编码的主要目的是,信道编码的主要目的是2、信源的剩余度主要来自两个方面,一是,二是3、三进制信源的最小熵为,最大熵为4、无失真信源编码的平均码长最小理论极限制为5、当时,信源与信道达到匹配。

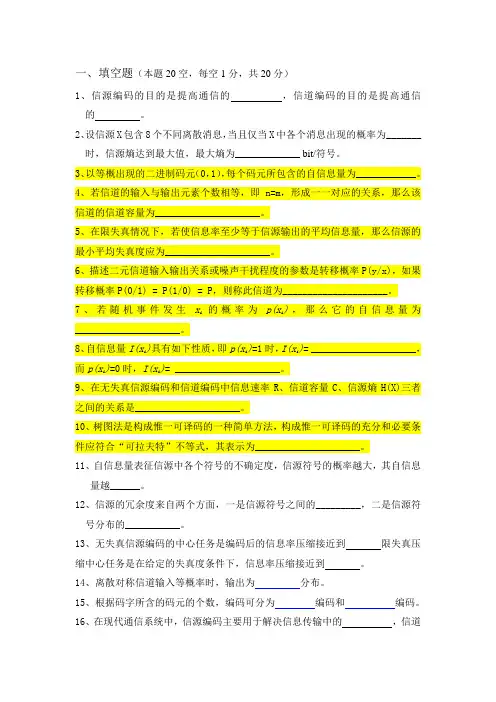

一、填空题(本题20空,每空1分,共20分)1、信源编码的目的是提高通信的,信道编码的目的是提高通信的。

2、设信源X包含8个不同离散消息,当且仅当X中各个消息出现的概率为_______时,信源熵达到最大值,最大熵为_____________ bit/符号。

3、以等概出现的二进制码元(0,1),每个码元所包含的自信息量为____________。

4、若信道的输入与输出元素个数相等,即n=m,形成一一对应的关系,那么该信道的信道容量为_____________________。

5、在限失真情况下,若使信息率至少等于信源输出的平均信息量,那么信源的最小平均失真度应为_____________________。

6、描述二元信道输入输出关系或噪声干扰程度的参数是转移概率P(y/x),如果转移概率P(0/1) = P(1/0) = P,则称此信道为_____________________。

7、若随机事件发生x i的概率为p(x i),那么它的自信息量为_____________________。

8、自信息量I(x i)具有如下性质,即p(x i)=1时,I(x i)= _____________________,而p(x i)=0时,I(x i)= _____________________。

9、在无失真信源编码和信道编码中信息速率R、信道容量C、信源熵H(X)三者之间的关系是_____________________。

10、树图法是构成惟一可译码的一种简单方法,构成惟一可译码的充分和必要条件应符合“可拉夫特”不等式,其表示为_____________________。

11、自信息量表征信源中各个符号的不确定度,信源符号的概率越大,其自信息量越______。

12、信源的冗余度来自两个方面,一是信源符号之间的_________,二是信源符号分布的___________。

13、无失真信源编码的中心任务是编码后的信息率压缩接近到限失真压缩中心任务是在给定的失真度条件下,信息率压缩接近到。

概率分布的熵概率分布的熵是信息论中一个重要的概念,用于衡量一个概率分布的不确定性或者信息量的平均值。

在信息论中,熵被定义为概率分布中所有可能事件的信息量的期望值的负数。

熵越大,表示概率分布越不确定,信息量越大。

概率分布的熵在各个领域都有广泛的应用。

在通信领域,熵被用来衡量信息的压缩和传输的效率。

在统计学中,熵被用来评估模型的复杂度和预测的准确性。

在物理学中,熵被用来描述系统的混乱程度和热力学性质。

在信息论中,概率分布的熵由概率分布的概率值计算得出。

对于一个离散的概率分布,熵的计算公式为:H(X) = -∑P(x)log₂P(x)其中,H(X)表示概率分布X的熵,P(x)表示事件x发生的概率,log₂表示以2为底的对数。

概率分布的熵有几个重要的性质。

首先,当概率分布是均匀分布时,熵达到最大值。

这是因为均匀分布中,所有事件发生的概率都是相等的,没有任何一种事件更可能发生,因此概率分布最不确定,熵最大。

其次,当概率分布是确定性分布时,即只有一个事件发生的概率为1,其他事件发生的概率为0时,熵为0。

因为只有一个事件发生,概率分布是确定的,没有不确定性。

概率分布的熵还可以用于比较不同概率分布的不确定性。

如果两个概率分布的熵相等,那么它们具有相同的不确定性。

如果一个概率分布的熵大于另一个概率分布的熵,那么前者比后者更不确定。

因此,熵可以用来量化不同概率分布之间的差异。

在实际应用中,概率分布的熵经常被用来优化问题。

例如,在机器学习中,熵被用来衡量分类模型的纯度。

对于一个分类问题,如果一个模型的熵较大,表示模型的预测结果更不确定,纯度较低。

相反,如果一个模型的熵较小,表示模型的预测结果更确定,纯度较高。

因此,通过最大化或最小化熵,可以得到更好的分类模型。

概率分布的熵是信息论中的一个重要概念,用于衡量概率分布的不确定性或者信息量的平均值。

熵越大,表示概率分布越不确定,信息量越大。

概率分布的熵在通信、统计学和物理学等领域有广泛的应用,可以用来衡量信息的压缩和传输的效率,评估模型的复杂度和预测的准确性,描述系统的混乱程度和热力学性质。

信源熵的原理及应用1. 介绍信源熵是信息论中一个重要的概念,它描述了一个随机信源所具有的信息量的平均度量。

信源的熵越大,表示信息的不确定性越高,需要更多的信息来描述。

本文将介绍信源熵的原理,并探讨其在通信、数据压缩以及密码学等领域的应用。

2. 信源熵的定义信源熵是正信息论中一个重要概念,它用来度量一个随机信源所具有的信息量的平均度量。

对于一个离散随机变量X,它的概率分布为P(X),则信源的熵定义如下:equationequation其中,xi是随机变量X的取值,P(xi)是xi对应的概率。

3. 信源熵的性质•信源熵的取值范围:信源的熵是非负的,即H(X) ≥ 0。

•最大熵原理:对于一个离散信源,当它的概率分布均匀时,即每个xi的概率相等时,信源熵达到最大值。

•如果一个信源越复杂,即其概率分布越不均匀,那么它的熵就越小。

4. 信源熵的应用4.1 通信系统在通信系统中,信源熵可以用来度量信道所传输信息的平均编码长度。

根据香农定理,信道传输的平均编码长度L与信源熵H(X)满足以下关系:equationequation当信道编码满足L = H(X)时,信道编码称为最优编码,即编码的平均长度等于信源熵。

4.2 数据压缩信源熵还可以应用于数据压缩领域。

数据压缩的目的是使用更少的位数来存储或传输数据。

通过统计一个数据源的概率分布,可以将出现概率低的数据编码为较长的二进制位,而出现概率高的数据编码为较短的二进制位。

信源熵提供了压缩算法的理论基础。

4.3 密码学在密码学中,信源熵用于度量消息或密码的随机性。

如果一个密码是完全随机的,并且每个密钥都是等概率选择的,那么这个密码的熵将达到最大值。

信源熵可以用来评估一个密码系统的安全性,以及密码生成算法的随机性。

5. 总结本文介绍了信源熵的原理及其应用。

信源熵是衡量信息量的重要度量指标,它在通信、数据压缩以及密码学等领域具有多种应用。

通过明确信源熵的定义和性质,我们可以更好地理解和应用它。

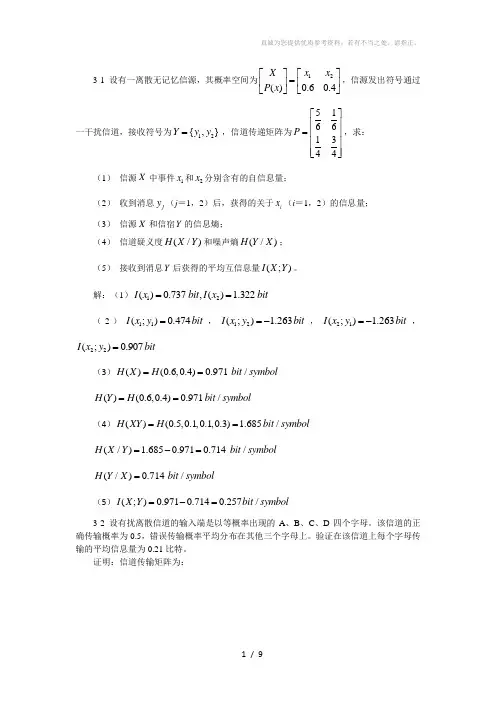

3-1 设有一离散无记忆信源,其概率空间为12()0.60.4X x x P x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦,信源发出符号通过一干扰信道,接收符号为12{,}Y y y =,信道传递矩阵为51661344P ⎡⎤⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦,求: (1) 信源X 中事件1x 和2x 分别含有的自信息量;(2) 收到消息j y (j =1,2)后,获得的关于i x (i =1,2)的信息量; (3) 信源X 和信宿Y 的信息熵;(4) 信道疑义度(/)H X Y 和噪声熵(/)H Y X ; (5) 接收到消息Y 后获得的平均互信息量(;)I X Y 。

解:(1)12()0.737,() 1.322I x bit I x bit ==(2)11(;)0.474I x y bit =,12(;) 1.263I x y bit =-,21(;) 1.263I x y bit =-,22(;)0.907I x y bit =(3)()(0.6,0.4)0.971/H X H bit symbol ==()(0.6,0.4)0.971/H Y H bit symbol ==(4)()(0.5,0.1,0.1,0.3) 1.685/H XY H bit symbol ==(/) 1.6850.9710.714/H X Y bit symbol =-= (/)0.714/H Y X bit symbol =(5)(;)0.9710.7140.257/I X Y bit symbol =-=3-2 设有扰离散信道的输入端是以等概率出现的A 、B 、C 、D 四个字母。

该信道的正确传输概率为0.5,错误传输概率平均分布在其他三个字母上。

验证在该信道上每个字母传输的平均信息量为0.21比特。

证明:信道传输矩阵为:11112666111162661111662611116662P ⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦,信源信宿概率分布为:1111()(){,,,}4444P X P Y ==, H(Y/X)=1.79(bit/符号),I(X;Y)=H(Y)- H(Y/X)=2-1.79=0.21(bit/符号)3-3 已知信源X 包含两种消息:12,x x ,且12()() 1/2P x P x ==,信道是有扰的,信宿收到的消息集合Y 包含12,y y 。

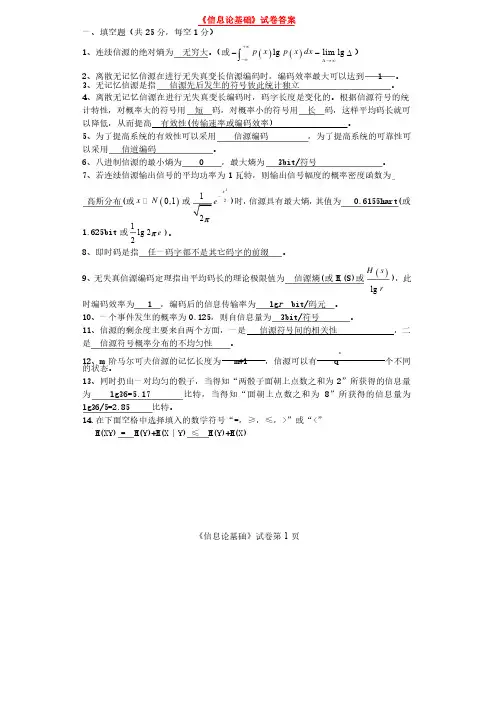

《信息论基础》试卷第1页《信息论基础》试卷答案一、填空题(共25分,每空1分)1、连续信源的绝对熵为无穷大。

(或()()lg lim lg p x p x dx +¥-¥D ®¥--D ò)2、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 1 1 。

3、无记忆信源是指信源先后发生的符号彼此统计独立。

4、离散无记忆信源在进行无失真变长编码时,码字长度是变化的。

根据信源符号的统计特性,对概率大的符号用短码,对概率小的符号用长码,这样平均码长就可以降低,从而提高有效性有效性((传输速率或编码效率传输速率或编码效率) ) ) 。

5、为了提高系统的有效性可以采用信源编码,为了提高系统的可靠性可以采用信道编码。

6、八进制信源的最小熵为、八进制信源的最小熵为 0 0 0 ,最大熵为,最大熵为,最大熵为 3bit/ 3bit/ 3bit/符号符号。

7、若连续信源输出信号的平均功率为1瓦特,则输出信号幅度的概率密度函数为高斯分布高斯分布((或()0,1x N 或2212x ep-)时,信源具有最大熵,其值为其值为 0.6155hart( 0.6155hart( 0.6155hart(或或1.625bit 或1lg 22e p )。

8、即时码是指任一码字都不是其它码字的前缀。

9、无失真信源编码定理指出平均码长的理论极限值为信源熵信源熵((或H r (S)(S)或或()lg H s r),此时编码效率为时编码效率为 1 1 1 ,编码后的信息传输率为,编码后的信息传输率为,编码后的信息传输率为 lg lg r bit/ bit/码元码元。

1010、一个事件发生的概率为、一个事件发生的概率为0.1250.125,则自信息量为,则自信息量为,则自信息量为 3bit/ 3bit/ 3bit/符号符号。

试题编号:重庆邮电大学2009/2010学年2学期《信息论基础》试卷(期末)(A卷)(开卷)一、填空题(共15分,每空1分)1、当时,信源与信道达到匹配。

2、若高斯白噪声的平均功率为6 W,则噪声熵为。

如果一个平均功率为9 W的连续信源的熵等于该噪声熵,则该连续信源的熵功率为。

3、信源符号的相关程度越大,信源的符号熵越,信源的剩余度越。

4、离散无记忆信源在进行无失真变长信源编码时,码字长度是变化的。

根据信源符号的统计特性,对概率的符号用短码,对概率的符号用长码,从而减少平均码长,提高编码效率。

8、香农第一编码定理指出平均码长的理论极限值为,《信息论基础》试卷第1页《信息论基础》试卷第2页此时编码效率为 。

4、在下面空格中选择填入数学符号“=,≥,≤,>”或“<” (1)()()2212X X H H =X ()X 3H = ()3321X X X H (2)()XY H ()()Y X H Y H |+ ()()X H Y H +。

9、有一信源X ,其概率分布为⎥⎥⎦⎤⎢⎢⎣⎡=⎥⎦⎤⎢⎣⎡818141214321xx x x P X ,若对该信源进行100次扩展,则每扩展符号的平均信息量是 。

11、当 时,信源熵为最大值。

8进制信源的最大熵为 。

二、判断题(正确打√,错误打×)(共5分,每小题1分)1)噪声功率相同的加性噪声信道中以高斯噪声信道的容量为最大。

( )2)即时码可以在一个码字后面添上一些码元构成另一个码字。

( ) 3)连续信源的熵可正、可负、可为零, ( ) 4)平均互信息始终是非负的。

( ) 5) 信道容量C 只与信道的统计特性有关,而与输入信源的概率分布无关。

( )《信息论基础》试卷第3页三、(10分)计算机终端发出A 、B 、C 、D 、E 五种符号,出现概率分别为1/16,1/16,1/8,1/4,1/2。

通过一条带宽为18kHz 的信道传输数据,假设信道输出信噪比为2047,试计算:1) 香农信道容量;2) 无误码传输的最高符号速率。

第二章 信源与信息熵(第二讲)(2课时)主要内容:(1)信源的描述(2)信源的分类 重点:信源的分类,马尔可夫信源。

难点:信源的描述,马尔可夫信源。

作业:2.1, 2.2, 2.3说明:本堂课推导内容较多,枯燥平淡,不易激发学生兴趣,要注意多讨论用途。

另外,注意,解题方法。

多加一些内容丰富知识和理解。

2.1 信源的描述与分类在通信系统中收信者在未收到消息以前对信源发出什么消息是不确定的,是随机的,所以可用随机变量、随机序列或随机过程来描述信源输出的消息,或者说用一个样本空间及其概率测度——概率空间来描述信源。

信源:产生随机变量、随机序列和随机过程的源。

信源的基本特性:具有随机不确定性。

信源的分类离散信源:文字、数据、电报——随机序列 连续信源:话音、图像——随机过程离散信源:输出在时间和幅度上都是离散分布的消息。

消息数是有限的或可数的,且每次只输出其中一个消息,即两两不相容。

发出单个符号的无记忆信源离散无记忆信源: 发出符号序列的无记忆信源离散信源离散有记忆信源: 发出符号序列的有记忆信源发出符号序列的马尔可夫信源 概率论基础:无条件概率,条件概率和联合概率的性质和关系: 非负性0()()(/)(/)()1i j j i i j i j p x p y p y x p x y p x y ≤≤,,,, 完备性111111()1,()1,(/)1,(/)1,()1n m nijiji j i mm nji i j j j i p x p y p x y p yx p x y ===========∑∑∑∑∑∑11()(),()()n mijjijii j p x y p y p x y p x ====∑∑联合概率()()(/)()(/)()()()(/)()(/)()i j i j i j i j i j i j j i j i j i p x y p x p y x p y p x y X Y p x y p x p y p y x p y p x y p x =====当与相互独立时,,贝叶斯公式11()()(/)(/)()()i j i j i j j i nmijiji j p x y p x y p x y p y x p x y p x y ====∑∑,2.1.1 无记忆信源:例如扔骰子,每次试验结果必然是1~6点中的某一个面朝上。

《信息理论与编码》习题参考答案1. 信息是什么?信息与消息有什么区别和联系?答:信息是对事物存在和运动过程中的不确定性的描述。

信息就是各种消息符号所包含的具有特定意义的抽象内容,而消息是信息这一抽象内容通过语言、文字、图像和数据等的具体表现形式。

2. 语法信息、语义信息和语用信息的定义是什么?三者的关系是什么? 答:语法信息是最基本最抽象的类型,它只是表现事物的现象而不考虑信息的内涵。

语义信息是对客观现象的具体描述,不对现象本身做出优劣判断。

语用信息是信息的最高层次。

它以语法、语义信息为基础,不仅要考虑状态和状态之间关系以及它们的含义,还要进一步考察这种关系及含义对于信息使用者的效用和价值。

三者之间是内涵与外延的关系。

第2章1. 一个布袋内放100个球,其中80个球是红色的,20个球是白色的,若随机摸取一个球,猜测其颜色,求平均摸取一次所能获得的自信息量?答:依据题意,这一随机事件的概率空间为120.80.2X x x P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦其中:1x 表示摸出的球为红球事件,2x 表示摸出的球是白球事件。

a)如果摸出的是红球,则获得的信息量是()()11log log0.8I x p x =-=-(比特)b)如果摸出的是白球,则获得的信息量是()()22log log0.2I x p x =-=-(比特)c) 如果每次摸出一个球后又放回袋中,再进行下一次摸取。

则如此摸取n 次,红球出现的次数为()1np x 次,白球出现的次数为()2np x 次。

随机摸取n 次后总共所获得信息量为()()()()1122np x I x np x I x +d)则平均随机摸取一次所获得的信息量为()()()()()()()()()112211221log log 0.72 H X np x I x np x I x n p x p x p x p x =+⎡⎤⎣⎦=-+⎡⎤⎣⎦=比特/次2. 居住某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。

第1章 绪论1.1 信源、编码器、信道、干扰、译码器、信宿 1.2 香农1.3 通信系统模型1.4信号是消息的表现形式,是物理的,比如电信号、光信号等。

消息是信息的载荷者,是信号的具体内容,不是物理的,但是又比较具体,例如语言、文字、符号、图片等。

信息包含在消息中,是通信系统中被传送的对象,消息被人的大脑所理解就形成了信息。

1.5 略第2章 信息的统计度量2.1 少2.2 y 的出现有助于肯定x 的出现、y 的出现有助于否定x 的出现、x 和y 相互独立 2.3 FTTTF 2.4 2.12比特2.5依题意,题中的过程可分为两步,一是取出一枚硬币恰好是重量不同的那一枚,设其发生的概率为1p ,由于每枚硬币被取出的概率是相同的,所以1181p =所需要的信息量()()1log 6.34I A p bit =-=二是确定它比其他硬币是重还是轻,设其发生的概率为2p ,则212p =总的概率12111812162p p p ==⨯=所需要的信息量()log log1627.34I p bit =-==2.6 设A 表示“大学生”这一事件,B 表示“身高1.60m 以上”这一事件,则()()()0.250.5|0.75p A p B p B A ===故()()()()()()|0.750.25|0.3750.5p AB p A p B A p A B p B p B ⨯====()()()11|loglog 1.42|0.375I A B bit p A B ===2.7 四进制波形所含的信息量为()log 42bit =,八进制波形所含信息量为()log 83bit =,故四进制波形所含信息量为二进制的2倍,八进制波形所含信息量为二进制的3倍。

2.8()()()()()()2322log 3log 32log 3 1.585I p bit I p bit I I =-=-==故以3为底的信息单位是比特的1.585倍。

信息论复习题一、名词解释 1、信息 2、离散信源 3、自信息量4、离散平稳无记忆信源5、马尔可夫信源6、连续信源7、信源冗余度8、连续信道9、信道容量 10、强对称信道 11、对称信道 12、信息熵 13、平均互信息 14、平均失真度 15、码的最小距离 16、率失真函数二、判断1、 必然事件和不可能事件的自信息量都是0 。

错2、 自信息量是)(i x p 的单调递减函数。

对 3、 单符号离散信源的自信息和信源熵都具有非负性。

对4、 自信息量、条件自信息量和联合自信息量之间有如下关系:)/()()/()()(j i j i j i j i y x I y I x y I x I y x I +=+= 对5、 自信息量、条件自信息量和互信息量之间有如下关系:)/()()/()();(ij j j i i j i x y I y I y x I x I y x I -=-= 对 6、 当随机变量X 和Y 相互独立时,条件熵等于信源熵。

对 7、 当随机变量X 和Y 相互独立时,I (X ;Y )=H (X )。

错 8、 信源熵具有严格的下凸性。

错9、 平均互信息量I (X ;Y )对于信源概率分布p (x i )和条件概率分布p (y j /x i )都具有凸函数性。

对10、一维高斯分布的连续信源,其信源熵只与其均值和方差有关。

错 11、连续信源和离散信源的熵都具有非负性。

错 12、连续信源和离散信源都具有可加性。

对13、连续信源和离散信源的平均互信息都具有非负性。

对 14、定长编码的效率一般小于不定长编码的效率。

对15、离散无噪信道的信道容量等于log 2n ,其中n 是信源X 的消息个数。

错 16、率失真函数的最小值是0 。

对 17、率失真函数没有最大值。

错18、信源编码通常是通过压缩信源的冗余度来实现的。

对19、一般情况下,霍夫曼编码的效率大于香农编码和费诺编码。

对20、在编m (m>2)进制的霍夫曼码时,要考虑是否需要增加概率为0的码字,以使平均码长最短。