基于WordNet的英语词语相似度计算

- 格式:pdf

- 大小:650.59 KB

- 文档页数:8

基于中文WordNet的中英文词语相似度计算吴思颖;吴扬扬【摘要】介绍一种基于中文WordNet的中英文词语相似度计算方法.在WordNet同义词集的上下位关系图中,引入了距离、密度、深度3个因素来估计同义词集之间的相似度,采用一个自适应的方案来解决候选同义词集组合的权重和取舍问题.实现了一个可以计算英-英、汉-英、汉-汉词语之间相似度的算法,所得结果比较符合人们对词语的理解.【期刊名称】《郑州大学学报(理学版)》【年(卷),期】2010(042)002【总页数】4页(P66-69)【关键词】中文WordNet;词语相似度;语义相似度【作者】吴思颖;吴扬扬【作者单位】华侨大学计算机科学与技术学院,福建,厦门,361021;华侨大学计算机科学与技术学院,福建,厦门,361021【正文语种】中文【中图分类】TP391Wo rdNet是按语义关系组织的,它使用同义词集合代表概念,词汇关系在词语之间体现,语义关系在概念之间体现,一个词语属于若干个同义词集,而一个同义词集又包含若干个词语.由于语义关系是一种词义之间的关系,而词义是用同义词集合来表示,因此很自然地把语义关系看作为同义词集合之间的关系. WordNet中词汇概念的语义关系主要包括上下位、同义、反义、整体和部分、蕴含、属性、致使等不同的语义关系.中文Wo rdNet建立在普林斯顿大学开发的英文Wo rdNet词典的原理基础上,实现了一个约118 000中文词和115 400同义词集的中文-中文词典的功能,是使用了现有的英-汉词典库对英文WordNet中的词进行手工翻译而得到的.它同样也具有同义词、同等词、泛词等在英-英词典中提供的功能.词语相似度的计算方法主要分为两类[1-2]:一类方法称为基于上下文的方法,它利用大规模的语料或词语定义,收集统计数据,来评估词汇语义相似度;另一类是利用词典中的关系和层次结构,如概念之间的上下位关系和同位关系来计算词语的相似度.文献[3]利用了同义词集在WordNet中的最短距离和这条路径的转向次数来计算词语的相似度;文献[4]引入了本体和语料库,以2个同义词集的公共子结点的范围和公共的信息来计算其相似度;文献[1]从WordNet中提取同义词并采取向量空间方法计算英语词语的相似度.但由于Wo rdNet词典的语言限制,它们都局限于英文词语的语义相似度分析.文献[5]讨论了义原的相似度计算方法、集合和特征结构的相似度计算方法,并在此基础上提出了利用《知网》进行词语相似度计算的算法.本文利用中文Wo rdNet,在Wo rdNet同义词集的上下位关系图中,引入了距离、密度、深度3个因素来估计同义词集之间的相似度,用一个自适应的方案来解决候选同义词集组合的权重和取舍问题,设计并实现了一个能计算英-英、英-汉、汉-汉词语之间相似度的算法,所得结果比较符合人们对词语的理解.要计算2个词语之间的相似度,首先需要分别查出这2个词语所属的所有同义词集,并两两组合计算其相似度,最后根据这些同义词集组合的相似度计算出2个词语之间的相似度.下面分别介绍同义词集和词语的相似度计算.在WordNet中,同义词集(synset)之间的上下位关系形成了一个图结构,每个synset有0个或若干个上位和下位synset.因此,基于以下原则来计算同义词集之间的相似度[6]:1)在上下位关系图中,任意2个synset结点的距离越远,语义相似度越小.2)图中结点所处的位置密度越高,说明该局部的词义划分越细,相似度越低.3)在上下位关系图中相同距离的2个synset结点,所处的层次越深,描述的事物越具体,因此相似度越大.引入距离因子、密度因子、深度因子来衡量同义词集之间的相似度.距离因子σ计算公式为其中,lenth为2个synset之间的距离,θ为阈值参数.距离越大,σ值就越小,当距离大于阈值θ时,距离因子为0.密度越大,语义相似度越低.密度的计算可从局部结点的个数入手,具体方法为:分别从2个当前结点出发向上走3层,每一层的结点个数分别记PN1,PN2,PN3.期间2个结点若相遇,则终止,并将其上层结点数计为0,最终计算局部结点个数PN为其中,PN1是当前结点所在层次的结点个数,PN2,PN3依次为其上层结点个数.则密度因子φ为PN值越大表示密度越大,密度因子越小,且PN≥1,使得0<φ≤1.此外,深度越深,语义相似度越大.深度因子ω的计算公式为其中,dep th为该节点的深度,Ed为整棵语义树中所有结点的平均深度.即当结点的深度大于均值时,其深度因子为正,否则为负.综合考虑距离、密度、深度3个因素,则2个同义词集之间的相似度为若sim>1,则取sim=1.-φ和-ω分别为2个词的密度因子和深度因子的均值;α和β分别为密度因子和深度因子的权重.由于每个词语有一个或多个词义(sense),即它属于若干个同义词集,因此采用如下步骤计算2个词语之间的相似度:1)用联合查询语句在中文Wo rdNet词典数据库的各个翻译版本中,查找出被比较的词(英文单词或中文词语)所有可能出现的同义词集的id.2)将中文单词所属同义词集的标识synset_id转换为对应的英文同义词集的synset_id.3)令词a有m个词义(属于m个同义词集),词b有n个词义,即a,b所属的同义词集有m×n对组合.计算这m×n对同义词集的相似度,并排序.4)从大到小排序后,第1对同义词集所占的比重最大,令其权重为ρ,则第2对同义词集所占的权重为剩余比重×ρ,以此类推.设置一个阈值参数δ(0<δ<1),计算过程中仅考虑所有组合的前百分比阈值,如δ=0.3,则仅计算所有同义词集组合相似度最大的前30%.在实际操作中,当同义词集组合个数较多时,常出现1对或前几对同义词集的相似度非常大,因此首对权重ρ不宜过大,否则将失去综合权衡的意义.为了能够综合考虑被选取的同义词集组合的影响力,考虑根据选取的同义词集组合的数量来调节各组合所占的权重.因此,提出了一个根据同义词集组合个数num自适应调节参数ρ的公式,使得ρ∈[0.5,0.9],即当入选的同义词集组合个数num越小,首对同义词集的权重ρ越高(最大0.9),而ρ值随num的增加而递减(最小0.5),计算公式为其中,num=m×n.根据上述方法,实现了一个基于中文WordNet的词语相似度计算程序模块.在实验中,根据多次尝试中取得的经验,将文中提到的几个参数设置如下:距离因子中的阈值参数θ=7;深度因子中所有结点的平均深度经计算得Ed=8.624 3;密度因子权重α=0.1;深度因子权重β=0.1;同义词集组合前百分比阈值δ=0.2,即取相似度最大的前20%的组合考虑.对于词语相似度计算结果的评价,最好是放到实际的系统中(如本课题后期研究的数据空间的进化将利用此结果数据模式进行匹配),观察不同的计算方法对系统性能的影响,在条件不许可的情况下采用人工判别的方法.对比了文献[5]中介绍的同样能计算中文词语相似度的基于《知网》的词汇语义相似度计算方法,对比结果如表1所示,方法1为文献[5]中介绍的方法,方法2为本文介绍的基于中文WordNet的相似度计算方法.对比表1结果,方法2的实验结果与人们的理解比较一致,方法1得到的相似度与人们的理解相对差别大一些.例如,方法1对“论文”、“文章”、“文献”这样词义接近的词汇的相似度估计相差巨大,因为方法1中计算词语相似度时采用了2个词之间各个概念相似度的最大值.而方法2计算结果中,“论文”与“文章”、“文献”的相似度比较接近,都在0.91以上,因为方法2对词语各个概念(同义词集)的各种组合采取了一种动态加权和的办法,能自适应地调整组合之间的权重.本算法的另一个独特之处是兼容中英文双语的相似度计算,表2给出另外一些测试结果.从实验结果可以看出,“父亲”和“father”同为正式用语,相似度高于“父亲”和“爸爸”,而同为口语的“爸爸”和“dad”也有较高的相似度;“中国”和“亚洲”的相似度高于“中国”和“欧洲”也是较为合理的;“猫”直接类属于“动物”,因此“猫”和“动物”的相似度大于“猫”和“狗”的相似度.总体上看,该方法得到的大部分结果是较为准确的.本文主要分析了中文WordNet的体系结构,根据影响词语相似度的距离、密度和深度3个因素,定义了完整的同义词集之间的相似度算法,并采用了自适应的方法对被查词语的同义词集组合进行了取舍和权重定义.最后,实现了一个计算中英文词语相似度的算法,并进行了实验.测试结果表明:本方法得到的结果与人工判别结果基本一致,比基于《知网》的词汇语义相似度计算方法更符合人们的理解.下一步研究将把词语相似度算法应用于数据空间管理系统的进化和检索中,使数据空间的查询结果更为准确有效.【相关文献】[1] 荀恩东,颜伟.基于语义网计算英语词语相似度[J].情报学报,2006,25(1):43-48.[2] Sebti A,Barfrous A A.A new wo rd sense similarity measure inWordNet[C]//Proceedingsof the International M ulticonference on Computer Science and Information Technology.Washinton D C:IEEE Computer Society,2008:369-373.[3] Hirst G,St-Onge D.Lexical chains as rep resentationsof context fo r the detection and correction of malap ropisms[M]// WordNet:an Electronic Lexical Database.Cambridge M A:M IT Press,1998.[4] Resnik ing information content to evaluate semantic similarity in ataxonomy[C]//Proceedingsof the 14th International Joint Conference on A rtificial Intelligence.San Francisco:Mo rgan Kaufmann Publishers Inc,1995:448-453.[5] 刘群,李素建.基于《知网》的词汇语义相似度计算[J].计算语言学及中文信息处理,2002,7(2):59.[6] 张承立,陈剑波,齐开悦.基于语义网的语义相似度算法改进[J].计算机工程与应用,2006,42(17):165-166.。

一种基于WordNet语义相似度的改进算法作者:田姗来源:《数字技术与应用》2013年第08期摘要:随着信息的快速发展,计算词语语义相似度在很多领域得到了广泛应用与研究,包括信息检索,信息抽取,词义排歧,基于实例的机器翻译,文本分类等等。

本文在相关研究的基础上除了考虑路径外考虑了节点所在树中的深度和宽度,提出一种基于WordNet语义相似度的改进算法。

关键词:WordNet 语义距离语义相似度中图分类号:TP391 文献标识码:A 文章编号:1007-9416(2013)08-0113-01语义相似度计算在很多领域都有着广泛的应用,如自然语义处理,信息检索,词义排歧,文本分类以及基于实例的机器翻译等。

随着Internet技术的高速发展,语义相似度成为信息检索研究的重要组成部分。

当前语义相似度计算方法大致可以分为两类:一类是根据世界知识或者某种分类体系的方法来计算,主要是基于按照概念间结构层次关系组织的语义词典的方法,根据在这类语言学资源中概念之间的上下位关系和同位关系来计算词语的相似度;第二类是基于统计的方法,主要将上下文信息的概率分布作为词汇语义相似度的参照。

现有的研究中有的通过词结点之间上下位关系构成的最短路径计算语义相似度,文献[1-2]通过两个词的公共祖先结点的最大信息量计算语义相似度,文献[3-5]通过结合结点间的路径长度,概念层次树的深度,概念层次树的区域密度等因素综合考虑计算语义相似度。

国外很多研究者利用WordNet 中的同义词集组成的树状层次体系结构计算语义相似度。

1 WordNet简介WordNet是由Princeton 大学的心理学家,语言学家和计算机工程师联合设计的一种基于认知语言学的英语词典,它不只把单词以字母顺序排列,而且按照单词的意义组成一个“网络”。

由于包含了语义信息,所以WordNet有别于通常意义上的字典。

WordNet描述对象包括复合词、短语动词、搭配次词、成语、单词,其中单词是最基本的单位。

nltk计算词向量相似度

当使用 NLTK(自然语言处理工具包)计算词向量相似度时,可以使用其中的`word_similarity`函数来实现。

下面是一个示例代码,演示了如何使用 NLTK 计算词向量相似度:

```python

from nltk.corpus import wordnet

from nltk.metrics import word_similarity

# 定义两个词

word1 = "猫"

word2 = "狗"

# 计算词向量相似度

similarity = word_similarity(word1, word2)

# 打印相似度结果

print("相似度:", similarity)

```

在上述示例中,我们首先导入了`wordnet`和`word_similarity`模块。

然后,定义了两个要比较的词`word1`和`word2`。

接下来,使用`word_similarity`函数计算了这两个词的相似度,并将结果存储在`similarity`变量中。

最后,打印出相似度的结果。

需要注意的是,NLTK 的`word_similarity`函数基于 WordNet 词典来计算相似度,它考虑了词的语义关系和词汇层次结构。

然而,该函数仅适用于英文词汇。

如果你要处理其他语言或需要更高级的词向量相似度计算方法,可能需要使用其他的自然语言处理库或工具,如 GloVe、ELMo、BERT 等。

希望这个示例对你有帮助。

如果你有任何进一步的问题,请随时提问。

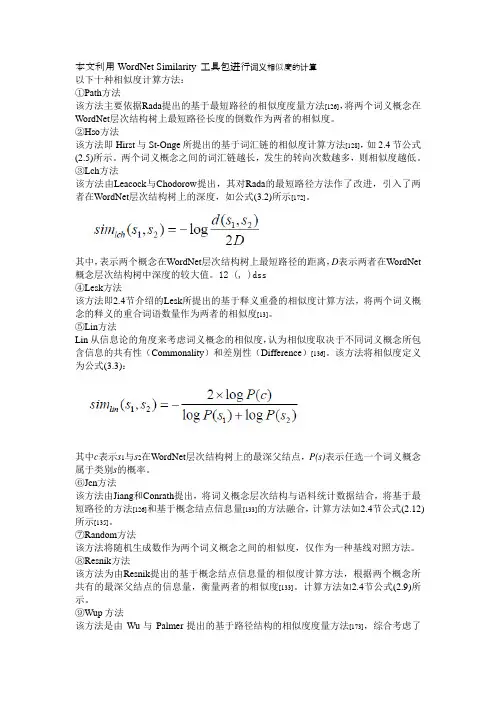

本文利用WordNet Similarity 工具包进行词义相似度的计算以下十种相似度计算方法:①Path方法该方法主要依据Rada提出的基于最短路径的相似度度量方法[126],将两个词义概念在WordNet层次结构树上最短路径长度的倒数作为两者的相似度。

②Hso方法该方法即Hirst与St-Onge所提出的基于词汇链的相似度计算方法[128],如2.4节公式(2.5)所示。

两个词义概念之间的词汇链越长,发生的转向次数越多,则相似度越低。

③Lch方法该方法由Leacock与Chodorow提出,其对Rada的最短路径方法作了改进,引入了两者在WordNet层次结构树上的深度,如公式(3.2)所示[172]。

其中,表示两个概念在WordNet层次结构树上最短路径的距离,D表示两者在WordNet 概念层次结构树中深度的较大值。

12 (, )dss④Lesk方法该方法即2.4节介绍的Lesk所提出的基于释义重叠的相似度计算方法,将两个词义概念的释义的重合词语数量作为两者的相似度[13]。

⑤Lin方法Lin从信息论的角度来考虑词义概念的相似度,认为相似度取决于不同词义概念所包含信息的共有性(Commonality)和差别性(Difference)[136]。

该方法将相似度定义为公式(3.3):其中c表示s1与s2在WordNet层次结构树上的最深父结点,P(s)表示任选一个词义概念属于类别s的概率。

⑥Jcn方法该方法由Jiang和Conrath提出,将词义概念层次结构与语料统计数据结合,将基于最短路径的方法[126]和基于概念结点信息量[133]的方法融合,计算方法如2.4节公式(2.12)所示[135]。

⑦Random方法该方法将随机生成数作为两个词义概念之间的相似度,仅作为一种基线对照方法。

⑧Resnik方法该方法为由Resnik提出的基于概念结点信息量的相似度计算方法,根据两个概念所共有的最深父结点的信息量,衡量两者的相似度[133]。

一种基于WordNet和Corpus Statistics的语义相似性计算方法张东娜;周春光;刘彦斌;郭东伟【摘要】提出一种新的基于WordNet和文本集语义参数IC的计算方法, 通过综合考虑概念在WordNet中语义信息以及数据集中的概率信息, 即概念的自信息, 同时利用新的参数考虑概念对在WordNet中的共享信息, 设计了一种通用的概念语义相似性计算方法, 该方法简化了传统语义相似性算法, 并解决了语义相似性计算领域的相关问题, 可以应用在信息抽取、信息检索、文档分类及本体学习中. 领域通用的数据集R&B数据实验结果表明, 该方法在计算语义相似度问题上有效.【期刊名称】《吉林大学学报(理学版)》【年(卷),期】2010(048)005【总页数】6页(P811-816)【关键词】语义相似性;布朗词集;IC模式【作者】张东娜;周春光;刘彦斌;郭东伟【作者单位】吉林大学,计算机科学与技术学院,长春,130012;吉林大学,计算机科学与技术学院,长春,130012;吉林大学,计算机科学与技术学院,长春,130012;吉林大学,计算机科学与技术学院,长春,130012【正文语种】中文【中图分类】TP391.1实现一个有效的概念语义相似性计算方法在对自然语言处理及其相关领域有重要作用, 如在Web图像检索方面, 使用短文字的检索方法可以提高对于图片检索的精确度. 语义相似性计算在互联网为基础的应用程序方面有重要作用, 如可以提高网页分类的效率[1], 结合网页特征用于网页噪音处理等, 也可以促进本体自动学习注重概念的语义信息, 避免只考虑字形相似性.近年来, 一些语义相似性计算方法被相继提出, 总体上算法可以分为以下几类:(1) 基于单词之间的路径距离;(2) 以信息为基础(IC-based);(3) 以特征为基础的计算方式(feature-based);(4) 综合的计算方法[2].文献[3]提出的算法只考虑两个概念间在知识库层次结构中概念间的最短路径长度; Leacock等[4]提出的算法都是从路径长度以及概念的深度上考虑概念间的相似性; Resnik[5]提出了以IC(Information Content)为基础的方法, 该方法主要分析两个概念间在知识库中的共享信息; Lin[6]提出了IC计算方法, 但只是单纯的考虑了两个概念共享信息与两个概念分别带有语义信息的比率; Jiang等[7]提出了遵循IC模式的新路径距离算法.本文提出一种新的基于WordNet和Corpus Statistics的IC计算模式IC-CW, IC 是衡量概念的语义信息[8], 一个概念在文档中出现的概率越高, 表明它越抽象, 带有的语义信息越少[9]. 除了在文档集中出现的概率, 在知识库中(由IS-A关系构建的层次结构)也能反映概念的语义信息, 越靠近叶子节点, 含有越少子概念的节点含有的语义信息越丰富[10]. IC-CW多方面考虑了概念的语义信息, 可以充分体现概念的语义性差异. 在计算语义相似性时应该充分考虑两个概念的语义信息, 如果两个概念共享的语义信息越多, 说明两个概念越相似[11]. 在IC-CW的基础上, 本文综合考虑概念在WordNet中语义信息及文本集中的概率信息, 并针对目前已有语义相似性计算方法均与领域相关的特点, 设计了一种通用的计算方法SS-CW. 通过在领域通用的数据集R&B数据进行实验[12], 表明该方法在计算语义相似度问题上较其他算法与人工判断具有更高的一致性.1 基于文集与WordNet的IC计算模式IC-CW以IC为参数的语义相似性计算考虑的信息理论基础是语义相似性来源于概念对的共享信息量. 本文相似性计算以Princeton开发的WordNet词法库为相似性计算的基本知识库[13]. WordNet是一个在线的词汇参照系统, 与传统词典不同, 它使用同义词集合代表概念, 利用概念的IS-A关系将概念组合成标准的层次结构, 这个新的知识结构符合人类在某一个特定领域的常识, 也符合英语的基本语法. WordNet中部分名词形成的层次语义结构如1所示.图1 部分层次语义结构Fig.1 Hierarchical semantic knowledge base综合考虑概念在经典文本集Brown Corpus中出现的概率以及WordNet中概念的语义信息, 本文提出一种新的IC计算方法IC-CW(Information Content Based on Corpus Statistics and WordNet):(1.1)(1.2)IC(c)=(1-p(c))(1-WIC)/WIC,(1.3)其中: hypo(c)返回在WordNet中概念c的下义词(在WordNet中概念的子概念)个数; nodemax返回在WordNet单词分类中某一类中概念的总数; deep(c)返回在WordNet中概念c的深度; deepmax返回知识库概念的最大深度; W(c)表示知识库中概念c的下义词; k表示因素深度和下义词个数的因子.由式(1.1)可见, hypo(c)返回的下义词个数越多, 概念越抽象, WIC越小; 概念越靠近叶子节点, deep(c)越大, WIC也相应增大. 由式(1.3)可见, IC值随着概念在文集中出现的概率增大而减小, 随着WordNet中语义信息值WIC的增大而增大. IC-CW算法考虑了概念语义的多个因素, 可以充分体现概念的语义性差异.2 基于IC-CW的语义相似度计算方法SS-CW(Semantic Similarity Based on Corpus Statistics and WordNet)是基于IC-CW的语义相似性计算方法, 首先验证IC-CW的有效性. IC的计算方式可以较好反映概念的语义信息, 区分概念的语义性[2]. 越具体的概念出现的概率越小, 在知识库WordNet中越靠近叶子节点, 具有越少的子节点个数, IC值较大; 反之, IC值较小.2.1 IC-CW分析Nuno等[10]提出的模型被应用于许多经典的语义相似性计算算法中, 它只考虑了在知识库WordNet中概念的子概念一个因素, 公式如下:(2.1)图2为计算结果, 其中第一行为本文的计算结果, 第二行为Nuno模型计算结果, 改变k值可以调节式(1.1)中两项的权重, 在计算中k=0.5.图2 不同IC模式的计算结果Fig.2 Results of different IC models由图2可见, Nuno的IC模型只考虑了概念的子概念信息, 不能较好区分概念的语义性差别, 例如对于节点animal与child的计算结果完全相同, 但child节点很明显要比animal节点更具体, 在Nuno模型下并未区分. IC-CW更能反映概念的语义性差别.2.2 SS-CW算法以WordNet作为知识库计算概念间语义相似性时, 有很多经典算法. 本文提出一种新的计算方法, 在该方法中概念间的相似性涉及到如下3个因子:(1) 知识库中两个概念在知识库中的最短路径长度;(2) 两个概念的重合度:两个概念到根节点的路径中共享路径的比例;(3) 两个概念最小上层概念LSO(Least Common Object)的深度.在进行计算时重合度可以用LSO的深度与两个概念的深度代替. 因此, 概念间的相似度s(w1,w2)可表示成概念间的最短路径长度l、两个概念的深度hw1,hw2、概念间最小上层概念LSO的深度h的函数:s(w1,w2)=f(hw1,hw2,h,l).(2.2)综合考虑以上语义信息以及新的IC, 本文提出概念间相似性计算SS-CW算法公式如下:(2.3)(2.4)(2.5)其中: h表示LSO在知识库中的深度; hw1返回概念w1在知识库中的深度; hw2返回概念w2在知识库中的深度; α,β为式(2.5)中两个因子参数, 且α,β的取值范围均为(0,1]; LSO( )函数返回两个概念在知识库中的最小上层概念.传统相似性计算的最短路径距离[9]不能较好反映概念的相似性, 以图1中的节点(person,animal,boy)为例, person和boy与animal和boy距离相同, 但显然前者语义相似性更高. SS-CW算法中考虑l/rc(w1,w2), person和boy的计算结果是20, animal和boy的计算结果是24, 与最短路径相比, 它可以更好地反映概念的语义相似性. hp反映了两个概念在知识库中越具体、差异越小则相似性越大, 符合信息理论[12].在WordNet中概念由同义词集合t表示, 在计算概念间的相似性时会遇到3种情况: (1) 概念1和概念2在同一个同义词集合中; (2) 概念1和概念2不在同一个同义词集合, 但它们各自的同义词集合含有相同的同义词. 以图1为例, boy和girl 有一个共同的同义词child; (3) 概念1和概念2不在同一个同义词集合中, 也没有共同的同义词. 情况(1)中, 算法将最短路径设为0, 情况(2)说明两个概念有部分特征相同, 所以将路径设为1. 对于情况(3), 则要找到两个概念在知识库中的最短路径. 因此, SS-CW的总体计算公式如下:(2.6)其中c1i,c2j分别是概念w1和w2在知识库中概念同义词集合中的义元.3 实验结果与分析实验过程分为两个阶段: IC模式计算和概念间的相似性计算. 本文使用Rubenstein等[9]定义的65对语句, 对这些概念进行人工打分, 称为R&B数据集. 由上述65对概念抽取30对, 并对这些概念对进行重新打分, 每对概念的相似性分值在[0,1]间, 称为M&B数据集. 文本相似性计算在两个数据集上进行, 通过计算算法结果与人工判断结果的相关系数评价算法性能, 相关系数计算公式如下:(3.1)其中:Cov(x,y)=E{(x-E(x))(y-E(y))};D(x)和D(y)表示方差. 相关系数在[0,1]间, 其值越高表明算法性能越好.3.1 概念间语义相似性计算结果比较在R&B和M&C数据集上, 参数α,β取不同值时的计算结果列于表1, 由表1可见, α=0.10, β=0.45时得到的结果最好.表1 α,β取不同值时在R&B和M&C数据集上SS-CW计算结果Table 1 Results of SS-CW for α,β of different values in the R&B and M&C datasets数据集α=0.20,β=0.45α=0.10,β=0.55α=0.30,β=0.55α=0.40,β=0.78α=0.10,β=0.45R &B0.8520.8460.8300.8600.880M&C0.8750.8700.8530.8690.895α,β在进行多次实验后得到了一个优化值, 其中α=0.10, β=0.45时算法可以得到一个最优结果. 将文献[14]中概念语义相似性计算部分分别用本文算法SS-CW, Lin 方法以及文献[14]PMI-IR算法与人工判断进行比较, 在M&C数据集上的计算结果列于表2. 由表2可见, 本文算法SS-CW的计算结果与人工判断的计算结果具有较好的一致性, 尤其在当概念相似性为0.01~0.29以及0.60~0.96范围内时, 较PMI-IR算法以及Lin算法有明显的优势, 与人工判断一致, 但在其余的范围内并不完全优于PMI-IR算法.表2 在数据集上各算法的计算结果Table 2 Compared results of each algorithm on the dataset概念对号概念对定义人工判断Lin方法PMI-IR方法本文方法1Cord Smile0.010.330.060.045AutographShore0.010.290.110.089Asylum Fruit0.010.290.110.1213BoyRooster0.110.530.160.1217Coast Forest0.130.360.260.2021BoySage0.040.510.160.1825Forest Graveyard0.070.550.330.1329Bird Woodland0.010.330.120.0633Hill Woodland0.150.590.290.1937Magician Oracle0.130.440.200.1641Oracle Sage0.280.430.090.2447FurnaceStove0.350.720.300.3948Magician Wizard0.360.650.340.4049HillMound0.290.740.150.1650Cord String0.470.680.490.5251GlassTumbler0.140.650.340.2352Grin Smile0.490.490.320.3354JourneyVoyage0.360.520.410.4355Autograph Signature0.410.550.190.1856Coast Shore0.590.760.470.5357Forest Woodland0.630.700.260.6458Implement Tool0.590.750.510.5659Cock Rooster0.861.000.940.9260BoyLad0.580.660.600.6261Cushion Pillow0.520.660.600.5962Cemetery Graveyard0.770.730.510.7263Automobile Car0.560.640.520.5064Midday Noon0.961.000.930.9865Gem Jewel0.650.830.650.653.2 与IC-CW算法比较将本文算法与以IC为参数的经典语义相似性计算方法在R&B数据集上进行比较, 结果列于表3. 采用Siddharth Patwardhan and Ted Pederson[9]免费软件包,该软件包含了各种经典的语义相似性计算, 本文以经典IC模式的相似性算法Resnik算法, Lin算法, Jiang算法作为对照, IC公式如下:IC(c)=-log p(c),其中: 带*算法是将Nuno算法中的IC模式代替算法原模型; 带**的是采用本文IC-CW算法代替原模型; 最后为本文概念相似性计算算法SS-CW的结果. 由表3可见, 在利用新的IC计算模式IC-CW后, 以IC为基础的语义相似性计算与人工判断的相关性均有不同程度的提高, 同时验证了本文语义相似度计算算法SS-CW的有效性.综上所述, 本文提出一种基于WordNet 和 Corpus Statistics的IC计算方式IC-CW, 新的IC计算方法不同于传统的计算方法, 传统的IC计算方法只考虑了概念在经典文集中出现的概率, IC-CW除了考虑概率外也考虑了概念在知识库中的语义信息. 与传统的IC算法相比, 可以更好地反映概念的语义性, 区别概念间语义信息含量的差别. 在新的IC基础上本文提出了一种新的语义相似性计算方法SS-CW, 该算法不同于已有算法需要大量领域相关的知识, 它充分考虑了两个概念在知识库中的共享信息, 提炼概念在知识库中的信息, 实验结果表明, 该方法与人的常识判断具有更高的一致性.表3 人工相似性判断与算法相似性的相关系数Table 3 Coefficients of correlation between human rating similarity and machine similarity judgment相似性计算算法相关系数r相似性计算算法相关系数rResnik0.81Jiang and Conrath *-0.823Lin0.756Resnik**0.853Jiang and Conrath-0.779Lin**0.872Resnik*0.829Jiang and Conrath **-0.865Lin*0.845本文概念相似性计算算法0.895*将Nuno算法中的IC模式代替算法原模型; **采用本文IC-CW算法代替原模型. 参考文献【相关文献】[1] Park E K, Ra D Y, Jang M G. Techniques for Improving Web Retrieval Effectiveness [J]. Information Processing and Management, 2005, 41(5): 1207-1223.[2] Budanitsky A, Hirst G. Evaluating WordNet-Based Measures of Lexical Semantic Relatedness [J]. Computational Linguistics, 2006, 32(1): 13-47.[3] LI Yu-hua, Bandar Z H, McLean D. An Approach for Measuring Semantic Similarity between Works Using Multiple Information Sources [J]. IEEE Trans Knowledge and Data Eng, 2003, 15(4): 871-882.[4] Leacock C, Chodorow M. Combining Local Context and WordNet Similarity for Word Sense Identification [M]. Cambridge: MIT Press, 1998: 147-165.[5] Resnik P. Using Information Content to Evaluate Semantic Similarity in a Taxonomy[C]//Proceedings of the 14th International Joint Conference on Artificial Intelligence. San Francisco: Morgan Kaufmann Publishers Inc, 1995: 448-453.[6] Lin D. An Information-Theoretic Definition of Similarity [C]//Proceedings of the 15th International Conference on Machine Learning. San Francisco: Morgan Kaufmanm, 1998: 296-304.[7] Jiang J J, Conrath D W. Semantic Similarity Based on Corpus Statistics and LexicalTaxonomy [C]//Proceedings of International Conference on Research in Computational Linguistics. Taiwan: [s.n.], 1997: 19-33.[8] Lenhart Schubert, Matthew Tong. Extracting and Evaluating General World Knowledge from the Brown Corpus [C]//Human Language Technology Conference, Proceedings ofthe HLT-NAACL 2003 Workshop on Text Meaning-Volume 9. Morristown: Association for Computational Linguistics, 2003: 7-13.[9] Rubenstein H, Goodenough J B. Contextual Correlates of Synonymy [J]. Comm ACM, 1965, 8(10): 627-633.[10] Nuno S, Tony V, Jer H. An Intrinsic Information Content Metric for Semantic Similarity in WordNet [C]//Proceedings of ECAI’2004, the 16th European Conference on Artificial Intelligence Valencia. Penn State: Scientific Literature Digital Library and Search Engine, 2004.[11] ZHANG Chang-sheng, SUN Ji-gui, CUI Yan, et al. PSO Based Partition Clustering Algorithms [J]. Journal of Jilin University: Engineering and Technology Edition, 2008, 38(6):1371-1377. (张长胜, 孙吉贵, 崔妍, 等. 一种基于PSO的分割聚类算法 [J]. 吉林大学学报:工学版, 2008, 38(6): 1371-1377.)[12] LIU Lei, SONG Ya-juan, REN Ping. Semantic Web Service Discovery Method Oriented for Composed Web Service [J]. Journal of Jilin University: Science Edition, 2010, 48(2): 256-264. (刘磊, 宋雅娟, 任平. 一种面相组合服务的语义 Web服务发现方法 [J]. 吉林大学学报:理学版, 2010, 48(2): 256-264.)[13] ZHU Hui-feng, ZUO Wan-li, HE Feng-ling, et al. A Novel Text Clustering Method Based on Ontology [J]. Journal of Jilin University: Science Edition, 2010, 48(2): 277-283. (朱会峰, 左万利, 赫枫龄, 等. 一种基于本体的文本聚类算法 [J]. 吉林大学学报:理学版, 2010,48(2): 277-283.)[14] Aminul I, Diana I. Semantic Text Similarity Using Corpus-Based Word Similarity and String Similarity [J]. ACM Transactions on Knowledge Discovery from Data, 2008, 2(2): Article 10.。

基于《知网》的词语相似度计算方法孙润志;于放【期刊名称】《计算机系统应用》【年(卷),期】2015(000)007【摘要】词语相似度计算中常用的一种方法是基于某种语义词典的计算。

首先介绍《知网》中的基本概念和层次体系结构,借鉴刘群、李素建在词语相似度方面的基础理论,利用《知网》的义原层次体系结构计算出其中的义原相似度,再计算出概念的相似度,最后得到词语的相似度。

还对其中的计算方法做出适当的改进调整,使其计算出的结果更加符合实际情况。

%A common method of word similarity computing is based on a semantic dictionary. This paper introduces the “HowNet” in the basic concepts and hierarchical architecture, drawing lessons from Liu Qun, Li Sujianbasic theory in word similarity. It makes use of “HowNet” sememe hierarch ical architecture to calculate sememe similarity, then calculates the similarity of the concept, and finally gets the similarity of the words. This paper also makes appropriate adjustment to the computing method, so that the calculated results can be more in line with the actual situation.【总页数】4页(P155-158)【作者】孙润志;于放【作者单位】中国科学院大学,北京 100049; 中国科学院沈阳计算技术研究所,沈阳 110168;中国科学院沈阳计算技术研究所,沈阳 110168【正文语种】中文【相关文献】1.一种基于《知网》的词语相似度计算方法 [J], 史俊冰2.一种基于《知网》的词语相似度计算方法 [J], 史俊冰3.基于2008版《知网》的词语相似度计算方法 [J], 魏韡;向阳4.基于知网义原信息量的词语相似度计算方法 [J], 李国佳;杨喜亮5.一种基于《知网》的词语相似度计算方法 [J], 史俊冰;因版权原因,仅展示原文概要,查看原文内容请购买。

synonyms 相似度计算以synonyms(同义词)相似度计算为题,我们将探讨文本处理中的一个重要任务——计算两个词语或短语之间的相似度。

在自然语言处理和信息检索领域,同义词相似度计算是一个常见且具有挑战性的问题。

本文将介绍一些常用的同义词相似度计算方法,并讨论它们的优缺点。

一、引言在自然语言处理任务中,同义词相似度计算是一个重要且具有挑战性的问题。

在信息检索、问答系统、文本分类等应用中,准确计算词语或短语之间的相似度对于增强系统的性能和用户体验至关重要。

因此,研究同义词相似度计算方法具有重要的理论和实际意义。

二、基于词向量的相似度计算方法1. 余弦相似度余弦相似度是一种常用的词向量相似度计算方法。

它将词语表示为向量,然后计算向量之间的夹角余弦值。

余弦相似度的取值范围为[-1, 1],值越接近1表示两个词语越相似,值越接近-1表示两个词语越不相似。

2. 词嵌入模型词嵌入模型是一种将词语映射到连续向量空间的方法。

这种方法通过学习词语之间的上下文关系,将词语表示为向量。

常用的词嵌入模型有Word2Vec、GloVe等。

基于词嵌入模型的相似度计算方法可以通过计算词向量之间的距离或相似度来衡量词语之间的相似度。

三、基于语义网络的相似度计算方法1. 词义相似度网络词义相似度网络是一种将词语按照语义关系组织起来的方法。

在这个网络中,每个词语都与其相近的词语通过边相连。

词义相似度计算方法可以通过计算两个词语在词义相似度网络中的最短路径长度来衡量词语之间的相似度。

2. 基于WordNet的相似度计算方法WordNet是一个英语词典,其中的词语按照语义关系进行组织。

基于WordNet的相似度计算方法可以通过计算两个词语在WordNet 中的路径长度或路径相似度来衡量词语之间的相似度。

四、基于语料库的相似度计算方法1. 词频-逆文档频率(TF-IDF)相似度计算方法TF-IDF相似度计算方法是一种基于词语在语料库中的出现频率和重要性来计算相似度的方法。

基于WordNet的语义相似度算法改进研究作者:沈国祥来源:《软件导刊》2016年第05期摘要:本体匹配解决了本体异构问题,作为本体匹配的关键技术,相似度算法决定了匹配的精度和效率。

WordNet中概念节点的语义距离常作为相似度算法的依据。

设计了一种新的语义距离计算方法及相似度算法,并以此搭建一个本体匹配框架进行了验证。

关键词:本体匹配;WordNet;语义距离;语义相似度DOIDOI:10.11907/rjdk.161033中图分类号:TP312文献标识码:A 文章编号:1672-7800(2016)005-0034-040 引言随着Internet的发展,语义Web技术解决了海量信息与高效利用之间的突出矛盾。

语义Web通过在资源信息中加入语义信息,使信息的内容与表示分离处理,为描述的信息赋予了良好的语义,实现了计算机对海量信息处理的自动化和智能化,极大提高了信息使用效率。

作为语义Web中的关键技术,本体得到了越来越广泛的应用,本体已经成为语义Web中知识表示的标准。

为了实现语义信息共享,各个领域纷纷定义了相应的本体标准,但本体构造一直没有一个统一的规范和标准,从而导致本体存在各种异构问题。

为了更有效地使用和重用本体来完成信息交换与集成任务,就必须找出不同本体之间的映射关系,即本体匹配技术。

根据文献[1]对本体匹配流程的描述,可以将本体匹配总结为5个步骤:①本体特征(概念、关系、属性等)提取;②选择本体匹配的实体对;③语义相似度计算;④人工干预;⑤匹配输出,其中相似度计算是整个流程的核心技术,也是本文研究的主要内容。

对于相似度计算可以从自然语言、字符串、本体结构信息、本体推理等多角度进行。

本体匹配技术研究及本体匹配系统构建取得了一批成果。

目前,常见的本体匹配有基于语言学特征、基于结构和基于实例等多种方法。

1 WordNet简介WordNet[2]是在美国普林斯顿大学G. Miller教授的指导下,由心理学家、语言学家和计算机工程师联合设计的一种基于认知语言学的英语词典,是基于语言特征的本体匹配方法中常用的外部资源。

一种基于WordNet语义相似度的改进算法WordNet是一个广泛使用的英语词汇数据库,其中单词被组织成同义词集,每个同义词集表示一组拥有相似含义的单词。

WordNet已经广泛用于许多自然语言处理任务中,例如文本分类,语言翻译,信息检索等。

然而,在WordNet的语义相似度评估中,诸如“爱”和“喜欢”这样具有非常相似含义的单词,却被标记为相对不相似的单词。

这可能导致用WordNet进行文本挖掘和信息检索时产生一定的误导。

因此,一种基于WordNet语义相似度的改进算法显得尤为重要。

近年来,一种基于词向量的改进算法已经被广泛应用于自然语言处理的任务中。

该算法使用隐式语义分析将单词向量化,这些向量在实现语义相似度方面的表现比WordNet更加优良。

这些向量被称为词向量,并且可以用于衡量两个单词的语义相似度。

通常使用余弦相似度或欧几里得距离来计算。

然而,由于WordNet中的单词数量众多,对整个系统进行向量化是相对困难的,并且也需要大量的计算资源和时间。

因此,一种策略是使用WordNet中的相同同义词集中的单词的词向量,然后在这些词向量上计算相似度。

此外,我们可以使用WordNet的树形结构,以及从每个单词到它们对应的同义词集的路径长度来计算词汇相似度。

最后,将基于WordNet的相似度和词向量相似度结合起来,以得到更加准确的词汇相似度度量。

总之,基于WordNet语义相似度的改进算法可以有效提高文本挖掘和信息检索的准确性。

特别地,使用词向量的思路可以克服WordNet语义相似度的缺点,并且能够帮助我们更准确地刻画单词的含义。

例如,我们可以将“爱”和“喜欢”之间的关系描述为更加相近的相关性,从而使文本分析和检索更加容易。

该算法的研究和应用将我们的自然语言处理能力提升到了一定的高度。

基于语义网计算英语词语相似度

荀恩东;颜伟

【期刊名称】《情报学报》

【年(卷),期】2006(025)001

【摘要】本文介绍一种基于WordNet的计算英语词语相似度的实现方法:从WordNet中提取同义词并采取向量空间方法计算英语词语的相似度.向量包括三方面:(1)WordNet的同义词词集(Synset),(2)类属信息(Class),(3)意义解释(Sense explanation).实验结果表明,这是计算英语词语相似度的一种可行的方法.

【总页数】6页(P43-48)

【作者】荀恩东;颜伟

【作者单位】北京语言大学语言信息处理研究所,北京,100083;北京语言大学语言信息处理研究所,北京,100083

【正文语种】中文

【中图分类】G35

【相关文献】

1.基于边权重的WordNet词语相似度计算 [J], 郭小华;彭琦;邓涵;朱新华

2.基于信息内容的词林词语相似度计算 [J], 彭琦;朱新华;陈意山;孙柳;李飞

3.基于改进TF-IDF的百度百科词语相似度计算 [J], 杨欣;郭建彬

4.基于《知网》的词语相似度计算算法研究 [J], 徐智威

5.基于Word2Vec的WordNet词语相似度计算研究 [J], 陈丹华;王艳娜;周子力;赵晓函;李天宇;王凯莉

因版权原因,仅展示原文概要,查看原文内容请购买。