基于核熵成分分析的数据降维

- 格式:pdf

- 大小:242.63 KB

- 文档页数:3

数据分析知识:如何进行数据分析的核主成分分析数据分析知识:如何进行数据分析的核主成分分析在进行数据分析的过程中,一项重要的任务就是降维,即从大量数据中提取出主要的特征。

核主成分分析(Kernel PCA)是一种有效的降维方法,通过它可以将高维的数据转化为低维的数据,并在不失去重要信息的前提下,更好地表达数据。

1. PCA与Kernel PCA的区别在介绍Kernel PCA之前,我们先来了解一下主成分分析(PCA)。

PCA是一种常用的降维方法,它通过对原始数据进行线性变换,将其转化为一组新的维度,使得在新的维度下,数据的方差尽可能地大。

在新的维度下,数据形成一个坐标系,每个坐标轴被称为主成分。

与PCA不同的是,Kernel PCA(以下简称KPCA)是一种非线性的方法。

KPCA可以将高维数据通过核函数映射到特征空间,并在特征空间中进行PCA,从而实现对数据的降维。

2. KPCA的基本原理KPCA的基本原理是通过非线性映射将原始数据映射到一个高维的特征空间(称为核空间),然后在该空间中进行PCA,得到新的成分,最后再将其映射回原始的数据空间。

与PCA相比,KPCA提供了更高的灵活性和表达能力。

具体地,设有一个n个数据点的样本集{xi},x是一个d维的向量,即x∈R^d。

首先在原始的数据空间中定义一个核函数,用于将原始数据点映射到一个新的特征空间。

核函数的作用在于,通过量化数据点之间的相似性,并将相似的点映射到特征空间中的相邻位置。

核函数可以选择多项式核函数、高斯核函数或sigmoid核函数等。

这里以高斯核函数为例:K(x,xi)=exp(−|| x−xi ||^2 / 2σ^2)其中,x和xi是原始数据点,K(x,xi)是将x和xi映射到特征空间的函数值,σ是高斯核函数的带宽参数。

映射后,我们得到的是一个在特征空间内的数据集{Φ(xi) },Φ(xi)是一个M维的向量。

在特征空间中,我们可以得到主成分和贡献率,就像在PCA中一样。

核PCA的应用PCA是一种基于数学统计方法的数据降维技术,可以将高维数据降低为低维数据,从而更好地理解和处理数据。

在数据处理和分析的领域中,PCA已经被广泛应用。

而核PCA,作为传统PCA 的扩展,更是在一些特定领域有着广泛的应用前景。

一、PCA的基本原理在介绍核PCA之前,首先要了解PCA的基本原理。

PCA的主要目的是将高维数据降低为低维数据,同时最大化数据信息的维度。

其基本原理由以下步骤组成:1.计算均值:对于给定的数据集,首先需要计算每个维度上的均值。

2.计算协方差矩阵:通过计算每个数据点与其它数据点之间的协方差矩阵,可以进一步了解原始数据的结构。

3.计算特征值和特征向量:协方差矩阵的特征值和特征向量可以帮助我们实现数据降维。

4.选中要保留的特征向量:通过选取一定数量的协方差矩阵的特征向量,我们就可以将数据集从高维度降低到低维度。

以上就是PCA的基本原理,通过降低数据维度的同时,尽可能多的保留原有数据的信息。

二、核PCA的基本思想虽然PCA在数据降维方面的效果已经得到了广泛的应用,但在特定的领域中,它也有一些缺陷。

其中的一项典型的缺陷,是它不擅长处理非线性数据。

因此人们在此基础上,发展出了核PCA的新型技术,以帮助我们更好的解决问题。

首先,核PCA的基本思想是:数据集在高维空间中存在一个非线性的映射关系,而PCA所要做的,就是将这个高维空间映射到低维空间。

具体而言,就是将一些复杂、非线性的数据映射到一个更低维度、更简单的空间,这样,我们就可以更好地分析和处理数据。

在理解核PCA的过程中,还需要了解两个基本概念:核矩阵和核函数。

(1)核矩阵核矩阵是用来描述样本点之间的相似性的矩阵。

样本点之间的相似性可以直接用数据间的内积来表示。

因此,核矩阵就是所有样本之间的内积所组成的矩阵。

这里强调一下,核矩阵只与样本点在高维空间中的内积相关,与他们在低维度空间无关。

(2)核函数核函数通常具有以下两种基本属性:1.核函数只与样本之间的内积有关。

利用机器学习算法进行高维数据降维与特征提取研究在数据科学领域,高维数据和特征提取是两个重要的问题。

当数据具有很多特征时,我们往往需要找到一种方法来减少数据维度,并提取有用的特征以便进行进一步的分析和建模。

这就需要利用机器学习算法进行高维数据降维与特征提取研究。

高维数据降维是将高维数据映射到一个更低维度的空间,同时保留数据的主要结构和信息。

降维的目的是减少数据的冗余度,去除噪声,提高数据的可解释性。

常见的高维数据降维算法包括主成分分析(PCA)、线性判别分析(LDA)和t-SNE等。

首先,主成分分析是一种最常用的降维方法,它通过线性变换将高维数据映射到低维空间。

PCA通过计算数据的协方差矩阵,找到数据中的主要方向,并将数据投影到这些方向上,从而减少数据的维度。

主成分分析不仅能够降低数据维度,还能够提取数据中的重要特征。

其次,线性判别分析是一种有监督的降维方法,它将高维数据映射到一个低维空间,同时保留数据的类别信息。

LDA通过最大化类间距离和最小化类内距离的方式,选择最佳投影方向,从而实现数据的降维和特征提取。

相比于PCA,LDA更适用于分类问题,可以提高后续分类模型的性能。

另外,t-SNE(t-Distributed Stochastic Neighbor Embedding)是一种非线性降维方法,它能够将高维数据映射到低维空间,并保留数据之间的局部结构。

t-SNE通过计算高维数据点之间的相似度,构建一个低维空间中的相似度矩阵,然后使用梯度下降等优化算法来最小化高维和低维相似度之间的差异。

t-SNE在可视化和聚类等任务中广泛应用,能够更好地展现数据之间的关系。

除了以上提到的算法,还有很多其他的降维和特征提取方法,如因子分析、独立成分分析(ICA)和自动编码器等。

这些方法各有特点,适用于不同类型的数据和任务。

在应用机器学习算法进行高维数据降维和特征提取时,我们需要考虑以下几个因素。

首先,降维后的数据是否能够准确地表示原始数据的结构和信息。

降维的原理降维是指将高维数据映射到低维空间的过程,其目的是为了减少数据的复杂度和提高计算效率。

在实际应用中,降维技术被广泛应用于数据压缩、特征提取和数据可视化等领域。

本文将介绍降维的原理及其常见的方法。

降维的原理可以从线性代数和统计学的角度来理解。

在高维空间中,数据点之间的距离和角度关系复杂多变,给数据分析和处理带来了困难。

而在低维空间中,数据点之间的关系相对简单,更容易进行分析和处理。

因此,通过降维可以将原始数据中的噪声和冗余信息去除,保留主要特征,从而提高数据的表达能力和分类准确度。

在实际应用中,降维的方法主要包括主成分分析(PCA)、线性判别分析(LDA)、t分布邻域嵌入(t-SNE)等。

其中,PCA是一种常用的线性降维方法,它通过寻找数据中的主成分来实现降维。

而LDA则是一种监督学习的降维方法,它在保持数据类别信息的同时,将数据映射到低维空间。

另外,t-SNE是一种非线性降维方法,它可以有效地保留数据的局部结构,适用于数据可视化和聚类分析。

除了上述方法外,还有一些其他的降维技术,如自编码器、核主成分分析(Kernel PCA)等。

这些方法各有特点,可以根据具体的应用场景选择合适的方法进行降维处理。

需要注意的是,降维并不是万能的,它也存在一些局限性。

首先,降维可能会丢失一部分信息,导致数据表达能力下降。

其次,降维过程需要消耗一定的计算资源和时间。

因此,在选择降维方法时,需要综合考虑数据的特点、应用需求和计算资源等因素。

综上所述,降维是一种重要的数据预处理技术,它可以有效地提高数据的表达能力和计算效率。

在实际应用中,我们可以根据具体的需求选择合适的降维方法,并结合特征选择、模型训练等步骤,实现对高维数据的有效分析和处理。

希望本文对降维技术有所帮助,谢谢阅读!。

kpca算法的python实现kpca算法是一种非线性降维算法,它是基于核技巧的主成分分析方法。

本文将介绍kpca算法的原理和python实现。

我们来了解一下主成分分析(PCA)算法。

PCA是一种常用的线性降维算法,它通过寻找数据中的主要方向来减少数据的维度。

然而,PCA只适用于线性可分的数据,对于非线性数据效果不佳。

而kpca 算法则是通过引入核函数,将数据映射到高维空间中,从而使得原本线性不可分的数据在新的高维空间中线性可分。

具体来说,kpca算法的实现步骤如下:1. 计算核矩阵:首先,根据给定的核函数,计算原始数据的核矩阵。

核矩阵是一个对称的矩阵,它的元素是通过核函数计算得到的两个样本之间的相似度。

2. 中心化核矩阵:对核矩阵进行中心化操作,即将每一行和每一列的元素减去各自的均值,从而消除数据的平移影响。

3. 计算核矩阵的特征值和特征向量:通过对中心化的核矩阵进行特征值分解,得到核矩阵的特征值和对应的特征向量。

4. 选择主成分:根据特征值的大小,选择前k个最大的特征值和对应的特征向量作为主成分。

5. 降维:将原始数据投影到所选的主成分上,得到降维后的数据。

接下来,我们使用python实现kpca算法。

首先,我们需要导入所需的库:```pythonimport numpy as npfrom sklearn.decomposition import PCAfrom sklearn.preprocessing import StandardScaler```然后,我们定义一个kpca类,其中包含fit和transform两个方法:```pythonclass KPCA:def __init__(self, n_components=2, kernel='linear'):self.n_components = n_componentsself.kernel = kerneldef fit(self, X):# 计算核矩阵kernel_matrix = self._calculate_kernel_matrix(X)# 中心化核矩阵centered_kernel_matrix = self._center_kernel_matrix(kernel_matrix)# 计算核矩阵的特征值和特征向量eigenvalues, eigenvectors = self._calculate_eigen(centered_kernel_matrix)# 选择主成分ponents_ = eigenvectors[:, :self.n_components]return selfdef transform(self, X):# 计算核矩阵kernel_matrix = self._calculate_kernel_matrix(X)# 中心化核矩阵centered_kernel_matrix = self._center_kernel_matrix(kernel_matrix)# 将数据投影到主成分上return np.dot(centered_kernel_matrix, ponents_)def _calculate_kernel_matrix(self, X):# 计算核矩阵if self.kernel == 'linear':kernel_matrix = np.dot(X, X.T)elif self.kernel == 'rbf':sigma = 1.0pairwise_sq_dists = np.sum((X[:, np.newaxis] - X[np.newaxis, :]) ** 2, axis=-1)kernel_matrix = np.exp(-pairwise_sq_dists / (2 * sigma ** 2))else:raise ValueError("Invalid kernel.")return kernel_matrixdef _center_kernel_matrix(self, kernel_matrix):# 中心化核矩阵n_samples = kernel_matrix.shape[0]one_n = np.ones((n_samples, n_samples)) / n_samples centered_kernel_matrix = kernel_matrix - one_n.dot(kernel_matrix) - kernel_matrix.dot(one_n) + one_n.dot(kernel_matrix).dot(one_n)return centered_kernel_matrixdef _calculate_eigen(self, kernel_matrix):# 计算核矩阵的特征值和特征向量eigenvalues, eigenvectors = np.linalg.eigh(kernel_matrix)return eigenvalues[::-1], eigenvectors[:, ::-1]```在以上代码中,我们定义了一个KPCA类,其中包含了_fit_kernel_matrix、_center_kernel_matrix和_calculate_eigen三个私有方法。

时间序列数据的流形降维方法研究在大数据时代,时间序列数据越来越受到重视。

例如,金融数据、生物医学数据、气象数据等,在这些数据中,我们往往需要寻找的是潜在的规律和模式,以便更好地预测未来的趋势。

而流形降维是一种有效的数据降维方法,通过将高维数据映射到低维空间中,帮助我们更好地理解数据的结构和规律。

本篇文章主要介绍时间序列数据的流形降维方法及其应用。

一、时间序列数据的流形降维方法流形降维的主要思想是保留数据样本的局部结构,尽可能地减少噪声和冗余信息。

常见的流形降维方法包括核主成分分析(Kernel PCA)、局部线性嵌入(Locally Linear Embedding,LLE)、等距映射(Isomap)等。

不同的流形降维方法具有不同的优缺点,应根据数据的特征选择合适的方法。

时间序列数据的流形降维方法与普通流形降维方法有所不同。

时间序列数据由时序样本组成,而流形降维方法是一种非参数方法,不适用于时序数据。

因此,时间序列数据的流形降维方法需要考虑到数据的时序性。

目前,常见的时间序列流形降维方法包括基于机器学习的方法、基于时间序列分析的方法、基于图论的方法等。

机器学习方法中,基于自编码器的流形学习方法是较常用的方法之一。

自编码器是一种深度神经网络,其主要思想是通过将数据压缩到低维空间中,再通过解码器将压缩的数据重构为原始数据。

在自编码器中,激活函数起到关键作用,一般采用非线性函数,如ReLU函数、sigmoid函数等。

时间序列分析方法中,时间序列的相似性是降维的主要考虑因素。

一些经典的时间序列相似性度量方法包括欧氏距离、动态时间规整(DTW)等。

同时,在时间序列降维中,需要保留时间序列的基本信息,例如周期性、趋势性等。

基于图论的方法是一种新兴的时间序列流形降维方法。

由于时间序列数据通常具有多重分辨率,常规的距离度量方法不一定有效。

在图论方法中,常用的相似度度量方法包括近邻法、最短路径法等。

相似度度量之后,可以通过图嵌入方法将高维时间序列数据嵌入到低维空间中。

数据降维的常用方法

以下是 7 条关于数据降维的常用方法:

1. 主成分分析啊!这就像把一堆杂乱的拼图碎片整理出最关键的几块。

比如说,在分析一堆人的各种身体数据时,通过主成分分析,就能找出最能代表这些人特征的那几个关键指标,是不是超厉害!

2. 因子分析也不错呀!可以把复杂的关系变得简单明了。

就好比整理一个杂乱无章的房间,通过因子分析找到几个重要的类别,让房间瞬间清爽起来。

比如分析各种商品的销售数据,找出主要的影响因子。

3. 奇异值分解可别小瞧!它就像是在一座大宝藏中找到最闪亮的那些宝贝。

想象一下在大量的文档数据中,用奇异值分解提取出最核心的主题信息,哇,太酷了!

4. t-SNE 也值得一提呢!这就如同在茫茫人海中精准找到那些和你最

相似的人。

比如在分析图像特征时,t-SNE 能让相似的图像聚集在一起,多神奇!

5. 局部线性嵌入也很牛呀!它就像为数据开辟了一条捷径。

就好比在迷宫中找到最快到达终点的那条路一样。

像处理复杂的地理数据时,局部线性嵌入能发现隐藏的结构呢。

6. 拉普拉斯特征映射也好用呢!像是给数据穿上了一件合适的衣服,让它更合身。

比如在处理声音信号时,通过它来找到关键的特征。

7. 等距特征映射也不能忘啊!这简直就是给数据开了一道魔法之门。

想象一下在海量的交易数据中,它能迅速找到关键的模式,是不是很惊人!

总之,这些方法都各有各的神奇之处,掌握了它们,就能在数据的海洋中畅游啦!。

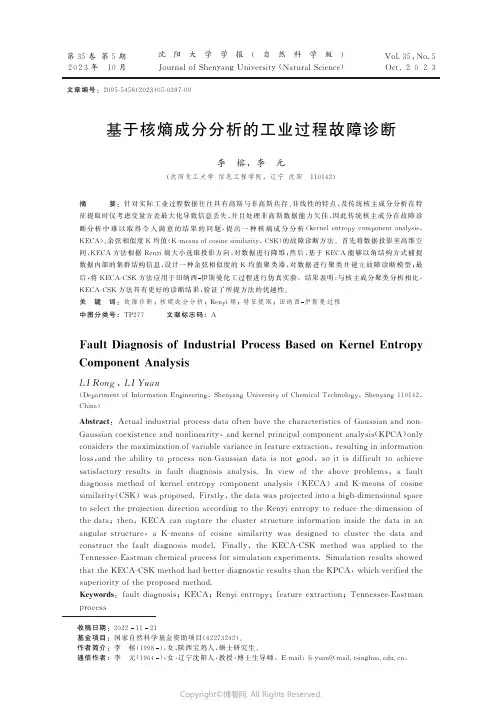

收稿日期:20221121基金项目:国家自然科学基金资助项目(62273242)㊂作者简介:李 榕(1998),女,陕西宝鸡人,硕士研究生㊂通信作者:李 元(1964),女,辽宁沈阳人,教授,博士生导师㊂E -m a i l :l i -y u a n @m a i l .t s i n g h u a .e d u .c n ㊂第35卷第5期2023年 10月沈阳大学学报(自然科学版)J o u r n a l o f S h e n y a n g U n i v e r s i t y (N a t u r a l S c i e n c e )V o l .35,N o .5O c t .2023文章编号:2095-5456(2023)05-0397-09基于核熵成分分析的工业过程故障诊断李 榕,李 元(沈阳化工大学信息工程学院,辽宁沈阳 110142)摘 要:针对实际工业过程数据往往具有高斯与非高斯共存㊁非线性的特点,及传统核主成分分析在特征提取时仅考虑变量方差最大化导致信息丢失,并且处理非高斯数据能力欠佳,因此传统核主成分在故障诊断分析中难以取得令人满意的结果的问题,提出一种核熵成分分析(k e r n e l e n t r o p y c o m p o n e n ta n a l ys i s ,K E C A )㊁余弦相似度K 均值(K -m e a n s o f c o s i n e s i m i l a r i t y ,C S K )的故障诊断方法㊂首先将数据投影至高维空间,K E C A 方法根据R e n y i 熵大小选取投影方向,对数据进行降维;然后,基于K E C A 能够以角结构方式捕捉数据内部的集群结构信息,设计一种余弦相似度的K 均值聚类器,对数据进行聚类并建立故障诊断模型;最后,将K E C A -C S K 方法应用于田纳西伊斯曼化工过程进行仿真实验㊂结果表明:与核主成分聚类分析相比,K E C A -C S K 方法具有更好的诊断结果,验证了所提方法的优越性㊂关 键 词:故障诊断;核熵成分分析;R e n yi 熵;特征提取;田纳西伊斯曼过程中图分类号:T P 277 文献标志码:AF a u l tD i a g n o s i s o f I n d u s t r i a l P r o c e s sB a s e do nK e r n e lE n t r o p yC o m p o n e n tA n a l ys i s L IR o n g ,L IY u a n (D e p a r t m e n t o f I n f o r m a t i o nE n g i n e e r i n g ,S h e n y a n g U n i v e r s i t y o fC h e m i c a lT e c h n o l o g y ,S h e n y a n g 110142,C h i n a)A b s t r a c t :A c t u a l i n d u s t r i a l p r o c e s sd a t ao f t e nh a v e t h e c h a r a c t e r i s t i c so fG a u s s i a na n dn o n -G a u s s i a n c o e x i s t e n c e a n dn o n l i n e a r i t y ,a n dk e r n e l p r i n c i p a l c o m p o n e n t a n a l y s i s (K P C A )o n l yc o n s ide r s t h em a x i m i z a t i o n of v a r i a b l e v a r i a n c e i n f e a t u r e e x t r a c t i o n ,r e s u l t i ng i n i n f o r m a t i o n l o s s ,a n dth ea bi l i t y t o p r o c e s sn o n -G a u s s i a nd a t a i sn o t g o o d ,s oi t i sd i f f i c u l t t oa c h i e v e s a t i s f a c t o r y r e s u l t si nf a u l td i a g n o s i sa n a l ys i s .I n v i e w o ft h ea b o v e p r o b l e m s ,af a u l t d i a g n o s i s m e t h o do fk e r n e le n t r o p y c o m p o n e n ta n a l ys i s (K E C A )a n d K -m e a n so fc o s i n e s i m i l a r i t y (C S K )w a s p r o p o s e d .F i r s t l y ,t h e d a t aw a s p r o j e c t e d i n t o a h i g h -d i m e n s i o n a l s p a c e t o s e l e c t t h e p r o j e c t i o nd i r e c t i o na c c o r d i n g t o t h eR e n y i e n t r o p y tor e d u c e t h ed i m e n s i o no f t h e d a t a ;t h e n ,K E C Ac a nc a p t u r et h ec l u s t e rs t r u c t u r e i n f o r m a t i o ni n s i d et h ed a t a i na n a n g u l a rs t r u c t u r e ,a K -m e a n so fc o s i n es i m i l a r i t y w a sd e s i gn e dt oc l u s t e rt h ed a t aa n d c o n s t r u c t t h ef a u l td i a g n o s i s m o d e l .F i n a l l y ,t h e K E C A -C S K m e t h o d w a sa p p l i e dt ot h e T e n n e s s e e -E a s t m a n c h e m i c a l p r o c e s s f o r s i m u l a t i o n e x p e r i m e n t s .S i m u l a t i o n r e s u l t s s h o w e d t h a t t h eK E C A -C S K m e t h o dh a d b e t t e r d i a gn o s t i c r e s u l t s t h a n t h eK P C A ,w h i c h v e r i f i e d t h e s u p e r i o r i t y o f t h e p r o po s e dm e t h o d .K e y w o r d s :f a u l t d i a g n o s i s ;K E C A ;R e n y i e n t r o p y ;f e a t u r ee x t r a c t i o n ;T e n n e s s e e -E a s t m a n pr o c e s s Copyright ©博看网. All Rights Reserved.893沈阳大学学报(自然科学版)第35卷随着工业生产过程越来越复杂多变,生产过程中对于设备的安全性和可靠性要求也愈加严格[12]㊂为了更多地捕捉过程信息,往往安装多样的传感器来获取大量反映过程信息的数据㊂通过分析正常数据和不同故障运行模式下的数据,实现基于数据驱动的故障诊断[35]㊂工业过程数据往往具有维数高㊁复杂性强等特点,若直接对获取的原始数据进行故障诊断,不仅消耗计算机资源多,而且诊断效果较差,因此,在工业过程数据上,对原始数据首先进行降维处理,去除数据冗余信息㊁压缩数据维度从而减少存储空间,消除数据噪声进而提高分类器的分类准确度㊂主成分分析(p r i n c i p a l c o m p o n e n t a n a l y s i s,P C A)[6]作为工业过程数据中最经典的降维方法,能够处理高维㊁嘈杂和高度相关的数据,因其优异的表现而被广泛应用于故障诊断领域㊂陈辉等[7]为了解决在设备故障分类识别中易受输入样本相关性影响的问题,提出P C A-B P神经网络方法对设备进行故障预测㊂张弛等[8]提出主成分分析和优化参数支持向量机的智能变电站故障诊断模型,用以解决目前智能变电站故障诊断结构复杂㊁样本数据量小的问题㊂但是,当数据分布具有非高斯和非线性特征时,由于使用二阶统计量和线性假设,P C A此时表现不佳㊂核主成分分析(k e r n e l p r i n c i p a lc o m p o n e n ta n a l y s i s, K P C A)[911]在一定程度拓宽了P C A的应用范畴,利用非线性映射将输入数据映射到高维特征空间,在特征空间执行P C A㊂李梦瑶等[12]用K P C A降低数据维度㊁剔除冗余信息,从而实现齿轮箱的故障诊断㊂武文栋等[13]提出K P C A结合麻雀搜索算法优化核极限学习机的方法,用以提高光伏阵列故障诊断的精度㊂然而,在实际工业过程中,数据通常同时存在着高斯分布和非高斯分布特性,而K P C A在选取主成分的过程中只使用过程变量的方差信息,因此缺少处理非高斯数据的能力,对一些复杂的系统故障处理效果也就不理想㊂2010年,J e n s s e n[14]提出一种新的降维方法核熵成分分析方法(k e r n e l e n t r o p y c o m p o n e n t a n a l y s i s,K E C A)㊂对比K P C A只考虑方差信息只能提取数据的高斯特征㊂K E C A[1517]以信息熵为信息衡量的指标,使用高阶统计量最大程度保留原始数据的熵值,同时,其能够捕捉到数据内部的结构信息㊂如今,K E C A在干旱监测㊁柴油机故障识别㊁风电功率预测等领域被广泛应用[1820]㊂但目前未查到该方法在化工工业过程多类型故障诊断领域的应用㊂针对传统算法在多类型故障诊断率较低的问题,本文提出一种K E C A-C S K的故障诊断方法㊂K E C A进行多种数据分析时,不同类别的数据样本往往互相垂直,而同一类别的数据样本往往共线,基于此特点设计一种基于余弦相似度的K均值聚类器,建立诊断模型,从而对未知类型的故障数据进行判别㊂本文对田纳西伊斯曼化工过程(T e n n e s s e e-E a s t m a n,T E)进行模拟实验,验证K E C A-C S K均值方法在故障诊断领域的有效性㊂1故障诊断方法1.1核熵成分分析方法定义数据集D={x1,x1, ,x n}的概率密度函数p(x),其R e n y i熵H(p)表示为H(p)=-l gʏp2(x)d()x㊂(1)由式(1)可以看出,R e n y i熵估计取决于数据集的概率密度函数,不需要对数据的分布进行限定,算法的适用性更强㊂因为对数函数本身具有单调性,因此只需考虑V(p)=ʏp2(x)d x㊂(2)为了估计V(p),引入P a r z e n窗函数p(x),表示为p(x)=1nðx tɪD kδ(x,x t)㊂(3)式中:n为样本数;kδ(x,x t)是M e r c e r核函数,δ为核参数㊂V(p)用样本均值近似估计V(p),表示为V(p)=1nðx tɪD p(x t)=1nðx tɪD1nðx tᶄɪD Kδ(x t,x tᶄ)=1n2I T K I㊂(4)式中:K为nˑn的核矩阵;I为nˑ1的单位向量㊂核矩阵包含了二次R e n y i熵估计值所需的所有元素㊂对核矩阵进行特征分解,K=EΛE T㊂(5)Copyright©博看网. All Rights Reserved.式中:Λ=d i a g (λ1,λ2, ,λn )表示特征值矩阵;E =(e 1,e 2, ,e n )表示特征向量矩阵㊂将式(5)代入式(4),得到V (p )=1n 2ðn i =1λi e T i()I 2=1n 2ðni =1ζi ㊂(6) 由式(6)可得,R e n yi 熵可以表示为n 个分量的累积,各个分量都同时包含特征值与特征向量㊂将输入数据集D ={x 1,x 2, ,x n },通过非线性φ映射到核特征空间定义为x i ңφ(x i )(i =1,2, ,n ),该特征空间的数据可表示为Φ=[φ(x 1),φ(x 2), ,φ(x n )]㊂由于K E C A 可以被看作最大限度地保留R e n y i 熵估计的主轴在包含原始数据最多信息的情况下构造成的子空间,即将数据映射到由k 个K P C A 主轴张成的子空间U k 上,对ζi 值从大到小排序,选取前k 个特征值和特征向量,转换后的数据表示为F e c a =U k Φ=Λ12k E Tk m i n λ1,e 1, ,λn ,e n{V (p )-V k (p )}㊂(7)式中:V k (p )是选取前k 个特征向量估计的R e n y i 熵;F e c a =(f 1,f 2, ,fk )表示得分矩阵㊂在K P C A 中,取前l 个特征值和特征向量,转换后的数据表示为F p c a =Λ121E T l㊂对于新的样本x n e w 在U k 上的投影可表示为F k n e w=U k Φ(x n e w )=Λ-12k E Tk K (x ,x n e w )㊂(8)1.2 C S K 方法K 均值算法由于其原理简单㊁易于理解㊁容易实现以及理论可靠等优点而被广泛应用于不同领域㊂由于T E 数据经K E C A 特征提取后不同类的数据分布在不同的角度方向上,因此本文使用样本到各个质心的夹角余弦值来衡量数据样本之间的相似性,即余弦值越大,表明数据与该类别的数据样本相似度越高㊂假设两个包含m 维特征的向量,表示为α=(a 1,a 2, ,a m ),b =(b 1,b 2, ,b m ),则夹角余弦值可表示为c o s θ=αb αb㊂(9) 当α,b 方向一致时,数据之间夹角越小,夹角余弦值就越接近于1,数据相似度也就越高;同理,当两者之间夹角越大,夹角余弦值就越小,数据相似度也就越低㊂基于C S K 的方法步骤如下:1)初始质心的确定㊂选取余弦相似度最低的数据样本作为前2个初始质心,然后再选择与前2个初始质心余弦相似度最低的数据样本作为第3个初始质心,以此类推,直至确定C 个初始质心;2)将数据样本划分到与C 个初始质心余弦相似度最高的类别中;3)更新每个数据类别中的类质心;4)重复步骤(2)~(3),当质心位置变化小于给定的阈值,循环结束,保留各类别中心㊂C S K 均值方法运用于故障诊断领域,首先是将混合的不同故障类别数据进行聚类,聚类结束以后,保留不同故障类别的聚类中心,构建诊断模型㊂对新获得的未知类别的测试数据进行故障诊断时,确定此故障数据样本与哪一类别的聚类中心余弦值最大,那么该样本的故障类别属性就与那一类故障样本的类别属性一致㊂1.3 K E C A 中核参数的选取本文K E C A 中核函数选取高斯核函数,表达式为k (x ,x t )=e x p (-0.5x -x t 2/δ2)㊂(10)式中,δ为待优化的核参数㊂在聚类分析中,尽可能使得同类数据之间相互靠近,不同类数据之间相互远离㊂因此,核参数选取规则定义如下:1)类内离散度㊂S w =1ðCi =1n2iðt ,t ᶄɪC ico s ø(F e c a(x t ),F e c a (x t ᶄ))㊂(11)993第5期 李 榕等:基于核熵成分分析的工业过程故障诊断Copyright ©博看网. All Rights Reserved.2)类间离散度㊂S b=1n2-ðC i=1n2i ðtɪC i,tᶄɪC j,iʂj c o sø(F e c a(x t),F e c a(x tᶄ)),∀i,j=1, ,C㊂(12)式中,C为数据样本类别个数㊂使用基于角结构的类内与类间离散度的差作为选取的准则函数,即:J=m a xδ(S w -S b)㊂(13)根据S h i等[21]提出的参数值选取方法,将原始空间样本欧氏距离中值的10%~20%作为参数选取范围,然后利用所定义的准则函数选取合适的核参数㊂2基于K E C A-C S K均值故障诊断基于K E C A-C S K均值故障诊断方法分为离线建模和在线诊断2部分,K E C A-C S K均值方法的诊断流程图如图1所示㊂图1基于K E C A-C S K均值故障诊断流程F i g.1F a u l t d i a g n o s i s f l o w c h a r t b a s e do nK E C A-C S K2.1离线建模1)获取训练数据共m个变量n个样本X=[x1,x2, ,x n]ɪR mˑn,并进行标准化处理;2)构建K E C A模型,根据式(7)计算得分矩阵F e c a;3)计算F e c a向量之间的余弦值,确定C个初始聚类中心;4)根据余弦相似度大小,将数据划分到相对应的类群中;5)更新C个类群的聚类中心;6)重复步骤4)~5),各类群中心变化小于阈值,则停止,获得聚类中心㊂2.2在线诊断1)测试数据x n e w并进行标准化处理;2)测试数据向K E C A模型进行投影,通过式(8)计算得分矩阵F k n e w;3)计算F k n e w与建模时各类群聚类中心的余弦值,将其划为余弦值最大的类群㊂3T E仿真实验T E过程是由美国E a s t m a n化学公司的D o w n s和V o g e l共同开发的T EB e n c h m a r k仿真模拟平台,由该平台产生T E数据,近年来被广泛应用于工业生产故障检测与诊断[2226]㊂T E工业流程主要包括反应器㊁冷凝器㊁循环压缩机㊁气液分离器和汽提塔等5个操作单元,整个过程中共涉及8种物料成分,分别为主要参加反应的气体进料U㊁C㊁D㊁E;惰性不可溶进料B;反应副产品F以及反应液态主产物G和H㊂该平台总共预设了21种故障,其中,I D V1~I D V7为阶跃故障,I D V8~I D V12为随机变化故004沈阳大学学报(自然科学版)第35卷Copyright©博看网. All Rights Reserved.障,I D V 13为慢偏移故障,I D V 14~I D V 15为堵塞干扰故障,I D V 16~I D V 21为未知型故障㊂3.1 样本选取表1 故障数据描述T a b l e1 F a u l t d a t ad e s c r i pt i o n 故障编号故 障 描 述故障类型I D V 1物料U ㊁C 进料比改变,B 不变阶跃I D V 5冷凝器冷却入口温度改变阶跃I D V 18未知未知本文选取T E 过程故障1㊁故障5和故障18作为研究对象㊂故障具体描述如表1所示㊂在训练集中,正常数据样本是在25h 运行仿真下获得,样本总数为500;故障数据样本是在24h 运行仿真下获得,样本总数为480㊂本文选取训练集3ˑ400ˑ52,其中3是3类故障类型,400是数据样本个数,52是变量数㊂在测试集中,正常数据样本是在48h 运行仿真下获得,采样间隔时间为3m i n ,样本总数为960;故障数据样本是在48h 运行仿真下获得,故障在8h 的时候引入,样本总数为960,其中,前160个数据样本为正常数据样本㊂本文选取测试集为3ˑ400ˑ52㊂3.2 故障诊断3.2.1 核参数确定图2 不同核参数下的准则函数值F i g .2 C r i t e r i o n f u n c t i o n v a l u e s u n d e r d i f f e r e n t k e r n e l pa r a m e t e r s 以T E 过程为背景进行仿真实验,训练数据选取故障类型1㊁5和18共1200个数据样本,测试数据为同样的未知标签的3类数据共1200个数据样本㊂经计算,原始空间样本欧氏距离中值为50.015,核参数的选择区间为δ=50.015ˑu ,u =0.1ʒ0.01ʒ0.2,利用准则函数选取合适的核参数,核参数的取值与准则函数值的关系如图2所示㊂为了便于可视化以及诊断分析,同时确定k ㊁l 为聚类数3㊂观察图2可得,当核参数取欧氏距离中值的17%时,准则函数最大,因此本实验中核参数取值为8.50255㊂3.2.2 实验分析为了验证K P C A (K P C A 中核参数的取值方式与K E C A 取值方式一致)与K E C A 之间的差异性,将所建立的核矩阵分解后,得到特征值和R e n y i 熵值,并将其归一化,如图3(a )所示,K P C A 依据特征值大小选取第1㊁2㊁3主成分,K E C A 中基于R e n y i 熵值贡献选取第1㊁2㊁6主成分,即特征值大的不一定取得R e n y i 熵值贡献也大㊂根据K P C A 与K E C A 两种方法选择各自不同的主成分后将数据进行投影,如图3(b )和3(c ),K P C A 投影将3类数据分开后,数据分布较为分散,也没有出现明显的角结构特性,而K E C A 分析中,数据之间具有明显的角结构特征,数据分布较为紧密,有利于C S K 方法对数据进行聚类㊂(a )规范化特征值和R e n yi 熵值104第5期 李 榕等:基于核熵成分分析的工业过程故障诊断Copyright ©博看网. All Rights Reserved.(b)前3个最大特征值对应的主成分(c )R e n yi 熵贡献前3主成分图3 3种故障聚类实验分析F i g .3 A n a l y s i s o f t h r e e f a u l t c l u s t e r i n g e x pe r i m e n t s 对核矩阵的第1㊁2㊁3和6特征向量进行分析,如图4所示㊂(a )e 1(b )e 2(c )e 3(d )e 6图4 训练数据核主成分F i g .4 K e r n e l p r i n c i p a l c o m p o n e n t s o f t r a i n i n g da t a 观察图4可得,K E C A 根据R e n y i 熵贡献大小,选择第e 1㊁e 2㊁e 6特征向量㊂e 1㊁e 2㊁e 6特征向量中均有一段对应于其中一个数据类别的正值或负值,而对于其他类别值均接近于零,即K E C A 所选取的特征向量携带数据集的簇结构信息,因此,转换数据集的角结构也将会出现,如图4(c )所示㊂对于e 3特征向量,其在零附近上下波动,对于R e n y i 熵贡献也基本为0,K E C A 按照R e n y i 熵值大小也就不会选取该特征向量作为投影方向㊂K P C A 对数据特征提取时,根据特征值降序排列选取e 1㊁e 2㊁e 3特征向量㊂然而,e 3特征向量分布没有刻画出故障18的数据的特点,不能获取数据的结构信息㊂因此,对比K P C A 204沈阳大学学报(自然科学版) 第35卷Copyright ©博看网. All Rights Reserved.方法,K E C A 能够提取不同类数据的差异性,获取数据内部存在的结构信息,使得转换后的数据保持较好的可区分性㊂3.2.3 训练数据聚类基于上述分析后,使用本文所提出的C S K 聚类器,对训练数据进行聚类,获取各类群的聚类中心,聚类结果如图5所示㊂(a )K E C A 聚类结果(b )K P C A 聚类结果图5 聚类结果F i g .5 C l u s t e r i n g re s u l t p l o t 图5(a )是训练数据K E C A -C S K 聚类结果,3种类型样本的聚类正确率分别为95.5%,96.0%和35.0%㊂图5(b )是K P C A 的聚类结果,3种故障类型数据样本的聚类正确率分别为89.25%,54.25%和28.00%㊂K P C A 聚类效果相比K E C A 聚类效果较差㊂训练数据聚类结果的正确率直接影响对未知类别故障数据的诊断正确率㊂3.2.4 未知类别的故障数据诊断对于包含与建模数据相同的测试样本,将其投影到建模模型获得得分向量,计算得分向量与建模结果中各类群中心的余弦值,将其划为余弦值最大的那一类别中㊂若测试数据的故障类型不同于建模数据的故障类型时,将其代入其他数据建立的诊断模型中,图6是K E C A 与K P C A 的诊断结果㊂(a )K E C A 诊断结果(b )K P C A 诊断结果图6 故障诊断结果F i g .6 T r o u b l e s h o o t i n g re s u l t s 图6(a )是K E C A 的诊断结果,3种未知故障类型的测试数据样本基本均能得到有效判别,总数据样本的诊断正确率为80.08%㊂K E C A 特征提取时候,捕捉到的数据集群结构信息使得C S K 方法在训练数据上能够取得较好的聚类结果,进而影响对测试数据的诊断结果㊂图6(b )是K P C A 诊断结果,诊断结果较差,总数据样本的诊断正确率为59.08%,验证了K E C A 在工业过程故障诊断领域的优越性㊂304第5期 李 榕等:基于核熵成分分析的工业过程故障诊断Copyright ©博看网. All Rights Reserved.404沈阳大学学报(自然科学版)第35卷4结论针对实际工业过程中,传统核主成分多故障类型诊断率低问题,本文提出一种基于K E C A-C S K均值的故障诊断方法,并在T E化工过程数据取得较好的诊断效果㊂K E C A对数据进行特征提取,转换后的数据不同类别数据之间保持角结构特性,在此基础上设计一种基于余弦相似度的K均值聚类方法,从而获得较高准确率的建模结果,提高对未知类型数据判别的正确率㊂后续工作集中于探究该方法在其他工业过程的应用是否也能取得较好的诊断结果㊂参考文献:[1]周东华,李钢,李元.数据驱动的工业过程故障诊断技术:基于主元分析与偏最小二乘的方法[M].北京:科学出版社,2011:176.Z HO U D H,L IG,L IY.D a t a-d r i v e ni n d u s t r i a l p r o c e s s f a u l td i a g n o s i s t e c h n o l o g y:b a s e do n p r i n c i p a l c o m p o n e n ta n a l y s i sa n d p a r t i a l l e a s t s q u a r e sm e t h o d[M].B e i j i n g:S c i e n c eP r e s s,2011:176.[2]姚羽曼,罗文嘉,戴一阳.数据驱动方法在化工过程故障诊断中的研究进展[J].化工进展,2021,40(4):17551764.Y A O Y M,L U O WJ,D A IY Y.R e s e a r c h p r o g r e s so f d a t a-d r i v e n m e t h o d s i n f a u l t d i a g n o s i so f c h e m i c a l p r o c e s s[J].C h e m i c a lI n d u s t r y a n dE n g i n e e r i n g P r o g r e s s,2021,40(4):17551764.[3]X I EY,Z H A N G T.Af a u l t d i a g n o s i s a p p r o a c hu s i n g S VM w i t hd a t ad i m e n s i o nr e d u c t i o nb y P C Aa n dL D A m e t h o d[C]ʊ2015C h i n e s eA u t o m a t i o nC o n g r e s s(C A C).N o v e m b e r27-29,2015,W u h a n.I E E E,2016:869874.[4]F A NST,Z HA N G X M,S O N GZH.I m b a l a n c e d s a m p l e s e l e c t i o nw i t hd e e p r e i n f o r c e m e n t l e a r n i n g f o r f a u l t d i a g n o s i s[J].I E E ET r a n s a c t i o n s o n I n d u s t r i a l I n f o r m a t i c s,2022,18(4):25182527.[5]WA N G G,Y I N S.Q u a l i t y-r e l a t e df a u l td e t e c t i o na p p r o a c hb a s e do no r t h o g o n a l s i g n a l c o r r e c t i o na n d m o d i f i e dP L S[J].I E E ET r a n s a c t i o n s o n I n d u s t r i a l I n f o r m a t i c s,2015,11(2):398405.[6]D O N G Y N,Q I NSJ.An o v e l d y n a m i cP C Aa l g o r i t h mf o r d y n a m i c d a t am o d e l i n g a n d p r o c e s sm o n i t o r i n g[J].J o u r n a l o f P r o c e s sC o n t r o l,2018,67:111.[7]陈辉,周圆圆.基于P C A-B P神经网络的设备故障预测研究[J].物流工程与管理,2021,43(6):150153.C H E N H,Z HO U Y Y.R e s e a r c ho ne q u i p m e n t f a u l t p r e d i c t i o nb a s e do nP C A-B Pn e u r a l n e t w o r k[J].L o g i s t i c sE n g i n e e r i n g a n dM a n a g e m e n t,2021,43(6):150153.[8]张弛,王广民,许会博,等.基于P C A和优化参数S VM的智能变电站故障诊断方法[J].计算机应用与软件,2022,39(7):8088.Z HA N GC,WA N G G M,X U H B,e ta l.F a u l td i a g n o s i s m e t h o do fs m a r ts u b s t a t i o nb a s e do nP C Aa n do p t i m i z e d p a r a m e t e r S VM[J].C o m p u t e rA p p l i c a t i o n s a n dS o f t w a r e,2022,39(7):8088.[9]S H I O K AWAY,D A T EY,K I K U C H I J.A p p l i c a t i o n o f k e r n e l p r i n c i p a l c o m p o n e n t a n a l y s i s a n d c o m p u t a t i o n a lm a c h i n e l e a r n i n g t oe x p l o r a t i o no fm e t a b o l i t e s s t r o n g l y a s s o c i a t e dw i t hd i e t[J].S c i e n t if i cR e p o r t s,2018,8:3426.[10]S O H W,K I M H,Y UM B J.A p p l i c a t i o n o fk e r n e l p r i n c i p a lc o m p o n e n ta n a l y s i st o m u l t i-c h a r a c t e r i s t i c p a r a m e t e rd e s i g np r o b l e m s[J].A n n a l s o fO p e r a t i o n sR e s e a r c h,2018,263(1):6991.[11]黄英华,陈大伟,斯小琴,等.基于K P C A-I A O A-P N N的变压器故障诊断方法[J].山西大同大学学报(自然科学版),2022,38(3):1015.HU A N G Y H,C H E ND W,S IXQ,e t a l.T r a n s f o r m e r f a u l t d i a g n o s i sm e t h o d b a s e d o nK P C A-I A O A-P N N[J].J o u r n a l o f S h a n x iD a t o n g U n i v e r s i t y(N a t u r a l S c i e n c eE d i t i o n),2022,38(3):1015.[12]李梦瑶,周强,于忠清.基于K P C A和优化E L M的齿轮箱故障诊断[J].组合机床与自动化加工技术,2021(4):8790.L IM Y,Z H O U Q,Y U Z Q.G e a r b o xf a u l td i a g n o s i sb a s e do nk e r n e l p r i n c i p a lc o m p o n e n ta n a l y s i sa n do p t i m i z e d E L M[J].M o d u l a rM a c h i n eT o o l&A u t o m a t i cM a n u f a c t u r i n g T e c h n i q u e,2021(4):8790.[13]武文栋,施保华,郑传良,等.基于K P C A-I S S A-K E L M的光伏阵列故障诊断方法[J].智慧电力,2022,50(11):6976.WU W D,S H IB H,Z H E N G CL,e t a l.F a u l td i a g n o s i sm e t h o do f p h o t o v o l t a i c a r r a y b a s e do nK P C A-I S S A-K E L M[J].S m a r t P o w e r,2022,50(11):6976.[14]J E N S S E N R.K e r n e l e n t r o p y c o m p o n e n t a n a l y s i s[J].I E E E T r a n s a c t i o n so nP a t t e r n A n a l y s i sa n d M a c h i n e I n t e l l i g e n c e,2010,32(5):847860.[15]于健,隋丽丽,仓定帮,等.基于核熵成分分析与支持向量机组合算法的瓦斯涌出量预测模型[J].数学的实践与认识,2020,50(23):9399.Y UJ,S U I LL,C A N GDB,e t a l.G a s e m i s s i o n q u a n t i t y p r e d i c t i o nm o d e l b a s e d o nk e r n e l e n t r o p y c o m p o n e n t a n a l y s i s a n d s u p p o r t v e c t o rm a c h i n e c o m b i n a t i o na l g o r i t h m[J].M a t h e m a t i c s i nP r a c t i c e a n dT h e o r y,2020,50(23):9399.[16]郭金玉,李文涛,李元.在线压缩K E C A的自适应算法在故障检测中的应用[J].化工学报,2021,72(8):42274238.G U OJY,L IW T,L IY.A p p l i c a t i o no f a d a p t i v e a l g o r i t h mo f o n l i n e r e d u c e dK E C Ai n f a u l t d e t e c t i o n[J].C I E S CJ o u r n a l,2021,Copyright©博看网. All Rights Reserved.72(8):42274238.[17]江风云,唐勇波.基于核熵成分分析的油中溶解气体浓度预测[J ].控制工程,2020,27(8):14191424.J I A N GFY ,T A N G YB .C o n c e n t r a t i o n p r e d i c t i o no f d i s s o l v e d g a s i no i l b a s e do nk e r n e l e n t r o p y c o m p o n e n t a n a l ys i s [J ].C o n t r o l E n g i n e e r i n g ofC h i n a ,2020,27(8):14191424.[18]郭盛明,粟晓玲,吴海江,等.基于核熵成分分析的综合干旱指数的构建与应用:以黑河流域中上游为例[J ].干旱地区农业研究,2021,39(1):148157.G U OS M ,S U X L ,WU H J ,e ta l .C o n s t r u c t i o na n da p p l i c a t i o no fc o m p r e h e n s i v ed r o u g h t i n d e x b a s e do n k e r n e le n t r o p yc o m p o n e n t a n a l y s i s :a c a s e s t ud y o f t he u p p e r a n dm i d d l eH e i h eR i v e rB a s i n [J ].A gr i c u l t u r a lR e s e a r c h i n t h eA r i dA r e a s ,2021,39(1):148157.[19]许昕,韩慧苗,潘宏侠,等.基于多特征提取和K E C A 柴油机关键部件故障识别[J ].电子测量技术,2021,44(19):6368.X U X ,HA N H M ,P A N H X ,e t a l .F a u l t i d e n t i f i c a t i o no f k e y c o m p o n e n t s o f d i e s e l e n g i n eb a s e do nm u l t i -f e a t u r e e x t r a c t i o na n d K E C A [J ].E l e c t r o n i cM e a s u r e m e n tT e c h n o l og y ,2021,44(19):6368.[20]张颖超,成金杰,邓华,等.基于相似日和特征提取的短期风电功率预测[J ].郑州大学学报(工学版),2020,41(5):4449.Z HA N G YC ,C H E N GJ J ,D E N G H ,e t a l .S h o r t -t e r m w i n d p o w e r p r e d i c t i o nb a s e do ns i m i l a rd a y a n df e a t u r ee x t r a c t i o n [J ].J o u r n a l o f Z h e n g z h o uU n i v e r s i t y (E n g i n e e r i n g S c i e n c e ),2020,41(5):4449.[21]S H IJ B ,MA L I K J .N o r m a l i z e dc u t sa n di m a g es e g m e n t a t i o n [J ].I E E E T r a n s a c t i o n so n P a t t e r n A n a l y s i sa n d M a c h i n e I n t e l l i ge n c e ,2000,22(8):888905.[22]A D E L IM ,MA Z I N A N A H.H i g h ef f i c i e n c y f a u l t -d e t e c t i o n a n d f a u l t -t o l e r a n t c o n t r o l a p p r o a c h i nT e n n e s s e eE a s t m a n p r o c e s s v i a f u z z y -b a s e dn e u r a l n e t w o r k r e p r e s e n t a t i o n [J ].C o m p l e x &I n t e l l i g e n t S y s t e m s ,2020,6(1):199212.[23]U D U G AMAIA ,G E R N A E YKV ,T A U B E M A ,e t a l .An o v e l u s e f o r a n o l d p r o b l e m :t h eT e n n e s s e e E a s t m a nc h a l l e n g e p r o c e s s a s a na c t i v a t i n g t e a c h i n g t o o l [J ].Ed u c a t i o n f o rC he m i c a l E n gi n e e r s ,2020,30:2031.[24]Y I NS ,D I N GSX ,H A G H A N IA ,e t a l .Ac o m p a r i s o ns t u d y o f b a s i c d a t a -d r i v e n f a u l t d i a g n o s i s a n d p r o c e s sm o n i t o r i n g m e t h o d s o n t h eb e n c h m a r kT e n n e s s e eE a s t m a n p r o c e s s [J ].J o u r n a l o f P r o c e s sC o n t r o l ,2012,22(9):15671581.[25]D OWN S J J ,V O G E L E F .A p l a n t -w i d e i n d u s t r i a l p r o c e s sc o n t r o l p r o b l e m [J ].C o m p u t e r s &C h e m i c a lE n g i n e e r i n g ,1993,17(3):245255.[26]M C A V O Y TJ ,Y E N ,G A N G C .A ni m p r o v e db a s ec o n t r o l f o rt h e T e n n e s s e eE a s t m a n p r o b l e m [C ]ʊP r o c e e d i n gso f1995A m e r i c a nC o n t r o l C o n f e r e n c e -A C C 95.J u n e 21-23,1995,S e a t t l e ,WA ,U S A.I E E E ,2002:240244.ʌ责任编辑:李 艳ɔ504第5期 李 榕等:基于核熵成分分析的工业过程故障诊断Copyright ©博看网. All Rights Reserved.。

降维法1. 引言降维法是在数据分析和机器学习领域中常用的一种技术,用于将高维数据转化为低维数据,从而降低数据的复杂性,便于后续的分析和处理。

在实际应用中,降维法可以帮助我们发现数据中的隐藏模式和结构,提高数据分析的效果和准确性。

本文将介绍降维法的原理和常用方法,以及它们在实际应用中的一些注意事项。

2. 降维原理在介绍降维法的具体方法之前,我们先来了解一下降维的原理。

高维数据通常包含大量冗余信息和噪声,这使得数据分析和处理变得复杂且计算开销较大。

而低维数据则包含了原始数据的关键信息,可以用较少的特征来表达。

因此,通过降维可以减少数据的复杂性,去除冗余信息和噪声,提高数据的表达能力和可解释性。

降维的关键问题就是如何选择合适的特征子集,使得低维数据能够尽可能地保留原始数据的信息。

不同的降维方法通过不同的策略来进行特征选择和变换,达到降维的目的。

下面我们将介绍几种常用的降维方法。

3. 主成分分析(PCA)主成分分析(Principal Component Analysis,简称PCA)是一种经典的降维方法。

它通过线性变换将高维数据投影到一个低维空间中,使得投影后的数据保留尽可能多的原始数据的方差。

PCA的基本思想是找到数据中方差最大的方向作为第一主成分,然后找出与第一主成分不相关且方差次大的方向作为第二主成分,依此类推。

PCA的具体算法步骤如下: 1. 对原始数据进行中心化处理,即将每个特征的均值减去去掉后的样本平均值。

2. 计算协方差矩阵。

3. 对协方差矩阵进行特征值分解,得到特征值和特征向量。

4. 按照特征值从大到小的顺序选择前k个特征向量,组成投影矩阵。

5. 将原始数据投影到低维空间中。

PCA的优点是简单易理解且计算效率高,但它假设数据的低维表示是线性的,对于非线性的数据结构表达可能效果较差。

4. 线性判别分析(LDA)线性判别分析(Linear Discriminant Analysis,简称LDA)是一种经典的降维方法,特别适用于分类问题。

降维算法⼀览在机器学习中经常会碰到⼀些⾼维的数据集,⽽在⾼维数据情形下会出现数据样本稀疏,距离计算等困难,这类问题是所有机器学习⽅法共同⾯临的严重问题,称之为“ 维度灾难 ”。

另外在⾼维特征中容易出现特征之间的线性相关,这也就意味着有的特征是冗余存在的。

基于这些问题,降维思想就出现了。

降维就是指采⽤某种映射⽅法,将原⾼维空间中的数据点映射到低维度的空间中。

通过降维,可以⽅便数据可视化+数据分析+数据压缩+数据提取等。

降维⽅法架构降维⽅法主要包括线性⽅法和⾮线性⽅法。

特征降维经常会和特征选择混淆。

实际上,特征选择和传统的特征降维有⼀定的区别。

特征降维本质上是从⼀个维度空间映射到另⼀个维度空间,特征的多少并没有减少,当然在映射的过程中特征值也会相应的变化。

特征选择就是单纯地从提取到的所有特征中选择部分特征作为训练集特征,特征在选择前和选择后不改变值,但是选择后的特征维数肯定⽐选择前⼩,毕竟我们只选择了其中的⼀部分特征。

这⾥我们主要讲述映射⽅法,对于特征选择,我们会在后⾯进⾏详细的阐述。

PCAPCA(Principal Component Analysis),即主成分分析⽅法,是⼀种使⽤最⼴泛的数据降维算法。

PCA通过线性变换将原始数据变换为⼀组各维度线性⽆关的表⽰,提取数据的主要特征分量,常⽤于⾼维数据的降维。

PCA有两种通俗易懂的解释:(1)最⼤⽅差理论;(2)最⼩平⽅误差。

下⾯主要从最⼤⽅差理论出发,推导出表达式最⼤⽅差理论PCA的⽬标可认为是最⼤化投影⽅差,也就是让数据在主轴上投影的⽅差最⼤。

对于给定的⼀组数据点{v1,v2,…,v n},其中所有向量均为列向量,对其进⾏中⼼化,表⽰为{x1,x2,…,x n}。

可得向量x i在w(单位⽅向向量)上的投影坐标可以表⽰为(x i,w)=x T i w,因此我们的⽬标是找到⼀个投影⽅向w,使得{x1,x2,…,x n}在w上的投影⽅差尽可能⼤。

因为投影之后的均值为0,因此⽅差可以表⽰为:D(x)=1nn∑i=1(x T i w)T x T i w=1nn∑i=1w T x i x i T w=w T(1nn∑i=1x i x T i)w其中,1n∑ni=1x i x T i为样本协⽅差矩阵,令为∑,另外由于w是单位⽅向向量,即w T w=1,因此⽬标可写作:{max引⼊拉格朗⽇乘⼦,对w求导令其为0,可以推出∑w=λw,此时D(x)=w^T∑w=λw^T w=λ即,x投影后⽅差即协⽅差矩阵的特征值,最佳投影⽅向就是最⼤特征值对应的特征向量。

数据降维的常用方法分析数据降维是一种数据处理技术,通过减少数据的维度来帮助人们更好地理解数据,提高机器学习模型的效果和效率。

在大数据时代,降维技术尤为重要,因为大量的高维数据往往会使数据处理和分析变得困难和耗时。

本文将介绍数据降维的常用方法,包括主成分分析(PCA)、线性判别分析(LDA)、因子分析(FA)和独立成分分析(ICA)。

主成分分析(PCA)是一种常用的数据降维方法,通过线性变换将原有的高维特征表示转化为一组新的低维特征表示。

PCA的核心思想是找到一组方向,使得数据在这些方向上的投影具有最大的方差。

简单来说,PCA希望能找到最能代表数据特征的方向,并将数据映射到这些方向上。

通过选择保留的主成分个数,可以实现数据降维。

PCA在不需要先验知识的情况下进行降维,但可能会丢失一些原始数据的细微差别。

线性判别分析(LDA)是一种有监督的降维方法,主要用于特征提取和分类。

LDA的目标是找到一个投影,使得同类样本的投影点尽可能接近,不同类样本的投影点尽可能远离。

与PCA不同,LDA在降维的过程中,利用了类别信息。

通过选择最能区分各个类别的投影,可以实现数据的降维。

因子分析(FA)是一种经典的数据降维方法,主要用于探索性数据分析和潜在变量分析。

FA的目标是通过寻找潜在的因子结构来解释观测到的变量之间的相关性。

FA假设观测到的变量是由一组潜在因子和测量误差共同决定的,通过找到最能解释数据中变异的潜在因子,可以实现数据的降维。

与PCA和LDA相比,FA更加注重数据背后的因果关系和隐含结构。

独立成分分析(ICA)是一种用于解决盲源分离问题的数据降维方法。

ICA假设观测到的数据是由多个相互独立的源信号混合得到的,通过寻找独立源信号,可以实现数据的降维和源信号的分离。

ICA广泛应用于信号处理、图像处理和语音识别等领域。

除了上述常用的数据降维方法,还有一些其他的方法,如核主成分分析(KPCA)、非负矩阵分解(NMF)和局部线性嵌入(LLE)等。

复杂机电系统核熵判别分析的异常分类方法亚森江·加入拉; 高建民; 高智勇; 姜洪权【期刊名称】《《机械设计与制造》》【年(卷),期】2019(000)008【总页数】4页(P8-11)【关键词】复杂机电系统; 核熵判别分析; 异常模式分类; TE过程数据【作者】亚森江·加入拉; 高建民; 高智勇; 姜洪权【作者单位】新疆大学机械工程学院新疆乌鲁木齐 830046; 西安交通大学机械制造系统工程国家重点实验室陕西西安 710049【正文语种】中文【中图分类】TH16; TH17; TH165+.31 引言以流程工业为代表的分布式复杂机电系统是高度耦合的众多生产设备群的有机结合。

因此,系统生产过程检测数据具有明显的高维非线性和分布复杂特点,用传统的方法难以监测和判断系统的健康状态。

因此异常模式的分类非常重要,具有一定的难度。

目前常用的异常模式的分类方法有线性判别分析(Linear Discriminant Analysis,LDA)[1],主成分分析(Principal Component Analysis,PCA)[2],局部线性判别分析(Local Linear Discrimination Analysis,LFDA)[3],核Fisher判别分析(Kernel Fisher Discrimination Analysis,KFDA)[4]。

这些方法具有方法简单,计算速度快,分类效果好等优点,得到了学者们的广泛应用并取得了不少的研究成果。

特罗姆瑟大学的Robert Jenssen教授于2010年详细阐述核熵成分分析(Kernel Entropy Component Analysis,KECA)方法以来,国际上众多学者开始使用KECA方法进行相关的研究。

文献[5]提出了模糊强壮的主成分分析方法—RF-KECA,建立了光谱降维模型并解决了生物医学数据处理的一系列复杂问题。

文献[6]研究了WT-KECA方法在工业过程的应用,此方法根据最高Renyi熵选择最好的主成分向量而不是判断简单核矩阵的最高特征值和特征向量,而且小波变换在数据处理的应用,能够降噪和防止外部因素的扰动。

什么是降维算法?随着数据量的不断增大和数据维度的不断提高,许多数据科学家和工程师面临的最大挑战之一就是如何有效地处理和分析高维数据。

这时就需要我们采用降维算法来解决这个问题。

降维算法的作用是将高维数据映射到低维空间,并保留最重要的信息。

这样既可以降低计算成本,提高算法的效率,又可以避免数据维度灾难。

本文将为您介绍降维算法的原理和应用,以及常用的降维算法。

1. 什么是降维算法?降维算法是一种基于数学变换的技术,用于将高维数据映射到低维空间。

通俗地说,就是将数据从复杂的多维空间中压缩到简单的低维空间中去。

降维算法不仅可以用于数据可视化,还可以用于机器学习、图像处理、聚类分析等领域。

降维算法的核心思想是在保留数据最重要的特征的同时,尽可能地压缩数据的维度,减少噪声的干扰,从而更好地解决问题。

2. 降维算法的原理在介绍具体的降维算法之前,我们先来了解一下降维算法的原理。

降维算法的原理是将高维数据映射到低维空间中,并通过一定的映射方式对数据进行压缩。

映射方式有很多种,常见的映射方式有PCA (主成分分析)、LDA(线性判别分析)等。

PCA是降维算法中最常用的一种方法。

其基本思想是通过正交变换将原数据转换为新的特征向量,使得新特征向量的维度尽可能小,并使得数据的信息损失最小。

LDA是一种有监督的降维算法,其基本思想是将原数据映射到一个能够区分不同类别数据的低维空间中去。

通过分析样本的蕴含关系,能够减少数据的维度,提高数据的解释性。

3. 常用的降维算法常用的降维算法有PCA、LDA、t-SNE等,下面我们来介绍一下常用的降维算法。

(1)PCAPCA是一种常用的无监督降维算法,其基本思想是通过正交变换将原数据转换为新的特征向量。

PCA可以将数据在原始空间中的方差最大化,从而尽可能保留原始数据的信息。

(2)LDALDA是一种有监督的降维算法,其基本思想是将原数据映射到一个能够区分不同类别数据的低维空间中去。

通过分析样本的蕴含关系,能够减少数据的维度,提高数据的解释性。

数据降维方法及其应用数据降维是在机器学习和数据分析中经常使用的一种技术,它可以帮助我们从海量的数据中提取出重要的特征,以减少数据的维度并保留数据的关键信息。

本文将介绍一些常用的数据降维方法,并探讨它们在实际应用中的作用和效果。

一、主成分分析法(Principal Component Analysis, PCA)主成分分析是一种经典的数据降维方法,它通过线性变换将高维数据映射到低维空间中。

其基本思想是找到一组新的正交基,使得数据在新的基上具有最大的方差。

这样做的好处是,我们可以只保留方差较大的主成分,而忽略方差较小的次要成分,从而达到降低数据维度的目的。

PCA的应用非常广泛,比如在图像处理中,可以利用PCA将高维图像数据降低到低维,以实现图像的压缩和去噪等功能。

此外,在生物信息学中,PCA也常被用于基因表达数据的降维和挖掘,以辅助研究人员发现潜在的基因调控模式。

二、独立成分分析法(Independent Component Analysis, ICA)独立成分分析是一种非线性的数据降维方法,它的目标是将高维数据分解为多个相互独立的成分。

与PCA不同的是,ICA假设数据是由多个独立的隐变量线性组合而成的,通过寻找这些隐变量的线性组合权重,可以将数据进行降维。

ICA在信号处理、盲源分离等领域有广泛的应用。

例如,在语音信号处理中,利用ICA可以将混合语音分解为原始的音频信号,有助于语音识别和语音增强等任务的完成。

三、线性判别分析法(Linear Discriminant Analysis, LDA)线性判别分析是一种经典的分类数据降维方法,它的目标是找到一个投影方向,使得同类别样本的投影点尽可能近,不同类别样本的投影点尽可能远,从而实现样本的有效分类。

LDA可以看作是PCA在分类问题上的扩展。

LDA在模式识别、人脸识别等领域有广泛的应用。

例如,在人脸识别中,利用LDA可以提取出具有判别性的特征,从而实现对人脸图像的分类和识别。

Vol.39 No.1Jan. 2021第 39 卷第 1 期2021 年 01 月干旱地区农业研究Agricultural Research in the Arid Areas 文章编号:1000-7601(2021)01-0148-10 doi :10.7606/j.issn.1000-7601.2021.01.20基于核熵成分分析的综合干旱指数的构建与应用—以黑河流域中上游为例郭盛明S 粟晓玲1,2,吴海江打姜田亮打梁筝',冯凯1(1.西北农林科技大学水利与建筑工程学院,陕西杨凌712100;2.西北农林科技大学旱区农业水土工程教育部重点实验室,陕西杨凌712100)摘要:针对传统单变量干旱指数难以全面表征干旱及部分综合干旱指数难以反映多变量之间的非线性关系等问题,采用标准化降水蒸散发指数(SPE7)、标准化径流指数(SR/)及标准化土壤湿度指数(SSM7) 3个单变量指数分别表征气象干旱、水文干旱和农业干旱,利用核熵成分分析法(KECA )构造综合干旱指数(SMQ/),采用M-K 趋势 检验、小波分析及典型历史旱情验证等方法分析干旱的时空变化特征以及干旱指数的适用性。

以黑河流域中上游 为例,结果表明:研究区全年77.6%的区域表现为干旱不显著加重的趋势;在流域尺度上,干旱存在43 a 的长周期,15~23 a 的中周期,3~8 a 的短周期;20世纪90年代夏、秋两季及21世纪以来春、冬两季干旱发生频率较高,且整体 夏旱发生频率最高;1969年春、1997年秋和2009年冬的典型历史旱情验证表明SMD/优于其他3种单变量干旱指数。

说明基于KECA 构建的SMQ/是一种有效的干旱监测指数,在黑河流域中上游干旱监测中有好的适用性。

关键词:核熵成分分析(KECA );综合干旱指数;干旱指数构建;应用;黑河流域中图分类号:S161.3文献标志码:AConstruction and application of comprehensive drought index based on kernel entropy component analysis—A case study of the upper and middle Heihe River BasinGUO Shengming 1 , SU Xiaoling 1,2, WU Haijiang 1 , JIANG Tianliang 1 , LIANG Zheng 1 , FENG Kai 1(1. College of IFater Resources and Architecture Engineering, Northwest A&F University, Wangling, Shaanxi 712100, China ;2. Aey Laboratory of Arid Area Agricultural 即ater and Soil Engineering , Ministry of Education ,Northwest A&F University, Wangling, Shaanxi 712100)Abstract : In view of the cavity that the traditional single variable drought indices are difficult to characterize the comprehensive drought situation , and some existed composite drought indices reflect poorly on the nonlinear re lationship among multiple variables. We adopted kernel entropy component analysis ( KECA ) to construct a com prehensive drought index ( SMD/) by considering three various single drought indices : the standardizedprecipitation evaporation index ( SPE/) to represent meteorological drought , standardized runoff index ( SR/) to characterize hydrological drought , and standardized soil moisture index ( SSM/) to show agricultural drought.Taking the upper and middle reaches of Heihe River Basin as an example to analyze the drought spatiotemporal var iation and the applicability of SMD/, the M-K trend test , wavelet analysis and typical historical drought events val idation were utilized. The results showed that 77.6% of the grids of the study area presented an insignificant worse ning trend of drought in the whole year. Drought had a long period of 43 a, a medium period of 15 〜 23 a and ashort period of 3 〜 8 a on the watershed scale. In the season of summer and autumn of 1990s as well as in spring and winter since the 21st century, the drought frequency was higher. Moreover, the overall frequency of summer drought收稿日期:2020-08-14修回日期:2020-09-15基金项目:国家自然科学基金项目(51879222)作者简介:郭盛明(1996-),男,河南驻马店人,硕士研究生,研究方向为水文干旱分析。