GreenPlum集群环境搭建

1、简介

环境搭建准备:greenplum-4.3.8.2

1.1greenplum介绍

简单的说它就是一个与ORACLE, DB2一样面向对象的关系型数据库。我们通过标准的SQL可以对GP中的数据进行访问存取。

GREENPLUM与其它普通的关系型数据库的区别?

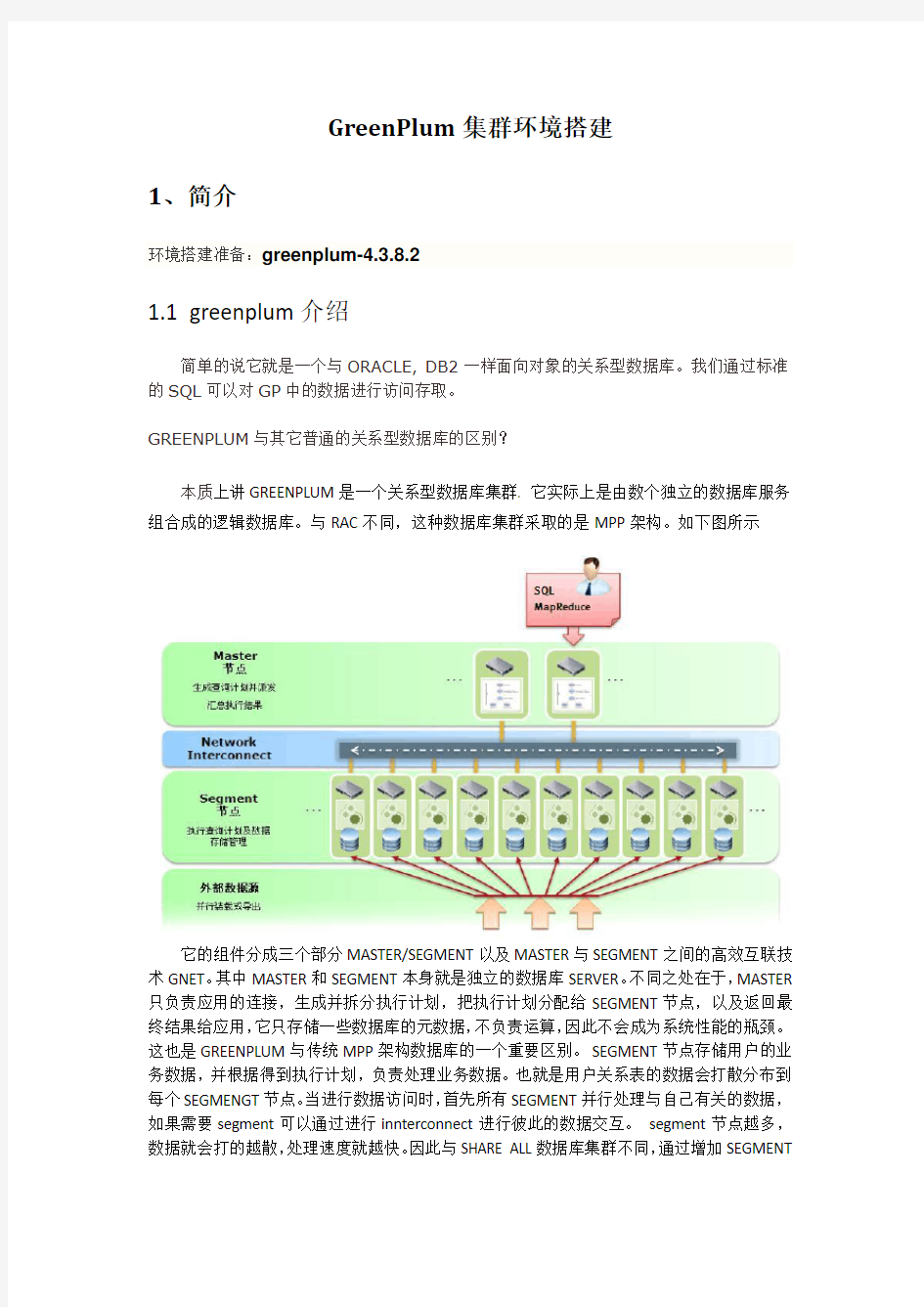

本质上讲GREENPLUM是一个关系型数据库集群. 它实际上是由数个独立的数据库服务组合成的逻辑数据库。与RAC不同,这种数据库集群采取的是MPP架构。如下图所示

它的组件分成三个部分MASTER/SEGMENT以及MASTER与SEGMENT之间的高效互联技术GNET。其中MASTER和SEGMENT本身就是独立的数据库SERVER。不同之处在于,MASTER 只负责应用的连接,生成并拆分执行计划,把执行计划分配给SEGMENT节点,以及返回最终结果给应用,它只存储一些数据库的元数据,不负责运算,因此不会成为系统性能的瓶颈。这也是GREENPLUM与传统MPP架构数据库的一个重要区别。SEGMENT节点存储用户的业务数据,并根据得到执行计划,负责处理业务数据。也就是用户关系表的数据会打散分布到每个SEGMENGT节点。当进行数据访问时,首先所有SEGMENT并行处理与自己有关的数据,如果需要segment可以通过进行innterconnect进行彼此的数据交互。segment节点越多,数据就会打的越散,处理速度就越快。因此与SHARE ALL数据库集群不同,通过增加SEGMENT

节点服务器的数量,GREENPLUM的性能会成线性增长。

GREENPLUM适用场景?

GREENPLUM虽然是关系型数据库产品,它的特点主要就是查询速度快,数据装载速度快,批量DML处理快。而且性能可以随着硬件的添加,呈线性增加,拥有非常良好的可扩展性。因此,它主要适用于面向分析的应用。比如构建企业级ODS/EDW,或者数据集市等等。

GREENPLUM运行的平台?

GREENPLUM运行在X86架构的硬件平台上,目前支持的操作系统包括32/64位的LINUX(REDHAT/SUSE)/SOLARIS/MAC OS

GREENPLUM的前景?

GREENPLUM 诞生于2003年硅谷,2010/07 EMC收购了GREENPLUM,并把GREENPLUM 作为EMC面向分析云的战略核心产品,加以大力发展。该产品不仅在国际市场发展很快,在国内市场发展也很快。最著名的案例就是阿里巴巴集团,经过多种产品的精心选型,最终选择GREENPLUM作为它们的数据仓库平台存放数百TB的业务数据去高效支持各种分析应用。

如何学习GREENPLUM?

正是由于产品发展速度很快,但是在相关人才上存在很大缺口。因此,我个人认为对于各位有兴趣的技术人员来说,是一个很好的职业发展机会。以个人经验来说,只要有其它关系型数据库的基础,尤其是POSTGRESQL或者INFORMIX基础的(因为GREENPLUM是在POSTGRESQL基础上开发出来的),很容就可以上手学习并掌握GREENPLUM。

GREENPLUM的手册写的非常好,完全可以作为入门的教材使用。其软件本身也是软性LICENSE,用于学习研究完全免费,而且与生产环境并无不同,这与ORACLE完全一样。

2、GreenPlum的HA

GP提供了几个选择性的功能来保证最大正常运行时间和高可用。

包括:

1. Segment Mirroring --segment镜像

2. Master Mirroring --master镜像

3. Fault Detection & Recovery --错误检测和恢复

-----Segment Mirroring------

Primary Segment和Mirror Segment放在不同主机上。

在数据库操作过程中,只有primary segment是活跃的,mirror仅仅做复制处理(file block replication process)

Segment挂了后系统操作流程:

1. 当segment挂了,文件复制进程停止,mirror segment自动的成为活跃的segment instance. 所有数据库操作则继续使用mirror。

2. 此时记录事务的模式发生改变,系统状态为Change Tracking 模式。

3. 当管理员把失败segment重新启动后,恢复进程将把2个之间的差异数据同步。

此时系统状态为Resynchronizing 模式

4. 一旦所有的mirror和primary都再次同步完成,系统状态将变更为Synchronized 模式。

------Master Mirroring------

你可以选择性的部署额外一台机器作为Standby Master。

gpsyncagent --复制进程,用来做master和standby之间的数据同步。

Master挂了后系统操作流程:

1. 如果primary master失败后,复制进程将被关闭,并且standby master能够被激活,以替换primary。

2. 于是激活的standby master被作为GP数据库master,接收和原master相同端口的连接

(replicated log是用来恢复最后成功提交事务时间点的master host的状态)

注: master是不包含用户数据,只是包含system catalog表。

这些表不经常更新,如果有更新的话,会自动同步到standby。故master和standby始终都保持一致。

------错误检测和恢复------

ftsprobe - GP中用来做错误检测的,GP Sever(postgres)的子进程。

该进程根据配置时间间隔监控GP队列、扫描所有segment和数据库进程。gprecoverseg - 检测宕掉的segment是否有效,并且和当前活跃segment比较,找出哪些改变丢失。它将只把差异部分做同步,然后把segment设成online。该进程在GP启动和运行(如果mirror没开,segment不可用,GP自动shutdown。必须做手工恢复。)

的时候会被执行。

3、greenplum 4.3.8.2分布式的安装部署

Centos6.5系统:64位

3.1系统设置

1. 编辑/etc/sysctl.conf文件

net.ipv4.ip_forward = 0

net.ipv4.conf.default.accept_source_route = 0

kernel.sysrq = 1

kernel.core_uses_pid = 1

net.ipv4.tcp_syncookies = 1

kernel.msgmnb = 65536

kernel.msgmax = 65536

kernel.sem = 250 64000 100 512

kernel.shmmax = 500000000

kernel.shmmni = 4096

kernel.shmall = 4000000000

kernel.sem = 250 64000 100 512

net.ipv4.tcp_tw_recycle=1

net.ipv4.tcp_max_syn_backlog=4096

https://www.doczj.com/doc/7911418088.html,dev_max_backlog=10000

vm.overcommit_memory=2

net.ipv4.conf.all.arp_filter = 1

对于练习环境来说,这个配置是没有问题的。但是在生产环境中,整个系统中有大量SEGMENT实例和镜像实例时,这样的配置可能导致无法启动服务。所以,请加大kernel.sem = 250 64000 100 512中最后一位的配置,比如把512改成1024,2048这样的值。另外,可以加大共享内存相关的配置,比如kernel.shmmax和kernel.shmall。

完成编辑之后,以root身份执行命令sysctl -p或者重启系统,使其配置生效。

2. 在/etc/security/limits.conf配置文件末尾处增加如下内容:

* soft nofile 65536 #nofile-打开文件的最大数目

* hard nofile 65536

* soft nproc 131072 # noproc - 进程的最大数目

* hard nproc 131072

* soft core unlimited # core - 限制内核文件的大小

注意:对于RedHat6.x系统,还需要将/etc/security/limits.d/90-nproc.conf文件中

的1024修改为131072。

3格式化磁盘

安装所需要的文件系统。GREENPLUM只能使用文件系统存放数据,不支持裸设备。出于性能考虑,EMC官方建议在LINUX上使用XFS文件系统,SOLARIS上使用ZFS文件系统。如果是练习环境则无所谓,只要相应操作系统可以支持的文件系统即可。对于LINUX来说,SUSE 的安装介质上就带有XFS文件系统。REHL 6.0以下/CENTOS 6.0以下版本则需要到相关网站单独下载XFS文件系统安装。

XFS文件系统安装:

64bit:

rpm -ivh kmod-xfs-0.4-2.x86_64.rpm

rpm -ivh xfsprogs-2.9.4-1.el5.centos.x86_64.rpm

32bit:

rpm -ivh kmod-xfs-0.4-2.i686.rpm

rpm -ivh xfsprogs-2.9.4-1.el5.centos.i386.rpm

先用fdisk -l查看要格式化的设备,然后使用命令mkfs -t xfs /dev/sdc,创建mount点,比如mkdir -p /data/vol1

为了保证系统重启后,可以自动mount磁盘,以root身份编辑/etc/fstab,添加条目[device file] /data xfs logbufs=8,noatime,nodiratime 1 1

也可以每次系统启动,自己用命令mount /data/vol1进行mount。

GP建议使用下面的挂载参数:

rw,noatime,inode64,allocsize=16m

比如,挂载XFS格式的设备/dev/sdb到目录/data1,/etc/fstab中的配置如下:

/dev/sdb /data1 xfs rw,noatime,inode64,allocsize=16m 1 1

4更改磁盘I/O策略

Linux磁盘I/O调度器对磁盘的访问支持不同的策略,默认的为CFQ,GP建议设置为deadline.

以root身份编辑/boot/grub/menu.lst,添加一行 elevator=deadline,但是不要修改failsafe的定义,如下图:

重启系统(必须),再以root身份执行命令cat /sys/block/*/queue/scheduler,输出的每行应该含有有[deadline],

比如noop anticipatory [deadline] cfq

然后应该设置磁盘预读,优化磁盘IO效率。以root身份编辑/etc/rc.d/rc.local,添加类这样的内容blockdev --setra 16384 /dev/sd*,重启系统。使用命令blockdev

--getra /dev/sd* 可以验证设置。

5配置read-ahead(blockdev)值

官方文档的推荐值为16384

检查某块磁盘的read-ahead设置:

# blockdev --getra devname

例如:# blockdev --getra /dev/sda

16384

修改系统的read-ahead设置,可通过/etc/rc.d/rc.local来修改,在文件尾部追加如下代码:

# blockdev --setra 16384 /dev/mapper/vg00-LV_01

如需临时修改read-ahead设置,可通过执行下面的命令来实现:

# blockdev --setra bytes devname

例如:# blockdev --setra 16384 /dev/sda

6 关闭防火墙

chkconfig iptables off 永久关闭

service iptables stop本次关闭

service iptables status 查看防火墙状态

3.2修改主机名和/etc/hosts文件

1)在各个主机上修改主机名

vi /etc/sysconfig/network

HOSTNAME=master

重启后生效。输入指令hostname 可查看当前主机的名字

2)/etc/hosts是ip地址和其对应主机名文件,使机器知道ip和主机名对应关系,格式如下:

注:每台机器都如上操作。

3.3 安装greenplum

1.准备配置文件

创建一个host_file,包含了Greenplum部署的所有主机名,内容如下:

mdw1

smdw1

sdw1

sdw2

创建一个hostfile_segonly,包含了所有的Segment Host的主机名,内容如下:

sdw1

sdw2

创建一个hostfile_exkeys,包含了所有的Greenplum主机的网口对应的主机名(因为有可能是双网卡的服务器),内如如下:

mdw1

smdw1

sdw1

sdw2

2.创建greenplum 账户

从4.1开始,GREENPLUM提供了一个工具gpseginstall,我们只需在master节点,以root 身份运行它,它会根据指定主机列表自动安装文件,创建系统用户gpadmin,并自动建立root 用户和系统用户(gpadmin)的等效性.

在greenplum bin目录下使用./gpseginstall -f host_file -u gpadmin -p gpadmin 来创建系统用户.

会输出类似以下信息:

3.确认安装

1). 在Master主机以gpadmin用户登录:

$ su gpadmin

2). 加载GPDB安装目录下的路径文件:

# source /usr/local/greenplum-db/greenplum_path.sh

3). 使用gpssh命令确认是否可以在不提示输入密码的情况下登录到所有安装了GP软件的主机。使用hostfile_exkeys文件。该文件需包含所有主机的所有网口对应的主机名。例如:

$ gpssh -f host_file -e ls -l $GPHOME

如果成功登录到所有主机并且未提示输入密码,安装没有问题。所有主机在安装路径显示相同的内容,且目录的所有权为gpadmin用户。

如果提示输入密码,执行下面的命令重新交换SSH密钥:

$ gpssh-exkeys -f host_file

4.创建数据存储区域

1)在Master 主机上创建数据目录位置

[root@gp_test1 Server]# mkdir /data/

[root@gp_test1 Server]# mkdir /data/master

[root@gp_test1 Server]# chown -R gpadmin:gpadmin /data/

2)使用gpssh命令在Standby Master上创建与和Master相同的数据存储位置[root@gp_test1 data]# source /usr/local/greenplum-db/greenplum_path.sh [root@gp_test1 data]# gpssh -h smdw1 -e 'mkdir /data/'

会显示如下信息:

[smdw1] mkdir /data/

[root@gp_test1 data]# gpssh -h smdw1 -e 'mkdir /data/master'

会显示如下信息:

[smdw1] mkdir /data/master

[root@gp_test1 data]#

[root@gp_test1 data]# gpssh -h smdw1 -e 'chown -R gpadmin:gpadmin /data/'

会显示如下信息:

[smdw1] chown -R gpadmin:gpadmin /data/

3)在所有Segment主机上创建数据目录位置

Tips:gpssh -h 针对给出的主机名hostname

gpssh -f 针对files文件里的清单

使用刚刚创建的hostfile_segonly文件指定Segment主机列表。例如:

[root@gp_test1 data]# gpssh -f /dba_files/gp_files/hostfile_segonly -e 'mkdir /data'

会显示如下信息:

[sdw2] mkdir /data

[sdw1] mkdir /data

[root@gp_test1 data]# gpssh -f /dba_files/gp_files/hostfile_segonly -e 'mkdir /data/primary'

会显示如下信息:

[sdw2] mkdir /data/primary

[sdw1] mkdir /data/primary

[root@gp_test1 data]# gpssh -f /dba_files/gp_files/hostfile_segonly -e 'mkdir /data/mirror'

会显示如下信息:

[sdw2] mkdir /data/mirror

[sdw1] mkdir /data/mirror

[root@gp_test1 data]# gpssh -f /dba_files/gp_files/hostfile_segonly -e 'chown -R gpadmin:gpadmin /data/'

会显示如下信息:

[sdw2] chown -R gpadmin:gpadmin /data/

[sdw1] chown -R gpadmin:gpadmin /data/

5.NTP配置同步系统时钟

GP建议使用NTP(网络时间协议)来同步GPDB系统中所有主机的系统时钟。

在Segment 主机上,NTP应该配置Master 主机作为主时间源,而Standby作为备选时间源。在Master和Standby上配置NTP到首选的时间源(如果没有更好的选择可以选择Master自身作为最上端的事件源)。

配置NTP

1. 在Master主机,以root登录编辑/etc/ntp.conf文件。设置server参数指向数据中心

的NTP时间服务器。例如(假如10.6.220.20是数据中心NTP服务器的IP地址):

server 10.6.220.20

2. 在每个Segment主机,以root登录编辑/etc/ntp.conf文件。设置第一个server参数

指向Master主机,第二个server参数指向Standby主机。例如:

server mdw1 prefer

server smdw1

3. 在Standby主机,以root登录编辑/etc/ntp.conf文件。设置第一个server参数指向Master主机,第二个参数指向数据中心的时间服务器。例如:

server mdw1 prefer

server 10.6.220.20

4. 在Master主机,使用NTP守护进程同步所有Segment主机的系统时钟。例如,使

用gpssh来完成:

# gpssh -f hostfile_ allhosts -v -e 'ntpd'

5. 要配置集群自动同步系统时钟,应开启各个NTP客户机的ntpd服务,并设置为开机时自动运行:

# /etc/init.d/ntpd start

# chkconfig --level 35 ntpd on

或是service ntpd start ,再设置ntsysv ,选择ntpd服务

传上NTP主机的/etc/ntp.conf 配置,也就是MASTER,修改部分见下划线

# Permit time synchronization with our time source, but do not

# permit the source to query or modify the service on this system.

restrict default kod nomodify notrap nopeer noquery

restrict -6 default kod nomodify notrap nopeer noquery

# Permit all access over the loopback interface. This could

# be tightened as well, but to do so would effect some of

# the administrative functions.

restrict 127.0.0.1

restrict -6::1

restrict 10.27.1.0 mask 255.255.255.0 nomodify

# Hosts on local network are less restricted.

#restrict 192.168.1.0 mask 255.255.255.0 nomodify notrap

# Use public servers from the https://www.doczj.com/doc/7911418088.html, project.

# Please consider joining the pool (https://www.doczj.com/doc/7911418088.html,/join.html).

#broadcast 192.168.1.255 key 42 # broadcast server

#broadcastclient # broadcast client

#broadcast 224.0.1.1 key 42 # multicast server

#multicastclient 224.0.1.1 # multicast client

#manycastserver 239.255.254.254 # manycast server

#manycastclient 239.255.254.254 key 42 # manycast client

# Undisciplined Local Clock. This is a fake driver intended for backup

# and when no outside source of synchronized time is available.

server 127.127.1.0# local clock

fudge 127.127.1.0 stratum 10

# Drift file. Put this in a directory which the daemon can write to.

# No symbolic links allowed, either, since the daemon updates the file

# by creating a temporary in the same directory and then rename()'ing

# it to the file.

enable auth monitor

driftfile /var/lib/ntp/drift

statsdir /var/lib/ntp/ntpstats/

filegen peerstats file peerstats type day enable

filegen loopstats file loopstats type day enable

filegen clockstats file clockstats type day enable

# Key file containing the keys and key identifiers used when operating

# with symmetric key cryptography.

keys /etc/ntp/keys

trustedkey 0

requestkey 0 controlkey

# Specify the key identifiers which are trusted. #trustedkey 4 8 42 # Specify the key identifier to use with the ntpdc utility. #requestkey 8 # Specify the key identifier to use with the ntpq utility. #controlkey 8

6.检查系统环境用gpadmin登录master主机

加载greenplum_path.sh文件

source /usr/local/greenplum-db/greenplum_path.sh

创建一个名为hostfile_gpcheck的文件,包含所有GP主机的主机名,确保无多余空格

vi /usr/local/gp_files/hostfile_gpcheck

mdw1

smdw1

sdw1

sdw2

可以用以下命令来check一下文件是否准确

# gpssh -f /dba_files/gp_files/hostfile_gpcheck -e hostname

这里会返回所有主机的hostname

#gpcheck -f /usr/local/gp_files/hostfile_gpcheck -m mdw1 -s smdw1

会显示类似如下信息:

20150314:20:07:34:017843 gpcheck:gp_test1:gpadmin-[INFO]:-dedupe hostnames 20150314:20:07:34:017843 gpcheck:gp_test1:gpadmin-[INFO]:-Detected platform: Generic Linux Cluster

20150314:20:07:34:017843 gpcheck:gp_test1:gpadmin-[INFO]:-generate data on servers 20150314:20:07:34:017843 gpcheck:gp_test1:gpadmin-[INFO]:-copy data files from servers 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[INFO]:-delete remote tmp files 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[INFO]:-Using gpcheck config file: /opt/greenplum//etc/https://www.doczj.com/doc/7911418088.html,f

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(None): utility will not check all settings when run as non-root user

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test4): on device (fd0) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test4): on device (hdc) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR

host(gp_test4): on device (sda) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test4): /etc/sysctl.conf value for key 'kernel.shmmax' has value '5000000000' and expects '500000000'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test4): /etc/sysctl.conf value for key 'kernel.sem' has value '250 5120000 100 20480' and expects '250 512000 100 2048'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test4): /etc/sysctl.conf value for key 'kernel.shmall' has value '40000000000' and expects '4000000000'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test1): on device (fd0) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test1): on device (hdc) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test1): on device (sda) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test1): /etc/sysctl.conf value for key 'kernel.shmmax' has value '5000000000' and expects '500000000'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test1): /etc/sysctl.conf value for key 'kernel.sem' has value '250 5120000 100 20480' and expects '250 512000 100 2048'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test1): /etc/sysctl.conf value for key 'kernel.shmall' has value '40000000000' and expects '4000000000'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test2): on device (fd0) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test2): on device (hdc) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test2): on device (sda) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test2): /etc/sysctl.conf value for key 'kernel.shmmax' has value '5000000000' and expects '500000000'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test2): /etc/sysctl.conf value for key 'kernel.sem' has value '250 5120000 100 20480' and expects '250 512000 100 2048'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test2): /etc/sysctl.conf value for key 'kernel.shmall' has value '40000000000' and expects '4000000000'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test3): on device (fd0) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test3): on device (hdc) IO scheduler 'cfq' does not match expected value 'deadline'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test3): on device (sda) IO scheduler 'cfq' does not match expected value 'deadline' 20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test3): /etc/sysctl.conf value for key 'kernel.shmmax' has value '5000000000' and expects '500000000'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test3): /etc/sysctl.conf value for key 'kernel.sem' has value '250 5120000 100 20480' and expects '250 512000 100 2048'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test3): /etc/sysctl.conf value for key 'kernel.shmall' has value '40000000000' and expects '4000000000'

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[ERROR]:-GPCHECK_ERROR host(gp_test3): potential NTPD issue. gpcheck start time (Sat Mar 14 20:07:34 2015) time on machine (Sat Mar 14 20:07:14 2015)

20150314:20:07:35:017843 gpcheck:gp_test1:gpadmin-[INFO]:-gpcheck completing...

3.4 检查硬件性能

1.检查网络性能

网络测试选项包括:并行测试(-r N)、串行测试(-r n)、矩阵测试(-r M)。测试时运行一个网络测试程序从当前主机向远程主机传输5秒钟的数据流。缺省时,数据并行传输到每个远程主机,报告出传输的最小、最大、平均和中值速率,单位为MB/S。如果主体的传输速率低于预期(小于100MB/S),可以使用-r n参数运行串行的网络测试以得到每个主机的结果。要运行矩阵测试,指定-r M参数,使得每个主机发送接收指定的所有其他主机的数据,这个测试可以验证网络层能否承受全矩阵工作负载。

[gpadmin@gp_test1 gp_files]$ gpcheckperf –f hostfile_exkeys -r N -d /tmp > subnet1.out [gpadmin@gp_test1 gp_files]$ vi subnet1.out

/usr/local/greenplum-db/bin/gpcheckperf -f hostfile_exkeys -r N -d /tmp

-------------------

-- NETPERF TEST

-------------------

====================

== RESULT

====================

Netperf bisection bandwidth test

mdw1 -> smdw1 = 366.560000

sdw1 -> sdw2 = 362.050000

smdw1 -> mdw1 = 363.960000

sdw2 -> sdw1 = 366.690000

Summary:

sum = 1459.26 MB/sec

min = 362.05 MB/sec

max = 366.69 MB/sec

avg = 364.81 MB/sec

median = 366.56 MB/sec

~

2.检查磁盘IO、内存带宽

[gpadmin@gp_test1 gp_files]$ gpcheckperf -f hostfile_segonly –d/data/mirror -r ds

/usr/local/greenplum-db/bin/gpcheckperf -f hostfile_segonly -d /data/mirror -r ds --------------------

-- DISK WRITE TEST

--------------------

--------------------

-- DISK READ TEST

--------------------

--------------------

-- STREAM TEST

--------------------

====================

== RESULT

====================

disk write avg time (sec): 752.24

disk write tot bytes: 4216225792

disk write tot bandwidth (MB/s): 5.46

disk write min bandwidth (MB/s): 0.00 [sdw2]

disk write max bandwidth (MB/s): 5.46 [sdw1]

disk read avg time (sec): 105.09

disk read tot bytes: 8432451584

disk read tot bandwidth (MB/s): 76.53

disk read min bandwidth (MB/s): 37.94 [sdw2]

disk read max bandwidth (MB/s): 38.59 [sdw1]

stream tot bandwidth (MB/s): 7486.56

stream min bandwidth (MB/s): 3707.16 [sdw2]

stream max bandwidth (MB/s): 3779.40 [sdw1]

3.5 初始化GreenPlum

1、确认前面的步骤已完成

2、创建只包含segment主机地址的host,如果有多网口,需要全部都列出来

3、配置文件,可以参考cp $GPHOME/docs/cli_help/gpconfigs/gpinitsystem_config /dba_files/gp_files

4、注意:可以在初始化时值配置Primary Segment Instance,而在之后使用gpaddmirrors命令部署Mirror Segment Instance

# FILE NAME: gpinitsystem_config

# Configuration file needed by the gpinitsystem

################################################

#### REQUIRED PARAMETERS

################################################

#### Name of this Greenplum system enclosed in quotes. 数据库的代号

ARRAY_NAME="Greenplum DW4P 2M2S(2m2p)"

#### Naming convention for utility-generated data directories. Segment的名称前缀

SEG_PREFIX=gpseg

#### Base number by which primary segment port numbers 起始的端口号

#### are calculated.

PORT_BASE=40000

#### File system location(s) where primary segment data directories

#### will be created. The number of locations in the list dictate

#### the number of primary segments that will get created per

#### physical host (if multiple addresses for a host are listed in

#### the hostfile, the number of segments will be spread evenly across

#### the specified interface addresses).

#### 指定Primary Segment的数据目录, DATA_DIRECTORY参数指定每个Segment主机配置多少个Instance。如果

#### 在host文件中为每个Segment主机列出了多个网口,这些Instance将平均分布到所有列出的网口上。

#### 这里的案例,hosts里有2个segment,sdw1,sdw2俩主机,都是单网卡

declare -a DATA_DIRECTORY=(/data/primary /data/primary)

#### OS-configured hostname or IP address of the master host.

#### Master所在机器的Hostname

MASTER_HOSTNAME=mdw1

#### File system location where the master data directory

#### will be created.

#### 指定Master的数据目录

MASTER_DIRECTORY=/data/master

#### Port number for the master instance.

#### Master的端口

MASTER_PORT=5432

#### Shell utility used to connect to remote hosts.

#### bash的版本

TRUSTED_SHELL=ssh

#### Maximum log file segments between automatic WAL checkpoints.

#### CHECK_POINT_SEGMENT

#### 设置的是检查点段的大小,较大的检查点段可以改善大数据量装载的性能,同时会加长灾难事务恢复的时间。更多信息可参考相关文档。缺省值为8,

#### 若为保守起见,建议配置为缺省值,本次测试环境为单台IBM3650M3,呃,可能要改叫联想3650了。

#### 如果多台服务器级的主机,有足够的内存>16G >16核,那么可以考虑设置为CHECK_POINT_SEGMENTS=256

CHECK_POINT_SEGMENTS=8

#### Default server-side character set encoding.

#### 字符集

ENCODING=UNICODE

################################################

#### OPTIONAL MIRROR PARAMETERS

################################################

#### Base number by which mirror segment port numbers

#### are calculated.

#### Mirror Segment起始的端口号

#MIRROR_PORT_BASE=50000

#### Base number by which primary file replication port

#### numbers are calculated.

#### Primary Segment主备同步的起始端口号

#REPLICATION_PORT_BASE=41000

#### Base number by which mirror file replication port

#### numbers are calculated.

#### Mirror Segment主备同步的起始端口号

#MIRROR_REPLICATION_PORT_BASE=51000

#### File system location(s) where mirror segment data directories

#### will be created. The number of mirror locations must equal the

#### number of primary locations as specified in the

#### DATA_DIRECTORY parameter.

#### Mirror Segment的数据目录

#declare -a MIRROR_DATA_DIRECTORY=(/data1/mirror /data1/mirror /data1/mirror /data2/mirror /data2/mirror /data2/mirror)

################################################

#### OTHER OPTIONAL PARAMETERS

################################################

#### Create a database of this name after initialization.

#DATABASE_NAME=name_of_database

#### Specify the location of the host address file here instead of

#### with the -h option of gpinitsystem.

#MACHINE_LIST_FILE=/home/gpadmin/gpconfigs/hostfile_gpinitsystem

接下来初始化集群:

[gpadmin@gp_test1 gp_files]$ gpinitsystem -c gpinitsystem_config -h hostfile_segonly -s smdw1 -S

输出类似如下信息:

20150317:15:28:50:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Checking configuration parameters, please wait...

20150317:15:28:50:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-ReadingGreenplum configuration file gpinitsystem_config

20150317:15:28:50:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Locale has not been setin gpinitsystem_config, will set to default value

20150317:15:28:50:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Localeset to en_US.utf8 20150317:15:28:50:030282 gpinitsystem:gp_test1:gpadmin-[WARN]:-Master hostname mdw1 does not match hostname output

20150317:15:28:50:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Checking to see if mdw1 can be resolved on this host

20150317:15:28:50:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Can resolve mdw1 to this host

20150317:15:28:50:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-No DATABASE_NAME set, will exit following template1 updates

20150317:15:28:50:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-MASTER_MAX_CONNECT not set, will set to default value 250

20150317:15:28:51:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Checking configuration parameters,Completed

20150317:15:28:51:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Commencing multi-home checks, please wait...

..

20150317:15:28:51:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Configuring build for standard array

20150317:15:28:51:030282 gpinitsystem:gp_test1:gpadmin-[WARN]:-Option-S supplied, but no mirrors have been defined, ignoring -S option

20150317:15:28:51:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Commencing multi-home checks,Completed

20150317:15:28:51:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Building primary segment instance array, please wait...

....

20150317:15:28:53:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-CheckingMaster host 20150317:15:28:53:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Checking new segment hosts, please wait...

....

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Checking new segment hosts,Completed

20150317:15:28:58:030282

gpinitsystem:gp_test1:gpadmin-[INFO]:-GreenplumDatabaseCreationParameters

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:---------------------------------------

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-MasterConfiguration 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:--------------------------------------- 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Master instance name =Greenplum DW4P 2M2S(2m2p)

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Master hostname = mdw1 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Master port =5432 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Master instance dir =/data/master/gpseg-1

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Master LOCALE = en_US.utf8 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Greenplum segment prefix = gpseg

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-MasterDatabase= 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Master connections =250 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Master buffers =128000kB 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Segment connections =750 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Segment buffers =128000kB 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Checkpoint segments =8 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Encoding= UNICODE 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Postgres param file =Off 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Initdb to be used =/opt/greenplum/bin/initdb

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-GP_LIBRARY_PATH is =/opt/greenplum/lib

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Ulimit check =Passed 20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Array host connect type =Single hostname per node

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Master IP address [1]=10.27.1.206

20150317:15:28:58:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-StandbyMaster= smdw1 20150317:15:28:59:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Primary segment # = 2 20150317:15:28:59:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Standby IP address =10.27.1.207

20150317:15:28:59:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-TotalDatabase segments =4 20150317:15:28:59:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Trusted shell = ssh 20150317:15:28:59:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Number segment hosts =2 20150317:15:28:59:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-Mirroring config = OFF 20150317:15:28:59:030282

gpinitsystem:gp_test1:gpadmin-[INFO]:----------------------------------------

20150317:15:28:59:030282

gpinitsystem:gp_test1:gpadmin-[INFO]:-GreenplumPrimarySegmentConfiguration 20150317:15:28:59:030282

gpinitsystem:gp_test1:gpadmin-[INFO]:----------------------------------------

20150317:15:28:59:030282 gpinitsystem:gp_test1:gpadmin-[INFO]:-sdw1 /data/primary/gpseg0 4000020

Cloudera大数据平台环境搭建(CDH5.13.1版)

目录

基础环境 软件环境 本文将介绍Centos7.4离线安装CDH和ClouderaManager过程,软件版本如下: 配置规划 本次安装共5台服务器,服务器配置及用途如下: 所需要的软件资源 1)JDK环境: JDK版本:51 jdk-8u151-linux-x64.rpm 下载地址: 2)CM包: CM版本:5.13.1 下载地址: 3)CDH包 CDH版本:5.13.1, ; .sha1; manifest.json 下载地址: 4)JDBC连接jar包: jar包版本:5.1.43, mysql-connector-java-5.1.43.jar 下载地址: 修改机器名(所有节点) 这种方式,在Centos7中可以永久性改变主机名称。

内容都改为: 设置防火墙(所有节点) 注:为了简便,可以先关闭防所有节点火墙,安装完成后,再按照下面步骤设置。 防火墙常用命令: 便,安装完毕后可以根据需要设置防火墙策略,保证集群安全。 配置免密码登录SSH 将子节点设置为从主节点ssh无密码登陆(主节点访问从节点需要无密码互通,否则后面会出现问题) 一路回车,生成无密码的密钥对。 把公钥拷贝至node169服务器上?: 登录到node169服务器上: 然后在node169服务器上,把公钥的内容追加到authorized_keys文件末尾(这个文件也在隐藏文件夹.ssh下,如果没有可以新建):

在node168节点出现下面表示成功登录node169节点: 以同样的方式将公钥拷贝至其他节点服务器上。 关闭SELINUX(所有节点) 关闭linuxSELINUX安全内核 (在Centos7中遇到SELINUX无法关闭的问题,重新启动机器恢复正常) 修改Linux内核参数(所有节点) 为避免安装过程中出现的异常问题,首先调整Linux内核参数。 1)设置swappiness,控制换出运行时内存的相对权重,Cloudera建议将swappiness设置为 10: 自CentOS6版本开始引入了TransparentHugePages(THP),从CentOS7版本开始,该特性默认就会启用。尽管THP的本意是为提升内存的性能,不过某些数据库厂商还是建议直接关闭THP,否则可能会导致性能出现下降。 表示已禁用:

运行环境: centos6.1 Mysql版本: MySQL-cluster-gpl-7.2.6-linux2.6-x86_6 下载地 址:https://www.doczj.com/doc/7911418088.html,/Downloads/MySQL-Cluster-7.2/mysql-cluster-gpl-7.2.6-linux2. 6-x86_64.tar.gz 对于这第一个MySQL数据库的集群,它由1个单一的MySQL服务引擎(mysqlds)、两个数据节点(ndbd)和一个单一的管理节点(ndb_mgmd)共同组成,所有的节点都运行在同一台主机上。 为配置文件和数据文件创建必要的存储文件夹,分别要建立如下几个文件夹: ① /home/mysql/my_cluster ② /home/mysql/my_cluster/ndb_data ③ /home/mysql/my_cluster/mysqld_data ④ /home/mysql/my_cluster/mysqld_data/mysql ⑤ /home/mysql/my_cluster/mysqld_data/ndbinfo ⑥ /home/mysql/my_cluster/conf 具体安装步骤: 1. 添用加户与组mysql [plain]view plaincopy 1.shell> groupadd mysql 2.shell> useradd -r -d /home/mysql -g mysql mysql [plain]view plain copy 1.shell> groupadd mysql 2.shell> useradd -r -d /home/mysql -g mysql mysql 2. 切换到mysql用户权限下 [plain]view plaincopy 1.shell> su - mysql [plain]view plain copy 1.shell> su - mysql

3台机器搭建集群环境 1. 集群配置如下 (3台机器) 管理节点:192.168.6.134 数据节点1:192.168.6.135 数据节点2:192.168.6.136 sql节点1:192.168.6.135 sql节点2:192.168.6.136 我使用3台机器进行配置,其中两台机器上的数据节点与sql节点在一起 2. 管理节点安装(192.168.6.134) 安装 1.shell> groupadd mysql 2.shell> useradd mysql -g mysql 3.shell> mv mysql-cluster-gpl-7.2.6-linux2.6-x86_6 4.tar.gz /usr/local/ 4.shell> cd /usr/local/ 5.shell> tar zxvf mysql-cluster-gpl-7.2.6-linux2.6-x86_64.tar.gz /usr/local/ 6.shell> mv mysql-cluster-gpl- 7.2.6-linux2.6-x86_64 mysql 7.shell> chown -R mysql:mysql mysql 8.shell> cd mysql 9.shell> scripts/mysql_install_db --user=mysql 配置管理节点 1.shell> mkdir /var/lib/mysql-cluster 2.shell> cd /var/lib/mysql-cluster vi config.ini 添加以下内容 1.[ndbd default] 2.NoOfReplicas=2 3.DataMemory=80M 4.IndexMemory=18M 5.[ndb_mgmd]

虚拟机软件Vmware的安装 1、概述 在进行分布式架构的学习前,首先需进行基础环境准备。众所周知,在单机运算能力无法满足处理海量数据的运算能力时,人们普遍开始考虑使用分布式运算来代替单机运算,这也成为了大数据分析和小数据分析最显著的区别之一,即使用的工具不同。当前大数据行业标准是使用Hadoop及其生态组件来执行分布式处理,这也是我们后续文章的主要内容。 分布式集群的主要目的在于连接多台的物理机,以达到整合运算能力线性增长的效果,在学习过程中,我们仍然可以在单台物理机上模拟搭建和运行分布式集群。通常来说,单台物理机上模拟分布式集群有两种方法,其一是利用Hadoop进行分进程的分布式模拟,即一般意义上的伪分布式,通常用于实验和测试;其二则是利用虚拟化软件,将一台物理机分为三台虚拟物理机,然后搭建分布式集群。其中后者与实际工作情景无异,只不过在物理机本身运算能力上有所差别,企业多用服务器级物理机,而在学习过程中个人电脑性能可能稍差。后续文章将针对两种分布式集群搭建方法进行教学,同时也将更加侧重分布式集群的搭建。

注:这里推荐个人计算机配置:硬盘空间大于100G、内存大于等于8G、CPU大于两核。 尽管Apache Hadoop可适用于Windows、Linux和Mac OS操作系统,但就其稳定性而言,我们首推Linux系统或Mac OS系统,而二者相比选择Linux系统适用面更为广泛,因此后续文章我们将在Linux系统中安装Hadoop。由于个人用户普遍使用Windows或Mac OS系统,我们需要在当前操作系统中虚拟一个Linux系统,因此,虚拟化工具就是我们需要掌握和使用的第一个软件。除此之外,由于将要多个虚拟机的统一管理和多个终端的操作,因此我们还需要掌握一些终端管理软件和文件传输软件的基本操作方法。这些软件将在后续使用过程中进行详细介绍。 2、虚拟机软件 2.1虚拟机软件简介 就目前而言,VMware Workstation是使用最为广泛、功能最为强大的虚拟机软件,主要用于IT开发和系统管理等商业环境,而开源虚拟软件Oracle VM VirtualBox,则在所有免费虚拟机软件中表现较为突出,成为大多数教学、实验等非商业环境中的首选。后续文章主要将采用VMware Workstation作为虚拟机软件安装虚拟机,而关于Virtual Box的下载和安装方法,也会在后续文章中单独介绍已满足各位同学的不同需求。今天我们介绍VMware Workstation的安装使用方法。 2.2VMware Workstation下载安装 1)VMware WorkStation下载 2)VMware WorkStation安装 双击安装文件,开始安装,在安全警告窗口点击“运行”

Mysql集群架构文档 MySQL Cluster 是MySQL适合于分布式计算环境的高实用、高冗余版本。它采用了NDB Cluster 存储引擎,允许在1个Cluster 中运行多个MySQL服务器。在MyQL 5.0及以上的二进制版本中、以及与最新的Linux版本兼容的RPM中提供了该存储引擎。(注意,要想获得MySQL Cluster 的功能,必须安装mysql-server 和mysql-max RPM)。 目前能够运行MySQL Cluster 的操作系统有Linux、Mac OS X和Solaris(一些用户通报成功地在FreeBSD上运行了MySQL Cluster ,但MySQL AB公司尚未正式支持该特性)。 一、MySQL Cluster概述 MySQL Cluster 是一种技术,该技术允许在无共享的系统中部署“内存中”数据库的Cluster 。通过无共享体系结构,系统能够使用廉价的硬件,而且对软硬件无特殊要求。此外,由于每个组件有自己的内存和磁盘,不存在单点故障。 MySQL Cluster 由一组计算机构成,每台计算机上均运行着多种进程,包括MySQL服务器,NDB Cluster 的数据节点,管理服务器,以及(可能)专门的数据访问程序。关于Cluster 中这些组件的关系,请参见下图:

所有的这些节点构成一个完成的MySQL集群体系。数据保存在“NDB存储服务器”的存储引擎中,表(结构)则保存在“MySQL服务器”中。应用程序通过“MySQL服务器”访问这些数据表,集群管理服务器通过管理工具(ndb_mgmd)来管理“N DB存储服务器”。 通过将MySQL Cluster 引入开放源码世界,MySQL为所有需要它的人员提供了具有高可用性、高性能和可缩放性的Cluster 数据管理。 二.安装环境 1.Linux操作系统版本:CentonOS 4.7 2.Mysql数据库版本:mysql-max-5.0.24-linux-i686.tar.gz 共三台机器安装了CentonOS4.7版本,首先保证把系统中没有一个包带有mysql的,有的话

大数据环境软件 操作系统 CentOS 7 #zip unzip 命令安装 yum install zip unzip #netstat 等命令网络工具包安装 yum install net-tools 软件安装包 -rw-r--r--. 1 root root 20985335 4月30 10:14 apache-storm-0.9.3.tar.gz -rw-r--r--. 1 root root 153512879 5月26 16:15 jdk-7u79-linux-x64.tar.gz drwxr-xr-x. 10 root root 4096 7月10 11:55 jzmq -rw-r--r--. 1 root root 71503892 4月17 10:06 kafka_2.10-0.8.2.1.zip -rw-r--r--. 1 root root 1358190 5月27 11:26 redis-3.0.1.tar.gz -rw-r--r--. 1 root root 1877380 5月12 2011 zeromq-2.1.7.tar.gz -rw-r--r--. 1 root root 17699306 7月10 02:50 zookeeper-3.4.6.tar.gz JAVA vi /etc/profile 在文件末尾增加如下配置内容 #set java environment JAVA_HOME=/usr/local/jdk1.7.0_79/ CLASSPATH=.:$JAVA_HOME/lib/tools.jar PATH=$JAVA_HOME/bin:$PATH export JAVA_HOME CLASSPATH PATH 配置生效 source /etc/profile 验证配置结果 [root@localhost local]# java -version java version "1.7.0_79"

Cloudera大数据平台环境搭建 (版)

目 录 Cloudera 大数据平台环境搭建错误! 未定义书签。 版)错误! 未定义书 签。 1. 基础环 境. 错误! 未定义书签。 软件环境错误!未定义书签。 2. 3. 配置规划...... 所需要的软件资源 错误!未定义书签。 错误!未定义书签。 修改机器名(所有节点) 设置防火墙(所有节点) 配置免密码登录 SSH.. 关闭SELINUX(所有节点)…… 修改 Linux 内核参数(所有节 点) 其他安装与配置(所有节点) . 配置NTP服务................. 安装 oracle (所有节点) Mysql 安装(主节点) 安装CM 传包,解包 创建数据库 创建用户 制作本地YUM源 拷贝 修改 启动 访问 安装CDH 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 错误! 未定义书 签。 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 jar 包................. cloudera-scm-agent 配置 CM Server 和 Agent ..... 错误!未定义书签。 错误!未定义书签。 错误!未定义书签。 CM. 错误!未定义书签。 错误! 未定义书 签。 登录后界面错误!未定义书签。 选择CM版本错误!未定义书签。 指定主机错误!未定义书签。 选择CDH版本错误!未定义书签。 出现“主机运行状态不良”错误 检查主机正确性................... 错误!未定义书签。 错误!未定义书签。 选择安装的服务错误!未定义书签。 角色分配 . 数据库设置 错误!未定义书签。 错误!未定义书签。 测试连接报错:错误!未定义书签。 群集设置错误!未定义书签。

在为某证券公司设计其OA架构时,初期客户是30万用户在线;然而在项目实施中,客户又提出50万用户同时在线的需求,而且都有写的需求;这样初始的设计master-master-slave,读写分离满足不了客户的要求,所以我们打算采用Mysql Cluster方案;MySQL Cluster 是MySQL适合于分布式计算环境的高实用、高冗余版本。它采用了NDB Cluster 存储引擎,允许在1个Cluster中运行多个MySQL服务器。在MyQL 5.0及以上的二进制版本中、以及与最新的Linux版本兼容的RPM中提供了该存储引擎。 一、MySQL Cluster概述 MySQL Cluster 是一种技术,该技术允许在无共享的系统中部署“内存中”数据库的 Cluster 。通过无共享体系结构,系统能够使用廉价的硬件,而且对软硬件无特殊要求。此外,由于每个组件有自己的内存和磁盘,不存在单点故障。 MySQL Cluster 由一组计算机构成,每台计算机上均运行着多种进程,包括MySQL服务器,NDB Cluster 的数据节点,管理服务器,以及(可能)专门的数据访问程序。 所有的这些节点构成一个完成的MySQL集群体系。数据保存在“NDB存储服务器”的存储引擎中,表(结构)则保存在“MySQL服务器”中。应用程序通过“MySQL服务器”访问这些数据表,集群管理服务器通过管理工具(ndb_mgmd)来管理“NDB存储服务器”。 通过将MySQL Cluster 引入开放源码世界,MySQL为所有需要它的人员提供了具有高可用性、高性能和可缩放性的 Cluster 数据管理。 二、MySQL Cluster 基本概念 “NDB” 是一种“内存中”的存储引擎,它具有可用性高和数据一致性好的特点。 MySQL Cluster 能够使用多种故障切换和负载平衡选项配置NDB存储引擎,但在 Cluster 级别上的存储引擎上做这个最简单。MySQL Cluster的NDB存储引擎包含完整的数据集,仅取决于 Cluster本身内的其他数据。 目前,MySQL Cluster的 Cluster部分可独立于MySQL服务器进行配置。在MySQL Cluster中, Cluster的每个部分被视为1个节点。 管理(MGM)节点:这类节点的作用是管理MySQL Cluster内的其他节点,如提供配置数据、启动并停止节点、运行备份等。由于这类节点负责管理其他节点的配置,应在启动其他节点之前首先启动这类节点。MGM节点是用命令 “ndb_mgmd”启动的。 数据节点:这类节点用于保存 Cluster的数据。数据节点的数目与副本的数目相关,是片段的倍数。例如,对于两个副本,每个副本有两个片段,那么就

作者:杨鑫奇 前言 做大数据相关的后端开发工作一年多来,随着Hadoop社区的不断发展,也在不断尝试新的东西,本文 着重来讲解下Ambari,这个新的Apache的项目,旨在让大家能够方便快速的配置和部署Hadoop生态圈相关的组件的环境,并提供维护和监控的功能. 作为新手,我讲讲我自己的学习经历,刚刚开始学习的时候,当然最简单的 Google 下Hadoop ,然后下载相关的包,在自己的虚拟机(CentOS 6.3) 上安装一个单机的Hadoop版本用来做测试,写几个测试类,然后做下CRUD测试之类的,跑跑Map/Reduce的测试,当然这个时候对于Hadoop还不是很了解,不断的看别人的文章,了解下整体的架构,自己所做的就是修改conf下的几个配置文件,让Hadoop能够正常的跑起来,这个时候几种在修改配置上,这个阶段之后,又用到了HBase,这个Hadoop生态圈的另外一个产品,当然还是修改配置,然后 start-all.sh , start-hbase.sh 把服务起起来,然后就是修改自己的程序,做测试,随着用Hbase 学了下 Zookeeper 和Hive等, 接着过了这个操作阶段了之后,开始研究Hadoop2.0看了董的博客的相关文章,还有CSDN上很多大牛的文章了之后, 算是对Hadoop的生态圈整体有一些了解,介于自己在公司所承担的开发所涉及到相关的技术仅仅就这些.但是作为一个 爱好探索的人,是否想多了解下呢,它的性能怎么样? 它是具体如何运作的? 看大公司的那些PPT,人家(淘宝等大公司)动不动就是几十个,几百个,乃至几千个节点,人家是如何管理的,性能是怎么样的?看着PPT里面的那些性能测试的曲线,你是否也能够详细的了解,并且对自己的项目进行性能调优呢? 我貌似找到答案了,那就是 Ambari , 由HortonWorks开发的一个Hadoop相关的项目,具体可以上官方去了解. 了解Hadoop生态圈 现在我们经常看到的一些关键字有: HDFS,MapReduce,HBase,Hive,ZooKeeper,Pig,Sqoop,Oozie,Ganglia,Nagios,CDH3,CDH4,Flume,Scri be,Fluented,HttpFS等等,其实应该还有更多,Hadoop生态圈现在发展算是相当繁荣了,而在这些繁 荣的背后又是谁在推动的呢? 读过Hadoop历史的朋友可能知道,Hadoop最早是始于Yahoo,但是现在主要是由 HortonWorks 和 Cloudera 这2家公司在维护者,大部分的commiter 都属于这2家公司,所以现在市面上看到的主要有2个版本,CDH系列,和社区版, 我最早用的是社区版本,后来换到CDH3,现在又换回社区版,因为有Ambari.当然,用什么和不用什么,只要自己的技术到家,还是都能修改的跑的正常的.这里就不多说了. 讲了这么多废话了,开始讲 Ambari安装吧. 开始部署 首先了解下Ambari, 项目地址在:https://www.doczj.com/doc/7911418088.html,/ambari/

在PCSERVER上安装MARIADB。 一、先检查主机的环境 如果主机已经安装了MYSQL的早期版本,并且有MYSQL实例正在主机上运行,要先行清理早期的版本,具体步骤如下: 1、优雅地停掉当前正在运行的MYSQL服务。 2、卸载MYSQL早期版本及其组件 rpm -qa|grep -i mysql #查看已经安装的mysql相关包 rpm -ev package_name #package_name包名比如:mysql-server-5.0.51b-1.el5 二、用YUM安装MARIADB 具体步骤如下: 1、cd /etc/yum.repos.d 2、vi MariaDB.repo然后粘上官网上的内容(用CENTOS操作系统举例) Here is your custom MariaDB YUM repository entry for CentOS. Copy and paste it into a file under /etc/yum.repos.d/ (we suggest naming the file MariaDB.repo or something similar). See "Installing MariaDB with yum" for detailed information. 3、执行yum -y install MariaDB-client MariaDB-server MariaDB-devel 4、如果发现用YUM装时,代理服务器的网速下载太慢了导致超时然后报错退出,解决方案如下: A自己用个人电脑到官网下载列表中的RPM文件,

组建MySQL集群的几种方案 LVS+Keepalived+MySQL(有脑裂问题?但似乎很多人推荐这个) DRBD+Heartbeat+MySQL(有一台机器空余?Heartbeat切换时间较长?有脑裂问题?) MySQL Proxy(不够成熟与稳定?使用了Lua?是不是用了他做分表则可以不用更改客户端逻辑?) MySQL Cluster (社区版不支持INNODB引擎?商用案例不足?稳定性欠佳?或者还有其他问题?又或者听说现在发展不错?) MySQL + MHA (如果配上异步复制,似乎是不错的选择,又和问题?) MySQL + MMM (似乎反映有很多问题,未实践过,谁能给个说法) 淘宝的Cola(似乎现在停止开发了?)?变形虫Amoeba(事务支持?) 或者,其他方案? 回答1: 不管哪种方案都是有其场景限制或说规模限制,以及优缺点的。 1. 首先反对大家做读写分离,关于这方面的原因解释太多次数(增加技术复杂度、可能导致读到落后的数据等),只说一点:99.8%的业务场景没有必要做读写分离,只要做好数据库设计优化和配置合适正确的主机即可。 2.Keepalived+MySQL --确实有脑裂的问题,还无法做到准确判断mysqld是否HANG 的情况; 3.DRBD+Heartbeat+MySQL --同样有脑裂的问题,还无法做到准确判断mysqld是否HANG的情况,且DRDB是不需要的,增加反而会出问题; 3.MySQL Proxy -- 不错的项目,可惜官方半途夭折了,不建议用,无法高可用,是一个写分离; 4.MySQL Cluster -- 社区版本不支持NDB是错误的言论,商用案例确实不多,主要是跟其业务场景要求有关系、这几年发展有点乱不过现在已经上正规了、对网络要求高; 5.MySQL + MHA -- 可以解决脑裂的问题,需要的IP多,小集群是可以的,但是管理大的就麻烦,其次MySQL + MMM 的话且坑很多,有MHA就没必要采用MMM 建议: 1.若是双主复制的模式,不用做数据拆分,那么就可以选择MHA或Keepalive 或heartbeat

大数据集群平台介绍 掌握搭建大数据集群的方法是学习大数据技术的人需要具备的基础技能,因此我会通过接下来的三十余篇文章介绍大数据平台的搭建方法。在本文中我将向小伙伴们介绍一下搭建大数据集群需要哪些知识以及我们接下来搭建的大数据集群平台架构,让大家对平台有个总体的认识并普及一些概念。 首先我们接触的是虚拟机,及在虚拟机中安装Linux操作系统

集群搭建完成后我们总共会有四个虚拟机,其中伪分布集群有一台虚拟机,虚拟机名称为single_node。分布式集群有三个虚拟机名称分别为master、slave1、slave2。各个虚拟机的IP配置及安装软件(含软件运行的模块)如下表所示。 注:hostname:每个节点的主机名称 IP:每个节点的IP地址 NN:NameNode DN:DataNode NM:NodeManager RM:ResourceManager SNN:SecondaryNameNode / :表示不安装 分布式集群的架构如下图所示

slave1 192.168.***.12 slave2 192.168.***.13 Master 192.168.***.11 1、硬件 节点:我们后面会经常提到节点,分布式环境中一个服务器就是一个节点,在我们搭建的集群中服务器指的是通过VMware软件虚拟出来的虚拟机。 操作系统:服务器上运行的操作系统基本上都是Linux操作系统,当然虚拟机中安装的也是Linux系统。 网络:集群中的多个节点之间协同工作需要不断交换数据及状态、命令等信息,因此需要互通的网络环境。我们的集群是通过虚拟机软件虚拟出来的,网络也是由虚拟机软件虚拟出的虚拟网卡来实现数据交换的。 2、软件 集群中的软件主要有hadoop、spark、hive、hbase、zookeeper这几个。Hadoop 虽然大数据集群平台根据具体业务需求不同配置组成不同,但大部分集群都会以hadoop集群为基础。例如大数据仓库Hive及分布式数据库Hbase的存储都会用到hadoop 集群的分布式文件系统HDFS,计算部分默认使用Hadoop原生的MapReduce计算框架。分布式计算框架spark可以使用hadoop内置的通用资源管理模块yarn来提供统一的资源管理和调度。

通过KeepAlived搭建MySQL双主模式的高可用集群系统 一、整体架构 企业级mysql集群具备高可用、可扩展、易管理、低成本的特点。下面将介绍企业环境中经常应用的一个解决方案,即MySQL的双主互备架构,主要设计思路是通过MySQL Replication技术将两台MySQL Server互相将对方作为自己的Master,自己又同时作为对方的Slave来进行复制。这样就实现了高可用构架中的数据同步功能,同时,将采用KeepAlived 来实现Mysql的自动failover。在这个构架中,虽然两台MySQL Server互为主从,但同一时刻只有一个MySQL Server可读写,另一个MySQL Server只能进行读操作,这样可保证数据的一致性。整个架构下图所示。 二、MySQL主主互备模式配置环境 第一步要做的工作是在这两天机器上都安装mysql,在做主从复制的时候mysql的版本尽量保持一致。即使不一样一定要以主服务的版本为最高的版本,从服务器的版本不能高于主服务器的版本。 1、Mysql的安装与配置 Mysql5.6版本之后,编译mysql方式变为cmake 安装cmake: #yum install cmake #cd mysql-5.6.17

#cmake \ -DCMAKE_INSTALL_PREFIX=/usr/local/mysql \ -DMYSQL_DATADIR=/usr/local/mysql/data \ -DSYSCONFDIR=/etc \ -DWITH_MYISAM_STORAGE_ENGINE=1 \ -DWITH_INNOBASE_STORAGE_ENGINE=1 \ -DWITH_MEMORY_STORAGE_ENGINE=1 \ -DWITH_READLINE=1 \ -DMYSQL_UNIX_ADDR=/var/lib/mysql/mysql.sock \ -DMYSQL_TCP_PORT=3306 \ -DENABLED_LOCAL_INFILE=1 \ -DWITH_PARTITION_STORAGE_ENGINE=1 \ -DEXTRA_CHARSETS=all \ -DDEFAULT_CHARSET=utf8 \ -DDEFAULT_COLLATION=utf8_general_ci make && make install 如果没有就创建用户就创建如下用户: #groupadd mysql #useradd -g mysql mysql 修改/usr/local/mysql权限: #chown -R mysql:mysql /usr/local/mysql #cd /usr/local/mysql 进入安装路径,执行初始化配置脚本,创建系统自带的数据库和表: #scripts/mysql_install_db--basedir=/usr/local/mysql--datadir=/usr/local/mysql/data --user=mysql 2、启动MySQL 添加服务,拷贝服务脚本到init.d目录,并设置开机启动 #cd /usr/local/mysql #cp support-files/mysql.server /etc/init.d/mysql #chkconfig mysql on #service mysql start--启动MySQL

1、下载完成MariaDB-Galera-server galera MariaDB-client安装包 配置yum源 vim /etc/yum.repos.d/mariadb.repo [mariadb] name = MariaDB enable=1 priority=3 baseurl = https://www.doczj.com/doc/7911418088.html,/5.5.33a/centos6-amd64/ gpgkey=https://https://www.doczj.com/doc/7911418088.html,/RPM-GPG-KEY-MariaDB gpgcheck=1 安装yum -y install MariaDB-Galera-server galera MariaDB-client 2、编辑每台机器的hosts文件,添加如下内容 [root@client137 ~]# vim /etc/hosts 2.192.168.1.137 https://www.doczj.com/doc/7911418088.html, client137 3.192.168.1.138 https://www.doczj.com/doc/7911418088.html, client138 4.192.168.1.139 https://www.doczj.com/doc/7911418088.html, client139 # 启动测试一下 6.[root@client137 ~]# /etc/init.d/mysql start 7.Starting MySQL.... SUCCESS! 8.[root@client137 ~]# chkconfig mysql on 设置MariaDB的root密码,并做安全加固 01.[root@client137 ~]# /usr/bin/mysql_secure_installation 02.[root@client137 ~]# /usr/bin/mysql_secure_installation 03.# 登陆数据库,授权用于集群同步的用户和密码 04.[root@client137 ~]# mysql -uroot -pkongzhong 05.mysql> GRANT USAGE ON *.* to sst@'%' IDENTIFIED BY 'sstpass123'; 06.mysql> GRANT ALL PRIVILEGES on *.* to sst@'%'; 07.mysql> FLUSH PRIVILEGES; 08.mysql> quit 09.# 创建并配置https://www.doczj.com/doc/7911418088.html,f文件 10.[root@client137 ~]# cp /usr/share/mysql/https://www.doczj.com/doc/7911418088.html,f /etc/https://www.doczj.com/doc/7911418088.html,f.d/ 11.[root@client137 ~]# vim /etc/https://www.doczj.com/doc/7911418088.html,f.d/https://www.doczj.com/doc/7911418088.html,f 12.# 只需要修改如下4行:

大数据平台-kerberos安装部署文档

————————————————————————————————作者: ————————————————————————————————日期: ?

1.环境准备 1.1.操作系统 本次安装部署要求在操作系统为CentOS release 6.5(Final)的版本下进行部署,所以在安装部署kerberos之前请先确保操作系统为以上版本,并且集群 中各机器已做时钟同步。 本次安装部署以csdm-hadoop-04作为主kdc服务器,以csdm-hadoop-05作为从kdc服务器,以csdm-hadoop-03作为客户端。一般不建议在服务器上再 安装其他应用程序,比如hadoop。但为了节省资源本次安装在这三台机器均已安 装hadoop相关软件。 1.2.创建操作用户 创建操作系统hdfs、yarn、mapred用户,并使其归属于hadoop用户组: adduserhdfs -gHadoop adduseryarn -g Hadoop adduser mapred-gHadoop 1.3.配置hosts文件 为各台机器修改/etc/hosts文件,将真实ip与主机名对应配置,服务端与 客户端均需配置,形如:(不能存在127.0.0.1的配置,否则hadoop进行k erberos验证时将会出错) 1.4.关闭防火墙 执行以下命令关闭防火墙: service iptables stop 出现以下界面表示关闭成功 1.5.注册服务与端口的对应 在/etc/service文件最后增加以下信息,以便后续使用: ?krb5_prop754/tcp # Kerberos slave propagation 2.安装配置Kerberos 2.1.安装rpm包 ?以root用户登录并创建目录存放安装包: mkdir /var/kerberos

Galera Cluster for MySQL集群搭建 要架设Galera Cluster Server,有两种套件选择,一个 是Percona XtraDB Cluster另一个是MariaDB Galera Cluster,这次介绍后者的安装。 Galera Cluster 介绍 为什么要选择Galera Cluster Server,它有什么优点及功能呢?MySQL/Galera 是一套可以同步多台MySQL/InnoDB 机器的丛集系统,底下可以列出功能。 同步复制资料 可读取和写入丛集系统内任一节点 自动侦测节点错误,如果有节点当机,则丛集系统自动移除该节 点 可任意扩充节点 采用row level 方式来平行复制资料 从上面功能看来,我们可以平行任意扩充节点,动态增加服务器到丛集系统,要做到上面功能,就是利用Galera library来做到同步资料处

理,同步的详细细节,可以参考Galera library连结。这边就不再多描 述了。 Galera Cluster的部署 安装Galera Cluster Server 本篇介绍的MySQL Server是使用MariaDB套件,而不是安装原始 的MySQL。CentOS和Ubuntu安装方式雷同,前者是用yum后者则是aptitude,在安装前请先下载对应的repository配置文件 [https://https://www.doczj.com/doc/7911418088.html,/mariadb/repositories/#mirror=qiming] CentOS $ yum -y update; yum -y upgrade $ yum –y install MariaDB-Galera-server MariaDB-client galera Ubuntu $ aptitude -y update $ aptitude -y install mariadb-galera-server-5.5 galera 或者apt-get: $ apt-get -y update $ apt-get -y install mariadb-galera-server-5.5 galera 启动MySQL $/etc/init.d/mysql start 设置Galera Cluster Server 先讲一下环境,目前总共两台Galera Server,IP 分别是:

《大数据技术原理与应用》实验报告一 题目:安装Hadoop 姓名:高聪江班级:大数据1533 学号:2015005677 日期:2017.11.01 实验环境: 笔记本电脑一台 Archlinux虚拟机3台 Hadoop 2-7-10 Java 1-8-0 实验内容与完成情况: 下载相关软件已完成 安装虚拟机已完成 配置环境变量已完成 安装Hadoop 已完成 出现的问题: 01 虚拟机运行软件选择 02 虚拟机选择 03 虚拟机的分盘出现问题 04 虚拟机命令不被识别 05 Hadoop版本选择 06 Hadoop无法正常启动 07 结束安装后活节点数是0 解决方案(列出遇到的问题和解决办法,列出没有解决的问题): 01 虚拟机运行软件选择使用了VirtualBox 02 虚拟机选择使用了Archlinux 03 虚拟机的分盘出现问题再分了一次,成功解决 04 虚拟机命令不被识别系统的环境变量出现问题,修改配置文件解决 05 Hadoop版本选择选择了2-7-10这一比较广泛的版本Hadoop 06 Hadoop无法正常启动由于格式化节点的时候没有先把生成文件都删除 07 结束安装后活节点数是0 这个问题原因一直没有找到,重装解决的 报告正文 1.实验内容与步骤 本实验主要内容和步骤如下: 1.1.实验内容

Hadoop集群搭建(由于伪分布比较简单,所以实验报告描述集群搭建),WorldCount实例测试。 1.2.实验步骤 1>下载相关软件。主要是Java,VirtualBox,Hadoop安装包,虚拟机的镜像 文件。 2>安装ArchLinux虚拟机(由于此发行版本比较洁净,系统体积小,运 行比较流畅) 安装结果如图: 3>进行Hadoop集群安装 >>启用网络并安装SSH和JDK >>配置SSH免密登录

大数据环境搭建 1、CentOS 6.5 2、JDK 1.8 3、Hadoop 2.6 4、Hive 1.1.0 5、ZooKeeper-3.4.9 6、kafka_2.11- 7、Spark 2.1.1 8、flume-ng-1.6.0 CentOS 6.5防火墙和DNS配置 1、关闭防火墙 2、配置yum JDK 1.7安装 1、将jdk-8u131-linux- 2、安装JDK:把压缩包放到/usr/java/目录下

3、配置jdk相关的环境变量 5、rm -f /etc/udev/rules.d/70-persistent-net.rules 安装第二台和第三台服务器 1、安装上述步骤,再安装两台一模一样环境的服务器,因为后面hadoop和spark都是要搭建集群的。 2、集群的最小环境就是三台。因为后面要搭建ZooKeeper、kafka等集群。 3、另外两台机器的hostname分别设置为spark2和spark3即可,ip分别为 4、在安装的时候,另外两台服务器的centos镜像文件必须重新拷贝一份,放在新的目录里,使用各自自己的镜像文件。 5、服务器的硬盘文件也必须重新选择一个新的目录,以更好的区分。 6、安装好之后,记得要在三台机器的/etc/hosts文件中,配置全三台机器的ip地址到hostname 的映射,而不能只配置本机,这个很重要! 7、在windows的hosts文件中也要配置全三台机器的ip地址到hostname的映射。 配置集群ssh免密码登录 1、首先在三台机器上配置对本机的ssh免密码登录

生成本机的公钥,过程中不断敲回车即可,ssh-keygen命令默认会将公钥放在/root/.ssh目录下 ssh-keygen -t rsa 将公钥复制为authorized_keys文件,此时使用ssh连接本机就不需要输入密码了 cd /root/.ssh cp id_rsa.pub authorized_keys 2、接着配置三台机器互相之间的ssh免密码登录 使用ssh-copy-id -i spark命令将本机的公钥拷贝到指定机器的authorized_keys文件中(方便好用) Hadoop 安装hadoop包 1、使用hadoop-,使用W in SCP上传到CentOS的/usr/local目录下。 2、将hadoop包进行解压缩:tar -zxvf hadoop- 3、对hadoop目录进行重命名:mv hadoop-2.4.1 hadoop 4、配置hadoop相关环境变量

MYSQL双机热备+LVS负载均衡集群实现 四台服务器均采用Asianux-3sp3 Linux操作系统!~ 1.MYSQL双机热备配置(主主模式) (1)配置mysql01服务器IP地址为172.16.1.101 (2)配置mysql02服务器IP地址为172.16.1.102 (3)在两台mysql服务器上安装MYSQL服务. (4)使用service mysqld start 启动mysql服务 (5)使用mysqladmin –u 账号password 密码来创建管理账号 (6)使用mysql –u 账号–p 回车输入密码登入MySQL

(7)在mysql>状态下使用grant all on *.* to 账号@对端mysql2服务器的ip地址identified by ‘密码’;创建双机热备所使用的mysql账号 (8)使用exit命令退出mysql (9)使用命令vi /etc/https://www.doczj.com/doc/7911418088.html,f 编辑/etc/https://www.doczj.com/doc/7911418088.html,f 在文件最上方添加如下信息: server-id=1 mysql的id 两台mysql服务器一个为1一个为2 log-bin=mysqlback 指定日志的名字 master-host=172.16.1.102 对端mysql的ip地址 master-user=hnspi 对端mysql设置的用于同步的账号,见(6) master-password 对端账号的密码 master-port=3306 指定数据库使用的端口号 保存退出 (10)使用命令service mysqld restart重启mysql服务 (11)使用mysql –u 管理账号–p 回车输入密码登入mysql (12)Mysql>状态下输入slave start ;启动slave(同步数据库)功能