《语音识别入门教程》

- 格式:pdf

- 大小:277.49 KB

- 文档页数:10

语音识别怎么操作?其实很简单,看完你就会了

在一些会议或者是讲座中如果我们来不及用笔做记录时,就会选择用录音的方式来进行记录,那么后期如果我们需要将这些语音文件识别成文字,都能用哪些方法呢。

操作步骤:

第一步:在手机浏览器或应用市场中寻找【录音转文字助手】,接着就可以看见【录音识别】、【文件识别】和【录音机】三大功能。

第二步:【录音识别】是边录音边转换成文字,【文件识别】则是上传音频文件进行识别,【录音机】仅支持录音,如果需要转文字和翻译,可以录音结束后在文件库中进行,小编这里就举例说明下【录音识别】。

第三步:点击【录音识别】进入录音的界面,点击下方蓝色按钮就可以开始说出你想要录制的话,接着你刚说的话就会变成文字显示出来了。

第四步:这里还可以做翻译,点击翻译按钮,等一小会儿就可以把刚识别出来的文字翻译成英文。

第五步:还可以点击【复制】在弹出的对话框中选择好需要复制的选项,就可以将识别的内容粘贴到你需要的地方。

第五步:如果你还想把识别的内容分享给你的好友,可以点击【导出】,选择好你需要需要导出的选项,然后分享给你的好友就可以了。

第六步:保存到本地;点击右上角的【保存】按钮,在弹出的对话框中点击【确定】就保存好了,点击下面【文件库】选项,就可以看到刚保存的文件了。

以上就是语音识别的具体步骤了,将语音转换为文字内容,你学会了没有呢?。

第四章 基于模式匹配方式的语音识别技术4.1 语音的端点检测4.1.1 语音端点检测的困难性语音端点检测是指从包含语音的一段信号中确定出该语音的起始点及终止点。

有效的端点检测不仅能减少语音识别的处理时间(减少处理帧数),而且还能排除静息语音段背景噪声的干扰,从而保证了处理质量。

然而,端点检测的困难在于静息语音段背景噪声或发声前后人为的呼吸等原因所产生的杂音,它使得语音的端点比较模糊。

当端点处是弱摩擦音或弱爆破音,以及终点处是鼻音或振幅较小的有声语音时,端点检测将成为困难。

下面,介绍一种综合利用短时平均能量和过零数来进行语音端点检测的方法。

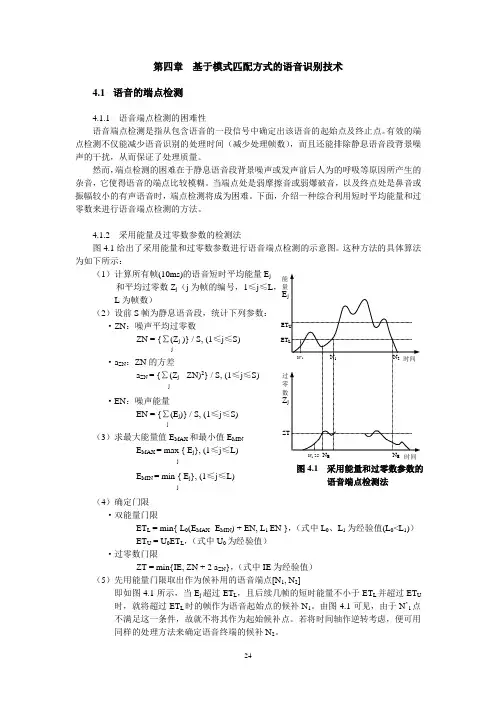

4.1.2 采用能量及过零数参数的检测法图4.1给出了采用能量和过零数参数进行语音端点检测的示意图。

这种方法的具体算法为如下所示:(1)计算所有帧(10ms)的语音短时平均能量E j 和平均过零数Z j (j 为帧的编号,1≤j ≤L , L 为帧数)(2)设前S 帧为静息语音段,统计下列参数:·ZN :噪声平均过零数ZN = {∑(Z j )} / S, (1≤j ≤S)j·a ZN :ZN 的方差a ZN = {∑(Z j - ZN)2} / S, (1≤j ≤S)j·EN :噪声能量EN = {∑(E j )} / S, (1≤j ≤S) j(3)求最大能量值E MAX 和最小值E MIN E MAX = max { E j }, (1≤j ≤L) jE MIN = min { E j }, (1≤j ≤L)j(4)确定门限 ·双能量门限ET L = min{ L 0(E MAX -E MIN ) + EN, L 1 EN },(式中L 0、L 1为经验值(L 0<L 1)) ET U = U 0ET L ,(式中U 0为经验值) ·过零数门限ZT = min{IE, ZN + 2 a ZN },(式中IE 为经验值) (5)先用能量门限取出作为候补用的语音端点[N 1, N 2]即如图4.1所示,当E j 超过ET L ,且后续几帧的短时能量不小于ET L 并超过ET U 时,就将超过ET L 时的帧作为语音起始点的候补N 1。

语音识别技术的使用教程与应用案例随着科技的不断发展,语音识别技术越来越受到关注。

它可以将人类的语音转化为文本或者命令,为我们的生活带来了便利。

本文将为您介绍语音识别技术的使用教程,并通过一些实际的应用案例来说明其在各个领域的应用。

一、语音识别技术的使用教程1. 软件介绍语音识别技术的应用软件有很多,其中最知名的一款是谷歌的语音识别引擎。

该引擎可以免费使用,且支持多种语言的语音识别。

另外,还有一些商业化的语音识别软件,如苹果的Siri、微软的Cortana等。

2. 安装与设置安装谷歌语音识别引擎需要前往谷歌开发者平台,进行账号注册并生成API密钥。

获取API密钥后,在终端中设置环境变量,并下载相关的Python库。

然后,您就可以使用该引擎进行语音识别的编程操作了。

3. 语音录制与识别录制语音可以使用智能手机、电脑内置的麦克风等设备。

录制的语音需要清晰、流畅,以便提高识别准确率。

在录制结束后,将录制的语音发送到语音识别软件中进行识别,就可以得到识别结果。

4. 语音识别的优化要提高语音识别的准确率,可以改进语音输入的环境,降低噪音干扰;调整语音识别软件的参数,如增大识别模型的大小、提高识别阈值等;使用合适的语言模型,增加识别的准确性。

二、语音识别技术的应用案例1. 智能助理语音识别技术被广泛应用于智能助理系统中,如Siri、Cortana 等。

用户可以通过语音指令来操作手机或电脑,如拨打电话、发送短信、播放音乐等。

智能助理的出现使得用户的日常操作更加便捷。

2. 语音搜索随着移动互联网的普及,语音搜索逐渐成为一种主流的搜索方式。

用户可以通过语音输入搜索关键词,系统会将语音转化为文本并进行搜索。

通过语音搜索,用户无需手动输入文字,节省了大量时间和精力。

3. 语音翻译语音识别技术在语音翻译领域也有着广泛的应用。

用户可以通过语音输入一种语言,系统会将其转化为目标语言的文本或语音。

语音翻译可以帮助人们更加便利地进行跨语言交流,对于国际间的商务沟通和旅行,有着重要意义。

语音识别技术的使用教程和技巧语音识别技术一直以来都是人工智能领域的热门研究方向之一。

它的应用十分广泛,能够帮助人们提高工作效率、改善生活质量。

本文将为大家介绍语音识别技术的基础知识、使用教程以及一些常用技巧,希望能够帮助大家更好地利用语音识别技术。

一、语音识别技术的基础知识1. 什么是语音识别技术?语音识别技术是指通过计算机对语音信号进行处理和分析,将其转化为文字或者其他形式的信息。

它利用机器学习、模式识别等技术,通过对人声信号进行特征提取和模式匹配,从而实现对语音内容的识别和理解。

2. 语音识别技术的应用领域语音识别技术在很多领域都有应用。

例如,语音助手(如Siri、小爱同学等)可以通过语音指令实现文字输入、打电话、寻找信息等功能;语音识别技术还可以应用于语音转写、语音翻译、语音控制等领域。

二、语音识别技术的使用教程1. 使用语音助手(1)打开语音助手:通常,语音助手可以通过唤醒词或者按键来启动,根据不同的设备和系统设置,具体操作方式可能会有所不同。

(2)进行语音指令:启动语音助手后,可以直接通过语音进行指令。

例如,可以说“打电话给XXX”来进行拨号;说“播放音乐”来播放音乐等。

2. 使用语音转写工具(1)选择语音转写工具:根据需要,选择一款适合的语音转写工具。

常见的语音转写工具有讯飞输入法、微软小冰等。

(2)录制语音:打开语音转写工具后,点击录音按钮进行录制。

注意,录制时要尽量保持清晰,避免噪音干扰。

(3)获取转写结果:录制完成后,语音转写工具会将录制的语音转化为文字,并显示在界面上。

可以复制、编辑、保存转写结果,以满足不同的需求。

3. 使用语音控制(1)选择支持语音控制的设备:语音控制通常需要设备具备麦克风和语音处理功能,如智能音箱、智能手机等。

(2)开启语音控制:根据设备系统的设置,开启语音控制功能。

常见的方式是通过短按或长按指定的按键,或者使用唤醒词激活功能。

(3)进行语音控制:启动语音控制后,可以通过语音进行设备控制。

语音识别系统的使用方法语音识别系统是一种可以将人的语音信息转化为文字信息的技术,它能够帮助人们在日常生活和工作中更加便捷地进行沟通和交流。

目前,语音识别系统已经被广泛应用于智能手机、智能音箱、语音助手等产品中,成为人们生活中不可或缺的一部分。

在本文中,将介绍语音识别系统的使用方法,以及一些注意事项和技巧。

一、如何使用语音识别系统1. 打开语音识别功能大多数智能设备都内置了语音识别功能,用户可以通过简单的操作打开这一功能。

在智能手机上,通常可以在键盘上找到语音输入的图标,点击即可进入语音识别模式。

而在智能音箱和语音助手中,用户可以直接唤醒设备,然后说出自己的指令或问题。

2. 语音输入一旦进入语音识别模式,用户可以开始说话。

在说话的过程中,尽量保持清晰、流畅的语速,避免突然停顿或者口齿不清。

此外,也要注意说话的音量和音调,尽量使自己的语音信息更加易于识别。

3. 识别结果语音识别系统会将用户的语音信息转化为文字信息,并显示在屏幕上。

用户可以在屏幕上阅读并确认识别结果,如果有错误的地方可以进行修正。

此外,一些语音识别系统也支持语音播放回复,用户可以直接听到识别结果。

二、如何提高语音识别的准确性1. 在安静的环境中使用语音识别系统对环境的噪音比较敏感,所以在使用时最好选择安静的环境。

避免在嘈杂的场所使用语音识别系统,以免影响识别的准确性。

2. 说话时保持清晰清晰的发音是提高语音识别准确性的关键。

在使用语音识别系统时,用户应该尽量保持清晰、流畅的语音,避免口齿不清或者模糊不清的发音。

3. 使用标点符号和语气词在使用语音识别系统时,用户可以适当添加标点符号和语气词,以便更加清晰地表达自己的意思。

这样不仅可以提高识别的准确性,还能让识别结果更加符合自己的语气和表达方式。

三、语音识别系统的应用场景1. 办公场景在办公场景中,语音识别系统可以帮助用户更加快捷地进行文字输入,节省时间和提高工作效率。

用户可以通过语音输入大段的文字内容,避免繁琐的打字过程。

AI语音识别技术的使用教程随着人工智能技术的快速发展,AI语音识别技术逐渐成为人们生活和工作中不可或缺的一部分。

它使用人工智能算法和模型,将人类的声音转化为可识别和理解的文本,为用户提供了更加便捷和高效的交互体验。

本文将为大家介绍AI语音识别技术的使用教程,帮助读者了解如何利用这一技术提升工作和生活效率。

一、选择合适的AI语音识别工具首先,我们需要选择适合我们需求的AI语音识别工具。

当前市场上有多种成熟的AI语音识别工具可供选择,例如百度语音识别、科大讯飞语音识别、阿里云语音识别等。

我们可以根据自己的需求和预算选择合适的工具。

二、获取API密钥在开始使用AI语音识别技术之前,我们需要先获取相应的API密钥。

不同的语音识别工具提供了不同的API接口,我们需要根据选择的工具进行相应的申请。

一般情况下,我们需要注册一个开发者账号,并通过开发者后台获取到API密钥。

三、搭建开发环境在获得API密钥后,我们需要搭建相应的开发环境。

根据选择的语音识别工具,我们需要下载和安装相应的语音识别SDK或者API库。

一般来说,这些工具提供了详细的文档和示例代码,可以帮助我们快速入门。

四、语音识别示例代码接下来,我们可以尝试运行一些语音识别的示例代码,以了解基本的使用方法和功能。

首先,我们需要将语音文件转换为适合识别的格式。

通常,语音识别工具支持多种音频格式,如wav、mp3等。

我们可以使用音频编辑软件或者相应的命令行工具将音频文件转换为支持的格式。

然后,我们可以使用SDK或者API提供的接口上传音频文件并获取识别结果。

五、调试和优化完成基本的语音识别功能后,我们可以对识别结果进行调试和优化。

有时候,语音识别可能会对一些特定的语音或口音识别出现偏差。

我们可以通过调整识别模型的参数或者使用一些特定的配置文件来优化识别效果。

此外,一些语音识别工具还提供了自定义的语音模型训练接口,可以根据自己的需求训练自己的语音模型,提高识别准确率。

语音识别技术教程随着科技的不断发展,语音识别技术已经逐渐走入我们的生活,为我们的工作和生活带来了便利。

语音识别技术是指将人的语音信息转化为相应的文字或命令的过程,它的应用广泛涉及语音输入、人机交互、智能助理等各个领域。

本文将从语音识别技术的基本原理、应用场景以及未来发展进行介绍和探讨。

一、基本原理语音识别技术的基本原理是通过分析声音信号的频率、时长等特征来确定所表达的意思。

整个过程包含音频采集、特征提取、模型训练、解码等步骤。

首先,音频信号被麦克风采集并转换为数字信号;接着,对音频信号进行特征提取,常用的方法有梅尔频率倒谱系数(MFCC)等;然后,使用训练集对模型进行训练,让它能够识别不同的语音特征;最后,通过解码算法将语音信号转化为文字或命令。

二、应用场景1. 语音助手语音助手是语音识别技术的一项重要应用。

例如,苹果的Siri、亚马逊的Alexa、微软的Cortana等智能助手都能通过语音输入与人进行交流。

用户可以通过语音指令,让语音助手为自己提供天气信息、播放音乐、查找资料等各种服务。

2. 语音输入语音输入是语音识别技术的另一个常见应用场景。

人们可以用语音替代键盘进行文字输入,提高工作效率和便利程度。

例如,在移动设备上,人们可以通过语音输入进行消息发送、邮件撰写等操作。

同时,在智能家居设备中,语音指令也可以控制家电的开关和调节。

3. 语音翻译语音翻译是语音识别技术在跨语言交流中的应用。

利用语音翻译技术,人们可以将一种语言转化为另一种语言,实现实时的口语翻译。

这对于旅行者、商务人士等经常需要跨语言交流的人来说非常方便。

三、未来展望随着人工智能的发展,语音识别技术将有更广阔的应用前景。

首先,技术的精确度和稳定性将得到进一步提升,用户的语音指令可以更加准确地被识别和理解。

其次,与其他技术结合,语音识别技术将进一步拓展应用场景。

例如,结合自然语言处理技术,可以实现更智能化的对话交互;结合虚拟现实技术,可以实现更沉浸式的语音交互体验。

智能语音识别技术的使用教程引言:随着科技的飞速发展,智能语音识别技术的应用越来越广泛。

无论是智能助手、智能家居,还是语音翻译、语音搜索,智能语音识别技术都扮演着重要的角色。

本文将为大家介绍智能语音识别技术的基本原理以及如何使用智能语音识别技术。

一、智能语音识别技术的原理智能语音识别技术是通过分析人类语音信号,并将其转化为可识别的文本或命令。

它基于机器学习和深度学习的算法,不断优化其识别准确率。

其基本原理包括三个步骤:语音信号的采集、特征提取和模型训练。

1. 语音信号的采集语音信号的采集是智能语音识别的第一步。

通常采用专用的麦克风或智能设备的内置麦克风来收集语音信号。

在采集过程中,需要注意噪声干扰的排除,以确保信号的质量。

2. 特征提取特征提取是智能语音识别的核心步骤。

它将语音信号转化为机器可识别的形式。

常用的特征提取算法包括傅里叶变换、梅尔倒谱系数(MFCC)等。

这些算法可以提取语音的频谱特征,用于后续的模型训练和识别。

3. 模型训练模型训练是智能语音识别的最后一步。

通过使用大量的语音数据和相应的文本或命令,训练出一个准确可靠的识别模型。

训练过程中,模型会自动学习语音信号和文本的对应关系,从而提高识别准确率。

目前,主要采用的技术包括深度神经网络(DNN)和长短时记忆网络(LSTM)等。

二、智能语音识别技术的应用智能语音识别技术在各行各业都有广泛的应用。

以下是几个常见的应用领域:1. 智能助手智能助手是最常见的应用之一。

比如智能手机中的Siri,智能音箱中的小爱同学,它们能够通过识别语音指令,为用户提供各种服务,比如播放音乐、查天气、发送短信等。

2. 智能家居智能家居也是智能语音识别技术的重要应用之一。

通过语音指令,可以实现家居设备的远程控制,比如智能灯光、智能窗帘、智能家电等。

3. 语音翻译语音翻译是智能语音识别技术的重要应用之一。

通过识别语音指令,并将其转化为文本或命令,进而对其进行翻译。

这在旅行、商务交流等场景中非常有用。

语音识别与语音合成基础入门语音识别和语音合成是人工智能领域中非常重要的技术分支,其在语音识别、智能音箱、语音助手等方面都有广泛应用。

本篇文章将介绍语音识别和语音合成的基础知识。

一、语音识别语音识别是将语音信号转化成文字的过程。

它通过分析语音信号的频谱特征和语音模型,来推测语音内容。

语音识别技术经过多年的发展,已经取得了很大的进步。

1.1 语音信号的特征提取在进行语音识别之前,需要先对语音信号进行特征提取。

常用的特征提取方法有MFCC(Mel频率倒谱系数),MFCC通过对语音信号进行傅里叶变换,提取出其频谱特征。

1.2 语音模型的训练语音识别依赖于语音模型的训练。

语音模型通常使用隐马尔可夫模型(HMM)或者循环神经网络(RNN)进行建模。

在训练语音模型时,需要使用大量的语音数据进行训练,并进行模型参数的优化。

1.3 语音识别的应用语音识别在日常生活中有很广泛的应用,例如语音输入、语音搜索、语音翻译等。

同时,语音识别也被应用于智能音箱、语音助手等智能设备中,为用户提供便捷的交互方式。

二、语音合成语音合成是将文字转化成语音的过程,通过模拟人类的语音输出,生成自然流畅的语音。

语音合成技术经过多年的发展,已经逐渐接近人类语音表达的水平。

2.1 文本预处理在进行语音合成之前,需要对待合成的文本进行预处理。

预处理包括对文本的切分、标点符号的处理等。

同时,为了提高语音合成的效果,还可以对文本进行情感分析,使合成的语音更加生动。

2.2 参数生成语音合成需要根据文本生成对应的语音参数。

常用的参数生成方法有基频分析、声学模型等。

通过调节参数的值,可以对合成语音的音色、音调等进行控制。

2.3 语音合成引擎语音合成引擎是实现语音合成的核心组件。

目前市场上有多种语音合成引擎可供选择,例如百度的度秘、Google的Text-to-Speech等。

这些引擎采用不同的算法和方法,可以实现高质量的语音合成。

2.4 语音合成的应用语音合成在多个领域都有广泛的应用,例如智能客服、有声读物、导航系统等。

使用AI技术进行语音识别的步骤指南一、介绍语音识别是一项基于人工智能技术的重要应用,它可以将口述的语音转化为文字形式。

随着人工智能技术的快速发展,语音识别在日常生活和商业领域发挥着越来越重要的作用。

本文将为您介绍使用AI技术进行语音识别的步骤指南。

二、准备工作在进行语音识别之前,我们需要准备以下材料和设备:1. 音频输入设备:如麦克风、手机录音、数字记录仪等。

2. 电脑或其他相应设备:用于运行语音识别软件。

3. 语音识别软件:市面上有许多开源和商业化的语音识别软件可供选择。

根据需求选择合适的软件,并确保其支持AI技术。

三、选择合适的AI技术1. 主流模型:目前主流的语音识别模型包括基于深度学习的循环神经网络(RNN)和卷积神经网络(CNN),以及将两者结合起来的Transformer模型。

根据应用场景和需求评估不同模型的性能并选择最适合自己需求的模型。

2. 深度学习框架:常用的深度学习框架有TensorFlow、PyTorch等。

选择一个熟悉且功能强大的框架,以支持AI模型的训练和部署。

四、数据准备1. 数据采集:为了训练和验证语音识别模型,需要收集大量的音频数据。

可以通过多种途径进行数据采集,如录制自然语言对话、从互联网上获取开源的语音数据集等。

2. 数据清洗:对于采集到的音频数据,必须进行数据清洗以去除噪声、非语音信息等。

这可以通过一系列信号处理技术来实现,如降噪、滤波等。

保证训练数据的质量对后续模型的准确性起着至关重要的作用。

五、模型训练与优化1. 特征提取:在语音识别任务中,输入是时域上连续的声波信号。

为了将其转化为适合机器学习算法处理的特征表示形式,常常需要进行特征提取。

常用特征提取方法包括Mel频谱倒谱系数(MFCC)、梅尔滤波器组(Mel Filter Bank)等。

2. 模型设计与训练:根据选择的AI技术和框架,设计合适的模型架构,并使用准备好的数据进行训练。

可以采用端到端(End-to-End)方式进行训练,也可将语音识别任务划分为声学模型和语言模型两个子任务来解决。

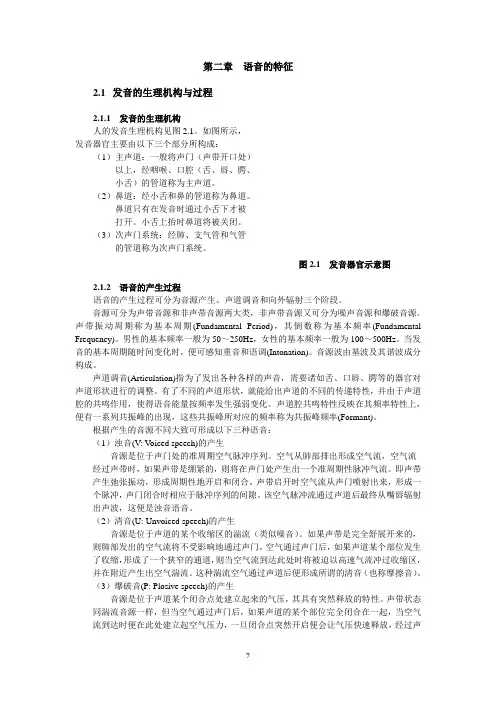

第二章语音的特征2.1发音的生理机构与过程2.1.1 发音的生理机构人的发音生理机构见图2.1。

如图所示,发音器官主要由以下三个部分所构成:(1)主声道:一般将声门(声带开口处)以上,经咽喉、口腔(舌、唇、腭、小舌)的管道称为主声道。

(2)鼻道:经小舌和鼻的管道称为鼻道。

鼻道只有在发音时通过小舌下才被打开。

小舌上抬时鼻道将被关闭。

(3)次声门系统:经肺、支气管和气管的管道称为次声门系统。

图2.1 发音器官示意图2.1.2 语音的产生过程语音的产生过程可分为音源产生、声道调音和向外辐射三个阶段。

音源可分为声带音源和非声带音源两大类,非声带音源又可分为噪声音源和爆破音源。

声带振动周期称为基本周期(Fundamental Period),其倒数称为基本频率(Fundamental Frequency)。

男性的基本频率一般为50~250Hz,女性的基本频率一般为100~500Hz。

当发音的基本周期随时间变化时,便可感知重音和语调(Intonation)。

音源波由基波及其谐波成分构成。

声道调音(Articulation)指为了发出各种各样的声音,需要诸如舌、口唇、腭等的器官对声道形状进行的调整。

有了不同的声道形状,就能给出声道的不同的传递特性,并由于声道腔的共鸣作用,使得语音能量按频率发生强弱变化。

声道腔共鸣特性反映在其频率特性上,便有一系列共振峰的出现,这些共振峰所对应的频率称为共振峰频率(Formant)。

根据产生的音源不同大致可形成以下三种语音:(1)浊音(V: V oiced speech)的产生音源是位于声门处的准周期空气脉冲序列。

空气从肺部排出形成空气流,空气流经过声带时,如果声带是绷紧的,则将在声门处产生出一个准周期性脉冲气流。

即声带产生弛张振动,形成周期性地开启和闭合。

声带启开时空气流从声门喷射出来,形成一个脉冲,声门闭合时相应于脉冲序列的间隙。

该空气脉冲流通过声道后最终从嘴唇辐射出声波,这便是浊音语音。

语音识别基础讲义吴亚栋上海交通大学计算机科学与工程系2000年1月目录第一章绪论 (1)1.1语音识别的重要性 (1)1.1.1语音信息处理与语音识别1.1.2语音识别的重要性1.2语音识别的定义、原理和分类 (2)1.2.1语音识别的定义1.2.2语音识别的基本原理1.2.3语音识别的分类1.3本课程的内容与要求 (4)1.4语音识别的历史回顾 (4)1.4.1 国外语音识别的历史1.4.2我国语音识别的历史第二章语音的特征 (7)2.1发音的生理机构与过程 (7)2.1.1发音的生理机构2.1.2语音的产生过程2.1.3语音分类2.2语音的基本特性 (8)2.2.1语音的物理属性2.2.2汉语语音基础及其特性2.2.3语音的波形特征2.2.4语音的频谱特性2.2.5语音的音律特性第三章用于语音识别的信号处理及分析方法 (13)3.1短时分析与窗函数 (13)3.1.1语音信号的数字化3.1.2短时分析概要3.1.3几种典型的窗函数3.2时域分析 (14)3.2.1短时平均能量、幅度及过零数3.2.2短时自相关函数与平均幅度差函数3.2.3中值滤波3.3频域分析 (16)3.3.1傅里叶分析概要3.3.2短时离散傅里叶变换(DFT: Discrete Fourier Transform)3.3.3DFT与快速傅里叶变换(FFT: Fast Fourier Transform )3.3.4振幅谱和功率谱3.4倒谱域分析 (17)3.4.1倒谱的概念3.4.2倒谱的分析流程3.4.3倒谱系数的求法3.4.4倒谱分析在语音识别中的用途3.5线性预测分析 (19)3.5.1线性预测分析的概念3.5.2线性预测系数的求法3.5.3线性预测分析在语音识别中的用途3.6矢量量化法(VQ: Vector Quantization) (21)3.6.1矢量量化的原理3.6.2码本设计---LBG算法(2分割法)概要3.6.3矢量量化在语音识别中的用途第四章基于模式匹配方式的语音识别技术 (24)4.1语音的端点检测 (24)4.1.1语音端点检测的难点4.1.2采用能量及过零数参数的检测法4.2失真测度 (25)4.2.1距离测度与失真测度4.2.2几种典型的失真测度4.3动态时间规正法(DTW: Dynamic Time Warping) (26)4.3.1语音模式匹配的问题点4.3.2DTW的原理4.3.3DTW的具体解法4.4基于DTW技术的语音识别方案 (29)第五章基于统计模型(HMM)方式的语音识别技术 (30)5.1基于统计模型框架的识别法 (30)5.1.1预备知识5.1.2基于统计模型框架的识别法5.2隐马尔柯夫模型(HMM)的概念 (31)5.2.1马尔柯夫过程5.2.2隐马尔柯夫模型的概念5.2.3HMM的要素及其模型描述5.2.4基于HMM的观察符号序列的生成方式5.3HMM的三个基本问题及其解法 (33)5.3.1HMM的三个基本问题5.3.2模型评估问题的解法5.3.3最佳路径问题的解法5.3.4模型训练问题的解法5.4基于HMM的孤立字(词)语音识别方案 (37)第六章孤立字(词)语音识别系统 (39)6.1语音输入装置的实用化条件 (39)6.2系统构成及其主要技术项目 (39)6.2.1系统构成6.2.2主要技术项目6.3几种典型的识别方式 (40)6.3.1基于DTW技术的多重样板识别方式6.3.2基于语音特征轨迹的时间规正技术的识别方式6.3.3基于VQ-HMM技术的识别方式6.4系统实例介绍 (41)第七章连续语音识别系统 (43)7.1连续语音识别问题的难点 (43)7.2连续单词语音识别的几种典型算法 (43)7.2.1两极DP法(two-level dynamic programming)7.2.2分层构造法(level building)7.2.3一次通过法(one pass)7.3语音听写系统 (50)第八章语音识别的应用及展望 (51)8.1语音识别应用大分类 (51)8.2语音识别展望 (52)硬腭软腭上腭喉斗食道鼻腔鼻孔嘴唇舌牙齿口腔声带声道气管肺(声门)(斜线部分)硬腭软腭上腭喉斗食道鼻腔鼻孔嘴唇舌牙齿口腔声带声道气管肺(声门)(斜线部分)基于LPC的频普包络基于LPC对数倒频谱的频谱包络短时频谱基于FFT对数倒频谱的频谱包络基于LPC的频普包络基于LPC对数倒频谱的频谱包络短时频谱基于FFT对数倒频谱的频谱包络频率[kHz]对数振幅[dB] 时间(10ms/格) 频率(kHz) 时间(5ms/格) 时间(5ms/格)。

语音识别算法的使用教程随着技术的不断发展,语音识别技术成为了近年来备受关注的热门领域之一。

语音识别算法可以将人类的语音转化为可被计算机理解的文本或命令。

它在人机交互、智能音箱、智能手机等众多领域中有着广泛的应用。

本文将为您介绍语音识别算法的使用教程,以帮助您更好地了解和掌握这一领域的知识。

一、语音识别算法的基本原理在学习如何使用语音识别算法之前,我们首先需要了解其基本原理。

语音识别算法主要分为以下几个步骤:1. 语音信号的采集与预处理:语音信号是通过麦克风等设备采集得到的,采集到的语音信号需要经过预处理,去除背景噪音等干扰因素。

2. 特征提取:通过对预处理后的语音信号进行分析,提取其中的特征信息。

常用的特征提取方法包括短时能量、过零率、梅尔频率倒谱系数(MFCC)等。

3. 建立语音模型:基于特征提取后的语音信号,建立相应的语音模型。

语音模型可以使用隐马尔可夫模型(Hidden Markov Model,HMM)等方法进行建模。

4. 模型训练和优化:使用大量的已知语音样本对语音模型进行训练,并通过优化算法提高模型的准确性和鲁棒性。

5. 语音识别:将输入的语音信号与语音模型进行匹配,最终输出与输入语音信号相匹配的文字或命令。

二、如何使用语音识别算法1. 准备语音数据:为了进行语音识别任务,您首先需要准备一定量的语音数据。

可以选择从互联网上下载开源的语音数据集,或者自行收集一些符合需要的语音数据。

2. 数据预处理:对收集到的语音数据进行预处理,包括去除噪音、降低采样率等操作,以提高语音识别算法的准确性。

3. 特征提取:使用合适的特征提取方法,将预处理后的语音信号转化为特征向量。

这些特征向量将作为语音模型的输入。

4. 建立语音模型:选择适合您任务的语音模型,比如隐马尔可夫模型。

通过大量的已知语音样本,使用模型训练算法对语音模型进行训练,以提高其识别准确性。

5. 优化模型:语音识别算法中常用的优化方法包括最大似然估计、贝叶斯网络等。

语音识别软件入门教学第一章:语音识别软件的基础知识(300字)语音识别软件是一种利用计算机识别和理解人类语言的工具。

它通过将语音信号转化为文本或命令,进而实现语音与计算机的交互。

语音识别软件的发展对人机交互技术有着重要的推动作用,如语音搜索、智能助手等功能的实现。

语音识别软件的基本原理是将语音信号转化为数字化的波形数据,通过声音的频谱分析、特征提取和模式匹配等技术,将其转换为文本。

语音识别软件通常由两个主要部分组成:前端和后端。

前端负责获取声音信号,并将其转化为特征向量。

后端则利用这些特征向量进行模式匹配,最终输出识别结果。

第二章:语音识别软件的应用领域(300字)语音识别软件在各个领域都有广泛的应用。

在医疗领域,语音识别软件可以辅助医生进行病历记录和医嘱书写,提高医疗工作效率。

在司法领域,语音识别软件可以用于法庭记录和调查取证等工作。

在教育领域,语音识别软件可以用于语音评测和外语学习等方面。

在智能家居领域,语音识别软件可以实现语音控制家电和智能设备等功能。

第三章:常见的语音识别软件(300字)1. 百度语音识别:百度语音识别是一款领先的中文语音转文字工具,提供准确率高、稳定性强的识别服务,支持多种语言和方言的识别。

2. Google语音识别:Google语音识别是一款广泛应用于Android系统的语音识别软件,支持多种语言和方言的识别,并具有较高的准确率。

3. 微软语音识别:微软语音识别是一款可定制的语音识别引擎,可根据不同的应用场景和需求进行配置和使用。

4. 讯飞语音识别:讯飞语音识别是一款国内领先的语音识别软件,具有较高的准确率和稳定性,广泛应用于各个行业领域。

第四章:学习使用语音识别软件的步骤(300字)1. 下载与安装:根据自己的操作系统选择合适的语音识别软件,并下载安装到电脑或移动设备上。

2. 注册与登录:完成安装后,根据软件提示进行注册与登录,以获取更多功能和服务。

3. 训练与调整:语音识别软件通常需要进行训练和调整,以适应个人的发音、语速和语调等特点。

语音识别教程语音识别是一种技术,它将音频输入转换为文本输出。

在过去的几十年中,语音识别技术取得了巨大的进步,并广泛应用于各个领域。

一、背景介绍语音识别起源于20世纪50年代,当时的研究人员开始尝试将口头语言转换为文字。

然而,由于技术的限制和计算能力的不足,直到20世纪70年代后期,语音识别才开始进入实用阶段。

二、声学模型声学模型是语音识别的核心组成部分之一。

它通过将声音与预定义的音素进行匹配,来确定输入的语音是哪个单词或音素组合。

在声学模型的训练过程中,会使用大量的音频数据和相应的转录文本。

这些数据用于训练基于统计模型的声学模型,如隐马尔可夫模型(HMM)和深度神经网络(DNN)。

三、语言模型语言模型用于判断输入的语音在语法和语义上的合理性。

它通过计算文本中的单词之间的概率来帮助识别器选择最合适的文本输出。

语言模型可以是基于概率的统计模型,也可以是基于神经网络的模型。

四、特征提取特征提取是语音识别的重要步骤之一。

它将声音信号转换为一系列用于识别的特征向量。

常用的特征提取方法包括梅尔频率倒谱系数(MFCC)、线性预测编码(LPC)和短时傅里叶变换(STFT)。

五、声学模型训练声学模型的训练是一个复杂的过程,涉及到大量的数据和计算资源。

一般来说,训练一个准确和鲁棒的声学模型需要数百到数千小时的语音数据,并使用强大的计算机进行模型训练和优化。

六、语言模型训练语言模型的训练依赖于大量的文本数据。

这些数据可以是来自互联网、书籍、报纸等。

一般来说,语言模型的训练需要一个庞大的语料库,并使用一些特定的技术和算法进行模型训练和优化。

七、后处理识别结果的后处理是为了提高语音识别的准确性和可用性而进行的一系列操作。

后处理包括错误修正、语音分割、声音增强等。

总结:语音识别是一项复杂而广泛应用的技术,它在交通、医疗、教育、智能家居等领域都有重要的作用。

随着深度学习和神经网络的发展,语音识别的准确性和性能不断提升。

未来,语音识别将在更多领域发挥巨大的作用。

语音识别软件的初学者指南第一章:什么是语音识别软件语音识别软件是一种能够将人类的语音转化为文本的技术工具。

它利用自然语言处理、机器学习等先进技术,使得计算机能够理解并转录人类的语音信息。

语音识别软件被广泛应用于语音助手、语音导航、语音输入等领域。

第二章:语音识别软件的工作原理语音识别软件通过以下几个步骤实现语音到文本的转换。

首先,收集语音输入,可以通过麦克风或其他音频设备获取。

然后,语音信号被转化为数字信号,并经过预处理,包括降噪、增强等操作。

接下来,声音特征会被提取出来,并转换为特征向量。

最后,特征向量会通过模型进行识别,得到对应的文本输出。

第三章:语音识别软件的应用场景语音识别软件在现实生活中有着广泛的应用。

在智能手机上,用户可以利用语音识别软件进行语音输入、发消息、语音搜索等。

在智能家居中,语音识别软件可以实现语音控制家电的功能。

在医疗领域,语音识别软件可以帮助医生记录病历、转录医嘱等。

第四章:常见的语音识别软件市场上存在许多语音识别软件,其中一些领先的产品包括:百度语音识别、阿里云智能语音识别、Microsoft Azure语音识别等。

这些软件都具有较高的识别准确率和丰富的功能,可以满足不同场景下的需求。

第五章:提高语音识别准确率的方法为了提高语音识别软件的准确率,我们可以采取以下几个策略。

首先,清晰、流畅地发声,尽可能避免口吃或说话过快导致的错误。

其次,使用合适的硬件设备,如高质量的麦克风,以获得清晰的语音输入。

另外,合理选择语音识别软件,根据自己的需求选择准确率较高的产品。

第六章:语音识别软件的发展趋势随着人工智能技术的不断发展,语音识别软件也在不断演进。

未来,语音识别软件将更加智能化,可以更好地理解人类的语义和情感。

同时,与其他技术的结合,如自然语言处理技术、图像识别技术等,将进一步提升语音识别软件的功能和应用范围。

结语:语音识别软件是一项能够方便人类与计算机交互的重要技术。

了解其工作原理、应用场景以及提高准确率的方法,对初学者来说非常重要。

百度语⾳识别⼊门⼀.提前需要的的资料1.FFmpeg:密码:w6hk2.baidu-aip:pip install baidu-aip终于进⼊主题了,此篇是⼈⼯智能应⽤的重点,只⽤现成的技术不做底层算法,也是让初级程序员快速进⼊⼈⼯智能⾏业的捷径⽬前市⾯上主流的AI技术提供公司有很多,⽐如百度,阿⾥,腾讯,主做语⾳的科⼤讯飞,做只能问答的图灵机器⼈等等这些公司投⼊了很⼤⼀部分财⼒物⼒⼈⼒将底层封装,提供应⽤接⼝给我们,尤其是百度,完全免费的接⼝既然百度这么仗义,咱们就不要浪费掉怎么好的资源,从百度AI⼊⼿,开启⼈⼯智能之旅看看我⼤百度的AI⼤法,这些技术全部都是封装好的接⼝,看着就爽接下来咱们就⼀步⼀步的操作⼀下⾸先进⼊控制台,注册⼀个百度的账号(百度账号通⽤)开通⼀下我们百度AI开放平台的授权然后找到已开通服务中的百度语⾳⾛到这⾥,想必已经知道咱们要从语⾳⼊⼿了,语⾳识别和语⾳合成打开百度语⾳,进⼊语⾳应⽤管理界⾯,创建⼀个新的应⽤创建语⾳应⽤App就可以创建应⽤了,回到应⽤列表我们可以看到已创建的应⽤了这⾥⾯有三个值 AppID , API Key , Secret Key 记住可以从这⾥⾯看到 , 在之后的学习中我们会⽤到好了百度语⾳的应⽤已经创建完成了接下来我会⽤Python 代码作为实例进⾏应⽤及讲解⼀.安装百度的⼈⼯智能SDK:⾸先咱们要 pip install baidu-aip 安装⼀个百度⼈⼯智能开放平台的Python SDK实在是太⽅便了,这也是为什么我们选择百度⼈⼯智能的最⼤原因安装完成之后就来测试⼀下:在⼯程⽬录下,就可以看到 s1.mp3 这个⽂件了,来听⼀听上⾯咱们测试了⼀个语⾳合成的例⼦,那么就从语⾳合成开始⼊⼿⼆.语⾳合成:技术上,代码上任何的疑惑,都可以从官⽅⽂档中得到答案刚才我们做了⼀个语⾳合成的例⼦,就⽤这个例⼦来展开说明先来看第⼀段代码这是与百度进⾏⼀次加密校验 , 认证你是合法⽤户合法的应⽤AipSpeech 是百度语⾳的客户端认证成功之后,客户端将被开启,这⾥的client 就是已经开启的百度语⾳的客户端了再来看第⼆段代码:⽤百度语⾳客户端中的synthesis⽅法,并提供相关参数成功可以得到⾳频⽂件,失败则返回⼀段错误信息从参数⼊⼿分析:按照这些参数,从新发起⼀个语⾳合成这次声⾳是不是与⼀点点萝莉了呢?这都是语⾳语调的作⽤ 0 - 9 其实就是御姐⾳ - 萝莉⾳这就是⼈⼯智能中的语⾳合成技术,调⽤百度的SDK,只⽤了5分钟,完成了1年的开发量,哈哈哈哈⼀定要⾃⼰练习⼀下语⾳合成, 别把它玩⼉坏了三.语⾳识别:哎,每次到这⾥,我都默默⽆语泪两⾏,声⾳这个东西格式太多样化了,如果要想让百度的SDK识别咱们的⾳频⽂件,就要想办法转变成百度SDK 可以识别的格式PCMFFmpeg 环境变量配置:⾸先你要解压缩,然后找到bin⽬录,我的⽬录是 C:\ffmpeg\bin然后以 windows 10 为例,配置环境变量如果没搞明⽩的话,我也没有办法了,这么清晰这么明⽩尝试⼀下,是否配置成功看到这个界⾯就算配置成功了,配置成功有什么⽤呢, 这个⼯具可以将wav wma mp3 等⾳频⽂件转换为 pcm ⽆压缩⾳频⽂件做⼀个测试,⾸先要打开windows的录⾳机,录制⼀段⾳频(说普通话)现在假设录制的⾳频⽂件的名字为 audio.wav 放置在 D:\DragonFireAudio\然后我们⽤命令⾏对这个 audio.wav 进⾏pcm格式的转换然后得到 audio.pcm命令是 :ffmpeg -y -i audio.wav -acodec pcm_s16le -f s16le -ac 1 -ar 16000 audio.pcm然后打开⽬录就可以看到pcm⽂件了pcm⽂件已经得到了,赶紧进⼊正题吧百度语⾳识别SDK的应⽤:前提是你的audio.pcm 要与你当前的⽂件在同⼀个⽬录,还是分段看⼀下代码读取⽂件的内容,file_context 是 audio.pcm ⽂件打开的⼆进制流asr函数需要四个参数,第四个参数可以忽略,⾃有默认值,参照⼀下这些参数是做什么的第⼀个参数: speech ⾳频⽂件流建⽴包含语⾳内容的Buffer对象, 语⾳⽂件的格式,pcm 或者 wav 或者 amr。

语音识别入门(V1.0)丁鹏、梁家恩、苏牧、孟猛、李鹏、王士进、王晓瑞、张世磊中科院自动化所高创中心,北京,100080【摘要】本文主要以剑桥工程学院(CUED)的语音识别系统为例,并结合我们实验室自身的研究与开发经验,讲述当前主流的大词汇量连续语音识别系统(LVCSR)的框架和相关技术,对实验室的同学进行一个普及和入门引导。

【关键词】语音识别,HTK,LVCSR,SRI1. 引言语音识别技术发展到今天,取得了巨大的进步,但也存在很多的问题。

本文主要以CUED 的语言识别系统为例,说明LVCSR系统技术的最新进展和研究方向,对实验室的同学进行一个普及和入门引导。

1.1 国际语音识别技术研究机构(1)Cambridge University Engineering Department (CUED)(2)IBM(3)BBN(4)LIMSI(5)SRI(6)RWTH Aachen(7)AT&T(8)ATR(9)Carnegie Mellon University (CMU)(10)Johns Hopkins University (CLSP)1.2 国际语音识别技术期刊(1)Speech Communication(2)Computer Speech and Language (CSL)(3)IEEE Transactions on Speech and Audio Processing1.3 国际语音识别技术会议(1)ICASSP(International Conference on Acoustic, Speech and Signal Processing)每年一届,10月截稿,次年5月开会。

(2)ICSLP(International Conference on Spoken Language Processing)偶数年举办,4月截稿,9月开会。

(3)EuroSpeech:奇数年举办,4月截稿,9月开会。

1.4 国际语音识别技术评测z NIST Spoken Language Technology Evaluations Benchmark Tests(/speech/tests/index.htm)1.5 语音识别技术工具包•AT&T FSM Library•CMU-Cambridge Statistical LM Toolkit•CMU Sphinx•CSLU toolkit•CUED HTK•Edinburgh Speech Tools Library•KTH WaveSurfer•MSState ASR Toolkit•NIST Utility Software•SPRACHcore software package•SRI Language Modelling Toolkit•SoX -- Sound eXchange•Transcriber•UCL Speech Filing System•FBVIEW multi-channel audio file viewer1.6 语音识别技术研究语音识别技术研究目前以CUED最为开放和活跃,其工具包HTK和相关研究组的网址如下,通过这些网址可以链接到上述语音识别相关的网站。

z /z /research/speech/通过参考文献的学习,在了解相关的基础原理和研究动态之后,可以结合实验室的发展需求深入研究相关的核心算法。

下面将简要介绍LVCSR的基本原理,以及国际上目前热点研究的核心技术问题,最后给出相关领域的参考文献。

2. 语音识别基本原理2.1 语音识别系统流程语音识别系统的基本任务就是将输入的语音信号,识别成文字符号输出,基本流程如下图所示,基本上分成两个部分:前端处理(Front End Processing, FE)、搜索和解码(Search and Decoding)。

其中,搜索和解码需要利用训练好的声学模型(Acoustic Model,AM)、语言模型(Language Model, LM),以及联系这两个模型的发音词典(Lexicon)。

图一:语音识别系统基本流程图其中,前端处理完成的基本任务就是特征提取和归一化,在广播语音或者电话语音等大段语音处理中,还需要做相应的前端预处理工作,切分成语音片断输入;搜索和解码引擎是整个识别器的主要算法所在,主要采用Viterbi 搜索算法等动态规划方法,搜索在给定模型情况下的最优结果;语言和声学模型则是通过统计方法训练得到的,发音词典是将这两个模型联系起来的桥梁。

2.2 语音识别的统计模型描述语音识别系统首先将输入语音提取成为特征向量序列1T X ,目标是给出特定声学和语言模型下的最大后验词串1N W ,即11111111*********{(|,,,)}(|)*(){}() {(|)*()}{(|)*()}arg max arg max arg max arg max NNNNN N T W T N N TW T N N W T N N W W P W X AM LM Lex P X W P W P X P X W P W LogP X W LogP W λ====+其中,第二个等式中略去了AM 、LM 和Lex ,第三个等式略去主要是因为该项不影响1(T P X )1N W 的选择,第四个等式用对概率取对数也不影响对1N W 的选择,主要用于控制动态范围,参数λ用于平衡声学和语言模型的权重,因为声学和语言模型是用不同语料独立训练的。

为声学得分,11(|T N LogP X W ))1(N LogP W 为语言得分,分别用相应的声学和语言模型计算,语言模型概率具体计算如下:1112111111N11k=1()()*(|)*...*(|)()*...*(|)*...*(|) =P(|)N N N k N k k M N N M k k k M P W P W P W W P W W P W P W W P W W W W −−−−+−+−−+=≈∏1 其中,第一个等式是联合概率的展开,第二个是用M-Gram 近似计算,第三个等式是第二个等式的简写形式。

声学模型概率具体计算如下:11111111111111(|)(|) (,|){(,|)} (|)*(|)max T T T N T L T T L S T T L S Tt t t t t P X W P X H P X S H P X S H P X S P S S −===≈=∑∏其中,第一个等式是利用Lex 信息将词串1N W 转换成音素模型串1L H ,该模型串为隐马尔可夫模型(HMM );第二个等式引入隐含声学状态序列,包含模型的时间对齐信息,用于计算声学得分;第三个等式为Viterbi 近似,用“最优”状态序列近似求和式,便于引入动态规划算法搜索最优识别结果;第四个等式将状态跳转概率和观测序列概率分开计算,并略去1T S 11(|T L P S H ))111(|,T T L P X S H 1L H 符号,因为模型已经确定;每帧观测概率通常由混合高斯模型(Gaussian Mixture Model, GMM )描述:(|t t P X S ))2,,1(|)*(;,t t Mt t i t S i S ii P X S C N X μσ==∑ 其中,为混合项系数,M 为混合项数,为第i 个单高斯分布混合项。

声学模型的HMM 描述如下图所示:i C 2,,(;,)t t t S i S i N X μσ图二:典型的HMM 声学模型结构图图中,声学模型是由5个状态构成:第1个和第5个状态只起到连接作用,没有观测概率;中间的2、3、4状态具有GMM描述的观测概率分布。

模型是一个从左到右的跳转结构,每个跳转有一个概率,这样,每个音素的发音特征就由这样一个模型描述。

2.3 语音识别的模型训练在通常情况下,语音识别的解码器搜索错误相对比较低,语音识别的准确率主要取决于声学和语言模型的精度。

模型精度主要取决于两个方面:一是训练语料的规模和质量,二是训练的工具和算法。

一、声学模型训练声学模型训练就是利用带标注的训练语料,训练每个音素的发音HMM模型。

声学模型训练需要考虑两个基本因素:一是模型的精度,即模型要尽可能精细,以提高系统的识别率;二是模型的鲁棒性,即模型的参数必须得到比较好的估计,有足够的训练参数,确保模型对训练集外的数据具有足够的泛化能力。

通常模型需要考虑这两个方面因素的折中,达到比较好的效果。

目前的LVCSR系统通常采用音素作为基本的建模单元,为了提高建模精度,通常要选用上下文相关的音素模型(Context Dependent Phone Model),即对不同声学上下文下的音素建立不同的模型。

为了保证鲁棒性,通常需要对模型参数进行共享,这种共享的方法,通常是通过决策树分裂的方式,根据给定的上下文问题集,进行自顶向下的分裂,确保训练集中样本很稀疏的模型可以得到鲁棒地估计。

声学模型训练的过程,实际上就是对训练数据的拟合过程,最基本的方法就是最大似然(Maximum Likelihood, ML)的方法,通过Baum-Welch的EM算法,迭代优化模型参数得到。

其它的区分度准则,如MMI和MPE准则也可以用于优化模型,提高模型精度。

为了提高声学模型的精度,通常需要做一些特征归一化、噪声抑制等算法,提高声学模型对声道、说话人、加性噪声等因素的鲁棒性。

另外,自适应技术也用于提高系统对环境和说话人的自适应能力,提高系统的性能。

声学模型训练的典型工具就是HTK工具包。

二、语言模型训练语言模型训练和声学模型训练类似,利用大量的文本语料对模型参数进行估计,对于稀疏的数据,采用回退和平滑技术,提高模型对训练集外语言现象的估计能力。

语言模型训练典型的工具包有SRILM和HTKLM,都可以对语言模型进行训练。

3. 语音识别系统核心技术3.1 前端预处理技术在进行广播新闻或者电话、会议录音等语料时,往往需要对大段的语料进行预处理,切分成适合语音识别系统处理的片断。

预处理主要完成功能为:(1)语音切分(2)语音/非语音判别(3)宽窄带判别(4)男女声判别(5)说话人聚类(6)音乐片断剔除语音预处理的性能对语音识别的效果有比较大的影响,是实用系统中不可缺少的模块。

3.2 特征提取和归一化技术语音特征提取和归一化技术主要是将语音提取成为特征,常用的特征为MFCC特征和PLP特征,在特征提取基础上,通常需要进行一定的归一化,如:(1)均值归一化CMN,主要降低信道影响(2)方差归一化CVN,主要降低加性噪声影响(3)声道长度归一化VTLN,主要降低声道差异造成的影响(4)高斯化Gaussianization,是CMN+CVN的推广算法。