2-正则图的cordial性

- 格式:pdf

- 大小:81.48 KB

- 文档页数:2

L1和L2正则化L1正则化与稀疏性稀疏性说⽩了就是模型的很多参数是0。

这相当于对模型进⾏了⼀次特征选择,只留下⼀些⽐较重要的特征,提⾼模型的泛化能⼒,降低过拟合的可能。

正则化通过降低复杂模型的复杂度来防⽌过拟合的规则被称为正则化!正则化⽅法是在经验风险或者经验损失\(L_{e m p}\)(emprirical loss)上加上⼀个结构化风险,我们的结构化风险⽤参数范数惩罚,⽤来限制模型的学习能⼒、通过防⽌过拟合来提⾼泛化能⼒。

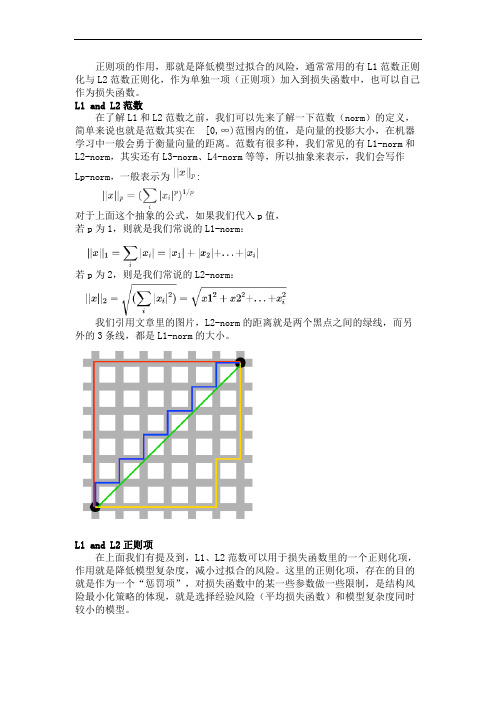

L1正则化(Lasso回归):通过对损失函数加上所有权重值的绝对值来惩罚损失函数;\[J=J_{0}+\alpha \sum_{w}|w| \]L2正则化(岭回归):通过对损失函数加上所有权重值的平⽅来惩罚失函数!\[J=J_{0}+\alpha \sum_{w} w^{2} \]⾓度1:解空间形状在⼆维的情况下,黄⾊的部分是L2和L1正则项约束后的解空间,绿⾊的等⾼线是凸优化问题中⽬标函数的等⾼线。

L2正则项约束后的解空间是圆形,⽽L1正则项约束的解空间是菱形。

显然,菱形的解空间更容易在尖⾓处与等⾼线碰撞出稀疏解。

L1正则化等价于在原优化⽬标函数中增加约束条件:\(\|w\|_{1} \leq C\)L2正则化等价于在原优化⽬标函数中增加约束条件:\(\|w\|_{2}^{2} \leq C\)L2正则化相当于为参数定义了⼀个圆形的解空间,⽽L1正则化相当于为参数定义了⼀个菱形的解空间。

如果原问题⽬标函数的最优解不是恰好落在解空间内,那么约束条件下的最优解⼀定是在解空间的边界上,⽽L1“棱⾓分明”的解空间显然更容易与⽬标函数等⾼线在⾓点碰撞,从⽽产⽣稀疏解。

⾓度2:函数叠加仅考虑⼀维的情况,多维情况是类似的。

假设棕线是原始⽬标函数\(L(w)\)的曲线图,显然最⼩值点在蓝点处,且对应的\(w*\)值⾮0。

考虑加上L2正则化项,⽬标函数变成\(L(w)+C w^{2}\),其函数曲线为黄⾊。

L1和L2正则化原理及分析在介绍正则化原理之前,首先需要了解一下过拟合问题。

过拟合是指模型在训练数据上表现良好,但在测试数据上表现较差的现象。

过拟合通常发生在模型过于复杂的情况下,模型会记住训练数据中的每一个细节,导致对新的数据缺乏泛化能力。

L1正则化(也称为Lasso正则化)的原理是在损失函数中增加参数的L1范数(绝对值之和)作为正则化项。

L1正则化能够使得模型的参数稀疏化,即将一部分参数设置为0,从而达到特征选择的效果。

这是因为L1正则化的几何解释是正则项的等值线是一个菱形,菱形的顶点就是参数为0的点,而L1范数的范围圆角,更容易产生参数为0的情况。

L1正则化的数学表达式如下:\[\lambda\,W\,_1\]其中,\(\lambda\)是正则化参数,控制正则化的强度,\(W\)是模型的参数。

L2正则化(也称为Ridge正则化)的原理是在损失函数中增加参数的L2范数(平方和的开平方)作为正则化项。

L2正则化通过对参数的平方惩罚,使得参数尽量小,进而降低模型的复杂程度。

与L1正则化不同,L2正则化的等值线是一个圆形,更容易产生参数接近于0的情况。

L2正则化的数学表达式如下:\[\lambda\,W\,_2^2\]其中,\(\lambda\)是正则化参数,控制正则化的强度,\(W\)是模型的参数。

L1和L2正则化的选择主要取决于具体问题的特点。

一般来说,如果模型的特征很多,但只有少数特征对结果起到重要作用,那么就可以使用L1正则化进行特征选择。

而如果模型的特征不是很多,特征之间的关联性较大,那么可以使用L2正则化来减小参数的值,从而避免过拟合。

另外,L1和L2正则化还可以用于解决高维数据集的问题。

在高维数据集中,由于特征的维度很大,模型容易过拟合。

通过加入正则化项,可以缩小参数的解空间,从而降低模型的复杂度,提高模型的泛化能力。

总结起来,L1和L2正则化是常用的控制模型复杂度、防止过拟合的方法。

图D (1,3)的H -cordial 性陈丽娜(仰恩大学数学系,福建泉州362014)摘要:Cahit 首次提出H -cordial 图概念,先定义每条边的标号为-1,1{},由边的标号导出顶点v 的标号———与顶点v 关联的所有边的标号之和.若存在一个正整数k ,对于每个顶点v ,其标号是k 或-k ,且同时满足条件e (-1)-e (1)≤1和v (-k )-v (k )≤1,符号D (1,3)表示每个顶点的度为1或3的图集,则D (1,3)是H -cordial 图当且仅当其含有偶数条边.关键词:H -cordial ;标号;3-正则图中图分类号:O157.5文献标识码:A文章编号:2096-2134(2019)03-0013-030引言本文只讨论无向有限的简单图,使用的图论符号与文献[1,2]相同.对于任意图G ,定义它的每条边e 的标号为-1,1{},即任给e ∈E (G ),其标号f (e )=1或-1.由边的标号f 导出顶点v 的标号:f (v )=e ∈I (v )∑f (e ),其中I (v )为与顶点v 关联的边所构成的集合.用符号e f (k )和v f (k )记标号为k 的边、顶点的数目.在不引起混淆的情况下,下标f 可省略.本文所涉及的标号均如上所述,之后不再一一赘述.通过上述定义,可得到:引理[3]对于图G 的每一个标号f ,均有v ∈V (G )∑∈f (v )=2e ∈E (G )∑f (e ).I.Cahit 在文献[4]中首次提出H -cordial 标号.定义若对图G 的标号f ,存在一个正整数k ,使得对于G 中的每个顶点v ,都有f (v )=k ;且满足下面两个条件:(1)e f (-1)-e f (1)≤1;(2)v f (-k )-v f (k )≤1.则称标号f 为图G 的一个H -cordial 标号.具有H -cordial 标号的图,称为H -cordial 图.在文献[3,4]中,I.Cahit ,M.Ghebleh 和R.Khoeilar 解决了关于一些特殊图,如二部图K m ,n 、完全图K n 、轮w n 的H -cordial 性.设图G 的顶点集为V (G )=v 1,v 2,…,v n {},d i (i =1,2,…,n )为顶点v i 的度数.用符号D (1,3)表示每个顶点的度数为1或3的图集合.本文将得出D (1,3)为H -cordial 图的充要条件,该结论更具一般性.1预备知识引理1[3]具有n 个顶点、m 条边的图G 为H -cordial 图,则m-n 为偶数.由定义,可得出下述引理:引理2任意图G 为H -cordial 图,则G 要么为奇度图,要么为偶度图.注:引理2在本文中将起到非常重要的作用.引理3图G 是3-正则连通图,则存在一个标号f ,使得e f (-1)-e f (1)≤1,并且每个顶点必同时关联-1边、1边.证明因G 是3-正则连通图,则G 必存在一个偶圈C ,不妨设其顶点为x 1,x 2,…,x 2t ,令收稿日期:2019-03-26作者简介:陈丽娜(1981-),女,福建泉州人,讲师,理学硕士,主要研究方向为图论.DOI :10.13933/ki.2096-2134.2019.03.004喀什大学学报Journal of Kashi University2019年6月Vol.40No.3Jun.2019第40卷第3期边x 1x 2,x 2x 3,…,x 2t x 1分别标-1,1,-1,1,….根据偶圈C 的顶点,分以下两种情形:(1)若V (C )=V (G ),显然G 只剩下t 条边未标号,可随机选择t2[]条边标-1,剩余边标1,引理条件已满足.(2)若V (C )≠V (G ),即至少存在一个顶点u ∈V (G )\V (C ),使得u 与C 中的某个顶点相邻,不妨设为x 1,即ux 1∈E (G ).因d (u )=3,则存在顶点u 1≠x 1,且u 1u ∈E (G ),令f (ux 1)=-1,f (u 1u )=1,用符号E k 表示已标号的k 条边集合,G k 表示由E k 中的边导出的子图,即G k =G E k [].在偶圈C =G 2t =G E 2t []的基础上,每次增加两条边,得到一系列的子图G 2t +2,G 2t +4,…,且每个子图G 2k (k =t ,t +1,…)均满足下列三条性质:(Ⅰ)G 2k 至多只有1个1度点;(Ⅱ)G 2k 中的2度点或3度点均同时关联-1、1边;(Ⅲ)e G 2k (-1)=e G 2k (1).利用数学归纳法证明.假设当k =m 时三条性质成立,即已有G 2m 具有上述(Ⅰ)(Ⅱ)(Ⅲ)性质,我们只需在G 2m 基础上构造G 2m +2且满足(Ⅰ)(Ⅱ)(Ⅲ)性质即可.情形1:若G 2m 有1个1度点u ,设v 是u的邻点,不妨设f (uv )=-1.若N G (u )⊂V (G 2m ),因d (u )=3,则存在两个邻点v 1,v 2∈V (G 2m ),令f (uv 1)=-1,f (uv 2)=1,则得到G 2m +2满足上述三个条件.否则u 在V (G 2m )外至少有一个邻点v 1,对于顶点v 1可找到其另一个邻点v 2,令f (uv 1)=1,f (v 1v 2)=-1,则得到G 2m +2.情形2:G 2m 无1度点,且至少有1个2度点u ,而u 有一个邻点u 1∉V (G 2m ),不妨设u 1的另一邻点为u 2(u ≠u 2),令f (uu 1)=-1,f (u 1u 2)=1,则得到满足条件的G 2m +2.情形3:G 2m 无1度点,且所有2度点的邻点均在V (G 2m ),则随机选择两条未标号的边给予标号-1、1,则得到G 2m +2.………以此类推,直到所有的边都标完或只剩下一条边未标.令最后一边标-1,显然,该标号满足引理3.引理4若图G ∈D (1,3)但非1-正则图或3-正则图,则G 存在一个标号f ,使得(1)e f (-1)-e f (1)≤1;(2)G 中每一个3度顶点必同时关联-1边、1边.证明若G 的每个分支是1-正则图(就1条边)或3-正则图,据引理3,可容易验证引理4的正确性,否则必存在三个顶点x ,y ,z ,其中d (x )=1且xy ,yz ∈E (G ),令G 2=G xy ,yz []以此为底图,每次新增两条边,得到一系列的边导出子图G 4,G 6,…,且每个子图G 2k (k =2,3,…)均满足:(i )G 2k 中至多只有1个1度点,但在G 中的度为3;(ii )G 2k 中的2度点或3度点必同时关联-1边、1边;(iii )e G 2k(-1)=e G 2k(1).利用数学归纳法证明.假设当k=m 时成立,即已有G 2m 具有上述(i )(ii )(iii )性质,我们只需在此基础上构造G 2m +2且满足(i )(ii )(iii )性质即可.情形1:G 2m 有1个1度点u ,但在G 中的度为3.不妨设v 是u 在G 2m 中的邻点,且f (uv )=-1.u 的另两个邻点为v 1,v 2.若v 1,v 2∈V (G 2m ),令f (uv 1)=1,f (uv 2)=-1,则得到G 2m +2满足上述三个条件.若v 1∈V (G 2m ),v 2∉V (G 2m ),令f (uv 1)=1,f (uv 2)=-1,则得到G 2m +2.若v 1,v 2均在V (G 2m )外,分两种情况,若v 1,v 2中至少有1个3度点,不妨设为v 1,则可找到v 1的另一邻点v 3,令f (uv 1)=1,f (v 1v 3)=-1,则得到G 2m +2;若v 1,v 2均为1个1度点,令f (uv 1)=1,f (uv 2)=-1,则得到G 2m +2.情形2:G 2m 无1度点,且至少存在1个2度点u ,当u 有另一个3度邻点u 1∉V(G 2m ),不妨设u 1的另一邻点为u 2,令f (uu 1)=-1,f (uu 2)=1,则得到满足条件的G 2m +2.当u 只有1个1度点u 1∉V (G 2m ),也分两种情形,(1)G 2m 中有其它2度点w ,且w 有1个1度邻点w 1∉V (G 2m ),令f(uu 1)=-1,f (w 1w )=1;(2)否则,则有V (G 2m )∪u 1{}=V (G ),则G 只剩下uu 1未标号或未标号的边的两个端点均为2度点.………以此类推,直到所有的边都标完或只剩下一条边未标.令最后一边标-1,显然,该标号满足引理4.引理5图G ∈D (1,3),则G 必存在标号f ,使得(1)e f (-1)-e f (1)≤1;(2)度为3的顶点必同时关联-1边、1边.证明设G 的分支为G 1,G 2,…,G m .若G i(i =1,2,…,m )不为1-正则图,利用引理3、喀什大学学报第40卷14··引理4,若e (G i )为偶,则e G i (-1)=e G i (1),否则e G i (-1)=e G i (1)+1.在后一种情形下,我们可找另一分支G j ,且e (G j )为奇,对调G j 的标号,则有e G i ∪G j (-1)=e G i ∪G j (1).………以此类推,只剩下t 边(1-正则分支)未标号,任取t2[]边标-1,剩余标1即可.2主要结论定理1G ∈D (1,3),则G 是H-cordial 图当且仅当e (G )为偶.证明必要性.因G ∈D (1,3),则G 的顶点数为偶数.利用引理1,则e (G )为偶.充分性.利用引理5,因e (G )为偶,则得到G 的一个标号f ,使得(1)e f (-1)=e f (1);(2)度为3的顶点必同时关联-1边、1边.由v f (1)-v f (-1)=v ∈V (G )∑f (v )=2e ∈E (G )∑f (e )=2e f (1)-e f (-1)[]=0,故v f (1)=v f (-1),则G 是H-cordial 图.定理2设G 是3-正则图,则G 是H-cordial 图当且仅当v (G )=0(mod4).证明与定理1证明类似,在此从略.3总结本文主要研究顶点度只为1度和3度的图H-cordial 的标号问题,这类图涵盖了很多类型的图,具有广泛的延伸性.证明主要是从偶圈开始,依次给边-1,1,-1,1,…的标号,在此基础上每次只增加两条边,分别标-1,1,直到图的所有边标完.此方法的最大优点在于:(1)标号为-1,1的边数的差距最多不超过1,这也是H-cordial 图定义中所要求的;(2)度为3的顶点必同时关联-1边、1边,这就保证顶点的标号只能为-1或1.为了满足图定义中顶点标号为-1、1的顶点数相差为1,利用引理,很容易就得到“顶点度只为1度和3度的图G 是H -cordial 图当且仅当其含有偶数条边”的结论.参考文献:[1]Bondy J A,Murty U S R.Graph Theory with Applications[M].North Holland ,New York ,1976.[2]I.Cahit.Cordial graphs :A weaker version of graceful andharmoniousgraphs[J].ArsCombinatorial ,1987,23:201-208.[3]M.Ghebleh ,R.Khoeilar.A note on graph [J].Bull Inst Combin Appl ,2001,31:60-68.[4]I.Cahit.H -Cordial graphs [J].Bull Inst Combin Appl ,1996,18:87-101.陈丽娜:图D (1,3)的H-cordial 性第3期The H-cordial of D(1,3)CHEN Li-na(Department of Mathematics,Yang-en University,Quanzhou 362014,Fujian,China )Abstract :Cahit calls a graph H -cordial if it is possible to label the edges with the numbers from the set -1,1{}in such a way that,for some k ,at each vertex v the sum of the labels on the edges incident with v is either k or -k and the inequalities e (-1)-e (1)≤1andv (-k )v (k )≤1are also satisfied.The symbol D(1,3)is the set of graphs of which the degree of each vertex is 1or 3.In this paper,we prove that D (1,3)is H -cordial if and only if it has even edges.Key words :H -cordial ;Labeling;3-Regular graph15··。

正则项的作用,那就是降低模型过拟合的风险,通常常用的有L1范数正则化与L2范数正则化,作为单独一项(正则项)加入到损失函数中,也可以自己作为损失函数。

L1 and L2范数在了解L1和L2范数之前,我们可以先来了解一下范数(norm)的定义,简单来说也就是范数其实在[0,∞)范围内的值,是向量的投影大小,在机器学习中一般会勇于衡量向量的距离。

范数有很多种,我们常见的有L1-norm和L2-norm,其实还有L3-norm、L4-norm等等,所以抽象来表示,我们会写作Lp-norm,一般表示为:对于上面这个抽象的公式,如果我们代入p值,若p为1,则就是我们常说的L1-norm:若p为2,则是我们常说的L2-norm:我们引用文章里的图片,L2-norm的距离就是两个黑点之间的绿线,而另外的3条线,都是L1-norm的大小。

L1 and L2正则项在上面我们有提及到,L1、L2范数可以用于损失函数里的一个正则化项,作用就是降低模型复杂度,减小过拟合的风险。

这里的正则化项,存在的目的就是作为一个“惩罚项”,对损失函数中的某一些参数做一些限制,是结构风险最小化策略的体现,就是选择经验风险(平均损失函数)和模型复杂度同时较小的模型。

针对线性回归模型,假设对其代价函数里加入正则化项,其中L1和L2正则化项的表示分别如下所示,其中λ >= 0,是用来平衡正则化项和经验风险的系数。

(1)使用L1范数正则化,其模型也被叫作Lasso回归(Least Absolute Shrinkage and Selection Operator,最小绝对收缩选择算子)。

(2)使用L2范数正则化,其模型被叫做Ridge回归,中文为岭回归。

机器学习中一般怎么选择正则项上面介绍的L1和L2范数正则化都有着降低过拟合风险的功能,但它们有什么不同?我们到底应该选择哪一个呢,两者之间各有什么优势和适用场景?别急,我们一一来展开讲讲。

L1正则化和L2正则化有什么区别在模型训练中的作用是什么L1正则化和L2正则化是机器学习领域中常用的正则化方法,它们在模型训练过程中起着重要的作用。

本文将深入探讨L1正则化和L2正则化的区别以及它们在模型训练中的作用。

第一章:L1正则化和L2正则化的原理及区别在介绍L1正则化和L2正则化之前,我们先简单回顾一下正则化的概念。

正则化是指在模型训练过程中为了防止过拟合而引入的一种惩罚项,通过向损失函数中添加正则化项来限制模型的复杂度,从而提高模型的泛化能力。

L1正则化和L2正则化分别是对模型参数的不同约束方式。

L1正则化通过向损失函数中添加参数的绝对值之和来限制模型参数的大小,其数学表达式为:L1(w) = ||w||_1,其中||w||_1表示参数向量w的L1范数。

而L2正则化则是通过向损失函数中添加参数的平方和来限制模型参数的大小,其数学表达式为:L2(w) = ||w||_2^2,其中||w||_2表示参数向量w的L2范数。

L1正则化和L2正则化的主要区别在于对模型参数的惩罚方式不同。

L1正则化会让部分参数变为0,从而实现特征选择的功能,即可以通过L1正则化将不重要的特征的权重置为0,从而达到特征筛选的效果;而L2正则化则会让所有参数都变小但不为0,能够更好地控制模型的复杂度。

第二章:L1正则化和L2正则化在模型训练中的作用L1正则化和L2正则化在模型训练中起着重要的作用,主要体现在以下几个方面:1. 防止过拟合:正则化可以有效地防止模型过拟合训练数据,提高模型的泛化能力。

L1正则化和L2正则化都是常用的正则化方法,可以通过控制模型参数的大小来避免模型在训练集上过度拟合,提高模型在测试集上的表现。

2. 特征选择:L1正则化可以实现特征选择的功能,即可以通过L1正则化将不重要的特征的权重置为0,从而达到特征筛选的效果。

这对于高维数据中选择最重要的特征变量非常有帮助,可以提高模型的解释性和泛化能力。

L2 正则化(也称为权重衰减)在机器学习中是一种用于控制模型复杂度的技术,

通过向模型的损失函数中添加权重的 L2 范数来实现。

当应用 L2 正则化时,优化

过程会倾向于使权重向量的所有元素都很小,而不是使其中的一些元素非常大。

这可以促使模型学习到更加稀疏的表示,即使得一些特征的权重趋于零。

以下是关于 L2 正则化如何导致稀疏解的详细解释:

1.L2 正则化的数学形式:

L2 正则化将模型的损失函数修改为原始损失和正则化项的和。

对于线性回

归模型来说,带有 L2 正则化的损失函数如下:

Loss=Original Loss+λ⋅∥w∥22

其中,λ是正则化强度,w是权重向量,∥w∥22是权重向量的 L2 范数的平

方。

2.梯度下降更新规则:

在使用梯度下降法优化带有L2 正则化的损失函数时,权重的更新规则变为:

w=(1−αλ)⋅w−α⋅∇w Original Loss

其中,α是学习率。

3.影响因素:

当αλ较大时,权重更新中的(1−αλ)会趋近于零,导致权重向量中的元素

减小。

这种趋势会促使模型学习到一些特征的权重趋近于零,从而实现稀疏

性。

总的来说,L2 正则化对权重的更新进行了衰减,使得权重向量更趋向于小的值,

从而可以在一些情况下促使模型学习到稀疏的特征表示。

这对于特征选择和模型泛化能力的提高是有帮助的。

l2正则化计算L2正则化是一种常用的机器学习方法,它可以帮助我们处理数据中的过拟合问题。

在本文中,我们将深入探讨L2正则化的概念、原理以及应用。

L2正则化,也被称为岭回归或权重衰减,是一种用于线性回归模型的正则化方法。

它通过在损失函数中增加一个正则化项来对模型进行约束,以防止模型过度拟合训练数据。

正则化项是模型参数的平方和乘以一个正则化参数λ,用于惩罚模型复杂度。

为了更好地理解L2正则化的原理,我们先来回顾一下线性回归模型。

线性回归模型的目标是最小化预测值与真实值之间的平方损失。

但当训练数据过少或特征过多时,模型很容易过拟合,即在训练数据上表现良好但在测试数据上表现不佳。

L2正则化通过引入正则化项来解决过拟合问题。

正则化项的作用是通过惩罚模型复杂度来防止模型过度拟合。

具体来说,正则化项会使模型的参数尽量接近于0,从而降低模型的复杂度。

而正则化参数λ则控制了正则化项在损失函数中的权重,λ越大,正则化项的影响就越大。

L2正则化的数学表示如下:损失函数 = 平方损失+ λ * Σ(模型参数的平方和)在实际应用中,我们通常使用梯度下降法来求解L2正则化的线性回归模型。

梯度下降法是一种迭代优化算法,通过不断调整模型参数来最小化损失函数。

对于L2正则化,梯度下降法的更新公式如下:参数更新 = 学习率 * (梯度+ λ * 参数)其中,学习率是指定每次迭代中参数更新的步长,梯度是损失函数关于模型参数的偏导数。

L2正则化不仅可以用于线性回归模型,也可以应用于其他机器学习算法,如逻辑回归、支持向量机等。

在这些算法中,L2正则化的原理和应用方式都是类似的。

除了防止过拟合,L2正则化还具有其他一些优点。

首先,它可以减少模型参数的方差,提高模型的稳定性。

其次,L2正则化可以帮助我们筛选出对模型最重要的特征,从而简化模型并提高其解释性。

然而,L2正则化也有一些限制。

首先,正则化参数λ需要手动调整,这需要一定的经验和领域知识。