梯度投影法matlab程序可执行

- 格式:doc

- 大小:44.00 KB

- 文档页数:18

matlab 梯度法在MATLAB中,可以使用梯度法来最小化或最大化一个函数。

梯度法是一种迭代优化算法,通过迭代调整参数值以逐步逼近目标函数的极小值或极大值。

首先,需要定义一个目标函数。

例如,假设我们要最小化一个函数f(x) = x^2,在MATLAB中可以定义如下:```matlabfunction y = f(x)y = x^2;end```接下来,我们可以使用fminunc函数来实现梯度法。

fminunc函数是MATLAB中用于非线性优化的函数,可以处理带有约束和无约束的问题。

在梯度法中,我们不需要提供目标函数的梯度信息,fminunc会自动计算梯度。

```matlabx0 = 1; % 初始参数值options = optimoptions('fminunc', 'Display', 'iter', 'Algorithm','quasi-newton'); % 配置选项[x, fval] = fminunc(@f, x0, options); % 使用fminunc函数进行优化```在上述代码中,我们使用了optimoptions函数来配置fminunc函数的选项。

其中,'Display', 'iter'选项用于显示每一步的迭代信息,'Algorithm', 'quasi-newton'选项用于指定使用拟牛顿法进行优化。

运行以上代码,MATLAB将输出每一步迭代的信息,并在最后给出最优参数值和最小化的函数值。

需要注意的是,梯度法的性能通常会受到初始参数值的影响。

因此,选择合适的初始参数值可能对优化结果产生重要影响。

matlab梯度算法Matlab梯度算法在数学和计算机科学中,梯度是指一个多元函数在某一点上的变化率或斜率。

梯度算法是一种优化算法,用于找到函数的最小值或最大值。

在Matlab中,有多种方法可以使用梯度算法来优化函数,包括梯度下降和共轭梯度法。

本文将详细介绍Matlab中的梯度算法,并逐步讲解其原理和应用。

I. 梯度下降法梯度下降法是一种基于迭代的优化算法,通过计算函数的梯度来更新参数的值,以逐步接近函数的最小值。

在Matlab中,可以使用"gradientDescent"函数来实现梯度下降法。

1. 实现梯度下降法首先,我们需要定义一个优化目标函数,例如:f(x) = x^2 + 2x + 1。

然后,定义其梯度函数为g(x) = 2x + 2。

接下来,我们可以使用以下代码来计算梯度下降:matlab定义优化目标函数f = (x) x^2 + 2*x + 1;定义梯度函数g = (x) 2*x + 2;初始化参数x0 = 0;设置学习率和迭代次数alpha = 0.01;iterations = 100;梯度下降法for i = 1:iterationsx0 = x0 - alpha * g(x0);end打印最优解disp(['Optimal solution: ', num2str(x0)]);在这个例子中,我们使用了学习率(alpha)为0.01,迭代次数(iterations)为100。

通过不断更新参数x0的值,最终得到了最优解。

2. 梯度下降法的原理梯度下降法的核心思想是利用函数在当前点的梯度信息来更新参数的值,以便能够向着函数的最小值前进。

具体来说,算法的步骤如下:a. 初始化参数的值:选择一个初始参数的值作为起始点。

b. 计算梯度:计算函数在当前点的梯度,即求解函数关于参数的偏导数。

c. 更新参数:根据当前点的梯度和学习率,通过减去梯度的乘积来更新参数的值。

灰度投影法 matlab灰度投影法是一种常用的图像处理方法,可以用来提取图像中的特定信息。

在matlab中,可以使用灰度投影法来实现图像的分割、识别等操作。

本篇文章将介绍灰度投影法的原理和matlab实现方法。

首先,我们来了解一下灰度投影法的原理。

灰度投影法是指将一幅图像的每一行或每一列的像素值加起来,得到一组灰度值,这组灰度值表示了该行或该列的亮度变化情况。

通过对这些灰度值进行统计和分析,可以得到图像中的特定信息,例如图像的边缘、字符等。

在matlab中,实现灰度投影法的过程如下:1.读取图像并转换为灰度图像2.对灰度图像的每一行或每一列进行像素值加和,得到一组灰度值3.通过统计和分析这组灰度值,得到图像中的特定信息4.根据得到的信息进行图像分割、识别等操作下面是一个灰度投影法的matlab实现示例:%读取图像并转换为灰度图像img = imread('test.jpg');gray_img = rgb2gray(img);%对灰度图像的每一行或每一列进行像素值加和,得到一组灰度值row_sum = sum(gray_img, 2); %每一行的像素值加和col_sum = sum(gray_img, 1); %每一列的像素值加和%通过统计和分析这组灰度值,得到图像中的特定信息%例如,可以找到图像中的边缘row_edge = diff(row_sum);col_edge = diff(col_sum);%根据得到的信息进行图像分割、识别等操作%例如,可以通过边缘信息进行图像的分割上述示例仅为灰度投影法的一种实现方式,实际应用中可能需要根据具体情况进行调整和优化。

同时,还可以结合其他图像处理方法来实现更为复杂的图像处理任务。

Matlab中的方向与梯度计算技巧概述Matlab作为一种功能强大的数学软件,提供了丰富的工具和函数来进行图像处理和计算机视觉任务。

其中,计算图像的方向与梯度是图像处理的重要一部分。

本文将介绍一些在Matlab中常用的方向与梯度计算技巧,并探讨其原理和应用。

1. 图像梯度图像的梯度用于表示图像像素在空间上的变化程度。

在Matlab中,可以使用函数gradient或imgradient来计算图像的梯度。

gradient函数可用于计算二维图像的梯度。

它将输入图像视为计算图像函数f(x, y)在x和y方向上的偏导数。

使用方法如下:```matlab[Gx, Gy] = gradient(image);```其中,image为输入的图像,Gx和Gy为计算得到的梯度。

imgradient函数在Matlab R2016a版本引入,与gradient函数类似,不同的是可以指定不同的梯度算子。

使用方法如下:```matlab[Gmag, Gdir] = imgradient(image);```其中,image为输入的图像,Gmag为计算得到的梯度大小,Gdir为计算得到的梯度方向。

2. 方向直方图方向直方图是用于表示图像中不同方向上的梯度分布情况的一种统计方法。

在Matlab中,可以使用函数histcounts来计算方向直方图。

首先,需要计算图像的梯度,可以使用前文介绍的gradient或imgradient函数。

然后,将梯度方向值进行量化,通常将其划分为一定数量的方向区间。

最后,对每个像素的梯度方向进行统计,得到方向直方图。

下面是一个简单的示例:```matlab[Gmag, Gdir] = imgradient(image);numBins = 10; % 将方向划分为10个区间binEdges = linspace(-180, 180, numBins+1); % 计算方向区间边界histogram = histcounts(Gdir(:), binEdges); % 计算方向直方图```在上述示例中,Gdir为梯度方向矩阵,binEdges为方向区间边界数组,histogram为计算得到的方向直方图。

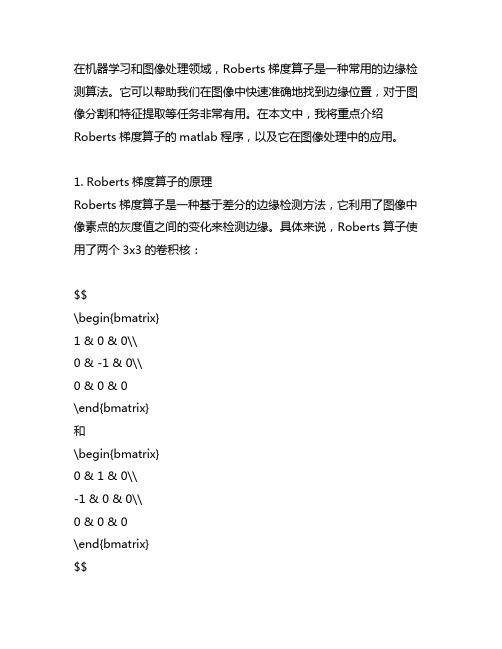

在机器学习和图像处理领域,Roberts梯度算子是一种常用的边缘检测算法。

它可以帮助我们在图像中快速准确地找到边缘位置,对于图像分割和特征提取等任务非常有用。

在本文中,我将重点介绍Roberts梯度算子的matlab程序,以及它在图像处理中的应用。

1. Roberts梯度算子的原理Roberts梯度算子是一种基于差分的边缘检测方法,它利用了图像中像素点的灰度值之间的变化来检测边缘。

具体来说,Roberts算子使用了两个3x3的卷积核:$$\begin{bmatrix}1 & 0 & 0\\0 & -1 & 0\\0 & 0 & 0\end{bmatrix}和\begin{bmatrix}0 & 1 & 0\\-1 & 0 & 0\\0 & 0 & 0\end{bmatrix}$$分别对图像进行卷积运算,然后将它们的平方和再开方得到边缘检测结果。

这种方法可以很好地捕捉到图像灰度值的变化,从而找到图像中的边缘。

2. Roberts梯度算子的matlab程序下面是一个简单的Roberts梯度算子的matlab程序示例:```matlabfunction [edge_image] = roberts_edge_detection(image)[m, n] = size(image);edge_image = zeros(m, n);for i = 1 : m - 1for j = 1 : n - 1% 对图像进行卷积运算edge_image(i, j) = abs(image(i, j) - image(i+1, j+1)) + abs(image(i, j+1) - image(i+1, j));endendend```这段matlab代码实现了对图像的Roberts边缘检测。

首先读入图像,然后对每个像素点进行Roberts算子的卷积运算,最后得到一个边缘图像。

投影梯度计算法投影梯度计算法1. 简介投影梯度计算法是一种优化算法,用于解决凸优化问题。

它通过在每次迭代中计算投影梯度并更新解向量,逐步逼近最优解。

该方法常用于处理约束条件下的优化问题,其优点在于能够在较短时间内找到接近最优解的解向量。

2. 基本原理投影梯度计算法基于梯度信息和投影操作来更新解向量。

在每次迭代中,我们首先计算当前解向量的梯度,然后将其投影到可行解空间,从而获得一个新的解向量。

具体来说,我们假设有一个凸优化问题:minimize f(x)subject to g(x) <= 0其中,f(x)是目标函数,g(x)是约束条件。

在投影梯度计算法中,我们定义梯度向量g(x)为目标函数f(x)的梯度加上约束条件的梯度的线性组合。

我们通过投影操作将解向量更新为一个满足约束条件的新向量。

3. 算法步骤投影梯度计算法的算法步骤如下:1) 初始化解向量x0。

2) 计算当前解向量x的梯度g(x)。

3) 计算新的解向量x' = x - λg(x),其中λ是一个步长参数。

4) 对于新的解向量x',将其投影到可行解空间,得到最终的解向量x。

5) 如果终止条件不满足,则返回步骤2;否则算法结束。

4. 优点和应用投影梯度计算法具有以下优点:- 算法过程简单,易于实现。

- 可以处理约束条件下的优化问题,求解凸优化问题效果良好。

- 通过每次迭代逼近最优解,适用于大规模问题。

投影梯度计算法在许多领域中有广泛的应用,如机器学习、图像处理和操作研究等。

投影梯度计算法可以用于线性规划、支持向量机、稀疏编码和最小二乘问题的求解。

5. 总结投影梯度计算法是一种用于解决凸优化问题的有效算法。

通过在每次迭代中计算投影梯度并更新解向量,该算法能够在较短时间内找到接近最优解的解向量。

投影梯度计算法简单易懂,适用于处理约束条件下的优化问题,并在许多领域中有广泛的应用。

值得一提的是,投影梯度计算法的性能高度依赖于步长参数的选择,因此在实际应用中需要进行合适的调参。

源信号数目未知的自然梯度盲信号分离算法邵莲莲【摘要】总结了源信号数目未知的盲信号分离自然梯度算法,得到自然梯度算法发散的原因,分离矩阵的各行沿混合矩阵转置的零空间方向无效的冗余移动.借助投影自然梯度算法,从理论上证明,冗余分量的范数随迭代次数的增加呈指数分布.【期刊名称】《电子科技》【年(卷),期】2015(028)003【总页数】4页(P79-82)【关键词】盲信号分离;自然梯度算法;冗余分量;指数分布【作者】邵莲莲【作者单位】西安电子科技大学数学与统计学院,陕西西安 710071【正文语种】中文【中图分类】TN911.7所谓盲信源分离,是指未知传输信道特性及源信号任何先验知识的情况下,仅通过观测信号来实现信号辨识或信号恢复。

其是当前信号处理和神经网络学界共同研究的课题,在无线电通信、雷达、图像、语音及生物医学等领域均具有良好的应用前景[1]。

盲源分离问题根据源信号数目n和混合信号m数目之间的大小关系可分为正定盲信号分离(m=n)、欠定盲信号分离(m<n)和超定盲信号分离(m>n)3种情况。

迄今为止,盲信源分离的大部分经典算法均是围绕信源数已知展开的,对于信源数未知算法研究较少,尤其是对于信源数未知或数目动态变化的超定盲信号分离算法,至今少有研究[2-3]。

然而在众多实际场合,源信号的数目未知甚至可能动态变化,例如在移动通讯中,一个小区中用户的个数就是随机变化的,因此源信号数目未知的盲信号分离问题研究更具现实意义[4-5]。

1 问题描述考虑盲信源分离模型[1-13]A是m×n维的混合矩阵,x t是m维的观测数据,s t是n维的源信号向量。

对源信号向量有如下假设:(1)源信号st的各分量相互统计独立且最多有一个信号服从高斯分布。

(2)源信号具有零均值和单位方差。

(3)混合矩阵列A满秩,即m≥n。

为实现盲信号分离,通常用n×m维的分离矩阵B作用于观测信号向量x t,使系统输出y t=Bx t是源信号向量s t的某个拷贝或估计[6]。

matlab投影函数MATLAB提供了多种函数用于进行投影操作,其中最常用的是几何投影和正交投影。

几何投影是一种把三维物体映射到二维平面上的方法。

在MATLAB中,几何投影可以使用projeciton函数来实现。

projection函数采用三个输入参数:投影类型、三维点坐标和二维平面法向量。

投影类型可以是'orthographic'(正交投影)和'perspective'(透视投影)。

三维点坐标是一个N某3的矩阵,每一行包含一个三维点的坐标。

二维平面法向量是一个1某3的向量,定义了二维平面的法向量方向。

函数返回一个N某2的矩阵,每一行包含一个对应于三维点的二维投影点的坐标。

正交投影是一种把三维物体映射到一个二维平面上的方法。

在MATLAB中,正交投影可以使用orthographicProjection函数来实现。

orthographicProjection函数接受三个输入参数:三维点坐标、二维平面法向量和平面上的一个点。

三维点坐标是一个N某3的矩阵,每一行包含一个三维点的坐标。

二维平面法向量是一个1某3的向量,定义了二维平面的法向量方向。

平面上的一个点是一个1某3的向量,定义了平面上的一个点。

函数返回一个N某2的矩阵,每一行包含一个对应于三维点的二维投影点的坐标。

透视投影是一种通过仿射变换将三维物体映射到一个二维平面上的方法。

在MATLAB中,透视投影可以使用perspectiveProjection函数来实现。

perspectiveProjection函数接受三个输入参数:三维点坐标、二维平面法向量和摄像机位置。

三维点坐标是一个N某3的矩阵,每一行包含一个三维点的坐标。

二维平面法向量是一个1某3的向量,定义了二维平面的法向量方向。

摄像机位置是一个1某3的向量,定义了摄像机在世界坐标系中的位置。

函数返回一个N某2的矩阵,每一行包含一个对应于三维点的二维投影点的坐标。

梯度下降法是一种常用的优化算法,可用于求解最优化问题。

在MATLAB 中,我们可以通过编写梯度下降法的程序来解决各种复杂的优化问题。

本文将深入介绍 MATLAB 中梯度下降法的编程方法,并根据其深度和广度要求,逐步探讨梯度下降法的原理、实现步骤、优化调节和应用场景,帮助读者全面理解和掌握这一优化算法。

1. 梯度下降法的原理梯度下降法是一种迭代优化算法,其基本原理是不断沿着目标函数的负梯度方向更新参数,直至达到局部最小值或全局最小值。

在MATLAB 中,我们可以利用数值计算和矩阵运算来实现梯度下降法,通过不断迭代来更新参数并逐步逼近最优解。

2. 梯度下降法的实现步骤在 MATLAB 中实现梯度下降法主要包括以下步骤:定义目标函数、计算目标函数的梯度、选择学习率和迭代次数、初始化参数、通过循环迭代更新参数直至收敛。

通过编写 MATLAB 程序来实现这些步骤,我们可以轻松地对各种复杂的优化问题进行求解。

3. 优化调节和应用场景在实际应用中,梯度下降法的效果受到学习率和迭代次数的影响,因此需要进行适当的优化调节。

在 MATLAB 中,我们可以通过调节学习率和设置合理的停止准则来提高梯度下降法的收敛速度和稳定性。

梯度下降法在机器学习、神经网络训练、参数优化等领域有着广泛的应用场景,通过 MATLAB 编程可以快速应用于实际问题中。

总结回顾通过本文的介绍,我们全面了解了 MATLAB 中梯度下降法的编程方法。

从梯度下降法的原理到实现步骤,再到优化调节和应用场景,我们逐步深入地探讨了这一优化算法。

在实际编程中,我们需要注意学习率和迭代次数的选择,并结合具体问题进行调节优化。

梯度下降法在各种优化问题中具有广泛的应用,通过 MATLAB 编程可以轻松应用于实际场景中。

个人观点和理解我个人认为,掌握 MATLAB 中梯度下降法的编程方法对于解决各种复杂的优化问题非常重要。

通过编写梯度下降法的程序,我们可以深入理解优化算法的原理,并在实际问题中灵活应用。

梯度下降法matlab代码梯度下降法matlab代码是一种基于梯度下降的机器学习算法,它的核心思想是:在每次迭代中,以当前参数值计算损失函数的梯度,根据梯度更新参数值,使得参数值不断趋向于使损失函数最小值。

它是目前最流行的机器学习优化方法之一,可用于解决回归、分类等问题。

梯度下降法matlab代码的具体实现步骤如下:1.加载数据:首先,根据实际情况,加载所需要的数据集,并将其分割成训练集和测试集。

2.初始化参数:接下来,需要初始化模型参数,可以采用随机初始化法,也可以采用其他方法(如高斯分布)。

3.计算损失函数:接下来,需要计算损失函数,可以采用常见的损失函数,如均方误差(MSE)、交叉熵(CE)等。

4.计算梯度:然后,需要计算损失函数的梯度,以便进行参数更新。

5.更新参数:根据上一步计算的梯度,计算各参数的更新值,并将其应用于模型参数中,以进行参数更新。

6.重复步骤3-5:重复步骤3-5,直到模型收敛或超过预定的迭代次数。

最后,通过上述步骤,即可得到梯度下降法matlab代码的实现步骤,从而解决机器学习中的优化问题。

以下是梯度下降法matlab代码的示例:% 加载数据 load('data.mat'); % 初始化参数w=rand(size(X,2),1); b=rand(); % 设定学习率alpha=0.01; % 设定迭代次数 epochs=1000; % 训练 fori=1:epochs % 计算损失函数 Y_hat=X*w+b; loss=mean((Y-Y_hat).^2); % 计算梯度grad_w=mean(-2*X.*(Y-Y_hat)); grad_b=mean(-2*(Y-Y_hat)); % 更新参数 w=w-alpha*grad_w; b=b-alpha*grad_b; end。

function [x,minf]=minRosen(f,A,b,x0,var,eps) %目标函数:f;%约束矩阵:A;%约束右端力量:b;%初始可行点:x0;%自变量向量:var;%精度:eps;%目标函数取最小值时的自变量值:x;%目标函数的最小值:minf;format long;if nargin == 5eps=;endsyms l;x00=transpose(x0);n=length(var);sz=size(A);m=sz(1);gf=jacobian(f,var);bConti=1;while bContik=0;s=0;A1=A;A2=A;b1=b;b2=b;for i=1:mdfun=A(i,:)*x00-b(i); if abs(dfun)<k=k+1;A1(k,:)=A(i,:); b1(k,1)=b(i); elses=s+1;A2(s,:)=A(i,:); b2(s,1)=b(i); endendif k>0A1=A1(1:k,:);b1=b1(1:k,:);endif s>0A2=A2(1:s,:);b2=b2(1:s,:);endwhile 1P=eye(n,n);if k>0tM=transpose(A1);P=P-tM*inv(A1*tM)*A1; endgv=Funval(gf,var,x0); gv=transpose(gv);d=-P*gv ;if d==0if k==0x=x0;bConti=0;break;elsew=inv(A1*tM)*A1*gv;if w>=0x=x0;bConti=0;break;else[u,index]=min(w);sA1=size(A1);if sA1(1)==1k=0;elsek=sA1(2);A1=[A1(1:(index-1),:);A1((index+1):sA1(2),:)]; %去掉A1对应的行endendendelsebreak;endendd1=transpose(d);y1=x0+l*d1;tmpf=Funval(f,var,y1);bb=b2-A2*x00;dd=A2*d;if dd>=0[tmpI,lm]=minJT(tmpf,0,; elselm=inf;for i=1:length(dd)if dd(i)<0if bb(i)/dd(i)<lmlm=bb(i)/dd(i); endendendend[xm,minf]=minHJ(tmpf,0,lm,; tol=norm(xm*d);if tol<epsx=x0;break;endx0=x0+xm*d1;%disp('x0');x0endminf=Funval(f,var,x)function fv = Funval(f,varvec,varval) var = findsym(f);varc = findsym(varvec);s1 = length(var);s2 = length(varc);m =floor((s1-1)/3+1);varv = zeros(1,m);if s1 ~= s2for i=0: ((s1-1)/3)k = findstr(varc,var(3*i+1));index = (k-1)/3;varv(i+1) = varval(index+1);% index(i+1);% varv(i+1)=varval(index(i+1));endfv = subs(f,var,varv);elsefv = subs(f,varvec,varval);endfunction [x,minf] = minHJ(f,a,b,eps) format long;if nargin == 3eps = ;endl = a + *(b-a);u = a + *(b-a);k=1;tol = b-a;while tol>eps && k<100000fl = subs(f , findsym(f), l);fu = subs(f , findsym(f), u);if fl > fua = l;l = u;u = a + *(b - a);elseb = u;u = l;l = a + *(b-a);endk = k+1;tol = abs(b - a);endif k == 100000disp('找不到最小值!');x = NaN;minf = NaN;return;endx = (a+b)/2;minf = subs(f, findsym(f),x);format short;function [minx,maxx] = minJT(f,x0,h0,eps) format long;if nargin == 3eps = ;endx1 = x0;k = 0;h = h0;while 1x4 = x1 + h;k = k+1;f4 = subs(f, findsym(f),x4); f1 = subs(f, findsym(f),x1); if f4 < f1x2 = x1;x1 = x4;f2 = f1;f1 = f4;h = 2*h;elseif k==1h = -h;x2 = x4;f2 = f4;elsex3 = x2;x2 = x1;x1 = x4;break;endendendminx = min(x1,x3);maxx = x1+x3 - minx;format short;% syms x1 x2 x3 ;% f=x1^2+x1*x2+2*x2^2+2*x3^2+2*x2*x3+4*x1+6*x2+12*x3;% [x,mf]=minRosen(f,[1 1 1 ;1 1 -2],[6;-2],[1 1 3],[x1 x2 x3])% syms x1 x2;%f=x1^3+x2^2-2*x1-4*x2+6;% [x,mf]=minRosen(f,[2,-1;1,1;-1,0;0,-1],[1;2;0;0],[1 2],[x1 x2])% syms x1 x2 x3;% f=-x1*x2*x3;% [x,mf]=minRosen(f,[-1,-2,-2;1,2,2],[0;72],[10 10 10],[x1 x2 x3])% syms x1 x2;%f=2*x1^2+2*x2^2-2*x1*x2^3-4*x1^7-6*x2;% [x,mf]=minRosen(f,[1 1;1 5;-1 0;0 -1],[2;5;0;0],[-1 -1],[x1 x2])------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------syms x1 x2 x3;% f=2*x1^2+2*x2^2-2*x1*x2^3-4*x1^7-6*x2;% var=[x1,x2];% valst=[-1,-1];% A=[1 1;1 5;-1 0;0 -1];% b=[2 5 0 0]';% f=x1^3+x2^2-2*x1-4*x2+6;% var=[x1,x2];% valst=[0 0];% A=[2,-1;1,1;-1,0;0,-1];% b=[1 2 0 0]';var=[x1,x2,x3];valst=[10,10,10];f=-x1*x2*x3;A=[-1,-2,-2;1,2,2];b=[0 72]';[x,mimfval]=MinRosenGradientProjectionMethod(f,A,b,valst,var)[x2,fval]=fmincon('confun',valst,A,b)function [x,minf]=MinRosenGradientProjectionMethod(f,A,b,x0,var,eps)%f is the objection function;%A is the constraint matrix; 约束矩阵%b is the right-hand-side vector of the constraints;%x0 is the initial feasible point; 初始可行解%var is the vector of independent variable; 自变量向量%eps is the precision; 精度%x is the value of the independent variable when the objective function is minimum; 自变量的值是当目标函数最小%minf is the minimum value of the objective function; 目标函数的最小值format long;if nargin == 5eps=;endsyms l;x00=transpose(x0);n=length(var);sz=size(A);m=sz(1);% m is the number of rows of A 行数gf=jacobian(f,var);%calculate the jacobian matrix of the objective function 计算目标函数的雅可比矩阵bConti=1;while bContik=0;s=0;A1=A;A2=A;b1=b;b2=b;for i=1:mdfun=A(i,:)*x00-b(i); %separate matrix A and b 分离矩阵A和bif abs(dfun)< %find matrixs that satisfy A1 x_k=b1 找到满足的矩阵k=k+1;A1(k,:)=A(i,:);b1(k,1)=b(i);else%find matrixs that satisfy A2 x_k<b2 找到满足的矩阵s=s+1;A2(s,:)=A(i,:);b2(s,1)=b(i);endendif k>0A1=A1(1:k,:);b1=b1(1:k,:);endif s>0A2=A2(1:s,:);b2=b2(1:s,:);endwhile 1P=eye(n,n);if k>0tM=transpose(A1);P=P-tM*inv(A1*tM)*A1; %calculate P;endgv=Funval(gf,var,x0);gv=transpose(gv);d=-P*gv; %calculate the searching direction 计算搜索方向% flg=1;% if(P==zeros(n))% flg =0;% end% if flg==1% d=d/norm(d); %normorlize the searching direction 搜索方向% end% 加入这部分会无止境的循环if d==0if k==0x=x0;bConti=0;break;elsew=-inv(A1*tM)*A1*gv;if w>=0x=x0;bConti=0;break;else[u,index]=min(w);%find the negative component in wsA1=size(A1);if sA1(1)==1k=0;elsek=sA1(2);A1=[A1(1:(index-1),:);A1((index+1):sA1(1),:)]; %delete corresponding row in A1 删除对应的行A1endendendelsebreak;endendd1=transpose(d);y1=x0+l*d1; %new iteration variable 新的迭代变量tmpf=Funval(f,var,y1);bb=b2-A2*x00;dd=A2*d;if dd>=0[tmpI,lm]= ForwardBackMethod(tmpf,0,; %find the searching interval 找到搜索区间elselm=inf; %find lambda_maxfor i=1:length(dd)% if(dd(i)>0)% %if dd(i)<0% %if bb(i)/dd(i)<lmlm=bb(i)/dd(i);endendendendif lm==inflm=1e9;end[xm,minf]=GoldenSectionSearch(tmpf,0,lm,; %guarantee lambda>0 保证λ> 0%find the minimizer by one dimension searching method 找到由一维搜索方法得到目标tol=norm(xm*d);if tol<epsx=x0;break;endx0=x0+xm*d1;disp('x0');x0endminf=Funval(f,var,x);搜索法确定局部最优值function [x,minf]=GoldenSectionSearch(f,a,b,eps)% search method to find minimum value of function f 搜索方法找到函数f的最小值format long;if nargin==3eps=;endl=a+*(b-a);u=a+*(b-a);k=1;tol=b-a;while tol>eps&&k<100000fl=subs(f ,findsym(f),l);fu=subs(f ,findsym(f),u);if fl>fua=l;l=u;u=a+*(b-a);elseb=u;u=l;l=a+*(b-a);endk=k+1;tol=abs(b-a);endif k==100000disp('找不到最小值!');x=NaN;minf=NaN;return;endx=(a+b)/2; %return the minimizer 返回最小值minf=subs(f, findsym(f),x);format short;进退法确定搜索区间function [left,right]=ForwardBackMethod(f,x0,step) if nargin==2step =endif nargin==1x0=0;step =endf0 =subs(f,findsym(f),{x0});x1=x0+step;f1=subs(f,findsym(f),{x1});if(f1<=f0)step2=2*step;x2=x1+step;f2=subs(f,findsym(f),{x2});while(f1>f2)x0=x1;x1=x2;f0=f1;f1=f2;step=2*step;x2=x1+step;f2=subs(f,findsym(f),{x2}); endleft=min(x0, x2);right=max(x0, x2);elsestep=2*step;x2=x1-step;f2=subs(f,findsym(f),{x2});while(f0>f2)x1=x0;x0=x2;f1=f0;f0=f2;step=2*step;x2=x1-step;f2=subs(f,findsym(f),{x2});endleft=min(x1,x2);%left end pointright=max(x1,x2);%right end pointendfunction fv=Funval(f,varvec,varval)var=findsym(f); %找出表达式包含的变量t,s f=t^2+s+1varc=findsym(varvec); %找出传递参数的变量[t s]中的 t ss1=length(var); %函数的个数s2=length(varc); %变量的个数m=floor((s1-1)/3+1); %靠近左边的整数varv=zeros(1,m);if s1 ~= s2%if the number of variable is different, deal with it specially 如果变量的数量是不同的,专门处理它for i=0: ((s1-1)/3)k=findstr(varc,var(3*i+1));index=(k-1)/3;varv(i+1) = varval(index+1);endfv=subs(f,var,varv);elsefv=subs(f,varvec,varval); %return the value of the function 如果原来函数变量个数与传递参数中变量个数一致,调用subs函数,计算给定点处函数值end% disp('here')% f% varvec% varval%fv = subs(f,varvec,varval);。