全局负载均衡

- 格式:ppt

- 大小:3.80 MB

- 文档页数:30

1. 平台优化方案大型网站,在面对大量用户访问、高并发请求方面,基本的解决方案集中在这样几个环节:使用高性能的服务器、高性能的数据库、高效率的编程语言、还有高性能的Web容器。

但是除了这几个方面,还没法根本解决大型网站面临的高负载和高并发问题.上面提供的几个解决思路在一定程度上也意味着更大的投入,并且这样的解决思路具备瓶颈,没有很好的扩展性,下面我从低成本、高性能和高扩张性的角度来说说我的一些经验。

1.1. HTML静态化由于效率最高、消耗最小的就是纯静态化的html页面,所以尽可能使网站上的页面采用静态页面来实现,这个最简单的方法其实也是最有效的方法。

但是对于大量内容并且频繁更新的网站,无法全部手动去挨个实现,于是出现了常见的信息发布系统CMS,信息发布系统可以实现最简单的信息录入自动生成静态页面,还能具备频道管理、权限管理、自动抓取等功能,对于一个大型网站来说,拥有一套高效、可管理的CMS是必不可少的。

除了门户和信息发布类型的网站,对于交互性要求很高的社区类型网站来说,尽可能的静态化也是提高性能的必要手段,将社区内的帖子、文章进行实时的静态化,有更新的时候再重新静态化也是大量使用的策略,如Mop的大杂烩就是使用了这样的策略,网易社区等也是如此。

同时,html静态化也是某些缓存策略使用的手段,对于系统中频繁使用数据库查询但是内容更新很小的应用,可以考虑使用html静态化来实现,比如论坛中论坛的公用设置信息,这些信息目前的主流论坛都可以进行后台管理并且存储在数据库中,这些信息其实大量被前台程序调用,但是更新频率很小,可以考虑将这部分内容进行后台更新的时候进行静态化,这样避免了大量的数据库访问请求。

1.2. 图片服务器分离对于Web服务器来说,不管是Apache、IIS还是其他容器,图片是最消耗资源的,于是有必要将图片与页面进行分离,这是基本上大型网站都会采用的策略,他们都有独立的图片服务器,甚至很多台图片服务器。

负载均衡器部署方式和工作原理2011/12/16 小柯信息安全在现阶段企业网中,只要部署WEB应用防火墙,一般能够遇到负载均衡设备,较常见是f5、redware的负载均衡,在负载均衡方面f5、redware的确做得很不错,但是对于我们安全厂家来说,有时候带来了一些小麻烦。

昨日的一次割接中,就遇到了国内厂家华夏创新的负载均衡设备,导致昨日割接失败。

在本篇博客中,主要对负载均衡设备做一个介绍,针对其部署方式和工作原理进行总结。

概述负载均衡(Load Balance)由于目前现有网络的各个核心部分随着业务量的提高,访问量和数据流量的快速增长,其处理能力和计算强度也相应地增大,使得单一的服务器设备根本无法承担。

在此情况下,如果扔掉现有设备去做大量的硬件升级,这样将造成现有资源的浪费,而且如果再面临下一次业务量的提升时,这又将导致再一次硬件升级的高额成本投入,甚至性能再卓越的设备也不能满足当前业务量增长的需求。

负载均衡实现方式分类1:软件负载均衡技术该技术适用于一些中小型网站系统,可以满足一般的均衡负载需求。

软件负载均衡技术是在一个或多个交互的网络系统中的多台服务器上安装一个或多个相应的负载均衡软件来实现的一种均衡负载技术。

软件可以很方便的安装在服务器上,并且实现一定的均衡负载功能。

软件负载均衡技术配置简单、操作也方便,最重要的是成本很低。

2:硬件负载均衡技术由于硬件负载均衡技术需要额外的增加负载均衡器,成本比较高,所以适用于流量高的大型网站系统。

不过在现在较有规模的企业网、政府网站,一般来说都会部署有硬件负载均衡设备(原因1.硬件设备更稳定,2.也是合规性达标的目的)硬件负载均衡技术是在多台服务器间安装相应的负载均衡设备,也就是负载均衡器来完成均衡负载技术,与软件负载均衡技术相比,能达到更好的负载均衡效果。

3:本地负载均衡技术本地负载均衡技术是对本地服务器群进行负载均衡处理。

该技术通过对服务器进行性能优化,使流量能够平均分配在服务器群中的各个服务器上,本地负载均衡技术不需要购买昂贵的服务器或优化现有的网络结构。

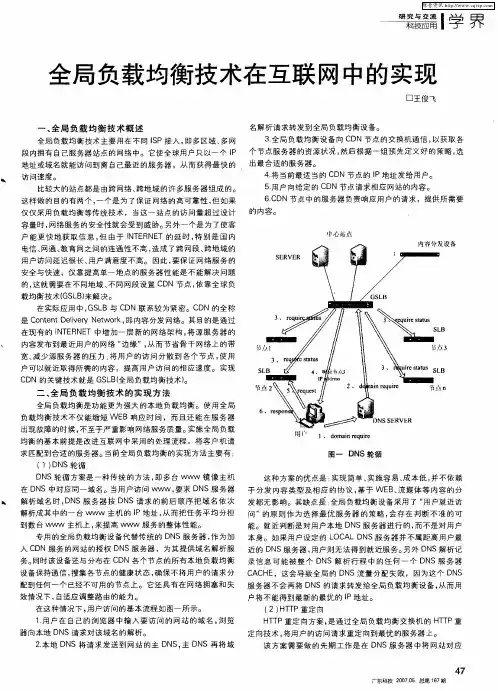

基于DNS的全局负载均衡(GSLB)详解(上篇)前⾔DNS解析现在已经成为互联⽹访问的第⼀步,访问⽹络资源必然要经过DNS解析流程。

对于⼀个⽐较复杂的⽹站来说,DNS解析时间⼤概占到初始页⾯登录时间的29%,所以DNS解析的性能对于访问⼀个⽹站有着⾄关重要的作⽤。

如果DNS性能⽐较差,或者它的稳定性⽐较差,可能会对⽤户的访问带来⾮常⼤的影响。

既然DNS有这么重要的⼀个作⽤,我们应该如何提⾼DNS的安全性和可⽤性,这是很多运维⼈员和互联⽹技术⼈员所关⼼的问题。

全局负载均衡(GSLB)技术使得⽹络DNS服务更快捷更安全。

本⽚内容将会对DNS全局负载均衡(GSLB )进⾏详细介绍。

为了更好的表述整个的全局流量负载的流程,⾸先回顾⼀下DNS的基本原理(可查看⽂章)。

了解DNS访问的整个流程,对于更好地讲解全局流量负载有所帮助。

DNS流量负载和容灾切换功能的意义DNS流量负载和容灾切换是全局负载均衡中重要的两项技术。

下⾯我们将阐述它们在单数据中⼼、双数据中⼼、云服务下扮演的⾓⾊。

单数据中⼼随着互联⽹的发展,企业许多业务都已经迁到线上进⾏,线上的应⽤越来越重要。

最早的时候只有⼀个单数据中⼼,随着业务增多和业务的扩展,单数据中⼼同时接⼊电信、联通、移动三家运营商的线路,这个时候运营商线路之间就会出现跨⽹访问的问题。

这种情况下,如果这个⽤户的宽带是联通的,我们需要⾃动把它引流到服务器的联通线路上,防⽌跨⽹访问的问题出现,因此会使更多⽤户访问⽹站的时候速度都⽐较快。

在单数据中⼼情况下,会有在多线路之间的⼀个智能解析调度或者流量负载的应⽤,把不同的运营商分开,形成流量负载的架构。

双数据中⼼/两地三中⼼后来慢慢随着业务进⼀步发展,我们发现单数据中⼼已经不能满⾜需求,便出现双数据中⼼或者是两地三中⼼的架构。

通常情况下,这两个数据中⼼可能是同城的,也有可能是异地的,相互作为容灾,同时也作为双活的架构。

通过DNS域名解析将不同⽤户的流量调度到不同的数据中⼼来,不同数据中⼼也会分多条运营商线路,通过这些⽅式进⾏流量负载。

HUAWEI USG6000V系列NFV防火墙技术白皮书之---服务器负载均衡技术白皮书华为技术有限公司Huawei Technologies Co., Ltd.目录1背景和概述 (2)2全局服务器负载均衡(GSLB) (3)3本地服务器负载均衡(LSLB) (4)3.1使用目的MAC地址转换的服务器负载均衡(DR) (4)3.2使用网络地址转换实现的服务器负载均衡(L4 SLB) (5)3.3使用轻量代理和网络地址转换的服务器负载均衡(L4 lwProxy SLB) (7)3.4使用全量Socket 代理的服务器负载均衡(L7 Socket Proxy SLB) (9)3.4.1socket代理加业务会话关联保持 (9)3.4.2根据URL类型不同的分担,静态资源访问和动态计算访问分开多种服务器103.4.3SSL卸载 (10)3.4.4链路优化:压缩、协议优化、本地cache、多路复用 (11)3.5业务保持技术 (13)4华为USG防火墙支持的SLB功能列表 (14)1 背景和概述随着互联网的快速发展,用户访问量的快速增长,使得单一的服务器性能已经无法满足大量用户的访问,企业开始通过部署多台服务器来解决性能的问题,由此就产生了服务器负载均衡的相关技术方案。

在实际的服务器负载均衡应用中,由于需要均衡的业务种类以及实际服务器部署场景的不同(比如是否跨地域、跨ISP数据中心等),存在多种负载均衡的技术。

如下典型的组网方式如图所示:服务提供方为了支撑大批量的用户访问,以及跨不同地域、不同接入ISP的用户都能够获得高质量的业务访问体验,其已经在不同地域、不同ISP数据中心搭建了服务器,这样就带来一个需求,也就是客户的访问能够就近、优先选择同一个ISP数据中心的服务器,从而获得高质量的业务访问体验。

同时,基于单台服务器能够提供的业务访问并发是有限的,那么就自然想到使用多台服务器来形成一个“集群”,对外展现出一个业务访问服务器,以满足大量用户访问、而且可以根据业务访问量的上升可以动态的进行业务能力扩容的需要。

阿里巴巴网站全局负载均衡及DDOS攻击防范解决方案一、客户(项目)背景A()是全球企业间(B2B)电子商务的著名品牌,是目前全球最大的网上贸易市场。

良好的定位,稳固的结构,优秀的服务使A成为全球首家拥有210万商人的电子商务网站,成为全球商人网络推广的首选网站,被商人们评为"最受欢迎的B2B网站"。

四次被美国权威财经杂志《福布斯》选为全球最佳B2B站点之一,多次被相关机构评为全球最受欢迎的B2B网站、中国商务类优秀网站、中国百家优秀网站、中国最佳贸易网,被国内外媒体、硅谷和国外风险投资家誉为与Yahoo,Amazon,eBay,AOL比肩的五大互联网商务流派代表之一。

二、客户需求在网络建设的初期,A网站的服务器集群位于美国的数据中心,提供集中式的在线服务。

随着Internet 网络及用户的飞速发展,A在用户越来越多,公司盈利健康增长的同时,面临的问题越来越显著的表现在以下几个方面:如何保证客户服务的稳定性。

很直接的一个问题是,一旦美国访问入口的服务器集群停止工作或美国方面的ISP服务中断,如何保证B-to-B的服务始终在线呢?这将直接关系到A网站在客户中的信誉和公司的受益。

如何为客户提供最及时的响应。

所有用户都必须访问美国站点,无论是用户位于中国、亚洲其它国家还是其它大洲的国家。

虽然现在的网络状况越来越好,但是仍旧无法保证客户得到最及时的响应。

美国站点的负载也会不断增长。

而用户始终会越来越挑剔,响应因此必须通过更快的响应速度来满足客户的需求。

网络安全。

越知名和盈利越高的网站往往更容易受到黑客的恶意攻击,特别是危害极大的DOS和DDOS攻击。

因此,交换级别的安全服务和攻击防范能力是网站及客户急需的服务之一。

因此,A急需建立世界范围内的CDN(Content Delivery Network)网络,在保证客户服务稳定的基础上提供最快、最佳的响应,并同时确保网站安全,免于遭受DOS/DDOS攻击的侵害。

A10 链路负载均衡解决方案1. 概述由于国内各运营商之间的互联互通一直存在很大的问题,采用运营商自身单条互联网出口,在为用户提供IDC主机托管服务和大客户专线接入服务时,会遇到用户抱怨访问速度差的问题。

同时,单条链路本身存在单点故障问题。

因此,通过在多个数据中心分别拉不同运营商的线路或者同一数据中心或公司网络出口采用多条互联网链路并使用专门的负载均衡设备智能选择最佳链路成为提高服务水平和用户满意度的一种有效方式,我们把多数据中心负载均衡和多链路负载均衡统称为全局负载均衡或者广域网负载均衡。

2. 需求描述对于全局和链路负载均衡,需要解决两种流量类型的负载均衡以及容灾问题:入向流量(Inbound Traffic):从Internet上的客户端发起,到数据中心内部的应用服务的流量。

如:Internet上用户访问企业Web网站。

对于入向流量,需要根据当前网络延时、就近性等因素,来判断哪一条链路可以对外部用户提供最佳的访问服务。

出向流量(Outbound Traffic):从内部网络发起的,对Internet上应用资源的访问。

如:内部局域网用户访问Internet上Web网站应用。

对于出向流量,需要根据当前链路的就近行、负载情况、和应用服务的重要性等选择最佳的链路。

容灾:多数据中心除了可以提高服务质量之外,另外一个重要的目的就是容灾,当一个数据中心出现故障,将所有用户访问由灾备数据中心来处理。

3. A10 LLB 负载均衡解决方案3.1. 出向流量链路负载均衡(Outbound LLB )相对于入向流量的链路负载均衡,出向流量的链路负载均衡则比较简单。

当内部用户发起对外界的访问请求时,链路负载均衡控制器根据链路选择算法选择合适的链路,并对内部用户的IP 地址进行NAT 转换。

出向负载均衡是对每个数据中心内部的机器来而言的,通过放置在每个数据中心出口位置的AX 来实现。

WebClientLLB ControllerISP_A LinkISP_B LinkInternetPrivate IP: 192.168.1.10图例 3 采用LLB的Outbound访问实例如图例3所示,内部局域网用户访问外部Web网站时,链路负载均衡控制器的处理过程如下:内部局域网用户在浏览器输入要访问网站的域名,根据DNS返回的域名解析结果,发起对外部服务器的访问请求。

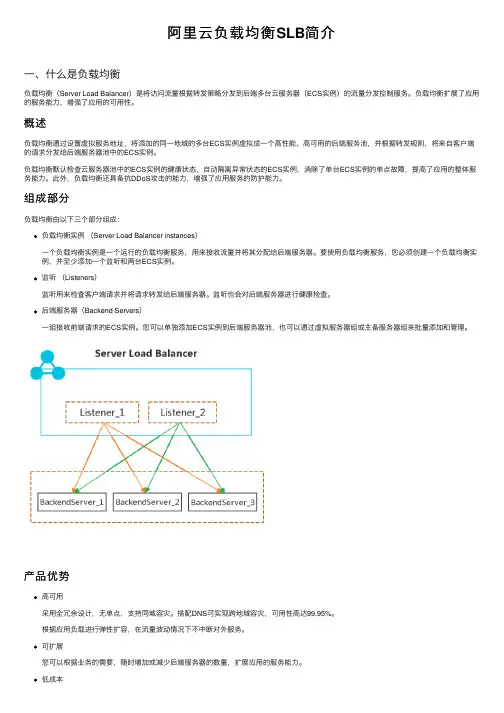

阿⾥云负载均衡SLB简介⼀、什么是负载均衡负载均衡(Server Load Balancer)是将访问流量根据转发策略分发到后端多台云服务器(ECS实例)的流量分发控制服务。

负载均衡扩展了应⽤的服务能⼒,增强了应⽤的可⽤性。

概述负载均衡通过设置虚拟服务地址,将添加的同⼀地域的多台ECS实例虚拟成⼀个⾼性能、⾼可⽤的后端服务池,并根据转发规则,将来⾃客户端的请求分发给后端服务器池中的ECS实例。

负载均衡默认检查云服务器池中的ECS实例的健康状态,⾃动隔离异常状态的ECS实例,消除了单台ECS实例的单点故障,提⾼了应⽤的整体服务能⼒。

此外,负载均衡还具备抗DDoS攻击的能⼒,增强了应⽤服务的防护能⼒。

组成部分负载均衡由以下三个部分组成:负载均衡实例(Server Load Balancer instances)⼀个负载均衡实例是⼀个运⾏的负载均衡服务,⽤来接收流量并将其分配给后端服务器。

要使⽤负载均衡服务,您必须创建⼀个负载均衡实例,并⾄少添加⼀个监听和两台ECS实例。

监听(Listeners)监听⽤来检查客户端请求并将请求转发给后端服务器。

监听也会对后端服务器进⾏健康检查。

后端服务器(Backend Servers)⼀组接收前端请求的ECS实例。

您可以单独添加ECS实例到后端服务器池,也可以通过虚拟服务器组或主备服务器组来批量添加和管理。

产品优势⾼可⽤采⽤全冗余设计,⽆单点,⽀持同城容灾。

搭配DNS可实现跨地域容灾,可⽤性⾼达99.95%。

根据应⽤负载进⾏弹性扩容,在流量波动情况下不中断对外服务。

可扩展您可以根据业务的需要,随时增加或减少后端服务器的数量,扩展应⽤的服务能⼒。

低成本与传统硬件负载均衡系统⾼投⼊相⽐,成本可下降60%。

安全结合云盾,可提供5Gbps的防DDoS攻击能⼒。

⾼并发集群⽀持亿级并发连接,单实例提供千万级并发能⼒。

⼆、产品架构负载均衡基础架构是采⽤集群部署,提供四层(TCP协议和UDP协议)和七层(HTTP和HTTPS协议)的负载均衡,可实现会话同步,以消除服务器单点故障,提升冗余,保证服务的稳定性。

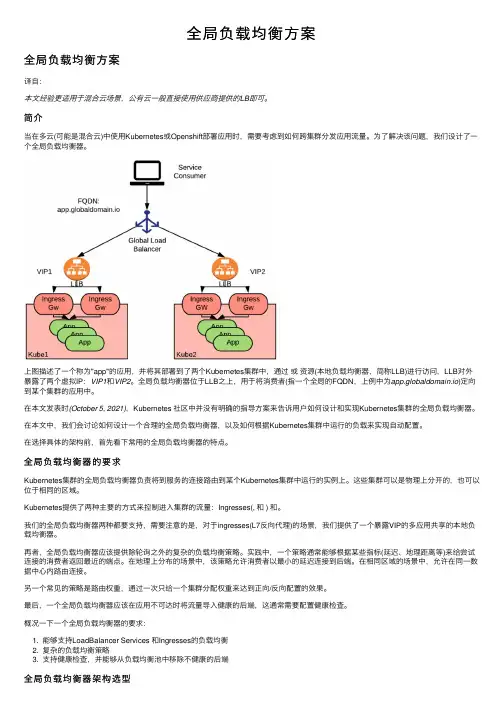

全局负载均衡⽅案全局负载均衡⽅案译⾃:本⽂经验更适⽤于混合云场景,公有云⼀般直接使⽤供应商提供的LB即可。

简介当在多云(可能是混合云)中使⽤Kubernetes或Openshift部署应⽤时,需要考虑到如何跨集群分发应⽤流量。

为了解决该问题,我们设计了⼀个全局负载均衡器。

上图描述了⼀个称为"app"的应⽤,并将其部署到了两个Kubernetes集群中,通过或资源(本地负载均衡器,简称LLB)进⾏访问,LLB对外暴露了两个虚拟IP:VIP1和VIP2。

全局负载均衡器位于LLB之上,⽤于将消费者(指⼀个全局的FQDN,上例中为app.globaldomain.io)定向到某个集群的应⽤中。

在本⽂发表时(October 5, 2021),Kubernetes 社区中并没有明确的指导⽅案来告诉⽤户如何设计和实现Kubernetes集群的全局负载均衡器。

在本⽂中,我们会讨论如何设计⼀个合理的全局负载均衡器,以及如何根据Kubernetes集群中运⾏的负载来实现⾃动配置。

在选择具体的架构前,⾸先看下常⽤的全局负载均衡器的特点。

全局负载均衡器的要求Kubernetes集群的全局负载均衡器负责将到服务的连接路由到某个Kubernetes集群中运⾏的实例上。

这些集群可以是物理上分开的,也可以位于相同的区域。

Kubernetes提供了两种主要的⽅式来控制进⼊集群的流量:Ingresses(, 和 ) 和。

我们的全局负载均衡器两种都要⽀持,需要注意的是,对于ingresses(L7反向代理)的场景,我们提供了⼀个暴露VIP的多应⽤共享的本地负载均衡器。

再者,全局负载均衡器应该提供除轮询之外的复杂的负载均衡策略。

实践中,⼀个策略通常能够根据某些指标(延迟、地理距离等)来给尝试连接的消费者返回最近的端点。

在地理上分布的场景中,该策略允许消费者以最⼩的延迟连接到后端。

在相同区域的场景中,允许在同⼀数据中⼼内路由连接。

为了提高服务器的性能和工作负载能力,天互云计算通常会使用DNS服务器、网络地址转换等技术来实现多服务器负载均衡,特别是目前企业对外的互联网Web 网站,许多都是通过几台服务器来完成服务器访问的负载均衡。

目前企业使用的所谓负载均衡服务器,实际上它是应用系统的一种控制服务器,所有用户的请求都首先到此服务器,然后由此服务器根据各个实际处理服务器状态将请求具体分配到某个实际处理服务器中,对外公开的域名与IP地址都是这台服务器。

负载均衡控制与管理软件安装在这台服务器上,这台服务器一般只做负载均衡任务分配,但不是实际对网络请求进行处理的服务器。

一、企业实现Web服务器负载均衡为了将负载均匀的分配给内部的多个服务器上,就需要应用一定的负载均衡策略。

通过服务器负载均衡设备实现各服务器群的流量动态负载均衡,并互为冗余备份。

并要求新系统应有一定的扩展性,如数据访问量继续增大,可再添加新的服务器加入负载均衡系统。

对于WEB服务应用,同时有几台机器提供服务,每台机器的状态可以设为regular(正常工作)或backup(备份状态),或者同时设定为regular状态。

负载均衡设备根据管理员事先设定的负载算法和当前网络的实际的动态的负载情况决定下一个用户的请求将被重定向到的服务器。

而这一切对于用户来说是完全透明的,用户完成了对WEB服务的请求,并不用关心具体是哪台服务器完成的。

二、使用网络地址转换实现多服务器负载均衡支持负载均衡的地址转换网关中可以将一个外部IP地址映射为多个内部IP地址,对每次TCP连接请求动态使用其中一个内部地址,达到负载均衡的目的。

很多硬件厂商将这种技术集成在他们的交换机中,作为他们第四层交换的一种功能来实现,一般采用随机选择、根据服务器的连接数量或者响应时间进行选择的负载均衡策略来分配负载。

然而硬件实现的负载控制器灵活性不强,不能支持更优化的负载均衡策略和更复杂的应用协议。

基于网络地址转换的负载均衡器可以有效的解决服务器端的CPU和磁盘I/O负载,然而负载均衡器本身的性能受网络I/O的限制,在一定硬件条件下具有一定的带宽限制,但可以通过改善算法和提高运行负载均衡程序的硬件性能,来提高这个带宽限制。

灾备数据中心全局负载测试方案目录第1章测试背景 (1)第2章测试部署描述 (2)第3章应用交付AD测试情况汇报 (3)3.1设备运行实时信息 (3)3.1.1链路状态信息 (3)3.1.2节点池状态信息 (4)3.1.3全局负载状态 (4)3.2链路负载测试效果 (5)3.3应用负载测试效果 (7)3.4全局负载测试效果 (8)3.5商业决策分析(用户地域) (9)3.6系统访问高峰期测试情况 (9)第4章测试总结 (10)第1章测试背景XX公司是马来西亚完美资源有限公司于1994年在广东省中山市投资设立的侨资企业,2006年12月1日经国家商务部批准在广东省开展直销业务,销售保健食品、化妆品和保洁用品。

随着公司业务增长,人员规模扩大,分支机构(专卖店)分布于全国各地,而专卖店的日常运作对贵公司信息化应用系统依赖性越来越强,如何保障这些关键业务系统能够不间断运行、快速交付已经成为信息化建设的重点目标。

完美公司目前在中山已经建设了数据中心,并且也采用了相关的冗余保护机制,但是单个数据中心仍然会因为不可抗拒原因造成系统访问中断,重则导致数据丢失。

因此,本次数据中心容灾建设项目,目的在于实现数据的异地灾备,用户就近性进入,保证专卖店访问的快速性和持续性。

而测试深信服应用交付AD主要从以下三个方面来进行:1、中山数据中心互联网出口连接双链路(电信和联通),DMZ区域对外发布的门户网站系统、电子商务系统和邮件系统都通过多台服务器承载,为了保障链路和服务器资源充分利用及故障切换,因此需要测试双链路入站负载均衡和应用系统负载均衡功能。

2、为了保障在中山数据中心站点出现灾难性故障情况下,自动引导专卖店去访问扬州数据中心(电信接入)的电子商务系统,而且整个过程中对于专卖店来说是透明的,因此需要在双数据中心情况下测试全局负载的功能。

3、虽然现在的数据中心已部署了两条运营商的链路,然而专卖店用户遍布全国各地,有些由于使用了非主流运营商线路,有些网络质量本身很差,导致他们在访问电子商务系统的时候还是体验很慢。

f5 gslb例子F5 GSLB例子什么是F5 GSLB?全局负载均衡(Global Server Load Balancing,简称GSLB)是一种网络服务,通过将流量在多个数据中心之间分布,提高应用程序的性能、可用性和可靠性。

F5 GSLB是一种GSLB解决方案,由F5 Networks提供。

例子1:多数据中心负载均衡问题描述假设有一家跨国公司,在北美、欧洲和亚太地区各有一个数据中心,每个数据中心都托管着公司的应用程序。

公司希望实现跨地理位置的负载均衡,以确保用户能够快速访问到最近的数据中心。

解决方案公司可以部署F5 GSLB设备在每个数据中心的边界,这些设备一起构成一个GSLB集群。

每个设备都监控和测量不同地理位置的用户的访问请求。

当用户发送请求时,GSLB设备根据用户的位置和预定义的策略,将用户的流量分配给最近的数据中心。

实际操作1.在北美、欧洲和亚太各个数据中心部署F5 GSLB设备。

2.配置GSLB设备集群,确保设备之间有始终可靠的通信。

3.设置GSLB设备的IP地址和域名信息。

4.配置GSLB设备的负载均衡策略,例如基于地理位置。

5.监控和优化GSLB设备的性能和流量分配。

例子2:容灾和故障恢复问题描述某家电子商务网站在数据中心A部署了核心应用服务器,但由于某种原因导致数据中心A暂时不可用。

该网站希望能够快速切换到备用数据中心B,并让用户无感知地访问网站。

解决方案通过部署F5 GSLB设备,该网站可以实现自动的容灾和故障恢复。

GSLB设备可以监视数据中心的运行状况,并在检测到故障时,将流量转发到备用数据中心。

实际操作1.在数据中心A和B分别部署F5 GSLB设备。

2.配置GSLB设备的监控设置,例如心跳检测、汇报频率等。

3.设置GSLB设备的故障恢复策略,例如超时时间、重试次数等。

4.配置GSLB设备的故障转移策略,例如优先级、权重等。

5.监控GSLB设备的运行状态,确保故障时能够快速切换并恢复服务。

全局负载均衡(GSLB)

Global Server Load Balancing

全局负载均衡

SLB(Server load balancing)是对集群内物理主机的负载均衡,⽽GSLB是对物理集群的负载均衡。

这⾥的负载均衡可能不只是简单的流量均匀分配,⽽是会根据策略的不同实现不同场景的应⽤交付。

做到全局负载均衡的原因:

⾼可⽤性

更快的响应时间

多版本分发

具体:

1、(灾难恢复)Disater recovery,发⽣故障时提供⼀个备⽤的位置来获取资源或者能提供可简易调整流量的装置,或两者都能提供。

2、(流量分发)Load sharing,基于多个地理位置的流量分发,可以做到:

a.尽量节省带宽

b.限制给定位置的能⼒

c.限制暴露断电,地理灾害等问题

3、(资源性能)Performance,将资源置于离⽤户更近的地⽅,增强⽤户体验。

4、(灰度)多版本,根据本地政策提供不同版本的资源,或者根据⾃定义的规则提供为特殊⽤户提供特殊版本,如灰度交付等。