模式识别试题2

- 格式:doc

- 大小:58.00 KB

- 文档页数:3

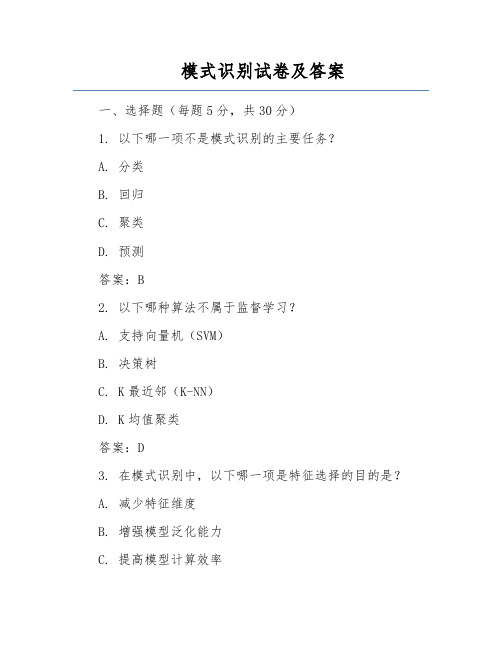

模式识别试卷及答案一、选择题(每题5分,共30分)1. 以下哪一项不是模式识别的主要任务?A. 分类B. 回归C. 聚类D. 预测答案:B2. 以下哪种算法不属于监督学习?A. 支持向量机(SVM)B. 决策树C. K最近邻(K-NN)D. K均值聚类答案:D3. 在模式识别中,以下哪一项是特征选择的目的是?A. 减少特征维度B. 增强模型泛化能力C. 提高模型计算效率D. 所有上述选项答案:D4. 以下哪种模式识别方法适用于非线性问题?A. 线性判别分析(LDA)B. 主成分分析(PCA)C. 支持向量机(SVM)D. 线性回归答案:C5. 在神经网络中,以下哪种激活函数常用于输出层?A. SigmoidB. TanhC. ReLUD. Softmax答案:D6. 以下哪种聚类算法是基于密度的?A. K均值聚类B. 层次聚类C. DBSCAND. 高斯混合模型答案:C二、填空题(每题5分,共30分)1. 模式识别的主要任务包括______、______、______。

答案:分类、回归、聚类2. 在监督学习中,训练集通常分为______和______两部分。

答案:训练集、测试集3. 支持向量机(SVM)的基本思想是找到一个______,使得不同类别的数据点被最大化地______。

答案:最优分割超平面、间隔4. 主成分分析(PCA)是一种______方法,用于降维和特征提取。

答案:线性变换5. 神经网络的反向传播算法用于______。

答案:梯度下降6. 在聚类算法中,DBSCAN算法的核心思想是找到______。

答案:密度相连的点三、简答题(每题10分,共30分)1. 简述模式识别的基本流程。

答案:模式识别的基本流程包括以下几个步骤:(1)数据预处理:对原始数据进行清洗、标准化和特征提取。

(2)模型选择:根据问题类型选择合适的模式识别算法。

(3)模型训练:使用训练集对模型进行训练,学习数据特征和规律。

模式识别期末考试题及答案一、选择题(每题2分,共20分)1. 以下哪一项不是模式识别的主要任务?A. 分类B. 回归C. 聚类D. 预测答案:B2. 以下哪一种方法不属于统计模式识别方法?A. 最小二乘法B. 感知机C. 支持向量机D. 决策树答案:A3. 在模式识别中,以下哪种技术用于降低特征维度?A. 主成分分析(PCA)B. 线性判别分析(LDA)C. 神经网络D. K-均值聚类答案:A4. 以下哪一种模式识别方法适用于非线性问题?A. 线性判别分析(LDA)B. 支持向量机(SVM)C. 主成分分析(PCA)D. K-最近邻(K-NN)答案:B5. 以下哪一项不是模式识别的评价指标?A. 准确率B. 精确率C. 召回率D. 信息熵答案:D二、填空题(每题2分,共20分)6. 模式识别的主要任务包括分类、回归、聚类和________。

答案:预测7. 统计模式识别方法包括最小二乘法、感知机、________和决策树。

答案:支持向量机8. 主成分分析(PCA)的主要目的是________特征。

答案:降低维度9. 在模式识别中,________用于将样本分为不同的类别。

答案:分类器10. 支持向量机(SVM)的基本思想是找到一个________,使得不同类别的样本之间的间隔最大化。

答案:最优分割超平面三、简答题(每题10分,共30分)11. 请简述模式识别的主要步骤。

答案:(1)数据预处理:对原始数据进行清洗、标准化和降维等处理。

(2)特征提取:从原始数据中提取有助于分类的特征。

(3)模型训练:使用训练集对分类器进行训练。

(4)模型评估:使用测试集对分类器的性能进行评估。

(5)模型优化:根据评估结果对模型进行调整和优化。

12. 请简述支持向量机(SVM)的基本原理。

支持向量机是一种二分类模型,其基本思想是找到一个最优分割超平面,使得不同类别的样本之间的间隔最大化。

SVM通过求解一个凸二次规划问题来寻找最优分割超平面,从而实现分类任务。

模式识别第二章2. K-均值分类算法1. 实验原理和步骤以初始化聚类中心为1x 和10x 为例。

第一次迭代:第一步:取K=2,并选T x z )00()1(11==,T x z )67()1(102==。

第二步:因)1()1(2111z x z x -<-,故)1(11S x ∈因)1()1(2212z x z x -<-,故)1(12S x ∈因)1()1(2313z x z x -<-,故)1(13S x ∈……得到:},,,,,,,{)1(876543211x x x x x x x x S =},,,,,,,,,,,{)1(201918171615141312111092x x x x x x x x x x x x S =。

第三步:计算新的聚类中心:⎪⎪⎭⎫ ⎝⎛=+⋯⋯++==∑∈125.1250.1)(811)2(821)1(111x x x x N z S x ⎪⎪⎭⎫ ⎝⎛=+⋯⋯++==∑∈333.7663.7)(1211)2(20109)1(222x x x x N z S x (1N 和2N 分别为属于第一类和第二类的样本的数目)。

第四步:因)2()1(z z ≠,返回第二步。

第二次迭代(步骤同上):第二次迭代得到的⎪⎪⎭⎫ ⎝⎛=125.1250.1)3(1z ,⎪⎪⎭⎫ ⎝⎛=333.7663.7)3(2z ,)3()2(z z ≠,结束迭代,得到的最终聚类中心为:⎪⎪⎭⎫ ⎝⎛=125.1250.11z ,⎪⎪⎭⎫ ⎝⎛=333.7663.72z 。

2. 实验结果截图(1)初始化聚类中心为1x 和10x 时:(2)初始化聚类中心为1x 和2x 时:(3)初始化聚类中心为12x 和20x 时:3. 程序代码%程序功能:实现K-均值分类%作者:赵晓梅 201428014628066%时间:2014.10.3clc;clear all ;fprintf('K-均值分类算法\n');k=0;%记录迭代次数x=[0,0;1,0;0,1;1,1;2,1;1,2;2,2;3,2;6,6;7,6;8,6;6,7;7,7;8,7;9,7;7,8;8,8;9,8;8,9;9,9];%输入样本[N n]=size(x);%N 表示样本数目;n 表示样本维度m=[12,20];z=[x(m(1),:);x(m(2),:)];%初始化聚类中心fprintf('初始聚类中心选:x%d 和x%d\n',m(1),m(2));%显示初始化聚类中心 D=size(z);K=D(1);%获取聚类数目d=zeros(1,K);%用于保存一个样本到K 个聚类中心的距离label=zeros(1,N);%用于标记每个样本属于哪个类,取值为1-K 之间的整数flag_end=0;%迭代结束标志,当为1时,迭代结束while(~flag_end)for i=1:Nfor j=1:Kd(j)=norm(x(i,:)-z(j,:));%计算第i个样本到第j个聚类中心的距离endmin_d=d(1);for j=1:Kif d(j)<=min_d%选取最短的距离,并用最短距离的索引标记样本,记样本为第j类min_d=d(j);label(i)=j;endendendz_new=zeros(K,n);%用于保存更新的聚类中心的坐标for j=1:K%更新聚类中心坐标num=0;for i=1:Nif label(i)==jz_new(j,:)=z_new(j,:)+x(i,:);num=num+1;endendz_new(j,:)=z_new(j,:)/num;%新的聚类中心的坐标为第j类样本的均值向量endif z==z_new%如果原聚类中心与更新的聚类中心相等,则迭代结束,迭代结束标志置1 flag_end=1;endz=z_new;k=k+1;%迭代次数加1endfprintf('经过 %d次迭代\n',k);%显示迭代次数for j=1:Kfprintf('第 %d类的聚类中心坐标为:(%f,%f)\n',j,z(j,1),z(j,2));%显示聚类中心坐标end。

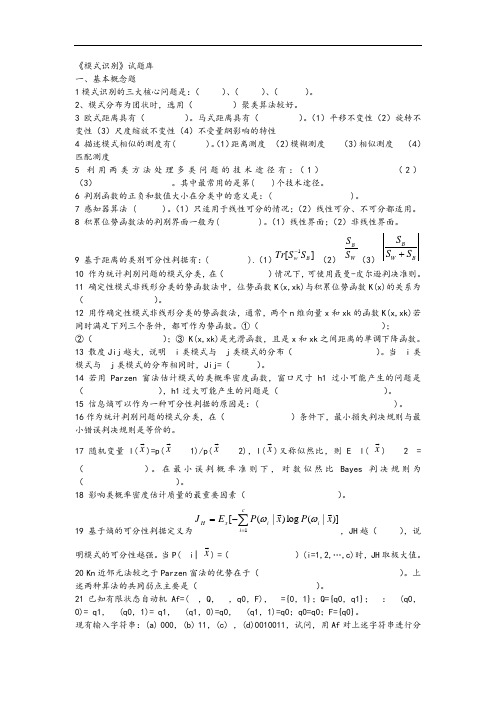

《模式识别》试题库一、基本概念题 1模式识别的三大核心问题是:( )、( )、( )。

2、模式分布为团状时,选用( )聚类算法较好。

3 欧式距离具有( )。

马式距离具有( )。

(1)平移不变性(2)旋转不变性(3)尺度缩放不变性(4)不受量纲影响的特性4 描述模式相似的测度有( )。

(1)距离测度 (2)模糊测度 (3)相似测度 (4)匹配测度5 利用两类方法处理多类问题的技术途径有:(1) (2)(3) 。

其中最常用的是第( )个技术途径。

6 判别函数的正负和数值大小在分类中的意义是:( )。

7 感知器算法 ( )。

(1)只适用于线性可分的情况;(2)线性可分、不可分都适用。

8 积累位势函数法的判别界面一般为( )。

(1)线性界面;(2)非线性界面。

9 基于距离的类别可分性判据有:( ).(1)1[]w B Tr S S - (2) BW S S (3) B W B S S S +10 作为统计判别问题的模式分类,在( )情况下,可使用聂曼-皮尔逊判决准则。

11 确定性模式非线形分类的势函数法中,位势函数K(x,xk)与积累位势函数K(x)的关系为( )。

12 用作确定性模式非线形分类的势函数法,通常,两个n 维向量x 和xk 的函数K(x,xk)若同时满足下列三个条件,都可作为势函数。

①( );②( );③ K(x,xk)是光滑函数,且是x 和xk 之间距离的单调下降函数。

13 散度Jij 越大,说明i 类模式与j 类模式的分布( )。

当i 类模式与j 类模式的分布相同时,Jij=( )。

14 若用Parzen 窗法估计模式的类概率密度函数,窗口尺寸h1过小可能产生的问题是( ),h1过大可能产生的问题是( )。

15 信息熵可以作为一种可分性判据的原因是:( )。

16作为统计判别问题的模式分类,在( )条件下,最小损失判决规则与最小错误判决规则是等价的。

17 随机变量l(x )=p(x 1)/p(x 2),l(x )又称似然比,则E l( x )2=( )。

模式识别习题及答案模式识别习题及答案【篇一:模式识别题目及答案】p> t,方差?1?(2,0)-1/2??11/2??1t,第二类均值为,方差,先验概率??(2,2)?122???1??1/21??-1/2p(?1)?p(?2),试求基于最小错误率的贝叶斯决策分界面。

解根据后验概率公式p(?ix)?p(x?i)p(?i)p(x),(2’)及正态密度函数p(x?i)?t(x??)?i(x??i)/2] ,i?1,2。

(2’) i?1基于最小错误率的分界面为p(x?1)p(?1)?p(x?2)p(?2),(2’) 两边去对数,并代入密度函数,得(x??1)t?1(x??1)/2?ln?1??(x??2)t?2(x??2)/2?ln?2(1) (2’)1?14/3-2/3??4/32/3??1由已知条件可得?1??2,?1,?2??2/34/3?,(2’)-2/34/31设x?(x1,x2)t,把已知条件代入式(1),经整理得x1x2?4x2?x1?4?0,(5’)二、(15分)设两类样本的类内离散矩阵分别为s1??11/2?, ?1/21?-1/2??1tt,各类样本均值分别为?1?,?2?,试用fisher准(1,0)(3,2)s2-1/21??(2,2)的类别。

则求其决策面方程,并判断样本x?解:s?s1?s2??t20?(2’) ??02?1/20??-2??-1?*?1w?s()?投影方向为12?01/22?1? (6’) ???阈值为y0?w(?1??2)/2??-1-13 (4’)*t2?1?给定样本的投影为y?w*tx??2-1?24?y0,属于第二类(3’) ??1?三、(15分)给定如下的训练样例实例 x0 x1 x2 t(真实输出) 1 1 1 1 1 2 1 2 0 1 3 1 0 1 -1 4 1 1 2 -1用感知器训练法则求感知器的权值,设初始化权值为w0?w1?w2?0;1 第1次迭代2 第2次迭代(4’)(2’)3 第3和4次迭代四、(15分)i. 推导正态分布下的最大似然估计;ii. 根据上步的结论,假设给出如下正态分布下的样本,估计该部分的均值和方差两个参数。

1 .简述模式的概念及其直观特性,模式识别的分类,有哪几种方法。

(6')答(1):什么是模式?广义地说,存在于时间和空间中可观察的物体,如果我们可以区别它们是否相同或是否相似,都可以称之为模式。

模式所指的不是事物本身,而是从事物获得的信息,因此,模式往往表现为具有时间和空间分布的信息。

模式的直观特性:可观察性;可区分性;相似性.答(2):模式识别的分类:假说的两种获得方法(模式识别进行学习的两种方法):•监督学习、概念驱动或归纳假说:•非监督学习、数据驱动或演绎假说。

模式分类的主要方法:•数据聚类:用某种相似性度量的方法将原始数据组织成有意义的和有用的各种数据集。

是一种非监督学习的方法,解决方案是数据驱动的。

•统计分类:基于概率统计模型得到各类别的特征向量的分布,以取得分类的方法。

特征向量分布的获得是基于一个类别已知的训练样本集。

是一种监督分类的方法,分类器是概念驱动的。

•结构模式识别:该方法通过考虑识别对象的各部分之间的联系来达到识别分类的目的。

(句法模式识别)•神经网络:由一系列互相联系的、相同的单元(神经元)组成。

相互间的联系可以在不同的神经元之间传递增强或抑制信号。

增强或抑制是通过调整神经元相互间联系的权重系数来(weight)实现。

神经网络可以实现监督和非监督学习条件下的分类。

2.什么是神经网络?有什么主要特点?选择神经网络模式应该考虑什么因素?(8,)•(1 ):所谓△工神经网络就是基于模仿生物大脑的结构和功能而构成的二种值息处理系统计算机Z由于我们建立的信息处理系统实际上是模仿生理神经网络, 的复杂程度,通过调整内部大量节点之间相互连接的关系, 人工神经网络的两种操作过程:训练学习、正常操作答(2):人工神经网络的特点:•固有的并行结构和并行处理;•知识的分布存储,•有较强的容错性,•有一定的自适应性,人工神经网络的局限性:•人工神经网络不适于高精度的计算;•人工神经网络不适于做类似顺序计数的工作;•人工神经网络的学习和训练往往是一个艰难的过程;•人工神经网络必须克服时间域顺序处理方面的困难;•硬件限制:•正确的训练数据的收集。

《模式识别》试题库一、基本概念题1模式识别的三大核心问题是:( )、( )、( )。

2、模式分布为团状时,选用( )聚类算法较好。

3 欧式距离具有( )。

马式距离具有( )。

(1)平移不变性(2)旋转不变性(3)尺度缩放不变性(4)不受量纲影响的特性4 描述模式相似的测度有( )。

(1)距离测度 (2)模糊测度 (3)相似测度 (4)匹配测度5 利用两类方法处理多类问题的技术途径有:(1) (2)(3) 。

其中最常用的是第( )个技术途径。

6 判别函数的正负和数值大小在分类中的意义是:( )。

7 感知器算法 ( )。

(1)只适用于线性可分的情况;(2)线性可分、不可分都适用。

8 积累位势函数法的判别界面一般为( )。

(1)线性界面;(2)非线性界面。

9 基于距离的类别可分性判据有:( ).(1)1[]w B Tr S S - (2) BW S S (3) B W B S S S +10 作为统计判别问题的模式分类,在( )情况下,可使用聂曼-皮尔逊判决准则。

11 确定性模式非线形分类的势函数法中,位势函数K(x,xk)与积累位势函数K(x)的关系为( )。

12 用作确定性模式非线形分类的势函数法,通常,两个n 维向量x 和xk 的函数K(x,xk)若同时满足下列三个条件,都可作为势函数。

①( );②( );③ K(x,xk)是光滑函数,且是x 和xk 之间距离的单调下降函数。

13 散度Jij 越大,说明ωi 类模式与ωj 类模式的分布( )。

当ωi 类模式与ωj 类模式的分布相同时,Jij=( )。

14 若用Parzen 窗法估计模式的类概率密度函数,窗口尺寸h1过小可能产生的问题是( ),h1过大可能产生的问题是( )。

15 信息熵可以作为一种可分性判据的原因是:( )。

16作为统计判别问题的模式分类,在( )条件下,最小损失判决规则与最小错误判决规则是等价的。

17 随机变量l(x ρ)=p(x ρ|ω1)/p(x ρ|ω2),l(x ρ)又称似然比,则E {l( x ρ)|ω2}=( )。

在最小误判概率准则下,对数似然比Bayes 判决规则为( )。

18 影响类概率密度估计质量的最重要因素( )。

19 基于熵的可分性判据定义为)]|(log )|([1x P x P E J i c i i x H ρρωω∑=-=,JH 越( ),说明模式的可分性越强。

当P(ωi| x ρ) =( )(i=1,2,…,c)时,JH 取极大值。

20 Kn 近邻元法较之于Parzen 窗法的优势在于( )。

上述两种算法的共同弱点主要是( )。

21 已知有限状态自动机Af=(∑,Q ,δ,q0,F),∑={0,1};Q={q0,q1};δ:δ(q0,0)= q1,δ(q0,1)= q1,δ(q1,0)=q0,δ(q1,1)=q0;q0=q0;F={q0}。

现有输入字符串:(a) 00011101011,(b) 1100110011,(c) 101100111000,(d)0010011,试问,用Af 对上述字符串进行分类的结果为( )。

22 句法模式识别中模式描述方法有:( )。

(1)符号串 (2)树 (3)图 (4)特征向量23设集合X={a,b,c,d }上的关系,R={(a,a),(a,b),(a,d),(b,b),(b,a),(b,d),(c,c),(d,d),(d,a),(d,b)},则a,b,c,d 生成的R 等价类分别为( [a]R= ,[b]R= ,[c]R= [d]R= )。

24 如果集合X 上的关系R 是传递的、( )和( )的,则称R 是一个等价关系。

25一个模式识别系统由那几部分组成?画出其原理框图。

26 统计模式识别中,模式是如何描述的。

27 简述随机矢量之间的统计关系:不相关,正交,独立的定义及它们之间的关系。

28 试证明,对于正态分布,不相关与独立是等价的。

29 试证明,多元正态随机矢量的线性变换仍为多元正态随机矢量。

30 试证明,多元正态随机矢量X ρ的分量的线性组合是一正态随机变量。

第二部分 分析、证明、计算题第二章 聚类分析2.1 影响聚类结果的主要因素有那些?2.2 马氏距离有那些优点?2.3 如果各模式类呈现链状分布,衡量其类间距离用最小距离还是用最大距离?为什么?2.4 动态聚类算法较之于简单聚类算法的改进之处何在?层次聚类算法是动态聚类算法吗?比较层次聚类算法与c-均值算法的优劣。

2.5 ISODATA 算法较之于c-均值算法的优势何在?2.9 (1)设有M 类模式ωi ,i=1,2,...,M ,试证明总体散布矩阵ST 是总类内散布矩阵SW 与类间散布矩阵SB 之和,即ST =SW +SB 。

(2)设有二维样本:x1=(-1,0)T ,x2=(0,-1)T ,x3=(0,0)T ,x4=(2,0)T 和x5=(0,2)T 。

试选用一种合适的方法进行一维特征特征提取yi = WTxi 。

要求求出变换矩阵W ,并求出变换结果yi ,(i=1,2,3,4,5)。

(3)根据(2)特征提取后的一维特征,选用一种合适的聚类算法将这些样本分为两类,要求每类样本个数不少于两个,并写出聚类过程。

2.10 (1)试给出c-均值算法的算法流程图;(2)试证明c-均值算法可使误差平方和准则∑∑∈=--=)()()()()(1)(k j i x k j i T k j i c j k z x z x J ωρρρρρ最小。

其中,k 是迭代次数;)(k j z ρ是 )(k j ω的样本均值。

2.12 有样本集}01,55,45,54,44,10,00{⎪⎪⎭⎫ ⎝⎛⎪⎪⎭⎫ ⎝⎛⎪⎪⎭⎫ ⎝⎛⎪⎪⎭⎫ ⎝⎛⎪⎪⎭⎫ ⎝⎛⎪⎪⎭⎫ ⎝⎛⎪⎪⎭⎫ ⎝⎛,试用谱系聚类算法对其分类。

第三章 判别域代数界面方程法3.1 证明感知器算法在训练模式是线性可分的情况下,经过有限次迭代后可以收敛到正确的解矢量*w 。

3.2(1)试给出LMSE 算法(H-K 算法)的算法流程图;(2)试证明X#e(k)=0,这里, X#是伪逆矩阵;e(k)为第k 次迭代的误差向量;(3)已知两类模式样本ω1:x1=(-1,0)T, x2=(1,0)T ;ω2:x3=(0,0)T ,x4=(0,-1)T 。

试用LMSE 算法判断其线性可分性。

3.4 已知二维样本:1x ρ=(-1,0)T , 2x ρ=(0,-1)T ,=(0,0)T , 4x ρ=(2,0)T 和 5x ρ=(0,2)T ,1321},,{ω∈x x x ρρρ, 254},{ω∈x x ρρ。

试用感知器算法求出分类决策函数,并判断 6x ρ=(1,1)T 属于哪一类?3.4. 已知模式样本 x1=(0,0)T,x2=(1,0)T,x3=(-1,1)T 分别属于三个模式类别,即, x1∈ω1,x2∈ω2,x3∈ω3,(1)试用感知器算法求判别函数gi(x),使之满足,若xi ∈ωi 则gi(x)>0,i=1,2,3;(2)求出相应的判决界面方程,并画出解区域的示意图。

给定校正增量因子C=1,初始值可以取:w1(1)=(4,-9,-4)T ,w2(1)=(4,1,-4,)T ,w3(1)=(-4,-1,-6)T 。

3.5 已知ω1:{(0,0)T},ω2:{(1,1)T},ω3:{(-1,1)T}。

用感知器算法求该三类问题的判别函数,并画出解区域。

第四章 统计判决4.1 使用最小最大损失判决规则的错分概率是最小吗?为什么?4.3 假设在某个地区的细胞识别中正常1ω和异常 2ω两类的先验概率分别为 正常状态 :1()0.9P ω= 异常状态:2()0.1P ω=现有一待识的细胞,其观测值为x ,从类条件概率密度分布曲线上查得 12()0.2,()0.4p x p x ω==并且已知损失系数为λ11=0,λ12=1,λ21=6,λ22=0。

试对该细胞以以下两种方法进行分类: ①基于最小错误概率准则的贝叶斯判决;②基于最小损失准则的贝叶斯判决。

请分析两种分类结果的异同及原因。

4.4 试用最大似然估计的方法估计单变量正态分布的均值μ和方差 2σ。

4.5 已知两个一维模式类别的类概率密度函数为⎧ x 0≤x<1 ⎧ x -1 1≤x<2p(x |ω2)=⎨ 3-x 2≤x ≤3 p(x |ω1)=⎨ 2-x 1≤x ≤2⎩ 0 其它 ⎩ 0 其它先验概率P(ω1)=0.6,P(ω2)=0.4,(1)求0-1代价Bayes 判决函数; (2)求总错误概率P(e);(3)判断样本{x1=1.35,x2=1.45,x3=1.55,x4=1.65}各属于哪一类别。

4.16在两类分类问题中,限定其中一类的错分误概率为ε1=ε,证明,使另一类的错分概率ε2最小等价于似然比判决:如果P(ω1)/P(ω2)> θ,则判x ∈ω1,这里,θ是使ε1=ε成立的似然比判决门限。

注:这就是Neyman-Pearson 判决准则, 它类似于贝叶斯最小风险准则。

提示:该问题等价于用Langrange 乘子法,使q=θ(ε1-ε)+ε2最小化。

第五章 特征提取与选择5.1 设有M 类模式ωi ,i=1,2,...,M ,试证明总体散布矩阵St 是总类内散布矩阵Sw 与类间散布矩阵Sb 之和,即St =Sw +Sb 。