回归预测模型论文

- 格式:pdf

- 大小:255.36 KB

- 文档页数:9

回归分析方法范文回归分析是一种用来研究变量之间关系的统计方法,它被广泛应用于各个领域,包括经济、社会科学、医学和工程等。

回归分析可以用来预测一个变量(因变量)如何随着其他变量(自变量)的变化而变化,或者检验变量之间是否存在关联。

在回归分析中,我们通常关注的是因变量和自变量之间的函数关系,可以用以下的线性回归模型来描述:Y=β0+β1*X1+β2*X2+...+βn*Xn+ε其中,Y是因变量,X1,X2,...,Xn是自变量,β0,β1,β2,...,βn 是模型参数(系数),ε是误差项。

回归分析的目标是通过估计这些参数来找到最佳拟合,使得模型对观测数据的解释度最大化。

回归分析的基本步骤包括选择适当的模型、估计模型参数、检验模型显著性和解读结果。

下面将详细介绍每个步骤。

1.选择适当的模型:在回归分析中,有多种模型可供选择,例如简单线性回归、多元线性回归和非线性回归等。

选择适当的模型需要基于理论知识和研究目的,并通过判断模型的合理性和拟合优度进行评估。

2.估计模型参数:通过最小化误差项来估计模型参数。

最常用的估计方法是最小二乘法,它试图找到使残差平方和最小化的参数估计值。

这可以通过计算样本数据的特定统计量来完成,如样本均值、样本方差和样本协方差等。

3.检验模型显著性:回归分析的一个重要目标是确定模型是否显著。

这通常通过检验模型的拟合优度和参数的显著性来完成。

常用的检验方法包括F检验、t检验和R方检验等。

4.解读结果:一旦确认模型的显著性,我们可以解读模型的结果,包括参数估计、拟合优度和预测值等。

参数估计告诉我们自变量对因变量的贡献程度,拟合优度告诉我们模型对数据的解释度,预测值则可以用来进行未来值的推断。

除了基本步骤外,回归分析还有一些常用的扩展方法,如变量选择、模型诊断和回归残差的分布检验等。

在变量选择中,我们可以使用逐步回归、岭回归和Lasso回归等方法来确定哪些自变量对模型具有重要影响。

这可以帮助简化模型,并提高模型的预测能力。

R语言回归模型项目分析报告论文摘要本文旨在介绍并分析一个使用R语言实现的回归模型项目。

该项目主要探究了自变量与因变量之间的关系,并利用R语言的回归模型进行了预测和估计。

本文将首先介绍项目背景和数据来源,接着阐述模型的构建和实现过程,最后对结果进行深入分析和讨论。

一、项目背景和数据来源本项目的目的是探究自变量X1、X2、X3等与因变量Y之间的关系。

为了实现这一目标,我们收集了来自某一领域的实际数据,数据涵盖了多个年份和多个地区的情况。

数据来源主要是公开可用的数据库和相关文献。

在数据处理过程中,我们对缺失值、异常值和重复值进行了适当处理,以保证数据的质量和可靠性。

二、模型构建和实现过程1、数据预处理在构建回归模型之前,我们对数据进行预处理。

我们检查并处理缺失值,采用插值或删除的方法进行处理;我们检测并处理异常值,以防止其对回归模型产生负面影响;我们进行数据规范化,将不同尺度的变量转化为同一尺度,以便于回归分析。

2、回归模型构建在数据预处理之后,我们利用R语言的线性回归函数lm()构建回归模型。

我们将自变量X1、X2、X3等引入模型中,然后通过交叉验证选择最佳的模型参数。

我们还使用了R-squared、调整R-squared、残差标准误差等指标对模型性能进行评价。

3、模型实现细节在构建回归模型的过程中,我们采用了逐步回归法(stepwise regression),以优化模型的性能。

逐步回归法是一种回归分析的优化算法,它通过逐步添加或删除自变量来寻找最佳的模型。

我们还使用了R语言的arima()函数进行时间序列分析,以探究时间序列数据的规律性。

三、结果深入分析和讨论1、结果展示通过R语言的回归模型分析,我们得到了因变量Y与自变量X1、X2、X3等之间的关系。

我们通过表格和图形的方式展示了回归分析的结果,其中包括模型的系数、标准误差、t值、p值等指标。

我们还提供了模型的预测值与实际值之间的比较图,以便于评估模型的性能。

《几个预测方法及模型的研究》篇一一、引言随着科技的发展,预测已经渗透到生活的各个领域。

从天文学到气候学,从金融投资到社会经济发展,预测在多个方面起着关键的作用。

预测不仅仅需要收集大量数据,而且还要依赖于合适的预测方法和模型。

本文将深入探讨几个常用的预测方法及模型。

二、数据驱动的预测方法1. 时间序列分析模型时间序列分析模型是最常用的预测方法之一,常用于金融市场和经济领域等的时间趋势预测。

通过研究数据的变动模式,分析周期性变化等因素,可以对未来数据进行估计。

主要的时间序列分析模型包括ARIMA(自回归移动平均)模型和SARIMA (季节性自回归移动平均)模型等。

2. 回归分析模型回归分析模型是利用一个或多个自变量与因变量之间的关系进行预测。

这种方法可以用于各种领域,如房价预测、销售量预测等。

通过收集历史数据,建立自变量和因变量之间的数学关系,从而对未来进行预测。

三、机器学习模型1. 神经网络模型神经网络是一种模拟人脑神经元网络的算法,常用于处理复杂的非线性问题。

在预测领域,神经网络可以通过学习大量的历史数据,找到输入和输出之间的复杂关系,从而实现较为准确的预测。

2. 支持向量机(SVM)模型支持向量机是一种基于统计理论的机器学习算法,常用于分类和回归问题。

在预测领域,SVM可以用于找到最优的分类边界或回归函数,以实现较高的预测准确率。

四、其他预测方法1. 灰色预测模型灰色预测模型主要用于解决数据不完全或不确定性较高的预测问题。

通过建立灰色微分方程,对数据进行处理和分析,从而得到较为准确的预测结果。

2. 专家系统预测法专家系统预测法是一种基于专家知识和经验的预测方法。

通过收集专家的知识和经验,建立专家系统,然后利用系统进行预测。

这种方法在许多领域都得到了广泛的应用。

五、结论《几个预测方法及模型的研究》篇二一、引言随着科技的飞速发展,预测技术已经成为许多领域中不可或缺的一部分。

从经济预测、天气预报到医学诊断,预测方法及模型的应用日益广泛。

线性回归模型的研究毕业论文1 引言回归分析最早是由19世纪末期高尔顿(Sir Francis Galton)发展的。

1855年,他发表了一篇文章名为“遗传的身高向平均数方向的回归”,分析父母与其孩子之间身高的关系,发现父母的身高越高或的其孩子也越高,反之则越矮。

他把儿子跟父母身高这种现象拟合成一种线性关系。

但是他还发现了个有趣的现象,高个子的人生出来的儿子往往比他父亲矮一点更趋向于平均身高,矮个子的人生出来的儿子通常比他父亲高一点也趋向于平均身高。

高尔顿选用“回归”一词,把这一现象叫做“向平均数方向的回归”。

于是“线形回归”的术语被沿用下来了。

回归分析中,当研究的因果关系只涉及因变量和一个自变量时,叫做一元回归分析;当研究的因果关系涉及因变量和两个或两个以上自变量时,叫做多元回归分析。

此外,回归分析中,又依据描述自变量与因变量之间因果关系的函数表达式是线性的还是非线性的,分为线性回归分析和非线性回归分析。

按照参数估计方法可以分为主成分回归、偏最小二乘回归、和岭回归。

一般采用线性回归分析,由自变量和规定因变量来确定变量之间的因果关系,从而建立线性回归模型。

模型的各个参数可以根据实测数据解。

接着评价回归模型能否够很好的拟合实际数据;如果不能够很好的拟合,则重新拟合;如果能很好的拟合,就可以根据自变量进行下一步推测。

回归分析是重要的统计推断方法。

在实际应用中,医学、农业、生物、林业、金融、管理、经济、社会等诸多方面随着科学的发展都需要运用到这个方法。

从而推动了回归分析的快速发展。

2 回归分析的概述2.1 回归分析的定义回归分析是应用极其广泛的数据分析方法之一。

回归分析(regression analysis)是确定两种或两种以上变数间相互依赖的定量关系的一种统计分析方法。

2.2 回归分析的主要容(1)从一组数据出发,确定某些变量之间的定量关系式,即建立数学模型并估计其中的未知参数。

估计参数的常用方法是最小二乘法。

实用回归分析论文回归分析是一种广泛应用于研究和预测变量关系的统计方法。

它可以用来探索自变量与因变量之间的关系,并根据这些关系进行预测。

本篇论文旨在利用SPSS软件进行回归分析,并解释实验结果。

为了说明回归分析的实用性,本论文以一个假设为例进行讨论。

假设我们想研究其中一种健康饮食对人体血糖水平的影响。

我们能够搜集到500名参与者的相关数据,包括他们的饮食习惯和血糖水平。

在SPSS软件中,我们可以采用多元线性回归模型来探索自变量(饮食习惯)与因变量(血糖水平)之间的关系。

首先,我们需要将数据输入SPSS软件,并进行数据清洗和处理,确保数据的准确性和可靠性。

接下来,我们可以使用回归模型来进行实验结果的分析。

在SPSS软件中,我们可以选择"回归"选项,并指定因变量和自变量。

在这个示例中,我们将血糖水平作为因变量,饮食习惯作为自变量。

SPSS软件会给出回归模型的结果。

其中最重要的指标是相关系数和显著性水平。

相关系数用来衡量自变量与因变量之间的线性关系的强度,取值范围在-1到+1之间。

显著性水平可以告诉我们这个自变量对因变量的解释力是否显著。

通常,显著性水平小于0.05表示相关关系是显著的。

在这个案例中,回归分析的结果显示饮食习惯与血糖水平之间存在显著相关性(相关系数为0.4,显著性水平为0.01)。

这意味着饮食习惯对于解释血糖水平的变异有统计学意义。

我们可以通过这一结果来推测具体的饮食习惯与血糖水平之间的关系,进一步指导实际生活中的健康饮食选择。

此外,在SPSS软件中,我们还可以进行其他的回归分析,如逐步回归和多重回归。

这些方法可以帮助我们确定最佳的自变量组合,以及对因变量的解释力。

逐步回归可用于选择最有意义的自变量,而多重回归可以进一步探索多个自变量对因变量的解释力。

总结起来,回归分析是一种实用的统计方法,可以用来研究和预测变量之间的关系。

使用SPSS软件进行回归分析,可以对实验结果进行详细的解释和推断,从而指导实际生活中的决策和行动。

实用回归分析范文回归分析是一种常用的统计分析方法,用于探索两个或多个变量之间的关系。

通过回归分析,我们可以预测一个因变量(依赖变量)如何随着一个或多个自变量(独立变量)的变化而变化。

回归分析可以帮助我们了解变量之间的关系,并进行预测和决策。

首先,我们需要收集相关变量的数据。

例如,我们想要了解一个人的体重如何与其身高和性别相关,我们需要收集一组样本,其中包括每个人的身高、体重和性别。

接下来,我们将构建一个回归模型来描述因变量(体重)如何受到自变量(身高和性别)的影响。

常用的回归模型包括线性回归模型和非线性回归模型。

线性回归模型假设因变量与自变量之间存在一个线性关系,而非线性回归模型假设它们之间存在一个非线性关系。

构建回归模型后,我们将评估模型的准确性和可靠性。

通常采用最小二乘法来估计模型参数,并计算残差来衡量模型的拟合程度。

如果残差具有随机性、接近正态分布并且没有明显的模式,那么我们可以认为模型是可靠的。

同时,我们还可以计算拟合优度指标(如R方值)来评估模型的解释能力。

在评估模型之后,我们可以使用模型进行预测和推断。

通过输入自变量的值,我们可以根据回归模型预测因变量的值。

同时,我们还可以使用模型的参数估计值来进行统计推断,比如计算置信区间和假设检验。

最后,我们需要解释回归模型的结果。

我们可以通过分析模型的参数和对应的显著性水平,来判断自变量对因变量的影响是否显著。

同时,我们还可以通过散点图、回归方程式和拟合线来直观地展示变量之间的关系。

总之,实用回归分析是一种强大的工具,可以帮助我们了解变量之间的关系,并进行预测和决策。

通过适当的数据收集、模型建立和结果解释,回归分析可以为实际问题的解决提供有力支持。

逻辑回归是一种常用的机器学习算法,它能够在给定一些特征的情况下,对一个二元变量的概率进行预测。

逻辑回归模型的应用非常广泛,例如在医学诊断、金融风险评估、市场营销预测等领域都有着重要的作用。

在本文中,我们将探讨如何使用逻辑回归模型进行预测,并讨论一些相关的技巧和注意事项。

首先,我们需要了解逻辑回归模型的基本原理。

逻辑回归是一种广义线性模型,它使用逻辑函数(也称为Sigmoid函数)将线性方程的输出映射到[0, 1]的范围内。

逻辑函数的公式为:\[h_{\theta}(x) = \frac{1}{1 + e^{-\theta^Tx}}\]其中,\(h_{\theta}(x)\)表示预测的概率,\(\theta\)表示模型的参数,\(x\)表示输入的特征向量。

在使用逻辑回归模型进行预测时,我们需要进行一些数据的预处理工作。

首先,我们需要对数据进行清洗和处理缺失值。

其次,我们需要对特征进行选择和转换,例如使用特征缩放和多项式特征。

另外,我们需要对数据进行划分,将数据集划分为训练集和测试集,通常采用交叉验证的方法来保证模型的泛化能力。

在模型训练阶段,我们需要选择合适的损失函数和优化算法。

通常来说,逻辑回归模型使用的是对数损失函数(log loss),并且可以使用梯度下降法或者牛顿法等优化算法来进行参数的更新。

在实际应用中,我们还需要进行超参数的调优,例如正则化参数的选择等。

在模型预测阶段,我们需要对模型的输出进行阈值处理,将概率值转换为类别标签。

通常来说,我们可以选择作为阈值,大于的样本预测为正类,小于的样本预测为负类。

此外,我们还可以采用其他的阈值选择策略,例如根据模型的性能指标选择最优的阈值。

在使用逻辑回归模型进行预测时,我们需要注意一些常见的问题和技巧。

首先,我们需要进行特征的筛选和转换,选择对模型预测有影响的特征进行建模。

其次,我们需要处理样本不平衡的问题,例如使用过采样或者欠采样的方法来平衡不同类别的样本。

线性回归模型论文回归模型论文一种基于线性回归模型的运动矢量重估算法摘要:针对H.264/AVC空间分辨率缩减的视频转码,提出一种基于线性回归模型的运动矢量重估计算法。

它利用原始视频流的运动矢量与下采样视频流的运动矢量之间的相关性,运用线性回归模型建模,得到下采样视频的运动矢量。

仿真实验结果表明:在保持率失真性能的同时,计算复杂度明显降低。

关键词:视频转码;H.264;线形回归模型;运动矢量重估计A Motion Vector Re-estimation Algorithm based on Linear Regression ModelYANG Gao-bo1, XIA Zhong-chao1, ZHANG Zhao-yang2, WANG Hui-qian1(1.College of Computer and Communication, Hunan Univ, Changsha, Hunan410082, China;2.Key Lab of Advanced Display and System Applications, Ministry of Education, Shanghai Univ, Shanghai 200072, China) Abstract: For the spatial resolution reduction ofH.264/AVC stream, a motion re-estimation algorithm based on linear regression model is proposed in this paper. It exploits the correlation between the motion vectors of original video stream and those of down-sampled video, which is modelled bylinear regression model to obtain the estimated motion vectors. Experimental results demonstrate that the proposed approach can significantly reduce the computational complexity of the transcoder with only slight sacrifice of visual quality.Key words: video transcoding;H.264/AVC;linear regression model;motion vector re-estimation随着网络和多媒体通信的发展,不同网络上各种视频信息的交流需求在不断增加。

《几个预测方法及模型的研究》篇一一、引言预测是现代社会中不可或缺的一部分,它涉及到众多领域,如经济、气象、医疗、科技等。

随着科技的发展,预测方法及模型也在不断更新和优化。

本文将介绍几种常见的预测方法及模型,并对其应用和优缺点进行分析。

二、回归分析模型回归分析是一种通过建立变量之间的依赖关系来预测目标变量的方法。

回归分析模型根据历史数据建立自变量和因变量之间的关系,并通过对新数据的分析来预测未来的趋势。

优点:1. 可以揭示变量之间的因果关系;2. 适用于连续性数据;3. 适用于探索变量之间的非线性关系。

缺点:1. 无法考虑数据间的相互作用和交互影响;2. 回归模型建立时对假设条件的敏感性较高。

三、时间序列分析模型时间序列分析是一种基于历史数据来预测未来趋势的方法。

它通过分析时间序列数据中的模式和周期性变化来预测未来的变化。

常见的时间序列分析模型包括简单移动平均、加权移动平均、指数平滑法、ARIMA模型等。

优点:1. 可以捕捉时间序列数据的动态变化;2. 适用于具有明显季节性变化的数据;3. 可以对未来的趋势进行较为准确的预测。

缺点:1. 对数据的质量要求较高,如需保持数据的连续性和完整性;2. 无法处理具有非线性变化的数据。

四、机器学习模型机器学习是一种基于数据的学习方法,它通过训练大量的历史数据来建立模型,并利用该模型对新的数据进行预测。

常见的机器学习模型包括神经网络、支持向量机、决策树等。

优点:1. 可以处理大规模的数据集;2. 可以自动捕捉数据间的复杂关系;3. 具有较高的预测精度。

缺点:1. 需要大量的历史数据进行训练;2. 对算法的优化和调参有一定的难度;3. 在某些情况下可能会出现过拟合的现象。

五、集成学习模型及混合模型应用随着技术的不断发展,人们开始将不同的预测方法及模型进行集成或混合,以实现更准确的预测。

例如,集成学习模型(如随机森林、梯度提升机等)将多个弱学习器组合成一个强学习器,以提高预测的准确性。

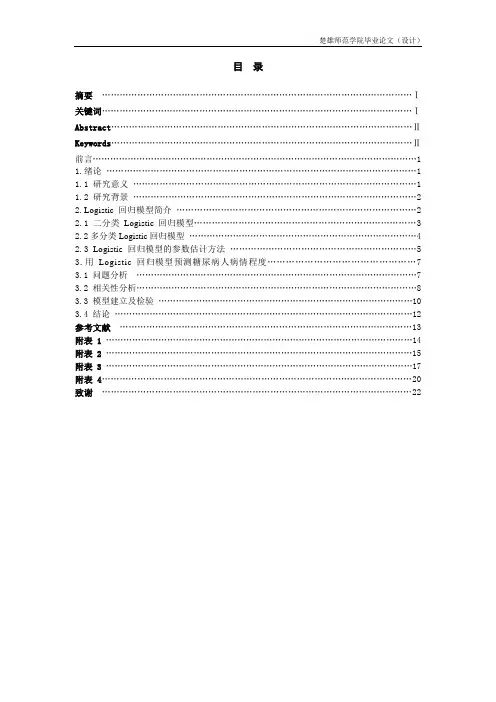

楚雄师范学院毕业论文(设计)目录摘要 (Ⅰ)关键词 (Ⅰ)Abstract (Ⅱ)Keywords (Ⅱ)前言 (1)1.绪论 (1)1.1 研究意义 (1)1.2 研究背景 (2)2.Logistic回归模型简介 (2)2.1二分类Logistic回归模型 (3)2.2多分类Logistic回归模型 (4)2.3 Logisti c回归模型的参数估计方法 (5)3.用Logistic回归模型预测糖尿病人病情程度 (7)3.1问题分析 (7)3.2相关性分析 (8)3.3模型建立及检验 (10)3.4结论 (12)参考文献 (13)附表1 (14)附表2 (15)附表3 (17)附表4 (20)致谢 (22)用Logistic回归模型预测糖尿病人病情程度摘要:本文首先总结近年来有关Logistic回归模型的研究概况。

然后在Logistic回归模型的基础上,重点介绍了二分类和多分类变量Logistic回归模型。

并使用最大似然估计法对模型中的参数进行估计,然后根据拟合优度检验法对模型进行检验。

最后利用SPSS统计软件对糖尿病人的病情程度建立模型,进行系统的分析并将预测结果与实际结果进行比对。

关键词:Logistic回归模型;拟合优度;最大似然估计;回归系数Logistic regression model was used to predict the severity of diabeticpatientsAbstract:This topic summarizes some surveys researched in recent years about Logistic Regression Model. Then on the basis of Logistic Regression Model, introduce two categories and multiple categories variable of Logistic Regression Model, .Firstly, use maximum likelihood to estimste parameters of the model, and secondly, use the goodness of fit test for the model, thirdly, use SPSS statistical software to build model for the severity of patients with diabetes mellitus, carry out the system analysis and contrast the forecast and real result.Keywords:Logistic regression model; goodness of fit;maximum likelihood estimate; regression coefficients.前言Logistic回归模型作为重要的统计模型,对种群生态学的研究具有核心理论价值。

统计回归模型的研究论文作者:林成家专业:信息与计算科学班级:050803学号:20052005指导教师:杨孝英摘要统计回归模型是用一个或多个其他变数来预测另一个变量。

通过现在或过去事件的信息来预测现在和未来的事项,同时统计回归模型在现实中的应用更是有着广泛和实际的意义。

本论文主要研究统计回归模型在现实生活中的应用,以达到学以致用的目的。

文章分三个部分,第一部分,统计回归模型的概念以及基础知识;第二部分是统计回归模型在现实生活中实际应用的示范举例,例如在电信行业、化工行业、农业等方面;第三部分是文章的总结。

文章涉及到最小二乘法解法以及t检验,F检验,误差分析,残差分析,区间估计等本科学习中的一些知识,这也是对以前所学知识的一种复习与巩固,希望通过研究能真正达到将理论知识应用到现实生活中的效果,为社会更好的服务。

关键词:统计回归模型最小二乘法 t检验区间估计AbstractStatistical regression models are used to predict one variable from one or more other variables. Regression models provide the scientist with a powerful tool, allowing predictions about past, present, or future events to be made with information about past or present events. At the same time, the statistical regression model is a broad and practical significance application in reality. This paper major research the application of statistical regression model in real life, the purpose is apply what they have learned. The article is divided into three parts: the first part is the concept of statistical regression model and basic knowledge; the second part is the examples of statistical regression model in real life, for example, in the telecommunications industry, chemical industry, agriculture, etc; the third part is a summary of the article. Articles related to some knowledge in undergraduate study, such as least squares solution and the t test, F test, error analysis, residuals analysis, interval estimation. This is a review and consolidation to the previously learned knowledge. Hope through research to be able to really achieve the desired effect that theoretical knowledge apply to real life, better service for the community.Keywords: statistical regression model, least squares, t test, interval estimation目录一、绪论 (1)二、统计回归模型的应用 (3)1、统计回归模型在电信行业的应用 (5)1.1 指标选取及小组划分 (5)1.2 各组电信业务收入回归模型及其检验 (6)1.3 各组影响因素分析 (7)1.4 结论及研究意义 (8)2、统计回归模型在化工行业的应用 (9)2.1统计回归模型在酮苯脱蜡脱油装置上的应用 (9)2.2 酮苯脱蜡模型建立 (10)2.3 模型验证 (11)2.4 蜡收率模型验证 (13)2.5 结论 (15)3、统计回归模型在农业中的应用 (15)3.1 建模背景 (15)3.2 组建统计回归模型 (16)3.3 回归值的统计精度分析 (18)3.4 概率预报及其区间估计 (18)3.5 结语 (19)三、参考文献 (21)一、绪论当人们对研究对象的内在特性和各因素的关系有比较充分的认识时,一般用机理分析方法建立数学模型,如果由于客观事物内部规律的复杂性以及人们认识程度的限制,无法分析实际对象内在的因果关系,建立合乎机理规律的数学模型,那么通常的办法是搜索大量的数据,基于对数据的统计分析去建立模型,而统计回归模型是一种用途非常广泛的一类随机模型。

基于数学建模的经济变量线性回归统计预测研究摘要:用数学方程式确定两种或两种以上变数间相互依赖的定量关系的一种统计分析方法,被称之为回归分析,在估计和预测因变量的值时比较常用。

本文对基于数学建模的经济变量线性回归统计预测做了简单的分析研究。

关键词:数学建模经济变量回归统计预测研究回归分析是一种确定两种或者两种以上变数间相互依赖的定量关系的统计分析方法,回归分析按照自变量的多少,可以分为一元回归分析和多元回归分析。

随着回归分析的发展,统计学家们建立了多种回归模型进行统计分析,数学建模和预测参数成为了回归分析研究的主要内容。

回归分析是通过规定因变量和自变量来确定变量之间的因果关系,建立回归模型。

回归分析按照自变量的多少可在表1中体现出来。

在我们研究产品价格和其他因素对于销量影响程度的时候,我们可以应用到回归分析的相关理论,如表2。

利用数学建模回归分析可以解释如下问题:价格、广告、促销等各种因素之间的关系是怎样的。

价格是怎样做到影响销量的?如果价格和广告支出同时变化一定量的值。

那么销量预期又是多少。

在这个实例中,销售额属于因变量、价格、广告、促销等属于自变量。

在回归分析应用中,一般会采用与方法相适应的固定步骤,首先,要根据自变量和因变量的因果关系来确定回归模型;然后,根据认真观测数据,评价回归函数的实时数据,并且估计该回归函数的相关参数;最后,还要检验该估计数学的准确性。

一、绘制并观测散点图要根据散点图来判断,假设是否存在线性关系,例如以上广告与销售额的关系,我们通过绘制散点图,并且观测,最终得到这样一个结论,二者之间的呈一元一次的函数关系趋势,而且呈正相关形态。

此时,我们就要考虑建立回归模型,根据散点图判断,我们建立的是一元一次方程模型。

二、建立数学模型,预测回归函数1.一元线性回归分析一元线性回归的标准式为:y=a+bx+ε,这里x是自变量,y 是因变量,ε是随机误差。

以我们上面举过的广告费和销售额为例,我们在估计因变量y(销售额)的值,所以做出建立如下函数:回归函数y’=a+bx在这个函数中y’作为y的估算值,a当自变量为零时,因变量的值,b是函数的系数、直线的斜率。

回归分析模型范文回归分析是一种统计学方法,用于研究变量之间的关系。

它涉及到一个因变量和一个或多个自变量之间的关系,该关系用数学公式来表示。

回归分析被广泛应用于各个领域,如经济学、金融学、医学、社会科学等。

Y=β₀+β₁*X₁+β₂*X₂+...+βₙ*Xₙ+ε其中,Y是因变量,X₁,X₂等是自变量,β₀,β₁等是回归系数,ε是误差项。

回归系数表示了自变量对因变量的影响程度。

误差项表示了不能通过自变量来解释的部分。

回归分析模型有多种类型,包括简单线性回归、多元线性回归、逻辑回归、多项式回归等。

简单线性回归模型在只有一个自变量和一个因变量的情况下使用。

多元线性回归模型在有多个自变量和一个因变量的情况下使用。

逻辑回归模型用于分析因变量为二元(0或1)的情况,多项式回归模型用于分析自变量和因变量之间非线性的关系。

回归分析模型可以用于诸如预测、推断和关联分析等应用。

在预测中,可以使用回归模型来预测因变量的值。

在推断中,可以使用回归模型来检验因变量和自变量之间的关系是否显著。

在关联分析中,可以使用回归模型来确定自变量和因变量之间的相关性和强度。

在使用回归分析模型时,需要注意一些前提条件。

首先,自变量和因变量之间应该有一种线性关系。

其次,观测值应该是独立的,并且误差项应该服从正态分布。

此外,自变量之间应该是无关的,即不能存在多重共线性。

总之,回归分析模型是一种强大的统计工具,用于研究变量之间的关系。

它可以应用于各种学科和领域,帮助我们理解和解释数据,预测未来,并从中提取有价值的信息。

掌握回归分析模型的基本原理和应用方法,可以帮助我们做出更准确和有效的决策。

逻辑回归模型的原理及应用论文1. 引言逻辑回归是一种经典的分类算法,常用于解决二分类问题。

它基于线性回归模型,通过将线性预测结果通过一个特定的函数变换到 [0, 1] 之间,从而得到样本属于某一类的概率。

本文将介绍逻辑回归模型的原理以及在实际应用中的一些案例。

2. 逻辑回归模型的原理逻辑回归模型基于线性回归模型,假设输入特征与输出的对数几率之间存在线性关系。

对于二分类问题,对数几率可以定义为:$$\\log{\\frac{p}{1-p}} = \\theta^{T}X$$其中,p表示样本属于正类的概率,$\\theta$ 表示模型的参数向量,X表示输入特征向量。

为了将对数几率转换为概率,我们可以使用sigmoid函数:$$p = \\frac{1}{1+e^{-\\theta^{T}X}}$$接下来,通过最大似然估计的方法,可以求解出模型的参数 $\\theta$。

3. 逻辑回归模型的应用案例逻辑回归模型在实际应用中有着广泛的应用,下面将介绍几个典型的案例。

3.1 信用评分逻辑回归模型可以用于信用评分,帮助银行或金融机构评估客户信用风险。

通过建立逻辑回归模型,可以根据客户的一些基本信息(如年龄、收入、职业等),预测其违约概率。

在信用评分模型中,往往需要根据业务需求来确定违约的阈值,从而决定是否给予贷款。

3.2 疾病预测逻辑回归模型也可以用于疾病预测。

以肿瘤预测为例,通过收集患者的一些临床特征(如年龄、性别、肿瘤大小等),建立逻辑回归模型来预测患者是否患有恶性肿瘤。

该模型可以辅助医生进行诊断,提高早期发现疾病的准确率。

3.3 用户分类逻辑回归模型还可以应用于用户分类问题。

在电商领域,可以通过收集用户的一些行为特征(如浏览历史、购买记录等),来预测用户是否会购买某个商品。

这样可以有针对性地向用户推荐商品,提高销售转化率。

4. 总结逻辑回归模型是一种经典的分类算法,通过将线性预测结果通过sigmoid函数转换为概率,能够有效地解决二分类问题。

多元线性回归统计预测模型摘要:本文以多元统计分析为理论基础,在对数据进行统计分析的基础上建立多元线性回归模型并对未知量作出预测,为相关决策提供依据和参考。

重点介绍了模型中参数的估计和自变量的优化选择及简单应用举例。

关键词:统计学;线性回归;预测模型一.引言多元线性回归统计预测模型是以统计学为理论基础建立数学模型,研究一个随机变量Y 与两个或两个以上一般变量X“X?,…,Xp之间相依关系,利用现有数据,统计并分析,研究问题的变化规律,建立多元线性回归的统计预测模型,来预测未来的变化情况。

它不仅能解决一些随机的数学问题,而且还可以通过建立适当的随机模型进而解决一些确定的数学问题,为相关决策提供依据和参考。

目前统计学与其他学科的相互渗透为统计学的应用开辟新的领域。

并被广泛的应用在各门学科上,从物理和社会科学到人文科学,甚至被用来工业、农业、商业及政府部门。

而多元线性回归是多元统计分析中的一个重要方法,被应用于众多自然科学领域的研究中。

多元线性回归分析作为一种较为科学的方法,可以在获得影响因素的前提下,将定性问题定量化,确定各因素对主体问题的具体影响程度。

二.多元线性回归的基本理论多元线性回归是多元统计分析中的一个重要方法,被广泛应用于众多自然科学领域的研究中。

多元线性回归分析的基本任务包括:根据因变量与多个自变量的实际观测值建立因变量对多个自变量的多元线性回归方程;检验、分析各个自变量对因自变量的综合线性影响的显著性;检验、分析各个自变量对因变量的单纯线性影响的显著性,选择仅对因变量有显著线性影响的自变量,建立最优多元线性回归方程;评定各个自变量对因变量影响的相对重要性以及测定最优多元线性回归方程的偏离度等。

由于多数的多元非线性回归问题都可以化为多元线性回归问题,所以这里仅讨论多元线性回归。

许多非线性回归和多项式回归都可以化为多元线性回归来解决,因而多元线性回归分析有着广泛的应用。

2.1多元线性回归模型的一般形式设随机变量y与一般变量内,修,…,勺线性回归模型为v, + /32X2+...+p p x p + s(2. 1)y = + /?r模型中Y为被解释变量(因变量),而内,修,…,”是P个可以精确测量并可控制的一般变量,称为解释变量(自变量)。

多项式回归模型的研究毕业论文

引言

本论文旨在研究多项式回归模型的应用及其在数据分析和预测

中的效果。

多项式回归模型是一种基于多项式函数的回归分析方法,被广泛应用于不同领域的数据分析中。

方法

研究采用了多项式回归模型对收集到的数据进行分析。

首先,

收集并整理了适用于多项式回归的数据集。

然后,使用多项式回归

模型来拟合数据,并进行模型评价和分析。

结果

通过对多项式回归模型的应用,我们得到了一组拟合度较高的

模型。

这些模型能够准确地预测与输入变量关联的输出变量。

此外,通过对模型的评价和分析,我们还发现了模型的一些优缺点。

讨论

本论文的研究结果表明,多项式回归模型在数据分析和预测中具有较好的应用效果。

然而,该模型在处理高维数据时可能存在过拟合的问题,需要进行合适的调参和模型选择。

结论

通过本论文的研究,我们深入探讨了多项式回归模型的应用及其在数据分析和预测中的效果。

研究结果表明,多项式回归模型是一种有效的分析方法,可以帮助我们理解数据之间的关系并进行准确的预测。

参考文献

1. 引用文献1

2. 引用文献2

3. 引用文献3。