实验5-RAID实验-实验报告

- 格式:doc

- 大小:141.00 KB

- 文档页数:7

实验四磁盘阵列●实验目的通过磁盘阵列的配置,达到通过实践去学习网络存储技术中磁盘阵列RAID0、RAID1、RAID5标准的相关知识。

●实验要求要求各位同学在理解存储技术中磁盘阵列相关基础知识后能够独立动手完成此实验●实验原理介绍RAID:廉价冗余磁盘阵列,是Redundant Arrays of Independent Disks的简称,是在阵列控制器(软件或阵列卡硬件)的管理下,将多个磁盘集成到一起,形成一个整体存储系统的技术。

磁盘阵列可以分为软阵列和硬阵列两种。

软阵列就是通过软件程序来完成,要由计算机的CPU提供控制和运算能力,只能提供最基本的RAID容错功能。

而硬阵列是由独立操作的硬件(如磁盘阵列卡)提供整个磁盘阵列的控制和计算功能,卡上具备独立的处理器,不占用系统的CPU资源,所有需要的容错机制均可以支持,所以现实当中硬阵列所提供的功能和性能均比软阵列好。

作为高性能的存储技术,RAID的级别已经发展了很多种,但大多都是基于最常用的0、1、3、5四个级别(其他的RAID级别请各位实验完毕参考教材进行自学),本次重点介绍这四个级别。

RAID 0:是将多个磁盘(至少2个硬盘)并列起来,形成一个大的硬盘,不具有冗余功能,执行并行I/O读写,速度最快。

RAID0总容量=(磁盘数量)*(成员的磁盘容量)在存放数据时,其首先将数据按磁盘的个数来进行分段,然后同时将这些数据并行写进这些磁盘中。

如果发挥一下想象力,你就会觉得数据像一条带子一样横跨过所有的阵列磁盘,所以RAID0 又叫条带磁盘阵列目前在所有的RAID级别中,RAID 0的读写速度是最快的,但其没有任何冗余功能,即如果有一个磁盘(物理)损坏,则所有的数据都无法使用。

RAID1:两组相同的磁盘(至少2个硬盘)互作镜像,以镜像作为冗余手段,读写速度没有提高,但是可靠性最高,100%的数据冗余,它是在追求最高的安全性的基础上牺牲了大部分的性能,RAID 1就是镜像,其原理为在主硬盘上存放数据的同时也会在镜像硬盘上拷贝写入一份同样的数据。

湖北文理学院《网络存储》实验报告专业班级:计科1211姓名:***学号:***任课教师:李学峰2014年11月16日实验01 Windows 2003的磁盘阵列技术一、实验目的1.掌握在Windows 2003环境下做磁盘阵列的条件和方法。

2.掌握在Windows 2003环境下实现RAID0的方法。

3. 掌握在Windows 2003环境下实现RAID1的方法。

4. 掌握在Windows 2003环境下实现RAID5的方法。

5. 掌握在Windows 2003环境下实现恢复磁盘阵列数据的方法。

二、实验要求1.在Windows 2003环境下实现RAID02.在Windows 2003环境下实现RAID13.在Windows 2003环境下实现RAID54.在Windows 2003环境下实现恢复磁盘阵列数据三、实验原理(一)磁盘阵列RAID技术的概述RAID是一种磁盘容错技术,由两块以上的硬盘构成冗余,当某一块硬盘出现物理损坏时,换一块同型号的硬盘即可自行恢复数据。

RAID有RAID0、RAID1、RAID5等。

RAID 技术是要有硬件来支持的,即常说的RAID卡,如果没RAID卡或RAID芯片,还想做RAID,那就要使用软件RAID技术,微软Windows系统只有服务器版本才支持软件RAID技术,如Windows Server 2003等。

(二)带区卷(RAID0)带区卷是将多个(2-32个)物理磁盘上的容量相同的空余空间组合成一个卷。

需要注意的是,带区卷中的所有成员,其容量必须相同,而且是来自不同的物理磁盘。

带区卷是Windows 2003所有磁盘管理功能中,运行速度最快的卷,但带区卷不具有扩展容量的功能。

它在保存数据时将所有的数据按照64KB分成一块,这些大小为64KB的数据块被分散存放于组成带区卷的各个硬盘中。

(三)镜像卷(RAID1)镜像卷是单一卷的两份相同的拷贝,每一份在一个硬盘上。

盘的区别实验目的:对动态磁盘和基本磁盘的理解和应用数据的备份。

实验环境:两个和两个以上的基本磁盘实验步骤:(1)基本磁盘1.基本磁盘只可以分两种区一种是主分区一种是扩展分区,扩展区里面在分逻辑区2.基本磁盘最都能建4个扩展分区,超出4个就无法在建3.主分区和扩展分区加在一起不能超过4个分区否则剩下的空间无法分配主分区是必不可少的不可以不建,在建完一个逻辑分区后,逻辑分区的选项变灰了,只有主分区可以选择5.删除主分区和扩展分区它们之间互不影响6.不可扩展。

新加卷:(G)前面的120MB的未指派空间不管分什么区它都是120MB不能扩展(2).动态磁盘磁盘的多少是否容错能否扩展磁盘分区是否删除一个分区,则全部被删除数据的写法简单卷 1 否能是顺着一块磁盘写完跨区卷2~32 否能是顺着磁盘写一个磁盘先写完再写另一块磁盘;带区卷2~32 否不能是数据平分写(例如上一个磁盘写1,那么下面磁盘写2,如上一直往后推;)镜像卷2个相同的磁盘否不能是数据重复写(第一块磁盘写什么那么第二块磁盘也就写什么)RAID-5 3个及3个以上是不能是简单卷:1.只需要一个磁盘.2.能扩展。

给它扩展300MB如图:3.一删除都删除4.不能容错。

删除了就能能正常工作。

跨区卷:1.要两个和两个以上的磁盘一个硬盘的时候跨区卷不可以建。

跨区卷要在两个和两个以上的磁盘才可以建。

2.能扩展(磁盘1和磁盘2扩展100MB)3.一删除都删除4.无容错。

删除了就能能正常工作.带区卷:1.两个和两个以上的磁盘一个硬盘的时候跨区卷不可以建。

跨区卷要在两个和两个以上的磁盘才可以建。

2.无扩展性3.一删除都删除4.无容错,删除了就能能正常工作.镜像卷 1.要两个和两个以上的磁盘一个硬盘的时候跨区卷不可以建。

跨区卷要在两个和两个以上的磁盘才可以建。

2.无扩展3.一删除不一定都删除(有两中删除方式一种删除镜像卷一种删除卷)删除镜像删除卷3.有容错1.建一个镜像卷删除一个镜像3.这时候镜像卷变成了简单卷。

实验报告实验内容:◆管理磁盘卷◆远程桌面相关操作◆磁盘配额的实现◆共享文件◆磁盘备份实验目的:在Windows 2003下进行基本磁盘和动态磁盘的管理;通过磁盘管理,在此基础上进而实现磁盘卷的管理;通过远程桌面实现在客户端连接到文件服务器与主域服务器;根据创建的用户来跟踪和控制磁盘的使用,达到磁盘的配额。

方便管理员能很好的管理服务器和磁盘的管理,熟练使用磁盘管理工具,管理基本磁盘和动态磁盘在Windows 2003 Server中,系统集成了许多磁盘管理方面的新特性和新功能。

在用户使用磁盘管理程序之前,有必要首先了解一些有关磁盘管理的基础知识以及Windows 2003Server采用的磁盘管理新技术,以便用户更好的对本地磁盘进行管理、设置和维护,保证计算机系统快速、安全与稳定地工作相关知识:服务中的磁盘管理属于服务器系统管理的基本范围。

磁盘管理主要包括基本存储与动态存储,使用磁盘管理工具管理存储设备,设置磁盘配额,以及优化存储设备。

有效的磁盘系统管理不仅可以使服务发挥最佳性能,满足许多先进的磁盘数据存储应用需求,而且还可以确保服务器的安全和用户有效的登录。

要创建镜像卷首先需要保证有两个或两个以上的动态磁盘,如果这其中包括安装Windows系统的磁盘,则在转换成动态磁盘后需要重新启动操作系统。

在NTFS文件系统中,卷使用信息按用户安全标识符(SID)存储,而不是按用户帐户名称存储。

第一次打开“配额项”窗口时,磁盘配额必须从网络域控制器或本地用户和组上获得用户帐户名称,将这些用户帐户名与当前卷用户的SID匹配,并使用用户名填充“名称”列上的项目。

从域控制器或本地用户和组中获得这些名称时,名称将显示在该字段中。

第一次查看配额项时,这个过程立即开始。

磁盘配额是以文件所有权为基础的,并且不受卷中用户文件的文件夹位置的限制。

简单卷是由单个动态磁盘的磁盘空间所组成的动态卷。

简单卷可以由磁盘上的单个区域或同一磁盘上链接在一起的多个区域组成。

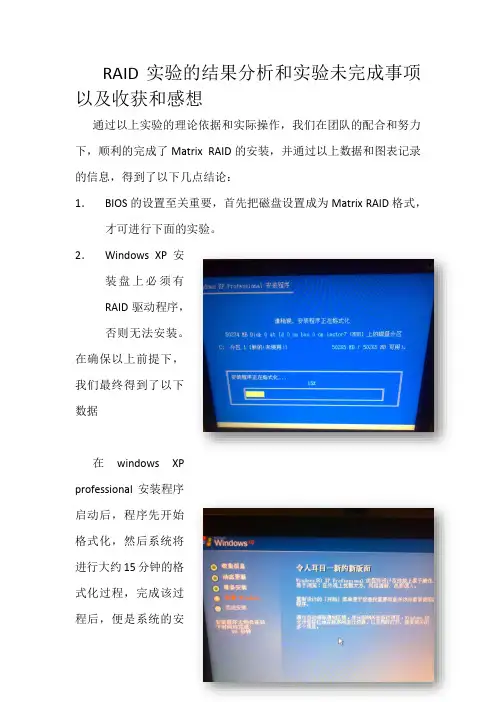

RAID实验的结果分析和实验未完成事项以及收获和感想通过以上实验的理论依据和实际操作,我们在团队的配合和努力下,顺利的完成了Matrix RAID的安装,并通过以上数据和图表记录的信息,得到了以下几点结论:1.BIOS的设置至关重要,首先把磁盘设置成为Matrix RAID格式,才可进行下面的实验。

2.Windows XP安装盘上必须有RAID驱动程序,否则无法安装。

在确保以上前提下,我们最终得到了以下数据在windows XPprofessional安装程序启动后,程序先开始格式化,然后系统将进行大约15分钟的格式化过程,完成该过程后,便是系统的安装读取过程,该过程中我们组做的比较顺利,该过程之后,便是xp系统的正式安装,如图1-2所示,在五步中,系统的安装花时间较长,约10分钟左右,之后,完成者五步便完成了基本的安装,下面需要对xp系统进行优化。

完成一系列的安装之后,重启电脑,便可以顺利的进入xp系统。

之后需要对RAID进行测试,测试结果如图1-3 1-4所示测试一从图中的数据中,我们可以看出,随机访问是11.9ms,CPU的占用率是0%,平均读盘速度是111.1MB/s,突发传输速度是227.2MB/s。

与普通的想比较我们可以看到,平均读盘比普通高56MB/S.超出一倍。

突发速度比普通高99MB/s,超出88%左右。

可以明显的看出,该模式优于普通模式。

测试二从该表我们可以看到,随机访问的时间是15.4ms,平均传输是55.3MB/s突发传输速度是128.6MB/s。

测试三从该图中我们可以看出,平均读取时间17ms cpu使用率o%,平均读取速度65.9MB/s,突发速度为136.5Mb/s。

比普通的大2mb/s。

可见效果佳于普通。

以上几组测试都说明了RAID模式下的优越性。

可以明显的感觉到速度的提升。

完成该实验重要点在于1、BIOS设置2、Intel Matrix Storage Manager Option ROM设置3、盘上是否有RAID驱动程序4、Matrix RAID 性能测试实验需要团队的配合和分工,也需要很好的耐心和信心。

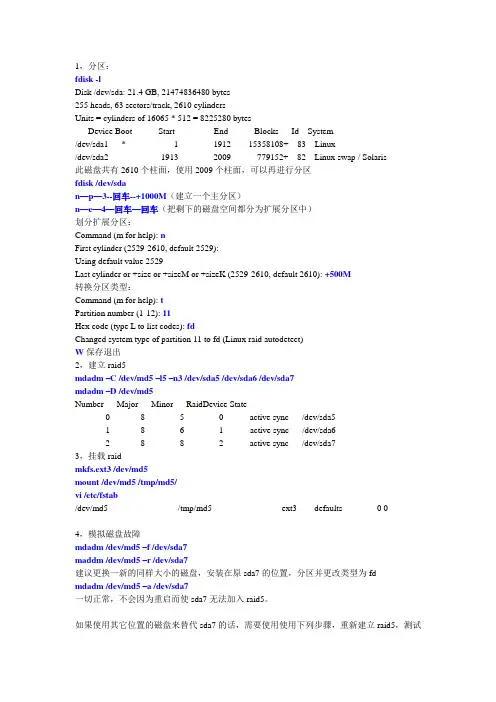

1,分区:fdisk -lDisk /dev/sda: 21.4 GB, 21474836480 bytes255 heads, 63 sectors/track, 2610 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 1912 15358108+ 83 Linux/dev/sda2 1913 2009 779152+ 82 Linux swap / Solaris此磁盘共有2610个柱面,使用2009个柱面,可以再进行分区fdisk /dev/sdan—p—3--回车--+1000M(建立一个主分区)n—e—4—回车—回车(把剩下的磁盘空间都分为扩展分区中)划分扩展分区:Command (m for help): nFirst cylinder (2529-2610, default 2529):Using default value 2529Last cylinder or +size or +sizeM or +sizeK (2529-2610, default 2610): +500M转换分区类型:Command (m for help): tPartition number (1-12): 11Hex code (type L to list codes): fdChanged system type of partition 11 to fd (Linux raid autodetect)W保存退出2,建立raid5mdadm –C /dev/md5 –l5 –n3 /dev/sda5 /dev/sda6 /dev/sda7mdadm –D /dev/md5Number Major Minor RaidDevice State0 8 5 0 active sync /dev/sda51 8 6 1 active sync /dev/sda62 8 8 2 active sync /dev/sda73,挂载raidmkfs.ext3 /dev/md5mount /dev/md5 /tmp/md5/vi /etc/fstab/dev/md5 /tmp/md5 ext3 defaults 0 04,模拟磁盘故障mdadm /dev/md5 –f /dev/sda7maddm /dev/md5 –r /dev/sda7建议更换一新的同样大小的磁盘,安装在原sda7的位置,分区并更改类型为fdmdadm /dev/md5 –a /dev/sda7一切正常,不会因为重启而使sda7无法加入raid5。

raid基础实验报告Title: RAID Basic Experiment ReportIntroductionIn the world of data storage and management, RAID (Redundant Array of Independent Disks) plays a crucial role in ensuring data integrity, availability, and performance. RAID technology allows multiple hard drives to be combined into a single logical unit, providing various levels of data protection and performance improvements. In this experiment, we aimed to understand the basic concepts of RAID and evaluate its performance and fault tolerance through practical experiments.Experiment SetupFor this experiment, we set up a simple RAID 1 (mirroring) configuration using two identical hard drives. We used a computer with a RAID controller and installed the necessary software to configure and manage the RAID array. The RAID 1 configuration mirrors the data across both drives, providing fault tolerance in case of a drive failure.Experiment ProcedureWe started by initializing and formatting the two hard drives before configuring them into a RAID 1 array. Once the RAID array was set up, we conducted several performance tests to measure the read and write speeds of the RAID 1 configuration compared to a single hard drive. We also simulated a drive failure by disconnecting one of the drives while the system was running to observe theRAID's ability to maintain data integrity and availability.Results and AnalysisThe performance tests showed that the RAID 1 array provided a slight improvement in read speeds compared to a single hard drive, while write speeds remained similar. This is expected as RAID 1 focuses on data redundancy rather than performance enhancement. When we simulated a drive failure, the RAID 1 array seamlessly continued to operate without any data loss or downtime, demonstrating its fault tolerance capabilities.ConclusionOur experiment with RAID 1 configuration provided valuable insights into the basic principles and functionality of RAID technology. We observed the benefits of data redundancy and fault tolerance offered by RAID 1, as well as its impact on performance. This experiment serves as a solid foundation for further exploration of more advanced RAID levels and their applications in real-world scenarios. RAID technology continues to be a critical component in modern data storage systems, and understanding its capabilities is essential for IT professionals and data management practitioners.。

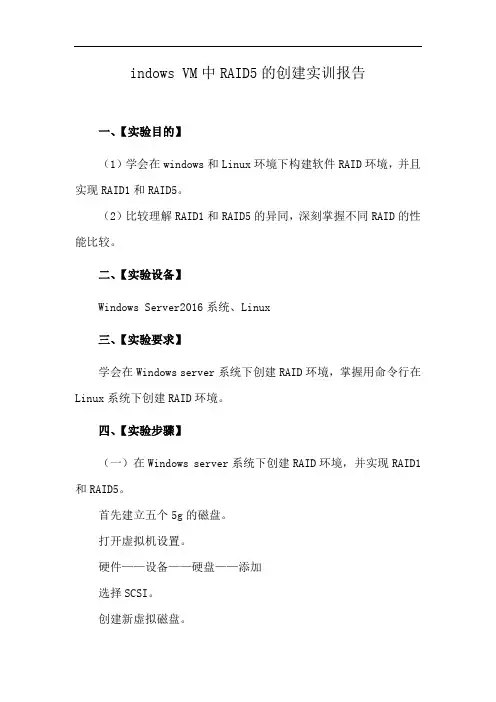

indows VM中RAID5的创建实训报告一、【实验目的】(1)学会在windows和Linux环境下构建软件RAID环境,并且实现RAID1和RAID5。

(2)比较理解RAID1和RAID5的异同,深刻掌握不同RAID的性能比较。

二、【实验设备】Windows Server2016系统、Linux三、【实验要求】学会在Windows server系统下创建RAID环境,掌握用命令行在Linux系统下创建RAID环境。

四、【实验步骤】(一)在Windows server系统下创建RAID环境,并实现RAID1和RAID5。

首先建立五个5g的磁盘。

打开虚拟机设置。

硬件——设备——硬盘——添加选择SCSI。

创建新虚拟磁盘。

磁盘大小设为5g,选择将虚拟磁盘存储为单个文件。

选择一个合适的地方存储,命名为experience Windows Server 2016-0这样就完成了一个磁盘的建立,接下来再按照上述方法创建四个。

打开磁盘管理,发现这五个磁盘属于脱机状态。

右键——联机再次右键——初始化磁盘。

这时就可以建立卷了。

除了这样直接用之外,还可以输入命令让磁盘脱机和清除磁盘属性。

打开cmd,进入diskpart界面,list disk 表示查看磁盘状态,select disk 2表示选择磁盘2进行操作,online disk表示使磁盘2联机,attr disk clear readonly表示删除磁盘属性。

这样设置完再进入磁盘管理,会自动弹出弹窗,让你进行初始化。

我们直接点击确认即可。

右键选择磁盘0——新建镜像卷。

(要注意此时要有两个已经初始化好的磁盘才可以建立镜像卷,因为RAID 1最少要两个磁盘。

从左边再选择一个磁盘,这样右边就有两个,符合建立RAID1的标准。

随便选一个磁盘驱动器号。

命名为RAID1,并且勾选快速格式化。

成功创建。

接下来创建RAID5,首先要有三个初始化好的磁盘,因为RAID5的建立至少要3个磁盘。

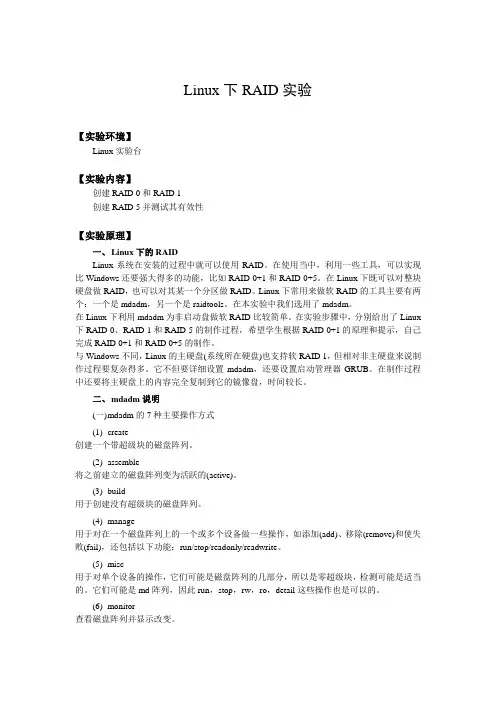

Linux下RAID实验【实验环境】Linux实验台【实验内容】创建RAID 0和RAID 1创建RAID 5并测试其有效性【实验原理】一、Linux下的RAIDLinux系统在安装的过程中就可以使用RAID。

在使用当中,利用一些工具,可以实现比Windows还要强大得多的功能,比如RAID 0+1和RAID 0+5。

在Linux下既可以对整块硬盘做RAID,也可以对其某一个分区做RAID。

Linux下常用来做软RAID的工具主要有两个:一个是mdadm,另一个是raidtools。

在本实验中我们选用了mdadm。

在Linux下利用mdadm为非启动盘做软RAID比较简单。

在实验步骤中,分别给出了Linux 下RAID 0、RAID 1和RAID 5的制作过程,希望学生根据RAID 0+1的原理和提示,自己完成RAID 0+1和RAID 0+5的制作。

与Windows不同,Linux的主硬盘(系统所在硬盘)也支持软RAID 1,但相对非主硬盘来说制作过程要复杂得多。

它不但要详细设置mdadm,还要设置启动管理器GRUB。

在制作过程中还要将主硬盘上的内容完全复制到它的镜像盘,时间较长。

二、mdadm说明(一)m dadm的7种主要操作方式(1)create创建一个带超级块的磁盘阵列。

(2)assemble将之前建立的磁盘阵列变为活跃的(active)。

(3)build用于创建没有超级块的磁盘阵列。

(4)manage用于对在一个磁盘阵列上的一个或多个设备做一些操作,如添加(add)、移除(remove)和使失败(fail),还包括以下功能:run/stop/readonly/readwrite。

(5)misc用于对单个设备的操作,它们可能是磁盘阵列的几部分,所以是零超级块,检测可能是适当的。

它们可能是md阵列,因此run,stop,rw,ro,detail这些操作也是可以的。

(6)monitor查看磁盘阵列并显示改变。

实验五文件系统

一、实验目的

1.掌握Linux系统下fdisk命令的用法。

2.掌握Linux系统下文件系统的创建、挂载与卸载。

3.掌握Linux系统下利用RAID技术实现磁盘冗余阵列的方法。

二、实验内容

1.磁盘分区管理

2.动态磁盘管理

三、实验指导

1.服务器现需要新建一块20GB的硬盘,需要对新增的硬盘进行分区管理、分区方案为/user目录所在分区10GB,/backup目录所在分区5GB,/home目录所在分区5GB。

步骤一,添加新硬盘

点击“编辑虚拟机设置”按钮,如下图

选择添加硬盘,如下图

下一步选择“SCSI(S)推荐”,如下图

下一步创建“新虚拟磁盘”,设置磁盘空间大小为“20GB”,如下图所示

单击完成,即完成了新硬盘的添加,如下图所示

通过fdisk -l命令查看新硬盘是否添加成功

步骤二,利用fdisk命令对/dev/sdb/进行分区

步骤三,格式化新建分区,在各分区上建立ext3类型的文件的系统,建立时要求检查磁盘坏块并显示详细信息。

步骤四,将/dev/sdb1挂载到/user目录,/dev/sdb2挂载到

/backup目录,/dev/sdb3挂载到/home目录

2、某公司的Linux服务器新增两块硬盘,硬盘大小为40GB。

为了实现数据保护功能,现需利用2块硬盘创建RAID1卷。

要求创建的RAID设备名为/dev/md110,并利用mkfs命令创建ext3文件系统。

最后将文件系统挂载到系统上。

四、实验总结

通过本次实验,我学习到fdisk 的一些命令和在Linux 系统下利用RAID 技术实现磁盘冗余阵列的方法。

第1篇一、实验背景随着雷达技术的不断发展,雷达在各个领域的应用越来越广泛。

从军事到民用,从空间探测到地表监测,雷达技术都发挥着至关重要的作用。

本实验旨在通过拓展雷达应用,探讨雷达技术在新型领域的可行性,并验证其实际效果。

二、实验目的1. 探索雷达技术在新型领域的应用潜力。

2. 验证雷达技术在不同环境下的性能表现。

3. 分析雷达技术在新型应用中的优缺点,为实际应用提供参考。

三、实验内容1. 实验设备- 雷达发射器- 雷达接收器- 数据采集系统- 控制软件- 实验场地(如森林、水域、城市等)2. 实验步骤(1)确定实验目标:根据实验目的,选择雷达在新型领域的应用场景,如森林火灾监测、水域探测、城市交通管理等。

(2)搭建实验平台:根据实验目标,搭建相应的实验平台,包括雷达发射器、接收器、数据采集系统等。

(3)进行实验测试:在实验场地进行雷达发射和接收测试,记录数据,分析雷达在不同环境下的性能表现。

(4)数据处理与分析:对采集到的数据进行处理和分析,评估雷达在新型领域的应用效果。

3. 实验项目(1)森林火灾监测:利用雷达对森林进行监测,实时掌握森林火情,提高火灾防控能力。

(2)水域探测:利用雷达对水域进行探测,监测水质、水流速度等参数,为水资源管理提供依据。

(3)城市交通管理:利用雷达监测城市道路交通流量,为交通信号控制提供数据支持。

四、实验结果与分析1. 森林火灾监测实验结果表明,雷达在森林火灾监测中具有较高的灵敏度和准确度。

雷达可以实时监测森林火情,为火灾防控提供有力支持。

2. 水域探测实验结果显示,雷达在水域探测中表现出良好的性能。

雷达可以监测水质、水流速度等参数,为水资源管理提供可靠数据。

3. 城市交通管理实验数据表明,雷达在城市交通管理中具有较好的应用前景。

雷达可以实时监测道路交通流量,为交通信号控制提供数据支持,提高交通效率。

五、实验结论1. 雷达技术在新型领域的应用具有广阔的前景,可以为相关领域提供有力支持。

实现RAID0、1、5 实验报告班级:10网工三班学生姓名:谢昊天学号:1215134046实验目的:1.掌握软RAID的配置方法。

2.掌握RAID0、1、5的配置过程。

3.掌握RAID1、5数据恢复方法。

实验要求:1.实验中仔细观察、记录、比较实验结果,如果不一致应找出原因。

2.实验中凡是需要命名的地方,均以自己名字的全拼来命名,可以用不同后缀来区分。

如张三的两台服务器可以命名为:zhangsanS1,zhangsanS2。

实验内容:1、在VMware中创建一台Windows Server。

2、将该Server添加3块虚拟磁盘。

3、格式化新添加的3块磁盘。

4、在新磁盘上分别配置RAID0 、1、5,对应驱动器号分别为E、F、G。

5、在以上三个卷中分别建立不同的文件。

6、关闭Server,去掉所添加硬盘中的第一块。

7、开启Server,查看E、F、G还能否访问。

8、关闭Server,重新添加一块新磁盘,并使用其恢复RAID1和RAID5。

实验步骤与实验过程:1、首先在VMware中创建出一台Windows Server,将Server添加3块虚拟磁盘,然后打开虚拟机格式化添加的3块磁盘,在新磁盘上分别配置为RAID0 、1、5,对应驱动器号分别为E、F、G,并在以上三个卷中分别建立出不同的文件。

2、关闭Server,去掉添加硬盘中的第一块,开启Server,查看E、F、G是否还能否访问。

3、关闭Server,重新添加一块新的磁盘,并恢复RAID1和RAID5。

实验结果:1、配置了成功RAID0、1、5,并将名为Inetpub、Program Files、web的三个文件分别加入到E、F、G三个磁盘。

2、去掉所添加硬盘中的第一块后,打开虚拟机后只剩下新建的F盘,并且可以访问F盘的文件Program Files3、去掉所添加硬盘中的第一块后,E、F、G在磁盘管理中都显示失败,修复磁盘RAID1、5后显示状态良好,并且可以访问F、G盘的文件Program Files、web。

磁盘阵列实验报告1. 引言磁盘阵列是一种由多个硬盘组成的存储系统,通过组合多个硬盘的存储容量和性能,提供了更高的数据可靠性和读写速度。

在本次实验中,我们搭建了一个磁盘阵列系统,进行了性能测试,并对其性能进行了评估和分析。

2. 实验目的本次实验的主要目的包括:1. 掌握磁盘阵列的组建和配置方法;2. 测试磁盘阵列的读写性能,并分析其性能表现;3. 评估磁盘阵列在不同工作负载下的性能表现。

3. 实验环境本次实验的实验环境如下:- CPU:Intel Core i7-9700K;- 内存:16GB DDR4;- 硬盘:8块SATA硬盘(容量为2TB,转速为7200RPM);- 操作系统:Ubuntu Linux 20.04.1 LTS。

4. 磁盘阵列配置在实验中,我们选择了一种常见的磁盘阵列配置方式:RAID 0。

RAID 0使用条带化(striping)的方式将数据均匀分布在多个硬盘上,从而提高了读写性能。

然而,由于数据没有冗余备份,RAID 0无法实现数据的冗余和容错。

我们通过软件配置方式实现了RAID 0。

首先,我们使用Linux提供的`mdadm`工具将物理硬盘建立为RAID设备,然后进行格式化和挂载。

5. 性能测试与分析我们对磁盘阵列进行了一系列性能测试,包括顺序读写、随机读写以及不同读写负载下的性能测试。

5.1 顺序读写性能测试在顺序读写性能测试中,我们使用了`dd`命令进行测试。

对于顺序读测试,我们从磁盘阵列中读取了一个大文件,并计算了读取速度。

对于顺序写测试,我们向磁盘阵列中写入一个大文件,并计算了写入速度。

5.2 随机读写性能测试在随机读写性能测试中,我们使用了`fio`工具进行测试。

我们设置了一系列随机读写的负载,包括不同的队列深度和线程数,并分别测试了随机读和随机写的性能。

通过分析测试结果,我们评估了磁盘阵列在不同负载下的性能表现。

5.3 不同读写负载下的性能测试在不同读写负载下的性能测试中,我们使用了`iozone`工具进行测试。

计算机系统结构实验报告班级:xxxxxxxxxxxxxxxx 姓名:xxxxxx 学号:2xxxxxxxxxxxxxx 报告完成时间:20xxxxxxxx计算机系统结构实验报告班级xxxxxxx 实验日期xxxxxxxxx 实验成绩姓名xxxxxxxxxx 学号xxxxxxxxxxxx实验名称存储系统RAID 性能测试实验目的、要求及器材实验目的与要求:①掌握RAID0-5的基本组织方式和特点②RAID0,1,5配置与简单测试;③探究RAID的小写性能或参数敏感性实验器材:虚拟LINUX环境Ubuntu;d isksim-4.0;计算机一台。

实验内容、步骤及结果1.编译Disksim①通过邮件将disksim-4.0.tar.gz和ssd-add-on.zip传送至Ubuntu。

②Tar -vxzf disksim-4.0.tar.gz③在disksim-4.0中编译 make④Unzip ../ssd-add-on.zip⑤patch -p1 < ssdmodel/ssd-patch⑥在Ssdmodel中make⑦进入valid,chmod a+x runvalidOK now!在disksim-4.0中的valid或者ssdmodel/valid 中执行./runvalid即可得到所有文件的测试结果2.修改parv内logorg,模拟RAID0有效盘数设为5Raid0.parv中参数设置如下# component instantiationinstantiate [ statfoo ] as Statsinstantiate [ ctlr0 .. ctlr4 ] as CTLR0instantiate [ bus0 ] as BUS0instantiate [ disk0 .. disk4 ] as HP_C3323Ainstantiate [ driver0 ] as DRIVER0instantiate [ bus1 .. bus5 ] as BUS1# end of component instantiation# system topology[设为5个盘并行的拓扑结构]设置冗余模式、编址模式、分配策略等:disksim_logorg org0 {Addressing mode = Array,Distribution scheme = Striped,Redundancy scheme = Noredun,devices = [ disk0 .. disk4 ],Stripe unit = 64,……}设置随机概率Probability of sequential access = 0.2,Probability of local access = 0.4,Probability of read access = 0.66,Probability of time-critical request = 0.1,Probability of time-limited request = 0.3,存储器总容量为Storage capacity per device = 2056008*5 = 10280040,接下来便可进行虚拟测试../src/disksim raid0.parv raid0.txt ascii 0 1打开raid0.txt查看测试结果:Overall I/O System Total Requests handled: 10002Overall I/O System Requests per second: 100.928186Overall I/O System Completely idle time: 11953.034363 0.120616Overall I/O System Response time average: 24.486686Overall I/O System Response time std.dev.: 13.542895Overall I/O System Response time maximum: 137.672973Overall I/O System Response time distribution< 5 < 10 < 20 < 40 < 60 < 90 <120 <150 <200 200+ 196 332 3551 4960 690 220 44 9 0 0可见raid0 组织模式的I/O系统平均响应时间为24.486686 ms3.修改parv内logorg,模拟RAID1有效盘数设为4Raid1.parv中参数设置如下# component instantiationinstantiate [ statfoo ] as Statsinstantiate [ ctlr0 .. ctlr7 ] as CTLR0instantiate [ bus0 ] as BUS0instantiate [ disk0 .. disk7 ] as HP_C3323Ainstantiate [ driver0 ] as DRIVER0instantiate [ bus1 .. bus8 ] as BUS1# end of component instantiation# system topology[设为8个盘并行的拓扑结构]冗余模式设为Redundancy scheme = Shadowed,存储容量 Storage capacity per device = 8224032,其余设置同raid0接下来进行虚拟测试../src/disksim raid1.parv raid1.txt ascii 0 1打开raid1.txt查看测试结果:OVERALL I/O SYSTEM STATISTICS-----------------------------Overall I/O System Total Requests handled: 9999Overall I/O System Requests per second: 100.452735Overall I/O System Completely idle time: 12533.813298 0.125918Overall I/O System Response time average: 23.141863Overall I/O System Response time std.dev.: 11.234684Overall I/O System Response time maximum: 136.662648Overall I/O System Response time distribution< 5 < 10 < 20 < 40 < 60 < 90 <120 <150 <200 200+ 185 255 3912 4958 553 114 21 1 0 0可见raid1 组织模式的I/O系统平均响应时间为23.141863 ms4.修改parv内logorg,模拟RAID5有效盘数设为4Raid0.parv中参数设置如下# component instantiationinstantiate [ statfoo ] as Statsinstantiate [ ctlr0 .. ctlr4 ] as CTLR0instantiate [ bus0 ] as BUS0instantiate [ disk0 .. disk4 ] as HP_C3323Ainstantiate [ driver0 ] as DRIVER0instantiate [ bus1 .. bus5 ] as BUS1# end of component instantiation# system topology[设为5个盘并行的拓扑结构]冗余模式设为Redundancy scheme = Parity_rotated,存储容量 Storage capacity per device = 8224032,其余设置同raid0接下来进行虚拟测试../src/disksim raid5.parv raid5.txt ascii 0 1打开raid5.txt查看测试结果:OVERALL I/O SYSTEM STATISTICS-----------------------------Overall I/O System Total Requests handled: 10001Overall I/O System Requests per second: 100.494066Overall I/O System Completely idle time: 6.907489 0.000069Overall I/O System Response time average: 56.222291Overall I/O System Response time std.dev.: 49.033242Overall I/O System Response time maximum: 480.847859Overall I/O System Response time distribution< 5 < 10 < 20 < 40 < 60 < 90 <120 <150 <200 200+ 109 164 1496 3273 1722 1503 752 439 324 219可见raid5 组织模式的I/O系统平均响应时间为56.222291 ms5.探究性试验设计实验,任意选择其中一种RAID模式,分析验证其参数敏感性参数包括盘数,条带大小敏感性指,给定负载,其性能是否会随着参数变化而剧烈变化本实验采用ssdmodel执行,期间同时加载了<tracefile> 和<synthgen>发现得到的结果反而相差不大,所以后来只加载了ssd-postmark-aligned2.trace。

第1篇一、实验目的1. 理解磁盘的工作原理和结构,了解磁盘寻道的基本概念。

2. 掌握常用的磁盘寻道算法,如先来先服务(FCFS)、最短寻道时间优先(SSTF)、SCAN和循环SCAN算法。

3. 比较不同磁盘寻道算法的性能,分析其优缺点。

4. 提高对操作系统磁盘管理模块的理解。

二、实验内容1. 磁盘结构及工作原理2. 磁盘寻道算法a. 先来先服务(FCFS)算法b. 最短寻道时间优先(SSTF)算法c. SCAN算法d. 循环SCAN算法3. 实验数据及结果分析三、实验步骤1. 磁盘结构及工作原理(1)观察实验所提供的磁盘,了解其结构及工作原理。

(2)记录磁盘的转速、平均寻道时间、磁盘传输速率等参数。

2. 磁盘寻道算法(1)编写程序模拟FCFS算法,输入一组磁盘请求,输出磁头移动轨迹及磁头移动距离。

(2)编写程序模拟SSTF算法,输入一组磁盘请求,输出磁头移动轨迹及磁头移动距离。

(3)编写程序模拟SCAN算法,输入一组磁盘请求,输出磁头移动轨迹及磁头移动距离。

(4)编写程序模拟循环SCAN算法,输入一组磁盘请求,输出磁头移动轨迹及磁头移动距离。

3. 实验数据及结果分析(1)收集实验数据,包括不同磁盘寻道算法的磁头移动轨迹及磁头移动距离。

(2)比较不同磁盘寻道算法的性能,分析其优缺点。

(3)根据实验结果,得出结论。

四、实验结果与分析1. FCFS算法FCFS算法是一种简单的磁盘寻道算法,按照请求顺序服务磁盘请求。

该算法的优点是实现简单,缺点是效率较低,容易产生“饥饿现象”。

2. SSTF算法SSTF算法优先处理距离磁头最近的磁盘请求,以减少磁头移动距离。

该算法的优点是寻道时间较短,缺点是可能会造成某些请求长时间得不到服务。

3. SCAN算法SCAN算法按照磁道顺序移动磁头,当磁头到达磁盘的另一端时,反向移动。

该算法的优点是寻道时间较短,且公平性较好,缺点是可能会产生“振荡现象”。

4. 循环SCAN算法循环SCAN算法是SCAN算法的一种改进,当磁头到达磁盘的另一端时,不再反向移动,而是继续按照磁道顺序移动。

计算机系统结构实验报告

班

级

实验日期

实验成绩

学号

实

验

名

称

计算机系统结构实验5(磁盘、固态盘仿真)

实

验

目

的

、

要

求

编译Disksim,测试单个磁盘的性能(Response time)

配置RAID0、RAID1、RAID5并做性能测试

探究性实验(2选1)

实

验

容

、

步

骤

及

结

果

一、编译D ISKSIM,测试单个磁盘的性能(R ESPONSE TIME)

测试某个磁盘,cheetah4LP.parv

../src/disksim cheetah4LP.parv cheetah4LP.outv validate cheetah4LP.trace 0 查看相应的outv文件,获取响应时间结果,使用grep命令得到

grep "IOdriver Response time average" cheetah4LP.outv

二、配置RAID0、RAID1、RAID5并做性能测试

(1)RAID5:为了方便对性能进行比较,进行如下的参数修改:

保存为synthraid5.parv,并进行测试

(2)RAID0:删除多余的generator 0 只留下一个,做如下更改:

保存为synthraid0.parv,并进行测试

(3)RAID1:删除多余的generator 0 只留下一个,做如下更改:

保存为synthraid1.parv,并进行测试

结论:通过测试我们可以发现在有效存储容量相同的情况下,RAID0使用的时间最少,速度最快。

三、探究性实验(2选1)

设计实验,任意选择其中一种RAID模式,分析验证其参数敏感性

参数包括盘数,条带大小。

◎敏感性指:给定负载,其性能是否会随着参数变化而剧烈变化?

◎看上去完全没变化?注意负载强度是否足够。

这里我们选择RAID5模式进行测试。

(1)条带大小一定,磁盘数改变

此时(Stripe unit = 64,Parity stripe unit = 64)

磁盘个数7个8个9个10个11个

设备有效容量12336048 14392056 16448064 18504072 20560080 Synthetic结

21.657719 20.865686 20.332438 19.923599 19.728367

果

2014.436976 1355.984474 1019.857911 882.827067 676.563854 Financial结

果

从一二两幅图中我们可以看到性能受磁盘个个数影响明显,对参数磁盘个数敏感,随着磁盘个数的增加,花费的时间减少。

通过第三幅图我们可以看到当负载比较大的时候这种影响格外明显。

(2)磁盘数一定条带大小改变

此时 devices = [ disk0 .. disk7],Storage capacity per device = 14392056, I(2^i) 6 7 8 9 10 11

条带大小64 128 256 512 1024 2048 Synthetic结果20.865686 20.746338 20.819863 20.569234 20.548522 20.551389

Financial结果1355.98447

4

1513.5870

13

1343.2734

10

1591.5768

56

1461.6568

59

1363.0097

25

从图一图二中我们可以看出条带的大小会影响到磁盘读写的性能,但这种影响并不是规律性的,而且性能基本是在一定围波动变化,我们可以认为磁盘对于参数条带大小的变化不是十分敏感。

同时通过第三幅图我们可以看到负载大波动的围也会相应的变大。

四、思考题

考虑以下应用场景,选择你认为合适的RAID设计RAID模式,条带大小(给出大致围即可)并给出理由:

A.非线性编辑工作站(做视频编辑的电脑)

答:RAID0,32~64;视频编辑一般处理起来文件比较大,速度比较慢,为了让并行性更好,我们应该让条带大小变小,磁盘个数变多,同时一个磁盘的失效并不会带来太大损失,只需等待其恢复即可继续进行视频处理。

B.web服务器

答:RAID1,128,web服务器对数据的可靠性要求更高,RAID1出现磁盘损坏系统仍然能够工作,速度也比较快

C.代理服务器

答:RAID1,128,代理器对数据的可靠性要求更高,RAID1出现磁盘损坏系统仍然能够工作,速度也比较快

D.FTP服务器

答:RAID3,128,当某个磁盘发生错误的时候磁盘控制器本身能够很容易的发现那个磁盘出错。

并且检验空间开销也比较小。