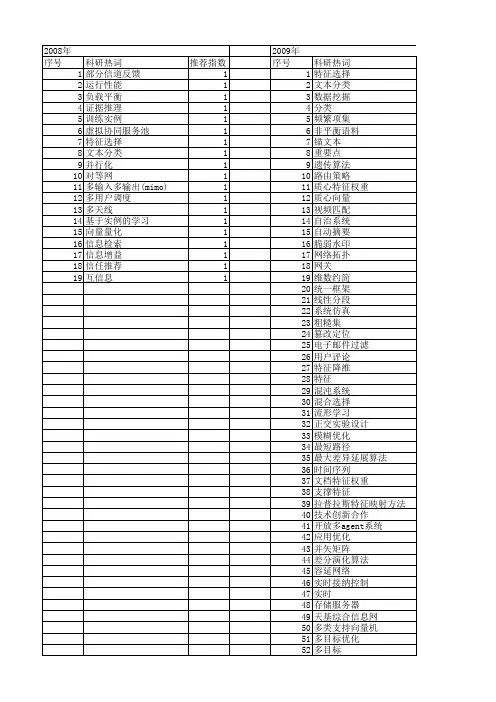

谭松波中文文本分类语料_数据挖掘_科研数据集

- 格式:pdf

- 大小:35.51 KB

- 文档页数:1

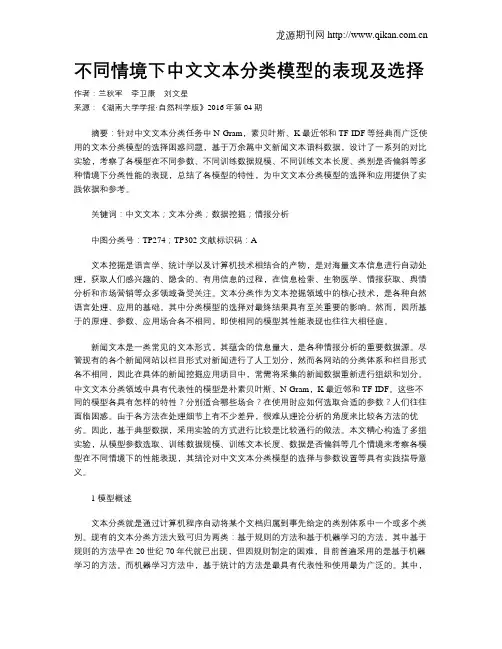

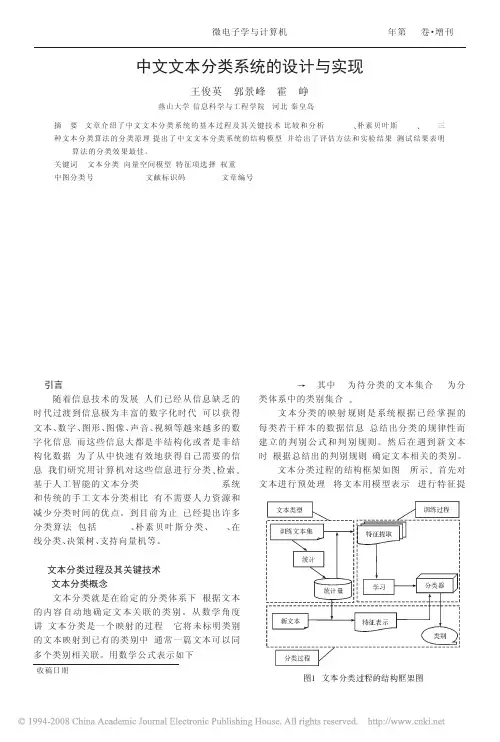

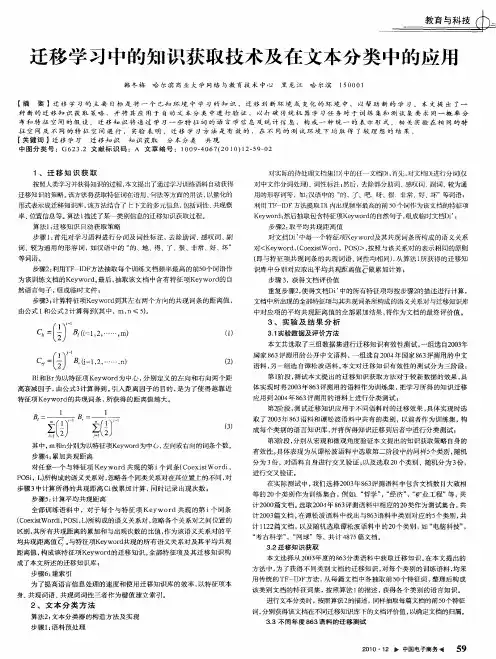

不同情境下中文文本分类模型的表现及选择作者:兰秋军李卫康刘文星来源:《湖南大学学报·自然科学版》2016年第04期摘要:针对中文文本分类任务中N-Gram,素贝叶斯、K最近邻和TF-IDF等经典而广泛使用的文本分类模型的选择困惑问题,基于万余篇中文新闻文本语料数据,设计了一系列的对比实验,考察了各模型在不同参数、不同训练数据规模、不同训练文本长度、类别是否偏斜等多种情境下分类性能的表现,总结了各模型的特性,为中文文本分类模型的选择和应用提供了实践依据和参考。

关键词:中文文本;文本分类;数据挖掘;情报分析中图分类号:TP274;TP302 文献标识码:A文本挖掘是语言学、统计学以及计算机技术相结合的产物,是对海量文本信息进行自动处理,获取人们感兴趣的、隐含的、有用信息的过程,在信息检索、生物医学、情报获取、舆情分析和市场营销等众多领域备受关注。

文本分类作为文本挖掘领域中的核心技术,是各种自然语言处理、应用的基础。

其中分类模型的选择对最终结果具有至关重要的影响。

然而,因所基于的原理、参数、应用场合各不相同,即使相同的模型其性能表现也往往大相径庭。

新闻文本是一类常见的文本形式,其蕴含的信息量大,是各种情报分析的重要数据源。

尽管现有的各个新闻网站以栏目形式对新闻进行了人工划分,然而各网站的分类体系和栏目形式各不相同,因此在具体的新闻挖掘应用项目中,常需将采集的新闻数据重新进行组织和划分。

中文文本分类领域中具有代表性的模型是朴素贝叶斯、N-Gram,K最近邻和TF-IDF。

这些不同的模型各具有怎样的特性?分别适合哪些场合?在使用时应如何选取合适的参数?人们往往面临困惑。

由于各方法在处理细节上有不少差异,很难从理论分析的角度来比较各方法的优劣。

因此,基于典型数据,采用实验的方式进行比较是比较通行的做法。

本文精心构造了多组实验,从模型参数选取、训练数据规模、训练文本长度、数据是否偏斜等几个情境来考察各模型在不同情境下的性能表现,其结论对中文文本分类模型的选择与参数设置等具有实践指导意义。

人工智能自然语言技术练习(试卷编号191)1.[单选题]以下四个任务中,逻辑回归可以做哪个A)数据降维B)垃圾邮件分类C)电影票房预测D)房价预测答案:B解析:2.[单选题]CART回归树和XGBoost使用的什么相同的方法去寻找最优结果A)贪心算法B)线性回归C)逻辑回归D)岭回归答案:A解析:3.[单选题]tf.reverse的正确说法是哪一项?A)沿着某一维度连结tensorB)沿着某一维度将tensor分离为num_split tensorsC)对tensor进行切片操作D)沿着某维度进行序列反转答案:D解析:4.[单选题]GAN网络指的是哪个网路A)生成对抗网络B)卷积神经网络C)循环神经网络D)全连接网络答案:A解析:5.[单选题]以下四个表达式中,哪个属于线性回归模型的数学表达式A)Y=K*X+bB)Y=lnXC)Y=XD)Y=K*X6.[单选题]( )函数用于搜索搭配词语。

A)concordanceB)common_contextsC)collocationsD)Sorted答案:C解析:7.[单选题]自然语言处理难点目前有四大类,下列选项中不是其中之一的是A)机器性能B)语言歧义性C)知识依赖D)语境答案:A解析:8.[单选题]对于数据的处理过程过采样和欠采样可以解决什么问题的A)词向量化处理B)提取特征C)样本类别不平衡D)文本摘要处理答案:C解析:9.[单选题]在预处理极端,关于数据归一化的描述正确的哪个选项A)通过中值和均值进行确定B)通过方差和均值确定C)通过平均值和最小值确定D)通过标准差和均值确定答案:B解析:10.[单选题]()根据文本的不同特征划分为不同的类A)文本概括B)文本分类C)文本聚类D)都可以答案:C解析:A)传统EM算法对初始值不敏感B)EM算法不能应用到HMM的求解中C)不确定D)传统EM算法对初始值敏感答案:D解析:12.[单选题]能根据学生的特点、 弱点和基础知识, 以最适当的教案和教学方法对学生进行教学和辅导的专家系统是( )。

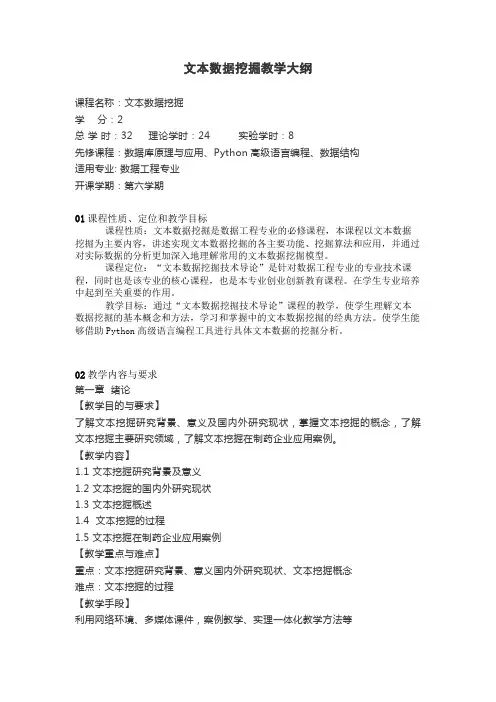

文本数据挖掘教学大纲课程名称:文本数据挖掘学分:2总学时:32 理论学时:24 实验学时:8先修课程:数据库原理与应用、Python高级语言编程、数据结构适用专业: 数据工程专业开课学期:第六学期01课程性质、定位和教学目标课程性质:文本数据挖掘是数据工程专业的必修课程,本课程以文本数据挖掘为主要内容,讲述实现文本数据挖掘的各主要功能、挖掘算法和应用,并通过对实际数据的分析更加深入地理解常用的文本数据挖掘模型。

课程定位:“文本数据挖掘技术导论”是针对数据工程专业的专业技术课程,同时也是该专业的核心课程,也是本专业创业创新教育课程。

在学生专业培养中起到至关重要的作用。

教学目标:通过“文本数据挖掘技术导论”课程的教学,使学生理解文本数据挖掘的基本概念和方法,学习和掌握中的文本数据挖掘的经典方法。

使学生能够借助Python高级语言编程工具进行具体文本数据的挖掘分析。

02教学内容与要求第一章绪论【教学目的与要求】了解文本挖掘研究背景、意义及国内外研究现状,掌握文本挖掘的概念,了解文本挖掘主要研究领域,了解文本挖掘在制药企业应用案例。

【教学内容】1.1 文本挖掘研究背景及意义1.2 文本挖掘的国内外研究现状1.3 文本挖掘概述1.4 文本挖掘的过程1.5 文本挖掘在制药企业应用案例【教学重点与难点】重点:文本挖掘研究背景、意义国内外研究现状、文本挖掘概念难点:文本挖掘的过程【教学手段】利用网络环境、多媒体课件,案例教学、实理一体化教学方法等【课后作业】1. 文本挖掘与数据挖掘有何联系和区别?2. 目前文本挖掘的领域主要涉及到哪些?第二章文本切分及特征词选择【教学目的与要求】掌握文本数据采集的常用方法、了解中文语料库与词典,熟练掌握文本切分和文本特征词选择的方法,熟练掌握Python Jieba分词模块及其用法。

【教学内容】2.1 文本数据采集2.2 语料库与词典简介2.3 文本切分2.4 文本特征词选择2.5 Python Jieba分词模块及其用法【教学重点与难点】重点:文本切分、文本特征词选择、Python Jieba分词模块及其用法难点:Python Jieba分词模块及其用法【教学手段】利用网络环境、多媒体课件,案例教学、实理一体化教学方法等【课后作业】1 利用现代汉语语料库进行一段中文文本的汉语分词、词性自动标注、字频统计和词频统计。

第 22卷第 4期2023年 4月Vol.22 No.4Apr.2023软件导刊Software Guide基于Albert与TextCNN的中文文本分类研究李飞鸽,王芳,黄树成(江苏科技大学计算机学院,江苏镇江,212100)摘要:互联网数据众多,为高效管理互联网的海量中文文本数据,提出基于Albert与TextCNN的中文文本分类方法(ATT)。

该方法引入Albert模型解决一词多义问题,使用TF-IDF算法抽取当前文本数据中权重最高的5个词构建整个文档关键词表,将关键词表与Albert生成的词向量进行向量拼接,构成一个融合关键词信息的多义词向量。

并且,在传统TextCNN基础上根据中文语言特点调整卷积核窗口大小以提取文本数据的深层局部特征。

实验表明,ATT模型相较于未加入TF-IDF关键词表、未调整卷积核大小的传统模型,F1值分别提升1.88%和2.26%,为中文文本分类提供了一种新方法。

关键词:向量;文本特征提取;多标签;文本分类DOI:10.11907/rjdk.221591开放科学(资源服务)标识码(OSID):中图分类号:TP391.1 文献标识码:A文章编号:1672-7800(2023)004-0027-05Research on Chinese Text Classification Based on Albert and TextCNNLI Fei-ge, WANG Fang, HUANG Shu-cheng(School of Computer, Jiangsu University of Science and Technology, Zhenjiang 212100, China)Abstract:Due to the large amount of Internet data, in order to efficiently manage the massive Chinese text data on the Internet, a Chinese text classification method based on Albert and TextCNN (referred to as ATT) is proposed. This method introduces Albert model to solve the problem of polysemy. TF-IDF algorithm is used to extract the five words with the highest weight in the current text data to build the whole docu‐ment keyword table. The keyword table and the word vector generated by Albert are vector spliced to form a polysemy word vector that inte‐grates keyword information. Moreover, on the basis of traditional TextCNN, the window size of convolution kernel is adjusted according to the characteristics of Chinese language to extract the deep local features of text data. The experimental results show that the ATT model, compared with the traditional model without TF-IDF keyword list and without adjusting the size of convolution kernel, increases the F1 value by 1.88% and 2.26% respectively, providing a new method for Chinese text classification.Key Words:word vector; text feature extraction; multi-label; text classification0 引言在移动互联时代,文本数据呈现爆炸式增长。

复旦开源中文金融语料

近年来,人工智能和数据挖掘技术的快速发展,对金融领域的应

用带来了巨大的机遇和挑战。

在这个背景下,为金融领域提供高质量

的中文语料库,是很有价值的工作。

近日,复旦大学推出了一款开源

的中文金融语料库,为金融领域的研究和应用提供了很好的数据基础。

这款中文金融语料库包含了数十万条金融相关的中文文本数据,

包括了新闻、评论、公告和研报等多种形式的文本。

这些数据的来源

包括了多家国内金融机构、媒体和研究机构,能够广泛而全面地反映

出金融领域的动态和趋势。

此外,中文金融语料库还提供了多种数据预处理和分析工具,包

括了分词、文本分类、命名实体识别和情感分析等功能。

这些工具能

够帮助研究人员更加高效地处理和分析语料库中的数据,从而挖掘出

潜在的金融风险和机会。

复旦大学的中文金融语料库不仅为学术界提供了丰富的研究资源,也为金融业内的从业人员提供了实践应用的支持。

比如,通过对金融

市场的新闻和评论进行情感分析,可以推测市场的情绪和预期,提前

布局投资策略;通过对上市公司的公告进行文本分类,可以及时了解

公司的业务和发展动态,从而更好地评估投资价值。

中文金融语料库的开源意味着数据的透明和共享,为更多的研究

机构和从业人员提供了便利。

同时,也能够促进数据科学和人工智能

技术在金融领域的应用,加快金融创新和发展。

总之,中文金融语料库的推出,为金融领域的研究和应用提供了

重要的基础资源。

相信在大家的共同努力下,这个资源将不断完善和

更新,为金融领域的创新和发展带来更大的动力和支持。

Google word2vec 学习基础陈良臣2015年10月18日1. word2vec简介word2vec是word to vector 的缩写。

word2vec 是Google 在2013年年中开源的一款将词表征为实数值向量的高效工具,采用的模型有CBOW(Continuous Bag-Of-Words,即连续的词袋模型)和Skip-Gram 两种。

能够把词映射到K维向量空间,甚至词与词之间的向量操作还能和语义相对应。

(word2vec 通过训练,可以把对文本内容的处理简化为K 维向量空间中的向量运算,而向量空间上的相似度可以用来表示文本语义上的相似度。

) 因此,word2vec输出的词向量可以被用来做很多NLP相关的工作,比如聚类、找同义词、词性分析等等。

如果换个思路,把词当做特征,那么Word2vec就可以把特征映射到K 维向量空间,可以为文本数据寻求更加深层次的特征表示。

2. 词向量介绍词向量就是用来将语言中的词进行数学化的一种方式,顾名思义,词向量就是把一个词表示成一个向量。

词向量,顾名思义,就是用一个向量来表示一个单词,这个向量不是随便的一个,而是根据单词在语料中的上下文而产生,具有意义的向量。

而word2vec 就是根据语料来生成单词向量的一个工具。

生成单词向量有什么用?最主要的一点就是用来计算相似度。

直接计算两个词的余弦值便可以得到。

一种最简单的词向量方式是one-hot representation,就是用一个很长的向量来表示一个词,向量的长度为词典的大小,向量的分量只有一个1,其他全为0,1 的位置对应该词在词典中的位置。

举个例子,“话筒”表示为[0 0 0 1 00 0 0 0 0 0 0 0 0 0 0 ...]“麦克”表示为[0 0 0 0 00 0 0 1 0 0 0 0 0 0 0 ...]每个词都是茫茫0 海中的一个1。

3. word2vec代码word2vec的原版代码是google code上的,基于c语言。

中文文本分类语料文本自动分类就是用电脑对文本按照一定的分类体系或标准进行自动分类标记。

文本分类问题与其它分类问题没有本质上的区别,其方法可以归结为根据待分类数据的某些特征来进行匹配,当然完全的匹配是不太可能的,因此必须(根据某种评价标准)选择最优的匹配结果,从而完成分类。

现如今,统计学习方法已经成为了文本分类领域绝对的主流。

统计学习方法需要一批由人工进行了准确分类的文档作为学习的材料(称为训练集,注意由人分类一批文档比从这些文档中总结出准确的规则成本要低得多),计算机从这些文档中挖掘出一些能够有效分类的规则,这个过程被形象的称为训练,而总结出的规则集合常常被称为分类器。

训练完成之后,需要对计算机从来没有见过的文档进行分类时,便使用这些分类器来进行。

下面提供一些网上能下载到的中文的好语料,供研究人员学习使用。

1.中科院自动化所的中英文新闻语料库/data/13484中文新闻分类语料库从凤凰、新浪、网易、腾讯等版面搜集。

英语新闻分类语料库为Reuters-21578的ModApte版本。

2.搜狗的中文新闻语料库/labs/dl/c.html包括搜狐的大量新闻语料与对应的分类信息。

有不同大小的版本可以下载。

3.李荣陆老师的中文语料库 /data/11968压缩后有240M大小4.谭松波老师的中文文本分类语料/data/11970不仅包含大的分类,例如经济、运动等等,每个大类下面还包含具体的小类,例如运动包含篮球、足球等等。

能够作为层次分类的语料库,非常实用。

5.网易分类文本数据/data/11965包含运动、汽车等六大类的4000条文本数据。

6.中文文本分类语料/data/11963包含Arts、Literature等类别的语料文本。

7.更全的搜狗文本分类语料 /labs/dl/c.html搜狗实验室发布的文本分类语料,有不同大小的数据版本供免费下载8.2002年中文网页分类训练集/data/150212002年秋天北京大学网络与分布式实验室天网小组通过动员不同专业的几十个学生,人工选取形成了一个全新的基于层次模型的大规模中文网页样本集。

基于不平衡数据集的文本分类技术

王成强

【期刊名称】《电脑知识与技术》

【年(卷),期】2009(005)036

【摘要】文本自动分类是信息检索和数据挖掘领域的研究热点和核心技术,但是在实际应用中,经常会出现文本实例中一些类中欧冠的文本很多,而另一些类中的文本较少的情况,而这些应用往往就是为了预测其中很少出现但很重要的文本,这就是所谓的文本分类不平衡问题.传统方法对少数类的识别率低,如何有效的提高少数类的分类性能成为机器学习和模式识别领域亟待解决的问题.因此,该文针对提高不平衡数据集中的少数类文本的分类性能之一问题,从数据层面处理的角度对数据进行重抽样.使用随机抽样的方法以提高分类器在非平衡数据集上的泛化性能.

【总页数】3页(P10571-10572,10589)

【作者】王成强

【作者单位】贵州大学计算机科学与信息学院,贵州,贵阳,550025

【正文语种】中文

【中图分类】TB565

【相关文献】

1.基于不平衡数据集的文本分类技术研究 [J], 白凤凤

2.不平衡数据集上的文本分类特征选择新方法 [J], 张玉芳;王勇;熊忠阳;刘明

3.基于偏斜数据集的文本分类特征选择方法研究 [J], 刘振岩;孟丹;王伟平;王勇

4.基于TF-IDF特征词提取的不平衡文本分类 [J], 陈欢;王忠震

5.基于不平衡文本分类的改进Stacking模型 [J], 蒋瑶;赵礼峰

因版权原因,仅展示原文概要,查看原文内容请购买。