如何用Python机器学习搞定爬虫验证码

- 格式:pdf

- 大小:381.94 KB

- 文档页数:7

python爬虫点选验证码原理Python爬虫点选验证码原理随着网络的迅速发展,爬虫技术已经成为大数据挖掘、自动化测试以及网站内容抓取的重要工具。

然而,随之而来的是各种反爬虫机制,其中之一就是验证码。

验证码是一种用于区分人类用户和机器爬虫的技术手段,通过要求用户在网页上输入或者点选处理图片中的文字、数字或者图片等信息,从而验证用户是人类而非机器。

本文将详细介绍Python爬虫点选验证码的原理,并提供一种实现该功能的方法。

1. 了解验证码首先,为了能够成功应对验证码的阻挠,我们需要了解验证码的工作原理。

一般来说,验证码主要有两个组成部分:生成部分和验证部分。

生成部分负责产生随机的验证码数据,通常以图片的形式展示给用户。

而验证部分则负责接收用户输入的验证码数据,并与生成部分产生的验证码进行比对,判断用户是否输入正确。

2. 识别验证码类型在实施爬虫点选验证码之前,我们需要先识别验证码的类型,以便确定采取相应的处理方法。

常见的验证码类型包括文字型验证码、数字型验证码和滑动验证码等。

3. 分析验证码布局针对不同类型的验证码,我们需要分析其布局,找出用户需要点击的有效区域。

这通常涉及到对验证码图片的像素分析、图像处理以及目标检测等技术。

通过分析验证码布局,我们可以确定用户需要点击的关键坐标位置。

4. 模拟用户操作接下来,我们需要模拟用户的操作,通过自动化脚本模拟用户在浏览器上的点击行为,将鼠标指针移动到准确的坐标位置,并模拟点击操作。

通过模拟用户操作,我们可以成功通过验证码的验证。

5. 应对反爬虫策略为了应对网站的反爬虫策略,我们还需要模拟用户的其他行为,例如:模拟鼠标移动轨迹、添加延迟等,以使爬虫行为更加类似于真实用户。

综上所述,Python爬虫点选验证码主要包括了识别验证码类型、分析验证码布局、模拟用户操作和应对反爬虫策略等关键步骤。

通过理解验证码原理,并使用适当的技术方法,我们可以编写出一个能够自动识别、点击验证码的爬虫程序。

Python爬虫如何应对网站的验证码机制在当今的网络世界中,Python 爬虫成为了获取大量数据的有力工具。

然而,当我们在爬取网站数据时,常常会遇到网站设置的验证码机制这一“拦路虎”。

验证码的出现旨在防止自动化程序的过度访问和滥用,确保网站的正常运行和数据安全。

但对于爬虫开发者来说,如何有效地应对验证码机制就成为了一个必须解决的问题。

首先,我们需要了解一下常见的验证码类型。

目前,网站上常见的验证码有图像验证码、短信验证码、邮件验证码以及滑动验证码等。

图像验证码是最为常见的一种,通常包含数字、字母、汉字或者图形的组合。

这种验证码的识别难度较大,对于爬虫来说是一个不小的挑战。

短信验证码和邮件验证码则是通过向用户的手机或邮箱发送一串随机生成的数字或字符,用户在输入正确的验证码后才能继续进行操作。

这种方式相对较为安全,但对于爬虫来说,获取验证码的难度极高。

滑动验证码则要求用户通过拖动滑块完成指定的动作,以验证用户的真实性。

那么,面对这些种类繁多的验证码,Python 爬虫可以采取哪些策略呢?一种常见的方法是使用打码平台。

打码平台是专门提供验证码识别服务的第三方平台。

我们可以将获取到的验证码图片发送到打码平台,由打码平台的工作人员或者机器进行识别,并返回识别结果。

这种方法的优点是简单快捷,不需要自己进行复杂的图像处理和识别算法开发。

但缺点是需要支付一定的费用,并且识别的准确率可能会受到一定的影响。

另一种方法是通过机器学习和深度学习算法来自己训练验证码识别模型。

这种方法需要大量的验证码样本数据进行训练,并且需要一定的数学和编程基础。

但一旦训练成功,识别准确率会相对较高,并且可以根据不同网站的验证码特点进行定制化的训练。

在处理图像验证码时,我们可以先对获取到的验证码图片进行预处理,例如灰度化、二值化、去噪等操作,以提高后续识别的准确性。

然后,可以使用诸如模板匹配、特征提取、神经网络等算法进行识别。

对于短信验证码和邮件验证码,由于获取的难度较大,我们可以尝试模拟用户的注册和登录过程,获取网站发送验证码的接口,并通过自己的手机或者邮箱接收验证码。

Python网络爬虫中的像识别与验证码破解Python网络爬虫中的图片识别与验证码破解Python网络爬虫是一种自动化获取互联网页面数据的工具,然而在进行数据爬取时,往往会遇到验证码这一关。

验证码通常通过图片形式呈现,为了防止恶意爬取和机器人攻击。

本文将介绍在Python网络爬虫中如何进行图片识别与验证码破解的技术。

一、验证码的作用与类型简介验证码(CAPTCHA,全自动区分计算机和人类的公开图灵测试)主要用于区别真实用户和机器人,根据其形式和特点,验证码分为以下几种类型:1. 图片验证码:通过图片形式展示的验证码,常见的有数字、字母、汉字、图形等。

2. 文字验证码:通过文本形式展示的验证码,需要用户输入指定的文字或数字。

3. 声音验证码:通过声音形式展示的验证码,需要用户听取验证码并输入。

二、Python图像处理库与机器学习算法在进行图片识别与验证码破解之前,我们需要使用Python图像处理库和机器学习算法来实现相关功能。

常用的Python图像处理库包括PIL(Python Imaging Library)和OpenCV(Open Source ComputerVision Library),机器学习算法中常用的有卷积神经网络(CNN)和支持向量机(SVM)等。

三、图片验证码的识别与破解针对图片验证码的识别与破解,我们可以分以下几个步骤进行:1. 图片预处理:导入图片验证码并将其转化为灰度图像,去除噪声和干扰,提高图像质量。

2. 分割字符:对预处理后的图像进行字符分割,将每个字符单独提取出来,形成字符图像序列。

3. 特征提取:对字符图像序列进行特征提取,常用的方法有灰度直方图、图像边缘、图像梯度等。

4. 模型训练与预测:使用机器学习算法(如CNN、SVM等)对提取的特征进行训练,并预测验证码中每个字符的结果。

5. 文本合并与输出:将预测结果进行合并,并输出识别出来的验证码。

四、应用案例以下是一个示例,演示如何使用Python进行图片验证码的识别与破解:```pythonimport PILfrom PIL import Imageimport pytesseractdef image_to_text(image_path):im = Image.open(image_path)text = pytesseract.image_to_string(im)return textimage_path = 'captcha.png'text = image_to_text(image_path)print(text)```通过上述代码,我们可以将指定路径下的验证码图片进行识别,并将结果打印输出。

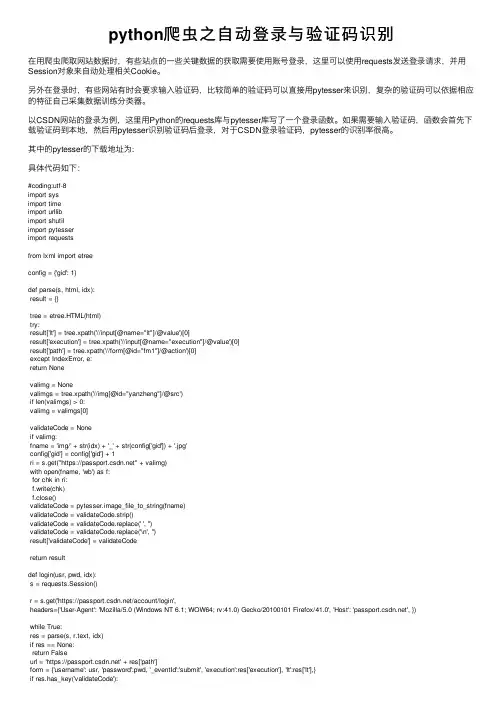

python爬⾍之⾃动登录与验证码识别在⽤爬⾍爬取⽹站数据时,有些站点的⼀些关键数据的获取需要使⽤账号登录,这⾥可以使⽤requests发送登录请求,并⽤Session对象来⾃动处理相关Cookie。

另外在登录时,有些⽹站有时会要求输⼊验证码,⽐较简单的验证码可以直接⽤pytesser来识别,复杂的验证码可以依据相应的特征⾃⼰采集数据训练分类器。

以CSDN⽹站的登录为例,这⾥⽤Python的requests库与pytesser库写了⼀个登录函数。

如果需要输⼊验证码,函数会⾸先下载验证码到本地,然后⽤pytesser识别验证码后登录,对于CSDN登录验证码,pytesser的识别率很⾼。

其中的pytesser的下载地址为:具体代码如下:#coding:utf-8import sysimport timeimport urllibimport shutilimport pytesserimport requestsfrom lxml import etreeconfig = {'gid': 1}def parse(s, html, idx):result = {}tree = etree.HTML(html)try:result['lt'] = tree.xpath('//input[@name="lt"]/@value')[0]result['execution'] = tree.xpath('//input[@name="execution"]/@value')[0]result['path'] = tree.xpath('//form[@id="fm1"]/@action')[0]except IndexError, e:return Nonevalimg = Nonevalimgs = tree.xpath('//img[@id="yanzheng"]/@src')if len(valimgs) > 0:valimg = valimgs[0]validateCode = Noneif valimg:fname = 'img/' + str(idx) + '_' + str(config['gid']) + '.jpg'config['gid'] = config['gid'] + 1ri = s.get("https://" + valimg)with open(fname, 'wb') as f:for chk in ri:f.write(chk)f.close()validateCode = pytesser.image_file_to_string(fname)validateCode = validateCode.strip()validateCode = validateCode.replace(' ', '')validateCode = validateCode.replace('\n', '')result['validateCode'] = validateCodereturn resultdef login(usr, pwd, idx):s = requests.Session()r = s.get('https:///account/login',headers={'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:41.0) Gecko/20100101 Firefox/41.0', 'Host': '', })while True:res = parse(s, r.text, idx)if res == None:return Falseurl = 'https://' + res['path']form = {'username': usr, 'password':pwd, '_eventId':'submit', 'execution':res['execution'], 'lt':res['lt'],}if res.has_key('validateCode'):form['validateCode'] = res['validateCode']s.headers.update({'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:41.0) Gecko/20100101 Firefox/41.0','Accept-Language': 'zh-CN,zh;q=0.8,en-US;q=0.6,en;q=0.4','Content-Type': 'application/x-www-form-urlencoded','Host': '','Origin': 'https://','Referer': 'https:///account/login','Upgrade-Insecure-Requests': 1,})r = s.post(url, data=form)tree = etree.HTML(r.text)err_strs = tree.xpath('//span[@id="error-message"]/text()')if len(err_strs) == 0:return Trueerr_str = err_strs[0]print err_strerr = err_str.encode('utf8')validate_code_err = '验证码错误'usr_pass_err = '帐户名或登录密码不正确,请重新输⼊'try_later_err = '登录失败连续超过5次,请10分钟后再试'if err[:5] == validate_code_err[:5]:passelif err[:5] == usr_pass_err[:5]:return Falseelif err[:5] == try_later_err[:5]:return Falseelse:return Trueif __name__ == '__main__':main(sys.argv[1], sys.argv[2], 0)以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

python识别验证码ocr_Python爬⾍过程中验证码识别的三种解决⽅案在Python爬⾍过程中,有些⽹站需要验证码通过后⽅可进⼊⽹页,⽬的很简单,就是区分是⼈阅读访问还是机器爬⾍。

验证码问题看似简单,想做到准确率很⾼,也是⼀件不容易的事情。

为了更好学习爬⾍,后续推⽂中将会更多介绍爬⾍问题的解决⽅案。

本篇推⽂将分享三种解决验证码的⽅法,如果你有⽐较好的⽅案,欢迎留⾔区讨论交流,共同进步。

1.pytesseract很多⼈学习python,不知道从何学起。

很多⼈学习python,掌握了基本语法过后,不知道在哪⾥寻找案例上⼿。

很多已经做案例的⼈,却不知道如何去学习更加⾼深的知识。

pytesseract是google做的ocr库,可以识别图⽚中的⽂字,⼀般⽤在爬⾍登录时验证码的识别,在安装pytesseract环境过程中会遇到各种坑的事情,如果你需要安装,可以按照如下流程去做,避免踩坑。

下⾯以 mac为例。

1.安装⽅法pip install pytesseract2.此外,还需安装Tesseract,它是⼀个开源的OCR引擎,能识别100多种语⾔。

brew install tesseract3.查看安装位置为brew list tesseract/usr/local/Cellar/tesseract/4.1.1/bin/tesseract/usr/local/Cellar/tesseract/4.1.1/include/tesseract/ (19 files)/usr/local/Cellar/tesseract/4.1.1/lib/libtesseract.4.dylib/usr/local/Cellar/tesseract/4.1.1/lib/pkgconfig/tesseract.pc/usr/local/Cellar/tesseract/4.1.1/lib/ (2 other files)/usr/local/Cellar/tesseract/4.1.1/share/tessdata/ (35 files)4.配置环境变量export TESSDATA_PREFIX=/usr/local/Cellar/tesseract/4.1.1/share/tessdataexport PATH=PATH:TESSDATA_PREFIX5.如何出现如下报错'TesseractNotFoundError: tesseract is not installed or it's not in your PATH'6.修改pytesseract.py的cmd'tesseract_cmd = '/usr/local/Cellar/tesseract/4.1.1/bin/tesseract''先验证⼀个简单的验证码代码如下from PIL import Image,ImageFilterimport pytesseractpath ='/Users/****/***.jpg'captcha = Image.open(path)result = pytesseract.image_to_string(captcha)print(result)51188再换⼀张试⼀下输⼊代码后,结果错误输出为1364由此看出,pytesseract对于简单⽅法有效,并不像有些⼈写的这么好,当然可以通过灰度、⼆值等⽅法,效果并不是很理想,稍微复杂的需要寻找其他解决⽅案,如果解决上述问题呢,我们看下⾯的解决⽅案。

Python网络爬虫的验证码识别与破解方法网络爬虫是一种用于自动获取网页信息的程序,它可以在互联网上自动化地浏览网页、抓取数据等。

然而,在进行网络爬取时,我们经常会遇到验证码的问题,这给爬虫程序带来了困扰。

本文将介绍基于Python的网络爬虫的验证码识别与破解方法。

一、验证码的作用与种类验证码(CAPTCHA)是为了区分人类用户和计算机程序的一种技术手段。

它目的在于阻止自动化程序(如爬虫)对网站进行恶意攻击,保障网站的安全性。

常见的验证码类型包括数字验证码、字母验证码、混合验证码、中文验证码等。

二、验证码识别的原理验证码识别是指通过计算机程序自动识别并破解验证码的过程。

常用的验证码识别方法包括图像处理与模式识别两部分内容。

图像处理主要用于降噪、二值化、分割等预处理操作,以便提取验证码中的有效信息。

模式识别则使用机器学习算法,通过训练模型来对验证码进行分类和识别。

三、验证码识别的Python库Python提供了许多强大的图像处理和机器学习库,为验证码识别提供了便捷的解决方案。

以下是常用的Python库:1. PIL(Python Imaging Library):用于图像预处理、特征提取等操作。

2. OpenCV(Open Source Computer Vision):提供了丰富的图像处理函数和工具。

3. Scikit-learn:用于机器学习任务,提供了常见的分类算法和模型评估方法。

4. TensorFlow:深度学习框架,可以应用于验证码的识别和破解。

5. Keras:基于TensorFlow的高级神经网络库,可以快速搭建验证码识别模型。

四、验证码识别与破解方法基于以上提到的Python库,我们可以采用以下方法来识别和破解验证码:1. 图像预处理:使用PIL和OpenCV库进行验证码图像的读取、降噪、二值化、分割等预处理操作。

2. 特征提取与选择:通过特征工程技术,提取验证码图像中的有效特征,如轮廓、颜色、形状等。

Python中的网络爬虫验证与反反爬机制解析网络爬虫是在互联网上自动抓取信息的程序,它们对于获取大量的数据以及进行数据分析和挖掘非常有用。

然而,为了保护网站的数据安全和防止恶意爬虫行为,许多网站都采取了验证策略和反反爬机制。

本文将介绍Python中的网络爬虫验证和反反爬机制,并提供解析策略的方法。

一、网络爬虫验证机制1. 验证码验证码是应用最为广泛的网络爬虫验证机制之一。

网站会在登录、提交表单等操作时要求用户输入验证码以确认其为真实用户。

在Python中,可以使用第三方库如Pillow和Tesseract-OCR来处理验证码,并自动识别和输入验证码。

另外,一些网站还会采用滑动验证码等更复杂的验证形式,需要通过模拟用户行为来绕过。

2. 用户代理用户代理(User Agent)是浏览器发送给服务器的标识,用于描述使用的浏览器类型和版本信息等。

许多网站会通过检查用户代理来识别爬虫。

为了模拟正常用户的行为,可以在爬虫请求头中设置合适的用户代理,例如使用常见浏览器的User Agent信息。

3. CookiesCookies是服务器保存在客户端的小型文本文件,用于跟踪用户的会话状态和个人偏好等信息。

一些网站会使用Cookies进行验证,例如保存用户的登录状态或者限制频繁访问。

在Python中,可以使用第三方库如requests库来处理Cookies,通过正确设置Cookies来通过验证。

二、反反爬机制解析1. 动态页面加载许多网站采用动态页面加载技术,将页面的内容通过Ajax或者JavaScript动态加载,而不是一次性传输。

这种技术可以减少爬虫的效率。

解析这类网页时,使用Python的selenium库可以模拟用户交互操作,获取完整的页面数据。

2. IP封禁一些网站会监控访问者的IP地址,并在发现大量访问或异常行为时进行封禁。

为了绕过IP封禁,可以使用代理IP进行访问。

Python中的第三方库如requests库提供了设置代理IP的功能,可以通过随机切换代理IP来避免封禁。

Python网络爬虫验证码处理与破解技术介绍网络爬虫是一种自动化检索和提取网络信息的程序。

然而,许多网站为了防止被爬虫程序过度利用,会使用验证码来验证用户的身份。

验证码是一种人机识别技术,通过要求用户输入特定的字符或执行特定的任务来确保用户是真人而不是机器。

对于Python网络爬虫来说,与验证码的处理与破解是一个重要而复杂的技术挑战。

一、验证码的类型及特点1. 图片验证码图片验证码是最常见的一种验证码形式。

它通常由一张包含随机字符和干扰元素的图片组成。

图片验证码的特点是难以被自动识别,需要利用图像处理算法进行处理分析。

2. 数字验证码数字验证码是指只包含数字字符的验证码。

相较于图片验证码,数字验证码的处理更为简单,只需要对字符进行识别即可。

3. 滑块验证码滑块验证码是一种常见的拖动验证形式,它通过要求用户在一个特定的滑块区域内进行操作,验证用户身份。

与其他验证码相比,滑块验证码更加难以破解,因为它涉及到用户与页面的交互。

4. 点击验证码点击验证码要求用户在某个特定区域内点击特定的图标或字符,以此来验证用户身份。

点击验证码相对较难破解,因为它需要模拟用户点击行为。

二、验证码的处理方法1. 图像处理算法对于图片验证码,可以使用图像处理算法进行处理分析,提取出验证码上的字符。

常用的算法包括图像二值化、去噪、字符分割等。

通过这些算法的组合运用,可以准确提取出验证码中的字符。

2. 机器学习方法机器学习方法在验证码处理中有广泛的应用。

可以使用已标注好的验证码数据集来训练模型,通过模型的学习和分类能力来进行验证码的识别。

3. 借助第三方接口有些网站为了方便用户,提供了验证码识别的API接口。

我们可以利用这些接口来进行验证码的识别,减少自行处理的工作量。

三、验证码的破解技术1. 验证码识别库验证码识别库是解决验证码问题的一个重要工具。

例如,Python中的Tesseract OCR库就是一种非常常用的验证码识别库,它可以处理多种类型的验证码,并且具有较高的识别准确性。

主题:Python 人工处理验证码实例随着互联网的发展,验证码作为一种人机交互检测工具,被广泛应用在各种全球信息湾和APP中,以防止恶意行为和机器人攻击。

然而,传统的验证码识别技术在面对各种变化多端的验证码时存在识别困难的问题。

针对这一问题,利用Python进行人工处理验证码成为了一种可行的解决方案。

1. Python 在验证码处理中的应用Python 作为一种简洁、高效的编程语言,具有丰富的第三方库和工具,可以帮助实现验证码的自动识别和处理。

通过结合Python的图像处理库和机器学习算法,可以有效地应对各种类型的验证码,提高验证码处理的准确性和效率。

2. 人工处理验证码的基本流程人工处理验证码一般包括验证码的获取、图像处理预处理、特征提取和识别等步骤。

需要从目标全球信息湾或APP中获取验证码图片,然后利用Python的图像处理库对验证码进行预处理,如去噪、二值化等操作。

接下来,通过机器学习算法或模式识别技术提取验证码的特征,并进行识别,最终得到验证码的文本信息。

3. Python 在验证码处理中的优势Python作为一种高级编程语言,具有丰富的图像处理库和机器学习工具,可以帮助简化验证码处理的流程。

与传统的验证码识别技术相比,Python可以更灵活地处理各种复杂的验证码,同时也方便进行算法的调优和优化,提高识别的准确性和稳定性。

4. 实例分析:使用Python进行人工处理验证码以某全球信息湾的登录验证码为例,我们将使用Python来实现对该验证码的自动处理。

我们需要利用Python的网络爬虫工具来获取验证码图片,并保存到本地。

利用Python的图像处理库对验证码进行预处理,去除噪声并进行二值化处理。

接下来,我们可以选择使用机器学习算法或深度学习模型来对验证码进行识别,从而实现自动化处理过程。

5. 结论通过以上实例分析,我们可以看到,利用Python进行人工处理验证码是一种有效的解决方案,可以帮助应对各种类型的验证码,提高识别的准确性和效率。

Python爬虫中的验证码识别技术Python爬虫是一种强大的工具,可以用于从网页中获取数据。

然而,在实际的爬取过程中,有时会遇到验证码的问题。

验证码是一种用于区分人类用户和机器程序的技术,它通过向用户展示一些随机生成的字符或图像,并要求用户输入正确的答案。

验证码的存在给爬虫带来了困难,因为爬虫通常无法识别验证码,导致无法完成自动化的操作。

为了解决这个问题,我们可以使用验证码识别技术来让爬虫自动识别并输入正确的验证码。

验证码识别技术是指通过计算机程序自动识别验证码的方法。

在Python爬虫中,有多种验证码识别技术可供选择,下面我将介绍几种常用的方法。

一、图像处理与机器学习1. 图像处理首先,我们需要对验证码图像进行预处理。

这包括图像的灰度化、二值化、降噪等操作。

通过这些处理,我们可以将验证码图像转换为更容易处理的形式。

2. 特征提取接下来,我们需要提取验证码图像的特征。

常用的特征提取方法有边缘检测、数学形态学、块特征法等。

这些方法可以从图像中提取出与验证码内容相关的特征。

3. 机器学习提取完特征后,我们可以使用机器学习算法来训练模型。

常用的机器学习算法有支持向量机(SVM)、决策树、卷积神经网络(CNN)等。

通过将提取的特征作为输入,将验证码的正确答案作为标签,我们可以训练一个模型来自动识别验证码。

二、第三方库除了使用图像处理与机器学习技术,我们还可以使用第三方库来简化验证码识别的过程。

1. pytesseractpytesseract是一个优秀的OCR库,可以识别包括验证码在内的各种图像中的文本。

借助pytesseract,我们只需要将验证码图像传入库中,即可获得识别结果。

2. pillowpillow是Python中一个功能强大的图像处理库,它提供了对图像的各种操作和处理方法。

我们可以使用pillow来进行验证码图像的各种处理,例如裁剪、旋转、缩放等。

三、验证码接口平台除了自己进行验证码识别技术的开发,我们还可以使用一些验证码接口平台来实现自动识别。

Python网络爬虫中的验证码识别与处理方法在进行网络爬取数据时,经常会遇到验证码的限制。

验证码是一种人机识别技术,被广泛应用于网站登录、用户注册、信息提交等场景,旨在防止恶意机器人的滥用行为。

然而,对于网络爬虫来说,验证码成为了一道难题,因为它们常常阻碍了数据的自动采集。

为了克服这一挑战,本文将探讨Python网络爬虫中的验证码识别与处理方法。

一、验证码的种类和特点在介绍验证码识别与处理方法之前,我们先了解一下验证码的种类和特点。

常见的验证码类型有数字、字母、汉字、图像、滑动拼图等。

而验证码的特点则是多变、不规则、扭曲、颜色复杂等。

这些特点使得传统的图像处理技术难以准确识别。

二、Python中的验证码识别库Python中有一些优秀的验证码识别库,可以帮助我们处理各种类型的验证码。

下面介绍几个常用的库。

1. pytesseractpytesseract库是一个优秀的OCR(Optical Character Recognition,光学字符识别)库,可以识别图片中的文字。

利用pytesseract库,我们可以将验证码图片中的文字提取出来,进而实现验证码的自动识别。

需要注意的是,pytesseract库需要依赖于Tesseract OCR引擎,请确保你已经正确安装了这个引擎。

2. opencv-pythonopencv-python库是一个非常强大的图像处理库,它提供了各种图像处理功能,包括图像预处理、特征提取、图像匹配等。

借助opencv-python库,我们可以对验证码进行图像处理,去除噪声、调整亮度、增强对比度等,从而提高验证码识别的准确率。

3. scikit-imagescikit-image库是一个基于NumPy的图像处理库,提供了一系列图像处理算法和函数。

通过使用scikit-image库,我们可以进行图像预处理、特征提取、图像分割等操作,有助于验证码的准确识别。

三、验证码识别与处理流程下面我们来总结一下验证码识别与处理的一般流程。

Python网络爬虫中的验证码识别与破解技术网络爬虫是目前互联网数据抓取和处理的主要手段之一,它可以自动化地获取网页上的数据并进行后续的处理。

然而,很多网站为了防止被爬虫过度使用,会在登录、注册、评论等操作时添加验证码,以确认用户的真实身份。

这给爬虫的自动化处理带来了一定的困难。

本文将介绍Python网络爬虫中的验证码识别与破解技术。

一、验证码的种类和特点验证码(CAPTCHA)是一种区分用户是机器人还是人类的技术。

常见的验证码种类有数字验证码、文字验证码、滑动验证码等。

1. 数字验证码:由一串数字组成,一般为4位或6位数。

特点是简单、易于生成,但安全性较低,容易被破解。

2. 文字验证码:由一串随机的英文字母和数字组成,一般为4位或6位。

相对于数字验证码,文字验证码的安全性更高一些,但同样存在被破解的风险。

3. 滑动验证码:需要用户拖动滑块,以验证用户的真实性。

相对于数字和文字验证码,滑动验证码的安全性更高,更难以被破解。

二、验证码识别技术验证码识别是将验证码图像转化为可识别的文本或数字的过程。

常见的验证码识别技术包括以下几种:1. 图像处理技术:使用Python中的图像处理库,如OpenCV和PIL,进行图像的预处理和特征提取,再通过机器学习或深度学习算法进行训练和识别。

2. 机器学习技术:使用支持向量机(SVM)、随机森林(Random Forest)等机器学习算法,通过训练模型来实现验证码的识别。

首先,将验证码图像转换为特征向量,然后使用机器学习算法对特征向量进行分类。

3. 深度学习技术:使用深度神经网络,如卷积神经网络(CNN)等,进行验证码的训练和识别。

深度学习技术在图像识别领域有较高的准确性和鲁棒性。

三、验证码破解技术验证码破解是指通过各种技术手段绕过验证码功能,实现自动化操作。

常见的验证码破解技术包括以下几种:1. 模拟浏览器:使用Python中的Selenium库,模拟真实的浏览器行为,包括自动输入验证码,以及处理验证码验证页面的跳转。

Python网络爬虫中的数据验证与验证技术在Python网络爬虫的开发中,数据验证是一项至关重要的任务。

由于网络上存在着大量的信息和数据,我们需要通过验证技术确保我们获取的数据是准确可靠的。

本文将讨论Python网络爬虫中的数据验证以及一些常用的验证技术。

一、数据验证的重要性在进行数据的提取和解析过程中,我们往往依赖于特定网站或API 的数据接口。

然而,这些数据接口的响应并不总是可靠的,可能会存在数据缺失、错误或者异常情况。

为了确保我们获取的数据是准确可靠的,数据验证就变得至关重要。

二、数据验证方法1. 基本数据验证基本数据验证是最基础也是最常用的数据验证方法之一。

通过对数据进行类型与格式的检查,我们可以初步验证数据的正确性。

例如,我们可以使用正则表达式对提取的字符串进行格式验证,或者使用Python的内置函数对数据进行类型判断。

2. 数据一致性验证数据一致性验证是指对不同数据源提取的数据进行验证,并确保它们在同一语义范围内是一致的。

常用的数据一致性验证方法包括比对数据的关键信息、比对数据的属性、比对数据的结构等。

3. 异常数据验证异常数据验证是指对数据进行异常值判断和处理。

在实际的数据提取中,我们经常会遇到一些异常情况,例如数据为空、数字超过范围等。

通过对这些异常数据进行验证和处理,我们可以提高数据的可靠性和准确性。

4. 数据库验证在爬虫开发中,我们往往需要将提取的数据存储到数据库中。

数据验证在此时尤为重要。

通过合理的数据库设计和数据结构,我们可以对数据进行完整性和一致性验证。

例如,可以通过约束条件、索引等机制来保证数据的正确性和准确性。

5. 机器学习验证机器学习验证是一种高级的数据验证方法。

通过训练机器学习模型,我们可以对提取的数据进行模式识别和异常检测,从而提高数据的验证精度和效果。

然而,机器学习验证通常需要大量的数据和计算资源,在实际应用中需要权衡利弊。

三、验证技术1. 数据库验证技术数据库验证技术是一种常用的数据验证方法。

Python网络爬虫动态验证码识别与破解技术随着互联网的普及,网络爬虫成为了获取大量数据的一种重要手段。

然而,很多网站为了保护信息的安全性,采用了验证码来阻止机器人程序的访问。

虽然验证码对于提高安全性起到了一定的作用,但它也给进行数据采集的爬虫带来了困扰。

为了解决这个问题,研究人员们提出了多种Python网络爬虫动态验证码识别与破解技术。

一、图像处理技术图像处理技术是识别与破解动态验证码的基础。

通过图像处理技术,我们可以识别验证码中的文字或者图形,从而获取验证码的值。

常用的图像处理技术包括图像灰度化、二值化、降噪等。

在Python中,我们可以使用第三方库如OpenCV和PIL来实现图像处理的各种操作。

二、机器学习技术机器学习技术可以提高验证码的自动化识别效果。

通过训练模型,我们可以使爬虫程序自动学习并识别不同类型的验证码。

常用的机器学习算法包括支持向量机(SVM)、卷积神经网络(CNN)等。

在Python中,我们可以使用Scikit-learn和TensorFlow等库来实现机器学习的各种算法。

三、验证码生成技术为了测试验证码识别与破解技术的有效性,研究人员们也提出了验证码生成技术。

通过生成各种不同类型的验证码,我们可以评估识别与破解技术的准确性和鲁棒性。

常见的验证码生成技术包括随机字符生成、干扰线添加等。

在Python中,我们可以使用Captcha和Pillow 等库来生成验证码。

四、深度学习技术深度学习技术是识别与破解复杂动态验证码的有效手段。

通过构建深度神经网络模型,我们可以提高验证码识别的准确率和鲁棒性。

常用的深度学习算法包括循环神经网络(RNN)、长短时记忆网络(LSTM)等。

在Python中,我们可以使用Keras和PyTorch等库来实现深度学习的各种算法。

五、借助第三方服务除了自行开发验证码识别与破解技术,我们还可以借助第三方服务来简化工作流程。

例如,一些第三方服务提供了API接口,可以直接调用进行验证码识别,如Tesseract OCR和百度云OCR等。

python⽹络爬⾍实现发送短信验证码的⽅法前⾔:今天要总结的是如何⽤程序来实现短信发送功能。

但是呢,可能需要我们调⽤⼀些api接⼝,我会详细介绍。

都是⾃⼰学到的,害怕忘记,所以要总结⼀下,让写博客成为⼀种坚持的信仰。

废话不多说,我们开始吧!⽹络爬⾍实现发送短信验证码在实现我们⽬标的功能之前,我们要有⾃⼰的思路,否则你没有⽅向,⼜如何实现⾃⼰的代码功能呢?我们要发送短信,那么我们其实是需要分析的。

我们可以去分析⼀个可以发送短信的⽹站页⾯。

我们来到这⾥如下:可以看到这是⼀个注册界⾯,我们在注册时会被要求需要填写⼿机号码的·,其实还有⼀栏验证码识别,像这⾥打开没有,那你就填写⼏个号码,发送,多刷新⼏次,就可以了。

不为别⼈添⿇烦,我填写⾃⼰的号码。

多次刷新会出现,不过要填写不同的⼿机号码。

你们懂的,我们要看到这个有验证码的界⾯。

我们打开chrome⾕歌抓包⼯具,也就是邮件检查即可。

我们点击network直接进⾏抓包,记得在抓包前最好清除下⾯出现的⼀切包。

我们要点击验证码,让⽹页做出反应,然后同步⼀下,进⾏抓包。

当我们填写⼿机号以后,我们只要点击那个验证码,然后进⾏抓包如下看到没有,其实点击同步瞬间只有⼀个数据包的,在你做其他的动作时,可能会出现其他的数据包,但是与此⽆关。

我们直接点进去看我们看这个url我们打开这个url看看庐⼭真⾯⽬留意观察这个time参数,很明显是⼀个时间戳参数时间戳参数⼜是什么概念呢?这⾥有必要介绍⼀下时间戳:格林威治时间1970年1⽉0点0分0秒到⽬前为⽌秒级时间戳:10数字毫秒级时间戳:13位数字微秒级时间戳:16位数字可以看到这个time参数属于毫秒级别的时间戳的。

我们访问这个见⾯,每次刷新都会有不同的验证码,返回当前的时间。

如果我们要获取当前的验证码,我们需要url,前⾯的参数都⼀样,只有time,我们需要获取time时间。

如何获取呢。

python中有⼀个time库,我们导⼊,来看如何使⽤。

python基于机器学习识别验证码1、背景验证码⾃动识别在模拟登陆上使⽤的较为⼴泛,⼀直有⽿闻好多⼈在使⽤机器学习来识别验证码,最近因为刚好接触这⽅⾯的知识,所以特定研究了⼀番。

发现⽹上已有很多基于machine learning的验证码识别,本⽂主要参考⼏位⼤⽜的研究成果,集合⾃⼰的需求,进⾏改进、学习。

2、基本⼯具开发环境:python 3.5 + pycharm模块:Pillow、sklearn、numpy及其他⼦模块3、基本流程描述整个识别流程:①验证码清理并⽣成训练集样本②验证码特征提取③拟合识别模型④识别模型测试4、关于数据集没有特意⽹上找python的⽣成脚本,⽤了⼀个java的验证码⽣成脚本。

验证码是数字+⼤写字母+⼩写字母的组合,即[0-9]+[A-Z]+[a-z]。

⽂件名是验证码的正确数字标签,实例如下使⽤三个数据集:①训练集(training set):10000张验证码②测试集(test set):100张验证码③验证集(validation set):100张验证码5、验证码清理并⽣成训练集样本(1)读取图⽚⾸先读取该⽂件路径下的所有图⽚⽂件名称,并逐张打开。

返回结果image_array,每⼀个元素类型为“<class'PIL.JpegImagePlugin.JpegImageFile'>”。

def read_captcha(path):image_array = []image_label = []file_list = os.listdir(path) # 获取captcha⽂件for file in file_list:image = Image.open(path + '/' + file) # 打开图⽚file_name = file.split(".")[0] #获取⽂件名,此为图⽚标签image_array.append(image)image_label.append(file_name)return image_array, image_label(2)图像粗清理图像粗清理包括以下步骤:step 1:原始图像是RGB图像,即维度为 (26, 80, 3)。

Python爬⾍模拟登录带验证码⽹站爬取⽹站时经常会遇到需要登录的问题,这是就需要⽤到模拟登录的相关⽅法。

python提供了强⼤的url库,想做到这个并不难。

这⾥以登录学校教务系统为例,做⼀个简单的例⼦。

⾸先得明⽩cookie的作⽤,cookie是某些⽹站为了辨别⽤户⾝份、进⾏session跟踪⽽储存在⽤户本地终端上的数据。

因此我们需要⽤Cookielib模块来保持⽹站的cookie。

可以发现这个验证码是动态更新的每次打开都不⼀样,⼀般这种验证码和cookie是同步的。

其次想识别验证码肯定是吃⼒不讨好的事,因此我们的思路是⾸先访问验证码页⾯,保存验证码、获取cookie⽤于登录,然后再直接向登录地址post数据。

⾸先通过抓包⼯具或者⽕狐或者⾕歌浏览器分析登录页⾯需要post的request和header信息。

以⾕歌浏览器为例。

其中需要提交的表单数据中txtUserName和TextBox2分别⽤户名和密码。

现在直接到关键部分上代码!!import urllib2import cookielibimport urllibimport reimport sys'''模拟登录'''reload(sys)sys.setdefaultencoding("utf-8")# 防⽌中⽂报错CaptchaUrl = "http://202.115.80.153/CheckCode.aspx"PostUrl = "http://202.115.80.153/default2.aspx"# 验证码地址和post地址cookie = cookielib.CookieJar()handler = urllib2.HTTPCookieProcessor(cookie)opener = urllib2.build_opener(handler)# 将cookies绑定到⼀个opener cookie由cookielib⾃动管理username = 'username'password = 'password123'# ⽤户名和密码picture = opener.open(CaptchaUrl).read()# ⽤openr访问验证码地址,获取cookielocal = open('e:/image.jpg', 'wb')local.write(picture)local.close()# 保存验证码到本地SecretCode = raw_input('输⼊验证码: ')# 打开保存的验证码图⽚输⼊postData = {'__VIEWSTATE': 'dDwyODE2NTM0OTg7Oz6pH0TWZk5t0lupp/tlA1L+rmL83g==','txtUserName': username,'TextBox2': password,'txtSecretCode': SecretCode,'RadioButtonList1': '学⽣','Button1': '','lbLanguage': '','hidPdrs': '','hidsc': '',}# 根据抓包信息构造表单headers = {'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8','Accept-Language': 'zh-CN,zh;q=0.8','Connection': 'keep-alive','Content-Type': 'application/x-www-form-urlencoded','User-Agent': 'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/46.0.2490.86 Safari/537.36', }# 根据抓包信息构造headersdata = urllib.urlencode(postData)# ⽣成post数据 ?key1=value1&key2=value2的形式request = urllib2.Request(PostUrl, data, headers)# 构造request请求try:response = opener.open(request)result = response.read().decode('gb2312')# 由于该⽹页是gb2312的编码,所以需要解码print result# 打印登录后的页⾯except urllib2.HTTPError, e:print e.code# 利⽤之前存有cookie的opener登录页⾯登录成功后便可以利⽤该openr访问其他需要登录才能访问的页⾯。