预处理计算方法

- 格式:doc

- 大小:21.50 KB

- 文档页数:1

ILU预处理Newton—Krylov方法的潮流计算作者:廖小兵王文超李奔来源:《计算技术与自动化》2015年第04期摘要:由于电力系统修正方程组具有高维、稀疏的特点,本文提出将预处理Krylov子空间方法应用于潮流修正方程组的求解,形成预处理NewtonKrylov的潮流计算方法。

结合ILU 预处理方法,比较了最常用的3类NewtonKrylov方法求解潮流方程的计算效果。

通过对IEEE30、IEEE118、IEEE300 和3个Poland大规模电力系统进行潮流计算,结果表明:3类NewtonKrylov方法是电力系统潮流计算的有效方法,呈现出良好的收敛特性和计算效率。

关键词:潮流计算;修正方程组;ILU预处理;NewtonKrylov方法中图分类号:TM744 文献标识码:A1引言潮流计算是电力系统分析中最古老的经典课题之一。

传统的电力系统潮流计算通常以牛顿法为主[1]。

牛顿法是求解非线性代数方程组的有效方法之一,它将非线性方程组的求解转化为线性代数方程组的求解,但由于每次迭代后都需更新雅可比矩阵的元素,导致每次都需求解高维的线性代数方程组。

传统的直接法,如Gauss消去法,LU分解等,计算量和存储量较大,且固有的前推回代过程难以并行[2-3]。

迄今为止,越来越多的国内外研究人员在电力系统潮流计算中采用NewtonKrylov方法求解潮流方程[4-8]。

NewtonKrylov方法是在不精确牛顿法的基础上,结合Krylov子空间迭代法,形成的一类新的求解非线性方程组的数值方法。

这类方法结合了Newton方法的良好收敛特性,以及Krylov子空间方法的存储量少、计算量小、易于并行等优点[9],非常适合并行求解大规模的非线性方程组问题[10]。

文献[4]首次将Krylov子空间法中的GMRES方法应用于潮流计算中。

文献[5]将此类迭代法与不精确牛顿法相结合(NewtonGMRES),同时采用不同的预处理方法,对两个大规模电力系统进行了对比分析计算。

python数据预处理的方法

Python中常用的数据预处理方法有以下几种:

1. 数据清洗:对数据进行去重、缺失值处理、异常值处理、数据类型转换等操作,以保证数据的准确性和完整性。

2. 特征选择:根据特征重要性和相关性等指标,选择最具代表性和区分度的特征,以提高模型的准确性和泛化能力。

3. 特征缩放:对特征进行缩放操作,使得不同特征之间具有相同的尺度,以便于模型的训练和优化。

4. 特征编码:将文本型特征进行编码,以便于模型的处理和计算。

常见的编码方法包括one-hot编码、标签编码、二进制编码等。

5. 数据归一化:将数据进行归一化处理,以使得数据分布在[0,1]或[-1,1]之间,以便于模型的训练和优化。

6. 数据降维:对高维数据进行降维处理,以减少特征数量和计算复杂度,常用的降维方法包括主成分分析法(PCA)、线性判别分析法(LDA)等。

7. 数据集划分:将数据集划分为训练集、验证集和测试集,以便于模型的训练、评估和优化。

以上是Python中常用的数据预处理方法,不同的数据预处理方法可以根据具体情况进行选择和组合。

带状矩阵方程预处理方法

嘿,咱今儿就来唠唠带状矩阵方程预处理方法。

这玩意儿啊,就好

像是一把解开复杂难题的钥匙。

你想想看,矩阵就像是一个大迷宫,而带状矩阵呢,就是这个迷宫

里有规律可循的那部分。

处理带状矩阵方程,就像是在迷宫中找到一

条最快捷的路。

预处理方法呢,就好比给这条路先清理清理障碍,让我们能更顺利

地走过去。

它可以让计算变得更高效,就像给汽车加上了超强马力。

比如说,我们在处理一些大型数据的时候,要是没有好的预处理方法,那可就像没头苍蝇一样乱撞啦。

但有了它,就能快速准确地找到

答案。

咱再打个比方,这预处理方法就像是给运动员做的热身准备,只有

充分热身了,才能在比赛中发挥出最好的水平呀。

它能让整个计算过

程变得更流畅,更轻松。

那怎么选择合适的预处理方法呢?这可得好好琢磨琢磨。

不同的问

题可能需要不同的方法,就像不同的病症需要不同的药一样。

有时候

可能需要试试几种方法,才能找到最适合的那个。

而且啊,这可不是一劳永逸的事儿。

就像人的习惯会变一样,问题

也可能会变,那预处理方法也得跟着变呀。

不能死脑筋,得灵活点儿。

有时候可能会遇到一些特别难搞的情况,就像爬山遇到了陡峭的山峰。

但别怕呀,咱有预处理方法这根“登山杖”呢,总能找到办法爬上去的。

总之呢,带状矩阵方程预处理方法是个很重要的东西。

它能让我们在解决复杂问题的时候更得心应手,就像有了一个得力的助手。

咱可得好好研究研究它,让它为我们的学习和工作发挥最大的作用呀!可别小瞧了它哦!。

大规模数据分析中的计算方法在当今数字化时代,数据分析已经成为商业、科学甚至社会决策的重要基础。

然而,大规模数据的处理和分析需要高效的计算方法来实现。

本文将探讨现代大规模数据分析中常用的计算方法,包括数据预处理、机器学习和深度学习等方面。

一、数据预处理的计算方法在大规模数据分析中,数据预处理是一个必不可少的步骤,因为数据的质量和准确性直接影响到后续分析的可靠性。

数据预处理的主要目的是去除重复数据、异常数据,填补缺失值,并对数据进行标准化和归一化等操作。

为了实现数据预处理,常用的计算方法包括以下几个方面:1. 去重。

可以使用哈希表或者位图等方法实现快速查找与去重。

以哈希表为例,在将数据插入哈希表时,如果发现哈希表中已经存在该数据,则删除该数据。

2. 数据填充。

数据填充可以使用线性插值、KNN填充等方法。

以KNN填充为例,首先选择一个KNN算法,然后选择适当的K值,计算出缺失值周围的K个邻居,最后使用这K个邻居的平均值或中位数来填充缺失值。

3. 标准化和归一化。

标准化和归一化的目的是将数据转换为一定范围内的值,以便更好地进行分析。

常用的方法包括Min-Max Scaling以及Z-Score Scaling。

其中,Min-Max Scaling将数据转换到[0,1]之间,而Z-Score Scaling将数据转换为均值为0,方差为1的正态分布。

二、机器学习中的计算方法机器学习是一种通过训练从数据中提取规律的方法,是大规模数据分析中最常用的方法之一。

常见的机器学习算法包括决策树、支持向量机、朴素贝叶斯、KNN等。

这些算法通过学习输入数据和答案之间的关系,并在更大的数据集上进行测试和预测。

对于这些算法,计算方法包括以下几个方面:1. 特征提取。

特征提取是机器学习过程中最关键的步骤之一。

它涉及到选择合适的特征,将复杂的输入数据转换为简单的数值向量。

例如,在进行图像识别时,特征提取就可以将每个图像转换为一组数字,表示其纹理、形状和颜色等特征。

第五讲预处理方法1.预处理Krylov子空间方法2.基于矩阵分裂的预处理技术3.基于不完全分解的预处理子4.基于稀疏近似逆的预处理子5.其他预处理技术为什么预处理Nothing will be more central to computational science in the next century thanthe art of transforming a problem that appears intractable into another whosesolution can be approximated rapidly.For Krylov subspace matrix iterations,this is preconditioning.—Trefethen&Bau,1997.•为什么预处理:改善迭代法的收敛性与可靠性.•预处理的根本目的:将难求解的原问题转化成等价的容易求解的新问题.•1968年,Evans首先提出“preconditioning”,并考虑了不完全LU分解预处理.•预处理技术的研究是目前科学计算领域中的重要研究课题之一.1预处理Krylov子空间方法1.1怎么做预处理1.2预处理CG方法1.3预处理GMRES方法1.4左、右预处理方式的最优性质1.5Flexible GMRES方法1.6预处理BiCGSTAB方法1.1怎么做预处理预处理方法考虑线性方程组Ax=b,A∈R n×n非奇异,b∈R n.(5.1)在方程组的两边同时左乘一个非奇异矩阵P的逆,则可得P−1Ax=P−1b(5.2)这个新方程组就是预处理后的方程组,P就称为预处理子(preconditioner).当Krylov子空间方法被用于求解(5.2)时,就称为预处理Krylov子空间方法.好的预处理子理论上讲,任何一个非奇异矩阵都可以作为预处理子.但一个好的预处理子P通常需满足下面两个要求:(1)P容易构造且P z=r容易求解→实用(2)大大提高迭代法的收敛速度→有效(P−1A具有更小的条件数,更好的特征值分布,次数更低的最小多项式)三种不同的预处理方式预处理方式(5.2)称为左预处理,即从左边做预处理.相应地,可以对系数矩阵右乘P−1,这就是右预处理,即AP−1u=b,x=P−1u(5.3)另外,如果P可以分解成两个矩阵的乘积,或者P是由两个矩阵的乘积构成,即P=P L P R,则可以用下面的方式对原方程组进行预处理P−1 L AP−1Ru=L−1b,x=P−1Ru(5.4)这就是两边预处理三种预处理方式的几点说明以上三种方式预处理后的系数矩阵分别为P−1A,AP−1和P−1L AP−1R:•具有相同的特征值分布(三个矩阵是相似的)•如果A和P都是对称正定的,则使用共轭梯度法求解时,这三种方式的预处理效果基本上是一样的.•对于非对称(特别是非正规)情形,效果可能会相差很大.三种预处理方式的几点说明(续)1.2预处理CG方法PCG设A对称正定,为了保证预处理后的系数矩阵仍然是对称正定的,通常要求预处理子P也是对称正定的.考虑使用两边预处理方式.设P的Cholesky分解为P=LL⊺.于是我们得到下面的预处理方程组L−1A(L⊺)−1u=L−1b,x=(L⊺)−1u.(5.5)近似解记为u (k ),预处理残量记为˜r k ≜L −1b −L −1A (L ⊺)−1u (k ).算法1.1两边预处理CG 方法1:给定初值x (0),计算r 0=b −Ax (0)2:令˜r 0=L −1r 0,˜p 1=˜r 03:for k =1,2,...do 4:ξk =(˜r k −1,˜r k −1)(L −1A (L ⊺)−1˜p k ,˜p k )5:u (k )=u (k −1)+ξk ˜p k 6:˜r k =˜r k −1−ξk L −1A (L ⊺)−1˜p k 7:µk =(˜r k ,˜r k )(˜r k −1,˜r k −1)8:˜p k +1=˜r k +µk ˜p k 9:end for原方程组残量PCG得到的是预处理后的近似解u(k)和残量˜r k,因此我们还需要考虑原方程组的近似解和残量的计算.对上述算法中进行适当的改写.首先引入一个辅助变量p k:p k≜(L⊺)−1˜p k,k=1,2,....于是有p k+1=(L⊺)−1p k+1=(L⊺)−1˜r k+µk(L⊺)−1˜p k=(L⊺)−1˜r k+µk p k.由˜r k的表达式可知,原方程组的残量r k=L˜r k,所以有r k=L˜r k=L(˜r k−1−ξk L−1A(L⊺)−1˜p k)=r k−1−ξk Ap k,p k+1=(L⊺)−1˜r k+µk p k=(L⊺)−1L−1r k+µk p k=P−1r k+µk p k,x(k)=(L⊺)−1u(k)=(L⊺)−1(u(k−1)+ξk˜p k)=x(k−1)+ξk p k,其中ξk=(L−1r k−1,L−1r k−1)(L−1A(L⊺)−1˜p k,˜p k)=(r k−1,(L⊺)−1L−1r k−1)(A(L⊺)−1˜p k,(L⊺)−1˜p k)=(r k−1,P−1r k−1)(Ap k,p k),µk=(L−1r k,L−1r k)(L−1r k−1,L−1r k−1)=(r k,P−1r k)(r k−1,P−1r k−1).记z k≜P−1r k,则可得下面的预处理CG方法.算法1.2预处理CG方法(PCG)1:给定初值x(0),(相对)精度要求ε>0和最大迭代步数IterMax 2:计算r0=b−Ax(0)和β=∥r0∥23:令z0=P−1r0,p1=z04:计算ρ=r⊺0z05:for k=1to IterMax do6:q k=Ap k7:ξk=ρ/(p⊺k q k)8:x(k)=x(k−1)+ξk p k9:r k=r k−1−ξk q k10:relres=∥r k∥2/β11:if relres<εthen12:break13:end if14:ρ0=ρ15:z k=P−1r k16:ρ=r⊺k z k17:µk=ρ/ρ018:p k+1=z k+µk p k19:end for20:if relres<εthen21:输出近似解x(k)及相关信息22:else23:输出算法失败信息24:end if左预处理方式事实上,PCG也可以通过左预处理方式导出.考虑左预处理方程组P−1Ax=P−1b.(5.6)易知P−1A是正定的,但通常不是对称的,因此我们不能直接对(5.6)实施CG方法.此时我们需要定义一个新的内积:P-内积,即(x,y)P≜(P x,y)=(x,P y).(5.7)由于P是对称正定的,所以这个内积定义是有效的.在该内积下,有(P−1Ax,y)P=(Ax,y)=(x,Ay)=(x,P(P−1Ay))=(x,P−1Ay)P,即P−1A关于P-内积是自伴随的,即在P-内积意义下,P−1A是“对称”的.这时可以用CG 方法来求解预处理方程组(5.6),但需要将欧拉内积改为P -内积.引入辅助变量z k ≜P −1r k ,则求解预处理方程组(5.6)的CG 方法可描述如下:算法1.3基于P -内积的CG 方法1:给定初值x (0),(相对)精度要求ε>0和最大迭代步数IterMax 2:计算r 0=b −Ax (0)和β=∥r 0∥23:令z 0=P −1r 0,p 1=z 04:for k =1to IterMax do 5:ξk =(z k −1,z k −1)P (P −1Ap k ,p k )P =(r k −1,z k −1)(Ap k ,p k )6:x (k )=x (k −1)+ξk p k 7:r k =r k −1−ξk Ap k 8:relres =∥r k ∥2/β9:if relres <εthen10:break 11:end if 12:z k =z k −1−αk P −1Ap k =P −1r k 13:µk =(z k ,z k )P (z k −1,z k −1)P =(r k ,z k )(r k −1,z k −1)14:p k +1=z k +µk p k 15:end for1.3预处理GMRES方法左预处理GMRES对于非对称情形的GMRES方法,也有三种预处理方式.但与对称正定情形不同的是,这三种方式并不等价,而且有时效果会相差很大.首先考虑左预处理方式,即P−1Ax=P−1b(5.8)记r k=b−Ax(k)为原问题的残量,则预处理方程组(5.8)的残量为˜r k=P−1r k将GMRES用于求解方程组(5.8),即可得左预处理GMRES方法.算法1.4左预处理GMRES方法1:给定初值x(0)和(相对)精度要求ε>02:计算˜r0=P−1(b−Ax(0))和β=∥˜r0∥23:令v1=˜r0/β,ξ=βe14:for j=1,2,...do5:˜w j=Av j6:w j=P−1˜w j%Apply preconditioning,solve P w j=˜w j for w j7:for i=1,2,...,j do8:h ij=(w j,v i)9:w j=w j−h ij v i10:end for11:h j+1,j=∥w j∥212:for i=1,2,...,j−1do%Apply G j−1,...,G1to last column of H j+1,j13:[h i,jh i +1,j ]=[c i s i −s i c i ][h i,j h i +1,j ]14:end for 15:if h j +1,j =0then 16:set m =j and break 17:end if 18:v j +1=w j /h j +1,j 19:if |h j,j |>|h j +1,j |then %Form the Givens rotation G j 20:c j =1√1+τ2,s j =c j τwhere τ=h j +1,j h j,j 21:else 22:s j =1√1+τ2,c j =s j τwhere τ=h j,j h j +1,j 23:end if 24:h j,j =c j h j,j +s j h j +1,j ,h j +1,j =0%Apply G j to last column of H j +1,j25:[ξjξj+1]=[c j s j−s j c j][ξj]%Apply G j to the right-hand side26:if|ξj+1|/β<εthen%Check convergence:∥˜r j∥2=|ξj+1|27:set m=j and break28:end if29:end for30:计算y(m)=R−1mξ(m),其中R m=H(1:m,1:m),ξ(m)=ξ(1:m)31:计算近似解x(m)=x(0)+V m y(m)需要指出的是,在左预处理GMRES方法中,停机准则中的|ξj+1|并不是原方程组残量r k的模,而是预处理残量˜r k=P−1(b−Ax(k))的模.如果要计算真实残量,除了显式计算外,没有其它更好的办法.所以,如果停机准则是基于真实残量的,则需要额外去计算r k,这就会增加很多额外的运算量.右预处理GMRES如果用P做右预处理,则对应的预处理方程组为AP−1u=b,x=P−1u.(5.9)给定迭代初值x(0),则u(0)=P x(0).相应的预处理初始残量为˜r0=b−AP−1u(0)=b−Ax(0)=r(0),即预处理残量与原方程组残量是一样的.因此无需计算u(0).设u(m)=u(0)+V m y m 是迭代m步后的近似解,则对应的原方程组近似解x(m)为x(m)=P−1u(m)=P−1(u(0)+V m y m)=x(0)+P−1V m y m,原方程组的残量为r m=b−Ax(m)=r0−AP−1V m y m=βv1−V m+1H m+1,m y m=V m+1(βe1−H m+1,m y m).由于y m是最小二乘问题∥βe1−H m+1,m y∥2miny∈R m的解,因此∥r m∥2=∥βe1−H m+1,m y m∥2=β·|q1(m+1)|.这与不带预处理的GMRES方法是一样的.因此在实际求解过程中我们可以直接得到原方程组残量的模,而无需计算u(m)和x(m).这是右预处理方式与左预处理方式的主要区别.右预处理GMRES方法具体描述如下:算法1.5右预处理GMRES方法1:给定初值x(0)和(相对)精度要求ε>0 2:计算r0=b−Ax(0)和β=∥r0∥23:令v1=˜r0/β,ξ=βe14:for j=1,2,...do5:˜w j=P−1v j%Apply preconditioning 6:w j=A˜w j7:for i=1,2,...,j do8:h ij=(w j,v i)9:w j=w j−h ij v i10:end for11:h j+1,j=∥w j∥212:for i =1,2,...,j −1do %Apply G j −1,...,G 1to the last column of H j +1,j 13:[h i,j h i +1,j ]=[c i s i −s i c i ][h i,jh i +1,j]14:end for15:if h j +1,j =0then16:set m =j and break17:end if18:v j +1=w j /h j +1,j19:if |h j,j |>|h j +1,j |then %Form the Givens rotation G j 20:c j =1√1+τ2,s j =c j τwhere τ=h j +1,jh j,j21:else22:s j =1√1+τ2,c j =s j τwhere τ=h j,jh j +1,j23:end if24:h j,j =c j h j,j +s j h j +1,j ,h j +1,j =0%Apply G j to last column of H j +1,j 25:[ξj ξj +1]=[c j s j −s j c j ][ξj 0]%Apply G j to the right-hand side 26:if |ξj +1|/β<εthen %Check convergence:∥r j ∥2=|ξj +1|27:set m =j and break 28:end if29:end for30:计算y (m )=R −1m ξ(m ),其中R m =H (1:m,1:m ),ξ(m )=ξ(1:m )31:计算近似解x (m )=x (0)+P −1V m y (m )两边预处理方式如果预处理子P是由乘积形式给出的,即P=P L P R,则可以构造下面的两边预处理方程组P−1 L AP−1Ru=P−1Lb,x=P−1Ru.将GMRES用于求解上述线性方程组,则可得到两边预处理GMRES方法.具体推导过程与前面类似,留作练习.需要指出的是,对于两边预处理GMRES方法,其预处理后的残量为˜r k=P−1L(b−Ax(k)).1.4左、右预处理方式的最优性质设x(0)是迭代初始值,记x(k)L 和x(k)R分别是左预处理GMRES方法和右预处理GM-RES方法迭代k步后得到的近似解.根据GMRES方法的最优性质可知,对于左预处理GMRES方法,有x(k)L=argminx∈x(0)+K k(P−1A,P−1r0)∥P−1(b−Ax)∥2(5.10)而对于右预处理GMRES,我们有x(k)R=P−1u(k),其中u(k)=argminu∈u(0)+K k(AP−1,r0)∥b−AP−1u∥2.通过变量代换x=P−1u,可得x(k)R=argminx∈x(0)+P−1K k(AP−1,r0)∥b−Ax∥2(5.11)又P−1K k(AP−1,r0)=P−1span{r0,AP−1r0,(AP−1)2r0,...,(AP−1)k−1r0}=span{P−1r0,P−1AP−1r0,P−1(AP−1)2r0,...,P−1(AP−1)k−1r0}=span{P−1r0,(P−1A)P−1r0,(P−1A)2P−1r0,...,(P−1A)k−1P−1r0} =K k(P−1A,P−1r0),由(5.10)和(5.11)可知,x(k)L 和x(k)R属于同一个子空间中.不同之处在于,x(k)L极小化的是预处理后残量的范数,即∥P−1(b−Ax)∥2,而x(k)R极小化的是原方程组残量的范数,即∥b−Ax∥2.1.5Flexible GMRES方法在前面的讨论中,我们假定预处理子P是固定不变的.事实上,我们可以在每步迭代中取不同的预处理子.这就是Flexible GMRES(FGMRES)方法的基本思想.下面介绍右预处理方式的Flexible GMRES方法.我们知道,在右预处理GMRES方法1.5中,近似解可以写成下面的形式:x(m)=x(0)+P−1V m˜y=x(0)+m∑j=1(P−1v j)˜y j.(5.12)这意味着x(m)−x(0)是向量P−1v1,P−1v2,...,P−1v m的线性组合.而这些向量可由算法1.5中的第5步计算得到.但事实上,我们无需存储这些向量,因为它们是由同一个预处理子P作用到向量v′j s上所得到的.因此,在计算近似解x(m)时,只需将P作用到v1,v2,...,v m的线性组合上即可,即V m˜y上.但如果每次迭代时采用不同的预处理子,即将算法1.5中的第5步改为5':solve P j w=v j for w,that is,w=P−1j v j因此,我们很自然地想到用下面的方式来获取近似解:x(m)=x(0)+m∑j=1(P−1jv j)˜y j=x(0)+Z m˜y,其中Z m=[z1,z2,...,z m].这z j=P−1jv j,向量˜y则跟之前一样计算.需要注意的是,此时我们需要存储所有的向量z j=P−1jv j,j=1,2,...,m.这就是FGMRES与右预处理GMRES方法的根本区别.FGMRES算法描述如下:算法1.6Flexible GMRES(FGMRES)1:给定初值x(0)和(相对)精度要求ε>02:计算r0=b−Ax(0)和β=∥r0∥23:setξ=βe1and v1=r0/β4:for j=1,2,...do5:solve P j z j=v j for z j,that is,z j=P−1v j%Apply the preconditioner 6:w j=Az j7:for i=1,2,...,j do%Arnoldi process8:h ij=(w j,v i)9:w j=w j−h ij v i10:end for11:h j+1,j=∥w j∥212:if h j +1,j =0then 13:set m =j and break 14:end if15:v j +1=w j /h j +1,j16:for i =1,2,...,j −1do %Apply G j −1,...,G 1to the last column of H i +1,j17:[h i,j h i +1,j ]=[c i s i −s i c i ][h i,jh i +1,j ]18:end for19:if |h j,j |>|h j +1,j |then %Form the Givens rotation G j20:set c j =1√1+τ2,s j =c j τwhere τ=h j +1,jh j,j 21:else 22:set s j =1√1+τ2,c j =s j τwhere τ=h j,j h j +1,j23:end if24:h j,j =c j h j,j +s j h j +1,j ,h j +1,j =0%Apply G j to last column of H j +1,j 25:[ξj ξj +1]=[c j s j −s j c j ][ξj0]%Apply G j to the right-hand side 26:if ∥ξj +1∥2<εthen %Check convergence:∥˜r ∥2=ξj +127:set m =j and break28:end if 29:end for30:compute ˜y =R −1m ξm with R m =H (1:m,1:m )upper-triangular and ξm =ξ(1:m )31:compute the approximate solution x (m )=x (0)+Z m ˜y1.6预处理BiCGSTAB方法右预处理BiCGSTAB与带预处理的GMRES方法类似,为了使得计算过程中得到的残量是真实残量(而不是预处理后的残量),我们一般采用右预处理方式,即AM−1u=b with u=Mx,(5.13)其中M为预处理子.在BiCGSTAB方法中,主要迭代过程为:q k=r k−1−αk Ap k withαk=(r k−1,˜r0) (Ap k,˜r0),r k=q k−ωk Aq k withωk=(q k,Aq k) (Aq k,Aq k),x(k)=x(k−1)+αk p k+ωk q k,p k+1=r k+βk(p k−ωk Ap k)withβk=αkωk·(r k,˜r0)(r k−1,˜r0),其中k=1,2,...,p1=r0.记˜p k=M−1p k,˜q k=M−1q k,则针对预处理后的线性方程组(5.13)的BiCGSTAB迭代过程为:q k=r k−1−αk A˜p k withαk=(r k−1,˜r0) (A˜p k,˜r0),r k=q k−ωk A˜q k withωk=(q k,A˜q k) (A˜q k,A˜q k),x(k)=x(k−1)+αk˜p k+ωk˜q k,p k+1=r k+βk(p k−ωk A˜p k)withβk=αkωk·(r k,˜r0)(r k−1,˜r0).整理后即可得下面的预处理BiCGSTAB方法:算法1.7Preconditioned BiCGSTAB1:Given an initial guess x(0)and stopping toleranceε>02:compute r0=b−Ax(0)3:choose˜r0such that(r0,˜r0)=0%one common choice is˜r0=r0 4:set p1=r05:for k=1,2,...do6:ρk−1=(r k−1,˜r0)%ifρk−1=0,then breakdown7:if k>1then8:βk−1=(αk−1/ωk−1)·(ρk−1/ρk−2)9:p k=r k−1+βk−1(p k−1−ωk−1v k−1)10:end if11:˜p k=M−1p k%solve M˜p k=p k for˜p k12:v k=A˜p k13:αk=ρk−1/(v k,˜r0)%if(v k,˜r0)=0,then breakdown 14:q k=r k−1−αk v k15:x(k)=x(k−1)+αk˜p k%if∥q k∥<ε,then converged and stop 16:˜q k=M−1q k%solve M˜q k=q k for˜q k17:w k=A˜q k18:ωk=(q k,w k)/(w k,w k)%ifωk=0,then breakdown19:r k=q k−ωk w k20:x(k)=x(k)+ωk˜q k21:if∥r k∥2<εthen%check convergence22:stop%converged23:end if24:end for2基于矩阵分裂的预处理技术Finding a good preconditioner to solve a given sparse linear system is oftenviewed as a combination of art and science.Theoretical results are rare andsome methods work surprisingly well,often despite expectations.—Saad,2003.预处理能否取得成功的关键是能否找到一个好的预处理子.预处理子的构造与问题本身是密切相关的,通用的“好预处理子”是不存在的.关于预处理技术的理论分析很少,大多数情况下只能根据经验来构造.尽管如此,在实际应用中,这些根据经验构造出来的预处理子往往能取得很好的效果,有时效果之好会大大出乎人们的意料之外.一般来说,预处理子可以分为两大类:(a)代数预处理子(Algebraic Preconditioner),即仅仅根据所给方程组的系数矩阵来构造预处理子.(b)专用预处理子(Problem-Specific Preconditioner),即根据问题的物理背景所构造的专用预处理子.显然,由于专用预处理子充分利用了问题的物理背景知识,所以它们往往具有很好的数值表现,如多重网格,区域分解,快速变换等等.但它们严重依赖于原问题的物理背景,因此不具有通用性.我们这里只介绍代数预处理子,即仅仅根据所给的系数矩阵来构造预处理方法.这种预处理方法具有一定的通用性.考虑线性方程组Ax=b,A∈R n×n,对A做如下的矩阵分裂:A=M−N(5.14)其中M非奇异,则可以得到下面的迭代方法x(k+1)=M−1Nx(k)+M−1b=x(k)+(M−1b−M−1A)x(k).k=0,1,2,....这等价于求解下面的方程组M−1Ax=M−1b.(5.15)这就是与矩阵分裂(5.14)相对应的预处理线性方程组.。

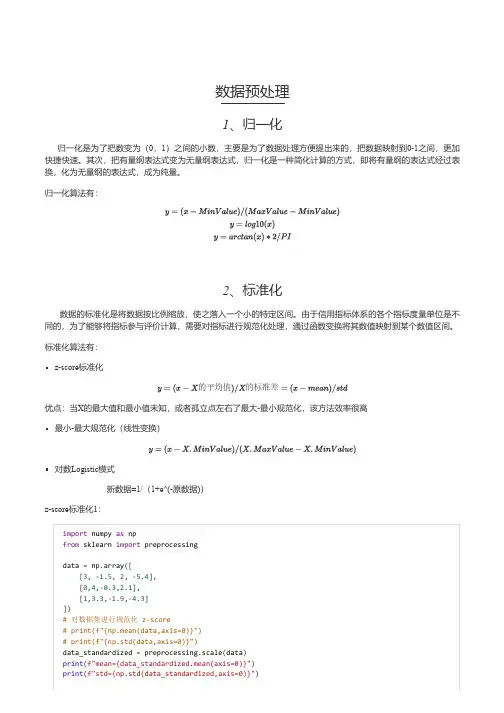

数据预处理1、归一化归一化是为了把数变为(0,1)之间的小数,主要是为了数据处理方便提出来的,把数据映射到0-1之间,更加快捷快速。

其次,把有量纲表达式变为无量纲表达式,归一化是一种简化计算的方式,即将有量纲的表达式经过表换,化为无量纲的表达式,成为纯量。

归一化算法有:2、标准化数据的标准化是将数据按比例缩放,使之落入一个小的特定区间。

由于信用指标体系的各个指标度量单位是不同的,为了能够将指标参与评价计算,需要对指标进行规范化处理,通过函数变换将其数值映射到某个数值区间。

标准化算法有:z-score标准化的平均值的标准差优点:当X的最大值和最小值未知,或者孤立点左右了最大-最小规范化,该方法效率很高最小-最大规范化(线性变换)对数Logistic模式新数据=1/(1+e^(-原数据))z-score标准化1:import numpy as npfrom sklearn import preprocessingdata = np.array([[3, -1.5, 2, -5.4],[0,4,-0.3,2.1],[1,3.3,-1.9,-4.3]])# 对数据集进行规范化 z-score# print(f"{np.mean(data,axis=0)}")# print(f"{np.std(data,axis=0)}")data_standardized = preprocessing.scale(data)print(f"mean={data_standardized.mean(axis=0)}")print(f"std={np.std(data_standardized,axis=0)}")print(data_standardized)mean=[ 5.55111512e-17-1.11022302e-16-7.40148683e-17-7.40148683e-17]std=[1.1.1.1.][[ 1.33630621-1.40451644 1.29110641-0.86687558][-1.069044970.84543708-0.14577008 1.40111286][-0.267261240.55907936-1.14533633-0.53423728]]z-score标准化2:import numpy as npfrom sklearn.preprocessing import StandardScalerX = np.array([[ 1., -1., 2.],[ 2., 0., 0.],[ 0., 1., -1.]])scaler = StandardScaler().fit(X)print scaler.mean_print scaler.std_print scaler.transform(X)[ 1.0.0.33333333][ 0.816496580.81649658 1.24721913][[ 0.-1.22474487 1.33630621][ 1.224744870.-0.26726124][-1.22474487 1.22474487-1.06904497]]最大最小标准化:import numpy as npfrom sklearn import preprocessingdata=np.array([[3, -1.5, 2, -5.4],[0, 4,-0.3,2.1],[1, 3.3, -1.9, -4.3]]) # 原始数据矩阵 shape=(3,4)data_scaler=preprocessing.MinMaxScaler(feature_range=(0,1)) # 缩放到(0,1)之间data_scaled=data_scaler.fit_transform(data)print('scaled matrix: *********************************')print(data_scaled)scaled matrix: *********************************[[1.0. 1.0. ][0. 1.0.410256411. ][0.333333330.872727270.0.14666667]]公式原理:3、正则化正则化的过程是将每个样本缩放到单位范数(每个样本的范数为1),如果后面要使用如二次型(点积)或者其它核方法计算两个样本之间的相似性这个方法会很有用。

详细的数据预处理方法为什么数据处理很重要?熟悉数据挖掘和机器学习的小伙伴们都知道,数据处理相关的工作时间占据了整个项目的70%以上。

数据的质量,直接决定了模型的预测和泛化能力的好坏。

它涉及很多因素,包括:准确性、完整性、一致性、时效性、可信性和解释性。

而在真实数据中,我们拿到的数据可能包含了大量的缺失值,可能包含大量的噪音,也可能因为人工录入错误导致有异常点存在,非常不利于算法模型的训练。

数据清洗的结果是对各种脏数据进行对应方式的处理,得到标准的、干净的、连续的数据,提供给数据统计、数据挖掘等使用。

有哪些数据预处理的方法?数据预处理的主要步骤分为:数据清理、数据集成、数据规约和数据变换。

本文将从这四个方面详细的介绍具体的方法。

如果在一个项目中,你在这几个方面的数据处理做的都很不错,对于之后的建模具有极大的帮助,并且能快速达到一个还不错的结果。

数据清理数据清理(data cleaning) 的主要思想是通过填补缺失值、光滑噪声数据,平滑或删除离群点,并解决数据的不一致性来“清理“数据。

如果用户认为数据时脏乱的,他们不太会相信基于这些数据的挖掘结果,即输出的结果是不可靠的。

1、缺失值的处理由于现实世界中,获取信息和数据的过程中,会存在各类的原因导致数据丢失和空缺。

针对这些缺失值的处理方法,主要是基于变量的分布特性和变量的重要性(信息量和预测能力)采用不同的方法。

主要分为以下几种:•删除变量:若变量的缺失率较高(大于80%),覆盖率较低,且重要性较低,可以直接将变量删除。

•定值填充:工程中常见用-9999进行替代•统计量填充:若缺失率较低(小于95%)且重要性较低,则根据数据分布的情况进行填充。

对于数据符合均匀分布,用该变量的均值填补缺失,对于数据存在倾斜分布的情况,采用中位数进行填补。

•插值法填充:包括随机插值,多重差补法,热平台插补,拉格朗日插值,牛顿插值等•模型填充:使用回归、贝叶斯、随机森林、决策树等模型对缺失数据进行预测。

Matlab中的数据预处理方法详解引言数据预处理是数据分析的重要环节,它涉及到对原始数据进行清洗、转换和集成等操作,以获得高质量、完整、一致和可用的数据,为后续的分析和建模提供良好的基础。

Matlab作为一个强大的数值计算和数据处理工具,提供了丰富的函数和工具箱来支持各种数据预处理任务。

本文将详细介绍Matlab中常用的数据预处理方法,包括数据清洗、数据变换、特征选择和离群值处理等。

一、数据清洗1. 缺失值处理缺失值是指数据中的某些观测值缺失或无效的情况。

在数据预处理过程中,我们需要对缺失值进行处理,以保证后续分析的准确性和可靠性。

Matlab提供了多种处理缺失值的方法,包括删除缺失值、插补缺失值和不处理缺失值等。

常用的插补方法有均值插补、中位数插补和回归插补等。

2. 噪声处理噪声是指数据中存在的不符合真实规律的异常值或错误值。

噪声数据会对分析结果产生严重的干扰和误导,因此需要在数据预处理阶段对其进行处理。

Matlab提供了多种处理噪声数据的方法,包括平滑法、滤波法和异常值检测等。

平滑法可以通过计算滑动平均值或指数平均值来减少噪声的影响;滤波法可以通过设计合适的滤波器来滤除噪声;异常值检测可以通过统计方法或机器学习方法来识别和处理噪声数据。

二、数据变换1. 特征缩放特征缩放是指将不同尺度或不同单位的特征值转换为统一的尺度或单位。

特征缩放可以帮助我们消除由于特征单位不同而产生的偏差,提高数据的可比性和分析的准确性。

Matlab提供了多种特征缩放方法,包括最小-最大缩放、z-score标准化和正则化等。

最小-最大缩放将特征值线性转换为指定区间内的数值,z-score标准化将特征值转换为以特征均值为中心的单位方差分布,正则化将特征值转换为单位长度的向量。

2. 特征编码特征编码是将特征值转换为数值或向量表示的过程。

特征编码可以帮助我们处理非数值特征或高维特征,提供更好的数据表示和建模效果。

Matlab提供了多种特征编码方法,包括独热编码、标签编码和二进制编码等。

pca计算方法假设我们有一个m×n的数据矩阵X,其中每一行代表一个样本,每一列代表一个特征。

我们的目标是将X降维到k维,其中k<n。

下面是PCA的计算步骤:1.预处理数据:首先,对数据进行预处理。

对于每一列特征,我们减去该列特征的平均值,使得每个特征的均值为0。

这是为了消除特征之间的差异,使得每个特征对结果的影响权重相同。

2.计算协方差矩阵:接下来,我们计算数据矩阵的协方差矩阵。

协方差矩阵表示了每对特征之间的相关性。

协方差的计算公式为:Cov(X) = (1/m) * X^T * X其中,X^T表示X的转置,m为样本数。

3.计算特征值和特征向量:通过对协方差矩阵进行特征值分解,我们可以得到特征值和对应的特征向量。

特征值表示了每个特征在新的空间中的方差,特征向量表示着数据在新的空间中的方向。

协方差矩阵的特征值分解可以通过奇异值分解(SVD)来实现。

通过SVD,我们可以得到协方差矩阵的特征值和对应的特征向量。

特征向量按照对应的特征值的大小排序,特征值越大,说明对应的特征向量所代表的特征在新的空间中的方差越大。

4.选择主要成分:根据特征值的大小,我们选择前k个特征值对应的特征向量作为主要成分。

这些主要成分代表了原始数据中的主要信息。

通常情况下,我们选择前k个特征值的总和占所有特征值之和的90%以上作为阈值。

5.生成新的特征矩阵:将选择的前k个特征向量组成一个新的特征矩阵W,其中每一列代表一个主要成分。

通过矩阵乘法,我们可以将原始数据矩阵X转换到新的低维空间中:Y=X*W其中,Y为降维后的特征矩阵。

综上所述,PCA的计算方法包括预处理数据、计算协方差矩阵、计算特征值和特征向量、选择主要成分以及生成新的特征矩阵等步骤。

通过这些步骤,我们可以将高维数据降维到低维空间,并且保留了主要信息。

PCA在数据处理和分析中具有广泛的应用,例如图像处理、模式识别、数据压缩等领域。

预处理计算方法

●多介质过滤器、活性炭过滤器、保安过滤器和树脂罐型号的选择:

主要看RO终端出水流量,以RO设备对水的利用率计算预处理的流量.一般小型RO对水利用率大概为50---60%,大型系统在75%,最高不超过80%。

举例说明相关问题:

假设一级RO产水30 m3/h,回收率取75%,预处理产水量40 m3/h,暂不考虑预处理预备自用水率;

◆多介质过滤器产水量40 m3/h,设计流速取8---10m/h,根据Q=SV

【Q流量、S罐体截面积、V设计流速,S=π R2.罐体直径d=2R】

可以计算出罐体的直径,高度查厂家手册。

◆活性炭过滤器产水量40 m3/h,设计流速取10---12m/h,根据Q=SV

【Q流量、S罐体截面积、V设计流速,S=π R2.罐体直径d=2R】可

以计算出罐体的直径,高度查厂家手册。

◆软化器产水量40 m3/h,设计流速取15---20m/h,根据Q=SV【Q流

量、S罐体截面积、V设计流速,S=π R2.罐体直径d=2R】可以计算

出罐体的直径,高度查厂家手册。

◆保安过滤器产水量40 m3/h,滤芯通量取10 m3/ m3•h,按照滤芯的

规格,40〞滤芯外表面积是0.2 m2,即单只滤芯产水2 m3/h,(滤

芯的外径基本是63㎜,长度取1m,计算下来的表面积是0.1979 m2)

按照这个通量计算下来就是2m3/40〞,滤芯总数20支,选择20芯

40〞的过滤器即可。

解线性方程组的预处理方法的开题报告题目:解线性方程组的预处理方法研究与应用摘要:线性方程组是数值线性代数中的基础问题,常常要进行大规模的计算。

为了提高求解速度和精度,需要采用一些预处理方法对系数矩阵进行改造,使其更易于求解。

本文将从预处理方法的理论分析出发,探讨几种典型的预处理方法,并通过实验数据分析它们的优缺点。

关键词:线性方程组,预处理方法,典型方法,实验分析一、绪论线性方程组的求解是数学和工程领域中的基础问题,涉及到很多科学计算的应用。

线性方程组的求解方法可以分为直接法和迭代法两类。

直接法通过对矩阵进行初等变换,实现从方程组到三角矩阵的转换,可精确地求得方程组的解。

但是直接法的时间和空间复杂度很高,在求解大规模线性方程组时不适用。

迭代法则是通过从一个初始近似解开始,逐步逼近精确解的过程。

迭代法具有较高的效率和稳定性,并且可以用预处理技术进行改进。

预处理技术是解决大规模线性方程组问题的有效手段,它是对系数矩阵进行初步加工处理,以便更好地适应某种求解算法的特性。

通常情况下,预处理技术可以使求解速度加快,精度提高,收敛性增强。

本文将从预处理方法的理论分析出发,重点探讨下列典型方法:ILU 分解、SSOR预处理、AMG预处理等,并通过实验比较它们的性能差异。

二、预处理方法的理论分析预处理方法是解决系数矩阵的稀疏特性与求解算法的高效性之间的冲突的方法,其本质思想是通过改变线性方程组的系数矩阵,使其满足求解算法的特性,以此提高求解过程的性能。

预处理技术可以分为不完全预处理和完全预处理两类。

1. 不完全预处理不完全预处理采用一种近似的方法来求解原问题,它可以针对特定的求解算法进行预处理,以简化原问题矩阵的结构,加速求解过程,减少计算复杂度。

其中,ILU分解是一种经典的非完全预处理方法,其主要思想是将原矩阵分解成一个下三角矩阵L和一个上三角矩阵U的乘积形式。

2. 完全预处理完全预处理则是通过对系数矩阵进行完全分解,得到矩阵的特征和结构信息,进而利用这些信息进行求解或加速。

边缘计算技术的数据预处理方法数据预处理是数据分析和挖掘过程中一个关键的步骤,它涉及到对原始数据进行清洗、转换、集成和规范化等操作,以便进一步的处理和分析。

而边缘计算技术的快速发展为数据预处理带来了新的挑战和机遇。

本文将探讨边缘计算技术的数据预处理方法,以提高数据处理效率和准确性。

1. 数据清洗数据清洗是数据预处理的第一步,它涉及到对原始数据中的噪声、错误和不一致性进行处理。

在边缘计算环境中,由于数据传输的延迟和带宽限制,数据清洗的效率和准确性都面临着挑战。

因此,可以采用以下几种方法来进行数据清洗:a. 基于规则的数据清洗:利用预定义的规则对数据进行清洗,例如删除重复记录、修复缺失值、处理异常值等。

这种方法可以在边缘设备上进行实时清洗,以减少数据传输的开销。

b. 基于模型的数据清洗:利用机器学习算法建立数据清洗模型,对数据进行自动清洗。

这种方法可以在边缘服务器上进行离线训练,并将训练得到的模型部署到边缘设备上进行实时清洗。

2. 数据转换数据转换是将原始数据从一种形式转换为另一种形式,以满足进一步处理和分析的需求。

边缘计算环境中的数据转换主要包括以下几方面:a. 数据格式转换:将原始数据从一种格式转换为另一种格式,例如从文本格式转换为CSV格式、从图像格式转换为矢量格式等。

在边缘设备上进行数据格式转换可以减少数据传输的开销。

b. 特征提取:从原始数据中提取有效的特征以支持进一步的分析和挖掘。

在边缘计算环境中,可以采用轻量级的特征提取算法,以减少计算和存储的开销。

3. 数据集成数据集成是将来自不同源头的数据进行合并,以获得更全面和一致的数据集。

在边缘计算环境中,数据集成方法需要考虑到数据传输的延迟和带宽限制。

因此,可以采用以下几种方法来进行数据集成:a. 增量式数据集成:将增量数据传输到边缘服务器,并与已有的数据进行合并。

这种方法可以减少数据传输的开销,并保持数据集的实时性。

b. 模型驱动的数据集成:利用机器学习模型或数据挖掘模型将来自不同源头的数据进行集成。

边缘计算技术的数据预处理方法随着物联网和人工智能等技术的迅猛发展,边缘计算作为一种新兴的计算模式正在崭露头角。

边缘计算技术的出现解决了传统云计算模式在延迟、带宽和隐私保护等方面的局限性,为各行各业的数据处理和应用带来了新的可能。

数据预处理是边缘计算中的重要环节,本文将从数据采集、数据清洗、数据聚合和数据压缩四个方面介绍边缘计算技术的数据预处理方法。

首先,数据采集是数据预处理的第一步。

边缘计算环境中的传感器节点能够实时采集环境中的各种数据,如温度、湿度、压力、光照等。

为了确保数据的准确性和完整性,边缘设备需要选择合适的传感器,并合理安置在被监测的物体或环境中。

此外,考虑到边缘节点资源有限的特点,数据采集过程中需要采用有效的压缩算法来减少数据的传输量,降低对带宽的需求。

数据采集完成后,接下来进行数据清洗。

由于传感器采集到的数据可能包含噪声、异常值或缺失值,造成数据的不准确性和不完整性。

因此,在数据预处理阶段,需要对数据进行清洗以消除这些问题。

数据清洗的过程主要包括噪声过滤、异常检测和缺失值处理。

噪声过滤通过使用滤波算法或数据平滑技术,对数据中的异常噪声进行滤除或平滑处理。

异常检测则采用统计学或机器学习算法来检测数据中的异常值,并进行修正或剔除。

而对于缺失值处理,可以通过插值、删除或补充估计值等方法进行处理。

数据清洗之后,边缘设备可以根据具体的应用需求对数据进行聚合。

数据聚合是指将分散的数据集合成一个整体。

在边缘计算环境下,大量的传感器节点产生的数据需要进行聚合,以降低数据传输和处理的成本。

数据聚合可以按照时间、空间或属性等方式进行。

时间聚合是指将一段时间内的数据进行合并,减少数据传输的频率。

空间聚合则是将某个区域内的数据进行合并,降低数据传输的距离。

属性聚合是将具有相同特征的数据进行合并,减少数据冗余。

通过合理选择聚合策略,可以提高边缘计算环境下的数据处理效率和网络性能。

最后,数据压缩是边缘计算中数据预处理的重要环节。

随着物联网和人工智能技术的飞速发展,边缘计算作为一种新兴的计算模式,正在逐渐成为人们关注的焦点。

边缘计算是指将数据处理和存储的工作从传统的集中式云计算中心转移到数据源附近的边缘设备上进行,以减少数据传输延迟和减轻网络负担。

在边缘计算中,数据清洗和预处理是至关重要的环节,它们直接影响着数据分析和计算的结果。

本文将探讨边缘计算中的数据清洗与预处理方法。

一、数据清洗的重要性边缘计算中的数据通常来自各种传感器、设备和终端用户,这些数据可能存在各种各样的问题,如缺失值、异常值、重复值等。

这些问题如果不及时处理,会影响数据的质量和可靠性,进而影响到后续的数据分析和决策。

因此,数据清洗是边缘计算中必不可少的一环。

数据清洗的方法包括但不限于:缺失值处理、异常值处理、重复值处理、数据转换和规范化等。

在边缘计算环境中,由于设备资源和能力有限,传统的数据清洗方法可能无法直接应用,因此需要针对边缘计算的特点,设计相应的数据清洗方法。

二、数据清洗方法1. 缺失值处理在边缘计算中,由于设备的资源有限,无法直接使用传统的缺失值处理方法,如均值、中位数、众数填充等。

因此,可以考虑使用插值法,根据已有的数据推算出缺失值,或者使用基于模型的方法,通过建立模型来预测缺失值。

2. 异常值处理在边缘计算环境中,由于数据量大、实时性要求高,传统的异常值处理方法可能无法满足需求。

因此,可以考虑使用基于规则的方法,设定异常值的阈值,对超出阈值的数据进行处理;或者使用基于模型的方法,通过建立模型来识别和处理异常值。

3. 重复值处理在边缘计算中,由于数据量大、实时性要求高,传统的重复值处理方法可能无法直接应用。

因此,可以考虑使用基于哈希函数的方法,将数据转换为哈希值,通过比较哈希值来识别和处理重复值。

4. 数据转换和规范化在边缘计算中,数据通常是异构的,需要进行数据转换和规范化。

可以使用基于规则的方法,根据数据的特点和需求,设计相应的转换和规范化规则;也可以使用基于模型的方法,通过建立模型来实现数据的转换和规范化。

预处理计算方法

●多介质过滤器、活性炭过滤器、保安过滤器和树脂罐型号的选择:

主要看RO终端出水流量,以RO设备对水的利用率计算预处理的流量.一般小型RO对水利用率大概为50---60%,大型系统在75%,最高不超过80%。

举例说明相关问题:

假设一级RO产水30 m3/h,回收率取75%,预处理产水量40 m3/h,暂不考虑预处理预备自用水率;

◆多介质过滤器产水量40 m3/h,设计流速取8---10m/h,根据Q=SV

【Q流量、S罐体截面积、V设计流速,S=π R2.罐体直径d=2R】

可以计算出罐体的直径,高度查厂家手册。

◆活性炭过滤器产水量40 m3/h,设计流速取10---12m/h,根据Q=SV

【Q流量、S罐体截面积、V设计流速,S=π R2.罐体直径d=2R】可

以计算出罐体的直径,高度查厂家手册。

◆软化器产水量40 m3/h,设计流速取15---20m/h,根据Q=SV【Q流

量、S罐体截面积、V设计流速,S=π R2.罐体直径d=2R】可以计算

出罐体的直径,高度查厂家手册。

◆保安过滤器产水量40 m3/h,滤芯通量取10 m3/ m3•h,按照滤芯的

规格,40〞滤芯外表面积是0.2 m2,即单只滤芯产水2 m3/h,(滤

芯的外径基本是63㎜,长度取1m,计算下来的表面积是0.1979 m2)

按照这个通量计算下来就是2m3/40〞,滤芯总数20支,选择20芯

40〞的过滤器即可。