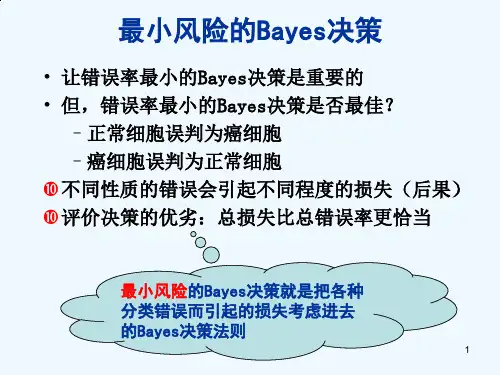

最小风险贝叶斯判决准则

- 格式:ppt

- 大小:587.00 KB

- 文档页数:80

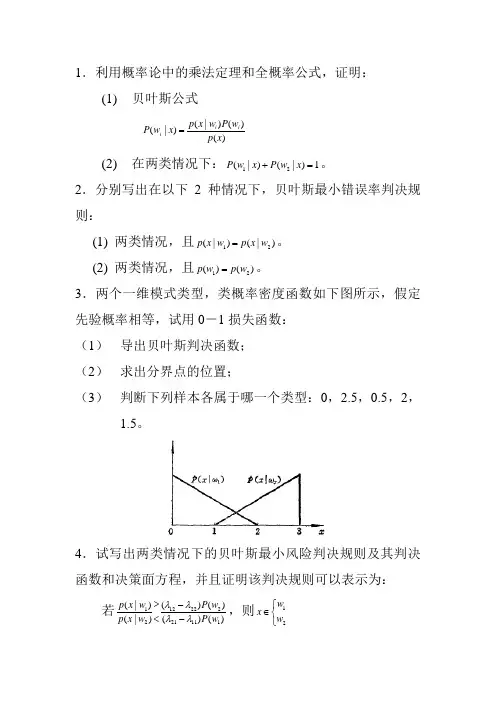

1.利用概率论中的乘法定理和全概率公式,证明:(1) 贝叶斯公式)()()|()|(x p w P w x p x w P i i i = (2) 在两类情况下:1)|()|(21=+x w P x w P 。

2.分别写出在以下2种情况下,贝叶斯最小错误率判决规则:(1) 两类情况,且)|()|(21w x p w x p =。

(2) 两类情况,且)()(21w p w p =。

3.两个一维模式类型,类概率密度函数如下图所示,假定先验概率相等,试用0-1损失函数:(1) 导出贝叶斯判决函数;(2) 求出分界点的位置;(3) 判断下列样本各属于哪一个类型:0,2.5,0.5,2,1.5。

4.试写出两类情况下的贝叶斯最小风险判决规则及其判决函数和决策面方程,并且证明该判决规则可以表示为: 若)()()()()|()|(111212221221w P w P w x p w x p λλλλ--<>,则⎩⎨⎧∈21w wx式中,12λ、22λ、21λ、11λ,为损失函数)|(j i w L α,2,1,=j i 。

若02211==λλ,2112λλ=,证明此时最小最大决策面使来自两类的错误率相等。

5.似然比)(x l 是随机变量,对两类问题)|()|()(21w x p w x p x l =,试证明: (1)]|)([]|)([211w x l E w x l E n n +=(2)1]|)([2=w x l E(3)]|)([]|)([]|)([221w x l Var w x l E w x l E =-注意:方差})]({[)()(2X E x E x Var x D -==。

6.属于两类的一维模式,每类都是正态分布的,并且已知两类的均值分别为01=μ和22=μ,均方差分别为21=σ和22=σ先验概率相等,可用0-1损失函数,试绘出类概率密度函数及判决边界;若已获得样本:-3,-2,1,3,5,试判断它们各属于哪一种类型。

最小风险贝叶斯决策判决规则1. 走进最小风险的世界你有没有过这种经历?你站在一个十字路口,不知道该往哪边走。

左边可能有更美丽的风景,但也可能遇到堵车;右边看似平淡无奇,但也许会有惊喜。

决定究竟走哪边,真是让人抓狂。

其实,这就像是贝叶斯决策中的一个经典问题:如何在不确定的情况下做出最优选择?听起来复杂对吧?别担心,让我们一步步来解开这个谜团。

2. 贝叶斯决策规则大揭秘2.1 贝叶斯的魔法贝叶斯决策规则的核心思想就是最小化风险。

我们先得了解什么是风险。

想象一下,你在赌场里,拿着一把筹码,面前有一副扑克牌。

你能选择赌一手,但不确定对手的牌有多强。

你知道,如果你选择错了,可能会输钱;如果选择对了,可能会赢大钱。

最小风险的意思就是在这张扑克牌游戏中,怎么才能让你输钱的概率最小,也就是风险最小。

2.2 如何选择最小风险的路径回到我们的十字路口问题。

假如你想用贝叶斯决策规则来决定走哪条路,首先,你需要知道每条路的可能结果和这些结果的概率。

简单来说,你得了解每条路可能带来的好事和坏事的概率。

比如,左边的路你知道可能会遇到拥堵,概率是50%,而右边的路,你知道它的拥堵概率只有20%。

这时候,你就需要计算走每条路的期望风险。

期望风险就是对所有可能结果的风险进行加权平均。

简单点说,就是把每条路的所有可能坏结果的风险加起来,看哪个路的综合风险最小。

听起来是不是有点像在做数学题?别担心,做这种选择题其实就像是你在超市挑选打折商品,挑那个最划算的就对了。

3. 风险最小化的妙招3.1 把风险控制在合理范围内在现实生活中,我们面临的风险多得数不过来,比如投资股市、选择工作、甚至是买房子。

最小风险贝叶斯决策规则就像是你手里的一个万能工具,可以帮助你在这些选择中做出更理智的决定。

想象一下,你要投资一个新项目。

你可以用贝叶斯方法来估算这个项目的成功概率和可能带来的损失。

你计算出每种可能结果的风险,然后把它们加权,看看哪种投资最能让你的钱包安稳。

风险投资中的最小贝叶斯风险决策基金项目:泰山医学院青年科学基金资助项目最小贝叶斯风险决策使贝叶斯风险最小的决策方法。

本文通过一个具体实例,阐述贝叶斯决策在风险投资分析中的应用。

并由此得出结论:贝叶斯决策属于风险型决策,决策者虽不能控制客观因素的变化,但却可掌握其变化的可能状况及各状况的分布概率,并利用期望值即未来可能出现的平均状况作为决策准则。

贝叶斯決策不是使决策问题完全无风险,而是通过其他途径增加信息量使决策中的风险减小。

由此可以看出,贝叶斯决策是一种比较实际可行的方法。

[ 关键词] 风险投资贝叶斯决策最小贝叶斯风险决策贝叶斯决策就是在不完全情报下,对部分未知的状态用主观概率估计,然后用贝叶斯公式对发生概率进行修正,最后再利用期望值和修正概率做出最优决策。

贝叶斯决策理论方法是统计模型决策中的一个基本方法,其基本思想是:1. 已知含有未知参数的概率密度表达式以及未知参数先验概率;2. 利用先验分布计算其后验概率;3. 根据后验概率求参数贝叶斯决策。

寻求贝叶斯决策函数有两条路径,一条是使后验风险最小,一条是使贝叶斯风险最小。

实际中,人们常使用后验风险途径,因为它的计算相对简单和方便,本文我们使用的实际上正是后验风险准则。

在不同的先验分布假设下,参数的贝叶斯决策量一般是不同的。

本文旨在通过在各种不同的先验分布条件下进行参数的贝叶斯决策,最终比较并探讨各种情况下贝叶斯决策的优良性问题。

一、提出问题设想有一投资公司对某一项目已经投入100万元。

现在决定是追加投资100万或是保持原投资不变,还是将已经投入的100万撤回。

若在一年后该项投资的收益会因市场的变化而不同,如果一年后的市场对该项投资分为有利和不利两种情况。

且根据以往的经验有利和不利两种情况发生的概率分别为:0.7和0.3。

有利时可获利30%,不利时会损失40%。

在这种情况下,寻求最小贝叶期风险决策。

如果该公司投资前用5万元聘请一名投资顾问,该顾问在未来有利的情况下预测的准确率为85%,不利时预测的准确率是90%。

2 1一、填空题(15个空,每空2分,共30分)1.基于机器学习的模式识别系统通常由两个过程组成,即()和分类判决。

2.统计模式识别把观察对象表达为一个随机向量(即特征向量),将()表达为由有穷或无穷个具有相似数值特性的模式组成的集合。

3.特征一般有两种表达方法:(1)将特征表达为();(2)将特征表达为基元。

4.特征提取是指采用变换或映射实现由模式测量空间向()的转变。

5.同一类模式类样本的分布比较集中,没有或临界样本很少,这样的模式类称为()。

6.加权空间的所有()都通过坐标原点。

7.线性多类判别:若每两个模式类间可用判别平面分开,在这种情况下,M 类有()个判别函数,存在有不确定区域。

8.当取()损失函数时,最小风险贝叶斯判决准则等价于最大后验概率判决准则。

9.Neyman-Pearson决策的基本思想是()某一错误率,同时追求另一错误率最小。

10.聚类/集群:用事先不知样本的类别,而利用样本的先验知识来构造分类器属于()学习。

11.相似性测度、()和聚类算法称为聚类分析的三要素。

12.K/C均值算法使用的聚类准则函数是()准则,通过反复迭代优化聚类结果,使所有样本到各自所属类别的中心的距离平方和达到最小。

13.根据神经元的不同连接方式,可将神经网络分为分层网络和相互连接型网络两大类。

其中分层网络可细分为前向网络、具有反馈的前向网络和()三种互连方式。

14.神经网络的特性及能力主要取决于()及学习方法。

15.BP神经网络是采用误差反向传播算法的多层前向网络,其中,神经元的传输函数为S型函数,网络的输入和输出是一种()映射关系。

1.分类器设计,2.模式类,3.数值,4.特征空间,5.紧致集,6.分界面,7.M(M-1)/2,8.0-1,9.约束或限制,10.无监督,11.聚类准则,12.误差平方和,13.层内互连前向网络,14.网络拓扑结构,15.非线性二、简答题(2题,每小题10分,共20分)1.简述有监督分类方法和无监督分类方法的主要区别。

实验一一、 实验原理1. 最小错误率贝叶斯决策规则:对于两类问题,最小错误率贝叶斯决策有如下判决规则:1212(|)(|),;P x P x x x ωωωω>∈∈则反之,则。

由于先验概率i (P ω)可以确定,与当前样本x 无关,所以决策规则也可整理成下面的形式: 121212(|)()(),()(|)P x P l x x x P P x ωωωωωω=>∈∈若,则否则。

2. 平均错误率决策边界把x 轴分割成两个区域,分别称为第一类和第二类的决策区域.样本在中但属于第二类的错误概率和样本在中但属于第一类的错误概率就是出现错误的概率,再考虑到样本自身的分布后就是平均错误率:212211()(|)()(|)()(|)P()(|)P()t t t t P e P x p x dx P x p x dx p x dx p x dx ωωωωωω∞-∞∞-∞=+=+⎰⎰⎰⎰3. 此实验中的判决门限和平均错误率(1) 判决门限假设随机脉冲信号f 中0的概率为,高斯噪声信号n 服从,信号叠加时的放大倍数为a ,叠加后的信号为*s f a n =+。

由最小错误率贝叶斯决策可得:1122()(|)()(|)P p x P p x ωωωω→→> 化简计算得:220022(ln(1)ln )2a a a p p t μσ+---=(2) 平均错误率由上述积分式可计算。

二、 实验内容1、 已知均值和方差,产生高斯噪声信号,计算其统计特性实验中利用MATLAB 产生均值为0,方差为1的高斯噪声信号,信号统计分布的程序和结果如下:%产生高斯噪声并统计其特性x=0;%均值为0y=1;%方差为1n=normrnd(x,y,[1 1000000]);%产生均值为0,方差为1的高斯噪声m1=mean(n);%高斯噪声的均值v1=var(n); %高斯噪声的方差figure(1)plot(n(1:400)); title('均值为0,方差为1的高斯噪声');figure(2)hist(n,10000); title('高斯噪声的统计特性');得到m1=-4.6534e-005;v1= 0.9971。

阈值选取是许多领域中的一个重要问题,尤其是在图像处理、信号处理、模式识别等学科中。

阈值选取准则通常是为了在一个给定的应用中找到一个合适的阈值,以便将数据分为两个不同的类别。

以下是一些常见的阈值选取准则:

1. 最小风险准则:在贝叶斯决策理论中,最小风险准则旨在找到一个阈值,使得错误分类的风险最小。

这通常涉及到计算误分类的成本或损失,并找到最优的阈值,以最小化这些成本的总和。

2. 最大似然准则:最大似然准则旨在找到一个阈值,使得给定数据的条件下,观测到的数据最有可能发生。

这在统计学中很常见,尤其是在阈值分割和分类问题中。

3. 最小距离准则:最小距离准则选择一个阈值,使得每个数据点与其对应的类别的距离之和最小。

这在分类问题中很常见,尤其是在监督学习算法中。

4. 基于熵的准则:熵是信息论中的一个度量,用于衡量不确定性。

基于熵的阈值选取准则旨在找到一个阈值,使得数据的熵最小,从而减少分类的不确定性。

5. 基于模式分类的准则:这种准则使用模式分类的原理来选择阈值,例如,通过分析数据的分布特性,找到一个能够最好地区分不同类别的阈值。

6. 自适应阈值选取:在某些情况下,阈值可能需要根据数据的局部特性或上下文来选取。

自适应阈值选取方法会根据数据的局部变化来调整阈值。

7. 遗传算法:遗传算法是一种启发式搜索算法,它模拟自然选择和遗传学原理来优化问题解决方案。

在阈值选取中,遗传算法可以用来找到一个良好的阈值,通过迭代地调整阈值来优化某个性能指标。

这些准则可以根据具体应用的需求和数据特性来选择。

在实际应用中,可能需要结合多个准则或对准则进行调整,以适应特定的问题。

实验一贝叶斯决策一、 实验原理1. 最小错误率贝叶斯决策规则:对于两类问题,最小错误率贝叶斯决策有如下判决规则:1212(|)(|),;P x P x x x ωωωω>∈∈则反之,则。

由于先验概率i (P ω)可以确定,与当前样本x 无关,所以决策规则也可整理成下面的形式:121212(|)()(),()(|)P x P l x x x P P x ωωωωωω=>∈∈若,则否则。

2. 平均错误率决策边界把x 轴分割成两个区域,分别称为第一类和第二类的决策区域.样本在中但属于第二类的错误概率和样本在中但属于第一类的错误概率就是出现错误的概率,再考虑到样本自身的分布后就是平均错误率:212211()(|)()(|)()(|)P()(|)P()ttt tP e P x p x dx P x p x dxp x dx p x dxωωωωωω∞-∞∞-∞=+=+⎰⎰⎰⎰3. 此实验中的判决门限和平均错误率 (1) 判决门限假设随机脉冲信号f 中0的概率为,高斯噪声信号n 服从,信号叠加时的放大倍数为a ,叠加后的信号为*s f a n =+。

由最小错误率贝叶斯决策可得:1122()(|)()(|)P p x P p x ωωωω→→>化简计算得:220022(ln(1)ln )2aa a p p t μσ+---=(2) 平均错误率 由上述积分式可计算。

二、 实验内容1、 已知均值和方差,产生高斯噪声信号,计算其统计特性 实验中利用MATLAB 产生均值为0,方差为1的高斯噪声信号,信号统计分布的程序和结果如下:%产生高斯噪声并统计其特性x=0;%均值为0 y=1;%方差为1n=normrnd(x,y,[1 1000000]);%产生均值为0,方差为1的高斯噪声 m1=mean(n);%高斯噪声的均值 v1=var(n); %高斯噪声的方差 figure(1)plot(n(1:400)); title('均值为0,方差为1的高斯噪声'); figure(2)hist(n,10000); title('高斯噪声的统计特性');得到m1=-4.6534e-005;v1= 0.9971。