异常值检验方法的比较分析

- 格式:pdf

- 大小:728.55 KB

- 文档页数:4

异常值的检验方法和判断标准全文共四篇示例,供读者参考第一篇示例:异常值是数据集中与大部分数值相差较大的数值,它可能会对数据分析产生影响,因此在数据处理前,需要对数据进行异常值的检验和处理。

异常值的检验方法和判断标准是数据分析的重要步骤之一,下面将介绍一些常见的异常值检验方法和判断标准。

一、常见的异常值检验方法1. 均值标准差方法均值标准差方法是一种比较简单直观的异常值检验方法。

首先计算数据的均值和标准差,然后根据正态分布的原理,认为落在均值加减3倍标准差范围之外的数据点为异常值。

2. 箱线图方法箱线图是一种直观显示数据分布情况的方法,通过箱线图可以很容易地识别出异常值。

在箱线图中,异常值通常被定义为小于Q1-1.5IQR或大于Q3+1.5IQR的数据点,其中Q1为下四分位数,Q3为上四分位数,IQR为四分位数间距。

3. Cook距离方法Cook距离是一种基于回归模型的异常值检验方法,它描述了在删除一个观测值时,对回归模型参数产生的影响程度。

一般来说,Cook 距离大于阈值(通常为4/n,n为样本量)的观测值可以被认为是异常值。

4. DBSCAN聚类方法DBSCAN是一种基于密度的聚类算法,可以用来识别数据中的异常值。

通过设定一定的距离和密度阈值,DBSCAN可以将数据点分为核心点、边界点和噪声点,噪声点可以被认为是异常值。

二、判断标准1. 统计学方法在使用均值标准差或箱线图等统计学方法进行异常值检验时,可以根据具体情况设定阈值,一般来说,超出均值加减3倍标准差或Q1-1.5IQR和Q3+1.5IQR范围的数据点可以被认为是异常值。

2. 领域知识方法在某些情况下,领域知识可能比统计学方法更能帮助我们识别异常值。

在医学领域,某些生理指标的异常值可能不是由数据采集或处理错误引起的,而是由于疾病或其他因素引起的,因此需要结合领域知识对异常值进行判断。

3. 机器学习方法机器学习方法也可以用来识别数据中的异常值,例如使用聚类算法(如DBSCAN)、离群点检测算法(如LOF、Isolation Forest)等方法。

8个判断异常的检验准则引言:在日常生活和工作中,我们常常会遇到各种异常情况,无论是在个人生活还是工作中,准确判断异常并采取相应措施是非常重要的。

在这篇文章中,我们将介绍8个判断异常的检验准则,帮助您更好地识别和解决异常情况。

一、观察准则:观察是判断异常的基本方法之一,通过观察可以发现异常的迹象和特征。

在判断异常时,我们应该注重细节,观察异常出现的时间、地点、频率、程度等方面的变化。

只有通过仔细观察,才能准确判断异常的性质和原因。

二、比较准则:通过比较不同时间、不同地点、不同情况下的数据,可以发现异常的存在。

比较准则可以帮助我们识别出数据中的异常值,并进一步分析异常的原因和影响。

在进行比较时,要注意数据的可比性,确保比较的数据具有相同的参考标准。

三、经验准则:经验准则是一种基于经验和常识的判断方法,通过积累和总结以往的经验,可以快速识别和判断异常情况。

在应对异常时,我们可以利用已有的经验进行判断,并根据经验采取相应的应对措施。

但是,经验准则也存在一定的局限性,因此需要不断学习和更新知识,以应对新的异常情况。

四、逻辑准则:逻辑准则是一种基于逻辑推理的判断方法,通过分析异常与正常情况之间的逻辑关系,可以推断出异常的存在。

在判断异常时,我们需要运用逻辑思维,分析异常与正常之间的差异和联系,并根据逻辑推理得出合理的结论。

五、统计准则:统计准则是一种基于统计学原理的判断方法,通过对数据进行统计分析,可以发现异常的存在。

在判断异常时,我们可以利用统计方法计算数据的均值、方差、偏度等指标,进而判断数据是否存在异常。

但是,在使用统计准则时,需要注意数据的分布和样本的大小,以保证结果的准确性。

六、专家准则:专家准则是一种基于专家经验和知识的判断方法,通过请教专家或专业人士,可以获取专业的意见和建议。

在判断异常时,我们可以向相关领域的专家咨询,借鉴他们的经验和知识,以提高判断的准确性和可靠性。

七、模型准则:模型准则是一种基于数学模型和实验数据的判断方法,通过建立模型并利用实验数据进行验证,可以判断异常的存在。

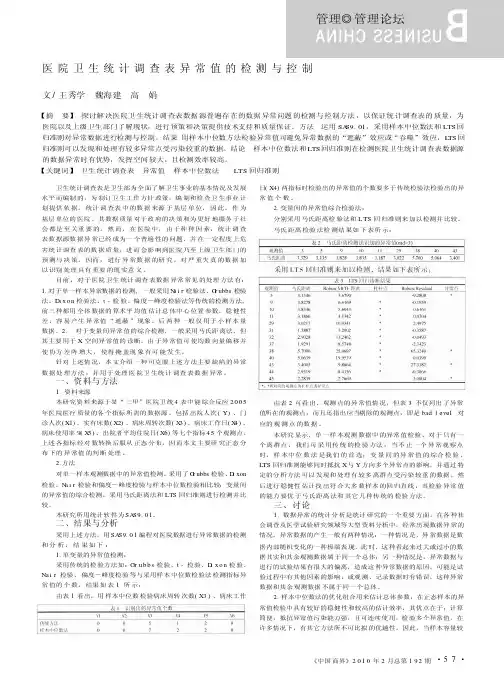

·5·《中国商界》年月总第期管理◎管理论坛卫生统计调查表是卫生部为全面了解卫生事业的基本情况及发展水平而编制的,为制订卫生工作方针政策,编制和检查卫生事业计划提供依据。

统计调查表中的数据来源于基层单位,因此,作为基层单位的医院,其数据质量对于政府的决策和为更好地服务于社会都是至关重要的。

然而,在医院中,由于种种因素,统计调查表数据源数据异常已经成为一个普遍性的问题,并在一定程度上危害统计调查表的数据质量,进而会影响到医院乃至上级卫生部门的预测与决策。

因而,进行异常数据的研究,对严重失真的数据加以识别处理具有重要的现实意义。

目前,对于医院卫生统计调查表数据异常常见的处理方法有:1.对于单一样本异常数据的检测,一般采用N a i r 检验法、G r ubbs 检验法、Di x o n 检验法、t -检验、偏度-峰度检验法等传统的检测方法,前三种都用全体数据的算术平均值估计总体中心位置参数,稳健性差,容易产生异常值“遮蔽”现象,后两种一般仅用于小样本量数据。

2.对于变量间异常值的综合检测,一般采用马氏距离法,但其主要用于X 空间异常值的诊断,由于异常值可使均数向量偏移并使协方差阵增大,使得掩盖现象有可能发生。

针对上述情况,本文介绍一种可克服上述方法主要缺陷的异常数据处理方法,并用于处理医院卫生统计调查表数据异常。

一、资料与方法1.资料来源本研究资料来源于某“三甲”医院卫统4表中能综合反应2005年医院医疗质量的各个指标所需的数据源,包括出院人次(Y)、门诊人次(X1)、实有床数(X2)、病床周转次数(X 3)、病床工作日(X 4)、病床使用率%(X 5)、出院者平均住院日(X6)等七个指标45个观测点。

上述各指标经对数转换后服从正态分布,因而本文主要研究正态分布下的异常值的判断处理。

2.方法对单一样本观测数据中的异常值检测,采用了G r ubbs 检验、D i xon 检验、N a i r 检验和偏度-峰度检验与样本中位数检验相比较;变量间的异常值的综合检测,采用马氏距离法和LTS 回归准则进行检测并比较。

机器学习中的异常检测与故障诊断方法在当今信息时代,大量的数据被生成和积累,这些数据包含了各种各样的信息和模式。

而对这些数据进行分析和利用,已经成为了各行各业的重要任务。

在工业生产和设备运行中,异常检测和故障诊断尤为重要。

机器学习技术在这个领域发挥了重要作用,其应用范围广泛,包括但不限于生产制造、汽车行业、能源领域等。

本文将探讨机器学习中的异常检测与故障诊断方法,介绍其中的几种常见方法和技术。

一、异常检测方法异常检测是指在数据中寻找不符合正常模式的数据点或者模式。

在机器学习中,异常检测是一个重要的研究领域,其应用包括金融风控、网络安全、工业生产等。

常见的异常检测方法包括基于统计的方法、基于聚类的方法、基于神经网络的方法等。

基于统计的方法是一种常见的异常检测方法,其思想是利用数据的统计特性来判断是否为异常。

例如,均值和方差是常用的统计特征,可以通过设定阈值来判断数据点是否为异常。

另一种方法是基于聚类的方法,通过对数据进行聚类分析,来判断某个数据点是否属于异常簇。

神经网络方法则是利用神经网络来学习数据中的模式,从而判断出现异常的情况。

二、故障诊断方法故障诊断是指在设备或者系统出现故障时,通过分析数据和监测信号来确定故障的原因和位置。

在工业生产中,故障诊断是非常重要的,可以帮助企业减少生产停机时间和维修成本。

机器学习方法在故障诊断中也发挥了重要作用,其应用包括但不限于设备健康监测、故障诊断、智能维护等。

故障诊断方法包括基于模型的方法、基于数据驱动的方法、基于深度学习的方法等。

基于模型的方法是指通过建立物理模型或者数学模型,来描述设备或者系统的运行特性,并通过比对模型和实际数据来诊断故障。

基于数据驱动的方法则是直接利用历史数据来进行故障诊断,例如利用监测信号和传感器数据来判断设备是否发生故障。

深度学习方法则是利用深度神经网络来学习大量数据,从而实现更加精准的故障诊断和预测。

三、结合异常检测与故障诊断在实际应用中,异常检测与故障诊断往往是密切相关的。

异常值的检验方法和判断标准1. 引言1.1 异常值的重要性异常值在数据分析中扮演着至关重要的角色,它们可能会对我们的分析结果产生影响,甚至导致我们做出错误的决策。

正确地检测和处理异常值至关重要。

异常值可能会影响我们对数据集的整体分布的理解。

如果数据中存在异常值,那么数据的均值、方差等统计量可能会被扭曲,从而误导我们对数据的解读。

通过寻找和排除异常值,我们可以更准确地描述数据的特征。

异常值也可能会影响我们建立的统计模型的准确性。

在一些情况下,异常值可能会对模型参数的估计造成严重偏差,从而影响我们对数据的预测能力。

及时发现和处理异常值可以提高我们建立的模型的质量。

1.2 异常值的定义异常值是指在数据集中与其他观测值明显不同的数值,它们可能是由于测量误差、数据录入错误或者真实现象导致的极端数值。

异常值在数据分析中具有重要性,因为它们可能对统计分析和模型建立产生影响,导致结果不准确或失真。

异常值的存在会影响数据的分布、均值和方差等统计性质,因此在数据处理和分析过程中需要进行检测和处理。

通常情况下,异常值可以通过与数据的整体分布进行比较来确定,例如通过绘制箱线图、直方图或散点图等可视化方法来识别异常值。

除了可视化方法外,统计学方法如Z-score、IQR等也常用于检测异常值。

机器学习方法如聚类分析、异常检测算法等也可以用来识别异常值。

专家经验在实际数据处理中也是重要的,经验丰富的专家可以通过直觉和经验判断数据中的异常值。

异常值在数据分析中起着重要作用,正确的检测和处理异常值可以确保数据分析结果的准确性和可靠性。

在实际应用中,我们需要综合考虑不同的方法来识别异常值,并根据具体情况选择合适的处理方法。

2. 正文2.1 可视化方法可视化方法是一种直观、直觉的异常值检验方法,通过图形展示数据的分布情况,可以帮助我们识别异常值。

常用的可视化方法包括箱线图、散点图、直方图等。

箱线图是一种常用的可视化方法,可以直观地展示数据的中位数、四分位数和异常值情况。

MATLAB中的异常值检测与处理技巧概述:异常值(Outliers),也称为离群点,在数据分析中扮演着重要的角色。

异常值可能是由于测量误差、仪器故障、非典型观测或随机噪声等原因引起的异常数据点。

这些异常值对于数据的分析和建模可能会产生不良影响,因此,准确地检测和处理异常值是数据分析的关键步骤之一。

在MATLAB中,有多种方法可以用于异常值的检测和处理。

本文将介绍一些常用的技巧和方法。

1. 数据可视化方法:在MATLAB中,通过绘制散点图、箱线图等可以直观地观察到数据的异常值。

散点图可以有效地揭示数据中存在的异常值,并提供了直观的观察视角。

箱线图则可以展示数据的离散程度和异常值的分布情况。

通过观察散点图或箱线图,我们可以较为容易地发现数据中的异常值,并对其进行处理。

2. 统计方法:除了可视化方法,MATLAB还提供了一些统计方法用于异常值的检测。

其中,最常用的方法之一是Z得分法。

该方法假设数据服从正态分布,通过计算每个数据点的Z得分(即偏离平均值的标准差)来判断数据是否为异常值。

一般来说,Z得分大于3或小于-3的数据点可以被认为是异常值。

MATLAB中可以使用zscore函数计算Z得分并进行异常值的检测。

3. 基于分布的方法:除了统计方法,基于分布的方法也是常用的异常值检测技巧之一。

在MATLAB中,可以使用一些假设检验的方法来检测异常值。

其中,最常用的方法之一是Grubbs'检验。

该方法假设数据服从正态分布,通过比较待测数据与其他数据的离差来判断数据是否为异常值。

通过计算计算统计量和临界值的比较,可以判断是否存在异常值。

MATLAB中可以使用goutlier函数来进行Grubbs'检验。

4. 插值法:除了检测异常值,对于异常值的处理也是十分重要的。

在MATLAB中,可以使用插值法来处理异常值。

插值法是一种将异常值替换为其他合理数值的方法。

其中,最常用的插值方法之一是线性插值法。

线性插值法假设数据的变化是线性的,通过相邻数据的线性关系来对异常值进行处理。

阿里巴巴1、异常值是指什么请列举1种识别连续型变量异常值的方法异常值Outlier 是指样本中的个别值,其数值明显偏离所属样本的其余观测值;在数理统计里一般是指一组观测值中与平均值的偏差超过两倍标准差的测定值.常见的异常值检验方法如下:●基于统计的方法●基于距离的方法●基于密度的方法●基于聚类的方法●基于偏差的方法●基于深度的方法t检验:按照t分布的实际误差分布范围来判别异常值,首先剔除一个可疑值,然后按t分布来检验剔除的值是否为异常值;狄克逊检验法:假设一组数据有序x1<x2<…<xn,且服从正态分布,则异常值最有可能出现在两端x1和xn;格拉布斯检验法:与狄克逊检验法思想一样,其检验公式为:指数分布检验:SPSS和R语言中通过绘制箱图可以找到异常值,分布在箱边框外部;2、什么是聚类分析聚类算法有哪几种请选择一种详细描述其计算原理和步骤;聚类分析cluster analysis是一组将研究对象分为相对同质的群组clusters的统计分析技术;聚类分析也叫分类分析classification analysis或数值分类numerical taxonomy;聚类与分类的不同在于,聚类所要求划分的类是未知的;聚类分析计算方法主要有:层次的方法hierarchical method、划分方法partitioning method、基于密度的方法density-based method、基于网格的方法grid-based method、基于模型的方法model-based method等;其中,前两种算法是利用统计学定义的距离进行度量; 常见的聚类方法有:K-pototypes算法,K-Means算法,CLARANS算法划分方法,BIRCH算法层次方法,CURE算法层次方法,DBSCAN算法基于密度的方法,CLIQUE算法综合了基于密度和基于网格的算法;k-means 算法的工作过程说明如下:首先从n个数据对象任意选择 k 个对象作为初始聚类中心;而对于所剩下其它对象,则根据它们与这些聚类中心的相似度距离,分别将它们分配给与其最相似的聚类中心所代表的聚类;然后再计算每个所获新聚类的聚类中心该聚类中所有对象的均值;不断重复这一过程直到标准测度函数开始收敛为止;一般都采用均方差作为标准测度函数. k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开;其流程如下:1从 n个数据对象任意选择 k 个对象作为初始聚类中心;2根据每个聚类对象的均值中心对象,计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分;3重新计算每个有变化聚类的均值中心对象;4循环2、3直到每个聚类不再发生变化为止标准测量函数收敛;优点:本算法确定的K 个划分到达平方误差最小;当聚类是密集的,且类与类之间区别明显时,效果较好;对于处理大数据集,这个算法是相对可伸缩和高效的,计算的复杂度为 ONKt,其中N是数据对象的数目,K是聚类中心,t是迭代的次数;缺点:1. K 是事先给定的,但非常难以选定;2. 初始聚类中心的选择对聚类结果有较大的影响;3.数据标准化技术是将数据按比例缩放,使之落入一个小的特定区间;去除数据的单位限制,将其转化为无量纲的纯数值,便于不同单位或量级的指标能够进行比较和加权;常用的方法有:1总和标准化;分别求出各要素所对应的数据的总和,以各要素的数据除以该要素的数据的总和,即4.缺失值处理方法1)直接丢弃含缺失数据的记录如:个案剔除法,这种方法却有很大的局限性;它是以减少样本量来换取信息的完备,会造成资源的大量浪费,丢弃了大量隐藏在这些对象中的信息;当缺失数据所占比例较大,特别是当缺数据非随机分布时,这种方法可能导致数据发生偏离,从而得出错误的结论;2补缺A. 用平均值来代替所有缺失数据:均值替换法,均值替换法也是一种简便、快速的缺失数据处理方法;使用均值替换法插补缺失数据,对该变量的均值估计不会产生影响;但这种方法是建立在完全随机缺失MCAR的假设之上的,而且会造成变量的方差和标准差变小;B.K -最近距离邻居法:先根据欧式距离或相关分析来确定距离具有缺失数据样本最近的K个样本,将这K个值加权平均来估计该样本的缺失数据;C.用预测模型来预测每一个缺失数据:该方法最大限度地利用已知的相关数据,是比较流行的缺失数据处理技术;如:回归替换法,该方法也有诸多弊端,第一,容易忽视随机误差,低估标准差和其他未知性质的测量值,而且这一问题会随着缺失信息的增多而变得更加严重;第二,研究者必须假设存在缺失值所在的变量与其他变量存在线性关系,很多时候这种关系是不存在的;5..Apriori算法和信息熵信息熵是数学中一个抽象的概念,他表示了信息源的不确定度,这里不妨把信息熵理解成某种特定信息的出现概率,当一种信息出现概率更高的时候,表明它被传播得更广泛,或者说,被引用的程度更高;我们可以认为,从信息传播的角度来看,信息熵可以表示信息的价值;支持度:SupportA->B=PA U B;支持度揭示了A与B同时出现的概率;如果A与B同时出现的概率小,说明A与B的关系不大;如果A与B同时出现的非常频繁,则说明A与B总是相关的;置信度Confidence的公式式:ConfidenceA->B=PA | B;置信度揭示了A出现时,B是否也会出现或有多大概率出现;如果置信度度为100%,则A和B可以捆绑销售了;如果置信度太低,则说明A的出现与B是否出现关系不大;Hx = EIxi = E log2,1/pxi = -∑pxilog2,pxi i=1,2,..n,单位是bit.其中,x表示随机变量,与之相对应的是所有可能输出的集合,定义为符号集,随机变量的输出用x表示;Px表示输出概率函数;变量的不确定性越大,熵也就越大,把它搞清楚所需要的信息量也就越大.以频繁项集{I1,I2,I3}为例产生强关联规则,最小置信度为40%(1)频繁项集{I1,I2,I3}的非空子集有{I1,I2},{I1,I3},{I2,I3},{I1},{I2},{I3}(2)产生强关联规则{I1,I2}=>I3 confidence=support{I1,I2,I3}/support{I1,I2}=2/4={I1,I3}=>I2 confidence=supportI1,I2,I3/supportI1,I3=2/4={I2,I3}=>I1 confidence=supportI1,I2,I3/supportI2,I3=2/4=I1=>{I2,I3} confidence=supportI1,I2,I3/supportI1=2/6=I2=>{I1,I3} confidence=supportI1,I2,I3/supportI2=2/7=I3=>{I1,I2} confidence=supportI1,I2,I3/supportI3=2/6=则强关联规则为:{I1,I2}=>I3;{I1,I3};{I2,I3}=>I13、根据要求写出SQL 没有学习过,之后的学习中需要补表A结构如下:Member_ID 用户的ID,字符型Log_time 用户访问页面时间,日期型只有一天的数据URL 访问的页面地址,字符型要求:提取出每个用户访问的第一个URL按时间最早,形成一个新表新表名为B,表结构和表A一致参考答案:create table B as select Member_ID, minLog_time, URL from A group by Member_ID ;5、用户调研某公司针对A、B、C三类客户,提出了一种统一的改进计划,用于提升客户的周消费次数,需要你来制定一个事前试验方案,来支持决策,请你思考下列问题:a 试验需要为决策提供什么样的信息c 按照上述目的,请写出你的数据抽样方法、需要采集的数据指标项,以及你选择的统计方法;a 试验要能证明该改进计划能显着提升A、B、C三类客户的周消费次数;b 根据三类客户的数量,采用分层比例抽样;需要采集的数据指标项有:客户类别,改进计划前周消费次数,改进计划后周消费次数;选用统计方法为:分别针对A、B、C三类客户,进行改进前和后的周消费次数的,两独立样本T-检验6.常见的抽样方法有哪些常用的有以下六种类型:简单抽样Simple sampling即简单随机抽样,指保证大小为n的每个可能的样本都有相同的被抽中的概率;例如:按照“抽签法”、“随机表”法抽取访问对象,从单位人名目录中抽取对象;优点:随机度高,在特质较均一的总体中,具有很高的总体代表度;是最简单的抽样技术,有标准而且简单的统计公式;缺点:未使用可能有用的抽样框辅助信息抽取样本,可能导致统计效率低;有可能抽到一个“差”的样本,使抽出的样本分布不好,不能很好地代表总体;系统抽样Systematic random sampling将总体中的各单元先按一定顺序排列,并编号,然后按照不一定的规则抽样;其中最常采用的是等距离抽样,即根据总体单位数和样本单位计算出抽样距离即相同的间隔,然后按相同的距离或间隔抽选样本单位;例如:从1000个电话号码中抽取10个访问号码,间距为100,确定起点起点<间距后每100号码抽一访问号码;优点:兼具操作的简便性和统计推断功能,是目前最为广泛运用的一种抽样方法;如果起点是随机确定的,总体中单元排列是随机的,等距抽样的效果近似简单抽样;与简单抽样相比,在一定条件下,样本的分布较好;缺点:抽样间隔可能遇到总体中某种未知的周期性,导致“差”的样本;未使用可能有用的抽样框辅助信息抽取样本,可能导致统计效率低;分层抽样Stratified random sampling是把调查总体分为同质的、互不交叉的层或类型,然后在各层或类型中独立抽取样本;例如:调查零售店时,按照其规模大小或库存额大小分层,然后在每层中按简单随机方法抽取大型零售店若干、中型若干、小型若干;调查城市时,按城市总人口或工业生产额分出超大型城市、中型城市、小型城市等,再抽出具体的各类型城市若干;优点:适用于层间有较大的异质性,而每层内的个体具有同质性的总体,能提高总体估计的精确度,在样本量相同的情况下,其精度高于简单抽样和系统抽样;能保证“层”的代表性,避免抽到“差”的样本;同时,不同层可以依据情况采用不同的抽样框和抽样方法;缺点:要求有高质量的、能用于分层的辅助信息;由于需要辅助信息,抽样框的创建需要更多的费用,更为复杂;抽样误差估计比简单抽样和系统抽样更复杂;整群抽样Cluster sampling层层深入抽样,不断缩小抽样的范围是先将调查总体分为群,然后从中抽取群,对被抽中群的全部单元进行调查;例如:入户调查,按地块或居委会抽样,以地块或居委会等有地域边界的群体为第一抽样单位,在选出的地块或居委会实施逐户抽样;市场调查中,最后一级抽样时,从居委会中抽取若干户,然后调查抽中户家中所有18岁以上成年人;优点:适用于群间差异小、群内各个体差异大、可以依据外观的或地域的差异来划分的群体;缺点:群内单位有趋同性,其精度比简单抽样为低;前面谈到抽样方法的一些基本分类和各自特点,需要注意的是,在实际的运用中,一个调查方案常常不是只局限于使用某一种抽样方式,而根据研究时段的不同采用多种抽样方法的组鸽为实现不同的研究目的,有时甚至在同一时段综合运用几种抽样方法;例如,设计一个全国城市的入户项目,在抽样上可以分为几个不同的步骤,包括:1在项目正式开始前,可以采用判断抽样法选出某一城市先作试点,在问卷设计初期可以采用任意抽样法选出部分人群进行问卷试访;2采用分层随机抽样法,确定全国要分别在多少个超大型市、多少个中型市、多少个小型市实施先分出城市的几个层次,再依据研究需要在各层用PPS法选取具体城市3采用简单抽样法或PPS抽样法,确定抽出城市中应抽的地块或居委会;4采用整群抽样法,确定抽出地块或居委会应访问的家庭户;5在项目后期,可以采用判断抽样法选取某城市进行深入研究;8.置信度与置信区间Px1<x<x2=1-a,称1-a为置信度,x1,x2为置信区间置信度越大,置信区间越宽;置信区间越宽,置信度越大;置信度越小,置信区间越窄曲线及含义ROC曲线指受试者工作特征曲线receiver operating characteristic curve, 是反映和的,是用构图法揭示敏感性和特异性的相互关系,它通过将连续变量设定出多个不同的临界值,从而计算出一系列敏感性和特异性,再以敏感性为纵坐标、1-特异性为横坐标绘制成曲线,曲线下面积越大,诊断准确性越高;在ROC曲线上,最靠近坐标图左上方的点为敏感性和特异性均较高的临界值;10.数据挖掘步骤①理解数据和数据的来源understanding;② 获取相关知识与技术acquisition;③ 整合与检查数据integration and checking;④ 去除错误或不一致的数据data cleaning;⑤ 建立模型和假设model and hypothesis development;⑥ 实际数据挖掘工作data mining;⑦ 测试和验证挖掘结果testing and verfication;⑧ 解释和应用interpretation and use;11.如何评估促销活动11. Bayes 公式全概率公式探索在已知结果的情况下,是由哪种原因引起的概率;()()(|)(|)()()(|)i i i i j j p B A p B p A B p B A p A p B p A B ==∑ 12. 逻辑回归分类问题逻辑回归适合求解哪些问题:逻辑回归本质上解决的是分类问题,Logistic 回归的主要用途: •寻找危险因素:寻找某一疾病的危险因素等; •预测:根据模型,预测在不同的自变量情况下,发生某病或某种情况的概率有多大; • 判别:实际上跟预测有些类似,也是根据模型,判断某人属于某病或属于某种情况的概率有多大,也就是看一下这个人有多大的可能性是属于某病;11. 线性回归线性回归一元和多元中对误差的假设都是假定服从均值为0方差为定值的正态分布,拟合系数的求解方法可以有最小二乘法梯度下降法等;关于残差的假设为:零均值,同方差,正态性,不相关,样本随机;回归分析的自变量为连续性变量,而方差分析的自变量为离散型分类变量; 广义线性回归于线性回归的最大区别是随机误差的分布不一定是正态分布,与非线性模型的最大区别是非线性回归无明确的随机误差分布假定;12. 过拟合现象以及避免的方法所谓过拟合问题:过拟合反映的是在学习训练中,模型对训练样本达到非常高的逼近精度, 为了能够对样本完全正确的分类,使得它的构造如此精细复杂,规则如此严格,以至于任何与样本数据稍有不同的文档它全都认为不属于这个类别,在测试数据上往往显示出很差的效果.产生过拟合是因为:1.由于对样本数据,可能存在隐单元的表示不唯一,即产生的分类的决策面不唯一.2.权值学习迭代次数足够多Overtraining,拟合了训练数据中的噪声和训练样例中没有代表性的特征.过度拟合解决方法:1.权值衰减.它在每次迭代过程中以某个小因子降低每个权值 ,此方法的动机是保持权值较小,避免weight decay,从而使学习过程向着复杂决策面的反方向偏;2. 减少特征的数量,有人工选择,或者采用模型选择算法3.验证数据一个最成功的方法是在训练数据外再为算法提供一套验证数据,应该使用在验证集合上产生最小误差的迭代次数,不是总能明显地确定验证集合何时达到最小误差.with some patterns交叉验证方法在可获得额外的数据提供验证集合时工作得很好,但是小训练集合的过度拟合问题更为严重.k-fold 交叉方法:把训练样例分成k 份,然后进行k 次交叉验证过程,每次使用不同的一份作为验证集合,其余k-1份合并作为训练集合.每个样例会在一次实验中被用作验证样例,在k-1次实验中被用作训练样例;5.正则化方法正则化是结构风险最小化策略的实现,是在经验风险上加一个正则化项或惩罚项;正则化项一般是模型复杂度的单调递增函数,模型越复杂,正则化项就越大,正则化方法的作用是:保留所有特征但减小参数的取值;13. 监督学习与非监督学习有监督学习:对具有概念标记分类的训练样本进行学习,以尽可能对训练样本集外的数据进行标记分类预测;这里,所有的标记分类是已知的;因此,训练样本的岐义性低;所有的分类回归算法都是有监督算法,常见的算法有:SVM,KNN,决策树算法,朴素Bayes 算法,神经网络,最小平方拟合,最大熵等;无监督学习:对没有概念标记分类的训练样本进行学习,以发现训练样本集中的结构性知识;这里,所有的标记分类是未知的;因此,训练样本的岐义性高;聚类就是典型的无监督学习,常见的无监督学习算法:聚类,PCA,关联规则算法Aprior,FP-Growth 等;14.分位数3σ原则3σ原则:在[]-3,+3μδμδ区间上的概率密度曲线之下的面积占总面积的%,对于标准正态分布有()330.997p x -≤≤=;15.常见分布的密度函数均值和方差16. 常见的区间估计以及假设检验表 对于均值的检验,方差已知一般采用U 检验标准正太分布,方差未知采用T 检验t 分布;关于方差的检验,一般都采用卡方检验,若是两个正太总体采用F 检验;17.假设检验P 值P value 是一个概率,就是当原假设为真时所得到的样本观察结果或更极端结果出现的几率;如果P值很小,说明原假设发生的概率很小,我们就有理由拒绝原假设,P值越小,我们拒绝原假设的理由越充分;总之,P值越小,表明结果越显着,一般以P < 为显着, P< 为非常显着;Sig值是显着性指标,一般大于拒绝原假设,否则接受原假设,一般大于表示差异不显着,小于表示差异显着,小于表示差异极显着;a:第一类错误是原假设真时拒绝了原假设弃真;b:第二类错误是原假设错误时接受了原假设取误;c=1-b:检验功效是原假设错误拒绝原假设;第一类错误与第二类错误互相矛盾的,检验功效越大越好即犯第二类错误的概率竟可能的小;18.数据分析的基本流程。

回归分析中异常值的诊断与处理1 引言对调查得到的大量原始数据进行加工处理,提取其中有用的信息,即统计整理,是进一步进行统计分析的前提.但是通常的统计整理方法往往都对样本数据有一个前提假设,即样本数据是来自同一个总体,而这个假设有时却不能成立.原因一是由客观因素造成的,如总体条件的突然变化或人们未知的某个因素的突然出现等等;二是由主观方面的因素造成的,即人为的差错如调查人员读错或抄错数据,不小心把另一些不同条件下的样本数据混杂进来.当样本中的个别数据明显的偏离样本中其余数据时,这些数据可能是来自不同的总体,我们称这样的数据为异常数据.若对混有异常数据的样本按常规进行统计整理、分析、推断,往往会得出不符合实际的结论.本文就样本中的异常数据提出了诊断方法和处理方法,并结合实例说明了简单回归中上述方法的具体应用.2 异常值的概念所谓异常值就是在所获统计数据中相对误差较大的观察数据,也称奇异值(Outliers).狭义地定义异常值就是一批数据中有部分数据与其余数据相比明显不一致的数据,也称离群值.社会经济统计中一切失实数据统称为异常值.由于人为或随机因素的影响,失实的数据随时都有可能出现,因而统计数据中的任何一个都有可能成为异常值,而狭义界定的异常值是指离群值,如果把统计数据按由小到大排列,若有异常值,它必位于其数据的两端,左端称为异常小值,右端的称为异常大值.残差:考虑线性回归模型y X e β=+,()0E e =,()2n Cov e I σ=. ()1其中 ⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y y 21,⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=---1,11,2211,111111p n n p p x x x x x x X ,⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=-110p ββββ ,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n e e e e 21. 分量形式为011,11i i i p p i y x x e βββ--=++++,n i ,, 1=. ()2定义ˆˆˆey y y X β=-=-为残差向量,其中ˆˆy X β=称为拟合值向量,βˆ为β在模型()1下的最小二乘估计.如果用n x x '',1表示X 的n 个行向量,则称 ˆˆi i i ey x β'=-, n i ,, 1=, 为第i 次试验或观测的残差.对简单回归,12111n x x X x ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y y 21,⎥⎦⎤⎢⎣⎡=10βββ.则ˆˆiiie y x β'=-,n i ,, 1=,其中()1,iix x '=.于是,异常值就是在回归分析中,一组数据()i i y x ,'如果它的残差i eˆ较其它组数据的残差大的多,则称此数据为异常值.异常值的出现有主客观的原因.主观上抽样调查技术有问题,疏忽大意记错,或人为的虚报,谎报数据等都可能导致异常数据,这直接影响了统计数据的质量;客观上某些样品由于特定原因在某些变量上的确表现突出,明显超出平均水平,这也可能产生异常值.异常值的存在必将导致相应统计分析误差增大,会对分析结果(平均值与标准差)产生重要影响,会降低测量的精度.如果不预先处理它们,用通常的统计整理方法所得出的结论可靠性差.而异常值的诊断与处理是保证原始数据可靠性,平均值与标准差计算准确性的前提.3 异常值的诊断方法在讨论异常值诊断问题时,通常要假设所得样本观测值在某中意义下遵从一定的分布规律.拿到一批数据,若能从其实际背景中明确看出它服从某中分布形式时,一般的做法是在这种分布假设下,导出能较好反映异常值与正常值差异的统计量,在没有异常值的原假设下作假设检验.以下给出两种检验方法.3.1 F 分布检验法学生化残差:考虑线性回归模型()1,记ˆˆyX β=,称y ˆ为拟合值向量,称其第i 个分量βˆˆi i x y'=为第i 个拟合值,则 ()1ˆy X X X X y Hy -''==,这里()1H X X X X -''=.文献中通常称H 为帽子矩阵.前面已经定义了ˆˆi i i ey x β'=-, n i ,, 1=, 为第i 次试验或观测的残差.将其标准化为iii h e-1ˆσ,再用σˆ代替σ,得到所谓学生化残差 ii i i h e r -=1ˆˆσ, n i , ,1=,这里ii h 为H 的第i 个对角元,pn eni i-=∑=122ˆˆσ.把正态线性回归模型()1改写成分量形式i i i e x y +'=β,()2,0~σN e i ,n i ,, 1=,这里i e ,)1(n i ,, =相互独立.如果第j 组数据()j j y x ,'是一个异常点,那么它的残差就很大.它的残差之所以很大是因为它的均值()j y E 发生了非随机性漂移η.从而()ηβ+'=j j x y E .这产生了一个新的模型i i ij j jy x e y x e ββη'=+⎧⎪⎨'=++⎪⎩ ()2~0,,i i j e N σ≠ ()3 记[]0,,0,1,0,,0j d '=.将模型()3改写成矩阵的形式j y X d e βη=++, ()I N e 2,0~σ, ()4模型()3和()4称为均值漂移线性回归模型.要判定()j j y x ,'不是异常点,等价于检验假设0=η:H .引理1 用()i y ,()i X 和()i e 分别表示从Y 、X 和e 剔除第i 行所得到的向量或矩.从线性回归模型()1剔除第i 组数据后,剩余的1-n 组数据的线性回归模型为()()()i i i y X e β=+,()()0i E e =,()()21n i Cov e I σ-=. ()5将从这个模型求到的β的最小二乘估计记为()i βˆ,则 ()()i iii i x X X h e11ˆˆˆ-'--=ββ. 证明:因为()()()()()()1ˆi i i i i X X X y β-''=. ()6设A 为n n ⨯可逆阵,v u 和均为1⨯n 向量.用恒等式()vA u A v u A A v u A 111111-----'-'+='- 有()()()()()()()111111i i i i iiiiX X x x X X X X X X x x X X h -----'''''''=-=+-, ()7这里i x '为X 的第i 行.将上式两边右乘X y ',并利用()()i i i i X y X y y x ''=+以及()6式,有()()()()()()iii i ii i i i h x x X X x X X y -''-'+=--1ˆˆˆ11βββ.()8将()7式右乘i x ,可以得到如下关系式()()()()i iii iix X X h x X X 1111--'-='. 将其代入()8式,得到()()i iii i x X X h e11ˆˆˆ-'--=ββ. 引理2 对均值漂移线性回归模型()4,β和η的最小二乘估计分别为()j ββˆ=*和j jje h ˆ11-=*η, 其中()j βˆ为从非均值漂移线性回归模型()1剔除第j 组数据后得到的β的最小二乘估计.()()X X X X h H jj ''==-1,jj h 为H 的第j 个对角元.j e ˆ为从模型()2导出的第j 个残差.证明:显然,j j y y d =',1='j j d d .记()12,,,n X x x x '=.则j j x d X ='.于是,根据定义()111j j j j j j X X X X x X y Xd y d d x y βη-*-*''''⎡⎤⎛⎫⎡⎤⎡⎤⎛⎫⎡⎤==⎢⎥ ⎪ ⎪⎢⎥⎢⎥⎢⎥'''⎢⎥⎣⎦⎝⎭⎣⎦⎣⎦⎝⎭⎣⎦. 根据分块矩阵的逆矩阵公式(见附录1),以及()j j jj x X X x h 1-''=.()()()()()()()()111111111111111111ˆˆ1111ˆ111ˆˆ11ˆ1j j j jj jjj j jj jjj j j j jj jjj j jj jj j j jjj jj X X X X x x X X X X x h h X y y x X X h h X X x x X X x y h h x y h h X X x e h e h βηββββ----**----⎡⎤'''''+-⎢⎥--'⎡⎤⎡⎤⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦''-⎢⎥--⎣⎦⎛⎫'''+- ⎪--⎪= ⎪'-+ ⎪ ⎪--⎝⎭⎛'--=-⎝⎫ ⎪⎪ ⎪ ⎪ ⎪⎭. 再由引理1知命题得证.现在应用引理来求检验0=η:H 的检验统计量.注意到,对现在的情形,在约束条件0=η下,模型()4就化为模型()1,于是=H RSS 模型()1无约束情形下的残差平方和 y X y y ''-'=βˆ. 而模型()4的无约束残差平方和y d y X y y RSS j '-'-'=**'ηβ. ()9利用引理2得()2ˆˆˆ1ˆˆ111H jj j j j j jj jj jjRSS RSS X y d y e y e e x h h h ββηβ**'''-=-+'=-+=---.这里βˆˆj j j x y e'-=为第j 组数据的残差. 利用*β和*η的具体表达式将()9式作进一步化简:jj j j jjj j h y e h y e y X y y RSS ---+''-'=1ˆ1ˆˆˆβ=()jjj h e p n ---1ˆˆ22σ,其中pn eni i-=∑=122ˆˆσ.根据引理2,所求的检验统计量为()()()()22222111ˆ1ˆ1ˆ1jj jj j jj jH r p n r p n h p n e p n p n h e p n RSS RSSRSS F ----=--------=---=σ. 于是,我们证明了如下事实:定理[]2 对于均值漂移线性回归模型()4,如果假设0=η:H 成立,则()1,122~1------=p n j j j F r p n r p n F .据此,我们得到如下检验:对给定的()10<<αα,若()()α1,1221-->----=p n jj j F rp n r p n F ,则判定第j 组数据()j j y x ,'为异常点.当然,这种检验会犯“判无为有”的错误,也就是()jjy x ,'可能不是异常点,而被误判为异常点.但我们犯这种错误的概率只有α,事先我们可以把它控制的很小.显然,根据t 分布与F 分布的关系,我们也可以用t 检验法完成上面的检验.若定义()()212211⎥⎥⎦⎤⎢⎢⎣⎡----==j j j j r p n p n r F t . 对给定的α,当⎪⎭⎫⎝⎛>--21αp n j t t时,我们拒绝假设0=η:H .即判定第j 组数据()j j y x ,'为异常点.3.2 残差及残差图检验异常值前面定义了βˆˆX y e-=,称为残差向量,其分量形式ˆˆi i i e y x β'=-,()1,,i n =,称为第i 次试验或观测的残差.特别地,对简单回归,()i i x x ,1=',n i ,, 1=.⎪⎪⎪⎪⎪⎪⎭⎫ ⎝⎛---=⎥⎦⎤⎢⎣⎡=∑∑==n i i n i i i x n x y x n y x x y 1221110ˆˆˆˆββββ.所以,()i i i x y e 10ˆˆˆββ+-=,n i ,, 1=. 残差是最重要的一种回归诊断量,它蕴涵了有关模型基本假设的许多重要信息.残差分析就是对残差进行统计处理,从中提炼出这些信息的方法.而残差图就是残差分析中使用的基本工具.所谓残差图就是残差i eˆ对因变量y 或自变量n X X X ,, 21,,或其它导出统计量(如拟合值i yˆ)的点子图,有时候也用残差对时间或对数据序数的点子图.最简单的图,尤其在简单回归中,为残差i eˆ对拟合值i y ˆ的图. 所谓异常数据就是相对于其它观测值来说,具有大的残差的数据点.利用残差及残差图检验异常值的方法是用所给数据计算出残差i eˆ,与其余观测值的残差进行比较,具有大的残差的数据点被怀疑为异常值.然后作出自变量与因变量的散点图,残差i e ˆ对拟合值i y ˆ的残差图以及残差i eˆ对自变量i x 的残差图,从图中观察,那些远离大多数观测点的孤立的点有理由被认为是异常点.然后从数据中删除这些点,再次估计回归方程,作出X 与Y 的散点图以及i eˆ对i y ˆ的残差图,计算标准差,与删除前进行比较. 4 提出两种处理方法4。

数据挖掘中的异常检测算法比较分析引言:在当今大数据时代,数据的增长速度迅猛,其中包含了大量的异常数据。

异常数据的存在可能带来负面影响,对于数据的准确性和可靠性造成威胁。

因此,异常检测在数据分析中变得越来越重要。

本文将对数据挖掘中常用的异常检测算法进行比较分析,探讨它们的优劣势以及适用场景。

一、简介异常检测是指在一个数据集中,通过识别那些与大多数数据不相符的数据项,从而找出数据分布中不正常的部分。

它是数据挖掘中的重要任务之一,广泛应用于金融风险管理、网络入侵检测、医疗诊断等领域。

二、常见的异常检测算法1. 基于统计学方法的异常检测算法基于统计学方法的异常检测算法通常假设数据集服从某种分布,通过计算数据的离散程度或概率分布来确定异常值。

常见的算法包括Z-score、箱线图、基于均值和方差的方法等。

这些算法适用于数据呈正态分布或近似正态分布的情况,但对于非正态分布的数据效果可能不佳。

2. 基于聚类的异常检测算法聚类是将数据集划分为若干个组或簇的过程。

基于聚类的异常检测算法将异常数据视为与其他数据点距离较远的点。

例如,LOF(局部离群因子)算法通过计算数据点与周围点之间的距离来确定异常值。

这种算法对于异常数据所属的簇与其他簇之间的距离较大的情况敏感,但对数据集中的噪声点容易产生误判。

3. 基于分类的异常检测算法基于分类的异常检测算法通过构建分类模型来判断数据点的异常程度。

典型的算法有单类支持向量机(One-Class SVM)和孤立森林(Isolation Forest)。

单类支持向量机通过将数据映射到高维空间,通过寻找一个超平面最大化正常样本与其他样本之间的间隔来判断异常值。

孤立森林通过随机选取特征和切分点构建一个二叉树,根据异常点在树中路径的长度来判断异常值。

这些算法在处理高维数据和非线性数据时表现较好,但对于训练集中异常样本过少的情况可能不准确。

4. 基于距离的异常检测算法基于距离的异常检测算法通过计算数据点之间的距离来判断异常值。

综合评价中异常值的识别及无量纲化处理方法李伟伟;易平涛;李玲玉【摘要】针对综合评价中的异常值现象,讨论了原始数据中是否存在异常值、若存在异常值该如何识别异常值以及对含有异常值的评价数据如何进行无量纲化处理三个问题.关于异常值的判断与识别,给出了以"中位数"为参考点,通过比较排序后两端数据偏离中位数的距离的处理思路.对含有异常值的评价数据的无量纲化处理问题,基于常用的"极值处理法",通过分别指定异常值和非异常值无量纲化取值区间的方式,提出了一种分段的无量纲化处理方法.最后,通过与已有文献异常值识别及无量纲化处理结果的对比分析,验证了本文方法的有效性,发现本文给出的方法能够实现对异常值的适度筛选,且能够提升无量纲化数据分布均衡性.%In face of the outliers in comprehensive evaluation,this paper analyses three questions:are there outli-ers in original data if there are outliers,how to recognize them And how to design dimensionless method for all data included in outliers For the judgment and recognition of outliers,we tahe"median"as a reference.Based on this,the outliers can be identified by comparing the distance of the former endpoint to the median and that of the later endpoint to the median.To the dimensionless question,based on the frequently-used linear scale trans-formation(max-min)method, we provide a piecewise dimensionless method by allocating dimensionless value interval to outliers and non-outliers respectively.At last,the validity of this research is illustrated by the compar-ison with the results of available literature.And it is found the methods in this paper can not only recognizeoutliers moderately,but also promote the proportionality of dimensionless results.【期刊名称】《运筹与管理》【年(卷),期】2018(027)004【总页数】6页(P173-178)【关键词】综合评价;无量纲化处理;异常值;极值处理法;分段无量纲化方法【作者】李伟伟;易平涛;李玲玉【作者单位】东北大学工商管理学院,辽宁沈阳110167;东北大学工商管理学院,辽宁沈阳110167;南昌大学经济管理学院,江西南昌330031【正文语种】中文【中图分类】C9340 引言多指标综合评价是经济、管理及统计等多学科领域的一项交叉研究内容,是综合多个指标信息对被评价对象所进行的客观、公正、合理的全面评价[1]。

评定测试结果不确定度的两种方法之比较分析文/班琦刘志腾朱梦阳[摘要] 检测实验室中测试结果的不确定度是对测试结果可靠性的度量,本文以铁矿石中铁含量的检测为例,分别通过灵敏系数法和相对标准不确定度法进行测试结果的不确定度分析,并加以比较,以期为相关检测实验室提供参考。

[关键词] 灵敏系数法 相对标准不确定度法 测试结果的不确定度根据国际标准I S O/I E C 17025:2017检测和校准实验室能力认可准则以及国家标准G B/T 27025-2019 检测和校准实验室能力的通用要求,本文主要针对检测实验室在以化学法检测铁矿石中铁含量时,分别采用灵敏系数法和相对标准不确定度法对测试结果的不确定度进行分析。

一、试验原理本试验采用化学法测定铁矿石中铁的含量,将被测的铁矿石样品放置于盐酸溶液中分解、过滤后,把滤液作为主液保存。

过滤后的滤渣置于马弗炉内进行高温灼烧挥硅,并使用焦硫酸钾熔融后再用稀盐酸溶液浸取,用氨水沉淀铁后再使用加热过的盐酸热水将沉淀的铁洗入主液中。

加入氯化亚锡目的是使三价铁还原成二价铁,然后用氯化高汞氧化过量的氯化亚锡,最后加入配置好的重铬酸钾标准溶液滴定铁,根据加入的重铬酸钾标准溶液的体积以及被测铁矿石的质量得到铁矿石中铁含量。

二、分析不确定度来源及建立测试模型1.分析不确定度来源实验室检测人员应该熟悉业务知识,熟练掌握专业技术,深入研究可能会影响到测试结果的因素,具体问题具体分析,根据实际测试情况分析对测试结果有明显影响的不确定度来源。

本文所采用的化学法测定铁含量过程中,A类不确定度产生在测定方法的选择、测试设备的准确度等级、操作过程是否符合要求、温度的改变对测试的影响、铁矿石样品的均匀性、称量是否准确以及其他一些随机性因素的影响。

B类不确定度发生在重铬酸钾标准溶液的滴定度、天平称量以及滴定管等测试仪器方面。

2.建立测试模型测试模型是指在测试过程中涉及的所有已知量间的数学关系。

测试铁矿石中铁的含量的数学模型为:W(Fe)= 。

对异常值的判别和剔除方法

异常值的判别和剔除是数据处理中的重要步骤,以下是一些常用的方法:

1. 箱线图检测:箱线图是一种常用的异常值检测方法,它以数据的分位数为基础,通过上下四分位距来判断数据是否异常。

根据箱线图,可以判断出数据中的异常值,并将其剔除。

2. 3σ原则:3σ原则是一种基于数据的均值和标准差的统计方法,用于判断数据是否异常。

在正态分布下,大约68%的数据位于均值的±1σ范围内,95%的数据位于均值的±2σ范围内,%的数据位于均值的±3σ范围内。

因此,可以基于3σ原则来剔除异常值。

3. 物理判别法:根据人们对客观事物已有的认识,判别由于外界干扰、人为误差等原因造成实测数据值偏离正常结果,在实验过程中随时判断,随时剔除。

4. 统计判别法:给定一个置信概率,并确定一个置信限,凡超过此限的误差,就认为它不属于随机误差范围,将其视为异常值剔除。

在实际应用中,可以根据数据类型、分布情况和需求选择合适的方法。

同时,也要注意不同方法的适用范围和局限性。

第1篇一、引言随着市场经济的发展,企业面临着日益激烈的市场竞争。

财务报表是企业经营状况的重要反映,通过对财务报表的分析,可以了解企业的财务状况、经营成果和现金流量。

然而,在实际的财务报表分析过程中,可能会出现一些异常值,这些异常值可能会对企业经营决策产生重大影响。

本报告旨在通过对财务报表异常值的分析,揭示企业潜在的风险和问题,为企业决策提供参考。

二、异常值分析的方法1. 统计分析法:通过计算财务数据的均值、标准差等统计指标,识别出显著偏离整体数据的异常值。

2. 比较分析法:将企业财务数据与同行业平均水平、历史数据进行比较,发现异常波动。

3. 因素分析法:分析导致异常值产生的原因,包括外部环境、内部管理等方面。

4. 案例分析法:通过对特定案例的分析,总结异常值产生的原因及应对措施。

三、异常值分析案例1. 案例背景某公司是一家从事电子产品研发、生产和销售的企业,近年来,公司业绩持续增长,但2019年财务报表显示,公司存货周转率明显低于行业平均水平,同时应收账款周转率也出现异常波动。

2. 异常值分析(1)统计分析法通过计算2019年存货周转率和应收账款周转率的均值、标准差,发现存货周转率低于行业平均水平,且标准差较大,存在显著异常;应收账款周转率也低于行业平均水平,且波动较大。

(2)比较分析法将2019年存货周转率和应收账款周转率与同行业平均水平及公司历史数据进行比较,发现存货周转率低于历史平均水平,应收账款周转率低于行业平均水平,存在明显异常。

(3)因素分析法分析导致存货周转率和应收账款周转率异常的原因:a. 外部环境:市场竞争加剧,公司产品滞销,导致存货积压。

b. 内部管理:公司销售部门管理不善,应收账款回收不力。

(4)案例分析通过对案例的分析,发现公司存货积压和应收账款回收不力是导致财务异常的主要原因。

为解决这一问题,公司采取了以下措施:a. 加强销售部门管理,提高销售团队执行力。

b. 优化库存管理,降低存货积压。

样本数据中异常值(Outliers)检测⽅法及SPSSR实现⼀、概述异常值检验,⼜称为离群点分析或者孤⽴点挖掘。

在⼈们对数据进⾏分析处理的过程中,经常会遇到少量这样的数据,它们与数据⼀般模式不⼀致,或者说与⼤多数样相⽐有些不⼀样,我们称这样的数据为异常数据。

异常数据挖掘涉及两个基本问题。

其⼀,在对⼀个给定的数据集分析之前必须事先约定满⾜什么样的数据才是异常数据,也就是异常数据定义的问题。

其⼆,⽤什么⽅法来从给定的数据集中将异常数据提取出来。

⼆、异常数据的定义关于异常值的问题,最早可以追溯到 18 世纪中叶,当时很多学者就开始关注异常值的问题了。

1755 年,Boscovich 在确定地球椭圆率的时候,在所得到的10 个观测值中丢弃了其中的两个极端值,然后再计算剩下的 8 个观测值的平均值。

⽽最早有关异常值的定义,是 Bernoulli 于1777 年⾸先提出的,之后它的定义在⼀直变化,Hawkins 认为异常值是那些数据集中与众不同的数据,让⼈怀疑这些数据并⾮由于随机偏差产⽣的,⽽是产⽣于完全不同的机制,这在⼀定意义上揭⽰了异常值的本质;⽽ Weisberg 将异常值定义为那些与数据集中其余部分不服从相同统计模型的数据,这个定义更符合统计检验的异常数据描述;Samuels将异常值定义为“⾜够地不同于数据集中其余部分的数据”;Grubbs 将异常值定异常数据是少量的、与众不同的,与⼤多数数据相⽐是有偏差的,⽽且产⽣这种偏差的原因不是随机的,⽽是有其更深层次的必然原因,它产⽣于完全不同的机制。

张德然在吸收归纳前⼈的研究基础上,将异常值从内涵上分为⼴义异常值和狭义异常值。

⼴义异常值是指:所获统计数据与真实数据相对误差较⼤的数据,统指⼀切失真数据;狭义异常值是指:所获统计数据中部分数据与其余主体数据相⽐明显不⼀致的数据,也称离群值。

为了从数据集中识别异常数据,就必须有⼀个明确的标准。

这需要找到数据的内在规律,在⼀个可接受的误差范围内,满⾜内在规律的数据就是正常数据,⽽不满⾜内在规律的数据就是异常数据。

统计分析中的数据预处理和异常值检测在进行统计分析的过程中,数据预处理和异常值检测是非常重要的环节。

数据预处理是指在对数据进行统计分析之前,对数据进行一定的处理和调整,以保证数据的有效性和可靠性。

而异常值检测则是指在统计分析中,通过观察数据的分布情况和规律性,及时检测出异常值,避免其对结果产生干扰。

数据预处理数据预处理主要包括数据清洗、数据缺失值处理、数据离散化和数据标准化等方面。

1. 数据清洗在进行统计分析的过程中,由于数据可能涉及多个来源和多个角度,可能会出现重复、缺失、错误或无法识别的情况,因此需要对数据进行清洗。

数据清洗的主要目的是保证数据的准确性和可信度。

2. 数据缺失值处理数据缺失是指在数据收集和整理的过程中,因为某种原因部分数据缺失,需要对缺失值进行处理。

数据缺失值处理的方法主要包括删除、插值和离散化。

3. 数据离散化数据离散化是指将数据按照某个标准进行分类,将数据分为若干个离散的类别,以便于后续的统计分析。

数据离散化的方法主要包括等距离散化、等频离散化和基于聚类的离散化等。

4. 数据标准化数据标准化是指将数据转换为具有固定均值和方差的标准分布,在统计分析中,标准化后的数据更方便进行比较和分析。

数据标准化的方法主要包括Z-score标准化、最大-最小标准化和百分位数标准化等。

异常值检测异常值是指在数据集中,与其他数据相比较为明显不同的数据点。

异常值常常由数据测量或记录的错误、数据缺失或异常事件等导致。

异常值若不被及时发现和处理,可能会对统计分析结果产生重大影响。

1. 基本的统计方法通过基本的统计方法,如均值、方差、标准偏差和四分位数等,可以确定正常数据的范围和规律性,从而判断哪些数据是异常值。

对于正态分布数据可以采用正态分布的偏差判断,即3倍标准差的判断方法。

2. 箱线图箱线图也叫箱型图,是一种常用的图像方法,可以直观的发现异常点。

箱线图由最小值、最大值、第一、二和三四分位数构成,中间一条线代表中位数。