第十一章线性相关分析报告与线性回归分析报告

- 格式:doc

- 大小:959.50 KB

- 文档页数:19

相关关系从单变量从发,在一个样本数据中想知道某一指标在样本中的离散程度用方差(样本偏离均值的平均距离的平方数,也叫总变差)或者标准差(样本偏离均值的平均距离)表示。

两个变量的时候,这两个变量在样本中的离散程度用协方差(类比于方差)表示。

协方差表示的是总变差,描述的是两个变量的总体误差(总体误差的期望)。

协方差:协方差:cov(X,Y)=E[(X−E[X])(Y−E[Y])]数据点的协方差:2数据点的协方差:(x1−ux)(y1−uy)+(x2−ux)(y2−uy)2如果两个变量的变化趋势一致,也就是说如果其中一个大于自身的期望值时另外一个也大于自身的期望值,那么两个变量之间的协方差就是正值(用上图公式表示的是每一个点与均值的误差值都是正数);如果两个变量的变化趋势相反,即其中一个变量大于自身的期望值时另外一个却小于自身的期望值,那么两个变量之间的协方差就是负值(用上图公式表示的是每一个点与均值的误差值都是负数)。

协方差为正值,表示两个变量正相关;协方差为负值,表示两个变量负相关;协方差为0则表示不相关(每一个点与均值的误差值有正有负)。

相关系数协方差的数值可以衡量两个变量的关系,在同一物理量纲之下有一定的作用,但同样的两个量采用不同的量纲使它们的协方差在数值上表现出很大的差异。

(举个向量的栗子,两个向量的夹角大小表示相关关系,但是两向量的长度不影响夹角的大小,协方差的计算类似于计算向量的距离,向量的距离也可以表示向量之间的关系,但是会受到向量长度的影响)。

因此,相关关系需要去掉量纲的影响,使用协方差同时除以X 和Y的标准差,这就是相关系数(皮尔逊相关系数)相关系数:相关系数r:cov(X,Y)σxσy相关系数r的取值范围是[-1,1],正值表示正相关,负值表示负相关。

当相关系r>0.6时,可以认为两个变量之前强相关,0.3<=r<=0.6时,可以认为是中等相关,当r<0.3时认为弱相关,r=0时表示不相关。

,,,本科学生实验报告学号:########## 姓名:¥¥¥¥¥¥学院:生命科学学院专业、班级:11级应用生物教育A班实验课程名称:生物统计学实验教师:孟丽华(教授)开课学期:2012 至2013 学年下学期填报时间:2013 年 5 月22 日云南师范大学教务处编印线回归方程进行预测或控制,一般只能内插,不要轻易外延;2、直线回归相关分析的注意事项:1)、相关分析只是以相关系数来描述两个变量间线性相关的程度和方向,并不阐明事物间存在联系的本质,也不是两事物间存在联系的证据。

要阐明两事物间的本质联系,必须凭专业知识从理论上加以论证。

因此,把两个毫无关系的事物放在一起作相关分析是毫无意义的。

同样,作回归分析也要有实际意义;2)、在进行直线回归前应绘制散点图,有直线趋势时,才适宜作直线回归分析。

散点图还能提示资料有无异常点;3)、直线回归方程的适用范围一般以自变量的取值范围为限;4)、对同一组资料作回归和相关分析,其相关系数和回归系数的显著性检验结果完全相同。

由于相关系数的显著性检验结果可直接查表,比较方便;而回归系数的显著性检验计算复杂,故在实际应用中常用相关系数的显著性检验结果代替回归系数的显著性检验。

5)、在资料要求:相关分析要求两个变量服从双变量正态分布。

回归分析要求因变量服从正态分布,自变量可以是精确测量和严格控制的变量。

如两个变量服从双变量正态分布,则可以作两个回归方程,用X推算Y,或用Y推算X;3、相关分析中,不区分自变量和因变量。

相关分析只研究两个变量之间线性相关的程度或一个变量与多个变量之间线性相关的程度,不能用一个或多个变量去预测另一个变量的值,这是回归分析与相关分析的主要区别;4、通过此次实验,更加熟悉了SPSS软件的应用,学习了线性回归与相关性分析,考察两变量之间线性关系,建立回归方程,并对回归系数作假设检验;计算。

线性回归分析实验报告线性回归分析实验报告引言线性回归分析是一种常用的统计方法,用于研究因变量与一个或多个自变量之间的关系。

本实验旨在通过线性回归分析方法,探究自变量与因变量之间的线性关系,并通过实验数据进行验证。

实验设计本实验采用了一组实验数据,其中自变量为X,因变量为Y。

通过对这组数据进行线性回归分析,我们将得到回归方程,从而可以预测因变量Y在给定自变量X的情况下的取值。

数据收集与处理首先,我们收集了一组与自变量X和因变量Y相关的数据。

这些数据可以是实际观测得到的,也可以是通过实验或调查获得的。

然后,我们对这组数据进行了处理,包括数据清洗、异常值处理等,以确保数据的准确性和可靠性。

线性回归模型在进行线性回归分析之前,我们需要确定一个线性回归模型。

线性回归模型的一般形式为Y = β0 + β1X + ε,其中Y是因变量,X是自变量,β0和β1是回归系数,ε是误差项。

回归系数β0和β1可以通过最小二乘法进行估计,最小化实际观测值与模型预测值之间的误差平方和。

模型拟合与评估通过最小二乘法估计回归系数后,我们将得到一个拟合的线性回归模型。

为了评估模型的拟合程度,我们可以计算回归方程的决定系数R²。

决定系数反映了自变量对因变量的解释程度,取值范围为0到1,越接近1表示模型的拟合程度越好。

实验结果与讨论根据我们的实验数据,进行线性回归分析后得到的回归方程为Y = 2.5 + 0.8X。

通过计算决定系数R²,我们得到了0.85的值,说明该模型能够解释因变量85%的变异程度。

这表明自变量X对因变量Y的影响较大,且呈现出较强的线性关系。

进一步分析除了计算决定系数R²之外,我们还可以对回归模型进行其他分析,例如残差分析、假设检验等。

残差分析可以用来检验模型的假设是否成立,以及检测是否存在模型中未考虑的其他因素。

假设检验可以用来验证回归系数是否显著不为零,从而判断自变量对因变量的影响是否存在。

线性回归分析实验报告实验报告:线性回归分析一、引言线性回归是一种基本的统计分析方法,用于研究自变量与因变量之间的线性关系。

此实验旨在通过一个实际案例对线性回归进行分析,并解释如何使用该方法进行预测和解释。

二、实验方法1.数据收集:从电商网站收集了一份销售量与广告费用的数据集,其中包括了十个月的数据。

该数据集包括两个变量:广告费用(自变量)和销售量(因变量)。

2.数据处理:首先对数据进行清洗,包括处理缺失值和异常值等。

然后进行数据转换,对广告费用进行对数转换,以适应线性回归的假设。

3.构建模型:使用线性回归模型,将广告费用作为自变量,销售量作为因变量,构建一个简单的线性回归模型。

模型的公式为:销售量=β0+β1*广告费用+ε,其中β0和β1是回归系数,ε是误差项。

4.模型评估:通过计算回归系数的置信区间和检验假设以评估模型的拟合程度和相关性。

此外,还使用残差分析来检验模型的合理性和独立性。

5.模型预测:根据模型的回归系数和新的广告费用数据,预测销售量。

三、实验结果1.数据描述:首先对数据进行描述性统计。

数据集的平均广告费用为1000元,标准差为200元。

平均销售量为1000件,标准差为150件。

广告费用和销售量之间的相关系数为0.8,说明两者存在一定的正相关关系。

2. 模型拟合:通过拟合线性回归模型,得到回归系数的估计值。

估计值的标准误差很小,R-square值为0.64,说明模型可以解释63%的销售量变异。

3.置信区间和假设检验:通过计算回归系数的置信区间,发现β1的置信区间不包含零,说明广告费用对销售量有显著影响。

假设检验结果也支持这一结论。

4.残差分析:通过残差分析,发现残差的分布基本符合正态性假设,没有明显的模式或趋势。

这表明模型的合理性和独立性。

四、结论与讨论通过线性回归分析,我们得出以下结论:1.广告费用对销售量有显著影响,且为正相关关系。

随着广告费用的增加,销售量也呈现增加的趋势。

2.线性回归模型可以解释63%的销售量变异,说明模型的拟合程度较好。

实验一:线性回归分析实验目的:通过本次试验掌握回归分析的基本思想和基本方法,理解最小二乘法的计算步骤,理解模型的设定T检验,并能够根据检验结果对模型的合理性进行判断,进而改进模型。

理解残差分析的意义和重要性,会对模型的回归残差进行正态型和独立性检验,从而能够判断模型是否符合回归分析的基本假设。

实验内容:用线性回归分析建立以高血压作为被解释变量,其他变量作为解释变量的线性回归模型。

分析高血压与其他变量之间的关系。

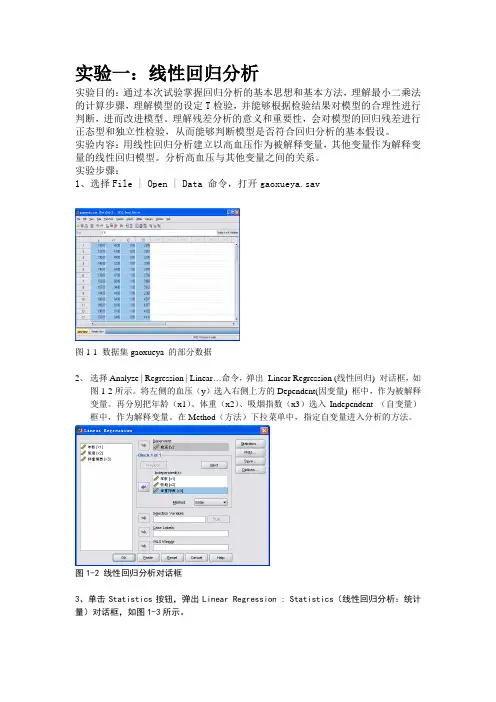

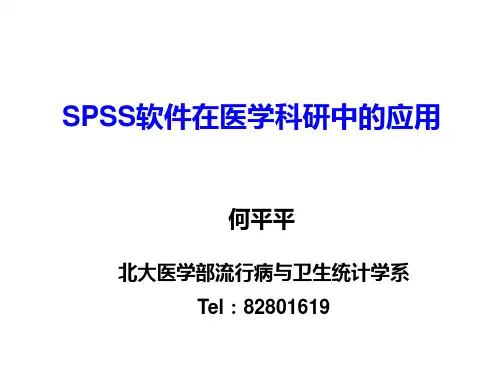

实验步骤:1、选择File | Open | Data 命令,打开gaoxueya.sav图1-1 数据集gaoxueya 的部分数据2、选择Analyze | Regression | Linear…命令,弹出Linear Regression (线性回归) 对话框,如图1-2所示。

将左侧的血压(y)选入右侧上方的Dependent(因变量) 框中,作为被解释变量。

再分别把年龄(x1)、体重(x2)、吸烟指数(x3)选入Independent (自变量)框中,作为解释变量。

在Method(方法)下拉菜单中,指定自变量进入分析的方法。

图1-2 线性回归分析对话框3、单击Statistics按钮,弹出Linear Regression : Statistics(线性回归分析:统计量)对话框,如图1-3所示。

1-3线性回归分析统计量对话框4、单击 Continue 回到线性回归分析对话框。

单击Plots ,打开Linear Regression:Plots (线性回归分析:图形)对话框,如图1-4所示。

完成如下操作。

图1-4 线性回归分析:图形对话框5、单击Continue ,回到线性回归分析对话框,单击Save按钮,打开Linear Regression;Save 对话框,如图1-5所示。

完成如图操作。

图1-5 线性回归分析:保存对话框6、单击Continue ,回到线性回归分析对话框,单击Options 按钮,打开Linear Regression ;Options 对话框,如图1-6所示。

报告中的相关性分析与回归模型相关性分析和回归模型是统计学中常用的分析方法,在报告中它们经常被应用于数据的解读和预测。

本文将从六个方面展开对相关性分析和回归模型的详细论述。

一、相关性分析相关性分析是用来研究两个或多个变量之间的相关关系,它主要通过计算相关系数来度量变量之间的相关性强度。

相关系数的范围在-1到1之间,0表示两个变量之间无关,正数表示正相关,负数表示负相关。

我们可以通过相关性分析来探索变量之间的线性关系,并根据相关系数的大小来判断关系强度。

二、简单线性回归模型简单线性回归模型用于研究两个变量之间的线性关系。

通过拟合一条直线来描述自变量和因变量之间的关系,并通过回归方程来表示。

回归方程中的斜率表示两个变量之间的变化程度,截距表示当自变量为0时,因变量的取值。

我们可以使用简单线性回归模型来预测因变量的取值,并评估模型的拟合程度。

三、多元回归模型多元回归模型是在简单线性回归模型的基础上进行拓展的。

它可以研究多个自变量对因变量的影响,并通过回归方程进行建模。

多元回归模型可以更全面地理解各个变量对因变量的影响,并控制其他变量的影响。

在报告中,我们可以使用多元回归模型来解释变量之间的关系,并进行因果推断。

四、回归模型的评估回归模型的拟合程度可以使用各种指标来评估,如决定系数R-squared、均方差等。

决定系数表示模型能解释因变量变异的比例,越接近1表示模型拟合得越好。

均方差衡量预测值与实际值的离散程度,值越小表示预测得越准确。

在报告中,我们可以使用这些评估指标来判断回归模型的拟合程度和预测准确度。

五、多重共线性的检验多重共线性是指在多元回归模型中,自变量之间存在高度相关关系的情况。

多重共线性会导致回归模型估计量不准确,难以进行因果推断。

我们可以使用方差扩大因子来检验自变量之间的共线性程度,方差扩大因子越大表示共线性越严重。

在报告中,我们可以通过多重共线性的检验来评估回归模型的可靠性。

六、回归模型的应用回归模型在实际应用中有广泛的应用领域。

第1篇一、引言线性回归分析是统计学中一种常用的数据分析方法,主要用于研究两个或多个变量之间的线性关系。

本文以某城市房价数据为例,通过线性回归模型对房价的影响因素进行分析,以期为房地产市场的决策提供数据支持。

二、数据来源与处理1. 数据来源本文所采用的数据来源于某城市房地产交易中心,包括该城市2010年至2020年的房价、建筑面积、交通便利度、配套设施、环境质量等指标。

2. 数据处理(1)数据清洗:对原始数据进行清洗,去除缺失值、异常值等。

(2)数据转换:对部分指标进行转换,如交通便利度、配套设施、环境质量等指标采用五分制评分。

(3)变量选择:根据研究目的,选取建筑面积、交通便利度、配套设施、环境质量等指标作为自变量,房价作为因变量。

三、线性回归模型构建1. 模型假设(1)因变量与自变量之间存在线性关系;(2)自变量之间不存在多重共线性;(3)误差项服从正态分布。

2. 模型建立(1)选择合适的线性回归模型:根据研究目的和数据特点,采用多元线性回归模型。

(2)计算回归系数:使用最小二乘法计算回归系数。

(3)检验模型:对模型进行显著性检验、方差分析等。

四、结果分析1. 模型检验(1)显著性检验:F检验结果为0.000,P值小于0.05,说明模型整体显著。

(2)回归系数检验:t检验结果显示,所有自变量的回归系数均显著,符合模型假设。

2. 模型结果(1)回归系数:建筑面积、交通便利度、配套设施、环境质量的回归系数分别为0.345、0.456、0.678、0.523,说明这些因素对房价有显著的正向影响。

(2)R²:模型的R²为0.876,说明模型可以解释约87.6%的房价变异。

3. 影响因素分析(1)建筑面积:建筑面积对房价的影响最大,说明在房价构成中,建筑面积所占的比重较大。

(2)交通便利度:交通便利度对房价的影响较大,说明在购房时,消费者对交通便利性的需求较高。

(3)配套设施:配套设施对房价的影响较大,说明在购房时,消费者对生活配套设施的需求较高。

相关与回归分析实验报告一、实验目的:学会根据一组数据,来分析其相关性,根据其相关性的分析,再进行回归分析。

学会运用EXCEL中的数据分析软件,并对数据进行回归分析。

得出一元线性回归方程,并对其检验评价。

二、实验环境实验地点:实训楼计算机实验中心五楼实验室3试验时间:第十二周周二实验软件:Microsoft Excel 2003三、实验原理:变量之间的相关关系需要用相关分析法来进行识别和判断。

相关分析,就是借助于图形或若干分析指标对变量之间的依存关系的密切程度进行测定的过程。

相关关系通常通过散点图、相关系数进行识别。

一元线性回归(linear regression)是描述两个变量之间相互联系的最简单的回归模型(regression model).通过一元线性回归模型的建立过程,我们可以了解回归分析方法的基本统计思想以及它在经济问题研究中的应用原理。

四、实验内容1 相关分析:(选择的变量是什么?然后开始进行相关分析)以绝对数(元)为自变量x,指数 (1978=100)为因变量y。

图1.1 (1)散点图图1.2图1.3(2)相关系数的计算在标题栏里找到:工具→数据分析→相关系数→导入数据→输出结果由图表可知相关系数r=0.9893,由散点图的分布以及相关系数的结果可推测,x 与y相关系数很高,且成一元线性回归,故继续对以上两个变量进行回归分析所以相关系数R=0.9893,为高度正线性相关。

2 回归分析:现对变量进行回归分析,工具→数据分析→回归,即可得到下图图1.4图1.5点击确定,即可得到以下结果。

图1.6(继续对上面两个变量进行回归分析)(1)三个表格输出:可以输出几个重要的量:R square,Syx,F,2个系数coefficientsR square=0.9893S yx =δ^=2^^102---∑∑∑n xy y y ββ=461.3088F=1853.55(2)回归方程:回归方程为y ^^=β0+β1X,β1=∑∑∑∑∑--2)(2xi xi n yi xi xiyi n =0.045β0 =y -β1x =114.7285091所以回归方程y=114.7285091+0.045x(3)方程的评价:在数据中,F=1853.55,sig F<0.0001说明回归方程整体显著性差,b 的t 统计量t= 21.66,回归方程比较合理。

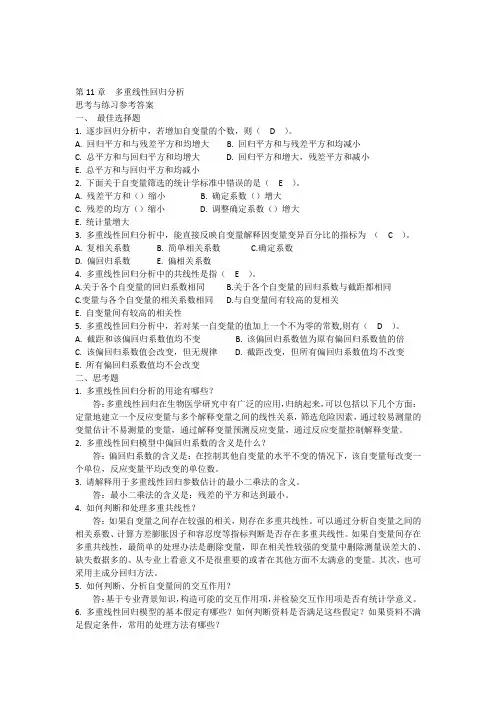

一章1. 解:回归分析是确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,运用十分广泛。

回归分析按照涉及的变量的多少,分为一元回归和多元回归分析;在线性回归中,按照因变量的多少,可分为简单回归分析和多重回归分析;按照自变量和因变量之间的关系类型,可分为线性回归分析和非线性回归分析。

如果在回归分析中,只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。

如果回归分析中包括两个或两个以上的自变量,且自变量之间存在线性相关,则称为多元线性回归分析。

相关分析,相关分析是研究现象之间是否存在某种依存关系,并对具体有依存关系的现象探讨其相关方向以及相关程度,是研究随机变量之间的相关关系的一种统计方法。

相关分析和回归分析是研究客观现象之间数量联系的重要统计方法。

既可以从描述统计的角度,也可以从推断统计的角度来说明。

所谓相关分析,就是用一个指标来表明现象间相互依存关系的密切程度。

所谓回归分析,就是根据相关关系的具体形态,选择一个合适的数学模型,来近似地表达变量间的平均变化关系。

它们具有共同的研究对象,在具体应用时,相关分析需要依靠回归分析来表明现象数量相关的具体形式,而回归分析则需要依靠相关分析来表明现象数量变化的相关程度。

只有当变量之间存在着高度相关时,进行回归分析寻求其相关的具体形式才有意义。

由于相关分析不能指出变量间相互关系的具体形式,所以回归分析要对具有相关关系的变量之间的数量联系进行测定,从而为估算和预测提供了一个重要的方法。

在有关管理问题的定量分析中,推断统计加具有更加广泛的应用价值。

需要指出的是,相关分析和回归分析只是定量分析的手段。

通过相关与回归分析,虽然可以从数量上反映现象之间的联系形式及其密切程度,但是现象内在联系的判断和因果关系的确定,必须以有关学科的理论为指导,结合专业知识和实际经验进行分析研究,才能正确解决。

因此,在应用时要把定性分析和定量分析结合起来,在定性分析的基础上开展定量分析。

线性回归分析实验报告实验报告:线性回归分析一、引言线性回归是一种常用的统计分析方法,用于建立自变量与因变量之间的线性关系模型。

它可以通过对已知数据的分析,预测未知数据的数值。

本实验旨在通过应用线性回归分析方法,探究自变量和因变量之间的线性关系,并使用该模型进行预测。

二、实验方法1. 数据收集:收集相关的自变量和因变量的数据,确保数据的准确性和完整性。

2. 数据处理:对收集到的数据进行清洗和整理,确保数据的可用性。

3. 模型建立:选择合适的线性回归模型,建立自变量和因变量之间的线性关系模型。

4. 模型训练:将数据集分为训练集和测试集,使用训练集对模型进行训练。

5. 模型评估:使用测试集对训练好的模型进行评估,计算模型的拟合度和预测准确度。

6. 预测分析:使用训练好的模型对未知数据进行预测,分析预测结果的可靠性和合理性。

三、实验结果1. 数据收集和处理:我们收集了100个样本数据,包括自变量X和因变量Y。

通过数据清洗和整理,我们得到了可用的数据集。

2. 模型建立:我们选择了简单线性回归模型,即Y = aX + b,其中a为斜率,b为截距。

3. 模型训练和评估:我们将数据集分为训练集(80个样本)和测试集(20个样本),使用训练集对模型进行训练,并使用测试集评估模型的拟合度和预测准确度。

4. 预测分析:使用训练好的模型对未知数据进行预测,分析预测结果的可靠性和合理性。

四、实验讨论1. 模型拟合度:通过计算模型的拟合度(如R方值),可以评估模型对训练数据的拟合程度。

拟合度越高,说明模型对数据的解释能力越强。

2. 预测准确度:通过计算模型对测试数据的预测准确度,可以评估模型的预测能力。

预测准确度越高,说明模型对未知数据的预测能力越强。

3. 模型可靠性:通过对多个不同样本集进行训练和评估,可以评估模型的可靠性。

如果模型在不同样本集上的表现一致,说明模型具有较高的可靠性。

五、实验结论通过本实验,我们建立了一种简单线性回归模型,成功实现了对自变量和因变量之间的线性关系进行分析和预测。

,,,本科学生实验报告学号: ########## 姓名:¥学院:生命科学学院专业、班级:11级应用生物教育A班实验课程名称:生物统计学实验教师:孟丽华(教授)开课学期: 2021 至 2021 学年下学期填报时间: 2021 年 5 月 22 日云南师范大学教务处编印→“线性(L)…”,将“5月上旬50株棉蚜虫数(Y)”移到因变量列表(D)中,将“4月下旬平均气温(X)”移入自变量列表(I)中进行分析;1)、点“统计量(S)”,回归系数:在“估计(E)”、“置信区间水平(%)95”前打钩,“模型拟合性(M)”、“描述性”前打钩,残差:个案诊断(C)前打钩,点“所有个案”,点“继续”;2)、点“绘制(T)…”,将“DEPENDNP”移入“Y(Y)”列表中,将“ZPRED”移入“X2(X)”中,标准化残差图:在“直方图(H)”、“正太概率图(R)”前打钩,点“继续”;3)、点“保存(S)…”,所有的默认,点“继续”;4)、点“选项(O)…”,所有的都默认,点“继续”,然后点击“确定”便出结果;统计量(S)…选项(O)…(默认)绘制(T)…保存(S)…(默认)(二)、习题1、启动spss软件:开始→所有程序→SPSS→spss for windows→spss for windows,直接进入SPSS数据编辑窗口进行相关操作;2、定义变量,输入数据。

点击“变量视图”定义变量工作表,用“name”命令定义变量“维生素C的含量”(小数点两位);变量“受冻情况”(小数点零位),“未受冻”赋值为“1”,“受冻”赋值为“2” ,点击“变量视图工作表”,一一对应将不同“未受冻”与“受冻”的维生素C的含量数据依次输入到单元格中;3、设置分析变量。

数据输入完后,点菜单栏:“分析(A)”→“相关(C)”→“双变量(B)…”,将“维生素C含量”、“受冻情况”变量(V)列表中,相关系数:“Pearson”前打钩,显著性检验:双侧检验(T)前打钩,“标记显著性相关(F)前打钩”,点“选项(O)…”,统计量:在“均值和标准差(M)”前打钩,缺失值:在“按对排除个案(P)”前打钩,点“继续”,然后点击“确定”便出结果。

第十一章线性相关分析与线性回归分析11.1 两个变量之间的线性相关分析相关分析是在分析两个变量之间关系的密切程度时常用的统计分析方法。

最简单的相关分析是线性相关分析,即两个变量之间是一种直线相关的关系。

相关分析的方法有很多,根据变量的测量层次不同,可以选择不同的相关分析方法。

总的来说,变量之间的线性相关关系分为三种。

一是正相关,即两个变量的变化方向一致。

二是负相关,即两个变量的变化方向相反。

三是无相关,即两个变量的变化趋势没有明显的依存关系。

两个变量之间的相关程度一般用相关系数r 来表示。

r 的取值范围是:-1≤r≤1。

∣r∣越接近1,说明两个变量之间的相关性越强。

∣r∣越接近0,说明两个变量之间的相关性越弱。

相关分析可以通过下述过程来实现:11.1.1 两个变量之间的线性相关分析过程1.打开双变量相关分析对话框执行下述操作:Analyze→Correlate(相关)→Bivariate(双变量)打开双变量相关分析对话框,如图11-1 所示。

图11-1 双变量相关分析对话框2.选择进行相关分析的变量从左侧的源变量窗口中选择两个要进行相关分析的变量进入Variable 窗口。

3.选择相关系数。

Correlation Coefficient 是相关系数的选项栏。

栏中提供了三个相关系数的选项:(1)Pearson:皮尔逊相关,即积差相关系数。

适用于两个变量都为定距以上变量,且两个变量都服从正态分布的情况。

这是系统默认的选项。

(2)Kendall:肯德尔相关系数。

它表示的是等级相关,适用于两个变量都为定序变量的情况。

(3)Spearman:斯皮尔曼等级相关。

它表示的也是等级相关,也适用于两个变量都为定序变量的情况。

4.确定显著性检验的类型。

Test of Significance 是显著性检验类型的选项栏,栏中包括两个选项:(1)Two-tailed:双尾检验。

这是系统默认的选项。

(2)One-tailed:单尾检验。

5.确定是否输出相关系数的显著性水平Flag significant Correlations:是标出相关系数的显著性选项。

如果选中此项,系统在输出结果时,在相关系数的右上方使用“*”表示显著性水平为0.05;用“**”表示显著性水平为0.01。

6. 选择输出的统计量单击Options 打开对话框,如图11-2 所示。

图11-2 相关分析选项对话框(1)Statistics 是输出统计量的选项栏。

1)Means and standard deviations 是均值与标准差选项。

选择此项,系统将在输出文件中输出均值与标准差。

2)Cross- product deviations and covariances 是叉积离差与协方差选项。

选择此项,系统将在输出文件中输出每个变量的离差平方和与两个变量的协方差。

上述两项选择只有在主对话框中选择了Pearson:皮尔逊相关后,计算结果才有价值。

(2)缺失值的处理办法Missing Valuess 是处理缺失值的选项栏。

1)Exclude cases pairwise 是成对剔除参与相关系数计算的两个变量中有缺失值的个案。

2)Exclude cases listwise 是剔除带有缺失值的所有个案。

上述选项做完以后,单击Continue 按钮,返回双变量相关分析对话框。

8.单击OK 按钮,提交运行。

系统在输出文件窗口中输出相关分析的结果。

11.1.2 两个变量之间的线性相关分析实例分析实例:在“休闲调查1”中,对被调查者的“住房面积”和“家月收入”作相关分析打开数据文件“休闲调查1”后,执行下述操作:1.Analyze→Correlate→Bivariate 打开双变量相关分析对话框。

2.从左侧的源变量中选择“住房面积”和“家月收入”进入Variable 窗口。

其它选项采用系统默认状态。

3.单击Options 按钮,打开对话框。

选择Means and standard deviations 选项和Cross- product deviations and covariances 选项。

单击Continue 按钮,返回双变量相关分析对话框。

4.单击OK 按钮,提交运行。

可以在输出文件中看到相关分析的结果如表11-1、表11-2 所示表11-1 变量的描述统计表11-2相关分析表由于在选项中选择了Means and standard deviations选项。

所以在输出文件中出现了表11-1,表中的内容就是两个变量的平均值、标准差和个案数。

表11-2是以交叉表的形式表现的相关分析的结果。

下面将表的内容作如下解释:Pearson Correlation是皮尔逊相关系数。

在它右侧“住房使用面积”一列中对应的数据为1.000,这是“住房使用面积”与“住房使用面积”的相关系数。

由于使用同一个变量计算相关,数据完全一一对应,所以计算的相关系数为1。

在“家月收入”下面对应的数据为0.393,这是“住房使用面积”与“家月收入”的皮尔逊相关系数。

Sig. (2-tailed)是双端检验的显著性水平。

可以看出,相关系数0.393 的显著性水平为0.000,表明总体中两个变量的相关是显著的。

0.393 的“**”和表下面的英文说明Correlation is significant at the 0.05 level (2-tailed) (相关系数在0.01 的水平上显著)即说明了这一点。

Sum of Squares and Cross-products 是离差平方和与叉积和。

如果以“家月收入”为X 变量,“住房使用面积”为Y 变量的话,离差平方和是指()2∑-X X 或()2∑-Y Y 。

差积和是指Σ(x − x )(y − y )。

表11-2 中“家月收入”一列下面所对应的94462797 是“家月收入”变量的离差平方和。

而879447.51 则是差积和。

Covariance 是协方差。

表11-2 中“家月收入”一列下面所对应的3118.608 是“家月收入”的方差。

“住房使用面积”一列下面所对应的187.904 是“家月收入”变量与“住房使用面积”变量的协方差。

从输出的情况来看,“住房面积”和“家月收入”呈正相关,其相关系数为0.393,在总体中这个相关系数在0.01 的水平上是显著的。

11.2 线性回归分析回归分析是用确定性的方法来研究变量之间的非确定性关系的最重要的方法之一。

非确定性关系是指变量在变化过程中表现出来的数量上具有一定的依存性,但并非象函数关系那样一一对应的关系。

如果把其中的一个或几个变量作为自变量,把另一个随着自变量的变化而变化的变量作为因变量,通过建立线性关系的数学模型来研究它们之间的非确定性的关系的方法就是回归分析的方法。

由于回归分析中表现的是自变量和因变量之间的关系,所以这种方法也多用于研究因果关系的数量表现。

在SPSS 中的回归分析方法有七种,本节只介绍最简单、最常用的线性回归分析。

回归分析在Analyze 的下拉菜单中,如图11-3 所示。

图11-3 回归分析的指令菜单图中的主菜单中Regression 是回归,二级菜单中的Linear 是线性。

11.2.1 一元线性回归11.2.1.1 一元线性回归的原理1.一元线性回归方程一元线性回归也就是直线回归。

适用于对两个定距以上变量之间关系的分析。

是通过给一定数量的样本观测值拟合一条直线 bx a y+=ˆ,来研究变量之间关系的方法。

这条直线也叫回归直线或回归方程。

求回归方程的过程就是利用观测值求出方程中的回归直线中的a 、b 两个系数。

一般采用最小二乘法。

a 是回归直线的截距,b 是回归直线的斜率,也称为回归系数。

2.回归方程的假定条件有了回归直线,每一个样本观测值都可以表示为 y i = a + bx i +εi 。

(i=1,2…n )εi 称为随机误差项。

用回归方程来表示变量之间的关系需要满足一定的假定条件。

这些假定条件是:(1) 正态性假定。

即随机误差项εi 服从正态分布。

(2) 零均值假定。

εi 的均值为零,即E(εi )=0。

(3) 同方差假定。

εi 分布的方差相等。

(4) 独立性假定。

εi 是相互独立的随机变量。

(5) 无系列相关假定。

εi 的变化与x i 的变化无相关上述的假定条件中有一个不满足,回归方程都是没有价值的。

由于上述的假定都是对总体而言的,而总体的情况又属于未知。

因此在建立回归方程后应该用样本观测值对上述假定进行检验。

3.回归方程的显著性检验由于回归方程是用样本观测值建立的,用它来描述总体情况时,需要进行假设检验。

(1)回归系数的显著性检验1)对回归系数b 的检验:检验的原假设是b=0,检验的方法是T 检验。

2)对截距a 的检验:检验的原假设是a=0,检验的方法是T 检验。

(2)对回归直线拟合优度的检验采用最小二乘法可以给任何一组数据配合一条直线。

但只有两个变量之间的相关较强时,用回归直线来描述它们之间的关系才有意义。

回归直线拟合优度检验的指标是判定系数R 2。

R 2=r 2,即相关系数的平方。

它说明因变量的变化中有多少是由自变量的变化引起的。

如R 2=0.65,则说明,因变量的变化中的65%是由自变量的变化引起的。

R 2越接近1,说明拟合优度越好。

R 2=0,说明自变量与因变量没有任何关系,配合回归直线没有价值。

(3)对回归直线意义的检验对一组数据配合回归直线是否有意义,可以通过方差分析和F 检验的方法来确定。

把某一样本观测值到回归直线的距离的平方和定义为残差平方和。

它反映了除自变量以外的其它因素对因变量的影响。

把回归直线到总平均值之间的距离的平方和定义为回归平方和。

它反映了自变量对因变量的影响。

如果回归平方和很大而残差平方和很小,说明自变量对因变量的解释能力很大,则配合回归直线有意义。

反之则说明配合回归直线没有意义。

将两个平方和分别除以各自的自由度,就得到了平均回归平方和及平均残差平方和。

统计量F=平均回归平方和/平均残差平方和。

F 值过小,达不到显著性水平,说明自变量对因变量的解释力度很差,配合回归直线没有意义。

(4)残差的独立性检验残差的独立性检验也称系列相关检验。

如果随机误差项不独立,那么对回归模型的任何估计与假设所做出的结论都是不可靠的。

残差的独立性检验是通过Durbin-Watson 检验来完成的。

Durbin-Watson 检验的参数用D 表示。

D 的取值范围是0<D<4。

当残差与自变量相互独立时,D≈2。

当相邻两点的残差正相关时,D<2。

当相邻两点的残差负相关时,D>2。

其它如随机误差项的零均值,同方差,独立性的检验可根据残差散点图来进行。

将在后面的输出文件中介绍。

11.2.1.2 一元线性回归的分析过程1.打开回归分析对话框执行下述操作:Analyze→Regression→Linear 打开对话框,如图11-4所示。