10-Pyspark启动与日志设置

- 格式:pptx

- 大小:1.88 MB

- 文档页数:15

设置合适的日志级别和日志格式设置合适的日志级别和日志格式对于系统的监控和故障排查至关重要。

在软件开发和系统运维中,日志被广泛应用于记录系统运行状态、用户行为、错误信息等重要数据,为了更好地利用这些日志信息,开发人员需要设置合适的日志级别和日志格式。

首先,让我们来看一下日志级别。

日志级别用于指定日志的重要性和优先级,常见的日志级别包括TRACE、DEBUG、INFO、WARN、ERROR、FATAL等。

不同的日志级别适用于不同的场景,设置合适的日志级别可以帮助开发人员快速定位问题,减少不必要的日志输出。

在实际开发中,一般会设置默认的日志级别为INFO,这样可以保证系统正常运行时日志不会太过冗杂。

而在调试和故障排查时,可以临时调整日志级别为DEBUG或者更低级别,以获取更详细的日志信息,帮助定位问题。

除了设置默认的日志级别外,还可以根据不同的模块和功能设置不同的日志级别。

比如对于网络模块,可以设置更详细的日志级别,以便监控网络通信的细节;对于业务逻辑模块,可以设置更高的日志级别,只记录重要的业务信息和错误信息。

另外,对于一些特定的功能和场景,也可以通过代码来动态调整日志级别,比如在进行性能测试时,可以将日志级别调整为TRACE,以便记录更详细的性能信息。

除了日志级别,日志格式也是非常重要的一部分。

合适的日志格式可以使日志信息更易于阅读和分析,提高日志的可读性和可搜索性。

常见的日志格式包括文本格式、JSON格式、XML格式等,其中JSON格式在分布式系统中应用较为广泛。

JSON格式的日志可以很容易地被各种日志分析工具解析和处理,提供更丰富的数据结构和更灵活的查询方式。

在实际开发中,可以根据具体的需求,选择合适的日志格式。

比如对于分析和监控型的系统,可以选择JSON格式的日志,便于后续的数据分析和可视化;而对于一些传统的系统,可以选择文本格式的日志,以便人工查看和分析。

另外,在设置日志格式时,还可以加入一些额外的信息,比如线程ID、时间戳、日志级别等,以便更好地理解日志信息。

pyspark实验报告Pyspark实验报告引言:在当今的数据驱动时代,大数据分析和处理成为了各个行业的核心需求之一。

为了满足这一需求,Apache Spark应运而生。

作为一种快速、可扩展且易于使用的大数据处理引擎,Spark已经成为了业界的热门选择。

而Pyspark作为Spark的Python API,为Python开发者提供了一种便捷的方式来利用Spark的强大功能。

本实验报告将介绍Pyspark的基本概念、使用方法以及在实际项目中的应用。

一、Pyspark简介Pyspark是Spark的Python API,它允许开发者使用Python语言来编写Spark 应用程序。

相比于其他编程语言,Python具有简洁、易读的语法,使得Pyspark成为了数据科学家和机器学习工程师的首选工具。

同时,Pyspark提供了丰富的库和函数,使得数据处理和分析变得更加简单高效。

二、Pyspark的基本概念1. SparkContextSparkContext是Pyspark的入口点,它负责与Spark集群进行通信。

通过SparkContext,我们可以创建RDD(弹性分布式数据集)并对其进行操作。

在Pyspark中,可以使用以下代码创建一个SparkContext:```pythonfrom pyspark import SparkContextsc = SparkContext()```2. RDDRDD是Spark中最基本的数据结构,它代表了一个不可变、可分区、可并行计算的数据集合。

通过RDD,我们可以在分布式环境下对数据进行转换和操作。

在Pyspark中,可以使用以下代码创建一个RDD:```pythonrdd = sc.parallelize([1, 2, 3, 4, 5])```3. DataFrameDataFrame是一种具有结构化数据的分布式数据集合,它类似于关系型数据库中的表。

通过DataFrame,我们可以使用SQL语句进行数据查询和分析。

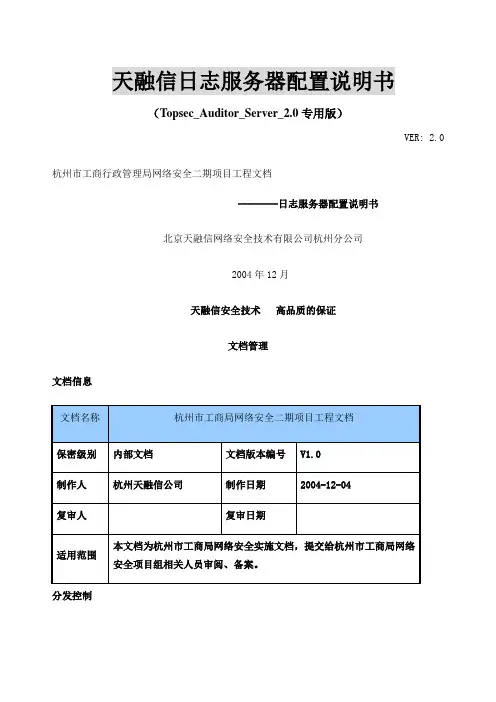

天融信日志服务器配置说明书Document number:NOCG-YUNOO-BUYTT-UU986-1986UT天融信日志服务器配置说明书(专用版)VER: 杭州市工商行政管理局网络安全二期项目工程文档--------日志服务器配置说明书北京天融信网络安全技术有限公司杭州分公司2004年12月天融信安全技术高品质的保证文档管理文档信息分发控制版本控制目录安装数据库服务器系统要求:操作系统:中英文windows 2000/2003 服务器版数据库系统:MS SQL Server 2000 + Service Pack 3 ( 不支持 MS SQL Server )最低配置:CPU :PIII 内存:256M 硬盘:10G推荐配置:CPU:P4 内存:512M 硬盘 80G安装步骤:1. 插入SQL Server 2000 安装光盘:2. 选择<安装SQL Server 2000 组件>,开始安装数据库服务器,依照安装向导的提示,安装数据库服务器和客户端工具。

3. 在安装类型页面,用自定义方式,选择程序文件和数据文件的安装目的文件夹:【注意】选择自定义也方便了加速查询的排序次序的设置,强烈建议修改默认的排序方式为二进制。

另外,数据文件所在文件夹分区必须是NTFS 格式,如果是FAT32 格式的分区,文件的限制为4G,当超过4G 时,文件无法继续增长。

同时建议不要安装SQL数据文件与程序文件在系统盘,可单独安装数据文件到大的磁盘与系统盘分开。

4. 下一步,选择身份验证模式为<混合模式>,输入sa 登录密码,请管理员务必牢记:5. 在接下来的排序规则设置页面,本系统推荐“二进制”排序,这样可以提高查询速度:6. 设置工作完成后,安装程序开始复制文件。

7. SQL Server 安装完成。

8. 安装Microsoft SQL Server 2000 Service Pack 3。

使用Python进行大数据处理PySpark入门在当今信息爆炸的时代,大数据处理成为了许多企业和机构必须面对的一个重要挑战。

为了有效地处理大规模的数据集,出现了许多大数据处理框架,其中Apache Spark受到了广泛的关注和应用。

而PySpark作为Spark的Python API,为Python开发者提供了一个强大的工具来处理大数据。

本文将介绍如何使用Python 进行大数据处理并入门PySpark框架。

一、大数据处理简介随着科技的不断发展,我们很容易产生大量的数据,而这些数据往往具有复杂的结构和庞大的规模。

传统的数据处理方法往往难以胜任,为了解决这个问题,大数据处理技术应运而生。

大数据处理是指对大规模数据集进行存储、管理、分析和可视化的过程。

它能够帮助机构和企业挖掘出有价值的信息,从而做出更加明智的决策。

二、Apache Spark简介Apache Spark是一个通用的大数据处理框架,具有高度的可扩展性和容错性。

它能够并行处理大规模数据集,并提供了丰富的API来支持数据处理、机器学习、图计算等各种计算模式。

Spark采用了内存计算的方式,大大加快了数据处理速度。

同时,Spark 还提供了多种编程语言的API,方便开发者使用不同语言进行数据处理。

三、PySpark简介PySpark是Spark的Python API,提供了Python开发者对Spark 进行操作和控制的能力。

相比于其他编程语言,Python具有简洁易用的语法和丰富的数据科学库,使得利用PySpark进行大数据处理变得更加便捷。

Python对于数据的处理、分析和可视化等都有很好的支持,因此结合Spark和Python是进行大数据处理的不二选择。

四、安装PySpark要使用PySpark进行大数据处理,首先需要安装Spark和Python。

可以在Spark官方网站上下载Spark,并根据官方文档进行安装。

安装完成后,我们需要配置环境变量,使得Spark和Python可以顺利协同工作。

MySQL中的日志开关与级别设置MySQL是一种常用的关系型数据库管理系统,广泛应用于Web应用程序和其他需要持久化存储数据的软件中。

在MySQL中,日志功能对于系统运维和故障排查非常重要。

本文将介绍MySQL中的日志开关与级别设置,以及各个日志类型的特点和使用场景。

一、日志的重要性日志是数据库系统中记录操作和状态的重要工具。

通过日志,我们可以了解系统的运行情况,追踪故障产生的原因,恢复数据的一致性和完整性。

在MySQL中,主要有以下几种日志类型:1. 错误日志(Error Log):记录系统运行过程中的错误信息,比如数据库启动失败、死锁、服务器崩溃等。

错误日志对于排查故障和调优非常有帮助。

2. 查询日志(Query Log):记录所有客户端连接到数据库系统执行的SQL语句和其执行结果。

查询日志可以用于审计、性能分析和调试。

3. 慢查询日志(Slow Query Log):记录执行时间超过设定阈值的查询语句。

慢查询日志对于发现性能瓶颈和优化查询语句非常有用。

4. 二进制日志(Binary Log):记录所有更改数据的语句,并以二进制格式存储。

二进制日志可以用于数据恢复、数据库复制和故障恢复。

二、日志的开关与级别设置在MySQL中,可以通过修改配置文件或使用SQL语句来开关和配置各个日志类型。

下面分别介绍各个日志类型的开关和级别设置。

1. 错误日志错误日志默认是开启的,其位置和文件名可以在配置文件中指定。

可以通过以下SQL语句查看当前错误日志的路径:```SHOW VARIABLES LIKE 'log_error';```如果需要关闭错误日志,可以在配置文件中增加或修改以下参数:```log_error = 0```2. 查询日志查询日志默认是关闭的,我们可以通过以下SQL语句开启查询日志:```SET GLOBAL general_log = 1;```开启日志后,可以通过以下SQL语句查看当前查询日志的路径:```SHOW VARIABLES LIKE 'general_log_file';```如果需要关闭查询日志,可以执行以下SQL语句:```SET GLOBAL general_log = 0;3. 慢查询日志慢查询日志默认是关闭的,我们可以通过以下SQL语句开启慢查询日志:```SET GLOBAL slow_query_log = 1;```开启日志后,可以通过以下SQL语句查看当前慢查询日志的路径:```SHOW VARIABLES LIKE 'slow_query_log_file';```如果需要关闭慢查询日志,可以执行以下SQL语句:```SET GLOBAL slow_query_log = 0;```4. 二进制日志二进制日志默认是开启的,其位置和文件名可以在配置文件中指定。

【sparkSQL】SparkSession的认识在Spark1.6中我们使⽤的叫Hive on spark,主要是依赖hive⽣成spark程序,有两个核⼼组件SQLcontext和HiveContext。

这是Spark 1.x 版本的语法1 2 3 4 5//set up the spark configuration and create contextsval sparkConf = new SparkConf().setAppName("SparkSessionZipsExample").setMaster("local") // your handle to SparkContext to access other context like SQLContextval sc = new SparkContext(sparkConf).set("spark.some.config.option", "some-value")val sqlContext = new org.apache.spark.sql.SQLContext(sc)⽽Spark2.0中我们使⽤的就是sparkSQL,是后继的全新产品,解除了对Hive的依赖。

从Spark2.0以上的版本开始,spark是使⽤全新的SparkSession接⼝代替Spark1.6中的SQLcontext和HiveContext来实现对数据的加载、转换、处理等⼯作,并且实现了SQLcontext和HiveContext的所有功能。

我们在新版本中并不需要之前那么繁琐的创建很多对象,只需要创建⼀个SparkSession对象即可。

SparkSession⽀持从不同的数据源加载数据,并把数据转换成DataFrame,并⽀持把DataFrame转换成SQLContext⾃⾝中的表。

开发PySpark所需准备环境1) 安装python环境安装python有两种⽅式:原⽣安装、Ancona安装以上安装路径中不能有中⽂,不能有空格2) window中必须配置SPARK_HOME3) 在python中安装py4j模块两种安装⽅式:建议使⽤第⼆(2)种(1)使⽤ pip install py4j进⼊ Anaconda3的Scripts⽬录下,cmd输⼊:pip install py4j(2)找到spark-2.3.1-bin-hadoop2.6\python\lib⽬录解压py4j-0.10.7-src.zip和pyspark.zip两个⽂件:将py4j⽂件夹复制到Anaconda3\Lib\site-packages下:验证py4j是否安装成功:只要不报错,说明py4j已经安装成功。

4) 在python中安装pyspark模块(pyspark提供了开发spark代码时所需的各种包)两种安装⽅式:建议使⽤第(2)中(1)使⽤ pip install py4j(2)找到spark-2.3.1-bin-hadoop2.6\python\lib⽬录解压py4j-0.10.7-src.zip和pyspark.zip两个⽂件:将pyspark⽂件夹复制到Anaconda3\Lib\site-packages下:验证pyspark是否安装成功:只要不报错,说明pyspark已经安装成功。

完成开发PySpark 所需准备环境这四个步骤之后,就可以开始下代码了。

注意:★py4j是⼀个⽤ Python和Java编写的库。

通过Py4J,Python程序能够动态访问Java虚拟机中的Java对象,Java程序也能够回调Python对象。

★pyspark 是 Spark 为 Python 开发者提供的 API。

windowns使⽤PySpark环境配置和基本操作下载依赖⾸先需要下载hadoop和spark,解压,然后设置环境变量。

HADOOP_HOME => /path/hadoopSPARK_HOME => /path/spark安装pyspark。

pip install pyspark基本使⽤可以在shell终端,输⼊pyspark,有如下回显:输⼊以下指令进⾏测试,并创建SparkContext,SparkContext是任何spark功能的⼊⼝点。

>>> from pyspark import SparkContext>>> sc = SparkContext("local", "First App")如果以上不会报错,恭喜可以开始使⽤pyspark编写代码了。

不过,我这⾥使⽤IDE来编写代码,⾸先我们先在终端执⾏以下代码关闭SparkContext。

>>> sc.stop()下⾯使⽤pycharm编写代码,如果修改了环境变量需要先重启pycharm。

在pycharm运⾏如下程序,程序会起本地模式的spark计算引擎,通过spark统计abc.txt⽂件中a和b出现⾏的数量,⽂件路径需要⾃⼰指定。

from pyspark import SparkContextsc = SparkContext("local", "First App")logFile = "abc.txt"logData = sc.textFile(logFile).cache()numAs = logData.filter(lambda s: 'a' in s).count()numBs = logData.filter(lambda s: 'b' in s).count()print("Line with a:%i,line with b:%i" % (numAs, numBs))运⾏结果如下:20/03/11 16:15:57 WARN NativeCodeLoader: Unable to load native-hadoop library for your platform... usingbuiltin-java classes where applicableUsing Spark's default log4j profile: org/apache/spark/log4j-defaults.propertiesSetting default log level to "WARN".To adjust logging level use sc.setLogLevel(newLevel). For SparkR, use setLogLevel(newLevel).20/03/11 16:15:58 WARN Utils: Service 'SparkUI' could not bind on port 4040. Attempting port 4041.Line with a:3,line with b:1这⾥说⼀下,同样的⼯作使⽤python可以做,spark也可以做,使⽤spark主要是为了⾼效的进⾏分布式计算。

使用Python脚本在Linux上实现系统登录日志分析Linux系统登录日志是系统管理员用来分析和追踪用户登录行为的重要信息源。

通过使用Python脚本,我们可以有效地对登录日志进行分析和提取,以获取有用的统计数据和警告信息。

本文将介绍如何使用Python脚本在Linux系统上实现系统登录日志的分析。

一、准备工作在开始之前,我们需要准备以下工作:1. 安装Python和必要的模块:首先,确保你的Linux系统已经安装了Python。

然后,安装必要的Python模块,包括re、datetime和collections等。

可以使用pip命令来安装这些模块。

2. 获取系统登录日志:登录到你的Linux系统上,使用命令行或者GUI方式获取系统登录日志文件。

通常,系统登录日志文件位于/var/log目录下,文件名可能是auth.log、secure等。

二、分析系统登录日志下面是使用Python脚本对系统登录日志进行分析的步骤:1. 打开日志文件:使用Python的open函数打开系统登录日志文件,并将其赋值给一个变量,以便后续的操作。

2. 逐行读取日志内容:使用Python的readlines函数逐行读取日志文件的内容,并将每一行的内容存储在一个列表中。

3. 解析日志内容:对于每一行的日志内容,我们可以使用正则表达式来解析出有用的信息,例如登录用户名、登录时间和登录结果等。

使用Python的re模块可以方便地进行正则表达式匹配。

4. 统计数据:根据解析得到的信息,我们可以统计每个用户的登录次数、登录失败次数、最后登录时间等。

可以使用Python的collections模块中的Counter类来实现登录次数的统计。

5. 输出结果:将统计得到的结果输出到控制台或者保存到文件中,以便进一步分析和使用。

三、示例代码下面是一个简单的示例代码,用于演示如何使用Python脚本在Linux系统上实现系统登录日志的分析:```import refrom collections import Counterlogfile = "/var/log/auth.log" # 日志文件路径def parse_log(logfile):log_pattern =r'(\w+\s+\d+\s\d+:\d+:\d+)\s\w+\ssshd\[\d+\]:\s(?P<username>\w+)\s.*\s(?P <status>(Accepted|Failed))' # 正则表达式模式with open(logfile, 'r') as f:log_lines = f.readlines()login_info = []for line in log_lines:match = re.search(log_pattern, line)if match:login_time = match.group(1)username = match.group('username')status = match.group('status')login_info.append({"login_time": login_time, "username": username, "status": status})return login_infodef analyze_log(login_info):total_logins = len(login_info)successful_logins = sum(1 for info in login_info if info['status'] == 'Accepted')failed_logins = total_logins - successful_loginslogin_counts = Counter(info['username'] for info in login_info)last_logins = {info['username']: info['login_time'] for info in login_info}print("总登录次数:", total_logins)print("成功登录次数:", successful_logins)print("失败登录次数:", failed_logins)print("登录次数统计:", login_counts)print("最后登录时间:", last_logins)if __name__ == "__main__":login_info = parse_log(logfile)analyze_log(login_info)```通过运行以上示例代码,我们可以在控制台输出登录次数统计和最后登录时间等信息。

天融信日志服务器配置说明书(Topsec_Auditor_Server_2.0专用版)VER: 2.0杭州市工商行政管理局网络安全二期项目工程文档--------日志服务器配置说明书北京天融信网络安全技术有限公司杭州分公司2004年12月天融信安全技术高品质的保证文档管理文档信息分发控制版本控制目录安装数据库服务器 (1)安装并配置审计服务器 (3)安装并配置审计管理器 (4)配置防火墙日志权限 (5)安装数据库服务器系统要求:操作系统:中英文windows 2000/2003 服务器版数据库系统:MS SQL Server 2000 + Service Pack 3 ( 不支持 MS SQL Server 7.0 )最低配置:CPU :PIII 内存:256M 硬盘:10G推荐配置:CPU:P4 2.4G 内存:512M 硬盘 80G安装步骤:1. 插入SQL Server 2000 安装光盘:2. 选择<安装SQL Server 2000 组件>,开始安装数据库服务器,依照安装向导的提示,安装数据库服务器和客户端工具。

3. 在安装类型页面,用自定义方式,选择程序文件和数据文件的安装目的文件夹:【注意】选择自定义也方便了加速查询的排序次序的设置,强烈建议修改默认的排序方式为二进制。

另外,数据文件所在文件夹分区必须是NTFS 格式,如果是FAT32 格式的分区,文件的限制为4G,当超过4G 时,文件无法继续增长。

同时建议不要安装SQL数据文件与程序文件在系统盘,可单独安装数据文件到大的磁盘与系统盘分开。

4. 下一步,选择身份验证模式为<混合模式>,输入sa 登录密码,请管理员务必牢记:5. 在接下来的排序规则设置页面,本系统推荐“二进制”排序,这样可以提高查询速度:6. 设置工作完成后,安装程序开始复制文件。

7. SQL Server 安装完成。

8. 安装Microsoft SQL Server 2000 Service Pack 3。

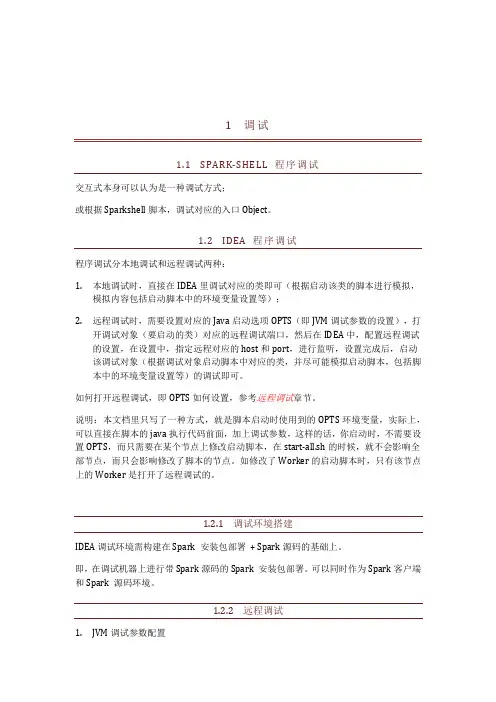

1调试1.1SPARK-SHELL 程序调试交互式本身可以认为是一种调试方式;或根据Sparkshell脚本,调试对应的入口Object。

1.2IDEA 程序调试程序调试分本地调试和远程调试两种:1.本地调试时,直接在IDEA里调试对应的类即可(根据启动该类的脚本进行模拟,模拟内容包括启动脚本中的环境变量设置等);2.远程调试时,需要设置对应的Java启动选项OPTS(即JVM调试参数的设置),打开调试对象(要启动的类)对应的远程调试端口,然后在IDEA中,配置远程调试的设置,在设置中,指定远程对应的host和port,进行监听,设置完成后,启动该调试对象(根据调试对象启动脚本中对应的类,并尽可能模拟启动脚本,包括脚本中的环境变量设置等)的调试即可。

如何打开远程调试,即OPTS如何设置,参考远程调试章节。

说明:本文档里只写了一种方式,就是脚本启动时使用到的OPTS环境变量,实际上,可以直接在脚本的java执行代码前面,加上调试参数,这样的话,你启动时,不需要设置OPTS,而只需要在某个节点上修改启动脚本,在start-all.sh的时候,就不会影响全部节点,而只会影响修改了脚本的节点。

如修改了Worker的启动脚本时,只有该节点上的Worker是打开了远程调试的。

1.2.1调试环境搭建IDEA调试环境需构建在Spark 安装包部署+ Spark源码的基础上。

即,在调试机器上进行带Spark源码的Spark 安装包部署。

可以同时作为Spark客户端和Spark 源码环境。

1.2.2远程调试1.JVM调试参数配置远程调试时,结合JDWP(Java Debug Wire Protocol)进行,在JVM进程启动前,添加相应的JAVA_OPTS,设置远程调试参数,比如:启动JVM进程(通常就是执行对应的启动脚本)后会停留在Listening for transport dt_socket at address: 7777 ,IDE连接后才会继续。

天融信日志服务器配置说明书(Topsec_Auditor_Server_2.0专用版)VER: 2.0杭州市工商行政管理局网络安全二期项目工程文档--------日志服务器配置说明书北京天融信网络安全技术有限公司杭州分公司2004年12月天融信安全技术高品质的保证文档管理文档信息分发控制版本控制目录安装数据库服务器 (3)安装并配置审计服务器 (5)安装并配置审计管理器 (11)配置防火墙日志权限 (17)安装数据库服务器系统要求:操作系统:中英文windows 2000/2003 服务器版数据库系统:MS SQL Server 2000 + Service Pack 3 ( 不支持 MS SQL Server 7.0 ) 最低配置:CPU :PIII 内存:256M 硬盘:10G推荐配置:CPU:P4 2.4G 内存:512M 硬盘 80G安装步骤:1. 插入SQL Server 2000 安装光盘:2. 选择<安装SQL Server 2000 组件>,开始安装数据库服务器,依照安装向导的提示,安装数据库服务器和客户端工具。

3. 在安装类型页面,用自定义方式,选择程序文件和数据文件的安装目的文件夹:【注意】选择自定义也方便了加速查询的排序次序的设置,强烈建议修改默认的排序方式为二进制。

另外,数据文件所在文件夹分区必须是NTFS 格式,如果是FAT32 格式的分区,文件的限制为4G,当超过4G 时,文件无法继续增长。

同时建议不要安装SQL数据文件与程序文件在系统盘,可单独安装数据文件到大的磁盘与系统盘分开。

4. 下一步,选择身份验证模式为<混合模式>,输入sa 登录密码,请管理员务必牢记:5. 在接下来的排序规则设置页面,本系统推荐“二进制”排序,这样可以提高查询速度:6. 设置工作完成后,安装程序开始复制文件。

7. SQL Server 安装完成。

8. 安装Microsoft SQL Server 2000 Service Pack 3。

Spark入门Hadoop是对大数据集进行分布式计算的标准工具,这也是为什么当你穿过机场时能看到”大数据(Big Data)”广告的原因。

它已经成为大数据的操作系统,提供了包括工具和技巧在内的丰富生态系统,允许使用相对便宜的商业硬件集群进行超级计算机级别的计算。

2003和2004年,两个来自Google的观点使Hadoop 成为可能:一个分布式存储框架(Google文件系统),在Hadoop中被实现为HDFS;一个分布式计算框架(MapReduce)。

这两个观点成为过去十年规模分析(scaling analytics)、大规模机器学习(machine learning),以及其他大数据应用出现的主要推动力!但是,从技术角度上讲,十年是一段非常长的时间,而且Hadoop还存在很多已知限制,尤其是MapReduce。

对MapReduce编程明显是困难的。

对大多数分析,你都必须用很多步骤将Map和Reduce任务串接起来。

这造成类SQL的计算或机器学习需要专门的系统来进行。

更糟的是,MapReduce要求每个步骤间的数据要序列化到磁盘,这意味着MapReduce作业的I/O成本很高,导致交互分析和迭代算法(iterative algorithms)开销很大;而事实是,几乎所有的最优化和机器学习都是迭代的。

为了解决这些问题,Hadoop一直在向一种更为通用的资源管理框架转变,即YARN (Yet Another Resource Negotiator, 又一个资源协调者)。

YARN实现了下一代的MapReduce,但同时也允许应用利用分布式资源而不必采用MapReduce进行计算。

通过将集群管理一般化,研究转到分布式计算的一般化上,来扩展了MapReduce的初衷。

Spark是第一个脱胎于该转变的快速、通用分布式计算范式,并且很快流行起来。

Spark使用函数式编程范式扩展了MapReduce模型以支持更多计算类型,可以涵盖广泛的工作流,这些工作流之前被实现为Hadoop之上的特殊系统。

天融信日志服务器配置说明书公司标准化编码 [QQX96QT-XQQB89Q8-NQQJ6Q8-MQM9N]天融信日志服务器配置说明书(专用版)VER:杭州市工商行政管理局网络安全二期项目工程文档--------日志服务器配置说明书北京天融信网络安全技术有限公司杭州分公司2004年12月天融信安全技术高品质的保证文档管理文档名称杭州市工商局网络安全二期项目工程文档保密级别内部文档文档版本编号目录安装数据库服务器系统要求:操作系统:中英文windows 2000/2003 服务器版数据库系统:MS SQL Server 2000 + Service Pack 3 ( 不支持 MS SQL Server )最低配置:CPU :PIII 内存:256M 硬盘:10G推荐配置:CPU:P4 内存:512M 硬盘 80G安装步骤:1. 插入SQL Server 2000 安装光盘:2. 选择<安装SQL Server 2000 组件>,开始安装数据库服务器,依照安装向导的提示,安装数据库服务器和客户端工具。

3. 在安装类型页面,用自定义方式,选择程序文件和数据文件的安装目的文件夹:【注意】选择自定义也方便了加速查询的排序次序的设置,强烈建议修改默认的排序方式为二进制。

另外,数据文件所在文件夹分区必须是NTFS 格式,如果是FAT32 格式的分区,文件的限制为4G,当超过4G 时,文件无法继续增长。

同时建议不要安装SQL数据文件与程序文件在系统盘,可单独安装数据文件到大的磁盘与系统盘分开。

4. 下一步,选择身份验证模式为<混合模式>,输入sa 登录密码,请管理员务必牢记:5. 在接下来的排序规则设置页面,本系统推荐“二进制”排序,这样可以提高查询速度:6. 设置工作完成后,安装程序开始复制文件。

7. SQL Server 安装完成。

8. 安装Microsoft SQL Server 2000 Service Pack 3。

pyspark教程Apache Spark是⽤ Scala编程语⾔编写的。

为了⽤Spark⽀持Python,Apache Spark社区发布了⼀个⼯具PySpark。

使⽤PySpark,您也可以使⽤Python编程语⾔中的 RDD 。

正是由于⼀个名为 Py4j 的库,他们才能实现这⼀⽬标。

它将创建⼀个⽬录 spark-2.1.0-bin-hadoop2.7 。

在启动PySpark之前,需要设置以下环境来设置Spark路径和 Py4j路径。

export SPARK_HOME = /home/hadoop/spark-2.1.0-bin-hadoop2.7export PATH = $PATH:/home/hadoop/spark-2.1.0-bin-hadoop2.7/binexport PYTHONPATH = $SPARK_HOME/python:$SPARK_HOME/python/lib/py4j-0.10.4-src.zip:$PYTHONPATHexport PATH = $SPARK_HOME/python:$PATH或者,要全局设置上述环境,请将它们放在 .bashrc⽂件中。

然后运⾏以下命令以使环境正常⼯作。

# source .bashrcSparkContext是任何spark功能的⼊⼝点。

当我们运⾏任何Spark应⽤程序时,启动⼀个驱动程序,它具有main函数,并在此处启动SparkContext。

然后,驱动程序在⼯作节点上的执⾏程序内运⾏操作。

SparkContext使⽤Py4J启动 JVM 并创建 JavaSparkContext。

默认情况下,PySpark将SparkContext作为 'sc'提供,因此创建新的SparkContext将不起作⽤。

以下代码块包含PySpark类的详细信息以及SparkContext可以采⽤的参数。

class pyspark.SparkContext (master = None,appName = None,sparkHome = None,pyFiles = None,environment = None,batchSize = 0,serializer = PickleSerializer(),conf = None,gateway = None,jsc = None,profiler_cls = <class 'pyspark.profiler.BasicProfiler'>)参数以下是SparkContext的参数。

spark作业运行流程

Spark作业运行流程简述如下:

1. 创建SparkContext:在应用中初始化Spark环境,连接到集群资源管理器(如Standalone、YARN或Mesos)。

2. 提交作业:通过spark-submit命令提交打包好的应用程序给Master节点。

3. 申请资源:SparkContext向资源管理器请求Executor资源,资源管理器分配资源并在Worker节点上启动Executor进程。

4. DAG构建与优化:根据用户代码生成DAG(有向无环图),表示任务的执行计划。

DAGScheduler将DAG划分为Stage(阶段),每个Stage包含多个可以并行执行的Task。

5. 任务调度:DAGScheduler将TaskSet提交给TaskScheduler,后者负责在Executor之间调度和分配任务。

6. 执行任务:Executor执行任务,任务可能涉及数据加载、转换操作和行动操作,结果写回存储系统或输出到控制台。

7. 反馈与容错:Driver监控所有任务的执行状态,并处理失败任务的重试,确保作业最终成功完成。