SVM-算法实现

- 格式:ppt

- 大小:3.65 MB

- 文档页数:66

spark算法实现——svm⽀持向量机svm是⼀种分类算法,⼀般先分为两类,再向多类推⼴⼀⽣⼆,⼆⽣三,三⽣。

⼤致可分为:线性可分⽀持向量机硬间隔最⼤化hard margin maximization硬间隔⽀持向量机线性⽀持向量机软间隔最⼤化soft margin maximization软间隔⽀持向量机⾮线性⽀持向量机核函数kernel function基本概念:分割超平⾯设C和D为两不相交的凸集,则存在超平⾯P,P可以将C和D分离。

线性可分⽀持向量机SVM从线性可分情况下的最优分类⾯发展⽽来。

最优分类⾯就是要求分类线不但能将两类正确分开(训练错误率为0),且使分类间隔最⼤ 给定线性可分训练数据集,通过间隔最⼤化得到的分离超平⾯为相应的分类决策函数该决策函数称为线性可分⽀持向量机。

φ(x)是某个确定的特征空间转换函数,它的作⽤是将x映射到(更⾼的)维度。

线性⽀持向量机分类线能将两类分开(训练错误率⼤于0,存在个别样本点分错),且使分类间隔最⼤⾮线性⽀持向量机存在⾮线性分割超平⾯,讲样本分开sparkmllib代码实现package mllibimport org.apache.spark.mllib.classification.{SVMModel, SVMWithSGD}import beledPointimport org.apache.spark.mllib.util.MLUtilsimport org.apache.spark.rdd.RDDimport org.apache.spark.sql.SQLContextimport org.apache.spark.{SparkContext, SparkConf}//⼆分类object SVMwithSGD {def main(args: Array[String]) {val conf = new SparkConf().setAppName("test").setMaster("local")val sc = new SparkContext(conf)val sql = new SQLContext(sc);val data: RDD[LabeledPoint] = MLUtils.loadLibSVMFile(sc, "svm.txt")val splits = data.randomSplit(Array(0.6, 0.4), seed = 11L)val training = splits(0).cache()val test = splits(1)// data.foreach( x => println(x.toString()))// data.foreach( x => println(bel))data.foreach( x => println(x.features))val numIterations = 100val model: SVMModel = SVMWithSGD.train(training, numIterations)model.clearThreshold()//为了模型拿到评分不是处理过之后的分类结果val scoreAndLabels: RDD[(Double, Double)] = test.map { point => // ⼤于0 ⼩于0 两类val score = model.predict(point.features)(score, bel)}scoreAndLabels.foreach(println)}}评分>0表⽰样本点在分割⾯之上,<0表⽰在分割⾯之下。

SVM的原理和代码实现SVM(Support Vector Machine,支持向量机)是一种常用的机器学习算法,用于二分类和回归问题。

SVM的核心思想是找到一个最优的超平面,将不同类别的数据样本分开。

这个超平面由支持向量(样本)确定,使得支持向量到超平面的距离最大化。

本文将介绍SVM的原理及其代码实现。

一、SVM原理:1.线性可分情况:对于线性可分的数据集,SVM的目标是找到一个超平面,使得所有正例样本都位于超平面的一侧,负例样本都位于另一侧。

超平面的方程可以表示为:w^T*x+b=0,其中w是一个向量,表示法向量,b是偏置。

2.间隔最大化:SVM的关键是最大化两个不同类别样本之间的几何间隔。

间隔是沿着超平面的宽度,因此离分类超平面最近的实例点,即两个最靠近超平面的支持向量(x1和x2),满足w^T*x1+b=1和w^T*x2+b=-1、它们满足w^T*(x1-x2)=2/(,w,)。

因此,SVM的优化问题转化为求解最大化2/(,w,)的最小化问题。

也就是求解以下优化问题:minimize ,w,^2/2,其中y_i*(w^T*x_i + b) >= 13.引入松弛变量:当数据不是完全线性可分时,引入松弛变量xi,使得一些样本可以处于错误的一侧。

此时优化问题转化为:minimize ,w,^2/2 + C*Σξ_i,其中y_i*(w^T*x_i + b) >= 1 - ξ_i,ξ_i >= 0。

C是一个超参数,用于控制错误样本的惩罚程度。

当C越大,对错误样本的惩罚越重;C越小,则对错误样本的惩罚越轻。

4.对偶问题:为了方便求解SVM的优化问题,引入拉格朗日乘子,将SVM的原始问题转化为对偶问题。

通过求解对偶问题,可以得到最优解。

对偶问题如下:maximize Σα_i - 1/2*ΣΣ α_i*α_j*y_i*y_j*x_i*x_j,其中Σα_i*y_i = 0,0 <= α_i <= C。

⽀持向量机(SVM)算法的matlab的实现⽀持向量机(SVM)的matlab的实现⽀持向量机是⼀种分类算法之中的⼀个,matlab中也有对应的函数来对其进⾏求解;以下贴⼀个⼩例⼦。

这个例⼦来源于我们实际的项⽬。

clc;clear;N=10;%以下的数据是我们实际项⽬中的训练例⼦(例⼦中有8个属性)correctData=[0,0.2,0.8,0,0,0,2,2];errorData_ReversePharse=[1,0.8,0.2,1,0,0,2,2];errorData_CountLoss=[0.2,0.4,0.6,0.2,0,0,1,1];errorData_X=[0.5,0.5,0.5,1,1,0,0,0];errorData_Lower=[0.2,0,1,0.2,0,0,0,0];errorData_Local_X=[0.2,0.2,0.8,0.4,0.4,0,0,0];errorData_Z=[0.53,0.55,0.45,1,0,1,0,0];errorData_High=[0.8,1,0,0.8,0,0,0,0];errorData_CountBefore=[0.4,0.2,0.8,0.4,0,0,2,2];errorData_Local_X1=[0.3,0.3,0.7,0.4,0.2,0,1,0];sampleData=[correctData;errorData_ReversePharse;errorData_CountLoss;errorData_X;errorData_Lower;errorData_Local_X;errorData_Z;errorData_High;errorData_CountBefore;errorData_Local_X1];%训练例⼦type1=1;%正确的波形的类别,即我们的第⼀组波形是正确的波形,类别号⽤ 1 表⽰type2=-ones(1,N-2);%不对的波形的类别,即第2~10组波形都是有故障的波形。

SVM算法推导及其分类的算法实现SVM(Support Vector Machine)是一种常用的监督学习算法,被广泛应用于二分类和多分类问题中。

它的基本原理是找到一个超平面,将不同类别的数据分开。

这篇文章将介绍SVM算法的推导及其分类的算法实现。

一、推导1.数据预处理:将数据进行标准化或归一化处理,使不同特征之间具有相同的重要性。

2.确定超平面:SVM算法的目标是找到一个超平面,能够将不同类别的数据完全分开。

超平面可以表示为w*x+b=0的形式,其中w是法向量,b是偏置项。

3.确定分类边界:SVM算法中存在两个平行的超平面,它们与训练数据中的支持向量间隔相等。

这两个平面被称为分类边界。

4.样本分类:根据数据点到超平面的位置,确定其所属类别。

点在超平面之下表示负类数据,点在超平面之上表示正类数据。

5.寻找最优超平面:SVM算法的目标是寻找一个最优超平面,使分类误差最小。

通常使用最大间隔法来确定最优超平面。

6.引入松弛变量:考虑到有时数据无法完全线性分开,SVM算法允许一定程度上的分类错误。

通过引入松弛变量,可以允许部分数据点落在错误的一侧。

7.目标函数确定:根据以上步骤,可以得到SVM的目标函数,即在最大间隔的同时,使得分类误差最小。

8.优化求解:使用优化算法来求解目标函数,例如使用拉格朗日对偶问题等方法。

二、算法实现下面是SVM算法的基本实现步骤:1.数据预处理:将原始数据进行标准化或者归一化处理,使得不同特征之间的取值范围一致。

2.确定超平面:假设训练数据是线性可分的,通过训练数据找到一个超平面,将不同类别的数据完全分开。

3.最大间隔法:选择两个平行的超平面,使其与训练数据中的支持向量间隔最大。

4.构建目标函数:根据最大间隔法,构建目标函数,同时引入松弛变量。

5.目标函数求解:使用优化算法,求解目标函数,例如使用拉格朗日对偶问题等方法。

6.分类边界:根据超平面和支持向量,确定分类边界。

7.样本分类:根据数据点到超平面的位置,确定其所属类别。

SVM算法原理及其Matlab应用SVM(Support Vector Machine)是一种常用的机器学习算法,广泛应用于分类和回归问题。

本文将详细介绍SVM算法的原理,并讨论其在Matlab中的应用。

一、SVM算法原理SVM算法的核心思想是找到一个最优的超平面,将不同类别的样本分开。

具体来说,SVM通过最大化间隔来寻找这个超平面,使得离超平面最近的样本点到超平面的距离最大化。

这些离超平面最近的样本点被称为支持向量,它们决定了超平面的位置和方向。

SVM算法的数学模型可以表示为以下优化问题:minimize: 1/2 * ||w||^2 + C * Σξsubject to: yi(w·xi + b) ≥ 1 - ξi, ξi ≥ 0其中,w是超平面的法向量,b是超平面的偏置项,xi是样本特征向量,yi是样本的类别标签,ξi是松弛变量,C是正则化参数。

二、SVM在Matlab中的应用Matlab是一种功能强大的科学计算软件,提供了丰富的机器学习工具箱,其中包括了SVM算法的实现。

1. 数据准备首先,我们需要准备训练数据。

训练数据应包括样本的特征向量和对应的类别标签。

可以使用Matlab中的数据导入功能,将数据从外部文件导入到Matlab工作环境中。

2. 模型训练接下来,我们可以使用Matlab中的svmtrain函数来训练SVM模型。

该函数的输入参数包括训练数据、正则化参数C和核函数类型等。

通过调整这些参数,可以得到不同的模型效果。

3. 模型评估训练完成后,我们可以使用svmclassify函数来对新的样本进行分类预测。

该函数的输入参数包括待分类的样本特征向量和训练得到的SVM模型。

函数将返回预测的类别标签。

4. 结果可视化为了更直观地观察分类结果,可以使用Matlab中的scatter函数将样本点绘制在二维平面上,并使用不同的颜色表示不同的类别。

5. 参数调优SVM算法中的正则化参数C和核函数类型等参数对模型的性能有重要影响。

SVM——详细讲解SMO算法优化两个变量以及变量的选择支持向量机(SVM)是一种二分类模型,它在分类超平面的构建过程中,通过优化二次规划问题求解得到最优的超平面。

而序列最小最优化(Sequential Minimal Optimization,SMO)算法则是一种用于求解SVM 二次规划问题的简化算法。

在SVM中,分类超平面可以表示为w*x+b=0,其中w为法向量,b为截距,x为输入样本。

SVM的目标是找到具有最大边界的超平面,使得训练样本与超平面的距离最大化。

优化SVM的问题可以转化为求解以下二次规划问题:\begin{align*}\min\limits_{\alpha} & \quad \frac{1}{2}\sum_{i=1}^{N}{\sum_{j=1}^{N}{\alpha_i \alpha_j y_i y_j K(x_i, x_j)}} - \sum_{i=1}^{N}{\alpha_i}\\s.t. & \quad \sum_{i=1}^{N}{\alpha_i y_i} = 0 \\& \quad 0 \leq \alpha_i \leq C, \quad i = 1, 2, ..., N\end{align*}\]其中,N是训练样本数量,C是惩罚参数,K(x_i,x_j)是核函数。

SMO算法通过迭代优化变量alpha_i和alpha_j,来逐渐优化整个二次规划问题。

SMO算法的核心步骤有两个:选择变量和优化变量。

1.变量的选择:在每次迭代中,SMO算法通过两个嵌套循环选择优化变量alpha_i和alpha_j。

首先,外层循环选择第一个变量alpha_i,通过遍历所有训练样本点,选择违反KKT条件的样本点。

KKT条件是SVM最优解必须满足的条件,对于正样本来说,条件是alpha_i=0,对于负样本来说,条件是alpha_i=C。

如果选择到了违反KKT条件的alpha_i,就进入内层循环。

⼿把⼿教你实现SVM算法(⼀)什么是机器学习(Machine Learning)机器学习是研究计算机怎样模拟或实现⼈类的学习⾏为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善⾃⾝的性能。

它是⼈⼯智能的核⼼,是使计算机具有智能的根本途径,其应⽤遍及⼈⼯智能的各个领域。

机器学习的⼤致分类:1)分类(模式识别):要求系统依据已知的分类知识对输⼊的未知模式(该模式的描述)作分析,以确定输⼊模式的类属,例如⼿写识别(识别是不是这个数)。

2)问题求解:要求对于给定的⽬标状态,寻找⼀个将当前状态转换为⽬标状态的动作序列。

SVM⼀般是⽤来分类的(⼀般先分为两类,再向多类推⼴⼀⽣⼆,⼆⽣三,三⽣万物哈)问题的描述向量表⽰:假设⼀个样本有n个变量(特征):Ⅹ= (X1,X2,…,Xn)T样本表⽰⽅法:SVM线性分类器SVM从线性可分情况下的最优分类⾯发展⽽来。

最优分类⾯就是要求分类线不但能将两类正确分开(训练错误率为0),且使分类间隔最⼤。

SVM考虑寻找⼀个满⾜分类要求的超平⾯,并且使训练集中的点距离分类⾯尽可能的远,也就是寻找⼀个分类⾯使它两侧的空⽩区域(margin)最⼤。

过两类样本中离分类⾯最近的点且平⾏于最优分类⾯的超平⾯上H1,H2的训练样本就叫做⽀持向量。

图例:问题描述:假定训练数据:可以被分为⼀个超平⾯:进⾏归⼀化:此时分类间隔等于:即使得:最⼤间隔最⼤等价于使最⼩下⾯这两张图可以看⼀下,有个感性的认识。

那个好?看下⾯这张图:下⾯我们要开始优化上⾯的式⼦,因为推导要⽤到拉格朗⽇定理和KKT条件,所以我们先了解⼀下相关知识。

在求取有约束条件的优化问题时,拉格朗⽇乘⼦法(Lagrange Multiplier) 和KKT条件是⾮常重要的两个求取⽅法,对于等式约束的优化问题,可以应⽤拉格朗⽇乘⼦法去求取最优值;如果含有不等式约束,可以应⽤KKT条件去求取。

当然,这两个⽅法求得的结果只是必要条件,只有当是凸函数的情况下,才能保证是充分必要条件。

Svm算法原理及实现Svm(support Vector Mac)⼜称为⽀持向量机,是⼀种⼆分类的模型。

当然如果进⾏修改之后也是可以⽤于多类别问题的分类。

⽀持向量机可以分为线性核⾮线性两⼤类。

其主要思想为找到空间中的⼀个更够将所有数据样本划开的超平⾯,并且使得本本集中所有数据到这个超平⾯的距离最短。

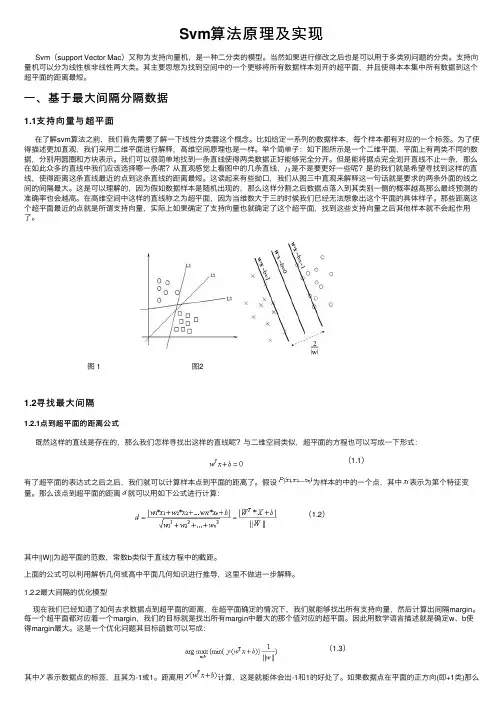

⼀、基于最⼤间隔分隔数据1.1⽀持向量与超平⾯在了解svm算法之前,我们⾸先需要了解⼀下线性分类器这个概念。

⽐如给定⼀系列的数据样本,每个样本都有对应的⼀个标签。

为了使得描述更加直观,我们采⽤⼆维平⾯进⾏解释,⾼维空间原理也是⼀样。

举个简单⼦:如下图所⽰是⼀个⼆维平⾯,平⾯上有两类不同的数据,分别⽤圆圈和⽅块表⽰。

我们可以很简单地找到⼀条直线使得两类数据正好能够完全分开。

但是能将据点完全划开直线不⽌⼀条,那么在如此众多的直线中我们应该选择哪⼀条呢?从直观感觉上看图中的⼏条直线,是不是要更好⼀些呢?是的我们就是希望寻找到这样的直线,使得距离这条直线最近的点到这条直线的距离最短。

这读起来有些拗⼝,我们从图三中直观来解释这⼀句话就是要求的两条外⾯的线之间的间隔最⼤。

这是可以理解的,因为假如数据样本是随机出现的,那么这样分割之后数据点落⼊到其类别⼀侧的概率越⾼那么最终预测的准确率也会越⾼。

在⾼维空间中这样的直线称之为超平⾯,因为当维数⼤于三的时候我们已经⽆法想象出这个平⾯的具体样⼦。

那些距离这个超平⾯最近的点就是所谓⽀持向量,实际上如果确定了⽀持向量也就确定了这个超平⾯,找到这些⽀持向量之后其他样本就不会起作⽤了。

图 1 图21.2寻找最⼤间隔1.2.1点到超平⾯的距离公式既然这样的直线是存在的,那么我们怎样寻找出这样的直线呢?与⼆维空间类似,超平⾯的⽅程也可以写成⼀下形式:(1.1)有了超平⾯的表达式之后之后,我们就可以计算样本点到平⾯的距离了。

假设为样本的中的⼀个点,其中表⽰为第个特征变量。

那么该点到超平⾯的距离就可以⽤如下公式进⾏计算:(1.2)其中||W||为超平⾯的范数,常数b类似于直线⽅程中的截距。

MATLAB技术SVM算法实现引言:支持向量机(Support Vector Machine, SVM)是机器学习领域中一种常用的监督学习方法,广泛应用于分类和回归问题。

本文将介绍如何使用MATLAB技术实现SVM算法,包括数据预处理、特征选择、模型训练和性能评估等方面的内容。

一、数据预处理在使用SVM算法之前,我们需要先进行数据的预处理。

数据预处理是为了将原始数据转化为能够被SVM算法处理的形式,一般包括数据清洗、特征缩放和特征编码等步骤。

1. 数据清洗数据清洗是指对数据中的缺失值、异常值和噪声进行处理的过程。

在MATLAB中,可以使用诸如ismissing和fillmissing等函数来处理缺失值。

对于异常值和噪声的处理,可以使用统计学方法或者基于模型的方法。

2. 特征缩放特征缩放是指对特征值进行标准化处理的过程,使得各个特征值具有相同的量纲。

常用的特征缩放方法有均值归一化和方差归一化等。

在MATLAB中,可以使用zscore函数来进行特征缩放。

3. 特征编码特征编码是指将非数值型特征转化为数值型的过程,以便SVM算法能够对其进行处理。

常用的特征编码方法有独热编码和标签编码等。

在MATLAB中,可以使用诸如dummyvar和encode等函数来进行特征编码。

二、特征选择特征选择是指从原始特征中选择出最具有代表性的特征,以减少维度和提高模型性能。

在SVM算法中,选择合适的特征对分类效果非常关键。

1. 相关性分析通过分析特征与目标变量之间的相关性,可以选择与目标变量相关性较高的特征。

在MATLAB中,可以使用corrcoef函数计算特征之间的相关系数。

2. 特征重要性评估特征重要性评估可以通过各种特征选择方法来实现,如基于统计学方法的方差分析、基于模型的递归特征消除和基于树模型的特征重要性排序等。

在MATLAB 中,可以使用诸如anova1、rfimportance等函数进行特征重要性评估。

三、模型训练与评估在进行完数据预处理和特征选择之后,我们可以开始进行SVM模型的训练和评估了。

SVM算法在PIR专用处理器中的实现郁草凌,肖伟华,韩志刚,杨淼(同济大学电子与信息工程学院,上海,201800)摘要:随着人们对安全意识的不断提高,红外产品作为人体运动检测技术已经广泛应用于安防领域。

本文根据PIR传感器采集到的信号,建立一个数据库模型,根据采集到的数据,对其使用卡尔曼滤波进行预处理,对预处理之后的数据采用两种不同的算法进行数据有效性的判别,实验结果表明,采用SVM+FFT 算法可以使模型的达到97%的准确率。

在确立数据处理算法之后,根据以上算法流程,使用硬件描述语言设计,形成一个可以实时检测的IP核,设计该IP核的接口设计、时序设计、功能设计等,该IP核可以作为一个独立外设连接至MCU,形成一个PIR专用处理器,最终可以实时检测15m远的距离。

关键词:PIR传感器;数据采集;数理统计;SVM分类;FFT变换The Implementation of SVM Algorithms in PIR Special ProcessorYU Cao-ling,XIAO Wei-hua,HAN Zhi-gang,YANG Miao(School of Electronic and Information Engineering,Tongji University,Shanghai201800,China)Abstract:With the continuous improvement of people's safety awareness,infrared products as human motion detection technology have been widely used in the field of security.According to the signal collected by PIR sensor, this paper establishes a database model.According to the data collected,Kalman filter is used to preprocess the data. Two different algorithms are used to judge the validity of the data after preprocessing.The experimental results show that the accuracy of the model can reach97%by using SVM+FFT algorithm.After establishing the data processing algorithm,according to the above algorithm flow,a real-time IP core is designed by using hardware description language.The interface design,timing design and function design of the IP core are designed.The IP core can be connected to the MCU as an independent peripheral to form a PIR special processor,which can detect the distance of 15m in real time.Key words:PIR sensor;data acquisition;mathematical statistics;SVM classification;fast fourier transform1前言近年来,随着人们对工作、生活智能化的要求不断变高,以及对于安防意识的不断提高,人体运动探测技术已经广泛应用于我们的生活,红外产品的市场需求也逐年上升,与之对应的相关产品如红外照明、智能门控、智能感应系统、红外报警系统等红外探测产品的发展和竞争而愈发激烈。

基于SVM的通用隐写检测算法设计与实现摘要:通用隐写检测是隐写分析技术研究的重点。

针对加性噪声隐写模型,以BMP图像为研究对象,进行通用隐写检测算法研究与设计,在此基础上,给出了算法设计与实现的流程和其性能的有效性验证。

实验结果表明该算法具有较好的检测精度、较低的虚惊率和漏警率。

关键词:通用隐写检测SVM BMP PCA1 设计思路BMP图像因其占有的文件存储空间相对较大,而秘密信息的嵌入主要在变换域实现,且以Cox提出的加性和乘性模型,或其延伸模型居多。

因此,将BMP灰度图像隐写嵌入直接操作域作为隐写分析域,同时引入Hilbert变换,产生高敏感数据源,提取敏感特征、构建敏感特征向量、采用PCA技术对所选特征进行降维处理,并且基于支持向量机(SupportVectorMachine,SVM)实现待测对象的检测,有利于提高算法综合性能。

2 设计流程2.1 产生敏感数据源将DCT域和DWT域作为直接隐写分析域,并且对两域高频系数进行Hilbert变换,然后将其高频系数包络解析信号作为特征提取的源数据,能够提高特征敏感性。

2.2 构建敏感特征向量特征提取是在隐写数据嵌入直接操作域进行,则有利于提高其的敏感性。

将DCT域和DWT域高频子带包络解析信号作为敏感特征提取源数据.式中,为待测图像,代表预测图像,则代表相应图像的特征。

为特征向量。

因HMT模型在描述小波系数相关性方面具有优势,系统采用HMT模型生成预测图像。

提取特征包括:变换域高频包络解析信号HCF绝对原点矩,见式(2);变换域高频包络解析信号主成分特征值的信息熵和方差,分别见式(3)、(4)。

1.3 PCA降维处理为降低特征,消除冗余特征,采PCA技术对特征提取特征进行优化处理,根据特征的贡献率,确定用于实现通用隐写分析检测的有效分类特征矢量集。

1.4 分类器选择SVM且具有较好的泛化能力且结构简单,而成为机器学习领域最有影响的成果之一,并被成功用于模式识别和隐写分析等。

本文部分内容来自网络整理,本司不为其真实性负责,如有异议或侵权请及时联系,本司将立即删除!== 本文为word格式,下载后可方便编辑和修改! ==svm算法实验实验报告篇一:SVM 实验报告SVM分类算法一、数据源说明1、数据源说远和理解:采用的实验数据源为第6组:The Insurance Company Benchmark (COIL 201X) TICDATA201X.txt: 这个数据集用来训练和检验预测模型,并且建立了一个5822个客户的记录的描述。

每个记录由86个属性组成,包含社会人口数据(属性1-43)和产品的所有关系(属性44-86 )。

社会人口数据是由派生邮政编码派生而来的,生活在具有相同邮政编码地区的所有客户都具有相同的社会人口属性。

第86个属性:“大篷车:家庭移动政策” ,是我们的目标变量。

共有5822条记录,根据要求,全部用来训练。

TICEVAL201X.txt: 这个数据集是需要预测( 4000个客户记录)的数据集。

它和TICDATA201X.txt它具有相同的格式,只是没有最后一列的目标记录。

我们只希望返回预测目标的列表集,所有数据集都用制表符进行分隔。

共有4003(自己加了三条数据),根据要求,用来做预测。

TICTGTS201X.txt:最终的目标评估数据。

这是一个实际情况下的目标数据,将与我们预测的结果进行校验。

我们的预测结果将放在result.txt文件中。

数据集理解:本实验任务可以理解为分类问题,即分为2类,也就是数据源的第86列,可以分为0、1两类。

我们首先需要对TICDATA201X.txt进行训练,生成model,再根据model进行预测。

2、数据清理代码中需要对数据集进行缩放的目的在于:A、避免一些特征值范围过大而另一些特征值范围过小;B、避免在训练时为了计算核函数而计算内积的时候引起数值计算的困难。

因此,通常将数据缩放到 [ -1,1] 或者是 [0,1] 之间。