离散无记忆的扩展信源

- 格式:ppt

- 大小:668.51 KB

- 文档页数:12

![信息论与编码[第二章离散信源及其信息测度]山东大学期末考试知识点复习](https://uimg.taocdn.com/4f9eb902763231126edb115f.webp)

第二章离散信源及其信息测度2.1.1 信源的分类信源是信息的来源,是产生消息或消息序列的源泉。

不同的信源输出的消息其随机性质不同。

根据消息所具有的随机性质的不同,对信源进行如下分类:按照消息取值集合以及取值时刻集合的离散性和连续性,信源可分为离散信源(数字信源)和波形信源(模拟信源);按照某取值时刻消息的取值集合的离散性和连续性,信源可分为离散信源和连续信源;按照信源输出消息所对应的随机序列的平稳性,信源可分为平稳信源和非平稳信源;按照信源输出的信息所对应的随机序列中随机变量前后之间有无统计依赖关系,信源可分为无记忆信源和有记忆信源。

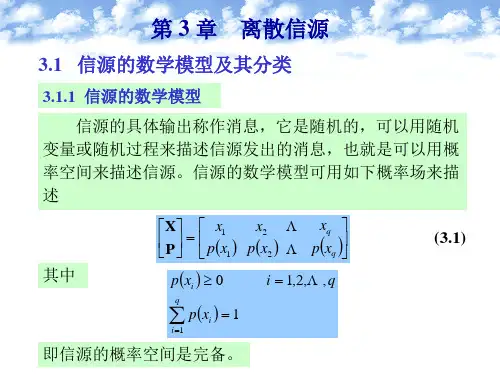

2.1.2 基本信源的数学模型根据信源输出消息所对应的不同的随机特性就有不同的信源数学模型。

而基本的信源数学模型有以下几种。

1.离散信源信源输出的是单个符号或代码的消息,信源符号集的取值是有限的,或可数的,可以用一维离散型随机变量来描述。

信源的数学模型就是离散型随机变量x的概率空间,表示为2.连续信源信源输出的是单个符号或代码的消息,但信源符号集的取值是连续的,可以用一维连续型随机变量来描述。

相应的信源的数学模型就是连续型随机变量的概率空间,表示为其中(a,b)是连续随机变量X的取值区间,R表示全实数集,而p(x)是连续随机变量X的概率密度函数。

2.1.3 离散信源的信息熵1.自信息自信息即为某事件a i发生所含有的信息量。

事件的自信息定义为式中P(a i)是事件a i发生的概率。

自信息的单位有几种:以2为底的对数时单位是比特(bit);以e为底的自然对数时单位是奈特(nat);以10为底的常用对数时单位是哈特(hart)。

2.信息熵离散随机变量X的信息熵就是其概率空间中每个事件所含有的自信息量的数学期望,即其单位是:以2为底的对数时是比特/符号(bit/symbol);以e为底的对数时是奈特/符号(nat/symbol);以10为底的对数时是哈特/符号(hart/symbol)。

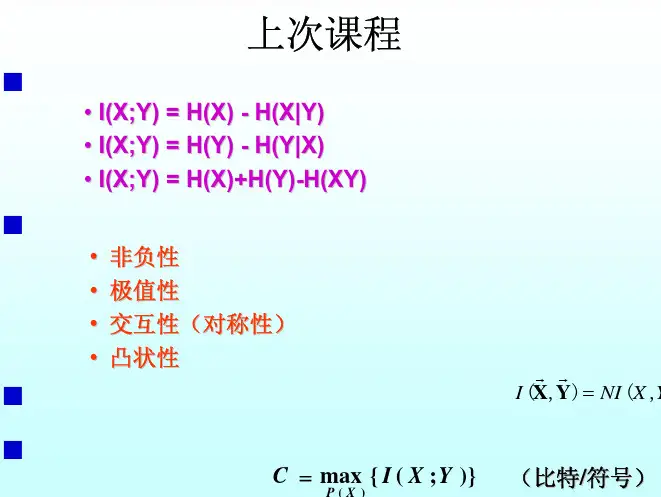

信息理论基础(第七讲)授课教师:于泽电子信息工程学院201教研室2粟傈37010703 docx李远宁docxbarry-hp docx付立37230131苏立焱362301133第三章离散信源内容提要3.1 信源的数学模型及其分类3.2 离散无记忆信源3.3 离散无记忆信源的扩展信源3.4 离散平稳信源3.5 马尔可夫信源3.6 信源的相关性和剩余度4m 时刻有限状态马尔科夫链⎧⎪⎪⎨⎪⎪⎩状态空间转移概率⎧⎪⎪⎨⎪⎪⎩基本转移概率p ij (m )k 步转移概率p (k )ij (m )k 步转移矩阵P ={p (k )ij (m )}齐次马尔科夫链(时齐马尔科夫链)基本转移概率同时刻m 无关(具有平稳转移概率矩阵)C-K 方程初始分布⎫⎪⎬⎪⎭()()()n m n m +=PP Pi 0()i i P X S p ==任意时刻系统的状态分布C-K方程初始分布⎫⎪⎬⎪⎭()()()n m n m+=P P P i()i iP X S p==任意时刻系统的状态分布平稳分布(极限分布)()lim nij j np p →∞=稳态分布存在定理⎧⎪⎪⎨⎪⎪⎩唯一性定理存在定理=W P WiNP中元素均大于零563.5.3 马尔可夫信源1. 状态信源输出符号的概率仅与已经输出的若干个符号有关,而与在前面的符号无关,称这若干个符号为信源的状态S i ,所有可能的状态集合S 称为状态空间{}12,,,mJ J q S S S ==S7{}()()121212112,,,,,,1,2,,m l l q ml l l l l l m x a a a a x x x x u a a a l l l q +⎧=∈⎪⎪⎪⎨=⎪⎪∈⎪⎩信源输出信源状态{}()()121212,,,,,,1,2,,m l l q l l l l m x a a a a u a a a l l l q ⎧=∈⎪⎨=∈⎪⎩信源输出符号在某一状态下信源状态,转入新状态u l+1=(a l1···a lm a l ),J=q m 个状态,m 称为马尔可夫信源阶数8X 1X i+1X 2X i X i+2S j X i-2S j-1X i-1…………S j+1S 2S 1…………121111()()()i i i i i j j j p X X X X p X S p S S +−−+−−==若信源随机状态序列服从马尔可夫链,则称该信源为马尔可夫信源三阶马尔可夫信源92. 马尔可夫信源满足下列条件的信源称为马尔可夫信源(1) 信源输出仅与当时状态有关(2) 信源状态由当时输出符号与前一时刻信源状态决定()()11|,;, |l k l j l j l i l k l j P x a u S x a u S P x a u S −−======= ()0101|,0l i l k l j i i P u S x a u S i i −=⎧====⎨≠⎩10m 阶马尔可夫信源的状态空间为其中,p (S i |S j )由信源符号条件概率确定,()12|mq i jS S S p S S ⎡⎤⎢⎥⎢⎥⎣⎦()112|m mi i i i p a a a a + ()()12112,1,2,,,,,,,,,,m m mi i i i q i j q a a a a a a a +∈∈11(3) 信源的极限熵当时间足够长时,遍历的m 阶马尔可夫信源可视为平稳信源其中,p (S j )是平稳分布()()|jj j s p S H X S =∑121111121lim (|)lim (|)(|)N N N N N m N m N N m m m H H X X X X H X X X X H X X X X H ∞−→∞−−+−→∞++==== 时齐性限制关联长度时齐性定义式1211111111111111,,,,(,,)log (|,,)(,,)(|)log (|)()(|)log (|)()(|)m m mm mm m m m m m ii i i i i i i i i i i i i i i i i i i i i S i i ip x x p x x x p x x p x s p x s p s p x s p x s p s H X s +++++++++=−=−==∑∑∑∑∑ 1m H +H (X|S j )是信源处于状态S j 时的条件熵X 的取值集()()()||log |jj i j i j SH X S p a S p a S =∑()12,,,q A a a a =13例设有一个二进制马尔可夫信源,其信源符号集为{0,1},条件概率为p (0|00)=p (1|11)=0.8p (1|00)=p (0|11)=0.2p (0|01)=p (0|10)=p (1|01)=p (1|10)=0.8信源符号个数q=2,故可能的状态为q m =22=4,S 1=00,S 2=01,S 3=10,S 4=11。

第1章 绪论1.1 信源、编码器、信道、干扰、译码器、信宿 1.2 香农1.3 通信系统模型1.4信号是消息的表现形式,是物理的,比如电信号、光信号等。

消息是信息的载荷者,是信号的具体容,不是物理的,但是又比较具体,例如语言、文字、符号、图片等。

信息包含在消息中,是通信系统中被传送的对象,消息被人的大脑所理解就形成了信息。

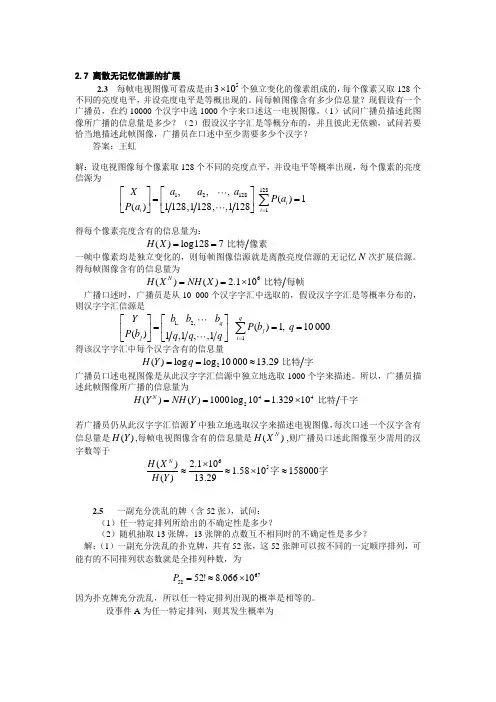

1.5 略第2章 信息的统计度量2.1 少2.2 y 的出现有助于肯定x 的出现、y 的出现有助于否定x 的出现、x 和y 相互独立 2.3 FTTTF 2.4 2.12比特2.5依题意,题中的过程可分为两步,一是取出一枚硬币恰好是重量不同的那一枚,设其发生的概率为1p ,由于每枚硬币被取出的概率是相同的,所以1181p =所需要的信息量()()1log 6.34I A p bit =-=二是确定它比其他硬币是重还是轻,设其发生的概率为2p ,则212p =总的概率12111812162p p p ==⨯=所需要的信息量()log log1627.34I p bit =-==2.6 设A 表示“大学生”这一事件,B 表示“身高1.60m 以上”这一事件,则()()()0.250.5|0.75p A p B p B A ===故()()()()()()|0.750.25|0.3750.5p AB p A p B A p A B p B p B ⨯====()()()11|loglog 1.42|0.375I A B bit p A B ===2.7 四进制波形所含的信息量为()log 42bit =,八进制波形所含信息量为()log 83bit =,故四进制波形所含信息量为二进制的2倍,八进制波形所含信息量为二进制的3倍。

2.8()()()()()()2322log 3log 32log 3 1.585I p bit I p bit I I =-=-==故以3为底的信息单位是比特的1.585倍。

通信原理试卷一1、如果系统满足理想低通传输特性,则频带利用率可以达到:a、1B/Hzb、1bit/Hzc、2B/Hzd、2bit/Hz2、一个均值为零的平稳高斯窄带噪声,它的包络一维分布服从a、高斯分布b、均匀分布c、瑞利分布d、莱斯分布3、模拟信号解调的“门限效应"有可能出现在_________信号的解调中:a、DSBb、AMc、PMd、SSB4、发端发送纠错码,收端译码器自动发现并纠正错误,传输方式为单向传输,这种差错控制的工作方式被称为:a、FECb、ARQc、IFd、HEC5、在“0”、“1"等概率出现情况下,以下哪种码能够直接提取位同步信号:a、单极性不归零码b、双极性归零码c、单极性归零码d、双极性不归零码6、无码间串扰的基带系统传输双极性信号时,误码率与信噪功率比ρ的关系为a、 b、 c、 d、7、平稳随机过程协方差函数C(τ)与自相关函数R(τ)和均值m的关系为:a、 b、 c、 d、8、以奈奎斯特速率进行抽样得到的以下抽样信号,仅用理想低通滤波器不可能将原始信号恢复出来的是.a、自然抽样b、曲顶抽样c、理想抽样d、平顶抽样9、由发送端发送专门的同步信息,接收端把这个专门的同步信息检测出来作为同步信号的方法,被称为:a、外同步法b、自同步法c、位同步法d、群同步法10、连贯式插入法中的群同步保护,在维持态时通常要求:a、判决门限提高,漏同步概率提高b、判决门限降低,漏同步概率提高c、判决门限提高,漏同步概率降低d、判决门限降低,漏同步概率降低11、设x(t)为调制信号,调相波的表示式为:,则PM调制方式的瞬时角频率偏差为:a、 b、 c、 d、12、码长n=7的汉明码,监督位应是:a、2位b、3位c、4位d、5位13、如果在已知发送独立的符号中,符号“E”出现的概率为0.125,则符号“E”所包含的信息量为:a、1bitb、2 bitc、3 bitd、4 bit二、填空题(1分/空)1、已知二进制数字信号每个码元占有的时间为1ms,0、1码等概率出现,则码元速率为__________,信息速率为__________;2、从信息传输角度来看,数字通信系统的主要质量指标是__________和__________.3、高斯白噪声是指噪声的概率密度服从__________分布,功率谱密度服从__________分布。

离散信源的分类和数学模型离散⽆记忆信源的熵1.离散信源的分类和数学模型 在离散时间发出离散符号的信源称为离散信源。

如果信源符号集为有限集,则称为有限离散信源。

如果信源符号集为⽆限可数集,则称为⽆限离散信源。

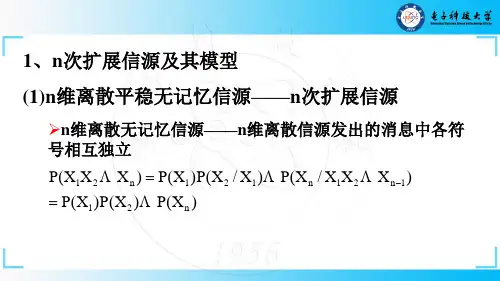

离散⽆记忆信源的N次拓展源:设信源为X,则由X构成的N维随机⽮量集合X N = X1X2X3...X N(其中X i与X同分布),称为信源X的N次扩展源。

2.离散⽆记忆信源的熵 2.1离散平稳信源若具有有限符号集A={a1,a2,a3,...,a n}的信源X产⽣的随机序列{x i},i=...1,2...且满⾜:对所有的i1,i2,...i n,h,j1,j2,...,j n及x i ε X,有p(x i1=a j1,x i2=a j2,x i3=a j3,...x i N=a jN) = p(x i1+h=a j1,x i2+h=a j2,...,x in+h=a jn)则称信源为离散平稳信源,所产⽣的序列为平稳序列。

平稳序列的统计特性与时间的推移⽆关,即序列中符号的额任意维联合概率分布与时间起点⽆关。

2.2离散平稳有记忆信源的熵设X为离散平稳有记忆信源,X的N次扩展源记为X N, X N=X1X2X3...X N. 根据熵的可加性,有H(X N)=H(X1X2X3...X N)=H(X1)+H(X2|X1)+...+H(X N|X1...X N-1) 定理1:对任意离散平稳信源,若H1(X)<∞,有以下结论:(1)H(X N|X1...X N-1)不随N⽽增加;(2)H N(X)≥H(X N|X1...X N-1); (3) H N(X)不随N⽽增加;(4)H∞(X)存在,且H∞(X)=limH(X N|X1...X N-1); 式(4)表明,有记忆信源的符号熵也可以通过计算极限条件熵得到。

3.有限状态马尔可夫链 3.1马⽒链的基本概念 设信源的符号集为{a1,a2,..,a q},信源的输出序列为x1,x2,...,x N,如果其中每个随机变量x n仅通过最接近的变量x n-1依赖于过去的随机变量x n-1,x n-2,...,即对所有的i,j,k,...有p(x n=j|x n-1=i,x n-2=k,...,x0=m ) = p(x n=j|x n-1=i) 则称{x n,n≥0}为马尔可夫链,简称马⽒链。