利用赛门铁克veritas SFHA技术实现双机集群架构案例

- 格式:doc

- 大小:388.50 KB

- 文档页数:3

赛门铁克大集群方案一、前言传统方式的集群系统,通常是1+1的方式(或者成为主备方式),即一台服务器运行正常的业务系统,称为主机;另外一台服务器做为备机,平常不做业务;当主机发生故障的时候,备机接管主机的任务。

所以,往往将之称为双机系统(示意图如下)。

上述传统的集群系统(或者双机系统),消除了服务器单点故障,一定程度上提高了系统可用性,但是其不足之处也较明显:∙可靠性不高。

在其中一台发生故障期间,业务将运行在高风险中。

∙服务器资源利用率低。

1+1集群方式很有可能使得每个业务系统都需要两台服务器。

∙存储资源利用率低。

1+1集群无法利用目前光纤存储网络的共享优势。

∙无法实现节能减排目标。

1+1集群方式因为服务器数量和相应的设备数量都很多,功耗和产生热量很高,对于企业实现节能减排目标非常不利。

∙采购费用高。

∙维护困难。

管理员需要管理数量众多独立的1+1集群。

随着集群技术水平的提高,多服务器集群(或者称为大集群)方案得到了大多数用户的认可,并在生产中大规模应用。

二、大集群方案简介多服务器集群,有多种结构,简介如下:∙N to 1结构:特点是多台主服务器共用一台专用备机。

任何一台主机发生故障,其业务系统都切换到专用备机。

主机修复后,在维护时间将备机上的业务系统切换回原主机。

示意图如下。

∙N + 1结构:特点与上述方式类似,但是不使用专用备机。

任何一台主机发生故障,其业务系统都切换到备机。

主机修复后即作为备机。

示意图如下。

∙N to N结构:特点是所有的服务器都作为主机,没有备机。

当某主机发生故障后,切换到另外一台主机。

主机修复后,在维护时间视实际情况将部分业务切换回该主机。

前提是每台主机都有一定的计算能力冗余。

示意图如下。

举个例子,以往支持15个业务系统,可能需要30台服务器(按照1+1集群方式计算)。

使用大集群后,可以采用15+2或者15to2结构,大大减少服务器数量,真正实现了节能减排目标。

不光是减少了采购服务器的费用,更重要的是管理员现在只要管理一个集群就可以处理所有的业务系统高可用问题,大大降低了管理难度。

Veritas Cluster Server for Oracle双机热备的配置-概述将Oracle的双机放在DB2双机后面讲有两个原因:一是DB2的配置相对于oracle的配置来说比较简单,数据库的模式也比较容易理解,从简单的开始了解有利于用户的学校,而其中相似的地方用户可以参照DB2的配置;二是DB2双机的配置,也只能说是oracle双机配置的子集,用户在学习了DB2的双机之后,oracle双机配置的很多相似的地方简单说明一下即可,不会让用户感觉到重复,但是用户可以比较一下这两种模式的异同,有利于用户选择更合适自己的双机配置模式。

将sybase放在最后并不是因为它更复杂,而是它在这三个数据库之中,用户相对比较少,需要的人不多。

-DB2与Oracle数据库的对比DB2和Oracle有很多的不同,要想了解清楚,那个不是一朝一夕的功夫了。

幸运的是,因为我们现在只是需要做双机配置,所以我们只是在可能会影响配置的概念上,做一个简单的比较。

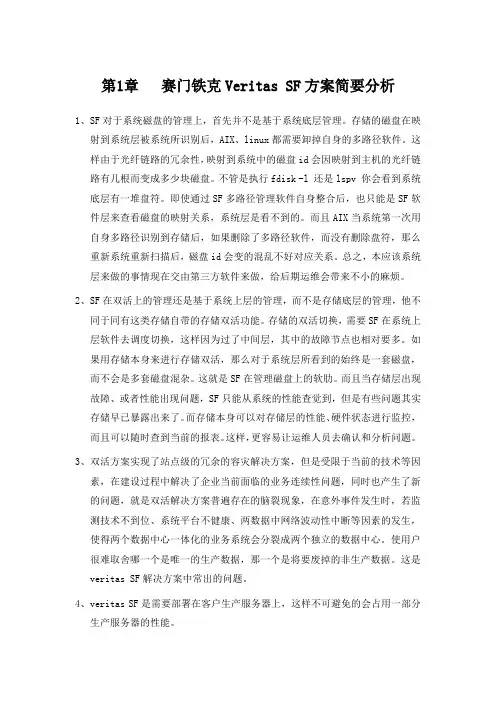

1.配置结构的不同:DB2数据库的双机热备只支持一种模式,就是DB2的程序在两台机器上各有一份,只有数据文件存放在共享存储中,如下图所示:图1,DB2双机配置结构图这种配置模式的优点是有利于数据库的升级,当其中systemA需要升级的时候,就把服务切换到systemB上运行,升级A的DB2程序,之后还可以把服务切换回到A来,然后升级B的DB2程序。

这个升级过程不会影响用户的DB2使用,因为总有一台机器可以使用DB2程序来响应用户的服务请求。

对于oracle来说不但可以支持这种程序存放在不同机器上的做法,而且支持把oracle的程序文件也同时放在共享盘上,其结构图如下所示:图2,oracle双机结构图-程序在各个服务器上图3,oracle双机结构图-程序和数据都在共享盘上将数据与程序同时放在共享盘上的优点有两个:一是节省磁盘空间,用户只需要保留一份数据库备份;二是有利于程序的一致性,不会因为数据库版本的不同,产生差异,可以避免产生一些莫名的问题。

第1章赛门铁克Veritas SF方案简要分析1、SF对于系统磁盘的管理上,首先并不是基于系统底层管理。

存储的磁盘在映射到系统层被系统所识别后,AIX、linux都需要卸掉自身的多路径软件。

这样由于光纤链路的冗余性,映射到系统中的磁盘id会因映射到主机的光纤链路有几根而变成多少块磁盘。

不管是执行fdisk -l 还是lspv 你会看到系统底层有一堆盘符。

即使通过SF多路径管理软件自身整合后,也只能是SF软件层来查看磁盘的映射关系,系统层是看不到的。

而且AIX当系统第一次用自身多路径识别到存储后,如果删除了多路径软件,而没有删除盘符,那么重新系统重新扫描后,磁盘id会变的混乱不好对应关系。

总之,本应该系统层来做的事情现在交由第三方软件来做,给后期运维会带来不小的麻烦。

2、SF在双活上的管理还是基于系统上层的管理,而不是存储底层的管理,他不同于同有这类存储自带的存储双活功能。

存储的双活切换,需要SF在系统上层软件去调度切换,这样因为过了中间层,其中的故障节点也相对要多。

如果用存储本身来进行存储双活,那么对于系统层所看到的始终是一套磁盘,而不会是多套磁盘混杂。

这就是SF在管理磁盘上的软肋。

而且当存储层出现故障、或者性能出现问题,SF只能从系统的性能查觉到,但是有些问题其实存储早已暴露出来了。

而存储本身可以对存储层的性能、硬件状态进行监控,而且可以随时查到当前的报表。

这样,更容易让运维人员去确认和分析问题。

3、双活方案实现了站点级的冗余的容灾解决方案,但是受限于当前的技术等因素,在建设过程中解决了企业当前面临的业务连续性问题,同时也产生了新的问题,就是双活解决方案普遍存在的脑裂现象,在意外事件发生时,若监测技术不到位、系统平台不健康、两数据中网络波动性中断等因素的发生,使得两个数据中心一体化的业务系统会分裂成两个独立的数据中心。

使用户很难取舍哪一个是唯一的生产数据,那一个是将要废掉的非生产数据。

这是veritas SF解决方案中常出的问题。

赛门铁克数据保护新产品发布会在京召开

佚名

【期刊名称】《铁路计算机应用》

【年(卷),期】2005(14)9

【摘要】2005年8月30日,赛门铁克公司在京召开以“超越备份无所畏惧”为主题的巡展,介绍数据保护新产品VERITAS NetBackupTM6.0。

会上,该公司对当今企业存储所面临的问题和用户需求、技术趋势、NetBackupTM6.0的新特点以及用户案例作了讲解。

NetBackup Operations Manager的主要功能包括。

【总页数】1页(P55-55)

【关键词】赛门铁克公司;新产品发布会;数据保护;NetBackup;VERITAS;Manager;用户需求;企业存储;技术趋势

【正文语种】中文

【中图分类】TP393.08;TP391.7

【相关文献】

1.生态家纺绿色革命海兴生物质舒弹丝创新产品新闻发布会在京召开 [J], 雷蕾

2.科技,让城市更清洁--中交西筑在京召开2014环保、养护新产品发布会 [J], 苏红云;胡晓雯

3.天空卫士2016年新产品新技术发布会在京隆重召开 [J],

4.天空卫士2016新产品发布会在京召开 [J], ;

5.打破技术垄断,共创英雄事业天空卫士2016年新产品新技术发布会在京隆重召开 [J], 李近

因版权原因,仅展示原文概要,查看原文内容请购买。

Veritas Cluster Serve for DB2 agent双机互备配置(高级)本文的读者在阅读本文之前,应该先阅读《Veritas Cluster Server for DB2双机热备的配置》一文,了解到DB2双机热备的基本原理和配置方法。

本文针对的是DB2的高级需求-大规模并行处理(Massively Parallel Processing, MPP)-环境下,用户如何利用VCS配置双机互备环境。

MPP简介首先介绍一下DB2的大规模并行处理(MPP)的含义。

MPP其实就是多台计算机协同工作,共同完成同一个任务,目的就是为了能够使用一些比较廉价的服务器一起工作,提供给用户单机无法完成的服务。

而双机互备就是指当这些机器中的某一天出现故障的时候,其他的服务器可以接管运行在其上的服务请求,保证服务的高可用性。

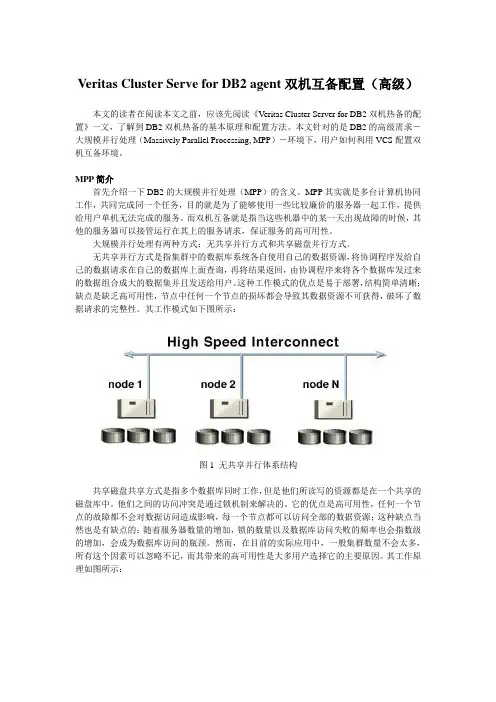

大规模并行处理有两种方式:无共享并行方式和共享磁盘并行方式。

无共享并行方式是指集群中的数据库系统各自使用自己的数据资源,将协调程序发给自己的数据请求在自己的数据库上面查询,再将结果返回,由协调程序来将各个数据库发过来的数据组合成大的数据集并且发送给用户。

这种工作模式的优点是易于部署,结构简单清晰;缺点是缺乏高可用性,节点中任何一个节点的损坏都会导致其数据资源不可获得,破坏了数据请求的完整性。

其工作模式如下图所示:图1 无共享并行体系结构共享磁盘共享方式是指多个数据库同时工作,但是他们所读写的资源都是在一个共享的磁盘库中。

他们之间的访问冲突是通过锁机制来解决的。

它的优点是高可用性,任何一个节点的故障都不会对数据访问造成影响,每一个节点都可以访问全部的数据资源;这种缺点当然也是有缺点的:随着服务器数量的增加,锁的数量以及数据库访问失败的频率也会指数级的增加,会成为数据库访问的瓶颈。

然而,在目前的实际应用中,一般集群数量不会太多,所有这个因素可以忽略不记,而其带来的高可用性是大多用户选择它的主要原因。

用Veritas i3驾驭复杂性——赛门铁克前瞻式性能管理方案穆兰

【期刊名称】《中国金融电脑》

【年(卷),期】2006(000)009

【摘要】近日,全球解决方案领导厂商赛门铁克面向中国市场适时推出赛门铁克数据中心基础架构Symantec Data Center Foundation,旨在支持核心IT服务管理进程。

该集成解决方案主张企业数据前瞻式控制、降低成本、提高服务级别标准化,是唯一可以使企业跨异构应用程序、数据库、服务器和存储平台对一致软件基础结构进行标准化的解决方案。

【总页数】1页(P83)

【作者】穆兰

【作者单位】无

【正文语种】中文

【中图分类】TP311.56

【相关文献】

1.VERITAS I3助力浙江移动BOSS系统性能管理 [J], VERITAS软件公司

2.基于Symantec I3实现面向应用的性能管理 [J], 李小庆

3.驾驭复杂性前瞻式性能管理——赛门铁克Veritas i3 APM方案 [J], 袁萌

4.驾驭复杂性前瞻式性能管理——赛门铁克Veritas i3 APM方案 [J],

5.驾驭数据中心的复杂性Veritas NetBackup加强数据保护 [J],

因版权原因,仅展示原文概要,查看原文内容请购买。

Symantec sfs5.5安装报告赛门铁克软件(北京)有限公司四川分公司2011-4-29Your Infrastructure. Your Information. Your Interactions. Only Symantec Protects Them All.索引目录1. 安装cluster中的第一个节点filestore1 (5)2. 安装cluster中的第二个节点filestore2 (21)3. 把第二个节点增加进cluster (25)环境准备:节点名及物理ip起始范围:Filestore1: 192.168.0.10/24Filestore2: 192.168.0.11/24物理服务器:192.168.0.100网卡:为每个filestore节点配置四张网卡,前两张为私有网卡,后两张为公有网卡。

公有网卡和私有网卡不在同一个vmnet里面。

如下图:使用vmware network editor主节点的前两张网卡(私有网卡)把dhcp功能禁用(去掉VMnet1的host_only下面对应的“Use local DHCP service to distribute ip Adapter VMnet1"前面的勾),以便其他节点从网络启动安装sfs时使用主节点的公有网卡的dhcp功能来得到ip地址。

软件介质:安装目的:为了对sfs5.5的相关功能及性能进行测试。

1. 安装cluster中的第一个节点filestore1 选择菜单栏的”file”->”new”->“virtual machine”进入欢迎界面,选择定制安装:选择虚拟机平台兼容性:选择filestore的安装介质:输入虚拟机名字及文件放置位置:选择虚拟机cpu及核的个数:指定虚拟机内存:指定网络连接方式为host_only:选择创建一个新的磁盘:指定磁盘大小(50G)及磁盘空间分配方式,如果磁盘空间太小会在安装过程出错。

XXX公司企业备份管理系统设计方案目录一.项目概述 (1)二.系统需求分析 (2)2.1、系统现状分析 (2)2.2、备份管理目的 (2)三.备份系统的设计方案 (3)3.1、系统设计原则 (3)3.2、备份架构设计 (3)3.3、备份架构说明 (4)3.4、备份软件配置及管理界面说明 (4)3.5、NBU产品简单介绍 (5)3.6、NBU基本概念 (6)3.7、NBU一些配置策略 (6)四.灾难恢复计划 (8)4.1、灾难恢复的意义 (8)4.2、灾难恢复的方式 (8)一.项目概述Xxx公司将会根据A公司的网络实际需求制定一套完整的数据备份,灾难恢复方案。

一个完整的企业数据备份与恢复解决方案就意味着:安全、性能与完美的集成;一条龙式的服务,包括产品的选择、服务与支持。

我们在选择备份系统时,既要做到满足系统容量不断增加的需求,又需要所用的备份软件能够支持多平台系统。

要做到这些,就要充分使用网络数据存储管理系统,在分布式网络环境下,通过专业的数据备份管理软件,结合相应的硬件和存储介质,对网络式的数据备份进行集中管理,从而实现自动化的备份、数据分级存储及灾难恢复等。

我公司的企业数据备份和恢复解决方案以Symantec的Veritas Netbackup备份管理软件为基础,结合我公司多年来对各行业顶尖公司的服务支持经验,结合客户实际的业务发展与IT系统结构现状,帮助客户把重要的企业数据做备份保护,以防不测。

确保企业的业务连续性,使企业的IT系统能够充分满足企业战略发展的能力要求。

二.系统需求分析2.1、系统现状分析A公司的网络基础结构是基于Windows和UNIX平台,现在已经拥有超过N台PC服务器,N台存储,一台小型机等。

A公司的网络核心应用包括了电子邮件、数据库服务器、文件服务器、域控制器等企业信息管理系统,为企业的发展提供了强有力的信息化支持。

主要数据库包括了Microsoft SQL、Exchange、Oracle和Active Directory 。

Oracle与赛门铁克-Veritas采用共同认证为响应客户对Oracle坚不可摧Linux计划(Oracle Unbreakable Linux) 支持程序不断增长的需求,Oracle与赛门铁克共同宣布对使用Oracle Enterprise Linux 的V eritas 数据中心软件进行认证。

该认证将帮助在Linux上运行赛门铁克软件的企业缩短部署时间并降低实施成本。

Oracle坚不可摧Linux计划于2006 年推出,旨在帮助推动Linux 在企业中的采用,该软件为客户提供了业界领先的全球Linux 支持。

Oracle Enterprise Linux 是Oracle坚不可摧Linux计划程序的一项功能,可与Red Hat Enterprise Linux 完全兼容。

凭借此次最新认证,在Oracle Enterprise Linux上部署使用Veritas 解决方案的Oracle坚不可摧Linux计划支持客户将会从这两个厂商获得企业级支持。

该认证涵盖了以下六款Veritas 数据中心软件产品:Veritas Storage Foundation 5.0;Veritas Storage Foundation for Oracle 5.0;Veritas Storage Foundation Cluster File System 5.0;Veritas Cluster Server 5.0、Veritas NetBackup 6.0 Client and Veritas i3。

Oracle Linux 工程副总裁Wim Coekaerts 表示:“我们正在扩展与业界领先者的合作,以简化Linux 在企业内的采用、开发及部署。

Oracle坚不可摧Linux计划支持程序一直表现了强大的发展势头。

采用Linux 的企业客户想要充分利用企业级存储管理及高可用性流程与标准,而这也正是他们UNIX 环境的支柱。

一个VERITAS集群服务器的应用实例——北航SAP航材系统高可用性方案的实现邓曙康中国南方航空集团北方公司信息中心摘要北航SAP航材系统的实施是南航集团北方公司在航材管理ERP之路上迈出的重要一步。

应用的关键性决定了实施高可用性方案的必要性。

本文介绍了北航SAP系统的VCS方案和具体实现方法。

主要有以下内容:⑴简介现有的集群方式,及本方案集群方式和软件的选择原因;⑵阐述VCS集群内资源的具体配置方法;⑶使用shell脚本实现对SAP R/3应用启停的控制,满足特定的系统管理需求。

关键词高可用性(HA) Veritas Cluster Server agent 服务组1引言今天,大型企业的运行管理和业务操作与信息系统的结合越来越紧密,对应用和数据的可靠性要求也越来越高,高可用性(HA)已经成为企业级关键应用解决方案中不可缺少的部分。

北航SAP航材系统是企业资源计划(ERP)应用于航空公司的一个实例,它采用了SAP R/3软件的财务会计(FI)、物料管理(MM)、销售和分销(SD)、设备维护(PM)四个模块,为航材存货订货和资金周转提供了管理平台,对机务维修和安全飞行起着重要的保障作用。

如何将高可用性方案和北航SAP系统架构特点融合在一起,既能实现对包括SAP R/3在内的所有应用的保护,又能满足特定的系统管理需求,是这一方案要解决的主要问题。

2HA方案概述2.1 方案选择集群系统和相应的冗余配置是实现系统保护的主要方式。

集群系统可分为以下几种。

●共享数据,共享磁盘(Shared-data Cluster):当节点切换时备用节点会接管原来的磁盘和数据。

包括切换式和并行式。

●共享数据,不共享磁盘(Replicated-Data Cluster):采用复制技术将数据复制到另外的磁盘上,对承载数据的磁盘实现了冗余。

只包括切换式。

●不共享数据:当主节点故障后,备用节点的应用程序采用另外的不同数据。

包括切换式和并行式。

Symantec 在Windows双机热备环境下数据备份和灾难备份方案建议书上海软盛信息技术有限公司上目录第1章方案背景1.1 用户目前数据环境及需求1.2 用户目前数据备份环境和存在的问题第2章设计方案2.1 设计原则2.2 方案的设计2.3 Backup Exec 产品及模块介绍第3章用户双机集群VSS数据备份和操作系统灾难备份所需的模块第一章方案背景1.1 用户目前数据环境及需求根据提供的信息,目前用户的系统环境如下描述:操作系统:Windows 操作系统关键数据:VSS数据库现在用户要备份的服务器为2台VSS服务器做双机热备集群,整个系统对于备份的要求:备份系统稳定可靠,保证随时能够备份/还原关键数据;对服务器有灾备的考虑,操作系统崩溃时能通过灾难备份快速恢复操作系统。

同时考虑远期建设目标平滑过渡,避免重复投资。

1.2 用户目前备份状态和存在的问题目前用户双机服务器拓扑图如下用户目前在主机上连接了一台磁带机,通过Windows 自带的备份软件把数据备份到磁带中。

这样的备份方式存在以下问题:1、由于Windows 自带备份软件不支持Open File 热备份,无法对正在使用的VSS数据进行备份,造成只有在深夜夜无人使用VSS数据的时候,才能进行备份,给IT工作带来很大的不便2、由于磁带机是接在主机上的,当主机出现故障,VSS切换到辅机运行的时候,就无法对VSS数据进行备份。

3、Windows自带备份软件无法设定备份计划和策略,让服务器自动按时备份数据。

4、无法对服务器操作系统进行灾难备份,当服务器操作系统崩溃时,无法快速恢复。

第2章设计方案2.1 设计原则根据上述问题建议的备份方案应该遵循以下原则:备份系统应该支持Open File 热备份功能磁带机连接在专用的备份服务器上、对双机集群中的2台机器都能进行数据备份备份软件支持定时计划备份备份软家支持服务器灾难备份备份软件提供网络集中备份功能,能集中备份网络上其余Exchange 、SQL Server或文件数据,提供良好的扩展性2.2 方案的设计依据上述设计原则,建议采用Symantec BACKUP EXEC 专业备份软件安装在一台备份服务器上,通过网络对双机VSS系统进行数据备份和操作系统灾难备份。

杭州环境监测中心站灾备系统技术方案聚光科技(杭州)股份有限公司4/26/2022目录第1章综述 (1)1.1项目背景 (1)1.2系统现状 (1)1.2.1现有系统环境 (1)1.2.2现有系统分析 (2)1.3面临的挑战 (3)1.4系统建设原则 (3)第2章需求分析 (4)2.1备份需求 (4)第3章技术方案 (5)3.1备份系统架构设计 (5)3.1.1系统架构说明 (6)3.1.2软件配置说明 (8)3.2备份和恢复方式 (8)3.3备份策略规划 (10)3.4方案技术特点 (10)3.4.1介质服务器负载均衡/切换 ............................................. 错误!未定义书签。

3.4.2智能磁盘容量管理........................................................... 错误!未定义书签。

3.4.3可选择用户恢复与复制的介质服务器........................... 错误!未定义书签。

3.4.4存储生命周期策略........................................................... 错误!未定义书签。

3.4.5真实镜像恢复(True Image Restore) ........................... 错误!未定义书签。

3.4.6合成全备份....................................................................... 错误!未定义书签。

第4章方案优势总结 (11)综述项目背景环境监测经过数年的向数字化,信息化方向的发展后,如何安全保存和有效利用日益增多的环境监测数据,成为了现阶段需要解决的问题。

杭州市环境监测中心站对于环境监测数据的保存给予了更多的重视。

1

利用赛门铁克veritas SFHA 技术实现

双机集群架构案例

一、系统拓扑结构: A 机

IBM P750B 机IBM P750

FC SWITCH1FC SWITCH1

磁盘阵列1

IBM-DS5100磁盘阵列2IBM-DS5100

(一)环境描述

两台IBM P750 小型机,其中A 机和B 机组成一个Oracle Rac ,两个存储上划分同等Lun 。

(二)SFRAC 功能

1.通过底层VXVM 功能,实现两个盘柜的镜像(Mirror ),保证在一个阵列出现down 机,损坏等情况下保证应用的可用;

2.通过文件系统CFS ,提供Oracle 的并行操作,到达Oracle RAC 的功能。

3.设置IO Fencing 功能,防止因心跳线断掉,而出现的脑裂情况。

二、详细功能:

(一)镜像功能

赛门铁克

Storage Foundation 采用独特的镜像双写技术,构造全冗余的存储高可用架构,在存储层面实现“HA ”,当一个存储发生硬件故障时,业务系统主机会自动采用另一个镜像存储提供数据,核心业务丝毫不受影响。

另外,当生产存储性能下降到一定程度时,Storage Foundation 会自动断掉主机与生产存储的连接,直接读取镜像存储数据,使业务应用性能免受生产存储性能的恶劣影响。

而且Storage Foundation 能够实现异构存储之间的高可用HA ,最大限度避免来自同构同型号存储的Bug 并发影响。

该技术彻底消除核心业务系统的存储单故障点,减少业务中断风险,有效加固存储层面的高可用性,减少意外停机时间。

(二)DMP动态多路径

DMP(Dynamic):采用Symantec DMP组件(动态多路径)实现主机对存储的多路径读写;在 I/O 路径出现故障时,确保可以访问存储设备,保证数据的可用性;通过I/O路径优化算法改进I/O 性能。

其主要功能如下:

1.光纤多通道的Fast failover 快速切换;

2.I/O 路径优化,提供六种算法:平衡路径,循环,最小队列长度,自适应,优先级,单个活动路径;

3.自动发现光纤路径;

4.动态监测多路径的状态;

5.异构环境支持,支持所有主流的磁盘阵列。

(三)IO fencing

多块仲裁盘:仲裁盘的冗余,同时多个仲裁盘的机制可以保证多数节点集群存活。

I/O Fencing技术,磁盘仲裁技术的高级应用,防止Panic集群再次造成脑裂或破坏数据。

(无需额外的硬件或软件代理).建议基数磁盘。

(四)Cluster File System

CFS(Cluster File System):通过部署CFS,将相同的文件系统同时MOUNT 到多个节点上,实现双中心三个数据库节点同时共享文件系统。

1.CFS 体系结构

SF Oracle RAC 使用 CFS 管理大型数据库环境中的文件系统。

由于 CFS 是VxFS 的扩展,所以它以类似的方式运行并在内存(通常称为缓冲区高速缓存或vnode 缓存)中缓存元数据和数据。

CFS 使用称为 Global Lock Manager (GLM) 的分布式锁机制确保所有节点都具有一致的文件系统视图。

GLM 通过协调对文件系统元数据(如 inode 和空闲列表)的访问,实现跨节点的元数据和缓存的一致性。

GLM 的角色是基于每个文件系统进行设置,以实现负载平衡。

CFS 涉及主要/辅助体系结构。

集群中的一个节点是文件系统的主节点。

虽然任何节点都可以启动操作来创建、删除数据或调整大小,但仅 GLM 主节点执行实际操作。

创建文件之后,GLM 主节点会为了保持多个节点中数据的一致性而提供锁。

例如,如果节点尝试修改文件内的某个块,则它必须获取独占锁,以确保其他可能缓存了相同文件的节点的缓存副本失效。

SF Oracle RAC 配置尽量减少了对 GLM 锁定的使用。

Oracle RAC 通过 ODM 接口访问文件系统并处理自己的锁定,只有 Oracle(而不是 GLM)才缓冲数据并协调对文件的写入操作。

单点锁定和缓冲可确保实现最佳性能。

仅当文件的元数据发生更改时(如创建和调整大小操作期间),才涉及 GLM 锁定。

2.CFS 文件系统的优点

在 VxFS 中适用的多种功能在 SF Oracle RAC 环境中不起作用,因为 ODM 负责此类功能。

CFS 为 VxFS 增加了高可用性、一致性和可伸缩性及集中管理等功能。

在SF Oracle RAC 环境中使用 CFS 具有下列优点:

■增强了可管理性,包括易于创建和扩展文件

如果没有 CFS,您必须为 Oracle 提供固定大小的分区。

而使用 CFS,则可以动态扩充文件系统以满足未来的需求。

■减少了用户错误的发生率

原始分区不可见,因此管理员可能会因误将文件系统放置到这些分区上而对其造成损害。

Oracle 中没有任何机制可防止此类错误。

■数据中心一致性

如果有原始分区,则您只能使用特定于 RAC 的备份策略。

CFS 允许您通过数据中心实施备份策略。

(五)Veritas Cluster Server

Veritas Cluster Server (VCS) 通过控制组件层的启动和关闭,以及提供监视功能和故障通知功能来指示 SF Oracle RAC 操作。

在典型 SF Oracle RAC 配置中,VCS 的 Oracle RAC 服务组作为“并行”服务组而不是“故障转移”服务组运行;发生故障之后,VCS 不会尝试迁移发生故障的服务组。

相反,可以使用该软件将该服务组配置为在发生故障时重新启动。

VCS 体系结构

高可用性后台驻留程序 (HAD) 是运行在每个节点上的主 VCS 后台驻留程序。

HAD跟踪集群配置中的变化并通过 GAB 和 LLT 通信来监视资源状态。

HAD 使用代理管理所有应用程序服务,这些代理是已安装的程序,用于管理资源(特定的硬件或软件实体)。

VCS 体系结构设计具有可扩展性和高效率的特点。

HAD 不需要了解如何启动 Oracle或受 VCS 控制的任何其他应用程序。

相反,可以添加代理来管理不同资源,且不会对该引擎 (HAD) 产生任何影响。

代理仅与本地节点上的 HAD 通信,而 HAD 通过与其他节点上的 HAD 进程通信来交流状态信息。

由于代理不需要在系统间通信,所以 VCS 能够最大限度地减少集群互联上的通信量。

SF Oracle RAC 为 VCS 提供了特定代理,用于管理 Oracle Grid Infrastructure 和数据库(包括实例)等 CVM、CFS 和 Oracle 组件。