MATLAB实现FCM 聚类算法

- 格式:pdf

- 大小:431.30 KB

- 文档页数:8

23.模糊聚类剖析原理及实现聚类剖析,就是用数学方法研究和办理所给定对象,依据事物间的相像性进行区分和分类的过程。

传统的聚类剖析是一种硬区分,它把每个待识其他对象严格地区分到某个类中,拥有非此即彼的性质,这种分类的类型界线是分明的。

跟着模糊理论的成立,人们开始用模糊的方法来办理聚类问题,称为模糊聚类剖析。

因为模糊聚类获得了样本数与各个类其他不确立性程度,表达了样本类属的中介性,即成立起了样本关于类其他不确立性的描绘,能更客观地反应现实世界。

本篇先介绍传统的两种(适合数据量较小情况,及理解模糊聚类原理):鉴于择近原则、模糊等价关系的模糊聚类方法。

(一)预备知识一、模糊等价矩阵定义 1 设 R=(r ij )n×n为模糊矩阵, I 为 n 阶单位矩阵,若R 知足i)自反性: I≤R (等价于 r ii =1);ii)对称性: R T=R;则称 R 为模糊相像矩阵,若再知足niii) 传达性: R2≤R(等价于( r ik r kj ) r ij)k1则称 R 为模糊等价矩阵。

定理 1 设 R 为 n 阶模糊相像矩阵,则存在一个最小的自然数k(k<n), 使得 R k为模糊等价矩阵,且对全部大于k 的自然数 l,恒有R l=R k. R k称为 R 的传达闭包矩阵,记为 t(R).二、模糊矩阵的λ-截矩阵定义 2 设 A=(a ij)n×m为模糊矩阵,对随意的λ∈[0,1], 作矩阵Aa ij( )n m此中,a ij( )1,aij 0,aij称为模糊矩阵 A 的λ-截矩阵。

明显,Aλ为布尔矩阵,且其等价性与与A一致。

意义:将模糊等价矩阵转变为等价的布尔矩阵,能够获得有限论域上的一般等价关系,而等价关系是能够分类的。

所以,当λ在[0,1]上改动时,由 Aλ获得不一样的分类。

若λ1<λ2,则Aλ1≥Aλ2,进而由Aλ2 确立的分类是由Aλ1 确立的分类的加细。

当λ从 1 递减变化到 0 时,Aλ的分类由细变粗,渐渐合并,形成一个分级聚类树。

在Matlab中使用模糊C均值聚类进行图像分析的技巧在图像分析领域,模糊C均值聚类(FCM)是一种常用的工具,它可以帮助我们发现图像中隐藏的信息和模式。

通过使用Matlab中的模糊逻辑工具箱,我们可以轻松地实现FCM算法,并进行图像分析。

本文将介绍在Matlab中使用FCM进行图像分析的技巧。

首先,让我们简要了解一下FCM算法。

FCM是一种基于聚类的图像分割方法,它将图像的像素分为不同的聚类,每个聚类代表一类像素。

与传统的C均值聚类算法不同,FCM允许像素属于多个聚类,因此能够更好地处理图像中的模糊边界。

在Matlab中使用FCM进行图像分析的第一步是加载图像。

可以使用imread函数将图像加载到Matlab的工作区中。

例如,我们可以加载一张名为“image.jpg”的图像:```matlabimage = imread('image.jpg');```加载图像后,可以使用imshow函数显示图像。

这可以帮助我们对图像有一个直观的了解:```matlabimshow(image);```接下来,我们需要将图像转换为灰度图像。

这是因为FCM算法通常用于灰度图像分析。

可以使用rgb2gray函数将彩色图像转换为灰度图像:```matlabgrayImage = rgb2gray(image);```在使用FCM算法之前,我们需要对图像进行预处理。

预处理的目的是消除图像中的噪声和不必要的细节,从而更好地提取图像中的特征。

常用的图像预处理方法包括平滑、锐化和边缘检测等。

Matlab中提供了许多图像预处理函数。

例如,可以使用imnoise函数向图像中添加高斯噪声:```matlabnoisyImage = imnoise(grayImage, 'gaussian', 0, 0.01);```还可以使用imfilter函数对图像进行平滑处理。

常见的平滑方法包括均值滤波和高斯滤波:```matlabsmoothImage = imfilter(noisyImage, fspecial('average', 3));```一旦完成预处理步骤,我们就可以使用模糊逻辑工具箱中的fcm函数执行FCM算法。

模糊c均值聚类FCM算法的MATLAB代码我做毕业论文时需要模糊C-均值聚类,找了好长时间才找到这个,分享给大家:FCM算法的两种迭代形式的MA TLAB代码写于下,也许有的同学会用得着:m文件1/7:function [U,P,Dist,Cluster_Res,Obj_Fcn,iter]=fuzzycm(Data,C,plotflag,M,epsm)% 模糊C 均值聚类FCM: 从随机初始化划分矩阵开始迭代% [U,P,Dist,Cluster_Res,Obj_Fcn,iter] = fuzzycm(Data,C,plotflag,M,epsm)% 输入:% Data: N×S 型矩阵,聚类的原始数据,即一组有限的观测样本集,% Data 的每一行为一个观测样本的特征矢量,S 为特征矢量% 的维数,N 为样本点的个数% C: 聚类数,1<C<N% plotflag: 聚类结果2D/3D 绘图标记,0 表示不绘图,为缺省值% M: 加权指数,缺省值为2% epsm: FCM 算法的迭代停止阈值,缺省值为1.0e-6% 输出:% U: C×N 型矩阵,FCM 的划分矩阵% P: C×S 型矩阵,FCM 的聚类中心,每一行对应一个聚类原型% Dist: C×N 型矩阵,FCM 各聚类中心到各样本点的距离,聚类中% 心i 到样本点j 的距离为Dist(i,j)% Cluster_Res: 聚类结果,共C 行,每一行对应一类% Obj_Fcn: 目标函数值% iter: FCM 算法迭代次数% See also: fuzzydist maxrowf fcmplotif nargin<5epsm=1.0e-6;endif nargin<4M=2;endif nargin<3plotflag=0;end[N,S]=size(Data);m=2/(M-1);iter=0;Dist(C,N)=0; U(C,N)=0; P(C,S)=0;% 随机初始化划分矩阵U0 = rand(C,N);U0=U0./(ones(C,1)*sum(U0));% FCM 的迭代算法while true% 迭代计数器iter=iter+1;% 计算或更新聚类中心PUm=U0.^M;P=Um*Data./(ones(S,1)*sum(Um'))';% 更新划分矩阵Ufor i=1:Cfor j=1:NDist(i,j)=fuzzydist(P(i,:),Data(j,:));endendU=1./(Dist.^m.*(ones(C,1)*sum(Dist.^(-m))));% 目标函数值: 类内加权平方误差和if nargout>4 | plotflagObj_Fcn(iter)=sum(sum(Um.*Dist.^2));end% FCM 算法迭代停止条件if norm(U-U0,Inf)<epsmbreakendU0=U;end% 聚类结果if nargout > 3res = maxrowf(U);for c = 1:Cv = find(res==c);Cluster_Res(c,1:length(v))=v;endend% 绘图if plotflagfcmplot(Data,U,P,Obj_Fcn);endm文件2/7:function [U,P,Dist,Cluster_Res,Obj_Fcn,iter]=fuzzycm2(Data,P0,plotflag,M,epsm) % 模糊C 均值聚类FCM: 从指定初始聚类中心开始迭代% [U,P,Dist,Cluster_Res,Obj_Fcn,iter] = fuzzycm2(Data,P0,plotflag,M,epsm)% 输入: Data,plotflag,M,epsm: 见fuzzycm.m% P0: 初始聚类中心% 输出: U,P,Dist,Cluster_Res,Obj_Fcn,iter: 见fuzzycm.m% See also: fuzzycmif nargin<5epsm=1.0e-6;if nargin<4M=2;endif nargin<3plotflag=0;end[N,S] = size(Data); m = 2/(M-1); iter = 0;C=size(P0,1);Dist(C,N)=0;U(C,N)=0;P(C,S)=0;% FCM 的迭代算法while true% 迭代计数器iter=iter+1;% 计算或更新划分矩阵Ufor i=1:Cfor j=1:NDist(i,j)=fuzzydist(P0(i,:),Data(j,:));endendU=1./(Dist.^m.*(ones(C,1)*sum(Dist.^(-m))));% 更新聚类中心PUm=U.^M;P=Um*Data./(ones(S,1)*sum(Um'))';% 目标函数值: 类内加权平方误差和if nargout>4 | plotflagObj_Fcn(iter)=sum(sum(Um.*Dist.^2));end% FCM 算法迭代停止条件if norm(P-P0,Inf)<epsmbreakendP0=P;end% 聚类结果if nargout > 3res = maxrowf(U);for c = 1:Cv = find(res==c);Cluster_Res(c,1:length(v))=v;endend% 绘图if plotflagfcmplot(Data,U,P,Obj_Fcn);m文件3/7:function fcmplot(Data,U,P,Obj_Fcn)% FCM 结果绘图函数% See also: fuzzycm maxrowf ellipse[C,S] = size(P); res = maxrowf(U);str = 'po*x+d^v><.h';% 目标函数绘图figure(1),plot(Obj_Fcn)title('目标函数值变化曲线','fontsize',8)% 2D 绘图if S==2figure(2),plot(P(:,1),P(:,2),'rs'),hold onfor i=1:Cv=Data(find(res==i),:);plot(v(:,1),v(:,2),str(rem(i,12)+1))ellipse(max(v(:,1))-min(v(:,1)), ...max(v(:,2))-min(v(:,2)), ...[max(v(:,1))+min(v(:,1)), ...max(v(:,2))+min(v(:,2))]/2,'r:') endgrid on,title('2D 聚类结果图','fontsize',8),hold off end% 3D 绘图if S>2figure(2),plot3(P(:,1),P(:,2),P(:,3),'rs'),hold onfor i=1:Cv=Data(find(res==i),:);plot3(v(:,1),v(:,2),v(:,3),str(rem(i,12)+1))ellipse(max(v(:,1))-min(v(:,1)), ...max(v(:,2))-min(v(:,2)), ...[max(v(:,1))+min(v(:,1)), ...max(v(:,2))+min(v(:,2))]/2, ...'r:',(max(v(:,3))+min(v(:,3)))/2) endgrid on,title('3D 聚类结果图','fontsize',8),hold off endm文件4/7:function D=fuzzydist(A,B)% 模糊聚类分析: 样本间的距离% D = fuzzydist(A,B)D=norm(A-B);m文件5/7:function mr=maxrowf(U,c)% 求矩阵U 每列第c 大元素所在行,c 的缺省值为1% 调用格式: mr = maxrowf(U,c)% See also: addrif nargin<2c=1;endN=size(U,2);mr(1,N)=0;for j=1:Naj=addr(U(:,j),'descend');mr(j)=aj(c);endm文件6/7:function ellipse(a,b,center,style,c_3d)% 绘制一个椭圆% 调用: ellipse(a,b,center,style,c_3d)% 输入:% a: 椭圆的轴长(平行于x 轴)% b: 椭圆的轴长(平行于y 轴)% center: 椭圆的中心[x0,y0],缺省值为[0,0]% style: 绘制的线型和颜色,缺省值为实线蓝色% c_3d: 椭圆的中心在3D 空间中的z 轴坐标,可缺省if nargin<4style='b';endif nargin<3 | isempty(center)center=[0,0];endt=1:360;x=a/2*cosd(t)+center(1);y=b/2*sind(t)+center(2);if nargin>4plot3(x,y,ones(1,360)*c_3d,style)elseplot(x,y,style)endm文件7/7:function f = addr(a,strsort)% 返回向量升序或降序排列后各分量在原始向量中的索引% 函数调用:f = addr(a,strsort)% strsort: 'ascend' or 'descend'% default is 'ascend'% -------- example --------% addr([ 4 5 1 2 ]) returns ans:% [ 3 4 1 2 ]if nargin==1strsort='ascend';endsa=sort(a); ca=a;la=length(a);f(la)=0;for i=1:laf(i)=find(ca==sa(i),1);ca(f(i))=NaN;endif strcmp(strsort,'descend') f=fliplr(f);end几天前我还在这里发帖求助,可是很幸运在其他地方找到了,在这里和大家分享一下!function [center, U, obj_fcn] = FCMClust(data, cluster_n, options)% FCMClust.m 采用模糊C均值对数据集data聚为cluster_n类%% 用法:% 1. [center,U,obj_fcn] = FCMClust(Data,N_cluster,options);% 2. [center,U,obj_fcn] = FCMClust(Data,N_cluster);%% 输入:% data ---- nxm矩阵,表示n个样本,每个样本具有m的维特征值% N_cluster ---- 标量,表示聚合中心数目,即类别数% options ---- 4x1矩阵,其中% options(1): 隶属度矩阵U的指数,>1 (缺省值: 2.0)% options(2): 最大迭代次数(缺省值: 100)% options(3): 隶属度最小变化量,迭代终止条件(缺省值: 1e-5)% options(4): 每次迭代是否输出信息标志 (缺省值: 1)% 输出:% center ---- 聚类中心% U ---- 隶属度矩阵% obj_fcn ---- 目标函数值% Example:% data = rand(100,2);% [center,U,obj_fcn] = FCMClust(data,2);% plot(data(:,1), data(:,2),'o');% hold on;% maxU = max(U);% index1 = find(U(1,:) == maxU);% index2 = find(U(2,:) == maxU);% line(data(index1,1),data(index1,2),'marker','*','color',' g');% line(data(index2,1),data(index2,2),'marker','*','color',' r');% plot([center([1 2],1)],[center([1 2],2)],'*','color','k') % hold off;if nargin ~= 2 & nargin ~= 3, %判断输入参数个数只能是2个或3个error('Too many or too few input arguments!');enddata_n = size(data, 1); % 求出data的第一维(rows)数,即样本个数in_n = size(data, 2); % 求出data的第二维(columns)数,即特征值长度% 默认操作参数default_options = [2; % 隶属度矩阵U的指数100; % 最大迭代次数1e-5; % 隶属度最小变化量,迭代终止条件1]; % 每次迭代是否输出信息标志if nargin == 2,options = default_options;else %分析有options做参数时候的情况% 如果输入参数个数是二那么就调用默认的option;if length(options) < 4, %如果用户给的opition数少于4个那么其他用默认值;tmp = default_options;tmp(1:length(options)) = options;options = tmp;end% 返回options中是数的值为0(如NaN),不是数时为1nan_index = find(isnan(options)==1);%将denfault_options中对应位置的参数赋值给options中不是数的位置.options(nan_index) = default_options(nan_index);if options(1) <= 1, %如果模糊矩阵的指数小于等于1error('The exponent should be greater than 1!');endend%将options 中的分量分别赋值给四个变量;expo = options(1); % 隶属度矩阵U的指数max_iter = options(2); % 最大迭代次数min_impro = options(3); % 隶属度最小变化量,迭代终止条件display = options(4); % 每次迭代是否输出信息标志obj_fcn = zeros(max_iter, 1); % 初始化输出参数obj_fcnU = initfcm(cluster_n, data_n); % 初始化模糊分配矩阵,使U满足列上相加为1,% Main loop 主要循环for i = 1:max_iter,%在第k步循环中改变聚类中心ceneter,和分配函数U的隶属度值;[U, center, obj_fcn(i)] = stepfcm(data, U, cluster_n, expo);if display,fprintf('FCM:Iteration count = %d, obj. fcn = %f\n', i, obj_fcn(i));end% 终止条件判别if i > 1,if abs(obj_fcn(i) - obj_fcn(i-1)) < min_impro,break;end,endenditer_n = i; % 实际迭代次数obj_fcn(iter_n+1:max_iter) = [];[center, U, obj_fcn] = FCMClust(Data,N_cluster,options)data=[94.4304 98 60 0 8592.8068 70 70 0 75.286.3522 100 75 24.87 91.580.5512 50 90 0 65.480.494 76 100 0 9888.1528 100 60 80 78.484.567 55 80 0 8587.722 30 60 0 4988.0056 95 70 46.459 45.885.948 100 60 0 55.683.9578 10 90 0 78.490.0822 5 60 0 58.876.7448 10 60 0 39.295.062 100 70 62.37 94.8];N_cluster=4;options(1)=[2];options(2)=[100];options(3)=[1e-5];options(4)=[1];。

c均值聚类matlab

在MATLAB中,使用c均值聚类(C-means clustering)可以通

过以下步骤实现:

1. 导入数据,首先,你需要准备你的数据集并将其导入MATLAB中。

你可以使用`csvread`或`xlsread`函数来从CSV文件或Excel文件中读取数据,或者直接创建一个数据矩阵。

2. 数据预处理,在进行聚类之前,通常需要对数据进行预处理,例如归一化或标准化,以确保各个特征对聚类结果的影响是均衡的。

3. 调用c均值聚类函数:MATLAB提供了`fcm`函数来实现c均

值聚类。

你可以使用以下语法来调用该函数:

[centers, U] = fcm(data, clusterNum);

其中,`data`是你的数据矩阵,`clusterNum`是你想要得到

的聚类中心的数量。

`centers`包含了每个聚类中心的坐标,`U`是

一个隶属度矩阵,描述了每个数据点属于每个聚类的概率。

4. 可视化结果,你可以使用MATLAB的绘图函数,如`scatter`或`plot`来可视化聚类结果,以及聚类中心的位置。

5. 结果分析,最后,对聚类结果进行分析和解释,可以使用各种统计工具和可视化手段来理解不同聚类之间的差异和相似性。

需要注意的是,c均值聚类的结果可能受初始聚类中心的选择和随机性影响,因此通常需要多次运行算法并比较结果,以确保得到稳健的聚类结果。

希望这些信息能够帮助到你在MATLAB中实现c 均值聚类。

matlab模糊c均值聚类算法模糊C均值聚类算法是一种广泛应用于数据挖掘、图像分割等领域的聚类算法。

相比于传统的C均值聚类算法,模糊C均值聚类算法能够更好地处理噪声数据和模糊边界。

模糊C均值聚类算法的基本思想是将样本集合分为K个聚类集合,使得每个样本点属于某个聚类集合的概率最大。

同时,每个聚类集合的中心点被计算为该聚类集合中所有样本的均值。

具体实现中,模糊C均值聚类算法引入了模糊化权重向量来描述每个样本点属于各个聚类集合的程度。

这些权重值在每次迭代中被更新,直至达到预设的收敛精度为止。

模糊C均值聚类算法的目标函数可以表示为:J = ∑i∑j(wij)q||xi-cj||2其中,xi表示样本集合中的第i个样本,cj表示第j个聚类集合的中心点,wij表示第i个样本点属于第j个聚类集合的权重,q是模糊指数,通常取2。

不同于C均值聚类算法,模糊C均值聚类算法对每个样本点都考虑了其属于某个聚类集合的概率,因此能够更好地处理模糊边界和噪声数据。

同时,模糊C均值聚类算法可以自适应地确定聚类的数量,从而避免了事先设定聚类数量所带来的限制。

在MATLAB中,可以使用fcm函数实现模糊C均值聚类算法。

具体来说,fcm函数的使用方法如下:[idx,center] = fcm(data,k,[options]);其中,data表示样本矩阵,k表示聚类数量,options是一个包含算法参数的结构体。

fcm函数的输出包括聚类标签idx和聚类中心center。

MATLAB中的fcm函数还提供了其他参数和选项,例如模糊权重阈值、最大迭代次数和收敛精度等。

可以根据具体应用需求来设置这些参数和选项。

MATLAB实现FCM聚类算法本⽂在阐述聚类分析⽅法的基础上重点研究FCM聚类算法。

FCM算法是⼀种基于划分的聚类算法,它的思想是使得被划分到同⼀簇的对象之间相似度最⼤,⽽不同簇之间的相似度最⼩。

最后基于MATLAB实现了对图像信息的聚类。

第1章概述聚类分析是数据挖掘的⼀项重要功能,⽽聚类算法是⽬前研究的核⼼,聚类分析就是使⽤聚类算法来发现有意义的聚类,即“物以类聚”。

虽然聚类也可起到分类的作⽤,但和⼤多数分类或预测不同。

⼤多数分类⽅法都是演绎的,即⼈们事先确定某种事物分类的准则或各类别的标准,分类的过程就是⽐较分类的要素与各类别标准,然后将各要素划归于各类别中。

确定事物的分类准则或各类别的标准或多或少带有主观⾊彩。

为获得基于划分聚类分析的全局最优结果,则需要穷举所有可能的对象划分,为此⼤多数应⽤采⽤的常⽤启发⽅法包括:k-均值算法,算法中的每⼀个聚类均⽤相应聚类中对象的均值来表⽰;k-medoid算法,算法中的每⼀个聚类均⽤相应聚类中离聚类中⼼最近的对象来表⽰。

这些启发聚类⽅法在分析中⼩规模数据集以发现圆形或球状聚类时⼯作得很好,但当分析处理⼤规模数据集或复杂数据类型时效果较差,需要对其进⾏扩展。

⽽模糊C均值(Fuzzy C-means,FCM)聚类⽅法,属于基于⽬标函数的模糊聚类算法的范畴。

模糊C均值聚类⽅法是基于⽬标函数的模糊聚类算法理论中最为完善、应⽤最为⼴泛的⼀种算法。

模糊c均值算法最早从硬聚类⽬标函数的优化中导出的。

为了借助⽬标函数法求解聚类问题,⼈们利⽤均⽅逼近理论构造了带约束的⾮线性规划函数,以此来求解聚类问题,从此类内平⽅误差和WGSS(Within-Groups Sum of Squared Error)成为聚类⽬标函数的普遍形式。

随着模糊划分概念的提出,Dunn[10]⾸先将其推⼴到加权WGSS函数,后来由Bezdek扩展到加权WGSS的⽆限族,形成了FCM聚类算法的通⽤聚类准则。

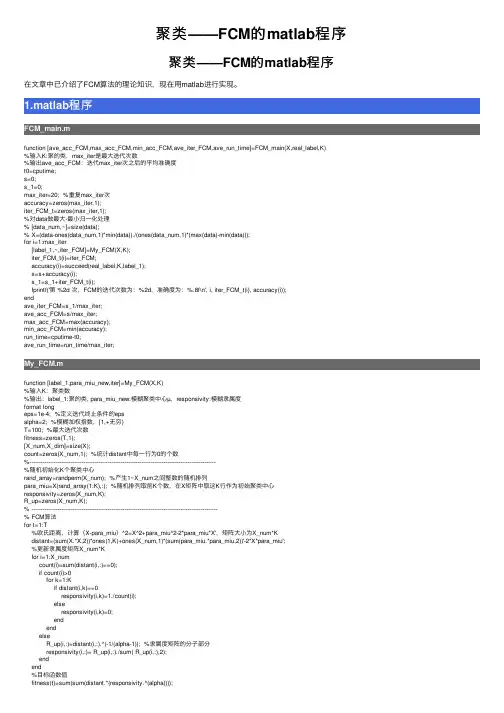

聚类——FCM的matlab程序聚类——FCM的matlab程序在⽂章中已介绍了FCM算法的理论知识,现在⽤matlab进⾏实现。

1.matlab程序FCM_main.mfunction [ave_acc_FCM,max_acc_FCM,min_acc_FCM,ave_iter_FCM,ave_run_time]=FCM_main(X,real_label,K)%输⼊K:聚的类,max_iter是最⼤迭代次数%输出ave_acc_FCM:迭代max_iter次之后的平均准确度t0=cputime;s=0;s_1=0;max_iter=20; %重复max_iter次accuracy=zeros(max_iter,1);iter_FCM_t=zeros(max_iter,1);%对data做最⼤-最⼩归⼀化处理% [data_num,~]=size(data);% X=(data-ones(data_num,1)*min(data))./(ones(data_num,1)*(max(data)-min(data)));for i=1:max_iter[label_1,~,iter_FCM]=My_FCM(X,K);iter_FCM_t(i)=iter_FCM;accuracy(i)=succeed(real_label,K,label_1);s=s+accuracy(i);s_1=s_1+iter_FCM_t(i);fprintf('第 %2d 次,FCM的迭代次数为:%2d,准确度为:%.8f\n', i, iter_FCM_t(i), accuracy(i));endave_iter_FCM=s_1/max_iter;ave_acc_FCM=s/max_iter;max_acc_FCM=max(accuracy);min_acc_FCM=min(accuracy);run_time=cputime-t0;ave_run_time=run_time/max_iter;My_FCM.mfunction [label_1,para_miu_new,iter]=My_FCM(X,K)%输⼊K:聚类数%输出:label_1:聚的类, para_miu_new:模糊聚类中⼼µ,responsivity:模糊⾪属度format longeps=1e-4; %定义迭代终⽌条件的epsalpha=2; %模糊加权指数,[1,+⽆穷)T=100; %最⼤迭代次数fitness=zeros(T,1);[X_num,X_dim]=size(X);count=zeros(X_num,1); %统计distant中每⼀⾏为0的个数%----------------------------------------------------------------------------------------------------%随机初始化K个聚类中⼼rand_array=randperm(X_num); %产⽣1~X_num之间整数的随机排列para_miu=X(rand_array(1:K),:); %随机排列取前K个数,在X矩阵中取这K⾏作为初始聚类中⼼responsivity=zeros(X_num,K);R_up=zeros(X_num,K);% ----------------------------------------------------------------------------------------------------% FCM算法for t=1:T%欧⽒距离,计算(X-para_miu)^2=X^2+para_miu^2-2*para_miu*X',矩阵⼤⼩为X_num*Kdistant=(sum(X.*X,2))*ones(1,K)+ones(X_num,1)*(sum(para_miu.*para_miu,2))'-2*X*para_miu';%更新⾪属度矩阵X_num*Kfor i=1:X_numcount(i)=sum(distant(i,:)==0);if count(i)>0for k=1:Kif distant(i,k)==0responsivity(i,k)=1./count(i);elseresponsivity(i,k)=0;endendelseR_up(i,:)=distant(i,:).^(-1/(alpha-1)); %⾪属度矩阵的分⼦部分responsivity(i,:)= R_up(i,:)./sum( R_up(i,:),2);endend%⽬标函数值fitness(t)=sum(sum(distant.*(responsivity.^(alpha))));%更新聚类中⼼K*X_dimmiu_up=(responsivity'.^(alpha))*X; %µ的分⼦部分para_miu=miu_up./((sum(responsivity.^(alpha)))'*ones(1,X_dim));if t>1if abs(fitness(t)-fitness(t-1))<epsbreak;endendendpara_miu_new=para_miu;iter=t; %实际迭代次数[~,label_1]=max(responsivity,[],2);succeed.mfunction accuracy=succeed(real_label,K,id)%输⼊K:聚的类,id:训练后的聚类结果,N*1的矩阵N=size(id,1); %样本个数p=perms(1:K); %全排列矩阵p_col=size(p,1); %全排列的⾏数new_label=zeros(N,p_col); %聚类结果的所有可能取值,N*p_colnum=zeros(1,p_col); %与真实聚类结果⼀样的个数%将训练结果全排列为N*p_col的矩阵,每⼀列为⼀种可能性for i=1:Nfor j=1:p_colfor k=1:Kif id(i)==knew_label(i,j)=p(j,k); %iris数据库,1 2 3endendendend%与真实结果⽐对,计算精确度for j=1:p_colfor i=1:Nif new_label(i,j)==real_label(i)num(j)=num(j)+1;endendendaccuracy=max(num)/N;2.在UCI数据库的iris上的运⾏结果>> data_load=dlmread('E:\My matlab\database\iris.data');data=data_load(:,1:4);real_label=data_load(:,5); >> [ave_acc_FCM,max_acc_FCM,min_acc_FCM,ave_iter_FCM,ave_run_time]=FCM_main(data,real_label,3)第 1 次,FCM的迭代次数为:33,准确度为:0.89333333第 2 次,FCM的迭代次数为:41,准确度为:0.89333333第 3 次,FCM的迭代次数为:14,准确度为:0.89333333第 4 次,FCM的迭代次数为:13,准确度为:0.89333333第 5 次,FCM的迭代次数为:16,准确度为:0.89333333第 6 次,FCM的迭代次数为:10,准确度为:0.89333333第 7 次,FCM的迭代次数为:21,准确度为:0.89333333第 8 次,FCM的迭代次数为:46,准确度为:0.89333333第 9 次,FCM的迭代次数为:19,准确度为:0.89333333第 10 次,FCM的迭代次数为:18,准确度为:0.89333333第 11 次,FCM的迭代次数为:17,准确度为:0.89333333第 12 次,FCM的迭代次数为:38,准确度为:0.89333333第 13 次,FCM的迭代次数为:37,准确度为:0.89333333第 14 次,FCM的迭代次数为:11,准确度为:0.89333333第 15 次,FCM的迭代次数为:22,准确度为:0.89333333第 16 次,FCM的迭代次数为:17,准确度为:0.89333333第 17 次,FCM的迭代次数为:13,准确度为:0.89333333第 18 次,FCM的迭代次数为: 8,准确度为:0.89333333第 19 次,FCM的迭代次数为:13,准确度为:0.89333333第 20 次,FCM的迭代次数为:20,准确度为:0.89333333ave_acc_FCM =0.893333333333333max_acc_FCM =0.893333333333333min_acc_FCM =0.893333333333333ave_iter_FCM =21.350000000000001ave_run_time =0.0359375000000003. iris.data 5.1,3.5,1.4,0.2,14.9,3.0,1.4,0.2,1 4.7,3.2,1.3,0.2,14.6,3.1,1.5,0.2,15.0,3.6,1.4,0.2,1 5.4,3.9,1.7,0.4,14.6,3.4,1.4,0.3,15.0,3.4,1.5,0.2,1 4.4,2.9,1.4,0.2,14.9,3.1,1.5,0.1,15.4,3.7,1.5,0.2,1 4.8,3.4,1.6,0.2,1 4.8,3.0,1.4,0.1,14.3,3.0,1.1,0.1,15.8,4.0,1.2,0.2,1 5.7,4.4,1.5,0.4,1 5.4,3.9,1.3,0.4,1 5.1,3.5,1.4,0.3,1 5.7,3.8,1.7,0.3,1 5.1,3.8,1.5,0.3,1 5.4,3.4,1.7,0.2,1 5.1,3.7,1.5,0.4,14.6,3.6,1.0,0.2,15.1,3.3,1.7,0.5,14.8,3.4,1.9,0.2,15.0,3.0,1.6,0.2,1 5.0,3.4,1.6,0.4,1 5.2,3.5,1.5,0.2,1 5.2,3.4,1.4,0.2,1 4.7,3.2,1.6,0.2,14.8,3.1,1.6,0.2,15.4,3.4,1.5,0.4,1 5.2,4.1,1.5,0.1,1 5.5,4.2,1.4,0.2,14.9,3.1,1.5,0.1,15.0,3.2,1.2,0.2,1 5.5,3.5,1.3,0.2,1 4.9,3.1,1.5,0.1,14.4,3.0,1.3,0.2,15.1,3.4,1.5,0.2,1 5.0,3.5,1.3,0.3,1 4.5,2.3,1.3,0.3,14.4,3.2,1.3,0.2,15.0,3.5,1.6,0.6,1 5.1,3.8,1.9,0.4,14.8,3.0,1.4,0.3,15.1,3.8,1.6,0.2,14.6,3.2,1.4,0.2,15.3,3.7,1.5,0.2,1 5.0,3.3,1.4,0.2,1 7.0,3.2,4.7,1.4,26.4,3.2,4.5,1.5,2 6.9,3.1,4.9,1.5,25.5,2.3,4.0,1.3,26.5,2.8,4.6,1.5,25.7,2.8,4.5,1.3,26.3,3.3,4.7,1.6,2 4.9,2.4,3.3,1.0,2 6.6,2.9,4.6,1.3,2 5.2,2.7,3.9,1.4,2 5.0,2.0,3.5,1.0,25.9,3.0,4.2,1.5,26.0,2.2,4.0,1.0,2 6.1,2.9,4.7,1.4,25.6,2.9,3.6,1.3,26.7,3.1,4.4,1.4,2 5.6,3.0,4.5,1.5,25.8,2.7,4.1,1.0,26.2,2.2,4.5,1.5,2 5.6,2.5,3.9,1.1,25.9,3.2,4.8,1.8,26.1,2.8,4.0,1.3,2 6.3,2.5,4.9,1.5,2 6.1,2.8,4.7,1.2,2 6.4,2.9,4.3,1.3,2 6.6,3.0,4.4,1.4,2 6.8,2.8,4.8,1.4,2 6.7,3.0,5.0,1.7,2 6.0,2.9,4.5,1.5,2 5.7,2.6,3.5,1.0,2 5.5,2.4,3.8,1.1,25.5,2.4,3.7,1.0,25.8,2.7,3.9,1.2,26.0,2.7,5.1,1.6,25.4,3.0,4.5,1.5,26.0,3.4,4.5,1.6,2 6.7,3.1,4.7,1.5,2 6.3,2.3,4.4,1.3,2 5.6,3.0,4.1,1.3,2 5.5,2.5,4.0,1.3,25.5,2.6,4.4,1.2,26.1,3.0,4.6,1.4,2 5.8,2.6,4.0,1.2,2 5.0,2.3,3.3,1.0,2 5.6,2.7,4.2,1.3,2 5.7,3.0,4.2,1.2,25.7,2.9,4.2,1.3,26.2,2.9,4.3,1.3,2 5.1,2.5,3.0,1.1,25.7,2.8,4.1,1.3,26.3,3.3,6.0,2.5,3 5.8,2.7,5.1,1.9,37.1,3.0,5.9,2.1,3 6.3,2.9,5.6,1.8,36.5,3.0,5.8,2.2,37.6,3.0,6.6,2.1,3 4.9,2.5,4.5,1.7,3 7.3,2.9,6.3,1.8,36.7,2.5,5.8,1.8,37.2,3.6,6.1,2.5,3 6.5,3.2,5.1,2.0,3 6.4,2.7,5.3,1.9,3 6.8,3.0,5.5,2.1,3 5.7,2.5,5.0,2.0,35.8,2.8,5.1,2.4,36.4,3.2,5.3,2.3,36.5,3.0,5.5,1.8,37.7,3.8,6.7,2.2,3 7.7,2.6,6.9,2.3,3 6.0,2.2,5.0,1.5,3 6.9,3.2,5.7,2.3,3 5.6,2.8,4.9,2.0,3 7.7,2.8,6.7,2.0,3 6.3,2.7,4.9,1.8,36.7,3.3,5.7,2.1,37.2,3.2,6.0,1.8,3 6.2,2.8,4.8,1.8,3 6.1,3.0,4.9,1.8,36.4,2.8,5.6,2.1,37.2,3.0,5.8,1.6,3 7.4,2.8,6.1,1.9,3 7.9,3.8,6.4,2.0,3 6.4,2.8,5.6,2.2,3 6.3,2.8,5.1,1.5,36.1,2.6,5.6,1.4,37.7,3.0,6.1,2.3,3 6.3,3.4,5.6,2.4,3 6.4,3.1,5.5,1.8,3 6.0,3.0,4.8,1.8,3 6.9,3.1,5.4,2.1,3 6.7,3.1,5.6,2.4,3 6.9,3.1,5.1,2.3,35.8,2.7,5.1,1.9,36.8,3.2,5.9,2.3,3 6.7,3.3,5.7,2.5,3 6.7,3.0,5.2,2.3,3 6.3,2.5,5.0,1.9,3 6.5,3.0,5.2,2.0,3 6.2,3.4,5.4,2.3,3 5.9,3.0,5.1,1.8,3。

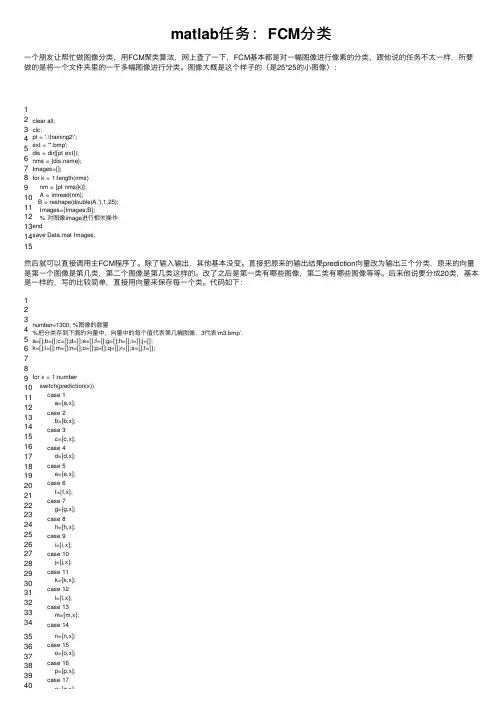

matlab任务:FCM分类⼀个朋友让帮忙做图像分类,⽤FCM聚类算法,⽹上查了⼀下,FCM基本都是对⼀幅图像进⾏像素的分类,跟他说的任务不太⼀样,所要做的是将⼀个⽂件夹⾥的⼀千多幅图像进⾏分类。

图像⼤概是这个样⼦的(是25*25的⼩图像):12 3 4 5 6 7 8 9 10 11 12 13 14 15clear all;clc;pt = '.\training2\';ext = '*.bmp';dis = dir([pt ext]);nms = {};Images=[];for k = 1:length(nms)nm = [pt nms{k}];A = imread(nm);B = reshape(double(A.'),1,25); Images=[Images;B];% 对图像image进⾏相关操作endsave Data.mat Images;然后就可以直接调⽤主FCM程序了。

除了输⼊输出,其他基本没变。

直接把原来的输出结果prediction向量改为输出三个分类,原来的向量是第⼀个图像是第⼏类,第⼆个图像是第⼏类这样的。

改了之后是第⼀类有哪些图像,第⼆类有哪些图像等等。

后来他说要分成20类,基本是⼀样的,写的⽐较简单,直接⽤向量来保存每⼀个类。

代码如下:123 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40number=1300; %图像的数量%把分类存到下⾯的向量中,向量中的每个值代表第⼏幅图像,3代表‘m3.bmp’. a=[];b=[];c=[];d=[];e=[];f=[];g=[];h=[];i=[];j=[];k=[];l=[];m=[];n=[];o=[];p=[];q=[];r=[];s=[];t=[];for x = 1:numberswitch(prediction(x))case1a=[a,x];case2b=[b,x];case3c=[c,x];case4d=[d,x];case5e=[e,x];case6f=[f,x];case7g=[g,x];case8h=[h,x];case9i=[i,x];case10j=[j,x];case11k=[k,x];case12l=[l,x];case13m=[m,x];case14n=[n,x];case15o=[o,x];case16p=[p,x];case17q=[q,x];40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 q=[q,x];case18r=[r,x];case19s=[s,x];case20t=[t,x];endendsave.\result\A.mat a;save.\result\B.mat b;save.\result\C.mat c;save.\result\D.mat d; save.\result\E.mat e;save.\result\F.mat f;save.\result\G.mat g;save.\result\H.mat h; save.\result\I.mat i;save.\result\J.mat j;save.\result\K.mat k;save.\result\L.mat l; save.\result\M.mat m;save.\result\N.mat n;save.\result\O.mat o;save.\result\P.mat p; save.\result\Q.mat q;save.\result\R.mat r;save.\result\S.mat s;save.\result\T.mat t; 分类最后的结果是这个样⼦的:哦,中途还出了⼀个问题,错误提⽰是:fcm输⼊的参数太多,想了很久才想通,原来matlab有个⾃带的fcm函数,它的参数只有两个,难怪会提⽰输⼊的参数太多。

如何在Matlab中进行模糊聚类分析在数据分析领域,模糊聚类分析是一种常用的技术,它可以应用于各种领域的数据处理和模式识别问题。

而Matlab作为一种功能强大的数据分析工具,也提供了丰富的函数和工具箱,以支持模糊聚类分析的实施。

1. 引言模糊聚类分析是一种基于模糊集理论的聚类方法,与传统的硬聚类方法不同,它允许样本属于多个聚类中心。

这种方法的优势在于可以更好地应对数据中的不确定性和复杂性,对于某些模糊或模糊边界问题具有更好的解释能力。

2. 模糊聚类算法概述Matlab提供了多种模糊聚类算法的实现,其中最常用的是基于模糊C均值(Fuzzy C-Means,FCM)算法。

FCM算法的基本思想是通过最小化聚类后的模糊划分矩阵与原始数据之间的距离来确定每个样本所属的聚类中心。

3. 数据预处理与特征提取在进行模糊聚类分析之前,需要对原始数据进行预处理和特征提取。

预处理包括数据清洗、缺失值处理和异常值处理等;特征提取则是从原始数据中抽取出具有代表性和区分性的特征,用于模糊聚类分析。

4. 模糊聚类分析步骤在Matlab中,进行模糊聚类分析通常包括以下步骤:(1) 初始化聚类中心:通过随机选择或基于某种准则的方法初始化聚类中心。

(2) 计算模糊划分矩阵:根据当前的聚类中心,计算每个样本属于各个聚类中心的隶属度。

(3) 更新聚类中心:根据当前的模糊划分矩阵,更新聚类中心的位置。

(4) 判断终止条件:通过设置一定的终止条件,判断是否达到停止迭代的条件。

(5) 输出最终结果:得到最终的聚类结果和每个样本所属的隶属度。

5. 模糊聚类结果评估在进行模糊聚类分析后,需要对聚类结果进行评估以验证其有效性和可解释性。

常用的评估指标包括模糊划分矩阵的聚类有效性指标、外部指标和内部指标等。

通过这些指标的比较和分析,可以选择合适的模糊聚类算法和参数设置。

6. 模糊聚类的应用模糊聚类分析在诸多领域中都有广泛的应用。

例如,在图像处理中,可以利用模糊聚类方法对图像进行分割和识别;在生物信息学中,可以应用于基因表达数据的分类和模式识别等。

利用MATLAB进行模糊聚类分析1. 引言近年来,随着数据科学的飞速发展,模糊聚类分析作为一种有效的数据挖掘技术被广泛应用于各个领域。

模糊聚类分析可以在数据集中找到隐含的模式和结构,帮助人们更好地理解数据和做出预测。

本文将介绍如何利用MATLAB进行模糊聚类分析,并通过实例演示其应用。

2. 模糊聚类分析原理模糊聚类分析是一种非监督学习方法,其目标是将数据集中的样本划分为若干个模糊的聚类。

与传统的硬聚类方法不同,模糊聚类分析允许一个样本属于多个聚类的成员,这样可以更好地反映样本之间的相似性和差异性。

模糊聚类分析的核心是模糊C-均值(FCM)算法,它基于样本与聚类中心之间的模糊隶属度进行迭代优化,直到达到停止条件为止。

3. MATLAB中的模糊聚类分析工具MATLAB提供了丰富的工具箱和函数,方便进行模糊聚类分析。

其中,Fuzzy Logic Toolbox是一个强大的工具箱,提供了各种用于模糊逻辑和模糊推理的函数。

可以利用该工具箱中的函数,如genfis1和genfis2,生成模糊推理系统的模糊近似模型。

此外,MATLAB还提供了fcm函数,用于执行模糊C-均值算法进行聚类分析。

4. 实例演示假设我们有一个数据集包含N个样本和M个属性,我们希望将这些样本进行聚类分析。

首先,我们需要准备数据集,并进行预处理,如缺失值处理、标准化等。

然后,我们利用genfis1函数生成一个模糊推理系统的模糊近似模型,设置聚类数目和输入输出变量。

接下来,我们使用fcm函数执行模糊C-均值算法进行聚类分析,得到样本的隶属度矩阵和聚类中心。

5. 结果分析通过模糊聚类分析,我们可以得到每个样本对于每个聚类的隶属度,根据隶属度大小,我们可以确定每个样本的主要归属聚类。

此外,聚类中心可以用于描述聚类的特征,可以通过可视化的方式展示。

通过对结果的分析,我们可以发现潜在的模式和结构,并可以进一步进行数据挖掘和预测。

6. 总结本文介绍了利用MATLAB进行模糊聚类分析的原理和步骤,并通过实例演示了该方法的应用。

FCM,PCM聚类算法MA TLAB程序function [U,center,result,w,obj_fcn]= fenlei(data) [data_n,in_n] = size(data);m= 2; % Exponent for Umax_iter = 100; % Max. iterationmin_impro =1e-5; % Min. improvementc=3;[center, U, obj_fcn] = fcm(data, c);for i=1:max_iterif F(U)>0.98break;elsew_new=eye(in_n,in_n);center1=sum(center)/c;a=center1(1)./center1;deta=center-center1(ones(c,1),:);w=sqrt(sum(deta.^2)).*a;for j=1:in_nw_new(j,j)=w(j);enddata1=data*w_new;[center, U, obj_fcn] = fcm(data1, c);center=center./w(ones(c,1),:);obj_fcn=obj_fcn/sum(w.^2);endenddisplay(i);result=zeros(1,data_n);U_=max(U);for i=1:data_nfor j=1:cif U(j,i)==U_(i)result(i)=j;continue;endendend聚类算法Kmeans-----matlab codefunction [cid,nr,centers] = cskmeans(x,k,nc)% CSKMEANS K-Means clustering - general method.%% This implements the more general k-means algorithm, where % HMEANS is used to find the initial partition and then each% observation is examined for further improvem ents in minimizing % the within-group sum of squares.%% [CID,NR,CENTERS] = CSKMEANS(X,K,NC) Performs K-means% clustering using the data given in X.%% INPUTS: X is the n x d matrix of data,% where each row indicates an observation. K indicates% the number of desired clusters. NC is a k x d matrix for the% initial cluster centers. If NC is not specified, then the% centers will be randomly chosen from the observations.%% OUTPUTS: CID provides a set of n indexes indicating cluster% membership for each point. NR is the number of observations % in each cluster. CENTERS is a matrix, where each row% corresponds to a cluster center.%% See also CSHMEANS% W. L. and A. R. Martinez, 9/15/01% Computational Statistics Toolboxwarning off[n,d] = size(x);if nargin < 3% Then pick some observations to be the cluster centers.ind = ceil(n*rand(1,k));% We will add some noise to make it interesting.nc = x(ind,:) + randn(k,d);end% set up storage% integer 1,...,k indicating cluster membershipcid = zeros(1,n);% Make this different to get the loop started.oldcid = ones(1,n);% The number in each cluster.nr = zeros(1,k);% Set up maximum number of iterations.maxiter = 100;iter = 1;while ~isequal(cid,oldcid) & iter < maxiter% Implement the hmeans algorithm% For each point, find the distance to all cluster centers for i = 1:ndist = sum((repmat(x(i,:),k,1)-nc).^2,2);[m,ind] = min(dist); % assign it to this cluster centercid(i) = ind;end% Find the new cluster centersfor i = 1:k% find all points in this clusterind = find(cid==i);% find the centroidnc(i,:) = mean(x(ind,:));% Find the number in each cluster;nr(i) = length(ind);enditer = iter + 1;end% Now check each observation to see if the error can be minimized some more. % Loop through all points.maxiter = 2;iter = 1;move = 1;while iter < maxiter & move ~= 0move = 0;% Loop through all points.for i = 1:n% find the distance to all cluster centersdist = sum((repmat(x(i,:),k,1)-nc).^2,2);r = cid(i); % This is the cluster id for x%%nr,nr+1;dadj = nr./(nr+1).*dist'; % All adjusted distances[m,ind] = min(dadj); % minimum should be the cluster it belongs toif ind ~= r % if not, then move xcid(i) = ind;ic = find(cid == ind);nc(ind,:) = mean(x(ic,:));move = 1;endenditer = iter+1;endcenters = nc;if move == 0disp('No points were moved after the initial clustering procedure.') elsedisp('Some points were moved after the initial clustering procedure.') endwarning onfunction d=data()%K-means算法主程序k=4;x =[ 1.2126&<60;&<60; 2.1338&<60;&<60; 0.5115&<60;&<60; 0.2044&<60; -0.9316&<60;&<60; 0.7634&<60;&<60; 0.0125&<60;&<60; -0.2752 &<60; -2.9593&<60;&<60; 0.1813&<60;&<60; -0.8833&<60;&<60; 0.8505 &<60; 3.1104&<60;&<60; -2.5393&<60;&<60; -0.0588&<60;&<60; 0.1808 &<60; -3.1141&<60;&<60; -0.1244&<60;&<60; -0.6811&<60;&<60; 0.9891 &<60; -3.2008&<60;&<60; 0.0024&<60;&<60; -1.2901&<60;&<60; 0.9748 &<60; -1.0777&<60;&<60; 1.1438&<60;&<60; 0.1996&<60;&<60; 0.0139 &<60; -2.7213&<60;&<60; -0.1909&<60;&<60; 0.1184&<60;&<60; 0.1013 &<60; -1.1467&<60;&<60; 1.3820&<60;&<60; 0.1427&<60;&<60; -0.2239 &<60; 1.1497&<60;&<60; 1.9414&<60;&<60; -0.3035&<60;&<60; 0.3464 &<60; 2.6993&<60;&<60; -2.2556&<60;&<60; 0.1637&<60;&<60; -0.0139 &<60; -3.0311&<60;&<60; 0.1417&<60;&<60; 0.0888&<60;&<60; 0.1791 &<60; -2.8403&<60;&<60; -0.1809&<60;&<60; -0.0965&<60;&<60; 0.0817 &<60; 1.0118&<60;&<60; 2.0372&<60;&<60; 0.1638&<60;&<60; -0.0349 &<60; -0.8968&<60;&<60; 1.0260&<60;&<60; -0.1013&<60;&<60; 0.2369 &<60; 1.1112&<60;&<60; 1.8802&<60;&<60; -0.0291&<60;&<60; -0.1506 &<60; 1.1907&<60;&<60; 2.2041&<60;&<60; -0.1060&<60;&<60; 0.2167 &<60; -1.0114&<60;&<60; 0.8029&<60;&<60; -0.1317&<60;&<60; 0.0153 &<60; -3.1715&<60;&<60; 0.1041&<60;&<60; -0.3338&<60;&<60; 0.0321 &<60; 0.9718&<60;&<60; 1.9634&<60;&<60; 0.0305&<60;&<60; -0.3259 &<60; -1.0377&<60;&<60; 0.8889&<60;&<60; -0.2834&<60;&<60; 0.2301 &<60; -0.8989&<60;&<60; 1.0185&<60;&<60; -0.0289&<60;&<60; 0.0213 &<60; -2.9815&<60;&<60; -0.4798&<60;&<60; 0.2245&<60;&<60; 0.3085 &<60; -0.8576&<60;&<60; 0.9231&<60;&<60; -0.2752&<60;&<60; -0.0091 &<60; -3.1356&<60;&<60; 0.0026&<60;&<60; -1.2138&<60;&<60; 0.7733 &<60; 3.4470&<60;&<60; -2.2418&<60;&<60; 0.2014&<60;&<60; -0.1556 &<60; 2.9143&<60;&<60; -1.7951&<60;&<60; 0.1992&<60;&<60; -0.2146 &<60; 3.4961&<60;&<60; -2.4969&<60;&<60; -0.0121&<60;&<60; 0.1315 &<60; -2.9341&<60;&<60; -0.1071&<60;&<60; -0.7712&<60;&<60; 0.8911 &<60; -2.8105&<60;&<60; -0.0884&<60;&<60; -0.0287&<60;&<60; -0.1279&<60; 3.1006&<60;&<60; -2.0677&<60;&<60; -0.2002&<60;&<60; -0.1303 &<60; 0.8209&<60;&<60; 2.1724&<60;&<60; 0.1548&<60;&<60; 0.3516&<60; -2.8500&<60;&<60; 0.3196&<60;&<60; 0.1359&<60;&<60; -0.1179 &<60; -2.8679&<60;&<60; 0.1365&<60;&<60; -0.5702&<60;&<60; 0.7626 &<60; -2.8245&<60;&<60; -0.1312&<60;&<60; 0.0881&<60;&<60; -0.1305 &<60; -0.8322&<60;&<60; 1.3014&<60;&<60; -0.3837&<60;&<60; 0.2400 &<60; -2.6063&<60;&<60; 0.1431&<60;&<60; 0.1880&<60;&<60; 0.0487 &<60; -3.1341&<60;&<60; -0.0854&<60;&<60; -0.0359&<60;&<60; -0.2080&<60; 0.6893&<60;&<60; 2.0854&<60;&<60; -0.3250&<60;&<60; -0.1007&<60; 1.0894&<60;&<60; 1.7271&<60;&<60; -0.0176&<60;&<60; 0.6553 &<60; -2.9851&<60;&<60; -0.0113&<60;&<60; 0.0666&<60;&<60; -0.0802 &<60; 1.0371&<60;&<60; 2.2724&<60;&<60; 0.1044&<60;&<60; 0.3982&<60; -2.8032&<60;&<60; -0.2737&<60;&<60; -0.7391&<60;&<60; 1.0277 &<60; -2.6856&<60;&<60; 0.0619&<60;&<60; -1.1066&<60;&<60; 1.0485 &<60; -2.9445&<60;&<60; -0.1602&<60;&<60; -0.0019&<60;&<60; 0.0093 &<60; 1.2004&<60;&<60; 2.1302&<60;&<60; -0.1650&<60;&<60; 0.3413 &<60; 3.2505&<60;&<60; -1.9279&<60;&<60; 0.4462&<60;&<60; -0.2405 &<60; -1.2080&<60;&<60; 0.8222&<60;&<60; 0.1671&<60;&<60; 0.1576 &<60; -2.8274&<60;&<60; 0.1515&<60;&<60; -0.9636&<60;&<60; 1.0675 &<60; 2.8190&<60;&<60; -1.8626&<60;&<60; 0.2702&<60;&<60; 0.0026 &<60; 1.0507&<60;&<60; 1.7776&<60;&<60; -0.1421&<60;&<60; 0.0999 &<60; -2.8946&<60;&<60; 0.1446&<60;&<60; -0.1645&<60;&<60; 0.3071 &<60; -1.0105&<60;&<60; 1.0973&<60;&<60; 0.0241&<60;&<60; 0.1628 &<60; -2.9138&<60;&<60; -0.3404&<60;&<60; 0.0627&<60;&<60; 0.1286 &<60; -3.0646&<60;&<60; -0.0008&<60;&<60; 0.3819&<60;&<60; -0.1541 &<60; 1.2531&<60;&<60; 1.9830&<60;&<60; -0.0774&<60;&<60; 0.2413 &<60; 1.1486&<60;&<60; 2.0440&<60;&<60; -0.0582&<60;&<60; -0.0650 &<60; -3.1401&<60;&<60; -0.1447&<60;&<60; -0.6580&<60;&<60; 0.9562 &<60; -2.9591&<60;&<60; 0.1598&<60;&<60; -0.6581&<60;&<60; 1.1937 &<60; -2.9219&<60;&<60; -0.3637&<60;&<60; -0.1538&<60;&<60; -0.2085&<60; 2.8948&<60;&<60; -2.2745&<60;&<60; 0.2332&<60;&<60; -0.0312 &<60; -3.2972&<60;&<60; -0.0219&<60;&<60; -0.0288&<60;&<60; -0.1436&<60; -1.2737&<60;&<60; 0.7648&<60;&<60; 0.0643&<60;&<60; 0.0858 &<60; -1.0690&<60;&<60; 0.8108&<60;&<60; -0.2723&<60;&<60; 0.3231 &<60; -0.5908&<60;&<60; 0.7508&<60;&<60; -0.5456&<60;&<60; 0.0190 &<60; 0.5808&<60;&<60; 2.0573&<60;&<60; -0.1658&<60;&<60; 0.1709 &<60; 2.8227&<60;&<60; -2.2461&<60;&<60; 0.2255&<60;&<60; -0.3684 &<60; 0.6174&<60;&<60; 1.7654&<60;&<60; -0.3999&<60;&<60; 0.4125 &<60; 3.2587&<60;&<60; -1.9310&<60;&<60; 0.2021&<60;&<60; 0.0800 &<60; 1.0999&<60;&<60; 1.8852&<60;&<60; -0.0475&<60;&<60; -0.0585 &<60; -2.7395&<60;&<60; 0.2585&<60;&<60; -0.8441&<60;&<60; 0.9987 &<60; -1.2223&<60;&<60; 1.0542&<60;&<60; -0.2480&<60;&<60; -0.2795 &<60; -2.9212&<60;&<60; -0.0605&<60;&<60; -0.0259&<60;&<60; 0.2591 &<60; 3.1598&<60;&<60; -2.2631&<60;&<60; 0.1746&<60;&<60; 0.1485 &<60; 0.8476&<60;&<60; 1.8760&<60;&<60; -0.2894&<60;&<60; -0.0354 &<60; 2.9205&<60;&<60; -2.2418&<60;&<60; 0.4137&<60;&<60; -0.2499 &<60; 2.7656&<60;&<60; -2.1768&<60;&<60; 0.0719&<60;&<60; -0.1848 &<60; -0.8698&<60;&<60; 1.0249&<60;&<60; -0.2084&<60;&<60; -0.0008 &<60; -1.1444&<60;&<60; 0.7787&<60;&<60; -0.4958&<60;&<60; 0.3676 &<60; -1.0711&<60;&<60; 1.0450&<60;&<60; -0.0477&<60;&<60; -0.4030 &<60; 0.5350&<60;&<60; 1.8110&<60;&<60; -0.0377&<60;&<60; 0.1622&<60; -2.7887&<60;&<60; -0.2119&<60;&<60; 0.0566&<60;&<60; 0.0120 &<60; -1.2567&<60;&<60; 0.9274&<60;&<60; 0.1104&<60;&<60; 0.1581 &<60; -2.9946&<60;&<60; -0.2086&<60;&<60; -0.8169&<60;&<60; 0.6662 &<60; 1.0536&<60;&<60; 1.9818&<60;&<60; -0.0631&<60;&<60; 0.2581 &<60; -2.8465&<60;&<60; -0.2222&<60;&<60; 0.2745&<60;&<60; 0.1997 &<60; -2.8516&<60;&<60; 0.1649&<60;&<60; -0.7566&<60;&<60; 0.8616 &<60; -3.2470&<60;&<60; 0.0770&<60;&<60; 0.1173&<60;&<60; -0.1092 &<60; -2.9322&<60;&<60; -0.0631&<60;&<60; -0.0062&<60;&<60; -0.0511&<60; -2.7919&<60;&<60; 0.0438&<60;&<60; -0.1935&<60;&<60; -0.5023 &<60; 0.9894&<60;&<60; 1.9475&<60;&<60; -0.0146&<60;&<60; -0.0390 &<60; -2.9659&<60;&<60; -0.1300&<60;&<60; 0.1144&<60;&<60; 0.3410 &<60; -2.7322&<60;&<60; -0.0427&<60;&<60; -1.0758&<60;&<60; 0.9718 &<60; -1.4852&<60;&<60; 0.8592&<60;&<60; -0.0503&<60;&<60; -0.1373 &<60; 2.8845&<60;&<60; -2.1465&<60;&<60; -0.0533&<60;&<60; -0.1044 &<60; -3.1470&<60;&<60; 0.0536&<60;&<60; 0.1073&<60;&<60; 0.3323 &<60; 2.9423&<60;&<60; -2.1572&<60;&<60; 0.0505&<60;&<60; 0.1180 &<60; -3.0683&<60;&<60; 0.3434&<60;&<60; -0.6563&<60;&<60; 0.8960 &<60; 1.3215&<60;&<60; 2.0951&<60;&<60; -0.1557&<60;&<60; 0.3994 &<60; -0.7681&<60;&<60; 1.2075&<60;&<60; -0.2781&<60;&<60; 0.2372 &<60; -0.6964&<60;&<60; 1.2360&<60;&<60; -0.3342&<60;&<60; 0.1662 &<60; -0.6382&<60;&<60; 0.8204&<60;&<60; -0.2587&<60;&<60; 0.3344 &<60; -3.0233&<60;&<60; -0.1496&<60;&<60; -0.2607&<60;&<60; -0.0400&<60; -0.8952&<60;&<60; 0.9872&<60;&<60; 0.0019&<60;&<60; 0.3138 &<60; -0.8172&<60;&<60; 0.6814&<60;&<60; -0.0691&<60;&<60; 0.1009 &<60; -3.3032&<60;&<60; 0.0571&<60;&<60; -0.0243&<60;&<60; -0.1405 &<60; 0.7810&<60;&<60; 1.9013&<60;&<60; -0.3996&<60;&<60; 0.7374 &<60; -0.9030&<60;&<60; 0.8646&<60;&<60; -0.1498&<60;&<60; 0.1112 &<60; -0.8461&<60;&<60; 0.9261&<60;&<60; -0.1295&<60;&<60; -0.0727 &<60; 2.8182&<60;&<60; -2.0818&<60;&<60; -0.1430&<60;&<60; -0.0547 &<60; 2.9295&<60;&<60; -2.3846&<60;&<60; -0.0244&<60;&<60; -0.1400 &<60; 1.0587&<60;&<60; 2.2227&<60;&<60; -0.1250&<60;&<60; 0.0957 &<60; 3.0755&<60;&<60; -1.7365&<60;&<60; -0.0511&<60;&<60; 0.1500 &<60; -1.3076&<60;&<60; 0.8791&<60;&<60; -0.3720&<60;&<60; 0.0331 &<60; -2.8252&<60;&<60; -0.0366&<60;&<60; -0.6790&<60;&<60; 0.7374 &<60; -2.6551&<60;&<60; -0.1875&<60;&<60; 0.3222&<60;&<60; 0.0483 &<60; -2.9659&<60;&<60; -0.1585&<60;&<60; 0.4013&<60;&<60; -0.1402 &<60; -3.2859&<60;&<60; -0.1546&<60;&<60; 0.0104&<60;&<60; -0.1781 &<60; -0.6679&<60;&<60; 1.1999&<60;&<60; 0.1396&<60;&<60; -0.3195 &<60; -1.0205&<60;&<60; 1.2226&<60;&<60; 0.1850&<60;&<60; 0.0050 &<60; -3.0091&<60;&<60; -0.0186&<60;&<60; -0.9111&<60;&<60; 0.9663 &<60; -3.0339&<60;&<60; 0.1377&<60;&<60; -0.9662&<60;&<60; 1.0664&<60; -2.8481&<60;&<60; 0.1963&<60;&<60; -0.1428&<60;&<60; 0.0382 &<60; 1.0796&<60;&<60; 2.1353&<60;&<60; -0.0792&<60;&<60; 0.6491 &<60; -0.8732&<60;&<60; 0.8985&<60;&<60; -0.0049&<60;&<60; 0.0068 &<60; 1.0620&<60;&<60; 2.1478&<60;&<60; -0.1275&<60;&<60; 0.3553 &<60; 3.4509&<60;&<60; -1.9975&<60;&<60; 0.1285&<60;&<60; -0.1575 &<60; -3.2280&<60;&<60; -0.0640&<60;&<60; -1.1513&<60;&<60; 0.8235 &<60; -0.6654&<60;&<60; 0.9402&<60;&<60; 0.0577&<60;&<60; -0.0175 &<60; -3.2100&<60;&<60; 0.2762&<60;&<60; -0.1053&<60;&<60; 0.0626 &<60; 3.0793&<60;&<60; -2.0043&<60;&<60; 0.2948&<60;&<60; 0.0411 &<60; 1.3596&<60;&<60; 1.9481&<60;&<60; -0.0167&<60;&<60; 0.3958 &<60; -3.1267&<60;&<60; 0.1801&<60;&<60; 0.2228&<60;&<60; 0.1179 &<60; -0.7979&<60;&<60; 0.9892&<60;&<60; -0.2673&<60;&<60; 0.4734 &<60; 2.5580&<60;&<60; -1.7623&<60;&<60; -0.1049&<60;&<60; -0.0521 &<60; -0.9172&<60;&<60; 1.0621&<60;&<60; -0.0826&<60;&<60; 0.1501 &<60; -0.7817&<60;&<60; 1.1658&<60;&<60; 0.1922&<60;&<60; 0.0803 &<60; 3.1747&<60;&<60; -2.1442&<60;&<60; 0.1472&<60;&<60; -0.3411 &<60; 2.8476&<60;&<60; -1.8056&<60;&<60; -0.0680&<60;&<60; 0.1536 &<60; -0.6175&<60;&<60; 1.4349&<60;&<60; -0.1970&<60;&<60; -0.1085 &<60; 0.7308&<60;&<60; 1.9656&<60;&<60; 0.2602&<60;&<60; 0.2801&<60; -1.0310&<60;&<60; 1.0553&<60;&<60; -0.2928&<60;&<60; -0.1647 &<60; -2.9251&<60;&<60; -0.2095&<60;&<60; 0.0582&<60;&<60; -0.1813 &<60; -0.9827&<60;&<60; 1.2720&<60;&<60; -0.2225&<60;&<60; 0.2563 &<60; -1.0830&<60;&<60; 1.1158&<60;&<60; -0.0405&<60;&<60; -0.1181 &<60; -2.8744&<60;&<60; 0.0195&<60;&<60; -0.3811&<60;&<60; 0.1455 &<60; 3.1663&<60;&<60; -1.9241&<60;&<60; 0.0455&<60;&<60; 0.1684 &<60; -1.0734&<60;&<60; 0.7681&<60;&<60; -0.4725&<60;&<60; -0.1976];[n,d] = size(x);bn=round(n/k*rand);%第一个随机数在前1/K的范围内nc=[x(bn,:);x(2*bn,:);x(3*bn,:);x(4*bn,:)];%初始聚类中心[cid,nr,centers] = kmeans(x,k,nc)%调用kmeans函数for i=1:150,&<60; if cid(i)==1,&<60;&<60;&<60; plot(x(i,1),x(i,2),'r*') % 显示第一类&<60;&<60;&<60; hold on&<60; else&<60; if cid(i)==2,&<60;&<60;&<60;&<60;&<60; plot(x(i,1),x(i,2),'b*') %显示第二类&<60;&<60;&<60;&<60;&<60; hold on&<60; else&<60;&<60;&<60;&<60;&<60; if cid(i)==3,&<60;&<60;&<60;&<60;&<60;&<60;&<60; plot(x(i,1),x(i,2),'g*') %显示第三类&<60;&<60;&<60;&<60;&<60;&<60;&<60; hold on&<60;&<60;&<60;&<60;&<60; else&<60;&<60;&<60;&<60;&<60;&<60;&<60;&<60;&<60; if cid(i)==4,&<60;&<60;&<60;&<60;&<60;&<60;&<60; plot(x(i,1),x(i,2),'k*') %显示第四类&<60;&<60;&<60;&<60;&<60;&<60;&<60; hold on&<60;&<60;&<60;&<60;&<60;&<60;&<60;&<60;&<60; end&<60;&<60;&<60;&<60;&<60; end&<60; end&<60; endendstrt=['红色*为第一类;蓝色*为第二类;绿色*为第三类;黑色*为第四类' ];text(-4,-3.6,strt); %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%BasicKMeans.m主类function [cid,nr,centers] = kmeans(x,k,nc)[n,d] = size(x);% 设置cid为分类结果显示矩阵cid = zeros(1,n);% Make this different to get the loop started.oldcid = ones(1,n);% The number in each cluster.nr = zeros(1,k);% Set up maximum number of iterations.maxgn= 100;iter = 1;while iter < maxgn%计算每个数据到聚类中心的距离for i = 1:ndist = sum((repmat(x(i,:),k,1)-nc).^2,2);[m,ind] = min(dist); % 将当前聚类结果存入cid中cid(i) = ind;endfor i = 1:k%找到每一类的所有数据,计算他们的平均值,作为下次计算的聚类中心ind = find(cid==i);nc(i,:) = mean(x(ind,:));% 统计每一类的数据个数nr(i) = length(ind);enditer = iter + 1;end% Now check each observation to see if the error can be minimized some more. % Loop through all points.maxiter = 2;iter = 1;move = 1;while iter < maxiter & move ~= 0move = 0;% 对所有的数据进行再次判断,寻求最佳聚类结果for i = 1:ndist = sum((repmat(x(i,:),k,1)-nc).^2,2);r = cid(i); % 将当前数据属于的类给rdadj = nr./(nr+1).*dist'; % 计算调整后的距离[m,ind] = min(dadj); % 早到该数据距哪个聚类中心最近if ind ~= r % 如果不等则聚类中心移动&<60; cid(i) = ind;%将新的聚类结果送给cid&<60; ic = find(cid == ind);%重新计算调整当前类别的聚类中心&<60; nc(ind,:) = mean(x(ic,:));&<60; move = 1;endenditer = iter+1;endcenters = nc;if move == 0disp('No points were moved after the initial clustering procedure.')elsedisp('Some points were moved after the initial clustering procedure.')end。

[转载]MATLAB⾃带的FCM算法整合整理+代码注释详解整理+KFCM与FCM的原⽂地址:MATLAB⾃带的FCM算法整合整理+代码注释详解整理+KFCM与FCM的测试⽐较(转)作者:jiandanjinxin⾸先,我们看以下fcm函数语法使⽤【功能描述】Fuzzy c-means clustering模糊C均值聚类算法,可将输⼊的数据集data聚为指定的cluster_n类【函数描述】语法格式[center, U, obj_fcn] = FCM(data, cluster_n, options)⽤法:1. [center,U,obj_fcn] = FCM(Data,N_cluster,options);2. [center,U,obj_fcn] = FCM(Data,N_cluster);输⼊变量data ---- n*m矩阵,表⽰n个样本,每个样本具有m维特征值cluster_n ---- 标量,表⽰聚合中⼼数⽬,即类别数options ---- 4*1列向量,其中options(1): ⾪属度矩阵U的指数,>1(缺省值: 2.0)options(2): 最⼤迭代次数(缺省值: 100)options(3): ⾪属度最⼩变化量,迭代终⽌条件(缺省值: 1e-5)options(4): 每次迭代是否输出信息标志(缺省值: 0)输出变量center ---- 聚类中⼼U ---- ⾪属度矩阵obj_fcn ---- ⽬标函数值【函数实例】接着,我们来详细研究⼀下fcm的实现代码=============该词条在函数啦的位置fcm/index.php?doc-view-919.html==外⼀篇KFCM与FCM的测试⽐较==从⽐较中可以看出KFCM的迭代步骤更少⽽且可以得出同样模式的聚类,能更有效的进⾏聚类,即将核函数的思想引⼊FCM可以提⾼聚类效率(也可以提⾼聚类的效果尤其是对噪声的抵御能⼒,但这个在下⾯的仿真测试中还没有体现)测试1:测试2:测试3:测试4:测试5:测试6:。

模糊神经和模糊聚类的MATLAB实现模糊神经网络(Fuzzy Neural Networks)是一种结合了模糊逻辑和神经网络的方法,用于处理不确定性和模糊性问题。

它具有模糊逻辑的灵活性和神经网络的学习和优化能力。

在MATLAB中,可以使用Fuzzy Logic Toolbox来实现模糊神经网络。

下面将介绍如何使用MATLAB实现模糊神经网络。

首先,我们需要定义输入和输出的模糊集合。

可以使用Fuzzy Logic Toolbox提供的各种方法来定义模糊集合的隶属函数,例如使用trimf定义三角隶属函数或者使用gaussmf定义高斯隶属函数。

```input1 = trimf(inputRange, [a1, b1, c1]);input2 = gaussmf(inputRange, [mean, sigma]);output = trapmf(outputRange, [d1, e1, f1, g1]);```接下来,可以使用FIS Editor界面来创建和训练模糊神经网络。

在MATLAB命令窗口中输入fuzzy命令即可打开FIS Editor界面。

在FIS Editor界面中,可以添加输入和输出变量,并设置它们的隶属函数。

然后,可以添加规则来定义输入与输出之间的关系。

规则的形式可以使用自然语言或者模糊规则表达式(Fuzzy Rule Expression)。

训练模糊神经网络可以使用基于模糊神经网络的系统识别方法。

在MATLAB中,可以使用anfis函数来进行自适应网络训练。

anfis函数可以根据训练数据自动调整隶属函数参数和规则权重,以优化模糊神经网络的性能。

```fis = anfis(trainingData);```使用trainfis命令可以将训练好的模糊神经网络应用于新的数据。

trainfis命令将输入数据映射到输出模糊集中,并使用模糊推理进行预测。

输出结果是一个模糊集,可以使用defuzz命令对其进行模糊化。

在Matlab中实现模糊聚类和模糊决策的方法引言:模糊聚类和模糊决策作为模糊理论的重要应用分支,已经在各个领域得到了广泛的研究与应用。

在实际问题中,常常会面临到数据具有模糊性、不确定性等挑战。

而模糊聚类和模糊决策方法能够有效地处理这些问题,为解决实际问题提供了有力的工具。

本文将介绍在Matlab中实现模糊聚类和模糊决策的方法,详细介绍模糊聚类和模糊决策的基本原理和常用方法,并以实例进行说明。

一、模糊聚类方法的基本原理模糊聚类方法是在传统的聚类算法的基础上引入了模糊理论的思想,将每个样本与各个聚类中心之间的关系表示为隶属度,从而实现对模糊数据的聚类。

在Matlab中,常用的模糊聚类方法有模糊C均值聚类(FCM)和模糊谱聚类(FSC)等。

(1)模糊C均值聚类(FCM):模糊C均值聚类是模糊聚类方法中最常用的一种方法。

其基本原理是通过迭代的方式,更新样本的隶属度和聚类中心,直至收敛。

在Matlab中,可以使用fcm函数来实现模糊C均值聚类。

下面是一个示例代码:```matlabdata = load('data.mat'); % 导入数据[U, centroids] = fcm(data, k); % 调用fcm函数进行聚类,k是聚类的类别数```(2)模糊谱聚类(FSC):模糊谱聚类是一种基于图论的聚类方法,它通过建立样本的相似度矩阵,然后通过对相似度矩阵进行模糊化处理,进而得到聚类结果。

在Matlab中,可以使用fuzzy_spectral_clustering函数来实现模糊谱聚类。

下面是一个示例代码:```matlabdata = load('data.mat'); % 导入数据[U, V] = fuzzy_spectral_clustering(data, k); % 调用fuzzy_spectral_clustering函数进行聚类,k是聚类的类别数```二、模糊决策方法的基本原理模糊决策方法是一种基于模糊理论的决策方法,它通过将问题中的模糊性和不确定性转化为数学上的隶属度,从而实现对决策问题的处理。

本文在阐述聚类分析方法的基础上重点研究FCM聚类算法。

FCM算法是一种基于划分的聚类算法,它的思想是使得被划分到同一簇的对象之间相似度最大,而不同簇之间的相似度最小。

最后基于MATLAB实现了对图像信息的聚类。

第1章概述聚类分析是数据挖掘的一项重要功能,而聚类算法是目前研究的核心,聚类分析就是使用聚类算法来发现有意义的聚类,即“物以类聚”。

虽然聚类也可起到分类的作用,但和大多数分类或预测不同。

大多数分类方法都是演绎的,即人们事先确定某种事物分类的准则或各类别的标准,分类的过程就是比较分类的要素与各类别标准,然后将各要素划归于各类别中。

确定事物的分类准则或各类别的标准或多或少带有主观色彩。

为获得基于划分聚类分析的全局最优结果,则需要穷举所有可能的对象划分,为此大多数应用采用的常用启发方法包括:k-均值算法,算法中的每一个聚类均用相应聚类中对象的均值来表示;k-medoid算法,算法中的每一个聚类均用相应聚类中离聚类中心最近的对象来表示。

这些启发聚类方法在分析中小规模数据集以发现圆形或球状聚类时工作得很好,但当分析处理大规模数据集或复杂数据类型时效果较差,需要对其进行扩展。

而模糊C均值(Fuzzy C-means,FCM)聚类方法,属于基于目标函数的模糊聚类算法的范畴。

模糊C均值聚类方法是基于目标函数的模糊聚类算法理论中最为完善、应用最为广泛的一种算法。

模糊c均值算法最早从硬聚类目标函数的优化中导出的。

为了借助目标函数法求解聚类问题,人们利用均方逼近理论构造了带约束的非线性规划函数,以此来求解聚类问题,从此类内平方误差和WGSS(Within-Groups Sum of Squared Error)成为聚类目标函数的普遍形式。

随着模糊划分概念的提出,Dunn[10]首先将其推广到加权WGSS函数,后来由Bezdek扩展到加权WGSS的无限族,形成了FCM聚类算法的通用聚类准则。

从此这类模糊聚类蓬勃发展起来,目前已经形成庞大的体系。

第2章聚类分析方法2-1聚类分析聚类分析就是根据对象的相似性将其分群,聚类是一种无监督学习方法,它不需要先验的分类知识就能发现数据下的隐藏结构。

它的目标是要对一个给定的数据集进行划分,这种划分应满足以下两个特性:①类内相似性:属于同一类的数据应尽可能相似。

②类间相异性:属于不同类的数据应尽可能相异。

图2.1是一个简单聚类分析的例子。

图 2.1聚类分析的例子聚类分析是数据挖掘的一项重要功能,而聚类算法是目前研究的核心,聚类分析就是使用聚类算法来发现有意义的聚类,即“物以类聚”。

虽然聚类也可起到分类的作用,但和大多数分类或预测不同。

大多数分类方法都是演绎的,即人们事先确定某种事物分类的准则或各类别的标准,分类的过程就是比较分类的要素与各类别标准,然后将各要素划归于各类别中。

确定事物的分类准则或各类别的标准或多或少带有主观色彩。

聚类分析是归纳的,不需要事先确定分类的准则来分析数据对象,不考虑己知的类标记。

一般情况下,训练数据中不提供类标记,因为不知道从何开始,聚类可以用于产生这种标记。

对象根据最大化类内的相似性,最小化类间的相似性的原则进行聚类或分组,它通过一些计算来把观测进行合理的分类,使得同类的观测比较接近,不同类的观测相差较多。

所形成的每个簇可看成一个对象类,由它可以导出规则。

聚类增强了人们对客观现实的认识,是概念描述和偏差分析的先决条件。

2-2主要聚类算法的分类聚类方法包含很多类型的算法,主要可以分为划分方法、层次方法、基于密度的方法、基于网格的方法和基于模型的方法等几个大类。

(1)划分方法给定一个包含n个对象或数据行的数据集,划分方法将数据集划分为k个子集(划分),其中每个子集均代表一个聚类,即将数据分为k组。

这些组满足以下要求:1.每组至少应包含一个对象;2.每个对象必须只能属于某一组。

后一个要求在一些模糊划分方法中可以放宽。

给定需要划分的个数k,一个划分方法首先创建一个初始划分,然后利用循环再定位技术,即通过移动不同划分(组)中的对象来改变划分内容。

一个好的划分衡量标准通常是使得同一个组中的对象“相近”或彼此相关,而不同组中的对象“较远”或彼此不同。

为获得基于划分聚类分析的全局最优结果,需要穷举所有可能的对象划分,为此大多数应用采用的常用启发方法包括:k-均值算法,算法中的每一个聚类均用相应聚类中对象的均值来表示;k-medoid算法,算法中的每一个聚类均用相应聚类中离聚类中心最近的对象来表示。

这些启发聚类方法在分析中小规模数据集以发现圆形或球状聚类时工作得很好,但当分析处理大规模数据集或复杂数据类型时效果较差,需要对其进行扩展。

(2)层次方法层次方法是通过分解所给定的数据对象集来创建一个层次。

根据层次分解形成的方式,可以将层次方法分为自下而上和自上而下两种类型。

自下而上的层次方法从每个对象均为一个单独的组开始,逐步将这些(对象)组进行合并,直到这些组位于层次顶端或满足终止条件为止。

自上而下层次方法从所有均属于一个组的对象开始,每一次循环将组分解为更小的组,直到每个对象构成一组或满足终止条件为止。

(3)基于密度的方法大多数划分方法是基于对象间距离进行聚类的,这类方法仅能发现圆形或球状的聚类而较难发现具有任意形状的聚类。

而基于密度概念的聚类方法实际上就是不断增长所获得的聚类,直到“邻近”(数据对象或点)密度超过一定域值(如:一个聚类中的点数,或一个给定半径内必须包含至少的点数)为止。

这种方法可以用于消除数据中的噪声(异常数据),以及帮助发现任意形状的聚类。

常用的基于密度的方法,如k-最近邻方法是根据某个对象与其相邻的k个对象的距离和来判断其是否为异常数据。

(4)基于网格的方法基于网格的方法将对象空间划分为有限数目的单元以形成网格结构,所有聚类操作均是在这一网格结构上进行的。

这种方法的主要优点是,由于与数据对象个数无关,而仅与划分对象空间的网格数相关,从而执行时间显得相对较快。

基于网格的方法主要包括GRIDCLUS,BANG-CLUSTERY,STING,wave cluster等(5)基于模型的方法基于模型方法就是为每个聚类假设一个模型,然后再去发现符合相应模型的数据对象。

一个基于模型的算法可以通过构造一个描述数据点空间分布的密度函数来确定具体聚类。

它采用了标准的统计方法,并考虑了“噪声”或异常数据,可以自动确定聚类个数,因此可以产生具有鲁棒性的聚类方法。

还有一些聚类算法是将几种聚类方法的思想结合在一起的,因此有时很难明确界定一个聚类算法究竟属于哪一个聚类方法类别。

此外一些应用也需要将多个聚类技术结合起来才能实现其应用目标。

第3章模糊聚类算法3-1模糊理论的概述和发展模糊集的理论是美国加利福尼亚大学的控制论专家扎德(L.A.Zadeh)教授首先提出来的,近年来发展很快。

1965年,扎德在《信息与控制》(Information and Control)杂志上发表了论文“模糊集合”(Fuzzy Sets)。

这标志着模糊理论的产生。

与其他科学一样,模糊数学也是由于实践的需要产生的,经典数学是以精确性为特征。

但是模糊概念(或现象)处处存在,例如,日常生活中的大、小,快、慢,长、短都无法用具体的尺度衡量都属于模糊概念。

模糊数学目前正沿着理论研究和应用研究两个方向迅速发展。

理论研究主要是经典数学概念的模糊化。

由于模糊集自身的层次结构,使得这种理论研究更加复杂,当然也因而更具吸引力。

目前己形成了模糊拓扑、模糊代数、模糊分析、模糊测度及模糊计算机等模糊数学分支。

应用研究主要是对模糊性的内在规律的探讨,对模糊逻辑及模糊信息处理技术的研究。

模糊数学的应用范围己遍及自然科学与社会科学的几乎所有的领域。

特别是在模糊控制、模式识别、聚类分析、系统评价、数据库、系统决策、人工智能及信息处理等方面取得了显著的成就。

目前,模糊理论方面的专业学术杂志有:Fuzzy Sets and Systems(模糊集与系统,国际模糊系统协会会刊,德国承办),模糊系统与数学(中国模糊系统协会会刊,国防科技大学承办),Fuzzy Math(模糊数学杂志,美国),BUSEFAL(模糊集及其应用研究快报,法国),IEEE Transactions on Fuzzy System(IEEE 模糊系统,美国电气和电子工程师学会主办)。

3-2模糊集合对于一个普通的集合A ,空间中任一元素x ,要么x ∈A 要么x ∉A ,二者必居其一。

如果利用特征函数法来描述元素属于集合的程度,则对于集合A ,其特征函数A ()x μ可以标记为:A 1,0,x A x x A μ∈⎧⎨∉⎩()=(3.1)从上式可以看出,对于任意给定的x ∈X 都有唯一确定的特征函数A ()x μ∈{0,1}与之对应,因此可以将集合A 表示为:A ():{0,1}x X μ→(3.2)其中A ()x μ是从X 到{0,1}的一个映射,它唯一确定了集合A 。

对于模糊集合来说,每一个元素都是以一定的程度属于某个集合,也可以同时以不同的程度隶属于几个集合,那么这种处于中介过渡事物对差异双方所具有的倾向性,通常用隶属度函数(Membership Function )来描述。

隶属度函数是一个表示元素x 隶属于集合A 的程度的函数,可以认为隶属度函数是传统集合中特征函数的推广。

当特征函数A ()x μ的值域有{0,1}二值扩展到[0,1]区间时,就描述了一个模糊集合。

定义2.1:模糊集合:论域X 上的模糊集合A 由隶属度()A x μ来表征,其中()A x μ在实轴的闭区间[0,1]上取值,()A x μ的值反应了X 中的元素x 对于A 的隶属程度。

模糊集合完全由隶属度函数所刻画。

()A x μ的值越接近1,表示x 隶属于A 的程度很高;()A x μ值越接近于0,表示x 隶属于A 的程度很低;当()A x μ的值域为{0,1}二值时,()A x μ演化为普通集合的特征函数A ()x μ,A 便演化成一个普通集合A 。

我们可以认为模糊集合是普通集合的一般化。

对于任给x ∈X ,都有唯一确定的隶属函数()A x μ∈[0,1]与之对应:():{0,1}A x X μ→(3.3)即()A x μ是从X 到[0,1]的一个映射,它唯一确定了模糊集合A 。

3-3模糊聚类传统的聚类分析是一种硬划分,它把每个待识别的对象严格地划分到某类中,具有“非此即彼”的性质,也就是说对于数据空间中的任何元素,或者属于某一类,或者不属于该类,两者必居且仅居其一,因此这种类别划分的界限是分明的。

然而在现实世界中的许多实际问题并没有严格的属性,它们在性态和类属方面存在着中介性,具有“亦此亦彼”的性质,那么用传统的聚类分析就无法解决这类问题。