Hadoop大数据分析平台培训-傅一航

- 格式:pptx

- 大小:1.10 MB

- 文档页数:24

《Hadoop大数据技术》课程教学大纲一、课程基本情况课程代码:1041139083课程名称(中/英文):Hadoop大数据技术/Hadoop Big Data Technology课程类别:专业必修课学分:3.5总学时:56理论学时:32实验/实践学时:24适用专业:数据科学与大数据技术适用对象:本科先修课程:JA V A程序设计、Linux基础教学环境:课堂、多媒体、实验机房二、课程简介《Hadoop大数据技术》课程是数据科学与大数据技术专业的专业必修课程。

《Hadoop大数据技术》主要学习当前广泛使用的大数据Hadoop平台及其主要组件的作用及使用。

通过学习Hadoop 平台框架,学会手动搭建Hadoop环境,掌握Hadoop平台上存储及计算的原理、结构、工作流程,掌握基础的MapReduce编程,掌握Hadoop生态圈常用组件的作用、结构、配置和工作流程,并具备大数据的动手及问题分析能力,使用掌握的知识应用到实际的项目实践中。

课程由理论及实践两部分组成,课程理论部分的内容以介绍Hadoop平台主要组件的作用、结构、工作流程为主,对Hadoop 平台组件的作用及其工作原理有比较深入的了解;课程同时为各组件设计有若干实验,使学生在学习理论知识的同时,提高实践动手能力,做到在Hadoop的大数据平台上进行大数据项目开发。

三、课程教学目标2.课程教学目标及其与毕业要求指标点、主要教学内容的对应关系四、教学内容(一)初识Hadoop大数据技术1.主要内容:掌握大数据的基本概念、大数据简史、大数据的类型和特征、大数据对于企业带来的挑战。

了解对于大数据问题,传统方法、Google的解决方案、Hadoop框架下的解决方案,重点了解Google的三篇论文。

掌握Hadoop核心构成、Hadoop生态系统的主要组件、Hadoop发行版本的差异及如何选择;了解Hadoop典型应用场景;了解本课程内容涉及到的Java语言基础;了解本课程实验涉及到的Linux基础。

大数据hadoop云平台日常运维知识考试1. IT公司所有()应系统为单位配备二线运维现场值班、备班(非现场)人员,确保系统出现故障后第一时间处理。

[单选题] *A.业务系统B.核心系统(正确答案)C.重要系统D.一般系统答案解析:《中移(动)信息技术有限公司IT系统运维质量管理办法》第六章第二十八条核心系统二线运维值班备班管理要求。

IT公司所有核心系统应以系统为单位配备二线运维现场值班、备班(非现场)人员,确保系统出现故障后第一时间处理。

2. 二线运维备班人员应保持7×24小时实时待命状态,确保系统出现故障后()分钟内可接入生产系统开展运维处置工作。

[单选题] *A.30分钟B.20分钟C.15分钟D.10分钟(正确答案)答案解析:《中移(动)信息技术有限公司IT系统运维质量管理办法》第六章第二十八条二线运维备班人员应保持7×24小时实时待命状态,确保系统出现故障后10分钟内可接入生产系统开展运维处置工作。

3. 根据公司割接管理要求,下列哪项不属于“四个必须”管理要求。

[单选题] *A.割接实施过程中涉及的关键步骤、关键动作,必须做到有人复核、有人验证。

B.割接方案经过评审后,方可实施。

涉及或潜在影响多部门或外单位的割接,必须通过割接工单或其它形式提前告知。

C.割接工作涉及或潜在影响其他系统的,必须请相关系统的主体运营部门参与方案评审。

D.各部门应对割接方案进行评审,项目经理作为割接工作的第一责任人,必须要对割接方案进行审核。

(正确答案)答案解析:《中移(动)信息技术有限公司IT系统运维质量管理办法》第七章割接报备管理第三十三条割接管理须遵循“四个必须”管理要求(一)各部门应对割接方案进行评审,部门领导作为割接工作的第一责任人,必须要对割接方案进行审核。

(二)割接工作涉及或潜在影响其他系统的,必须请相关系统的主体运营部门参与方案评审。

(三)割接方案经过评审后,方可实施。

《Hadoop大数据技术原理与应用》课程教学大纲课程编号:3250578学分:4学分学时:72学时(其中:讲课学时36 上机学时:36)先修课程:《Linux基础》、《关系数据库基础》、《程序设计基础》、《Java面向对象编程》后续课程:Spark,《Python编程基础》、《Python数据分析与应用》适用专业:大数据应用技术一、课程的性质与目标《大数据应用开发》本课程是软件技术专业核心课程,大数据技术入门课程。

通过学习课程使得学生掌握大数据分析的主要思想和基本步骤,并通过编程练习和典型应用实例加深了解;同时对Hadoop平台应用与开发的一般理论有所了解,如分布式数据收集、分布式数据存储、分布式数据计算、分布式数据展示。

开设本学科的目的是让学生掌握如何使用大数据分析技术解决特定业务领域的问题。

完成本课程学习后能够熟练的应用大数据技术解决企业中的实际生产问题。

二、教学条件要求操作系统:Center OSHadoop版本:Hadoop2.7.4开发工具:Eclipse三、课程的主要内容及基本要求第1章初识Hadoop第2章构建Hadoop集群第3章 HDFS分布式文件系统第4章 MapReduce分布式计算系统第5章 Zookeeper分布式协调服务第6章 Hadoop2.0新特性第7章 Hive数据仓库第8章 Flume日志采集系统第9章 Azkaban工作流管理器第10章 Sqoop数据迁移第11章综合项目——网站流量日志数据分析系统四、学时分配五、考核模式与成绩评定办法本课程为考试课程,期末考试采用百分制的闭卷考试模式。

学生的考试成绩由平时成绩(30%)和期末考试(70%)组成,其中,平时成绩包括出勤(5%)、作业(5%)、上机成绩(20%)。

六、选用教材和主要参考书本大纲是参考教材《Hadoop大数据技术原理与应用》所设计的。

七、大纲说明本课程的授课模式为:课堂授课+上机,其中,课堂主要采用多媒体的方式进行授课,并且会通过测试题阶段测试学生的掌握程度;上机主要是编写程序,要求学生动手完成指定的程序设计或验证。

《Hadoop大数据技术与应用》课程教学大纲

【课程名称】HadoOP大数据技术与应用

【课程类型】专业必修课

【授课对象】大数据技术与应用、云计算技术与应用专业、人工智能技术专业高职,二年级学生【学时学分】周学时4,64学时,6学分

【课程概况】

《Hadoop大数据技术与应用》课程是大数据技术与应用、云计算技术与应用专业必修课,是计算机基础理论与应用实践相结合的课程,也是大数据专业的高核心课程,它担负着系统、全面地理解大数据,提高大数据应用技能的重任。

本课程的先修课为《大数据技术概论》、《编程基础》、《1inux操作系统》、《数据库设计与实现》等课程,要求学生掌握HadOOP生态系统的框架组件,操作方法。

[课程目标]

通过本课程的学习,让学生接触并了解HadOOP生态系统各组件的原理和使用方法,使学生具有Had。

P相关技术,具备大数据开发的基本技能,并具有较强的分析问题和解决问题的能力,为将来从事大数据相关领域的工作打下坚实的基础。

【课程内容及学时分布】

【使用教材及教学参考书】

使用教材:《Hadoop生态系统及开发》,邓永生、刘铭皓等主编,西安电子

科技大学出版社,2023年

大纲执笔人:

大纲审定人:

年月日。

hardoop教学大纲Hadoop教学大纲随着大数据时代的到来,Hadoop作为一种分布式计算框架,成为了处理海量数据的重要工具。

对于学习Hadoop的人来说,掌握其核心概念和技术是非常重要的。

本文将围绕Hadoop教学大纲展开,帮助读者了解Hadoop的基本知识和应用。

一、Hadoop概述1.1 Hadoop的起源和发展1.2 Hadoop的特点和优势1.3 Hadoop在大数据处理中的应用场景二、Hadoop核心组件2.1 Hadoop分布式文件系统(HDFS)2.1.1 HDFS的架构和工作原理2.1.2 HDFS的数据读写和容错机制2.2 Hadoop分布式计算框架(MapReduce)2.2.1 MapReduce的基本原理和编程模型2.2.2 MapReduce的任务调度和数据处理流程2.3 Hadoop集群管理器(YARN)2.3.1 YARN的架构和功能2.3.2 YARN的资源调度和作业管理三、Hadoop生态系统3.1 Hadoop生态系统的概述3.2 Hadoop的相关工具和组件3.2.1 Hadoop的数据导入和导出工具3.2.2 Hadoop的数据存储和查询工具3.2.3 Hadoop的数据处理和分析工具四、Hadoop的安装和配置4.1 Hadoop的安装环境和前期准备4.2 Hadoop的安装步骤和配置文件4.3 Hadoop集群的搭建和管理五、Hadoop应用开发5.1 Hadoop编程模型和API介绍5.2 Hadoop的数据输入和输出格式5.3 Hadoop的开发工具和调试技巧5.4 Hadoop的性能调优和优化策略六、Hadoop的实际应用6.1 Hadoop在互联网行业的应用案例6.2 Hadoop在金融行业的应用案例6.3 Hadoop在医疗行业的应用案例6.4 Hadoop在其他领域的应用前景七、Hadoop的未来发展7.1 Hadoop的发展趋势和挑战7.2 Hadoop与人工智能的结合7.3 Hadoop在边缘计算中的应用7.4 Hadoop生态系统的扩展和创新总结:通过本文对Hadoop教学大纲的论述,我们可以了解到Hadoop的概述、核心组件、生态系统、安装配置、应用开发以及实际应用等方面的知识。

好程序员大数据培训Hadoop知识要点查缺补漏如果用一个词来形容好程序员最优秀的品质,那么必须提一下最近大火的词汇“佛系”,我就是这样一个默默无闻,辛勤编码的佛系“大叔”,曾经游走大街小巷,英姿勃发,想要拯救世界的傲娇少年,现在电脑桌前噼里啪啦,信手拈来把码来刷!是什么让我一朝佛系?此时此刻必须容我细细说来。

好程序员大数据高端班,风头浪尖,千锤百炼,造就了今天的我。

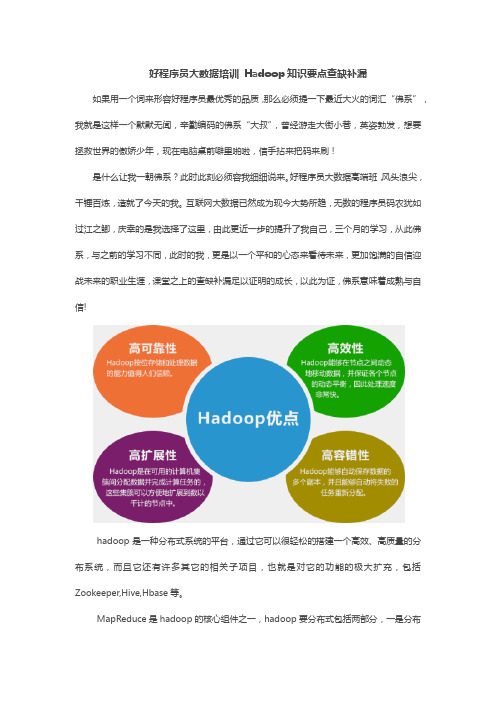

互联网大数据已然成为现今大势所趋,无数的程序员码农犹如过江之鲫,庆幸的是我选择了这里,由此更近一步的提升了我自己,三个月的学习,从此佛系,与之前的学习不同,此时的我,更是以一个平和的心态来看待未来,更加饱满的自信迎战未来的职业生涯,课堂之上的查缺补漏足以证明的成长,以此为证,佛系意味着成熟与自信!hadoop是一种分布式系统的平台,通过它可以很轻松的搭建一个高效、高质量的分布系统,而且它还有许多其它的相关子项目,也就是对它的功能的极大扩充,包括Zookeeper,Hive,Hbase等。

MapReduce是hadoop的核心组件之一,hadoop要分布式包括两部分,一是分布式文件系统hdfs,一部是分布式计算框,就是mapreduce,缺一不可,也就是说,可以通过mapreduce很容易在hadoop平台上进行分布式的计算编程。

Hadoop是一种分布式数据和计算的框架。

它很擅长存储大量的半结构化的数据集。

数据可以随机存放,所以一个磁盘的失败并不会带来数据丢失。

Hadoop也非常擅长分布式计算——快速地跨多台机器处理大型数据集合。

MapReduce是处理大量半结构化数据集合的编程模型。

编程模型是一种处理并结构化特定问题的方式。

例如,在一个关系数据库中,使用一种集合语言执行查询,如SQL。

告诉语言想要的结果,并将它提交给系统来计算出如何产生计算。

还可以用更传统的语言(C++,Java),一步步地来解决问题。

这是两种不同的编程模型,MapReduce就是另外一种。

Hadoop平台搭建与应用教案靠、高性能、分布式和面向列的动态模式数据库。

⑤ ZooKeeper(分布式协作服务):其用于解决分布式环境下的数据管理问题,主要是统一命名、同步状态、管理集群、同步配置等。

⑥ Sqoop(数据同步工具):Sqoop是SQL-to-Hadoop的缩写,主要用于在传统数据库和Hadoop之间传输数据。

⑦ Pig(基于Hadoop的数据流系统):Pig的设计动机是提供一种基于MapReduce 的Ad-Hoc(计算在query时发生)数据分析工具。

⑧ Flume(日志收集工具):Flume是Cloudera开源的日志收集系统,具有分布式、高可靠、高容错、易于定制和扩展的特点。

⑨ Oozie(作业流调度系统):Oozie是一个基于工作流引擎的服务器,可以运行Hadoop的MapReduce和Pig任务。

⑩ Spark(大数据处理通用引擎):Spark提供了分布式的内存抽象,其最大的特点就是快,是Hadoop MapReduce处理速度的100倍。

YARN(另一种资源协调者):YARN是一种新的Hadoop资源管理器,它是一个通用资源管理系统,可为上层应用提供统一的资源管理和调度,它的引入为集群在利用率、资源统一管理和数据共享等方面带来了巨大好处。

Kafka(高吞吐量的分布式发布订阅消息系统):Kafka可以处理消费者规模的网站中的所有动作流数据。

任务1.1 认知大数据,完成系统环境搭建(1)安装CentOS系统(确保CentOS系统版本在7及以上,以便配合后续Docker 安装)。

①在VMware中设置CentOS 7镜像,进入后选择第一项安装CentOS 7,如图1-8所示。

②在新打开页面中设置时间(DATE&TIME),分配磁盘(INSTALLATION DESTINATION)和网络设置(NETWORK&HOST NAME)等,如图1-9所示。

③单击“INSTALLATION DESTINATION”链接,在打开的界面中选择“I will configure partitioning”选项,然后单击“Done”按钮,跳转到分配磁盘页面即可进行磁盘分配,如图1-10所示。

Hadoop实训报告引言Hadoop是一个开源的分布式计算平台,用于处理大规模数据集的存储和分析。

在本次实训中,我们学习了Hadoop的基本概念和使用方法,并通过实践掌握了Hadoop的各种组件及其功能。

实训内容1. Hadoop概述首先,我们学习了Hadoop的基本概念和架构。

Hadoop由HDFS(Hadoop分布式文件系统)和MapReduce两个核心组件组成。

HDFS用于存储大规模数据集,并提供高可靠性和容错性。

MapReduce是一种分布式计算模型,用于将数据分成多个小块,在集群中并行处理。

2. Hadoop安装与配置接下来,我们进行了Hadoop的安装与配置。

首先,我们下载了Hadoop的安装包,并解压到本地目录。

然后,我们配置了Hadoop的环境变量,使其能够在命令行中被识别。

3. Hadoop集群搭建为了更好地理解Hadoop的分布式特性,我们搭建了一个Hadoop集群。

我们使用了三台虚拟机,分别作为一个主节点和两个从节点。

在主节点上配置了HDFS和MapReduce的相关文件,并在从节点上配置了对应的通信信息。

4. Hadoop基本操作在学习了Hadoop的基本概念和架构后,我们开始进行一些基本的Hadoop操作。

首先,我们学习了Hadoop的文件操作命令,如上传、下载、删除等。

然后,我们学习了Hadoop的作业操作命令,如提交作业、查看作业状态等。

5. Hadoop应用开发在掌握了Hadoop的基本操作后,我们开始进行Hadoop应用的开发。

我们使用Java语言编写了一个简单的MapReduce程序,用于统计一个文本文件中的单词出现次数。

通过编写这个程序,我们更深入地理解了MapReduce的工作原理和应用。

6. Hadoop性能优化最后,我们学习了Hadoop的性能优化方法。

我们通过调整各种参数和配置文件,来提高Hadoop的运行效率和并行性能。

我们还学习了如何监控Hadoop集群的运行状态,并根据监控结果进行调整和优化。

你不知道的大数据文/傅一航在过去两年,“大数据”一词成了最流行最时尚的热词,大数据被塑造成了现代企业经营决策的机制,互联网营销的工具,成了传统企业转型的引擎。

特别是,大数据战略上升到国家意志,成了国家竞争力的体现,这使得大数据成了万众瞩目的焦点。

无论是零售、金融、电信、交通,甚至是政治、教育,所有的行业和领域,都可以看到大数据的身影。

网站上大数据论坛,人满为患;关于大数据的协会,也随处可见。

似乎我们面临的企业发展转型、政府治理与变革等问题,有了数据,全部都可以解决。

尽管,大数据可以应用于几乎所有的行业和领域,但对大数据的理解却仍然不多数人想象的那样。

1、大数据就是大?数据要多大才叫大数据,100TB以上?PB级?大数据并没有一个标准的定义,也没有一个定量的描述。

事实上,数据量的大小,并不是想像的那么重要。

大数据不在于大,而在于其是否有价值。

不管是大数据,还是小数据,只要能够用于解决你的商业问题,都是有用的数据。

2、大数据是大公司玩的东东?大数据没有你想像的高不可攀。

大公司确实有实力、有资金、有人才,更有优势投入到大数据的系统建设和大数据技术研究中去。

但大数据的价值不在于系统和技术,而在于应用。

对于大数据的应用,并不需要强大的资金和高深的技术,只需要你有一个待解决的应用问题、一个合适的分析工具,再加上你的一颗富有创新和奇思妙想的大脑即可。

因此,小公司也可以玩转大数据,大数据不是大公司的专用品。

3、大数据是IT部门的事?大数据的主导者到底是IT部门还是业务部门?很多企业都错误地认为,大数据应该IT部门的事情。

大数据的收集、存储、分析确实是IT部门要做的工作。

然而,收集哪些数据?收集的数据如何使用?这些绝对是业务部门的工作。

所以,大数据由谁来主导,就看你的公司到底是技术驱动,还是业务应用驱动的?如果大数据产业链中,你们企业提供技术服务(如IBM),那么你们的大数据战略应该由IT部门来负责;如果你们企业只是想发挥出本企业数据的价值,则应该主要由业务部门来负责。