§2 回归系数的最小二乘估计

- 格式:doc

- 大小:164.50 KB

- 文档页数:7

加权最小二乘回归系数的估计计算过程1. 概述加权最小二乘回归是一种对数据进行线性建模的方法,在现实应用中经常被使用。

通过加权最小二乘回归,我们可以得到对数据的线性关系进行建模的最佳拟合直线,并估计出各个自变量的系数。

本文将详细介绍加权最小二乘回归系数的估计计算过程,以便读者能够深入了解这一方法的原理和实现。

2. 加权最小二乘回归的基本原理加权最小二乘回归方法是最小化因变量的观测值与回归函数预测值之间的加权残差平方和来确定回归系数的方法。

其数学表达式为:(1)min∑wi(yi - β0 - β1xi1 - ... - βpxip)^2其中wi是观测值的权重,yi表示因变量的观测值,β0是截距项,β1到βp为自变量系数,xi1到xip为自变量观测值。

3. 加权最小二乘回归系数的估计计算步骤加权最小二乘回归系数的估计计算过程可以分为以下几个步骤:(1)计算加权变量根据给定的权重,对自变量和因变量进行加权变换,得到加权后的自变量和因变量。

(2)构建加权矩阵根据加权后的自变量和因变量,构建加权矩阵。

加权矩阵是一个n×(p+1)的矩阵,其中n为样本量,p为自变量的个数。

(3)计算加权矩阵的转置矩阵对加权矩阵进行转置,得到加权矩阵的转置矩阵。

(4)计算加权矩阵的乘积将加权矩阵和其转置矩阵相乘,得到乘积矩阵。

(5)计算乘积矩阵的逆矩阵对乘积矩阵进行求逆运算,得到逆矩阵。

(6)计算加权矩阵和因变量的乘积将加权矩阵和因变量相乘,得到乘积向量。

(7)计算回归系数利用逆矩阵和乘积向量,通过线性代数方法计算得到回归系数的估计值。

4. 加权最小二乘回归的优势加权最小二乘回归相对于普通最小二乘回归的优势在于,它能够更好地处理数据的异方差性。

在普通最小二乘回归中,对所有观测值一视同仁,忽略了不同观测值的方差可能不同的情况。

而通过加权最小二乘回归,我们可以根据数据的特点赋予不同观测值不同的权重,从而更准确地估计回归系数。

相关性最小二乘估计回归分析与独立性检验一、相关性相关性是指两个变量之间的相互关系程度。

在统计学中,常用的衡量相关性的指标是相关系数。

相关系数可以分为皮尔逊相关系数和斯皮尔曼相关系数。

1. 皮尔逊相关系数(Pearson correlation coefficient):用于测量两个连续变量之间的线性相关性。

其取值范围为[-1,1],其中1表示完全正相关,-1表示完全负相关,0表示无相关性。

2. 斯皮尔曼相关系数(Spearman correlation coefficient):用于测量两个变量之间的单调相关性,适用于变量类型是有序或等级的情况。

与皮尔逊相关系数类似,斯皮尔曼相关系数的取值范围也是[-1,1]。

二、最小二乘估计最小二乘估计是一种常用的参数估计方法,主要用于线性回归模型。

其思想是通过最小化残差平方和来寻找最优的模型参数。

在回归分析中,最小二乘估计可以帮助我们找到最佳拟合线,使得观测值与预测值之间的差异最小化。

具体而言,最小二乘估计的步骤如下:1.指定一个线性回归模型,并假设模型中的参数。

2.根据观测值和估计的参数计算预测值。

3.计算观测值与预测值之间的差异,即残差。

4.最小化残差平方和,得到最优的模型参数。

最小二乘估计的优点是计算简单,容易理解。

然而,最小二乘估计也有一些局限性,如对异常值敏感等。

三、回归分析回归分析是一种用于研究两个或多个变量之间关系的统计方法。

在回归分析中,自变量用于预测因变量的取值。

回归分析可以帮助我们了解变量之间的相互作用,并可以用于预测未来值。

回归分析主要有两种类型:线性回归和非线性回归。

线性回归假设自变量和因变量之间存在线性关系,而非线性回归假设关系可以是任意的。

回归分析的步骤如下:1.选择回归模型:确定自变量和因变量之间的关系类型。

2.收集数据:收集自变量和因变量的观测值。

3.估计参数:使用最小二乘估计等方法估计回归方程中的参数。

4.检验拟合优度:通过计算残差平方和等指标来评估回归模型的拟合优度。

多元回归分析原理回归分析是一种处理变量的统计相关关系的一种数理统计方法。

回归分析的基本思想是: 虽然自变量和因变量之间没有严格的、确定性的函数关系, 但可以设法找出最能代表它们之间关系的数学表达形式。

回归分析主要解决以下几个方面的问题:(1) 确定几个特定的变量之间是否存在相关关系, 如果存在的话, 找出它们之间合适的数学表达式;(2) 根据一个或几个变量的值, 预测或控制另一个变量的取值, 并且可以知道这种预测或控制能达到什么样的精确度;(3) 进行因素分析。

例如在对于共同影响一个变量的许多变量(因素)之间, 找出哪些是重要因素, 哪些是次要因素, 这些因素之间又有什么关系等等。

回归分析有很广泛的应用, 例如实验数据的一般处理, 经验公式的求得, 因素分析, 产品质量的控制, 气象及地震预报, 自动控制中数学模型的制定等等。

多元回归分析是研究多个变量之间关系的回归分析方法, 按因变量和自变量的数量对应关系可划分为一个因变量对多个自变量的回归分析(简称为“一对多”回归分析)及多个因变量对多个自变量的回归分析(简称为“多对多”回归分析), 按回归模型类型可划分为线性回归分析和非线性回归分析。

本“多元回归分析原理”是针对均匀设计3.00软件的使用而编制的, 它不是多元回归分析的全面内容, 欲了解多元回归分析的其他内容请参阅回归分析方面的书籍。

本部分内容分七个部分, §1~§4介绍“一对多”线性回归分析, 包括数学模型、回归系数估计、回归方程及回归系数的显著性检验、逐步回归分析方法。

“一对多”线性回归分析是多元回归分析的基础, “多对多”回归分析的内容与“一对多”的相应内容类似, §5介绍“多对多”线性回归的数学模型, §6介绍“多对多”回归的双重筛选逐步回归法。

§7简要介绍非线性回归分析。

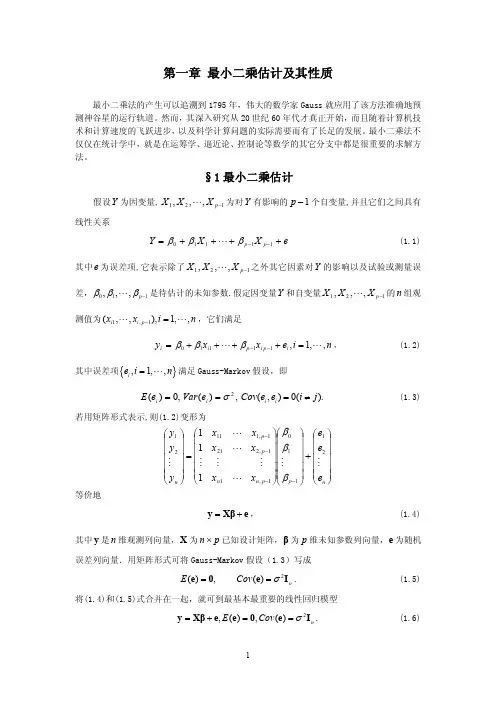

§1 一对多线性回归分析的数学模型§2 回归系数的最小二乘估计§3 回归方程及回归系数的显著性检验§4 逐步回归分析§5 多对多线性回归数学模型§6 双重筛选逐步回归§7 非线性回归模型§1 一对多线性回归分析的数学模型设随机变量与个自变量存在线性关系:, (1.1)(1.1)式称为回归方程, 式中为回归系数, 为随机误差。

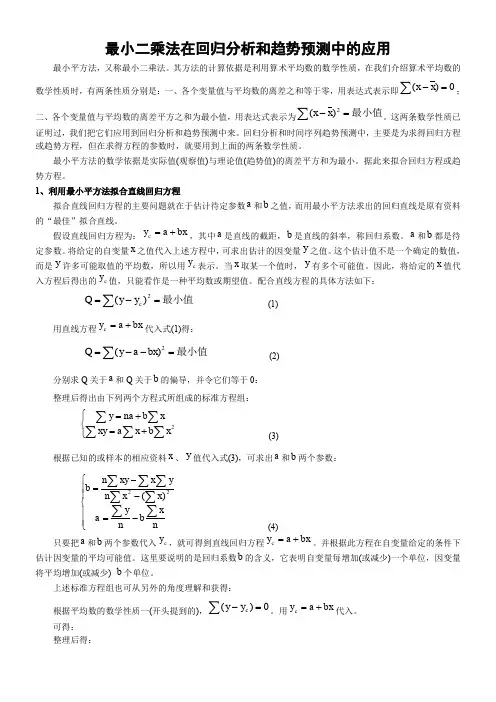

最小二乘法在回归分析和趋势预测中的应用最小平方法,又称最小二乘法。

其方法的计算依据是利用算术平均数的数学性质,在我们介绍算术平均数的数学性质时,有两条性质分别是:一、各个变量值与平均数的离差之和等于零,用表达式表示即0)(=-∑x x ;二、各个变量值与平均数的离差平方之和为最小值,用表达式表示为最小值=-∑2)(x x 。

这两条数学性质已证明过,我们把它们应用到回归分析和趋势预测中来。

回归分析和时间序列趋势预测中,主要是为求得回归方程或趋势方程,但在求得方程的参数时,就要用到上面的两条数学性质。

最小平方法的数学依据是实际值(观察值)与理论值(趋势值)的离差平方和为最小。

据此来拟合回归方程或趋势方程。

1、利用最小平方法拟合直线回归方程拟合直线回归方程的主要问题就在于估计待定参数a 和b 之值,而用最小平方法求出的回归直线是原有资料的“最佳”拟合直线。

假设直线回归方程为:bx a y c +=,其中a 是直线的截距,b 是直线的斜率,称回归系数。

a 和b 都是待定参数。

将给定的自变量x 之值代入上述方程中,可求出估计的因变量y 之值。

这个估计值不是一个确定的数值,而是y 许多可能取值的平均数,所以用c y 表示。

当x 取某一个值时,y 有多个可能值。

因此,将给定的x 值代入方程后得出的c y 值,只能看作是一种平均数或期望值。

配合直线方程的具体方法如下:∑=-=最小值2)(c y y Q (1) 用直线方程bx a y c +=代入式(1)得:最小值=--=∑2)(bx a y Q (2) 分别求Q 关于a 和Q 关于b 的偏导,并令它们等于0: 整理后得出由下列两个方程式所组成的标准方程组:⎩⎨⎧+=+=∑∑∑∑∑2x b x a xy x b na y (3)根据已知的或样本的相应资料x 、y 值代入式(3),可求出a 和b 两个参数:⎪⎪⎩⎪⎪⎨⎧-=--=∑∑∑∑∑∑∑n x b n y a x x n y x xy n b 22)( (4)只要把a 和b 两个参数代入c y ,就可得到直线回归方程bx a y c +=。

估计回归系数的最小二乘法原理一、引言最小二乘法是一种常用的回归分析方法,用于估计自变量和因变量之间的关系。

在实际应用中,我们通常需要通过样本数据来估计回归系数,以便预测未知的因变量值。

本文将介绍最小二乘法原理及其应用。

二、最小二乘法原理最小二乘法是一种寻找最优解的方法,在回归分析中,它被用来寻找使预测值和实际值之间误差平方和最小的回归系数。

具体地说,我们假设有n个样本数据,每个样本数据包含一个自变量x和一个因变量y。

我们希望找到一个线性模型y = β0 + β1x + ε,其中β0和β1是待估参数,ε是误差项。

我们可以通过求解下面的最小化目标函数来得到β0和β1:min Σ(yi - β0 - β1xi)^2这个目标函数表示所有样本数据预测值与实际值之间误差平方和的总和。

我们希望找到一个β0和β1的组合,使得这个总和尽可能地小。

三、最小二乘法求解为了求解上述目标函数的最优解,我们需要对其进行微积分,并令其导数等于0。

具体地说,我们需要求解下面的两个方程组:Σyi = nβ0 + β1ΣxiΣxiyi = β0Σxi + β1Σ(xi)^2这两个方程组分别表示回归线的截距和斜率的估计值。

通过解这两个方程组,我们可以得到最小二乘法的估计结果。

四、最小二乘法的应用最小二乘法在实际应用中非常广泛,尤其是在经济学、统计学和金融学等领域。

例如,在股票市场上,我们可以使用最小二乘法来预测股票价格的变化趋势。

在医学研究中,我们可以使用最小二乘法来确定药物剂量与治疗效果之间的关系。

五、总结最小二乘法是一种常用的回归分析方法,它通过寻找使预测值和实际值之间误差平方和最小的回归系数来估计自变量和因变量之间的关系。

在实际应用中,我们可以使用最小二乘法来预测未知的因变量值,并确定自变量和因变量之间的关系。

多元回归分析原理及例子多元回归分析原理回归分析是一种处理变量的统计相关关系的一种数理统计方法。

回归分析的基本思想是: 虽然自变量和因变量之间没有严格的、确定性的函数关系, 但可以设法找出最能代表它们之间关系的数学表达形式。

回归分析主要解决以下几个方面的问题:(1) 确定几个特定的变量之间是否存在相关关系, 如果存在的话, 找出它们之间合适的数学表达式;(2) 根据一个或几个变量的值, 预测或控制另一个变量的取值, 并且可以知道这种预测或控制能达到什么样的精确度;(3) 进行因素分析。

例如在对于共同影响一个变量的许多变量(因素)之间, 找出哪些是重要因素,哪些是次要因素, 这些因素之间又有什么关系等等。

回归分析有很广泛的应用, 例如实验数据的一般处理, 经验公式的求得, 因素分析, 产品质量的控制, 气象及地震预报, 自动控制中数学模型的制定等等。

多元回归分析是研究多个变量之间关系的回归分析方法, 按因变量和自变量的数量对应关系可划分为一个因变量对多个自变量的回归分析(简称为“一对多”回归分析)及多个因变量对多个自变量的回归分析(简称为“多对多”回归分析), 按回归模型类型可划分为线性回归分析和非线性回归分析。

本“多元回归分析原理”是针对均匀设计3.00软件的使用而编制的, 它不是多元回归分析的全面内容, 欲了解多元回归分析的其他内容请参阅回归分析方面的书籍。

本部分内容分七个部分, §1~§4介绍“一对多”线性回归分析, 包括数学模型、回归系数估计、回归方程及回归系数的显著性检验、逐步回归分析方法。

“一对多”线性回归分析是多元回归分析的基础, “多对多”回归分析的内容与“一对多”的相应内容类似, §5介绍“多对多”线性回归的数学模型, §6介绍“多对多”回归的双重筛选逐步回归法。

§7简要介绍非线性回归分析。

§1 一对多线性回归分析的数学模型§2 回归系数的最小二乘估计§3 回归方程及回归系数的显著性检验§4 逐步回归分析§5 多对多线性回归数学模型§6 双重筛选逐步回归§7 非线性回归模型§1 一对多线性回归分析的数学模型设随机变量与个自变量存在线性关系:, (1.1)(1.1)式称为回归方程, 式中为回归系数, 为随机误差。

估计回归系数的最小二乘法的原理是最小二乘法是一种常见的统计学方法,用于估计数学模型中的未知参数。

在回归分析中,最小二乘法用于确定给定预测变量与响应变量之间的最佳线性关系。

回归系数是这个线性关系中的参数,它包括斜率和截距。

最小二乘法的原理是通过最小化残差平方和来确定回归系数。

残差是指预测的响应变量与实际响应变量之间的差异。

残差平方和是每个残差平方的总和,它表示实际响应变量与预测响应变量之间的总差异。

最小二乘法的目标是找到一条直线,使得残差平方和达到最小值。

这条直线可以被表示为y=b某+a的形式,其中y表示响应变量,某表示预测变量,b表示斜率,a表示截距。

回归系数是直线的斜率和截距,因此最小二乘法的目标是找到最佳的回归系数。

最小二乘法的实现需要使用数学公式来计算回归系数。

首先,计算预测变量和响应变量的均值和方差,然后计算它们之间的协方差。

回归系数可以通过以下公式计算:

b = Cov(某,y) / Var(某)

a = y_mean -

b 某某_mean

其中,b表示斜率,a表示截距,Cov(某,y)表示某和y的协方差,Var(某)表示某的方差,y_mean和某_mean分别表示y和某的均值。

通过最小二乘法估计回归系数的原理是通过最小化残差平方和来确定最佳线性关系。

这个方法可以应用于单变量或多变量回归。

在应用最小二乘法时,我们需要注意数据的线性关系和异常值对回归分析的影响,以确保回归系数的准确性。

估计值的回归方程最小二乘法

最小二乘法是一种常用的回归分析方法,可以用来估计一组数据的回归方程,使得这些数据点的误差平方和最小。

具体步骤如下:

1. 收集数据:首先需要收集一组数据,包括自变量和因变量的测量值。

2. 绘制散点图:将自变量和因变量的测量值绘制成散点图,以便观察数据的分布情况。

3. 计算回归系数:使用最小二乘法计算回归系数,使得所有数据点的误差平方和最小。

回归系数表示自变量每增加一个单位,因变量的变化量。

4. 计算截距:截距表示当自变量为0时,因变量的取值。

同样使用最小二乘法计算截距。

5. 写出回归方程:将计算出的回归系数和截距代入回归方程,即可得到估计值的回归方程。

最小二乘法的优点是可以处理多个自变量和非线性关系,但是它假设误差服从正态分布,且对异常值比较敏感。

在实际应用中,需要根据数据的特点选择合适的回归分析方法。

回归系数的最小二乘估计公式推导回归分析是一种常用的统计方法,用于建立变量之间的关系模型。

其中,回归系数是衡量自变量对因变量的影响程度的重要指标。

最小二乘法是一种常用的估计回归系数的方法。

本文将从最小二乘估计公式的推导角度,介绍回归系数的计算方法。

假设我们有一个包含n个观测样本的数据集,其中自变量为x ,因变量为y 。

我们希望通过这些数据来估计回归方程中的回归系数。

最小二乘法的基本思想是,找到一组回归系数,使得所有样本的残差平方和最小。

我们需要建立回归方程,假设回归方程为:y = β0 + β1*x + ε其中,β0和β1为回归系数,ε为误差项。

我们的目标是找到最优的回归系数,使得误差项的平方和最小。

即,最小化残差平方和:RSS = Σ(yi - β0 - β1*xi)^2为了找到最小化RSS的回归系数,我们需要对RSS进行求导,并令导数等于零。

这样,我们可以得到关于回归系数的方程组,从而解得回归系数的估计值。

对β0求导:∂RSS/∂β0 = -2Σ(yi - β0 - β1*xi) = 0整理得到:Σ(yi - β0 - β1*xi) = 0进一步展开:Σyi - n*β0 - β1*Σxi = 0化简得到:β0 = (Σyi - β1*Σxi) / n接下来,对β1求导:∂RSS/∂β1 = -2Σxi(yi - β0 - β1*xi) = 0展开后得到:Σxi*yi - β0*Σxi - β1*Σ(xi^2) = 0将β0的表达式代入,得到:Σxi*yi - ((Σyi - β1*Σxi) / n)*Σxi - β1*Σ(xi^2) = 0进一步整理可得:Σxi*yi - Σyi*Σxi/n - β1*Σ(xi^2) + β1*Σ(xi^2)/n = 0化简得到:Σxi*yi - Σyi*Σxi/n = β1*Σ(xi^2) - β1*Σ(xi^2)/n再次整理得到:β1 = (Σxi*yi - Σyi*Σxi/n) / (Σ(xi^2) - Σ(xi^2)/n)至此,我们得到了回归系数β0和β1的估计值的计算公式。

多元线性回归与最小二乘估计1.假定条件、最小二乘估计量和高斯—马尔可夫定理 多元线性回归模型:y t = β0 +β1x t 1 +β2x t 2 +…+βk - 1x t k -1 + u t(1.1)其中y t 是被解释变量(因变量),x t j 是解释变量(自变量),u t 是随机误差项,βi , i = 0, 1, … , k - 1是回归参数(通常未知)。

对经济问题的实际意义:y t 与x t j 存在线性关系,x t j , j = 0, 1, … , k - 1, 是y t 的重要解释变量。

u t 代表众多影响y t 变化的微小因素。

使y t 的变化偏离了E( y t ) =多元线性回归与最小二乘估计1.假定条件、最小二乘估计量和高斯—马尔可夫定理 多元线性回归模型:y t = β0 +β1x t 1 +β2x t 2 +…+βk - 1x t k -1 + u t(1.1)其中y t 是被解释变量(因变量),x t j 是解释变量(自变量),u t 是随机误差项,βi , i = 0, 1, … , k - 1是回归参数(通常未知)。

对经济问题的实际意义:y t 与x t j 存在线性关系,x t j , j = 0, 1, … , k - 1, 是y t 的重要解释变量。

u t 代表众多影响y t 变化的微小因素。

使y t 的变化偏离了E( y t ) =β0 +β1x t 1 +β2x t 2 +…+βk - 1x t k -1决定的k 维空间平面。

当给定一个样本(y t , x t 1, x t 2 ,…, x t k -1), t = 1, 2, …, T 时, 上述模型表示为y 1 =β0 +β1x 11 +β2x 12 +…+βk - 1x 1 k -1 + u 1, 经济意义:x t j 是y t 的重要解释变量。

y 2 =β0 +β1x 21 +β2x 22 +…+βk - 1x 2 k -1 + u 2, 代数意义:y t 与x t j 存在线性关系。

§2 回归系数的最小二乘估计

设分别为的最小二乘估计值, 于是的观测值

, , (2.1)

其中为误差的估计值, 称为残差或剩余。

令为的估计值, 则有

, (2.2)

, , (2.3)

(2.3)式表示实际值与估计值的偏离程度。

欲使估计值与实际值拟合的最好, 则应使残差平方和

达到最小, 为此, 我们可以应用微分求极值原理确定, 即解下列方程组

, (2.4)

即

, (2.5)

整理并化简则得以下正规方程组:

, (2.6)

如果记(2.6)式的系数矩阵为, 右端常数项矩阵记为, 则有

, (2.7)

, (2.8)

因此正规方程(2.6)的矩阵形式为

, (2.9)

或

, (2.10)

其中为正规方程中待定的未知实数向量, 如果系数矩阵满秩, 则存在, 此时有

, (2.11)

(2.11)式即为多元线性回归模型(1.2)式中参数的最小二乘估计。

正规方程组(2.6)亦可表达为下述另一种形式, 如果记

, ,

,

则由(2.6)式中第一等式可解出

, (2.12)

再将(2.12)代入到(2.6)其它各式中并经化简整理可得

, (2.13)

又由

, ,

, ,

如果记

, , (2.14)

, , (2.15)

则(2.13)式可以表示为

, (2.16)

(2.16)式称为正规方程组, 解此方程组可得, 再代入到(2.12)式中则得, 于是得回归方程

, (2.17)

(2.17)式称为回归超平面方程。

如果记(2.16)式的系数矩阵为, 右端常数项向量为, 则

,

,

且记, 则正规方程组(2.16)的矩阵形式为

, (2.18)

解(2.18)得

, (2.19)

再代回到(2.12), 则得到。

以下是一对多线性回归分析的两个例子。

例2.1某养猪场估算猪的毛重, 测得14头猪的体长(cm)、胸围(cm)与体重(kg)数据如表1, 试建立与及的预测方程。

表2.1

经计算: , , , ,

,

,

,

,

,

于是正规方程组为

,

解此方程组得

, ,

又

,

因此所求预测回归方程为

回归方程中系数与的含义是体长每增加1cm, 则猪体重毛重平均增加0.522kg, 胸围每增加1cm, 则猪体重毛重平均增加0.475kg。

例2.2某地区二化螟的第一代成虫发生量与四个因素有关, 这四个因素分别如下, 已知原始观测数据如表2.2, 试建立二化螟发生总量的回归方程。

: 冬季积雪期限(单位为周),

: 每年化雪日期(以2月1日为1),

: 二月份平均气温(℃),

: 三月份平均气温(℃),

: 二化螟发生总量(头),

经计算:

,

,

表2.2

,

于是

,

又

=24 + 0.99742×11.8462 + 1.62581×26.6923 + 11.19263×0.3615 + 16.95291×3.1692 = 136.98554,

因此所求二化螟发生总量的预测回归方程为。