基于FPGA的语音识别前端算法研究实现

- 格式:pdf

- 大小:375.50 KB

- 文档页数:4

基于FPGA的卷积神经网络手写数字识别系统的实现共3篇基于FPGA的卷积神经网络手写数字识别系统的实现1随着科技的发展,人工智能已经成为人们生活中不可分割的一部分。

其中,深度学习是人工智能领域的一个热门话题。

而卷积神经网络作为深度学习的重要算法之一,其应用也愈加广泛。

本文将重点介绍基于FPGA的卷积神经网络手写数字识别系统的实现。

一、卷积神经网络简介卷积神经网络(Convolutional Neural Network, CNN)是一种前向反馈人工神经网络,是深度学习中常见的算法之一。

该网络主要用于图像识别、语音识别等领域。

卷积神经网络主要由输入层、隐藏层和输出层构成。

其中,隐藏层包括多个卷积层、池化层和全连接层。

卷积层是卷积神经网络中的核心层,它利用一组可学习的滤波器对输入的图像进行卷积操作,从而获得图像中的特征。

这些特征在后面的池化层和全连接层中都会用到。

池化层则对卷积层中获得的特征图进行降维处理,从而减少计算量。

常见的池化操作有最大池化和平均池化两种。

全连接层则将池化层中的特征图作为输入,进行分类判断。

全连接层的输出通常会经过一个激活函数。

二、FPGA简介FPGA(Field-Programmable Gate Array)是一种可编程逻辑器件,其具有高度灵活性和可重构性。

FPGA可以通过编程实现不同的电路功能,因此在高速、低功耗、高可靠等方面有着很强的优势。

在深度学习中,利用FPGA进行计算的方式可以大大提高计算速度和效率。

三、基于FPGA的卷积神经网络手写数字识别系统本文的识别系统采用了FPGA作为处理器,并使用卷积神经网络对手写数字进行识别,部分个人感想如下。

1. FPGA的搭建本次实验搭建使用的是Altera的CYCLONE II FPGA,需要先进行硬件电路的设计和代码实现。

硬件电路的设计可以使用VHDL或Verilog等HDL语言进行实现,代码实现则可以使用Quartus II或其他类似的软件进行集成。

语音识别的技术实现原理随着人工智能技术的不断发展,语音识别技术越来越成熟。

语音识别技术是指将人的语音信号转换为文字信号的过程。

这种技术已经广泛应用于智能家居、车载导航、医疗诊断等领域,为人们生活的方方面面带来了很多的方便。

语音识别的基本流程语音识别的基本流程包括:信号的获取、预处理、特征提取、语音识别、后处理和结果输出等环节。

这些环节的主要作用是,首先将人的语音信号录制下来,然后对信号进行预处理和特征提取,最终生成可供计算机处理的数学模型,从而实现语音识别。

信号获取语音信号的获取是语音识别技术实现的第一步。

在实际应用中,人们通常使用麦克风等设备采集语音信号,然后将信号传输到计算机中,由计算机对信号进行处理。

预处理语音信号的预处理是为了提高语音识别的准确率。

预处理包括去除杂音、增加信号的能量、滤波等处理方法。

例如,如果语音信号中包含明显的环境噪声,就需要进行噪声消除处理,以提高信号的清晰度和可分辨性。

特征提取语音信号的特征提取是为了将其转化为计算机可以处理的数学模型。

在这个过程中,需要从语音信号中提取出一些特殊的特征,例如频率、音量、节奏等,然后将这些特征映射到数学模型中。

常见的特征提取方法包括Mel 频率倒谱系数(MFCC)、傅里叶变换等。

语音识别语音识别是将语音信号转化为文字信号的过程。

这一过程是通过计算机算法来实现的。

计算机首先将处理后的语音信号转化为数学模型,然后应用统计学知识来计算每个可能的字或词的概率,从而选择最有可能的单词或语句。

最终,计算机将文字结果输出。

后处理语音识别的后处理是为了减少识别错误,提高识别准确率。

后处理可以使用语言模型、上下文信息等进行修正和优化,从而减少识别错误率和提高识别准确率。

结果输出结果输出是将结果呈现给用户的过程。

结果可以直接输出为文字,也可以通过合成语音的方式,将结果直接转化为人类可以听懂的语音。

在实际的应用中,一般会综合考虑应用场景、用户需求等因素,选择输出方式。

语音识别中的端到端技术研究语音识别是指将口述语音转化为文本的过程。

它是如今最热门的研究领域之一,因为语音识别可以提高我们的效率,方便人们的日常工作和生活。

在此领域,端到端技术的出现对于语音识别的开展和研究起到了巨大的推动作用。

什么是端到端技术?端到端(End-to-End)技术是一种新兴的技术领域,是指一个系统能够完整地处理输入信息并输出期望的结果,从而所有处理步骤都由一个统一的系统实现,而不是由多个单元(如系统和模块)协同工作实现的。

在语音识别中,端到端技术指的是通过机器学习算法和神经网络来实现从音频输入到文本输出的完整过程,省略了传统语音识别技术中需要用到的各种模块和中间环节,减少了错误和失误的发生,提高了识别的准确性和效率。

端到端技术的研究现状近年来,端到端技术在语音识别中的应用和研究快速兴起。

大量的研究机构和企业在这一领域积极投入了研究,并发布了许多高水平的论文和科研成果。

例如,2015年,谷歌的语音团队就发布了一篇名为“End-to-End Speech Recognition”的论文,其中提到了他们使用了一个经典的递归神经网络(RNN)作为识别器,取得了显著的成果。

这样的模型可以不需要词典和发音字典,直接学习从声学场景到文本的转换,可以适应不同的语言和方言,从而在离线语音识别领域中取得了不少成绩。

另外,因为英语相比其他语言更加规范,因此在端到端技术领域的研究中,也有不少重要成果。

2016年,IBM的语音团队就在NTIMIT数据集上发布了一篇名为“End-to-End Speech Recognition with Recurrent Neural Networks”的论文,他们使用长短时记忆(LSTM)网络,结合有限状态转移网络(FST)来提高准确性,将最优词图检索添加到最终的解码过程中。

这种系统还可以直接输入音频流,并逐帧输出一个连续的文字流。

端到端技术的优势传统的语音识别技术中,多阶段的算法需要多个子系统共同协作完成。

基于FPGA的神经网络硬件实现随着和深度学习领域的快速发展,神经网络的规模和复杂性不断增加,对计算能力和效率的要求也越来越高。

传统的基于CPU和GPU的实现方式虽然可以实现大规模神经网络的训练和推理,但是存在着计算资源利用率低、功耗高等问题。

FPGA作为一种可编程逻辑器件,具有高度的灵活性和并行计算能力,可以被用来实现神经网络硬件加速器。

本文将介绍基于FPGA的神经网络硬件实现的相关技术和应用。

FPGA(Field Programmable Gate Array)是一种可以通过编程来配置其硬件资源的集成电路。

它由大量的可编程逻辑块和可编程互连资源组成,可以用来实现各种数字电路和算法。

与传统的ASIC和GPU相比,FPGA具有以下优点:可编程性:FPGA可以通过编程来配置其硬件资源,实现不同的算法和电路。

并行计算:FPGA由大量的可编程逻辑块和可编程互连资源组成,可以实现并行计算。

灵活性:FPGA不仅可以用来实现数字电路和算法,还可以用来实现模拟电路和信号处理算法。

低功耗:FPGA的功耗比CPU和GPU低得多,可以提高设备的续航能力和可靠性。

基于FPGA的神经网络硬件实现主要可以分为以下几个步骤:算法设计:根据实际应用需求,设计和实现神经网络模型,确定网络结构和参数。

数据流图设计:将神经网络模型转化为硬件可实现的数据流图,确定每个计算单元的计算方式和数据传输方式。

硬件描述语言编程:使用硬件描述语言(如Verilog或VHDL)编写程序,将数据流图转化为硬件电路。

硬件仿真与验证:使用仿真工具对硬件电路进行仿真测试,验证其正确性和性能是否达到预期。

硬件实现:将硬件电路加载到FPGA上,进行实际测试和性能优化。

基于FPGA的神经网络硬件加速器可以广泛应用于各种领域,如图像处理、语音识别、自然语言处理等。

以下是一个图像处理领域的应用案例:神经网络模型:YOLO(You Only Look Once)算法数据流图设计:将YOLO算法的卷积层、激活层和全连接层等计算单元转化为硬件可实现的数据流图。

基于机器学习的语音识别系统设计与实现语音识别系统是指将语音信号转换为对应的文字或命令的技术系统。

近年来,随着机器学习技术的不断发展与应用,基于机器学习的语音识别系统得到了广泛的关注和研究。

本文将介绍基于机器学习的语音识别系统的设计与实现,并讨论其应用领域、关键技术和挑战。

一、应用领域基于机器学习的语音识别系统广泛应用于语音助手、智能音箱、电话语音识别、语音翻译等领域。

它能够实现方便快捷的人机交互,提高人们对计算机的操作和控制效率,推动智能化应用的发展。

二、系统设计与实现1. 数据采集与预处理语音识别系统的第一步是收集并预处理语音数据。

通常会采集大量的语音样本,包括来自不同说话人的不同语音单元,以确保系统的鲁棒性。

采集的语音数据需要经过预处理,包括语音分帧、语音去噪、音调归一化等步骤,以保证输入的语音数据质量。

2. 特征提取与表示特征提取是将语音信号转换为机器学习算法可接受的数学形式的过程。

常用的特征提取方法包括MFCC(Mel频率倒谱系数)和PLP(偏移谱线性预测系数)等。

这些特征能够捕捉语音信号的频谱特征,并且对噪声具有一定的鲁棒性。

3. 训练模型在语音识别系统中,常用的机器学习算法包括隐马尔可夫模型(HMM)和深度神经网络(DNN)。

通过使用带有标注的语音数据集进行模型训练,可以使系统逐渐学习到语音信号与文本之间的映射关系。

而在模型训练过程中,还可以利用大规模数据和GPU加速技术,以提高模型的准确性和性能。

4. 解码与后处理解码是将音频数据转换为对应的文本或命令的过程。

在解码阶段,语音识别系统会根据模型学习到的语音特征与文本之间的对应关系,选择最有可能的文本输出。

针对不同的场景,还可以应用后处理技术来进一步提升识别结果的准确性。

三、关键技术1. 深度学习随着深度学习技术的快速发展,特别是深度神经网络(DNN)在语音识别领域的广泛应用,语音识别系统的准确性和性能得到了极大的提升。

DNN能够自动提取高级特征并建模语音信号的复杂结构,从而实现更准确的语音识别。

基于深度学习的语音识别系统的研究与实现随着科技的不断发展,语音识别技术也得以迅速提升。

其中基于深度学习的语音识别系统不仅可以识别出口语,还可以识别手语、普通话、英语、粤语等各种语言。

该系统已经广泛应用于人工智能、家庭智能控制、语音助手、智能汽车等领域中,给我们的生活带来了巨大的便利。

一、深度学习在语音识别中的应用深度学习技术是一种人工神经网络技术,它能够模拟人类神经系统对信息进行处理和分析。

在语音识别中,深度学习技术被广泛应用,通过神经网络对声音信号进行处理和分析,而不是传统的傅里叶变换等数学计算方法。

深度学习技术对语音信号进行的处理包括噪声消除、声音特征提取和语音识别等多个方面。

其中对声音特征的提取是深度学习技术中的核心环节,常见的方法包括时域特征分析、频域特征分析和梅尔频率倒谱系数(MFCC)等方法。

通过这些方法对声音信号进行分析和提取,即可为接下来的语音识别提供准确的特征。

二、语音识别系统的构建语音识别系统的构建需要包括四个部分:数据准备、声音特征提取、深度学习模型训练和语音识别结果输出。

其中,数据准备是语音识别中的第一步,需要从各种来源收集大量的语音数据集并进行处理。

声音特征提取是语音识别的第二步,需要采用各种声音特征提取方法对声音信号进行处理和分析。

深度学习模型训练是语音识别的第三步,需要构建深度学习模型并使用训练数据对其进行训练和优化。

最后一步是语音识别结果输出,在这一步中,我们需要根据模型得到的结果进行后续处理和输出结果。

三、语音识别系统的模型选择和优化在语音识别系统的构建过程中,深度学习模型的选择和优化是十分关键的。

常见的语音识别系统模型包括循环神经网络(RNN)、长短时记忆网络(LSTM)和卷积神经网络(CNN)等。

其中,LSTM模型受到了广泛的关注和应用,它具有记忆能力、长序列处理能力以及较强的抗干扰性等优点。

对于模型的优化,我们可以采用dropout、正则化等方法,同时通过采用不同的激活函数和优化器等手段,也能够提高模型的准确率和性能。

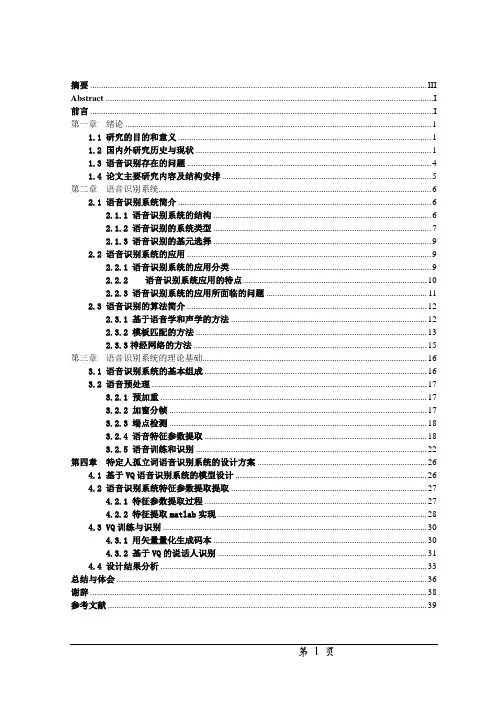

摘要 (III)Abstract (I)前言 (I)第一章绪论 (1)1.1 研究的目的和意义 (1)1.2 国内外研究历史与现状 (1)1.3 语音识别存在的问题 (4)1.4 论文主要研究内容及结构安排 (5)第二章语音识别系统 (6)2.1 语音识别系统简介 (6)2.1.1 语音识别系统的结构 (6)2.1.2 语音识别的系统类型 (7)2.1.3 语音识别的基元选择 (9)2.2 语音识别系统的应用 (9)2.2.1 语音识别系统的应用分类 (9)2.2.2语音识别系统应用的特点 (10)2.2.3 语音识别系统的应用所面临的问题 (11)2.3 语音识别的算法简介 (12)2.3.1 基于语音学和声学的方法 (12)2.3.2 模板匹配的方法 (13)2.3.3神经网络的方法 (15)第三章语音识别系统的理论基础 (16)3.1 语音识别系统的基本组成 (16)3.2 语音预处理 (17)3.2.1 预加重 (17)3.2.2 加窗分帧 (17)3.2.3 端点检测 (18)3.2.4 语音特征参数提取 (18)3.2.5 语音训练和识别 (22)第四章特定人孤立词语音识别系统的设计方案 (26)4.1 基于VQ语音识别系统的模型设计 (26)4.2 语音识别系统特征参数提取提取 (27)4.2.1 特征参数提取过程 (27)4.2.2 特征提取matlab实现 (28)4.3 VQ训练与识别 (30)4.3.1 用矢量量化生成码本 (30)4.3.2 基于VQ的说话人识别 (31)4.4 设计结果分析 (33)总结与体会 (36)谢辞 (38)参考文献 (39)摘要本文主要介绍了语音识别系统的基础知识,包括语音识别系统的应用、结构以及算法。

重点阐述了语音识别系统的原理以及相关算法,通过参考查阅资料,借助MATLAB工具,设计基于VQ码本训练程序和识别程序,识别特定人的语音。

系统主要包括训练和识别两个阶段。

随着语音识别技术的应用越来越广,对其实时性的要求也越来越高。

专用的DSP语音芯片虽然有硬件加速功能,但其指令依然是串行计算,在实时性方面有所欠缺。

如今,具有并行运算能力的FPGA主频不断提高,加上其设计灵活、功耗低、体积小等优点[1],可以满足语音信号实时处理的要求。

目前很多语音处理算法都是基于软件平台的,真正的语音处理硬件实现很少。

本文针对非特定人的语音信号,研究当前主流的语音处理算法,并将这些基于软件平台的算法“硬件化”。

在保证一定精度的前提下将浮点运算转换成便于FPGA实现的定点运算[2]。

本文以通过对语音信号滤波、分帧、加窗、能量计算等模块的设计为例,介绍语音信号实时处理的方法,需要运用到MATLAB.、DSP Builder、QUARTUS II、ModelSim 等EDA工具联合设计[3]。

语音信号经过模数转换进入FPGA以后,对其滤波,因为要对信号进行实时处理,需要采用动态分帧,最后计算出每帧的能量为语音信号的下一步处理如端点检测、特征提取[4]等做好前期准备。

1实时处理算法分析语音数据经过A/D转换之后进入芯片,首先对其进行滤波。

为了使信号的频谱趋向平坦,需要对其进行预加重滤波,这里采用一阶FIR滤波器[5]:H(z)=1-μz-1μ≈0.9375(1)差分方程表示为:s[i]=s[i]-μ×s[i-1]0≤i≤N(2)语音信号虽然是一种非平稳信号,但在短时内(10ms~ 30ms)可以看作是平稳的[2],这样就可以对其进行分帧处理。

在实时系统中无法确定语音的长度和大小,只能对其进行动态分帧。

考虑到帧的连续性,采用交叠分帧,帧移取0.5,硬件中可以用两个FIFO实现,其中FIFO1的读时钟频率是写时钟的两倍,且FIFO2的读写时钟频率与FIFO1读时钟频率相同。

分帧后的数据需要窗函数对其加权,加窗后的语音信号为sω(n)=s(n)×ω(n)。

由于汉明窗在语音频段的平滑特性,因此本文采取汉明窗[4]:基于FPGA的语音信号实时处理姜元亭,樊昌元,杨军华(成都信息工程学院电子工程学院,四川成都610225)摘要:介绍一种在语音识别系统中运用FPGA技术对语音信号进行前期实时处理的方法。

基于FPGA的关键词识别系统实现阙大顺;田犇;赵永安【摘要】随着微电子技术的高速发展,基于片上系统SOC的关键词识别系统的研究已成为当前语音处理领域的研究热点和难点.运用Xilinx公司ViterxII Pro开发板作为硬件平台,结合ISE10.1集成开发环境,完成了语音帧输出、MFCC、VQ 和HMM等子模块的设计;提出了一种语音帧压缩模块架构,有效实现了语音帧信息到VQ标号序列的压缩,实现了由语音帧压缩模块和HMM模块构建的FPGA关键词识别系统.仿真实验结果表明,该系统具有较高的识别率和实时性,为关键词识别系统的FPGA硬件电路的实现研究提供了实例.%With the rapid development of microelectronics, the research of keyword recognition system based on SOC(System on a Chip)has become a hot and difficult topic of speech processing field. This paper completes the module design of speech frame output, Mel Frequency Cepstrum Coefficient(MFCC), Vector Quantization(VQ)and Hidden Markov Model(HMM), using ViterxII Pro board by Xilinx Inc combined with ISE10. 1 integrated development environment. A new structure of speech frame compression module is proposed, which effectively achieves the compression from the speech frame information to VQ label sequence. The Field Programmable Gate Array(FPGA)keyword recognition system is also constructed based on the speech frame compression module and HMM module. The experimental results show that the system has a high recognition rate and good real-time performance. The paper provides an example for studying keyword recognition system based on FPGA.【期刊名称】《计算机工程与应用》【年(卷),期】2013(000)008【总页数】5页(P217-221)【关键词】识别;片上系统(SOC);现场可编程门阵列(FPGA);隐马尔可夫模型(HMM);矢量量化(VQ)【作者】阙大顺;田犇;赵永安【作者单位】武汉理工大学信息工程学院,武汉 430070;武汉理工大学信息工程学院,武汉 430070;深圳华为海思半导体有限公司,广东深圳 518129【正文语种】中文【中图分类】TN912.34关键词识别是指检测连续语音流中是否包含有特定的词并识别出该词,其在人机交互、国防监听、工业控制、交通管理和产品证件防伪等领域都有着广泛应用。

一、概述1.1. 选题意义目前,高科技发展迅速,日新月异,而因为实际需要,各种防盗技术也日趋多样化。

其中智能人声防盗系统引起了我们的兴趣,因此我们选了语音识别算法及其实现这一课题,来探究一下语音识别的原理及其实现过程。

语音识别研究的根本目的是研究出一种具有听觉功能的机器,能直接接受人的口呼命令,理解人的意图并做出相应的反映。

语音识别系统的研究涉及微机技术、人工智能、数字信号处理、模式识别、声学、语言学和认知科学等许多学科领域,是一个多学科综合性研究领域。

近年来,高性能数字信号处理芯片DSP技术的迅速发展,为语音识别的实时实现提供了可能。

其中,凌阳公司的单片机以其良好的性价比和代码的可移植性被广泛地应用于各个领域。

因此,我们采用凌阳公司的具有DSP功能和语音特色的完全SOC技术的凌阳十六位单片机来实现语音信号的识别。

1.2. 实验目的1、掌握特定人语音辨识技术。

2、可以应用于简单语音控制场合。

二、算法原理2.1.语音识别的基本过程根据实际中的应用不同,语音识别系统可以分为:特定人与非特定人的识别、独立词与连续词的识别、小词汇量与大词汇量以及无限词汇量的识别。

但无论那种语音识别系统,其基本原理和处理方法都大体类似。

一个典型的语音识别系统的原理图如图1所示。

语音识别过程主要包括语音信号的预处理、特征提取、模式匹配几个部分。

预处理包括预滤波、采样和量化、加窗、端点检测、预加重等过程。

语音信号识别最重要的一环就是特征参数提取。

提取的特征参数必须满足以下的要求:(1)提取的特征参数能有效地代表语音特征,具有很好的区分性;(2)各阶参数之间有良好的独立性;(3)特征参数要计算方便,最好有高效的算法,以保证语音识别的实时实现。

在训练阶段,将特征参数进行一定的处理后,为每个词条建立一个模型,保存为模板库。

在识别阶段,语音信号经过相同的通道得到语音特征参数,生成测试模板,与参考模板进行匹配,将匹配分数最高的参考模板作为识别结果。

基于深度学习的语音识别系统设计与实现语音识别技术是近年来快速发展的一项重要技术,深度学习技术在其中扮演着重要的角色。

本文将围绕任务名称"基于深度学习的语音识别系统设计与实现"展开分析和讨论。

一、引言语音识别系统的设计与实现是一个复杂的过程,它可以分为两个主要部分:语音特征提取和分类模型训练。

本文将重点介绍使用深度学习算法进行语音特征提取和分类模型训练的方法。

二、语音特征提取1. MFCC特征提取Mel频率倒谱系数(MFCC)是一种常用的语音特征提取方法,它能够有效地捕捉语音信号中的频谱特征。

MFCC特征提取主要包括以下步骤:预处理、短时能量计算、梅尔滤波器组的应用、对数操作、离散余弦变换(DCT)。

通过这些步骤,我们可以得到一个具有较低维度的特征向量表示语音信号。

2. 深度学习特征提取除了MFCC特征外,深度学习技术还可以用于直接从原始语音信号中提取特征。

常用的深度学习模型包括卷积神经网络(CNN)、循环神经网络(RNN)和长短时记忆网络(LSTM)。

这些模型能够自动学习和提取语音信号中的抽象特征,相对于传统的手工特征提取方法具有更好的效果。

三、分类模型训练1. 深度学习分类模型常用的深度学习分类模型包括多层感知机(MLP)、卷积神经网络(CNN)和循环神经网络(RNN)。

这些模型能够通过大量的语音数据进行训练,从而学习到语音信号与对应文本标签之间的映射关系。

模型可以通过反向传播算法进行训练,并通过梯度下降来优化模型的参数。

2. 模型评估与调优在训练完成后,需要对模型进行评估和调优,以提高语音识别的性能。

常用的评估指标包括准确率、召回率和F1值等。

如果模型性能不佳,可以尝试调整模型的参数、增加训练数据或者尝试新的深度学习模型进行训练。

四、实验与结果分析为了验证所设计的基于深度学习的语音识别系统的性能,我们进行了一系列实验。

我们使用了大量的语音数据集进行训练,并将数据集划分为训练集、验证集和测试集。

基于语音识别技术的智能语音交互系统设计与实现随着现代科技的发展,人工智能(AI)领域的研究得到了越来越多的关注。

其中,语音识别技术就是人工智能领域的一项核心技术,而语音交互系统则是应用这一技术的重要领域。

本文将介绍基于语音识别技术的智能语音交互系统的设计与实现。

一、语音识别技术语音识别技术是指将人的声音转换成计算机可识别的文字或命令的技术。

通过对语音信号进行采集、信号处理、特征提取、模型训练等步骤,可以实现语音识别的过程。

语音识别技术的出现,让计算机可以实现与人类语音交互的能力,而智能语音交互系统的应用也因此得以逐渐广泛。

二、智能语音交互系统的应用场景智能语音交互系统是一种实现人机交互的技术,可以让人类通过语音指令控制计算机,实现各种功能。

其中,智能音箱、智能家居控制、智能车载系统等应用,可以让用户通过语音指令控制各种设备,实现更便捷的使用体验。

此外,智能客服、智能助手等应用,也可以通过语音指令实现语音交互的沟通,提高人工智能领域的效率。

三、基于语音识别技术的智能语音交互系统的设计与实现在设计和实现基于语音识别技术的智能语音交互系统时,首先需要进行语音识别的模型训练。

通过建立语言模型和声学模型,提高语音识别的准确率。

同时,还需要通过对用户习惯和语音表达习惯的分析,来优化系统的设计。

接下来,可以通过接入不同的技术模块,来实现不同的应用场景。

例如,可以接入智能家居控制模块,实现智能家居的语音控制。

在实现语音交互的过程中,还需要进行自然语言理解和生成的处理,以实现更自然、更智能的语音交互效果。

在实现智能语音交互系统时,还需要考虑语音数据的保护和安全。

为了避免被黑客攻击,可以采用多种安全措施,例如静态、动态加密,以保护语音数据的安全。

四、智能语音交互系统的未来发展趋势随着技术的进一步发展,智能语音交互系统的应用将会更加广泛。

例如,可以将智能语音交互系统应用于医疗健康领域,实现智能化的医疗服务;也可以将其应用于智慧城市领域,实现智慧交通、智慧停车等应用。