6种粒子群算法程序

- 格式:pdf

- 大小:36.79 KB

- 文档页数:33

粒子群算法1.粒子群算法简介1.1集群智能(Swarm Intelligence)Swarm可被描述为一些相互作用相邻的个体的集合体,蜂群、蚁群、鸟群都是Swarm 的典型例子。

鱼聚集成群可以有效地逃避捕食者,因为任何一只鱼发现异常都可以带动整个鱼群逃避。

蚂蚁成群则有利于寻找食物,因为任何一只蚂蚁发现食物都可以带领蚁群来共同搬运和进食。

一只蜜蜂或蚂蚁的能力非常有限,它几乎不可能独立存在于自然世界中,而多个蜜蜂或蚂蚁形成的Swarm则具有非常强的生存能力,且这种能力不是通过多个个体之间的能力简单叠加所获得的。

社会性动物群体所拥有的这种特性能够帮助个体很好的适应环境,个体所能获得的信息远比它通过自身感觉器官所取得的多,其根本原因在于个体之间存在着信息交互能力。

信息交互过程不仅仅在群体中传播信息,而且群内个体还能处理信息,并根据所获得的信息改变自身的一些行为模式和规范,这就使得群体涌现出一些单个个体不具备的能力和特性,尤其是对环境的适应能力。

这种对环境变化所具有适应的能力可以被认为是一种智能,称为集群智能(Swarm Intelligence)。

集群智能具有如下几个特点:1)群内个体具有执行简单的时间或空间上的评估和计算的能力。

2)群内个体能对环境(包括群内其他个体)的关键性因素的变化做出响应。

3)群内不同个体对环境中某一变化所表现出的响应行为具有多样性。

4)不是每次环境的变化都会导致整个群体的行为模式发生改变。

5)环境所发生的变化中,若出现群体值得付出代价的改变机遇,群体必须能够改变其行为模式。

1.2 粒子群算法介绍粒子群算法,也称粒子群优化算法(Particle Swarm Optimization),缩写为PSO,是根据集群智能Swarm Intelligence思想发展而来的一种算法,最早由Kennedy和Eberhart提出,该算法模拟了鸟群飞行觅食的行为,鸟之间通过集体的协作使群体达到最优目的。

粒子群优化算法程序粒子群优化算法(Particle Swarm Optimization, PSO)是一种基于群体智能的优化算法,它模拟了鸟群或鱼群等生物群体的行为,用于解决各种优化问题。

下面我将从程序实现的角度来介绍粒子群优化算法。

首先,粒子群优化算法的程序实现需要考虑以下几个关键步骤:1. 初始化粒子群,定义粒子的数量、搜索空间的范围、每个粒子的初始位置和速度等参数。

2. 计算适应度,根据问题的特定适应度函数,计算每个粒子的适应度值,以确定其在搜索空间中的位置。

3. 更新粒子的速度和位置,根据粒子的当前位置和速度,以及粒子群的最优位置,更新每个粒子的速度和位置。

4. 更新全局最优位置,根据所有粒子的适应度值,更新全局最优位置。

5. 终止条件,设置终止条件,如最大迭代次数或达到特定的适应度阈值。

基于以上步骤,可以编写粒子群优化算法的程序。

下面是一个简单的伪代码示例:python.# 初始化粒子群。

def initialize_particles(num_particles, search_space):particles = []for _ in range(num_particles):particle = {。

'position':generate_random_position(search_space),。

'velocity':generate_random_velocity(search_space),。

'best_position': None,。

'fitness': None.}。

particles.append(particle)。

return particles.# 计算适应度。

def calculate_fitness(particle):# 根据特定问题的适应度函数计算适应度值。

particle['fitness'] =evaluate_fitness(particle['position'])。

粒子群算法(1)----粒子群算法简介二、粒子群算法的具体表述上面罗嗦了半天,那些都是科研工作者写论文的语气,不过,PSO的历史就像上面说的那样。

下面通俗的解释PSO算法。

PSO算法就是模拟一群鸟寻找食物的过程,每个鸟就是PSO中的粒子,也就是我们需要求解问题的可能解,这些鸟在寻找食物的过程中,不停改变自己在空中飞行的位置与速度。

大家也可以观察一下,鸟群在寻找食物的过程中,开始鸟群比较分散,逐渐这些鸟就会聚成一群,这个群忽高忽低、忽左忽右,直到最后找到食物。

这个过程我们转化为一个数学问题。

寻找函数y=1-cos(3*x)*exp(-x)的在[0,4]最大值。

该函数的图形如下:当x=0.9350-0.9450,达到最大值y=1.3706。

为了得到该函数的最大值,我们在[0,4]之间随机的洒一些点,为了演示,我们放置两个点,并且计算这两个点的函数值,同时给这两个点设置在[0,4]之间的一个速度。

下面这些点就会按照一定的公式更改自己的位置,到达新位置后,再计算这两个点的值,然后再按照一定的公式更新自己的位置。

直到最后在y=1.3706这个点停止自己的更新。

这个过程与粒子群算法作为对照如下:这两个点就是粒子群算法中的粒子。

该函数的最大值就是鸟群中的食物计算两个点函数值就是粒子群算法中的适应值,计算用的函数就是粒子群算法中的适应度函数。

更新自己位置的一定公式就是粒子群算法中的位置速度更新公式。

下面演示一下这个算法运行一次的大概过程:第一次初始化第一次更新位置第二次更新位置第21次更新最后的结果(30次迭代)最后所有的点都集中在最大值的地方。

粒子群算法(2)----标准的粒子群算法在上一节的叙述中,唯一没有给大家介绍的就是函数的这些随机的点(粒子)是如何运动的,只是说按照一定的公式更新。

这个公式就是粒子群算法中的位置速度更新公式。

下面就介绍这个公式是什么。

在上一节中我们求取函数y=1-cos(3*x)*exp(-x)的在[0,4]最大值。

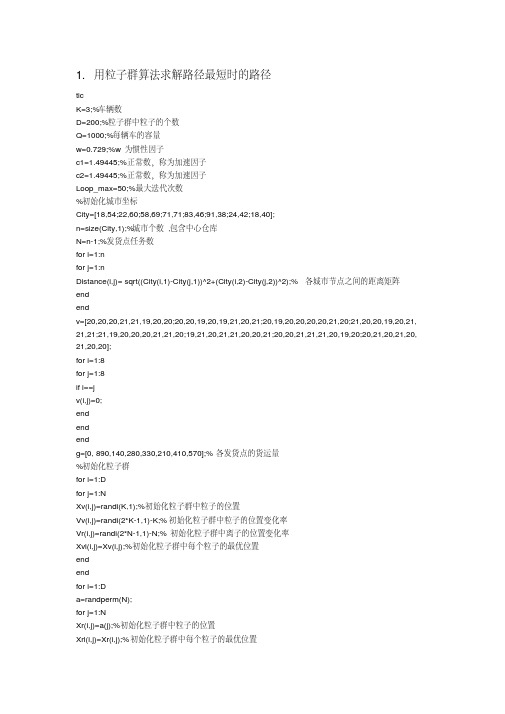

§6.4 粒子群优化算法人们提出了群搜索概念,利用它们来解决现实中所遇到的优化问题,并取得了良好的效果.粒子群优化算法就是群体智能中的一种算法.粒子群算法是一种演化计算技术,是一种基于迭代的优化工具,系统初始化为一组随机解,通过迭代搜寻最优值,将鸟群运动模型中栖息地类比为所求问题空间中可能解的位置,利用个体间的传递,导致整个群体向可能解的方向移动,逐步发现较好解.6.4.1 基本粒子群算法粒子群算法,其核心思想是对生物社会性行为的模拟.最初粒子群算法是用来模拟鸟群捕食的过程,假设一群鸟在捕食,其中的一只发现了食物,则其他一些鸟会跟随这只鸟飞向食物处,而另一些会去寻找更好的食物源.在捕食的整个过程中,鸟会利用自身的经验和群体的信息来寻找食物.粒子群算法从鸟群的这种行为得到启示,并将其用于优化问题的求解.若把在某个区域范围内寻找某个函数最优值的问题看作鸟群觅食行为,区域中的每个点看作一只鸟,现把它叫粒子(particle).每个粒子都有自己的位置和速度,还有一个由目标函数决定的适应度值.但每次迭代也并不是完全随机的,如果找到了新的更好的解,将会以此为依据来寻找下一个解.图6.21给出了粒子运动的思路图.图6.21粒子运动的路线图下面给出粒子群算法的数学描述.假设搜索空间是D维的,群中的第i个粒子能用如下D维矢量所表示:12(,,,)i i i iD X x x x '=(6.43)每个粒子代表一个潜在的解,这个解有D 个维度.每个粒子对应着D 维搜索空间上的一个点.粒子群优化算法的目的是按照预定目标函数找到使得目标函数达到极值的最优点.第i 个粒子的速度或位置的变化能用如下的D 维向量表示:12(,,,)i i i iD V v v v '= (6.44)为了更准确地模拟鸟群,在粒子群优化中引入了两个重要的参量.一个是第i 个粒子曾经发现过的自身历史最优点(Personal best ,pbest),可以表示为:12(,,,)i i i iD P p p p '= (6.45)另一个是整个种群所找到的最优点(Global best ,gbest),可以表示为:12(,,,)g g g gD P p p p '= (6.46)PSO 初始化为一群随机粒子(随机解),然后通过迭代找到最优解.在每一次的迭代中,粒子通过跟踪两个“极值”(i P 和g P )来更新自己.在找到这两个最优值后,粒子通过下面的公式来更新自己的速度和位置:1122(1)()()(()())()(()())id id id id gd id v t wv t c r t p t x t c r t p t x t +=+-+-,(速度更新公式)(6.46)(1)()(1)id id id x t x t v t +=++(位置更新公式) (6.47)其中w 称之为惯性因子,在一般情况下,取1w =,1,2,,t G = 代表迭代序号,G 是预先给出的最大迭代数;1,2,,d D = , 1,2,,i N = ,N 是群的大小;1c 和2c 是正的常数,分别称为自身认知因子和社会认知因子,用来调整i P 和g P 的影响强度.1r 和2r 是区间[0,1]内的随机数.由(6.46)和(6.47)构成的粒子群优化称为原始型粒子群优化.从社会学的角度来看,公式(6.47)的第一部分称为记忆项,表示上次优化中的速度的影响;公式第二部分称为自身认知项,可以认为是当前位置与粒子自身最优位置之间的偏差,表示粒子的下一次运动中来源于自己经验的部分;公式的第三部分称为社会认知项,是一个从当前位置指向种群最佳位置的矢量,反映了群内粒子的协作和知识共享.可见,粒子就是通过自己的经验和同伴中最好的经验来决定下一步的运动.随着迭代进化的不断进行,粒子群逐渐聚集到最优点处,图6.22 给出了某个优化过程中粒子逐渐聚集的示意图.图6.22 粒子群在优化过程聚集示意图 综上所述,我们得到如下基本粒子群算法流程:(1) 设定参数,初始化粒子群,包括随机位置和速度;(2) 评价每个粒子的适应度;(3) 对每个粒子,将其当前适应值与其曾经访问过的最好位置pbest 作比较,如果当前值更好,则用当前位置更新pbest ;(4) 对每个粒子,将其当前适应值与种群最佳位置gbest 作比较,如果当前值更好,则用当前位置更新gbest ;(5) 根据速度和位置更新公式更新粒子;(6)若未满足结束条件则转第二步;否则停止迭代.迭代终止条件根据具体问题一般选为迭代至最大迭代次数或粒子群搜索到的最优位置满足预定的精度阈值.6.4.2 粒子群算法的轨迹分析1998年,Ozcan 在文献[13]中首先对粒子在一维空间的轨迹进行了讨论,并在1999年将粒子运动的轨迹分析推广到多维空间的情形,2002年,文献[14]从矩阵代数的观点讨论了粒子的轨迹问题,本节采用[15]中的差分方程思想分别讨论单个粒子在一维以及二维空间的轨迹问题。

1.用粒子群算法求解路径最短时的路径ticK=3;%车辆数D=200;%粒子群中粒子的个数Q=1000;%每辆车的容量w=0.729;%w为惯性因子c1=1.49445;%正常数,称为加速因子c2=1.49445;%正常数,称为加速因子Loop_max=50;%最大迭代次数%初始化城市坐标City=[18,54;22,60;58,69;71,71;83,46;91,38;24,42;18,40];n=size(City,1);%城市个数,包含中心仓库N=n-1;%发货点任务数for i=1:nfor j=1:nDistance(i,j)= sqrt((City(i,1)-City(j,1))^2+(City(i,2)-City(j,2))^2);%各城市节点之间的距离矩阵endendv=[20,20,20,21,21,19,20,20;20,20,19,20,19,21,20,21;20,19,20,20,20,20,21,20;21,20,20,19,20,21, 21,21;21,19,20,20,20,21,21,20;19,21,20,21,21,20,20,21;20,20,21,21,21,20,19,20;20,21,20,21,20, 21,20,20];for i=1:8for j=1:8if i==jv(i,j)=0;endendendg=[0, 890,140,280,330,210,410,570];%各发货点的货运量%初始化粒子群for i=1:Dfor j=1:NXv(i,j)=randi(K,1);%初始化粒子群中粒子的位置Vv(i,j)=randi(2*K-1,1)-K;%初始化粒子群中粒子的位置变化率Vr(i,j)=randi(2*N-1,1)-N;%初始化粒子群中离子的位置变化率Xvl(i,j)=Xv(i,j);%初始化粒子群中每个粒子的最优位置endendfor i=1:Da=randperm(N);for j=1:NXr(i,j)=a(j);%初始化粒子群中粒子的位置Xrl(i,j)=Xr(i,j);%初始化粒子群中每个粒子的最优位置endLg=100000;%初始化最优粒子对应的配送方案的总路径长度Xvg=ones(1,N);%粒子群中最优的粒子Xrg=ones(1,N);%粒子群中最优的粒子Loop=1;%迭代计数器while Loop<=Loop_max%循环终止条件%对粒子群中的每个粒子进行评价for i=1:Dk1=find(1==Xv(i,:));%找出第一辆车配送的城市编号nb1=size(k1,2);%计算第一辆车配送城市的个数if nb1>0%判断第一辆车配送城市个数是否大于0,如果大于0则a1=[Xr(i,k1(:))];%找出第一辆车配送城市顺序号b1=sort(a1);%对找出第一辆车的顺序号进行排序G1(i)=0;%初始化第一辆车的配送量k51=[];am=[];for j1=1:nb1am=find(b1(j1)==Xr(i,:));k51(j1)=intersect(k1,am);%计算第一辆车配送城市的顺序号G1(i)=G1(i)+g(k51(j1)+1);%计算第一辆车的配送量endk61=[];k61=[0,k51,0];%定义第一辆车的配送路径L1(i)=0;%初始化第一辆车的配送路径长度for k11=1:nb1+1L1(i)=L1(i)+Distance(k61(k11)+1,k61(k11+1)+1);%计算第一辆车的配送路径长度endelse%如果第一辆车配送的城市个数不大于0则G1(i)=0;%第一辆车的配送量设为0L1(i)=0;%第一辆车的配送路径长度设为0endk2=find(2==Xv(i,:));%找出第二辆车配送的城市编号nb2=size(k2,2);%计算第二辆车配送城市的个数if nb2>0%判断第二辆车配送城市个数是否大于0,如果大于0则a2=[Xr(i,k2(:))];%找出第二辆车配送城市的顺序号b2=sort(a2);%对找出的第二辆车的顺序号进行排序G2(i)=0;%初始化第二辆车的配送量k52=[];bm=[];for j2=1:nb2bm=find(b2(j2)==Xr(i,:));k52(j2)=intersect(k2,bm);%计算第二辆车配送城市的顺序号G2(i)=G2(i)+g(k52(j2)+1);%计算第二辆车的配送量k62=[];k62=[0,k52,0];%定义第二辆车的配送路径L2(i)=0;%初始化第二辆车的配送路径长度for k22=1:nb2+1L2(i)=L2(i)+Distance(k62(k22)+1,k62(k22+1)+1);%计算第二辆车的路径长度endelse%如果第二辆车配送的城市个数不大于0则G2(i)=0;%第二辆车的配送量设为0L2(i)=0;%第二辆车的配送路径长度设为0endk3=find(3==Xv(i,:));%找出第三辆车配送的城市编号nb3=size(k3,2);%计算第三辆车配送城市的个数if nb3>0%判断第三辆车配送城市个数是否大于0,如果大于0则a3=[Xr(i,k3(:))];%找出第三辆车配送城市的顺序号b3=sort(a3);%对找出的第三辆车的顺序号进行排序G3(i)=0;%初始化第三辆车的配送量k53=[];cm=[];for j3=1:nb3cm=find(b3(j3)==Xr(i,:));k53(j3)=intersect(k3,cm);%计算第三辆车配送城市的顺序号G3(i)=G3(i)+g(k53(j3)+1);%计算第三辆车的配送量endk63=[];k63=[0,k53,0];%定义第三辆车的配送路径L3(i)=0;%初始化第三辆车的配送路径长度for k33=1:nb3+1L3(i)=L3(i)+Distance(k63(k33)+1,k63(k33+1)+1);%计算第三辆车的路径长度endelse%如果第三辆车配送的城市个数不大于0则G3(i)=0;%第三辆车的配送量设为0L3(i)=0;%第三辆车的配送路径长度设为0endL(i)=0;%初始化每个粒子对应的配送方案总路径长度L(i)=L1(i)+L2(i)+L3(i);%计算每个粒子对应的配送方案总路径长度if L(i)<Lg&&G1(i)<Q&&G2(i)<Q&&G3(i)<Q%如果第i个粒子的总路径长度优于历史最优粒子并且满足车辆容量要求Xvg(:)=Xv(i,:);%将粒子i设为历史最优粒子Xrg(:)=Xr(i,:);%将粒子i设为历史最优粒子Lg=L(i);%将粒子i的总路径长度设为最优粒子对应的配送方案的总路径长度elseXvg(:)=Xvg(:);%最优粒子保持不变Xrg(:)=Xrg(:);%最优粒子保持不变Lg=Lg;%最优粒子所对应的配送方案的总路径长度也不变endLimin(i)=10000000;%初始化每个粒子代表的配送方案的历史最优总路径长度if L(i)<Limin(i)%如果本次循环得到的总路径长度优于粒子i历史最优总路径长度Limin(i)=L(i);%更新本次循环得到的总路径长度为粒子i的历史最优路径长度Xvl(i,:)=Xv(i,:);%更新本次得到的粒子i为i粒子的历史最优位置Xrl(i,:)=Xr(i,:); %更新本次得到的粒子i为i粒子的历史最优位置else%否则,保持粒子i的历史最优位置及历史最优路径长度不变Limin(i)=LL(i);Xvl(i,:)=Xv1(i,:);Xrl(i,:)=Xr1(i,:);endend%记录本次循环得到的所有粒子的位置for i=1:Dfor j=1:NXv1(i,j)=Xvl(i,j);%记录本次循环得到的所有粒子的位置Xr1(i,j)=Xrl(i,j);%记录本次循环得到的所有离子的位置endendLL(i)=0;%初始化每个粒子的历史最优路径总长度for i=1:DLL(i)=Limin(i);%对每个粒子的历史最优路径总长度进行赋值end%对粒子群中每个粒子进行迭代for i=1:Dfor j=1:NVv(i,j)=w*Vv(i,j)+c1*rand(1)*(Xvl(i,j)-Xv(i,j))+c2*rand(1)*(Xvg(1,j)-Xv(i,j));%计算位置变化率Vr(i,j)=w*Vr(i,j)+c1*rand(1)*(Xrl(i,j)-Xr(i,j))+c2*rand(1)*(Xrg(1,j)-Xr(i,j));%计算位置变化率%Vv(i,j)和Vr(i,j)进行上下限的限制if Vv(i,j)>K-1Vv(i,j)=K-1;elseif Vv(i,j)<1-KVv(i,j)=1-K;elseVv(i,j)=Vv(i,j);endendendfor i=1:Dfor j=1:NXv(i,j)=ceil(Xv(i,j)+Vv(i,j));%更新位置坐标%对Xv(i,j)进行上下限的限制if Xv(i,j)>KXv(i,j)=K;elseif Xv(i,j)<1Xv(i,j)=1;elseXv(i,j)=Xv(i,j);endXr(i,j)=Xr(i,j)+Vr(i,j);%更新位置坐标endendzx(Loop)=Lg;Loop=Loop+1;endXvg%输出粒子群中的最优粒子Xrg%输出粒子群中的最优粒子Lg%输出最优粒子所代表方案的总路径长度Loop%输出迭代的次数%计算最优粒子所代表的配送方案k1=find(1==Xvg(:));%找出第一辆车配送的城市编号k1=k1';nb1=size(k1,2);%计算第一辆车配送城市的个数if nb1>0%判断第一辆车配送城市个数是否大于0,如果大于0则a1=[Xrg(k1(:))];%找出第一辆车配送城市顺序号b1=sort(a1);%对找出第一辆车的顺序号进行排序G1=0;%初始化第一辆车的配送量k51=[];am=[];for j1=1:nb1am=find(b1(j1)==Xrg(:));k51(j1)=intersect(k1,am);%计算第一辆车配送城市的顺序号G1=G1+g(k51(j1)+1);%计算第一辆车的配送量endk61=[];k61=[0,k51,0];%定义第一辆车的配送路径L1=0;%初始化第一辆车的配送路径长度for k11=1:nb1+1L1=L1+Distance(k61(k11)+1,k61(k11+1)+1);%计算第一辆车的配送路径长度endelse%如果第一辆车配送的城市个数不大于0则G1=0;%第一辆车的配送量设为0L1=0;%第一辆车的配送路径长度设为0endk2=find(2==Xvg(:));%找出第二辆车配送的城市编号k2=k2';nb2=size(k2,2);%计算第二辆车配送城市的个数。

多目标粒子群算法流程

多目标粒子群算法是一种优化算法,用于解决多目标优化问题。

它的流程包括以下几个步骤:

1. 初始化:设置种群大小、粒子的初始位置和速度、惯性权重等参数。

2. 适应度计算:根据目标函数计算每个粒子的适应度值。

3. 个体历史最优更新:根据粒子的适应度值和历史最优位置,更新每个粒子的个体历史最优位置。

4. 群体历史最优更新:根据所有粒子的个体历史最优位置,更新全局历史最优位置。

5. 速度更新:根据个体历史最优位置和全局历史最优位置,以及惯性权重和加速系数,更新每个粒子的速度。

6. 位置更新:根据更新后的速度,更新每个粒子的位置。

7. 终止条件判断:如果达到指定的终止条件(如迭代次数、适应度值等),则算法停止。

8. 输出结果:输出最优解及其对应的适应度值。

多目标粒子群算法的优点是可以同时考虑多个目标函数,并找到它们之间的权衡点,从而得到更加全面和优秀的解。

- 1 -。

粒⼦群算法粒⼦群算法粒⼦群算法,也称粒⼦群优化算法或鸟群觅⾷算法(Particle Swarm Optimization),缩写为 PSO,是近年来由J. Kennedy和R. C. Eberhart等开发的⼀种新的进化算法(Evolutionary Algorithm - EA)。

PSO 算法属于进化算法的⼀种,和模拟退⽕算法相似,它也是从随机解出发,通过迭代寻找最优解,它也是通过适应度来评价解的品质,但它⽐遗传算法规则更为简单,它没有遗传算法的“交叉”(Crossover)和“变异”(Mutation) 操作,它通过追随当前搜索到的最优值来寻找全局最优。

这种算法以其实现容易、精度⾼、收敛快等优点引起了学术界的重视,并且在解决实际问题中展⽰了其优越性。

粒⼦群算法是⼀种并⾏算法。

1算法介绍粒⼦群优化算法的基本思想是通过群体中个体之间的协作和信息共享来寻找最优解。

PSO的优势在于简单容易实现并且没有许多参数的调节。

⽬前已被⼴泛应⽤于函数优化、神经⽹络训练、模糊系统控制以及其他遗传算法的应⽤领域。

1.1问题提出设想这样⼀个场景:⼀群鸟在随机的搜索⾷物。

在这个区域⾥只有⼀块⾷物,所有的鸟都不知道⾷物在哪。

但是它们知道⾃⼰当前的位置距离⾷物还有多远。

那么找到⾷物的最优策略是什么?最简单有效的就是搜寻⽬前离⾷物最近的鸟的周围区域。

1.2问题抽象鸟被抽象为没有质量和体积的微粒(点),并延伸到N维空间,粒⼦在N维空间的位置表⽰为⽮量X i=(x1,x2,…,x N),飞⾏速度表⽰为⽮量V i=(v1,v2,…,v N)。

每个粒⼦都有⼀个由⽬标函数决定的适应值(fitness value),并且知道⾃⼰到⽬前为⽌发现的最好位置(pbest)和现在的位置X i。

这个可以看作是粒⼦⾃⼰的飞⾏经验。

除此之外,每个粒⼦还知道到⽬前为⽌整个群体中所有粒⼦发现的最好位置(gbest)(gbest 是pbest中的最好值)。

粒子群算法(Particle Swarm Optimization,PSO)是一种基于群体智能的优化算法,用于解决优化问题。

下面是粒子群算法的一般步骤:1. 初始化参数:- 定义问题的适应度函数。

- 设置群体规模(粒子数量)和迭代次数。

- 随机初始化每个粒子的位置和速度。

- 设置每个粒子的个体最佳位置和整个群体的全局最佳位置。

2. 迭代优化:- 对于每个粒子:- 根据当前位置和速度更新粒子的新速度。

- 根据新速度更新粒子的新位置。

- 根据新位置计算适应度函数值。

- 更新粒子的个体最佳位置和整个群体的全局最佳位置。

- 结束条件判断:达到预设的迭代次数或满足特定的停止条件。

3. 输出结果:- 输出全局最佳位置对应的解作为优化问题的最优解。

在更新粒子的速度和位置时,通常使用以下公式:速度更新:v(t+1) = w * v(t) + c1 * r1 * (pbest - x(t)) + c2 * r2 * (gbest - x(t))位置更新:x(t+1) = x(t) + v(t+1)其中:- v(t) 是粒子在时间t 的速度。

- x(t) 是粒子在时间t 的位置。

- w 是惯性权重,用于平衡粒子的历史速度和当前速度的影响。

- c1 和c2 是加速因子,控制个体和全局最佳位置对粒子速度的影响。

- r1 和r2 是随机数,用于引入随机性。

- pbest 是粒子的个体最佳位置。

- gbest 是整个群体的全局最佳位置。

以上是粒子群算法的基本步骤,您可以根据具体的优化问题进行调整和扩展。

写出基本的粒子群算法,并用球形函数验证。

粒子群算法是一种经典的群体智能算法,通过模拟鸟群捕食过程中群体的协同行为,寻找最优解。

其基本思想是将问题的解看作空间中的一个粒子,并通过考虑粒子周围的信息和个体最优解来更新粒子的位置,以找到全局最优解。

本文将介绍基本的粒子群算法,并通过验证球形函数的方式对算法进行测试。

基本的粒子群算法的步骤如下:1.初始化粒子群:随机生成一定数量的粒子,并给每个粒子分配一个随机的初速度和位置。

同时,记录每个粒子的历史最优位置和历史最优适应度。

2.计算粒子的适应度:根据问题的适应度函数,计算每个粒子当前位置的适应度。

3.更新粒子的速度和位置:根据粒子的历史最优位置和全局最优位置来更新粒子的速度和位置。

设第i个粒子的当前速度为Vi,当前位置为Xi,历史最优位置为Pi,全局最优位置为Pg,学习因子为c1和c2,速度更新公式为:Vi(t+1) = w * Vi(t) + c1 * rand() * (Pi - Xi) + c2 * rand() * (Pg - Xi)位置更新公式为:Xi(t+1) = Xi(t) + Vi(t+1)其中,w为惯性因子,rand()为0到1的随机数。

4.更新粒子的历史最优位置:比较粒子当前位置的适应度与其历史最优适应度,如果当前适应度更优,则更新历史最优位置。

5.更新全局最优位置:将当前适应度最优的粒子位置作为全局最优位置。

6.终止条件判断:如果满足终止条件(如达到最大迭代次数或适应度满足要求),则停止算法;否则,回到步骤2。

接下来,我们使用球形函数作为问题的适应度函数对粒子群算法进行验证。

球形函数(Sphere Function)是优化问题中常用的测试函数之一,其计算公式为:f(x) = x1^2 + x2^2 + x3^2 + ... + xn^2其中,n为变量的维度。

首先,我们需要确定算法的参数,包括粒子数量、迭代次数、惯性因子w、学习因子c1和c2的取值等。

基本粒子群算法1. 算法原理基本粒子群算法采用常数因子和及常惯性权重,粒子根据如下的公式来更新自己的速度和新的位置。

2. 算法步骤基本粒子群算法的基本步骤如下:(1)随机初始化种群中各微粒的位置和速度;(2)评价每个微粒的适应度,将当前各微子的位置和适应值存储在各微子的中,将所有的中适应最优个体的位置和适应值存储在中;(3)用下式更新粒子的速度和位移:(4)对每个微粒,将其适应值与其经历的最好位置作比较,如果较好,将其作为当前的最好位置;(5)比较当前所有和的值,更新;(6)若满足停止条件(通常为预设的运算精度或迭代次数),搜索停止,输出结果,否知返回(3)继续搜索。

3. 算法MATLAB实现在MATLAB中编程实现的基本粒子群算法优化函数为:。

功能:用基本粒子群算法求解无约束优化问题。

调用格式:其中,:待优化的目标函数;:粒子数目;:学习因子1;:学习因子2;:惯性权重;:最大迭代次数;:自变量的个数;:目标函数取最小值时的自变量值;:目标函数的最小值。

基本粒子群算法的MATLAB代码如下:function [xm,fv]=PSO(fitness,N,c1,c2,w,M,D)% fitness:待优化的目标函数;% N:粒子数目;% c1:学习因子1;% c2:学习因子2;% w:惯性权重;% M:最大迭代次数;% D:自变量的个数;% xm:目标函数取最小值时的自变量值;% fv:目标函数的最小值。

format long;for i=1:Nfor j=1:Dx(i,j)=randn; %随机初始化位置v(i,j)=randn; %随机初始化速度endendfor i=1:Np(i)=fitness(x(i,:));y(i,:)=x(i,:);endpg=x(N,:); %pg为全局最优for i=1:(N-1)if fitness(x(i,:))<fitness(pg)pg=x(i,:);endendfor t=1:Mfor i=1:N %速度、位移更新v(i,:)=w*v(i,:)+c1*rand*(y(i,:)-x(i,:))+c2*rand*(pg-x(i,:)); x(i,:)=x(i,:)+v(i,:);if fitness(x(i,:))<p(i)p(i)=fitness(x(i,:));y(i,:)=x(i,:);endif p(i)<fitness(pg)pg=y(i,:);endendpbest(t)=fitness(pg);endxm=pg';fv=fitness(pg);例采用基本粒子群算法求取函数的最小值。