一种加权的KNN中文问句分类方法研究

- 格式:pdf

- 大小:176.13 KB

- 文档页数:3

加权knn算法加权KNN算法(Weighted K Nearest Neighbors)是K最近邻算法的一个扩展。

它可以通过引入距离的权重来更准确地推断一个样本的类标号。

权重分配可以根据预定义的接近程度规则而改变,可以增加算法的准确性。

普通KNN算法只考虑某个样本到其它K个最近邻样本的距离,而忽略了样本特征。

例如,假设将一个测试样本和三个训练样本进行比较,训练样本一距离测试样本最近,但是有不同的特征值,而训练样本二和三的特征值较接近于测试样本的特征值,但是距离测试样本比训练样本一要远。

在这种情况下,默认的KNN算法可能会错误地将测试样本归为训练样本一类,而加权KNN算法可以更准确地归类。

加权KNN算法根据距离做一定的改进,所以既考虑了与训练样本的距离,也考虑了特征的值,距离的越近,特征的值越接近,则给其分配的权重越大。

加权KNN算法比普通KNN算法的准确率更高。

由于它考虑了距离和特征的影响,因此可以更加准确地确定来自某个类的样本。

同时,它也可以用于多类分类任务中。

除了距离,加权KNN算法也可以使用其它如时间和特征空间相似性等作为权重来进行分类,从而可以实现更加准确的分类。

加权KNN算法的缺点是时间复杂度比较高,因为它需要计算大量的数据点之间的距离以及权重,加上支持向量机和逻辑回归等其他机器学习方法也可以应用到相似的问题上,所以加权KNN算法并不是最优的选择。

综上所述,加权KNN算法是一种有效的机器学习算法,它可以比普通KNN算法更加准确地推断一个样本的类标号,但也有一定的缺点,包括时间复杂度相对较高等,所以应谨慎使用。

KNN(k近邻)机器学习算法详解KNN算法详解一、算法概述1、kNN算法又称为k近邻分类(k-nearest neighbor classification)算法。

最简单平凡的分类器也许是那种死记硬背式的分类器,记住所有的训练数据,对于新的数据则直接和训练数据匹配,如果存在相同属性的训练数据,则直接用它的分类来作为新数据的分类。

这种方式有一个明显的缺点,那就是很可能无法找到完全匹配的训练记录。

kNN算法则是从训练集中找到和新数据最接近的k条记录,然后根据他们的主要分类来决定新数据的类别。

该算法涉及3个主要因素:训练集、距离或相似的衡量、k的大小。

2、代表论文Discriminant Adaptive Nearest Neighbor ClassificationTrevor Hastie and Rolbert Tibshirani3、行业应用客户流失预测、欺诈侦测等(更适合于稀有事件的分类问题)二、算法要点1、指导思想kNN算法的指导思想是“近朱者赤,近墨者黑”,由你的邻居来推断出你的类别。

计算步骤如下:1)算距离:给定测试对象,计算它与训练集中的每个对象的距离?2)找邻居:圈定距离最近的k个训练对象,作为测试对象的近邻?3)做分类:根据这k个近邻归属的主要类别,来对测试对象分类2、距离或相似度的衡量什么是合适的距离衡量?距离越近应该意味着这两个点属于一个分类的可能性越大。

觉的距离衡量包括欧式距离、夹角余弦等。

对于文本分类来说,使用余弦(cosine)来计算相似度就比欧式(Euclidean)距离更合适。

3、类别的判定投票决定:少数服从多数,近邻中哪个类别的点最多就分为该类。

加权投票法:根据距离的远近,对近邻的投票进行加权,距离越近则权重越大(权重为距离平方的倒数)三、优缺点简单,易于理解,易于实现,无需估计参数,无需训练适合对稀有事件进行分类(例如当流失率很低时,比如低于0.5%,构造流失预测模型)特别适合于多分类问题(multi-modal,对象具有多个类别标签),例如根据基因特征来判断其功能分类,kNN比SVM的表现要好懒惰算法,对测试样本分类时的计算量大,内存开销大,评分慢可解释性较差,无法给出决策树那样的规则。

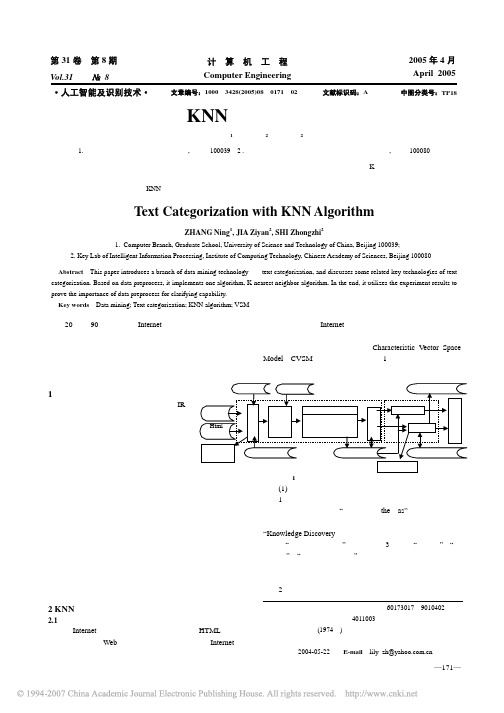

浅谈KNN算法在文本分类中的应用K-最邻近算法在文本分类中的应用目录:一、引言二、算法简介三、KNN的实现过程四、总结分析摘要:随着现在Internet以惊人的速度发展起来,人们已经进入信息大爆炸的时代,网络上的各种信息让我们眼花缭乱,如何在这海量的信息中给各种信息进行分类,从中提取出对我们有用的信息点,已日愈成为众多企业家、IT认识关注的焦点,在众多算法中,可以对信息进行的分类的有很多,包括k-Nearest Neighbor(kNN)、支持向量机(Support VectorMachines, SVM)、简单贝叶斯(Na?ve Bayes,NB)、Linear Least Squares Fits(LLSF)、NeuralNetwork(NNet),而以下则是本人对k-Nearest Neighbor(kNN)算法在文本分类中的见解。

关键字:K-最邻近算法文本分类网页分类经过的简短的16节的数据挖掘课程后,对数据挖掘这一专业方向,从一无所知到,到有所了解,课上简单的了解几个数据挖掘的算法,其中一个印象比较深刻的就K-最邻近算法,但却不知道可以具体运用到什么地方去。

后来,经过课后上网学习研究得知,K-最邻近算法可以运用到分类问题中去,例如:对短信分类、过滤垃圾短信、网络页面分类等。

在网上经过了一番简单的研究,更具体的了解了KNN算法,并得知了在文本分类中的简单运用.一、引言信息时代的发展,离不开Internet的飞速发展,这是一个信息爆炸的时代,人类每天产生的信息量都在急剧增长,而信息量的海量增加离不开网页,为了有效地组织和处理这海量的Web信息,需要对网页进行有效的分类.从文档分类得角度来看,文档分类可以分为人工分类和自动分类.人工分类是根据人的判断来进行分类,其特点是更准确,但是随之来的是确实需要投入大量的人力,这无疑给网络作业带来的高昂的代价,而且人工分类的效率很低,根本赶不上信息增长的速度.面对着每日剧增的信息量,人工分类显得那么的低效和昂贵,因此我们需要对网页实现自动分类,这一技术的实现则可以用到K-最邻近算法(KNN)。

knn算法的解题思路

KNN(K-Nearest Neighbors)算法是一种基于实例的学习,或者说是非泛化学习。

其基本思想是:在特征空间中,如果一个实例的大部分近邻都属于某个类别,则该实例也属于这个类别。

以下是使用KNN算法进行分类的解题思路:

1. 选择距离度量方式:首先,需要选择一个合适的距离度量方式。

常用的距离度量方式有欧氏距离、曼哈顿距离等。

选择哪种距离度量方式取决于数据的性质和问题背景。

2. 选择K值:K是一个用户定义的参数,表示在计算某个实例的类别时考虑的近邻数量。

选择合适的K值非常重要,因为K值太小可能导致模型过于敏感,而K值太大则可能导致模型过于平滑。

通常,可以通过交叉验证来选择最佳的K 值。

3. 计算距离:对于待分类的实例,计算其与训练集中每个实例的距离。

距离的计算可以使用上述选择的距离度量方式。

4. 找出K个最近邻:根据计算出的距离,找出待分类实例的K个最近邻。

5. 投票:对于待分类实例的类别,由其K个最近邻进行投票决定。

具体的投票方式可以是多数投票,也可以是加权投票。

6. 返回结果:返回投票结果作为待分类实例的类别。

需要注意的是,KNN算法虽然简单,但在某些情况下可能会出现过拟合或欠拟合的问题。

为了解决这些问题,可以使用一些优化技巧,例如使用核技巧、选择合适的距离度量方式、使用加权KNN等。

一种基于关联分析的KNN文本分类方法范恒亮;成卫青【摘要】KNN算法在数据挖掘的分支-文本分类中有重要的应用。

在分析了传统KNN方法不足的基础上,提出了一种基于关联分析的KNN改进算法。

该方法首先针对不同类别的训练文本提取每个类别的频繁特征集及其关联的文本,然后基于对各个类别文本的关联分析结果,为未知类别文本确定适当的近邻数k,并在已知类别的训练文本中快速选取k个近邻,进而根据近邻的类别确定未知文本的类别。

相比于基于传统KNN的文本分类方法,改进方法能够较好地确定k值,并能降低时间复杂度。

实验结果表明,文中提出的基于改进KNN的文本分类方法提高了文本分类的效率和准确率。

%The KNN algorithm is largely applied in text classification,one branch of data mining. On the basis of analyzing the deficien-cies of the traditional KNN method,an improved KNN algorithm based on association analysis is proposed in this paper. In this method, frequent feature sets for each class of training documents and associated documents should be extracted in advance. When a document with unknown class is to be classified,by the use of the results of association analysis,the number of nearest neighbors,k can be decided,k nearest neighbors can be found quickly from all classes of training documents,and the class of the document can be decided by the classes of its neighbors. Compared with the traditional KNN algorithm,this method has greatly improved in the selection of the best number of nearest neighbors. Moreover,it can also reduce the time complexity of the algorithm. Theexperimental results show that the proposed al-gorithm has better efficiency and accuracy in text classification.【期刊名称】《计算机技术与发展》【年(卷),期】2014(000)006【总页数】4页(P71-74)【关键词】数据挖掘;文本分类;KNN;关联分析【作者】范恒亮;成卫青【作者单位】南京邮电大学计算机学院,江苏南京 210003;南京邮电大学计算机学院,江苏南京 210003【正文语种】中文【中图分类】TP301随着网络信息技术的飞速发展,Internet的信息资源呈现指数级的增长趋势,而文本作为最基本的信息载体,其分类技术已经成为现代信息处理的一大热点。

基于改进KNN算法的中文文本分类方法王爱平;徐晓艳;国玮玮;李仿华【期刊名称】《微型机与应用》【年(卷),期】2011(030)018【摘要】介绍了中心向量算法和KNN算法两种分类方法。

针对KNN分类方法在计算文本相似度时存在的不足,提出了改进方案。

新方案引入了中心向量分类法的思想。

通过实验,对改进的KNN算法、中心向量算法和传统的KNN算法应用于文本分类效果进行了比较。

实验结果表明,改进的KNN算法较中心向量法和传统的KNN算法在处理中文文本分类问题上有较好的分类效果,验证了对KNN算法改进的有效性和可行性。

%This paper mainly introduces the central vector algorithms and KNN algorithms two classification method. According to KNN classification method in calculating text the shortcomings of the similarity, put out one improved scheme. The new scheme introduces the idea of central vector classification method. At last an empirical study of using the improved KNN algorithm,the central vector algorithm and the traditional KNN algorithm to categorize the Chinese text is conducted. The result of the experiment shows that,compared with central vector algorithm and traditional KNN algorithm,improved KNN algorithm has better categorization effect of the Chinese text,and verify the validity and feasibility of improvement KNN algorithm.【总页数】4页(P8-10,13)【作者】王爱平;徐晓艳;国玮玮;李仿华【作者单位】安徽大学计算智能与信号处理教育部重点实验室,安徽合肥230039;安徽大学计算智能与信号处理教育部重点实验室,安徽合肥230039;安徽大学计算智能与信号处理教育部重点实验室,安徽合肥230039;安徽大学计算智能与信号处理教育部重点实验室,安徽合肥230039【正文语种】中文【中图分类】TP39【相关文献】1.应用于中文文本分类的改进KNN算法 [J], 刘慧;杨宏光2.基于粗糙集与改进KNN算法的文本分类方法的研究 [J], 邵莉3.一种基于改进型KNN算法的文本分类方法 [J], 钱强;庞林斌;高尚4.基于改进ERNIE模型的中文文本分类方法 [J], 邢照野;刘晓群5.基于改进的kNN算法的中文网页自动分类方法研究 [J], 胡燕;吴虎子;钟珞因版权原因,仅展示原文概要,查看原文内容请购买。