Feudal reinforcement learning

- 格式:pdf

- 大小:94.20 KB

- 文档页数:8

matlab中reinforcement learning designer使用**1.MATLAB中强化学习设计师简介**MATLAB中的强化学习设计师(Reinforcement Learning Designer)是一个强大的工具,可以帮助研究人员和工程师快速实现和测试强化学习算法。

通过这个工具,用户可以方便地构建、训练和评估各种强化学习模型。

在MATLAB中,强化学习设计师基于REINFORCE算法进行实现。

**2.强化学习基本概念与原理**强化学习是一种通过与环境互动学习最优行为策略的机器学习技术。

在强化学习中,智能体(Agent)通过执行动作(Action)获得奖励(Reward),并根据奖励信号调整策略以最大化累积奖励。

强化学习的核心目标是找到一个最优策略,使得智能体在无限次与环境互动中获得的累积奖励最大。

**3.REINFORCE算法介绍**REINFORCE(Reinforcement Learning with Policy Gradient)是一种基于梯度的强化学习算法,用于学习连续动作空间中的最优策略。

REINFORCE 算法通过估计策略梯度来更新策略,从而使累积奖励最大化。

REINFORCE的主要优点是能够处理高维动作空间和连续状态空间,适用于许多实际应用场景。

**4.示例:使用REINFORCE解决连续控制问题**以下是一个使用MATLAB中强化学习设计师解决连续控制问题的示例:- 首先,定义环境参数,如状态空间、动作空间和奖励函数;- 然后,创建一个REINFORCE对象,并设置相关参数,如学习率、折扣因子和梯度裁剪;- 接下来,初始化智能体状态和缓冲区;- 开始训练,通过不断与环境互动,更新智能体策略;- 最后,评估智能体在测试环境中的表现,并优化算法参数以提高性能。

**5.总结与展望**MATLAB中的强化学习设计师为研究人员和工程师提供了一个便捷的平台,可以快速实现和测试强化学习算法。

强化学习强化学习(Reinforcement Learning, RL),又称再励学习、评价学习或增强学习,是机器学习的范式和方法论之一,用于描述和解决智能体(agent)在与环境的交互过程中通过学习策略以达成回报最大化或实现特定目标的问题。

强化学习的常见模型是标准的马尔可夫决策过程(Markov Decision Process, MDP)。

按给定条件,强化学习可分为基于模式的强化学习(model-based RL)和无模式强化学习(model-free RL),以及主动强化学习(active RL)和被动强化学习(passive RL)。

强化学习的变体包括逆向强化学习、阶层强化学习和部分可观测系统的强化学习。

求解强化学习问题所使用的算法可分为策略搜索算法和值函数(value function)算法两类。

深度学习模型可以在强化学习中得到使用,形成深度强化学习。

强化学习理论受到行为主义心理学启发,侧重在线学习并试图在探索-利用(exploration-exploitation)间保持平衡。

不同于监督学习和非监督学习,强化学习不要求预先给定任何数据,而是通过接收环境对动作的奖励(反馈)获得学习信息并更新模型参数。

强化学习问题在信息论、博弈论、自动控制等领域有得到讨论,被用于解释有限理性条件下的平衡态、设计推荐系统和机器人交互系统。

一些复杂的强化学习算法在一定程度上具备解决复杂问题的通用智能,可以在围棋和电子游戏中达到人类水平。

中文名强化学习外文名Reinforcement Learning, RL别名再励学习,评价学习,增强学习;强化学习是智能体(Agent)以“试错”的方式进行学习,通过与环境进行交互获得的奖赏指导行为,目标是使智能体获得最大的奖赏,强化学习不同于连接主义学习中的监督学习,主要表现在强化信号上,强化学习中由环境提供的强化信号是对产生动作的好坏作一种评价(通常为标量信号),而不是告诉强化学习系统RLS(reinforcement learning system)如何去产生正确的动作。

多智能体强化学习的几种BestPractice(草稿阶段,完成度40%)多智能体强化学习的几种Best Practice - vonZooming的文章 - 知乎 https:///p/99120143这里分享一下A Survey and Critique of Multiagent Deep Reinforcement Learning这篇综述里面介绍的多智能体强化学习Best Practice。

这部分内容大部分来自第四章,但是我根据自己的理解加上了其他的内容。

1.改良Experience replay buffer1.1 传统的Single-agent场景之下的Replay bufferReplay Buffer[90, 89]自从被提出后就成了Single-Agent强化学习的常规操作,特别是DQN一炮走红之后[72] 。

不过,Replay Buffer有着很强的理论假设,用原作者的话说是——The environment should not changeover time because this makes pastexperiences irrelevantor even harmful.(环境不应随时间而改变,因为这会使过去的experience replay变得无关紧要甚至有害)Replay buffer假设环境是stationary的,如果当前的环境信息不同于过去的环境信息,那么就无法从过去环境的replay中学到有价值的经验。

(画外音:大人,时代变了……别刻舟求剑了)在multi-agent场景下,每个agent都可以把其他的agent当作环境的一部分。

因为其他的agent不断地学习进化,所以agent所处的环境也是在不断变换的,也就是所谓的non-stationary。

因为multi-agent场景不符合replay buffer的理论假设,所以有的人就直接放弃治疗了——例如2016年发表的大名鼎鼎的RIAL和DIAL中就没有使用replay buffer。

model-based reinforcement learning 随着人工智能技术的不断发展,强化学习被视为目前最有前途的研究领域之一,其中Model-Based Reinforcement Learning,即基于模型的强化学习在近年来备受研究者的关注。

本文将从强化学习的定义、Model-Based Reinforcement Learning的原理和应用等方面进行分析。

强化学习是一种人工智能的学习方法,用于训练智能体从环境中学习,以最大化其在特定任务上的汇报。

强化学习的核心是设计智能体的策略,让其能够自我学习、适应环境、实现预设目标。

强化学习通常采用奖励反馈机制进行学习,智能体在环境中做出的不同决策获得不同的奖励,通过调整策略提高获取奖励的机会,从而实现学习。

Model-Based Reinforcement Learning是围绕着建立环境的模型而展开的强化学习,它主要包括模型的学习和利用两个过程。

模型学习是指通过监督学习等方法,将智能体观察到的环境状态和动作作为输入,预测出当前环境状态下智能体下一个状态和获得的奖励,从而建立环境的模型。

模型利用是指根据模型进行策略搜索、规划或模拟,在不同的状态下采取最优的操作,以达到最优的目标。

Model-Based Reinforcement Learning有很多优点。

一方面,通过建立模型,可以提高智能体的学习效率,减少在真实环境中的探索次数,节省时间和成本。

另一方面,通过模拟环境,可以避免在真实环境中出现的错误,从而保护智能体的资源和安全,提高学习效果。

在实际应用中,Model-Based Reinforcement Learning已被广泛应用于多种场景,如自动驾驶、智能游戏等。

虽然Model-Based Reinforcement Learning有很多优点,但也存在一些局限性。

首先,建立准确的环境模型是一项艰巨的任务,需要大量的数据和计算资源,容易受到模型误差和误差传递的影响。

利用Matlab进行深度强化学习的技术方法深度强化学习(Deep Reinforcement Learning,DRL)是一种结合了深度学习和强化学习的方法,在众多领域都展现出了惊人的潜力。

利用Matlab进行深度强化学习,可以充分发挥Matlab强大的工程化和数学建模能力,实现高效、可靠的DRL算法。

首先,我们需要了解什么是深度强化学习。

DRL是一种通过智能体(agent)与环境(environment)的交互学习最优策略的方法。

智能体通过观察环境的状态,采取行动并获取回报,从而不断优化自己的策略。

深度强化学习则是在这一过程中引入了深度神经网络来近似值函数或策略函数,以实现高维、复杂环境下的决策和控制。

利用Matlab进行深度强化学习首先需要搭建一个强化学习的框架。

Matlab提供了强大的神经网络工具箱,可以方便地实现深度神经网络模型。

此外,Matlab还提供了丰富的工具和函数来处理数据、可视化结果以及进行模型评估。

下面将介绍一些利用Matlab进行深度强化学习的关键技术方法。

1. 数据处理与预处理:在深度强化学习中,数据的质量对于算法的性能起着重要作用。

Matlab提供了各种数据处理函数和工具,可以方便地进行数据清洗、标准化、降噪等预处理操作。

此外,Matlab还提供了强大的数据可视化工具,可以快速观察数据的特征和分布,辅助我们进行数据分析和挖掘。

2. 深度学习模型设计与训练:深度强化学习依赖于深度神经网络模型的设计和训练。

Matlab提供了神经网络工具箱,可以方便地搭建各种深度神经网络模型,并提供了多种训练算法和优化器。

通过调整网络结构和参数,我们可以实现对特定问题的精准建模和快速训练。

3. 强化学习算法实现:Matlab提供了强化学习工具箱,包含了多种经典和先进的强化学习算法,如Q-learning、DQN、DDPG等。

我们可以根据具体问题选择合适的算法,并根据需要进行自定义修改和扩展。

matlab中reinforcement learning designer使用1. 引言1.1 概述引言部分从整体上介绍了本文的主题和内容。

在本篇文章中,我们将探讨Matlab 中的Reinforcement Learning Designer(以下简称RL Designer)的使用。

RL Designer是一款集成了强化学习算法和视觉化工具的软件,可用于设计、建模、仿真以及训练强化学习智能体。

本文将全面介绍RL Designer的功能和特点,并详细描述如何使用这个工具。

1.2 文章结构此处我们将简要介绍文章的整体结构和各部分内容安排。

本文共分为五个主要部分。

首先,引言部分提供了对RL Designer概念和目标的概述。

接下来,第二部分将详细介绍RL Designer的基本信息、功能和特点。

第三部分将解析强化学习的基本概念,包括Agent、Environment以及Reward Signal等重要要素。

第四部分将重点探讨RL Designer提供的主要功能和工具,包括环境建模与仿真、强化学习算法集成与配置,以及模型训练与评估等方面。

最后,在结论部分,我们将对文章进行总结并提到重点知识点,并鼓励读者进一步深入了解RLDesigner相关的领域发展。

1.3 目的此部分将明确本篇文章的目标和意义。

通过全面介绍RL Designer的使用方法和功能特点,本文旨在帮助读者理解如何在Matlab中利用这个工具进行强化学习任务的设计和模型开发。

同时,我们也希望通过本文能够唤起更多人对于Reinforcement Learning领域发展的关注,并为其提供一个简单易懂、实用可行的入门指南。

2. Reinforcement Learning Designer介绍2.1 什么是Reinforcement Learning DesignerReinforcement Learning Designer是一款MATLAB工具,专门用于开发和实现强化学习算法。

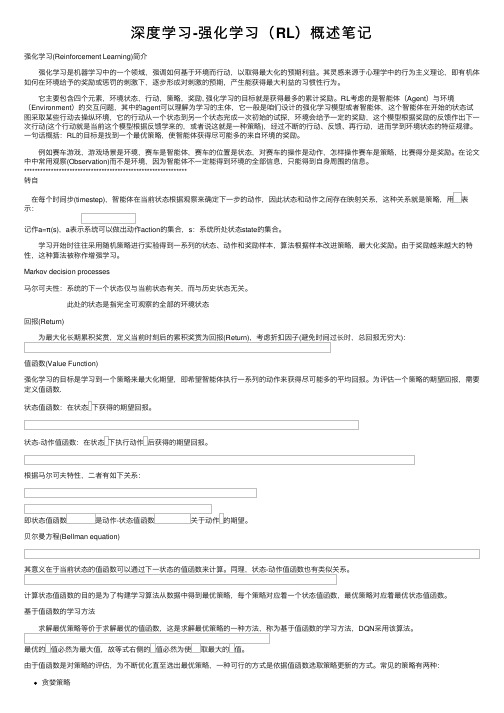

深度学习-强化学习(RL)概述笔记强化学习(Reinforcement Learning)简介 强化学习是机器学习中的⼀个领域,强调如何基于环境⽽⾏动,以取得最⼤化的预期利益。

其灵感来源于⼼理学中的⾏为主义理论,即有机体如何在环境给予的奖励或惩罚的刺激下,逐步形成对刺激的预期,产⽣能获得最⼤利益的习惯性⾏为。

它主要包含四个元素,环境状态,⾏动,策略,奖励, 强化学习的⽬标就是获得最多的累计奖励。

RL考虑的是智能体(Agent)与环境(Environment)的交互问题,其中的agent可以理解为学习的主体,它⼀般是咱们设计的强化学习模型或者智能体,这个智能体在开始的状态试图采取某些⾏动去操纵环境,它的⾏动从⼀个状态到另⼀个状态完成⼀次初始的试探,环境会给予⼀定的奖励,这个模型根据奖励的反馈作出下⼀次⾏动(这个⾏动就是当前这个模型根据反馈学来的,或者说这就是⼀种策略),经过不断的⾏动、反馈、再⾏动,进⽽学到环境状态的特征规律。

⼀句话概括:RL的⽬标是找到⼀个最优策略,使智能体获得尽可能多的来⾃环境的奖励。

例如赛车游戏,游戏场景是环境,赛车是智能体,赛车的位置是状态,对赛车的操作是动作,怎样操作赛车是策略,⽐赛得分是奖励。

在论⽂中中常⽤观察(Observation)⽽不是环境,因为智能体不⼀定能得到环境的全部信息,只能得到⾃⾝周围的信息。

*************************************************************转⾃ 在每个时间步(timestep),智能体在当前状态根据观察来确定下⼀步的动作,因此状态和动作之间存在映射关系,这种关系就是策略,⽤表⽰:记作a=π(s),a表⽰系统可以做出动作action的集合,s:系统所处状态state的集合。

学习开始时往往采⽤随机策略进⾏实验得到⼀系列的状态、动作和奖励样本,算法根据样本改进策略,最⼤化奖励。

由于奖励越来越⼤的特性,这种算法被称作增强学习。

multi-agent reinforcement learning中文-概述说明以及解释1.引言1.1 概述多智能体强化学习是一种重要的机器学习方法,它能够让多个智能体在相互交互的环境中学习并协同解决问题。

在传统的强化学习中,只有一个智能体与环境进行交互,而多智能体强化学习则引入了多个智能体之间的相互作用。

通过学习如何与其他智能体进行合作或竞争,多智能体强化学习可以实现更高级别的决策和更复杂的任务解决。

在多智能体强化学习中,每个智能体都具有自己的策略和学习算法。

智能体根据其个体的奖励和环境的状态,通过与其他智能体进行交互来学习最优的策略。

通过与其他智能体的协作或竞争,智能体可以共同提高整体性能,并解决单个智能体无法完成的任务。

多智能体强化学习在多个领域都有广泛的应用。

例如,在群体机器人中,多个机器人需要协调完成任务。

通过多智能体强化学习,这些机器人可以学习如何有效地合作,以实现任务的最佳完成。

此外,多智能体强化学习还在分布式控制系统、自动驾驶车辆和多智能体游戏等领域得到了广泛的应用。

然而,多智能体强化学习也面临着一些挑战和困难。

首先,多智能体之间的相互作用增加了问题的复杂性,增加了学习的难度。

其次,多智能体强化学习中的策略更新问题需要解决,因为每个智能体的策略变化会影响其他智能体的学习和决策。

此外,多智能体强化学习中的合作与竞争之间的平衡也是一个重要的问题。

未来,多智能体强化学习有许多可探索的发展方向。

一方面,可以进一步研究多智能体强化学习中的协作与竞争的机制,以提高系统性能和稳定性。

另一方面,可以探索如何将深度学习与多智能体强化学习结合,以应对更复杂的任务和更大规模的智能体群体。

此外,如何解决多智能体强化学习中的学习效率问题也是一个关键的研究方向。

总结而言,多智能体强化学习是一个具有潜力和挑战的研究领域。

通过研究多智能体之间的协作与竞争,我们可以更好地理解复杂系统中的智能体间相互作用,并应用于广泛的实际应用领域。

增强学习R e i n f o r c e m e n tL e a r n i n g经典算法梳理(总6页)-CAL-FENGHAI.-(YICAI)-Company One1-CAL-本页仅作为文档封面,使用请直接删除增强学习Reinforcement Learning经典算法梳理1:policy and value iteration前言就目前来看,深度增强学习(Deep Reinforcement Learning)中的很多方法都是基于以前的增强学习算法,将其中的value function价值函数或者Policy function策略函数用深度神经网络替代而实现。

因此,本文尝试总结增强学习中的经典算法。

本文主要参考:1Reinforcement Learning: An Introduction;2Reinforcement Learning Course by David Silver1 预备知识对增强学习有所理解,知道MDP,Bellman方程详细可见:Deep Reinforcement Learning 基础知识(DQN方面)很多算法都是基于求解Bellman方程而形成:Value IterationPolicy IterationQ-LearningSARSA2 Policy Iteration 策略迭代Policy Iteration的目的是通过迭代计算value function 价值函数的方式来使policy收敛到最优。

Policy Iteration本质上就是直接使用Bellman方程而得到的:那么Policy Iteration一般分成两步:Policy Evaluation 策略评估。

目的是更新Value FunctionPolicy Improvement 策略改进。

使用 greedy policy 产生新的样本用于第一步的策略评估。

本质上就是使用当前策略产生新的样本,然后使用新的样本更新当前的策略,然后不断反复。

深度强化学习研究综述一、本文概述随着技术的快速发展,深度强化学习作为其中的一个重要分支,已经在众多领域展现出强大的潜力和应用价值。

本文旨在对深度强化学习的研究进行全面的综述,以揭示其基本原理、发展历程、应用领域以及未来的发展趋势。

文章首先介绍了深度强化学习的基本概念及其与传统强化学习的区别,然后详细阐述了深度强化学习的主要算法和技术,包括深度Q网络、策略梯度方法、演员-评论家方法等。

接着,文章回顾了深度强化学习在游戏、机器人控制、自然语言处理、金融等领域的应用案例,分析了其在解决实际问题中的优势和挑战。

文章展望了深度强化学习的未来发展方向,包括模型泛化能力的提升、多智能体系统的研究、以及与其他技术的融合等。

通过本文的综述,读者可以对深度强化学习的研究现状和未来趋势有一个全面而深入的了解,为相关领域的研究和应用提供参考和借鉴。

二、深度强化学习基础知识深度强化学习(Deep Reinforcement Learning, DRL)是领域中的一个重要分支,它结合了深度学习的表征学习能力和强化学习的决策能力,旨在解决复杂环境下的序列决策问题。

在DRL中,深度神经网络被用作函数逼近器,以处理高维状态空间和动作空间,而强化学习算法则负责在探索和利用之间找到平衡,以最大化长期回报。

深度强化学习的基础知识包括深度神经网络、强化学习算法以及两者的结合方式。

深度神经网络是DRL的核心组件,它通过逐层传递和非线性变换,将原始输入转换为高层次的特征表示。

常见的深度神经网络结构包括卷积神经网络(CNN)、循环神经网络(RNN)以及它们的变体。

这些网络结构在处理图像、文本和序列数据等不同类型的输入时表现出色。

强化学习算法是DRL的另一个重要组成部分。

它通过与环境的交互来学习最优决策策略。

强化学习中的关键概念包括状态、动作、奖励和策略等。

状态是环境在当前时刻的描述,动作是智能体在当前状态下可以采取的行为,奖励是环境对智能体行为的评价,而策略则是智能体根据当前状态选择动作的依据。

深度强化学习求解流程1.首先,我们需要定义问题并确定环境。

First, we need to define the problem and determine the environment.2.然后,我们需要选择合适的深度强化学习模型。

Next, we need to choose an appropriate deep reinforcement learning model.3.接着,我们要设计合适的奖励函数。

Then, we need to design a suitable reward function.4.在完成模型设计后,还需要对模型进行训练。

After the model design is completed, the model needs to be trained.5.训练后的模型需要进行测试和评估。

The trained model needs to be tested and evaluated.6.根据测试结果,我们需要对模型进行调整和优化。

Based on the test results, we need to adjust and optimize the model.7.完成模型优化后,我们还需要进行进一步的测试和评估。

After optimizing the model, further testing andevaluation are needed.8.最终,我们需要将模型部署到实际环境中进行应用。

Finally, we need to deploy the model for application inthe actual environment.9.深度强化学习求解流程需要谨慎设计和严格执行。

The process of solving deep reinforcement learningrequires careful design and strict execution.10.每个步骤都需要认真对待,以确保最终结果的准确性和可靠性。

integral reinforcement learningmatlabIntegral reinforcement learning (IRL) is a reinforcement learning algorithm that seeks to optimize the expected value of a cumulative reward over an infinite horizon. It does this by combining the advantages of policy iteration and value iteration, which are two popular techniques for solving reinforcement learning problems.IRL is particularly useful in environments where the agent must balance short-term and long-term rewards. For example, in a robotics task, the agent might need to both avoid obstacles in the short term and reach a destination in the long term. IRL can help the agent learn how to strike this balance by accounting for the effects of its actions on future rewards.MATLAB is a popular programming language and environment that supports the development of reinforcement learning algorithms. There are several MATLAB toolboxes available that provide functions for implementing IRL algorithms, such as the MATLAB Robotics System Toolbox and the MATLAB Reinforcement Learning Toolbox.These toolboxes provide functions for defining the agent's policy, value function, and transition dynamics, as well as for performing policy evaluation, policy improvement, and value iteration. They also provide functions for visualizing the agent's behavior and reward over time, which can be useful for understanding and debugging the algorithm.IRL is a powerful technique for solving reinforcement learning problems, and MATLAB provides a rich set of tools for implementing and analyzing IRL algorithms. However, it is important to note that IRL can be computationally intensive, especially in complex environments, and may require the use of efficient numerical algorithms and data structures.。

神经网络强化学习的流程English Answer:Neuroevolution reinforcement learning process.1. Define the environment and reward function. The environment is the setting in which the agent will learn to act, and the reward function determines how the agent is evaluated.2. Create a neural network. The neural network will represent the agent's policy, i.e. the mapping from states to actions.3. Train the neural network. The neural network is trained to maximize the expected reward over time. This can be done using a variety of methods, such as backpropagation or evolutionary algorithms.4. Evaluate the neural network. Once the neural networkhas been trained, it is evaluated on the environment to see how well it performs.5. Repeat steps 2-4 until the neural network performs well enough.Chinese Answer:神经网络强化学习流程。

1. 定义环境和奖励函数。

【超级转载】⼤⽩话说说深度学习之卷积神经⽹络声明:1)该⽂章整理⾃⽹上的⼤⽜和机器学习专家⽆私奉献的资料,具体引⽤的资料请看参考⽂献。

2)本⽂仅供学术交流,⾮商⽤。

所以每⼀部分具体的参考资料并没有详细对应。

如果某部分不⼩⼼侵犯了⼤家的利益,还望海涵,并联系博主删除。

3)博主才疏学浅,⽂中如有不当之处,请各位指出,共同进步,谢谢。

4)此属于第⼀版本,若有错误,还需继续修正与增删。

还望⼤家多多指点。

⼤家都共享⼀点点,⼀起为祖国科研的推进添砖加⽡。

# ⽂章⽬录O、前⾔本博客创作的主要⽬的,是对时下最⽕最流⾏的深度学习算法的基础知识做⼀个简介,本⼈看过许多教程,感觉对⼩⽩不是特别友好,尤其是在踩过好多坑之后,于是便有了写这篇博客的想法。

本⽂⽂中会有相关部分的链接,并且在博客的最后会给出个⼈推荐的学习资源,如果着急寻找资源的同学可以通过⽬录直接跳到最后。

⼀、简介百度百科中对深度学习的定义是深度学习(DL, Deep Learning)是机器学习(ML, Machine Learning)领域中⼀个新的研究⽅向,它被引⼊机器学习使其更接近于最初的⽬标——⼈⼯智能(AI, Artificial Intelligence)。

这个定义太⼤了,反⽽让⼈有点不懂,简答来说,深度学习就是通过多层神经⽹络上运⽤各种机器学习算法学习样本数据的内在规律和表⽰层次,从⽽实现各种任务的算法集合。

各种任务都是啥,有:数据挖掘,计算机视觉,语⾳识别,⾃然语⾔处理等。

可能有⼈会问那么深度学习,机器学习还有⼈⼯智能的关系是怎么样的呢?在这个博客中有详细介绍:,我们这⾥直接拿出结论:AI:让机器展现出⼈类智⼒机器学习:抵达AI⽬标的⼀条路径深度学习:实现机器学习的技术深度学习从⼤类上可以归⼊神经⽹络,不过在具体实现上有许多变化,并不像⼤家听到的⼀样,觉得这两个概念其实是同⼀个东西,在知乎上有相关讨论:看,我们这⾥直接拿出结论:从⼴义上说深度学习的⽹络结构也是多层神经⽹络的⼀种。