相关与回归分析

- 格式:doc

- 大小:247.50 KB

- 文档页数:7

相关分析与回归分析的区别和联系

一、回归分析和相关分析主要区别是:

1、在回归分析中,y被称为因变量,处在被解释的特殊地位,而在相关分析中,x与y处于平等的地位,即研究x与y的密切程度和研究y与x的密切程度是一致的;

2、相关分析中,x与y都是随机变量,而在回归分析中,y是随机变量,x 可以是随机变量,也可以是非随机的,通常在回归模型中,总是假定x是非随机的;

3、相关分析的研究主要是两个变量之间的密切程度,而回归分析不仅可以揭示x对y的影响大小,还可以由回归方程进行数量上的预测和控制.

二、回归分析与相关分析的联系:

1、回归分析和相关分析都是研究变量间关系的统计学课题。

2、在专业上研究上:

有一定联系的两个变量之间是否存在直线关系以及如何求得直线回归方程等问题,需进行直线相关分析和回归分析。

3、从研究的目的来说:

若仅仅为了了解两变量之间呈直线关系的密切程度和方向,宜选用线性相关分析;若仅仅为了建立由自变量推算因变量的直线回归方程,宜选用直线回归分析.

三、扩展资料:

1、相关分析是研究两个或两个以上处于同等地位的随机变量间的相关关系的统计分析方法。

例如,人的身高和体重之间;空气中的相对湿度与降雨量之间的相关关系都是相关分析研究的问题。

2、回归分析是确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法。

运用十分广泛。

回归分析按照涉及的变量的多少,分为一元回归和多元回归分析;按照因变量的多少,可分为简单回归分析和多重回归分析;按照自变量和因变量之间的关系类型,可分为线性回归分析和非线性回归分析。

回归分析与相关分析回归分析是通过建立一个数学模型来研究自变量对因变量的影响程度。

回归分析的基本思想是假设自变量和因变量之间存在一种函数关系,通过拟合数据来确定函数的参数。

回归分析可以分为线性回归和非线性回归两种。

线性回归是指自变量和因变量之间存在线性关系,非线性回归是指自变量和因变量之间存在非线性关系。

回归分析可用于预测、解释和控制因变量。

回归分析的应用非常广泛。

例如,在经济学中,回归分析可以用于研究收入与消费之间的关系;在医学研究中,回归分析可以用于研究生活方式与健康之间的关系。

回归分析的步骤包括确定自变量和因变量、选择合适的回归模型、拟合数据、检验模型的显著性和解释模型。

相关分析是一种用来衡量变量之间相关性的方法。

相关分析通过计算相关系数来度量变量之间的关系的强度和方向。

常用的相关系数有Pearson相关系数、Spearman相关系数和判定系数。

Pearson相关系数适用于连续变量,Spearman相关系数适用于顺序变量,判定系数用于解释变量之间的关系。

相关分析通常用于确定两个变量之间是否相关,以及它们之间的相关性强度和方向。

相关分析的应用也非常广泛。

例如,在市场研究中,相关分析可以用于研究产品价格与销量之间的关系;在心理学研究中,相关分析可以用于研究学习成绩与学习时间之间的关系。

相关分析的步骤包括确定变量、计算相关系数、检验相关系数的显著性和解释相关系数。

回归分析与相关分析的主要区别在于它们研究的对象不同。

回归分析研究自变量与因变量之间的关系,关注的是因变量的预测和解释;相关分析研究变量之间的关系,关注的是变量之间的相关性。

此外,回归分析通常是为了解释因变量的变化,而相关分析通常是为了量化变量之间的相关性。

综上所述,回归分析和相关分析是统计学中常用的两种数据分析方法。

回归分析用于确定自变量与因变量之间的关系,相关分析用于测量变量之间的相关性。

回归分析和相关分析在实践中有广泛的应用,并且它们的步骤和原理较为相似。

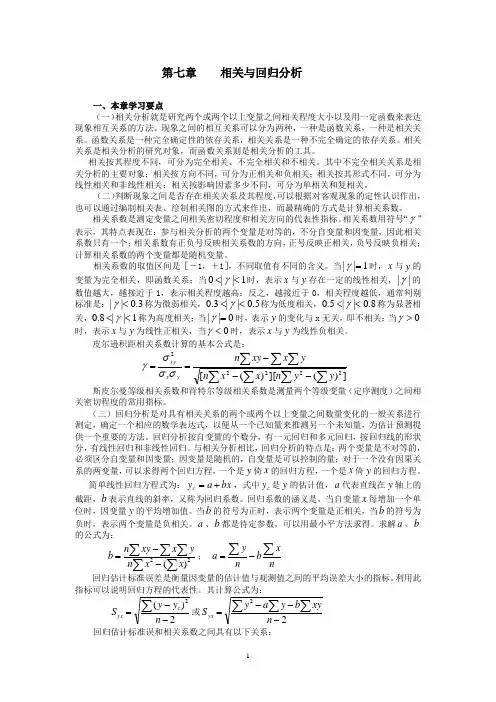

第七章 相关与回归分析一、本章学习要点(一)相关分析就是研究两个或两个以上变量之间相关程度大小以及用一定函数来表达现象相互关系的方法。

现象之间的相互关系可以分为两种,一种是函数关系,一种是相关关系。

函数关系是一种完全确定性的依存关系,相关关系是一种不完全确定的依存关系。

相关关系是相关分析的研究对象,而函数关系则是相关分析的工具。

相关按其程度不同,可分为完全相关、不完全相关和不相关。

其中不完全相关关系是相关分析的主要对象;相关按方向不同,可分为正相关和负相关;相关按其形式不同,可分为线性相关和非线性相关;相关按影响因素多少不同,可分为单相关和复相关。

(二)判断现象之间是否存在相关关系及其程度,可以根据对客观现象的定性认识作出,也可以通过编制相关表、绘制相关图的方式来作出,而最精确的方式是计算相关系数。

相关系数是测定变量之间相关密切程度和相关方向的代表性指标。

相关系数用符号“γ”表示,其特点表现在:参与相关分析的两个变量是对等的,不分自变量和因变量,因此相关系数只有一个;相关系数有正负号反映相关系数的方向,正号反映正相关,负号反映负相关;计算相关系数的两个变量都是随机变量。

相关系数的取值区间是[-1,+1],不同取值有不同的含义。

当1||=γ时,x 与y 的变量为完全相关,即函数关系;当1||0<<γ时,表示x 与y 存在一定的线性相关,||γ的数值越大,越接近于1,表示相关程度越高;反之,越接近于0,相关程度越低,通常判别标准是:3.0||<γ称为微弱相关,5.0||3.0<<γ称为低度相关,8.0||5.0<<γ称为显著相关,1||8.0<<γ称为高度相关;当0||=γ时,表示y 的变化与x 无关,即不相关;当0>γ时,表示x 与y 为线性正相关,当0<γ时,表示x 与y 为线性负相关。

皮尔逊积距相关系数计算的基本公式是: ∑∑∑∑∑∑∑---==])(][)([22222y y n x x n y x xy n y x xy σσσγ 斯皮尔曼等级相关系数和肯特尔等级相关系数是测量两个等级变量(定序测度)之间相关密切程度的常用指标。

相关分析和回归分析相关分析和回归分析是统计学中最基础的两种分析方法,它们都用于研究数据变量之间的关系。

因为它们都是研究两个变量之间关系的,所以它们常常会被混淆起来,但它们其实在原理上是不同的,有不同的应用场景。

一、相关分析相关分析是一种简单的统计分析,用来检验不同变量之间是否存在相互关系。

它可以通过计算出变量之间的相关系数,来判断变量之间是线性关系还是非线性关系。

另外,它还可以度量两个变量的线性关系的相关程度,用来度量不同变量之间的关系强度。

相关分析的应用非常广泛,它可以帮助研究者了解数据之间的关系,也可以用来预测数据的变化趋势。

比如,可以用相关分析来研究一个地区的薪水水平和就业水平之间的关系,用来预测未来就业水平和薪资水平会有怎样的变化趋势。

二、回归分析回归分析是一种统计分析,用以研究两个变量之间的数量关系,并建立起变量之间的数量模型。

它用于预测和分析数据,从而探索数据之间的关系。

比如,从客户收入、购买频率等多个因素来建立一个回归模型,从而预测客户的未来购买意愿。

回归分析也是一种非常有用的统计方法,它可以用来研究数据之间的关系,并预测数据未来的变化趋势。

另外,它还可以用来预测特定变量的值,比如预测未来股市的涨跌情况。

总结以上就是相关分析和回归分析的基本内容介绍。

相关分析用于研究数据变量之间的关系,可以帮助研究者了解数据之间的关系,并预测数据的变化趋势;而回归分析是一种统计分析,用以研究两个变量之间的数量关系,可以用来预测特定变量的值,也可以研究数据之间的关系,并预测数据未来的变化趋势。

相关分析和回归分析可以说是统计学中最基础的两种分析方法,它们都具有重要的应用价值,广泛用于各种数据分析工作。

统计学中的相关性和回归分析统计学中,相关性和回归分析是两个重要的概念和方法。

它们旨在揭示变量之间的关系,并可以用来预测和解释观察结果。

本文将介绍相关性和回归分析的基本原理、应用及其在实践中的意义。

一、相关性分析相关性是指一组变量之间的关联程度。

相关性分析可以帮助我们理解变量之间的关系,以及这种关系的强度和方向。

常用的相关性指标有皮尔逊相关系数、斯皮尔曼相关系数和判定系数等。

皮尔逊相关系数是最常见的衡量变量之间线性关系的指标。

它的取值范围在-1到1之间,其中-1表示完全负相关,1表示完全正相关,0表示无相关。

例如,在研究身高和体重之间的关系时,如果相关系数为0.8,则说明身高和体重呈现较强的正相关。

斯皮尔曼相关系数则不要求变量呈现线性关系,而是通过对变量的序列进行排序,从而找到它们之间的关联程度。

它的取值也在-1到1之间,含义与皮尔逊相关系数类似。

判定系数是用于衡量回归模型的拟合程度的指标。

它表示被解释变量的方差中可由回归模型解释的部分所占的比例。

判定系数的取值范围在0到1之间,越接近1表示模型对数据的拟合越好。

二、回归分析回归分析是一种用于建立变量之间关系的统计方法。

它通过建立一个数学模型来解释和预测依赖变量和自变量之间的关系。

回归模型可以是线性的,也可以是非线性的。

线性回归是最常见的回归分析方法之一。

它假设自变量和因变量之间存在着线性关系,并通过最小二乘法来估计模型中的参数。

线性回归模型通常表示为y = β0 + β1x1 + β2x2 + ... + βnxn,其中y为因变量,x1、x2等为自变量,β0、β1等为模型的参数。

非线性回归则适用于自变量和因变量之间存在非线性关系的情况。

非线性回归模型可以是多项式回归、指数回归、对数回归等。

回归分析在实践中有广泛的应用。

例如,在市场营销中,回归分析可以用来预测销售量与广告投入之间的关系;在医学研究中,回归分析可以用来探究疾病发展与遗传因素之间的联系。

相关分析和回归分析的区别:1, 在相关分析中,解释变量X与被解释变量Y之间处于平等的位置。

而回归分析中,解释变量与被解释变量必须是严格确定的。

2 相关分析中,被解释变量Y与解释变量X全是随机变量。

而回归,被解释变量Y是随机的,解释变量X可能是随机的,可能是非随机的确定变量。

3 相关的研究主要主要是为刻画两变量间线性相关的密切程度。

而回归不仅可以揭示解释变量X和被解释变量Y的具体影响形式,而且还可以由回归方程进行预测和控制。

如果两变量间互为因果关系,解释变量与被解释变量互换位置,相关分析结果一样,回归分析结果不同。

样本回归函数与总体回归函数的区别: 1 总体是未知的,是客观唯一存在的。

样本是根据样本数据拟合的,每抽取一个样本,变可以拟合一条样本回归线。

2 总体中的β0和β1是未知参数,表现为常数。

而样本中的是随机变量,其具体数值随样本观测值的不同而变化。

3 随机误差ui 是实际Yi值与总体函数均值E(Yi)的离差,即Yi与总体回归线的纵向距离,是不可直接观测的。

而样本的残差ei是yi与样本回归线的纵向距离,当拟合了样本回归后,可以计算出ei的具体数值。

一元的五个基本假定:1 随机扰动项ui的均值为零,即E(ui)=02 随机扰动项ui的方差为常数Var(ui)=E[ui-E(ui)]^2=E(ui^2)=σ^23 任意两个随机扰动项ui和uj互不(i不等于j)互不相关,其其协方差为0Cov(ui,uj)=04 随机扰动项ui与解释变量Xi线性无关Cov(ui,Xi)=05 随机扰动项服从正态分布,即ui~N(0,σ^2)样本分段比较法适用于检验样本容量较大的线性回归模型可能存在的递增或递减型的异方差性,思路是首先量样本按某个解释变量从大到小或小到大顺序排列,并将样本均匀分成两段,有时为增强显著性,可去掉中间占样本单位1/4或1/3的部分单位;然后就各段分别用普通最小二乘法拟合回归直线,并计算各自的残差平方和,大的用RSS1,小的用RSS2表示,如果数值之比明显大于1,则存在异方差异方差性的后果:1 参数估计值虽然是无偏的,但却不是有效的。

回归分析与相关分析联系区别

一、定义:

1.回归分析:回归分析是一种用于研究变量之间关系的统计方法,旨

在通过一个或多个自变量与一个因变量的关系来预测和解释因变量的变化。

2.相关分析:相关分析是一种用于度量两个变量之间线性关系的统计

方法,通过计算相关系数来判断变量之间的相互关联程度。

二、应用领域:

1.回归分析:回归分析广泛应用于社会科学、经济学、市场营销等领域,常用于预测、解释和因果推断等研究中,也可以用于探索性数据分析

和模型诊断。

2.相关分析:相关分析适用于自然科学、医学、环境科学等领域,可

用于分析变量之间的关联,评估变量之间的相关性以及预测未来的变化趋势。

三、应用步骤:

1.回归分析的应用步骤通常包括:确定研究问题、收集数据、选择适

当的回归模型、进行模型拟合和参数估计、模型诊断和解释回归结果等。

2.相关分析的应用步骤通常包括:明确研究目的、收集数据、计算相

关系数、进行假设显著性检验、解释相关结果和绘制相关图等。

四、结果解释:

1.回归分析的结果解释主要包括判断拟合度(如R-squared)、解释

变量的显著性和系数大小、诊断模型的合理性、进行预测和因果推断等。

2.相关分析的结果解释主要包括相关系数的显著性、方向(正相关或负相关)和强度(绝对值的大小),还可通过散点图等图形来展示变量之间的线性相关关系。

回归分析和相关分析的联系和区别一、引言回归分析和相关分析是统计分析中最常用的两个分析方法,它们都可以用来研究变量之间的关系,但是它们有着很大的不同。

本文将深入探讨回归分析和相关分析之间的联系和区别。

二、回归分析回归分析是一种统计分析方法,它可以用来研究两个变量之间的关系,通常一个变量被视为自变量,另一个变量被视为因变量,回归分析可以用来推断自变量对因变量的影响。

回归分析可以用来预测因变量的值,从而帮助人们做出更好的决策。

举例来说,如果我们想研究一个公司的销售额与其广告投入之间的关系,我们可以使用回归分析,自变量为广告投入,因变量为销售额,我们可以通过回归分析来推断广告投入对销售额的影响,从而帮助公司做出更好的决策。

三、相关分析相关分析是一种统计分析方法,它可以用来研究两个变量之间的关系,它可以用来检测两个变量之间是否存在线性关系,以及这种关系的强度有多强。

举例来说,如果我们想研究一个公司的销售额与其广告投入之间的关系,我们可以使用相关分析,我们可以通过相关分析来检测销售额与广告投入之间是否存在线性关系,以及这种关系的强度有多强。

四、联系和区别回归分析和相关分析是统计分析中最常用的两个分析方法,它们都可以用来研究变量之间的关系,但是它们有着很大的不同。

首先,回归分析可以用来推断自变量对因变量的影响,从而帮助人们做出更好的决策,而相关分析只能用来检测两个变量之间是否存在线性关系,以及这种关系的强度有多强。

其次,回归分析可以用来预测因变量的值,而相关分析不能用来预测因变量的值。

最后,回归分析可以用来研究多个自变量对因变量的影响,而相关分析只能用来研究两个变量之间的关系。

五、结论回归分析和相关分析是统计分析中最常用的两个分析方法,它们都可以用来研究变量之间的关系,但是它们有着很大的不同,回归分析可以用来推断自变量对因变量的影响,从而帮助人们做出更好的决策,而相关分析只能用来检测两个变量之间是否存在线性关系,以及这种关系的强度有多强。

回归分析与相关分析回归分析是一种通过建立数学模型来预测或解释因变量与自变量之间关系的方法。

它的核心思想是通过对已有数据建立一个函数,通过这个函数可以推断其他未知数据的值。

常见的回归模型包括线性回归、多项式回归、逻辑回归等。

线性回归是最为常见的回归模型之一,其基本原理是通过拟合一条直线来描述自变量与因变量之间的关系。

在线性回归中,常常使用最小二乘法来确定最佳拟合直线。

最小二乘法通过使得残差平方和最小来确定回归系数。

回归系数表示了自变量与因变量之间的关系强度和方向。

除了线性回归,还有多项式回归可以拟合非线性关系。

逻辑回归则适用于因变量为二元分类变量的情况。

相关分析是一种用来研究变量之间相关性的方法。

它可以帮助我们判断两个变量之间是否存在其中一种关系,并且能够量化这种关系的强度和方向。

常见的相关系数有皮尔逊相关系数和斯皮尔曼相关系数。

皮尔逊相关系数是一种用来测量两个连续变量之间线性相关程度的指标。

它的取值范围为-1到+1之间,-1表示完全负相关,0表示无相关,+1表示完全正相关。

斯皮尔曼相关系数则是一种非参数的相关系数,适用于两个变量之间的关系非线性的情况。

回归分析和相关分析可以相互配合使用,用来探索和解释变量之间的关系。

首先,通过相关分析,可以初步判断两个变量之间是否存在相关性。

然后,如果判断出存在相关性,可以使用回归分析来建立一个数学模型,以解释自变量对因变量的影响。

总之,回归分析和相关分析是统计学中常用的两种数据分析方法。

它们可以帮助我们研究和解释变量之间的关系,并用于预测和控制因变量的变化。

了解和掌握这两种方法,对于研究者和决策者来说都是非常重要的。

统计学中的回归分析与相关性回归分析与相关性是统计学中重要的概念和方法,用于研究变量之间的关系和预测。

本文将介绍回归分析和相关性分析的基本原理、应用领域以及实际案例。

一、回归分析回归分析是研究两个或多个变量之间关系的一种统计方法。

它的基本思想是通过对一个或多个自变量与一个因变量之间的关系进行建模,来预测因变量的取值。

1.1 简单线性回归简单线性回归是回归分析中最基本的形式,用于研究一个自变量和一个因变量之间的关系。

其数学模型可以表示为:Y = β0 + β1X + ε,其中Y是因变量,X是自变量,β0和β1是回归系数,ε是误差项。

1.2 多元回归多元回归是回归分析的扩展形式,用于研究多个自变量对一个因变量的影响。

其数学模型可以表示为:Y = β0 + β1X1 + β2X2 + ... + βnXn + ε。

1.3 回归诊断回归分析需要对建立的模型进行诊断,以确保模型的有效性和合理性。

常见的回归诊断方法包括检验残差的正态性、检验变量之间的线性关系、检验残差的独立性和方差齐性等。

二、相关性分析相关性分析是统计学中用来研究两个变量之间线性关系强弱的方法。

通过计算两个变量的相关系数,可以判断它们之间的相关性。

2.1 皮尔逊相关系数皮尔逊相关系数是最常用的衡量两个连续变量之间线性相关强度的指标,取值范围在-1到1之间。

当相关系数接近1时,表示两个变量呈正相关;当相关系数接近-1时,表示两个变量呈负相关;当相关系数接近0时,表示两个变量之间没有线性关系。

2.2 斯皮尔曼相关系数斯皮尔曼相关系数是一种非参数统计量,用于衡量两个变量之间的等级相关性。

与皮尔逊相关系数不同,斯皮尔曼相关系数不要求变量呈线性关系。

三、回归分析与相关性的应用回归分析和相关性分析在各个领域都有广泛的应用。

下面以两个实际案例来说明其应用:3.1 股票市场分析在股票市场分析中,可以使用回归分析来研究某只股票的收益率与市场整体指数之间的关系。

相关分析和回归分析有什么区别在统计学和数据分析的领域中,相关分析和回归分析是两个常用的方法,它们都用于研究变量之间的关系,但在目的、方法和结果解释等方面存在着明显的区别。

首先,从目的上来看,相关分析主要是为了衡量两个或多个变量之间线性关系的强度和方向。

它并不关心变量之间的因果关系,只是简单地描述变量之间的关联程度。

例如,我们想了解身高和体重之间的关系,相关分析可以告诉我们它们之间的关联是紧密还是松散,是正相关(即身高增加体重也增加)还是负相关(身高增加体重反而减少)。

而回归分析则更进一步,它不仅要确定变量之间的关系,还试图建立一个数学模型来预测因变量的值。

这里就涉及到了因果关系的探讨,虽然在很多情况下,回归分析所确定的因果关系也并非绝对的,但它的目的在于找到自变量对因变量的影响程度,从而能够根据给定的自变量值来预测因变量的值。

比如,我们想知道教育程度如何影响收入水平,通过回归分析,就可以建立一个方程,根据一个人的教育年限来预测他可能的收入。

其次,在方法上,相关分析通常使用相关系数来衡量变量之间的关系。

最常见的相关系数是皮尔逊相关系数(Pearson correlation coefficient),其取值范围在-1 到 1 之间。

-1 表示完全的负相关,1 表示完全的正相关,0 则表示没有线性相关关系。

但需要注意的是,相关系数只能反映线性关系,如果变量之间存在非线性关系,相关系数可能无法准确反映其关联程度。

回归分析则通过建立回归方程来描述变量之间的关系。

常见的回归模型有线性回归、多项式回归、逻辑回归等。

在线性回归中,我们假设因变量与自变量之间存在线性关系,通过最小二乘法等方法来估计回归系数,从而得到回归方程。

对于非线性关系,可以通过对变量进行变换或者使用专门的非线性回归模型来处理。

再者,结果的解释也有所不同。

在相关分析中,我们关注的是相关系数的大小和符号。

一个较大的绝对值表示变量之间有较强的线性关系,正号表示正相关,负号表示负相关。

第十二章相关与回归分析社会学研究不满足于对单变量的分析,往往要求进一步分析双变量之间的关系,然后再拓展到分析多变量之间的关系。

第十章提出了两总体的检验及估计的问题,这意味着我们开始与双变量统计方法打交道了。

双变量统计与单变量统计最大的不同之处是,客观事物间的关联性开始披露出来。

第一节变量之间的相互关系1.相关程度与方向从一定意义上讲,函数关系是相关关系的一个特例,即变量间严格一一对应,这是相关程度最强的一种相关关系,称为完全相关(perfect association)。

而变量相关程度的另一个极端值是无相关(no association)或零相关(zero association),即变量之间不存在任何数量上的依存关系。

相关程度介于两个极端值之间的则是不完全相关,相关关系大多指的是这种情况,这时变量间在数量关系上有着不很严格的相互依存关系。

在统计中,对于线性相关,采用相关系数(记作r)这一指标来量度相关关系程度或强度。

就线性相关来说,当r=l时,表示为完全相关;当r=0时,表现为无相关或零相关;当0<r<1时,表现为不完全相关。

但在采用相关系数r这一指标时必须注意到,存在着完善曲线而r=0的情况。

当然,变量在其他测量层次的关系强度,也可以用同样的思路加以考虑。

当变量间相关时,还可以探讨其相关方向,可以分正和负两个方向。

所谓正相关关系是指一个变量的值增加时,另一变量的值也增加。

而负相关关系是指一个变量的值增加时,另一变量的值却减少要强调的是,只有定序以上测量层次的变量才能分析相关方向,因为只有这些变量的值有高低或多少之分。

至于定类变量,由于变量的值并无大小、高低之分,故定类变量与其他变量相关时就没有正负方向了。

2.因果关系除了相关程度与方向这两种性质外,还应注意两个变量的相关关系是否具有因果性。

只有当两个变量之间的关系同时满足以下三个条件时,才能断定这种关系是因果关系:(1)两个变量有共变关系,即一个变量的变化会伴随着另一个变量的变化。

(2)两个变量之间的关系不是由其他因素形成的,即因变量的变化是由自变量的变化引起的。

(3)两个变量的产生和变化有明确的时间顺序,即一个在前,另一个在后,前者称为自变量,后者称为因变量。

因果关系是一种非对称关系(asymmetrical relationship),这时只是自变量影响因变量,因变量不会反过来影响自变量。

如果不能确定或无法区分变量的作用方向,这种情况就称为对称关系(symmetrical relationship)。

第二节定类变量的相关分析1.列联表列联表,是按品质标志把两个变量的频数分布进行交互分类,由于表内的每一个频数都需同时满足两个变量的要求,所以列联表又称条件频数表。

2×2列联表,是最简单的交互分类表,r ×c 频数分布列联表则是一般形式。

条件频数表中各频数因基数不同不便作直接比较,因此有必要将频数化成相对频数,使基数标准化。

这样,我们就从频数分布的列联表得到了相对频数分布的列联表(或称频率分布的列联表)。

在相对频数分布列联表中,各数据为各分类出现的相对频数ij P (或者频率)。

将频数ij f 化成相对频数ij P 有两种做法:①如果ij P =n f ij ,我们得到的是联合分布的列联表,此时ij P 也可以称为联合频率;②如果ij P = X ijF f 或者ij P = Y ij F f ,我们得到的是关于X 或者关于Y 的相对频数的条件分布,此时ij P 也可以称为条件频率通过列联表研究定类变量之间的关联性,实际上是通过相对频数条件分布的比较进行的。

如果不同的X ,Y 的相对频数条件分布不同,且和Y 的相对频数边际分布不同,则两变量之间是相关的。

而如果变量间是相互独立的话,必然存在着Y 的相对频数条件分布相同,且和它的相对频数边际分布相同。

2.削减误差比例在社会统计中,表达相关关系的强弱,削减误差比例PRE(Proportionate Reductionin Error)的概念是非常有价值的。

削减误差比例的原理是,如果两变量间存在着一定的关联性,那么知道这种关联性,必然有助于我们通过一个变量去预测另一变量。

其中关系密切者,在由一变量预测另一变量时.其盲目性必然较关系不密切者为小。

因此,变量间的相关程度,可以用不知Y 与X 有关系时预测Y 的误差E 0,减去知道Y 与X 有关系时预测Y 的误差E 1,再将其化为比例来度量。

将削减误差比例记为PRE ,得PRE = 010E E E -=-原来的误差后来的误差原来的误差 削减误差比例PRE 适用于各测量层次的变量,但公式中E 1、E 2的具体定义,不仅对不同测量层次的变量有所不同,而且对同一测量层次的变量也有所不同。

λ系数和τ系数便是在定类测量的层次上以削减误差比例PRE 为基础所设计的两种相关系数。

3.λ系数(1)对称的λ系数(假设X 是自变量,Y 是因变量)()()0000002Y X Y X Y X F F n F F f f +-+-+=∑∑λ (2)不对称的λ系数(假设X 是自变量,Y 是因变量) 000Y Y Y F n F f --=∑λλ系数有PRE 意义,其统计值域是[0,1]。

λ系数的缺点是比较粗略,不够灵敏,因为它以众数作为预测的准则,对条件频数分布列联表中众数频数以外的条件频数不予理会。

另外,如果众数频数集中在条件频数分布列联表的同一行中,λ系数便会等于0,从而无法显示两变量之间的相关性。

3.τ系数τ系数的统计值域是[0,1],其特点是在计算时考虑所有的边际频数和条件频数。

先求出不知X ,预测Y 时全部误差E 0;然后求出知道X ,以X 预测Y 时的全部误差E 1;最后求出消减误差比例作为其相关系数值。

公式是τ=n F n n F F f Y Y X ∑∑∑∑--222 τ系数有PRE 意义,它比λ系数灵敏。

第三节 定序变量的相关分析如果变量不仅可以区分类,而且可排出序(或秩),那么我们就得面对定序变量的相关分析了。

定序变量是只能排列高低次序、而无法确定其精确数量的变量。

故在分析定序变量的X 与Y 相关时,只能考虑X 与Y 两变量变化的顺序是否一致及其等级之间的差距,并以此来求算两变量相关关系之相关系数。

1. 同序对、异序对、同分对社会学研究常用的两定序变量的相关测量法,有一类是以同序对、异序对、同分对的概念为基础的,如Gamma 系数,肯得尔系数、d 系数等。

所以我们在讨论这几种相关系数之前,先要掌握这三个概念。

(1)同序对在观察X 序列时如果我们看到i X <j X ,在Y 序列中看到的是i Y <j Y ,则称这一配对是同序对。

同序对只要求X 变化方向和Y 变化方向相同,并不要求X 变化大小和Y 变化大小相等。

同序对的总数用符号s n 表示。

(2)异序对在观察X 序列时如果我们看到i X <j X ,在Y 序列中看到的是i Y >j Y ,则称这一配对是异序对。

同样,异序对只要求X 变化方向和Y 变化方向相同,并不要求X 变化大小和Y 变化大小相等。

异序对的总数用符号d n 表示。

(3)同分对如果在X 序列中,我们观察到i X =j X ,则这个配对为X 同分对;X 同分对的总数用符号x T 表示。

如果在Y 序列中,我们观察到i Y =j Y ,则称这个配对为Y 同分对,Y 同分对的总数用符号y T 表示。

如果我们观察到i X =j X 时,也观察到i Y =j Y ,则称这两个配对为X 与Y 同分对,以xy T 代表。

对于列联表的资料,计算同序对,要用“右下余子式”法;计算异序对,要用 “左下余子式”法。

五种不同配对的总的数目是xy y x d s T T T N N T ++++=)(总对数。

2.Gamma 系数Gamma 系数适用于测量两对称的定序变项的相关系数,计算公式是ds d s n n n n G +-=。

Gamma 系数同样具有削减误差比例PRE 性质。

3.肯德尔等级相关系数对于求等级相关系数,统计学家肯德尔(Kendall)提出了多种方案:(1) a τ系数; (2) b τ系数;(3) c τ系数。

4. 萨默斯(d 系数)与G 系数、b τ系数、c τ系数不同,d 系数的值依赖于将哪一个变量作为自变量,哪一个变量作为因变量,是一种不对称测量。

具体地说, yx d 测量Y X →,用于以X 预测Y ;xy d 测量Y X ←,用于以Y 预测X 。

两者的值域是[–1,1],公式是yd s d s yx T n n n n d ++-= x d s d s xy T n n n n d ++-=5. 斯皮尔曼等级相关系数第一位推导等级之间相关系数的人是英国心理学家查尔斯·斯皮尔曼。

他创造的一个等级相关的公式,可以用来计算两个定序变量之间的相关程度。

斯皮尔曼系数通常以s r 代表,即()16122--=∑n n d r s6.肯德尔和谐系数(k r ) 前面我们谈的都是对双变量求等级相关系数。

对于多变量求等级相关系数,肯德尔运用数理分析方法,提出了一个计算公式 1)1(3)1(122212-+--=∑=n n n n k R r n i k I 第四节 定距变量的相关分析两个定距变量之间的相关测量,最常用的就是所谓积差系数.它是由英国统计学家皮尔逊(Pearson)用积差方法推导出来,所以也称皮尔逊相关系数,用符号r 表示。

而在本章一开头,关于相关程度与方向,我们谈到了定距—定距变量线性相关的问题。

其实,积差系数表达的是两定距变量之间的线性相关关系。

不仅如此,我们根据两变量之间的这种线性关系,可以进一步建立代数公式,以一个自变量X 的值去预测一个因变量Y 的值,这就是下一节讲的回归分析。

1.相关表和相关图在社会统计学中,由于变量之间的测量层次不同,研究相关关系的方法也有所不同。

相关表是在定距测量的层次上,反映两变量之间对应关系的数据表,它是积差系数计算的依据。

将相关表所示的各个有对应关系的数据在直角坐标系上画出来,以直观地观察X 和Y 之间的相互关系,即得相关图。

相关图又称散点图。

如果数据足够多,从散点图上可以直观地看出两变量之间存在着何种相关关系。

2.积差系数的导出和计算皮尔逊相关系数用来测量两个定距变量相关强度和方向,即 r =∑∑∑))((22y x xy不难看出,在r 系数的计算公式中,变量X 和Y 是对等关系。

引入协方差2XY S ,积差系数又可以表达为r =YX XY S S S ⋅2不难看出,积差系数是协方差与两个随机变量X 、Y 的标准差乘积的比率。

实际计算时,一般采用以下简化r =∑∑∑∑∑∑∑---2222)()(Y Y n X X n YX XY n3.积差系数的性质(1)皮尔逊相关系数是线性相关系数。