第七章马尔可夫过程简介

- 格式:pdf

- 大小:273.20 KB

- 文档页数:13

马尔可夫决策过程简介马尔可夫决策过程(Markov Decision Process,MDP)是一种在人工智能和运筹学领域广泛应用的数学模型。

它可以描述一类随机决策问题,并提供了一种优化决策的框架。

在现实世界中,许多问题都可以被建模为马尔可夫决策过程,比如自动驾驶车辆的路径规划、机器人的行为控制和资源分配等。

1. 马尔可夫决策过程的基本概念在马尔可夫决策过程中,问题被建模为一个五元组(S, A, P, R, γ):- S 表示状态空间,包括所有可能的状态;- A 表示动作空间,包括所有可能的动作;- P 表示状态转移概率,描述了在某个状态下采取某个动作后转移到下一个状态的概率分布;- R 表示奖励函数,描述了在某个状态下采取某个动作后获得的即时奖励;- γ(gamma)表示折扣因子,用于平衡当前奖励和未来奖励的重要性。

2. 马尔可夫决策过程的模型马尔可夫决策过程的模型可以用有向图表示,其中节点表示状态,边表示从一个状态到另一个状态的动作,边上的权重表示状态转移概率和即时奖励。

通过对模型进行分析和计算,可以找到最优的决策策略,使得在长期累积奖励最大化的情况下,系统能够做出最优的决策。

3. 马尔可夫决策过程的求解方法对于小规模的马尔可夫决策过程,可以直接使用动态规划方法进行求解,比如值迭代和策略迭代。

值迭代是一种迭代算法,通过不断更新状态值函数来找到最优策略;策略迭代则是一种迭代算法,通过不断更新策略函数来找到最优策略。

这些方法可以保证最终收敛到最优解,但是计算复杂度较高。

对于大规模的马尔可夫决策过程,通常采用近似求解的方法,比如蒙特卡洛方法、时序差分学习方法和深度强化学习方法。

蒙特卡洛方法通过对大量样本进行采样和统计来估计状态值函数和策略函数;时序差分学习方法则是一种在线学习算法,通过不断更新估计值函数来逼近真实值函数;深度强化学习方法则是一种基于神经网络的方法,通过端到端的学习来直接从环境中学习最优策略。

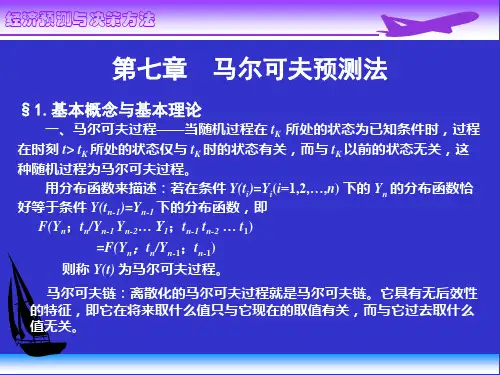

1第七章 马尔可夫过程简介§7.1 马尔可夫过程定义对于一个随机过程,如果它具有以下特性:即当过程在现在时刻k t 所处的状态为已知的条件下,过程在将来时刻k t t >处的状态,只与过程在k t 时刻的状态有关,而与过程在k t 时刻以前所处的状态无关,则具具有此种特性的随机过程称为马尔可夫过程。

上述随机过程所具有的特性又称为无后效应。

无后效应也理解为:过程)(t X 在现在时刻k t 的状态,k k i t X =)(已知的条件下,过程“将来”的情况与“过去”的情况是无关的。

或者说,这种随机过程的“将来”只是通过“现在”与“过去”发生联系,如果一旦“现在”已知,那么“将来”和“过去”就无关了。

或者说,这种随机过程的“将来”只是通过“现在”与“过去”发生联系,如果一旦“现在”已知,那么“将来”和“过去”就无关了。

严格定义如下:定义马尔可夫过程:考虑随机过程)(t X ,并设1110+<<<<k k t t t t t ,如果它的条件概率密度函数满足)]()([)](,),(),()([1011k k k k k t x t x f t x t x t x t x f +-+= 则称为)(t X 为马尔可夫过程。

定义表明,)1(+k t x 的概率密度函数只取决于)(k t x 的状态,而与前)(,),(01t x t x k -个状态无关。

也就是“现在”的状态)(k t x 才对“将来”的状态)(1+k t x 有影响,而“过去”的状态)(,),(),(021t x t x t x k k --对“将来”没有影响。

由马尔要夫定义再根据条件密度函数公式,可写出马乐可夫过程的联合概率密度。

∵ ])(,),()([01t x t x t x f k k +)](,),(),([)](,),(),(),([01011t x t x t x f t x t x t x t x f k k k k k --+=)](,),(),(),([011t x t x t x t x f k k k -+2)](,),(),([)](,),(|)([0101t x t x t x f t x t x t x f k k k k -+= )](,),(),([)](|)([011t x t x t x f t x t x f k k k k -+=∏=+=ki i i t f t x t x f 01)()](|)([由上式要知,马尔可夫过程的联合概率密度函数等于各个转移概率密度和初始概率密度的乘积。

第7章 马尔可夫过程与泊松过程7.1 马尔可夫过程1.引例例1:随机游动问题。

质点在一直线上作随机游动,如果某一时刻质点位于点i ,则下一步质点以概率p 向左移动一格达到点1-i ,以概率)1(p -向右移动一格达到点1+i 。

用)(n X 表示时刻n 质点的位置,则)(n X 是一随机过程。

在时刻1+n 质点所处的位置)1(+n X 只与时刻n 质点的位置)(n X 有关,而与n 以前的位置)1(-n X …)2(X 、)1(X 无关。

例2:遗传病问题。

某些疾病常遗传给下一代,但不隔代遗传。

第1+n 代是否有此种疾病只与第n 代是否有此疾病有关,而与n 代以前的健康状况无关。

2.马尔可夫过程描述性概念一般而言,若随机过程在时刻n t 所处的状态)(n t X 为已知的条件下,过程在时刻t (n t t >)所处的状态)(t X 只与过程在时刻n t 的状态)(n t X 有关,而与n t 以前的状态无关,则称此过程为马尔可夫过程。

3.马尔可夫过程分类马尔可夫过程分为四类:(1) 离散马尔可夫链:时间t 取离散值1t , ,2t ,n t ,可直接记为 ,,2,1n t =。

状态)(n X 取离散值1a , ,2a ,n a ,可直接记为 ,,2,1n X =。

(2) 连续马尔可夫链:时间t 取离散值1t , ,2t ,n t ,状态)(n X 取连续值。

(3) 离散马尔可夫过程:时间t 取连续值,状态)(t X 取离散值。

(4) 连续马尔可夫过程:时间t 取连续值,状态)(t X 取连续值。

.4.马尔可夫过程的研究与应用概况在随机过程的研究领域,马尔可夫过程是主要的研究对象,有关的专著、专题无计其数,其原因是马尔可夫过程与众多的应用领域有关联。

5.马尔可夫链(1)定义设时间t 取离散值 ,,2,1n t =,记)(n X X n =,设状态n X 取有限个离散值N X ,2,1=,若{}{}i X j X P i X i X i X j X P n n n n n n =======+--+111111,,称n X 马尔可夫链。

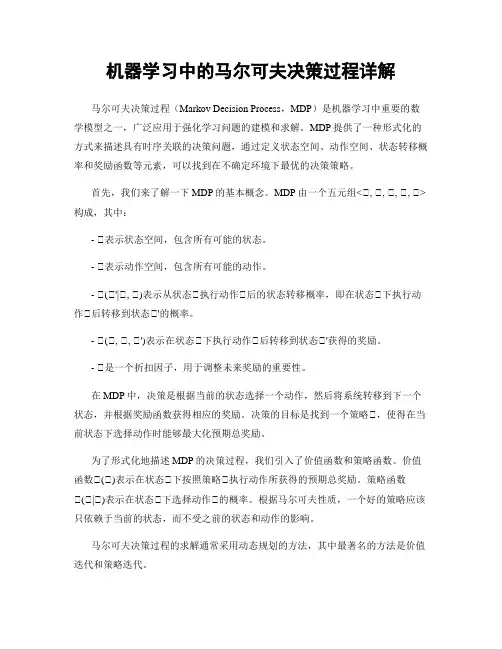

机器学习中的马尔可夫决策过程详解马尔可夫决策过程(Markov Decision Process,MDP)是机器学习中重要的数学模型之一,广泛应用于强化学习问题的建模和求解。

MDP提供了一种形式化的方式来描述具有时序关联的决策问题,通过定义状态空间、动作空间、状态转移概率和奖励函数等元素,可以找到在不确定环境下最优的决策策略。

首先,我们来了解一下MDP的基本概念。

MDP由一个五元组<S, S, S, S, S>构成,其中:- S表示状态空间,包含所有可能的状态。

- S表示动作空间,包含所有可能的动作。

- S(S'|S, S)表示从状态S执行动作S后的状态转移概率,即在状态S下执行动作S后转移到状态S'的概率。

- S(S, S, S')表示在状态S下执行动作S后转移到状态S'获得的奖励。

- S是一个折扣因子,用于调整未来奖励的重要性。

在MDP中,决策是根据当前的状态选择一个动作,然后将系统转移到下一个状态,并根据奖励函数获得相应的奖励。

决策的目标是找到一个策略S,使得在当前状态下选择动作时能够最大化预期总奖励。

为了形式化地描述MDP的决策过程,我们引入了价值函数和策略函数。

价值函数S(S)表示在状态S下按照策略S执行动作所获得的预期总奖励。

策略函数S(S|S)表示在状态S下选择动作S的概率。

根据马尔可夫性质,一个好的策略应该只依赖于当前的状态,而不受之前的状态和动作的影响。

马尔可夫决策过程的求解通常采用动态规划的方法,其中最著名的方法是价值迭代和策略迭代。

价值迭代是一种基于价值函数的迭代方法。

它通过不断更新状态的价值函数来逐步优化策略。

在每一次迭代中,我们根据贝尔曼方程S(S) = max S∑S' S(S'|S, S) (S(S, S, S') + SS(S'))来更新每个状态的价值函数。

其中max运算表示在当前状态下选择能够最大化预期总奖励的动作,S(S'|S, S)表示从状态S执行动作S后转移到状态S'的概率,S(S, S, S')表示在状态S下执行动作S后转移到状态S'获得的奖励,S是折扣因子,S(S')表示状态S'的价值函数。

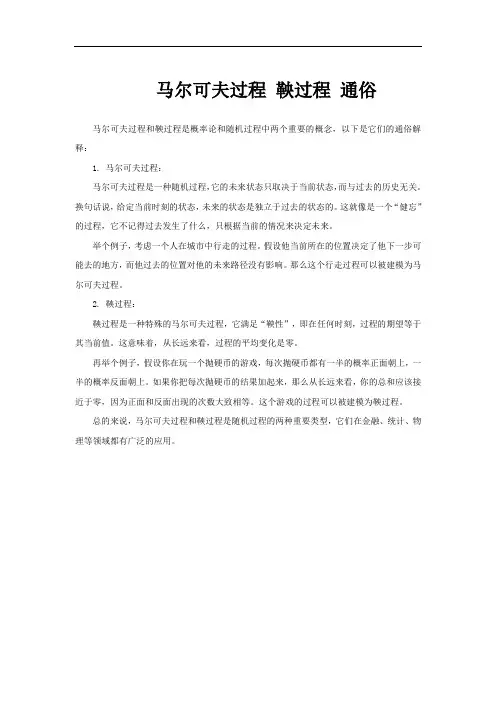

马尔可夫过程鞅过程通俗

马尔可夫过程和鞅过程是概率论和随机过程中两个重要的概念,以下是它们的通俗解释:

1. 马尔可夫过程:

马尔可夫过程是一种随机过程,它的未来状态只取决于当前状态,而与过去的历史无关。

换句话说,给定当前时刻的状态,未来的状态是独立于过去的状态的。

这就像是一个“健忘”的过程,它不记得过去发生了什么,只根据当前的情况来决定未来。

举个例子,考虑一个人在城市中行走的过程。

假设他当前所在的位置决定了他下一步可能去的地方,而他过去的位置对他的未来路径没有影响。

那么这个行走过程可以被建模为马尔可夫过程。

2. 鞅过程:

鞅过程是一种特殊的马尔可夫过程,它满足“鞅性”,即在任何时刻,过程的期望等于其当前值。

这意味着,从长远来看,过程的平均变化是零。

再举个例子,假设你在玩一个抛硬币的游戏,每次抛硬币都有一半的概率正面朝上,一半的概率反面朝上。

如果你把每次抛硬币的结果加起来,那么从长远来看,你的总和应该接近于零,因为正面和反面出现的次数大致相等。

这个游戏的过程可以被建模为鞅过程。

总的来说,马尔可夫过程和鞅过程是随机过程的两种重要类型,它们在金融、统计、物理等领域都有广泛的应用。

马尔可夫决策过程简介马尔可夫决策过程(Markov Decision Process, MDP)是一种用于描述随机决策问题的数学框架。

它是由苏联数学家安德雷·马尔可夫在20世纪初提出的,被广泛应用于控制理论、人工智能、经济学等领域。

马尔可夫决策过程的核心思想是通过数学模型描述决策者在具有随机性的环境中做出决策的过程,以及这些决策对环境的影响。

本文将介绍马尔可夫决策过程的基本概念和应用。

1. 随机过程马尔可夫决策过程是建立在随机过程的基础上的。

随机过程是指随机变量随时间变化的过程,它可以用来描述许多自然现象和工程问题。

在马尔可夫决策过程中,状态和行动都是随机变量,它们的变化是随机的。

这种随机性使得马尔可夫决策过程具有很强的适用性,可以用来描述各种真实世界中的决策问题。

2. 状态空间和转移概率在马尔可夫决策过程中,环境的状态被建模为一个有限的状态空间。

状态空间中的每个状态都代表了环境可能处于的一种情况。

例如,在一个机器人导航的问题中,状态空间可以表示为机器人可能所处的每个位置。

转移概率则描述了从一个状态转移到另一个状态的概率。

这个概率可以用一个转移矩阵来表示,矩阵的每个元素代表了从一个状态到另一个状态的转移概率。

3. 奖励函数在马尔可夫决策过程中,决策者的目标通常是最大化长期的累积奖励。

奖励函数用来描述在不同状态下采取不同行动所获得的奖励。

这个奖励可以是实数,也可以是离散的,它可以是正也可以是负。

决策者的目标就是通过选择合适的行动,使得累积奖励达到最大。

4. 策略在马尔可夫决策过程中,策略是决策者的行动规则。

它描述了在每个状态下选择行动的概率分布。

一个好的策略可以使得决策者在长期累积奖励最大化的同时,也可以使得系统的性能达到最优。

通常情况下,我们希望找到一个最优策略,使得系统在给定的状态空间和转移概率下能够最大化累积奖励。

5. 值函数值函数是描述在给定策略下,系统在每个状态下的长期累积奖励的期望值。

(完整word版)马尔可夫决策过程马尔可夫决策过程(MarkovDecisionProcesses 马尔可夫决策过程马尔可夫决策过程(Markov Decision Processes,MDP)马尔可夫决策过程概述马尔可夫决策过程是基于马尔可夫过程理论的随机动态系统的最优决策过程。

马尔可夫决策过程是序贯决策的主要研究领域。

它是马尔可夫过程与确定性的动态规划相结合的产物,故又称马尔可夫型随机动态规划,属于运筹学中数学规划的一个分支.马尔可夫决策过程是指决策者周期地或连续地观察具有马尔可夫性的随机动态系统,序贯地作出决策。

即根据每个时刻观察到的状态,从可用的行动集合中选用一个行动作出决策,系统下一步(未来)的状态是随机的,并且其状态转移概率具有马尔可夫性。

决策者根据新观察到的状态,再作新的决策,依此反复地进行。

马尔可夫性是指一个随机过程未来发展的概率规律与观察之前的历史无关的性质。

马尔可夫性又可简单叙述为状态转移概率的无后效性。

状态转移概率具有马尔可夫性的随机过程即为马尔可夫过程。

马尔可夫决策过程又可看作随机对策的特殊情形,在这种随机对策中对策的一方是无意志的。

马尔可夫决策过程还可作为马尔可夫型随机最优控制,其决策变量就是控制变量。

马尔可夫决策过程的发展概况50年代R。

贝尔曼研究动态规划时和L.S。

沙普利研究随机对策时已出现马尔可夫决策过程的基本思想。

R。

A.霍华德(1960)和D。

布莱克韦尔(1962)等人的研究工作奠定了马尔可夫决策过程的理论基础.1965年,布莱克韦尔关于一般状态空间的研究和E.B。

丁金关于非时齐(非时间平稳性)的研究,推动了这一理论的发展。

1960年以来,马尔可夫决策过程理论得到迅速发展,应用领域不断扩大。

凡是以马尔可夫过程作为数学模型的问题,只要能引入决策和效用结构,均可应用这种理论。

马尔可夫决策过程的数学描述周期地进行观察的马尔可夫决策过程可用如下五元组来描述:{S,(A(i),i∈S,q,γ,V},其中S 为系统的状态空间(见状态空间法); A(i)为状态i(i∈S)的可用行动(措施,控制)集;q为时齐的马尔可夫转移律族,族的参数是可用的行动;γ是定义在Γ(Г呏{(i,ɑ):a∈A(i),i∈S}上的单值实函数;若观察到的状态为i,选用行动a,则下一步转移到状态 j的概率为q(j│i,ɑ),而且获得报酬γ(j,ɑ),它们均与系统的历史无关;V是衡量策略优劣的指标(准则)。

马尔可夫过程Markov process1951年前后,伊藤清建立的随机微分方程的理论,为马尔可夫过程的研究开辟了新的道路。

1954年前后,W.费勒将半群方法引入马尔可夫过程的研究。

流形上的马尔可夫过程、马尔可夫向量场等都是正待深入研究的领域。

类重要的随机过程,它的原始模型马尔可夫链,由俄国数学家Α.Α.马尔可夫于1907年提出。

人们在实际中常遇到具有下述特性的随机过程:在已知它目前的状态(现在)的条件下,它未来的演变(将来)不依赖于它以往的演变(过去)。

这种已知“现在”的条件下,“将来”与“过去”独立的特性称为马尔可夫性,具有这种性质的随机过程叫做马尔可夫过程。

荷花池中一只青蛙的跳跃是马尔可夫过程的一个形象化的例子。

青蛙依照它瞬间或起的念头从一片荷叶上跳到另一片荷叶上,因为青蛙是没有记忆的,当现在所处的位置已知时,它下一步跳往何处和它以往走过的路径无关。

如果将荷叶编号并用X0,X1,X2,…分别表示青蛙最初处的荷叶号码及第一次、第二次、……跳跃后所处的荷叶号码,那么{Xn,n≥0} 就是马尔可夫过程。

液体中微粒所作的布朗运动,传染病受感染的人数,原子核中一自由电子在电子层中的跳跃,人口增长过程等等都可视为马尔可夫过程。

还有些过程(例如某些遗传过程)在一定条件下可以用马尔可夫过程来近似。

关于马尔可夫过程的理论研究,1931年Α.Η.柯尔莫哥洛夫发表了《概率论的解析方法》,首先将微分方程等分析方法用于这类过程,奠定了它的理论基础。

1951年前后,伊藤清在P.莱维和C.H.伯恩斯坦等人工作的基础上,建立了随机微分方程的理论,为研究马尔可夫过程开辟了新的道路。

1954年前后,W.弗勒将泛函分析中的半群方法引入马尔可夫过程的研究中,Ε.Б.登金(又译邓肯)等并赋予它概率意义(如特征算子等)。

50年代初,角谷静夫和J.L.杜布等发现了布朗运动与偏微分方程论中狄利克雷问题的关系,后来G.A.亨特研究了相当一般的马尔可夫过程(亨特过程)与位势的关系。