基于Padde的人流检测和红绿灯识别

- 格式:pptx

- 大小:8.34 MB

- 文档页数:18

利用深度学习实现交通信号灯识别随着交通工具的普及,市面上各种形状的交通信号灯如雨后春笋般涌现。

这些灯光不断变化着,为我们提供着准确的信号指引和路况提示。

但是,在夜晚或者雨雪天气中,这些信号灯的可辨识度会大大降低,甚至变得模糊不清,这也为司机们带来了不小的危险。

所以,如何快速准确地辨别交通信号灯,一直是交通行业研究的热点之一。

本文将介绍一种新的方法,利用深度学习技术,实现交通信号灯的快速识别。

深度学习是一种人工智能技术,其主要目的是让机器模拟人类的认知过程,即通过大量的数据和模式识别算法进行学习,并能够进行自我调整和改进。

应用于交通信号灯识别中,我们可以使用拍摄下的交通信号灯图像进行深度学习,并对其逐帧进行分类,从而能够实现对交通信号灯的快速准确识别。

具体而言,识别交通信号灯可以分为三个步骤:图像处理、特征提取和分类信号灯。

首先,我们需要对拍摄下的交通信号灯图像进行处理,将其转化为数字信号,从而能够进行下一步的特征提取工作。

可以通过采用图像处理技术,比如颜色分离、二值化等方法,去除图像中杂乱的信息,只保留交通信号灯的部分。

这样做可以在一定程度上减少数据量和计算时间。

接着,我们需要对处理后的数据进行特征提取。

特征提取的目的是将交通信号灯图像中的重要特征提取出来,并将其转化为数字信号的形式。

这里,我们可以使用深度学习中的卷积神经网络(CNN)进行训练和特征提取。

CNN是一种权重共享的神经网络结构,其通过多层卷积和池化操作,将输入图像转化为特征映射。

这里,我们可以使用预训练好的CNN模型,或者通过自建模型进行训练,从而提取出适合信号灯分类的特征。

最后,我们将提取出的特征与交通信号灯的不同类型进行分类,从而实现对交通信号灯的快速和准确识别。

这里,我们可以使用支持向量机(SVM)、决策树等机器学习模型进行分类。

值得注意的是,可以通过增加数据的多样性和数量,进一步提高识别效果。

总的来说,利用深度学习技术进行交通信号灯识别具有许多优点。

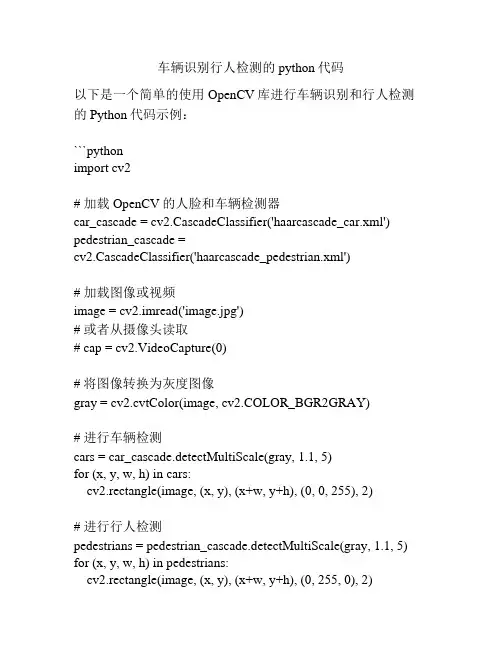

车辆识别行人检测的python代码以下是一个简单的使用OpenCV库进行车辆识别和行人检测的Python代码示例:```pythonimport cv2# 加载OpenCV的人脸和车辆检测器car_cascade = cv2.CascadeClassifier('haarcascade_car.xml') pedestrian_cascade =cv2.CascadeClassifier('haarcascade_pedestrian.xml')# 加载图像或视频image = cv2.imread('image.jpg')# 或者从摄像头读取# cap = cv2.VideoCapture(0)# 将图像转换为灰度图像gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)# 进行车辆检测cars = car_cascade.detectMultiScale(gray, 1.1, 5)for (x, y, w, h) in cars:cv2.rectangle(image, (x, y), (x+w, y+h), (0, 0, 255), 2)# 进行行人检测pedestrians = pedestrian_cascade.detectMultiScale(gray, 1.1, 5) for (x, y, w, h) in pedestrians:cv2.rectangle(image, (x, y), (x+w, y+h), (0, 255, 0), 2)# 显示结果cv2.imshow('Car and Pedestrian Detection', image)cv2.waitKey(0)cv2.destroyAllWindows()```要运行此代码,您需要将`haarcascade_car.xml`和`haarcascade_pedestrian.xml`文件下载到同一目录下。

如何使用计算机视觉技术进行红绿灯识别随着人工智能技术的不断发展,计算机视觉技术逐渐成为人们关注的焦点之一。

计算机视觉技术可以通过模拟人类视觉,将照片、视频、实时图像等可视化信息转化为数字信号,实现对场景、物体、动作的检测、跟踪、识别等任务。

在交通领域中,红绿灯识别技术就是计算机视觉技术的重要应用之一。

红绿灯识别技术可以通过图像处理和深度学习算法的结合,实现对红绿灯的快速、准确识别,在保障交通安全、减少交通拥堵等方面发挥着越来越重要的作用。

一、红绿灯识别的基本原理红绿灯识别技术的核心是对交通标志、红绿灯的检测和识别。

其基本流程主要包括:提取候选区域、特征提取和分类决策三个阶段。

首先,在图片或视频中提取出可能存在红绿灯的候选区域,可以通过像素级分割、滑动窗口等方法进行。

候选区域提取的目的是减少计算机处理的数据量,缩短处理时间,以提高处理效率。

接着,对候选区域进行特征提取。

特征提取是指将图片(候选区域)中的信息转化为计算机可处理的数字信号,一般采用SIFT、HOG、LBP等现有的特征提取器进行特征分析提取,以提高红绿灯识别的准确性。

最后,通过人工分类或者深度学习分类器进行分类决策。

在分类过程中,分类器将图片或候选区域分为“红灯”、“绿灯”、“黄灯”或“无灯”四类,从而实现对红绿灯的快速识别和准确判断。

二、红绿灯识别技术的重要性红绿灯识别技术在现代城市交通中发挥着越来越重要的作用,其价值主要体现在以下三个方面。

1、优化红绿灯控制技术。

采用计算机视觉技术进行红绿灯识别,可以实时获取红绿灯的状态信息,优化红绿灯配时控制,减少交通堵塞和能源浪费。

2、提高智能交通系统效率。

红绿灯识别技术是智能交通系统中的重要组成部分,它能够实现对交通流量、拥堵状态等数据的实时采集和处理,实现交通信号控制的协调和优化,提高智能交通系统的效率和精度。

3、保障交通安全。

红绿灯识别技术不仅能够实时检测红绿灯的状态,还能够检测并识别交通标志、行人、车辆等,提高交通安全性。

开题报告一、选题背景随着人工智能技术的不断发展,图像识别技术在各个领域得到了广泛应用,如人脸识别、车牌识别、商品识别等。

paddlepaddle作为国内领先的深度学习评台,提供了丰富的图像识别模型和工具,为开发者提供了便利。

二、选题意义本识别项目旨在基于paddlepaddle开发一个图像识别系统,通过结合深度学习技术和大规模数据训练,提高图像识别的准确率和速度,为用户提供更好的使用体验。

该项目的实施将有效推动图像识别技术的研究与应用,为行业发展和社会进步做出积极贡献。

三、选题内容1. 确定识别领域:本项目将重点关注人脸识别、车牌识别和商品识别等领域;2. 数据采集与预处理:对大规模图像数据进行采集和预处理,为后续模型训练提供支持;3. 模型选择与构建:结合paddlepaddle提供的图像识别模型和算法,构建适用于不同场景的识别模型;4. 模型性能优化:通过调参和模型融合等方法,提升识别模型的准确率和速度;5. 系统部署与性能测试:将优化后的识别模型集成到系统中,并进行性能测试和稳定性评估。

四、技术路线1. 数据采集与预处理:利用网络爬虫技术和开放数据源,采集人脸、车牌和商品的图像数据,并进行数据清洗和标注;2. 模型选择与构建:选择ResNet、VGG等经典的图像识别模型,在paddlepaddle评台上进行模型构建和训练;3. 模型性能优化:通过学习率调整、网络剪枝等方法,优化模型的性能;4. 系统部署与性能测试:将优化后的模型部署到服务器上,进行并发性能测试和实际场景测试。

五、进度安排1. 第一阶段(1-2周):完成数据采集和预处理工作;2. 第二阶段(3-5周):选择并构建图像识别模型,并进行初步性能测试;3. 第三阶段(6-8周):深入优化模型性能,并完成系统部署和性能测试;4. 第四阶段(9-10周):整理项目文档、撰写技术报告、准备毕业答辩。

六、预期成果1. 完成一个基于paddlepaddle的图像识别系统原型,实现对人脸、车牌和商品的自动识别;2. 在常见数据集上取得较高的识别准确率,满足实际应用需求;3. 撰写一篇学术论文,并提交至相关期刊或会议;4. 参加学校的毕业设计答辩,并取得优异成绩。

如何利用计算机视觉技术进行行人与车辆检测与识别计算机视觉技术在近年来得到了广泛应用,其中之一就是行人与车辆检测与识别。

这项技术可以应用于许多领域,如交通管理、智能监控和自动驾驶等。

本文将介绍如何利用计算机视觉技术进行行人与车辆检测与识别,并探讨其应用和未来发展。

行人与车辆检测与识别是计算机视觉的一个重要研究方向。

它的目标是通过对图像或视频进行处理和分析,准确地检测和识别出行人和车辆。

这项技术可以应用于很多场景,如智能交通监控、机器人导航以及自动驾驶等。

首先,行人与车辆检测与识别的关键是图像处理和特征提取。

对于行人检测,常用的方法有基于部件的检测和基于全身的检测。

基于部件的检测方法将行人视为由身体和头部等部位组成的部件,通过对这些部位进行定位和识别来达到目标检测的目的。

而基于全身的检测则直接对整个行人进行检测和识别。

相比之下,车辆检测相对较为简单,常用的方法主要依赖于车辆的外观特征。

其次,对于行人与车辆的识别,关键是构建有效的分类器。

深度学习是当前行人与车辆识别中最常用的方法之一。

通过训练神经网络模型,可以实现对行人和车辆的准确识别。

此外,还可以借助传统的机器学习方法,如支持向量机(SVM)和随机森林(Random Forest),来提高分类的准确性。

除了基本的行人和车辆检测与识别,计算机视觉技术还可以应用于更复杂的场景,如行人重识别和行人姿态估计。

行人重识别是指在多个摄像头或视频序列中,通过比对行人的特征,实现行人在不同场景中的准确识别。

行人姿态估计则是通过分析行人的姿态信息,提取出行人的动作特征,用于行人行为分析和动作识别。

在实际应用中,计算机视觉技术在交通管理和智能监控领域有着广泛的应用。

在交通管理方面,可以通过车辆检测和识别来实现交通流量监测、交通违规检测和智能交通信号控制等。

在智能监控方面,可以借助行人检测和识别来实现安防监控、行人行为分析和人员定位等功能。

此外,随着自动驾驶技术的发展,行人与车辆检测与识别也成为自动驾驶中不可或缺的一部分。

paddledetection参数参数是计算机科学中常见的概念,它用于指定程序或函数的输入和输出。

在计算机视觉领域中,有一个名为paddledetection的开源检测库,它是基于PaddlePaddle深度学习框架开发的。

本文将介绍paddledetection库中的参数以及其作用,以帮助读者更好地理解和使用该库。

一、paddledetection库简介paddledetection是一个面向目标检测任务的深度学习库,它提供了多种经典和先进的检测算法,包括Faster R-CNN、YOLOv3、SSD等。

该库是基于PaddlePaddle深度学习框架开发的,具有高性能和灵活性的优势。

paddledetection库可以广泛应用于各种场景,如人脸检测、车辆检测、行人检测等。

二、paddledetection参数介绍1. 配置文件参数在paddledetection库中,配置文件用于指定模型的各种参数,如网络结构、数据增强方式、学习率等。

常见的配置文件为`.yaml`格式,它可以包含如下几个常用参数:- `num_classes`:指定模型的类别数目,用于分类任务。

- `arch`:指定使用的网络结构,如ResNet、MobileNet等。

- `backbone`:指定用于提取特征的主干网络。

- `batch_size`:指定训练和推理时的批量大小。

- `learning_rate`:指定学习率的初始值和衰减策略。

- `data`:指定数据集的路径和预处理方式等。

2. 模型参数模型参数用于定义模型的结构和权重。

在paddledetection库中,可以通过读取预训练的模型参数来初始化模型,也可以通过训练自定义的模型来得到参数。

常见的模型参数有:- `pretrained_model`:指定预训练模型的路径,用于加载模型权重。

- `weights`:指定训练好的模型的权重。

3. 数据处理参数paddledetection库提供了丰富的数据处理方法,如随机翻转、随机裁剪、颜色扰动等。

paddledetection 三段码-概述说明以及解释1.引言1.1 概述概述部分的内容可以从以下方面进行描述:本文将介绍paddledetection三段码的相关内容。

paddledetection 是一个开源的目标检测框架,采用PaddlePaddle作为底层框架,具有高效、灵活、易用的特点。

三段码是该框架的核心组成部分之一,用于实现目标检测任务中的目标识别和定位。

在目标检测任务中,传统的方法主要依赖于手工设计的特征和模型。

然而,这些方法的性能往往受限于特征表示和模型的选择。

而深度学习的发展使得使用神经网络进行目标检测成为一种有效的方法。

paddledetection框架就是基于深度学习的目标检测方法之一。

paddledetection框架的一个重要特点是三段码。

其基本思想是将目标检测任务分为目标识别和目标定位两个阶段,分别采用不同的策略和模型来完成。

在目标识别阶段,三段码利用卷积神经网络来提取图像的特征,并根据这些特征对图像中的目标进行分类。

在目标定位阶段,三段码通过回归模型来预测目标在图像中的位置。

三段码的设计考虑了目标检测任务的特点和需求。

通过将目标识别和目标定位分离,可以充分发挥不同模型的优势,提高目标检测的准确性和效率。

此外,三段码还允许使用不同的模型进行组合,以适应不同的目标检测场景和要求。

总之,paddledetection框架中的三段码是一种有效的目标检测方法,通过分离目标识别和目标定位,可以提高检测的准确性和效率。

本文将对三段码的原理、实现和应用进行详细介绍,旨在帮助读者更好地理解和应用这一方法。

1.2 文章结构文章结构部分主要介绍了整篇文章的组织结构和各个部分的内容概要。

下面是对文章结构部分的内容描述:在本文中,将围绕"paddledetection 三段码"这一主题展开讨论。

本篇文章主要分为三个部分:引言、正文和结论。

引言部分将给读者一个简要的概述,包括对paddledetection三段码的背景和定义进行说明。

如何利用计算机视觉技术实现实时人流监测与统计随着城市化进程的加快,人口流动成为一个重要的话题。

了解人流量的情况对城市规划、交通管理以及商业决策等方面都具有重要意义。

传统的人流监测与统计通常依赖于人工的人工统计,耗时、耗力且容易出错。

而利用计算机视觉技术来实现实时人流监测与统计,不仅可以提高效率,还能减少人为错误的发生。

本文将介绍如何利用计算机视觉技术来实现这一目标。

首先,实现实时人流监测与统计需要使用到图像处理技术。

图像处理技术可以对观测场景中的人体进行定位和识别,进而实现人流量的统计。

在这个过程中,需要使用到计算机视觉算法,如人体检测和跟踪算法。

这些算法通常基于机器学习和深度学习的原理,通过对大量的图像数据进行训练,可以达到较高的准确率和鲁棒性。

其次,为了实现实时的人流监测与统计,需要使用到高性能的硬件设备和优化的算法实现。

计算机视觉算法通常需要处理大量的图像数据,因此对计算能力和存储空间的要求较高。

近年来,随着硬件设备的发展,如高性能处理器和图形处理器,计算能力大幅提升,使得实时人流监测与统计成为可能。

同时,针对实时性要求,还需要对算法进行优化,以提高实时监测与统计的速度和效率。

另外,实时人流监测与统计还需要解决一些实际的问题。

例如,如何在复杂多变的环境中进行准确的人体检测和跟踪,如何处理遮挡和光照变化等问题。

这些问题对算法的鲁棒性和稳定性提出了更高的要求。

对于这些问题,可以通过使用更高级的算法、引入多传感器融合技术以及使用更精确的摄像设备等方式来解决。

此外,实时人流监测与统计还可以结合其他数据源进行分析。

例如,可以将人流量与天气数据、交通数据等进行关联分析,从而更全面地了解人流量的情况。

这种数据融合分析可以为城市规划、商业决策等提供更深入的参考依据。

最后,实时人流监测与统计的应用广泛。

除了城市规划和交通管理领域,实时人流监测与统计还可以应用于商业决策、安防监控等各个领域。

例如,商店可以通过实时监测和统计人流量来优化布局和促销策略,从而提高销售额。

paddledetection 模型调用PaddleDetection模型调用PaddleDetection是一个基于PaddlePaddle深度学习框架开发的目标检测工具库。

它提供了一系列高效的目标检测模型,并且支持多种常见的目标检测任务,如人脸检测、行人检测、车辆检测等。

本文将介绍如何使用PaddleDetection模型进行目标检测。

一、PaddleDetection模型简介PaddleDetection模型是基于PaddlePaddle深度学习框架开发的一个目标检测工具库。

它提供了多种常见的目标检测模型,包括Faster RCNN、YOLO、SSD等。

这些模型在目标检测任务上具有较好的性能和准确度。

二、安装PaddleDetection要使用PaddleDetection模型进行目标检测,首先需要安装PaddlePaddle深度学习框架和PaddleDetection工具库。

可以通过PaddlePaddle官方网站提供的安装文档进行安装。

三、下载预训练模型在使用PaddleDetection模型进行目标检测之前,需要先下载相应的预训练模型。

PaddleDetection提供了一些预训练模型供用户使用,可以从PaddleDetection官方网站下载。

根据自己的需求选择相应的模型进行下载。

四、模型调用下载完成预训练模型后,就可以使用PaddleDetection模型进行目标检测了。

下面以Faster RCNN模型为例,介绍如何进行模型调用。

1. 导入相关库和模块首先需要导入PaddlePaddle深度学习框架和PaddleDetection模块。

可以使用以下代码进行导入:```pythonimport paddleimport paddle.fluid as fluidfrom paddle.fluid.dygraph import to_variablefrom paddle.fluid.dygraph import Linearfrom paddle.fluid.dygraph import Conv2Dfrom paddle.fluid.dygraph import Pool2Dfrom paddle.fluid.dygraph import Sequentialfrom paddle.fluid.dygraph import BatchNormimport paddledetection as pdet```2. 加载预训练模型使用以下代码加载预训练模型:```pythonmodel = pdet.models.FasterRCNN()model.load_weights('path/to/weights')```其中,'path/to/weights'是预训练模型的路径。

paddleocr 识别原理PaddleOCR是一个基于飞桨(PaddlePaddle)的开源OCR工具集,能够实现文字识别(Text Recognition)、文本检测(Text Detection)和文本识别(Text Recognition)三大主要功能。

PaddleOCR的主要原理是深度学习神经网络,其中使用的模型是基于EAST (Efficient and Accurate Scene Text Detector)和CRNN(Convolutional Recurrent Neural Network)模型。

文本检测在文本检测阶段,PaddleOCR采用的是基于EAST模型的方法。

EAST模型是一种基于深度学习的文本检测网络,其主要目标是从图像中检测文本的位置,并将其转换为矩形区域。

该模型由一个卷积层和四个分支组成,其中分支1和分支2用于检测文本的边界框,分支3和分支4用于检测边界框的朝向。

在这个过程中,PaddleOCR采取了一些技巧来优化模型的效果,例如使用类似多尺度图像金字塔的方法来消除大小变化的影响,使用ROIPooling技术来缩放图像并且保持特征映射的分辨率等。

文本识别在文本识别阶段,PaddleOCR采用的是基于CRNN模型的方法。

CRNN模型是一种基于深度学习的序列识别模型,其主要目标是将经过图像处理、文本检测的图像块转换为识别结果。

CRNN模型由卷积神经网络(Convolutional Neural Network,CNN)和循环神经网络(Recurrent Neural Network,RNN)组成。

CNN负责提取图像特征,RNN负责序列建模。

在这个过程中,PaddleOCR采取了一些技巧来优化模型的效果,例如使用Attention技术来加强模型对精细特征的学习,使用Beam Search技术来提高识别准确率等。

总体思路总的来说,PaddleOCR的识别原理是基于深度学习神经网络的方法,其中涉及到文本检测和文本识别两个过程。

paddleclas的评估指标PaddleClas是一个基于百度PaddlePaddle深度学习框架的图像分类模型,它可以应用于各种场景,如人脸识别、车牌识别、病理分析等。

为了评估PaddleClas模型的性能,我们需要一些指标来衡量模型的准确性和效率。

以下是PaddleClas的主要评估指标:1. 准确率(Accuracy):准确率是最基本的评估指标之一。

它表示模型分类正确的样本占总样本数的比例。

例如,如果模型正确分类了90个图像中的85个,则准确率为85/90=0.94。

2. 精确率(Precision):精确率是指模型分类为正例的样本中真正为正例的比例。

例如,如果模型将100个图像分类为正例,但只有90个是真正的正例,则精确率为90/100=0.9。

3. 召回率(Recall):召回率是指真正为正例的样本中被模型正确分类的比例。

例如,如果100个正例样本中有90个被正确分类,则召回率为90/100=0.9。

4. F1分数(F1-Score):F1分数是精确率和召回率的加权平均值,用于综合衡量模型的分类性能。

它的计算公式为:F1-Score=2*(精确率*召回率)/(精确率+召回率)。

5. Top-K准确率(Top-K Accuracy):Top-K准确率是指模型在前K个预测结果中是否包括真实标签,可以更全面地评估模型的性能。

例如,如果模型在前3个预测结果中包含了真实标签,则Top-3准确率为1。

6. 模型推理速度:模型推理速度是指模型对一个样本进行预测所需的时间。

通常用每秒推理样本数(Inference Samples per Second)来衡量模型的效率。

以上是PaddleClas常用的评估指标,这些指标能够全面地评估模型的性能,并且可以帮助我们不断优化模型,提高模型的分类准确性和效率。

paddle ocr 原理

PaddleOCR 是基于深度学习技术的OCR(Optical Character Recognition,光学字符识别)工具。

其原理主要包括以下几个步骤:

1. 图像预处理:将输入图像进行预处理,包括缩放、灰度化、二值化等操作,以提高图像质量和减少噪声。

2. 物体检测:使用物体检测模型(如Faster R-CNN、YOLO等)对图像中可能含有文字的区域进行标定,以便进行后续的字符识别。

3. 文字行划分:将检测到的文字区域进行排列,形成文字行。

这一步的目的是在后续的字符识别过程中提供更准确的上下文信息。

4. 文字识别:使用文字识别模型(如CRNN、Attention OCR等)对每个文字区域进行识别。

OCR模型会将每个文字区域分解为一个个字符,并使用深度学习算法对字符进行分类。

5. 输出结果:将识别结果转换为字符串,并输出对应的文字内容。

PaddleOCR 采用了PaddlePaddle作为底层深度学习框架,包含了多个预训练的模型和丰富的数据集,能够支持多种语言的文字识别任务,并且具备较高的精度和鲁棒性。

基于开源的PaddleOCR,用户可以自行调整和扩展OCR模型,以满足不同的需求。

一、背景介绍1. paddledetection是什么?2. paddledetection的训练目的及意义是什么?二、训练过程解析1. 数据准备2. 模型选择3. 训练参数设置4. 训练过程分析三、训练结果分析1. 模型评估指标2. 检测结果可视化3. 训练结果优劣比较四、应用场景及展望1. paddledetection的应用前景2. 改进方向及未来发展趋势五、结论一、背景介绍1. paddledetection是飞桨(PaddlePaddle)深度学习框架下的一个用于目标检测的开源库,它提供了一整套目标检测的解决方案,包括不同网络结构、多种损失函数和数据增强方法等。

2. paddledetection的训练目的是通过深度学习算法让计算机能够自动识别和定位图像中的目标物体,应用于人脸识别、智能监控、自动驾驶等领域,具有极大的意义。

二、训练过程解析1. 数据准备在进行paddledetection的训练前,首先需要准备大量的标注好的数据集,用于模型的训练和验证。

数据集的质量对训练结果有着至关重要的影响,因此需要对数据进行清洗、标注和划分,保证数据集的多样性和代表性。

2. 模型选择paddledetection支持多种经典的目标检测网络结构,包括Faster R-CNN、YOLO、SSD等,根据应用场景和性能要求选择适合的模型结构进行训练。

3. 训练参数设置在进行训练前,需要对模型的训练参数进行设置,包括学习率、优化器、损失函数等。

合理的训练参数设置能够加快模型的收敛速度,提高训练效果。

4. 训练过程分析在训练过程中,可以利用飞桨提供的可视化工具对模型的训练过程进行监控和分析,包括训练损失、验证精度等,帮助优化模型的训练效果。

三、训练结果分析1. 模型评估指标在完成训练后,需要对模型进行评估,采用常见的目标检测评价指标如精确率、召回率、F1值等对模型的性能进行评估。

2. 检测结果可视化通过可视化工具对模型的检测结果进行可视化展示,直观地了解模型的检测效果,包括定位精度、多目标检测能力等。

基于Python实现简单的⼈脸识别系统⽬录前⾔基本原理代码实现创建虚拟环境安装必要的库前⾔最近⼜多了不少朋友关注,先在这⾥谢谢⼤家。

关注我的朋友⼤多数都是⼤学⽣,⽽且我简单看了⼀下,低年级的⼤学⽣居多,⼤多数都是为了完成课程设计,作为⼀个过来⼈,还是希望⼤家平时能多抽出点时间学习⼀下,这种临时抱佛脚的策略要少⽤嗷。

今天我们来python实现⼀个⼈脸识别系统,主要是借助了dlib这个库,相当于我们直接调⽤现成的库来进⾏⼈脸识别,就省去了之前教程中的数据收集和模型训练的步骤了。

B站视频:⽤300⾏代码实现⼈脸识别系统_哔哩哔哩_bilibili码云地址:基本原理⼈脸识别和⽬标检测这些还不太⼀样,⽐如⼤家传统的训练⼀个⽬标检测模型,你只有对这个⽬标训练了之后,你的模型才能找到这样的⽬标,⽐如你的⽬标检测模型如果是检测植物的,那显然就不能检测动物。

但是⼈脸识别就不⼀样,以你的⼿机为例,你发现你只录⼊了⼀次你的⼈脸信息,不需要训练,他就能准确的识别你,这⾥识别的原理是通过⼈脸识别的模型提取你脸部的特征向量,然后将实时检测到的你的⼈脸同数据库中保存的⼈脸进⾏⽐对,如果相似度超过⼀定的阈值之后,就认为⽐对成功。

不过我这⾥说的只是简化版本的⼈脸识别,现在⼿机和门禁这些要复杂和安全的多,也不是简单平⾯上的⼈脸识别。

总结下来可以分为下⾯的步骤:1.上传⼈脸到数据库2.⼈脸检测3.数据库⽐对并返回结果这⾥我做了⼀个简答的⽰意图,可以帮助⼤家简单理解⼀下。

代码实现废话不多说,这⾥就是我们的代码实现,代码我已经上传到码云,⼤家直接下载就⾏,地址就在博客开头。

不会安装python环境的兄弟请看这⾥:创建虚拟环境创建虚拟环境前请⼤家先下载博客开头的码云源码到本地。

本次我们需要使⽤到python3.7的虚拟环境,命令如下:conda create -n face python==3.7.3conda activate face安装必要的库pip install -r requirements.txt愉快地开始你的⼈脸识别吧!执⾏下⾯的主⽂件即可python UI.py或者在pycharm中按照下⾯的⽅式直接运⾏即可⾸先将你需要识别的⼈脸上传到数据库中通过第⼆个视频检测功能识别实时的⼈脸详细的代码如下:# -*- coding: utf-8 -*-"""-------------------------------------------------Project Name: yolov5-jungongFile Name: window.py.pyAuthor: chenmingCreate Date: 2021/11/8Description:图形化界⾯,可以检测摄像头、视频和图⽚⽂件-------------------------------------------------"""# 应该在界⾯启动的时候就将模型加载出来,设置tmp的⽬录来放中间的处理结果import shutilimport PyQt5.QtCorefrom PyQt5.QtGui import *from PyQt5.QtCore import *from PyQt5.QtWidgets import *import threadingimport argparseimport osimport sysfrom pathlib import Pathimport cv2import torchimport torch.backends.cudnn as cudnnimport os.path as ospFILE = Path(__file__).resolve()ROOT = FILE.parents[0] # YOLOv5 root directoryif str(ROOT) not in sys.path:sys.path.append(str(ROOT)) # add ROOT to PATHROOT = Path(os.path.relpath(ROOT, Path.cwd())) # relativefrom mon import DetectMultiBackendfrom utils.datasets import IMG_FORMATS, VID_FORMATS, LoadImages, LoadStreamsfrom utils.general import (LOGGER, check_file, check_img_size, check_imshow, check_requirements, colorstr, increment_path, non_max_suppression, print_args, scale_coords, strip_optimizer, xyxy2xywh) from utils.plots import Annotator, colors, save_one_boxfrom utils.torch_utils import select_device, time_sync# 添加⼀个关于界⾯# 窗⼝主类class MainWindow(QTabWidget):# 基本配置不动,然后只动第三个界⾯def __init__(self):# 初始化界⾯super().__init__()self.setWindowTitle('Target detection system')self.resize(1200, 800)self.setWindowIcon(QIcon("images/UI/lufei.png"))# 图⽚读取进程self.output_size = 480self.img2predict = ""self.device = 'cpu'# # 初始化视频读取线程self.vid_source = '0' # 初始设置为摄像头self.stopEvent = threading.Event()self.webcam = Trueself.stopEvent.clear()self.model = self.model_load(weights="runs/train/exp_yolov5s/weights/best.pt",device="cpu") # todo 指明模型加载的位置的设备self.initUI()self.reset_vid()'''***模型初始化***'''@torch.no_grad()def model_load(self, weights="", # model.pt path(s)device='', # cuda device, i.e. 0 or 0,1,2,3 or cpuhalf=False, # use FP16 half-precision inferencednn=False, # use OpenCV DNN for ONNX inference):device = select_device(device)half &= device.type != 'cpu' # half precision only supported on CUDAdevice = select_device(device)model = DetectMultiBackend(weights, device=device, dnn=dnn)stride, names, pt, jit, onnx = model.stride, s, model.pt, model.jit, model.onnx # Halfhalf &= pt and device.type != 'cpu' # half precision only supported by PyTorch on CUDA if pt:model.model.half() if half else model.model.float()print("模型加载完成!")return model'''***界⾯初始化***'''def initUI(self):# 图⽚检测⼦界⾯font_title = QFont('楷体', 16)font_main = QFont('楷体', 14)# 图⽚识别界⾯, 两个按钮,上传图⽚和显⽰结果img_detection_widget = QWidget()img_detection_layout = QVBoxLayout()img_detection_title = QLabel("图⽚识别功能")img_detection_title.setFont(font_title)mid_img_widget = QWidget()mid_img_layout = QHBoxLayout()self.left_img = QLabel()self.right_img = QLabel()self.left_img.setPixmap(QPixmap("images/UI/up.jpeg"))self.right_img.setPixmap(QPixmap("images/UI/right.jpeg"))self.left_img.setAlignment(Qt.AlignCenter)self.right_img.setAlignment(Qt.AlignCenter)mid_img_layout.addWidget(self.left_img)mid_img_layout.addStretch(0)mid_img_layout.addWidget(self.right_img)mid_img_widget.setLayout(mid_img_layout)up_img_button = QPushButton("上传图⽚")det_img_button = QPushButton("开始检测")up_img_button.clicked.connect(self.upload_img)det_img_button.clicked.connect(self.detect_img)up_img_button.setFont(font_main)det_img_button.setFont(font_main)up_img_button.setStyleSheet("QPushButton{color:white}""QPushButton:hover{background-color: rgb(2,110,180);}""QPushButton{background-color:rgb(48,124,208)}""QPushButton{border:2px}""QPushButton{border-radius:5px}""QPushButton{padding:5px 5px}""QPushButton{margin:5px 5px}")det_img_button.setStyleSheet("QPushButton{color:white}""QPushButton:hover{background-color: rgb(2,110,180);}""QPushButton{background-color:rgb(48,124,208)}""QPushButton{border:2px}""QPushButton{border-radius:5px}""QPushButton{padding:5px 5px}""QPushButton{margin:5px 5px}")img_detection_layout.addWidget(img_detection_title, alignment=Qt.AlignCenter)img_detection_layout.addWidget(mid_img_widget, alignment=Qt.AlignCenter)img_detection_layout.addWidget(up_img_button)img_detection_layout.addWidget(det_img_button)img_detection_widget.setLayout(img_detection_layout)# todo 视频识别界⾯# 视频识别界⾯的逻辑⽐较简单,基本就从上到下的逻辑vid_detection_widget = QWidget()vid_detection_layout = QVBoxLayout()vid_title = QLabel("视频检测功能")vid_title.setFont(font_title)self.vid_img = QLabel()self.vid_img.setPixmap(QPixmap("images/UI/up.jpeg"))vid_title.setAlignment(Qt.AlignCenter)self.vid_img.setAlignment(Qt.AlignCenter)self.webcam_detection_btn = QPushButton("摄像头实时监测")self.mp4_detection_btn = QPushButton("视频⽂件检测")self.vid_stop_btn = QPushButton("停⽌检测")self.webcam_detection_btn.setFont(font_main)self.mp4_detection_btn.setFont(font_main)self.vid_stop_btn.setFont(font_main)self.webcam_detection_btn.setStyleSheet("QPushButton{color:white}""QPushButton:hover{background-color: rgb(2,110,180);}""QPushButton{background-color:rgb(48,124,208)}""QPushButton{border:2px}""QPushButton{border-radius:5px}""QPushButton{padding:5px 5px}""QPushButton{margin:5px 5px}")self.mp4_detection_btn.setStyleSheet("QPushButton{color:white}""QPushButton:hover{background-color: rgb(2,110,180);}""QPushButton{background-color:rgb(48,124,208)}""QPushButton{border:2px}""QPushButton{border-radius:5px}""QPushButton{padding:5px 5px}""QPushButton{margin:5px 5px}")self.vid_stop_btn.setStyleSheet("QPushButton{color:white}""QPushButton:hover{background-color: rgb(2,110,180);}""QPushButton{background-color:rgb(48,124,208)}""QPushButton{border:2px}""QPushButton{border-radius:5px}""QPushButton{padding:5px 5px}""QPushButton{margin:5px 5px}")self.webcam_detection_btn.clicked.connect(self.open_cam)self.mp4_detection_btn.clicked.connect(self.open_mp4)self.vid_stop_btn.clicked.connect(self.close_vid)# 添加组件到布局上vid_detection_layout.addWidget(vid_title)vid_detection_layout.addWidget(self.vid_img)vid_detection_layout.addWidget(self.webcam_detection_btn)vid_detection_layout.addWidget(self.mp4_detection_btn)vid_detection_layout.addWidget(self.vid_stop_btn)vid_detection_widget.setLayout(vid_detection_layout)# todo 关于界⾯about_widget = QWidget()about_layout = QVBoxLayout()about_title = QLabel('欢迎使⽤⽬标检测系统\n\n 提供付费指导:有需要的好兄弟加下⾯的QQ即可') # todo 修改欢迎词语 about_title.setFont(QFont('楷体', 18))about_title.setAlignment(Qt.AlignCenter)about_img = QLabel()about_img.setPixmap(QPixmap('images/UI/qq.png'))about_img.setAlignment(Qt.AlignCenter)# label4.setText("<a href='https://oi.wiki/wiki/学习率的调整'>如何调整学习率</a>")label_super = QLabel() # todo 更换作者信息label_super.setText("<a href='https:///ECHOSON'>或者你可以在这⾥找到我-->肆⼗⼆</a>")label_super.setFont(QFont('楷体', 16))label_super.setOpenExternalLinks(True)# label_super.setOpenExternalLinks(True)label_super.setAlignment(Qt.AlignRight)about_layout.addWidget(about_title)about_layout.addStretch()about_layout.addWidget(about_img)about_layout.addStretch()about_layout.addWidget(label_super)about_widget.setLayout(about_layout)self.left_img.setAlignment(Qt.AlignCenter)self.addTab(img_detection_widget, '图⽚检测')self.addTab(vid_detection_widget, '视频检测')self.addTab(about_widget, '联系我')self.setTabIcon(0, QIcon('images/UI/lufei.png'))self.setTabIcon(1, QIcon('images/UI/lufei.png'))self.setTabIcon(2, QIcon('images/UI/lufei.png'))'''***上传图⽚***'''def upload_img(self):# 选择录像⽂件进⾏读取fileName, fileType = QFileDialog.getOpenFileName(self, 'Choose file', '', '*.jpg *.png *.tif *.jpeg')if fileName:suffix = fileName.split(".")[-1]save_path = osp.join("images/tmp", "tmp_upload." + suffix)shutil.copy(fileName, save_path)# 应该调整⼀下图⽚的⼤⼩,然后统⼀防在⼀起im0 = cv2.imread(save_path)resize_scale = self.output_size / im0.shape[0]im0 = cv2.resize(im0, (0, 0), fx=resize_scale, fy=resize_scale)cv2.imwrite("images/tmp/upload_show_result.jpg", im0)# self.right_img.setPixmap(QPixmap("images/tmp/single_result.jpg"))self.img2predict = fileNameself.left_img.setPixmap(QPixmap("images/tmp/upload_show_result.jpg"))# todo 上传图⽚之后右侧的图⽚重置,self.right_img.setPixmap(QPixmap("images/UI/right.jpeg"))'''***检测图⽚***'''def detect_img(self):model = self.modeloutput_size = self.output_sizesource = self.img2predict # file/dir/URL/glob, 0 for webcamimgsz = 640 # inference size (pixels)conf_thres = 0.25 # confidence thresholdiou_thres = 0.45 # NMS IOU thresholdmax_det = 1000 # maximum detections per imagedevice = self.device # cuda device, i.e. 0 or 0,1,2,3 or cpuview_img = False # show resultssave_txt = False # save results to *.txtsave_conf = False # save confidences in --save-txt labelssave_crop = False # save cropped prediction boxesnosave = False # do not save images/videosclasses = None # filter by class: --class 0, or --class 0 2 3agnostic_nms = False # class-agnostic NMSaugment = False # ugmented inferencevisualize = False # visualize featuresline_thickness = 3 # bounding box thickness (pixels)hide_labels = False # hide labelshide_conf = False # hide confidenceshalf = False # use FP16 half-precision inferencednn = False # use OpenCV DNN for ONNX inferenceprint(source)if source == "":QMessageBox.warning(self, "请上传", "请先上传图⽚再进⾏检测")else:source = str(source)device = select_device(self.device)webcam = Falsestride, names, pt, jit, onnx = model.stride, s, model.pt, model.jit, model.onnximgsz = check_img_size(imgsz, s=stride) # check image sizesave_img = not nosave and not source.endswith('.txt') # save inference images# Dataloaderif webcam:view_img = check_imshow()cudnn.benchmark = True # set True to speed up constant image size inferencedataset = LoadStreams(source, img_size=imgsz, stride=stride, auto=pt and not jit)bs = len(dataset) # batch_sizeelse:dataset = LoadImages(source, img_size=imgsz, stride=stride, auto=pt and not jit)bs = 1 # batch_sizevid_path, vid_writer = [None] * bs, [None] * bs# Run inferenceif pt and device.type != 'cpu':model(torch.zeros(1, 3, *imgsz).to(device).type_as(next(model.model.parameters()))) # warmup dt, seen = [0.0, 0.0, 0.0], 0for path, im, im0s, vid_cap, s in dataset:t1 = time_sync()im = torch.from_numpy(im).to(device)im = im.half() if half else im.float() # uint8 to fp16/32im /= 255 # 0 - 255 to 0.0 - 1.0if len(im.shape) == 3:im = im[None] # expand for batch dimt2 = time_sync()dt[0] += t2 - t1# Inference# visualize = increment_path(save_dir / Path(path).stem, mkdir=True) if visualize else Falsepred = model(im, augment=augment, visualize=visualize)t3 = time_sync()dt[1] += t3 - t2# NMSpred = non_max_suppression(pred, conf_thres, iou_thres, classes, agnostic_nms, max_det=max_det)dt[2] += time_sync() - t3# Second-stage classifier (optional)# pred = utils.general.apply_classifier(pred, classifier_model, im, im0s)# Process predictionsfor i, det in enumerate(pred): # per imageseen += 1if webcam: # batch_size >= 1p, im0, frame = path[i], im0s[i].copy(), dataset.counts += f'{i}: 'else:p, im0, frame = path, im0s.copy(), getattr(dataset, 'frame', 0)p = Path(p) # to Paths += '%gx%g ' % im.shape[2:] # print stringgn = torch.tensor(im0.shape)[[1, 0, 1, 0]] # normalization gain whwhimc = im0.copy() if save_crop else im0 # for save_cropannotator = Annotator(im0, line_width=line_thickness, example=str(names))if len(det):# Rescale boxes from img_size to im0 sizedet[:, :4] = scale_coords(im.shape[2:], det[:, :4], im0.shape).round()# Print resultsfor c in det[:, -1].unique():n = (det[:, -1] == c).sum() # detections per classs += f"{n} {names[int(c)]}{'s' * (n > 1)}, " # add to string# Write resultsfor *xyxy, conf, cls in reversed(det):if save_txt: # Write to filexywh = (xyxy2xywh(torch.tensor(xyxy).view(1, 4)) / gn).view(-1).tolist() # normalized xywhline = (cls, *xywh, conf) if save_conf else (cls, *xywh) # label format# with open(txt_path + '.txt', 'a') as f:# f.write(('%g ' * len(line)).rstrip() % line + '\n')if save_img or save_crop or view_img: # Add bbox to imagec = int(cls) # integer classlabel = None if hide_labels else (names[c] if hide_conf else f'{names[c]} {conf:.2f}')annotator.box_label(xyxy, label, color=colors(c, True))# if save_crop:# save_one_box(xyxy, imc, file=save_dir / 'crops' / names[c] / f'{p.stem}.jpg',# BGR=True)# Print time (inference-only)(f'{s}Done. ({t3 - t2:.3f}s)')# Stream resultsim0 = annotator.result()# if view_img:# cv2.imshow(str(p), im0)# cv2.waitKey(1) # 1 millisecond# Save results (image with detections)resize_scale = output_size / im0.shape[0]im0 = cv2.resize(im0, (0, 0), fx=resize_scale, fy=resize_scale)cv2.imwrite("images/tmp/single_result.jpg", im0)# ⽬前的情况来看,应该只是ubuntu下会出问题,但是在windows下是完整的,所以继续self.right_img.setPixmap(QPixmap("images/tmp/single_result.jpg"))# 视频检测,逻辑基本⼀致,有两个功能,分别是检测摄像头的功能和检测视频⽂件的功能,先做检测摄像头的功能。

paddleocr识别写入案例一、PaddleOCR简介PaddleOCR是一个基于PaddlePaddle开发的开源OCR工具,可以实现对各种场景下的文字检测和识别。

它具有高效、准确和可扩展的特点,广泛应用于身份证识别、车牌识别、银行卡识别、表格识别等场景中。

二、文字检测1. 光学文字检测(TextBoxes++):PaddleOCR采用了TextBoxes++模型,结合了文本检测和文本方向分类两个子网络,能够实现对水平和倾斜文本的准确检测。

该模型基于深度学习技术,可以在复杂背景和低分辨率的图像中准确地定位和提取文字区域。

2. 自然场景文字检测(CRAFT):自然场景中的文字检测是OCR中的一个难点,PaddleOCR使用了CRAFT模型,通过像素级别的文本区域生成,能够准确地检测出自然场景中的文字,如街道标志、商品包装等。

3. 多尺度文字检测(EAST):针对不同尺度的文字,PaddleOCR采用了EAST模型,通过多层次的特征融合和分割,能够实现对不同尺寸的文字进行准确的检测和识别。

三、文字识别1. CRNN模型:PaddleOCR使用了CRNN模型,实现了端到端的文字识别。

该模型将图像输入CNN网络进行特征提取,然后通过RNN网络进行序列建模,最后使用CTC算法对序列进行解码,得到最终的文字结果。

CRNN模型能够处理不定长的序列,并且对于不同字体和大小的文字具有良好的适应性。

2. Transformer模型:为了进一步提高文字识别的准确性,PaddleOCR引入了Transformer模型。

Transformer模型通过自注意力机制和位置编码,能够有效地处理长距离依赖关系,并且在大规模数据上训练得到更好的泛化能力。

四、应用案例1. 身份证识别:PaddleOCR可以准确地识别身份证上的文字信息,包括姓名、性别、民族、住址、身份证号码等,并且可以实现对身份证的边框检测和矫正,提高识别的准确性。

基于YOLOV5的行人机动车闯红灯检测

范子一;王宏生;姚钦建

【期刊名称】《长江信息通信》

【年(卷),期】2022(35)3

【摘要】随着中国制造2025战略的实施,人工智能领域相关技术的发展得到爆炸式的关注,其中计算机视觉是研究的热点之一。

目标检测作为计算机视觉领域的热点和难点,其目的是让计算机自动提取目标的行为特征,辨别异常行为,在视频监控、人机交互和医疗监护等诸多领域有着重要的应用价值。

文章叙述了目标检测中基于YOLO V5+Deep Sort的数据训练和识别行人和车辆闯红灯的研究方法,对行人和车辆的目标跟踪以及闯红灯检测的效果良好,端到端的方法切实有效,并给出测试结果。

【总页数】3页(P51-53)

【作者】范子一;王宏生;姚钦建

【作者单位】沈阳工业大学信息科学与工程学院;沈阳工业大学机械工程学院【正文语种】中文

【中图分类】TP391.41

【相关文献】

1.保定市行人及非机动车闯红灯现象调查

2.基于视频的行人闯红灯检测方法

3.基于视频分析的行人闯红灯违法行为检测系统

4.基于yolov5s的行人检测系统及实现

5.基于YOLOv5的行人检测方法研究

因版权原因,仅展示原文概要,查看原文内容请购买。