hadoop基本操作指令

- 格式:docx

- 大小:24.31 KB

- 文档页数:10

hadoop命令及使用方法Hadoop是一个分布式计算框架,用于存储和处理大规模数据集。

下面是一些常用的Hadoop命令及其使用方法:1. hdfs命令:- hdfs dfs -ls <路径>:列出指定路径下的文件和目录。

- hdfs dfs -mkdir <路径>:创建一个新的目录。

- hdfs dfs -copyFromLocal <本地路径> <HDFS路径>:将本地文件复制到HDFS 上。

- hdfs dfs -copyToLocal <HDFS路径> <本地路径>:将HDFS上的文件复制到本地。

- hdfs dfs -cat <文件路径>:显示HDFS上的文件内容。

2. mapred命令:- mapred job -list:列出当前正在运行的MapReduce作业。

- mapred job -kill <job_id>:终止指定的MapReduce作业。

3. yarn命令:- yarn application -list:列出当前正在运行的应用程序。

- yarn application -kill <application_id>:终止指定的应用程序。

4. hadoop fs命令(与hdfs dfs命令功能相似):- hadoop fs -ls <路径>:列出指定路径下的文件和目录。

- hadoop fs -cat <文件路径>:显示HDFS上的文件内容。

- hadoop fs -mkdir <路径>:创建一个新的目录。

- hadoop fs -put <本地文件路径> <HDFS路径>:将本地文件复制到HDFS上。

- hadoop fs -get <HDFS路径> <本地文件路径>:将HDFS上的文件复制到本地。

hdfs操作方法Hadoop Distributed File System (HDFS)是Hadoop框架中的一部分,它是一个可伸缩、可靠的分布式文件系统。

HDFS设计用于处理大数据集,提供了高吞吐量的数据访问以及数据冗余和容错功能。

以下是HDFS的一些常见操作方法。

1.文件系统操作:- 创建目录:使用hadoop fs -mkdir命令来创建一个新的目录。

例如,hadoop fs -mkdir /user/mydirectory。

- 上传文件:使用hadoop fs -put命令将本地文件上传到HDFS中。

例如,hadoop fs -put myfile.txt /user/mydirectory。

- 列出文件/目录:使用hadoop fs -ls命令列出HDFS中的文件和目录。

例如,hadoop fs -ls /user/mydirectory。

- 删除文件/目录:使用hadoop fs -rm命令删除HDFS中的文件或目录。

例如,hadoop fs -rm /user/mydirectory/myfile.txt。

2.文件操作:- 读取文件:使用hadoop fs -cat命令来读取HDFS中的文件内容。

例如,hadoop fs -cat /user/mydirectory/myfile.txt。

- 复制文件:使用hadoop fs -cp命令在HDFS中复制文件。

例如,hadoop fs -cp /user/mydirectory/myfile.txt/user/newdirectory/myfile.txt。

- 移动文件:使用hadoop fs -mv命令将文件从一个目录移动到另一个目录。

例如,hadoop fs -mv /user/mydirectory/myfile.txt/user/newdirectory/myfile.txt。

- 修改文件名:使用hadoop fs -mv命令将文件改名。

hadoop学习笔记(⼗):hdfs在命令⾏的基本操作命令(包括⽂件的上传和下载和

hdfs。

hdfs命令⾏

(1)查看帮助

hdfs dfs -help

(2)查看当前⽬录信息

hdfs dfs -ls /

(3)上传⽂件

hdfs dfs -put /本地路径 /hdfs路径

(4)剪切⽂件

hdfs dfs -moveFromLocal a.txt /aa.txt

(5)下载⽂件到本地

hdfs dfs -get /hdfs路径 /本地路径

(6)合并下载

hdfs dfs -getmerge /hdfs路径⽂件夹 /合并后的⽂件

(7)创建⽂件夹

hdfs dfs -mkdir /hello

(8)创建多级⽂件夹

hdfs dfs -mkdir -p /hello/world

(9)移动hdfs⽂件

hdfs dfs -mv /hdfs路径 /hdfs路径

(10)复制hdfs⽂件

hdfs dfs -cp /hdfs路径 /hdfs路径

(11)删除hdfs⽂件

hdfs dfs -rm /aa.txt

(12)删除hdfs⽂件夹

hdfs dfs -rm -r /hello

(13)查看hdfs中的⽂件

hdfs dfs -cat /⽂件

hdfs dfs -tail -f /⽂件

(14)查看⽂件夹中有多少个⽂件

hdfs dfs -count /⽂件夹

(15)查看hdfs的总空间

hdfs dfs -df /

hdfs dfs -df -h /

(16)修改副本数

hdfs dfs -setrep 1 /a.txt。

HDFS基本操作HDFS(Hadoop Distributed File System)是Hadoop生态系统中的一个关键组件,用于在大规模集群上存储和处理大数据集。

HDFS采用分布式文件存储的方式,将大文件切分成多个块,并分散存储在多个计算节点上,从而实现高容错性和高吞吐量的数据存储。

在使用HDFS进行文件操作时,可以通过命令行工具或者API进行操作。

下面是HDFS的一些基本操作:1. 查看文件系统状态:使用"hdfs dfsadmin -report"命令可以查看HDFS的整体状态,包括存储容量、副本数量、节点状态等。

2. 创建目录:使用"hdfs dfs -mkdir"命令可以在HDFS中创建新目录。

例如,可以使用"hdfs dfs -mkdir /data"命令创建一个名为"data"的目录。

3. 上传文件:使用"hdfs dfs -put"命令可以将本地文件上传到HDFS中。

例如,可以使用"hdfs dfs -put local_file hdfs_path"命令将名为"local_file"的本地文件上传到"HDFS_path"路径下。

5. 复制文件:使用"hdfs dfs -cp"命令可以复制HDFS中的文件。

例如,可以使用"hdfs dfs -cp source_file target_file"命令将"source_file"文件复制到"target_file"。

6. 移动文件:使用"hdfs dfs -mv"命令可以移动HDFS中的文件。

例如,可以使用"hdfs dfs -mv source_file target_file"命令将"source_file"文件移动到"target_file"。

hdfs基本操作HDFS(Hadoop Distributed File System)是Apache Hadoop生态系统中的分布式文件系统,用于存储和处理大规模数据集。

下面是HDFS的一些基本操作:1. 文件和目录操作:- 创建目录:`hadoop fs -mkdir <目录路径>`- 查看目录内容:`hadoop fs -ls <目录路径>`- 创建空文件:`hadoop fs -touchz <文件路径>` - 复制文件或目录到HDFS:`hadoop fs -put <本地路径> <HDFS路径>`- 复制文件或目录到本地:`hadoop fs -get <HDFS 路径> <本地路径>`- 删除文件或目录:`hadoop fs -rm [-r] <文件或目录路径>`2. 文件操作:- 查看文件内容:`hadoop fs -cat <文件路径>` - 移动文件:`hadoop fs -mv <源文件路径> <目标文件路径>`- 修改文件副本数:`hadoop fs -setrep [-R] <副本数> <文件路径>`- 修改文件权限:`hadoop fs -chmod [-R] <权限> <文件路径>`- 修改文件所有者:`hadoop fs -chown [-R] <所有者> <文件路径>`3. 文件系统操作:- 格式化文件系统:`hadoop namenode -format`- 查看文件系统状态:`hadoop fs -df [-h]`- 查看文件系统的块信息:`hadoop fsck <文件系统路径>`4. 权限和用户操作:- 查看文件或目录权限和所有者:`hadoop fs -ls -R <文件或目录路径>`- 修改文件或目录权限和所有者:`hadoop fs -chown [-R] <所有者> <文件或目录路径>`- 修改文件或目录权限:`hadoop fs -chmod [-R] <权限> <文件或目录路径>`这些是HDFS的一些基本操作,可以通过命令行工具(如hadoop fs)或Hadoop提供的API进行操作。

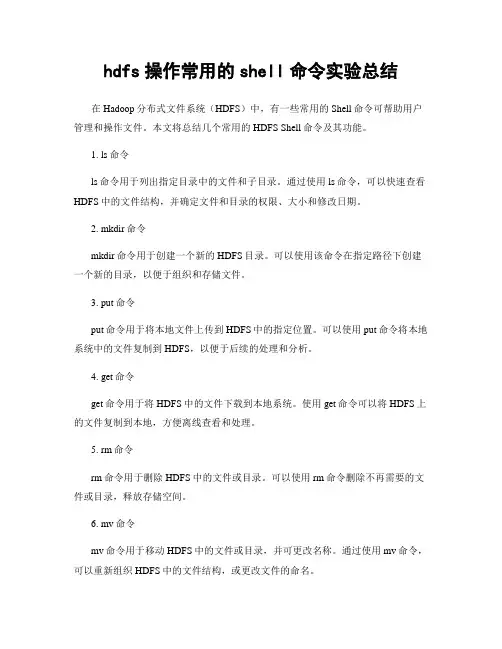

hdfs操作常用的shell命令实验总结在Hadoop分布式文件系统(HDFS)中,有一些常用的Shell命令可帮助用户管理和操作文件。

本文将总结几个常用的HDFS Shell命令及其功能。

1. ls命令ls命令用于列出指定目录中的文件和子目录。

通过使用ls命令,可以快速查看HDFS中的文件结构,并确定文件和目录的权限、大小和修改日期。

2. mkdir命令mkdir命令用于创建一个新的HDFS目录。

可以使用该命令在指定路径下创建一个新的目录,以便于组织和存储文件。

3. put命令put命令用于将本地文件上传到HDFS中的指定位置。

可以使用put命令将本地系统中的文件复制到HDFS,以便于后续的处理和分析。

4. get命令get命令用于将HDFS中的文件下载到本地系统。

使用get命令可以将HDFS上的文件复制到本地,方便离线查看和处理。

5. rm命令rm命令用于删除HDFS中的文件或目录。

可以使用rm命令删除不再需要的文件或目录,释放存储空间。

6. mv命令mv命令用于移动HDFS中的文件或目录,并可更改名称。

通过使用mv命令,可以重新组织HDFS中的文件结构,或更改文件的命名。

7. cat命令cat命令用于打印HDFS中文件的内容到标准输出。

可以使用cat命令快速查看文件的内容,对文件进行简单的检查。

8. chmod命令chmod命令用于更改HDFS中文件或目录的权限。

通过使用chmod命令,可以为文件或目录设置适当的权限,以确保数据的安全性和可访问性。

总之,以上提到的命令是HDFS操作中常用的一些Shell命令。

它们能够帮助用户管理和操作HDFS中的文件和目录,方便数据的存储、上传、下载、删除、移动和查看。

这些命令是Hadoop生态系统中不可或缺的一部分,对于大规模数据处理和分析具有重要的作用。

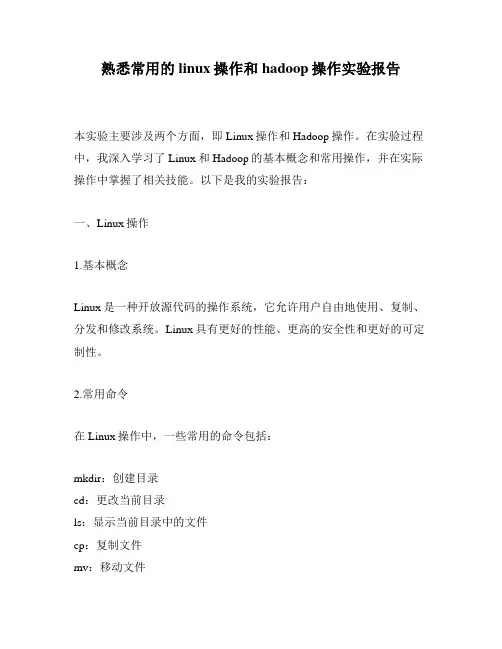

熟悉常用的linux操作和hadoop操作实验报告本实验主要涉及两个方面,即Linux操作和Hadoop操作。

在实验过程中,我深入学习了Linux和Hadoop的基本概念和常用操作,并在实际操作中掌握了相关技能。

以下是我的实验报告:一、Linux操作1.基本概念Linux是一种开放源代码的操作系统,它允许用户自由地使用、复制、分发和修改系统。

Linux具有更好的性能、更高的安全性和更好的可定制性。

2.常用命令在Linux操作中,一些常用的命令包括:mkdir:创建目录cd:更改当前目录ls:显示当前目录中的文件cp:复制文件mv:移动文件rm:删除文件pwd:显示当前所在目录chmod:更改文件权限chown:更改文件所有者3.实验操作在实验中,我对Linux的文件系统、文件权限、用户与组等进行了学习和操作。

另外,我还使用Linux命令实现了目录创建、文件复制、删除等操作。

二、Hadoop操作1.基本概念Hadoop是一种开源框架,用于处理大规模数据和分布式计算。

它使用Hadoop分布式文件系统(HDFS)来存储数据,使用MapReduce来处理大规模数据集。

2.常用命令在Hadoop操作中,一些常用的命令包括:hdfs dfs:操作HDFS文件系统hadoop fs:操作Hadoop分布式文件系统hadoop jar:运行Hadoop任务hadoop namenode -format:格式化文件系统start-all.sh:启动所有Hadoop服务3.实验操作在实验中,我熟悉了Hadoop的安装过程、配置过程和基本概念。

我使用Hadoop的命令对文件系统进行操作,如创建、删除、移动文件等。

此外,我还学会了使用MapReduce处理大规模数据集。

总结通过本次实验,我巩固了Linux和Hadoop操作的基本知识和技能。

我深入了解了Linux和Hadoop的基本概念和常用操作,并学会了使用相关命令进行实际操作。

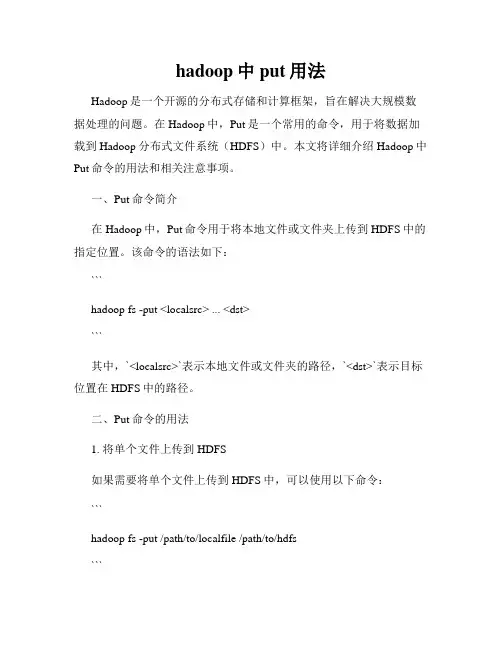

hadoop中put用法Hadoop是一个开源的分布式存储和计算框架,旨在解决大规模数据处理的问题。

在Hadoop中,Put是一个常用的命令,用于将数据加载到Hadoop分布式文件系统(HDFS)中。

本文将详细介绍Hadoop中Put命令的用法和相关注意事项。

一、Put命令简介在Hadoop中,Put命令用于将本地文件或文件夹上传到HDFS中的指定位置。

该命令的语法如下:```hadoop fs -put <localsrc> ... <dst>```其中,`<localsrc>`表示本地文件或文件夹的路径,`<dst>`表示目标位置在HDFS中的路径。

二、Put命令的用法1. 将单个文件上传到HDFS如果需要将单个文件上传到HDFS中,可以使用以下命令:```hadoop fs -put /path/to/localfile /path/to/hdfs```其中,`/path/to/localfile`是本地文件的路径,`/path/to/hdfs`是HDFS 中目标位置的路径。

例如,要将本地的文件`/home/user/data.txt`上传到HDFS中的`/user/hadoop`目录下,可以使用以下命令:```hadoop fs -put /home/user/data.txt /user/hadoop```2. 将文件夹上传到HDFS如果需要将整个文件夹上传到HDFS中,可以使用以下命令:```hadoop fs -put /path/to/localdir /path/to/hdfs```其中,`/path/to/localdir`是本地文件夹的路径,`/path/to/hdfs`是HDFS中目标位置的路径。

例如,要将本地的文件夹`/home/user/data`上传到HDFS中的`/user/hadoop`目录下,可以使用以下命令:```hadoop fs -put /home/user/data /user/hadoop```该命令将递归地将整个`/home/user/data`文件夹上传到HDFS中,并保持相同的目录结构。

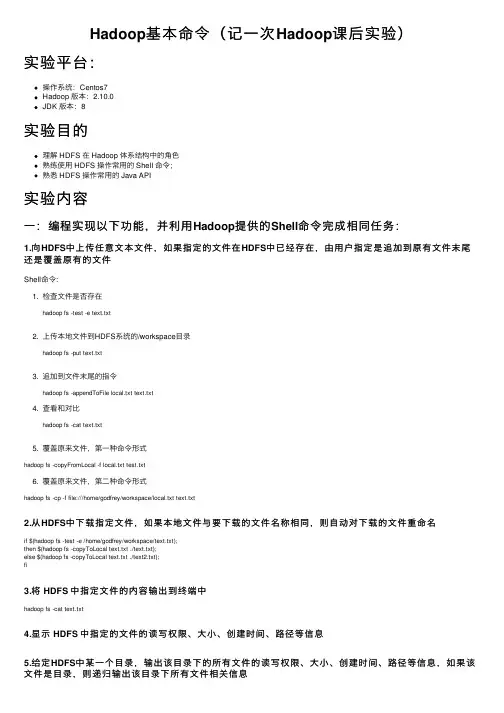

Hadoop基本命令(记⼀次Hadoop课后实验)实验平台:操作系统:Centos7Hadoop 版本:2.10.0JDK 版本:8实验⽬的理解 HDFS 在 Hadoop 体系结构中的⾓⾊熟练使⽤ HDFS 操作常⽤的 Shell 命令;熟悉 HDFS 操作常⽤的 Java API实验内容⼀:编程实现以下功能,并利⽤Hadoop提供的Shell命令完成相同任务:1.向HDFS中上传任意⽂本⽂件,如果指定的⽂件在HDFS中已经存在,由⽤户指定是追加到原有⽂件末尾还是覆盖原有的⽂件Shell命令:1. 检查⽂件是否存在hadoop fs -test -e text.txt2. 上传本地⽂件到HDFS系统的/workspace⽬录hadoop fs -put text.txt3. 追加到⽂件末尾的指令hadoop fs -appendToFile local.txt text.txt4. 查看和对⽐hadoop fs -cat text.txt5. 覆盖原来⽂件,第⼀种命令形式hadoop fs -copyFromLocal -f local.txt test.txt6. 覆盖原来⽂件,第⼆种命令形式hadoop fs -cp -f file:///home/godfrey/workspace/local.txt text.txt2.从HDFS中下载指定⽂件,如果本地⽂件与要下载的⽂件名称相同,则⾃动对下载的⽂件重命名if $(hadoop fs -test -e /home/godfrey/workspace/text.txt);then $(hadoop fs -copyToLocal text.txt ./text.txt);else $(hadoop fs -copyToLocal text.txt ./text2.txt);fi3.将 HDFS 中指定⽂件的内容输出到终端中hadoop fs -cat text.txt4.显⽰ HDFS 中指定的⽂件的读写权限、⼤⼩、创建时间、路径等信息5.给定HDFS中某⼀个⽬录,输出该⽬录下的所有⽂件的读写权限、⼤⼩、创建时间、路径等信息,如果该⽂件是⽬录,则递归输出该⽬录下所有⽂件相关信息hadoop fs -ls -R -h /6.提供⼀个HDFS内的⽂件的路径,对该⽂件进⾏创建和删除操作。

hadoop的基本操作命令Hadoop是目前最流行的分布式计算框架之一,其强大的数据处理能力和可扩展性使其成为企业级应用的首选。

在使用Hadoop时,熟悉一些基本操作命令是必不可少的。

以下是Hadoop的基本操作命令:1. 文件系统命令Hadoop的文件系统命令与Linux系统类似,可以用于管理Hadoop的文件系统。

以下是一些常用的文件系统命令:- hdfs dfs -ls:列出文件系统中的文件和目录。

- hdfs dfs -mkdir:创建一个新目录。

- hdfs dfs -put:将本地文件上传到Hadoop文件系统中。

- hdfs dfs -get:将Hadoop文件系统中的文件下载到本地。

- hdfs dfs -rm:删除文件系统中的文件或目录。

- hdfs dfs -du:显示文件或目录的大小。

- hdfs dfs -chmod:更改文件或目录的权限。

2. MapReduce命令MapReduce是Hadoop的核心计算框架,用于处理大规模数据集。

以下是一些常用的MapReduce命令:- hadoop jar:运行MapReduce作业。

- hadoop job -list:列出所有正在运行的作业。

- hadoop job -kill:终止正在运行的作业。

- hadoop fs -copyFromLocal:将本地文件复制到Hadoop文件系统中。

- hadoop fs -copyToLocal:将Hadoop文件系统中的文件复制到本地。

- hadoop fs -rmr:删除指定目录及其所有子目录和文件。

3. YARN命令YARN是Hadoop的资源管理器,用于管理Hadoop集群中的资源。

以下是一些常用的YARN命令:- yarn node -list:列出所有节点的状态。

- yarn application -list:列出所有正在运行的应用程序。

- yarn application -kill:终止正在运行的应用程序。

hdfs基础命令HDFS基础命令Hadoop分布式文件系统(HDFS)是Apache Hadoop的核心组件之一,用于存储和管理大数据集。

HDFS提供了一组命令行工具,用于与文件系统进行交互和管理。

本文将介绍HDFS的基础命令,帮助用户熟悉和使用HDFS。

1. hdfs dfs -ls命令:该命令用于列出HDFS中指定目录下的文件和子目录。

例如,要列出根目录下的所有文件和目录,可以使用以下命令:```hdfs dfs -ls /```该命令将输出根目录下的所有文件和目录的详细信息,如文件大小、权限、所有者和修改时间等。

2. hdfs dfs -mkdir命令:该命令用于在HDFS中创建新目录。

例如,要在根目录下创建一个名为"test"的新目录,可以使用以下命令:```hdfs dfs -mkdir /test```该命令将创建一个名为"test"的新目录。

3. hdfs dfs -put命令:该命令用于将本地文件复制到HDFS中。

例如,要将本地文件"localfile.txt"复制到HDFS的"/test"目录中,可以使用以下命令:```hdfs dfs -put localfile.txt /test```该命令将本地文件"localfile.txt"复制到HDFS的"/test"目录中。

4. hdfs dfs -get命令:该命令用于将HDFS中的文件复制到本地文件系统中。

例如,要将HDFS中的文件"/test/hdfsfile.txt"复制到本地目录"/local"中,可以使用以下命令:```hdfs dfs -get /test/hdfsfile.txt /local```该命令将HDFS中的文件"/test/hdfsfile.txt"复制到本地目录"/local"中。

cdh集群常用命令以下是CDH集群中常用的命令:1. hdfs dfs -ls: 列出HDFS文件系统中的文件和目录。

2. hdfs dfs -mkdir: 在HDFS中创建新目录。

3. hdfs dfs -put: 将文件从本地文件系统上传到HDFS。

4. hdfs dfs -get: 将文件从HDFS下载到本地文件系统。

5. hdfs dfs -rm: 从HDFS中删除文件或目录。

6. hdfs dfs -chown: 更改文件或目录的所有者。

7. hdfs dfs -chmod: 更改文件或目录的权限。

8. hdfs dfs -cat: 查看文件的内容。

9. hdfs dfs -tail: 查看文件的末尾内容。

10. hdfs dfs -du: 估算文件或目录的大小。

11. hdfs dfs -mv: 移动文件或目录。

12. hdfs dfsadmin -report: 获取HDFS的报告,包括集群的容量、使用情况等信息。

13. yarn node -list: 列出YARN集群中的节点。

14. yarn application -list: 列出YARN集群中正在运行的应用程序。

15. yarn application -kill: 终止指定的YARN应用程序。

16. hadoop fsck: 检查HDFS中的文件完整性和一致性。

17. hadoop job -list: 列出运行中的Hadoop作业。

18. hadoop job -kill: 终止指定的Hadoop作业。

这些是CDH集群中常用的命令,可以帮助您管理和操作HDFS和YARN。

根据您的需求,可以使用这些命令进行文件操作、权限管理、作业管理等任务。

实验4HDFS常用操作Hadoop分布式文件系统(HDFS)是一个高度可靠、可扩展的分布式文件系统,为Hadoop集群提供了存储和处理大量数据的能力。

在Hadoop中,用户可以使用各种HDFS常用操作来管理和操作存储在HDFS上的数据。

本文将介绍HDFS中的一些常用操作方法。

1. 上传文件:使用命令`hadoop fs -put <local_file_path><hdfs_path>`将本地文件上传到HDFS。

例如,`hadoop fs -put/home/user/file.txt /user/hadoop/`将本地文件`file.txt`上传到HDFS的`/user/hadoop/`目录下。

3. 创建目录:使用命令`hadoop fs -mkdir <hdfs_path>`在HDFS上创建目录。

例如,`hadoop fs -mkdir /user/hadoop/data`将在HDFS的根目录下创建一个名为`data`的目录。

4. 删除文件或目录:使用命令`hadoop fs -rmr <hdfs_path>`删除HDFS上的文件或目录。

例如,`hadoop fs -rmr/user/hadoop/file.txt`将删除HDFS上的`/user/hadoop/file.txt`文件。

5. 列出目录内容:使用命令`hadoop fs -ls <hdfs_path>`列出指定目录下的文件和子目录。

例如,`hadoop fs -ls /user/hadoop/`将列出`/user/hadoop/`目录下的文件和子目录。

6. 查看文件内容:使用命令`hadoop fs -cat <hdfs_path>`将HDFS上的文件内容输出到控制台。

例如,`hadoop fs -cat/user/hadoop/file.txt`将显示`/user/hadoop/file.txt`文件的内容。

hadoop的count -v用法Hadoop是一个分布式计算框架,用于高效地处理大规模数据。

其中,count命令是Hadoop中最基本的命令之一,可以用于计算文件或者目录中所有行的数量。

它的-v选项可以帮助用户更详细地了解计数的结果。

count命令的基本语法如下:hadoop fs -count [-q] [-h] [-v] [-t] [-u] <paths>其中,<paths>是需要计数的文件或者目录的路径。

当使用-v选项时,count命令会显示更详细的计数信息。

以下为-v选项的使用方法及其相关参数:1. -v - 显示详细计数信息使用-v选项时,count命令会显示文件或目录中的每个子目录和文件的计数信息,包括文件大小、块数和副本数。

示例:/user/hadoop/data 183 39276 10240/user/hadoop/data/dir1 5 20 2/user/hadoop/data/dir2 10 40 2/user/hadoop/data/file1 1 10 2/user/hadoop/data/file2 2 30 2/user/hadoop/data/file3 4 20 2上述命令计算了/user/hadoop/data目录下的所有文件和子目录的计数信息,并使用了-v选项来显示详细信息。

其中,183表示所有文件和子目录的数量(包括目录本身),39276表示所有文件和子目录的总大小,10240表示块大小(单位是字节)。

183 39276 10240使用-u选项时,count命令会将文件大小和总大小以字节为单位来显示。

使用-q选项时,count命令不显示任何详细信息,仅输出文件或目录中的总数量信息。

183其中,183表示所有文件和子目录的数量(包括目录本身)。

综上所述,count命令的-v选项可以帮助用户更详细地了解计数的结果,同时,它还提供了其他选项,如-t、-u、-q和-h等,可以满足用户不同的需求。

Hadoop命令大全本节比较全面的向大家介绍一下Hadoop命令,欢迎大家一起来学习,希望通过本节的介绍大家能够掌握一些常见Hadoop命令的使用方法。

下面是Hadoop命令的详细介绍。

Hadoop命令大全1、列出所有HadoopShell支持的命令$bin/hadoopfs-help2、显示关于某个命令的详细信息$bin/hadoopfs-helpcommand-name3、用户可使用以下命令在指定路径下查看历史日志汇总$bin/hadoopjob-historyoutput-dir这条命令会显示作业的细节信息,失败和终止的任务细节。

4、关于作业的更多细节,比如成功的任务,以及对每个任务的所做的尝试次数等可以用下面的命令查看$bin/hadoopjob-historyalloutput-dir5、格式化一个新的分布式文件系统:$bin/hadoopnamenode-format6、在分配的NameNode上,运行下面的Hadoop命令启动HDFS:$bin/start-dfs.shbin/start-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上启动DataNode守护进程。

7、在分配的JobTracker上,运行下面的命令启动Map/Reduce:$bin/start-mapred.shbin/start-mapred.sh脚本会参照JobTracker上${HADOOP_CONF_DIR}/sla ves文件的内容,在所有列出的slave上启动TaskTracker守护进程。

8、在分配的NameNode上,执行下面的Hadoop命令停止HDFS:$bin/stop-dfs.shbin/stop-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上停止DataNode守护进程。

hdfs的文件操作命令以及mapreduce程序设计Hadoop分布式文件系统(HDFS)是Hadoop框架的一部分,用于存储和处理大规模数据集。

以下是HDFS的一些常见文件操作命令:1. 查看文件和目录:- `hadoop fs -ls <path>`:列出指定路径下的文件和目录。

- `hadoop fs -du <path>`:查看指定路径下的文件和目录的大小。

2. 创建和删除目录:- `hadoop fs -mkdir <path>`:创建一个新目录。

- `hadoop fs -rmr <path>`:递归删除指定路径下的所有文件和目录。

3. 文件复制和移动:- `hadoop fs -cp <src> <dest>`:将源路径中的文件复制到目标路径。

- `hadoop fs -mv <src> <dest>`:将源路径中的文件移动到目标路径。

4. 文件上传和下载:- `hadoop fs -put <localSrc> <dest>`:将本地文件上传到HDFS中的指定路径。

- `hadoop fs -get <src> <localDest>`:将HDFS中的文件下载到本地目录。

5. 查看文件内容:- `hadoop fs -cat <path>`:显示指定路径下文件的内容。

- `hadoop fs -tail <path>`:显示指定文件的最后几行内容。

上述命令可以在命令行中使用。

此外,Hadoop还提供了Java 编程接口(API)和命令行工具(如`hadoop jar`)来编写和运行MapReduce程序。

以下是使用Java编写的简单MapReduce程序的示例:```javaimport org.apache.hadoop.fs.Path;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Job;import org.apache.hadoop.mapreduce.Mapper;import org.apache.hadoop.mapreduce.Reducer;import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; import java.io.IOException;public class WordCount {public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {private final IntWritable one = new IntWritable(1);private Text word = new Text();public void map(Object key, Text value, Context context) throws IOException, InterruptedException {String[] words = value.toString().split(" ");for (String w : words) {word.set(w);context.write(word, one);}}}public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {private IntWritable result = new IntWritable();public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException { int sum = 0;for (IntWritable val : values) {sum += val.get();}result.set(sum);context.write(key, result);}}public static void main(String[] args) throws Exception {Job job = Job.getInstance();job.setJarByClass(WordCount.class);job.setMapperClass(TokenizerMapper.class);job.setCombinerClass(IntSumReducer.class);job.setReducerClass(IntSumReducer.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);FileInputFormat.addInputPath(job, new Path(args[0]));FileOutputFormat.setOutputPath(job, new Path(args[1]));System.exit(job.waitForCompletion(true) ? 0 : 1);}}```该示例是一个简单的词频统计程序。

hdaoop hdfs平衡指令

Hadoop提供了两个主要的数据平衡命令:hdfs balancer和hdfs mover。

其中,hdfs balancer命令用于平衡整个Hadoop文件系统的数据,它会通过移动数据块来调整不平衡的数据分布。

具体操作步骤如下:

1. 打开终端或命令行界面,并登录到Hadoop集群的主节点。

2. 运行以下命令来启动HDFS平衡指令:hdfs balancer。

3. 可以通过添加适当的选项来自定义平衡操作的行为。

例如,可以使用-threshold <threshold>选项来设置平衡操作的阈值。

阈值是一个介于0和1之间的小数,表示节点的存储空间利用率达到多少时触发平衡操作。

默认阈值为1.0,即当节点的存储空间利用率超过100%时触发平衡操作。

Hadoop基本操作指令假设Hadoop的安装目录HADOOP_HOME为/home/admin/hadoop,默认认为Hadoop环境已经由运维人员配置好直接可以使用启动与关闭启动Hadoop1. 进入HADOOP_HOME目录。

2. 执行sh bin/start-all.sh关闭Hadoop1. 进入HADOOP_HOME目录。

2. 执行sh bin/stop-all.sh文件操作Hadoop使用的是HDFS,能够实现的功能和我们使用的磁盘系统类似。

并且支持通配符,如*。

查看文件列表查看hdfs中/user/admin/aaron目录下的文件。

1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop fs -ls /user/admin/aaron这样,我们就找到了hdfs中/user/admin/aaron目录下的文件了。

我们也可以列出hdfs中/user/admin/aaron目录下的所有文件(包括子目录下的文件)。

1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop fs -lsr /user/admin/aaron创建文件目录查看hdfs中/user/admin/aaron目录下再新建一个叫做newDir的新目录。

1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop fs -mkdir /user/admin/aaron/newDir删除文件删除hdfs中/user/admin/aaron目录下一个名叫needDelete的文件1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop fs -rm /user/admin/aaron/needDelete删除hdfs中/user/admin/aaron目录以及该目录下的所有文件1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop fs -rmr /user/admin/aaron上传文件上传一个本机/home/admin/newFile的文件到hdfs中/user/admin/aaron目录下1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop fs –put /home/admin/newFile /user/admin/aaron/下载文件下载hdfs中/user/admin/aaron目录下的newFile文件到本机/home/admin/newFile 中1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop fs –get /user/admin/aaron/newFile/home/admin/newFile查看文件我们可以直接在hdfs中直接查看文件,功能与类是cat类似查看hdfs中/user/admin/aaron目录下的newFile文件1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop fs –cat /home/admin/newFileMapReduce Job操作提交MapReduce Job原则上说,Hadoop所有的MapReduce Job都是一个jar包。

运行一个/home/admin/hadoop/job.jar的MapReduce Job1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop jar /home/admin/hadoop/job.jar [jobMainClass] [jobArgs]杀死某个正在运行的Job假设Job_Id为:job_201005310937_00531. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop job -kill job_201005310937_0053更多Hadoop的命令上面介绍的这些Hadoop的操作命令是我们最常用的。

如果你希望了解更多,可以按照如下的方式获取命令的说明信息。

1. 进入HADOOP_HOME目录。

2. 执行sh bin/hadoop我们可以看到更多命令的说明信息:Usage: hadoop [--config confdir] COMMANDwhere COMMAND is one of:namenode -format format the DFS filesystemsecondarynamenode run the DFS secondary namenodenamenode run the DFS namenodedatanode run a DFS datanodedfsadmin run a DFS admin clientfsck run a DFS filesystem checking utilityfs run a generic filesystem user clientbalancer run a cluster balancing utilityjobtracker run the MapReduce job Tracker nodepipes run a Pipes jobtasktracker run a MapReduce task Tracker nodejob manipulate MapReduce jobsqueue get information regarding JobQueuesversion print the versionjar <jar> run a jar filedistcp <srcurl> <desturl> copy file or directories recursivelyarchive -archiveName NAME <src>* <dest> create a hadoop archive daemonlog get/set the log level for each daemonorCLASSNAME run the class named CLASSNAMEMost commands print help when invoked w/o parameters.Hadoop命令大全1、列出所有Hadoop Shell支持的命令$ bin/hadoop fs -help2、显示关于某个命令的详细信息$ bin/hadoop fs -help command-name3、用户可使用以下命令在指定路径下查看历史日志汇总$ bin/hadoop job -history output-dir这条命令会显示作业的细节信息,失败和终止的任务细节。

4、关于作业的更多细节,比如成功的任务,以及对每个任务的所做的尝试次数等可以用下面的命令查看$ bin/hadoop job -history all output-dir5、格式化一个新的分布式文件系统:$ bin/hadoop namenode -format6、在分配的NameNode上,运行下面的命令启动HDFS:$ bin/start-dfs.shbin/start-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上启动DataNode守护进程。

7、在分配的JobTracker上,运行下面的命令启动Map/Reduce:$ bin/start-mapred.shbin/start-mapred.sh脚本会参照JobTracker上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上启动TaskTracker守护进程。

8、在分配的NameNode上,执行下面的命令停止HDFS:$ bin/stop-dfs.shbin/stop-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上停止DataNode守护进程。

9、在分配的JobTracker上,运行下面的命令停止Map/Reduce:$ bin/stop-mapred.shbin/stop-mapred.sh脚本会参照JobTracker上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上停止TaskTracker守护进程。

DFSShell10、创建一个名为/foodir 的目录$ bin/hadoop dfs -mkdir /foodir11、创建一个名为/foodir 的目录$ bin/hadoop dfs -mkdir /foodir12、查看名为/foodir/myfile.txt 的文件内容$ bin/hadoop dfs -cat /foodir/myfile.txtDFSAdmin13、将集群置于安全模式$ bin/hadoop dfsadmin -safemode enter14、显示Datanode列表$ bin/hadoop dfsadmin -report15、使Datanode节点datanodename退役$ bin/hadoop dfsadmin -decommission datanodename16、bin/hadoop dfsadmin -help 命令能列出所有当前支持的命令。

比如:* -report:报告HDFS的基本统计信息。

有些信息也可以在NameNode Web 服务首页看到。

* -safemode:虽然通常并不需要,但是管理员的确可以手动让NameNode 进入或离开安全模式。

* -finalizeUpgrade:删除上一次升级时制作的集群备份。

17、显式地将HDFS置于安全模式$ bin/hadoop dfsadmin -safemode18、在升级之前,管理员需要用(升级终结操作)命令删除存在的备份文件$ bin/hadoop dfsadmin -finalizeUpgrade19、能够知道是否需要对一个集群执行升级终结操作。

$ dfsadmin -upgradeProgress status20、使用-upgrade选项运行新的版本$ bin/start-dfs.sh -upgrade21、如果需要退回到老版本,就必须停止集群并且部署老版本的Hadoop,用回滚选项启动集群$ bin/start-dfs.h -rollback22、下面的新命令或新选项是用于支持配额的。

前两个是管理员命令。

* dfsadmin -setquota <N> <directory>...<directory>把每个目录配额设为N。