无约束优化方法(最速下降法-牛顿法)

- 格式:doc

- 大小:234.80 KB

- 文档页数:12

第四章

第四章

无约束优化问题标准形式:

无约束优化问题标准形式:

§

§

§

§

§

§

图最速下降法的收敛过程

αα

2

2

例4-1 求目标函数

取初始点

[2,2]

=

x

例4-2 求目标函数解取初始点[2,2]

=x

算出一维搜索最佳步长

§

例4-3 用梯度法求下面无约束优化问题:

例4-3 用梯度法求下面无约束优化问题:

例4-3 用梯度法求下面无约束优化问题:

例4-3 用梯度法求下面无约束优化问题:

例4-3 用梯度法求下面无约束优化问题:

梯度法的特点

x

给定0,ε

一般迭代式:

§4.3

§4.3

§4.3

§4.3

α0

d 0

x

x 1

x*

1

α1d 1

1()

f −∇x d 1

4-4 共轭方向法

假设目标函数f (x ) 在极值点附近的二次近似函数为

沿某个下降方向

如果能够选定这样的搜索方向,那么对于二

α

0d0

x0x1x*

1

α

1

d1

1

()

f

−∇x d

1。

Matlab中的最优化问题求解方法近年来,最优化问题在各个领域中都扮演着重要的角色。

无论是在工程、经济学还是科学研究中,我们都需要找到最优解来满足特定的需求。

而Matlab作为一种强大的数值计算软件,在解决最优化问题方面有着广泛的应用。

本文将介绍一些Matlab中常用的最优化问题求解方法,并探讨其优缺点以及适用范围。

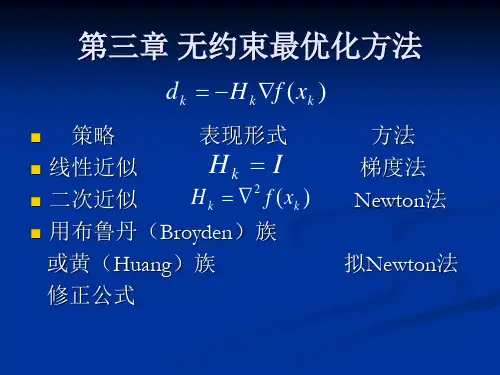

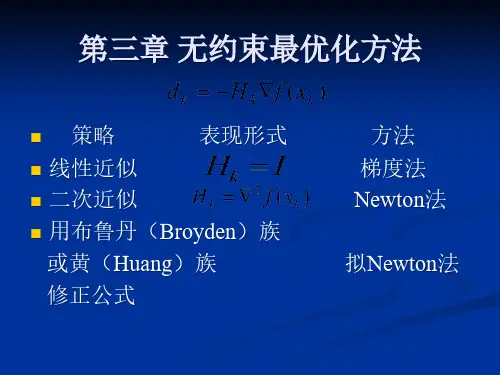

一. 无约束问题求解方法1. 最速下降法最速下降法是最简单且直观的无约束问题求解方法之一。

其基本思想是沿着梯度的反方向迭代求解,直到达到所需的精度要求。

然而,最速下降法的收敛速度通常很慢,特别是在局部极小值点附近。

2. 共轭梯度法共轭梯度法是一种改进的最速下降法。

它利用了无约束问题的二次函数特性,通过选择一组相互共轭的搜索方向来提高收敛速度。

相比于最速下降法,共轭梯度法的收敛速度更快,尤其适用于大规模优化问题。

3. 牛顿法牛顿法是一种基于二阶导数信息的优化方法。

它通过构建并求解特定的二次逼近模型来求解无约束问题。

然而,牛顿法在高维问题中的计算复杂度较高,并且需要矩阵求逆运算,可能导致数值不稳定。

二. 线性规划问题求解方法1. 单纯形法单纯形法是一种经典的线性规划问题求解方法。

它通过在可行域内进行边界移动来寻找最优解。

然而,当问题规模较大时,单纯形法的计算复杂度会大幅增加,导致求解效率低下。

2. 内点法内点法是一种改进的线性规划问题求解方法。

与单纯形法不同,内点法通过将问题转化为一系列等价的非线性问题来求解。

内点法的优势在于其计算复杂度相对较低,尤其适用于大规模线性规划问题。

三. 非线性规划问题求解方法1. 信赖域算法信赖域算法是一种常用的非线性规划问题求解方法。

它通过构建局部模型,并通过逐步调整信赖域半径来寻找最优解。

信赖域算法既考虑了收敛速度,又保持了数值稳定性。

2. 遗传算法遗传算法是一种基于自然进化过程的优化算法。

它模拟遗传操作,并通过选择、交叉和变异等操作来搜索最优解。

遗传算法的优势在于其适用于复杂的非线性规划问题,但可能需要较长的计算时间。

无约束优化方法1. 最速下降法(Gradient Descent Method)最速下降法是一种基于梯度信息的迭代优化算法。

其基本思想是从任意初始点开始,沿着目标函数的梯度方向进行迭代,直到达到收敛条件。

最速下降法的迭代更新公式如下:x_{k+1}=x_k-t_k*∇f(x_k)其中,x_k是第k次迭代的解向量,t_k是第k次迭代的步长(也称为学习率),∇f(x_k)是目标函数在x_k处的梯度向量。

最速下降法的步骤如下:1)选取初始点x_0。

2)计算目标函数的梯度∇f(x_k)。

3)计算步长t_k。

4)更新解向量x_{k+1}。

5)判断迭代终止条件,如果满足则停止迭代;否则返回第2步。

最速下降法的优点是易于实现和理解,收敛性较好。

然而,最速下降法存在的问题是收敛速度较慢,特别是对于目标函数呈现狭长或弯曲形状的情况下。

这导致了在高维优化问题中,最速下降法的性能较差。

2. 牛顿法(Newton's Method)牛顿法是一种基于二阶导数信息的迭代优化算法。

它使用目标函数的一阶和二阶导数信息构造一个二次近似模型,然后求解该模型的最小值。

牛顿法的迭代更新公式如下:x_{k+1}=x_k-H_k^{-1}*∇f(x_k)其中,H_k是目标函数在x_k处的海森矩阵,∇f(x_k)是目标函数在x_k处的梯度向量。

牛顿法的步骤如下:1)选取初始点x_0。

2)计算目标函数的梯度∇f(x_k)和海森矩阵H_k。

3)计算更新方向H_k^{-1}*∇f(x_k)。

4)更新解向量x_{k+1}。

5)判断迭代终止条件,如果满足则停止迭代;否则返回第2步。

牛顿法的优点是收敛速度快,尤其是在目标函数曲率大的地方。

然而,牛顿法也存在一些问题。

首先,计算海森矩阵需要大量的计算资源,特别是在高维空间中。

其次,当海森矩阵不可逆或近似不可逆时,牛顿法可能会失效。

综上所述,最速下降法和牛顿法是两种常用的无约束优化方法。

最速下降法简单易实现,但收敛速度较慢;牛顿法收敛速度快,但计算量大且可能遇到海森矩阵不可逆的问题。

最速下降法与牛顿法及其区别摘要:无约束优化方法是优化技术中极为重要和基本内容之一。

它不仅可以直接用来求解无约束优化问题,而且很多约束优化问题也常将其转化为无约束优化问题,然后用无约束优化方法来求解。

最速下降法和牛顿法是比较常见的求解无约束问题的最优化方法,这两种算法作为基本算法,在最优化方法中占有重要的地位。

其中最速下降法又称梯度法,其优点是工作量少,存储变量较少,初始点要求不高;缺点是收敛慢,效率低。

牛顿法的优点是收敛速度快;缺点是对初始点要求严格,方向构造困难,计算复杂且占用内存较大。

同时,这两种算法的理论和方法渗透到许多方面,特别是在军事、经济、管理、生产过程自动化、工程设计和产品优化设计等方面都有着重要的应用。

因此,研究最速下降法和牛顿法的原理及其算法对我们有着及其重要的意义。

关键字:无约束优化最速下降法牛顿法Abstract: unconstrained optimization method is to optimize the technology is extremely important and basic content of. It not only can be directly used to solve unconstrained optimization problems, and a lot of constrained optimization problems are often transformed into unconstrained optimization problem, and then use the unconstrained optimization methods to solve. The steepest descent method and Newton-Raphson method is relatively common in the unconstrained problem optimization method, these two kinds of algorithm as the basic algorithm, the optimization method plays an important role in. One of the steepest descent method also known as gradient method, its advantages are less workload, storage variable is less, the initial requirements is not high; drawback is the slow convergence, low efficiency. Newtonian method has the advantages of fast convergence speed; drawback is the initial point of strict construction difficulties, directions, complicated calculation and larger memory. At the same time, these two kinds of algorithm theory and methods into many aspects, especially in the military, economic, management, production process automation, engineering design and product optimization design has important applications. Therefore, to study the steepest descent method and Newton-Raphson method principle and algorithm for us with its important significance.Keywords: unconstrained optimization steepest descent method一、算法的基本原理1.1 最速下降法的基本原理在基本迭代公式k k k k P t X X +=+1中,每次迭代搜索方向k P 取为目标函数)(X f 的负梯度方向,即)(k k X f P -∇=,而每次迭代的步长k t 取为最优步长,由此确定的算法称为最速下降法。

最优化方法实验报告Numerical Linear Algebra And ItsApplications学生所在学院:理学院学生所在班级:计算数学10-1学生姓名:甘纯指导教师:单锐教务处2013年5月实验三实验名称:无约束最优化方法的MATLAB实现实验时间: 2013年05月10日星期三实验成绩:一、实验目的:通过本次实验的学习,进一步熟悉掌握使用MATLAB软件,并能利用该软件进行无约束最优化方法的计算。

二、实验背景:(一)最速下降法1、算法原理最速下降法的搜索方向是目标函数的负梯度方向,最速下降法从目标函数的负梯度方向一直前进,直到到达目标函数的最低点。

2、算法步骤用最速下降法求无约束问题n R()min的算法步骤如下:xxf,a )给定初始点)0(x ,精度0>ε,并令k=0;b )计算搜索方向)()()(k k x f v -∇=,其中)()(k x f ∇表示函数)(x f 在点)(k x 处的梯度;c )若ε≤)(k v ,则停止计算;否则,从)(k x 出发,沿)(k v 进行一维搜索,即求k λ,使得)(min )()()(0)()(k k k k v x f v x f λλλ+=+≥; d )令1,)()()1(+=+=+k k v x x k k k k λ,转b )。

(二)牛顿法1、算法原理牛顿法是基于多元函数的泰勒展开而来的,它将)()]([-)(1)(2k k x f x f ∇∇-作为搜索方向,因此它的迭代公式可直接写出来:)()]([)(1)(2)()(k k k k x f x f x x ∇∇-=-2、算法步骤用牛顿法求无约束问题n R x x f ∈),(min 的算法步骤如下:a )给定初始点)0(x ,精度0>ε,并令k=0;b )若ε≤∇)()(k x f ,停止,极小点为)(k x ,否则转c );c )计算)()]([,)]([)(1)(2)(1)(2k k k k x f x f p x f ∇∇-=∇--令;d )令1,)()()1(+=+=+k k p x x k k k ,转b )。

精心整理五种最优化方法1.最优化方法概述1.1最优化问题的分类1)无约束和有约束条件;2)确定性和随机性最优问题(变量是否确定);341.22.2.11232.23.3.11233.24.模式搜索法(步长加速法)4.1简介1)解决的是无约束非线性规划问题;2)不需要求目标函数的导数,所以在解决不可导的函数或者求导异常麻烦的函数的优化问题时非常有效。

3)模式搜索法每一次迭代都是交替进行轴向移动和模式移动。

轴向移动的目的是探测有利的下降方向,而模式移动的目的则是沿着有利方向加速移动。

4.2模式搜索法步骤5.评价函数法5.1简介评价函数法是求解多目标优化问题中的一种主要方法。

在许多实际问题中,衡量一个方案的好坏标准往往不止一个,多目标最优化的数学描述如下:min(f_1(x),f_2(x),...,f_k(x))s.t.g(x)<=0传统的多目标优化方法本质是将多目标优化中的各分目标函数,经处理或数学变换,转变成一个单目标函数,然后采用单目标优化技术求解。

常用的方法有“线性加权和法”、“极大极小法”、“理想点法”。

选取其中一种线性加权求合法介绍。

5.2线性加权求合法6.遗传算法智能优化方法是通过计算机学习和存贮大量的输入-输出模式映射关系,进而达到优化的一种方法,主要有人工神经网络法,遗传算法和模拟退火法等。

6.1遗传算法基本概念1.个体与种群个体就是模拟生物个体而对问题中的对象(一般就是问题的解)的一种称呼。

种群就是模拟生物种群而由若干个体组成的群体,它一般是整个搜索空间的一个很小的子集。

2.适应度与适应度函数适应度就是借鉴生物个体对环境的适应程度,而对问题中的个体对象所设计的表征其优劣的一种测度。

适应度函数就是问题中的全体个体与其适应度之间的一个对应关系。

该函数就是遗传算法中指导搜索的评价函数。

6.2遗传算法基本流程遗传算法的中心思想就是对一定数量个体组成的生物种群进行选择、交叉、变异等遗传操作,最终求得最优解或近似最优解。

五种最优化方法 Prepared on 22 November 2020五种最优化方法1. 最优化方法概述最优化问题的分类1)无约束和有约束条件;2)确定性和随机性最优问题(变量是否确定);3)线性优化与非线性优化(目标函数和约束条件是否线性);4)静态规划和动态规划(解是否随时间变化)。

最优化问题的一般形式(有约束条件):式中f(X)称为目标函数(或求它的极小,或求它的极大),si(X)称为不等式约束,hj(X)称为等式约束。

化过程就是优选X,使目标函数达到最优值。

2.牛顿法简介1)解决的是无约束非线性规划问题;2)是求解函数极值的一种方法;3)是一种函数逼近法。

原理和步骤3. 最速下降法(梯度法)最速下降法简介1)解决的是无约束非线性规划问题;2)是求解函数极值的一种方法;3)沿函数在该点处目标函数下降最快的方向作为搜索方向;最速下降法算法原理和步骤4. 模式搜索法(步长加速法)简介1)解决的是无约束非线性规划问题;2)不需要求目标函数的导数,所以在解决不可导的函数或者求导异常麻烦的函数的优化问题时非常有效。

3)模式搜索法每一次迭代都是交替进行轴向移动和模式移动。

轴向移动的目的是探测有利的下降方向,而模式移动的目的则是沿着有利方向加速移动。

模式搜索法步骤5.评价函数法简介评价函数法是求解多目标优化问题中的一种主要方法。

在许多实际问题中,衡量一个方案的好坏标准往往不止一个,多目标最优化的数学描述如下:min (f_1(x),f_2(x),...,f_k(x)). g(x)<=0传统的多目标优化方法本质是将多目标优化中的各分目标函数,经处理或数学变换,转变成一个单目标函数,然后采用单目标优化技术求解。

常用的方法有“线性加权和法”、“极大极小法”、“理想点法”。

选取其中一种线性加权求合法介绍。

线性加权求合法6. 遗传算法智能优化方法是通过计算机学习和存贮大量的输入-输出模式映射关系,进而达到优化的一种方法,主要有人工神经网络法,遗传算法和模拟退火法等。

机器学习算法系列最速下降法牛顿法拟牛顿法最速下降法(Gradient Descent)最速下降法是一种常用的优化算法,用于求解无约束的最小化问题。

其原理是通过不断迭代更新参数的方式来逼近最优解。

在最速下降法中,每次迭代的方向是当前位置的负梯度方向,即沿着目标函数下降最快的方向前进。

具体地,对于目标函数f(x),在当前位置x_k处的梯度为g_k=▽f(x_k),则下一次迭代的位置x_{k+1}可以通过以下公式计算:x_{k+1}=x_k-α*g_k其中,α 是一个称为学习率(learning rate)的参数,用于控制每次迭代的步长。

最速下降法的优点是简单易实现,收敛速度较快。

然而,它也有一些缺点。

首先,最速下降法的收敛速度依赖于学习率的选择,过小的学习率会导致收敛速度过慢,而过大的学习率可能会导致跳过最优解。

其次,最速下降法通常会在目标函数呈现弯曲或者高度相关的情况下表现不佳,很难快速收敛到最优解。

牛顿法(Newton's Method)牛顿法是一种通过二阶导数信息来优化的算法,可以更快地收敛到目标函数的最优解。

在牛顿法中,每次迭代的位置x_{k+1}可以通过以下公式计算:x_{k+1}=x_k-(H_k)^{-1}*▽f(x_k)其中,H_k是目标函数f(x)在当前位置x_k处的黑塞矩阵。

黑塞矩阵描述了目标函数的二阶导数信息,可以帮助更准确地估计参数的更新方向。

牛顿法的优点是收敛速度较快,特别是对于目标函数呈现弯曲或者高度相关的情况下,相较于最速下降法可以更快地达到最优解。

然而,牛顿法也有一些缺点。

首先,计算黑塞矩阵的代价较高,尤其是当参数较多时。

其次,黑塞矩阵可能不可逆或者计算代价较大,这时可以通过使用拟牛顿法来避免。

拟牛顿法(Quasi-Newton Method)拟牛顿法是一类基于牛顿法的优化算法,通过估计黑塞矩阵的逆来逼近最优解,从而避免了计算黑塞矩阵的代价较高的问题。

在拟牛顿法中,每次迭代的位置x_{k+1}可以通过以下公式计算:x_{k+1}=x_k-B_k*▽f(x_k)其中,B_k是一个对黑塞矩阵逆的估计。

五种最优化方法1. 最优化方法概述1.1最优化问题的分类1)无约束和有约束条件;2)确定性和随机性最优问题(变量是否确定);3)线性优化与非线性优化(目标函数和约束条件是否线性);4)静态规划和动态规划(解是否随时间变化)。

1.2最优化问题的一般形式(有约束条件):式中f(X)称为目标函数(或求它的极小,或求它的极大),si(X)称为不等式约束,hj(X)称为等式约束。

化过程就是优选X,使目标函数达到最优值。

2.牛顿法2.1简介1)解决的是无约束非线性规划问题;2)是求解函数极值的一种方法;3)是一种函数逼近法。

2.2 原理和步骤3. 最速下降法(梯度法)3.1最速下降法简介1)解决的是无约束非线性规划问题;2)是求解函数极值的一种方法;3)沿函数在该点处目标函数下降最快的方向作为搜索方向;3.2 最速下降法算法原理和步骤4. 模式搜索法(步长加速法)4.1 简介1)解决的是无约束非线性规划问题;2)不需要求目标函数的导数,所以在解决不可导的函数或者求导异常麻烦的函数的优化问题时非常有效。

3)模式搜索法每一次迭代都是交替进行轴向移动和模式移动。

轴向移动的目的是探测有利的下降方向,而模式移动的目的则是沿着有利方向加速移动。

4.2模式搜索法步骤5.评价函数法5.1 简介评价函数法是求解多目标优化问题中的一种主要方法。

在许多实际问题中,衡量一个方案的好坏标准往往不止一个,多目标最优化的数学描述如下:min (f_1(x),f_2(x),...,f_k(x))s.t. g(x)<=0传统的多目标优化方法本质是将多目标优化中的各分目标函数,经处理或数学变换,转变成一个单目标函数,然后采用单目标优化技术求解。

常用的方法有“线性加权和法”、“极大极小法”、“理想点法”。

选取其中一种线性加权求合法介绍。

5.2 线性加权求合法6. 遗传算法智能优化方法是通过计算机学习和存贮大量的输入-输出模式映射关系,进而达到优化的一种方法,主要有人工神经网络法,遗传算法和模拟退火法等。

哈哈,我已经实现了最速下降法语牛顿发的结合,并且还可以动画演示其求解最优值的迭代过程。

都已在程序上实现了。

(matlab).运行的时,最速下降精度不要弄得太小,到后面的牛顿精度就可以取任意值了。

ticclc;clear;syms x1 x2G=[];G=input('请输入想x1^2,x2^2,x1*x2,x1,x2,常系数,如[1,2,3,4,5,6] 系数向量=:');a=G(1,1);b=G(1,2);c=G(1,3);d=G(1,4);e=G(1,5);g=G(1,6);f=a*x1^2+b*x2^2+c*x1*x2+d*x1+e*x2+g;%画出原始图像figure;x11=-100:0.5:100;x22=x11;[x11,x22]=meshgrid(x11,x22);f11=a.*x11.^2+b*x22.^2+c*x11.*x22+d.*x11+e.*x22+g;surf(f11),grid on,hold on;%画出原始图像df1=diff(f,x1);df2=diff(f,x2);%对函数进行求一阶导DF=[df1;df2];df11=diff(df1,x1);df12=diff(df1,x2);df21=diff(df2,x1);df22=diff(df2,x2);%这里进行求函数二阶导数DEE=[df11,df12;df21,df22];x=input('请输入x的初始值为x=[x1,x2],x=:');x=x';E=input('请输入你所要求的最速下降法的精度数(一般取3~5)E=:');%这里进行一些相关初始值的计算T=[];d=T;T(:,1)=subs(DF,[x1,x2],[x(1),x(2)]);TH=subs(DEE,[x1,x2],[x(1),x(2)]);%这里进行一些相关初始值的计算disp('由于你输入的初始值,这里将开始最速下降法搜寻:');for k=1:100000d(:,1)=-T(:,1);%d(k)是x(k+1)=x(k)+A(k)*d(k)A(1)=(T(:,1)'*T(:,1))/(T(:,1)'*TH*T(:,1));TH=subs(DEE,[x1,x2],[x(1,k),x(2,k)]);T(:,k)=subs(DF,[x1,x2],[x(1,k),x(2,k)]);d(:,k+1)=-T(:,k);A(k)=(T(:,k)'*T(:,k))/(T(:,k)'*TH*T(:,k));KLJ(:,k)=norm(T(:,k));GG(k)=subs(f,[x1,x2],[x(1,k),x(2,k)]);if norm(T(:,k))<Edisp('有这里你就进入牛顿法求最优了');disp(' ');disp('FX就是最速下的解 ')FX=subs(f,[x1,x2],[x(1,k),x(2,k)])disp(' ');disp('对应的x值为 ');x(:,k)break;endx(:,k+1)=x(:,k)+A(k)*d(:,k);endtoc%画出最速下降迭代点最终停留位置figure;plot3(x11,x22,f11,'r'),grid on;for tk=1:kh1=line( 'Color' ,[0 1 0], 'Marker' , '.' , 'MarkerSize' ,20, 'EraseMode' , 'xor' ); set(h1, 'xdata' ,x(1,tk), 'ydata' ,x(2,tk), 'zdata' , GG(tk));drawnow; % 刷新屏幕pause(0.1);endfop1=getframe(gcf)image(fop1.cdata)%画出最速下降迭代点最终停留位置ticY=x(:,k);EE=input('请输入牛顿最终的精度系数EE=:');TT(:,1)=subs(DF,[x1,x2],[Y(1),Y(2)]);THH=subs(DEE,[x1,x2],[Y(1),Y(2)]);aa=1;disp('程序可以运行到这里');for kk=1:10000dd(:,kk)=-inv(THH)*TT(:,kk);Y(:,kk+1)=Y(:,kk)+ aa*dd(:,kk);THH=subs(DEE,[x1,x2],[Y(1,kk),Y(2,kk)]);TT(:,kk+1)=subs(DF,[x1,x2],[Y(1,kk+1),Y(2,kk+1)]);PP=norm(TT(:,kk));GG1(kk)=subs(f,[x1,x2],[Y(1,kk),Y(2,kk)]);if PP<EEdisp('到这里您已经得到全局最优解了');FXX=subs(f,[x1,x2],[Y(1,kk),Y(2,kk)])disp(' ');disp('对应的x值为: ');Y(:,kk)break;endendFXX=subs(f,[x1,x2],[Y(1,kk),Y(2,kk)])toc%画出最终极值点停留位置figure;plot3(x11,x22,f11,'r'),grid on;for J=1:kkh2=line( 'Color' ,[0 1 0], 'Marker' , '.' , 'MarkerSize' ,40, 'EraseMode' , 'xor' ); set(h2, 'xdata' ,Y(1,J), 'ydata' ,Y(2,J), 'zdata' , GG1(1,J));pause(0.1);fop=getframe(gcf);image(fop.cdata);enddisp('现在程序已经结束了');%画出最终极值点停留位置[attach]3912[/attach]。

五种最优化方法Document number:NOCG-YUNOO-BUYTT-UU986-1986UT五种最优化方法1. 最优化方法概述最优化问题的分类1)无约束和有约束条件;2)确定性和随机性最优问题(变量是否确定);3)线性优化与非线性优化(目标函数和约束条件是否线性);4)静态规划和动态规划(解是否随时间变化)。

最优化问题的一般形式(有约束条件):式中f(X)称为目标函数(或求它的极小,或求它的极大),si(X)称为不等式约束,hj(X)称为等式约束。

化过程就是优选X,使目标函数达到最优值。

2.牛顿法简介1)解决的是无约束非线性规划问题;2)是求解函数极值的一种方法;3)是一种函数逼近法。

原理和步骤3. 最速下降法(梯度法)最速下降法简介1)解决的是无约束非线性规划问题;2)是求解函数极值的一种方法;3)沿函数在该点处目标函数下降最快的方向作为搜索方向;最速下降法算法原理和步骤4. 模式搜索法(步长加速法)简介1)解决的是无约束非线性规划问题;2)不需要求目标函数的导数,所以在解决不可导的函数或者求导异常麻烦的函数的优化问题时非常有效。

3)模式搜索法每一次迭代都是交替进行轴向移动和模式移动。

轴向移动的目的是探测有利的下降方向,而模式移动的目的则是沿着有利方向加速移动。

模式搜索法步骤5.评价函数法简介评价函数法是求解多目标优化问题中的一种主要方法。

在许多实际问题中,衡量一个方案的好坏标准往往不止一个,多目标最优化的数学描述如下:min (f_1(x),f_2(x),...,f_k(x)). g(x)<=0传统的多目标优化方法本质是将多目标优化中的各分目标函数,经处理或数学变换,转变成一个单目标函数,然后采用单目标优化技术求解。

常用的方法有“线性加权和法”、“极大极小法”、“理想点法”。

选取其中一种线性加权求合法介绍。

线性加权求合法6. 遗传算法智能优化方法是通过计算机学习和存贮大量的输入-输出模式映射关系,进而达到优化的一种方法,主要有人工神经网络法,遗传算法和模拟退火法等。

五种最优化方法1. 最优化方法概述1.1最优化问题的分类1)无约束和有约束条件;2)确定性和随机性最优问题(变量是否确定);3)线性优化与非线性优化(目标函数和约束条件是否线性);4)静态规划和动态规划(解是否随时间变化)。

1.2最优化问题的一般形式(有约束条件):式中f(X)称为目标函数(或求它的极小,或求它的极大),si(X)称为不等式约束,hj(X)称为等式约束。

化过程就是优选X,使目标函数达到最优值。

2.牛顿法2.1简介1)解决的是无约束非线性规划问题;2)是求解函数极值的一种方法;3)是一种函数逼近法。

2.2 原理和步骤3. 最速下降法(梯度法)3.1最速下降法简介1)解决的是无约束非线性规划问题;2)是求解函数极值的一种方法;3)沿函数在该点处目标函数下降最快的方向作为搜索方向;3.2 最速下降法算法原理和步骤4. 模式搜索法(步长加速法)4.1 简介1)解决的是无约束非线性规划问题;2)不需要求目标函数的导数,所以在解决不可导的函数或者求导异常麻烦的函数的优化问题时非常有效。

3)模式搜索法每一次迭代都是交替进行轴向移动和模式移动。

轴向移动的目的是探测有利的下降方向,而模式移动的目的则是沿着有利方向加速移动。

4.2模式搜索法步骤5.评价函数法5.1 简介评价函数法是求解多目标优化问题中的一种主要方法。

在许多实际问题中,衡量一个方案的好坏标准往往不止一个,多目标最优化的数学描述如下:min (f_1(x),f_2(x),...,f_k(x))s.t. g(x)<=0传统的多目标优化方法本质是将多目标优化中的各分目标函数,经处理或数学变换,转变成一个单目标函数,然后采用单目标优化技术求解。

常用的方法有“线性加权和法”、“极大极小法”、“理想点法”。

选取其中一种线性加权求合法介绍。

5.2 线性加权求合法6. 遗传算法智能优化方法是通过计算机学习和存贮大量的输入-输出模式映射关系,进而达到优化的一种方法,主要有人工神经网络法,遗传算法和模拟退火法等。