emd算法python实现

- 格式:docx

- 大小:37.46 KB

- 文档页数:4

memd 多元经验模态分解 pythonMemD (Multimodal Experience Modeling Decomposition) 是一种多模态经验模型分解方法,用于将多模态数据(如文本、图像、音频等)转化为一个共享的语义空间。

下面是一个使用Python 实现 MemD 的示例:```pythonimport numpy as npfrom sklearn.decomposition import PCAdef memd(data, n_components):# 将每个模态数据矩阵进行降维,得到每个模态的低维表示low_dim_data = []for modality in data:pca = PCA(n_components=n_components)low_dim_data.append(pca.fit_transform(modality))# 计算每个模态数据矩阵的权重weights = []for i in range(len(data)):modality_data = data[i]W = np.dot(modality_data,np.linalg.pinv(np.dot(np.transpose(modality_data),modality_data)))weights.append(W)# 计算共享的语义表示shared_representation = np.zeros((data[0].shape[0],n_components))for i in range(len(data)):shared_representation += np.dot(data[i], weights[i])return shared_representation, low_dim_data# 示例调用text_data = np.random.rand(100, 10)image_data = np.random.rand(100, 20)audio_data = np.random.rand(100, 30)shared_representation, low_dim_data = memd([text_data,image_data, audio_data], n_components=5)```这个示例中,数据由文本、图像和音频三个模态组成。

emd分解算法 python一、emd分解算法原理emd分解算法的核心思想是将两个概率分布逐步分解为一组基本分布,然后比较这组基本分布之间的差异。

它的基本步骤如下:1. 输入两个概率分布P和Q,其中P的总质量等于Q的总质量;2. 根据P和Q的质量分布,将P和Q分解为一组基本分布;3. 计算每对基本分布之间的距离,得到一个距离矩阵;4. 使用线性规划方法优化距离矩阵,得到最优的基本分布匹配;5. 根据最优的匹配,计算P和Q之间的emd距离。

二、Python实现emd分解算法下面我们将使用Python实现emd分解算法。

首先,我们需要导入相关的库:```pythonimport numpy as npfrom scipy.optimize import linprog```然后,我们定义一个函数来计算emd距离:```pythondef emd_distance(p, q):n = len(p)m = len(q)c = np.zeros((n, m))for i in range(n):for j in range(m):c[i, j] = abs(p[i] - q[j])f = c.flatten()A_eq = np.zeros((n + m, n * m))b_eq = np.zeros(n + m)for i in range(n):for j in range(m):A_eq[i, i * m + j] = 1for j in range(m):for i in range(n):A_eq[n + j, i * m + j] = 1for i in range(n):b_eq[i] = p[i]for j in range(m):b_eq[n + j] = q[j]bounds = [(0, None)] * (n * m)result = linprog(f, A_eq=A_eq, b_eq=b_eq, bounds=bounds) return result.fun```在这段代码中,我们首先定义了一个二维数组c来存储两个分布之间的距离。

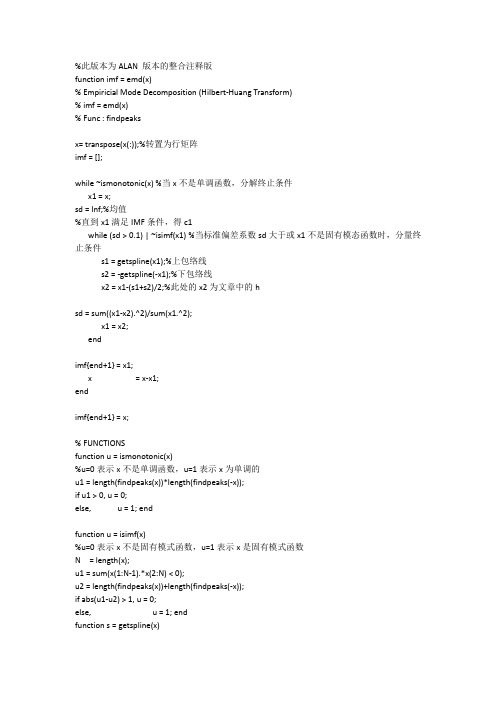

%此版本为ALAN 版本的整合注释版function imf = emd(x)% Empiricial Mode Decomposition (Hilbert-Huang Transform)% imf = emd(x)% Func : findpeaksx= transpose(x(:));%转置为行矩阵imf = [];while ~ismonotonic(x) %当x不是单调函数,分解终止条件x1 = x;sd = Inf;%均值%直到x1满足IMF条件,得c1while (sd > 0.1) | ~isimf(x1) %当标准偏差系数sd大于或x1不是固有模态函数时,分量终止条件s1 = getspline(x1);%上包络线s2 = -getspline(-x1);%下包络线x2 = x1-(s1+s2)/2;%此处的x2为文章中的hsd = sum((x1-x2).^2)/sum(x1.^2);x1 = x2;endimf{end+1} = x1;x = x-x1;endimf{end+1} = x;% FUNCTIONSfunction u = ismonotonic(x)%u=0表示x不是单调函数,u=1表示x为单调的u1 = length(findpeaks(x))*length(findpeaks(-x));if u1 > 0, u = 0;else, u = 1; endfunction u = isimf(x)%u=0表示x不是固有模式函数,u=1表示x是固有模式函数N = length(x);u1 = sum(x(1:N-1).*x(2:N) < 0);u2 = length(findpeaks(x))+length(findpeaks(-x));if abs(u1-u2) > 1, u = 0;else, u = 1; endfunction s = getspline(x)%三次样条函数拟合成元数据包络线N = length(x);p = findpeaks(x);s = spline([0 p N+1],[0 x(p) 0],1:N);---------------------------------------------------------------------------------------------------------------------------------------------------------------function n = findpeaks(x)% Find peaks.找到极值,n为极值点所在位置% n = findpeaks(x)n = find(diff(diff(x) > 0) < 0);u = find(x(n+1) > x(n));n(u) = n(u)+1;----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------function plot_hht00(x,Ts)% 双边带调幅信号的EMD分解% Plot the HHT.% plot_hht(x,Ts)%% :: Syntax% The array〔列〕x is the input signal and Ts is the sampling period〔取样周期〕. % Example on use: [x,Fs] = wavread('Hum.wav');% plot_hht(x(1:6000),1/Fs);% Func : emd% Get HHT.clear all;close all;Ts=0.0005;t=0:Ts:10; % 采样率2000HZ% 调幅信号%x=sin(2*pi*t).*sin(40*pi*t);x=sin(2*pi*t);s1 = getspline(x);%上包络线s2 = -getspline(-x);%上包络线x1 = (s1+s2)/2;%此处的x2为文章中的hfigure;plot(t,x);xlabel('Time'), ylabel('Amplitude');title('双边带调幅信号');hold on;plot(t,s1,'-r');plot(t,s2,'-r');plot(t,x1,'g');imf = emd(x);for k = 1:length(imf)b(k) = sum(imf{k}.*imf{k});th = angle(hilbert(imf{k}));d{k} = diff(th)/Ts/(2*pi);end[u,v] = sort(-b);b = 1-b/max(b);% Set time-frequency plots.N = length(x);c = linspace(0,(N-2)*Ts,N-1);%figure;for k = v(1:2)plot(c,d{k},'k.','Color',b([k k k]),'MarkerSize',3); hold on;set(gca,'FontSize',8,'XLim',[0 c(end)],'YLim',[0 50]);%设置x、y轴句柄xlabel('Time'), ylabel('Frequency');title('原信号时频图');end% Set IMF plots.M = length(imf);N = length(x);c = linspace(0,(N-1)*Ts,N);for k1 = 0:4:M-1figurefor k2 = 1:min(4,M-k1),subplot(4,1,k2),plot(c,imf{k1+k2});set(gca,'FontSize',8,'XLim',[0 c(end)]);title('EMD分解结果');endxlabel('Time');end。

emd分解matlab程序EMD(Empirical Mode Decomposition)是一种信号处理方法,用于将非线性和非平稳信号分解为一组称为本征模态函数(Intrinsic Mode Functions,IMFs)的振动模式。

本文将介绍如何使用MATLAB编写EMD程序,并对其进行详细解释。

首先,我们需要定义一个函数来实现EMD分解。

以下是一个基本的EMD函数的框架:```matlabfunction [IMFs, residual] = emd(signal)% 初始化IMFs和残差IMFs = [];residual = signal;% 循环分解信号直到残差为0或者只剩下一个IMFwhile (is_imf(residual))% 计算当前信号的极值点extrema = find_extrema(residual);% 计算当前信号的上包络线和下包络线upper_envelope = upper_envelope_line(residual, extrema);lower_envelope = lower_envelope_line(residual, extrema);% 计算当前信号的均值mean_value = (upper_envelope + lower_envelope) / 2;% 计算当前信号的IMFimf = residual - mean_value;% 将当前IMF添加到IMFs列表中IMFs = [IMFs, imf];% 更新残差为当前信号减去当前IMFresidual = residual - imf;endend```上述代码中,`is_imf`函数用于判断一个信号是否为IMF,`find_extrema`函数用于找到信号的极值点,`upper_envelope_line`函数和`lower_envelope_line`函数用于计算信号的上包络线和下包络线。

EM算法求解⾼斯混合模型python实现注:本⽂是对《统计学习⽅法》EM算法的⼀个简单总结。

1. 什么是EM算法?引⽤书上的话:概率模型有时既含有观测变量,⼜含有隐变量或者潜在变量。

如果概率模型的变量都是观测变量,可以直接使⽤极⼤似然估计法或者贝叶斯的⽅法进⾏估计模型参数,但是当模型含有隐藏变量时,就不能简单使⽤这些⽅法了。

EM算法就是含有隐变量的概率模型参数的极⼤似然估计法,或者极⼤似然后验概率估计法。

2. EM 算法的⼀个⼩例⼦:三硬币模型假设有3枚硬币,记作A,B,C。

这些硬币的正⾯出现的概率分别为π、p、q。

进⾏如下的试验:先掷硬币A,根据A的结果选择B和C,如果掷A得到正⾯,则选择B;如果掷A得到反⾯,则选择C。

接着掷出选出的硬币。

记录下这次掷硬币的结果,如果是正⾯,则记作1,反⾯则记作0。

独⽴重复做了n次试验(这⾥取n=10),得到结果如下:1,1,0,1,0,0,1,0,1,1。

假设只能观测到抛硬币的结果,不能观测到抛硬币的过程,那么我们该如何估计三硬币的参数π、p、q呢?(也就是估计三枚硬币正⾯向上的概率)EM算法分为E步和M步。

EM 算法⾸先选取了参数的初始值,记作θ(0)=(π(0),p(0),q(0))。

然后通过下⾯的步骤迭代计算参数的估计值,直到收敛为⽌,第i次迭代的参数的估计值记作θ(i)=(π(i),p(i),q(i)),则EM算法的第i+1次迭代为:E步:计算模型在参数π(i)、p(i)、q(i)下观测数据y j来⾃掷硬币B的概率为µ(i+1) j =π(i)(p(i))y j(1−p(i))1−y jπ(i)(p(i))y j(1−p(i))1−y j+(1−π(i))(q(i))y j(1−q(i))1−y jM步:计算模型新的参数的估计值:π(i+1)=1n∑nj=1µ(i+1)jp(i+1)=∑n j=1µ(i+1)jy j∑n j=1µ(i+1)jq(i+1)=∑n j=1(1−µ(i+1)j)y j∑n j=1(1−µ(i+1)j)下⾯带⼊具体的数字计算⼀下。

emd经验模态分解方法EMD方法的核心思想是将信号分解成一系列局部特征模态函数(IMFs)与一个长周期趋势函数之和。

IMFs是具有瞬时频率随时间变化的函数,可以看作是信号的自然模式。

EMD的目标是将原始信号分解成IMFs,使得每个IMF的频带尽可能窄且能够适应信号的非线性和非平稳特性。

EMD方法的步骤如下:1.将原始信号进行筛选,以去除可能的趋势分量。

这一步骤可以通过信号的平滑、滤波等方法实现。

2.寻找信号的极值点,作为IMF的上下包络线。

极大极小值点与信号交替出现,将信号分解成一系列的局部极值点序列。

3.连接相邻的极值点,得到区间内的局部极值曲线。

这些局部极值曲线可以被看作是信号的IMFs。

4.对局部极值曲线进行内插处理,得到IMF。

内插处理可以通过样条插值、三次样条插值等方法进行。

内插处理的目的是使IMF在局部区间内满足振幅变化的要求,并且在整个信号范围满足信号的连续性和光滑性。

5.将得到的IMF与原始信号相减,得到剩余项。

如果剩余项仍具有明显的趋势分量,可以继续对剩余项进行EMD分解。

6.重复以上步骤,直到得到满足条件的IMFs。

EMD方法具有自适应性,能够根据信号的特性动态调整分解过程,避免了对分解参数的预设。

此外,EMD方法还具有好的数学基础,理论上可以保证分解结果不失真且完备性。

EMD方法在信号分析领域被广泛应用,例如故障诊断、信号降噪、振动分析和图像去噪等。

与其他方法相比,EMD能够获取更细节的时频信息,对于非线性和非平稳信号具有更好的适应性。

然而,EMD方法也存在一些问题。

首先,由于EMD方法是一种迭代的数据驱动方法,计算量较大,需要进行大量的数据处理和插值操作。

其次,IMF的计算结果依赖于信号的极值点选择,不同的极值点选择可能会得到不同的IMFs。

此外,EMD方法对噪声敏感,噪声的存在会导致IMFs的偏离和模态混叠。

针对这些问题,许多改进的EMD方法被提出,如改进的EMD(CEEMD)、可变模态分解(VMD)等。

python⼤战机器学习——聚类和EM算法 注:本⽂中涉及到的公式⼀律省略(公式不好敲出来),若想了解公式的具体实现,请参考原著。

1、基本概念 (1)聚类的思想: 将数据集划分为若⼲个不想交的⼦集(称为⼀个簇cluster),每个簇潜在地对应于某⼀个概念。

但是每个簇所具有现实意义由使⽤者⾃⼰决定,聚类算法仅仅会进⾏划分。

(2)聚类的作⽤: 1)可以作为⼀个单独的过程,⽤于寻找数据的⼀个分布规律 2)作为分类的预处理过程。

⾸先对分类数据进⾏聚类处理,然后在聚类结果的每⼀个簇上执⾏分类过程。

(3)聚类的性能度量: 1)外部指标:该指标是由聚类结果与某个参考模型进⾏⽐较⽽获得的。

这些外部指标性能度量的结果都在[0,1]之间,这些值越⼤,说明聚类的性能越好。

Jaccard系数:它刻画了所有属于同⼀类的样本对同时在C和C*中⾪属于同⼀类的样本对的概率 JC=a/(a+b+c) FM指数:它刻画了在C中属于同⼀类的样本对中,同时属于C*的样本对的⽐例为p1;在C*中属于同⼀类的样本对中,同时属于C的样本对⽐例为p2,FMI 就是p1和p2的⼏何平均 FMI=sqrt((a/(a+b))*(a/(a+c))) Rand指数:它刻画的是同时⾪属于C,C*的样本对于既不⾪属于C,⼜不⾪属于C*的样本对之和占所有样本对的⽐例RI=2*(a+d)/(N*(N-1)) ARI指数:对于随机聚类,RI指数不保证接近0。

⽽ARI指数就可通过利⽤个随机聚类情况下的RI(即E[RI])来解决这个问题。

2)内部指标:该指标直接由考察聚类结果⽽得到的,并不利⽤任何参考模型 DB指数:它刻画的是,给定两个簇,每个簇样本之间平均值之和⽐上两个簇的中⼼点之间的距离作为作为度量。

然后考察该度量对所有簇的平均值。

显然DBI越⼩越好。

如果每个簇样本之间的平均值越⼩(即簇内样本距离都很近),则DBI越⼩;如果簇间中⼼点的距离越⼤(即簇间样本距离相互越远),则 DBI越⼩ Dunn指数:它刻画的是任意两个簇之间最近的距离的最⼩值,除以任意⼀个簇内距离最远的两个点的距离的最⼤值。

emd python代码EMD(经验模态分解)是一种信号处理技术,在Python中可以使用PyEMD库实现。

该库提供了几种不同的EMD方法,如标准EMD、快速EMD和可逆EMD等。

以下是使用PyEMD库实现标准EMD的示例代码: ```pythonfrom PyEMD import EMDimport numpy as np# 构造测试信号t = np.linspace(0, 1, 1000)s = np.sin(5*np.pi*t) + np.sin(10*np.pi*t) +np.sin(20*np.pi*t)# 初始化EMD对象emd = EMD()# 进行EMD分解imfs = emd(s)# 绘制分解结果import matplotlib.pyplot as pltplt.figure(figsize=(10, 6))plt.subplot(len(imfs)+1, 1, 1)plt.plot(t, s, 'k')plt.title('Original Signal')for i, imf in enumerate(imfs):plt.subplot(len(imfs)+1, 1, i+2)plt.plot(t, imf, 'g')plt.title('IMF {}'.format(i+1))plt.tight_layout()plt.show()```以上代码首先构造了一个由三个正弦波叠加而成的测试信号,然后使用PyEMD库的EMD对象对其进行EMD分解,并将分解结果绘制出来。

最终的图像中,第一行为原始信号,接下来的每一行为一个IMF 分量。

EMD经验模态分解MATLAB代码介绍在信号处理领域中,经验模态分解(Empirical Mode Decomposition,简称EMD)是一种用于将非平稳信号分解为一组固有模态函数(IMF)的方法。

EMD方法由黄俊杰于1998年提出,其具有局部性、自适应和数据驱动的特点,可以应用于多种非平稳信号的分析和处理。

本文将详细介绍EMD方法的原理,并提供基于MATLAB的代码实现。

EMD方法原理EMD方法基于信号自身的局部特征进行分解,主要包括以下步骤:1.首先,将待分解的信号进行去趋势处理,以消除信号的整体趋势;2.然后,寻找信号中的局部极大值点和局部极小值点,根据这些极值点构造上下包络线;3.在上下包络线之间找到局部平均线,作为当前信号的第一个固有模态函数(IMF1);4.将IMF1从原始信号中减去,得到一个新的信号,重复上述步骤直至剩余信号无法再分解。

MATLAB实现EMD方法基于MATLAB,我们可以使用以下代码实现EMD方法:function IMF = EMD(signal)IMF = []; % 存储固有模态函数while isIMF(signal) % 判断是否是IMF[upper_env, lower_env] = envelope(signal); % 计算上下包络线mean_env = (upper_env + lower_env) / 2; % 计算局部平均线IMF = [IMF, signal - mean_env]; % 存储当前IMFsignal = signal - mean_env; % 减去当前IMFif sum(abs(signal)) < 1e-6 % 剩余信号是否已经无法再分解IMF = [IMF, signal]; % 存储最后的趋势项break;endendendfunction flag = isIMF(signal)min_num = 3; % 判断是否是IMF所需的极大值和极小值点的最小数量max_num = 7; % 判断是否是IMF所需的过零点的最大数量extrema_num = length(find(diff(gradient(signal)) >= 0)); % 计算极大值和极小值点的数量zero_num = length(find(signal(1:end-1) .* signal(2:end) < 0)); % 计算过零点的数量flag = (extrema_num >= min_num && extrema_num <= max_num && zero_num == 0); % 判断是否是IMFend使用示例下面我们使用一个示例信号来演示EMD方法的使用:t = linspace(0, 1, 1000);signal = sin(20 * t.^2) + cos(10 * t.^3); % 待分解信号IMF = EMD(signal); % 进行信号分解figure;subplot(length(IMF) + 1, 1, 1);plot(t, signal);title('原始信号');for i = 1:length(IMF)subplot(length(IMF) + 1, 1, i + 1);plot(t, IMF(i, :));title(['IMF', num2str(i)]);end运行以上代码,我们可以得到原始信号及其分解后的IMF部分如下图所示:结论本文介绍了EMD经验模态分解方法的原理,并提供了基于MATLAB的代码实现。

(完整版)EMD方法编辑整理:尊敬的读者朋友们:这里是精品文档编辑中心,本文档内容是由我和我的同事精心编辑整理后发布的,发布之前我们对文中内容进行仔细校对,但是难免会有疏漏的地方,但是任然希望((完整版)EMD方法)的内容能够给您的工作和学习带来便利。

同时也真诚的希望收到您的建议和反馈,这将是我们进步的源泉,前进的动力。

本文可编辑可修改,如果觉得对您有帮助请收藏以便随时查阅,最后祝您生活愉快业绩进步,以下为(完整版)EMD方法的全部内容。

(完整版)EMD方法编辑整理:张嬗雒老师尊敬的读者朋友们:这里是精品文档编辑中心,本文档内容是由我和我的同事精心编辑整理后发布到文库,发布之前我们对文中内容进行仔细校对,但是难免会有疏漏的地方,但是我们任然希望(完整版)EMD方法这篇文档能够给您的工作和学习带来便利。

同时我们也真诚的希望收到您的建议和反馈到下面的留言区,这将是我们进步的源泉,前进的动力.本文可编辑可修改,如果觉得对您有帮助请下载收藏以便随时查阅,最后祝您生活愉快业绩进步,以下为 <(完整版)EMD方法〉这篇文档的全部内容。

经验模态分解(Empirical Mode Decomposition,简称EMD)特点:1。

适合于分析非线性、非平稳信号序列,具有很高的信噪比2. 依据数据自身的时间尺度特征来进行信号分解, 无须预先设定任何基函数,在理论上可以应用于任何类型的信号的分解EMD方法假设任何信号都由不同的本征模态函数(IMF)组成,每个IMF可以是线性的,也可以是非线性的,IMF分量必须满足下面两个条件:一是其极值点个数和过零点数相同或最多相差一个,二是其上下包络关于时间轴局部对称.这样任何一个信号就可以分解为有限个IMF之和。

EMD分解过程基于以下假设:(1)信号最少有一个极大值和一个极小值;(2)时域特性由极值间隔决定;(3)如果数据序列完全缺乏极值但是仅包含拐点,那么它也可通过求导一次或多次来表示极值点,而最终结果可以由这些成分求积分来获得。

主题:EMD算法Python实现

一、介绍EMD算法的概念

1. EMD算法全称为Earth Mover's Distance,中文意为“地球移动距离”,是一种用来衡量两个分布之间的相似性的算法。

2. EMD算法最早由Y. Rubner等人在1998年提出,是一种基于距离度量的非线性的分布对齐方法。

3. EMD算法被广泛应用于图像处理、信号处理、文本分析等领域,具有很好的实际应用价值。

4. EMD算法的核心思想是通过将一个分布转换为另一个分布的最小代价来计算两个分布之间的距离。

二、EMD算法Python实现的基本原理

1. EMD算法的实现需要解决一个最小化问题,即寻找两个分布之间的最小代价。

2. 在Python中,可以使用scipy包中的optimize模块来实现EMD算法,该模块提供了优化算法的实现,可以直接调用进行分布对齐计算。

3. EMD算法的实现可以分为以下几个步骤:

1)将两个分布表示为柱状图;

2)计算每个柱状图之间的距离矩阵;

3)使用optimize模块中的线性规划函数来求解最小代价;

4)根据求解结果得到两个分布之间的EMD距离。

三、EMD算法Python实现的具体步骤

1. 导入必要的Python库

import numpy as np

from scipy.optimize import linear_sum_assignment

2. 定义两个分布

distribution1 = np.array([0.3, 0.5, 0.2])

distribution2 = np.array([0.4, 0.4, 0.2])

3. 计算距离矩阵

distance_matrix = np.zeros((len(distribution1),

len(distribution2)))

for i in range(len(distribution1)):

for j in range(len(distribution2)):

distance_matrix[i][j] = abs(i - j)

4. 使用线性规划函数求解最小代价

row_ind, col_ind = linear_sum_assignment(distance_matrix)

5. 根据求解结果计算EMD距离

emd_distance = sum([distance_matrix[row_ind[i]][col_ind[i]] * distribution1[row_ind[i]] for i in range(len(row_ind))])

四、实例演示

假设有两个分布分别为distribution1 = [0.3, 0.5, 0.2]和distribution2 = [0.4, 0.4, 0.2],我们可以利用上述Python实现的EMD算法来计算它们之间的距禿:

distribution1 = np.array([0.3, 0.5, 0.2])

distribution2 = np.array([0.4, 0.4, 0.2])

distance_matrix = np.zeros((len(distribution1),

len(distribution2)))

for i in range(len(distribution1)):

for j in range(len(distribution2)):

distance_matrix[i][j] = abs(i - j)

row_ind, col_ind = linear_sum_assignment(distance_matrix) emd_distance = sum([distance_matrix[row_ind[i]][col_ind[i]] * distribution1[row_ind[i]] for i in range(len(row_ind))])

print("The EMD distance between distribution1 and distribution2 is:", emd_distance)

五、总结

1. EMD算法是一种用于计算两个分布之间距离的算法,具有广泛的应用价值。

2. 在Python中,可以利用scipy包中的optimize模块来实现EMD算法。

3. EMD算法的实现可以分为计算距离矩阵、求解最小代价和计算EMD距离等步骤。

4. 通过Python实现的示例演示,可以清晰地看到EMD算法的计

算过程和结果。

六、参考文献

1. Y. Rubner, C. Tomasi, and L. J. Guibas, "The Earth Mover's Distance as a Metric for Image Retrieval," International Journal

of Computer Vision, 2000.

2. McFee, B., Lanckriet, G. R. (2011). "The natural language of musical emotion." Music perception, 28(3), 307-319.

以上是关于EMD算法Python实现的介绍,通过本文的学习,相信读者已经对EMD算法有了更深入的了解。

希望本文可以对大家有所帮助。