模式识别-作业4

- 格式:doc

- 大小:295.57 KB

- 文档页数:4

模式识别习题及答案第⼀章绪论1.什么是模式具体事物所具有的信息。

模式所指的不是事物本⾝,⽽是我们从事物中获得的___信息__。

2.模式识别的定义让计算机来判断事物。

3.模式识别系统主要由哪些部分组成数据获取—预处理—特征提取与选择—分类器设计/ 分类决策。

第⼆章贝叶斯决策理论1.最⼩错误率贝叶斯决策过程答:已知先验概率,类条件概率。

利⽤贝叶斯公式得到后验概率。

根据后验概率⼤⼩进⾏决策分析。

2.最⼩错误率贝叶斯分类器设计过程答:根据训练数据求出先验概率类条件概率分布利⽤贝叶斯公式得到后验概率如果输⼊待测样本X ,计算X 的后验概率根据后验概率⼤⼩进⾏分类决策分析。

3.最⼩错误率贝叶斯决策规则有哪⼏种常⽤的表⽰形式答:4.贝叶斯决策为什么称为最⼩错误率贝叶斯决策答:最⼩错误率Bayes 决策使得每个观测值下的条件错误率最⼩因⽽保证了(平均)错误率最⼩。

Bayes 决策是最优决策:即,能使决策错误率最⼩。

5.贝叶斯决策是由先验概率和(类条件概率)概率,推导(后验概率)概率,然后利⽤这个概率进⾏决策。

6.利⽤乘法法则和全概率公式证明贝叶斯公式答:∑====m j Aj p Aj B p B p A p A B p B p B A p AB p 1)()|()()()|()()|()(所以推出贝叶斯公式7.朴素贝叶斯⽅法的条件独⽴假设是(P(x| ωi) =P(x1, x2, …, xn | ωi)= P(x1| ωi) P(x2| ωi)… P(xn| ωi))8.怎样利⽤朴素贝叶斯⽅法获得各个属性的类条件概率分布答:假设各属性独⽴,P(x| ωi) =P(x1, x2, …, xn | ωi) = P(x1| ωi) P(x2| ωi)… P(xn| ωi)后验概率:P(ωi|x) = P(ωi) P(x1| ωi) P(x2| ωi)… P(xn| ωi)类别清晰的直接分类算,如果是数据连续的,假设属性服从正态分布,算出每个类的均值⽅差,最后得到类条件概率分布。

《模式识别》课程2019年度大作业注意事项:(请务必详细阅读所有注意事项)1.本作业发布时间2019.5.5,交作业时间:2018.5.30日第一节课下课后,第二节课上课前(即上午9点整)。

与平时作业不同,不允许迟交,迟交则成绩以0分计。

2.与平时作业不同,大作业只有研究生同学完成,保送本系的本科同学也需要完成,但其他本科生无需完成。

请在作业的开始部分写上姓名、学号,缺少该信息的,本次作业总分扣除10分。

如果是已经完成保送手续,先修研究生课程的本校本科生,请一定每次作业在姓名后加注“(本科保送)”,否则无法拿到学分。

3.与平时作业不同,作业评分以电子版为准。

需要提交代码,具体的提交要求请仔细阅读作业说明。

总体文件大小不超过5MB(可以提交压缩文件)。

上传地址为/。

初始用户名和密码为学号。

研究生学号以MP18开头的暂时无法登陆,可将电子版email给助教(wangguohua@, yik@),其余同学务必使用网站系统上传。

是否迟交以cslabcms系统的时间戳或电子邮件的时间戳为准。

大作业:1.仔细阅读以下网页的内容(/weixs/project/DDT/DDT.html),包括其中提供链接的英文论文,理解DDT方法的运行步骤。

2.自行实现DDT算法。

实现时可以参考上述网页提供的Matlab代码以加深对DDT方法的理解,但是不可以使用MatConvNet这一深度学习框架,除此以外的其余任意深度学习软件框架都可以使用。

3.如尚未有深度学习、CNN的编程经验,请搜索网络资源完成自学。

4.如有可供使用的GPU加速卡资源,可以自由使用。

如无这种资源,可在编程中指定使用CPU(即,不使用GPU)来完成计算。

DDT方法的计算量很小,使用CPU也可完成计算。

5.在上述网页提供下载的代码链接里有少量图片可供使用,利用这些图片完成DDT方法的学习,利用可视化技术(参考论文和代码)直观考察DDT方法的效果。

6.请提交完成上述任务的文档和代码,需提交的内容如下:a.说明文档:自行组织文档的格式,保证文档的内容能让助教清晰地理解你的代码运行环境、实现的主要思路、你通过实现并运行代码后对DDT方法的理解等。

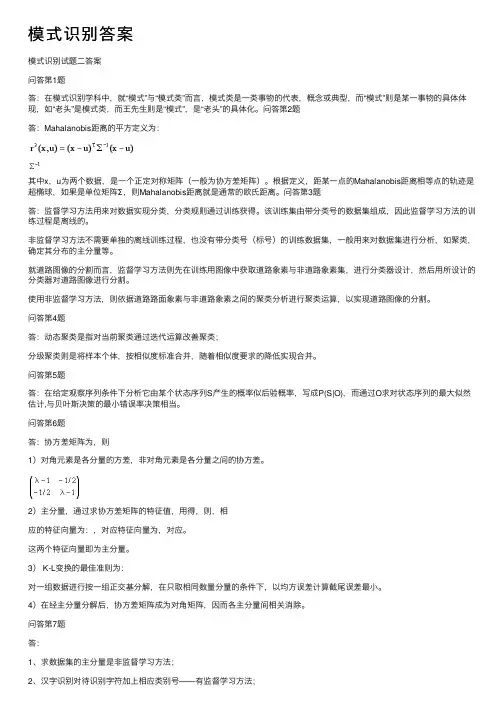

模式识别答案模式识别试题⼆答案问答第1题答:在模式识别学科中,就“模式”与“模式类”⽽⾔,模式类是⼀类事物的代表,概念或典型,⽽“模式”则是某⼀事物的具体体现,如“⽼头”是模式类,⽽王先⽣则是“模式”,是“⽼头”的具体化。

问答第2题答:Mahalanobis距离的平⽅定义为:其中x,u为两个数据,是⼀个正定对称矩阵(⼀般为协⽅差矩阵)。

根据定义,距某⼀点的Mahalanobis距离相等点的轨迹是超椭球,如果是单位矩阵Σ,则Mahalanobis距离就是通常的欧⽒距离。

问答第3题答:监督学习⽅法⽤来对数据实现分类,分类规则通过训练获得。

该训练集由带分类号的数据集组成,因此监督学习⽅法的训练过程是离线的。

⾮监督学习⽅法不需要单独的离线训练过程,也没有带分类号(标号)的训练数据集,⼀般⽤来对数据集进⾏分析,如聚类,确定其分布的主分量等。

就道路图像的分割⽽⾔,监督学习⽅法则先在训练⽤图像中获取道路象素与⾮道路象素集,进⾏分类器设计,然后⽤所设计的分类器对道路图像进⾏分割。

使⽤⾮监督学习⽅法,则依据道路路⾯象素与⾮道路象素之间的聚类分析进⾏聚类运算,以实现道路图像的分割。

问答第4题答:动态聚类是指对当前聚类通过迭代运算改善聚类;分级聚类则是将样本个体,按相似度标准合并,随着相似度要求的降低实现合并。

问答第5题答:在给定观察序列条件下分析它由某个状态序列S产⽣的概率似后验概率,写成P(S|O),⽽通过O求对状态序列的最⼤似然估计,与贝叶斯决策的最⼩错误率决策相当。

问答第6题答:协⽅差矩阵为,则1)对⾓元素是各分量的⽅差,⾮对⾓元素是各分量之间的协⽅差。

2)主分量,通过求协⽅差矩阵的特征值,⽤得,则,相应的特征向量为:,对应特征向量为,对应。

这两个特征向量即为主分量。

3) K-L变换的最佳准则为:对⼀组数据进⾏按⼀组正交基分解,在只取相同数量分量的条件下,以均⽅误差计算截尾误差最⼩。

4)在经主分量分解后,协⽅差矩阵成为对⾓矩阵,因⽽各主分量间相关消除。

模式识别大作业模糊聚类算法模糊聚类算法概述模糊聚类算法是一种基于函数最优方法的聚类算法,使用微积分计算技术求最优代价函数。

在基于概率算法的聚类方法中将使用概率密度函数,为此要假定合适的模型,模糊聚类算法的向量可以同时属于多个聚类,从而摆脱上述问题。

在模糊聚类算法中,定义了向量与聚类之间的近邻函数,并且聚类中向量的隶属度由隶属函数集合提供。

对模糊方法而言,在不同聚类中的向量隶属函数值是相互关联的。

硬聚类可以看成是模糊聚类方法的一个特例。

模糊聚类算法的分类模糊聚类分析算法大致可分为三类[4]:1)分类数不定,根据不同要求对事物进行动态聚类,此类方法是基于模糊等价矩阵聚类的,称为模糊等价矩阵动态聚类分析法。

2)分类数给定,寻找出对事物的最佳分析方案,此类方法是基于目标函数聚类的,称为模c均值聚类。

3)在摄动有意义的情况下,根据模糊相似矩阵聚类,此类方法称为基于摄动的模糊聚类分析法。

模糊c均值(FCM)聚类算法算法描述模糊c均值聚类算法的步骤还是比较简单的,模糊c均值聚类(FCM),即众所周知的模糊ISODATA,是用隶属度确定每个数据点属于某个聚类的程度的一种聚类算法。

1973年,Bezdek提出了该算法,作为早期硬c均值聚类(HCM)方法的一种改进。

FCM把n个向量x i(i=1,2,…,n)分为c个模糊组,并求每组的聚类中心,使得非相似性指标的价值函数达到最小。

FCM与HCM的主要区别在于FCM用模糊划分,使得每个给定数据点用值在0,1间的隶属度来确定其属于各个组的程度。

与引入模糊划分相适应,隶属矩阵U允许有取值在0,1间的元素。

不过,加上归一化规定,一个数据集的隶属度的和总等于1:∑==∀=ciijnju1,...,1,1(3.1)那么,FCM的价值函数(或目标函数)就是:∑∑∑====c i njijm ij c i i c d u J c c U J 1211),...,,(, (3.2)这里u ij 介于0,1间;c i 为模糊组I 的聚类中心,d ij =||c i -x j ||为第I 个聚类中心与第j 个数据点间的欧几里德距离;且[)∞∈,1m 是一个加权指数。

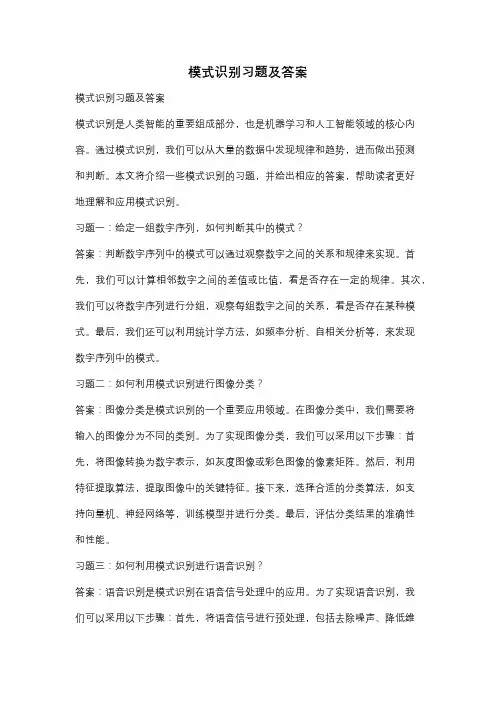

模式识别习题及答案模式识别习题及答案模式识别是人类智能的重要组成部分,也是机器学习和人工智能领域的核心内容。

通过模式识别,我们可以从大量的数据中发现规律和趋势,进而做出预测和判断。

本文将介绍一些模式识别的习题,并给出相应的答案,帮助读者更好地理解和应用模式识别。

习题一:给定一组数字序列,如何判断其中的模式?答案:判断数字序列中的模式可以通过观察数字之间的关系和规律来实现。

首先,我们可以计算相邻数字之间的差值或比值,看是否存在一定的规律。

其次,我们可以将数字序列进行分组,观察每组数字之间的关系,看是否存在某种模式。

最后,我们还可以利用统计学方法,如频率分析、自相关分析等,来发现数字序列中的模式。

习题二:如何利用模式识别进行图像分类?答案:图像分类是模式识别的一个重要应用领域。

在图像分类中,我们需要将输入的图像分为不同的类别。

为了实现图像分类,我们可以采用以下步骤:首先,将图像转换为数字表示,如灰度图像或彩色图像的像素矩阵。

然后,利用特征提取算法,提取图像中的关键特征。

接下来,选择合适的分类算法,如支持向量机、神经网络等,训练模型并进行分类。

最后,评估分类结果的准确性和性能。

习题三:如何利用模式识别进行语音识别?答案:语音识别是模式识别在语音信号处理中的应用。

为了实现语音识别,我们可以采用以下步骤:首先,将语音信号进行预处理,包括去除噪声、降低维度等。

然后,利用特征提取算法,提取语音信号中的关键特征,如梅尔频率倒谱系数(MFCC)。

接下来,选择合适的分类算法,如隐马尔可夫模型(HMM)、深度神经网络(DNN)等,训练模型并进行语音识别。

最后,评估识别结果的准确性和性能。

习题四:如何利用模式识别进行时间序列预测?答案:时间序列预测是模式识别在时间序列分析中的应用。

为了实现时间序列预测,我们可以采用以下步骤:首先,对时间序列进行平稳性检验,确保序列的均值和方差不随时间变化。

然后,利用滑动窗口或滚动平均等方法,将时间序列划分为训练集和测试集。

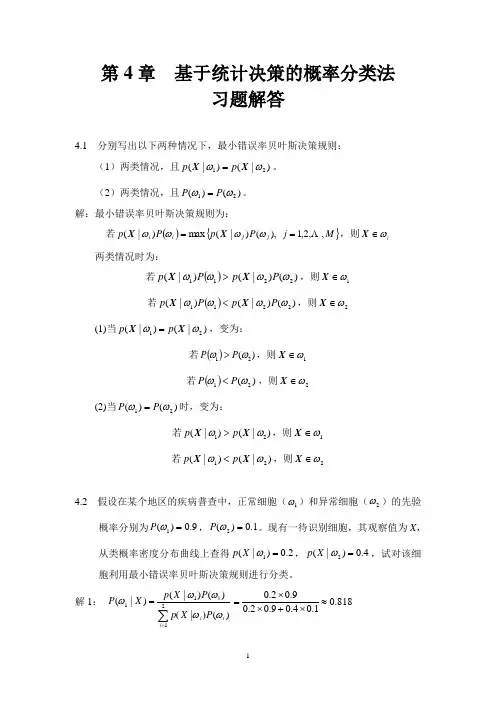

第4章 基于统计决策的概率分类法习题解答4.1 分别写出以下两种情况下,最小错误率贝叶斯决策规则:(1)两类情况,且)|()|(21ωωX X p p =。

(2)两类情况,且)()(21ωωP P =。

解:最小错误率贝叶斯决策规则为:若(){}M j P p P p j j i i ,,2,1),()|(max )|( ==ωωωωX X ,则i ω∈X两类情况时为:若())()|()|(2211ωωωωP p P p X X >,则1ω∈X 若())()|()|(2211ωωωωP p P p X X <,则2ω∈X(1)当)|()|(21ωωX X p p =,变为:若())(21ωωP P >,则1ω∈X 若())(21ωωP P <,则2ω∈X(2)当)()(21ωωP P =时,变为:若)|()|(21ωωX X p p >,则1ω∈X 若)|()|(21ωωX X p p <,则2ω∈X4.2 假设在某个地区的疾病普查中,正常细胞(1ω)和异常细胞(2ω)的先验概率分别为9.0)(1=ωP ,1.0)(2=ωP 。

现有一待识别细胞,其观察值为X ,从类概率密度分布曲线上查得2.0)|(1=ωX p ,4.0)|(2=ωX p ,试对该细胞利用最小错误率贝叶斯决策规则进行分类。

解1: ∑=1)(=2111)(|)()|()|(i iiP X p P X p X P ωωωωω818.01.04.09.02.09.02.0≈⨯+⨯⨯=182.01.04.09.02.01.04.0)|(2≈⨯+⨯⨯=X P ω)|()|(21X P X P ωω> 1ω∈∴X (正常)解2:()18.09.02.0)|(11=⨯=ωωP X p ,()04.01.04.0)|(22=⨯=ωωP X p())()|()|(2211ωωωωP X p P X p > 1ω∈∴X (正常)4.3 设以下模式类具有正态概率密度函数:1ω:T 1]0,0[=X ,T 2]0,2[=X ,[]T 32,2=X ,T 4]2,0[=X 2ω:[]T 54,4=X ,[]T 64,6=X ,[]T 76,6=X ,[]T 86,4=X(1)设5.0)()(21==ωωP P ,求两类模式之间贝叶斯判别界面的方程式。

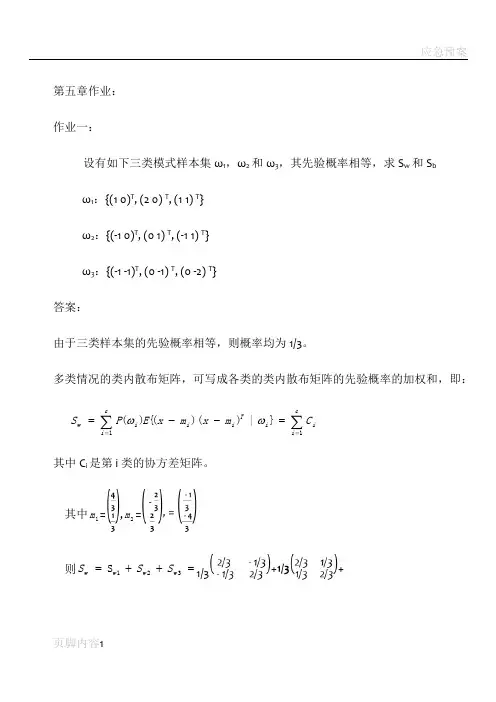

第五章作业: 作业一:设有如下三类模式样本集ω1,ω2和ω3,其先验概率相等,求S w 和S bω1:{(1 0)T , (2 0) T , (1 1) T } ω2:{(-1 0)T , (0 1) T , (-1 1) T }ω3:{(-1 -1)T , (0 -1) T , (0 -2) T }答案:由于三类样本集的先验概率相等,则概率均为1/3。

多类情况的类内散布矩阵,可写成各类的类内散布矩阵的先验概率的加权和,即:∑∑===--=cii i Ti i cii w C m x m x E P S 11}|))(({)(ωω 其中C i 是第i 类的协方差矩阵。

其中1m =,2m =则=++=321S w w w w S S S 1/3++=类间散布矩阵常写成:Ti i cii b m m m m P S ))(()(001--=∑=ω其中,m 0为多类模式(如共有c 类)分布的总体均值向量,即:c i m P x E m i cii i ,,2,1,,)(}{10 =∀==∑=ωω0m ==则Ti i cii b m m m m P S ))(()(001--=∑=ω=++=作业二:设有如下两类样本集,其出现的概率相等:ω1:{(0 0 0)T , (1 0 0) T ,(1 0 1) T , (1 1 0) T }ω2:{(0 0 1)T , (0 1 0) T ,(0 1 1) T , (1 1 1) T }用K-L 变换,分别把特征空间维数降到二维和一维,并画出样本在该空间中的位置。

答案:=+=∑∑==iiN jj N jj x x m 1211)4141(21将所有这些样本的各分量都减去0.5,便可以将所有这些样本的均值移到原点,即(0,0,0)点。

新得到的两类样本集为:ω1:{(-0.5-0.5-0.5)T , (0.5-0.5-0.5) T ,(0.5-0.50.5) T , (0.50.5-0.5) T }ω2:{(-0.5-0.50.5)T , (-0.50.5-0.5) T ,(-0.50.50.5) T , (0.50.50.5) T }I 25.041214121}{)(4122411121=⎥⎦⎤⎢⎣⎡+⎥⎦⎤⎢⎣⎡==∑∑∑===j T j j j Tjj i Ti x x x x xx E P R ω解特征值方程|R-λI|=0,求R 的特征值。

模式识别大作业一.K均值聚类(必做,40分)1.K均值聚类的基本思想以及K均值聚类过程的流程图;2.利用K均值聚类对Iris数据进行分类,已知类别总数为3。

给出具体的C语言代码,并加注释。

例如,对于每一个子函数,标注其主要作用,及其所用参数的意义,对程序中定义的一些主要变量,标注其意义;3.给出函数调用关系图,并分析算法的时间复杂度;4.给出程序运行结果,包括分类结果(只要给出相对应的数据的编号即可)以及循环迭代的次数;5.分析K均值聚类的优缺点。

二.贝叶斯分类(必做,40分)1.什么是贝叶斯分类器,其分类的基本思想是什么;2.两类情况下,贝叶斯分类器的判别函数是什么,如何计算得到其判别函数;3.在Matlab下,利用mvnrnd()函数随机生成60个二维样本,分别属于两个类别(一类30个样本点),将这些样本描绘在二维坐标系下,注意特征值取值控制在(-5,5)范围以内;4.用样本的第一个特征作为分类依据将这60个样本进行分类,统计正确分类的百分比,并在二维坐标系下将正确分类的样本点与错误分类的样本点用不同标志(正确分类的样本点用“O”,错误分类的样本点用“X”)画出来;5.用样本的第二个特征作为分类依据将这60个样本再进行分类,统计正确分类的百分比,并在二维坐标系下将正确分类的样本点与错误分类的样本点用不同标志画出来;6.用样本的两个特征作为分类依据将这60个样本进行分类,统计正确分类的百分比,并在二维坐标系下将正确分类的样本点与错误分类的样本点用不同标志画出来;7.分析上述实验的结果。

8.60个随即样本是如何产生的的;给出上述三种情况下的两类均值、方差、协方差矩阵以及判别函数;三.特征选择(选作,15分)1.经过K均值聚类后,Iris数据被分作3类。

从这三类中各选择10个样本点;2.通过特征选择将选出的30个样本点从4维降低为3维,并将它们在三维的坐标系中画出(用Excell);3.在三维的特征空间下,利用这30个样本点设计贝叶斯分类器,然后对这30个样本点利用贝叶斯分类器进行判别分类,给出分类的正确率,分析实验结果,并说明特征选择的依据;。

1=填空题1、模式识别系统的基本构成单元包括:模式采集、特征选择与提取和模式分类。

2、统计模式识别中描述模式的方法一般使用特征矢量;句法模式识别中模式描述方法一般有串、树、网。

3、影响层次聚类算法结果的主要因素有计算模式距离的测度、聚类准则、类间距离门限、预定的类别数目。

4、线性判别函数的正负和数值大小的几何意义是正(负)表示样本点位于判别界面法向量指向的正(负)半空间中;绝对值正比于样本点到判别界面的距离。

5、感知器算法丄。

(1 )只适用于线性可分的情况;(2)线性可分、不可分都适用。

6、在统计模式分类问题中,聂曼-皮尔逊判决准则主要用于某一种判决错误较另一种判决错误更为重愛情况;最小最大判别准则主要用于先验概率未知的情况。

7、“特征个数越多越有利于分类”这种说法正确吗?错误。

特征选择的主要目的是从n个特征中选出最有利于分类的的m个特征(m<n),以降低特征维数。

一般在可分性判据对特征个数具有单调性和(C n m»n )的条件下,可以使用分支定界法以减少计算量。

& 散度Jij越大,说明。

类模式与3j类模式的分布差别越大;当3类模式与(Oj类模式的分布相同时,Jij=_O_.选择题1、影响聚类算法结果的主要因素有(BCD ).A.已知类别的样本质量B.分类准则C.特征选取D.模式相似性测度2、模式识别中,马式距离较之于欧式距离的优点是(CD )。

A.平移不变性B.旋转不变性C.尺度不变性D.考虑了模式的分布3、影响基本K-均值算法的主要因素有(DAB )。

A.样本输入顺序B.模式相似性测度C.聚类准则D.初始类中心的选取4、在统计模式分类问题中,当先验概率未知时,可以使用(BD )。

A.最小损失准则B.最小最大损失准则C.最小误判概率准则D.N-P判决5、散度环是根据(C )构造的可分性判据。

A.先验概率B.后验概率C.类概率密度D.信息燔E.几何距离6、如果以特征向量的相关系数作为模式相似性测度,则影响聚类算法结果的主要因素有(B C )。

1、PCA和LDA的区别?PCA是一种无监督的映射方法,LDA是一种有监督的映射方法。

PCA只是将整组数据映射到最方便表示这组数据的坐标轴上,映射时没有利用任何数据内部的分类信息。

因此,虽然做了PCA后,整组数据在表示上更加方便(降低了维数并将信息损失降到了最低),但在分类上也许会变得更加困难;LDA在增加了分类信息之后,将输入映射到了另外一个坐标轴上,有了这样一个映射,数据之间就变得更易区分了(在低纬上就可以区分,减少了很大的运算量),它的目标是使得类别内的点距离越近越好,类别间的点越远越好。

2、最大似然估计和贝叶斯方法的区别?p(x|X)是概率密度函数,X是给定的训练样本的集合,在哪种情况下,贝叶斯估计接近最大似然估计?最大似然估计把待估的参数看做是确定性的量,只是其取值未知。

利用已知的样本结果,反推最有可能(最大概率)导致这样结果的参数值(模型已知,参数未知)。

贝叶斯估计则是把待估计的参数看成是符合某种先验概率分布的随机变量。

对样本进行观测的过程,把先验概率密度转化为后验概率密度,利用样本的信息修正了对参数的初始估计值。

当训练样本数量趋于无穷的时候,贝叶斯方法将接近最大似然估计。

如果有非常多的训练样本,使得p(x|X)形成一个非常显著的尖峰,而先验概率p(x)又是均匀分布,此时两者的本质是相同的。

3、为什么模拟退火能够逃脱局部极小值?在解空间内随机搜索,遇到较优解就接受,遇到较差解就按一定的概率决定是否接受,这个概率随时间的变化而降低。

实际上模拟退火算法也是贪心算法,只不过它在这个基础上增加了随机因素。

这个随机因素就是:以一定的概率来接受一个比单前解要差的解。

通过这个随机因素使得算法有可能跳出这个局部最优解。

4、最小错误率和最小贝叶斯风险之间的关系?基于最小风险的贝叶斯决策就是基于最小错误率的贝叶斯决策,换言之,可以把基于最小错误率决策看做是基于最小风险决策的一个特例,基于最小风险决策本质上就是对基于最小错误率公式的加权处理。

模式识别第四版Pattern Recognition Fourth EditionSergios Teodoridis / Konstantinos Koutroumbas第1章导论1.1 模式识别重要性1.2 特征、特征向量和分类器1.3 有监督、无监督和半监督学习1.4 MATLAB程序1.5 本书内容安排第2至10章有监督模式识别第2章估计未知概率密度函数的贝叶斯分类技术——重点关注:贝叶斯分类、最小距离、最近邻分类器、朴素贝叶斯分类器、贝叶斯网络。

第3章线性分类器的设计——均方理论的概率、偏差-方差、支持向量机(SVM Support Vector Machines)、线性可分性感知器算法均方和最小二乘法理论第4章非线性分类器的设计——反射传播算法基本原理、Cover定理、径向基函数(RBF Radial Basis Function)网络、非线性支持向量机、决策树、联合分类器第5章特征选择(介绍现有的知名技术)——t检验、发散、Bhattacharrya距离、散布矩阵、(重点)两类的Fisher线性判别方法(Fisher’s linear discriminant method LDA)第6章如何利用正交变换进行特征提取——KL变换、奇异值分解、DFT\DCT\DST\Hadamard\Haar变换、离散小波变换、第7章图像和声音分类中的特征提取一阶和二阶统计特征以及行程长度方法第8章模板匹配动态规划和Viterbi算法(应用于语音识别),相关匹配和可变形模板匹配的基本原理第9章上下文相关分类隐马尔可夫模型,并应用于通信和语音识别第10章系统评估和半监督学习第11章至第16章无监督模式识别第2章基于贝叶斯决策理论的分类器2.1 引言模式识别系统中的分类器设计共三章,这是其中的第1章以特征值的统计概率为基础。

设计分类器是将未知类型的样本分类到最可能的类别中。

现在的任务是定义什么是“最可能”首先要完成的任务是条件概率的计算,而贝叶斯规则条件概率是非常有用的2.2 贝叶斯决策理论BAYES DECISION THEORY概率中的贝叶斯规则P(x)是x的概率密度函数贝叶斯分类规则bayes classification rule结论等价表示为:若先验概率相等,上式可表示为:错误率Pe的计算公式最小化分类错误率Minimizing the Classification Error Probability:要证明贝叶斯分类器在最小化分类错误率上是最优的the Bayesian classifier is optimal with respect to minimizing the classification error probability.最小平均风险Minimizing the Average Risk用惩罚Penalty来衡量每一个错误it is more appropriate to assign a penalty term to weigh each error2.3 判别函数和决策面下面的主要讨论在高斯密度函数的情况下,与贝叶斯分类决策面有关的情况。

第五章作业: 作业一:

设有如下三类模式样本集ω1,ω2和ω3,其先验概率相等,求S w 和S b

ω1:{(1 0)T , (2 0) T , (1 1) T }

ω2:{(-1 0)T , (0 1) T , (-1 1) T } ω3:{(-1 -1)T , (0 -1) T , (0 -2) T } 答案:

由于三类样本集的先验概率相等,则概率均为1/3。

多类情况的类内散布矩阵,可写成各类的类内散布矩阵的先验概率的加权和,即:

∑∑===

--=

c

i

i i T

i i c

i

i w C m x m x E P S 1

1

}|))(({)(ωω 其中C i 是第i 类的协方差矩阵。

其中1m =

,2m =

则=++=321S w w w w S S S 1/3

+

+

=

类间散布矩阵常写成:

T

i i c

i

i b m m m m P S ))(()(001

--=

∑=ω

其中,m 0为多类模式(如共有c 类)分布的总体均值向量,即:

c i m P x E m i c

i

i i ,,2,1,,)(}{1

0K =∀=

=∑=ωω

0m =

=

则

T

i i c

i

i b m m m m P S ))(()(001

--=

∑=ω=++

=

作业二:

设有如下两类样本集,其出现的概率相等:

ω1:{(0 0 0)T , (1 0 0) T ,

(1 0 1) T , (1 1 0) T } ω2:{(0 0 1)T , (0 1 0) T , (0 1 1) T , (1 1 1) T }

用K-L 变换,分别把特征空间维数降到二维和一维,并画出样本在该空间中的位置。

答案:

=+=∑∑==i

i

N j

j N j

j x x m 1

21

1)4

1

4

1

(

21

将所有这些样本的各分量都减去0.5,便可以将所有这些样本

的均值移到原点,即(0,0,0)点。

新得到的两类样本集为:

ω1:{(-0.5-0.5-0.5)T , (0.5-0.5-0.5) T ,

(0.5-0.50.5) T , (0.50.5-0.5) T } ω2:{(-0.5-0.50.5)T , (-0.50.5-0.5) T , (-0.50.50.5) T , (0.50.50.5) T }

I 25.04

1214121

}{)(4

1

224

1112

1

=⎥⎦

⎤

⎢⎣⎡+⎥⎦⎤⎢⎣⎡=

=∑∑∑===j T j j j T

j

j i T

i x x x x xx E P R ω

解特征值方程|R-λI|=0,求R 的特征值。

求得特征值λ1=0.25,λ2=0.25,λ3=0.25 其对应的特征向量可由R Фi =λi Фi 求得:

⎪⎪⎪⎭⎫ ⎝⎛=Φ0011,⎪⎪⎪⎭⎫ ⎝⎛=Φ0102,⎪⎪⎪⎭

⎫ ⎝⎛=Φ1003

1、将其降到二维的情况:

选λ1和λ2对应的变换向量作为变换矩阵,由y=ФT x 得变换后的二维模式特征为:

ω1:{(-0.5-0.5)T , (0.5-0.5) T , (0.5-0.5) T , (0.50.5) T } ω2:{(-0.5-0.5)T , (-0.50.5) T , (-0.50.5) T , (0.50.5) T } 2、将其降到一维的情况:

选λ1对应的变换向量作为变换矩阵,由y=ФT x 得变换后的一维模式特征为:

{}0.5,0.5,0.5,0.5:1-ω{}0.5,0.5,0.5,0.5:2---ω。