回归分析操作方法

- 格式:docx

- 大小:179.96 KB

- 文档页数:3

回归分析的基本步骤回归分析是一种用来探究变量之间关系的统计方法。

通过回归分析,可以确定自变量对因变量的影响程度,并用回归方程来预测因变量的值。

本文将介绍回归分析的基本步骤,包括数据收集与准备、回归模型的选择、模型拟合以及模型评估等。

数据收集与准备在进行回归分析之前,首先需要收集与问题相关的数据。

这些数据可以通过实验、观测或问卷调查等方式获得。

在数据收集过程中需要注意保证数据的准确性和完整性,以及避免数据的缺失。

收集到数据后,还需要进行数据的预处理。

这包括数据的清洗和转换。

数据清洗主要是去除异常值和错误数据。

数据转换可以包括对变量进行标准化、对非线性关系进行变量转换等操作,以使数据符合回归分析的假设。

回归模型的选择在回归分析中,需要选择适当的回归模型来描述自变量和因变量之间的关系。

常见的回归模型包括线性回归模型、多项式回归模型、指数回归模型等等。

在选择回归模型时,需要考虑以下几点:1.因变量和自变量之间的关系类型:线性还是非线性关系;2.自变量之间是否存在多重共线性:即自变量之间是否存在相关性;3.应用领域的特点:不同领域对变量之间关系的要求不同。

模型拟合选择好回归模型后,需要对模型进行拟合。

拟合模型的目标是通过最小化残差平方和来找到最优的回归系数。

常用的拟合方法有最小二乘法和最大似然法。

最小二乘法是通过最小化实际观测值与回归模型预测值之间的差异来确定回归系数。

最大似然法是基于观测数据的概率分布来估计模型参数。

两种方法都可以得到相似的结果,选择哪种方法取决于实际问题和数据的性质。

模型评估在模型拟合完成后,需要对模型进行评估。

评估模型的好坏可以通过各种统计指标来衡量,如决定系数(R-squared)、均方差(MSE)等。

决定系数是指模型能够解释因变量变异性的比例,其取值范围为0到1。

值越接近1,说明模型对数据的拟合程度越好。

均方差是指观测值与模型预测值之间的平均偏差。

均方差越小,说明模型的预测精度越高。

你应该要掌握的7种回归分析⽅法你应该要掌握的7种回归分析⽅法标签:机器学习回归分析2015-08-24 11:29 4749⼈阅读评论(0) 收藏举报分类:机器学习(5)⽬录(?)[+]转载:原⽂链接:7 Types of Regression Techniques you should know!(译者/刘帝伟审校/刘翔宇、朱正贵责编/周建丁)什么是回归分析?回归分析是⼀种预测性的建模技术,它研究的是因变量(⽬标)和⾃变量(预测器)之间的关系。

这种技术通常⽤于预测分析,时间序列模型以及发现变量之间的因果关系。

例如,司机的鲁莽驾驶与道路交通事故数量之间的关系,最好的研究⽅法就是回归。

回归分析是建模和分析数据的重要⼯具。

在这⾥,我们使⽤曲线/线来拟合这些数据点,在这种⽅式下,从曲线或线到数据点的距离差异最⼩。

我会在接下来的部分详细解释这⼀点。

我们为什么使⽤回归分析?如上所述,回归分析估计了两个或多个变量之间的关系。

下⾯,让我们举⼀个简单的例⼦来理解它:⽐如说,在当前的经济条件下,你要估计⼀家公司的销售额增长情况。

现在,你有公司最新的数据,这些数据显⽰出销售额增长⼤约是经济增长的2.5倍。

那么使⽤回归分析,我们就可以根据当前和过去的信息来预测未来公司的销售情况。

使⽤回归分析的好处良多。

具体如下:1.它表明⾃变量和因变量之间的显著关系;2.它表明多个⾃变量对⼀个因变量的影响强度。

回归分析也允许我们去⽐较那些衡量不同尺度的变量之间的相互影响,如价格变动与促销活动数量之间联系。

这些有利于帮助市场研究⼈员,数据分析⼈员以及数据科学家排除并估计出⼀组最佳的变量,⽤来构建预测模型。

我们有多少种回归技术?有各种各样的回归技术⽤于预测。

这些技术主要有三个度量(⾃变量的个数,因变量的类型以及回归线的形状)。

我们将在下⾯的部分详细讨论它们。

对于那些有创意的⼈,如果你觉得有必要使⽤上⾯这些参数的⼀个组合,你甚⾄可以创造出⼀个没有被使⽤过的回归模型。

统计学中的回归分析方法回归分析是统计学中经常被使用的一种方法,它用于研究两个或多个变量之间的关系。

通过回归分析,我们可以预测一个变量如何随着其他变量的变化而变化,或者确定变量之间的因果关系。

在本文中,我将介绍几种常见的回归分析方法,帮助读者更好地理解和应用这一统计学方法。

一、简单线性回归分析简单线性回归分析是回归分析的最基本形式。

它适用于只涉及两个变量的场景,并且假设变量之间的关系可以用一条直线来描述。

在进行简单线性回归分析时,我们需要收集一组观测数据,并使用最小二乘法来拟合直线模型,从而得到最优的回归方程。

通过该方程,我们可以根据自变量的取值预测因变量的值,或者评估自变量对因变量的影响程度。

二、多元线性回归分析多元线性回归分析扩展了简单线性回归模型,允许多个自变量同时对因变量进行解释和预测。

当我们要考察一个因变量与多个自变量之间的复杂关系时,多元线性回归分析是一种有力的工具。

在进行多元线性回归分析时,我们需收集多组观测数据,并建立一个包含多个自变量的回归模型。

通过拟合最优的回归方程,我们可以分析每个自变量对因变量的影响,进一步理解变量之间的关系。

三、逻辑回归分析逻辑回归分析是回归分析的一种特殊形式,用于处理因变量为二元变量(如真与假)时的回归问题。

逻辑回归分析的目标是根据自变量的取值,对因变量的分类进行概率预测。

逻辑回归模型是通过将线性回归模型的输出映射到一个概率区间(通常为0到1)来实现的。

逻辑回归在实际应用中非常广泛,如市场预测、医学诊断等领域。

四、岭回归分析岭回归是一种用于解决多重共线性问题的回归分析方法。

多重共线性指多个自变量之间存在高度相关性的情况,这会导致回归分析结果不稳定。

岭回归通过在最小二乘法的基础上加入一个惩罚项,使得回归系数的估计更加稳定。

岭回归分析的目标是获得一个优化的回归方程,从而在存在多重共线性的情况下提高预测准确度。

五、非线性回归分析在某些情况下,变量之间的关系不是线性的,而是呈现出曲线或其他非线性形态。

回归模型操作方法

回归模型是一种用来预测连续因变量的统计模型。

常见的回归模型有线性回归、多项式回归、岭回归、Lasso回归等。

下面介绍回归模型的操作方法:

1. 数据准备:首先需要准备好回归分析所需的数据。

数据包括自变量和因变量,自变量是用来预测因变量的变量,因变量是需要被预测的变量。

2. 模型选择:选择适合问题的回归模型。

根据问题的特点和数据的分布选择合适的回归模型,如线性回归模型适用于自变量与因变量之间存在线性关系的情况,多项式回归模型适用于自变量与因变量之间存在非线性关系的情况。

3. 模型训练:使用已选择的回归模型对数据进行训练。

通过最小化损失函数的方法,根据现有数据来估计模型的参数,得到回归模型。

4. 模型评估:对训练得到的回归模型进行评估。

可以使用各种评估指标,如均方误差(MSE)、决定系数(R squared)等,来评估模型的预测效果。

5. 模型应用:使用训练好的回归模型来进行预测。

将新的自变量输入到回归模型中,通过模型公式计算得到对应的因变量预测值。

6. 模型调优:如果发现模型的表现不理想,可以通过调整模型的参数或选择其他回归模型进行优化。

以上是回归模型的一般操作步骤,具体操作方法还需根据具体问题和数据进行调整。

统计学中的回归分析方法回归分析是一种常用的统计学方法,旨在分析变量之间的关系并预测一个变量如何受其他变量的影响。

回归分析可以用于描述和探索变量之间的关系,也可以应用于预测和解释数据。

在统计学中,有多种回归分析方法可供选择,本文将介绍其中几种常见的方法。

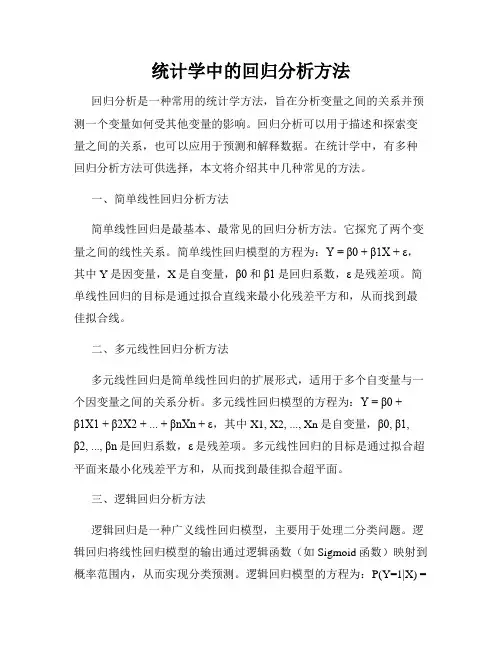

一、简单线性回归分析方法简单线性回归是最基本、最常见的回归分析方法。

它探究了两个变量之间的线性关系。

简单线性回归模型的方程为:Y = β0 + β1X + ε,其中Y是因变量,X是自变量,β0和β1是回归系数,ε是残差项。

简单线性回归的目标是通过拟合直线来最小化残差平方和,从而找到最佳拟合线。

二、多元线性回归分析方法多元线性回归是简单线性回归的扩展形式,适用于多个自变量与一个因变量之间的关系分析。

多元线性回归模型的方程为:Y = β0 +β1X1 + β2X2 + ... + βnXn + ε,其中X1, X2, ..., Xn是自变量,β0, β1,β2, ..., βn是回归系数,ε是残差项。

多元线性回归的目标是通过拟合超平面来最小化残差平方和,从而找到最佳拟合超平面。

三、逻辑回归分析方法逻辑回归是一种广义线性回归模型,主要用于处理二分类问题。

逻辑回归将线性回归模型的输出通过逻辑函数(如Sigmoid函数)映射到概率范围内,从而实现分类预测。

逻辑回归模型的方程为:P(Y=1|X) =1 / (1 + exp(-β0 - β1X)),其中P(Y=1|X)是给定X条件下Y=1的概率,β0和β1是回归系数。

逻辑回归的目标是通过最大似然估计来拟合回归系数,从而实现对未知样本的分类预测。

四、岭回归分析方法岭回归是一种用于处理多重共线性问题的回归分析方法。

多重共线性是指自变量之间存在高度相关性,这会导致估计出的回归系数不稳定。

岭回归通过在最小二乘法的目标函数中引入一个正则化项(L2范数),从而降低回归系数的方差。

岭回归模型的方程为:Y = β0 +β1X1 + β2X2 + ... + βnXn + ε + λ∑(β^2),其中λ是正则化参数,∑(β^2)是回归系数的平方和。

回归分析是一种统计学方法,用来分析两个或多个变量之间的关系。

它可以帮助我们理解变量之间的相关性,并进行预测和控制。

在实际应用中,回归分析被广泛用于经济学、社会学、医学等领域。

下面我将详细介绍如何进行回归分析的步骤,希望能对初学者有所帮助。

第一步:确定研究的目的和问题在进行回归分析之前,首先需要明确研究的目的和问题。

你需要想清楚你想要研究的变量是什么,以及你想要回答的问题是什么。

比如,你想要研究收入和教育水平之间的关系,那么你的目的就是确定这两个变量之间的相关性,并回答是否教育水平对收入有影响。

第二步:收集数据一旦确定了研究的目的和问题,接下来就需要收集相关的数据。

数据可以通过调查、实验、观察等方式获取。

在收集数据的过程中,需要注意数据的质量和完整性。

确保数据的准确性对于回归分析的结果至关重要。

第三步:进行描述性统计分析在进行回归分析之前,通常会先进行描述性统计分析。

这可以帮助我们对数据的基本特征有一个初步的了解,比如平均值、标准差、分布情况等。

描述性统计分析可以帮助我们确定变量之间的大致关系,为后续的回归分析奠定基础。

第四步:建立回归模型建立回归模型是回归分析的核心步骤。

在建立回归模型时,需要确定自变量和因变量,并选择合适的回归方法。

常见的回归方法包括线性回归、多元线性回归、逻辑回归等。

在选择回归方法时,需要考虑自变量和因变量之间的关系,以及数据的分布情况。

第五步:进行回归分析一旦建立了回归模型,接下来就可以进行回归分析了。

回归分析的主要目的是确定自变量和因变量之间的关系,并评估回归模型的拟合程度。

在进行回归分析时,需要注意检验回归模型的显著性、自变量的影响程度以及模型的预测能力。

第六步:解释回归结果进行回归分析后,需要解释回归结果。

这包括解释自变量对因变量的影响程度,以及回归模型的可解释性。

在解释回归结果时,需要注意避免过度解释或误导性解释,确保解释的准确性和可信度。

第七步:进行敏感性分析在完成回归分析后,通常会进行敏感性分析。

面板数据回归分析步骤(一)引言概述:面板数据回归分析是一种常用的经济学和统计学方法,用于研究面板数据的相关性、影响因素和趋势。

本文将详细介绍面板数据回归分析的步骤和方法,帮助读者更好地理解和应用这一方法。

正文:一、数据准备1. 收集面板数据:通过调查、观测或公共数据库来获得所需的面板数据。

2. 确定面板数据的类型:面板数据可以是平衡面板数据(每个交叉单元的观测次数相等)或非平衡面板数据(每个交叉单元的观测次数不相等)。

3. 检查数据的完整性和准确性:对面板数据进行缺失值和异常值的处理,确保数据的可靠性。

二、建立模型1. 确定因变量和自变量:根据研究目的和问题,确定面板数据中的因变量和自变量。

2. 选择适当的回归模型:根据变量的特点和关系,选择合适的面板数据回归模型,如随机效应模型、固定效应模型或混合效应模型。

3. 进行模型检验和诊断:对所选的面板数据回归模型进行统计检验,检查模型的拟合度和假设的成立情况。

三、估计回归系数1. 选择估计方法:根据面板数据的性质,选择合适的估计方法,如最小二乘法、广义最小二乘法或仪器变量法。

2. 进行回归系数估计:根据选择的估计方法,对面板数据回归模型进行回归系数估计,得到对各个自变量的系数估计值。

四、解释结果1. 解释回归系数:根据回归系数的估计结果,解释自变量对因变量的影响程度和方向。

2. 进行统计推断:对回归系数进行假设检验和置信区间估计,判断回归系数的显著性和可靠性。

五、结果分析与应用1. 分析回归结果:综合考虑回归系数的解释和统计推断结果,分析面板数据回归分析的整体效果和相关性。

2. 制定政策建议:通过分析回归结果,得出结论并提出政策建议,为决策者提供参考和借鉴。

总结:本文系统介绍了面板数据回归分析的步骤和方法,包括数据准备、模型建立、回归系数估计、结果解释和分析以及应用。

通过学习和应用面板数据回归分析,可以更好地理解和分析面板数据的相关性和趋势,从而为决策者提供有力的支持。

Stata面板数据回归分析的步骤和方法面板数据回归分析是一种用于分析面板数据的统计方法,可以通过观察个体和时间上的变化来研究变量之间的关系。

Stata软件是进行面板数据回归分析的常用工具之一,下面将介绍Stata中进行面板数据回归分析的步骤和方法。

一、数据准备在进行面板数据回归分析前,首先需要准备好相关的数据。

面板数据通常由个体和时间两个维度构成,个体维度可以是不同的个体、公司或国家,时间维度可以是不同的年、季度或月份。

将数据按照面板结构整理好,并确保数据的一致性和准确性,可以直接在Stata中导入数据进行处理。

二、面板数据回归模型选择在进行面板数据回归分析时,需要选择适合的回归模型来研究变量之间的关系。

常见的面板数据回归模型包括固定效应模型(Fixed Effects Model)和随机效应模型(Random Effects Model)。

固定效应模型通过控制个体固定效应来分析变量间的关系,而随机效应模型则假设个体固定效应与解释变量无关。

三、面板数据回归分析步骤1. 导入数据在Stata中,可以使用"import"命令导入面板数据。

例如:`import excel "data.xlsx", firstrow`可以导入Excel文件,并指定首行为变量名。

2. 设定面板数据结构在Stata中,需要将数据设置为面板数据结构,采用"xtset"命令即可完成设置。

例如:`xtset id year`将数据的个体维度设定为"id",时间维度设定为"year"。

3. 估计面板数据回归模型在Stata中,可以使用"xtreg"命令来估计面板数据回归模型。

例如:`xtreg dependent_var independent_var1 independent_var2, fe`可以用固定效应模型进行回归分析。

回归分析是一种统计学方法,用于查找变量之间的关系。

它可以帮助我们预测一个变量如何受其他变量的影响,或者帮助我们理解变量之间的相互作用。

在实际应用中,回归分析被广泛用于经济学、社会学、医学和其他领域。

在本文中,我将详细介绍如何进行回归分析的步骤。

1. 收集数据在进行回归分析之前,首先需要收集相关的数据。

这些数据可以是实验数据、调查数据或者观察数据。

确保数据的质量和完整性对于得出准确的回归分析结果至关重要。

同时,也要确保所收集的数据覆盖了所有需要考虑的变量。

2. 确定变量在进行回归分析之前,需要明确独立变量(自变量)和因变量(因变量)。

独立变量是我们用来预测因变量的变量,而因变量则是我们想要预测或解释的变量。

在确定变量的时候,要考虑到理论上的因果关系以及实际的可操作性。

3. 拟合模型选择合适的回归模型是进行回归分析的关键一步。

常用的回归模型包括线性回归、多元线性回归、逻辑回归等。

根据数据的性质和研究问题的需求,选择最合适的回归模型对于得出准确的分析结果至关重要。

4. 进行回归分析一旦确定了回归模型,就可以进行回归分析了。

这包括使用统计软件进行参数估计、假设检验和模型拟合度检验等步骤。

在进行回归分析时,要注意检查模型的假设是否符合实际情况,如线性性、残差的正态性和独立性等。

5. 解释结果进行回归分析后,需要对结果进行解释。

这包括理解模型参数的含义和统计显著性、解释模型的拟合度以及预测因变量的变异程度等。

在解释结果的过程中,要注意避免过度解释或武断解释,应该根据实际情况进行客观分析。

6. 检验模型最后,需要对建立的回归模型进行检验。

这包括对模型的预测效果进行验证,如使用交叉验证、留一验证等方法进行模型预测效果的检验。

同时,也需要对模型的稳健性进行检验,如对异常值、多重共线性等问题进行处理。

总结回归分析是一种重要的统计方法,它可以帮助我们理解变量之间的关系,预测变量的值以及验证理论模型。

在进行回归分析时,需要严格按照上述步骤进行,确保分析结果的科学性和可靠性。

第三章回归分析基本方法最小二乘法回归分析是统计学中一种常用的方法,主要用于研究一个或多个自变量与因变量之间关系的强度和方向。

在回归分析中,最常用的方法是最小二乘法。

最小二乘法是一种通过最小化观测值与拟合值之间的平方误差来估计参数的方法。

其基本思想是通过找到使得平方误差最小的参数值来拟合数据。

最小二乘法可以应用于各种类型的回归模型,包括简单线性回归和多元线性回归。

在简单线性回归中,我们研究一个自变量与一个因变量之间的关系。

假设我们有一组观测数据(x_i,y_i),其中x_i为自变量的取值,y_i为相应的因变量的取值。

我们想要找到一条直线来拟合这些数据点,使得误差最小化。

最小二乘法的目标是找到最合适的斜率和截距来拟合数据,最小化残差平方和。

具体而言,假设我们的模型为y=β_0+β_1*x,其中β_0为截距,β_1为斜率。

我们的目标是找到最合适的β_0和β_1来最小化残差平方和,即最小化∑(y_i-(β_0+β_1*x_i))^2最小二乘法的求解过程是通过对残差平方和关于β_0和β_1求偏导数,令偏导数为0,得到关于β_0和β_1的方程组。

通过求解这个方程组,我们可以得到最佳的β_0和β_1的估计值。

在多元线性回归中,我们考虑多个自变量与一个因变量之间的关系。

假设我们有p个自变量,我们的模型可以表示为y=β_0+β_1*x_1+β_2*x_2+...+β_p*x_p。

最小二乘法的求解过程与简单线性回归类似,只是需要求解一个更复杂的方程组。

最小二乘法在回归分析中的应用非常广泛。

它可以用于预测和建模,也可以用于建立因果关系的推断。

此外,最小二乘法还可以用于进行参数估计和统计检验。

总结起来,最小二乘法是一种基本的回归分析方法,通过最小化观测值与拟合值之间的平方误差来估计参数。

它在简单线性回归和多元线性回归中都有广泛应用,是统计学中重要的工具之一。

Stata面板数据回归分析的步骤和方法哎哟,说起Stata面板数据回归分析,我这心里就直发痒。

我这人就是喜欢琢磨这些个数字,特别是这面板数据,看着就亲切。

来来来,咱们就坐在这,我给你掰扯掰扯这回归分析的步骤和方法。

首先啊,你得准备数据。

这数据啊,得是面板数据,就是横着竖着都是数据。

你得把数据导进Stata里头,看着那一排排数字,心里就得有谱,知道这数据从哪儿来,将来要干啥用。

然后啊,咱们先得把数据整理一下。

Stata里有那么多命令,咱们得用上“xtset”这个命令,告诉Stata这是面板数据。

然后呢,就得看看数据有没有问题,比如有没有缺失值啊,有没有异常值啊。

这就像咱们做人,也得讲究个整洁,别邋里邋遢的。

接下来啊,咱们得确定模型。

面板数据回归模型有好几种,比如说固定效应模型、随机效应模型,还有混合效应模型。

你得根据实际情况来选择。

就像做菜,得看你要做什么菜,是做炒菜还是炖菜。

选好了模型,那就得建模型了。

Stata里有“xtreg”这个命令,专门干这个活。

你把数据输入进去,再指定你的模型,Stata就帮你算出来了。

就像咱们孩子写作业,咱们给他点拨点拨,他就写得有模有样了。

算完模型,就得检验。

这就像咱们看完电影,得聊聊感想。

检验模型,就是看这个模型有没有问题,比如有没有多重共线性啊,残差有没有自相关啊。

这就像咱们吃饭,得看看吃得饱不饱,营养均衡不均衡。

最后啊,你得解释结果。

这结果啊,得结合实际情况来说。

就像咱们买衣服,得看合不合身。

解释结果,就是要看这些数字背后的故事,看看这些数据能告诉我们什么。

哎呀,说起来这Stata面板数据回归分析,真是门学问。

得有耐心,得有细心,还得有恒心。

就像咱们种地,得用心浇灌,才能收获满满。

好啦,我这就唠叨这么多了。

你要是想学这玩意儿,得多看多练。

就像咱们学说话,得多说多练,才能说得溜。

来来来,咱们下次再聊聊其他的话题。

利用Excel的数据分析工具进行回归分析回归分析(Regression Analysis)是一种统计学方法,用于探索和建立变量之间的关系。

利用Excel的数据分析工具,我们可以轻松地进行回归分析,以帮助我们理解和解释数据。

首先,在Excel中打开你的数据集。

确保每个变量都在不同的列中,并且每个观测值都在不同的行中。

接下来,我们将使用Excel的数据分析工具来进行回归分析。

请按照以下步骤进行操作:1. 在Excel的菜单栏中选择“数据”选项卡,然后选择“数据分析”。

2. 在弹出的对话框中,选择“回归”选项,然后点击“确定”。

3. 在“回归”对话框中,将“输入Y范围”设定为你想要作为因变量的数据列。

4. 将“输入X范围”设定为你想要作为自变量的数据列。

5. 如果你有多个自变量,可以在“输入X范围”中逐一添加它们。

6. 如果你想要输出回归分析的统计数据和图表,请勾选“置信区间”和“残差”。

7. 点击“确定”按钮,Excel将生成回归分析的结果。

回归分析的结果将显示在一个新的工作表中。

在这个工作表中,你将看到回归方程、因变量和自变量的系数、回归分析的统计数据以及残差图表。

通过分析这些结果,你可以得出关于变量之间关系的结论。

另外,Excel还提供了其他有用的工具来辅助你进行回归分析。

例如,你可以使用Excel的散点图工具来可视化数据,进一步理解变量之间的关系。

你也可以使用Excel的数据透视表和图表功能来分析多个变量之间的复杂关系。

总之,利用Excel的数据分析工具进行回归分析可以帮助我们更好地理解和解释数据。

通过按照上述步骤进行操作,你可以轻松地进行回归分析,并从分析结果中获得有价值的信息。

无论是用于学术研究、商业决策还是其他领域,回归分析都是一种强大的工具,可以帮助我们做出准确的预测和推断。

大数据分析师如何进行回归分析回归分析是大数据分析中一种重要的统计方法,用于研究变量之间的关系,并预测一个变量对另一个或多个变量的影响程度。

在大数据时代,回归分析对于发现变量之间的关联性,深入理解数据并预测未来趋势至关重要。

本文将介绍大数据分析师如何进行回归分析,从数据准备到模型建立,以及结果解读等方面进行详细阐述。

一、数据准备在进行回归分析之前,首先需要收集和准备相关的数据。

大数据分析师应该明确自己研究的问题,明确需要收集的自变量(独立变量)和因变量(依赖变量)。

自变量通常是我们研究的影响因素,因变量则是我们要预测的目标变量。

收集数据后,需要进行数据清洗和预处理。

这可能包括处理缺失值、异常值,以及对数据进行归一化、标准化等操作,以确保数据的可靠性和一致性。

同时,还应该通过可视化手段对数据进行初步的探索性分析,以探索变量之间的关系。

二、模型建立在数据准备完成后,需要选择适合的回归模型。

常用的回归模型包括线性回归、多项式回归、逻辑回归等。

选择哪种模型要取决于自变量和因变量之间的关系以及问题的需求。

以线性回归为例,假设我们有一个自变量X和一个因变量Y,我们可以通过拟合一条直线来探索他们之间的关系。

线性回归模型的公式可以表示为:Y = β0 + β1X + ε,其中β0是截距,β1是斜率,ε是误差项。

在模型建立过程中,还需要考虑特征选择的问题。

特征选择是指从大量的自变量中选取能够对因变量起到解释性作用的变量。

这可以通过统计方法、经验法则或基于算法的特征选择方法来实现。

三、模型评估与优化模型建立完成后,需要对模型进行评估和优化。

一种常用的评估指标是均方误差(MSE),即预测值与真实值之间的平方差的平均值。

MSE越小,模型的拟合效果越好。

在评估模型的基础上,可以进行进一步的优化尝试。

这可能包括添加或删除自变量、调整模型参数、应用正则化技术等。

优化模型的目标是提高预测精度和模型的解释能力。

四、结果解读与应用模型建立和优化完成后,通过对模型进行结果解读和应用,可以得出对实际问题的预测和解释。