教育信息熵第二章

- 格式:ppt

- 大小:1.82 MB

- 文档页数:80

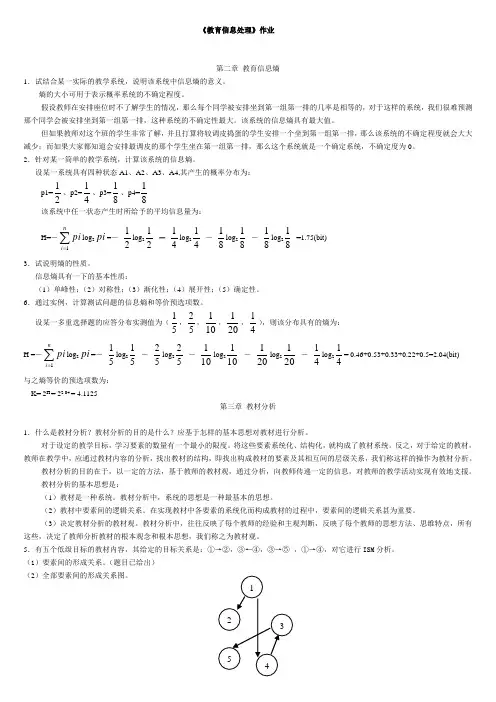

《教育信息处理》作业第二章 教育信息熵1.试结合某一实际的教学系统,说明该系统中信息熵的意义。

熵的大小可用于表示概率系统的不确定程度。

假设教师在安排座位时不了解学生的情况,那么每个同学被安排坐到第一组第一排的几率是相等的,对于这样的系统,我们很难预测那个同学会被安排坐到第一组第一排,这种系统的不确定性最大。

该系统的信息熵具有最大值。

但如果教师对这个班的学生非常了解,并且打算将较调皮捣蛋的学生安排一个坐到第一组第一排,那么该系统的不确定程度就会大大减少;而如果大家都知道会安排最调皮的那个学生坐在第一组第一排,那么这个系统就是一个确定系统,不确定度为0。

2.针对某一简单的教学系统,计算该系统的信息熵。

设某一系统具有四种状态A1、A2、A3、A4,其产生的概率分布为:p1=21、p2=41、p3=81、p4=81该系统中任一状态产生时所给予的平均信息量为: H=-∑=ni pi 1log 2pi =-21log 221 - 41log 241 - 81log 281 - 81log 281=1.75(bit) 3.试说明熵的性质。

信息熵具有一下的基本性质:(1)单峰性;(2)对称性;(3)渐化性;(4)展开性;(5)确定性。

6.通过实例,计算测试问题的信息熵和等价预选项数。

设某一多重选择题的应答分布实测值为(51,52,101,201,41),则该分布具有的熵为:H =-∑=ni pi 1log2pi =-51log 251 - 52log 252 - 101log 2101 - 201log 2201 - 41log 241= 0.46+0.53+0.33+0.22+0.5=2.04(bit)与之熵等价的预选项数为: K= 2H = 22.04 = 4.1125第三章 教材分析1.什么是教材分析?教材分析的目的是什么?应基于怎样的基本思想对教材进行分析。

对于设定的教学目标,学习要素的数量有一个最小的限度。

第一章教育信息概述1、试举例说明什么是信息,什么是数据和知识,彼此间有什么关系。

简单地讲,通过信息,可以告诉我们某件事情,可以使我们增加一定的知识。

信息被定义为熵的减少,即信息可以消除人们对事物认识的不确定性,并将消除不确定程度的多少作为信息量的量度。

比如我们在每天都会收看电视节目预报,在掌握了当天晚上的电视节目的信息后。

我们对于当晚要看什么电视,在哪个电台看等一些认识的不确定性就得以消除,而消除的程度就取决于我们对电视节目了解的多少即信息量的多少。

数据是信息的素材,是在各种现象和事件中收集的。

当我们根据一定的利用目的,采取相应的形式对数据进行处理后,就可得到新的信息(制作出新的信息)。

比如天气预报中的气温,天气情况多云、阴等。

知识是一种信息,是在对数据、信息理解的基础上,以某种可利用的形式,高度民主组织化后的可记忆的信息。

比如说,我们在看完书后,我们将书中的故事情节有机的组合,在加上自身对于故事的理解,将整个故事重新阐述,记忆在大脑中。

2、试从信息的特点说明信息产业与其他产业相比较,有什么特点由于信息不具大小,无论怎样小的空间,都可存放大量的信息,无论怎样狭窄的通道,都能高速地传递大量的信息。

信息产业是一种省空间、省能源的产业。

信息由于没有重量,在处理时,不需要能量。

信息产业是一种省能源产业。

信息一旦产生,很容易复制,它有利于大量生产。

3、说明教育信息数量化的特点和方法教育信息的数量化特点:不连续性和不可加性。

比如人的IQ4、从教育信息、教育信息所处理的对象和教育信息的结构化特点出发,说明用于教育信息处理的方法。

(1)加强与其他学科的交流。

教育信息处理是一种跨多门学科的综合性学科领域。

它涉及教育学、心理学、认知科学、信息科学等多门学科的研究。

教育信息处理应努力与这些学科进行交流,学习他们的思想、方法,学习它们的理论、技术,努力地完善自己,在实践的基础上,确立自己的理论和方法。

(2)从行为向认知变换。

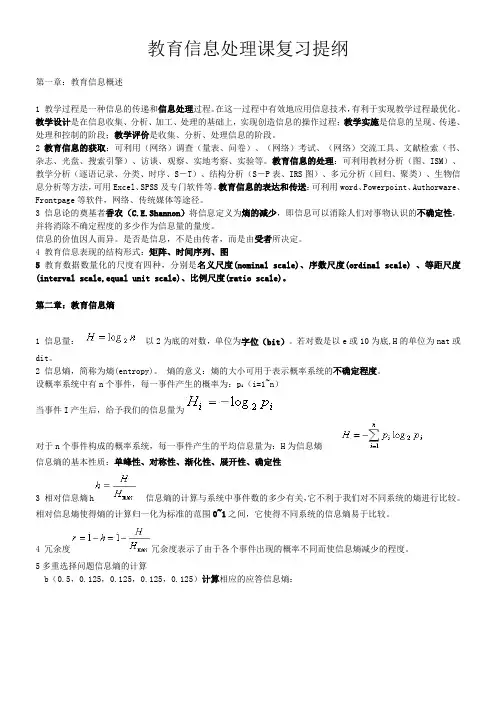

教育信息处理课复习提纲第一章:教育信息概述1 教学过程是一种信息的传递和信息处理过程。

在这一过程中有效地应用信息技术,有利于实现教学过程最优化。

教学设计是在信息收集、分析、加工、处理的基础上,实现创造信息的操作过程;教学实施是信息的呈现、传递、处理和控制的阶段;教学评价是收集、分析、处理信息的阶段。

2 教育信息的获取:可利用(网络)调查(量表、问卷)、(网络)考试、(网络)交流工具、文献检索(书、杂志、光盘、搜索引擎)、访谈、观察、实地考察、实验等。

教育信息的处理:可利用教材分析(图、ISM)、教学分析(逐语记录、分类、时序、S-T)、结构分析(S-P表、IRS图)、多元分析(回归、聚类)、生物信息分析等方法,可用Excel、SPSS及专门软件等。

教育信息的表达和传送:可利用word、Powerpoint、Authorware、Frontpage等软件,网络、传统媒体等途径。

3 信息论的奠基者香农(C.E.Shannon)将信息定义为熵的减少,即信息可以消除人们对事物认识的不确定性,并将消除不确定程度的多少作为信息量的量度。

信息的价值因人而异。

是否是信息,不是由传者,而是由受者所决定。

4 教育信息表现的结构形式:矩阵、时间序列、图5教育数据数量化的尺度有四种,分别是名义尺度(nominal scale)、序数尺度(ordinal scale) 、等距尺度(interval scale,equal unit scale)、比例尺度(ratio scale)。

第二章:教育信息熵1 信息量:以2为底的对数,单位为字位(bit)。

若对数是以e或10为底,H的单位为nat或dit。

2 信息熵,简称为熵(entropy)。

熵的意义:熵的大小可用于表示概率系统的不确定程度。

设概率系统中有n个事件,每一事件产生的概率为:p i(i=1~n)当事件I产生后,给予我们的信息量为对于n个事件构成的概率系统,每一事件产生的平均信息量为:H为信息熵信息熵的基本性质:单峰性、对称性、渐化性、展开性、确定性3 相对信息熵h信息熵的计算与系统中事件数的多少有关,它不利于我们对不同系统的熵进行比较。

第二章 信源与信息熵(第二讲)(2课时)主要内容:(1)信源的描述(2)信源的分类 重点:信源的分类,马尔可夫信源。

难点:信源的描述,马尔可夫信源。

作业:2.1, 2.2, 2.3说明:本堂课推导内容较多,枯燥平淡,不易激发学生兴趣,要注意多讨论用途。

另外,注意,解题方法。

多加一些内容丰富知识和理解。

2.1 信源的描述与分类在通信系统中收信者在未收到消息以前对信源发出什么消息是不确定的,是随机的,所以可用随机变量、随机序列或随机过程来描述信源输出的消息,或者说用一个样本空间及其概率测度——概率空间来描述信源。

信源:产生随机变量、随机序列和随机过程的源。

信源的基本特性:具有随机不确定性。

信源的分类离散信源:文字、数据、电报——随机序列 连续信源:话音、图像——随机过程离散信源:输出在时间和幅度上都是离散分布的消息。

消息数是有限的或可数的,且每次只输出其中一个消息,即两两不相容。

发出单个符号的无记忆信源离散无记忆信源: 发出符号序列的无记忆信源离散信源离散有记忆信源: 发出符号序列的有记忆信源发出符号序列的马尔可夫信源 概率论基础:无条件概率,条件概率和联合概率的性质和关系: 非负性0()()(/)(/)()1i j j i i j i j p x p y p y x p x y p x y ≤≤,,,, 完备性111111()1,()1,(/)1,(/)1,()1n m nijiji j i mm nji i j j j i p x p y p x y p yx p x y ===========∑∑∑∑∑∑11()(),()()n mijjijii j p x y p y p x y p x ====∑∑联合概率()()(/)()(/)()()()(/)()(/)()i j i j i j i j i j i j j i j i j i p x y p x p y x p y p x y X Y p x y p x p y p y x p y p x y p x =====当与相互独立时,,贝叶斯公式11()()(/)(/)()()i j i j i j j i nmijiji j p x y p x y p x y p y x p x y p x y ====∑∑,2.1.1 无记忆信源:例如扔骰子,每次试验结果必然是1~6点中的某一个面朝上。

第二章教育信息熵习题

填空:

1、对于n个事件构成的概率系统,设每一事件产生的概率为pi(i=1~n),则每一事件产生的平均信息量为:_______,我们称之为_______,简称______。

它的大小可用于表示概率系统的。

它所具有的基本性质有______、______、______、______、______。

2、基于联合熵H(X,Y) 和条件熵H(X︱Y)、H(Y︱X),互信

息量I(X,Y)= _______= _______。

3、最大熵原理是___________________。

熵模型是_____________________。

4、熵模型方法的基本流程图为_______,其目的函数为

______。

5、学习者对4道多重选择问题的应答概率分布为:

1( 0.5 , 0.5 , 0 , 0 , 0 )

2( 0.5 , 0.25 , 0.25 )

3( 0.5 , 0.125 , 0.125 , 0.125 , 0.125 )

4( 0.5 , 0.25 , 0.125 , 0.125 )

请算出: 每道题的应答信息熵:__________;

每道题的等价选项数: ___________;

每道题的相对信息熵:___________及冗余度______; 及这4道题的平均相对熵:______。