LVS+HA--NetSeek

- 格式:pdf

- 大小:177.70 KB

- 文档页数:6

LVS原理详解配置文件参数详解LVS(Linux Virtual Server)是一种基于Linux内核的负载均衡技术,可以通过多台物理服务器构建一个高可用的服务器集群,提高系统的可靠性和性能。

在LVS中,配置文件参数的设置非常关键,下面详细解释一些重要的配置文件参数。

1. 调度器(scheduler)参数:在LVS中,可以选择多种调度算法来分发客户端请求,如轮询(Round Robin)、源地址散列(Source Hash)、最少连接(Least Connection)等。

调度器参数用于指定所使用的调度算法,常用的参数值有:- rr:轮询算法,按照服务器从第一个到最后一个的顺序依次分发请求。

- wrr:加权轮询算法,根据服务器的权重分配请求。

具有较高权重的服务器将得到更多的请求。

- lc:最少连接算法,将请求分发到当前并发连接数最小的服务器上。

- wlc:加权最少连接算法,结合了最少连接和加权分配的特点。

2. 虚拟服务器(virtual server)参数:虚拟服务器是LVS集群中的前端服务器,用于接收客户端请求并将其转发给后端真实服务器。

虚拟服务器参数包括:- virtualhost:虚拟服务器的IP地址和端口号。

- realserver:后端真实服务器的IP地址和端口号。

- protocol:虚拟服务器使用的协议,如TCP、UDP等。

- scheduler:指定调度算法。

3. 真实服务器(real server)参数:真实服务器是LVS集群中的后端服务器,负责处理来自虚拟服务器的转发请求。

真实服务器参数包括:- address:真实服务器的IP地址。

- port:真实服务器监听的端口号。

- weight:服务器的权重,用于在加权调度算法中决定分发请求的比例。

- maxconn:服务器的最大并发连接数。

4. 会话保持(session persistence)参数:会话保持是LVS中的一个重要概念,用于确保客户端的请求在多次访问中被分发到同一台后端服务器。

lvs 和f5 实现原理全文共四篇示例,供读者参考第一篇示例:随着互联网应用的不断发展和普及,网络负载均衡技术已经成为保障网站可用性和性能的重要手段。

在负载均衡技术中,LVS(Linux Virtual Server)和F5分别代表着开源和商业两种不同的实现方式,它们在原理和使用中有着不同的特点和优势。

本文将就LVS和F5的实现原理进行探讨与比较。

LVS(Linux Virtual Server)是一种基于Linux操作系统的负载均衡技术,它充分利用了Linux内核的功能和特性来实现高效的负载均衡。

LVS通常采用四层负载均衡的方式,即在传输层上进行负载均衡,它通过IP地址和端口号进行请求的转发,实现对后端服务器的负载均衡。

LVS的实现原理主要包括三个组件:调度器、数据包转发和后端服务器。

调度器是LVS的核心组件,它负责根据负载均衡策略来选择合适的后端服务器进行请求的转发。

LVS采用了多种不同的负载均衡算法,如轮询、加权轮询、源地址散列等,根据具体的业务需求和场景选择合适的负载均衡算法。

调度器会根据请求的特性和当前后端服务器的负载情况来选择合适的后端服务器,从而实现负载均衡。

数据包转发是LVS的另一个关键组件,它负责接收客户端的请求并将请求转发给选定的后端服务器。

数据包转发通常采用Linux内核的IPVS模块来实现,通过在内核空间进行数据包的处理和转发,从而提高负载均衡的效率和性能。

数据包转发还可以支持连接的持久化和会话的保持,以确保客户端的请求在整个会话过程中都能顺利访问到同一台后端服务器。

后端服务器是LVS的最终目的地,它负责接收转发过来的请求并响应客户端的请求。

LVS通常将后端服务器配置成一个服务器集群,通过多台服务器共同处理客户端的请求来提高网站的可用性和性能。

后端服务器可以根据具体的业务需求来配置,如多个应用服务器、数据库服务器、文件服务器等,以满足不同的业务需求。

与LVS相比,F5是一家领先的应用交付控制公司,其产品包括硬件负载均衡器、应用交付控制器等。

如何配置LVS/NAT、LVS/TUN、LVS/DR方式的负载均衡集群2010年10月28日星期四下午 02:29转载自yupanlovehlq最终编辑yupanlovehlq实例理解了上述关于请求转发方式和调度算法的基本概念后,就可以运用LVS来具体实现几种不同方式的负载均衡的集群系统。

LVS的配置是通过前面所安装的IP虚拟服务器软件ipvsadm来实现的。

ipvsadm与LVS的关系类似于 iptables和NetFilter的关系,前者只是一个建立和修改规则的工具,这些命令的作用在系统重新启动后就消失了,所以应该将这些命令写到一个脚本里,然后让它在系统启动后自动执行。

网上有不少配置LVS的工具,有的甚至可以自动生成脚本。

但是自己手工编写有助于更深入地了解,所以本文的安装没有利用其它第三方提供的脚本,而是纯粹使用ipvsadm命令来配置。

下面就介绍一下如何配置LVS/NAT、LVS/TUN、LVS/DR方式的负载均衡集群。

1.设定LVS/NAT方式的负载均衡集群NAT是指Network Address Translation,它的转发流程是:Director机器收到外界请求,改写数据包的目标地址,按相应的调度算法将其发送到相应Real Server上,Real Server处理完该请求后,将结果数据包返回到其默认网关,即Director机器上,Director机器再改写数据包的源地址,最后将其返回给外界。

这样就完成一次负载调度。

构架一个最简单的LVS/NAT方式的负载均衡集群如图2所示。

图2 LVS/NAT方式的集群简图Real Server可以是任何的操作系统,而且无需做任何特殊的设定,惟一要做的就是将其默认网关指向Director机器。

Real Server可以使用局域网的内部IP(192.168.0.0/24)。

Director要有两块网卡,一块网卡绑定一个外部IP地址 (10.0.0.1),另一块网卡绑定局域网的内部IP(192.168.0.254),作为Real Server的默认网关。

LVS原理详解配置文件参数详解LVS(Linux Virtual Server)是一种基于四层(TCP/UDP)和七层(HTTP/HTTPS)负载均衡技术,能够将网络流量按照一定的策略分发到多个真实服务器上,从而提高服务器的可用性和负载能力。

LVS的主要原理是通过网络地址转换(NAT)、数据包转发(DR)和IP隧道(TUN)三种方式实现负载均衡。

在LVS的配置文件中,有一些重要的参数需要进行详细的解释。

1. Virtual Server(虚拟服务器)参数:- VIP(Virtual IP):虚拟服务器的IP地址。

当客户端请求访问这个VIP时,LVS会根据一定的策略将请求转发到后端真实服务器进行处理。

- Protocol(协议):虚拟服务器所使用的协议类型,如TCP、UDP、HTTP等。

根据不同的协议,LVS的配置和行为会略有差异。

- Scheduler(调度算法):LVS使用的负载均衡算法,常见的有轮询(Round Robin)、加权轮询(Weighted Round Robin)、最少连接(Least Connection)等。

2. Real Server(真实服务器)参数:- RIP(Real IP):真实服务器的IP地址。

- RS_PORT(Real Server Port):真实服务器上对外提供服务的端口号。

- RS_WEIGHT(Real Server Weight):真实服务器的权重值。

通过权重值可以实现负载均衡的策略,权重越高的服务器会处理更多的请求。

3.LVS模式参数:- NAT模式(Network Address Translation):LVS作为网络地址转换器,将客户端请求的源IP地址和目标IP地址进行转换,使得请求最终到达真实服务器。

- DR模式(Direct Routing):LVS将客户端请求的目标IP地址更改为真实服务器的IP地址,并通过修改ARP映射表使得请求直接发送给真实服务器。

LVS,Nginx和HAProxy区别LVS优缺点LVS的优点:1、抗负载能⼒强、⼯作在第4层仅作分发之⽤,没有流量的产⽣,这个特点也决定了它在负载均衡软件⾥的性能最强的;⽆流量,同时保证了均衡器IO的性能不会受到⼤流量的影响;2、⼯作稳定,⾃⾝有完整的双机热备⽅案,如LVS+Keepalived和LVS+Heartbeat;3、应⽤范围⽐较⼴,可以对所有应⽤做负载均衡;4、配置性⽐较低,这是⼀个缺点也是⼀个优点,因为没有可太多配置的东西,所以并不需要太多接触,⼤⼤减少了⼈为出错的⼏率;LVS的缺点:1、软件本⾝不⽀持正则处理,不能做动静分离,这就凸显了Nginx/HAProxy+Keepalived的优势。

2、如果⽹站应⽤⽐较庞⼤,LVS/DR+Keepalived就⽐较复杂了,特别是后⾯有Windows Server应⽤的机器,实施及配置还有维护过程就⽐较⿇烦,相对⽽⾔,Nginx/HAProxy+Keepalived就简单多了。

Nginx优缺点Nginx的优点:1.⼯作在OSI第7层,可以针对http应⽤做⼀些分流的策略。

⽐如针对域名、⽬录结构。

它的正则⽐HAProxy更为强⼤和灵活;2.Nginx对⽹络的依赖⾮常⼩,理论上能ping通就就能进⾏负载功能,这个也是它的优势所在;3.Nginx安装和配置⽐较简单,测试起来⽐较⽅便;4.可以承担⾼的负载压⼒且稳定,⼀般能⽀撑超过⼏万次的并发量;5.Nginx可以通过端⼝检测到服务器内部的故障,⽐如根据服务器处理⽹页返回的状态码、超时等等,并且会把返回错误的请求重新提交到另⼀个节点;6.Nginx不仅仅是⼀款优秀的负载均衡器/反向代理软件,它同时也是功能强⼤的Web应⽤服务器。

LNMP现在也是⾮常流⾏的web环境,⼤有和LAMP环境分庭抗礼之势,Nginx在处理静态页⾯、特别是抗⾼并发⽅⾯相对apache有优势;7.Nginx现在作为Web反向加速缓存越来越成熟了,速度⽐传统的Squid服务器更快,有需求的朋友可以考虑⽤其作为反向代理加速器;Nginx的缺点:1、Nginx不⽀持url来检测。

lvs验证步骤-回复LVS(Linux Virtual Server)是一种开源的软件负载均衡技术,它能够提供高可用性、可伸缩性和灵活性,用于提供稳定和可靠的网络服务。

在本文中,我将介绍LVS的验证步骤,以帮助读者了解如何正确地验证LVS 的配置。

验证LVS的步骤如下:1. 准备环境在验证LVS之前,我们需要准备一些基本环境。

首先,我们需要至少两台服务器,其中一台将作为LVS的负载均衡器,其他服务器将作为后端服务器。

另外,我们还需要安装并配置LVS软件,同时确保服务器之间能够正常通信。

2. 配置负载均衡器第一步是配置负载均衡器。

在LVS中,使用IPVS(IP Virtual Server)作为负载均衡的核心组件。

我们需要在负载均衡器上配置IPVS以确保其正常工作。

首先,我们需要创建一个VIP(Virtual IP),该VIP是客户端将访问的虚拟IP地址。

我们可以使用以下命令创建VIP:ip addr add VIP dev eth0其中VIP是我们选择的虚拟IP地址,eth0是服务器上的网络接口。

接下来,我们需要配置IPVS规则,以确定应将流量分发到哪些后端服务器。

我们可以使用以下命令来配置IPVS规则:ipvsadm -A -t VIP:端口-s 程序调度算法其中VIP是我们选择的虚拟IP地址,端口是要负载均衡的端口,程序调度算法是负载均衡使用的算法,例如轮询(rr)或加权轮询(wrr)。

3. 配置后端服务器在配置负载均衡器之后,我们需要配置后端服务器以确保它们能够正常工作。

首先,我们需要在每个后端服务器上启动服务,并确保它们可以相互通信。

然后,我们需要将后端服务器添加到负载均衡器中,以便流量可以被正确地分发。

我们可以使用以下命令将后端服务器添加到负载均衡器中:ipvsadm -a -t VIP:端口-r 后端服务器IP:端口-g其中VIP是我们选择的虚拟IP地址,端口是要负载均衡的端口,后端服务器IP是我们选择的后端服务器的IP地址,端口是要负载均衡的端口,-g选项表示将流量通过IP地址和端口进行分组。

lvs 简单用法LVS(Linux Virtual Server)是一个基于Linux操作系统的高性能、可扩展的负载均衡器。

它允许将网络流量均匀分配到多个后端服务器,从而提高系统的可用性和性能。

为了使用LVS,首先要确保在服务器上安装了ipvsadm工具包。

使用以下命令可以检查是否安装了该工具包:```ipvsadm -v```如果未安装ipvsadm,可以使用以下命令安装:```sudo apt-get install ipvsadm```安装完ipvsadm后,可以开始配置LVS。

配置LVS需要进行以下几个步骤:1. 配置LVS调度器:LVS调度器是负责接收客户端请求并将其转发至后端服务器的组件。

可以通过编辑`/etc/sysctl.conf`文件来配置LVS调度器。

添加以下行以启用IP转发:```net.ipv4.ip_forward = 1```然后使用以下命令使配置生效:```sudo sysctl -p```2. 配置LVS服务:编辑`/etc/ipvsadm.conf`文件,添加以下内容来配置LVS服务:```# 清除旧的配置sudo ipvsadm --clear# 添加LVS虚拟服务sudo ipvsadm -A -t <虚拟服务IP>:<端口> -s <调度算法>```这里需要将`<虚拟服务IP>`和`<端口>`替换为实际的虚拟服务IP和端口,`<调度算法>`可以选择使用的调度算法,例如`rr`表示使用轮询(Round Robin)算法。

3. 添加后端服务器:使用以下命令将后端服务器添加至LVS服务中:```sudo ipvsadm -a -t <虚拟服务IP>:<端口> -r <后端服务器IP>:<端口> -g```这里需要将`<虚拟服务IP>`和`<端口>`替换为实际的虚拟服务IP和端口,`<后端服务器IP>`和`<端口>`替换为实际的后端服务器IP和端口。

LVS原理详解配置⽂件参数详解LVS原理详解LVS简介 Internet的快速增长使多媒体⽹络服务器⾯对的访问数量快速增加,服务器需要具备提供⼤量并发访问服务的能⼒,因此对于⼤负载的服务器来讲, CPU、I/O处理能⼒很快会成为瓶颈。

由于单台服务器的性能总是有限的,简单的提⾼硬件性能并不能真正解决这个问题。

为此,必须采⽤多服务器和负载均衡技术才能满⾜⼤量并发访问的需要。

Linux 虚拟服务器(Linux Virtual Servers,LVS) 使⽤负载均衡技术将多台服务器组成⼀个虚拟服务器。

它为适应快速增长的⽹络访问需求提供了⼀个负载能⼒易于扩展,⽽价格低廉的解决⽅案。

LVS结构与⼯作原理⼀.LVS的结构 LVS由前端的负载均衡器(Load Balancer,LB)和后端的真实服务器(Real Server,RS)群组成。

RS间可通过局域⽹或⼴域⽹连接。

LVS的这种结构对⽤户是透明的,⽤户只能看见⼀台作为LB的虚拟服务器(Virtual Server),⽽看不到提供服务的RS群。

当⽤户的请求发往虚拟服务器,LB根据设定的包转发策略和负载均衡调度算法将⽤户请求转发给RS。

RS再将⽤户请求结果返回给⽤户。

⼆.LVS内核模型1.当客户端的请求到达负载均衡器的内核空间时,⾸先会到达PREROUTING链。

2.当内核发现请求数据包的⽬的地址是本机时,将数据包送往INPUT链。

3.LVS由⽤户空间的ipvsadm和内核空间的IPVS组成,ipvsadm⽤来定义规则,IPVS利⽤ipvsadm定义的规则⼯作,IPVS⼯作在INPUT链上,当数据包到达INPUT链时,⾸先会被IPVS检查,如果数据包⾥⾯的⽬的地址及端⼝没有在规则⾥⾯,那么这条数据包将被放⾏⾄⽤户空间。

4.如果数据包⾥⾯的⽬的地址及端⼝在规则⾥⾯,那么这条数据报⽂将被修改⽬的地址为事先定义好的后端服务器,并送往POSTROUTING链。

5.最后经由POSTROUTING链发往后端服务器。

lvs验证步骤-回复LVS( Linux Virtual Server) 是一个开源的负载均衡软件,它可以将多个服务器组合成一个高可用性、高性能的服务集群。

在使用LVS之前,我们需要对其进行验证以确保其功能和配置的正确性。

下面将介绍LVS验证的具体步骤。

1. 安装LVS软件首先,你需要在一台Linux服务器上安装LVS软件。

你可以选择使用预编译的二进制包,也可以从源代码编译安装。

根据不同的Linux发行版,安装方法可能有所不同,你可以参考官方文档或其他相关资源来完成安装。

2. 配置IPVS内核模块LVS使用IPVS内核模块来实现负载均衡功能,所以在开始验证之前,你需要确保IPVS模块已经正确加载到内核中。

你可以使用以下命令来检查其是否已加载:lsmod grep ip_vs如果没有输出,则说明IPVS模块未加载。

你可以使用以下命令来加载模块:modprobe ip_vs如果加载成功,则可以继续进行下一步。

3. 配置虚拟服务器LVS通过虚拟服务器来实现负载均衡。

虚拟服务器是由一个或多个真实服务器组成的逻辑实体。

你需要在LVS主机上为每个虚拟服务器配置一个唯一的IP地址。

配置虚拟服务器的方法取决于你选择的调度算法。

常见的调度算法有轮询、加权轮询、最小连接数等。

你可以在LVS配置文件中设置这些参数。

4. 配置真实服务器在LVS集群中,真实服务器是实际处理用户请求的服务器。

你需要为每个真实服务器分配一个唯一的IP地址,并确保它们与LVS主机在同一个子网内。

你还需要在真实服务器上安装和配置需要提供的服务,例如Web服务器或应用服务器。

确保真实服务器上的服务听取正确的端口并且能够正常工作。

5. 配置LVS集群在LVS集群中,你需要将虚拟服务器与真实服务器进行关联。

这可以通过配置LVS主机上的转发规则来完成。

你可以使用以下命令来添加转发规则:ipvsadm -A -t <虚拟服务器IP>:<端口> -s <调度算法>ipvsadm -a -t <虚拟服务器IP>:<端口> -r <真实服务器IP>:<端口> -g这将创建一个转发规则,将虚拟服务器上的请求转发到真实服务器上。

提高服务器响应能力的方法scale on 在原有服务器的基础上进行升级或者直接换一台新的性能更高的服务器。

scale out 横向扩展,将多台服务器并发向外响应客户端的请求。

优点:成本低,扩展架构比较简单。

集群(Cluster),通俗地讲就是按照某种组织方式将几台电脑组织起来完成某种特定任务的这样一种架构。

三种集群类型:LB,Load Balancing 负载均衡:在一定程度上能够实现高可用的目的。

HA,High Availability 高可用:实时在线,能够及时响应客户端请求,企业应用要求达到7*24小时,99.999%时间在线。

HP,High Performance 高性能提供大量超级运算能力的集群。

LB 负载均衡架构:Director(dispatcher):负责接收客户端请求,并将请求按照某种算法分发到后台真正提供服务的服务器上。

既可以基于硬件(F5)来实现,也可以基于软件来实现。

基于软件实现的又分为四层交换:基于IP地址和端口号组合起来对服务做重定向(LVS)。

七层交换:通常指的是反向代理(proxy),例如:squid。

LVS:Linux Virtual Server类似于iptables的架构,在内核中有一段代码用于实时监听数据包来源的请求,当数据包到达端口时做一次重定向。

这一系列的工作必须在内核中实现。

在内核中实现数据包请求处理的代码叫做ipvs。

ipvs仅仅提供了功能框架,还需要自己手动定义是数据对哪个服务的请求,而这种定义需要通过写规则来实现,写规则的工具就称为ipvsadm。

应用场景高吞吐量(higher throughput)冗余(redundancy)适应性(adaptability)LVS负载均衡架构Virtual IP(VIP)address:Director用来向客户端提供服务的IP地址Real IP (RIP) address:集群节点(后台真正提供服务的服务器)所使用的IP地址Director's IP (DIP) address:Director用来和D/RIP 进行联系的地址Client computer's IP (CIP) address:公网IP,客户端使用的IP。

LVS+HA环境描述:本文在配置LVS时使用三台linux,一台做Directorserver(192.168.0.25) ,两台做realserver(192.168.0.127 192.168.0.128,在配置lvs+heartbeat时又添加了一台(192.168.0.126)做为备份主节点,虚拟VIP:192.168.0.100软件列表:ipvsadm-1.24.tar.gzlibnet.tar 下载地址:/libnet/稳定版本是:1.1.2.1e2fsprogs 可以用rpm 安装光盘heartbeat-2.0.2.tar.gz2.6内核已经集成IPVS内核补订了,所以不再需要重新编译内核.配置此集群分以下几种情况一、配置基于DR模式Lvs集群二、配置基于隧道模式Lvs集群三、配置基于高可用Lvs+heartbeat四、此种配置方式可以加强LVS的主节点的高安全性前提下(主节点简称DR,备份主节点DRbak),考虑充分利用资源可以将DRbak做为realserver一、配置基于DR模式Lvs集群1、下载ipvsadm管理程序/software/注意对应自己的内核版本ipvsadm-1.24.tar.gztar zxvf ipvsadm-1.24.tar.gzcd ipvsadm-1.24make && make install注意在make时可能会出现很多错误的信息,请按照如下操作就可以心编译正常ln -s /usr/src/kernels/2.6.9-22.EL-i686/ /usr/src/linuxcd ipvsadm-1.24make && make install2、配置VIP脚本[root@ns ~]#more /etc/init.d/lvsDR#!/bin/sh#create in 20060812 by ghb# description: start LVS of DirectorserverVIP=192.168.0.100RIP1=192.168.0.127RIP2=192.168.0.128#RIPn=192.168.0.128~254GW=192.168.0.1. /etc/rc.d/init.d/functionscase "$1" instart)echo " start LVS of DirectorServer"# set the Virtual IP Address/sbin/ifconfig eth0:0 $VIP broadcast $VIP netmask 255.255.255.255 up/sbin/route add -host $VIP dev eth0:0#Clear IPVS table/sbin/ipvsadm -C#set LVS/sbin/ipvsadm -A -t $VIP:80 -s rr (如果需要session保持添加-p 默认保持300秒)/sbin/ipvsadm -a -t $VIP:80 -r $RIP1:80 -g/sbin/ipvsadm -a -t $VIP:80 -r $RIP2:80 -g#/sbin/ipvsadm -a -t $VIP:80 -r $RIP3:80 -g#Run LVS/sbin/ipvsadm#end;;stop)echo "close LVS Directorserver"/sbin/ipvsadm -C;;*)echo "Usage: $0 {start|stop}"exit 1esac(-s rr 是使用了轮叫算法,可以自行选择相应的算法,更改rr就可以了,ipvsadm -h查看帮助。

lvs验证的小技巧【最新版3篇】目录(篇1)1.引言2.LVS 验证的重要性3.LVS 验证的小技巧3.1 确保 LVS 配置正确3.2 合理利用 LVS 日志3.3 监控 LVS 性能3.4 及时调整 LVS 负载3.5 优化 LVS 集群4.结论正文(篇1)【引言】负载均衡技术在现代网络架构中扮演着越来越重要的角色,它不仅可以提高系统的可用性和性能,还能有效地保证应用的持续稳定运行。

在众多负载均衡技术中,LVS(Linux Virtual Server)凭借其高性能、稳定性和可扩展性,成为许多企业的首选。

然而,要想充分发挥 LVS 的性能优势,合理的验证和调优是必不可少的。

本文将为大家介绍一些 LVS 验证的小技巧。

【LVS 验证的重要性】LVS 验证的目的是确保负载均衡系统能够正常工作,发现并解决潜在问题。

通过验证,我们可以确保 LVS 的配置、性能和稳定性都满足预期要求。

这对于保障整个系统的正常运行,提高用户体验具有重要意义。

【LVS 验证的小技巧】【3.1 确保 LVS 配置正确】正确的配置是 LVS 正常运行的基础。

我们需要定期检查 LVS 的配置文件,确保虚拟服务器、真实服务器和负载均衡器的配置都没有问题。

此外,还要确保 LVS 服务和关联的虚拟服务器服务都处于运行状态。

【3.2 合理利用 LVS 日志】LVS 日志是诊断问题的重要依据。

我们可以通过查看日志文件,了解系统运行状况,发现潜在问题。

对于异常日志,我们要及时分析原因,采取相应措施进行处理。

【3.3 监控 LVS 性能】性能是衡量 LVS 负载均衡效果的重要指标。

我们要定期监控 LVS 的性能数据,如请求处理速度、吞吐量等,以便及时发现性能瓶颈,并采取优化措施。

【3.4 及时调整 LVS 负载】根据业务发展和系统运行状况,我们需要定期对 LVS 负载进行调整。

对于负载较重的服务器,可以适当增加服务器数量以分担负载;而对于负载较轻的服务器,可以考虑合并以减少资源浪费。

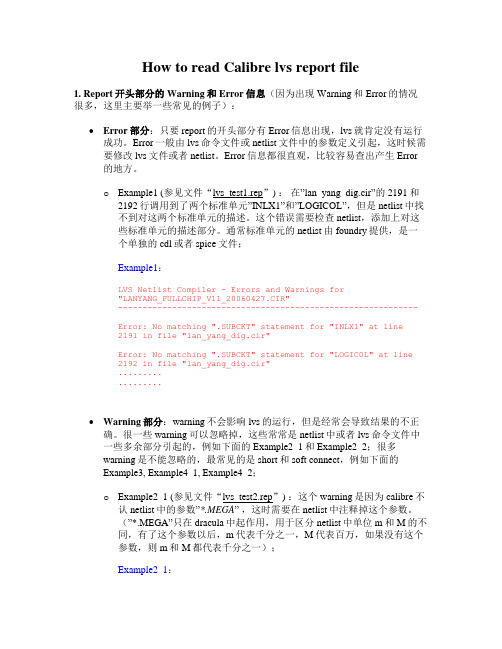

How to read Calibre lvs report file1.Report开头部分的Warning和Error信息(因为出现Warning和Error的情况很多,这里主要举一些常见的例子):∙Error部分:只要report的开头部分有Error信息出现,lvs就肯定没有运行成功。

Error一般由lvs命令文件或netlist文件中的参数定义引起,这时候需要修改lvs文件或者netlist。

Error信息都很直观,比较容易查出产生Error的地方。

o Example1 (参见文件“lvs_test1.rep”) :在”lan_yang_dig.cir”的2191和2192行调用到了两个标准单元”INLX1”和”LOGICOL”,但是netlist中找不到对这两个标准单元的描述。

这个错误需要检查netlist,添加上对这些标准单元的描述部分。

通常标准单元的netlist由foundry提供,是一个单独的cdl或者spice文件;Example1:LVS Netlist Compiler - Errors and Warnings for"LANYANG_FULLCHIP_V11_20060427.CIR"-------------------------------------------------------------Error: No matching ".SUBCKT" statement for "INLX1" at line2191 in file "lan_yang_dig.cir"Error: No matching ".SUBCKT" statement for "LOGIC0L" at line2192 in file "lan_yang_dig.cir"..................∙Warning部分:warning不会影响lvs的运行,但是经常会导致结果的不正确。

使用LVS实现负载均衡原理及安装配置详解负载均衡集群是load balance 集群的简写,翻译成中文就是负载均衡集群。

常用的负载均衡开源软件有nginx、lvs、haproxy,商业的硬件负载均衡设备F5、Netscale。

这里主要是学习LVS 并对其进行了详细的总结记录。

一、负载均衡LVS基本介绍LB集群的架构和原理很简单,就是当用户的请求过来时,会直接分发到Director Server上,然后它把用户的请求根据设置好的调度算法,智能均衡地分发到后端真正服务器(real server)上。

为了避免不同机器上用户请求得到的数据不一样,需要用到了共享存储,这样保证所有用户请求的数据是一样的。

LVS是Linux Virtual Server 的简称,也就是Linux虚拟服务器。

这是一个由章文嵩博士发起的一个开源项目,它的官方网站是现在LVS 已经是Linux 内核标准的一部分。

使用LVS 可以达到的技术目标是:通过LVS 达到的负载均衡技术和Linux 操作系统实现一个高性能高可用的Linux 服务器集群,它具有良好的可靠性、可扩展性和可操作性。

从而以低廉的成本实现最优的性能。

LVS 是一个实现负载均衡集群的开源软件项目,LVS架构从逻辑上可分为调度层、Server集群层和共享存储。

二、LVS的基本工作原理1.当用户向负载均衡调度器(Director Server)发起请求,调度器将请求发往至内核空间2.PREROUTING链首先会接收到用户请求,判断目标IP确定是本机IP,将数据包发往INPUT链3.IPVS是工作在INPUT链上的,当用户请求到达INPUT时,IPVS会将用户请求和自己已定义好的集群服务进行比对,如果用户请求的就是定义的集群服务,那么此时IPVS会强行修改数据包里的目标IP地址及端口,并将新的数据包发往POSTROUTING链4.POSTROUTING链接收数据包后发现目标IP地址刚好是自己的后端服务器,那么此时通过选路,将数据包最终发送给后端的服务器三、LVS的组成LVS 由2部分程序组成,包括ipvs 和ipvsadm。

lvs验证步骤-回复LVS(Linux Virtual Server)是一种开源的高性能、可扩展的服务器负载均衡解决方案。

它能够通过将服务分发到多个服务器上以提高性能和可用性。

本文将介绍LVS验证的步骤,以帮助读者更好地了解和应用这一技术。

第一步:环境搭建要开始进行LVS验证,我们首先需要搭建一个适合的实验环境。

在这个环境下,我们需要至少三台服务器,一台作为负载均衡器,两台作为真实的服务器。

这些服务器可以是物理服务器或者虚拟机。

我们还需要确保这些服务器之间可以相互通信,最常用的方式是通过内部网络或者交换机进行连接。

第二步:安装LVS软件包在负载均衡器上,我们需要安装LVS软件包以支持负载均衡功能。

具体而言,我们需要安装ipvsadm软件包来配置虚拟地址和服务转发规则。

我们可以使用Linux发行版自带的包管理工具来安装这个软件包,如apt、yum等。

安装完成后,我们可以通过运行ipvsadm命令来检查软件是否正确安装。

第三步:配置负载均衡器在负载均衡器上,我们需要进行一些配置操作来实现负载均衡的功能。

首先,我们需要创建一个虚拟地址,这个地址将会被客户端用来访问我们的服务。

我们可以使用ipvsadm命令来创建虚拟地址,并设置对应的服务协议(如TCP、UDP)和端口号。

接下来,我们需要设置服务器池,即真实的服务器列表。

我们可以使用ipvsadm命令将每台真实服务器添加到服务器池中,并设置对应的权重。

权重是一个用来表示服务器准备处理客户端请求的能力的参数,权重越高,服务器处理请求的机会越大。

在添加服务器之后,我们还需要设置服务转发规则,以确定请求如何分发到服务器池中的服务器。

第四步:验证负载均衡一旦负载均衡器和真实服务器的配置完成,我们就可以开始验证负载均衡的功能了。

首先,我们可以通过在客户端机器上使用curl或者telnet等工具来测试访问虚拟地址。

如果一切正常,我们应该能够访问到服务,并且请求将会被正确地分发到服务器池中的真实服务器上。

lvs -nat原理LVS(Linux Virtual Server)是一种基于Linux操作系统的负载均衡技术。

它通过将网络流量分发到多个服务器上,以提高系统的可用性和性能。

LVS的核心原理是通过网络地址转换(NAT)来实现。

NAT是一种将外部网络地址转换为内部网络地址的技术。

在LVS中,NAT被用于将客户端请求从虚拟服务器的公共IP地址转发到后端真实服务器的私有IP地址上。

这样,客户端就可以直接与真实服务器进行通信,而无需知道真实服务器的具体地址。

通过这种方式,LVS 可以实现负载均衡和高可用性。

在LVS中,NAT的工作原理如下:1. 首先,LVS通过监听虚拟服务器上的特定端口,接收来自客户端的请求。

2. 当收到请求后,LVS会根据事先配置的负载均衡算法,选择一个合适的真实服务器来处理该请求。

3. 接下来,LVS会将客户端请求的源IP地址和端口号修改为虚拟服务器的IP地址和端口号,并将请求转发给选定的真实服务器。

4. 真实服务器接收到请求后,将响应发送给虚拟服务器。

5. 虚拟服务器再将真实服务器的响应转发给客户端,同时将响应中的目标IP地址和端口号修改为客户端的IP地址和端口号。

通过这种方式,LVS实现了客户端和真实服务器之间的无缝通信,同时将客户端的请求平均分配给多个真实服务器,提高了系统的性能和可用性。

总结:LVS - NAT是一种基于Linux的负载均衡技术,通过网络地址转换实现。

它将客户端请求从虚拟服务器的公共IP地址转发到后端真实服务器的私有IP地址上,实现了负载均衡和高可用性。

通过对LVS - NAT的工作原理的了解,我们可以更好地理解和应用这一技术,提升系统的性能和稳定性。

LVS(⼀)调度原理以及调度算法LVS调度原理以及调度算法在了解LVS调度原理之前,⾸先的了解⼀下IPTABLES防⽕墙⼯作原理。

⼀.IPTABLES ⼯作原理 IPTABLES其实不是真正的防⽕墙,它实际上由两个组件netfilter 和 iptables 组成,netfilter 才是真正的防⽕墙,位于内核空间,⽽iptables是位于⽤户空间的⼀个命令⾏⼯具,我们使⽤这个⼯具制定规则,然后netfilter执⾏iptables⼯具制定的规则。

Netfilter是Linux引⼊的⼀个⼦系统,它作为⼀个通⽤的、抽象的框架,提供⼀整套的hook函数的管理机制,使得诸如数据包过滤、⽹络地址转换(NAT)和基于协议类型的连接跟踪成为了可能。

netfilter的架构就是在整个⽹络流程的若⼲位置放置了⼀些检测点(HOOK),⽽在每个检测点上登记了⼀些处理函数进⾏处理。

IP层的五个HOOK点(链、钩⼦)的如下1. NF_IP_PRE_ROUTING刚刚进⼊⽹络层的数据包通过此点(刚刚进⾏完版本号,校验和等检测),⽬的地址转换在此点进⾏。

2. NF_IP_LOCAL_IN经路由查找后,送往本机的通过此检查点,INPUT包过滤在此点进⾏。

3. NF_IP_FORWARD要转发的包通过此检测点,FORWARD包过滤在此点进⾏。

4. NF_IP_POST_ROUTING所有马上便要通过⽹络设备出去的包通过此检测点,内置的原地址转换功能(包括地址伪装)在此点进⾏。

5. NF_IP_LOCAL_OUT本机进程发出的包通过此检测点,OUTPUT包过滤在此点进⾏。

如上图所⽰,客户端在访问服务器的web服务时,⾸先经过prerouting链,然后接着对数据包进⾏路由,判断访问的⽬标是否为本机,1.⽬标为本机 则通过input链到达⽤户空间的web服务中,若web服务确实有个进程监听请求数据包的请求的端⼝,就开始响应服务,负责则拒绝,接着,当web服务要响应客户端请求时,web服务会将响应数据报⽂发送⾄output链,postrouting链,最后响应⾄客户端。

Red Hat Cluster Manager安装操作系统,选择组件advance server,安装LVS部分。

两台主机,主机名为haha和hehe主机haha的本地ip地址为net0:192.168.2.11,net1:192.168.2.14主机hehe的本地ip地址为net0:192.168.2.12,net1:192.168.2.16(主机网络连线只能用直连线进行连接,不能用交叉线连接,否则双机不能进行监控)修改/etc/hosts文件,封掉localhost行的内容,写入本地主机、对方主机和虚拟主机相应的ip地址和主机名:(两台主机配置相同)192.168.2.11 haha192.168.2.12 hehe192.168.2.13 xixi进入/etc/sysconfig/rawdevices文件,增加两行内容:(两台主机设置相同)/dev/raw/raw1 /dev/sdb1/dev/raw/raw2 /dev/sdb2以上两行是LVS需要的两个裸设备作为系统监控使用,每个裸设备的空间不能小于10M。

当然需要fdisk建立两个两个相应的设备。

然后从起主机,进入/sbin下,./cluconfig进行cluster的配置:Red Hat Cluster Manager Configuration Utility (running on haha) --haha为本地主机名Enter cluster name [Red Hat Cluster Manager]:xixi --xixi为虚拟主机名Enter IP address for cluster alias [NONE]:192.168.2.13 --地址为虚拟地址--------------------------------Information for Cluster Member 0--------------------------------Enter name of cluster member [haha]: --本地成员,回车即可Enter number of heartbeat channels (minimum = 1) [1]: 2 --两块网卡心跳线(也可串口心跳)Channel type: net or serial [net]: --第一块网卡做心跳Enter hostname of the cluster member on heartbeat channel 0 [haha]: --心跳线成员名称Channel type: net or serial [net]: --第二块网卡做心跳线Enter hostname of the cluster member on heartbeat channel 1:hehe --另外一个成员名称Information about Quorum PartitionsEnter Primary Quorum Partition [/dev/raw/raw1]:Enter Shadow Quorum Partition [/dev/raw/raw2]:Information About the Power Switch That Power Cycles Member 'haha'Choose one of the following power switches:o NONEo RPS10o BAYTECHo APCSERIALo APCMASTERo WTI_NPSo SW_W ATCHDOGPower switch [NONE]:--------------------------------Information for Cluster Member 1--------------------------------Enter name of cluster member:hehe --对方成员名Enter hostname of the cluster member on heartbeat channel 0: heheEnter hostname of the cluster member on heartbeat channel 1: hahaInformation about Quorum PartitionsEnter Primary Quorum Partition [/dev/raw/raw1]:Enter Shadow Quorum Partition [/dev/raw/raw2]:Information About the Power Switch That Power Cycles Member 'hehe'Choose one of the following power switches:o NONEo RPS10o BAYTECHo APCSERIALo APCMASTERo WTI_NPSo SW_W ATCHDOGPower switch [NONE]:Save the cluster member information? yes/no [yes]: --对配置信息进行保存Save the cluster member information? yes/no [yes]:Writing to configuration file...doneConfiguration information has been saved to /etc/cluster.conf.----------------------------Setting up Quorum Partitions----------------------------Running cludiskutil -I to initialize the quorum partitions: doneSaving configuration information to quorum partitions: doneDo you wish to allow remote monitoring of the cluster? yes/no [yes]: --是否允许远程主机进行cluster监视访问Configuration on this member is complete.To configure the next member, invoke the following command on that system:# /sbin/cluconfig --init=/dev/raw/raw1Refer to the Red Hat Cluster Manager Installation and Administration Guidefor details.本地主机配置完成进入对方主机的/sbin目录,执行cluconfig –init=/dev/raw/raw1显示信息如下:Information about Channel 0/sbin/cluconfig: [: haha: unary operator expectedLooking for host haha (may take a few seconds)...Information about Channel 1/sbin/cluconfig: [: hehe: unary operator expectedLooking for host hehe (may take a few seconds)...Information about Quorum PartitionsInformation About the Power Switch That Power Cycles Member 'haha'Note: Operating a cluster without a remote power switch does not prmaximum data integrity guarantees.--------------------------------Information for Cluster Member 1--------------------------------/sbin/cluconfig: [: hehe: unary operator expectedLooking for host hehe (may take a few seconds)...Information about Channel 0/sbin/cluconfig: [: hehe: unary operator expectedLooking for host hehe (may take a few seconds)...Information about Channel 1/sbin/cluconfig: [: haha: unary operator expectedLooking for host haha (may take a few seconds)...Hostname does not map to any interface. Keep your selection? [yes]: Information about Quorum PartitionsInformation About the Power Switch That Power Cycles Member 'hehe' Note: Operating a cluster without a remote power switch does not provide maximum data integrity guarantees.Press to continue. --按回车继续Cluster name: xixiCluster alias IP address: 192.168.2.13--------------------Member 0 Information--------------------Name: hahaPrimary quorum partition: /dev/raw/raw1Shadow quorum partition: /dev/raw/raw2Heartbeat channels: 2Channel type: net, Name: hahaChannel type: net, Name: hehePower switch IP address or hostname: haha Identifier on power controller for member haha: un --------------------Member 1 Information--------------------Name: hehePrimary quorum partition: /dev/raw/raw1 Shadow quorum partition: /dev/raw/raw2 Heartbeat channels: 2Channel type: net, Name: heheChannel type: net, Name: hahaPower switch IP address or hostname: hehe Identifier on power controller for member hehe: un --------------------------Power Switch 0 Information--------------------------Power switch IP address or hostname: haha Type: NONELogin or port: unusedPassword: unused--------------------------Power Switch 1 Information--------------------------Power switch IP address or hostname: hehe Type: NONELogin or port: unusedPassword: unusedSave the cluster member information? yes/no [yes]: --是否进行保存Writing to configuration file...doneConfiguration information has been saved to /etc/cluster.conf.Saving configuration information to quorum partitions: doneDo you wish to allow remote monitoring of the cluster? yes/no [yes]:----------------------------------------------------------------Configuration on this member is complete.Execute "/sbin/service cluster start" to start the cluster software.这时,双机软件基本配置已经完成,在两台主机上分别运行service cluster start启动服务通过cluadmin进行管理,如下所示:cluadmin> cluster statusCluster Status Monitor (xixi) 11:16:11Cluster alias: xixi========================= M e m b e r S t a t u s==========================Member Status Node Id Power Switch-------------- ---------- ---------- ------------haha Up 0 Goodhehe Up 1 Good========================= H e a r t b e a t S t a t u s ==================== Name Type Status------------------------------ ---------- ------------haha <--> hehe network ONLINE ============。

lvs验证步骤-回复LVS(Linux Virtual Server)是一个开源的负载均衡软件,用于分发网络流量到多台服务器上,从而提高性能和可靠性。

在本文中,我们将介绍LVS的验证步骤,以帮助您理解和应用这个强大的工具。

验证LVS之前,我们需要明确一些基本概念。

LVS由三个主要组件组成:LVS Director(调度器)、LVS Real Server(真实服务器)和LVS Client (客户端)。

LVS Director是负载均衡系统的入口点,负责接收和分发流量。

LVS Real Server是实际承载服务的服务器。

LVS Client则是访问服务的用户。

以下是验证LVS的步骤:1. 第一步是配置LVS Director。

配置LVS Director的方法有很多,这里我们以基于IPVS(IP Virtual Server)模块的TCP负载均衡为例。

首先,确保您的操作系统已加载IPVS模块。

然后,在Director上设置“ip_forward”以启用数据包转发功能。

接下来,创建一个虚拟IP地址,并将其绑定到网络接口上。

最后,配置调度算法(如Round Robin、Weighted Round Robin等)和后端服务器列表。

2. 第二步是配置LVS Real Server。

在每个LVS Real Server上,您需要设置虚拟IP地址,并确保与LVS Director上的虚拟IP地址相同。

然后,配置实际服务(如HTTP、FTP等)。

3. 第三步是测试LVS配置。

首先,您可以通过在LVS Director上运行“ipvsadm -Ln”命令来验证是否正确配置了负载均衡规则。

这将显示当前的IPVS连接状态。

然后,尝试通过虚拟IP地址访问LVS服务,以确保请求正确地转发到后端服务器上。

4. 第四步是监控LVS性能。

您可以使用一些工具来监控LVS的性能,如“ipvsadm”命令、LVS的日志文件以及其他网络监测工具。

Ifeng 技术交流(LVS+HA应用案例及经验分享)作者:NetSeek 【题纲】适?[LVS项目介绍] [LVS集群的体系结构] [LVS集群中的IP负载均衡技术][LVS集群的负载调度]2)LinuxTone 相关LVS技术档汇总: /thread-1191-1-1.html2、 LVS 三种IP负载均衡技术对比:三种IP负载均衡技术的优缺点归纳在下表中:_ VS/NAT VS/TUN VS/DRServer any Tunneling Non-arp device server network private LAN/WAN LANserver number low (10~20) High (100) High (100)server gateway load balancer own router Own router【注】 以上三种方法所能支持最大服务器数目的估计是假设调度器使用100M网卡,调度器的硬件配置与后端服务器的硬件配置相同,而且是对一般Web服务。

使用更 高的硬件配置(如千兆网卡和更快的处理器)作为调度器,调度器所能调度的服务器数量会相应增加。

当应用不同时,服务器的数目也会相应地改变。

所以,以上数 据估计主要是为三种方法的伸缩性进行量化比较。

3、LVS目前实现的几种调度算法IPVS在内核中的负载均衡调度是以连接为粒度的。

在HTTP协议(非持久)中,每个对象从WEB服务器上获取都需要建立一个TCP连接,同一用户的不同请求会被调度到不同的服务器上,所以这种细粒度的调度在一定程度上可以避免单个用户访问的突发性引起服务器间的负载不平衡。

在内核中的连接调度算法上,IPVS已实现了以下十种调度算法:* 轮叫调度(Round-Robin Scheduling)* 加权轮叫调度(Weighted Round-Robin Scheduling)* 最小连接调度(Least-Connection Scheduling)* 加权最小连接调度(Weighted Least-Connection Scheduling)* 基于局部性的最少链接(Locality-Based Least Connections Scheduling)* 带复制的基于局部性最少链接(Locality-Based Least Connections with Replication Scheduling)* 目标地址散列调度(Destination Hashing Scheduling)* 源地址散列调度(Source Hashing Scheduling)* 最短预期延时调度(Shortest Expected Delay Scheduling)* 不排队调度(Never Queue Scheduling)对应: rr|wrr|lc|wlc|lblc|lblcr|dh|sh|sed|nq,Ldirecotrd配置选项及ipvsadm使用参数.ldirectord配置选项 ipvsadm使用的参数 ipvsadm -L的输出 LVS转发方法 gate -g Route LVS-DRipip -i Tunnel LVS-TUNmasq -m Masq LVS-NAT4、集群架构时我们应该采用什么样的调度算法?在一般的网络服务(如HTTP和Mail Service等)调度中,我会使用加权最小连接调度wlc或者加权轮叫调度wrr算法。

基于局部性的最少链接LBLC和带复制的基于局部性最少链接LBLCR主要适用于Web Cache集群。

目标地址散列调度和源地址散列调度是用静态映射方法,可能主要适合防火墙调度。

最短预期延时调度SED和不排队调度NQ主要是对处理时间相对比较长的网络服务。

其实,它们的适用范围不限于这些。

我想最好参考内核中的连接调度算法的实现原理,看看那种调度方法适合你的应用。

5、LVS的ARP问题2.4.x kernels:Hidden Patcharptableiptables2.6.x kernels: (关闭arp查询响应请求)net.ipv4.conf.eth0.arp_ignore = 1net.ipv4.conf.eth0.arp_announce = 2net.ipv4.conf.all.arp_ignore = 1net.ipv4.conf.all.arp_announce = 2arping tools二、 L VS各种HA方案安装及对比1、三种方案安装及介绍.i.lvs+heartbeat+ldirectord (UltraMonkey)详细参照: /thread-1535-1-1.htmlii.Keepalived 方案 (keepalived.conf 一个配置文件搞定所有!)详细参照: /thread-1077-1-1.htmliii.Piranha 方案 (lvs.conf 配置简洁,漂亮的WEB配置界面.)详细参照: /thread-1607-1-1.html2、三种方案对比及评价:1)LVS+Heartbeat+Ldirectord 方案:配置较为复杂灵活.heartbeat心跳检测,heartbeat可定制的脚本资源比较多,可定制功能比较强,能够实现真正意义上的高可用性.2)Keepalived方案:配置简洁,由keepalived.conf一个配置文件就可以搞定.而且稳定和性能都不错,国内门户sina内部应用比较多.3)Piranha 方案:Piranha的一个独到之处,它可以通过检测节点的load信息,自动调整节点的权值。

还有Piranha提供了一个Web的配置管理界面Piranha-gui(不要BS我),这对于那些不熟悉LVS的管理员来说,是个有吸引力的东西。

3、列举部分网站项目实施采用的LVS+各HA方案例.1)LVS+Heartbeat+Ldirectord…………2)Keepalived sina应用此方案比较多.……..3)Piranha目前我没有在项目中实施,有新项目我会尽量实施这个方案。

七、 项目实施案例及经验分享.1、机房无法实时刷新MAC,LVS+Heartbeat方案无法正常随机切换IP?假如两台VS之间使用的互备关系,那么当一台VS接管LVS服务时,可能会网络不通,这时因为路由器的MAC缓存表里无法及时刷新MAC.关于vip这个地址的MAC地址还是替换的VS的MAC,有两种解决方法,一种是修改新VS的MAC地址,另一种是使用send_arp /arpiing命令.以arping命令为例./sbin/arping -I eth0 -c 3 -s ${vip}${gateway_ip} > /dev/null 2>&1Eg:/sbin/arping -I eth0 -c 3 -s 192.168.1.6192.168.1.1【注】07年部署项目时,263机房遇到此问题,最好让机房调整路由MAC缓存表的刷新频率;同朋公司移动机房实施相关项目时发现切换IP后还是无法访问VIP,最后利用上面的arping一个命令搞定.【附】如果采用Piranha/keealived方案切换的时候会内置自动发送send_arp命令.UltraMonkey方案经测试也会自动发送此命令.如用heartbeat方案,需要写一个send_arp或者arping相关的脚本当作heartbeat一个资源切换服务的时候自动发送相关命令脚本.2、某台机器down掉以后,IPVS列表中权值已经置0了,为什么还轮询到这台机器上?配置 ldirectord.confquiescent=no或 echo 1 >/proc/sys/net/ipv4/vs/expire_nodest_conn【注】经如上设置某台Realserver服务down掉以后如何从IPVS列表自动中删除恢复时如何自动添加.3、为什么做压力测试的时候,LVS不能负载均衡多部分连接只到某一台机器上?难道是LVS不能实现真正的负载均衡?这和LVS脚本里指定-p参数有关,如果指定了一个client在一定的时间内,将会被调度到同一台RS上。

所以你在从来源来做压力测试的时候大部分连接会调度到同一台机器上,这样就出现了负载不均衡的状况。

很多人经常问我这个问题,仍后我叫他们多从几个点去同时向LVS服务器做压力测试的时候就发现负载很均衡了。

四、关于LVS的几个小认识1.LVS调度的最小单位是“连接”。

2.当apache的KeepAlive被设置成Off时,“连接”才能被较均衡的调度。

3.在不指定-p参数时,LVS才真正以“连接”为单位按“权值”调度流量。

4.在指定了-p参数时,则一个client在一定时间内,将会被调度到同一台RS。

5.可以通过”ipvsadm -set tcp tcpfin udp”来调整TCP和UDP的超时,让连接淘汰得快一些。

6.在NAT模式时,RS的PORT参数才有意义。

7.DR和TUN模式时,InActConn 是没有意义的(Thus the count in the InActConn columnfor LVS-DR, LVS-Tun is inferred rather than real.)五、LVS性能调优Least services in System or Compile kernel.LVS self tuning( ipvsadm Timeout (tcp tcpfin udp)).ipvsadm -Ln --timeoutTimeout (tcp tcpfin udp): 900 120 300ipvsadm --set tcp tcpfin udpImproving TCP/IP performancenet.ipv4.tcp_tw_recyle=1net.ipv4.tcp_tw_reuse=1net.ipv4.tcp_max_syn_backlog=8192net.ipv4.tcp_keepalive_time=1800net.ipv4.tcp_fin_timeout=30net.core.rmem_max=16777216net.core.wmem_max=16777216net.ipv4.tcp_rmem=4096 87380 16777216net.ipv4.tcp_wmem=4096 65536 16777216dev_max_backlog=3000六、LVS监控1、Nagios/Cacti2、RRDtool /lvs-rrd/3、monipvsadm -L -n --statsProt LocalAddress:Port Conns InPkts OutPkts InBytes OutBytes连接数输入包输出包输入流量输出流量可根据此命令编写脚本,制作Cacti监控模板。