一种提高SVM分类能力的同步优化算法

- 格式:pdf

- 大小:517.47 KB

- 文档页数:9

支持向量机的性能优化和改进支持向量机(Support Vector Machine, SVM)是一种常用的监督学习算法,广泛应用于模式识别、文本分类、图像处理等领域。

然而,在实际应用中,SVM存在一些性能上的瓶颈和问题。

为了进一步提高SVM的性能和效率,并解决其在大规模数据集上的不足,研究者们提出了多种优化和改进方法。

本文将从几个方面介绍SVM的性能优化和改进.一、硬间隔支持向量机硬间隔支持向量机是SVM的最基本形式,其目标是找到一个最优的超平面,将两个不同类别的样本点分隔开来。

然而,硬间隔支持向量机对数据的要求非常严苛,要求数据是线性可分的。

对于线性不可分的数据,就无法使用硬间隔SVM进行分类。

因此,研究者提出了软间隔支持向量机。

二、软间隔支持向量机软间隔支持向量机允许一定程度上的数据混合在分隔超平面的两侧,引入了一个松弛变量来控制分隔裕度。

这样能够更好地适应线性不可分的情况,并且对噪声数据有一定的容错性。

然而,在实际应用中,软间隔SVM的性能也受到很多因素的影响,需要进行进一步的改进和优化。

三、核函数和非线性支持向量机在实际应用中,很多数据集是非线性可分的,使用线性支持向量机无法得到好的分类结果。

为了解决这个问题,研究者们提出了核支持向量机。

核函数将数据从原始空间映射到高维特征空间,使得数据在高维空间中更容易线性可分。

常用的核函数有线性核函数、多项式核函数、高斯核函数等。

通过使用核函数,支持向量机可以处理更加复杂的分类问题,提高了分类性能。

四、多分类支持向量机支持向量机最初是用于二分类问题的,即将数据分成两个类别。

然而,在实际应用中,很多问题是多分类问题。

为了解决多分类问题,研究者们提出了多分类支持向量机。

常见的方法有一对一(One-vs-One)和一对多(One-vs-Rest)两种。

一对一方法将多类别问题转化为多个二分类问题,每次选取两个类别进行训练。

一对多方法则将多个类别中的一个作为正例,其余类别作为反例进行训练。

提高SVM算法的分类准确率的方法与思路如今,SVM(支持向量机)算法已经成为了许多机器学习任务中的重要算法之一。

在分类问题中,SVM算法具有较好的准确率和泛化能力,但是,在实际应用中,我们也会遇到一些个例点(outlier),这些点具有很大的噪声和干扰,其被错误地分到了某一分类,从而导致分类准确率下降。

因此,如何处理个例点对于提升SVM算法的分类准确率至关重要。

1. 对数据进行预处理在SVM算法中,数据预处理是提高分类器性能的重要步骤。

有时,我们的数据集中可能会存在缺失值、离群点(outlier)或异常值等问题。

如果直接忽略或剔除这些问题,会导致SVM算法分类结果的偏差。

因此,我们需要对数据进行预处理以消除这些问题。

比如,我们可以使用插值法对数据中的缺失值进行填充,对离群点(outlier)或异常值进行处理,将其剔除或替换成合理的值,从而提高模型的表现力。

2. 对数据集进行均衡在训练数据集中,我们可能会发现某个类别的样本数很少,而另一个类别的样本数很多。

这种情况下,分类器容易出现偏差,导致分类的准确率降低。

因此,我们需要对数据集进行均衡处理。

可以通过下采样(undersampling)或上采样(oversampling)的方法来解决。

下采样是删除训练集中某个类别的一些样本,使得该类别与其他类别的样本数相等。

上采样是增加某个类别的样本数,使得该类别与其他类别的样本数相等。

这样,分类器就能够更好地学习数据,提高分类准确率。

3. 数据特征的提取在SVM算法中,数据特征的提取可以说是至关重要的。

合适的特征提取方法能够让数据更好地对分类器产生区分作用,从而提高分类预测的准确率。

常用的特征提取方法包括主成分分析(PCA)、线性判别分析(LDA)和t-SNE等。

这些方法可以有效地降低数据的维度,提取关键点特征,从而让SVM算法更好地进行分类。

4. SVM参数的调优SVM算法中的参数调优也是提高分类准确率的重要方法之一。

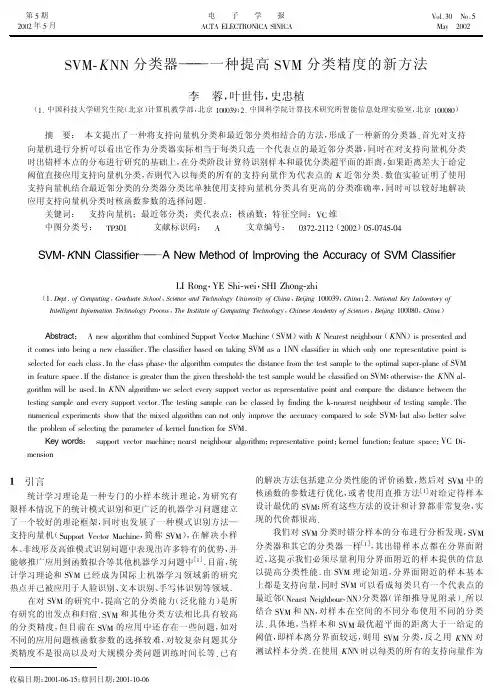

SVM-K NN 分类器———一种提高SVM 分类精度的新方法李蓉,叶世伟,史忠植(1.中国科技大学研究生院(北京)计算机教学部,北京100039;2.中国科学院计算技术研究所智能信息处理实验室,北京100080)摘要:本文提出了一种将支持向量机分类和最近邻分类相结合的方法,形成了一种新的分类器.首先对支持向量机进行分析可以看出它作为分类器实际相当于每类只选一个代表点的最近邻分类器,同时在对支持向量机分类时出错样本点的分布进行研究的基础上,在分类阶段计算待识别样本和最优分类超平面的距离,如果距离差大于给定阈值直接应用支持向量机分类,否则代入以每类的所有的支持向量作为代表点的K 近邻分类.数值实验证明了使用支持向量机结合最近邻分类的分类器分类比单独使用支持向量机分类具有更高的分类准确率,同时可以较好地解决应用支持向量机分类时核函数参数的选择问题.关键词:支持向量机;最近邻分类;类代表点;核函数;特征空间;VC 维中图分类号:TP301文献标识码:A文章编号:0372-2112(2002)05-0745-04SVM-!NN Classifier ———A New Method of lmproving the Accuracy of SVM Classifier LI Rong ,YE Shi-wei ,SHI Zhong-zhi(1.Dept.of Computing ,Graduate School ,Science and Technology Uniuersity of China ,Beijing 100039,China ;2.National Key Laboratory of Intelligent Information Technology Process ,The Institute of Computing Technology ,Chinese Academy of Sciences ,Beijing 100080,China )Abstract :A new algorithm that combined Support Vector Machine(SVM )with K Nearest neighbour (K NN )is presented and it comes into being a new classifier.The classifier based on taking SVM as a 1NN classifier in which only one representative point is selected for each class.In the class phase ,the algorithm computes the distance from the test sample to the optimal super-plane of SVM in feature space.If the distance is greater than the given threshold ,the test sample would be classified on SVM ;otherwise ,the K NN al-gorithm will be used.In K NN algorithm ,we select every support vector as representative point and compare the distance between the testing sample and every support vector.The testing sample can be classed by finding the k-nearest neighbour of testing sample.The numerical experiments show that the mixed algorithm can not only improve the accuracy compared to sole SVM ,but also better solve the problem of selecting the parameter of kernel function for SVM.Key words :support vector machine ;nearst neighbour algorithm ;representative point ;kernel function ;feature space ;VC Di-mension!引言统计学习理论是一种专门的小样本统计理论,为研究有限样本情况下的统计模式识别和更广泛的机器学习问题建立了一个较好的理论框架,同时也发展了一种模式识别方法—支持向量机(Support Vector Machine ,简称SVM ),在解决小样本、非线形及高维模式识别问题中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中[1].目前,统计学习理论和SVM 已经成为国际上机器学习领域新的研究热点并已被应用于人脸识别、文本识别、手写体识别等领域.在对SVM 的研究中,提高它的分类能力(泛化能力)是所有研究的出发点和归宿.SVM 和其他分类方法相比具有较高的分类精度,但目前在SVM 的应用中还存在一些问题,如对不同的应用问题核函数参数的选择较难,对较复杂问题其分类精度不是很高以及对大规模分类问题训练时间长等.已有的解决方法包括建立分类性能的评价函数,然后对SVM 中的核函数的参数进行优化,或者使用直推方法[1]对给定待样本设计最优的SVM ;所有这些方法的设计和计算都非常复杂,实现的代价都很高.我们对SVM 分类时错分样本的分布进行分析发现,SVM分类器和其它的分类器一样[1],其出错样本点都在分界面附近,这提示我们必须尽量利用分界面附近的样本提供的信息以提高分类性能.由SVM 理论知道,分界面附近的样本基本上都是支持向量,同时SVM 可以看成每类只有一个代表点的最近邻(Nearst Neighbour ,NN )分类器(详细推导见附录).所以结合SVM 和NN ,对样本在空间的不同分布使用不同的分类法.具体地,当样本和SVM 最优超平面的距离大于一给定的阈值,即样本离分界面较远,则用SVM 分类,反之用K NN 对测试样本分类.在使用K NN 时以每类的所有的支持向量作为收稿日期:2001-06-15;修回日期:2001-10-06第5期2002年5月电子学报ACTA ELECTRONICA SINICA Vol.30No.5May 2002代表点组,这样增加的运算量很少.实验证明了使用支持向量机结合最近邻的分类器分类比单独使用支持向量机分类具有更高的分类准确率,同时可以较好地解决应用支持向量机分类时核函数参数的选择问题.2SVM、!NN分类器简介2.1SVM分类器SVM是一种建立在统计学习理论基础上的分类方法[l].它主要基于以下三种考虑(l)基于结构风险最小化,通过最小化函数集的VC维来控制学习机器的结构风险,使其具有较强的推广能力.(2)通过最大化分类间隔(寻找最优分类超平面)来实现对VC维的控制,这是由统计学习理论的相关定理保证的.(3)而SVM在技术上采用核化技术,根据泛函中的Mercer定理,寻找一个函数(称核函数)将样本空间中内积对应于变换空间中的内积,即避免求非线形映射而求内积.2.2!NN分类器近邻法(简称NN)是模式识别非参数法中最重要的方法之一,NN的一个很大特点是将各类中全部样本点都作为“代表点”[l].lNN是将所有训练样本都作为代表点,因此在分类时需要计算待识别样本x到所有训练样本的距离,结果就是与x最近的训练样本所属于的类别.K NN是lNN的推广,即分类时选出x的I个最近邻,看这I个近邻中的多数属于哪一类,就把x分到哪一类.3SVM-!NN分类器实现3.1对SVM分类机理的分析在本文中,通过对SVM的分类机理分析,找到了SVM和NN分类器之间的联系,此联系由下面的定理给出:定理1SVM分类器等价于每类只选一个代表点的l-NN 分类器.证明见附录.区域",如分类用SVM,只计离测为支练分两示.旋示螺问题.差,的年惩罚参数C=5,分类阈值!选为0.8.选择了四组不同的核函数参数测试,比较两种算法对不同参数的分类效果.实验结果如表1所示.(2)文本分类实验:将下载的5642个中文网页后通过人工方式将其分为十三类后,对各个类标明其输出.这时一个多类分类问题,针对此多类问题我们构造了SVM多值分类器,构造方法采取一对一方式[4],训练了!(+1)2(=13)个SVM二值子分类器.本次实验所选取的核函数为感知机核函数(x,xi)=tanh(g !(x・x i)+c),大量数据测试证明对于网页分类数据,采用感知机核函数在分类准确率和速度上均优于其它核函数.在此实验中错误惩罚参数C=5,分类阈值!取为0.6.除了对综合测试集进行测试外,我们还从中选取了有代表性几个类分别测试,测试结果如表2所示.表!双螺旋线分类SVM和K SVM算法比较核参数分类算法圈数:2圈数:3圈数:4g=0.5SVM54.7312%50.9241%47.1546% KSVM49.3677%48.4618%50.0917%g=0.05SVM61.6282%50.9241%50.6731% KSVM95.7631%86.3446%81.0137%g=0.03SVM81.6002%82.1874%72.8237% KSVM92.8041%86.3446%85.1858%g=0.01SVM95.9519%87.8010%57.6668% KSVM95.7631%86.3446%85.1876%表"对于文本分类SVM和K SVM算法比较核参数分类算法综合类工业类体育类生活类政治类g=2SVM65.1423%56.9759%83.8684%63.3834%75.7044% KSVM68.8713%60.3927%88.8192%64.5993%78.3995%g=0.5SVM66.6612%59.888%83.3060%66.4731%81.4176% KSVM69.1269%62.0845%87.9798%65.5740%82.2401%g=0.1SVM46.2187% 2.9668%59.4340%26.8909%87.9119% KSVM64.1182%61.8701%85.3217%54.3182%89.1481%g=0.05SVM30.2999%0%31.3306%0%92.7028% KSVM64.0689%61.3808%82.9425%51.1887%93.9405%(3)实验分析从实验的结果数据可以得出两个结论:一是使用SVM-K NN分类可以减轻对核函数参数选择的敏感程度,缓解对参数选择的困难.对于SVM分类器,核函数参数的选择是非常重要但很困难的.如表1中当参数g=0.5、g=0.01及表2中的g=0.5、g=0.05,SVM的分类性能差别很大.对于同一参数,问题不同分类效果差别也很大,如上表1中g=0.01,对圈数为二、三的螺旋线,SVM的分类效果很好,但对于四圈的螺旋线,SVM的识别率不如选择g=0.03的识别率.带入K SVM算法后,对于参数的选择不是很敏感.如表1中的g= 0.05和g=0.01,K SVM算法的效果差别很小,性能比较稳定.第二个结论是使用SVM-K NN分类器在一定程度上比使用SVM具有更好的性能.针对四圈情况,数据的线形不可分程度高,使用SVM分类性能低,而使用K SVM算法分类精度提高较明显.而当实际问题相对好分时(表1中的二、三圈螺旋线),二者的分类效果差别不大.这是因为当实际问题比较易分时,SVM训练后所得到支持向量个数少,在K SVM中所选取的代表点也少;实际问题复杂程度高时,SVM训练后所得到支持向量个数多,K SVM算法所携带的信息更高,而此时SVM 分别对正反例支持向量组仅合成一个代表点,损失的信息也相对较多.#结论本文将SVM和K NN分类器相结合构造了一种新的分类器,该分类器基于将SVM分类器等价于对每类支持向量只取一个代表点的1NN分类器,针对当测试样本在分界面附近时容易分错的情形引入K NN分类选取每个支持向量作为代表点.SVM-K NN分类器是一种通用的分类算法,使用该分类器的分类准确率比单纯使用SVM分类器一般有不同程度的提高,并且该分类器在一定程度上不受核函数参数选择的影响,具有一定的稳健性.进一步的工作是从SVM的分类机理得到启发,不一定采用每个支持向量作为代表点,而对它们进行组合选取多个代表点进行分类.附录:定理!证明已知线性可分样本集为(xi,yi),i=1,…,l,xi"Rd,y"{-1,+1}为类别标志,d空间维数.最优分类面问题可以表示成如下优化问题的对偶问题W(")=#li=1"i-12#li,j=1"i"j y i y j(x i・x j)(1)约束条件为:0$"i,i=1,…,I与#li=1"i y i=0(2)根据Kuhn-tucker条件,这个优化问题的解必须满足"i(y i[(w,x i)-J]-1)=0,i=1,…,l(3)相应的分类函数也变为f(x)=Sgn#iy i"i・(x i,x)-()J(4)首先分别利用正、反例支持向量组成两个代表点#(x)+ =1C#lyi=1,i=1"i#(x i),#(x)-=1C#lyi=-1,i=1"i#(x i).其中#yi=1"i=#yi=-1"i=C(根据目标函数对偶问题的等式约束条件#li=1"i y i=0),对于最优解w=#li=1"i#(x i)=C(#(x)+-#(x)-),由式(3)对任意正例的样本有"i((w,#(x i))-J-1)=0,从而有0=#yi=1"i((w,#(x i))-J-1)=(w,#yi=1"i#(x i))-C・J-C=(C(#(x)+-#(x)-),C#(x)+)-C・J-C=C[C((#(x)+-#(x)-,#(x)+))-J-1](5)这样有J=C(#(x)+-#(x)-,#(x)+)-1同样由式(3),对任意反例的样本有747第5期李蓉:SVM-K NN分类器———一种提高SVM分类精度的新方法J=C((!(x)+-!(x)-,!(x)-))+1(6)由(式(5)+式(6))/2可得J=C2((!(x)+-!(x)-,!(x)++!(x)-))=C2((x+,x+)-(x-,x-))(7)在SVM的分类过程代入1NN分类,可得到下式:g(x)=!!(x)-!(x)-!2-!!(x)-!(x)+!2=2(x,x+)-2(x,x-)+(x-,x-)-(x+,x+)=2C"i"i y i(x,x i)+C2[(x-,x-)-(x+,x+ {})](由式(7)可得)=2C"i"i y i(x,x i)-{}J(8)参考文献:[1]Vapnik V N.The Nature of Statisticai Learning Theory[M].NY:Springer Veriag.[2]边肇祺,张学工.模式识别[M].北京:清华大学出版社.2000.[3]Vapnik V N.Estimation of dependencies based on empiricai data[R].Beriin:Springer Veriag,1982.[4]Burges C J C.A tutoriai on support vector machines for pattern recogni-tion[J].Data Mining and Knowiedge Discvery,1998,2(2).[5]Weston J,Watkins C.Muiti-ciass support vector[J].machines.Royai Hoiioway Coiiege,Tech Rep:CSK-TR-98-04,1998.[6]Thorston Joachims.Text Categorization With Support Vector Machine:iearning with reievant features[R].University Dortmund,1998.作者简介:李蓉女,1973年生于北京,1996年于北京理工大学获工学学士位,1999年进入中国科技大学研究生院(北京)计算机软件专业攻读硕士学位,2000年10月至今在中科院计算技术研究所智能信息处理开放实验室做硕士论文,师从于史忠植研究员,研究方向为机器学习、神经计算,已发表学术论文3篇.叶世伟男,1968年生于四川,分别于1991年、1993年、1996年于四川师范大学、北京大学、中科院计算技术研究所获得理学学士、理学硕士和工学博士学位,现任中科院研究生计算机教学部院副教授,主要研究方向为神经计算、优化理论,已发表学术论文十余篇###############################################.2002国际存储展览暨技术研讨会在京召开由信息产业部电子信息产品管理司、中国电信、国家邮政局及中国计算机学会信息存储技术专业委员会支持,中国电子信息产业发展研究院(CCID)主办,赛迪展览公司承办的“2002国际存储展览暨技术研讨会(Storage Infoworid2002)”4月25~27日在北京中国国际科技会展中心隆重举行.信息产业部苟仲文副部长参加开幕主题演讲并致欢迎辞,随后在信息产业部有关司局领导的陪同下饶有兴趣地参观了展览会,并与参展企业代表亲切座谈.来自各有关部委和行业用户部门的三十多位领导和近千余名专业人士出席了展览及研讨会.Sotrage Infoworid2002聚焦存储领域热点,汇聚如EMC、SUN、HP、Network Appiiance、Xiotech、Seagate、CA、Auspex、RC、Spectra Logic、VERITAS、Ouantum、Maxtor、SONY、ANEKtek、清华同方、亚美联等三十余家国内外知名存储软硬件厂商、存储系统集成商、存储技术开发商及相关的经销商和渠道合作伙伴,内容涵盖网络存储、光存储、移动存储、存储软件及存储应用解决方案.EMC公司在展会上推出了一系列高级、整合并经过验证的业务连续性解决方案;Sun公司的Storage ONE体系架构提供了一个开放、集成化和自动的存储管理解决方案;Network Appiiance作为数据存储和内容传输领域的世界领先者,为当今数据激增的企业提供开放的网络存储解决方案;亚美联公司作为国内首家完全自主知识产权的企业级存储产品供应商,推出的国内第一套达到国际先进技术水平的企业级存储系统Estor NAS18/2800、Estor SAN产品系列;Spectra Logic 公司的Spectra64000企业级磁带库、昆腾公司的基于磁盘的产品系列———第一款产品Ouantum DX30等都在展会上亮相.在两天半的研讨会中,来自EMC、SUN、HP、XIOtech、CA、Spectra Logic、清华同方等公司的国内外存储专家,将从存储的最新动态、发展方向、最新技术、解决方案和成功案例等方面发表精彩演讲.IT界称2001为存储年,而2002年将为中国存储市场迎来又一高峰.Storage Infoworid2002作为国内IT存储领域举办的权威盛会,必将以优质的服务为国内外关注中国存储市场发展的厂商及用户架起供需沟通的桥梁.847电子学报2002年。

遗传算法优化svm参数遗传算法是一种基于自然适应性进化理论的优化算法,它通过模拟自然界中的进化过程,通过遗传算子(交叉和变异操作)对个体进行进化和选择,以找到最优解决方案。

支持向量机(Support Vector Machine,SVM)是一种非常有效的分类算法,通过在数据集中找到最有代表性的样本点,构建超平面分离不同类别的样本。

优化SVM的参数可以提高分类的准确率和稳定性。

下面是使用遗传算法优化SVM参数的一般步骤:1. 确定优化目标:首先明确需要优化的SVM参数,如惩罚系数C、核函数类型和参数、松弛变量等,这些参数会影响模型的性能。

2. 设计基因编码:将待优化的参数映射为基因的编码形式,可以使用二进制、整数或浮点数编码。

例如,某个参数的取值范围为[0, 1],可以使用浮点数编码。

3. 初始化种群:随机生成初始的种群,每个个体都表示一个SVM参数的取值组合。

4. 适应度评估:使用训练集对每个个体进行评估,计算其在测试集上的准确率或其他指标作为个体的适应度。

5. 选择操作:根据适应度排序或轮盘赌等策略,选择优秀个体进行遗传操作。

6. 交叉操作:从选中的个体中进行交叉操作,生成新的个体。

可以使用单点交叉、多点交叉或均匀交叉等策略。

7. 变异操作:对生成的新个体进行变异操作,引入随机扰动,增加种群的多样性。

变异操作可以改变某个基因的值或重新随机生成某个基因。

8. 更新种群:将交叉和变异生成的个体合并到种群中。

9. 重复步骤4-8,直到满足终止条件(如达到最大迭代次数或种群适应度不再改变)。

10. 选择最优个体:从最终的种群中选择适应度最好的个体作为最优解,即SVM的最优参数。

通过以上步骤,遗传算法可以搜索参数空间,并找到最有解决方案。

通过尝试不同的参数组合,可以优化SVM模型的性能。

请注意,以上只是一般的遗传算法优化SVM参数的步骤,实际应用中可能会根据具体问题进行适当的调整。

在实际操作中,还可以通过引入其他优化技巧(如局部搜索)来进一步提高搜索效率。

SVM的SMO算法实现SVM(Support Vector Machine)是一种常用的分类算法,其原理是将数据集映射到一个高维空间中,使得不同类别的样本能够被一个超平面正确分割。

SMO(Sequential Minimal Optimization)算法是一种用于求解SVM问题的优化算法,其核心思想是将大问题分解为一系列的小问题,通过迭代求解这些小问题来得到最优解。

SMO算法允许一次只优化两个变量,即选择两个变量α_i和α_j进行优化。

具体的优化步骤如下:1. 选择一对需要优化的变量α_i和α_j,使用启发式方法选取这两个变量。

一般选择两个变量时,先遍历整个α向量,找到违反KKT条件最严重的点,KKT(Karush-Kuhn-Tucker)条件是SVM问题的最优性条件,通过判断α向量是否满足该条件来选择需要优化的变量。

2.固定其他变量,通过求解子问题的方式更新选择的两个变量。

通过求解两个变量的二次规划问题,得到更新后的α_i和α_j。

3.更新阈值b。

每次更新α_i和α_j之后,都需要计算新的阈值b。

根据KKT条件,选择满足条件的α_i或α_j来更新阈值b。

4.判断终止条件。

迭代过程中,根据一定的终止条件来决定是否终止算法,一般可以设置最大迭代次数或目标误差。

SMO算法的具体实现如下:1.初始化α向量、阈值b和错误率向量E。

2.选择需要优化的两个变量α_i和α_j。

3.计算变量α_i和α_j的边界。

4.根据变量α_i和α_j是否满足边界来选择优化方法。

5.在选择的两个变量上进行优化。

求解两个变量的二次规划子问题,得到更新后的α_i和α_j。

6.更新阈值b。

7.更新错误率向量E。

8.判断终止条件。

如果满足终止条件则停止迭代,否则返回第2步继续迭代。

完整的SMO算法实现如下:```pythondef smo(X, y, C, tol, max_iter):m, n = X.shapealpha = np.zeros(m)b=0iters = 0while iters < max_iter:alpha_changed = 0for i in range(m):E_i = np.sum(alpha * y * kernel(X, X[i, :])) + b - y[i]if (y[i] * E_i < -tol and alpha[i] < C) or (y[i] * E_i > tol and alpha[i] > 0):j = select_second_alpha(i, m)E_j = np.sum(alpha * y * kernel(X, X[j, :])) + b - y[j]alpha_i_old = alpha[i]alpha_j_old = alpha[j]if y[i] != y[j]:L = max(0, alpha[j] - alpha[i])H = min(C, C + alpha[j] - alpha[i])else:L = max(0, alpha[i] + alpha[j] - C)H = min(C, alpha[i] + alpha[j])if L == H:continueeta = 2 * kernel(X[i, :], X[j, :]) - kernel(X[i, :], X[i, :]) - kernel(X[j, :], X[j, :])if eta >= 0:continuealpha[j] = alpha[j] - y[j] * (E_i - E_j) / etaalpha[j] = clip_alpha(alpha[j], H, L)continuealpha[i] = alpha[i] + y[i] * y[j] * (alpha_j_old - alpha[j]) b1 = b - E_i - y[i] * (alpha[i] - alpha_i_old) *kernel(X[i, :], X[i, :]) - y[j] * (alpha[j] - alpha_j_old) * kernel(X[i, :], X[j, :])b2 = b - E_j - y[i] * (alpha[i] - alpha_i_old) *kernel(X[i, :], X[j, :]) - y[j] * (alpha[j] - alpha_j_old) * kernel(X[j, :], X[j, :])if 0 < alpha[i] < C:b=b1elif 0 < alpha[j] < C:b=b2else:b=(b1+b2)/2alpha_changed += 1if alpha_changed == 0:iters += 1else:iters = 0return alpha, b```以上是SMO算法的简单实现,其中使用了一些辅助函数(如选择第二个变量、计算核函数等),这些函数需要根据具体的问题进行实现。

SVM算法原理及SMO算法概述SVM (Support Vector Machine) 是一种广泛应用于分类和回归问题的机器学习算法。

它基于统计学习理论中的VC理论,使用间隔最大化的方法进行分类。

在SVM中,我们将训练数据集视为一个在高维空间中的点集。

SVM的目标是找到一个超平面,能够将不同类别的点分开,并且使其离超平面的距离最大化。

这个超平面被称为最优分隔超平面。

具体来说,SVM算法的原理如下:1.数据预处理:将训练样本映射到高维特征空间,使得样本点能够被线性分隔。

2.寻找最优超平面:在高维特征空间中,寻找能够将不同类别的点分开的超平面。

通常情况下,有多个超平面可以进行分类,而SVM的目标是找到使得间隔最大化的那个超平面。

3.使用支持向量进行分类:SVM找到了最优超平面后,它会选择离该超平面最近的一些点,这些点被称为支持向量。

分类时,SVM根据测试点和支持向量的关系进行判断。

SMO (Sequential Minimal Optimization) 是一种用来训练SVM的优化算法。

传统的SVM算法需要同时优化所有的模型参数,计算量较大。

而SMO算法则是一种序列化的简化方法,每次只优化两个模型参数。

SMO算法的主要思想如下:1.初始化模型参数:选择两个待优化的参数α1和α22.选择两个参数:基于一定的策略,选择两个不同的参数α进行优化。

3.通过求解两个参数的约束最优化问题,更新模型参数。

4.更新阈值和偏置:根据更新后的模型参数,计算出新的阈值和偏置。

5.判断终止条件:检查是否满足终止条件,如果满足则停止优化,否则返回第2步。

SMO算法的核心在于选择两个参数进行优化,并通过解决约束最优化问题来更新参数。

通过反复迭代这个过程,最终得到训练好的SVM模型。

SMO算法的优点是可以有效地处理大规模数据集,并且能够避免陷入局部最优解。

同时,SMO算法还可以引入核函数,使得SVM具有非线性分类和回归能力。

总结来说,SVM是一种基于统计学习理论的分类和回归算法,通过间隔最大化的方法寻找最优分隔超平面。

支持向量机的性能优化和改进支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,广泛应用于模式识别、数据分类和回归分析等领域。

然而,SVM在处理大规模数据集和高维特征空间时存在一些性能瓶颈。

为了克服这些问题,研究者们提出了许多性能优化和改进的方法。

本文将探讨这些方法,并分析它们在提高SVM性能方面的优势和局限性。

一、特征选择与降维特征选择是SVM性能优化的重要一环。

在处理大规模数据集时,特征数量通常非常庞大,这会导致计算复杂度上升和过拟合问题。

因此,通过选择最相关的特征子集来降低计算复杂度,并提高分类精度是非常重要的。

一种常用的特征选择方法是基于过滤器(Filter)与包装器(Wrapper)相结合的策略。

过滤器方法通过计算每个特征与目标变量之间相关性来评估其重要程度,并按照设定阈值进行筛选;而包装器方法则通过将特定子集输入分类器,并根据其分类精度进行评估来选择最佳子集。

此外,降维也是提高SVM性能的重要手段之一。

通过降低特征空间的维度,可以减少计算复杂度、提高模型训练速度和分类准确率。

常用的降维方法有主成分分析(PCA)和线性判别分析(LDA)等。

这些方法通过线性变换将高维数据映射到低维空间,以保留最重要的特征信息。

二、核函数选择与参数调优核函数是SVM中的关键组成部分,它可以将数据映射到高维特征空间,从而使非线性问题转化为线性可分问题。

常用的核函数有线性核、多项式核和高斯径向基函数(RBF)等。

在选择核函数时,需要根据数据集的特点和任务需求进行合理选择。

例如,在处理非线性问题时,RBF核通常能够取得较好效果;而在处理文本分类问题时,多项式核可以更好地捕捉特征之间的关系。

此外,在使用SVM训练模型时,参数调优也是非常重要的一步。

主要包括正则化参数C和径向基函数宽度γ两个参数。

正则化参数C 控制着模型对误分类样本的容忍程度;而径向基函数宽度γ则控制着模型的泛化能力。

基于PSO算法的SVM参数优化方法研究基于粒子群优化算法(Particle Swarm Optimization, PSO)的支持向量机(Support Vector Machine, SVM)参数优化是近年来机器学习领域中的热门研究方向。

本文将探讨PSO算法在SVM参数优化中的应用,并介绍其原理和优势。

首先,我们需要介绍一下支持向量机(SVM)。

SVM是一种常用的监督学习算法,可用于分类和回归问题。

其核心思想是在特征空间中找到一个最优的超平面来使不同类别的样本尽可能地分开。

SVM参数优化包括核函数选择、惩罚参数(C)以及其他控制参数的选择。

然而,SVM参数优化是一个复杂的优化问题,传统方法通常需要进行大量的计算和试验。

为了降低计算复杂度,提高参数优化效率,近年来研究者开始引入PSO算法来求解SVM参数优化问题。

PSO算法是一种启发式优化算法,模拟了鸟群捕食的行为。

在PSO算法中,每个解(粒子)都有一个速度和位置,并与其他粒子共享信息。

通过不断更新速度和位置,粒子会向全局最优解靠近。

在使用PSO算法进行SVM参数优化时,需要将SVM参数作为优化目标函数的参数。

PSO算法通过不断更新粒子的速度和位置来优化SVM参数,使得SVM模型在训练集上的性能最优。

具体而言,PSO算法的每个粒子可以看作是一个SVM的参数组合,包括核函数选择、惩罚参数(C)等。

每个粒子通过评估其对应的SVM模型在训练集上的性能来计算适应度值。

然后,粒子根据自己的当前最优位置和全局最优位置来更新速度和位置,以期望找到更好的解。

PSO算法有以下几个优势适合用于SVM参数优化。

首先,PSO算法具有全局能力,能够在参数空间中找到最优解。

其次,PSO算法不依赖于问题的具体形式,适用于各种类型的SVM参数优化。

而且,PSO算法不需要计算梯度,因此能够避免陷入局部最优解。

目前,PSO算法在SVM参数优化中得到了广泛的应用,并取得了较好的结果。

多分类SVM分类器优化技巧支持向量机(Support Vector Machine,SVM)是一种高效的分类算法,一般应用于二分类问题。

然而,在现实生活中,我们常常遇到需要将样本分为多个类别的问题。

这时就需要使用多分类SVM分类器。

本文将介绍一些优化技巧,以提高多分类SVM分类器的性能。

1. One-vs-All 方法One-vs-All 方法是一种简单有效的方法,用于将多分类问题转化为二分类问题。

该方法的思路是,对于有 k 个类别的问题,构造 k 个二分类学习器,每次将其中一个类别作为正例,剩余的 k-1 个类别作为负例。

训练完成后,对于一个待分类的样本,将其输入到 k 个分类器中,选择分类器输出中置信度最高的类别作为预测类别。

One-vs-All 方法的优点是简单易理解,但是分类器的数量较多,对于大规模数据集计算量较大。

2. One-vs-One 方法One-vs-One 方法是一种常用的多分类方法。

与 One-vs-All 方法不同,它的思路是通过构造 k(k-1)/2 个二分类学习器,每次仅将两个类别之间的样本作为正负例进行训练。

训练完成后,对于一个待分类的样本,将其输入到 k(k-1)/2 个分类器中,统计每个类别在分类器输出中的数量,选择具有最大数量的类别作为预测类别。

One-vs-One 方法相对于 One-vs-All 方法计算量较小,但是需要训练大量的分类器,对于数据集较大的问题,计算量依然非常大。

3. 多类核函数多类核函数是一种直接将多个类别映射到一个高维空间的方式。

通过在高维空间中构造一个多类别核函数,可以将多分类问题转化为在高维空间中的二分类问题。

多类核函数的优点是计算量小,但是需要对核函数进行特殊设计,使得其能够处理多类别问题。

4. 类别平衡技巧有时候,样本分布可能不均衡,导致分类器对样本量较多的类别预测结果较为准确,而对样本量较少的类别预测结果误差较大。

这时候,需要使用类别平衡技巧来解决这个问题。

支持向量机参数调优技巧支持向量机(Support Vector Machine,简称SVM)是一种常用的机器学习算法,广泛应用于分类和回归问题。

在实际应用中,参数调优是提高SVM模型性能的关键步骤之一。

本文将介绍一些常用的SVM参数调优技巧,帮助读者更好地理解和应用SVM算法。

首先,我们需要了解SVM的基本原理。

SVM通过寻找一个最优的超平面来将不同类别的样本分开。

在二分类问题中,SVM的目标是找到一个能够最大化两个类别之间的间隔(即最大化间隔超平面),并且能够正确分类训练样本的超平面。

为了实现这个目标,SVM引入了一些重要的参数。

一、核函数选择SVM可以通过核函数将样本从原始特征空间映射到一个高维特征空间,从而使得样本在新的空间中更容易分开。

常用的核函数有线性核函数、多项式核函数和高斯核函数等。

选择合适的核函数可以提高SVM模型的分类性能。

在实际应用中,可以通过交叉验证等方法选择最优的核函数。

二、正则化参数C正则化参数C是SVM的一个重要参数,用于控制模型的复杂度。

较小的C值会使得模型更加简单,容易欠拟合;较大的C值会使得模型更加复杂,容易过拟合。

因此,选择合适的C值可以避免模型的欠拟合和过拟合问题。

一种常用的方法是通过网格搜索或者交叉验证来选择最优的C值。

三、惩罚参数gamma在使用高斯核函数时,惩罚参数gamma用于控制每个样本对模型的影响程度。

较小的gamma值会使得模型的影响范围更广,较大的gamma值会使得模型的影响范围更窄。

选择合适的gamma值可以避免模型过拟合。

同样,可以通过网格搜索或者交叉验证来选择最优的gamma值。

四、样本权重调节在实际应用中,不同类别的样本可能存在数量不平衡的情况。

为了解决这个问题,可以通过调节样本权重来平衡不同类别的重要性。

一种常用的方法是使用class_weight参数来设置样本权重。

通过合理设置样本权重,可以提高模型对少数类样本的分类性能。

除了以上几个常用的参数调优技巧,还有一些其他的技巧也值得关注。

支持向量机优化算法与大数据处理的技巧与策略支持向量机(Support Vector Machine,简称SVM)是一种常用的机器学习算法,它在分类和回归问题中都有广泛的应用。

然而,随着大数据时代的到来,传统的SVM算法在处理大规模数据时面临着挑战。

本文将介绍支持向量机优化算法以及大数据处理的技巧与策略。

一、支持向量机优化算法支持向量机的核心思想是找到一个最优的超平面,将不同类别的样本分隔开。

在传统的SVM算法中,常用的优化算法有序列最小最优化(Sequential Minimal Optimization,简称SMO)和梯度下降法。

SMO算法通过将大优化问题分解为多个小优化子问题来求解,从而降低了计算复杂度。

而梯度下降法则通过迭代的方式逐步优化模型参数,直到达到最优解。

然而,在处理大规模数据时,传统的SVM算法存在着计算复杂度高、内存消耗大等问题。

为了解决这些问题,研究人员提出了一系列的优化算法,如基于并行计算的SVM算法、核函数近似算法等。

这些算法通过利用并行计算和近似计算的技术,加速了SVM算法的训练过程,提高了处理大规模数据的效率。

二、大数据处理的技巧与策略在处理大数据时,除了优化算法,还需要考虑数据处理的技巧与策略。

以下是一些常用的技巧与策略:1. 数据预处理:在进行支持向量机训练之前,需要对数据进行预处理。

常见的预处理方法包括数据清洗、特征选择和特征缩放等。

数据清洗可以去除异常值和噪声,提高模型的鲁棒性;特征选择可以选择对分类任务有用的特征,减少计算复杂度;特征缩放可以将不同特征的取值范围统一,避免某些特征对模型的影响过大。

2. 并行计算:在处理大规模数据时,可以利用并行计算的技术来加速计算过程。

例如,可以将数据划分为多个子集,分别在不同的计算节点上进行计算,最后将结果进行合并。

这样可以充分利用计算资源,提高计算效率。

3. 分布式存储:在处理大规模数据时,传统的单机存储已经无法满足需求。

GA优化的SVM在量化择时中的应用量化择时是在金融市场中用数学和统计方法来为投资者提供决策支持的一种方法。

优化算法被广泛应用于量化择时中,其中遗传算法(Genetic Algorithm,GA)是一种常见的优化方法。

支持向量机(Support Vector Machine,SVM)是一种常用于分类和回归问题的机器学习方法。

在量化择时中,GA优化的SVM可以应用于股票市场、期货市场等多个金融市场,为投资者提供交易决策的支持。

首先,SVM是一种监督学习方法,通过将数据映射到高维空间,找到一个最优的超平面来进行分类或回归。

在量化择时中,我们可以将时间序列数据作为输入,将未来的价格作为输出,利用SVM来预测未来的价格走势。

然而,由于金融市场数据的非线性和噪声的存在,传统的SVM可能无法达到理想的效果。

这时候,GA可以用来优化SVM的相关参数,以提高模型的预测能力。

在GA优化的SVM中,首先需要定义适应度函数。

适应度函数可以根据具体的量化择时策略来定义,例如可以使用收益率作为适应度函数。

然后,利用遗传算法对SVM的参数进行优化。

GA通过对不同的参数设置进行个体的交叉和变异,不断地进行迭代优化,直到找到最优解。

常见的SVM参数包括核函数类型、惩罚因子C和核函数参数等。

一旦找到了最优的SVM模型,就可以使用该模型进行未来价格的预测,进而进行量化择时的决策。

首先,GA能够全局最优参数组合。

由于金融市场数据的复杂性,传统的优化方法可能会陷入局部最优解。

而GA通过遗传操作,能够避免陷入局部最优解,同时保证全局的能力。

其次,GA优化的SVM可以灵活适应市场的变化。

金融市场的特征和行情经常发生变化,需要不断调整模型的参数。

GA可以通过迭代优化的方式,快速适应市场的变化,提高模型的鲁棒性。

另外,GA优化的SVM可以自动提取特征。

在量化择时中,选择合适的特征是非常重要的。

传统的人工选择特征的方法可能会忽略一些重要的信息。

而GA优化的SVM可以通过遗传操作自动提取特征,减少了人工选择特征的难度。

统计学习中的SVM分类算法改进支持向量机(Support Vector Machine,简称SVM)是一种常用的监督学习方法,在许多领域有着广泛的应用。

SVM通过将数据映射到高维特征空间,并在该空间中构建一个最优的超平面,实现对数据进行分类。

然而,传统的SVM算法在处理大规模数据时存在着一些问题,为了进一步提升其性能,在统计学习中有一些改进的方法被提出。

一、多核SVM分类算法传统的SVM算法采用的是线性核函数来进行数据映射,但是在实际应用中,存在着许多非线性问题。

为了解决这个问题,在SVM算法中引入了多核函数的概念,通过选择不同的核函数来处理不同类型的数据。

常见的核函数包括线性核函数、多项式核函数、高斯核函数等。

多核SVM将不同的核函数组合起来使用,根据数据的特点灵活选择不同的核函数,从而提高了SVM算法在非线性问题上的分类性能。

二、松弛变量的调节传统的SVM算法中,存在一个松弛变量用来放松约束条件,使得部分样本可以落在超平面的错误一侧。

然而,当样本数据量较大时,松弛变量会导致模型的过拟合问题,影响分类性能。

为了解决这个问题,可以通过调节松弛变量的权重,提高对分类错误的惩罚力度,减少过拟合的情况发生。

三、交叉验证选择超参数SVM算法中有一些超参数需要进行选择,例如正则化参数C和核函数的参数等。

传统的SVM算法中,通常通过网格搜索的方法来选择最优的超参数,但这种方法存在着计算复杂度高、效率低的问题。

为了优化超参数的选择过程,可以采用交叉验证的方法,将数据集划分为训练集和验证集,通过对不同组合超参数的模型进行评估,选择性能最好的超参数组合。

四、增加样本权重处理不均衡问题在实际应用中,往往会遇到样本不均衡的情况,即某些类别的样本数量较少。

这样会导致传统的SVM算法对多数类别样本的分类效果较好,而对少数类别样本的分类效果较差。

为了解决这个问题,可以给少数类别样本增加一定的权重,使其在模型训练中具有更大的影响力,从而实现更好的分类效果。

SVM算法原理及SMO算法概述支持向量机(Support Vector Machine,SVM)是一种非常常用的机器学习算法,被广泛应用于分类和回归问题中。

SVM算法的原理基于统计学习理论,具有较强的理论基础和实际应用。

具体来说,SVM算法的原理可以分为以下几个步骤:1.数据预处理:对原始数据进行标准化处理,使得不同特征之间具有相同的尺度。

2.特征转换:将数据从低维特征空间转换到高维特征空间。

这个转换的方法可以通过核函数来实现,常用的核函数有线性核函数、多项式核函数和高斯核函数等。

3.寻找最优超平面:在高维特征空间中,通过优化问题求解,找到一个最优的超平面,使得样本点距离该超平面的间隔最大。

4.生成分类模型:根据最优超平面,将数据点分为不同的类别。

简单来说,SVM算法的目标是在保证分类精度的前提下,找到使得间隔最大化的超平面,从而提高模型的鲁棒性和泛化能力。

SMO算法(Sequential Minimal Optimization)是一种用于求解SVM 二次规划问题的优化算法。

SMO算法的基本思想是将大规模的二次规划问题分解为一系列求解两个变量的二次规划子问题。

SMO算法的基本流程如下:1.初始化:选择两个变量作为优化变量,然后初始化所有变量的值。

2.选择变量:选择两个变量作为待优化变量。

选择的原则一般是按照最大步长原则,即第一个变量选择违反KKT条件最严重的变量,第二个变量选择使得优化问题目标函数增大最快的变量。

3.优化变量:固定其他变量的值,针对选定的两个变量,求解二次规划问题,更新这两个变量的值。

4.更新阈值:根据更新后的变量值,更新阈值。

5.检验终止条件:检验是否满足终止条件,如果满足则输出最优解,否则返回第二步。

SMO算法的关键在于选择变量和优化变量这两个步骤。

通过选择合适的变量和高效的求解二次规划子问题的方法,可以有效地提高算法的运算效率。

总结来说,SVM算法是一种基于统计学习理论的强大分类算法,通过优化目标函数找到最优的超平面。

基于改进的网格搜索法的SVM参数优化支持向量机(Support Vector Machine,SVM)是一种广泛使用的监督学习算法,用于分类和回归问题。

在SVM中,参数的选择对于模型的性能至关重要。

一种常用的方法是使用网格来寻找最佳的参数组合。

然而,传统的网格法存在计算复杂度高的问题。

本文将介绍基于改进的网格法的SVM参数优化,并讨论其优势和局限性。

传统的网格法是通过遍历给定的参数组合空间来选择最佳的参数组合。

然而,当参数空间很大时,这种方法的计算复杂度会呈指数级增长。

为了解决这个问题,我们可以采用改进的网格法。

改进的网格法使用迭代的方法来寻找最佳的参数组合。

具体而言,它首先选择一个初始参数组合,并在其周围进行。

然后,在过程中,逐步调整参数组合,并比较它们的性能。

这样,我们可以根据已知的结果来选择下一个参数组合进行。

通过这种方式,我们可以减少空间,从而降低计算复杂度。

改进的网格法的优势是可以更快地找到最佳的参数组合,并减少计算复杂度。

此外,它可以根据先前的结果动态调整参数范围,从而更好地适应不同的数据集。

此外,改进的网格法还可以根据不同的性能指标来选择最佳的参数组合,从而更好地满足需求。

然而,改进的网格法也存在一些局限性。

首先,它可能会在局部最优解附近徘徊,而忽略了全局最优解。

其次,由于在过程中依赖于先前的结果,在一些情况下可能会导致偏向一些参数组合,而忽略其他可能的组合。

此外,改进的网格法还可能存在过拟合的问题,特别是在训练数据集较小或噪声较多的情况下。

为克服改进的网格法的局限性,我们可以采用以下方法。

首先,我们可以使用交叉验证来评估每个参数组合的性能,并选择性能最好的组合。

其次,我们可以使用更复杂的算法,例如遗传算法或模拟退火算法,以更好地参数空间。

此外,我们还可以将改进的网格法与其他优化算法相结合,以充分利用它们的优势。

综上所述,改进的网格法是一种快速有效的SVM参数优化方法。

它可以大大减少计算复杂度,并根据先前的结果来动态调整参数范围。