第二章 EM类型与特点简介

- 格式:ppt

- 大小:9.61 MB

- 文档页数:62

分类em算法摘要:1.引言2.EM 算法的基本原理3.EM 算法的分类应用4.结论正文:1.引言EM 算法,全称Expectation-Maximization 算法,是一种常见的概率模型优化算法。

该算法在统计学、机器学习等领域具有广泛的应用,特别是在分类问题上表现出色。

本文将重点介绍EM 算法在分类问题上的应用及其基本原理。

2.EM 算法的基本原理EM 算法是一种迭代优化算法,主要通过两个步骤进行:E 步(Expectation)和M 步(Maximization)。

在E 步中,根据观测数据计算样本的隐含变量的期望值;在M 步中,根据隐含变量的期望值最大化模型参数的似然函数。

这两个步骤交替进行,直至收敛。

EM 算法的基本原理可以概括为:对于一个包含隐含变量的概率模型,通过迭代优化模型参数,使得观测数据的似然函数最大化。

在这个过程中,EM 算法引入了Jensen 不等式,保证了算法的收敛性。

3.EM 算法的分类应用EM 算法在分类问题上的应用非常广泛,典型的例子包括高斯混合模型(GMM)和隐马尔可夫模型(HMM)。

(1)高斯混合模型(GMM)在传统的分类问题中,我们通常使用极大似然估计(MLE)来求解最佳分类模型。

然而,当数据分布复杂时,MLE 可能无法得到一个好的解。

此时,我们可以引入EM 算法,通过迭代优化模型参数,提高分类的准确性。

在GMM 中,EM 算法可以有效地处理数据的多峰分布,从而提高分类效果。

(2)隐马尔可夫模型(HMM)HMM 是一种基于序列数据的概率模型,广泛应用于语音识别、时间序列分析等领域。

在HMM 中,EM 算法被用于求解最优路径和状态转移概率。

通过EM 算法,我们可以有效地处理观测序列与隐状态之间的不确定性,从而提高分类效果。

4.结论EM 算法作为一种强大的概率模型优化算法,在分类问题上表现出色。

通过引入隐含变量和迭代优化,EM 算法可以有效地处理数据的复杂性和不确定性,提高分类的准确性。

EM在畜牧业中的应用及发展前景刘炳义1,邱海芳,王守江,陈飞,李振华,于光芝(潍坊市畜牧局, 山东省,潍坊市,261041)摘要:EM作为一种纯天然、无公害的生物制剂,由多种正常菌群微生物制成,在加强肠道防御、防治疾病、提高饲料转化率、提高畜禽产品质量等方面发挥着重要的作用,在畜牧生产中有广泛的应用前景。

本文就EM种类及其特点、作用机理、应用现状、影响因素与发展前景进行简要概述。

认为应积极推广应用EM制剂, 以促进畜牧业健康持续发展。

关键词:EM,作用机理,应用现状,影响因素,发展前景The Applied and Foreground of Microorganisms(EM)inAnimal ProductionLIU Bin-yi, QIU Hai-fang, WANG Shou-jiang, CHEN Fei, LI Zheng-hua, YU Guang-zhi (Weifang Animal Husbandry Bureau, Shandong, Weifang, 261041)Abstract: EM preparation is a kind of pure natural, harmless biologic agents; it is made by many kinds of normal microbial flora. EM plays an important role in protection intestinal tract, prevention and cure disease, enhancing feed reward, improving product quality. It has an extensive application prospect. This article gives an overview of characteristics, mechanisms, application, influencing factor and foreground. In order to promote the husbandry healthily and continuously, EM should be popularized and applied positively.Key words: EM, effective organisms, application, influencing factor, foregroundEM是日本比嘉照夫教授发明的一种新型复合微生物菌剂,有5科10属80多种功能各异的有效微生物群组成,经独特工艺复合培养而成。

电路中em的值

在电路中,em代表电动势(Electromotive Force),它的单位是伏特(V)。

电动势是指电源或电池的电压,表示电源或电池的电能转化为电流的能力。

它是电路中的重要参数,决定了电路中电流的大小和方向。

电动势的值取决于电源或电池的性质和工作状态。

在交流电路中,特别是正弦交流电路中,电动势的最大值通常表示为Em。

这个值是根据电磁感应定律得出的,Em=NBSω,其中N是线圈匝数,B是磁感应强度,S是线圈的面积,ω是角频率。

对于固定完成后的发电机,这些参数都是常量,因此电动势的最大值Em是一个定值。

在电路中,电动势与电流的关系由欧姆定律给出,即I=V/R,其中I是电流,V是电压(电动势),R是电阻。

因此,电动势的大小决定了电路中电流的大小。

请注意,电动势的值可以是正值也可以是负值,这取决于电源或电池的极性。

当电源或电池的电压为正时,电子会从负极流向正极;当电压为负时,电子会从正极流向负极。

在交流电路中,电动势的值会随时间作周期性变化。

统计学习中的EM算法EM算法是一种常用的统计学习方法,它可以用于估计未知参数,特别是那些需要通过观察到的数据加以估计的复杂模型。

本文将介绍EM算法的基本原理、应用场景以及优缺点。

一、基本原理EM算法(Expectation Maximization)相当于是用一种迭代的方式,在“期望”(Expectation)和“最大化”(Maximization)之间进行交替,来求解模型参数的一种方法。

EM算法的基本思想是:在训练数据样本中,往往存在隐含变量,而且无法直接观测到。

我们需要发掘这些隐含变量的概率分布,从而求解最优的模型参数。

具体来说,EM算法的步骤如下:首先,选择一个初始化的参数值;然后,使用这些参数值来计算隐含变量的概率分布;接下来,根据这些概率分布来重新估计参数的值;不断重复以上三个步骤,直到收敛,得到最优的模型参数值。

EM算法通过迭代来求解未知的参数值,对于一些需要最大化其似然函数的模型,EM算法可以找到使得似然函数最大的参数值。

最常见的应用场景是在高斯混合模型(GMM)以及隐马尔可夫模型(HMM)中。

二、应用场景1、高斯混合模型高斯混合模型是一种将多个高斯分布加权叠加的模型,它常被用于描述复杂数据的分布情况。

举个例子,在股票市场上,可以将不同的股票价格看成不同的高斯分布,然后用高斯混合模型来描述整个市场的波动情况。

在这种情况下,EM算法可以用来估计每个高斯分布的权重、均值和方差。

2、隐马尔可夫模型隐马尔可夫模型是一种包含隐含状态的动态变化模型。

它常被用于语音识别、自然语言处理、图像处理等领域。

在隐马尔可夫模型中,我们需要估计各个状态转移概率以及各个隐含状态下的观测值概率分布。

EM算法可以用来求解这些参数值。

三、优缺点1、优点EM算法可以用来处理包含隐含变量的模型,在实际应用中非常普遍。

EM算法可以求解似然函数的最大值或者后验概率的最大值。

这样,在目标函数为凸函数的情况下,EM算法可以获得全局最优解。

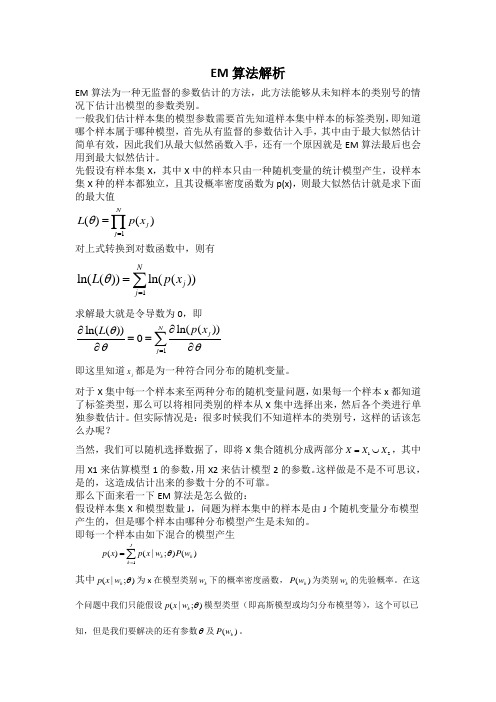

EM 算法解析EM 算法为一种无监督的参数估计的方法,此方法能够从未知样本的类别号的情况下估计出模型的参数类别。

一般我们估计样本集的模型参数需要首先知道样本集中样本的标签类别,即知道哪个样本属于哪种模型,首先从有监督的参数估计入手,其中由于最大似然估计简单有效,因此我们从最大似然函数入手,还有一个原因就是EM 算法最后也会用到最大似然估计。

先假设有样本集X ,其中X 中的样本只由一种随机变量的统计模型产生,设样本集X 种的样本都独立,且其设概率密度函数为p(x),则最大似然估计就是求下面的最大值1()()Nj j L p x θ==∏对上式转换到对数函数中,则有1ln(())ln(())Nj j L p x θ==∑求解最大就是令导数为0,即1ln(())ln(())0N jj p x L θθθ=∂∂==∂∂∑即这里知道j x 都是为一种符合同分布的随机变量。

对于X 集中每一个样本来至两种分布的随机变量问题,如果每一个样本x 都知道了标签类型,那么可以将相同类别的样本从X 集中选择出来,然后各个类进行单独参数估计。

但实际情况是:很多时候我们不知道样本的类别号,这样的话该怎么办呢?当然,我们可以随机选择数据了,即将X 集合随机分成两部分12X X X =⋃,其中用X1来估算模型1的参数,用X2来估计模型2的参数。

这样做是不是不可思议,是的,这造成估计出来的参数十分的不可靠。

那么下面来看一下EM 算法是怎么做的:假设样本集X 和模型数量J ,问题为样本集中的样本是由J 个随机变量分布模型产生的,但是哪个样本由哪种分布模型产生是未知的。

即每一个样本由如下混合的模型产生 1()(|;)()Jk k k p x p x w P w θ==∑ 其中(|;)k p x w θ为x 在模型类别k w 下的概率密度函数,()k P w 为类别k w 的先验概率。

在这个问题中我们只能假设(|;)k p x w θ模型类型(即高斯模型或均匀分布模型等),这个可以已知,但是我们要解决的还有参数θ及()k P w 。

干货必备机器学习基础之EM算法学习重磅干货,第一时间送达一、简介EM算法,又叫做期望最大化算法,该算法可以通过反复迭代来求解带有不可观察的隐变量的概率模型中的参数,本质上每次迭代都是对参数做最大似然估计。

在机器学习建模中,可以用来建模的因素如此之多,我们不可能将所有的因素都考虑进来,因此在模型中往往会有那些被我们忽略或者我们没有观测到的建模因素。

这些因素被称为隐变量。

EM算法可以将这些隐变量考虑到建模因素中,EM算法的过程如下图所示如图为完全数据的极大似然函数,但是由于存在隐变量我们没办法得出的正确式子。

因此我们定义了极大似然函数的下界函数当前仅当时,两函数的值才相等。

因此在E步,我们已有一个估计的参数值(初始化或上次迭代计算出的参数),但是此时这个参数值对应的的值不等于的值。

因此在E步中我们以当前的估计参数极大化,使得该参数对应的与的函数值相等。

结果如上图所示,处极大似然函数与下界函数的函数值相等。

然后在M步,我们求出使得取得极大的参数。

然后将作为下一次迭代的当前参数值。

EM算法通过反复的迭代一定可以收敛到某个局部最优,但不能保证能收敛到全局最优,因此,EM算法对初值敏感。

二、EM算法详解Q函数Q函数被定义为,完全数据的对数似然函数关于给定的观测数据Y和当前参数的条件下,对未观测数据Z的条件概率分布的期望。

即这里的Q函数和上面提到的下界函数是等价的,因此EM算法的E步是求解当前参数和观测值对应的Q函数,在M步求出使Q函数极大的参数。

EM算法的导出完全数据的对数似然函数为假设是使得上式达到极大的参数值,那么对于任意的参数估计值都会有且上式恒大于等于0,更进一步由琴生不等式可以得到因此我们可以定义下界函数为在M步我们要求使得下界函数取得极大的最终我们发现下界函数与Q函数是等价的。

EM算法的收敛性我们知道每次迭代后的参数都使得似然估计变大,由于极大似然函数有界,因此必有极限。

并且由下图我们可以知道,如果初始的参数很小的话,EM算法则会收敛到一个局部极大。

【机器学习】EM算法详细推导和讲解 今天不太想学习,炒个冷饭,讲讲机器学习⼗⼤算法⾥有名的EM算法,⽂章⾥⾯有些个⼈理解,如有错漏,还请读者不吝赐教。

众所周知,极⼤似然估计是⼀种应⽤很⼴泛的参数估计⽅法。

例如我⼿头有⼀些东北⼈的⾝⾼的数据,⼜知道⾝⾼的概率模型是⾼斯分布,那么利⽤极⼤化似然函数的⽅法可以估计出⾼斯分布的两个参数,均值和⽅差。

这个⽅法基本上所有概率课本上都会讲,我这就不多说了,不清楚的请百度。

然⽽现在我⾯临的是这种情况,我⼿上的数据是四川⼈和东北⼈的⾝⾼合集,然⽽对于其中具体的每⼀个数据,并没有标定出它来⾃“东北⼈”还是“四川⼈”,我想如果把这个数据集的概率密度画出来,⼤约是这个样⼦: 好了不要吐槽了,能画成这个样⼦我已经很⽤⼼了= = 其实这个双峰的概率密度函数是有模型的,称作⾼斯混合模型(GMM),写作: 话说往博客上加公式真是费劲= =这模型很好理解,就是k个⾼斯模型加权组成,α是各⾼斯分布的权重,Θ是参数。

对GMM模型的参数估计,就要⽤EM算法。

更⼀般的讲,EM算法适⽤于带有隐变量的概率模型的估计,什么是隐变量呢?就是观测不到的变量,对于上⾯四川⼈和东北⼈的例⼦,对每⼀个⾝⾼⽽⾔,它来⾃四川还是东北,就是⼀个隐变量。

为什么要⽤EM,我们来具体考虑⼀下上⾯这个问题。

如果使⽤极⼤似然估计——这是我们最开始最单纯的想法,那么我们需要极⼤化的似然函数应该是这个: 然⽽我们并不知道p(x;θ)的表达式,有同学说我知道啊,不就是上⾯那个混个⾼斯模型?不就是参数多⼀点麽。

仔细想想,GMM⾥的θ可是由四川⼈和东北⼈两部分组成哟,假如你要估计四川⼈的⾝⾼均值,直接⽤GMM做似然函数,会把四川⼈和东北⼈全考虑进去,显然不合适。

另⼀个想法是考虑隐变量,如果我们已经知道哪些样本来⾃四川,哪些样本来⾃东北,那就好了。

⽤Z=0或Z=1标记样本来⾃哪个总体,则Z就是隐变量,需要最⼤化的似然函数就变为: 然⽽并没有卵⽤,因为隐变量确实不知道。

em算法期望最⼤化算法(EM)或Dempster Laird Rubin算法是⼀种最⼤似然估计(MLE),MLE通常⽤作Newton Raphson⽅法的替代⽅法,以估计具有潜在变量或不完整数据的概率模型的参数。

EM算法的标准计算框架由E步骤和M步骤交替组成。

算法的收敛性可以确保迭代⾄少接近局部最⼤值。

EM算法是MM算法的特例之⼀。

有⼏种改进的版本,包括使⽤贝叶斯推理的EM算法,EM 梯度算法,⼴义EM算法等。

由于迭代规则易于实现并且可以灵活地考虑隐藏变量,因此EM 算法被⼴泛⽤于处理缺失数据以及许多机器学习(机器学习)算法,包括⾼斯混合模型(GMM)和隐马尔可夫模型(HMM)参数估算。

EM算法的研究源于统计误差分析问题。

1886年,美国数学家西蒙·纽科姆(Simon Newcomb)使⽤⾼斯混合模型(GMM)解释观测误差的长尾效应时,提出了⼀种类似于EM算法的迭代求解技术。

最⼤似然估计(MLE)出现后,英国学者安德森·麦肯德⾥克(Anderson McKendrick)于1926年提出了纽康理论,并将其应⽤于医学样本中。

1956年,Michael Healy和Michael Westmacott 提出了⼀种迭代⽅法来估计统计实验中的缺失数据,这被认为是EM 算法的特例。

1970年,B。

J. n。

light使⽤MLE讨论指数族分布的I型检查数据。

Rolf Sundberg从1971年到1974年进⼀步发展了指数族分布样本的MLE,并给出了迭代计算的完整推导。

EM算法由美国数学家Arthur Dempster,Nan laird和Donald Rubin正式提出。

他们于1977年发表的研究总结了以前的EM算法作为特例,并给出了标准算法的计算步骤。

EM算法也称为Dempster Laird Rubin算法。

1983年,美国数学家c.f. Jeff Wu 给出了指数族分布之外的EM算法收敛性的证明。