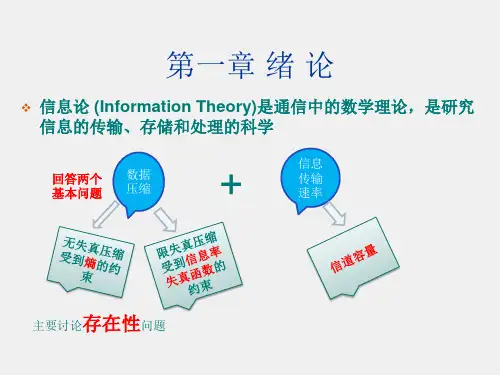

信息论 - 第1章

- 格式:ppt

- 大小:308.00 KB

- 文档页数:5

信息论第一章概论1.信息、消息、信号的定义及关系。

定义信息:事物运动状态或存在方式的不确定性的描述。

消息:指包含有信息的语言、文字和图像等。

信号:表示消息的物理量,一般指随时间而变化的电压或电流称为电信号。

关系信息和消息信息不等于消息。

消息中包含信息,是信息的载体。

同一信息可以用不同形式的消息来载荷。

同一个消息可以含有不同的信息量。

信息和信号信号是消息的载体,消息则是信号的具体内容。

信号携带信息,但不是信息本身。

同一信息可用不同的信号来表示,同一信号也可表示不同的信息。

2. 通信系统模型,箭头上是什么?通信的目的及方法。

通信的目的:是为了提高通信的可靠性和有效性。

信源编码:提高信息传输的有效性。

(减小冗余度)信道编码:提高信息传输的可靠性。

(增大冗余度)第二章 信源及其信息量★信源发出的是消息。

信源分类1、信源按照发出的消息在时间上和幅度上的分布情况可将信源分成离散信源和连续信源。

2、根据各维随机变量的概率分布是否随时间的推移而变化将信源分为平稳信源和非平稳信源。

单符号离散信源离散无记忆信源 无记忆扩展信源 离散平稳信源离散有记忆信源 记忆长度无限记忆长度有限(马尔可夫信源)一、单符号离散信源单符号离散信源的数学模型为定义:一个随机事件发生某一结果后所带来的信息量为自信息量。

定义为其发生概率对数的负值。

以 奇才 单位:•对数以2为底,单位为比特 (bit ) (binary unit ) •对数以e 为底,单位为奈特 (nat ) (nature unit)•对数以10为底,单位为笛特(det) (decimal unit) 或哈特 (hart) 物理含义:在事件xi 发生以前,等于事件xi 发生的不确定性的大小;在事件xi 发生以后,表示事件xi 所含有或所能提供的信息量。

性质:①I(x i )是非负值.②当p(x i )=1时,I(x i )=0. ③当p(x i )=0时,I(x i )=∞.④I(x i ) 是p(x i )的单调递减函数.联合自信息量条件自信息量自信息量、条件自信息量和联合自信息量之间有如下关系式:I(x i y j )= I(x i )+ I(y j / x i ) = I(y j )+ I(x i / y j )⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡)(,),(,),(),( ,, ,, , )( 2121n i n i x p x p x p x p x x x x X P X )(log )( i i x p x I -=)(log )( j i j i y x p y x I -=1)(,1)(01=≤≤∑=ni i i x p x p定义:各离散消息自信息量的数学期望,即信源的平均信息量.单位:比特/符号 物理含义: ① 信源熵H(X)表示信源输出后,离散消息所提供的平均信息量. ② 信源熵H(X)表示信源输出前,信源的平均不确定度. ③ 信源熵H(X)反映了变量X 的随机性.信源符号的概率分布越均匀,则平均信息量越大; 确定事件,不含有信息量。

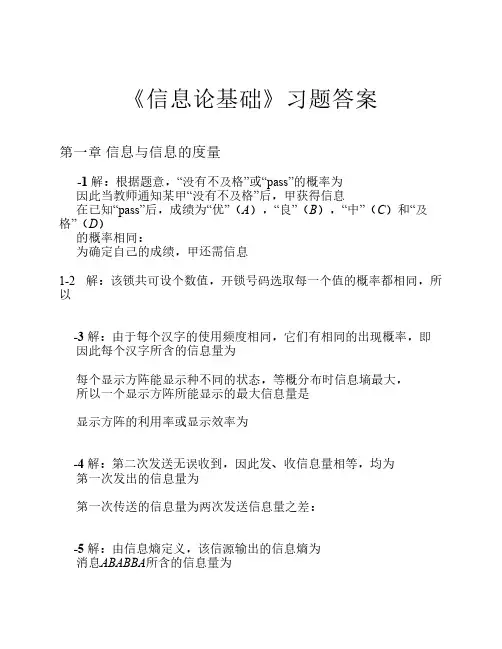

《信息论基础》习题答案第一章信息与信息的度量-1 解:根据题意,“没有不及格”或“pass”的概率为因此当教师通知某甲“没有不及格”后,甲获得信息在已知“pass”后,成绩为“优”(A),“良”(B),“中”(C)和“及格”(D)的概率相同:为确定自己的成绩,甲还需信息1-2 解:该锁共可设个数值,开锁号码选取每一个值的概率都相同,所以-3 解:由于每个汉字的使用频度相同,它们有相同的出现概率,即因此每个汉字所含的信息量为每个显示方阵能显示种不同的状态,等概分布时信息墒最大,所以一个显示方阵所能显示的最大信息量是显示方阵的利用率或显示效率为-4 解:第二次发送无误收到,因此发、收信息量相等,均为第一次发出的信息量为第一次传送的信息量为两次发送信息量之差:-5 解:由信息熵定义,该信源输出的信息熵为消息ABABBA所含的信息量为消息FDDFDF所含的信息量为6位长消息序列的信息量期望值为三者比较为-6 解:由信息熵定义,该信源输出的信息熵为消息ABABBA所含的信息量为消息FDDFDF所含的信息量为6位长消息序列的信息量期望值为三者比较为-7 解:X和Y的信息熵分别为因传输无误,信宿收到的信息等于发送信息。

因此当第一个字符传送结束后,两信宿收到信息量等于发送的信息量,即整个序列发送结束后,由于符号间独立,两信宿收到的总信息量是平均每次(每个符号)发送(携带)的信息为-8 解:(a) 根据扑克牌的构成,抽到“红桃”、“人头”、“红桃人头”的概率分别为13/52=1/4、12/52=3/13和3/52,所以当告知抽到的那张牌是:“红桃”、“人头”和“红桃人头”时,由信息量定义式(1-5),所得到的信息各是(b) 在52张扑克牌中,共有红人头6张(3张红桃,3张方块),因此在已知那张牌是红人头,为确切地知道是哪张牌,还需要信息。

-9 解:一个二元信息所含的最大信息熵是确定的,所以当以2或5为底时,最大信息熵相同,即1 bit = (该信息量单位)或 1 (该信息量单位) = 2.33 bits同理, 1 nat = 0.62 (该信息量单位)或 1(该信息量单位) = 1.61 nats。

信息论习题集信息论习题集第⼀章、判断题1、信息论主要研究⽬的是找到信息传输过程的共同规律,提⾼信息传输的可靠性、有效性、保密性和认证性,以达到信息传输系统的最优化。

(√)2、同⼀信息,可以采⽤不同的信号形式来载荷;同⼀信号形式可以表达不同形式的信息。

(√)3、通信中的可靠性是指使信源发出的消息准确不失真地在信道中传输;(√)4、有效性是指⽤尽量短的时间和尽量少的设备来传送⼀定量的信息。

(√)5、保密性是指隐蔽和保护通信系统中传送的消息,使它只能被授权接收者获取,⽽不能被未授权者接收和理解。

(√)6、认证性是指接收者能正确判断所接收的消息的正确性,验证消息的完整性,⽽不是伪造的和被窜改的。

(√)7、在⾹农信息的定义中,信息的⼤⼩与事件发⽣的概率成正⽐,概率越⼤事件所包含的信息量越⼤。

(×)第⼆章⼀、判断题1、通信中获得的信息量等于通信过程中不确定性的消除或者减少量。

(√)2、离散信道的信道容量与信源的概率分布有关,与信道的统计特性也有关。

(×)3、连续信道的信道容量与信道带宽成正⽐,带宽越宽,信道容量越⼤。

(×)4、信源熵是信号符号集合中,所有符号的⾃信息的算术平均值。

(×)5、信源熵具有极值性,是信源概率分布P的下凸函数,当信源概率分布为等概率分布时取得最⼤值。

(×)6、离散⽆记忆信源的N次扩展信源,其熵值为扩展前信源熵值的N倍。

(√)7、互信息的统计平均为平均互信息量,都具有⾮负性。

(×)8、信源剩余度越⼤,通信效率越⾼,抗⼲扰能⼒越强。

(×)9、信道剩余度越⼤,信道利⽤率越低,信道的信息传输速率越低。

(×)10、信道输⼊与输出之间的平均互信息是输⼊概率分布的下凸函数。

(×)11、在信息处理过程中,熵是不会增加的。

(√)12、熵函数是严格上凸的。

(√)13、信道疑义度永远是⾮负的。

(√)14、对于离散平稳信源,其极限熵等于最⼩平均符号熵。

第一章绪论(第一讲)(2课时)主要内容:(1)教学目标(2)教学计划(3)参考书(4)考试问题(5)信息论的基本概念(6)信息论发展简史和现状(7)通信系统的基本模型重点:通信系统的基本模型难点:通信系统的基本模型特别提示:运用说明:本堂课作为整本书的开篇,要交待清楚课程开设的目的,研究的内容,对学习的要求;在讲解过程中要注意结合一些具体的应用实例,避免空洞地叙述,以此激发同学的学习兴趣,适当地加入课堂提问,加强同学的学习主动性。

信息论与编码(Informatic s & Coding)开场白教学目标:本课程主要讲解香农信息论的基本理论、基本概念和基本方法,以及编码的理论和实现原理。

介绍信息的统计度量,离散信源,离散信道和信道容量;然后介绍无失真信源编码、有噪信道编码,以及限失真信源编码等,然后介绍信道编码理论,最后也简单介绍了密码学的一些知识。

教学重点:信息度量、无失真信源编码、限失真信源编码、信道编码的基本理论及实现原理。

教学计划:信息论:约20学时信道编码:约19学时*密码学:约8学时参考书:1.信息论与编码,曹雪虹张宗橙编,北京邮电大学出版社,20012.信息论—基础理论与应用,傅祖芸编著,电子工业出版社,20013.信息理论与编码,姜丹钱玉美编著4.信息论与编码,吴伯修归绍升祝宗泰俞槐铨编著,1987考试问题:第一章绪论信息论的基本概念信息论发展简史和现状通信系统的基本模型§1.1 信息论的基本概念信息论是一门应用近代数理统计方法来研究信息的传输和处理的科学。

在涉及这门课程的具体内容之前,很有必要在引言中,首先放宽视野,从一般意义上描述、阐明信息的基本含意。

然后,再把眼光收缩到信息论的特定的研究范围中,指明信息论的假设前提,和解决问题的基本思路。

这样,就有可能帮助读者,在学习、研究这门课程之前,建立起一个正确的思维方式,有一个正确的思路,以便深刻理解、准确把握以下各章节的具体内容。