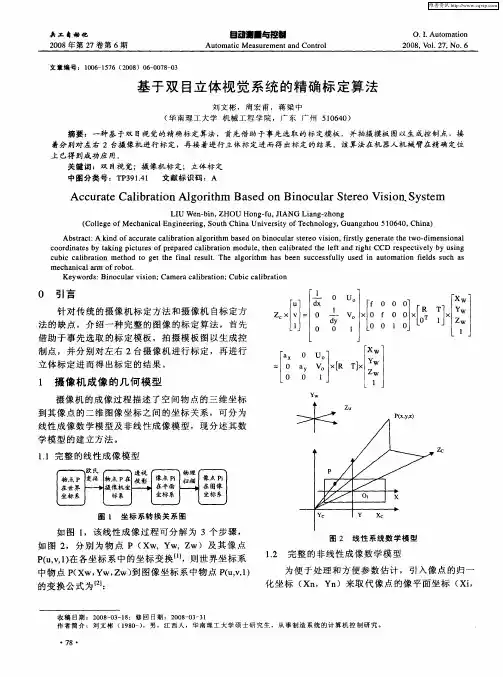

基于双目立体视觉的机械手精确定位系统

- 格式:pdf

- 大小:384.03 KB

- 文档页数:5

双目视觉定位原理双目视觉定位原理是一种常见的视觉定位原理,它是通过两个摄像头同时拍摄同一个物体的不同角度,再通过计算机图像处理技术将这些图像进行分析处理,从而确定目标物体的位置、大小、形态等信息。

这种技术被广泛应用于机器人、无人机、自动驾驶汽车等领域,它的基本原理是通过双目视觉模拟人类眼睛的立体视觉效果,以实现对目标物体的快速准确识别和定位。

双目视觉定位原理的基本原理双目视觉定位原理的基本原理是通过两个摄像头同时拍摄同一个物体的不同角度,再通过计算机图像处理技术将这些图像进行分析处理,从而确定目标物体的位置、大小、形态等信息。

双目视觉定位系统主要由两个摄像头、镜头、图像采集卡、图像处理器和计算机组成。

其中,两个摄像头被安装在一定距离的位置上,一般是左右两侧,成为双目视觉系统。

当目标物体出现在两个摄像头的视野中时,它将在两个摄像头的图像中分别呈现出不同的位置和角度。

计算机会对这些图像进行分析处理,通过计算两个图像之间的差异,确定目标物体的位置、大小、形态等信息,从而实现对目标物体的快速准确定位。

双目视觉定位原理的优势双目视觉定位原理相比其他定位原理具有以下优势:1.快速准确:双目视觉定位原理可以在短时间内快速准确地识别和定位目标物体,适用于高速运动物体的定位。

2.适应性强:双目视觉定位原理可以适应不同环境和光照条件下的定位需求,具有较高的灵活性和适应性。

3.精度高:双目视觉定位原理可以实现毫米级别的定位精度,可以满足高精度定位需求。

4.成本低:双目视觉定位原理不需要复杂的设备和技术,成本相对较低,适用于大规模应用。

双目视觉定位原理的应用领域双目视觉定位原理可以广泛应用于机器人、无人机、自动驾驶汽车等领域。

在机器人领域中,双目视觉定位原理可以用于机器人的自主导航、目标跟踪、障碍物避免等方面;在无人机领域中,双目视觉定位原理可以用于无人机的目标搜索、跟踪、拍摄等任务;在自动驾驶汽车领域中,双目视觉定位原理可以用于车辆的自主导航、障碍物检测、停车等方面。

双目立体视觉在工业中有很多应用例子,以下是一些常见的应用场景:

1.零件识别与定位:双目立体视觉可以通过对物体进行三维测量和重构,实现零件的精确识别和定位。

在生产线中,机器人可以使用双目立体视觉

系统来识别零件的位置和姿态,从而精确地拾取和操作零件。

2.质量检测:双目立体视觉可以用于检测产品的外观质量和尺寸精度。

通过获取产品的三维模型,可以对产品进行全方位的检测和分析,如检测产

品表面的缺陷、尺寸偏差、对称性等。

3.机器人导航:双目立体视觉可以用于机器人的自主导航和定位。

通过获取环境的三维信息,机器人可以精确地识别障碍物和路径,并进行避障和

路径规划。

4.增强现实:双目立体视觉可以与增强现实技术结合,将虚拟物体与现实场景进行融合。

通过获取现实场景的三维信息,可以将虚拟物体精确地放

置在场景中,从而实现更加逼真的增强效果。

5.自动化装配:在制造业中,装配过程需要很高的精度和准确性。

双目立体视觉可以通过对零件进行精确的定位和操作,实现自动化装配。

机器人

可以使用双目立体视觉系统来识别零件的位置和姿态,从而精确地装配零件。

总之,双目立体视觉在工业中具有广泛的应用前景,可以提高生产效率、降低成本、提高产品质量等。

随着技术的不断发展,双目立体视觉将会在更多的领域得到应用。

基于双目视觉机器人自定位与动态目标定位卢洪军【摘要】Aiming at the fact that, the mobile robot based on binocular vision is very easy to be disturbed by the complex environment, such as the influence of noise, illumination change and the occlusion of the robot, which will seriously affect the positioning accuracy of the self localization and the moving objects, the color feature of the HSV model is proposed to accurately segment the artificial landmarks, and the robot position is determined according to the principle of parallax.A method was proposed based on Harris operator which is accurate to the position of a moving object in a complex environment.The dynamic object is detected by the frame difference method.Harris operator was used to extract the feature points on the moving objects, so as to obtain the disparity value, and then to calculate the position of the moving objects.The experimental results show that the self localization and target localization can overcome the external disturbance and have strong adaptability by using this method.The algorithm has good real-time performance.%针对基于双目视觉自定位与动态目标定位极易受复杂环境(如噪声、机器人发生遮挡、光照变化等)的干扰导致移动机器人定位精度低的问题,提出基于HSV颜色模型特征准确分割出人工路标,根据视差原理确定机器人位置.同时提出一种双目机器人基于Harris算子实现在复杂环境下对动态目标精确定位的方法,利用帧间差分法将运动目标检测出来,采用Harris算子在该运动目标上提取特征点,并获得视差值,从而精确的计算出运动目标的位置.实验结果表明,利用该方法进行自定位与目标定位能够克服外界干扰,具有较强的适应性,且算法的实时性好.【期刊名称】《沈阳大学学报》【年(卷),期】2017(029)001【总页数】6页(P37-42)【关键词】双目视觉;目标定位;Harris算子;帧间差分法;HSV模型【作者】卢洪军【作者单位】沈阳工业大学信息科学与工程学院, 辽宁沈阳 110870【正文语种】中文【中图分类】TP391.420世纪末,对目标定位技术主要有基于红外线的定位技术、基于超声波的定位技术和基于频射识别技术等[1].近年来,由于图像处理和计算机视觉的飞速发展,机器视觉的研究越来越受到广大专家和学者的青睐[2].双目立体视觉是机器视觉的一个重要分支,能够直接模仿人类双眼处理外界环境[3],可以代替人类完成危险的工作(如深海探测、火灾救援、核泄漏监测等)[4].而基于双目立体视觉对动态目标检测与定位也是机器视觉领域备受关注的前沿课题之一[5].双目立体视觉定位主要分为六个步骤[6]:①图像获取;②图像预处理;③摄像机标定;④特征点提取;⑤特征点的立体匹配获取视差值;⑥基于视差原理实现机器人定位.特征点提取和立体匹配是实现机器人定位的关键环节.通常的方法是依靠目标的形状、颜色等特征检测目标,并以运动物体的形心或中心作为特征点[7].该方法虽然计算简单,但极易受噪声干扰,只选择一个点作为特征点,一旦该特征点发生遮挡或光照变化等,都会严重影响定位精度.1977年,Moravec提出根据图像的灰度变化来提取图像角点,称为Moravec角点[8].该方法计算相对简单,但对于处于边缘上的点会存在误检,也极易受光照变化的影响.SIFT特征点[9]和CenSurE特征点[10]虽然对尺度、亮度变化不敏感,但在弱纹理等复杂情况下难以提取稳定的特征点,算法复杂度高,计算时间较长.不满足移动机器人对实时性的要求.针对以上缺陷,本文首先利用帧间差分法检测出运动目标,然后在运动目标上基于Harris算法提取多个特征点来实现移动机器人在复杂环境下实时的对运动目标精确定位.机器人整体定位流程如图1所示,移动机器人首先基于HSV颜色模型空间分割出人工路标,实现机器人自定位.然后利用帧间差分法检测出运动目标,根据Harris算法在左右两幅图像上提取特征点,根据区域匹配原理获取视差值,利用视差原理即可求出运动目标的世界坐标,即完成了对运动目标的定位.1.1 人工路标检测(1) HSV颜色模型.RGB色彩空间分别以红色、绿色、蓝色为三原色,通过适当的搭配可以合成成千上万种颜色,是一种常见的颜色表示法.但是RGB色彩空间与人眼的感知差异大,其空间的相似不代表实际颜色的相似.为了能够更准确分割出人工路标,本文采用HSV色彩空间颜色模型,如图2所示.RGB颜色空间转化到HSV色彩空间只是一个简单的非线性变换,计算简单.HSV模型中H代表色调,S代表饱和度,并且独立于亮度信息V.色调H代表颜色信息,取值范围为0~180°,对其设定阈值可以区分不同颜色的路标;饱和度S表示颜色中掺杂白色的程度,取值范围为0~1,S 越大,颜色越深;亮度V表示颜色的明暗程度,取值范围为0~1,V越大,物体亮度越高.(2) 基于颜色特征提取人工路标.由于本文是在室内环境下对移动机器人定位,所以本文设计的人工路标是由红黄蓝三种颜色组成的矩形纸板.如图3a所示为左摄像机拍摄到的带有人工路标的室内环境.根据HSV颜色模型对H、S、V三个分量进行阈值设置即可分割出人工路标,如图3b所示.然后利用图像处理中的形态学操作对分割出的路标进行完善使其效果最佳,如图3c所示.图3d为获取人工路标的中心点,利用视差原理即可得到当前帧机器人的位置.1.2 帧间差分法帧间差分法[11]的思想是对一段连续视频的相邻两帧进行差分运算,从差分运算的结果中得到运动目标的轮廓.该算法的优点是实现简单,对光照变化不敏感,稳定性好.适用于多目标或背景变化较快的场合.图4为在室内环境下用帧间差分法检测到运动物体.结果显示,帧间差分法能够有效的将运动目标检测出来.2.1 双目立体视觉测距原理双目立体视觉的视差原理[12]是利用两台摄像机从两个视点观察同一景物,以获取在不同视角下的感知图像,通过计算空间点在两幅图像中的视差来获取目标物体的三维坐标.2.2 Harris角点检测Harris角点[13]是在Moravec角点的基础进行改进的算法. Harris算子是用高斯函数代替二值窗口函数, 对离中心点越远的像素赋予越小的权重, 以减少噪声的影响. 高斯函数如式(1)所示.Moravec算子只考虑了四个方向的像素值,Harris算子则用Taylor展开式去近似任意方向.图像I(x,y)平移(Δx,Δy)可以一阶近似为在图像I(u,v)中,像点(u,v)平移(Δx,Δy)后的自相关函数为将式(2)代入式(3)可得:其中M如下所示:根据式(5)中矩阵M的特征值可以近似的表示函数C(x,y)的变化特征.矩阵M的特征值需要考虑以下三种情况,如图5所示.(1) 如果矩阵M的两个特征值都比较小,则表征图像灰度变化函数C(x,y)的值也较小,就说明该像素点的邻域内灰度差值不大,图像较平滑,无角点.(2) 如果矩阵M的两个特征值一个较大,一个较小,说明该像素点的曲率也是如此,则该点的窗口区域处于一条边界,无角点.(3) 如果矩阵M的两个特征值都比较大,则图像灰度变化的自相关函数值也较大,该点的窗函数沿任意方向都将引起灰度的剧烈变化,该点即为角点.根据这一准则,只要计算行列式的特征值就可以检测图像中的哪些点是角点.Harris 提出角点的响应函数:det(M)为行列式的值,trace(M)为行列式的迹.而k根据Harris的建议一般取0.04~0.06之间.若Harris角点响应大于阈值,则被认为是角点.Harris角点的生成只涉及到一阶导数,所以该角点对噪声影响、光照变化引起的灰度值变化都不敏感,是一种比较稳定的特征提取算子.3.1 实验环境本文使用的机器人是由北京博创兴盛技术有限公司开发的自主移动机器人旅行家Ⅱ号,如图6所示.该机器人上安装了由加拿大Point Grey Research公司生产的Bumblebee2双目摄像机,其性能参数如表1所示.3.2 传统移动机器人对运动目标定位实验环境为一间办公室,装有双目摄像机Bumblebee2的移动机器人为工作机器人,用于检测运动目标.将另一台机器人视为运动目标,运动速度为0.1 m/s.传统的方法是提取运动目标的中心点,获取视差值,从而给运动目标定位.传统方法仅获取图像中的一个点作为立体匹配的特征点,当该点受到环境的干扰时定位精度会受到极大的影响,图7为传统方法提取运动目标中心点.表2为传统方法对运动目标定位的实验数据,表3为改变光照后传统方法移动机器人对运动目标定位的实验数据.可以得出传统方法机器人定位误差相对较大,一旦光照发生改变,对运动物体定位误差会更加严重.3.3 基于Harris算子机器人对运动目标定位针对传统方法定位精度不足,极易受外界环境的干扰的问题,决定采用基于Harris角点特征提取,即在相机获得的左右两幅图像上基于Harris算子提取多对特征点,如图8所示.表4、表5为基于Harris方法机器人对运动目标定位的实验数据,可以得出基于该方法对运动目标定位误差很小,相对误差降低到1%左右,当光照发生变化时也能实现对运动目标精确定位.最后将每一帧的两幅图像根据区域匹配原理[14]和极限束准则找到正确的匹配点,排出易受噪声干扰的点,从而得到视差值,即可准确的对运动目标定位.(1) 本文研究了机器人基于双目立体视觉实现自定位与对运动目标定位,充分利用双目视差原理,并结合Harris算法和帧间差分法来实现运动目标的精确定位.从仿真结果可以看出,提取多个特征点可以避免只用一个点易受干扰的不足,实现更精确的运动目标定位.(2) 虽然本文在运动目标上提取多个特征点,有效的克服了传统方法的不足.但还存在问题需要改进.首先,需要找到一种更快更准确的特征点立体匹配算法;其次,本文只是将每一帧图像得到的多个视差值做平均值处理,如何有效的将多个视差值融合也是对运动目标精确定位的关键.【相关文献】[1] 李艳. 双视频目标定位技术[J]. 沈阳大学学报(自然科学版), 2016,28(4):302-305. (LI Y. Dual video target location technology[J]. Journal of Shenyang University(Natural Science), 2016,28(4):302-305.)[2] 李天健. 基于机器人视觉的汽车零配件表面缺陷检测算法研究与实现[J]. 沈阳大学学报(自然科学版), 2013,25(6):476-480. (LI T J. Research and implementation of auto parts surface defect detection algorithm bases on robot visio[J]. Journal of Shenyang University (Natural Science), 2013,25(6):476-480.)[3] 杜宇. 三维重建中双目立体视觉关键技术的研究[D]. 哈尔滨:哈尔滨理工大学, 2014:1-5. (DU Y. Research on key technology of binocular stereo vision in three-dimensional reconstruction[D]. Harbin:Harbin University of Science and Technology, 2004:1-5.)[4] 余俊. 基于双目视觉的机器人目标检测与控制研究[D]. 北京:北京交通大学, 2011:1-4. (YU J. Research on target detection and robot control based on binocular vision[D]. Beijing: Beijing Jiaotong University, 2011:1-4.)[5] DESOUZA G N, KAK A C. Vision for mobile robot navigation: A survey[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002,24(2): 237-267.[6] 高栋栋. 基于双目立体视觉定位和识别技术的研究[D]. 秦皇岛:燕山大学, 2013:9-11. (GAO D D. Research on recognizing and locating binocular stereo vision technology[D]. Qinhuangdao:Yanshan University, 2013:9-11)[7] 崔宝侠,栾婷婷,张弛,等. 基于双目视觉的移动机器人运动目标检测与定位[J]. 沈阳工业大学学报, 2016,38(4):421-427. (CUI B X, LUAN T T, ZHANG C, et al. Moving object detection and positioning of robot based on binocular vision[J]. Journal of Shenyang University of Technology, 2016,38(4):421-427.)[8] 邓国栋. 基于多尺度特征的双目立体视觉目标定位[D]. 哈尔滨:哈尔滨工业大学, 2012: 21-22. (DENG G D. Object location of binocular stereo vision base on multi-scale feature[D]. Harbin: Harbin Institute of Technology, 2012:21-22.)[9] LOWE D G. Distinctive image feature from scale-invariant key point[J]. International Journal of Computer Vision, 2004,60(2):91-110.[10] KONOLIGE K, AGRAWAL M, SOLA J. Large-scale visual odometry for roughterrain[C]∥Robotics Research: The 13thInternational Symposium ISRR, 2011,66:201-212.[11] 熊英. 基于背景和帧间差分法的运动目标提取[J]. 计算机时代, 2014(3):38-41. (XIONG Y. Moving object extraction based on background difference and frame differencemethod[J]. Computer Era, 2014(3):38-41.)[12] 林琳. 机器人双目视觉定位技术研究[D]. 西安:西安电子科技大学, 2009:8-10. (LIN L. The research of visual positioning technology on the binocular robot[D]. Xi’an: Xi'an Electronic and Science University, 2009:8-10.)[13] 张从鹏,魏学光. 基于Harris角点的矩形检测[J]. 光学精密工程, 2014,22(8):2259-2266. (ZHANG C P, WEI X G. Rectangle detection base on Harris corner[J]. Optics and Precision Engineering, 2014,22(8):2259-2266.)[14] 罗桂娥. 双目立体视觉深度感知与三维重建若干问题研究[D]. 长沙:中南大学, 2012:48-53. (LUO G E. Some issues of depth perception and three dimension reconstruction from binocular stereo vision[D]. Changsha: Central South University, 2012:48-53.)。

双目相机在机器人手眼标定中的应用双目相机在机器人手眼标定中的应用机器人视觉系统是现代机器人技术中的重要组成部分,而双目相机作为一种常见的视觉传感器,其在机器人手眼标定中的应用尤为重要。

机器人手眼标定是指确定机器人手部(机械臂)和眼部(相机)之间的准确关系,使机器人能够根据相机图像进行精确的操作和定位。

以下是双目相机在机器人手眼标定中的应用步骤:第一步:准备标定板首先,需要准备一个标定板,通常使用黑白相间、大小合适的棋盘格标定板。

该标定板上的方格应尽可能保持水平和垂直,以便于后续标定过程的准确性。

第二步:安装相机和机器人手部将双目相机安装在机器人手部的末端,确保相机与机器人工作空间之间没有干涉。

同时,需要固定相机和机器人手部的位置,以保持标定板与相机之间的相对位置稳定。

第三步:采集图像数据通过控制机器人手部的运动,使标定板在相机的视野范围内以不同的姿态和位置进行移动。

在每个姿态和位置下,相机会拍摄到标定板的图像。

需要多次采集不同姿态和位置下的图像数据,以提高标定的准确性和鲁棒性。

第四步:提取特征点对于每张拍摄到的图像,通过图像处理算法提取标定板上的特征点。

常见的特征点提取算法包括角点检测和SIFT算法。

特征点的提取应该具有鲁棒性和准确性,以确保标定的准确性。

第五步:计算相机的内外参数通过特征点的坐标和相机的几何关系,可以计算出相机的内外参数。

内参数包括相机的焦距、主点位置和畸变参数等,外参数包括相机的旋转矩阵和平移矩阵。

这些参数描述了相机的成像特性和相机与机器人手部之间的几何关系。

第六步:计算机器人手部的关节坐标系根据相机的外参数和机器人手部的运动学模型,可以计算出机器人手部在世界坐标系下的位置和姿态。

这样,就建立了机器人手部的关节坐标系与相机坐标系之间的准确关系。

第七步:验证标定结果最后,需要对标定结果进行验证。

可以使用新的标定板图像或其他物体来测试机器人手部的定位精度和准确性。

如果标定结果满足要求,则可以将双目相机用于机器人操作和定位任务。

双目视觉技术在机器人领域中的应用研究随着科技的不断发展和进步,各种智能机器人已经成为了我们生活中不可或缺的一部分。

它们不仅能够协助我们完成各种任务,也可以为我们提供许多便利。

其中,双目视觉技术是机器人领域中最典型且广泛应用的技术之一,本文将探讨它在机器人领域中的应用研究。

一、双目视觉技术的基本原理双目视觉技术是指利用两个摄像头对同一目标进行拍摄,然后通过计算机算法来获取该目标的信息。

它的原理是利用两个摄像头之间的基线差异来获取深度信息,从而实现对三维目标的测量和计算。

因此,在机器人领域中,双目视觉技术可用于感知和判断其周围环境的深度信息,从而实现自主控制和运动。

二、双目视觉技术在机器人视觉导航中的应用在机器人视觉导航中,双目视觉技术也发挥着重要作用。

在自动驾驶汽车、无人机等机器人当中,利用双目摄像头可以获取道路、建筑物、行人等周围环境的深度信息,进而实现机器人对于环境的感知和判断。

同时,双目视觉技术也可以用于机器人路径规划,通过获取周围环境的深度信息,机器人可以获得更多的地形和道路信息,从而选择最佳路径进行行驶。

三、双目视觉技术在机器人操作上的应用在机器人操作过程中,双目视觉技术也具有很大的应用价值。

例如,利用双目摄像头对复杂物体的形状和轮廓进行检测和识别。

同时,还可以对物体的位置、大小、方向等进行测量和计算,实现机器人对于复杂操作的自主控制和运行。

此外,在机器人抓取物体过程中,双目视觉技术也可以提供更精准的信息,使得机器人抓取物体更加精准和高效。

四、双目视觉技术在机器人人机交互中的应用在机器人人机交互中,双目视觉技术也发挥着越来越重要的作用。

例如,在机器人服务领域中,可以利用双目摄像头对人脸进行识别和检测,从而实现机器人的智能服务和监测。

另外,在机器人教育领域中,利用双目视觉技术还可以实现机器人对学生的监测和评估。

五、双目视觉技术在机器人医疗领域中的应用前景在未来的机器人医疗领域中,双目视觉技术也将发挥重要作用。

挪动机器人双目视觉-惯导融合定位技术探究关键词:挪动机器人;双目视觉;惯性导航;融合算法;定位精度;鲁棒性1. 引言挪动机器人自主导航与定位是机器人领域亟待解决的技术难题。

传统的定位方式主要依靠GPS、激光等技术,但在室内环境或密闭环境下无法使用。

因此,双目视觉与惯性导航系统(INS)成为了探究的热点之一。

本文将双目视觉与惯性导航系统进行融合,提高了定位的精度和鲁棒性。

2. 双目视觉定位双目视觉利用左右两个摄像机从不同的角度拍摄同一物体,通过图像处理和三角测量等方法计算出目标物体的三维坐标。

双目视觉定位方法相对实惠,且容易实现,但在暗光、昏暗环境下精度无法保证,且对于透亮和高反光物体的识别存在困难。

3. 惯性导航定位惯性导航系统利用加速度计和陀螺仪等传感器测量机器人的姿态和运动状态,通过累计计算出机器人相对于起始位置的位移,从而实现机器人的定位。

INS的定位精度较高,但由于测量误差的叠加,随着时间的推移误差会越来越大。

4. 双目视觉-惯导融合定位技术双目视觉与惯性导航系统各自具有优缺点,因此将两者进行融合,可以弥补彼此的不足,提高定位精度和鲁棒性。

本文提出了一种基于卡尔曼滤波的双目视觉-惯导融合定位算法。

在该算法中,双目视觉通过图像处理和三角测量等方法计算出机器人相对于目标的距离和角度,惯性导航系统通过加速度计和陀螺仪等传感器测量机器人的位移和姿态信息,并依据卡尔曼滤波的原理对测量误差进行修正,从而提高定位精度和鲁棒性。

5. 试验结果分析本文对设计的双目视觉-惯导融合定位算法进行了试验验证,通过利用机器人在室内环境中的运动数据进行测试,验证了算法的可行性。

试验结果表明,与单独使用双目视觉和惯性导航系统相比,双目视觉-惯导融合定位算法具有更高的定位精度和更好的鲁棒性。

6. 结论本文提出了一种基于卡尔曼滤波的双目视觉-惯导融合定位算法,并通过试验验证了该算法的可行性和有效性。

该算法能够提高挪动机器人在室内环境中的定位精度和鲁棒性,为挪动机器人在实际应用中的导航和定位提供了可靠的技术支持。

《基于双目立体视觉定位和识别技术的研究》篇一一、引言随着科技的飞速发展,计算机视觉技术在众多领域中得到了广泛的应用。

其中,双目立体视觉定位和识别技术以其高精度、高效率的特点,在机器人导航、无人驾驶、三维重建等领域中发挥着越来越重要的作用。

本文旨在研究基于双目立体视觉的定位和识别技术,分析其原理、方法及在各领域的应用,以期为相关研究提供参考。

二、双目立体视觉原理双目立体视觉技术基于人类双眼的视觉原理,通过两个相机从不同角度获取物体的图像信息,然后利用图像处理技术对两幅图像进行匹配、计算,从而得到物体的三维空间信息。

该技术主要包括相机标定、图像预处理、特征提取与匹配、三维重建等步骤。

三、双目立体视觉定位技术双目立体视觉定位技术是利用双目相机获取的图像信息,通过图像处理算法对物体进行定位。

该技术主要包括以下步骤:1. 相机标定:确定相机内参和外参,包括相机的焦距、光心位置、畸变系数等。

2. 图像预处理:对两幅图像进行去噪、平滑等处理,以便更好地提取特征。

3. 特征提取与匹配:利用特征提取算法(如SIFT、SURF等)提取两幅图像中的特征点,并通过匹配算法(如暴力匹配、FLANN匹配等)找到对应的特征点。

4. 三维定位:根据匹配的特征点,利用三角测量法等算法计算物体的三维空间坐标。

四、双目立体视觉识别技术双目立体视觉识别技术是在定位技术的基础上,进一步对物体进行分类、识别。

该技术主要包括以下步骤:1. 特征描述与分类:根据提取的特征点,建立物体的特征描述符,并通过分类器(如支持向量机、神经网络等)进行分类。

2. 模式识别:利用机器学习等技术对物体进行识别,包括目标检测、语义分割等。

3. 深度学习应用:利用深度学习算法(如卷积神经网络等)对物体进行更精确的识别和分类。

五、应用领域双目立体视觉定位和识别技术在众多领域中得到了广泛的应用,主要包括以下几个方面:1. 机器人导航与无人驾驶:通过双目相机获取周围环境的信息,实现机器人的自主导航和无人驾驶。

aimposition光学定位原理

AimPosition光学定位系统是基于双目立体视觉进行跟踪和定位的光学导航设备。

其定位原理主要依赖于双目视觉和视差原理。

首先,该系统由双摄像机从不同角度同时获得被测物的两幅数字图像。

然后,基于视差原理,从两幅图像中恢复出物体的三维几何信息。

视差原理指的是,当两个摄像机从稍微不同的角度看同一物体时,物体在两个图像中的位置会有微小的差异,这个差异就是视差。

通过测量和解析这个视差,我们可以得到物体在三维空间中的位置和形状。

接下来,AimPosition光学定位系统利用这些三维几何信息,重建物体的三维轮廓及位置。

最后,系统可以动态地在特定的三维空间中确定任何工具尖端的位置,追踪精度可达0.12mm(RM5)。

此外,AimPosition光学定位系统基于FPGA技术平台构建,提高了双目视觉图像采集的高同步性、稳定性,使得系统可以在动态的三维空间中实时追踪工具位置。

总的来说,AimPosition光学定位系统的定位原理主要是利用双目立体视觉和视差原理,从两个不同角度的图像中恢复出物体的三维几何信息,然后重建物体的三维轮廓和位置,

从而实现对工具尖端的精确追踪和定位。

双目立体视觉匹配双目立体视觉匹配是一种通过两只眼睛同时观察物体来获取深度信息的技术。

通过比较两只眼睛看到的图像,可以确定物体的位置和形状,从而实现立体视觉。

这项技术在计算机视觉和机器人领域有着广泛的应用,可以用于三维重建、物体识别、姿态估计等领域。

双目立体视觉匹配的原理是利用人类的双眼视差来获得深度信息。

当一个物体处于距离眼睛较远的位置时,两只眼睛看到的图像有一定的差异,这种差异称为视差。

通过比较两只眼睛看到的图像,可以计算出物体的深度信息。

在计算机视觉中,双目立体视觉匹配也是通过比较两个图像中的像素点来确定它们之间的视差,从而获取深度信息。

在实际应用中,双目立体视觉匹配需要解决许多问题,如计算图像中的像素点之间的视差、处理图像中的噪声和遮挡等。

为了解决这些问题,研究人员提出了许多算法和方法,如卷积神经网络、特征点匹配、立体匹配算法等。

在双目立体视觉匹配中,特征点匹配是一种常用的方法。

该方法通过寻找图像中的特征点,并比较它们在两个图像中的位置来计算视差。

特征点可以是图像中的角点、边缘点、纹理点等。

当两个图像中的特征点匹配成功时,就可以计算出它们的视差,并获得深度信息。

除了特征点匹配外,立体匹配算法也是双目立体视觉匹配中的重要方法。

该算法通过比较两个图像中的区域来计算视差,并获取深度信息。

在立体匹配算法中,常用的方法包括区域匹配算法、基于能量函数的算法、基于图割的算法等。

这些算法都是通过比较两个图像中的区域来计算视差,并获取深度信息。

近年来,深度学习算法在双目立体视觉匹配中也得到了广泛的应用。

通过训练深度神经网络,可以实现对双目立体图像的特征提取和深度估计。

这种方法可以有效地处理图像中的噪声和遮挡,并获得更精确的深度信息。

双目立体视觉匹配是一种重要的计算机视觉技木,它可以在计算机视觉和机器人领域中实现三维重建、物体识别、姿态估计等应用。

要实现双目立体视觉匹配,需要解决图像中的特征点匹配、立体匹配算法、深度学习算法等问题。

双目视觉方案引言双目视觉是一种模拟人类双眼视觉的技术,通过两个摄像头模拟人眼的立体感知能力。

双目视觉方案被广泛应用于各种领域,包括计算机视觉、机器人导航、虚拟现实等。

本文将介绍双目视觉方案的原理、应用以及实现方法。

原理双目视觉方案基于立体视觉原理,利用两个摄像头分别记录目标物体在不同位置时的图像,并通过计算两个图像之间的视差来推断物体的距离。

视差是指在两个图像中同一点的像素位置之间的偏移量,视差越大代表物体距离摄像头越近,视差越小代表物体距离摄像头越远。

应用3D视觉重建双目视觉方案可用于实现高精度的三维物体重建。

通过采集目标物体在不同角度下的图像,可以利用双目视觉算法重建物体的三维模型。

这对于设计、制造和可视化等应用具有重要意义。

目标检测与跟踪双目视觉方案可以将两个摄像头放置在一定距离内,以获取不同角度的目标物体图像。

利用双目视觉算法可以从图像中提取物体的特征,并通过运动估计算法实现对目标物体的跟踪。

这对于自动驾驶、机器人导航等应用非常关键。

虚拟现实虚拟现实系统需要实时、准确地感知用户的头部位置和姿态信息,以提供逼真的虚拟体验。

双目视觉方案可以利用摄像头记录用户的眼睛位置和姿态,通过计算用户眼睛之间的视差,可以实时推断用户的头部位置和姿态,从而提供精确的头部跟踪。

实现方法目标标定在使用双目视觉方案之前,需要对双目系统进行标定,以获取相机的内部参数和外部参数。

标定过程一般包括摄像头的畸变校正、相机的内部参数计算、摄像头的外部位置和姿态计算等步骤。

视差计算双目视觉的核心算法是视差计算。

通过将两个图像进行匹配,可以计算出每个像素的视差值。

常用的视差计算算法包括基于区域的算法、基于特征点的算法等。

视差图可以通过将视差值映射到灰度图像上进行可视化。

三维重建根据视差图,可以通过三角测量的方法计算出物体的三维坐标。

三角测量可以使用相机的内外参数,将视差值转换为物体的实际距离。

目标检测与跟踪在双目视觉系统中,目标检测与跟踪是一个重要的应用。

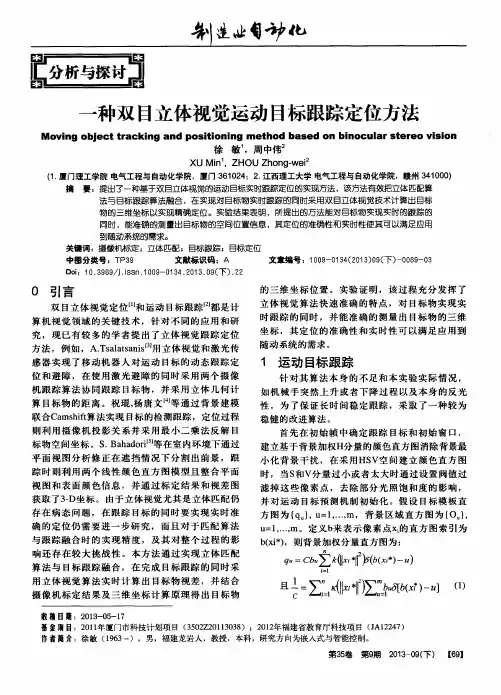

doi: 10.11857/j.issn.1674-5124.2020050146基于多目立体视觉的机械臂智能控制系统设计张青春, 王 旺, 杨广栋(淮阴工学院自动化学院,江苏 淮安 223003)摘 要: 为提高工业抓取物料的准确性与速度,针对质量为70 kg 物料抓取困难的问题,以工业摄像头、计算机、光源和工业机械手为硬件基础,5G 移动通信为系统与上位机之间的数据交互,构建多目立体视觉的机械臂智能控制系统。

提出一种改进的跨尺度引导滤波算法,在代价聚合阶段利用奇数采样层使用基于高斯拉普拉斯算子的引导图滤波、偶数采样层使用引导滤波的方法对不同高斯采样层的代价卷进行代价聚合,并在视差精细化阶段加入亚像素增强的方法。

最后在Matlab 和OpenCV 平台进行立体匹配实验和机械臂运动轨迹的仿真。

实验结果表明,该算法能更加准确获取物体的空间坐标,完成三维重建,机械臂能够成功完成智能抓取。

关键词: 立体视觉; 机械臂; 跨尺度; 三维重建中图分类号: TP241.2;TB9文献标志码: A文章编号: 1674–5124(2020)12–0079–07Design of industrial robot manipulator intelligentcontrol system based on multi-view stereo visionZHANG Qingchun, WANG Wang, YANG Guangdong(Automation Faculty, Huaiyin Institute of Technology, Huai’an 223003, China)Abstract : To improve the accuracy and speed of industrial grabbing material. To solve the problem of difficult material grabbing with a weight of 70 kg, an intelligent control system of mechanical arm with multi-view stereo vision is proposed. The system based on industrial camera, computer, light source and industrial mechanical arm and 5G mobile communication as data interaction between the system and upper computer. A stereo matching method based on the guided filtering cross-scale transform was improved. Different cost aggregation algorithm is used for the cost aggregation of different downsampling layers. In the odd downsampling layer, guided image filtering based on Laplacian of Gaussion operator is used. At the same time,by adding the Sub-pixel enhancement in the disparity refinement stage. Finally, a jiont simulation by using Matlab and OpenCV was conducted, by the stereo matched and the motion track of the mechanical arm.The experimental results show that the algorithm can obtain the spatial coordinates of the object more accurately and complete the 3D reconstruction,the mechanical arm can successfully completed intelligent grasp.Keywords : stereo vision; robot manipulator; cross scale; 3D reconstruction收稿日期: 2020-05-29;收到修改稿日期: 2020-06-23作者简介: 张青春(1964-),男,江苏淮安市人,教授,研究方向为智能检测技术、无线传感器、机器人与物联网、虚拟仪器技术等。

总733期第三十五期2020年12月河南科技Journal of Henan Science and Technology信息技术基于双目视觉的机器人抓取系统周晏韩毅王旭彬郭圆辉(安阳工学院计算机科学与信息工程学院,河南安阳455000)摘要:基于机器视觉系统引导的机器人抓取技术是当前机器人技术研究的热点,如何对机器人与摄像机进行精准的手眼标定是实现机器人精准抓取的前提和基础。

本文通过双目摄像机和四轴机器人建立了基于双目视觉的机器人抓取系统,采用张正友标定法对双目摄像机的内外参数进行标定,对眼在手外的抓取系统进行手眼标定,并将抓取目标物体空间坐标信息转化为机器人控制信息,完成目标抓取。

关键词:双目视觉;机器人;手眼标定;物体抓取中图分类号:TP242文献标识码:A文章编号:1003-5168(2020)35-0004-04Robot Grasping System Based on Binocular VisionZHOU Yan HAN Yi WANG Xubin GUO Yuanhui(Department of Computer Science and Information Engineering,Anyang Institute of Technology,Anyang Henan455000)Abstract:Robot grasping technology guided by the machine vision system is a hot spot in the current robotics re⁃search,and how to perform accurate hand-eye calibration of robots and cameras is the prerequisite and basis for achieving accurate robot grasping.A robot grasping system based on binocular vision through binocular cameras and four-axis robots was established in this paper,which used Zhang Zhengyou calibration method to calibrate the inter⁃nal and external parameters of the binocular cameras,and performed hand-eye calibration on the grasping system with eye-to-hand,and the space coordinate information of the captured target object was transformed into robot con⁃trol information to complete the target capture.Keywords:binocular vision;robot;hand-eye calibration;object grasping《中国制造2025》的核心目标是装备生产的信息化与智能化,而智能机器人恰好是实现这一目标的重要执行者。

基于3D视觉信息的机械手抓取机械零部件的关键技术研究基于3D视觉信息的机械手抓取机械零部件的关键技术研究摘要:随着机械制造业的发展,自动化生产逐渐成为一种趋势。

机械手作为自动化生产中的重要组成部分,需要准确抓取各种机械零部件才能完成任务。

而在抓取过程中,靠单纯的机械控制效果有限,因此需要结合3D视觉信息进行技术研究。

本文主要介绍了基于3D视觉信息的机械手抓取机械零部件的关键技术以及在实际应用中的影响。

关键词:3D视觉信息;机械手;抓取;机械零部件一、引言机械制造工业是国民经济的重要组成部分,随着科学技术的发展,自动化生产已经成为一种趋势。

而在自动化生产中,机械手作为重要的执行机构,起着关键的作用。

机械手在完成各类任务时,需要准确地抓取机械零部件,因此抓取技术的研究变得尤为重要。

传统的机械手在抓取机械零部件时主要依赖力学夹爪的力学原理,但是在某些场景下,单纯的机械控制的效果往往有限。

例如,机械零部件形状复杂、表面粗糙或者尺寸过小,以及堆叠在一起等情况下,机械手的抓取准确度难以保证。

为了解决这些问题,3D视觉信息被引入到机械手抓取技术中,提高了抓取的准确度和稳定性。

二、基于3D视觉信息的机械手抓取技术1. 3D传感器的设置基于3D视觉信息的机械手抓取技术首先需要获取场景中物体的三维信息。

为了实现这一点,通常在机械手周围设置3D传感器。

3D传感器可以通过激光扫描、结构光或者立体视觉等技术来获取物体的三维模型。

采集到的三维模型可以用来进行后续的物体检测和定位。

2. 物体检测与识别在获取到三维模型之后,需要进行物体检测和识别。

物体检测和识别是基于机器学习或者深度学习的算法来实现的。

通过将采集到的三维点云数据与预设的物体库进行比对,可以识别出待抓取的机械零部件。

物体检测和识别的准确性对于后续的抓取任务非常重要。

3. 抓取规划和路径规划在识别出待抓取的机械零部件之后,需要进行抓取规划和路径规划。

抓取规划的目标是确定机械手的抓取点和抓取姿态。