作业参考答案信息论

- 格式:doc

- 大小:2.61 MB

- 文档页数:37

2-1 同时掷两个正常的骰子,也就是各面呈现的概率都是1/6,求:(1)“3和5同时出现”这事件的自信息量。

(2)“两个1同时出现”这事件的自信息量。

(3)两个点数的各种组合(无序对)的熵或平均信息量。

(4)两个点数之和(即2,3,…,12构成的子集)的熵。

(5)两个点数中至少有一个是1的自信息。

解:(1)bitx p x I x p i i i 170.4181log )(log )(18161616161)(=-=-==⨯+⨯=(2)bit x p x I x p i i i 170.5361log)(log )(3616161)(=-=-==⨯=(3)两个点数的排列如下: 11 12 13 14 15 16 21 22 23 24 25 26 31 32 33 34 35 36 41 42 43 44 45 46 51 52 53 54 55 56 61 62 63 64 65 66共有21种组合:其中11,22,33,44,55,66的概率是3616161=⨯ 其他15个组合的概率是18161612=⨯⨯symbol bit x p x p X H ii i / 337.4181log 18115361log 3616)(log )()(=⎪⎭⎫ ⎝⎛⨯+⨯-=-=∑(4)参考上面的两个点数的排列,可以得出两个点数求和的概率分布如下:symbolbit x p x p X H X P X ii i / 274.3 61log 61365log 365291log 912121log 1212181log 1812361log 3612 )(log )()(36112181111211091936586173656915121418133612)(=⎪⎭⎫ ⎝⎛+⨯+⨯+⨯+⨯+⨯-=-=⎪⎭⎪⎬⎫⎪⎩⎪⎨⎧=⎥⎦⎤⎢⎣⎡∑(5)bitx p x I x p i i i 710.13611log )(log )(3611116161)(=-=-==⨯⨯=2-2 设有一离散无记忆信源,其概率空间为[]⎥⎦⎤⎢⎣⎡=====8/14/14/18/332104321x x x x P X(1) 求每个符号的自信息量;(2) 若信源发出一消息符号序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210),求该消息序列的自信息量及平均每个符号携带的信息量。

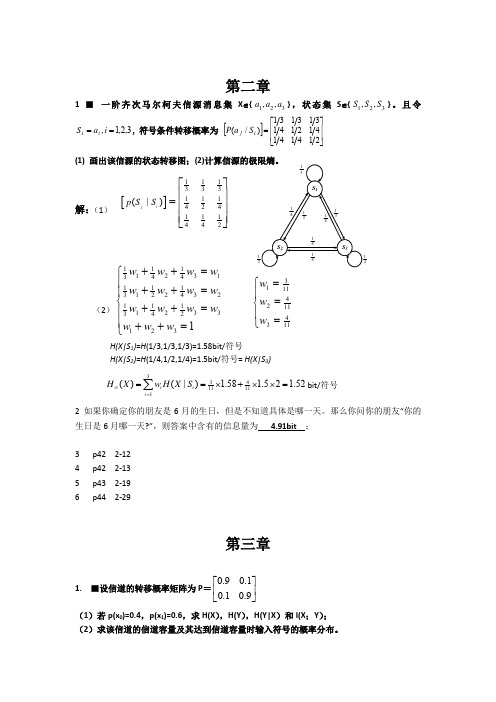

第二章1 ■ 一阶齐次马尔柯夫信源消息集X ∈{321,,a a a },状态集S ∈{321,,S S S }。

且令3,2,1,==i a S i i , 符号条件转移概率为 []⎥⎥⎦⎤⎢⎢⎣⎡=21414141214131311)/(i j S a P(1) 画出该信源的状态转移图;(2)解:(1)[]111333111424111442(|)jip S S ⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦(2)1111231344111123232411112333421231w w w w w w w w w w w w w w w ++=⎧⎪++=⎪⎨++=⎪⎪++=⎩311142114311w w w =⎧⎪=⎨⎪=⎩H(X|S 1)=H (1/3,1/3,1/3)=1.58bit/符号H(X|S 2)=H (1/4,1/2,1/4)=1.5bit/符号= H(X|S 3)33411111()(|) 1.58 1.52 1.52i i i H X w H X S ∞===⨯+⨯⨯=∑bit/符号2 如果你确定你的朋友是6月的生日,但是不知道具体是哪一天。

那么你问你的朋友“你的生日是6月哪一天?”,则答案中含有的信息量为 4.91bit ;3 p42 2-124 p42 2-135 p43 2-196 p44 2-29第三章1. ■设信道的转移概率矩阵为P =0.90.10.10.9⎡⎤⎢⎥⎣⎦(1)若p(x 0)=0.4,p(x 1)=0.6,求H(X ),H(Y ),H(Y|X )和I(X ;Y ); (2)求该信道的信道容量及其达到信道容量时输入符号的概率分布。

(3)设该信道以1800个二元符号/秒的速度传输输入符号。

现有一消息序列共有10000个二元符号,在p(x 0)=1/2,p(x 1)=1/2情况下,从信息传输的角度来考虑,10秒内能否将这消息序列无失真地传送完?解:(1)[]0.360.04(,)0.060.54p x y ⎡⎤=⎢⎥⎣⎦, [p(y)]=[0.42 0.58] H(X)(0.4,0.6)0.97H ==bit/符号 H(Y)(0.42,0.58)0.98H ==bit/符号 H(Y|X)(0.9,0.1)0.47H ==bit/符号I(X;Y)= H(Y)-H(Y|X)=0.51bit/符号(2)C=1-H(ε)=1-H(Y|X)=0.53bit/符号 p 0=p 1=0.5(3)H(X)×104=104 bit1800×C ×10=9540 bit < 104所以不能无失真传送完。

2009年信息论第一次作业参考答案1. 在NBA 季后赛中,两个队要进行七战四胜制的系列赛,当任意一个队获得四场胜利时,这一轮系列赛结束。

不妨用A、B 来表示这两个队,用X 表示这场系列赛中每场比赛的结果,X 可能的取值有AAAA,BABABAA,BBBAAAA 等。

用Y 来表示总共进行的比赛场次。

Y 的取值范围为4至7。

假设每场比赛独立,且两队实力相当,即每个队在每场比赛中获胜的概率均为50%。

求H(X),H(Y),H(Y|X)和H(X|Y)。

解:确定 Y=k 时,X 可能的取值个数为 312*k C −,因为如果A 队赢得整个系列赛,则最后一场必然是A 赢,而前面k-1场中A 赢了3场的可能情况有31k C −种,于是X 的可能取值为312*k C −。

其中每一个取值对应的概率为2k−。

Y=4时,X 可能取值个数有 2个,每个的概率为 1/16; 11(4)*2168P Y === Y=5时,X 可能取值个数有 342*8C =个,每个的概率为 1/32;11(5)*8324P Y === Y=6时,X 可能取值个数有 352*20C =个,每个的概率为 1/64;15(6)*206416P Y === Y=7时,X 可能取值个数有 362*40C =个,每个的概率为 1/128;15(7)*4012816P Y === 于是有()()log ()1155log16log 32log 64log 648416165.8125H X p x p x =−=+++=∑ ()()log ()11516516log8log 4log log 841651651.924H Y p y p y =−=+++=∑ (|)0H Y X =,因为确定X,Y 就完全确定了。

(|)()(|)()3.889H X Y H X H Y X H Y =+−=2. 和的熵设X ,Y 为两个随机变量,取值分别为{12,,...,r x x x }和{12,,...,s y y y }。

第6章习题参考答案6.6 解:(1)首先求联合概率矩阵111412611164121111264XYP ⎡⎤⎢⎥⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦最大后验概率准则即最小错误概率准则,也等同于最大联合概率准则,因此,从联合概率矩阵的每一列中选联合概率最大的发送符号作为译码输出,因此将112233,,y x y x y x →→→此时正确译码概率为11223313()()()344c p p x y p x y p x y =++=⨯=错误概率为114e c p p =-=(2)当信源等概率分布时,极大似然准则等价于最大后验概率准则,因此从信道矩阵的每一列中取转移概率最大的一个发送符号作为相应接收符号的译码输出,即是最佳译码方案,因此将112233,,y x y x y x →→→此时正确译码概率为112233111()()()(3)322c p p x y p x y p x y =++=⨯⨯=错误概率为112e c p p =-=6.10 解:(1)(;)()()D R I X Y H Y H Y X ==- 设信源的四个消息等概率出现,则有0114p p ==,12e p =[]01101111111424222201qq ⎡⎤⎢⎥⎡⎤⎡⎤⎢⎥==⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦⎢⎥⎣⎦111()()log 2[()(1)2]10.50.5224D R H Y H Y X H H =-=-+⨯=-=bit/符号 (2)按照译码准则译码时,由于后两位始终译为ee ,与发送代码后两位始终相同,故不存在误码;前两位,由于1000→→,1111→→,也不存在译码错误,因此所有码字的错误概率均为0。

或由联合概率矩阵1041188104XYP ⎡⎤⎢⎥⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦ 正确译码的概率为111(00)(11)()1442c p p x y p x y p ee ===+==+=++=(发送e 时始终可以正确译码),因此所有码字的错误概率为0。

2.1 同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求: (1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息; (3) 两个点数中至少有一个是1的自信息量。

2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。

假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量?2.3 掷两颗骰子,当其向上的面的小圆点之和是3时,该消息包含的信息量是多少?当小圆点之和是7时,该消息所包含的信息量又是多少?2.4 从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%,如果你问一位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含多少信息量,平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信息量是多少?2.5黑白气象传真图的消息只有黑色和白色两种,即信源X ={黑,白}。

设黑色出现的概率为P(黑) = 0.3,白色出现的概率为P(白) = 0.7。

假设图上黑白消息出现前后没有关联,求熵H(X);2.6 有两个随机变量X 和Y ,其和为Z = X + Y (一般加法),若X 和Y 相互独立,求证:H(X) ≤ H(Z), H(Y) ≤ H(Z)。

2.7 消息源以概率123451/2,1/4,1/8,1/16,1/16,P P P P P =====发送5种消息符号12345,,,,m m m m m 。

(1) 若每个消息符号出现是独立的,求每个消息符号的信息量。

(2) 求该符号集的平均信息量。

2.8 设离散无记忆信源⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202120130213001203210110321010021032011223210),求 (1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?2.9 汉字电报中每位十进制数字代码的出现概率如题9表所示,求该离散信源的熵。

第三章3.8 证明长为N的D元不等长码至多有D(D N-1)/(D-1)个码字。

证:已知长为N的不等长码D元可得此不等长为D进制,最大长为N所以例:N=2,D=2 {0,1}推出 {0,1,00,01,10,11}……可知码字数量n=D+D2+……D N即为等比数列求和:n=a1(1−q n)1−q =D(1−Dn)1−D=D(Dn−1)D−13.12 信源符号消息X={x1,x2,…x M},信源熵H(X),若对该信源能找到一个平均码长为⎺n=H(X)/log3的三元即时码,证明对每个x i∈X,其概率满足p(x i)=3−n i,式中n i为整数。

证:由题意已知:信源熵H(x)和平均码长,三元即时码设每个信源符号信息x1,x2,x3…x M ,对应的概率q1,q2,q3,q MH(x)=-q1logq1-q2logq2-q3logq3…-q M logq M平均码长:⎺n=q1+2*q2+2*q3+3*q4+…又因为⎺n=H(x)/log3⎺nlog3=( q1+2*q2+2*q3+3*q4+…)log3=-log(1/3)*( q1+2*q2+2*q3+3*q4+…)H(x)=-log(q1q1*q2q2*q3q3*q4q4…)因为H(x)= nlog3 所以-log(q1q1*q2q2*q3q3*q4q4…)=-log13q1+2∗q2+2∗q3+3∗q4+⋯得到:q1=1/3,q2=(1/3)2 ,q3=(1/3)2, q4=(1/3)3…q M=(1/3)ni概率满足P(x i)=3−ni (ni∈Z)3.16 某一信源有M 个消息,并且每个消息等概分布,对该信源进行二元霍夫曼编码,问当M=2i 和M=2i +1(i 为正整数)时,每个码字的长度n i 等于多少?平均码长⎺n 又为多少?答:当M=2i 时,得到等长码,码长为i ; 当M=2i+1时,平均码长为 :⎺n=2i −12i +1*i+22i +1*(i+1)=i+22i +13.17 信源分布[xq(x)]=[x 1x 2x 3x 41/31/31/41/12],(1) 对该信源进行二元霍夫曼编码;(2)证明存在两个不同的最佳码长集合,即证明码长集合{1,2,3,4}和{2,2,2,2}都是最佳的。

第1讲2、信息论创始人是谁?香农。

3、信息和消息、信号有什么联系与区别?从信息理论角度上看,信号是消息的载体,信息含藏在消息之中,有信号有消息不一定有信息。

4、通信系统的主要性能指标是什么? 有效性、可靠性和安全性。

5、举例说明信息论有哪些应用?为信息传送和处理系统提供数学模型和评估方法,在通信和信息处理领域是一门基础理论,在其它领域如语言学、生物学、医学、神经网络、经济学方面的应用也很成功。

具体应用实例有:语音、图像和数据信息的压缩,通信信道有效性和可靠性的提高,或信道传输功率指标要求的降低,通信或计算机系统可靠性和安全性的提高,信息处理领域的信号重建和模式识别等。

2.4 (求车牌自信息量)某车牌号的概率是(1/26)3×(1/10)3,24bit/牌,后一种概率为(1/36)6,31bit/牌, 第2讲设二元对称信道的传递矩阵(条件概率矩阵)为⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡32313132若P(0) = 3/4, P(1) = 1/4,求H(X), H(Y), H(X/Y), H(Y/X)和I(X;Y);先求P(Y)=∑X P(XY)和P(XY)=P(X)P(Y|X),再得各种熵和互信息。

H(X)=H(3/4,1/4), H(Y)=H(7/12,5/12);H(XY)=H(1/2,1/4,1/12,1/6); H(X/Y)=H(XY)-H(Y)H(Y/X)=H(XY)-H(X);或H(Y/X)=∑P(X=a)H(Y/a)=H(3/4,1/4) I(X;Y)=H(X)-H(X/Y)=H(X)+H(Y)-H(XY); 2.2(求条件信息量)1.6米以上女孩是条件,某个1.6米以上的女大学生是概率事件,得条件概率为:P=0.25×0.75/0.5=0.375=3/8,信息量为I= -log0.375=1.42比特。

2.52.10(1)(2)(由联合概率分布求熵、联合熵和条件熵)(1)思路:先求出X 、Y 、Z 、XZ 、YZ 、XYZ 的概率或联合分布,再求其熵。