第 40 卷 Vol.40 ·专栏· 专栏·

第2期 No.2

计 算 机 工 程 Computer Engineering

文章编号: 文章编号:1000—3428(2014)02—0001—05 文献标识码: 文献标识码:A

2014 年 2 月 February 2014

中图分类号: 中图分类号:TP311

基于 MapReduce 的高能物理数据分析系统

臧冬松 1,2,霍 菁 1,2,梁 栋 1,2,孙功星 1

(1. 中国科学院高能物理研究所,北京 100049;2. 中国科学院大学,北京 100049) 摘 要:将 MapReduce 思想引入到高能物理数据分析中,提出一个基于 Hadoop 框架的高能物理数据分析系统。通过建立事例的 TAG 信息数据库,将需要进一步分析的事例数减少 2~3 个数量级,从而减轻 I/O 压力,提高分析作业的效率。利用基于 TAG 信息 的事例预筛选模型以及事例分析的 MapReduce 模型,设计适用于 ROOT 框架的数据拆分、事例读取、结果合并等 MapReduce 类 库。在北京正负电子对撞机实验上进行系统实现后,将其应用于一个 8 节点实验集群上进行测试,结果表明,该系统可使 4×106 个事 例的分析时间缩短 23%,当增加节点个数时,每秒钟能够并发分析的事例数与集群的节点数基本呈正比,说明事例分析集群具有 良好的扩展性。 关键词: 键词:高能物理;大数据;数据分析;MapReduce 模型;集群;分布式计算

High Energy Physics Data Analysis System Based on MapReduce

ZANG Dong-song1,2, HUO Jing1,2, LIANG Dong1,2, SUN Gong-xing1

(1. Institute of High Energy Physics, Chinese Academy of Sciences, Beijing 100049, China; 2. University of Chinese Academy of Sciences, Beijing 100049, China) 【Abstract】This paper brings the idea of MapReduce parallel processing to high energy physics data analysis, proposes a high energy physics data analysis system based on Hadoop framework. It significantly reduces the number of events that need to do further analysis by 2~3 classes by establishing an event TAG information database, which reduces the I/O volume and improves the efficiency of data analysis jobs. It designs proper MapReduce libs that fit for the ROOT framework to do things such as data splitting, event fetching and result merging by using event pre-selection model based on TAG information and MapReduce model of event analysis. A real system is implemented on BESIII experiment, an 8-nodes cluster is used for data analysis system test, the test result shows that the system shortens the data analyzing time by 23% of 4×106 event, and event number of concurrence analysis per second is higher than cluster nodes when adding more worker nodes, which explains that the case analysis cluster has a good scalability. 【Key words】high energy physics; big data; data analysis; MapReduce model; cluster; distributed computing DOI: 10.3969/j.issn.1000-3428.2014.02.001

1

概述

高能物理实验产生了海量数据,位于法国和瑞士边境

支持,成为大数据领域的标准。 目前 Hadoop 在高能物理实验中的全面应用还非常少, 但已经出现了许多探索和部分应用。美国的 7 个 CMS 实验 网格站点采用了 HDFS 作为存储系统[5]; 意大利国家核物理 研究所探索了利用 Hadoop 的 MapReduce 框架分析高能物 理 实 验 数 据 [6] ; 文 献 [7] 探 索 了 在 亚 马 逊 云 计 算 中 采 用 Hadoop 框架进行高能物理数据分析。 本文分析高能物理数据分析的流程和特点,以及高能 物理普遍采用的 ROOT[8]软件及 ROOT 格式文件的 I/O 特 性,给出一种基于 Hadoop 框架的高能物理数据 MapReduce 分析系统,并进行初步的评估。

的大型强子对撞机(Large Hadron Collider, LHC)每年可产生 25 PB 的数据;改造后的北京正负电子对撞机(BEPCII)和北 京谱仪(BESIII)的取数效率和性能大幅提高, 2012 年产生的 数据量超过了过去几年的总和。数据量的不断膨胀促使不 断探索新的数据存储和计算技术。谷歌公司自 2003 年后相 继发表的 GFS 、MapReduce 和 BigTable 引领了互联网

[1] [2] [3]

界大数据处理的技术革新,而随后基于 Google 实现的 Hadoop 开源项目,更是被众多的公司和厂商广泛采用和

[4]

————————————

基金项目: 基金项目:国家自然科学基金资助重点项目(90912004) 作者简介: 作者简介:臧冬松(1981-),男,博士研究生,主研方向:分布式计算,海量数据管理;霍 研究员 收稿日期: 收稿日期:2013-02-20 修回日期: 修回日期:2013-03-20 E-mail:donal.zang@https://www.doczj.com/doc/d117459499.html, 菁、梁 栋,博士研究生;孙功星,

2

计 算 机

工 程

2014 年 2 月 15 日

2

2.1

背景介绍 背景介绍

高能物理数据处理 高能物理数据的处理主要包括数据的重建、分析以及

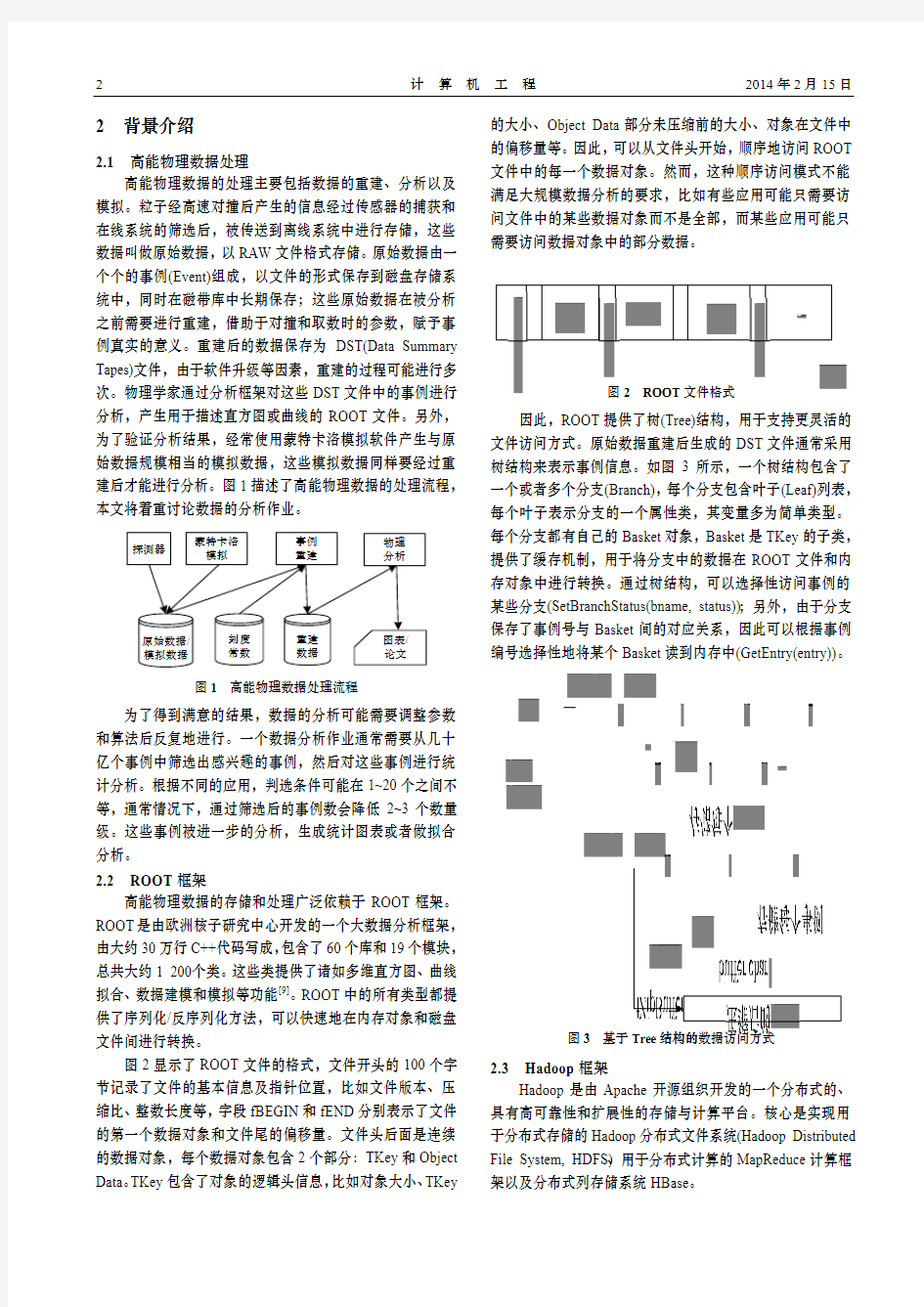

的大小、Object Data 部分未压缩前的大小、对象在文件中 的偏移量等。因此,可以从文件头开始,顺序地访问 ROOT 文件中的每一个数据对象。然而,这种顺序访问模式不能 满足大规模数据分析的要求,比如有些应用可能只需要访 问文件中的某些数据对象而不是全部,而某些应用可能只 需要访问数据对象中的部分数据。

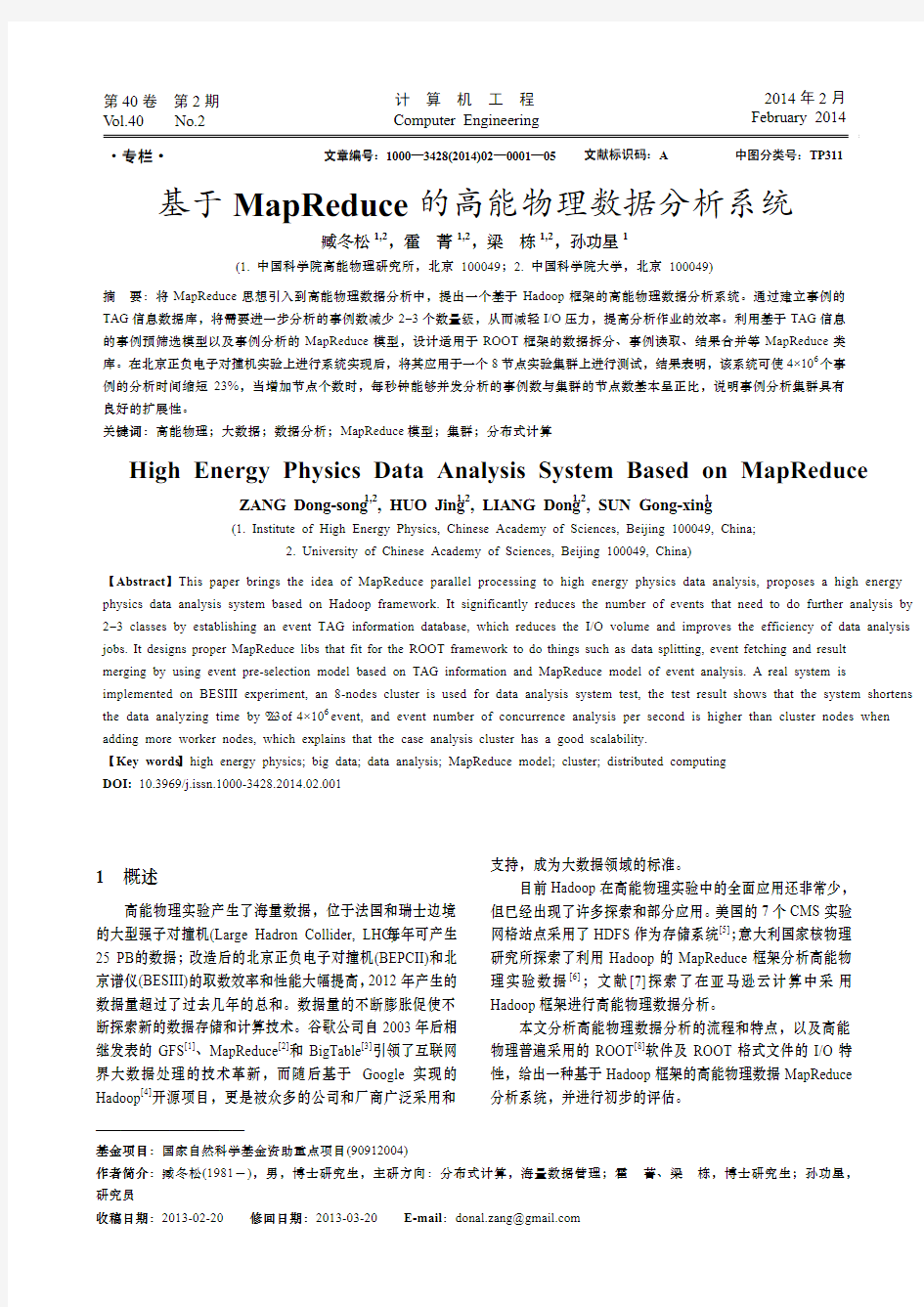

模拟。粒子经高速对撞后产生的信息经过传感器的捕获和 在线系统的筛选后,被传送到离线系统中进行存储,这些 数据叫做原始数据,以 RAW 文件格式存储。原始数据由一 个个的事例(Event)组成,以文件的形式保存到磁盘存储系 统中,同时在磁带库中长期保存;这些原始数据在被分析 之前需要进行重建,借助于对撞和取数时的参数,赋予事 例真实的意义。重建后的数据保存为 DST(Data Summary Tapes)文件,由于软件升级等因素,重建的过程可能进行多 次。物理学家通过分析框架对这些 DST 文件中的事例进行 分析,产生用于描述直方图或曲线的 ROOT 文件。另外, 为了验证分析结果,经常使用蒙特卡洛模拟软件产生与原 始数据规模相当的模拟数据,这些模拟数据同样要经过重 建后才能进行分析。图 1 描述了高能物理数据的处理流程, 本文将着重讨论数据的分析作业。

探测器 蒙特卡洛 模拟 事例 重建 物理 分析

图 2 ROOT 文件格式

因此,ROOT 提供了树(Tree)结构,用于支持更灵活的 文件访问方式。原始数据重建后生成的 DST 文件通常采用 树结构来表示事例信息。如图 3 所示,一个树结构包含了 一个或者多个分支(Branch),每个分支包含叶子(Leaf)列表, 每个叶子表示分支的一个属性类,其变量多为简单类型。 每个分支都有自己的 Basket 对象,Basket 是 TKey 的子类, 提供了缓存机制,用于将分支中的数据在 ROOT 文件和内 存对象中进行转换。通过树结构,可以选择性访问事例的 某些分支(SetBranchStatus(bname, status));另外,由于分支 保存了事例号与 Basket 间的对应关系,因此可以根据事例 编号选择性地将某个 Basket 读到内存中(GetEntry(entry))。

原始数据/ 模拟数据

刻度 常数

重建 数据

图表/ 论文

图 1 高能物理数据处理流程

为了得到满意的结果,数据的分析可能需要调整参数 和算法后反复地进行。一个数据分析作业通常需要从几十 亿个事例中筛选出感兴趣的事例,然后对这些事例进行统 计分析。根据不同的应用,判选条件可能在 1~20 个之间不 等,通常情况下,通过筛选后的事例数会降低 2~3 个数量 级。这些事例被进一步的分析,生成统计图表或者做拟合 分析。 2.2 ROOT 框架 高能物理数据的存储和处理广泛依赖于 ROOT 框架。

ROOT 是由欧洲核子研究中心开发的一个大数据分析框架, 由大约 30 万行 C++代码写成, 包含了 60 个库和 19 个模块, 总共大约 1 200 个类。这些类提供了诸如多维直方图、曲线 拟合、数据建模和模拟等功能[9]。ROOT 中的所有类型都提 供了序列化/反序列化方法,可以快速地在内存对象和磁盘 文件间进行转换。 图 2 显示了 ROOT 文件的格式,文件开头的 100 个字 节记录了文件的基本信息及指针位置,比如文件版本、压 缩比、整数长度等,字段 fBEGIN 和 fEND 分别表示了文件 的第一个数据对象和文件尾的偏移量。文件头后面是连续 的数据对象,每个数据对象包含 2 个部分:TKey 和 Object Data。 TKey 包含了对象的逻辑头信息, 比如对象大小、 TKey 2.3

图 3 基于 Tree 结构的 结构的数据访问方式

Hadoop 框架 Hadoop 是由 Apache 开源组织开发的一个分布式的、

具有高可靠性和扩展性的存储与计算平台。核心是实现用 于分布式存储的 Hadoop 分布式文件系统(Hadoop Distributed File System, HDFS)、用于分布式计算的 MapReduce 计算框 架以及分布式列存储系统 HBase。

第 40 卷 第 2 期

臧冬松,霍

菁,梁 栋,等:基于 MapReduce 的高能物理数据分析系统

3

HDFS 由一个名字节点(NameNode)和众多从节点数据 节点(DataNode)组成。数据被分块存储于各个数据节点上, 通过多个副本提高系统的可靠性。名字节点中存储了数据 块的位置等信息,数据的实际读写操作被分散到各个数据 节点上[10]。 MapReduce 框架由一个主节点(JobTracker)和多个工作 节点(TaskTracker)组成。主节点负责作业的拆分和调度,协 调 Map 和 Reduce 任务的执行,提供作业进度信息。工作节 点负责任务的具体执行,包括输入数据的读取, Map 和 Reduce 任务的执行,中间结果的获取、排序、合并等。 HBase[11]是运行于 HDFS 之上的分布式数据库, 具有很 好的扩展性,能够支持非常大的表(十亿行×百万列)。其组 成 包 括 主 服 务 器 (Master Server) 和 区 域 服 务 器 (Region Server) ,一个表的数据按照行关键字排序,并被分割到不 同的分区,这些分区被主服务器按照负载均衡策略分配给 各个区域服务器存储。

图 5 TAG 信息生成的 信息生成的 MapReduce 模型

基于 TAG 信息的事例预筛选模型如图 6 所示, TAG 表 中的行被拆分后并行地进行事例筛选,并将符合用户程序 逻辑的事例号写入指定的表中进行存储。

3

数据分析的 数据分析的 MapReduce 模型

在原有的分析模型中,所有的 DST 事例被读入内存,

图 6 基于 TAG 信息的事例预筛选模型

经过解压和反序列化后生成内存对象传递给用户的程序, 而用户程序中会首先过滤掉大部分的事例,这造成了计算 和 I/O 资源的极大浪费。 3.1 事例筛选 为了加快事例筛选的速度,减少 I/O 和计算资源消耗, 3.2

事例分析 事例分析作业的拆分要同时考虑 DST 数据位置和预筛

选事例个数,如图 7 所示,Map 任务按照事例号从 DST 文 件中读取完整的事例信息,生成内存对象并调用用户程序 进行分析, 生成的本地结果被 Reduce 任务获取并进行合并, 生成最终结果。

引入 TAG 数据的概念。 TAG 数据包括了事例的一些简单属 性( 比如带电轨迹数、光子数等) 以及事例在 RAW 文件和 DST 文件中的指针(事例号),RAW 文件、DST 文件、TAG 数据间的关系如图 4 所示(其中,黑色和灰色底纹分别表示 事例在 RAW 文件和 DST 文件中的索引,即在文件中的偏 移量)。每个事例的 TAG 信息通常只有原事例大小的 1%, 通过 TAG 数据,可以对事例进行快速的预筛选以及简单的 统计分析,同时又不会增加太多的存储需求。

图 7 事例分析的 事例分析的 MapReduce 模型

4

系统实现

系统实现基于 Hadoop1.0、HBase0.90.6 和 ROOT5.32,

系统总体框架如图 8 所示。系统服务层提供了文件存储、 作业管理和数据库服务。每个 DST 文件作为一个单独的数 据块保存在 HDFS 中,这主要为了提高任务的数据本地化 比例; AFS[12]系统为用户的统一认证和 ID 映射提供了方便,

图 4 RAW 文件、 文件、DST 文件、 文件、TAG 数据间的关系

同时为用户提供了轻量级的个人空间,以及方便用户为自 己的作业设置环境变量。Hadoop MapReduce 框架提供了资 源管理和任务调度,调度策略基于 Yahoo 提供的 CapacityTaskScheduler[13],建立多任务队列。任务的执行需要解决 Map 和 Reduce 任务之间的协调和高效数据传递以及 C++程 序在 MapReduce 框架下的执行问题。应用软件框架层提供

TAG 信息采用 HBase 作为存储,其生成模型如图 5 所 示,Mapper 是基于 ROOT 的 C++程序,读取 DST 数据后 产生 TAG 信息写入本地缓存,然后写入 HBase 的 TAG 表中。

4

计 算 机

工 程

2014 年 2 月 15 日

了应用系统层所依赖的开发框架和程序库。例如事例读取 (RootRecordReader)和输出(RootRecordWriter)依赖于 ROOT 框架,CLHEP[14]框架提供了高能物理中经常使用的基础和 功能类库。HBase 的 Thrift 接口及 MapReduce 库为 TAG 数 据的生成和并行筛选提供了方便。另外,系统提供了 CLI 和 Web 形式的用户接口;集群的用户认证和权限管理与 AFS 文件系统进行集成;机器的管理和监控采用 Puppet[15] 和 Ganglia

[16]

4.2

事例分析子系统 Hadoop 提供了 2 种在 MapReduce 框架中运行 C++任务

的方法:Streaming[17]和 Pipes[18]。其基本思路是启动一个单 独的进程运行用户的 C++Map/Reduce 程序,Map 的输出和 Reduce 的输入均通过标准输入输出和管道(Socket)在 Java 进程和 C++进程间传递。本文系统参考了 HCE[19]机制,如 图 10 所示,在 Map 端,C++进程接收 Java 虚拟机传输过 来的文件名, 调用 ROOT 框架及用户程序对文件进行处理, 报告任务进程和计数器信息。任务的输出经过序列化后以 IFile 格式(<关键字长度, 关键字, 值长度, 值>)写入本地文 件。在 Reduce 端,Java JVM 负责从所有 Map 任务的输出 中获取属于该 Reduce 任务的数据, 经过排序合并后以 IFile 格式保存到本地磁盘,然后 C++进程对 IFile 文件中的记录 进行反序列化后,交给用户的 Reduce 程序处理。

Hadoop分布式 文件系统

。应用系统主要实现了 2 个部分:TAG 数据管

理系统和事例分析系统。

MapRunner

HttpServer 4

OutputCommitter copy/sor/merge ReduceRunner 7

Java C++

split 1

report

2

RootRecordReader

RootRecordWriter 5 Committer Reducer 6 ReduceInputReader Root Deserializer IFileReader

图 8 高能物理数据分析系统框架

4.1

TAG 数据管理系统 TAG 数据管理系统主要提供如下功能: (1)TAG 数据的生成及更新; (2)基于 TAG 数据的事例号筛选及更新; (3)统计类查询,查询符合条件的事例数。 TAG 表结构包括行关键字(Row Key)和列簇(Columns)

OutputCollector Root Serializer IFileWriter 3

Mapper

LocalFS LocalFS file.out file.out.index 输入输出 数据流

map_TaskId.out C++进程与Java 进程间通信 Map和Reduce任务 中间数据

2 个部分。行关键字唯一确定了一个事例,HBase 会根据行 关键字将事例排序并分散到各个区域服务器上去;列簇包 含任意数量的<列名:列值>对。图 9 显示了 TAG 表内容示 例,行关键字的结构定义为“日期:文件名:事例编号” , 这样的设计既可以根据行关键字定位到事例,又可以根据 日期和 run 号进行范围查询和统计。

图 10 事例分析系统 事例分析系统

5

系统评估

系统评估采用 BESIII 实验的真实数据作为分析对象,

测试程序采用 BESIII 离线软件中的 Rhopi 事例分析程序, 每个测试节点的配置为:8×2.4 GHz CPU,24 GB 内存,千 兆以太网卡。 图 11 为在单个节点上分析 4×106 个事例所用的时间, 经过刷选后的事例数为 218 198 ,减少约 95%((4×106 - ,事例分析时间减少约 23%((3 126.92 - 218 198)/4×106 ) 2 393.91)/3 126.92)。时间的减少与事例数的减少比例存在 差距的主要原因是 DST 文件的读写是以 Basket 为单位的, 因此当每个 Basket 中包含的事例数较大(>5 000 个)时, 95% 的事例数减少并不能明显降低数据的读取时间。解决这个 问题的一种方法是减少每个 Basket 中的事例数;另一种方 法是如果事例的分析时间远大于数据读取时间,则通过预

图 9 TAG 表的内容示例

筛选而减少的事例分析时间效果将会更明显。

第 40 卷 第 2 期

3 500

臧冬松,霍

菁,梁 栋,等:基于 MapReduce 的高能物理数据分析系统

5

3 126.92 3 000 2 500 时间/s 2 000 1 500 1 000 500 497.246 0 1 2 事例数/106 3 685.424 1 451.19 1 083.44 1 684.7 无预筛选 有预筛选 4 2 233.63 2 393.91

Operating Systems Design & Implementation. San Francisco, USA: ACM Press, 2004: 107-113. [3] Chang F, Dean J, Ghemawat S, et al. Bigtable: A Distributed Storage System for Structured Data[J]. ACM Transactions on Computer Systems, 2008, 26(2): 205-218. [4] Apache. HADOOP[EB/OL]. (2012-05-01). http://HADOOP. https://www.doczj.com/doc/d117459499.html,. [5] Bradley D, Dasu S, Maier W, et al. A Highly Distributed, Petascale Migration from dCache to HDFS[C]//Proc. of HEPiX Fall 2011 Workshop. Vancouver, USA: [s. n.], 2011: 124. [6] Riahi H, Donvito G, Fanò L. Using HADOOP File System and MapReduce in a Small/Medium Grid Site[J]. Journal of Physics: Conference Series, 2012, 396(4): 50-55. [7] Glaser F, Neukirchen H. Analysing High-energy Physics Data Using the MapReduce Paradigm in a Cloud Computing Environment[EB/OL]. (2012-05-11). https://notendur.hi.is/~ helmut/publications/VHI-01-2012.pdf. [8] The ROOT Team. ROOT[EB/OL]. (2010-04-12). http://root. cern.ch. [9] Antcheva I, Ballintijn M, Bellenot, et al. ROOT——A C++ Framework for Petabyte Data Storage, Statistical Analysis and Visualization[J]. Computer Physics Communications, 2009, 180(12): 1384-1385. [10] Apache Hadoop HDFS Architecture Guide[EB/OL]. (2012-03-

图 11 无预筛选和有预筛选的事例分析时间

为了测试 Hadoop 集群的并行效率,对 39 个、361 个、 594 个事例(159 GB)在不同工作节点数(每个工作节点运行 8 个进程)下进行并行分析,如图 12 所示,Hadoop 集群的 并行加速效果非常理想,甚至超过了工作节点的增加倍数, 这主要是因为工作节点增加时,更多的任务被调度到数据 所在的节点上运行,从而节省了 I/O 时间。

图 12 Hadoop 集群的并行加速效果

22). https://www.doczj.com/doc/d117459499.html,/docs/r1.0.4/hdfs_design.html. [11] Apache. Hbase[EB/OL]. (2012-06-12). http://hbase.apache. org/. [12] OpenAFS[EB/OL]. (2012-04-15). https://www.doczj.com/doc/d117459499.html,/. [13] Apache Hadoop. Capacity Scheduler Guide[EB/OL]. (201302-15). https://www.doczj.com/doc/d117459499.html,/stable/capacity_scheduler. html. [14] CLHEP——A Class Library for High Energy Physics[EB/OL]. (2011-11-10). http://proj-clhep.web.cern.ch/proj-clhep/. [15] Puppet Labs. What is Puppet?[EB/OL]. (2013-02-15). http:// https://www.doczj.com/doc/d117459499.html,/puppet/what-is-puppet/. [16] IBM. Ganglia Monitoring System[EB/OL]. (2013-02-15). https://www.doczj.com/doc/d117459499.html,/. [17] Apache. HADOOP Streaming[EB/OL]. (2013-02-15). http:// https://www.doczj.com/doc/d117459499.html,/docs/stable/streaming.html. [18] White T. HADOOP: The Definitive Guide[M]. [S. l.]: O’Reilly Media, Inc., 2009. [19] Baidu. HADOOP C++ Extension[EB/OL]. (2013-02-15). https://https://www.doczj.com/doc/d117459499.html,/jira/browse/MAPREDUCE-1270. 编辑 陆燕菲

6

结束语

MapReduce 并行计算思想在互联网和科研领域得到了

越来越广泛的应用,高能物理等科研应用由于其复杂性、 软件栈庞大以及历史原因,在 MapReduce 的应用中遇到一 些问题。本文在深入分析高能物理数据处理特点后,给出 一个基于 MapReduce 的高能物理数据分析系统,建立了事 例并行分析模型并进行了系统实现。初步评估显示事例预 筛选提高了分析程序的效率,事例分析流程可以高度并行 化。而 MapReduce 在高能物理数据处理中还有很多需要研 究和改进之处, 比如适合 MapReduce 模型的事例存储方式、 HDFS 随机写问题、 广域网上的多集群管理以及重建作业和 模拟作业在 MapReduce 框架下的运行等。

参考文献 [1] Ghemawat S, Gobioff H. The Google File System[C]//Proc. of the 19th ACM Symposium on Operating Systems Principles. New York, USA: ACM Press, 2003: 29-43. [2] Dean J, Ghemawat S. MapReduce: Simplified Data Processing on Large Clusters[C]//Proc. of the 6th Symposium on

MapReduce海量数据并行处理 复习大纲 Ch. 1. 并行计算技术简介 1.为什么需要并行计算? 提高计算机性能有哪些基本技术手段 提高字长,流水线微体系结构技术,提高集成度,提升主频 迫切需要发展并行计算技术的主要原因 1)单处理器性能提升达到极限 2)爆炸性增长的大规模数据量 2)超大的计算量/计算复杂度 2.并行计算技术的分类 有哪些主要的并行计算分类方法? 1)按数据和指令处理结构:弗林(Flynn)分类 2)按并行类型

3)按存储访问构架 4)按系统类型 5)按计算特征 6)按并行程序设计模型/方法 1)按数据和指令处理结构:弗林(Flynn)分类 SISD:单指令单数据流 传统的单处理器串行处理 SIMD:单指令多数据流 向量机,信号处理系统 MISD:多指令单数据流 很少使用 MIMD:多指令多数据流 最常用,TOP500高性能计算机 基本都属于MIMD类型 2)按并行类型分类 位级并行(Bit-Level Parallelism) 指令级并行(ILP:Instruction-Level Parallelism) 线程级并行(Thread-Level Parallelism) 数据级并行:一个大的数据块划分为小块,分别由不同的处理器/线程处理 任务级并行:一个大的计算任务划分为子任务分别由不同的处理器/线程来处理 3)按存储访问结构分类 A.共享内存(Shared Memory) 所有处理器通过总线共享内存 多核处理器,SMP……

也称为UMA结构(Uniform Memory Access) B. 分布共享存储体系结构 各个处理器有本地存储器 同时再共享一个全局的存储器 C. 分布式内存(Distributed Memory) 各个处理器使用本地独立的存储器 B和C也统称为NUMA结构 (Non-Uniform Memory Access) 4)按系统类型分类 多核/众核并行计算系统MC(Multicore/Manycore) 或Chip-level multiprocessing, CMP 对称多处理系统SMP(Symmetric Multiprocessing) 多个相同类型处理器通过总线连接并共享存储器 大规模并行处理MPP(Massive Parallel Processing) 专用内联网连接一组处理器形成的一个计算系统 集群(Cluster) 网络连接的一组商品计算机构成的计算系统 网格(Grid) 用网络连接远距离分布的一组异构计算机构成的计算系统 5)按并行程序设计模型/方法分类 共享内存变量(Shared Memory Variables) 消息传递方式(Message Passing) MapReduce方式

数据分析与可视化 1.什么是数据分析? 数据分析是基于商业目的,有目的的进行收集、整理、加工和分析数据,提炼有价信息的一个过程。其过程概括起来主要包括:明确分析目的与框架、数据收集、数据处理、数据分析、数据展现和撰写报告等6个阶段。 1、明确分析目的与框架 一个分析项目,你的数据对象是谁?商业目的是什么?要解决什么业务问题?数据分析师对这些都要了然于心。基于商业的理解,整理分析框架和分析思路。例如,减少新客户的流失、优化活动效果、提高客户响应率等等。不同的项目对数据的要求,使用的分析手段也是不一样的。 2、数据收集 数据收集是按照确定的数据分析和框架内容,有目的的收集、整合相关数据的一个过程,它是数据分析的一个基础。 3、数据处理 数据处理是指对收集到的数据进行加工、整理,以便开展数据分析,它是数据分析前必不可少的阶段。这个过程是数据分析整个过程中最占据时间的,也在一定程度上取决于数据仓库的搭建和数据质量的保证。 数据处理主要包括数据清洗、数据转化等处理方法。 4、数据分析 数据分析是指通过分析手段、方法和技巧对准备好的数据进行探索、分析,从中发现因果关系、内部联系和业务规律,为商业目提供决策参考。 到了这个阶段,要能驾驭数据、开展数据分析,就要涉及到工具和方法的使用。其一要熟悉常规数据分析方法,最基本的要了解例如方差、回归、因子、聚类、分类、时间序列等多元和数据分析方法的原理、使用范围、优缺点和结果的解释;其二是熟悉1+1种数据分析工具,Excel是最常见,一般的数据分析我们可以通过Excel完成,后而要熟悉一个专业的分析软件,如数据分析工具SPSS/SAS/R/Matlab等,便于进行一些专业的统计分析、数据建模等。 5、数据展现 一般情况下,数据分析的结果都是通过图、表的方式来呈现,俗话说:字不如表,表不如图。借助数据展现手段,能更直观的让数据分析师表述想要呈现的信息、观点和建议。 常用的图表包括饼图、折线图、柱形图/条形图、散点图、雷达图等、金字塔图、矩阵图、漏斗图、帕雷托图等。 6、撰写报告 最后阶段,就是撰写数据分析报告,这是对整个数据分析成果的一个呈现。通过分析报

50个大数据可视化分析工具 在大数据时代,数据可视化工具必须具有以下特性: (1)实时性:数据可视化工具必须适应大数据时代数据量的爆炸式增长需求,必须快速的收集分析数据、并对数据信息进行实时更新; (2)简单操作:数据可视化工具满足快速开发、易于操作的特性,能满足互联网时代信息多变的特点; (3)更丰富的展现:数据可视化工具需具有更丰富的展现方式,能充分满足数据展现的多维度要求; (4)多种数据集成支持方式:数据的来源不仅仅局限于数据库,数据可视化工具将支持团队协作数据、数据仓库、文本等多种方式,并能够通过互联网进行展现。 Excel 是快速分析数据的理想工具,也能创建供内部使用的数据图,但在颜色、线条和样式上可选择的范围有限。 Google Charts 提供了大量现成的图表类型,从简单的线图表到复杂的分层树地图等,还内置了动画和用户交互控制。 D3 能够提供大量线性图和条形图之外的复杂图表样式,例如V oronoi图、树形图、圆形集群和单词云等。 R语言 是主要用于统计分析、绘图的语言和操作环境。 Visual.ly 如果你需要制作信息图而不仅仅是数据可视化,Visual.ly是最流行的一个选择。

Processing 是数据可视化的招牌工具,只需要编写一些简单的代码,然后编译成Java,可在几乎所有平台上运行。 Leaflet 用来开发移动友好地交互地图。 OpenLayers 对于一些特定的任务来说,能够提供一些其他地图库都没有的特殊工具。 Polymaps 是一个地图库,主要面向数据可视化用户。可以将符号字体与字体整合,创建出漂亮的矢量化图标。 Gephi 是一个可视化的网络探索平台,用于构建动态的、分层的数据图表。 可以用CartoDB很轻易就把表格数据和地图关联起来。 Weka是数据分析的强大工具,还能生成一些简单的图表。 NodeBox是OS X上创建二维图形和可视化的应用程序。 Kartograph不需要任何地图提供者像Google Maps,用来建立互动式地图。 Modest Maps在一些扩展库的配合下,例如Wax,Modest Maps立刻会变成一个强大的地图工具。 Tangle是个用来探索、Play和查看文档更新的交互式库。既是图表,又是互动图形用户界面的小程序。当你调整一个图表中的输入范围时,其他关联图表的数据也会随之改变。 Rapha憀与其他库最大的不同是输出格式仅限SVG和VML。 jsDraw2DX用来创建任意类型的SVG交互式图形,可生成包括线、举行、多边形、椭圆、弧线等等图形。 Pizza Pie Charts是个响应式饼图图表。 FusionCharts XT是一款跨平台、跨浏览器的JavaScript图表组件,可提供令人愉悦的JavaScript图表体验。 iCharts有交互元素,可以从Google Doc、Excel 表单和其他来源中获取数据。

大数据可视化设计 2015-09-16 15:40 大数据可视化是个热门话题,在信息安全领域,也由于很多企业希望将大数据转化为信息可视化呈现的各种形式,以便获得更深的洞察力、更好的决策力以及更强的自动化处理能力,数据可视化已经成为网络安全技术的一个重要趋势。 一、什么是网络安全可视化 攻击从哪里开始?目的是哪里?哪些地方遭受的攻击最频繁……通过大数据网络安全可视化图,我们可以在几秒钟内回答这些问题,这就是可视化带给我们的效率。大数据网络安全的可视化不仅能让我们更容易地感知网络数据信息,快速识别风险,还能对事件进行分类,甚至对攻击趋势做出预测。可是,该怎么做呢? 1.1 故事+数据+设计 =可视化 做可视化之前,最好从一个问题开始,你为什么要做可视化,希望从中了解什么?是否在找周期性的模式?或者多个变量之间的联系?异常值?空间关系?比如政府机构,想了解全国各个行业的分布概况,以及哪个行业、哪个地区的数量最多;又如企业,想了解内部的访问情况,是否存在恶意行为,或者企业的资产情况怎么样。总之,要弄清楚你进行可视化设计的目的是什么,你想讲什么样的故事,以及你打算跟谁讲。 有了故事,还需要找到数据,并且具有对数据进行处理的能力,图1是一个可视化参考模型,它反映的是一系列的数据的转换过程: 我们有原始数据,通过对原始数据进行标准化、结构化的处理,把它们整理成数据表。将这些数值转换成视觉结构(包括形状、位置、尺寸、值、方向、色彩、纹理等),通过视觉的方式把它表现出来。例如将高中低的风险转换成红黄蓝等色彩,数值转换成大小。将视觉结构进行组合,把它转换成图形传递给用户,用户通过人机交互的方式进行反向转换,去更好地了解数据背后有什么问题和规律。 最后,我们还得选择一些好的可视化的方法。比如要了解关系,建议选择网状的图,或者通过距离,关系近的距离近,关系远的距离也远。 总之,有个好的故事,并且有大量的数据进行处理,加上一些设计的方法,就构成了可视化。 1.2 可视化设计流程

硕士研究生实践报告 题目 作者姓名 作者学号 指导教师 学科专业 所在学院 提交日期 一题目要求 我们的项目背景是,可穿戴设备的实时数据分析。1.txt记录的是某一个用户的心跳周期数据,每一个数值表示一次心跳的周期,单位是秒。例如,0.8表示用户当时的心跳间隙是0.8秒。心跳间期按照顺序存储。 1.利用Hadoop的MapReduce框架编写程序,计算出总测量时间和平均心跳间期,即求和 与求平均。请写出程序,并在实验报告中简单描述你的思路。 2.探索Spark的Transformation中的mapPartition,写出示例程序,并思考何时会用到 mapPartition,为什么要用它? 3.探索Spark的Transformation中的flatMap,写出示例程序,并思考何时会用到它,为什 么要用到它。 4.(选做)SD1和SD2是表征心率变异性的一种指标。结合发给你们的论文,用Java或 者Scala实现SD1和SD2的计算(不用考虑并行化,普通的Java或Scala程序即可)。(选做)假设我们同时监控100个用户的心率,是否能够利用Spark的RDD的特性,并行地计算SD1和SD2?(提示:把每一个用户的心率数据作为RDD里面的一个元素,RDD中不同的元素表示不同用户的心率数据,利用map对每一个用户的心率数据进行并行分析)。请描述设计思路,并尽可能实现一个多用户心率监控的计算程序。 二题目实现 第一题: 本题就是利用Hadoop的MapReduce框架编写程序,计算出总测量时间和平均心跳间期,即求和与求平均,程序代码如下: package ; import ; import ; import ; import ;

大数据可视化分析平台 一、背景与目标 基于邳州市电子政务建设的基础支撑环境,以基础信息资源库(人口库、法人库、宏观经济、地理库)为基础,建设融合业务展示系统,提供综合信息查询展示、信息简报呈现、数据分析、数据开放等资源服务应用。实现市府领导及相关委办的融合数据资源视角,实现数据信息资源融合服务与创新服务,通过系统达到及时了解本市发展的综合情况,及时掌握发展动态,为政策拟定提供依据。 充分运用云计算、大数据等信息技术,建设融合分析平台、展示平台,整合现有数据资源,结合政务大数据的分析能力与业务编排展示能力,以人口、法人、地理,人口与地理,法人与地理,实现基础展示与分析,融合公安、交通、工业、教育、旅游等重点行业的数据综合分析,为城市管理、产业升级、民生保障提供有效支撑。 二、政务大数据平台 1、数据采集和交换需求:通过对各个委办局的指定业务数据进行汇聚,将分散的数据进行物理集中和整合管理,为实现对数据的分析提供数据支撑。将为跨机构的各类业务系统之间的业务协同,提供统一和集中的数据交互共享服务。包括数据交换、共享和ETL等功能。 2、海量数据存储管理需求:大数据平台从各个委办局的业务系统里抽取的数据量巨大,数据类型繁杂,数据需要持久化的存储和访问。不论是结构化数据、半结构化数据,还是非结构化数据,经过数据存储引擎进行建模后,持久化保存在存储系统上。存储系统要具备

高可靠性、快速查询能力。 3、数据计算分析需求:包括海量数据的离线计算能力、高效即席数据查询需求和低时延的实时计算能力。随着数据量的不断增加,需要数据平台具备线性扩展能力和强大的分析能力,支撑不断增长的数据量,满足未来政务各类业务工作的发展需要,确保业务系统的不间断且有效地工作。 4、数据关联集中需求:对集中存储在数据管理平台的数据,通过正确的技术手段将这些离散的数据进行数据关联,即:通过分析数据间的业务关系,建立关键数据之间的关联关系,将离散的数据串联起来形成能表达更多含义信息集合,以形成基础库、业务库、知识库等数据集。 5、应用开发需求:依靠集中数据集,快速开发创新应用,支撑实际分析业务需要。 6、大数据分析挖掘需求:通过对海量的政务业务大数据进行分析与挖掘,辅助政务决策,提供资源配置分析优化等辅助决策功能, 促进民生的发展。

一MapReduce概述 Map/Reduce是一个用于大规模数据处理的分布式计算模型,它最初是由Google工程师设计并实现的,Google已经将它完整的MapReduce论文公开发布了。其中对它的定义是,Map/Reduce是一个编程模型(programming model),是一个用于处理和生成大规模数据集(processing and generating large data sets)的相关的实现。用户定义一个map函数来处理一个key/value对以生成一批中间的key/value对,再定义一个reduce函数将所有这些中间的有着相同key的values合并起来。很多现实世界中的任务都可用这个模型来表达。 二MapReduce工作原理 1 Map-Reduce Map-Reduce框架的运作完全基于

云计算大数据的55个最实用 可视化分析工具 近年来,随着云和大数据时代的来临,数据可视化产品已经不再满足于使用传统的数据可视化工具来对数据仓库中的数据抽取、归纳并简单的展现。传统的数据可视化工具仅仅将数据加以组合,通过不同的展现方式提供给用户,用于发现数据之间的关联信息。新型的数据可视化产品必须满足互联网爆发的大数据需求,必须快速的收集、筛选、分析、归纳、展现决策者所需要的信息,并根据新增的数据进行实时更新。因此,在大数据时代,数据可视化工具必须具有以下特性: (1)实时性:数据可视化工具必须适应大数据时代数据量的爆炸式增长需求,必须快速的收集分析数据、并对数据信息进行实时更新; (2)简单操作:数据可视化工具满足快速开发、易于操作的特性,能满足互联网时代信息多变的特点; (3)更丰富的展现:数据可视化工具需具有更丰富的展现方式,能充分满足数据展现的多维度要求; (4)多种数据集成支持方式:数据的来源不仅仅局限于数据库,数据可视化工具将支持团队协作数据、数据仓库、文本等多种方式,并能够通过互联网进行展现。

为了进一步让大家了解如何选择适合的数据可视化产品,本文将围绕这一话题展开,希望能对正在选型中的企业有所帮助。下面就来看看全球备受欢迎的的可视化工具都有哪些吧! 1.Excel Excel作为一个入门级工具,是快速分析数据的理想工具,也能创建供内部使用的数据图,但是Excel在颜色、线条和样式上课选择的范围有限,这也意味着用Excel很难制作出能符合专业出版物和网站需要的数据图。 2.Google Chart API Google Chart提供了一种非常完美的方式来可视化数据,提供了大量现成的图标类型,从简单的线图表到复杂的分层树地图等。它还内置了动画和用户交互控制。 3.D3 D3(Data Driven Documents)是支持SVG渲染的另一种JavaScript库。但是D3能够提供大量线性图和条形图之外的复杂图表样式,例如Voronoi图、树形图、圆形集群和单词云等。 4.R

数据分析与可视化 1?什么是数据分析? 数据分析是基于商业目的,有目的的进行收集、整理、加工和分析数据,提炼有价信息的一个过程。其过程概括起来主要包括:明确分析目的与框架、数据收集、数据处理、数据分析、数据展现和撰写报告等 6个阶段。 1、明确分析目的与框架 一个分析项目,你的数据对象是谁?商业目的是什么?要解决什么业务问题?数据分 析师对这些都要了然于心。基于商业的理解,整理分析框架和分析思路。例如,减少新客户 的流失、优化活动效果、提高客户响应率等等。不同的项目对数据的要求,使用的分析手段 也是不一样的。 2、数据收集 数据收集是按照确定的数据分析和框架容,有目的的收集、整合相关数据的一个过程,它是数据分析的一个基础。 3、数据处理 数据处理是指对收集到的数据进行加工、整理,以便开展数据分析,它是数据分析前 必不可少的阶段。这个过程是数据分析整个过程中最占据时间的,也在一定程度上取决于数 据仓库的搭建和数据质量的保证。 数据处理主要包括数据清洗、数据转化等处理方法。 4、数据分析 数据分析是指通过分析手段、方法和技巧对准备好的数据进行探索、分析,从中发现因果关系、部联系和业务规律,为商业目提供决策参考。 到了这个阶段,要能驾驭数据、开展数据分析,就要涉及到工具和方法的使用。其一要熟悉常规数据分析方法,最基本的要了解例如方差、回归、因子、聚类、分类、时间序列等多元和数据分析方法的原理、 使用围、优缺点和结果的解释;其二是熟悉1 + 1种数据分析 工具,Excel是最常见,一般的数据分析我们可以通过Excel完成,后而要熟悉一个专业的 分析软件,如数据分析工具SPSS/SAS/R/Matlab等,便于进行一些专业的统计分析、数据建 模等。 5、数据展现 一般情况下,数据分析的结果都是通过图、表的方式来呈现,俗话说:字不如表,表不如图。借助数据展现手段,能更直观的让数据分析师表述想要呈现的信息、观点和建议。

MapReduce理论篇 2.1 Writable序列化 序列化就是把内存中的对象,转换成字节序列(或其他数据传输协议)以便于存储(持久化)和网络传输。 反序列化就是将收到字节序列(或其他数据传输协议)或者是硬盘的持久化数据,转换成内存中的对象。 Java的序列化是一个重量级序列化框架(Serializable),一个对象被序列化后,会附带很多额外的信息(各种校验信息,header,继承体系等),不便于在网络中高效传输。所以,hadoop自己开发了一套序列化机制(Writable),精简、高效。 2.1.1 常用数据序列化类型 常用的数据类型对应的hadoop数据序列化类型 2.1.2 自定义bean对象实现序列化接口 1)自定义bean对象要想序列化传输,必须实现序列化接口,需要注意以下7项。 (1)必须实现Writable接口 (2)反序列化时,需要反射调用空参构造函数,所以必须有空参构造 (3)重写序列化方法 (4)重写反序列化方法 (5)注意反序列化的顺序和序列化的顺序完全一致 (6)要想把结果显示在文件中,需要重写toString(),且用”\t”分开,方便后续用 (7)如果需要将自定义的bean放在key中传输,则还需要实现comparable接口,因为

mapreduce框中的shuffle过程一定会对key进行排序

详见3.2.1统计每一个手机号耗费的总上行流量、下行流量、总流量(序列化)。 2.2 InputFormat数据切片机制 2.2.1 FileInputFormat切片机制 1)job提交流程源码详解 waitForCompletion() submit(); // 1建立连接 connect(); // 1)创建提交job的代理 new Cluster(getConfiguration()); // (1)判断是本地yarn还是远程 initialize(jobTrackAddr, conf); // 2 提交job submitter.submitJobInternal(Job.this, cluster) // 1)创建给集群提交数据的Stag路径 Path jobStagingArea = JobSubmissionFiles.getStagingDir(cluster, conf); // 2)获取jobid ,并创建job路径 JobID jobId = submitClient.getNewJobID(); // 3)拷贝jar包到集群 copyAndConfigureFiles(job, submitJobDir); rUploader.uploadFiles(job, jobSubmitDir); // 4)计算切片,生成切片规划文件

大数据可视化和分析工具 大数据将为社会带来三方面变革:思维变革、商业变革、管理变革,各行业将大数据纳入企业日常配置已成必然之势。学习大数据的热潮也是风起云涌,千锋大数据全面推出新大纲,重磅来袭,今天千锋小编分享的是大数据可视化和分析工具。 1、Excel2016 Excel作为一个入门级工具,是快速分析数据的理想工具,也能创建供内部使用的数据图,同时,它也支持3D的可视化展示,微软发布了一款叫做GeoFlow 的插件,它是结合Excel和Bing地图所开发出来的3D数据可视化工具,可以直接通过Bing地图引擎生成可视化3D地图。但是Excel在颜色、线条和样式上课选择的范围有限,这也意味着用Excel很难制作出能符合专业出版物和网站需要的数据图。 2、SPSS 22 SPSS 22版本有强大的统计图制作功能,它不但可以绘制各种常用的统计图乃至复杂的3D视图,而且能够由制作者自定义颜色,线条,文字等,使制图变得丰富多彩,善心悦目。 3、R语言 R具有强大的统计计算功能和便捷的数据可视化系统。ggplot2是一个用来绘制统计图形的R软件包。ggplot2是由其背后的一套图形语法所支持的,它可以绘制出很多美观的图形,同时能避免诸多繁琐的细节。ggplot2采用了图层的设计方式,你可以从原始的图层开始,首先绘制原始数据,然后不断地添加图形注释和统计汇总的结果。

4、Tableau Public Tableau不仅可以制作图表、图形还可以绘制地图,用户可以直接将数据拖拽到系统中,不仅支持个人访问,还可以进行团队协作同步完成数据图表绘制。 5、Google Charts Google Charts提供大量数据可视化格式,从简单的散点图到分层树地图。可视化效果是完全个性化的,你可以通过动态数据进行实时连接。Google Charts可以兼容多个浏览器以及在多个平台可使用(IOS和安卓设备)。 6、D3.js D3 是流行的可视化库之一,它被很多其他的表格插件所使用。它允许绑定任意数据到DOM,然后将数据驱动转换应用到Document中。你可以使用它用一个数组创建基本的HTML表格,或是利用它的流体过度和交互,用相似的数据创建惊人的SVG条形图。 7、Gephi Gephi是一个支持动态和分层图的交互可视化与探测工具。Gephi强大的OpenGL引擎允许实时可视化,可以支持网络多达50,000个节点1,000,000条边。它给用户提供了切割边缘布局算法,包括基于力的算法和多层次算法,使得操作体验更高效。此外,该软件是完全免费使用,该公司仅收私有仓库的费用。 8、echarts echarts不是外国的,是国内百度团队的产物。总所周知,百度统计做得挺不错的。他们这个echarts也算是用到淋漓尽致。社区也算比较活跃,例子也十分多,实用一样方便。 9、highcharts

MapReduce编程 一、实验目的 1、理解MapReduce编程模型基本知识 2、掌握MapReduce开发环境的搭建 3、掌握MapReduce基本知识,能够运用MapReduce进行基本的开发 二、实验原理 MapReduce 是Hadoop两个最基础最重要的核心成员之一。它是大规模数据(TB 级)计算的利器,Map 和Reduce 是它的主要思想,来源于函数式编程语言。从编程的角度来说MapReduce分为Map函数和Reduce函数,Map负责将数据打散,Reduce负责对数据进行聚集,用户只需要实现map 和reduce 两个接口,即可完成TB级数据的计算。Hadoop Map Reduce的实现采用了Master/Slave 结构。Master 叫做JobTracker,而Slave 叫做TaskTracker。用户提交的计算叫做Job,每一个Job会被划分成若干个Tasks。JobTracker负责Job 和Tasks 的调度,而TaskTracker负责执行Tasks。常见的应用包括:日志分析和数据挖掘等数据分析应用,另外,还可用于科学数据计算,如圆周率PI 的计算等。 MapReduce 框架的核心步骤主要分两部分:Map 和Reduce。当你向MapReduce 框架提交一个计算作业时,它会首先把计算作业拆分成若干个Map 任务,然后分配到不同的节点上去执行,每一个Map 任务处理输入数据中的一部分,当Map 任务完成后,它会生成一些中间文件,这些中间文件将会作为Reduce 任务的输入数据。Reduce 任务的主要目标就是把前面若干个Map 的输出汇总到一起并输出。按照以上基本的描述,其工作图如下。

数据可视化常用的五种方式及案例分析 概念借助于图形化的手段,清晰、快捷有效的传达与沟通信息。从用户的角度,数据可视化可以让用户快速抓住要点信息,让关键的数据点从人类的眼睛快速通往心灵深处。数据可视化一般会具备以下几个特点:准确性、创新性和简洁性。 常用五种可视化方法 下面从最常用和实用的维度总结了如下5种数据可视化方法,让我们来一一看一下: 一、面积&尺寸可视化对同一类图形(例如柱状、圆环和蜘蛛图等)的长度、高度或面积加以区别,来清晰的表达不同指标对应的指标值之间的对比。 这种方法会让浏览者对数据及其之间的对比一目了然。制作这类数据可视化图形时,要用数学公式计算,来表达准确的尺度和比例。 a: 天猫的店铺动态评分天猫店铺动态评分模块右侧的条状图按精确的比例清晰的表达了不同评分用户的占比。从下图中我们第一眼就可以强烈的感知到5分动态评分的用户占绝对的比例。 b: 联邦预算图如下图,在美国联邦预算剖面图里,用不同高度的货币流清晰的表达了资金的来源去向,及每一项所占金额的比重。

c: 公司黄页-企业能力模型蜘蛛图如下图,通过蜘蛛图的表现,公司综合实力与同行平均水平的对比便一目了然。 二、颜色可视化

通过颜色的深浅来表达指标值的强弱和大小,是数据可视化设计的常用方法,用户一眼看上去便可整体的看出哪一部分指标的数据值更突出。a: 点击频次热力图比如下面这张眼球热力图,通过颜色的差异,我们可以直观的看到用户的关注点。 b: 2013年美国失业率统计在图中可以看到,通过对美国地图以州为单位的划分,用不同的颜色来代表不同的失业率等级范围,整个的全美失业率状况便尽收眼底了。

大数据可视化分析工具有哪些 社会因为大数据的加入而变得更加清楚明了,大数据掌握着我们每一个用户的喜好需求,在大数据的技术下,市场就在手中,得数据者得天下!那在大数据的深度学习中,大数据专家们都用哪些可视化工具呢?听千锋教育的专家怎么说。 首先是ACTIVIS Facebook 研发的交互式深度学习可视化系统,可以对生产环境中的大规模模型以及器运行的结果进行生动直观的呈现。这一系统可以支持四个方面的可视化。模型架构及其对应的计算图概览;用于审视激活情况的神经元激活矩阵、以及投影到2D的可视化;可以对于每一个实例结果进行可视化分析;支持增加不同的实例来对不同的实例、子集、类型的激活模式进行比较,寻找误分类的原因第二就是Grad-CAM Grad-CAM是指Gradient-weighted Class Activation Mapping,研究人员提出利用这种梯度权重激活映射来对卷积神经网络的分类进行解释,在输入的图片中粗略地显示出模型预测出的类别对应的重要性区间。这种方式可以广泛试用于CNN模型家族的模型预测可视化过程。 第三是Deep View

研究人员基于Deep View这一可视化工具研究了训练过程中深度网络的进化情况。利用判别矩阵和密度矩阵分别评价神经元和输出特征图在训练中的进化过程,总而建立了十分细致的视觉分析框架,能够有效展示模型在训练过程中局部和全局的特征变化。 第四是LSTMV 递归神经网络特别是长短时记忆网络是对于时序信号强有力的工具,可以有效的建立和表征时序输入的隐含模式。研究人员对于其中隐藏层随时间的变化十分感兴趣,这一工作主要聚焦于对递归神经网络中的隐藏层动力学可视化。用户可以利用这一工具针对性的选取输入范围并与相同模式的大数据集进行比较,同时还可以利用这一工具对独立的模式进行统计分析。 大数据火爆进行时,学习大数据正当时,千锋教育大数据培训的大门一直为你敞开着,让千锋陪你一起抓住机遇,挑战未来!

1.员工能力决策:在大数据环境下的人力资源规划,可以通过数据动态地跟踪、分析员工的工作情况和状态,离职率、员工需求量等信息,准确地进行人力资源诊断及决策。 2.定量化的人才筛选:大数据背景下,企业可以首先从现有的优秀员工中分析出岗位胜任力素质模型,量化岗位选拔规范。其次,把应聘者的基本信息、个人能力、社会关系、就业倾向等信息汇集起来,与企业的本岗位的胜任力素质模型相匹配,提高招聘员工与企业需求的匹配度,提高人员招聘的工作效率。 3.定制职业生涯发展规划:借助大数据的“学习分析技术”,通过对员工的相关数据分析,识别出员工的学习需求、行为、模式及效果,可以随时得到员工是我学习进程和效果等数据信息,使培训的过程更加的关注员工个人发展。 4.人才用工信用档案:可全面了解人才,可检索到人才的入职记录、在职表现、信用状况,综合判断其职业能力、职业信誉,使公司既可配合相关措施利用好员工的才能,又可防止员工失信行为带来的损失,提高人力资源经管效率,降低人力资源经管风险。 5.人才定位价值曲线:通过大数据分析职业特征,并根据专业人力测评,为人才指出最优职业方向。职业方向定位报告

不仅讲解适合的职业方向,而且从发展的角度,结合职业生涯规划的理念,告诉你确定职业方向、进行职业发展和职业转换最核心的理念和方法。 6.行业性决策支撑:主要解决通过大数据对整个人力资源过程监控,对人力资源经管监控分析。通过建立一套基于企业人力资源经管过程的分析模型,利用商业智能分析统计功能强大和展现形式丰富的特点,实现支持企业人力资源经管决策分析的分析系统。 7.企业人力资源竞争力分析:依靠大数据分析,进行有计划的人才资源开发,把人的智慧能力作为一种巨大的资源进行挖掘和利用,才能达到科技进步和经济腾飞。企业必须创造一个适合吸引人才、培养人才的良好环境,建立凭德才上岗、凭业绩取酬、按需要培训的人才资源开发机制,吸引人才,留住人才,满足企业经济发展和竞争对人才的需要,从而实现企业经济快速发展。 8.薪酬方案设计:在大数据环境下,大数据信息可以反映出行业的整体薪酬水平和员工在进入本企业之前的薪酬水平,更为准确的掌握劳动力薪酬变动和员工薪酬预期,提高人力资源经管工作中薪酬经管的有效性。

第 40 卷 Vol.40 ·专栏· 专栏·

第2期 No.2

计 算 机 工 程 Computer Engineering

文章编号: 文章编号:1000—3428(2014)02—0001—05 文献标识码: 文献标识码:A

2014 年 2 月 February 2014

中图分类号: 中图分类号:TP311

基于 MapReduce 的高能物理数据分析系统

臧冬松 1,2,霍 菁 1,2,梁 栋 1,2,孙功星 1

(1. 中国科学院高能物理研究所,北京 100049;2. 中国科学院大学,北京 100049) 摘 要:将 MapReduce 思想引入到高能物理数据分析中,提出一个基于 Hadoop 框架的高能物理数据分析系统。通过建立事例的 TAG 信息数据库,将需要进一步分析的事例数减少 2~3 个数量级,从而减轻 I/O 压力,提高分析作业的效率。利用基于 TAG 信息 的事例预筛选模型以及事例分析的 MapReduce 模型,设计适用于 ROOT 框架的数据拆分、事例读取、结果合并等 MapReduce 类 库。在北京正负电子对撞机实验上进行系统实现后,将其应用于一个 8 节点实验集群上进行测试,结果表明,该系统可使 4×106 个事 例的分析时间缩短 23%,当增加节点个数时,每秒钟能够并发分析的事例数与集群的节点数基本呈正比,说明事例分析集群具有 良好的扩展性。 关键词: 键词:高能物理;大数据;数据分析;MapReduce 模型;集群;分布式计算

High Energy Physics Data Analysis System Based on MapReduce

ZANG Dong-song1,2, HUO Jing1,2, LIANG Dong1,2, SUN Gong-xing1

(1. Institute of High Energy Physics, Chinese Academy of Sciences, Beijing 100049, China; 2. University of Chinese Academy of Sciences, Beijing 100049, China) 【Abstract】This paper brings the idea of MapReduce parallel processing to high energy physics data analysis, proposes a high energy physics data analysis system based on Hadoop framework. It significantly reduces the number of events that need to do further analysis by 2~3 classes by establishing an event TAG information database, which reduces the I/O volume and improves the efficiency of data analysis jobs. It designs proper MapReduce libs that fit for the ROOT framework to do things such as data splitting, event fetching and result merging by using event pre-selection model based on TAG information and MapReduce model of event analysis. A real system is implemented on BESIII experiment, an 8-nodes cluster is used for data analysis system test, the test result shows that the system shortens the data analyzing time by 23% of 4×106 event, and event number of concurrence analysis per second is higher than cluster nodes when adding more worker nodes, which explains that the case analysis cluster has a good scalability. 【Key words】high energy physics; big data; data analysis; MapReduce model; cluster; distributed computing DOI: 10.3969/j.issn.1000-3428.2014.02.001

1

概述

高能物理实验产生了海量数据,位于法国和瑞士边境

支持,成为大数据领域的标准。 目前 Hadoop 在高能物理实验中的全面应用还非常少, 但已经出现了许多探索和部分应用。美国的 7 个 CMS 实验 网格站点采用了 HDFS 作为存储系统[5]; 意大利国家核物理 研究所探索了利用 Hadoop 的 MapReduce 框架分析高能物 理 实 验 数 据 [6] ; 文 献 [7] 探 索 了 在 亚 马 逊 云 计 算 中 采 用 Hadoop 框架进行高能物理数据分析。 本文分析高能物理数据分析的流程和特点,以及高能 物理普遍采用的 ROOT[8]软件及 ROOT 格式文件的 I/O 特 性,给出一种基于 Hadoop 框架的高能物理数据 MapReduce 分析系统,并进行初步的评估。

的大型强子对撞机(Large Hadron Collider, LHC)每年可产生 25 PB 的数据;改造后的北京正负电子对撞机(BEPCII)和北 京谱仪(BESIII)的取数效率和性能大幅提高, 2012 年产生的 数据量超过了过去几年的总和。数据量的不断膨胀促使不 断探索新的数据存储和计算技术。谷歌公司自 2003 年后相 继发表的 GFS 、MapReduce 和 BigTable 引领了互联网

[1] [2] [3]

界大数据处理的技术革新,而随后基于 Google 实现的 Hadoop 开源项目,更是被众多的公司和厂商广泛采用和

[4]

————————————

基金项目: 基金项目:国家自然科学基金资助重点项目(90912004) 作者简介: 作者简介:臧冬松(1981-),男,博士研究生,主研方向:分布式计算,海量数据管理;霍 研究员 收稿日期: 收稿日期:2013-02-20 修回日期: 修回日期:2013-03-20 E-mail:donal.zang@https://www.doczj.com/doc/d117459499.html, 菁、梁 栋,博士研究生;孙功星,

大数据分析与可视化是什么 在大数据时代,人们迫切希望在由普通机器组成的大规模集群上实现高性能的以机器学习算法为核心的数据分析,为实际业务提供服务和指导,进而实现数据的最终变现。千锋教育培训专家指出:在大数据分析的应用过程中,可视化通过交互式视觉表现的方式来帮助人们探索和理解复杂的数据。 与传统的在线联机分析处理OLAP不同,对大数据的深度分析主要基于大规模的机器学习技术,一般而言,机器学习模型的训练过程可以归结为最优化定义于大规模训练数据上的目标函数并且通过一个循环迭代的算法实现。因而与传统的OLAP相比较,基于机器学习的大数据分析具有自己独特的特点。 (1)迭代性:由于用于优化问题通常没有闭式解,因而对模型参数确定并非一次能够完成,需要循环迭代多次逐步逼近最优值点。 (2)容错性:机器学习的算法设计和模型评价容忍非最优值点的存在,同时多次迭代的特性也允许在循环的过程中产生一些错误,模型的最终收敛不受影响。 (3)参数收敛的非均匀性:模型中一些参数经过少数几轮迭代后便不再改变,而有些参数则需要很长时间才能达到收敛。 这些特点决定了理想的大数据分析系统的设计和其他计算系统的设计有很

大不同,直接应用传统的分布式计算系统应用于大数据分析,很大比例的资源都浪费在通信、等待、协调等非有效的计算上。 在大数据分析的应用过程中,可视化通过交互式视觉表现的方式来帮助人们探索和理解复杂的数据。可视化与可视分析能够迅速和有效地简化与提炼数据流,帮助用户交互筛选大量的数据,有助于使用者更快更好地从复杂数据中得到新的发现,成为用户了解复杂数据、开展深入分析不可或缺的手段。大规模数据的可视化主要是基于并行算法设计的技术,合理利用有限的计算资源,高效地处理和分析特定数据集的特性。通常情况下,大规模数据可视化的技术会结合多分辨率表示等方法,以获得足够的互动性能。 在科学大规模数据的并行可视化工作中,主要涉及数据流线化、任务并行化、管道并行化和数据并行化4 种基本技术。学习大数据可视化技术还是选择千锋教育,千锋教育专家让你的技术水平一路飙升。