Ceph分布式存储平台

部署手册

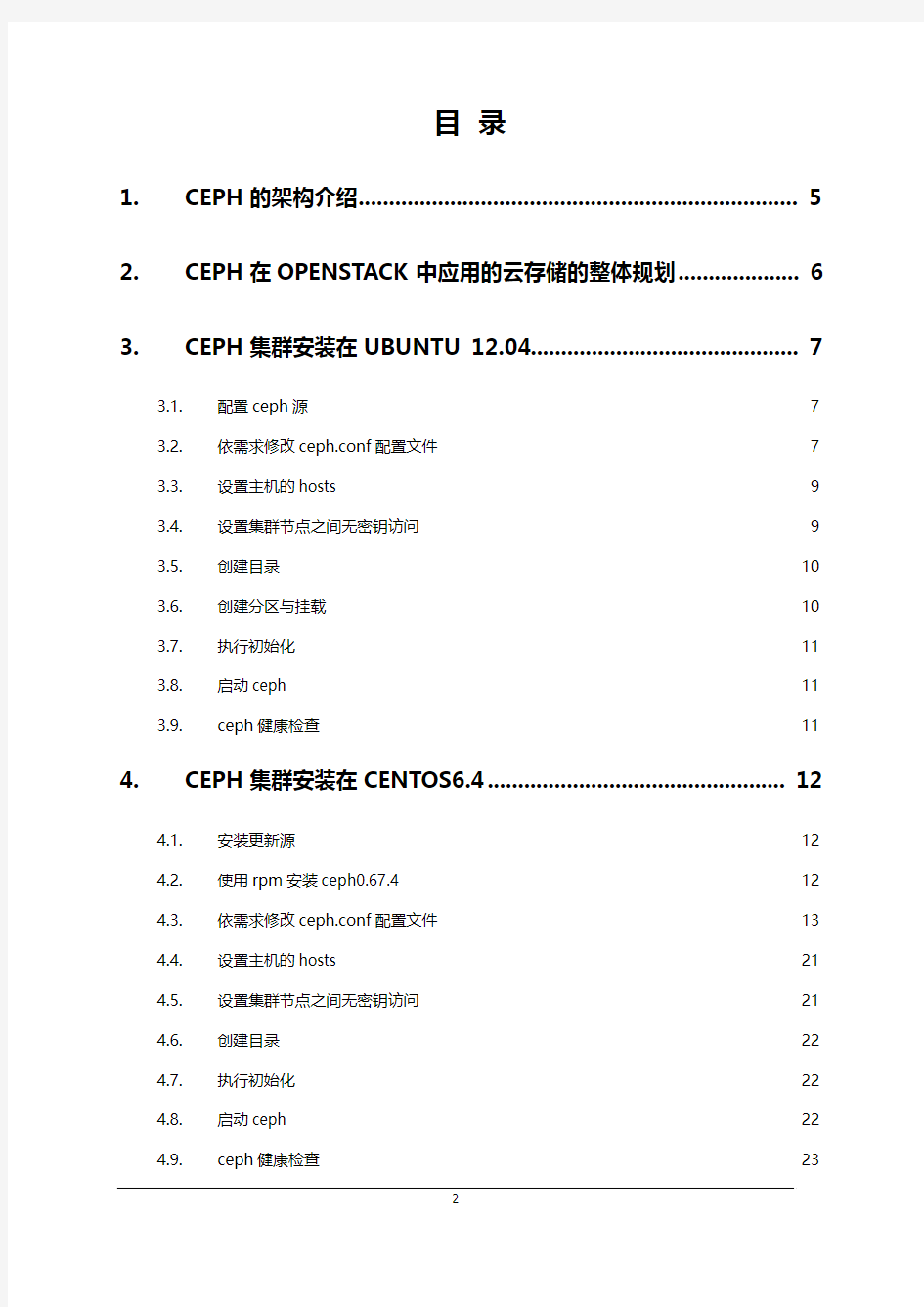

目录

1.CEPH的架构介绍 (5)

2.CEPH在OPENSTACK中应用的云存储的整体规划 (6)

3.CEPH集群安装在UBUNTU 12.04 (7)

3.1.配置ceph源7

3.2.依需求修改ceph.conf配置文件7

3.3.设置主机的hosts 9

3.4.设置集群节点之间无密钥访问9

3.5.创建目录10

3.6.创建分区与挂载10

3.7.执行初始化11

3.8.启动ceph 11

3.9.ceph健康检查11

4.CEPH集群安装在CENTOS6.4 (12)

4.1.安装更新源12

4.2.使用rpm安装ceph0.67.4 12

4.3.依需求修改ceph.conf配置文件13

4.4.设置主机的hosts 21

4.5.设置集群节点之间无密钥访问21

4.6.创建目录22

4.7.执行初始化22

4.8.启动ceph 22

4.9.ceph健康检查23

5.OPENSTACK GLANCE 使用CEPH集群的配置 (24)

5.1.创建卷池和图像池24

5.2.增加两个池的复制水平24

5.3.为池创建 Ceph 客户端和密钥环24

5.4.在计算节点应用密钥环24

5.4.1.创建libvirt密钥24

5.4.2.计算节点ceph安装25

5.5.更新你的 glance-api 配置文件25

6.OPENSTACK VOLUMES使用CEPH集群的配置 (27)

6.1.计算节点ceph安装27

6.2.创建临时的 secret.xml 文件27

6.3.设定 libvirt 使用上面的密钥28

6.4.更新 cinder 配置28

6.4.1.cinder.conf文件更改28

6.4.2.更改 cinder 启动脚本配置文件29

6.4.3.更改/etc/nova/nova.conf配置29

6.4.4.重启 cinder 服务29

6.5.验证cinder-volume 29

6.6.验证rdb创建volume 30

7.挂载CEPHFS (31)

7.1.配置/etc/fstab 31

7.2.挂载vm实例目录31

8.FQA (32)

1.CEPH的架构介绍

CEPH的组件主要包括客户端ceph client(数据用户),元数据服务器mds(缓存和同步分布式元数据),一个对象存储集群osd(将数据和元数据作为对象存储,执行其他关键职能),集群监视器mon(执行监视功能)。

2.CEPH在openstack中应用的云存储的整体规划

3.CEPH集群安装在ubuntu 12.04

3.1.配置ceph源

echo deb https://www.doczj.com/doc/c22349378.html,/debian-bobtail/ $(lsb_release -sc) main | sudo tee /etc/apt/sources.list.d/ceph.list

apt-get update && apt-get install ceph #安装ceph

ceph –V #检查ceph的安装版本

3.2.依需求修改ceph.conf配置文件

/etc/ceph/ceph.conf内容如下:

[global]

auth supported = cephx

keyring = /etc/ceph/keyring.admin

[mds]

keyring = /etc/ceph/keyring.$name

[mds.0]

host = network-n01

[osd]

osd data = /srv/ceph/osd$id

osd journal = /srv/ceph/osd$id/journal

osd journal size = 512

osd class dir = /usr/lib/rados-classes

keyring = /etc/ceph/keyring.$name

; working with ext4

filestore xattr use omap = true

osd mkfs type = xfs

osd mkfs options xfs = -f

osd mount options xfs = rw,noatime

; solve rbd data corruption

filestore fiemap = true

[osd.0]

host = network-n01

cluster addr = 10.10.10.21

public addr = 192.168.2.21

devs = /dev/sdb1

[osd.1]

host = network-n01

cluster addr = 10.10.10.21

public addr = 192.168.2.21

devs = /dev/sdc1

[osd.2]

host = control-n01

cluster addr = 10.10.10.11

public addr = 192.168.2.11

devs = /dev/cinder-volumes/vol002 [mon]

mon data = /srv/ceph/mon$id

[mon.0]

host = network-n01

mon addr = 10.10.10.21:6789

[mon.1]

Host = control-n01

Mon addr = 10.10.10.11:6789

[client.volumes]

keyring = /etc/ceph/ceph.client.volumes.keyring

#[client.images]

# keyring = /etc/ceph/client.images.keyring

3.3.设置主机的hosts

主机名是ceph通信的基础,因此集群中每个节点需要hosts同步。/etc/hosts如下:

192.168.2.11 https://www.doczj.com/doc/c22349378.html, control-n01 192.168.2.21 https://www.doczj.com/doc/c22349378.html, network-n01 192.168.2.31 https://www.doczj.com/doc/c22349378.html, compute-n01 192.168.2.32 https://www.doczj.com/doc/c22349378.html, compute-n02

3.4.设置集群节点之间无密钥访问

元数据节点、监控节点、存储节点ssh配置相同

ssh-keygen 一直回车生成密钥

ssh-copy-id –i ~/root/.ssh/id_rsa.pub 10.10.10.11 #复制公钥需去认证目标主机

3.5.创建目录

mkdir -p /srv/ceph/osd0

mkdir –p /srv/ceph/osd1

mkdir –p /srv/ceph/osd2

mkdir –p /srv/ceph/mon0

mkdir –p /srv/ceph/mon1

mkdir –p /srv/ceph/mds

3.6.创建分区与挂载

parted /dev/sdb #parted分区

parted /dev/sdc

mkfs.xfs –f /dev/sdb1

mkfs.xfs –f /dev/sdc1

vim /etc/fstab #添加挂载在fstab

/dev/sdb1 /srv/ceph/osd0 xfs rw,noexec,nodev,noatime,nodiratime,barrier=0 0 0

/dev/sdc1 /srv/ceph/osd1 xfs rw,noexec,nodev,noatime,nodiratime,barrier=0 0 0

3.7.执行初始化

mkcephfs -a -c /etc/ceph/ceph.conf -k /etc/ceph/keyring.admin chmod +r /etc/ceph/keyring.admin

3.8.启动ceph

service ceph –a start

3.9.ceph健康检查

ceph –s

ceph osd tree

ceph health

ceph df

4.CEPH集群安装在centos6.4

4.1.安装更新源

rpm --import 'https://https://www.doczj.com/doc/c22349378.html,/git/?p=ceph.git;a=blob_plain;f=keys/release.asc' rpm -Uvh https://www.doczj.com/doc/c22349378.html,/pub/epel/6/x86_64/epel-release-6-

8.noarch.rpm

4.2.使用rpm安装ceph0.67.4

在系统上安装ceph https://www.doczj.com/doc/c22349378.html,/rpm-dumpling/rhel6/x86_64/ 依据依赖关系安装CEPH 0.6.7.4

yum install -y leveldb snappy xfsprogs boost gdisk python-lockfile gperftools-libs python-flask python-requests python-argparse

rpm -i https://www.doczj.com/doc/c22349378.html,/rpm-dumpling/rhel6/x86_64/libcephfs1-0.67.4-

0.el6.x86_64.rpm

rpm -i https://www.doczj.com/doc/c22349378.html,/rpm-dumpling/rhel6/x86_64/librados2-0.67.4-

0.el6.x86_64.rpm

rpm -i https://www.doczj.com/doc/c22349378.html,/rpm-dumpling/rhel6/x86_64/librbd1-0.67.4-

0.el6.x86_64.rpm

rpm -i https://www.doczj.com/doc/c22349378.html,/rpm-dumpling/rhel6/x86_64/python-ceph-0.67.4-

0.el6.x86_64.rpm

rpm -i https://www.doczj.com/doc/c22349378.html,/rpm-dumpling/rhel6/x86_64/ceph-0.67.4-0.el6.x86_64.rpm rpm -i https://www.doczj.com/doc/c22349378.html,/rpm-dumpling/rhel6/x86_64/ceph-fuse-0.67.4-

0.el6.x86_64.rpm

4.3.依需求修改ceph.conf配置文件[global]

auth supported = cephx

max open files = 131072

log file = /var/log/ceph/$name.log

pid file = /var/run/ceph/$name.pid

keyring = /etc/ceph/keyring.admin [mon]

mon data = /srv/ceph/$name

;osd pool default size = 3

;osd pool default crush rule = 0

;mon clock drift allowed = 1

;mon clock drift warn backoff = 30

;debug ms = 1

;debug mon = 20

;debug paxos = 20

;debug auth = 20

[mon.0]

host = DG-store001

mon addr = 172.32.4.100:6789

[mon.1]

host = DG-store002

mon addr = 172.32.4.101:6789

[mon.2]

host = DG-store003

mon addr = 172.32.4.102:6789

[mds]

keyring = /etc/ceph/keyring.$name

; mds logging to debug issues.

;debug ms = 1

;debug mds = 20

[mds.0]

host = DG-store001

[mds.1]

host = DG-store002

[osd]

osd data = /srv/ceph/$name

osd journal = /srv/ssd/$name/journal

osd journal size = 5120 ; journal size, in megabytes

keyring = /etc/ceph/keyring.$name

;journal dio = false

; osd recovery max active = 3

; osd logging to debug osd issues, in order of likelihood of being ; helpful

;debug ms = 1

;debug osd = 20

;debug filestore = 20

;debug journal = 20

osd mkfs type = xfs

osd mount options xfs = rw,noatime

osd mkfs options xfs = -f

[osd.0]

host = DG-store001

public address = 172.16.4.100

cluster address = 192.168.2.10

devs = /dev/sdb

[osd.1]

host = DG-store001

public address = 172.16.4.100

cluster address = 192.168.2.10

devs = /dev/sdc

[osd.2]

Ceph分布式存储 1Ceph存储概述 Ceph 最初是一项关于存储系统的PhD 研究项目,由Sage Weil 在University of California, Santa Cruz(UCSC)实施。 Ceph 是开源分布式存储,也是主线Linux 内核(2.6.34)的一部分。1.1Ceph 架构 Ceph 生态系统可以大致划分为四部分(见图1):客户端(数据用户),元数据服务器(缓存和同步分布式元数据),一个对象存储集群(将数据和元数据作为对象存储,执行其他关键职能),以及最后的集群监视器(执行监视功能)。 图1 Ceph 生态系统 如图1 所示,客户使用元数据服务器,执行元数据操作(来确定数据位置)。元数据服务器管理数据位置,以及在何处存储新数据。值得注意的是,元数据存储在一个存储集群(标为―元数据I/O‖)。实际的文件I/O 发生在客户和对象存储集群之间。这样一来,更高层次的POSIX 功能(例如,打开、关闭、重命名)就由元数据服务器管理,不过POSIX 功能(例如读和

写)则直接由对象存储集群管理。 另一个架构视图由图2 提供。一系列服务器通过一个客户界面访问Ceph 生态系统,这就明白了元数据服务器和对象级存储器之间的关系。分布式存储系统可以在一些层中查看,包括一个存储设备的格式(Extent and B-tree-based Object File System [EBOFS] 或者一个备选),还有一个设计用于管理数据复制,故障检测,恢复,以及随后的数据迁移的覆盖管理层,叫做Reliable Autonomic Distributed Object Storage(RADOS)。最后,监视器用于识别组件故障,包括随后的通知。 图2 ceph架构视图 1.2Ceph 组件 了解了Ceph 的概念架构之后,您可以挖掘到另一个层次,了解在Ceph 中实现的主要组件。Ceph 和传统的文件系统之间的重要差异之一就是,它将智能都用在了生态环境而不是文件系统本身。 图3 显示了一个简单的Ceph 生态系统。Ceph Client 是Ceph 文件系统的用户。Ceph Metadata Daemon 提供了元数据服务器,而Ceph Object Storage Daemon 提供了实际存储(对数据和元数据两者)。最后,Ceph Monitor 提供了集群管理。要注意的是,Ceph 客户,对象存储端点,元数据服务器(根据文件系统的容量)可以有许多,而且至少有一对冗余的监视器。那么,这个文件系统是如何分布的呢?

日立存储设备操作维护手册 日立数据系统有限公司(HDS) 2009年11月17日

目录 第一部分硬件部分(高端、中端和低端的日立存储三种情况分别写) .... 错误!未定义书签。 1.日立存储的配置界面的登录方法。........................................................... 错误!未定义书签。 2.创建RAID组、划分LUN、初始化磁盘的步骤,在端口上划分DISK组,将主机的端口的WWN号加到相应的DISK组中的步骤。................................................... 错误!未定义书签。 3.在高端存储中配置TURECOPY的步骤。............................................... 错误!未定义书签。 4.在高端存储中配置SHADOWIMAGE的步骤。..................................... 错误!未定义书签。 5.系统告警灯的位置以及告警灯的显示方式,如何登陆系统查看系统告警,常见的告警代码及处理方法。........................................................................................................ 错误!未定义书签。 第二部分软件部分.......................................................................................... 错误!未定义书签。 1.AIX操作系统和HP-UNIX操作系统安装HDLM多路径管理软件的步骤。错误!未定义书签。 2.HDLM多路径管理软件安装完成后,配置磁盘多路径参数的步骤,日常维护的命令。.. 错误!未定义书签。 3.HUR 相关参数配置.................................................................................... 错误!未定义书签。 4.HUR 的日常维护........................................................................................ 错误!未定义书签。

Oracle数据库日常维护手册 在Oracle数据库运行期间,DBA应该对数据库的运行日志及表空间的使用情况进行监控,及早发现数据库中存在的问题。 一、Oracle警告日志文件监控 Oracle在运行过程中,会在警告日志文件(alert_SID.log)中记录数据库的一些运行情况: ●数据库的启动、关闭,启动时的非缺省参数; ●数据库的重做日志切换情况,记录每次切换的时间,及如果因为检查点(checkpoint)操作没有执行完成造成不能切换,会记录不能切换的原因; ●对数据库进行的某些操作,如创建或删除表空间、增加数据文件; ●数据库发生的错误,如表空间不够、出现坏块、数据库内部错误(ORA-600) DBA应该定期检查日志文件,根据日志中发现的问题及时进行处理 问题处理 启动参数不对检查初始化参数文件 因为检查点操作或归档操作没有完成造成重做日志不能切换如果经常发生这样的情况,可以考虑增加重做日志文件组;想办法提高检查点或归档操作的效率; 有人未经授权删除了表空间检查数据库的安全问题,是否密码太简单;如有必要,撤消某些用户的系统权限 出现坏块检查是否是硬件问题(如磁盘本生有坏块),如果不是,检查是那个数据库对象出现了坏块,对这个对象进行重建 表空间不够增加数据文件到相应的表空间 出现ORA-600根据日志文件的内容查看相应的TRC文件,如果是Oracle的bug,要及时打上相应的补丁 二、数据库表空间使用情况监控(字典管理表空间)

数据库运行了一段时间后,由于不断的在表空间上创建和删除对象,会在表空间上产生大量的碎片,DBA应该及时了解表空间的碎片和可用空间情况,以决定是否要对碎片进行整理或为表空间增加数据文件。 select tablespace_name, count(*) chunks , max(bytes/1024/1024) max_chunk from dba_free_space group by tablespace_name; 个人收集整理 上面的SQL列出了数据库中每个表空间的空闲块情况,如下所示: TABLESPACE_NAME CHUNKS MAX_CHUNK -------------------- ---------- ---------- INDX 1 57.9921875 RBS 3 490.992188 RMAN_TS 1 16.515625 SYSTEM 1 207.296875 TEMP 20 70.8046875 TOOLS 1 11.8359375 USERS 67 71.3671875个人收集整理 其中,CHUNKS列表示表空间中有多少可用的空闲块(每个空闲块是由一些连续的Oracle 数据块组成),如果这样的空闲块过多,比如平均到每个数据文件上超过了100个,那么该表空间的碎片状况就比较严重了,可以尝试用以下的SQL命令进行表空间相邻碎片的接合: alter tablespace 表空间名 coalesce; 然后再执行查看表空间碎片的SQL语句,看表空间的碎片有没有减少。如果没有效果,并且表空间的碎片已经严重影响到了数据库的运行,则考虑对该表空间进行重建。 MAX_CHUNK列的结果是表空间上最大的可用块大小,如果该表空间上的对象所需分配的空间(NEXT值)大于可用块的大小的话,就会提示ORA-1652、ORA-1653、ORA-1654的错误信息,DBA应该及时对表空间的空间进行扩充,以避免这些错误发生。 对表空间的扩充对表空间的数据文件大小进行扩展,或向表空间增加数据文件,具体操作见“存储管理”部份。 三、查看数据库的连接情况

全球眼?(MEGAEYES)网络图像管理系统2.0 ORACLE日常维护与管理手册 北京互信互通信息技术有限公司 2004-08-08

目录 全球眼?(MEGAEYES)网络图像管理系统2.0 (1) 1引言 (3) 1.1 目的 (3) 1.2 范围 (3) 1.3 参考资料 (3) 2日常维护与管理说明 (3) 2.1 运行环境 (3) 2.1.1硬件环境 (3) 2.1.2软件环境 (3) 2.2 数据库日常维护 (4) 2.2.1数据库初始设置 (4) 2.2.2每日工作内容 (5) 2.2.3每周工作内容 (6) 2.2.4每月工作内容 (7)

1引言 1.1目的 对于重要的商业系统来说,数据库系统的正常运行是保证商业应用平稳运行的关键。但是数据库在运行过程中可能会因为种种原因发生问题。这时,数据库的管理与日常维护工作将变得尤为重要。 为了指导数据库管理员做好日常维护工作,保证数据库系统的正常运行,特制定本文档。当然,数据库的日常维护是复杂和繁琐的,本文仅涉及一些常见的数据库日常维护的内容,在实际工作中,数据库管理员还需要做更多的工作。 1.2范围 本文档使用的人员:数据库维护管理人员和相关人员。 本文档涉及内容:oracle数据库的日常维护与管理解决方案。 1.3参考资料 中国电信网络视频监控技术(暂行)规范 2日常维护与管理说明 2.1运行环境 程序的运行环境包括硬件运行环境和软件运行环境。 2.1.1硬件环境 ◆CPU类型:Intel及其兼容系列CPU ◆内存容量:剩余内存要达2G以上 ◆硬盘容量:剩余硬盘容量要达1G以上 ◆网卡类型:100M网卡 2.1.2软件环境 ◆操作系统:RedHat Linux AS 3.0 ◆数据库:Oracle9i Database Release 2 (9.2.0.4.0) for Linux x86

EMC VNX5500 日常维护手册

目录 第一章 VNX日常配置错误!未定义书签。 登陆管理界面错误!未定义书签。 创建Raid Group 错误!未定义书签。 创建Hot Spare 错误!未定义书签。 创建LUN 错误!未定义书签。 创建Storage Group 错误!未定义书签。 指派LUN 错误!未定义书签。 指派主机错误!未定义书签。 第二章 VNX日常管理和维护错误!未定义书签。 开关机注意事项及详细步骤错误!未定义书签。 开机前注意事项错误!未定义书签。 关机前注意事项错误!未定义书签。 日常健康检查错误!未定义书签。 VNX报修错误!未定义书签。 VNX日常配置 登陆管理界面 在IE窗口中输入EMC存储的地址: 在弹出的窗口中输入帐号及密码即可登陆存储管理界面:(sysadmin/sysadmin) 打开管理界面如下所示:

创建Raid Group 在管理界面中选择“Storage”=》“Storage Pool”: 选择“Raid Group”标签即可显示已经创建的Raid Group:

点击“新建”可创建新的Raid Group: 在创建Raid Group窗口输入相应的参数:如Raid Type等,然后点击“select”选择需要加入到此Raid Group的硬盘:

选择需要加入到此Raid Group的硬盘后,点击“OK”: 确认加入到加入到此Raid Group的硬盘无误后,点击“应用”,在信息提示窗口点击“OK”完成Raid Group的创建:

在管理界面“storage”的“Raid Group”标签界面中即可查看创建完成的Raid Group信息: 到此,Raid Group创建操作完成。 创建Hot Spare 创建Hot Spare的步骤与Raid Group大致类似,仅在配置其Raid Group的类型时需要选择Hot Spare类型。 创建Hotspare: 选择需要创建的Hotspare类型和磁盘,点击应用:

E M C日常维护手册 (v20131108) 版本说明 目录 目录 版本说明 ......................................................................................................................................... 错误!未指定书签。1硬件部分 ...................................................................................................................................... 错误!未指定书签。 1.1ClariionCX系列产品硬件介绍........................................................................................... 错误!未指定书签。 1.2如何用Navisphere看存储的状态 ................................................................................... 错误!未指定书签。 1.3客户发现Clariion出现问题,应如何报修? ................................................................. 错误!未指定书签。 1.4EMCClariionCX系列开关机注意事项及详细步骤 ........................................................... 错误!未指定书签。 1.5Clariion主动性售后支持及call-home的介绍 ................................................................. 错误!未指定书签。 1.6如何收集日志 ................................................................................................................... 错误!未指定书签。

ceph源码分析之读写操作流程(2) 上一篇介绍了ceph存储在上两层的消息逻辑,这一篇主要介绍一下读写操作在底两层的流程。下图是上一篇消息流程的一个总结。上在ceph中,读写操作由于分布式存储的原因,故走了不同流程。 对于读操作而言: 1.客户端直接计算出存储数据所属于的主osd,直接给主osd 上发送消息。 2.主osd收到消息后,可以调用Filestore直接读取处在底层文件系统中的主pg里面的内容然后返回给客户端。具体调用函数在ReplicatedPG::do_osd_ops中实现。读操作代码流程如图:如我们之前说的,当确定读操作为主osd的消息时(CEPH_MSG_OSD_OP类型),会调用到ReplicatePG::do_osd_op函数,该函数对类型做进一步判断,当发现为读类型(CEPH_OSD_OP_READ)时,会调用FileStore中的函数对磁盘上数据进行读。 [cpp] view plain copy int ReplicatedPG::do_osd_ops(OpContext *ctx, vector<OSDOp>& ops) { …… switch (op.op) { …… case CEPH_OSD_OP_READ: ++ctx->num_read; { // read into a buffer bufferlist

bl; int r = osd->store->read(coll, soid, op.extent.offset, op.extent.length, bl); // 调用FileStore::read从底层文件系统读 取……} case CEPH_OSD_OP_WRITE: ++ctx->num_write; { ……//写操作只是做准备工作,并不实际的 写} ……} } FileStore::read 函数是底层具体的实现,会通过调用系统函数 如::open,::pread,::close等函数来完成具体的操作。[cpp] view plain copy int FileStore::read( coll_t cid, const ghobject_t& oid, uint64_t offset, size_t len, bufferlist& bl, bool allow_eio) { …… int r = lfn_open(cid, oid, false, &fd); …… got = safe_pread(**fd, bptr.c_str(), len, offset); //FileStore::safe_pread中调用了::pread …… lfn_close(fd); ……} 而对于写操作而言,由于要保证数据写入的同步性就会复杂很多: 1.首先客户端会将数据发送给主osd, 2.主osd同样要先进行写操作预处理,完成后它要发送写消息给其他的从osd,让他们对副本pg进行更改, 3.从osd通过FileJournal完成写操作到Journal中后发送消息

EMC VNX5700日常维护手册

目录 第一章 VNX日常配置 .................................................. 错误!未定义书签。 1.1登陆管理界面........................................................ 错误!未定义书签。 1.2创立R AID G ROUP .................................................. 错误!未定义书签。 1.3创立H OT S PARE..................................................... 错误!未定义书签。 1.4创立LUN ............................................................... 错误!未定义书签。 1.5创立S TORAGE G ROUP ........................................... 错误!未定义书签。 1.6指派LUN ............................................................... 错误!未定义书签。 1.7指派主机................................................................ 错误!未定义书签。第二章 VNX日常管理和维护 ...................................... 错误!未定义书签。 2.1开关机注意事项及详细步骤................................ 错误!未定义书签。 2.1.1 开机前注意事项 ............................................. 错误!未定义书签。 2.1.2 关机前注意事项 ............................................. 错误!未定义书签。 2.2日常健康检查........................................................ 错误!未定义书签。 2.3VNX报修 .............................................................. 错误!未定义书签。

FastDFS (7) Fastdfs简介 (7) Fastdfs系统结构图 (7) FastDFS和mogileFS的对比 (8) MogileFS (10) Mogilefs简介 (10) Mogilefs组成部分 (10) 0)数据库(MySQL)部分 (10) 1)存储节点 (11) 2)trackers(跟踪器) (11) 3)工具 (11) 4)Client (11) Mogilefs的特点 (12) 1. 应用层——没有特殊的组件要求 (12) 2. 无单点失败 (12) 3. 自动的文件复制 (12) 4. “比RAID好多了” (12) 5. 传输中立,无特殊协议 (13) 6.简单的命名空间 (13) 7.不用共享任何东西 (13) 8.不需要RAID (13)

9.不会碰到文件系统本身的不可知情况 (13) HDFS (14) HDFS简介 (14) 特点和目标 (14) 1. 硬件故障 (14) 2. 流式的数据访问 (14) 3. 简单一致性模型 (15) 4. 通信协议 (15) 基本概念 (15) 1. 数据块(block) (15) 2. 元数据节点(Namenode)和数据节点(datanode) . 16 2.1这些结点的用途 (16) 2.2元数据节点文件夹结构 (17) 2.3文件系统命名空间映像文件及修改日志 (18) 2.4从元数据节点的目录结构 (21) 2.5数据节点的目录结构 (21) 文件读写 (22) 1.读取文件 (22) 1.1 读取文件示意图 (22) 1.2 文件读取的过程 (23) 2.写入文件 (24) 2.1 写入文件示意图 (24)

CEPH分布式存储部署 PS:本文的所有操作均在mon节点的主机进行,如有变动另有注释 作者:网络技术部徐志权 日期:2014年2月10日 VERSION 1.0 更新历史: 2014.2.10:首次完成ceph部署文档,块设备及对象存储的配置随后添加。

一、部署前网络规划 1.1 环境部署 主机名公网IP(eth0)私网IP(eth1)操作系统运行服务node1 192.168.100.101 172.16.100.101 CentOS6.5 mon、mds node2 192.168.100.102 172.16.100.102 CentOS6.5 osd node3 192.168.100.103 172.16.100.103 CentOS6.5 osd ◆操作系统使用CentOS6.5,因为系统已经包含xfs的支持可以直接使用不需要再次 编译。 ◆由于CentOS6.5系统的内核为2.6.32,因此要关闭硬盘的写入缓存,若高于此版本 不需要关闭。 #hdparm -W 0 /dev/sdb 0 ◆本次部署一共有一个监控节点、一个元数据节点、两个数据节点,每个数据节点拥 有两个硬盘作为数据盘。 1.2 网络拓扑

1.3 配置服务器、安装ceph ●添加ceph的rpm库key #rpm --import 'https://https://www.doczj.com/doc/c22349378.html,/git/?p=ceph.git;a=blob_plain;f=keys/release.asc' #rpm --import 'https://https://www.doczj.com/doc/c22349378.html,/git/?p=ceph.git;a=blob_plain;f=keys/autobuild.asc' ●添加ceph-extras库 #vi /etc/yum.repos.d/ceph-extras [ceph-extras] name=Ceph Extras Packages baseurl=https://www.doczj.com/doc/c22349378.html,/packages/ceph-extras/rpm/centos6/$basearch enabled=1 priority=2 gpgcheck=1 type=rpm-md gpgkey=https://https://www.doczj.com/doc/c22349378.html,/git/?p=ceph.git;a=blob_plain;f=keys/release.asc [ceph-extras-noarch] name=Ceph Extras noarch baseurl=https://www.doczj.com/doc/c22349378.html,/packages/ceph-extras/rpm/centos6/noarch enabled=1 priority=2 gpgcheck=1 type=rpm-md gpgkey=https://https://www.doczj.com/doc/c22349378.html,/git/?p=ceph.git;a=blob_plain;f=keys/release.asc [ceph-extras-source] name=Ceph Extras Sources baseurl=https://www.doczj.com/doc/c22349378.html,/packages/ceph-extras/rpm/centos6/SRPMS enabled=1 priority=2 gpgcheck=1 type=rpm-md gpgkey=https://https://www.doczj.com/doc/c22349378.html,/git/?p=ceph.git;a=blob_plain;f=keys/release.asc ●添加ceph库 #rpm -Uvh https://www.doczj.com/doc/c22349378.html,/rpms/el6/noarch/ceph-release-1-0.el6.noarch.rpm ●添加epel库 #rpm -Uvh https://www.doczj.com/doc/c22349378.html,/pub/epel/6/x86_64/epel-release-6-8.noarch.rpm ●安装ceph #yum update -y && yum install ceph -y

Ceph分布式存储系统 Ceph是根据加州大学Santa Cruz分校的Sage Weil的博士论文所设计开发的新一代自由软件分布式文件系统,其设计目标是良好的可扩展性(PB级别以上)、高性能及高可靠性。Ceph其命名和UCSC(Ceph 的诞生地)的吉祥物有关,这个吉祥物是“Sammy”,一个香蕉色的蛞蝓,就是头足类中无壳的软体动物。这些有多触角的头足类动物,是对一个分布式文件系统高度并行的形象比喻。 其设计遵循了三个原则:数据与元数据的分离,动态的分布式的元数据管理,可靠统一的分布式对象存储机制。本文将从Ceph的架构出发,综合性的介绍Ceph分布式文件系统特点及其实现方式。 一、Ceph基本架构 Ceph是一个高可用、易于管理、开源的分布式存储系统,可以在一套系统中同时提供对象存储、块存储以及文件存储服务。其主要由Ceph存储系统的核心RADOS以及块存取接口、对象存取接口和文件系统接口组成,如图所示 Ceph的底层是RADOS,它的意思是“A reliable,autonomous, distributed object storage”。 RADOS作为Ceph分布式文件系统的一个子项目,是为了满足Ceph的需求

而设计的,但是,其也可以单独作为一种分布式数据存储系统,给其他的有类似需求的分布式文件系统提供数据存储服务。Ceph文件系统, Ceph对象存储和Ceph块设备从RADOS的存储集群中读去和写入数据。 Ceph作为一个分布式存储系统,其对外提供的接口,决定了其通用性以及扩展性。如上图架构图中所示的那样,Ceph对外提供了丰富多样的服务接口,包括多种编程语言接口LIBRADOS(备注,上图来自Ceph中文社区,社区人员在翻译的过程中将字母L遗失掉了)、对象存储接口(RADOSGW)、块存储接口(RBD)以及文件系统接口(Ceph FS)。其中LIBRADOS编程接口是其他各种客户端接口的基础,其他接口都是基于LIBRADOS 来进行扩展实现的。 1.1. RADOS Ceph中RADOS(Reliable Autonomic Distributed Object Store)存储集群是所有其他客户端接口使用和部署的基础。RADOS由两个组件组成: ?OSD: Object StorageDevice,提供存储资源。 ?Monitor:维护整个Ceph集群的全局状态。 典型的RADOS部署架构由少量的Monitor监控器以及大量的OSD存储设备组成,它能够在动态变化的基于异质结构的存储设备集群之上提供一种稳定的、可扩展的、高性能的单一逻辑对象存储接口。 RADOS系统的架构如图所示: 我们看到,RADOS不是某种组件,而是由OSD(Object Storage Device)集群和Monitor集群组成。通常,一个RADOS系统中,OSD集群是由大量的智能化的OSD节点组成;Monitor集群是由少量的Monitor节点组成。OSD集群负责存储所有对象的数据。Monitors集群负责管理Ceph集群中所有成员、关系、属性以及数据分发等信息。

EMC VNX5700 日常维护手册

目录 第一章 VNX日常配置 (3) 1.1登陆管理界面 (3) 1.2创建R AID G ROUP (4) 1.3创建H OT S PARE (7) 1.4创建LUN (9) 1.5创建S TORAGE G ROUP (11) 1.6指派LUN (14) 1.7指派主机 (16) 第二章 VNX日常管理和维护 (18) 2.1开关机注意事项及详细步骤 (18) 2.1.1 开机前注意事项 (18) 2.1.2 关机前注意事项 (19) 2.2日常健康检查 (19) 2.3VNX报修 (20)

第一章VNX日常配置 1.1登陆管理界面 在IE窗口中输入EMC存储的地址:http://172.20.15.60 在弹出的窗口中输入帐号及密码即可登陆存储管理界面:(sysadmin/sysadmin)打开管理界面如下所示:

1.2创建Raid Group 在管理界面中选择“Storage”=》“Storage Pool”: 选择“Raid Group”标签即可显示已经创建的Raid Group:

点击“新建”可创建新的Raid Group: 在创建Raid Group窗口输入相应的参数:如Raid Type等,然后点击“select”选择需要加入到此Raid Group的硬盘: 选择需要加入到此Raid Group的硬盘后,点击“OK”:

确认加入到加入到此Raid Group的硬盘无误后,点击“应用”,在信息提示窗口点击“OK”完成Raid Group的创建: 在管理界面“storage”的“Raid Group”标签界面中即可查看创建完成的Raid Group信息:

Ceph分布式存储 1. ceph概念 Ceph作为分布式存储,它有如下特点: ?高扩展性:普通的x86服务器组成的ceph集群,最多支持1000台以上的服务器扩展,并且可以在线扩展。 ?高可靠性:数据容错性高,没有因为单点故障造成的数据丢失;多副本技术,数据安全性更加可靠;自动修复,数据丢失或者部分磁盘故障对全局没影响,不会影响上层的应用,对用户全透明。 ?高性能:数据是均匀分布到每个磁盘上的,读写数据都是有多个osd并发完成的,集群性能理论上来说随着集群节点数和osd的增长而线性增长。 2. ceph架构 2.1 组件

Ceph的底层是RADOS,它的意思是“A reliable, autonomous, distributed object storage”(一个可靠的自治的分布式存储,字面意思哈)。 RADOS系统逻辑架构图: RADOS主要由两个部分组成。一种是大量的、负责完成数据存储和维护功能的OSD(Object Storage Device),另一种则是若干个负责完成系统状态检测和维护的monitor。osd和monitor之间相互传输节点状态信息。 而ceph集群主要包括mon、mds、osd组件 其中,mon负责维护整个集群的状态以及包括crushmap、pgmap、osdmap等一系列map 信息记录与变更。 Osd负责提供数据存储,数据的恢复均衡。 Mds(元数据服务器)主要是使用文件系统存储的时候需要,它主要负责文件数据的inode 信息,并让客户端通过该inode信息快速找到数据实际所在地。 2.2 数据映射流程 在Ceph中,文件都是以object(对象)的方式存放在众多osd上。 一个file(数据)的写入顺序: 首先mon根据map信息将file(数据)切分成多个的object;再通过hash算法决定这些个object对象分别会存放在那些pg(放置组)里面;接下来在通过crushmap再决定将pg放在底层的那些osd上,pg与osd的关系属于一对多的关系。一个osd可以包括多

HDS USP设备维护管理手册 ——VER 1.0 第1章HDS USP日常检查项目 (3) 第2章操作面板 (4) 第3章设备启停 (6) 3.1正常下电步骤 (6) 3.2正常上电步骤 (6) 3.3切断电源的步骤 (6) 3.4切断电源后的上电步骤 (7) 第4章异常处理 (8) 第5章维护管理 (9) 5.1通过SVP查看SIM信息 (9) 5.2通过S TORAGE N AVIGATOR查看SIM信息 (10) 第6章HDS动态路径管理软件――HDLM基本操作 (13) 6.1HDLM命令路径 (13) 6.2DLNKMGR帮助命令 (13) 6.3DLNKMGR VIEW命令 (13) 6.4O FFLINE命令 (15) 6.5O NLINE命令 (15) 第7章HDS热线服务电话 (17)

第1章HDS USP日常检查项目

第2章操作面板 操作面板简介

第3章设备启停 3.1正常下电步骤 确认主机已停止对磁盘系统的访问。 ?Shutdown数据库; ?Umount文件系统; ?Varyoff VG。 停止使用SVP。 将操作面板的PS左边开关⑨往上拨,同时将右边的开关⑩往下拨(Enable +OFF),磁盘系统将顺序自动下电。约5分钟后,除了BS-ON⑦灯(黄色)亮以外,其它指示灯都熄灭,磁盘下电完成。 3.2正常上电步骤 将操作面板的PS左边开关⑨和右边开关⑩往上拨(Enable+ON),此时PS-ON⑧指示灯亮(绿色),磁盘系统将顺序自动上电。约5分钟后READY①灯(绿色)亮,磁盘阵列上电完成。确认控制器组件前面的Main switch处于关闭(OFF)状态(按一下Main switch off开关)。 3.3切断电源的步骤 除非需要对电源供电进行更改/改造,否则请使用上述正常上下电步骤。实施本步骤之前,请预先知会HDS公司。 执行正常下电步骤。 阵列下电完成后,关USP相应的断路器(在机柜的后面,每个机柜有两个断路器)。此时BS-ON ⑦灯(黄色)熄灭。 ***若切断电源供电超过48小时,需要在正常关机后将备份电池开关拨到Disable状态(往下拨)。 实施本步骤之前,请预先知会HDS公司。

块存储与分布式存储 块存储,简单来说就是提供了块设备存储的接口。通过向内核注册块设备信息,在Linux 中通过lsblk可以得到当前主机上块设备信息列表。 本文包括了单机块存储介绍、分布式存储技术Ceph介绍,云中的块存储Cinder,以及华为软件定义的存储解决方案。 单机块存储 一个硬盘是一个块设备,内核检测到硬盘然后在/dev/下会看到/dev/sda/。因为需要利用一个硬盘来得到不同的分区来做不同的事,通过fdisk工具得到/dev/sda1, /dev/sda2等,这种方式通过直接写入分区表来规定和切分硬盘,是最死板的分区方式。 分布式块存储 在面对极具弹性的存储需求和性能要求下,单机或者独立的SAN越来越不能满足企业的需要。如同数据库系统一样,块存储在scale up的瓶颈下也面临着scale out的需要。 分布式块存储系统具有以下特性: 分布式块存储可以为任何物理机或者虚拟机提供持久化的块存储设备; 分布式块存储系统管理块设备的创建、删除和attach/detach; 分布式块存储支持强大的快照功能,快照可以用来恢复或者创建新的块设备; 分布式存储系统能够提供不同IO性能要求的块设备。 现下主流的分布式块存储有Ceph、AMS ESB、阿里云磁盘与sheepdog等。 1Ceph 1.1Ceph概述 Ceph目前是OpenStack支持的开源块存储实现系统(即Cinder项目backend driver之一) 。Ceph是一种统一的、分布式的存储系统。“统一的”意味着Ceph可以一套存储系统同时提供对象存储、块存储和文件系统存储三种功能,以便在满足不同应用需求的前提下简化部署

Red Hat Customer Content Services Red Hat Ceph Storage 1.3Ceph Block Device Red Hat Ceph Storage Block Device

Red Hat Ceph Storage 1.3 Ceph Block Device Red Hat Ceph Storage Block Device

Legal Notice Copyright ? 2015 Red Hat, Inc. The text of and illustrations in this document are licensed by Red Hat under a Creative Commons Attribution–Share Alike 3.0 Unported license ("CC-BY-SA"). An explanation of CC-BY-SA is available at https://www.doczj.com/doc/c22349378.html,/licenses/by-sa/3.0/ . In accordance with CC-BY-SA, if you distribute this document or an adaptation of it, you must provide the URL for the original version. Red Hat, as the licensor of this document, waives the right to enforce, and agrees not to assert, Section 4d of CC-BY-SA to the fullest extent permitted by applicable law. Red Hat, Red Hat Enterprise Linux, the Shadowman logo, JBoss, MetaMatrix, Fedora, the Infinity Logo, and RHCE are trademarks of Red Hat, Inc., registered in the United States and other countries. Linux ? is the registered trademark of Linus Torvalds in the United States and other countries. Java ? is a registered trademark of Oracle and/or its affiliates. XFS ? is a trademark of Silicon Graphics International Corp. or its subsidiaries in the United States and/or other countries. MySQL ? is a registered trademark of MySQL AB in the United States, the European Union and other countries. Node.js ? is an official trademark of Joyent. Red Hat Software Collections is not formally related to or endorsed by the official Joyent Node.js open source or commercial project. The OpenStack ? Word Mark and OpenStack Logo are either registered trademarks/service marks or trademarks/service marks of the OpenStack Foundation, in the United States and other countries and are used with the OpenStack Foundation's permission. We are not affiliated with, endorsed or sponsored by the OpenStack Foundation, or the OpenStack community. All other trademarks are the property of their respective owners. Abstract This document describes how to manage create, configure and use Red Hat Ceph Storage block devices.

Greenplum 日常维护手册 1.数据库启动:gpstart 常用可选参数:-a : 直接启动,不提示终端用户输入yes确认 -m:只启动master 实例,主要在故障处理时使用 2.数据库停止:gpstop: 常用可选参数:-a:直接停止,不提示终端用户输入确认 -m:只停止master 实例,与gpstart –m 对应使用 -M fast:停止数据库,中断所有数据库连接,回滚正在运 行的事务 -u:不停止数据库,只加载pg_hba.conf 和postgresql.conf中 运行时参数,当改动参数配置时候使用。 -f:强制停止数据库 -r:重启数据库 3.查看实例配置和状态 select * from gp_configuration order by 1 ; select * from gp_configuration_history order by 1 ; 主要字段说明: Content:该字段相等的两个实例,是一对P(primary instance)和M(mirror Instance) Isprimary:实例是否作为primary instance 运行 Valid:实例是否有效,如处于false 状态,则说明该实例已经down 掉。 Port:实例运行的端口 Datadir:实例对应的数据目录 注 4.0后,实例配置的数据表:gp_segment_configuration 、pg_filespace_entry、gp_fault_strategy;

其它常用的系统表:pg_class,pg_attribute,pg_database,pg_tables…… 可以用tab来匹配表名; 4.gpstate :显示Greenplum数据库运行状态,详细配置等信息 常用可选参数:-c:primary instance 和mirror instance 的对应关系 -m:只列出mirror 实例的状态和配置信息 -f:显示standby master 的详细信息 -s:查看详细状态,如在同步,可显示数据同步完成百分比 --version,查看数据库version (也可使用pg_controldata查看数据库版本和postgresql版本)该命令默认列出数据库运行状态汇总信息,常用于日常巡检。 5.查看用户会话和提交的查询等信息 select * from pg_stat_activity该表能查看到当前数据库连接的IP 地址,用户 名,提交的查询等。另外也可以在master 主机上查看进程,对每个客户端连接,master 都会创建一个进程。ps -ef |grep -i postgres |grep -i con pg_backend_pid(); pg_cancel_backend(integer) 6.查看数据库、表占用空间 select pg_size_pretty(pg_relation_size('schema.tablename'));(与pg_tables子查询查看所有表的占用空间) select pg_size_pretty(pg_database_size('databasename)); 必须在数据库所对应的存储系统里,至少保留30%的自由空间,日常巡检,要检查存储空间的剩余容量。 7.收集统计信息,回收空间 定期使用Vacuum analyze tablename 回收垃圾和收集统计信息,尤其在大数据量删除,导入以后,非常重要、需要定期对数据字典做vacuum和reindex ,如 pg_class,pg_attribute等系统表。 可以gp_toolkit.gp_bloat_diag看膨胀很大的表; 8.查看数据分布情况