HITS算法的二部图实现

- 格式:doc

- 大小:81.00 KB

- 文档页数:13

网络爬虫工作原理1 聚焦爬虫工作原理及关键技术概述网络爬虫是一个自动提取网页的程序,它为搜索引擎从Internet网上下载网页,是搜索引擎的重要组成。

传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

聚焦爬虫的工作流程较为复杂,需要根据一定的网页分析算法过滤与主题无关的链接,保留有用的链接并将其放入等待抓取的URL队列。

然后,它将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止,另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索;对于聚焦爬虫来说,这一过程所得到的分析结果还可能对以后的抓取过程给出反馈和指导。

相对于通用网络爬虫,聚焦爬虫还需要解决三个主要问题:(1) 对抓取目标的描述或定义;(2) 对网页或数据的分析与过滤;(3) 对URL的搜索策略。

抓取目标的描述和定义是决定网页分析算法与URL搜索策略如何制订的基础。

而网页分析算法和候选URL排序算法是决定搜索引擎所提供的服务形式和爬虫网页抓取行为的关键所在。

这两个部分的算法又是紧密相关的。

2 抓取目标描述现有聚焦爬虫对抓取目标的描述可分为基于目标网页特征、基于目标数据模式和基于领域概念3种。

基于目标网页特征的爬虫所抓取、存储并索引的对象一般为网站或网页。

根据种子样本获取方式可分为:(1)预先给定的初始抓取种子样本;(2)预先给定的网页分类目录和与分类目录对应的种子样本,如Yahoo!分类结构等;(3)通过用户行为确定的抓取目标样例,分为:a) 用户浏览过程中显示标注的抓取样本;b) 通过用户日志挖掘得到访问模式及相关样本。

其中,网页特征可以是网页的内容特征,也可以是网页的链接结构特征,等等。

现有的聚焦爬虫对抓取目标的描述或定义可以分为基于目标网页特征,基于目标数据模式和基于领域概念三种。

图数据处理中的图挖掘与关键节点识别技术研究图数据处理是指对图结构的数据进行分析、挖掘和可视化的过程,其中图挖掘和关键节点识别是图数据处理中的重要技术。

一、图挖掘技术图挖掘是指从图数据中发现潜在的模式、规律和知识的过程。

图挖掘技术可以分为图模式挖掘和图分类挖掘两个方面。

1. 图模式挖掘图模式挖掘主要是从图数据中发现频繁出现的子图结构,如图中的子图、路径、圈等。

这些子图结构可能代表了一些重要的模式或特征,在社交网络分析、生物信息学、计算机视觉等领域有广泛的应用。

常用的图模式挖掘算法包括Apriori算法、FP-Growth算法和GSpan算法等。

Apriori算法是一种基于频繁项集的挖掘方法,通过迭代的方式挖掘出频繁子图;FP-Growth算法是一种基于前缀树的挖掘方法,通过构建频繁子图的树形结构来提高挖掘效率;GSpan算法是一种基于图搜索的挖掘方法,通过遍历图数据中的所有可能子图来发现频繁子图。

2. 图分类挖掘图分类挖掘主要是将图数据进行分类,即根据图的属性和拓扑结构将其归类到不同的类别中。

图分类挖掘可应用于推荐系统、网络安全和图像识别等领域。

常用的图分类挖掘算法包括最近邻算法、支持向量机和神经网络等。

最近邻算法通过将待分类图与已知类别图进行相似度计算,将其归类到最相似的类别中;支持向量机采用超平面划分图数据空间,实现分类目标;神经网络通过训练神经元之间的权值来实现图分类。

二、关键节点识别技术关键节点识别是指从图数据中识别出对整个网络结构具有重要影响力的节点。

关键节点的识别对于理解网络的拓扑结构、控制网络的传播过程以及防止网络攻击具有重要意义。

关键节点的识别可以基于节点的度中心性、介数中心性、紧密中心性和特征向量中心性等指标进行。

1. 度中心性度中心性指节点的度数,即与该节点相连接的边的数量。

度中心性高的节点在图中具有很大的影响力,通常被认为是关键节点。

2. 介数中心性介数中心性指节点在所有最短路径中作为中间节点的频率。

一文读懂社会网络分析(SNA)理论、指标与应用开新坑!社交网络分析(又称复杂网络、社会网络,Social Network Analysis)是诞生于数学图论、计算机科学、物理学的交叉碰撞中的一门有趣的学科。

缘起:我研究SNA已经有近2年的时光,一路坎坷走来有很多收获、踩过一些坑,也在线上给很多学生讲过SNA的入门知识,最近感觉有必要将心得和基础框架分享出来,抛砖引玉,让各位对SNA感兴趣的同学们一起学习进步。

我的能力有限,如果有不足之处大家一起交流,由于我的专业的影响,本文的SNA知识可能会带有情报学色彩。

面向人群:优先人文社科类的无代码学习,Python、R的SNA 包好用是好用,但是对我们这这些社科的同学来说门槛太高,枯燥的代码首先就会让我们丧失学习兴趣。

特征:类综述文章,主要目的是以通俗的语言和精炼的框架带领各位快速对SNA领域建立起一个全面的认知,每个个关键概念会附上链接供感兴趣的同学深入学习。

开胃菜:SNA经典著作分享《网络科学引论》纽曼 (访问密码 : v9d9g3)2 概述篇:什么是网络?我们从哪些角度研究它?1) 认识网络SNA中所说的网络是由节点(node,图论中称顶点vertex)和边(edge)构成,如下图。

每个节点代表一个实体,可以是人、动物、关键词、神经元;连接各节点的边代表一个关系,如朋友关系、敌对关系、合作关系、互斥关系等。

最小的网络是由两个节点与一条边构成的二元组。

Les Miserables人际关系网络2) 构建网络就是建模马克思说过,“人的本质在其现实性上,它是一切社会关系的总和。

” 事实上,当我们想快速了解一个领域,无论该领域是由人、知识、神经元乃至其他实体集合构成,利用SNA的方法将实体及其相互关系进行抽象和网络构建,我们就完成了对某一领域的“建模”,这个模型就是网络图,拿科学网络计量学家陈超美的观点来说,借助网络图,“一图胜千言,一览无余”。

3) 社会网络类型此处展示常见且常用的网络类型名词,想要具体了解可以点击链接仔细查看!•网络中节点的来源集合异同o一模网络 one-modeo二模网络 two-mode•视角:•边权重o加权网络 weight networko无权网络 unweight networko符号网络 Signed network•关系是否有方向o有向网络 Directed networko无向网络 Undirected network4) 网络分析的5大中心问题SNA可以帮助我们快速了解该网络中的分布格局和竞争态势,“孰强孰弱,孰亲孰远,孰新孰老,孰胜孰衰”,这16字箴言是我学习SNA总结的精华所在,初中级甚至高级的社会网络分析学习几乎完全就是围绕着这四个方面开展,后面将要讲到的理论与方法皆为此服务,希望同学们可以重点关注。

短视频推荐算法研究与实现随着手机拍摄技术的不断升级和互联网的普及,短视频成为了一种特别流行的娱乐方式。

无论是抖音、快手、还是火山小视频,都在市场上占据了重要的位置。

而短视频的推荐算法则成为了这个行业的重要基石。

本文将从短视频推荐算法的优化入手,探讨其中的一些技术实现和应用场景。

一、短视频推荐算法涉及的技术短视频推荐算法主要借鉴了其他推荐系统的技术,比如搜索引擎、电商平台和社交媒体。

以下是其中一些常见技术:1. 排序算法排序算法是一种常用的推荐算法,将原始数据根据一定的规则进行排序,从而给用户推荐最合适的视频。

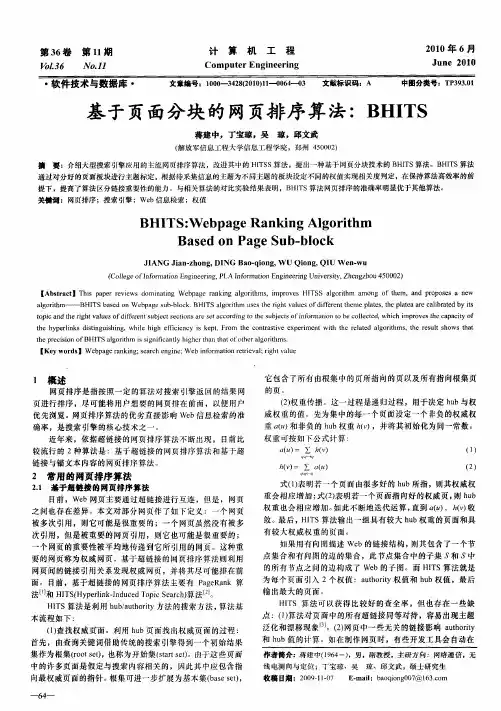

部分排序算法如PageRank和HITS利用链接分析原理,将节点之间的链接关系看作投票,再用极值的方法对节点进行排序。

这种算法强调了网页之间的互相影响,并在搜索引擎中得到广泛应用。

2. 矩阵分解矩阵分解是一种基于矩阵运算的推荐算法,可以处理大规模的数据并进行优化。

下面是一个简单的例子:如果某个用户喜欢A和B,另一个用户喜欢B和C,那么我们可以将这些偏好组成一个矩阵,并将其分解为两个矩阵(用户矩阵和项目矩阵)。

这样就能为每个用户提供推荐的内容,而且这种方法在电商和视频网站中得到广泛应用。

3. 基于标签的推荐标签是加在文本或其他资源上以便于搜索和分类的关键词或短语,常用于内容管理和信息检索。

在视频推荐中,标签可以分为诸如时长、内容、主题等类别。

通过对标签的处理,我们可以精确地分析用户的需求,并为每个用户提供个性化的推荐。

二、短视频推荐算法的应用场景在短视频领域,推荐算法是一个相对比较新的领域,但已经得到广泛应用。

以下是短视频推荐算法的四个常见应用场景:1. 用户兴趣推荐对于大多数短视频应用来说,用户兴趣推荐是最基本的推荐服务,需要根据用户的行为和看法,为其提供最合适的推荐视频。

在这种情况下,用户的兴趣可以通过历史观看行为、点赞和评论等参数进行评估。

2. 相似推荐相似推荐是一种利用用户特定行为和喜好,为其推荐与已知兴趣相似的内容的推荐服务。

一文读懂社会网络分析(SNA)理论、指标与应用开新坑!社交网络分析(又称复杂网络、社会网络,Social Network Analysis)是诞生于数学图论、计算机科学、物理学的交叉碰撞中的一门有趣的学科。

缘起:我研究SNA已经有近2年的时光,一路坎坷走来有很多收获、踩过一些坑,也在线上给很多学生讲过SNA的入门知识,最近感觉有必要将心得和基础框架分享出来,抛砖引玉,让各位对SNA感兴趣的同学们一起学习进步。

我的能力有限,如果有不足之处大家一起交流,由于我的专业的影响,本文的SNA知识可能会带有情报学色彩。

面向人群:优先人文社科类的无代码学习,Python、R的SNA 包好用是好用,但是对我们这这些社科的同学来说门槛太高,枯燥的代码首先就会让我们丧失学习兴趣。

特征:类综述文章,主要目的是以通俗的语言和精炼的框架带领各位快速对SNA领域建立起一个全面的认知,每个个关键概念会附上链接供感兴趣的同学深入学习。

开胃菜:SNA经典著作分享《网络科学引论》纽曼 (访问密码 : v9d9g3)2概述:什么是网络?我们从哪些角度研究它?1) 认识网络SNA中所说的网络是由节点(node,图论中称顶点vertex)和边(edge)构成,如下图。

每个节点代表一个实体,可以是人、动物、关键词、神经元;连接各节点的边代表一个关系,如朋友关系、敌对关系、合作关系、互斥关系等。

最小的网络是由两个节点与一条边构成的二元组。

Les Miserables人际关系网络2) 构建网络就是建模马克思说过,“人的本质在其现实性上,它是一切社会关系的总和。

” 事实上,当我们想快速了解一个领域,无论该领域是由人、知识、神经元乃至其他实体集合构成,利用SNA的方法将实体及其相互关系进行抽象和网络构建,我们就完成了对某一领域的“建模”,这个模型就是网络图,拿科学网络计量学家陈超美的观点来说,借助网络图,“一图胜千言,一览无余”。

3) 社会网络类型这里展示了常见和常用的网络类型名词。

elasticsearch中的geo_distance实现具体算法详解全文共四篇示例,供读者参考第一篇示例:Elasticsearch是一个流行的开源分布式搜索引擎,它被广泛用于构建高性能、可扩展的搜索应用程序。

其中一个重要的组件是geo_distance功能,它支持地理位置搜索,可以计算两个地理坐标之间的距离。

在本文中,我们将深入研究geo_distance的具体算法实现细节。

一、geo_distance功能概述geo_distance是Elasticsearch的一个核心功能,用于计算地理坐标之间的距离。

通常情况下,我们会将经纬度坐标传入geo_distance 函数,然后它会返回两个坐标之间的距离,单位可以是千米或者英里。

geo_distance功能可以在查询时使用,用于筛选出与给定地理位置距离在一定范围内的文档。

geo_distance的算法实现主要基于球面三角法,这是一种计算地球表面两点之间距离的经典方法。

根据地球的球体特性,我们可以将两个地理坐标视为该球体的两个点,然后通过球面三角形来计算它们之间的距离。

具体步骤如下:1. 将经纬度坐标转化为弧度在计算地球球面距离时,需要将地理坐标的经纬度值转化为弧度。

经度范围是-180到180度,纬度范围是-90到90度。

通过将度数乘以π/180,我们可以将经纬度转化为弧度。

2. 计算球面距离利用球面三角法,我们可以计算出两个坐标之间的球面距离。

根据大圆弧长度公式,我们可以使用余弦定理来计算出两个经纬度坐标之间的弧长,然后通过球半径来将弧长转化为实际距离。

3. 实际距离转化根据实际需求将距离单位转化为千米或者英里。

通常情况下,我们会使用地球平均半径作为球半径进行计算。

三、示例代码实现下面是一个简单的示例代码,展示了如何使用geo_distance功能计算两个地理坐标之间的距离:```pythonfrom elasticsearch import Elasticsearch# 定义地理位置A和B的经纬度坐标location_a = {"lat": 40.73, "lon": -73.93}location_b = {"lat": 37.77, "lon": -122.41}# 使用geo_distance功能计算两个地理坐标之间的距离res = es.search(index="places", body={"query": {"geo_distance": {"distance": "200km","location": {"lat": location_a["lat"],"lon": location_a["lon"]}}}})# 打印查询结果for hit in res['hits']['hits']:print(hit['_source'])```在这个示例中,我们首先连接到Elasticsearch服务,然后定义了两个地理位置A和B的经纬度坐标。

面向Web的数据挖掘技术[摘要] 随着internet的发展,web数据挖掘有着越来越广泛的应用,web数据挖掘是数据挖掘技术在web信息集合上的应用。

本文阐述了web数据挖掘的定义、特点和分类,并对web数据挖掘中使用的技术及应用前景进行了探讨。

[关键词] 数据挖掘web挖掘路径分析电子商务一、引言近年来,数据挖掘引起了信息产业界的极大关注,其主要原因是存在大量数据,可以广泛使用,并且迫切需要将这些数据转换成有用的信息和知识。

数据挖掘是面向发现的数据分析技术,通过对大型的数据集进行探查。

可以发现有用的知识,从而为决策支持提供有力的依据。

web目前已成为信息发布、交互和获取的主要工具,它是一个巨大的、分布广泛的、全球性的信息服务中心。

它涉及新闻、广告、消费信息、金融管理、教育、政府、电子商务和其他许多信息服务。

面向web的数据挖掘就是利用数据挖掘技术从web文档及web服务中自动发现并提取人们感兴趣的、潜在的有用模型或隐藏的信息。

二、概述1.数据挖掘的基本概念数据挖掘是从存放在数据库、数据仓库、电子表格或其他信息库中的大量数据中挖掘有趣知识的过程。

数据挖掘基于的数据库类型主要有: 关系型数据库、面向对象数据库、事务数据库、演绎数据库、时态数据库、多媒体数据库、主动数据库、空间数据库、遗留数据库、异质数据库、文本型、internet 信息库以及新兴的数据仓库等。

2.web数据挖掘web上有少量的数据信息,相对传统的数据库的数据结构性很强,即其中的数据为完全结构化的数据。

web上的数据最大特点就是半结构化。

所谓半结构化是相对于完全结构化的传统数据库的数据而言。

由于web的开放性、动态性与异构性等固有特点,要从这些分散的、异构的、没有统一管理的海量数据中快速、准确地获取信息也成为web挖掘所要解决的一个难点,也使得用于web的挖掘技术不能照搬用于数据库的挖掘技术。

因此,开发新的web挖掘技术以及对web文档进行预处理以得到关于文档的特征表示,便成为web挖掘的重点。

JAVA基于图⽚相似性算法实现以图搜图样例⼀、简述 本⽂主要讲如何利⽤图⽚相似性算法,基于LIRE来实现图⽚搜索。

⼆、依赖<dependencies><!-- https:///artifact/org.apache.lucene/lucene-core --><dependency><groupId>org.apache.lucene</groupId><artifactId>lucene-core</artifactId><version>6.3.0</version></dependency><!-- https:///artifact/org.apache.lucene/lucene-queryparser --><dependency><groupId>org.apache.lucene</groupId><artifactId>lucene-queryparser</artifactId><version>6.3.0</version></dependency><!-- https:///artifact/org.apache.lucene/lucene-analyzers-common --><dependency><groupId>org.apache.lucene</groupId><artifactId>lucene-analyzers-common</artifactId><version>6.3.0</version></dependency><!-- https:///artifact/commons-io/commons-io --><dependency><groupId>commons-io</groupId><artifactId>commons-io</artifactId><version>2.6</version></dependency><!-- https:///artifact/mons/commons-math3 --><dependency><groupId>mons</groupId><artifactId>commons-math3</artifactId><version>3.6.1</version></dependency><!-- https:///artifact/com.sangupta/jopensurf --><dependency><groupId>com.sangupta</groupId><artifactId>jopensurf</artifactId><version>1.0.0</version></dependency></dependencies>⼆、样例1 Data⽬录下存放所有图⽚的样本。

集成学习算法总结----Boosting和Bagging集成学习基本思想:如果单个分类器表现的很好,那么为什么不适⽤多个分类器呢?通过集成学习可以提⾼整体的泛化能⼒,但是这种提⾼是有条件的:(1)分类器之间应该有差异性;(2)每个分类器的精度必须⼤于0.5;如果使⽤的分类器没有差异,那么集成起来的分类结果是没有变化的。

如下图所⽰,分类器的精度p<0.5,随着集成规模的增加,分类精度不断下降;如果精度⼤于p>0.5,那么最终分类精度可以趋向于1。

接下来需要解决的问题是如何获取多个独⽴的分类器呢?我们⾸先想到的是⽤不同的机器学习算法训练模型,⽐如决策树、k-NN、神经⽹络、梯度下降、贝叶斯等等,但是这些分类器并不是独⽴的,它们会犯相同的错误,因为许多分类器是线性模型,它们最终的投票(voting)不会改进模型的预测结果。

既然不同的分类器不适⽤,那么可以尝试将数据分成⼏部分,每个部分的数据训练⼀个模型。

这样做的优点是不容易出现过拟合,缺点是数据量不⾜导致训练出来的模型泛化能⼒较差。

下⾯介绍两种⽐较实⽤的⽅法Bagging和Boosting。

Bagging(Bootstrap Aggregating)算法Bagging是通过组合随机⽣成的训练集⽽改进分类的集成算法。

Bagging每次训练数据时只使⽤训练集中的某个⼦集作为当前训练集(有放回随机抽样),每⼀个训练样本在某个训练集中可以多次或不出现,经过T次训练后,可得到T个不同的分类器。

对⼀个测试样例进⾏分类时,分别调⽤这T个分类器,得到T个分类结果。

最后把这T个分类结果中出现次数多的类赋予测试样例。

这种抽样的⽅法叫做,就是利⽤有限的样本资料经由多次重复抽样,重新建⽴起⾜以代表原始样本分布之新样本。

Bagging算法基本步骤:因为是随机抽样,那这样的抽样只有63%的样本是原始数据集的。

Bagging的优势在于当原始样本中有噪声数据时,通过bagging抽样,那么就有1/3的噪声样本不会被训练。

package extrcting; import java.io.*; import java.util.ArrayList; import java.util.HashMap; import java.util.HashSet; import java.util.Iterator;

public class HITS { //public ArrayList facet ; public HashMap> graphFacet;//没有必要采用hashset,因为反正都得遍历 public HashMap> graphEmo; public HashMap authScore; //每个节点的中心度 public HashMap centerScore; //每个节点的权威度

public HashMap edgeGraph; //边得信息,暂时没用上 public HashMap wordLex; // 词表,记录词语出现的次数 public HashSet Lexicon;

public HashMap facetScoreA; public HashMap facetScoreC; public HashMap emoScoreA; public HashMap emoScoreC; public final String data="20110317";

public Integer nounCount=0; public Integer emoCount=0;

public Integer nounCountEmo=0; public Integer emoCountEmo=0;

public int rowNumber;//所有行 public int rowNumberEmo=0;;//所有含有情感词的行

public HITS() throws IOException //构造函数 {

BufferedReader reader = new BufferedReader(new InputStreamReader(new FileInputStream("Lexicon.txt"))); String words=""; rowNumber=0; Lexicon = new HashSet(5000); authScore= new HashMap(10000); //每个节点的中心度 centerScore = new HashMap (10000); graphFacet = new HashMap>(); graphEmo = new HashMap>(); wordLex = new HashMap(); facetScoreA = new HashMap(5000); facetScoreC = new HashMap(5000); emoScoreA = new HashMap(5000); emoScoreC = new HashMap(5000);

while((words=reader.readLine())!=null) { Lexicon.add(words+"/n"); } extract(); // doHITS(); // finalScore();

// double averageNoun = nounCount/(double)rowNumber; // double averageEmo = emoCount/(double)rowNumber; // double averageNounEmo = nounCountEmo/(double)rowNumberEmo; // double averageEmoEmo = emoCountEmo/(double)rowNumberEmo; // System.out.println("名词个数"+nounCount); // System.out.println("情感词个数"+emoCount); // System.out.println("平均名词个数"+averageNoun); // System.out.println("平均情感词个数"+averageEmo); // System.out.println("所有行数"+rowNumber); // System.out.println("有情感的行数"+rowNumberEmo); // System.out.println("情感句平均名词个数"+averageNounEmo); // System.out.println("情感句平均情感词个数"+averageEmoEmo);

} public void doHITS() throws IOException { int iterOver=0; //代表迭代结束 final int iterTime = 1000; //迭代次数 int count =0; //计数,迭代次数

// File log = new File("E:\\HITSlog");//日志主要是查看盐的相关信息的 // if(log.exists()) // { // log.delete(); // } // log.createNewFile(); // FileWriter write = new FileWriter(log); // BufferedWriter bw = new BufferedWriter(write);

int codeNumber = authScore.size(); //while(iterOver!=1) while(iterOver!=1&&count{ double authMax=.0; double centerMax=.0;//新的归一化算法

double authSum =.0; double centerSum =.0;//用于归一化 HashMap authScoreLast= new HashMap(authScore); //做实验表明,必须new,不new存的是地址 HashMap centerScoreLast = new HashMap(centerScore);

System.out.println("第"+count+"迭代"+"节点数"+codeNumber+"个"); Iterator iteratorFacet =graphFacet.keySet().iterator();//对属性部分遍历 while(iteratorFacet.hasNext()) { String sFacet =""; sFacet = (String) iteratorFacet.next(); ArrayList iterEmoArray = new ArrayList(graphFacet.get(sFacet)); Double authScoreArray=.0; Double centerScoreArray =.0; for(int i=0;i/* * 每个点的中心度是各个点的权威度之和 * 每个点的权威度是各个点的中心度之和 */ { // if(sFacet.equals("盐/n")) // { // bw.write(iterEmoArray.get(i)); // bw.newLine(); // bw.flush(); // } authScoreArray = authScoreArray + centerScoreLast.get(iterEmoArray.get(i)); authSum = authSum + centerScoreLast.get(iterEmoArray.get(i)); centerScoreArray = centerScoreArray + authScoreLast.get(iterEmoArray.get(i)); centerSum = centerSum + authScoreLast.get(iterEmoArray.get(i)); } authScore.put(sFacet, authScoreArray); centerScore.put(sFacet, centerScoreArray);

if(authScoreArray>authMax)//新归一化 { authMax = authScoreArray; } if(centerScoreArray>centerMax) { centerMax = centerScoreArray; }

}

Iterator iteratorEmo =graphEmo.keySet().iterator();//对情感部分遍历 while(iteratorEmo.hasNext()) { String sEmo =""; sEmo = (String) iteratorEmo.next(); ArrayList iterFacetArray = new ArrayList(graphEmo.get(sEmo)); Double authScoreArray=.0; Double centerScoreArray =.0; for(int i=0;i/* * 每个点的中心度是各个点的权威度之和 * 每个点的权威度是各个点的中心度之和 */ { authScoreArray = authScoreArray + centerScoreLast.get(iterFacetArray.get(i)); authSum = authSum + centerScoreLast.get(iterFacetArray.get(i)); centerScoreArray = centerScoreArray + authScoreLast.get(iterFacetArray.get(i)); authScoreLast.get(iterFacetArray.get(i)); } authScore.put(sEmo, authScoreArray);