病态嗓音特征的小波变换提取及识别研究

于燕平

胡维平

,

摘 要:通过分析嗓音的发音机理、病态嗓音与正常嗓音在频域的表现差异,利用小波变换对信号进行分解,突出病态嗓音的特点,本文提出了基于多尺度分析的小波降噪、分解的熵系数(Entropy Coefficient based on De-noise ,Decomposition of Multi-scale Analysis, ECDDMA )作为识别的特征矢量集。并对比分析了语音识别中经典特征参数Mel 倒谱系数(MFCC ),分别运用这两种特征参数对242例正常嗓音和234例病态嗓音运用高斯混合模型(GMM )进行了识别。结果显示:ECDDMA 系数较传统的模拟人耳听觉非线性特性的MFCC 及其动态特征能更准确的表征正常与病态嗓音之间的差异,有利于同时提高病态和正常嗓音的识别率。

关键词: 高斯混合模型(GMM );病态嗓音; Mel 倒谱系数(MFCC );小波变换 1引言

声带的各种病理性改变导致其振动和闭合异常,使得喉声源声学性质发生改变,出现不同程度的声音嘶哑[1]。目前国内较为常用的喉功能检查方法是利用计算机技术,采用 Dr.speech 软件进行正常嗓音及病态嗓音的多种声学参数分析,同时和电声图结合能进一步地对基频(F0)、频率微扰 (Jitter)、振幅微扰(Shimmer)、规范化噪声能量(NNE)等各种声学参数进行检测,但它们在有效检测病态嗓音方面都存在一定局限[2][3]。而计算机病态嗓音识别方法对临床实现无痛无损伤化嗓音检查具有重要的意义[4]。

语音信号是一种非线性、非平稳的信号,以往求取特征的方法都是通过加窗傅立叶变换,这种变换最大的缺点就是不能同时提高时间与频率的分辨率,而小波变换则可以很好的克服这个缺点,它可以灵活的调整时-频窗,同时对时频分辨率作出贡献。在传统计算机语音识别方法中,因MFCC 能比较充分利用人耳特殊感知特性而获得了广泛的应用[5],但有分析认为人耳在最初识别声音时使用的是小波变换[6],结合病态嗓音在不同频率范围表现的差异[7],本文提出了基于多尺度分析的小波降噪、分解的熵系数(Entropy Coefficient based on De-noise, Decomposition of Multi-scale Analysis, ECDDMA ),并用实验证明了ECDDMA 在病态嗓音识别中与传统特征相比的优越性。近年来,HMM 广泛的用于语音识别,神经网络也被用于病态嗓音评估[8],作为状态数为1的连续型 HMM 的高斯混合模型(GMM )也同样得到了广泛的应用。由于在一个状态中可以包含多个 高斯密度函数, 不存在状态转移概率,因此在计算量上GMM 就比HMM 要小得多。使用GMM 对病态嗓音和正常嗓音尝试识别率。特征使用目前

广泛应用于语音识别的MFCC 参数及提出的ECDDMA 参数,并比较其识别效果。 2 数据来源

本文实验数据来源于临床病例,采集数据时的环境要求在安静的室内进行;采样频率为16kHz ,时间1.5s 至3s ;受试声样为汉语元音‘a ’,分别对正常人和患有各类喉科疾病的对象进行语音采样。正常对照组242例,年龄18—40周岁,平均年龄25周岁,经询问近期无喉部疾病者;病态嗓音组234例,年龄15—50周岁,平均年龄27周岁,为前来医院就诊临床病例。采集后用cooledit 软件进行语音分割,得到实验用语音库。

3 高斯混合模型(GMM )

GMM 作为高斯概率密度函数的一个线性组合,只要有足够数目的混合分量,就可以逼近任意一种密度函数。一个M 阶混合高斯模型的概率密度函数是由M 个高斯概率密度函数加权求和得到的,所示如下:

∑==M

i i i X b X P 1

)()(ω (1)

其中,X 是一个D 维随机向量,M i X b t i ,,1),( =是子分布,i ω,M i ,,1 =,是混合权重。每个

子分布是D 维的联合高斯概率分布,可表示为:

???

???-∑--∑=

∑-)()(21exp )2(1

),,(1i i t i i

D i i t X X x N μμπμ (2)

其中i μ代表此密度函数的均值向量,i ∑则代表此密度函数的协方差矩阵,混合权重需满足:

1=∑M

i

i

ω

(3)

完整的混合高斯模型有参数表示为:

M i i i i ,,1},,,{ =∑=μωλ (4)

GMM 模型参数估计最常用的参数估计方法是最大似然(Maximum Likelihood,简称为ML )估计。对于一组长度为T 的训练矢量序列,,,2,1},{T t X X t ==GMM 的似然度可以表示为: ∏==

T

t t

X

P X P 1

)/()(λλ (5)

由于上式是参数λ的非线性函数,很难直接求出上式的最大值。因此,常常采用EM (Expection Maximization,简称为EM )算法估计参数λ。对于多观察序列迭代的ML 重估公式为:

∑∑∑∑∑======

K

k c c T t c t

c

c T t c t

k c c

k k 111

11

)

()

(γ

γ

ω (6)

∑∑∑∑=====

c c T t c t

c

t c c T t c t k c c

k x k 1111)

()(γ

γ

μ (7)

∑∑∑∑====-=

∑c

c T t c t

k c t c

c T t c t

k c

c

k x k 11

2

11

)

()()(γ

μγ

(8)

其中c 为观察序列的数目,c T 是模型的第c 个观察序列的长度,)(k c

t γ是第c 个观察序列的第k 个混合

成分在时间t 是的概率:

∑=∑∑=

K

k k k c t k k c t c t

x

N x N k 1

)

,,()

,,()(μμγ (9)

4 基于小波变换的特征提取

4.1 二进离散小波变换原理及其Mallat 算法

为了便于计算机的处理,在对嗓音信号进行小波分析时,不仅对尺度参数a 和时移参数b 进行离散化处理,而且信号在时间上也是离散的,并表示为))((Z n n f ∈,这种情况下的母小波和相应的小波都

应该是离散时间的,分别用)(n ψ和)(,n k

j ψ

表示,

)2(2)(2/,k n n j j k j -=--ψψZ k j ∈, (10)

则

)(n f 关于)(,n k

j ψ

的离散二进小波变换((DWT)表示为

)()(),2(,n n f k f DWT k

j n j

ψ

ψ∑∞

-∞

==

)2

()(2

2

/k n n f j

n j -=-∞

-∞

=-∑ψZ k j ∈, (11)

其中)(,n k

j ψ

是)(,n k

j ψ的共轭。

Mallat 分解算法数学式为:

??

???-=-=-=-=∑∑+-+k j

j k j N j j M j n k g k s n d n n k h k s n s 1

,,1,0),2()()(12,,1,0),2()()(11 (12) 式中,)(k h 、)(k g 为分解低通H 、高通滤波器G 的冲激响应;M 为分解层数;j

s 、j

d 分别为第j 尺度

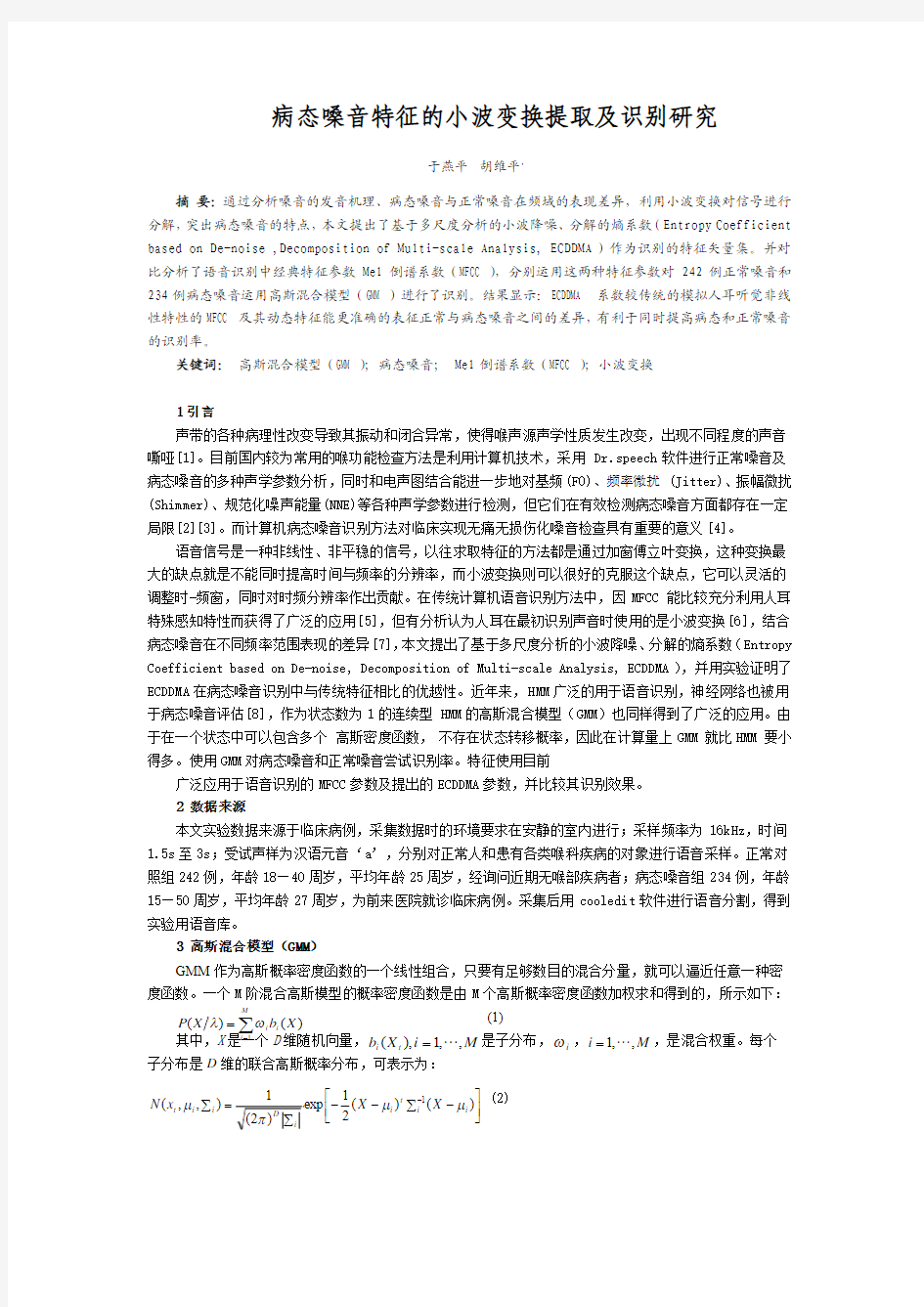

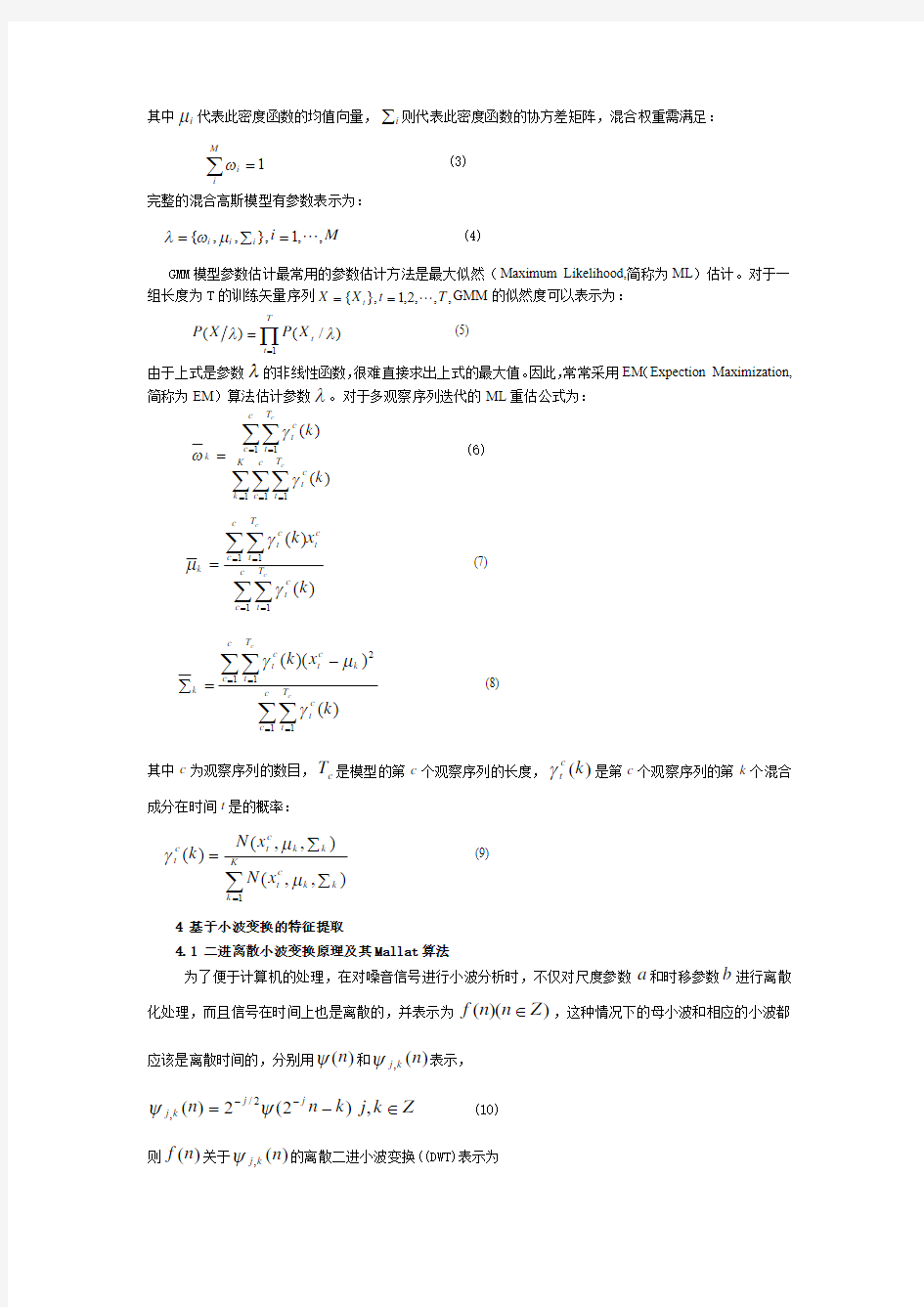

下的近似系数和细节系数,如图1。 Mallat 算法重构示意见图2,重构式为: ,

)}(]2[)(]2[{11∑++++-+-=k

j j j

k d k n g k s k n h s

0,,2,1 --=M M j

(13) 式中,)(k h

+

、)(k g +为重构低通、高通滤波器的冲激响应。

s

d

图2 离散小波的重构算法

4.2 特征提取

由于声带病理性的改变,其振动与闭合异常将导致产生的嗓音中存在的噪声随着症状的加重而不断的增多。文献[9]中提到:轻度喉病对声带振动的影响的是噪声首先在>1700Hz 的频谱高端出现,随着病情的加重,噪声才逐步出现在低于1700Hz 的频段中。在病情发展过程中(在发展到非常严重之前),一般低频段谐波都能保持正常,基本上极少有噪声出现。因此在病情发展初期噪声增加不是很明显的情况下,时域上

病态与正常嗓音差异甚微,要直接判断出病态与正常嗓音就显得非常的困难。通过以上对病态嗓音特性的分析,我们完全可以有理由认为如果对病态嗓音与正常嗓音进行滤波的预处理,可以突出其频域的区别。考虑到信号和噪声在小波域中有不同的形态表现,它们的小波系数幅值随尺度变化的趋势不同,随着尺度的增加,噪声系数的幅值很快衰减为零,而真实信号系数的幅值基本不变,本文采用小波阈值降噪的方法进行预滤波处理。

由于正常嗓音与病态嗓音之间的这些差别及噪声随着小波分解层数增加而迅速衰减的特性,本文首先对语音进行小波降噪预处理,提取出降噪后的语音,根据正常与病态语音能量集中的频段不同,其在各频段表现出的不稳定性也不同,这里再对降噪后语音作小波分解,分解出信号的各频率细节,为了更加准确的描述正常与病态嗓音的各频段幅度变化的差别,我们将不使用求方差的作法,而采用一种描述复杂度的量-近似熵[10]。

由于ECDDMA参数的求取是基于小波变换,而小波变换本身是一个灵活的时-频窗,它不需像以往的方法做加窗处理来满足语音的短时平稳性,因此在这种方法中不需要对语音信号分帧。有实验表明去噪的效果与选取的小波和阈值有关,硬阈值在逼近程度方面要优于软阈值,而在光滑程度方面却劣于软阈值[11],由于硬阈值难以确定,本文去噪时选取软阈值。ECDDMA参数提取过程如下:

(1)对输入语音X使用sym8小波对语音进行5层分解,返回小波分解向量C及相应的记录向量L;

(2)对小波分解后的信号的细节系数作软阈值自动降噪,重构降噪后的有用信号Xd;

(3)对降噪后的信号用db4小波做小波分解(本文对小波做10层分解),求取低频系数向量(cA)和高频系数向量(cD);

(4)重构低频信号A10和各层的高频信号D10,D9,D8,D7,D6,D5,D4,D3,D2,D1;

(5)对低频信号和各高频信号按文献[10]中求近似熵(共11维)。

5 基于GMM的病态嗓音识别实验结果及分析

本文实验采用GMM模型作为识别系统,在数据库的242例正常嗓音和234例病态嗓音中,随机选取正常嗓音和病态嗓音各80例作为模型训练集;其余作为测试集,各为162例和154例。

(1)为了表明预滤波的有效性,将语音提取ECDDMA特征参数时去掉去噪的部分提取出没有去噪的参数,与ECDDMA参数(都为11维)的识别结果对比如表1。

表1 去噪前参数与ECDDMA参数识别结果对比 (错误/正确)

去噪前参数97.50%

(2/78)

97.50%

(2/78)

91.97%

(13/149)

87.66%

(19/135)

ECDDMA 参数100%

(0/80)

100%

(0/80)

95.06%

(8/154)

92.20%

(12/142)

(2) 表2给出了使用传统特征MFCC(12维)及其差分参数(24维)的识别结果、ECDDMA参数(11维)以及A-F标准差参数[12](6维)的识别结果数对照表,其中模型混合数选取各种参数最佳的混合数。

表2 两种特征识别结果对照表(错误

/正确)

MFCC 参数100%

(0/80)

98.75%

(1/79)

69.75%

(49/113)

92.85%

(11/143)

MFCC+ △MFCC 100%

(0/80)

100%

(0/80)

70.98%

(47/115)

92.85%

(11/143)

ECDDMA 参数100%

(0/80)

100%

(0/80)

95.06%

(8/154)

92.20%

(12/142)

A-f标准差参数97.5%

(2/78)

98.75%

(1/79)

87.65%

(20/142)

92.85%

(11/143)

由于声带的病理性变化或功能性问题引起声门非完全关闭,特别是声带麻痹时声带固定,声门难于闭合,发声时由于声门空气泄露造成的骚动噪声增加[13]。本文从病态嗓音中不同频段表现及其噪声成分特性出发,使用先降噪再用小波分解的方法。表1中ECDDMA参数的识别效果要优于未去噪而直接作小波分解提取的参数,测试组正常样本和病态样本识别率分别高出3.09%,4.54%,结果表明:(1)语音信号经小波变换,分解到不同频率范围后求取近似熵得到的参数能有效的鉴别正常嗓音与病态嗓音;(2)在提取参数之前对语音作预滤波是能提高识别率的。表2识别结果显示:ECDDMA参数能够克服传统特征无法同时提高正常和病态样本识别结果的缺点,因此,ECDDMA能较准确的表征正常与病态嗓音之间的差别,测试集有效识别率正常组为95.06%,病态组为92.20%,正常组较MFCC高出24.08%;较文献[12]中提出的A-f标准差参数其正常识别率也高7.41%。由以上的分析看出:不论是模拟人耳特殊感知特性的MFCC及其动态参数,还是基于HHT提取出的A-f参数,本文提出的参数在病态嗓音识别中都显现出了优越性。

6 总结

这种特征提取的方法最大的优势在于:由于小波变换不依赖语音的短时平稳性,测试语音就不需要分帧;虽然A-f标准差参数特征维数为6维,但由于其提取过程中需对语音进行分帧处理,因此实际特征维数为6*帧数,本文中最终特征维数为11维,也就是说,一段复杂的语音只需几个简单的特征就足以描述,其计算量要比传统方法要快得多,作为一种无损伤的检测方法,这种能有效识别正常与病态嗓音的方法将对喉病临床诊断具有一定的实用价值,给临床医生提供了有力的参考。这中特征提取的方法也将为其他信号处理领域提供新的思路。但由于小波变换需要解决如何选取合适的小波基等问题,因此在取得好的结果之前总是要经过多次的实验来确定,这也是一直以来小波变换研究待解决的问题。

参考文献:

[1] 徐洁洁,乔宗海等.病态嗓音的计算机定量评估[J].南京医科大学学报.2000,20(2): 121-124.

[2] 杨式麟. 嗓音的声学检测1—7[J].听力学及言语疾病杂志.2001—2003年.

[3] 韩仲明. 嗓音疾病的临床检测[J].国外医学耳鼻咽喉科学分册.1998,22(5): 289-292.

[4] R. G.Bruce,K.Jody,et al. Theoretical and methodological development in the study of pathological voice quality [J].Journal of Phonetics. 2000,28:335-342.

[5] 何强,何英. MATLAB扩展编程[M]. 北京:清华大学出版社,2002.

[6] Ingrid Daubechics.小波十讲[M].北京:国防工业出版社.2004.5.

[7] 陈小玲,吴梁光,王薇.嗓音声学分析及声门图在喉疾病中的应用初探[J].听力学及言语疾病杂志.1999,7(1):4-7.

[8] R.T.Ritchings, M.McGillion,et al. Pathological voice quality assessment using artificial neural networks[J]. Medical Engineering Physics. 2002 (24): 561-564.

[9] 胡维平,王修信,姚铁钧等.频域相对信噪比对正常、病态嗓音声学的分析[J]. 临床耳鼻咽喉头颈外科杂志. 1998,117:219-224.

[10]雷雄国,曾以成等.基于近似熵的语音端点检测[J].声学技术.2007.2,26(1):121-125.

[11] 孙延奎.小波分析及其应用[M].机械工业出版社. 2005.3.

[12] 龚英姬,胡维平.基于HHT变换的病态嗓音特征提取及识别研究.计算机工程与应用.2007,43(34): 217-219.

[13] 刘绮明.病理嗓音的定量分析[J].山东医大基础医学学院学报.2002,16(2):89-91.

(原刊于《计算机工程与应用》2009年8月)

模式类别的可分性判据 在讨论特征选择和特征压缩之前,我们先要确定一个选择和提取的原则。对一个原始特征来说,特征选择的方案很多,从N 维特征种 选择出M 个特征共有()!!! M N N C M N M = -中选法,其中哪一种方案最佳, 则需要有一个原则来进行指导。同样,特征的压缩实际上是要找到M 个N 元函数,N 元函数的数量是不可数的,这也要有一个原则来指导找出M 个最佳的N 元函数。 我们进行特征选择和特征提取的最终目的还是要进行识别,因此应该是以对识别最有利原则,这样的原则我们称为是类别的可分性判据。用这样的可分性判据可以度量当前特征维数下类别样本的可分性。可分性越大,对识别越有利,可分性越小,对识别越不利。 人们对的特征的可分性判据研究很多,然而到目前为止还没有取得一个完全满意的结果,没有哪一个判据能够完全度量出类别的可分性。下面介绍几种常用的判据,我们需要根据实际问题,从中选择出一种。 一般来说,我们希望可分性判据满足以下几个条件: 1. 与识别的错误率由直接的联系,当判据取最大值时,识别的错误率最小; 2. 当特征独立时有可加性,即: ()()121 ,,,N ij N ij k k J x x x J x ==∑

ij J 是第i 类和第j 类的可分性判据,ij J 越大,两类的可分程度 越大,()12,,,N x x x 为N 维特征; 3. 应具有某种距离的特点: 0ij J >,当i j ≠时; 0 ij J =,当i j =时; ij ji J J =; 4. 单调性,加入新的特征后,判据不减小: ()()12121,,,,,,,ij N ij N N J x x x J x x x x +≤ 。 但是遗憾的是现在所经常使用的各种判据很难满足上述全部条件,只能满足一个或几个条件。 基于矩阵形式的可分性判据 1. 类内散度矩阵 设有M 个类别,1,,M ΩΩ ,i Ω类样本集()()(){}12,,,i i i i N X X X ,i Ω类 的散度矩阵定义为: () ()() ( )()() ( ) 1 1i N T i i i i i w k k k i S N == --∑X m X m 总的类内散度矩阵为: ()() ()() () ()() () () 1 1 1 1 i N M M T i i i i i w i w i k k i i k i S P S P N ==== Ω= Ω--∑∑∑X m X m 2. 类间散度矩阵 第i 个类别和第j 个类别之间的散度矩阵定义为: () () () ( )() () ( ) T ij i j i j B S =--m m m m 总的类间散度矩阵可以定义为:

中国中文信息学会第七次全国会员代表大会 暨学会成立30周年学术会议 语音识别发展现状与展望中科院自动化研究所徐波 2011年12月4日

报告提纲 ?语音识别技术现状及态势?语音识别技术的行业应用?语音识别技术研究方向?结论与展望

2010年始语音识别重新成为产业热点?移动互联网的兴起成为ASR最重要的应用环境。在Google引领下,互联网、通信公司纷纷把语音识别作为重要研究方向 –Android系统内嵌语音识别技术,Google语音 翻译等; –iPhone4S 上的Siri软件; –百度、腾讯、盛大、华为等都进军语音识别领 域; –我国语音技术领军企业讯飞2010年推出语音云识别、讯飞口讯 –已有的QQ2011版语音输入等等

成熟度分析-技术成熟度曲线 ?美国市场调查咨询公司Gartner于2011年7月发布《2011新兴技术成熟度曲线》报告:

成熟度分析-新兴技术优先矩阵?Gartner评出了2011年具有变革作用的技术,包括语音识别、语音翻译、自然语言问答等。其中语音翻译和自然语言问答有望在5-10年内获得大幅利用,而语音识别有望在2-5年内获得大幅利用;

三十年语音识别技术发展 ---特征提取与知识方面?MFCC,PLP,CMS,RASTA,VTLN;?HLDA, fMPE,neural net-based features ?前端优化 –融入更多特征信息(MLP、TrapNN、Bottle Neck Features等) ?特征很大特点有些是跟模型的训练算法相匹配?大规模FSN图表示,把各种知识源集中在一起–bigram vs. 4-gram, within word dependencies vs. cross-word

模式识别研究进展 刘成林,谭铁牛 中国科学院自动化研究所 模式识别国家重点实验室 北京中关村东路95号 摘要 自20世纪60年代以来,模式识别的理论与方法研究及在工程中的实际应用取得了很大的进展。本文先简要回顾模式识别领域的发展历史和主要方法的演变,然后围绕模式分类这个模式识别的核心问题,就概率密度估计、特征选择和变换、分类器设计几个方面介绍近年来理论和方法研究的主要进展,最后简要分析将来的发展趋势。 1. 前言 模式识别(Pattern Recognition)是对感知信号(图像、视频、声音等)进行分析,对其中的物体对象或行为进行判别和解释的过程。模式识别能力普遍存在于人和动物的认知系统,是人和动物获取外部环境知识,并与环境进行交互的重要基础。我们现在所说的模式识别一般是指用机器实现模式识别过程,是人工智能领域的一个重要分支。早期的模式识别研究是与人工智能和机器学习密不可分的,如Rosenblatt的感知机[1]和Nilsson的学习机[2]就与这三个领域密切相关。后来,由于人工智能更关心符号信息和知识的推理,而模式识别更关心感知信息的处理,二者逐渐分离形成了不同的研究领域。介于模式识别和人工智能之间的机器学习在20世纪80年代以前也偏重于符号学习,后来人工神经网络重新受到重视,统计学习逐渐成为主流,与模式识别中的学习问题渐趋重合,重新拉近了模式识别与人工智能的距离。模式识别与机器学习的方法也被广泛用于感知信号以外的数据分析问题(如文本分析、商业数据分析、基因表达数据分析等),形成了数据挖掘领域。 模式分类是模式识别的主要任务和核心研究内容。分类器设计是在训练样本集合上进行优化(如使每一类样本的表达误差最小或使不同类别样本的分类误差最小)的过程,也就是一个机器学习过程。由于模式识别的对象是存在于感知信号中的物体和现象,它研究的内容还包括信号/图像/视频的处理、分割、形状和运动分析等,以及面向应用(如文字识别、语音识别、生物认证、医学图像分析、遥感图像分析等)的方法和系统研究。 本文简要回顾模式识别领域的发展历史和主要方法的演变,介绍模式识别理论方法研究的最新进展并分析未来的发展趋势。由于Jain等人的综述[3]已经全面介绍了2000年以前模式分类方面的进展,本文侧重于2000年以后的研究进展。

模式识别特征选择与提取 中国矿业大学计算机科学与技术学院电子信息科学系 班级:信科11-1班,学号:08113545,姓名:褚钰博 联系方法(QQ或手机):390345438,e-mail:390345438@https://www.doczj.com/doc/8a5335337.html, 日期:2014 年06月10日 摘要 实际问题中常常需要维数约简,如人脸识别、图像检索等。而特征选择和特征提取是两种最常用的维数约简方法。特征选择是从某些事物中提取出本质性的功能、应用、优势等,而特征提取是对特征空间进行变换,将原始特征空间映射到低维空间中。 本文是对主成分分析和线性判别分析。 关键词:特征选择,特征提取,主成分分析,线性判别分析 1.引言 模式识别的主要任务是利用从样本中提取的特征,并将样本划分为相应的模式类别,获得好的分类性能。而分类方法与分类器设计,都是在d(变量统一用斜体)维特征空间已经确定的前提下进行的。因此讨论的分类器设计问题是一个选择什么准则、使用什么方法,将已确定的d维特征空间划分成决策域的问题。对分类器设计方法的研究固然重要,但如何确定合适的特征空间是设计模式识别系统另一个十分重要,甚至更为关键的问题。如果所选用的特征空间能使同类物体分布具有紧致性,即各类样本能分布在该特征空间中彼此分割开的区域内,这就为分类器设计成功提供良好的基础。反之,如果不同类别的样本在该特征空间中混杂在一起,再好的设计方法也无法提高分类器的准确性。本文要讨论的问题就是特征空间如何设计的问题。 基于主成分分析的特征选择算法的思想是建立在这样的基础上的:主成分分析方法将原始特征通过线性变换映射到新的低维空间时,获得的主成分是去了新的物理意义,难以理解,并且主成分是所有原始特征的线性组合。所以将主成分分析与特征选择相结合,设计多种相似性度量准则,通过找到与主成分相关的关键特征或者删除冗余、不相关以及没有意义的特征,将主成分又重新映射到原始空间,来理解成主成分的实际意义。 基于线性判别分析的高维特征选择将单个特征的Fisher准则与其他特征选择算法相结合,分层消除不相关特征与冗余特征。不相关特征滤波器按照每个特征的Fisher评价值进行特征排序,来去除噪音和不相关特征。通过对高维数据特征关联性的分析,冗余特征滤波器选用冗余度量方法和基于相关性的快速过滤器算法。分别在不同情境下进行数据分类实验,验证其性能。

语音信号特征的提取 摘要 随着计算机技术的发展,语音交互已经成为人机交互的必要手段,语音特征参数的精确度直接影响着语音合成的音质和语音识别的准确率。因此语音信号参数提取是语音信号处理研究中一项非常有意义的工作。 本文采用Matlab软件提取语音信号特征参数,首先对语音信号进行数字化处理,其次,进行预处理,包括预加重、加窗和分帧,本文讨论了预处理中各种参数的选择,以使信号特征提取更加准确。第三,讨论了各种时域特征参数的算法,包括短时能量、短时过零率等。 关键词:语音信号, 特征参数, 提取, Matlab 目录 第一章绪论 1.1语音信号特征提取概况 1.1.1研究意义 语音处理技术广泛应用于语音通信系统、声控电话交换、数据查询、计算机控制、工业控制等领域,带有语音功能的计算机也将很快成为大众化产品,语音将可能取代键盘和鼠标成为计算机的主要输入手段,为用户界面带来一次飞跃。 语音信号特征的提取是语音信号处理的前提和基础,只有分析出可表示语音信号本质特征的参数,才有可能利用这些参数进行高效的语音通信和准确的语音识别,才能建立语音合成的语音库。因此语音信号参数提取是语音信号处理研究中一项非常有意义的工作。 1.1.2 发展现状 语音信号处理是一门综合性的学科,包括计算机科学、语音学、语言学、声学和数学等诸多领域的内容。它的发展过程中,有过两次飞跃。第一次飞跃是1907年电子管的发明和1920年无线电广播的出现,电子管放大器使很微弱的声

音也可以放大和定量测量,从而使电声学和语言声学的一些研究成果扩展到通信和广播部门;第二次飞跃是在20世纪70年代初,电子计算机和数字信号处理的发展使声音信号特别是语音信号,可以通过模数转换器(A/D)采样和量化转换为数字信号,这样就可以用数字计算方法对语音信号进行处理和加工,提高了语音信号处理的准确性和高效性。 语音信号处理在现代信息科学中的地位举足轻重,但它仍有些基础的理论问题和技术问题有待解决,这些难题如听觉器官的物理模型和数学表示及语音增强的技术理论等,目前还有待发展。 1.2 本课题研究内容 本文主要介绍语音信号处理的理论及Matlab的相关内容,然后从Matlab仿真角度验证了录音、预处理、提取语音信号时域特征参数,主要讨论了预处理中各种参数的选择,以使信号特征提取更加准确。再次讨论了各种时域特征参数的算法,包括短时能量、短时过零率等,介绍了各环节的不同软件实现方法。最后对基于Matlab的语音信号特征参数提取进行总结。 第二章Matlab简介 MATLAB是国际上仿真领域最权威、最实用的计算机工具。它是MathWork 公司于1984年推出,它以强大的科学计算与可视化功能、简单易用、开放式可扩展环境,特别是所附带的30多种面向不同领域的工具箱支持,使得它在许多科学领域中成为计算机辅助设计和分析、算法研究和应用开发的基本工具和首选平台。 2.1 发展概况 Matlab是Matrix Laboratory(矩阵实验室的缩写),最初由美国Cleve Moler 博士在70年代末讲授矩阵理论和数据分析等课程时编写的软件包Linpack与Eispack组成,旨在使应用人员免去大量经常重复的矩阵运算和基本数学运算等繁琐的编程工作。1984年成立的Math Works公司正式把Matlab推向市场,并从事Matlab的研究和开发。1990年,该公司推出了以框图为基础的控制系统仿真工具Simulink,它方便了系统的研究与开发,使控制工程师可以直接构造系统框图进行仿真,并提供了控制系统中常用的各种环节的模块库。1993年,Math Works 公司推出的Matlab4.0版在原来的基础上又作了较大改进,并推出了Windows版,

---------------------------------------------------------------最新资料推荐------------------------------------------------------ 基于能量检测的复杂环境下的鸟鸣识别基于能量检测的复杂环境下的鸟鸣识别基于能量检测的复杂环境下的鸟鸣识别摘要: 针对实际环境噪声使得鸟鸣识别准确率受到影响的问题,提出一种基于能量检测的抗噪鸟鸣识别方法。 首先,对包含有噪声的鸟鸣信号用能量检测方法检测并筛选出有用鸟鸣信号;其次,根据梅尔尺度的分布,对有用鸟鸣信号提取小波包分解子带倒谱系数(WPSCC)特征;最后,用支持向量机(SVM)分类器分别对提取的小波包分解子带倒谱系数(WPSCC)和梅尔频率倒谱系数(MFCC)特征进行建模分类识别。 同时还对比了在添加不同信噪比的噪声下 15 类鸟鸣在能量检测前后的识别性能差异。 实验结果表明,提取的 WPSCC特征具有较好的抗噪功能,且经过能量检测后的识别性能更佳,更适用于复杂环境下的鸟鸣识别。 关键词: 能量检测;小波包分解子带倒谱系数;梅尔频率倒谱系数;支持向量机;鸟鸣识别 0 引言复杂生态环境中的鸟类能发出各种多样的鸣叫声,其声音蕴含着与人类生存环境息息相关的丰富信息。 人们可以通过检测、分析和识别鸟鸣来获取相关鸟类信息,了解鸟类物种种群的数量、种类以及生活习性,对鸟类进行监控和保 1/ 9

护,从而对周围的生态环境或居住环境进行评估与预测。 随着科技的日渐发展,鸟类声音的分类识别技术已经取得了不少的研究成果。 文献[1]用正弦曲线对连续鸟叫声的音节进行建模,进而用得到的参数对大量鸟叫声进行分类识别。 文献[2]把声音信号表征成码书帧柱状图,用由贝叶斯风险最小化导出的最大后验概率(Maximum APosteriori, MAP)和基于统计流形的 KullbackLeibler散度规则的最近邻分类器来对大量鸟叫声进行识别。 文献[3]提出了基于音节分割的鸟叫声分类识别方法,比对了正弦曲线模型特征、梅尔频率倒谱系数(MelFrequency Cepstrum Coefficient, MFCC)和基音时频特征三种特征,分析了动态时间规整(Dynamic Time Warping, DTW)、高斯混合模型(Gaussian Mixture Model, GMM)和隐马尔科夫模型(Hidden Markov Model,HMM)三种分类器对鸟叫声自动识别的适用性及有效性。 考虑到噪声的影响,研究者也探索了噪声中的鸟叫声识别方法。 文献[4]通过降噪分段后提取小波包分解(Wavelet Packet Decomposition, WPD)的小波系数特征,最后用无监督自组织映射(SelfOrganizing Map, SOM)和监督多层感知(MultiLayer Perceptron, MLP)两种神经网络分类器来对不和谐的瞬时鸟叫声进行分类识别。 文献[5]在多种鸟声重叠和存在自然噪声的情况下,对两种濒临

一、填空与选择填空(本题答案写在此试卷上,30分) 1、模式识别系统的基本构成单元包括:模式采集、特征提取与选择 和模式分类。 2、统计模式识别中描述模式的方法一般使用特真矢量;句法模式识别中模式描述方法一般有串、树、网。 3、聚类分析算法属于(1);判别域代数界面方程法属于(3)。 (1)无监督分类 (2)有监督分类(3)统计模式识别方法(4)句法模式识别方法 4、若描述模式的特征量为0-1二值特征量,则一般采用(4)进行相似性度量。 (1)距离测度(2)模糊测度(3)相似测度(4)匹配测度 5、下列函数可以作为聚类分析中的准则函数的有(1)(3)(4)。 (1)(2) (3) (4) 6、Fisher线性判别函数的求解过程是将N维特征矢量投影在(2)中进行。 (1)二维空间(2)一维空间(3)N-1维空间 7、下列判别域界面方程法中只适用于线性可分情况的算法有(1);线性可分、不可分都适用的有(3)。 (1)感知器算法(2)H-K算法(3)积累位势函数法 8、下列四元组中满足文法定义的有(1)(2)(4)。 (1)({A, B}, {0, 1}, {A→01, A→ 0A1 , A→ 1A0 , B→BA , B→ 0}, A) (2)({A}, {0, 1}, {A→0, A→ 0A}, A) (3)({S}, {a, b}, {S → 00S, S → 11S, S → 00, S → 11}, S) (4)({A}, {0, 1}, {A→01, A→ 0A1, A→ 1A0}, A) 9、影响层次聚类算法结果的主要因素有(计算模式距离的测度、(聚类准则、类间距离门限、预定的 类别数目))。 10、欧式距离具有( 1、2 );马式距离具有(1、2、3、4 )。 (1)平移不变性(2)旋转不变性(3)尺度缩放不变性(4)不受量纲影响的特性 11、线性判别函数的正负和数值大小的几何意义是(正(负)表示样本点位于判别界面法向量指向的 正(负)半空间中;绝对值正比于样本点到判别界面的距离。)。 12、感知器算法1。 (1)只适用于线性可分的情况;(2)线性可分、不可分都适用。

语音识别技术综述 The summarization of speech recognition 张永双 苏州大学 摘要 本文回顾了语音识别技术的发展历史,综述了语音识别系统的结构、分类及基本方法,分析了语音识别技术面临的问题及发展方向。 关键词:语音识别;特征;匹配 Abstact This article review the courses of speech recognition technology progress ,summarize the structure,classifications and basic methods of speech recognition system and analyze the direction and the issues which speech recognition technology development may confront with. Key words: speech recognition;character;matching 引言 语音识别技术就是让机器通过识别和理解过程把语音信号转变为相应的文本或命令的高技术。语音识别是一门交叉学科,所涉及的领域有信号处理、模式识别、概率论和信息论、发声机理和听觉机理、人工智能等等,甚至还涉及到人的体态语言(如人民在说话时的表情手势等行为动作可帮助对方理解)。其应用领域也非常广,例如相对于键盘输入方法的语音输入系统、可用于工业控制的语音控制系统及服务领域的智能对话查询系统,在信息高度化的今天,语音识别技术及其应用已成为信息社会不可或缺的重要组成部分。 1.语音识别技术的发展历史 语音识别技术的研究开始二十世纪50年代。1952年,AT&Tbell实验室的Davis等人成功研制出了世界上第一个能识别十个英文数字发音的实验系统:Audry系统。

特征提取 SIFT算法提取步骤 SIFT算法提取特征点的主要步骤: (1)检测尺度空间极值点 检测尺度空间极值的目的是确定特征点位置和所在尺度组。即先使用高斯过滤器对原始图像进行若干次连续滤波建立第一个尺度组,再把图形减小到原来的一半,进行同样的高斯滤波形成第二个尺度组。之后,重复操作直到图像小于某一个给定阀值为止。接下来对每个尺度组中的高斯图像进行差分,形成高斯差分尺度组(DoG尺度图像)。

图3-1 尺度空间的构造 在上面建立的DoG尺度空间金字塔中,为了检测到DoG空间的最大值和最小值,DoG尺度空间中中间层(最底层和最顶层除外)的每个像素点需要跟同一层的相邻8个像素点以及它上一层和下一层的9个相邻像素点总共26个相邻像素点进行比较,以确保在尺度空间和二维图像空间都检测到局部极值,如图3-2所示 图3-2 DoG空间局部极值检测 在图3-2中,标记为叉号的像素若比相邻26个像素的DoG值都大或都小,则该点将作为一个局部极值点。被检测工件的高斯滤波图像如图3-3所示。

图3-3 原始图像和部分高斯滤波图像 (2)精确定位极值点 由于DoG值对噪声和边缘较敏感,因此,在上面DoG尺度空间中检测到局部极值点还要经过进一步的检验才能精确定位为特征点。一般通过二阶Taylor 展开式计算极值点的偏移量,获得亚像素定位精度,同时通过阈值设置剔除差异小的点。最终保留下来的点称为特征点,特征点的检测是在尺度空间中进行的,特征点保持为尺度不变量。各层图像特征点如图3-4所示。

图3-4 各层图像的特征点 (3)为每个关键点指定方向参数 σ—尺度空间坐标 O —组(octave)数 S —组内层数 在上述尺度空间中,O 和S ,σ的关系如下: ()[][]2,...,0,1,...,02 ,0+∈-∈=+S s O o s o S s o σσ (3-10)

基于小波变换的人脸识别 近年来,小波变换在科技界备受重视,不仅形成了一个新的数学分支,而且被广泛地应用于模式识别、信号处理、语音识别与合成、图像处理、计算机视觉等工程技术领域。小波变换具有良好的时频域局部化特性,且其可通过对高频成分采取逐步精细的时域取样步长,从而达到聚焦对象任意细节的目的,这一特性被称为小波变换的“变聚焦”特性,小波变换也因此被人们冠以“数学显微镜”的美誉。 具体到人脸识别方面,小波变换能够将人脸图像分解成具有不同分辨率、频率特征以及不同方向特性的一系列子带信号,从而更好地实现不同分辨率的人脸图像特征提取。 4.1 小波变换的研究背景 法国数学家傅立叶于1807年提出了著名的傅立叶变换,第一次引入“频率”的概念。傅立叶变换用信号的频谱特性来研究和表示信号的时频特性,通过将复杂的时间信号转换到频率域中,使很多在时域中模糊不清的问题,在频域中一目了然。在早期的信号处理领域,傅立叶变换具有重要的影响和地位。定义信号(t)f 为在(-∞,+∞)内绝对可积的一个连续函数,则(t)f 的傅立叶变换定义如下: ()()dt e t f F t j ωω-? ∞ -∞ += (4-1) 傅立叶变换的逆变换为: ()()ωωπ ωd e F t f t j ? +∞ ∞ -= 21 (4-2) 从上面两个式子可以看出,式(4-1)通过无限的时间量来实现对单个频率

的频谱计算,该式表明()F ω这一频域过程的任一频率的值都是由整个时间域上的量所决定的。可见,式(4-1)和(4-2)只是同一能量信号的两种不同表现形式。 尽管傅立叶变换可以关联信号的时频特征,从而分别从时域和频域对信号进行分析,但却无法将两者有效地结合起来,因此傅立叶变换在信号的局部化分析方面存在严重不足。但在许多实际应用中,如地震信号分析、核医学图像信号分析等,研究者们往往需要了解某个局部时段上出现了哪个频率,或是某个频率出现在哪个时段上,即信号的时频局部化特征,傅立叶变换对于此类分析无能为力。 因此需要一种如下的数学工具:可以将信号的时域和频域结合起来构成信号的时频谱,描述和分析其时频联合特征,这就是所谓的时频局部化分析方法,即时频分析法。1964年,Gabor 等人在傅立叶变换的基础上引入了一个时间局部化“窗函数”g(t),改进了傅立叶变换的不足,形成窗口化傅立叶变换,又称“Gabor 变换”。 定义“窗函数”(t)g 在有限的区间外恒等于零或很快地趋于零,用函数(t )g -τ乘以(t)f ,其效果等同于在t =τ附近打开一个窗口,即: ()()()dt e t g t f G t j f ωττω-+∞ ∞--=?, (4-3) 式(4-3)即为函数f(t)关于g(t)的Gabor 变换。由定义可知,信号(t)f 的Gabor 变换可以反映该信号在t =τ附近的频谱特性。其逆变换公式为: ()()()ττωτωπ ωd G t g e d t f f t j ,21 ? ?+∞ ∞ --- = (4-4) 可见()τω,f G 的确包含了信号(t)f 的全部信息,且Gabor 窗口位置可以随着 τ的变化而平移,符合信号时频局部化分析的要求。 虽然Gabor 变换一定程度上克服了傅立叶变换缺乏时频局部分析能力的不

语音识别改进方法及难点分析 ——《模式识别》结课小论文 学院:化工与环境学院 学号:2120151177 姓名:杜妮

摘要:随着计算机技术的不断发展,人工智能程度也越来越高,作为人工智能的一部分——模式识别也在模型和算法上愈发成熟。本文根据近105年文献,分析最新声音识别的方法和应用。 关键字:模式识别声音识别方法应用 随着人工智能的迅速发展,语音识别的技术越来越成为国内外研究机构的焦点。人们致力于能使机器能够听懂人类的话语指令,并希望通过语音实现对机器的控制。语音识别的研究发展将在不远的将来极大地方便人们的生活。 语音识别大致的流程包括:特征提取、声学模型训练、语音模型训练以及识别搜索算法。作为一项人机交互的关键技术,语音识别在过去的几十年里取得了飞速的发展,人们在研究和探索过程中针对语音识别的各部流程进行了各种各样的尝试和改造,以期发现更好的方法来完成语音识别流程中的各步骤,以此来促进在不同环境下语音识别的效率和准确率。本文通过查阅近10年国内外文献,分析目前语音识别流程中的技术进展和趋势,并在文章最后给出几项语音识别在日常生活中的应用案例,从而分析语音识别之后的市场走势和实际利用价值。 一、语音识别的改进方法 (一)特征提取模块改进 特征提取就是从语音信号中提取出语音的特征序列。提取的语音特征应该能完全、准确地表达语音信号,特征提取的目的是提取语音信号中能代表语音特征的信息,减少语音识别时所要处理的数据量。语音信号的特征分析是语音信号处理的前提和基础,只有分析出可以代表语音信号本质特征的参数,才能对这些参数进行高效的语音通信,语音合成,和语音识别等处理,并且语音合成的好坏,语音识别率的高低,也都取决于语音特征提取的准确性和鲁棒性。目前,针对特定应用的中小词汇量、特定人的语音识别技术发展已较为成熟,已经能够满足通常应用的要求,并逐步投入了实用。而非特定人、大词汇量、连续语音识别仍是

2.1图像模式识别的方法 图像模式识别的方法很多,从图像模式识别提取的特征对象来看,图像识别方法可分为以下几种:基于形状特征的识别技术、基于色彩特征的识别技术以及基于纹理特征的识别技术。其中,基于形状特征的识别方法,其关键是找到图像中对象形状及对此进行描述,形成可视特征矢量,以完成不同图像的分类,常用来表示形状的变量有形状的周长、面积、圆形度、离心率等。基于色彩特征的识别技术主要针对彩色图像,通过色彩直方图具有的简单且随图像的大小、旋转变换不敏感等特点进行分类识别。基于纹理特征的识别方法是通过对图像中非常具有结构规律的特征加以分析或者则是对图像中的色彩强度的分布信息进行统计来完成。 从模式特征选择及判别决策方法的不同可将图像模式识别方法大致归纳为两类:统计模式(决策理论)识别方法和句法(结构)模式识别方法。此外,近些年随着对模式识别技术研究的进一步深入,模糊模式识别方法和神经网络模式识别方法也开始得到广泛的应用。在此将这四种方法进行一下说明。 2.1.1句法模式识别 对于较复杂的模式,如采用统计模式识别的方法,所面临的一个困难就是特征提取的问题,它所要求的特征量十分巨大,要把某一个复杂模式准确分类很困难,从而很自然地就想到这样的一种设计,即努力地把一个复杂模式分化为若干

较简单子模式的组合,而子模式又分为若干基元,通过对基元的识别,进而识别子模式,最终识别该复杂模式。正如英文句子由一些短语,短语又由单词,单词又由字母构成一样。用一组模式基元和它们的组成来描述模式的结构的语言,称为模式描述语言。支配基元组成模式的规则称为文法。当每个基元被识别后,利用句法分析就可以作出整个的模式识别。即以这个句子是否符合某特定文法,以判别它是否属于某一类别。这就是句法模式识别的基本思想。 句法模式识别系统主要由预处理、基元提取、句法分析和文法推断等几部分组成。由预处理分割的模式,经基元提取形成描述模式的基元串(即字符串)。句法分析根据文法推理所推断的文法,判决有序字符串所描述的模式类别,得到判决结果。问题在于句法分析所依据的文法。不同的模式类对应着不同的文法,描述不同的目标。为了得到于模式类相适应的文法,类似于统计模式识别的训练过程,必须事先采集足够多的训练模式样本,经基元提取,把相应的文法推断出来。实际应用还有一定的困难。 2.1.2统计模式识别 统计模式识别是目前最成熟也是应用最广泛的方法,它主要利用贝叶斯决策规则解决最优分类器问题。统计决策理论的基本思想就是在不同的模式类中建立一个决策边界,利用决策函数把一个给定的模式归入相应的模式类中。统计模式识别的基本模型如图2,该模型主要包括两种操作模型:训练和分类,其中训练主要利用己有样本完成对决策边界的划分,并采取了一定的学习机制以保证基于样本的划分是最优的;而分类主要对输入的模式利用其特征和训练得来的决策函数而把模式划分到相应模式类中。 统计模式识别方法以数学上的决策理论为基础建立统计模式识别模型。其基本模型是:对被研究图像进行大量统计分析,找出规律性的认识,并选取出反映图像本质的特征进行分类识别。统计模式识别系统可分为两种运行模式:训练和分类。训练模式中,预处理模块负责将感兴趣的特征从背景中分割出来、去除噪声以及进行其它操作;特征选取模块主要负责找到合适的特征来表示输入模式;分类器负责训练分割特征空间。在分类模式中,被训练好的分类器将输入模式根据测量的特征分配到某个指定的类。统计模式识别组成如图2所示。

美国科罗拉多州大学关于在噪声环境下对大量连续语音识别系统的改进 ---------噪声环境下说话声音的识别工作 简介 在本文中,我们报道美国科罗拉多州大学关于噪声环境下海军研究语音词汇系统方面的最新改进成果。特别地,我们介绍在有限语音数据的前提下,为了了解不确定观察者和变化的环境的任务(或调查方法),我们必须在提高听觉和语言模式方面努力下工夫。在大量连续词汇语音识别系统中,我们将展开MAPLR自适应方法研究。它包括单个或多重最大可能线形回归。当前噪声环境下语音识别系统使用了大量声音词汇识别的声音识别引擎。这种引擎在美国科罗拉多州大学目前得到了飞速的发展,本系统在噪声环境下说话声音系统(SPINE-2)评价数据中单词错识率表现为30.5%,比起2001年的SPINE-2来,在相关词汇错识率减少16%。 1.介绍 为获得噪声环境下的有活力的连续声音系统的声音,我们试图在艺术的领域做出计算和提出改善,这个工作有几方面的难点:依赖训练的有限数据工作;在训练和测试中各种各样的军事噪声存在;在每次识别适用性阶段中,不可想象的听觉溪流和有限数量的声音。 在2000年11月的SPIN-1和2001年11月SPIN-2中,海军研究词汇通过DARPT在工作上给了很大的帮助。在2001年参加评估的种类有:SPIIBM,华盛顿大学,美国科罗拉多州大学,AT&T,奥瑞哥研究所,和梅隆卡内基大学。它们中的许多先前已经报道了SPINE-1和SPLNE-2工作的结果。在这方面的工作中不乏表现最好的系统.我们在特性和主模式中使用了自适应系统,同时也使用了被用于训练各种参数类型的多重声音平行理论(例如MFCC、PCP等)。其中每种识别系统的输出通常通过一个假定的熔合的方法来结合。这种方法能提供一个单独的结果,这个结果的错误率将比任何一个单独的识别系统的结果要低。 美国科罗拉多州大学参加了SPIN-2和SPIN-1的两次评估工作。我们2001年11月的SPIN-2是美国科罗拉多州大学识别系统基础上第一次被命名为SONIC(大量连续语音识别系统)的。在那次评估中,我们单独的最好的系统在9x的实时性的解码速率下,有37.5%的错误率,在那篇论文中,我们描述了当前在通常识别系统发展的形式和工作依靠模式方面的改进.我们之所以关心这些问题,是因为这些问题是关系到在单独识别系统下降低噪声环境下说话声音的错识率,而不考虑那些工作中的识别融合问题。 2.噪声环境下说话者工作任务. 这个在噪声环境下的语音工作任务采用了ARCON通信实践,本实践的发展是源于测试

—172 — 基于Gabor 小波变换的人脸表情特征提取 叶敬福,詹永照 (江苏大学计算机科学与通信工程学院,镇江 212013) 摘 要:提出了一种基于Gabor 小波变换的人脸表情特征提取算法。针对包含表情信息的静态灰度图像,首先对其预处理,然后对表情子区域执行Gabor 小波变换,提取表情特征矢量,进而构建表情弹性图。最后分析比较了在不同光照条件下不同测试者做出6种基本表情时所提取的表情特征,结果表明Gabor 小波变换能够有效地提取与表情变化有关的特征,并能有效地屏蔽光照变化及个人特征差异的影响。关键词:模式识别;表情特征提取;Gabor 小波变换 Facial Expression Features Extraction Based on Gabor Wavelet Transformation YE Jingfu, ZHAN Yongzhao (School of Computer Science and Communications Engineering, Jiangsu University, Zhenjiang 212013) 【Abstract 】This paper introduces a facial expression features extraction algorithm. Given a still image containing facial expression information,preprocessors are executed firstly. Secondly, expression feature vectors of the expression sub-regions are extracted by Gabor wavelet transformation to form expression elastic graph. Different expression features are extracted and compared while different subjects display six basic expressions with illumination variety. Experiment shows that expression features can be extracted effectively based on Gabor wavelet transformation, which is insensitive to illumination variety and individual difference. 【Key words 】Pattern recognition; Expression feature extraction; Gabor wavelet transformation 计 算 机 工 程Computer Engineering 第31卷 第15期 Vol.31 № 15 2005年8月 August 2005 ·人工智能及识别技术·文章编号:1000—3428(2005)15—0172—03 文献标识码:A 中图分类号:TP37 人脸表情识别是指从给定的表情图像或者视频序列中分析检测出特定的表情状态,进而确定被识别对象的心理情绪。人脸表情识别技术在许多领域有着潜在的应用价值,这些领域包括心理学研究、图像理解、合成脸部动画、视频检索、机器人技术、虚拟现实技术以及新型人机交互环境等[1]。 典型的人脸表情识别系统包括人脸检测、表情特征提取、表情特征分类识别3个阶段。人脸检测要能够从复杂的背景中检测出人脸的存在并确定其位置,对于图像序列,还要能精确跟踪人脸区域,国内外在人脸检测方面已做了大量的研究,且已有相关的有效方法及成果报道。而对于表情特征的提取和分类识别算法的研究目前还处于探索之中,国外学者已做了一定的研究工作,国内关于这方面的研究则相对较少。 针对处理图像的性质,可将表情特征提取方法分为两类:基于静态图像的表情特征提取和基于视频序列的动态表情特征提取。前者处理的是单帧静态表情图像,一般要求该图像反映的表情处于夸张或极大状态,使得提取的表情特征更为典型,这类方法主要包括主成份分析、奇异值分解以及基于小波变换的方法等。后者处理的是表情图像序列,目标是提取表情特征的变化过程。光流模型(Optical Flow Models)是提取动态表情特征的典型方法。比较而言,静态方法处理的数据量少,方法简单可靠,且提取的特征较为典型,能获得较高的识别率,但待处理的图像所包含的表情信息需处于夸张状态。而动态方法处理视频序列中的每一帧图像,因此计算量较大,难以满足实时性要求。 1表情图像的预处理 表情图像的预处理包括表情图像子区域的分割以及表情图像的归一化处理。前者指从表情图像中分割出与表情最相关的子区域,而后者包括图像的灰度均衡和尺度归一。图像预处理的好坏直接影响表情特征提取的效果和计算量。 (a) (b) 图1 分割人脸表情图像以提取特征区域 人脸表情特征可分为两类:持久性表情特征和瞬态表情特征,前者包括嘴巴、眼睛和眉毛,决定了基本表情状态,后者包括脸颊和额角皱纹的瞬间变化,能在一定程度上揭示表情状态。实验表明[3],嘴角形状对表情的影响最大,其次是眼睛和眉毛,而皱纹变化属于动态特征,且受年龄等因素影响较大,对表情的贡献不大,甚至会对表情识别产生不利影响。因此表情识别应重点提取嘴巴、眼睛和眉毛等局部表情特征,并忽略皱纹的变化。图像分割算法的目标就是要精确定位和分离出持久表情特征子区域。对于样本图像,可以人工框出这些区域,也可以根据眼睛的灰度特征并结合先验知识采用特定的定位算法实现特征区域的自动分割。分割结 基金项目:国家自然科学基金资助项目(60273040);江苏省高校自然科学基金资助项目(02KJB520003) 作者简介:叶敬福(1980—),男,硕士生,研究方向:多媒体技术,CSCW ;詹永照,教授、博导 定稿日期:2004-06-26 E-mail :yejingfu@https://www.doczj.com/doc/8a5335337.html,

耳朵在声音识别中的原理 人们常说的听声辨位就是人们在听到声音以后,能辨别出声音是从哪个方向传播过来的,而声音在不同环境下传播的又不一样,这就是人耳对声音方向感的作用。 声源方位感,是听觉器官对声音的音高、音强、音色、音长感觉之外的又一个感觉要素,它涉及到复杂的生理学心理学方面的问题。同时,声源方位感也是立体声技术的理论依据。 一、时间差、相位差与声级差、音色差 双耳效应借以定位的原理是时间差、相位差、声级差、声色差。 (一)时间差和相位差 时间差主要是指声音刚到双耳瞬间的先后差异。声波在常温下传播的速度为344m/s,当声源偏离听音人正前方中轴线时,耳A与耳B同声源之间的距离有差别,从而出现声音到达耳A与耳B之间的时间差。 时间差作为声源定位机理,对正面和两侧的声源定位准确性较高,对来自后面的声源定位则误差较大。其原因尚不十分清楚。可能因为声音来自背侧,会因为左耳或右耳产生耳壳遮蔽效应,使得声音因衍射而时差有变化。 因为人耳对声音有适应性,当声音到达基底膜的刹那间,毛细胞表现兴奋而灵敏。当声音持续刺激,毛细胞的反应相对地迟钝。因此突发声和瞬态声的声源定位准确性较高。 一个迅速流动的声源,会吸引听觉的注意。因此,方位不断变化的声音,人耳对其方位辨认的误差较小。这就是近代立体声节目出现声移位的原因。 一个连续的声音,虽然到达双耳也存在时间差,但是因为达到同一只耳朵的后续声掩盖了前面的声音,使时间差变得不明显。 高频声与低频声传播速度是一致的,所以时间差同声源的频率无关。但相位差同声源的

频率有关。当一个声音到达双耳,在两耳之间出现时间差的同时,亦必然出现相位差。在一定的频率范围内,相位差是声源方位感的信息之一。 相位差定位机理在频率较低时效果较明显。例如,在常温中20Hz声音的波长是17m,200Hz为1.7m,时间差所形成的相位差人耳能够感觉出。而在声源处于高频区时,例如10kHz的波长85px,20kHz是42.5px,时间差所造成的相位差甚至超过360°,等于开始另一个波长。这时的相位差作为定位信息已无任何作用,因为已无法分辨出相位属于滞后或超前。因而高频声属于“混乱的相位差”信息。 (二)声级差和音色差 声级差指声波到达两耳出现不同的声强。形成声级差的主要原因是遮蔽效应。前进中的声波如遇到几何尺寸等于或大于声波长的障碍物,会发生遮蔽效应。其原理是:高频声在传播遇到障碍物时,因无法越过障碍物,在障碍物后面形成声阴影区;低频声波长大于障碍物而在障碍物后面形成声衍射区。对声级差起重要作用的是高频声,因为高频声波不能绕过听者头部,所以处于声阴影区的那只耳朵比能够听到直达声的那只耳朵,声强级产生差异。频率愈高,声源偏离正面中轴线愈大,声级差就愈明里。 从衍射效应的角度看,低频声当然也会形成声级差。但是由于头部直径为500px左右,低频声发生衍射时,多走的路程有限,因衍射而损失的能量很小,因而偏离中轴线的低频声,到达两耳的声级差几近于零,对声源定位作用不明显。 遮蔽效应对音级差产生作用的同时,亦必然对音色差发生作用。我们知道,构成音色的主要成分是基础音及其上方各次谐波的分量。举例说,一个基频为200Hz,入射角为45°的复合波点声源,那么,它的基础音和低次谐波遇到头部障碍后产生衍射效应,其高次谐波则被头部遮蔽而出现高频声阴影区。这时,到达一侧耳朵的声音为直达声(原音色),到达另一侧耳朵的声音因为高频损失而使音色发生变化。大脑皮质根据两耳的音色差来辨认声源

模式识别及其在图像处理中的应用 摘要:随着计算机和人工智能技术的发展,模式识别在图像处理中的应用日益广泛。综述了模式识别在图像处理中特征提取、主要的识别方法(统计决策法、句法识别、模糊识别、神经网络)及其存在的问题,并且对近年来模式识别的新进展——支持向量机与仿生模式识别做了分析和总结,最后讨论了模式识别亟待解决的问题并对其发展进行了展望。 关键词:模式识别;图像处理;特征提取;识别方法

模式识别诞生于20世纪20年代,随着计算机的出现和人工智能的发展,模式识别在60年代初迅速发展成一门学科。它所研究的理论和方法在很多学科和领域中得到广泛的重视,推动了人工智能系统的发展,扩大了计算机应用的可能性。图像处理就是模式识别方法的一个重要领域,目前广泛应用的文字识别( MNO)就是模式识别在图像处理中的一个典型应用。 1.模式识别的基本框架 模式识别在不同的文献中给出的定义不同。一般认为,模式是通过对具体的事物进行观测所得到的具有时间与空间分布的信息,模式所属的类别或同一类中模式的总体称为模式类,其中个别具体的模式往往称为样本。模式识别就是研究通过计算机自动地(或者人为进行少量干预)将待识别的模式分配到各个模式类中的技术。模式识别的基本框架如图1所示。 根据有无标准样本,模式识别可分为监督识别方法和非监督识别方法。监督识别方法是在已知训练样本所属类别的条件下设计分类器,通过该分类器对待识样本进行识别的方法。如图1,标准样本集中的样本经过预处理、选择与提取特征后设计分类器,分类器的性能与样本集的大小、分布等有关。待检样本经过预处理、选择与提取特征后进入分类器,得到分类结果或识别结果。非监督模式识别方法是在没有样本所属类别信息的情况下直接根据某种规则进行分类决策。应用于图像处理中的模式识别方法大多为有监督模式识别法,例如人脸检测、车牌识别等。无监督的模式识别方法主要用于图像分割、图像压缩、遥感图像的识别等。