SVM 小结

理论基础:

机器学习有三类基本的问题,即模式识别、函数逼近和概率密度估计.

SVM 有着严格的理论基础,建立了一套较好的有限训练样本下机器学习的理论框架和通用方法。他与机器学习是密切相关的,很多理论甚至解决了机器学习领域的其他的问题,所以学习SVM 和机器学习是相辅相成的,两者可以互相促进,有助于机器学习理论本质的理解。

VC 维理论:对一个指示函数集,如果存在h 个样本能够被函数集中的函数按所有可能的2h 种形式分开,则称函数集能够把h 个样本打散;函数集的VC 维就是它能打散的最大样本数目。VC 维反映了函数集的学习能力,VC 维越太则学习机器越复杂(容量越太)。

期望风险:其公式为[](,,(,))(,)y R f c y f y dP y χχχχ?=?,其中(,,(,))c y f y χχ为损失函数,(,)P y χ为概率分布,期望风险的大小可以直观的理解为,当我们用()f χ进行预测时,“平均”的损失程度,或“平均”犯错误的程度。

经验风险最小化(ERM 准则)归纳原则:但是,只有样本却无法计算期望风险,因此,传统的学习方法用样本定义经验风险[]emp R f 作为对期望风险的估计,并设计学习算法使之最小化。即所谓的经验风险最小化(ERM 准则)归纳原则。经验风险是用损失函数来计算的。对于模式识别问题的损失函数来说,经验风险就是训练样本错误率;对于函数逼近问题的损失函数来说,就是平方训练误差;而对于概率密度估计问题的损失函数来说,ERM 准则就等价于最大似然法。但是,经验风险最小不一定意味着期望风险最小。其实,只有样本数目趋近于无穷大时,经验风险才有可能趋近于期望风险。但是很多问题中样本数目离无穷大很远,那么在有限样本下ERM 准则就不一定能使真实风险较小。ERM 准则不成功的一个例子就是神经网络和决策树的过学习问题(某些情况下,训练误差过小反而导致推广能力下降,或者说是训练误差过小导致了预测错误率的增加,即真实风险的增加)。

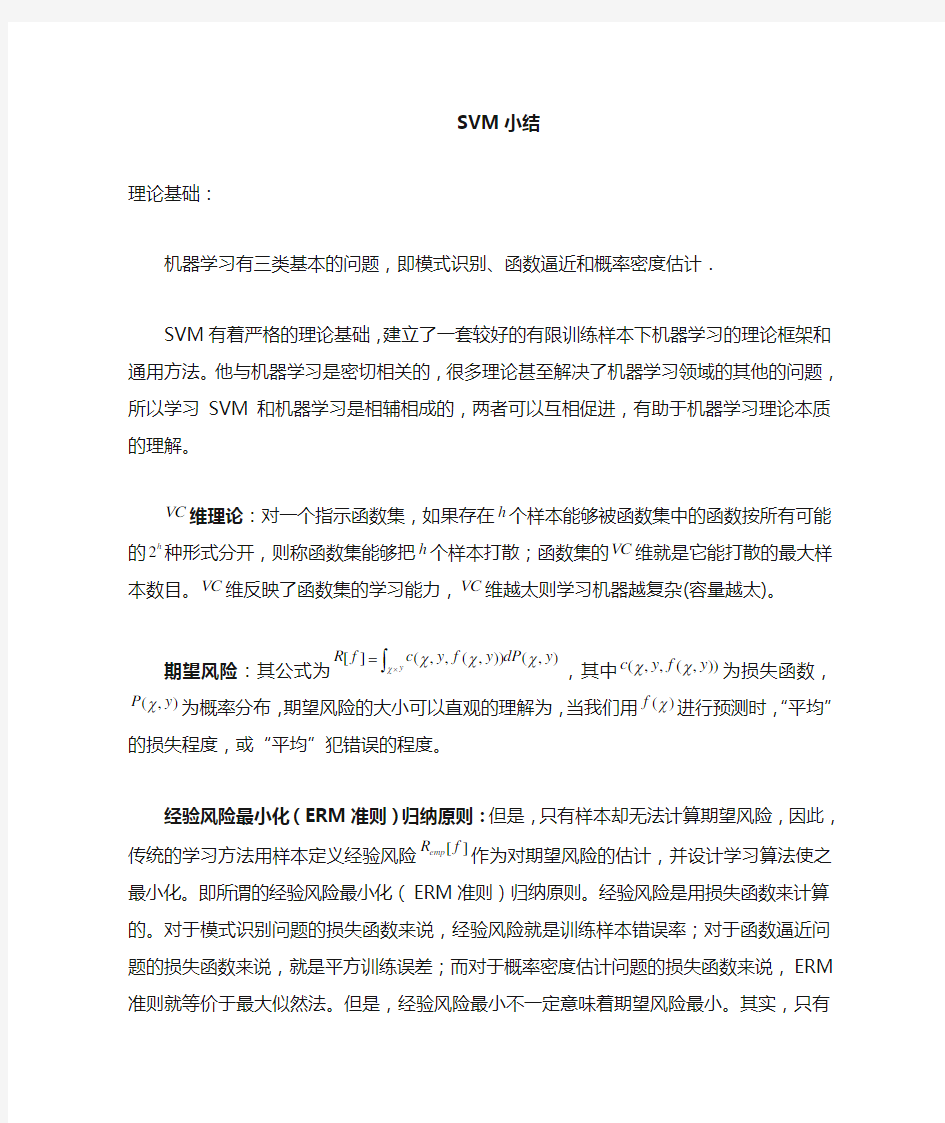

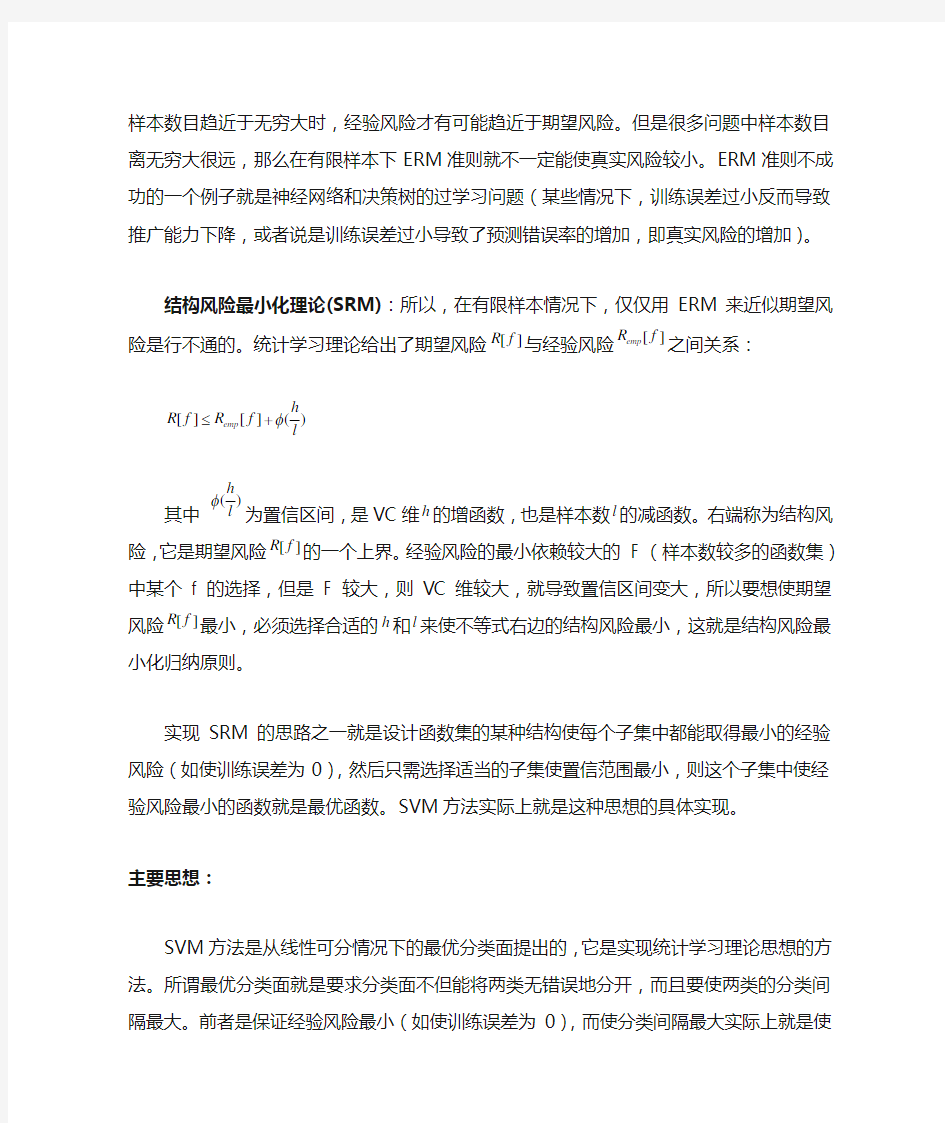

结构风险最小化理论(SRM):所以,在有限样本情况下,仅仅用ERM 来近似期望风险是行不通的。统计学习理论给出了期望风险[]R f 与经验风险[]emp R f 之间关系:

[][]()emp h R f R f l φ≤+

其中

()

h

l

为置信区间,是VC维h的增函数,也是样本数l的减函数。右端称为结构风险,

它是期望风险

[]

R f的一个上界。经验风险的最小依赖较大的 F (样本数较多的函数集)

中某个f 的选择,但是 F 较大,则VC维较大,就导致置信区间变大,所以要想使期望风

险

[]

R f最小,必须选择合适的h和l来使不等式右边的结构风险最小,这就是结构风险最

小化归纳原则。

实现SRM的思路之一就是设计函数集的某种结构使每个子集中都能取得最小的经验风险(如使训练误差为0),然后只需选择适当的子集使置信范围最小,则这个子集中使经验风险最小的函数就是最优函数。SVM方法实际上就是这种思想的具体实现。

主要思想:

SVM方法是从线性可分情况下的最优分类面提出的,它是实现统计学习理论思想的方法。所谓最优分类面就是要求分类面不但能将两类无错误地分开,而且要使两类的分类间隔最大。前者是保证经验风险最小(如使训练误差为0),而使分类间隔最大实际上就是使推广性的界中的置信范围最小,从而使真实风险最小。

构造这个最优分类面的方法有2个:平分最近点法和最大间隔法。这两个方法求解得到的是同一个超平面,这个方法就称为“线性可分支持向量分类机”。其实,这个分类机是将最大间隔法求解最优分类面的最优化问题转化为其对偶问题,从而通过求解相对简单的对偶问题来求解原分类问题的算法。随后引入松弛变量和惩罚因子来解决非线性分类问题,并且允许一定的分类错误,最终得到非线性软间隔的标准的C-支持向量机(C-SVC)。其中的巧妙之处就在于把一个复杂的最优化问题的求解简化为对原有样本数据的内积运算。我们要做的就是选择适当的核函数及其参数、惩罚因子就可以了。

对于线性不可分情况,则通过核函数,把输入映射到另一个空间中,在新的空间中使用线性支持向量机。

核函数:

核方法在数学中是个古老的命题.通过一个特征映射可以将输入空间(低维的)中的线性不可分数据映射成高维特征空间中(再生核Hilbert空间)中的线性可分数据.这样就可以在特征空间使用SVM方法了.因为使用svm方法得到的学习机器只涉及特征空间中的内积,而内积又可以通过某个核函数(所谓Mercer核)来表示,因此我们可以利用核函数来表示最终的学习机器.这就是所谓的核方法.核函数本质上是对应于高维空间中的内积的,从而与生成高维空间的特征映射一一对应.核方法正是借用这一对应关系隐性的使用了非线性特征映射(当然也可以是线性的).这一方法即使得我们能够利用高维空间让数据变得易于处理----不可分

的变成可分的,同时又回避了高维空间带来的维数灾难-----不用显式表达特征映射.

核技巧把高维空间中两个点的内积计算,用原来空间中的两个模式的简单函数即核函数的求值来代替。核技巧不仅应用于支持向量机,还可以应用于那些含有内积计算的非线性算法。例如函数逼近,主成分分析等等。

在支持向量机中使用的核函数主要有四类:

线性核函数:

(,)T

i j i j K X X X X

=

多项式核函数:

(,)(),0

T d

i j i j

K X X X X r

γγ

=+>

RBF核函数:

2 (,)exp(||||),0

i j i j

K X X X X

γγ

=-->

Sigmoid核函数:

(,)tanh()

T

i j i j

K X X X X r

γ

=+

其中,

,r

γ

和d均为核参数。

究竟用哪一种核函数取决对数据处理的要求,不过建议一般都是使用RBF核函数。因为RBF核函数具有良好的性态,在实际问题中表现出了良好的性能。

软件工具:

支持向量机的软件工具主要有LIBSVM和SVMLight,其中我详细了解了LIBSVM。LIBSVM 是一个开源的软件包,是台湾大学林智仁博士等开发的,可以解决上面所提到的三类机器学习基本问题,提供了线性、多项式、径向基和S形函数四种常用的核函数供选择。

LIBSVM 使用的一般步骤是:

1)按照LIBSVM软件包所要求的格式准备数据集;

2)对数据进行简单的缩放操作;

3)考虑选用RBF 核函数

2

(,)exp(||||),0

i j i j

K X X X X

γγ

=-->

;

4)采用交叉验证选择最佳参数C与g ;

5)采用最佳参数C与g 对整个训练集进行训练获取支持向量机模型;

6)利用获取的模型进行测试与预测。

应用领域

SVM可以用于模式识别、函数逼近和概率密度估计.

总的来说,SVM能够较好的解决小样本,非线性,高维数识别和局部极小点等问题。

详细说来,可以应用于如下领域:人脸检测,故障诊断,分类,回归,聚类,时间序列预测,系统辨识,金融工程,生物医药信号处理,数据挖掘,生物信息,文本挖掘,自适应信号处理,剪接位点识别,基于支持向量机的数据库学习算法,手写体相似字识别,支持向量机函数拟合在分形插值中的应用,基于支持向量机的惯导初始对准系统,岩爆预测的支持向量机,缺陷识别,计算机键盘用户身份验证,视频字幕自动定位于提取,说话人的确认,等等。

研究方向:

虽然SVM 方法在理论上具有很突出的优势, 但与其理论研究相比,应用研究尚相对比较滞后, 所以现在的主要的研究方向就是SVM的应用。包括SVM在新领域的应用以及跟其他方法的结合。例如SVM决策树可以用于多层分类。

所以,归纳如下

核函数的构造和参数的选择;支持向量机从两类问题向多类问题的推广;更多的应用领域的推广;与目前其它机器学习方法的融合;与数据预处理(样本的重要度,属性的重要度,特征选择等)方面方法的结合,将数据中脱离领域知识的信息,即数据本身的性质融入支持向量机的算法中从而产生新的算法;支持向量机训练算法的探索。

阅读材料

1.数据挖掘中的新方法-支持向量机邓乃扬田英杰著

2.支持向量机导论

3. A practical guide to SVM classification.pdf

4. LibSVM-2.6 程序代码注释.pdf

5. 一种新的SVm决策树.pdf

6. 2000年26卷1期-关于统计学习理论与向量机.pdf

7 支持向量机的研究现状与进展.pdf

8. 统计学习理论的本质

第六章 函数逼近与函数插值 本章介绍函数逼近与插值的有关理论和算法. 函数逼近问题与插值问题两者既有联系又有区别,它们都是用较简单的函数来近似未知的、或表达式较复杂的函数. 一般来说,函数逼近是要在整个区间、或一系列离散点上整体逼近被近似函数,而在进行插值时,则须保证在若干自变量点上的函数值与被近似函数相等. 6.1 函数逼近的基本概念 进行函数逼近一般是在较简单的函数类Φ中找一个函数p(x)来近似给定的函数f(x),以使得在某种度量意义下误差函数p (x )?f(x)最小. 被逼近函数f(x)可能是较复杂的连续函数,也可能是只在一些离散点上定义的表格函数,而函数类Φ可以是多项式、分段多项式、三角函数、有理函数,等等. 函数逼近问题中度量误差的手段主要是函数空间的范数,下面先介绍函数空间的范数、内积等有关概念,然后讨论函数逼近问题的不同类型. 6.1.1 函数空间 线性空间的概念大家都很熟悉,其定义中包括一个元素集合和一个数域,以及满足一定运算规则的“加法”和“数乘”运算. 简单说,若这个元素集合对于“加法”和“数乘”运算封闭,则为一线性空间. 线性空间的元素之间存在线性相关和线性无关两种关系,进而又有空间的基和维数的概念. 在这里我们先考虑连续函数形成的线性空间. 例如C [a,b ]按函数加法、以及函数与实数乘法,构成一个线性空间. 对于[a,b]区间上所有k 阶导数连续的函数全体C k [a,b ],也类似地构成一个线性空间. 我们一般讨论实数函数,因此对应的是实数域?,若讨论复数函数,则相应的是复数域?. 另外,与线性代数中讨论的向量空间?n 不同,连续函数空间是无限维的. 对线性空间可以定义范数的概念(见3.1.2节). 针对实连续函数空间C [a,b ],与向量空间类似,可定义如下三种函数的范数(function norm): 1) ∞-范数 设f (x )∈C [a,b ],则‖f (x )‖∞=max x∈[a,b ]|f (x )| . 其几何意义如图6-1所示,即函数值绝 对值的最大值. 2) 1-范数 ‖f (x )‖1=∫|f (x )|dx b a . 其几何意义如图6-2所示,即函数曲线 与横轴之间的面积总和. 3) 2-范数 ‖f (x )‖2=[∫f 2(x )dx b a ]1/2. 2-范数也常称为平方范数,其几何意义 与1-范数类似. 线性空间还有一个重要概念是内积,它 定义了空间中两个元素的一种运算. 下面给出一般的复数域上线性空间内积的定义.

智能控制理论及应用作业 1资料查询 BP 神经网络的主要应用: 人脸识别、风电功率预测、短时交通流混沌预测、高炉熔渣粘度预测、汇率预测、价格预测、函数逼近等 Rbf神经网络的主要应用: 函数逼近、短时交通流预测、模式识别、降水预测、民航客运量预测、遥感影像分析、声纹识别、语言识别、人脸识别、车牌识别、汇率预测 Hopfield网络应用: 车牌识别、图像识别、遥感影像分类、字母识别、交通标志识别、优化计算中的应用、联想记忆存储器的实现、 2 BP编程算法: 2.1 利用样本训练一个BP网络 注:此程序自李国勇书中学习而来 程序部分: function [ output_args ] = bp( input_args ) %UNTITLED Summary of this function goes here % Detailed explanation goes here %此设计为两层BP神经网络,3输入,3隐含层节点,两个输出 %初始化部分: lr=0.05; %%需要给定学习速率 error_goal=0.001; %期望的误差 max_epoch=100000; %训练的最大步长 a=0.9; %惯性系数 Oi=0; Ok=0; %给两组输入,以及目标输出: X=[1 1 1;-1 -1 1;1 -1 1;]; %随便给一组输入输入,训练BP网络

T=[1 1 1 ;1 1 1]; %X=-1:0.1:1; %输入范围 %T=sin(pi*X); %X=[] q=3; %隐含层的节点数自己定义,在此给3个 %初始化 [M,N]=size(X); %输入节点个数为M,N为样本数 [L,N]=size(T); %输出节点个数为L wij=rand(q,M); %先给定加权系数一组随机值 wki=rand(L,q); wij0=zeros(size(wij)); %加权系数矩阵的初始值 wki0=zeros(size(wki)); for epoch=1:max_epoch %计算开始 NETi=wij*X; %各个隐含层的净输入 for j=1:N for i=1:q Oi(i,j)=2/(1+exp(-NETi(i,j)))-1; %再输入作用下,隐含层的输出 end end NETk=wki*Oi; %各个输出层的净输入 for i=1:N for k=1:L Ok(k,i)=2/(1+exp(-NETk(k,i)))-1; %在输入作用下,输出层的输出end end E=((T-Ok)'*(T-Ok))/2; %性能指标函数,就是误差 if(E 二次函数配方法练习集团文件发布号:(9816-UATWW-MWUB-WUNN-INNUL-DQQTY- 1.抛物线y =2x 2-3x -5配方后的解析式为顶点坐标为______.当x =______时,y 有最______值是______,与x 轴的交点是______,与y 轴的交点是______,当x ______时,y 随x 增大而减小,当x ______时,y 随x 增大而增大. 2.抛物线y =3-2x -x 2的顶点坐标是______,配方后为 它与x 轴的交点坐标是______,与y 轴的交点坐标是______. 3.把二次函数y =x 2-4x +5配方成y =a (x -h )2+k 的形式,得______,这个函数的 图象有最______点,这个点的坐标为______. 4.已知二次函数y =x 2+4x -3,配方后为当x =______时,函数y 有最值______,当 x ______时,函数y 随x 的增大而增大,当x =______时,y =0. 5.抛物线y =ax 2+bx +c 与y =3-2x 2的形状完全相同,只是位置不同,则a =______. 6.抛物线y =2x 2如何变化得到抛物线y =2(x -3)2+4.请用两种方法变换。 7.抛物线y =-3x 2-4的开口方向和顶点坐标分别是() A .向下,(0,4) B .向下,(0,-4) C .向上,(0,4) D .向上,(0,-4) 8.抛物线x x y --=221 的顶点坐标是() A .)21,1(- B .)21,1(- C .)1,21 (- D .(1,0) Kernel Functions for Machine Learning Applications 机器学习中的核函数 1.核函数概述 In recent years, Kernel methods have received major attention, particularly due to the increased popularity of the Support Vector Machines. Kernel functions can be used in many applications as they provide a simple bridge from linearity to non-linearity for algorithms which can be expressed in terms of dot products. In this article, we will list a few kernel functions and some of their properties. Many of these functions have been incorporated in https://www.doczj.com/doc/5c7272570.html,, a extension framework for the popular https://www.doczj.com/doc/5c7272570.html, Framework which also includes many other statistics and machine learning tools. 2.机器学习中的核函数 Kernel Methods(核函数方法) Kernel methods are a class of algorithms for pattern analysis or recognition, whose best known element is the support vector machine (SVM). The general task of pattern analysis is to find and study general types of relations (such as clusters, rankings, principal components, correlations, classifications) in general types of data (such as sequences, text documents, sets of points, vectors, images, graphs, etc) (Wikipedia, 2010a). The main characteristic of Kernel Methods, however, is their distinct approach to this problem. Kernel methods map the data into higher dimensional spaces in the hope that in this higher-dimensional space the data could become more easily separated or better structured. There are also no constraints on the form of this mapping, which could even lead to infinite-dimensional spaces. This mapping function, however, hardly needs to be computed because of a tool called the kernel trick. The Kernel Trick(核函数构造) The kernel trick is a mathematical tool which can be applied to any algorithm which solely depends on the dot product between two vectors. Wherever a dot product is used, it is replaced by a kernel function. When properly applied, those candidate linear algorithms are transformed into a non-linear algorithms (sometimes with little effort or reformulation). Those non-linear algorithms are equivalent to their linear originals operating in the range space of a feature space φ. However, because kernels are used, the φ function does not need to be ever explicitly computed. This is highly desirable, as we noted previously, because this higher-dimensional feature space could even be infinite-dimensional and thus infeasible to compute. There are also no constraints on the nature of the input vectors. Dot products could be defined between any kind of structure, such as trees or strings. Kernel Properties(核函数特性) Kernel functions must be continuous, symmetric, and most preferably should have a positive (semi-) definite Gram matrix. Kernels which are said to satisfy the Mercer's theorem are positive 第六章函数逼近https://www.doczj.com/doc/5c7272570.html,/shuzhifenxi/index.htm 第一节曲线拟合的最小二乘法 问题的背景 通过观测、测量或试验得到某一函数在x1 ,x2,…,x n的函数值. 我们可以用插值的方法对这一函数进行近似,而插值方法要求所得到的插值多项式经过已知的这n个插值结点;在n比较大的情况下, 插值多项式往往是高次多项式, 这也就容易出现振荡现象:虽然在插值结点上没有误差,但在插值结点之外插值误差变得很,从“整体”上看,插值逼近效果将变得“很差”. 于是, 我们采用数据拟合的方法. 定义1 数据拟合就是求一个简单的函数φ(x), 例如是一个低次多项式,不要求通过已知的这n个点,而是要求在整体上“尽量好”的逼近原函数,这时在每个已知点上就会有误差y k -φ(x k),(k=1,2,…,n),数据拟合就是从整体上使误差 y k -φ(x k),(k=1,2,…,n), 尽量的小一些. 如果要求: 达到最小,因误差y k -φ(x k)可正可负 本来很大的误差可能会正负抵消,这样的提法不合理,为防止正负抵消,可以要求:达到最小,但是由于绝对值函数不可以求导,分析起来不方便,求解也很难. 为了既能防止正负抵消,又能便于我们分析、求解,提出如下问题: 求一个低次多项式φ(x) ,使得: 达到最小,此问题便是一个数据拟合的最小二乘问题. 一、直线拟合(一次函数) 通过观测、测量或试验得到某一函数在x1 ,x2,…,x n的函数值:y1 ,y2,…,y n ,即得到n组数据(x1 ,y1 ),(x2 ,y2),…,(x n ,y n ),如果这些数据在直角坐标系中近似地分布在一条直线上,我们可以用直线拟合的方法. 已知数据(x1 ,y1 ),(x2 ,y2),…,(x n ,y n ),求一次多项式φ(x)=a+bx(实际上,就是求a,b), 使得: (1) 达到最小. 注意到Q(a,b)中,x k ,y k均是已知的,而a,b是未知量,Q(a,b)是未知 量a,b的二元函数,利用高等数学求二元函数极 小值(最小值)的方法,上述问题转化为求解下 列方程组: 的解. 神经网络作业(函数逼近) 智能控制理论及应用作业 1资料查询 BP 神经网络的主要应用: 人脸识别、风电功率预测、短时交通流混沌预测、高炉熔渣粘度预测、汇率预测、价格预测、函数逼近等 Rbf神经网络的主要应用: 函数逼近、短时交通流预测、模式识别、降水预测、民航客运量预测、遥感影像分析、声纹识别、语言识别、人脸识别、车牌识别、汇率预测 Hopfield网络应用: 车牌识别、图像识别、遥感影像分类、字母识别、交通标志识别、优化计算中的应用、联想记忆存储器的实现、 2 BP编程算法: T=[1 1 1 ;1 1 1]; %X=-1:0.1:1; %输入范围 %T=sin(pi*X); %X=[] q=3; %隐含层的节点数自己定义,在此给3个 %初始化 [M,N]=size(X); %输入节点个数为M,N为样本数 [L,N]=size(T); %输出节点个数为L wij=rand(q,M); %先给定加权系数一组随机值 wki=rand(L,q); wij0=zeros(size(wij)); %加权系数矩阵的初始值 wki0=zeros(size(wki)); for epoch=1:max_epoch %计算开始 NETi=wij*X; %各个隐含层的净输入 for j=1:N for i=1:q Oi(i,j)=2/(1+exp(-NETi(i,j)))-1; %再输入作用下,隐含层的输出 end end NETk=wki*Oi; %各个输出层的净输入 for i=1:N for k=1:L Ok(k,i)=2/(1+exp(-NETk(k,i)))-1; %在输入作用下,输出层的输出 end end E=((T-Ok)'*(T-Ok))/2; %性能指标函数,就是误差 if(E 二次函数配方法练习 The latest revision on November 22, 2020 1.抛物线y =2x 2-3x -5配方后的解析式为顶点坐标为______.当x =______时,y 有最______值是______,与x 轴的交点是______,与y 轴的交点是______,当x ______时,y 随x 增大而减小,当x ______时,y 随x 增大而增大 . 2.抛物线y =3-2x -x 2的顶点坐标是______,配方后为 它与x 轴的交点坐标是______,与y 轴的交点坐标是______. 3.把二次函数y =x 2-4x +5配方成y =a (x -h )2+k 的形式,得______,这个函数的图象有最______点,这个点的坐标为______. 4.已知二次函数y =x 2+4x -3,配方后为当x =______时,函数y 有最值______,当x ______时,函数y 随x 的增大而增大,当x =______时,y =0. 5.抛物线y =ax 2+bx +c 与y =3-2x 2的形状完全相同,只是位置不同,则a =______. 6.抛物线y =2x 2如何变化得到抛物线y =2(x -3)2+4.请用两种方法变换。 7.抛物线y =-3x 2-4的开口方向和顶点坐标分别是() A .向下,(0,4) B .向下,(0,-4) C .向上,(0,4) D .向上,(0,-4) 8.抛物线x x y --=221 的顶点坐标是() A .)21,1(- B .)21,1(- C .)1,21 (- D .(1,0) BP网络实现分类问题 一,问题的提出 根据感知器的的相关理论易知感知器善于解决线性可分问题,而不能解决XOR问题,所以引进了BP网络,并通过相关知识来解决分类问题。 反向传播网络(Back-Propagation Network,简称BP网络)是将W-H学习规则一般化,对非线性可微分函数进行权值训练的多层网络。BP网络主要用于函数逼近,模式识别,分类,数据压缩。在人工神经网络的实际应用中,80%~90%的人工神经网络模型是采用BP网络或它的变化形式,也是前行网络的核心部分,体现了人工神经网络最精华的部分。 一个具有r个输入和一个隐含层的神经网络模型结构如图所示 下图所示是S型激活函数的图型,可以看到f ()是一个连续可微的函数,一阶导数存在。对于多层网络,这种激活函数所划分的区域不再是线性划分,而是有一个非线性的超平面组成的区域。它还可以严格利用梯度算法进行推算,他的权值修正的解析式十分明确,其算法被称为误差反向传播法,简称SP算法。 BP算法是有两部分组成:信息的正向传递与误差的反向传播。在正向传播过程中,输入信息从输入经隐含层逐层计算传向输出层,每一层神经元的状态值影响下一层神经元的状态。如果在输出层没有得到期望的输出,则计算输出层的误差变化值,然后转向反向传播,通过网络将误差信号沿原来的连接通路反传回来修改各层神经元的权值直至达到期望的目标。 BP网络分类问题 原程序: function main() InDim=2; % 样本输入维数OutDim=3; % 样本输出维数 % figure % colordef(gcf,'white') % echo off % clc % axis([-2,2,-2,2]) % axis on % grid % xlabel('Input x'); 龙源期刊网 https://www.doczj.com/doc/5c7272570.html, 核函数选择方法研究 作者:王振武何关瑶 来源:《湖南大学学报·自然科学版》2018年第10期 摘要:核函数的选择对支持向量机的分类结果有着重要的影响,为了提高核函数选择的客观性,提出了一种以错分实例到支持向量所在界面的距离来表示错分程度,并基于此进行秩和检验的核函数选择方法.通过与K折交叉验证、配对t测试等参数检验的统计方法进行对比 分析,对9种常用核函数的分类能力在15个数据集进行了定量研究.与参数检验方法不同,秩和检验并未假定数据的分布情况(很多情况下数据并不满足假定的分布),而且数据实验证明,秩和检验不但能够对核函数的分类能力进行客观评估,而且在某些数据集上还能产生更好的核函数选择效果. 关键词:核函数;支持向量机;秩和检验; K折交叉验证;配对t测试 中图分类号:TP301.6 文献标志码:A Abstract:The selection of kernel functions has an important influence on the classification results of support vector machines. This paper proposed a kernel functions selection method based on rank sum test in order to enhance the selection objectivity, where the error degree adopted in the rank sum test was represented by the distance between the error instance and the interface of support vectors. By comparing with other statistical methods, such as Kfolding cross validation and paired t test, the classification abilities of nine common kernel functions were quantitatively studied based on 15 datasets. Different from parameter test methods, the rank sum test does not assume the data distribution(in some cases data cannot satisfy the assumed distribution), the experimental data proves that the rank sum test not only can objectively evaluate the classification abilities of kernel functions, but also can produce better selection results on some data sets. Key words:kernel function; support vector machines; rank sum test; K folding cross validation; paired t test 支持向量機(Support Vector Machine,SVM)[1]的使用与核函数的正确选择是密不可分的,核函数技术巧妙地解决了在高维特征空间中计算的“维数灾难”等问题,直接决定了SVM 的非线性处理能力[2].当前对核函数选择方法的研究主要集中在构造新的核函数[3-7]、核函数参数选择[8-13]以及核函数的评估[1,14-16]上.由于在使用SVM进行分类的过程中只定义了核函数(并不显式地定义映射函数),所以在同一分类问题上选择不同的核函数对分类效果影响较大,另外映射函数的类型是多变的,在没有先验知识的情况下人们更多地是凭借主观经验进行核函数的选择,具有较大的随意性. 函数逼近与曲线拟合 3.1函数逼近的基本概念 3.1.1 函数逼近与函数空间 在数值计算中常要计算函数值,如计算机中计算基本初等函数及其他特殊函数;当函数只在有限点集上给定函数值,要在包含该点集的区间上用公式给出函数的 简单表达式,这些都涉及到在区间上用简单函数逼近已知复杂函数的问题,这就是函数逼近问题.上章讨论的插值法就是函数逼近问题的一种.本章讨论的函数逼近,是指“对函数类A中给定的函数,记作,要求在另一类简单的便于计算的函数类B中求函数,使与的误差在某种度量意义下最小”.函数类A通常是区间上的连续函数,记作,称为连续函数空间,而函数类B通常为n次多项式,有理函数或分段低次多项式等.函 数逼近是数值分析的基础,为了在数学上描述更精确,先要介绍代数和分析中一些基本概念及预备知识. 数学上常把在各种集合中引入某些不同的确定关系称为赋予集合以某种空间结构,并将为样的集合称为空间.例如将所有实n维向量组成集合,按向量加法及向量与数的乘法构成实数域上的线性空间,记作,称为n维向量空间.类似地,对次数不超过n(n为正整数)的实系数多项式全体,按通常多项式与多项式加法及数与多项式乘法也构成数域上的一个线性空间,用表示,称为多项式空间.所有定义在上的连续函数集合,按函数加法和数与函数乘法构 成数域上的线性空间,记作.类似地,记为具有p阶的连续导数的函数空间. 定义1设集合S是数域P上的线性空间,元素,如果存在不全为零的数,使得 , (3.1.1)则称线性相关.否则,若等式(3.1.1)只对成立,则称线性无关. 若线性空间S是由n个线性无关元素生成的,即对都有 则称为空间S的一组基,记为,并称空间S为n维空间,系数称为x在基下的坐标,记作,如果S中有无限个线性无关元素,…,则称S为无限维线性空间. 下面考察次数不超过n次的多项式集合,其元素表示为 , (3.1.2)它由个系数唯一确定.线性无关,它是的一组基,故,且是的坐标向量,是维的.对连续函数,它不能用有限个线性无关的函数表示,故是无限维的,但它的任一元素均可用有限维的逼近,使误差 (为任给的小正数),这就是著名的Weierstrass定理.定理1(Weierstrass)设,则对任何,总存在一个代数多项式,使 精品文档 1抛物线y = 2x2—3x—5配方后的解析式为 点坐标为______ .当x= ________ 时,y有最_______ 值是 _____ , 与x轴的交点是_______ ,与y轴的交点是______ ,当x _____ 时,y随x增大而减小,当x ______ 时,y随x增大而增大. 2. ____________________________________ 抛物线y = 3 —2x —x2的顶点坐标是___________________________ ,配方后为它与x轴的交点坐标是_______ ,与y轴的交点坐标是_______ . 3. 把二次函数y=x2—4x+ 5配方成y= a(x —h)2+ k的形式,得 ______ ,这个函数的图象有最________ 点,这个点的坐标为 4. 已知二次函数y = x2+ 4x—3,配方后为当x = ______ 时,函数y有最值____ ,当x 时,函数y随x 的增大而增 大,当x= __________________ 时,y= 0. 5. ____________ 抛物线y = ax2+bx+ c与y= 3—2x2的形状完全相同,只是位置不同,则a= . 6. 抛物线y= 2x2如何变化得到抛物线y = 2( x —3)2+ 4.请用两种 方法变换。 7. 抛物线y= —3x2—4的开口方向和顶点坐标分别是() A. 向下,(0 , 4) B. 向下,(0,—4) C. 向上,(0, 4) D.向 上,(0,—4) 8 .抛物线y -x2x的顶点坐标是() 2 A. (1, 1) B.( 1,2) C. (1, 1) D. (1 , 0) 课程作业 题目:函数逼近理论与方法 学院:数学与统计学院 专业:计算数学 研究方向:数字图像处理 学生姓名:安静 学号:2013201134 教师:张贵仓 函数逼近的理论与方法综述 函数逼近论是函数论的一个重要组成部分,涉及的基本问题是函数的近似表示问题。在数学的理论研究和实际应用中经常遇到下类问题:在选定的一类函数中寻找某个函数g,使它是已知函数在一定意义下的近似表示,并求出用g 近似表示而产生的误差。这就是函数逼近问题。在函数逼近问题中,用来逼近已知函数的函数类可以有不同的选择,即使函数类选定了,在该函数中用作的近似表示的函数g 的确定方式仍然是各式各样;g 对函数近似表达时产生的误差也有各种不同的含义。所以,函数逼近问题的提法具有多种多样的形式,其内容十分丰富。 一、 几种常用的插值函数 1.拉格朗日(Lagrange )插值 设y =()f x 是实变量x 的点值函数, 且已知()f x 在给定的1n +各互异点01,,,n x x x 处 得值01,, ,n y y y 即(),0, ,i i y f x i n ==差值的基本问题是, 寻求多项式()p x , 使得 (),0, ,i i p x y i n == (1-1) 设()p x 是一个m 次多项式()p x =2 012m m a a x a x a x ++++, 0m a ≠ 则差值问题是, 如何确定()p x 中的系数01,,,m a a a , 使得(1-1)式满足, 所以该问题等 价于求解下述的线性方程组 2 0102000 21112111 2012m m m m m m m m m n a a x a x a x y a a x a x a x y a a x a x a x y ?++++=?++++=??? ?++++= ? (1-2) 上述的线性方程组的系数矩阵为 2 00 02 11121 11 m m m n n m x x x x x x A x x x ????? ? =???????? 他是一个()()11n m +?+的矩阵. 当m A >时, A 的列数大于行数, 不难证明矩阵A 的秩数为1n +. 因为A 的前1n +列所组成的行列式为 SVM 小结 理论基础: 机器学习有三类基本的问题,即模式识别、函数逼近和概率密度估计. SVM 有着严格的理论基础,建立了一套较好的有限训练样本下机器学习的理论框架和通用方法。他与机器学习是密切相关的,很多理论甚至解决了机器学习领域的其他的问题,所以学习SVM 和机器学习是相辅相成的,两者可以互相促进,有助于机器学习理论本质的理解。 VC 维理论:对一个指示函数集,如果存在h 个样本能够被函数集中的函数按所有可能的2h 种形式分开,则称函数集能够把h 个样本打散;函数集的VC 维就是它能打散的最大样本数目。VC 维反映了函数集的学习能力,VC 维越太则学习机器越复杂(容量越太)。 期望风险:其公式为[](,,(,))(,)y R f c y f y dP y χχχχ?=?,其中(,,(,))c y f y χχ为损失函数,(,)P y χ为概率分布,期望风险的大小可以直观的理解为,当我们用()f χ进行预测时,“平均”的损失程度,或“平均”犯错误的程度。 经验风险最小化(ERM 准则)归纳原则:但是,只有样本却无法计算期望风险,因此,传统的学习方法用样本定义经验风险[]emp R f 作为对期望风险的估计,并设计学习算法使之最小化。即所谓的经验风险最小化(ERM 准则)归纳原则。经验风险是用损失函数来计算的。对于模式识别问题的损失函数来说,经验风险就是训练样本错误率;对于函数逼近问题的损失函数来说,就是平方训练误差;而对于概率密度估计问题的损失函数来说,ERM 准则就等价于最大似然法。但是,经验风险最小不一定意味着期望风险最小。其实,只有样本数目趋近于无穷大时,经验风险才有可能趋近于期望风险。但是很多问题中样本数目离无穷大很远,那么在有限样本下ERM 准则就不一定能使真实风险较小。ERM 准则不成功的一个例子就是神经网络和决策树的过学习问题(某些情况下,训练误差过小反而导致推广能力下降,或者说是训练误差过小导致了预测错误率的增加,即真实风险的增加)。 结构风险最小化理论(SRM):所以,在有限样本情况下,仅仅用ERM 来近似期望风险是行不通的。统计学习理论给出了期望风险[]R f 与经验风险[]emp R f 之间关系: [][]()emp h R f R f l φ≤+ 二次函数配方法练习 This model paper was revised by the Standardization Office on December 10, 2020 1.抛物线y =2x 2-3x -5配方后的解析式为 顶点坐标为 ______.当x =______时,y 有最______值是______,与x 轴的交点是______,与y 轴的交点是______,当x ______时,y 随x 增大而减小,当x ______时,y 随x 增大而增大. 2.抛物线y =3-2x -x 2的顶点坐标是______,配方后为 它与x 轴的交点坐标是______,与y 轴的交点坐标是______. 3.把二次函数y =x 2-4x +5配方成y =a (x -h )2+k 的形式,得______,这个函数的图象有最______点,这个点的坐标为______. 4.已知二次函数y =x 2+4x -3,配方后为 当x =______时,函数y 有最值______,当x ______时,函数y 随x 的增大而增大,当x =______时,y =0. 5.抛物线y =ax 2+bx +c 与y =3-2x 2的形状完全相同,只是位置不同,则a =______. 6.抛物线y =2x 2如何变化得到抛物线y =2(x -3)2+4.请用两种方法变换。 7.抛物线y =-3x 2-4的开口方向和顶点坐标分别是( ) A .向下,(0,4) B .向下,(0,-4) C .向上,(0,4) D .向上,(0,-4) 8.抛物线x x y --=22 1的顶点坐标是( ) 函数逼近的几种算法及其应用 摘要 在自然科学与技术科学领域中存在着大量的需要解决的非线性问题.近年来人们在数值与函数逼近问题以及计算机辅助几何设计的研究中取得了一系列深刻的结果.随着高性能、大容量计算机的出现,使得过去难以实现的问题变为可能,所以关于函数逼近的理论研究和应用有着巨大的发展潜力.本课设中共有两章,第一章介绍了函数逼近的产生及研究意义,基础知识,最佳平方逼近法,曲线拟合的最小二乘法,有理逼近,三角多项式逼近的算法的几种函数比较方式.第二章从函数逼近的应用角度,详细介绍了有理函数逼近在数值优化中的应用和泰勒级数判定迭代法的收敛速度,以及几种函数逼近的计算实例. 关键词最佳平方逼近法;曲线拟合的最小二乘法;有理逼近;三角多项式逼近; 帕徳逼近 目录 引言 (1) 第一章函数逼近 (2) §1.1 函数逼近的产生背景及研究意义 (2) §1.2 基础知识 (3) §1.2.1 函数逼近与函数空间 (3) §1.2.2 数与赋空间 (4) §1.3 最佳平方逼近 (5) §1.3.1 最佳平方逼近及其计算 (5) §1.3.2 用正交函数组作最佳平方逼近 (6) §1.4 有理逼近 (8) §1.4.1 有理逼近的定义及构造 (8) §1.4.2 有理插值函数的存在性 (9) §1.4.3 有理插值函数的唯一性 (10) §1.4.4 几种常见的有理逼近 (11) §1.5 三角多项式逼近与多项式逼近 (12) §1.5.1 三角多项式逼近 (12) §1.5.2 傅里叶级数的一致收敛性 (12) §1.5.3 以2π为周期的连续函数的三角多项式逼近 (13) §1.5.4 [0,π]上连续函数的三角多项式逼近 (14) §1.5.5 闭区间上连续函数的三角多项式逼近 (14) §1.5.6 闭区间上连续函数的多项式逼近 (15) §1.6 其他函数逼近 (15) §1.6.1 曲线拟合的最小二乘法 (15) §1.6.2 泰勒级数 (16) 第二章函数逼近应用 (18) §2.1 有理逼近在数值优化中的应用 (18) §2.1.1 直线搜索方法 (18) §2.1.2 计算方法 (19) §2.1.3 计算实例 (19) §2.2 各种泰勒级数判定迭代法的收敛速度 (20) §2.3 各种函数逼近的计算实例 (21) §2.3.1 最佳平方逼近多项式计算实例 (21) §2.3.2 曲线拟合的最小二乘法计算实例 (22) §2.3.3 帕德逼近的计算实例 (23) 参考文献 (24) 初三二次函数配方法,公式法及通过3个点求二次函数解析式计算练习 每天2题,第一题用配方法求顶点坐标,第二题用公式求顶点坐标 214y x x =+、 236y x x =-2、 226y x x =-3、 210y x x =+4、 223y x x =--5、 243y x x =++6、 232y x x =++7、 236y x x =--8、 261y x x =-+-9、 2285y x x =-+-10、 2367y x x =-+-11、 242y x x =-+-12、 213142y x x =--、 2114632y x x = -+、 2115452 y x x =-+、 216262y x x =--、 2117233y x x =-++、 21118423 y x x =--、 21119223y x x =--、 21323 y x x =-++20、 以下题目每天做一题 21、二次函数图像过点A(0,1),B(1,3),C(-1,1),求二次函数解析式 22、二次函数图像过点A(1,0),B(2,0),C(3,4),求二次函数解析式 23、二次函数图像过点A(0,1),B(-1,3),C(2,3),求二次函数解析式 24、二次函数图像过点A(1,0),B(3,0),C(2,-1),求二次函数解析式 25-、二次函数图像过顶点A(1,3)和点B(2,5),求二次函数解析式 263、二次函数图像过顶点A(-,-10)和点B(1,6),求二次函数解析式 答案 1、(-2,-4) 2、(1,-3) 3、39,22??- ??? 4、(-5,-25) 5、39,48??- ??? 6、(-2,-1) 7、31,24??-- ??? 8、(-1,3) 9、(3,8) 10、(2,3) 11、(1,-4) 12、(2,2) 13、(-1,3) 14、(6,-15) 15、(4,-3) 16、313, 22??- ??? 17、(3,6) 18、256,2??- ??? 19、 73,2? ?- ??? 20、935,24?? ??? 21、21y x x =++ 22、2264y x x =-+ 23、21y x x =-+ 24、243y x x =-+ 25、22(x 1)39y = ++ 26、2(x 3)10y =+- 核函数方法简介 (1)核函数发展历史 早在1964年Aizermann等在势函数方法的研究中就将该技术引入到机器学习领域,但是直到1992年Vapnik等利用该技术成功地将线性SVMs推广到非线性SVMs时其潜力才得以充分挖掘。而核函数的理论则更为古老,Mercer定理可以追溯到1909年,再生核希尔伯特空间(Reproducing Kernel Hilbert Space, RKHS)研究是在20世纪40年代开始的。 (2)核函数方法原理 核函数方法原理 根据模式识别理论,低维空间线性不可分的模式通过非线性映射到高维特征空间则可能实现线性可分,但是如果直接采用这种技术在高维空间进行分类或回归,则存在确定非线性映射函数的形式和参数、特征空间维数等问题,而最大的障碍则是在高维特征空间运算时存在的“维数灾难”。采用核函数技术可以有效地解决这样问题。 设x,z∈X,X属于R(n)空间,非线性函数Φ实现输入空间X到特征空间F的映射,其中F 属于R(m),n<二次函数配方法练习

机器学习中的核函数

第六章 函数逼近

神经网络作业(函数逼近)

二次函数配方法练习

BP函数逼近

核函数选择方法研究

函数逼近与曲线拟合

二次函数配方法练习

函数逼近的理论与方法综述

核函数

二次函数配方法练习

函数逼近的几种算法和应用

初三二次函数配方法,公式法及通过3个点求二次函数解析式计算练习有答案

核函数方法简介(亮亮修正版)