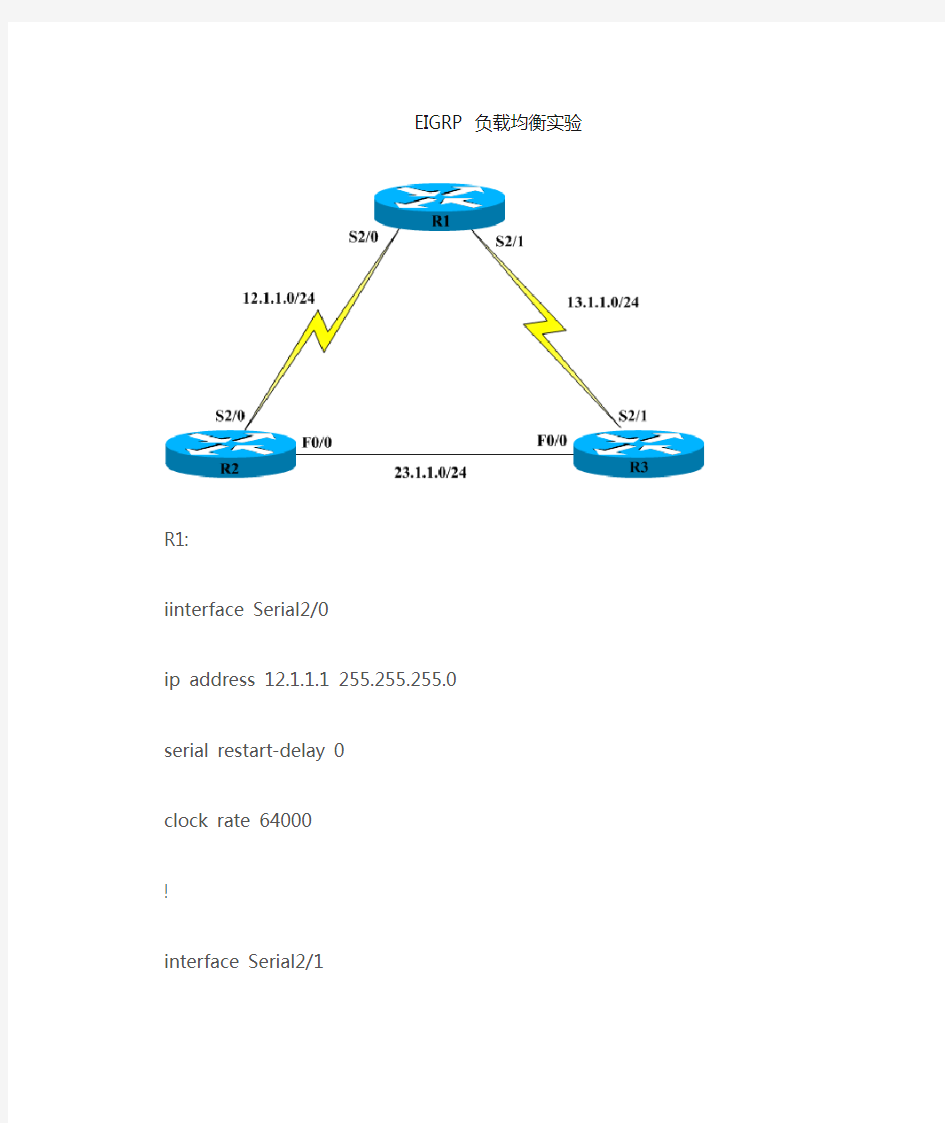

EIGRP 负载均衡实验

R1:

iinterface Serial2/0

ip address 12.1.1.1 255.255.255.0

serial restart-delay 0

clock rate 64000

!

interface Serial2/1

ip address 13.1.1.1 255.255.255.0

serial restart-delay 0

clock rate 64000

router eigrp 100

network 0.0.0.0

no auto-summary

R2:

interface FastEthernet0/0

ip address 23.1.1.1 255.255.255.0 duplex auto

speed auto

interface Serial2/0

ip address 12.1.1.2 255.255.255.0 serial restart-delay 0

router eigrp 100

network 0.0.0.0

no auto-summary

R3:

interface FastEthernet0/0

ip address 23.1.1.2 255.255.255.0 duplex auto

speed auto

interface Serial2/1

ip address 13.1.1.2 255.255.255.0 serial restart-delay 0

router eigrp 100

network 0.0.0.0

no auto-summary

R3路由表:

R3#show ip rou

Gateway of last resort is not set

23.0.0.0/24 is subnetted, 1 subnets

C 23.1.1.0 is directly connected, FastEthernet0/0

12.0.0.0/24 is subnetted, 1 subnets

D 12.1.1.0 [90/2172416] via 23.1.1.1, 00:01:06, FastEthernet0/0 //去

12.1.1.0网段via f0/0

13.0.0.0/24 is subnetted, 1 subnets

C 13.1.1.0 is directly connected, Serial2/1

R3#show ip eigrp to

IP-EIGRP Topology Table for AS(100)/ID(23.1.1.2)

Codes: P - Passive, A - Active, U - Update, Q - Query, R - Reply,

r - reply Status, s - sia Status

P 12.1.1.0/24, 1 successors, FD is 2172416

via 23.1.1.1 (2172416/2169856), FastEthernet0/0

via 13.1.1.1 (2681856/2169856), Serial2/1

P 13.1.1.0/24, 1 successors, FD is 2169856

via Connected, Serial2/1

P 23.1.1.0/24, 1 successors, FD is 28160

via Connected, FastEthernet0/0

//拓扑表中有两条可以到12.1.1.0网段的路径,F0/0和S1/1,经过s1/1那条路径的AD小于正在使用路由条目的FD2172416,所以被选为FS放在拓扑表中.

要想实验负载均衡,可以用的办法:

等价负载均衡(1):使得metric值相同

1.改带宽(不推荐,因为改带宽要用107 去除,会得到小数,)

2.改延迟,在R3上改f0/0 或s1/1其中的一个

R3#show inter f0/0

FastEthernet0/0 is up, line protocol is up

Hardware is AmdFE, address is cc02.07fc.0000 (bia cc02.07fc.0000) Internet address is 23.1.1.2/24

MTU 1500 bytes, BW 100000 Kbit, DLY 100 usec,

-----------------------------------------------------------------------

R3#show int s2/1

Serial2/1 is up, line protocol is up

Hardware is M4T

Internet address is 13.1.1.2/24

MTU 1500 bytes, BW 1544 Kbit, DLY 20000 usec,

先改s2/1

R3(config-if)#delay ?

<1-16777215> Throughput delay (tens of microseconds)

延迟路由器会自动乘以10所以这里要改成和f0/0 的DLY一样只需

R3(config-if)#delay 10

R3#clear ip eigrp neighbors

邻居关系重新建立

R3#show ip eigrp to

IP-EIGRP Topology Table for AS(100)/ID(23.1.1.2)

Codes: P - Passive, A - Active, U - Update, Q - Query, R - Reply, r - reply Status, s - sia Status

P 12.1.1.0/24, 2 successors, FD is 2172416

via 13.1.1.1 (2172416/2169856), Serial2/1

via 23.1.1.1 (2172416/2169856), FastEthernet0/0

P 13.1.1.0/24, 1 successors, FD is 1660416

via Connected, Serial2/1

P 23.1.1.0/24, 1 successors, FD is 28160

via Connected, FastEthernet0/0

R3#show ip route

Gateway of last resort is not set

23.0.0.0/24 is subnetted, 1 subnets

C 23.1.1.0 is directly connected, FastEthernet0/0

12.0.0.0/24 is subnetted, 1 subnets

D 12.1.1.0 [90/2172416] via 23.1.1.1, 00:01:08, FastEthernet0/0 [90/2172416] via 13.1.1.1, 00:01:08, Serial2/1

13.0.0.0/24 is subnetted, 1 subnets

C 13.1.1.0 is directly connected, Serial2/1

metric值已经相同,路由表中有两条路由,负载均衡成功!

当然也可以修改f0/0

R3(config)#int f0/0

R3(config-if)#delay 2000 一样可能达到负载均衡的效果

等价负载均衡(2): offset-list

P 12.1.1.0/24, 1 successors, FD is 2172416

via 23.1.1.1 (2172416/2169856), FastEthernet0/0

via 13.1.1.1 (2681856/2169856), Serial2/1

R3(config)#access-list 1 permit 12.1.1.0

R3(config)#router eigrp 100

R3(config-router)#offset-list 1 in 509440 f0/0

在这里只能改小的,大的减小的即为偏移的值,其中有个参数”in”,如果对自己产生影响用”in”如果对外面产生影响用”out”,509440是偏移值,后面还有个接口,是说,在这个接口上加上偏移值,如果不定义接口,默认在所有接口加偏移值.

R3#show ip rout

Gateway of last resort is not set

23.0.0.0/24 is subnetted, 1 subnets

C 23.1.1.0 is directly connected, FastEthernet0/0

12.0.0.0/24 is subnetted, 1 subnets

D 12.1.1.0 [90/2681856] via 23.1.1.1, 00:00:04, FastEthernet0/0 [90/2681856] via 13.1.1.1, 00:00:04, Serial2/1

13.0.0.0/24 is subnetted, 1 subnets

C 13.1.1.0 is directly connected, Serial2/1

不等价负载均衡:variance

P 12.1.1.0/24, 1 successors, FD is 2172416

via 23.1.1.1 (2172416/2169856), FastEthernet0/0

via 13.1.1.1 (2681856/2169856), Serial2/1

R3(config)#router eigrp 100

R3(config-router)#var

R3(config-router)#variance ?

<1-128> Metric variance multiplier

R3(config-router)#variance 2

R3#show ip rou

Gateway of last resort is not set

23.0.0.0/24 is subnetted, 1 subnets

C 23.1.1.0 is directly connected, FastEthernet0/0

12.0.0.0/24 is subnetted, 1 subnets

D 12.1.1.0 [90/2172416] via 23.1.1.1, 00:00:45, FastEthernet0/0

[90/2681856] via 13.1.1.1, 00:00:45, Serial2/1

13.0.0.0/24 is subnetted, 1 subnets

C 13.1.1.0 is directly connected, Serial2/1

Variance 默认为1,以最小的取一个倍数大于或者等于最大的.就可以实现不等价负载均衡

负载均衡默认时最大支持4条,修改后最大支持6条路径

当两条路负载均衡的时候,是不是各走一个包呢?不是,以前是按6:1算,即一条走6个另外一条走1个,现在新版本的IOS按实际的带宽得出一个比例

R3#show ip route 12.1.1.0

Routing entry for 12.1.1.0/24

Known via "eigrp 100", distance 90, metric 2172416, type internal Redistributing via eigrp 100

Last update from 13.1.1.1 on Serial2/1, 00:02:12 ago

Routing Descriptor Blocks:

* 23.1.1.1, from 23.1.1.1, 00:02:12 ago, via FastEthernet0/0

Route metric is 2172416, traffic share count is 120

Total delay is 20100 microseconds, minimum bandwidth is 1544 Kbit Reliability 255/255, minimum MTU 1500 bytes

Loading 1/255, Hops 1

13.1.1.1, from 13.1.1.1, 00:02:12 ago, via Serial2/1

Route metric is 2681856, traffic share count is 97

Total delay is 40000 microseconds, minimum bandwidth is 1544 Kbit Reliability 255/255, minimum MTU 1500 bytes

Loading 1/255, Hops 1

带”*”说明下一个包走这个路,关掉快速转发

R3(config)#no ip cef

用扩展PING

当PING到第N个包时就会走下面的13.1.1.1

为了只要我们PING的目的网段的包,可以加一条扩展的ACL

R3(config)#access-list 100 permit icmp any any

R3#debug ip packet 100

*Mar 1 01:04:54.543: IP: s=23.1.1.1 (FastEthernet0/0), d=23.1.1.2 (FastEthernet0/0), len 100, rcvd 3

*Mar 1 01:04:55.367: IP: s=13.1.1.2 (local), d=12.1.1.0 (Serial2/1), len 100, sending

*Mar 1 01:04:55.427: IP: tableid=0, s=13.1.1.1 (Serial2/1), d=13.1.1.2 (Serial2/1), routed via RIB

*Mar 1 01:04:55.431: IP: s=13.1.1.1 (Serial2/1), d=13.1.1.2 (Serial2/1), len 100, rcvd 3

*Mar 1 01:04:55.475: IP: tableid=0, s=13.1.1.2 (local), d=12.1.1.0 (Serial2/1), routed via RIB

广域网负载均衡 多链路广域网负载均衡 (1)Inbound多链路负载均衡算法策略:RTT+Topology+RoundRobin 具体描述: 当外部用户访问九州梦网网站时,首先由F5的3DNS对客户端的LDNS进行RTT(Round Trip Time)探测,对比从两条链路返回的探测结果(可以从统计列表中看到),选择一条返回值小的链路IP地址返回给客户端,从而客户端再发起访问请求;当F5的3DNS探测不到客户端的LDNS(由于LDNS安全防护等原因)时,F5的3DNS自动启用Topology算法,来静态匹配客户端的LDNS地理位置,从而根据客户端的来源,返回正确的A记录;当探测不到的LDNS又不在地址列表中时,F5 3DNS自动启用Global Availability 算法作为默认算法,将所有无法计算结果并且不在Topology范围之内的LocalDNS请求,定义到系统的默认线路上。 F5 的3DNS具备二十多种Inbound算法,可以根据需要进行组合。 ①RTT算法运行机制: 通过3DNS的RTT就近性算法会自动运算生成一个ldns就近分布表,通过这个动态的表,每个客户上来都会提供一个最快速的链路进行访问,由于站点有ISP1和ISP2的两条广域网线路。在3DNS上会针对站点服务器(以https://www.doczj.com/doc/2916830317.html, 为例)解析ISP1和ISP2的两个不同的公网地址。 对应于https://www.doczj.com/doc/2916830317.html,域名,在3DNS上配置wideip:https://www.doczj.com/doc/2916830317.html,,对应两个Virtual Server:VS1:202.106.83.177,VS2:219.17.66.100。分别属于ISP1和ISP2两条线路分配的IP地址段。在3DNS内部,同时定义两个DataCenter分别与ISP1和ISP2相对应。 用户的访问流程如下:

EIGRP和RIP单播实验 试验拓扑图如下: 根据拓扑图,做好相应基本配置并启用EIGRP协议 一 RA(config)#router eigrp 99 RA(config-router)#passive-int s1/0 *Aug 8 03:25:24.827: %DUAL-5-NBRCHANGE: IP-EIGRP(0) 99: Neighbor 12.1.1.2 (Seria l1/0) is down: interface passive RA#show ip eig nei IP-EIGRP neighbors for process 99 将RTA的s1/0接口被动掉并查看邻居表,发现此时邻居表为空,即A丢失与B的邻居关系,为了得到更详细的信息,查看一下Hello包的发送情况RA#debug eigrp packets EIGRP Packets debugging is on (UPDATE, REQUEST, QUERY, REPLY, HELLO, IPXSAP, PROBE, ACK, STUB, SIAQUE RY, SIAREPLY) RA# *Aug 8 03:27:51.179: EIGRP: Sending HELLO on Loopback0 *Aug 8 03:27:51.179: AS 99, Flags 0x0, Seq 0/0 idbQ 0/0 iidbQ un/rely 0/0 *Aug 8 03:27:51.179: EIGRP: Received HELLO on Loopback0 nbr 1.1.1.1 *Aug 8 03:27:51.179: AS 99, Flags 0x0, Seq 0/0 idbQ 0/0 *Aug 8 03:27:51.179: EIGRP: Packet from ourselves ignored RA# *Aug 8 03:27:55.747: EIGRP: Sending HELLO on Loopback0 *Aug 8 03:27:55.747: AS 99, Flags 0x0, Seq 0/0 idbQ 0/0 iidbQ un/rely 0/0 *Aug 8 03:27:55.747: EIGRP: Received HELLO on Loopback0 nbr 1.1.1.1 *Aug 8 03:27:55.747: AS 99, Flags 0x0, Seq 0/0 idbQ 0/0 *Aug 8 03:27:55.747: EIGRP: Packet from ourselves ignored 发现此时RTA在接口s1/0上既不能发送也不能接受Hello包,测试一下RTA到RTB环回接口的连通性 RA#ping 2.2.2.2 Type escape sequence to abort. Sending 5, 100-byte ICMP Echos to 2.2.2.2, timeout is 2 seconds: .....

EIGRP综合实验2 配置要点 ●帧中继交换机以及PVC的配置 ●帧中继多点子接口配置 ●帧中继点对点子接口配置 ●EIGRP基本配置(包括静态邻居的配置) ●NTP配置 ●EIGRP认证配置 实验拓扑 配置概述 ●在FRSW上配置帧中继交换机,PVC的设计如下: ?R41--S1/0--S1/0.12------412------S1/0--FRSW--S1/1------421------S1/0--R42; ?R41--S1/0--S1/0.12------415------S1/0--FRSW--S1/3------451------S1/0--R45; ?R41--S1/0--S1/0.14------414------S1/0--FRSW--S1/2------441------S1/0--R44;

●各站点的IP地址设计如下: ?R41--S1/0--S1/0.12--172.14.12.41/24------172.14.12.42/24--S1/0--R42; ?------172.14.12.45/24--S1/0--R45; ?R41--S1/0--S1/0.14--172.14.14.41/24------172.14.14.44/24--S1/0--R44; ●EIGRP的基本配置,包括静态邻居的配置; ●NTP的配置: ?把R41配置为NTP的服务器; ?把R42、R45和R44配置为NTP的客户端 ●以R41为中心与其他各个站点(R42、R45和R44)配置EIGRP认证。

FRSW3(config-if)#frame intf-type dce FRSW3(config-if)#frame route 441 int s 1/0 414 FRSW3(config-if)#no sh FRSW3(config-if)#^Z FRSW3# 配完之后看看接口 继续点对点子接口的配置 R41(config)#int s 1/0.14 ? multipoint Treat as a multipoint link point-to-point Treat as a point-to-point link

RIP: RIP是最早的路由协议,它一般被应用在小型网络里。由于它在选择两点间的最优路径时只考虑节点间的中继次数,它不考虑网络拥塞状况和连接速率因素,RIP每30秒广播一次自己的路由表,广播时会有极大的数据传输量。然后RIP的收敛时间很长,新的路由信息更新对于较远的路由器,可能要花费几分钟时间。同时RIP还限制中继次数不能超过16跳(经过16台路由器),多出16台路由器后即不可传输。所以在大型网络中,是不可能满足要求的。 总之RIP在路径较多时收敛慢,广播路由信息需占用较多带宽资源 RIP的管理距离为120 OSPF: 为了弥补RIP中的一些缺陷,并能够与RIP网络共存。OSPF在选择最优路径时使用了一种更灵活的算法。OSPF不受跳数限制;支持负载均衡;收敛速度和EIGRP相当;使用AREA对网络进行分层,减少了协议对CPU处理时间和内存的需求;采用SPF算法来计算出到达目标的最短路径。 Cost=10^8/bandwidth,所以对带宽是比较敏感的 OSPF管理距离为110 EIGRP: 增强型内部网关路由协议,它具有快速收敛时间和低网络开销。而且它具有比OSPF更容易配置及需要较少CPU开销的优点。但是他是cisco私有协议,不能与其他厂商路由器共存。 总之EIGRP比RIP具有更快收敛,减小带宽消耗,增大了网络规模(255跳)以及减小了CPU的消耗。同时它还支持非等价负载均衡。 EIGRP对带宽及延时比较敏感 增量路由更新:RIP是将整个路由表都发给对方,而EIGRP是将发生更新的路由发给对方,其采用的是触发更新,如果没有更新是不发送的,这点和RIP不同。 EIFRP管理距离为90,外部管理距离为170 1.距离矢量/链路状态路由协议 RIP v1和v2都是距离矢量型,OSPF是链路状态型,EIGRP是混合型的。 2.有类别/无类别路由协议 支持有类的:RIP v1 无类的RIP v2,OSPF,EIGRP 3.是否支持VLSM、CIDR 不支持的RIP v1 支持的:RIP v2,OSPF,EIGRP 4.是否支持认证技术 不支持的:RIP v1 支持的:RIP v2,OSPF,EIGRP 5.是否定期发送更新 定期:RIP v1和v2 不定期:OSPF,EIGRP 6.采用什么算法来完成网络收敛 RIP v1和v2:Bellman-Ford

前言:最近一直在对比测试F5 BIG-IP和Citrix NetScaler负载均衡器的各项性能,于是写下此篇文章,记录F5 BIG-IP的常见应用配置方法。 目前,许多厂商推出了专用于平衡服务器负载的负载均衡器,如F5 Network公司的BIG-IP,Citrix公司的NetScaler。F5 BIG-IP LTM 的官方名称叫做本地流量管理器,可以做4-7层负载均衡,具有负载均衡、应用交换、会话交换、状态监控、智能网络地址转换、通用持续性、响应错误处理、IPv6网关、高级路由、智能端口镜像、SSL加速、智能HTTP压缩、TCP优化、第7层速率整形、内容缓冲、内容转换、连接加速、高速缓存、Cookie加密、选择性内容加密、应用攻击过滤、拒绝服务(DoS)攻击和SYN Flood保护、防火墙—包过滤、包消毒等功能。 以下是F5 BIG-IP用作HTTP负载均衡器的主要功能: ①、F5 BIG-IP提供12种灵活的算法将所有流量均衡的分配到各个服务器,而面对用户,只是一台虚拟服务器。 ②、F5 BIG-IP可以确认应用程序能否对请求返回对应的数据。假如F5 BIG-IP后面的某一台服务器发生服务停止、死机等故障,F5会检查出来并将该服务器标识为宕机,从而不将用户的访问请求传送到该台发生故障的服务器上。这样,只要其它的服务器正常,用户的访问就不会受到影响。宕机一旦修复,F5 BIG-IP就会自动查证应用已能对客户请求作出正确响应并恢复向该服务器传送。 .1

③、F5 BIG-IP具有动态Session的会话保持功能。 ④、F5 BIG-IP的iRules功能可以做HTTP内容过滤,根据不同的域名、URL,将访问请求传送到不同的服务器。 .2

F5 Application Management Products 服务器负载均衡原理 F5 Networks Inc

1.服务器负载平衡市场需求 (3) 2.负载平衡典型流程 (4) 2..1 通过VIP来截获合适的需要负载平衡的流量 (4) 2.2 服务器的健康监控和检查 (5) 2.3 负载均衡和应用交换功能,通过各种策略导向到合适的服务器 (6)

1.服务器负载平衡市场需求 随着Internet的普及以及电子商务、电子政务的发展,越来越多的应用系统需要面对更高的访问量和数据量。同时,企业对在线系统的依赖也越来越高,大量的关键应用需要系统有足够的在线率及高效率。这些要求使得单一的网络服务设备已经不能满足这些需要,由此需要引入服务器的负载平衡,实现客户端同时访问多台同时工作的服务器,一则避免服务器的单点故障,再则提高在线系统的服务处理能力。从业界环境来说,如下的应用需求更是负载均衡发展的推动力: ?业务系统从Client-Server转向采用Browser-Server 系统结构,关键系统需要高可用性 ?电子商务系统的高可用性和高可靠性需要 ?IT应用系统大集中的需要(税务大集中,证券大集中,银行大集中) ?数据中心降低成本,提高效率 负载均衡技术在现有网络结构之上提供了一种廉价、有效、透明的方法,来扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。它有两方面的含义:首先,大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间;其次,单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,返回给用户,系统处理能力得到大幅度提高。 BIG/IP利用定义在其上面的虚拟IP地址来为用户的一个或多个应用服务器提供服务。因此,它能够为大量的基于TCP/IP的网络应用提供服务器负载均衡服务。BIG/IP 连续地对目标服务器进行L4到L7合理性检查,当用户通过VIP请求目标服务器服务时,BIG/IP根椐目标服务器之间性能和网络健康情况,选择性能最佳的服务器响应用户的请求。 下图描述了一个负载平衡发生的流程:

基础知识点: EIGRP的metric计算 有K1(带宽)、K2(负载)、K3(延迟)、K4(可靠性)、K5(MTU)五个参数,默认情况下k值如下:K1=K3=1;K2=K4=K5=0 metric=256*(10000000/K1*bandwidth(kbit/s)+ total delay/10) BW和DLY值都可以在接口模式下手工指定,使用delay值时是tens of microseconds,在show interface 时实际值要乘以10. 使用metric weights 可以修改k值;但同一自制系统内的所有K值必须一致。 BW和DLY值可以使用show interface命令查看如 Ethernet0/1 is up, line protocol is up Hardware is AmdP2, address is cc00.0ffc.0001 (bia cc00.0ffc.0001) Internet address is 192.168.4.1/24 MTU 1500 bytes, BW 10000 Kbit, DLY 1000 usec, reliability 255/255, txload 1/255, rxload 1/255 Encapsulation ARPA, loopback not set Keepalive set (10 sec) ARP type: ARPA, ARP Timeout 04:00:00 Last input 00:00:02, output 00:00:01, output hang never Last clearing of "show interface" counters never Input queue: 0/75/0/0 (size/max/drops/flushes); Total output drops: 0 Queueing strategy: fifo Output queue: 0/40 (size/max) 5 minute input rate 0 bits/sec, 0 packets/sec 5 minute output rate 0 bits/sec, 0 packets/sec 816 packets input, 75702 bytes, 0 no buffer Received 808 broadcasts, 0 runts, 0 giants, 0 throttles 0 input errors, 0 CRC, 0 frame, 0 overrun, 0 ignored 0 input packets with dribble condition detected 1172 packets output, 97655 bytes, 0 underruns 0 output errors, 0 collisions, 1 interface resets 0 babbles, 0 late collision, 0 deferred 0 lost carrier, 0 no carrier 0 output buffer failures, 0 output buffers swapped out total delay可以通过show ip route x.x.x.x 查看到:如 RC#show ip route 192.168.3.0 Routing entry for 192.168.3.0/24 Known via "eigrp 100", distance 90, metric 307200, type internal Redistributing via eigrp 100 Last update from 192.168.4.2 on Ethernet0/1, 00:36:32 ago

1.负载均衡的介绍 软/硬件负载均衡 软件负载均衡解决方案,是指在一台或多台服务器相应的操作系统上,安装一个或多个附加软件来实现负载均衡,如DNS 负载均衡等。它的优点是基于特定环境、配置简单、使用灵活、成本低廉,可以满足一般的负载均衡需求。硬件负载均衡解决方案,是直接在服务器和外部网络间安装负载均衡设备,这种设备我们通常称之为负载均衡器。由于专门的设备完成专门的任务,独立于操作系统,整体性能得到大量提高,加上多样化的负载均衡策略,智能化的流量管理,可达到最佳的负载均衡需求。一般而言,硬件负载均衡在功能、性能上优于软件方式,不过成本昂贵。[1] 本地/全局负载均衡 负载均衡从其应用的地理结构上,分为本地负载均衡和全局负载均衡。本地负载均衡是指对本地的服务器群做负载均衡,全局负载均衡是指在不同地理位置、有不同网络结构的服务器群间做负载均衡。本地负载均衡能有效地解决数据流量过大、网络负荷过重的问题,并且不需花费昂贵开支购置性能卓越的服务器,可充分利用现有设备,避免服务器单点故障造成数据流量的损失。有灵活多样的均衡策略,可把数据流量合理地分配给服务器群内的服务器,来共同负担。即使是再给现有服务器扩充升级,也只是简单地增加一个新的服务器到服务群中,而不需改变现有网络结构、停止现有的服务。全局负载均衡,主要用于在一个多区域拥有自己服务器的站点,为了使全球用户只以一个IP地址或域名就能访问到离自己最近的服务器,从而获得最快的访问速度,也可用于子公司分散站点分布广的大公司通过Intranet (企业内部互联网)来达到资源统一合理分配的目的。 更高网络层负载均衡 针对网络上负载过重的不同瓶颈所在,从网络的不同层次入手,我们可以采用相应的负载均衡技术来解决现有问题。更高网络层负载均衡,通常操作于网络的第四层或第七层。第四层负载均衡将一个Internet上合法注册的IP地址,映射为多个内部服务器的IP地址,对每次TCP连接请求动态使用其中一个内部IP地址,达到负载均衡的目的。第七层负载均衡控制应用层服务的内容,提供了一种对访问流量的高层控制方式,适合对HTTP服务器群的应用。第七层负载均衡技术通过检查流经的HTTP报头,根据报头内的信息来执行负载均衡任务。 [编辑本段] 网络负载平衡的优点 1、网络负载平衡允许你将传入的请求传播到最多达32台的服务器上,即可以使用最多32台服务器共同分担对外的网络请求服务。网络负载平衡技术保证即使是在负载很重的情况下它们也能作出快速响应。 2、网络负载平衡对外只须提供一个IP地址(或域名)。 3、如果网络负载平衡中的一台或几台服务器不可用时,服务不会中断。网络负载平衡自动检测到服务器不可用时,能够迅速在剩余的服务器中重新指派客户机通讯。此保护措施能够帮助你为关键的业务程序提供不中断的服务。可以根据网络访问量的增多来增加网络负载平衡服务器的数量。 4、网络负载平衡可在普通的计算机上实现。在Windows Server 2003中,网络负载平衡的应用程序包括Internet信息服务(IIS)、ISA Server 2000防火墙与代理服务器、VPN虚拟专用网、终端服务器、Windows Media Services(Windows视频点播、视频广播)等服务。同时,网络负载平衡有助于改善你的服务器性能和可伸缩性,以满足不断增长的基于Internet 客户端的需求。

EIGRP基本配置实验 一、实验目的 1.掌握EIGRP基本原理 2.掌握EIGRP基本配置 3.掌握EIGRP的验证配置 4.了解EIGRP的简单测试 二、实验拓扑图 三、实验内容 -配置IP地址实现直连互通 -在所有的路由器上配置EIGRP ,AS号位100, -查看R2的路由表和邻居表,并分析路由表中EIGRP路由条目的度量值的计算过程

-R1-R2之间启用EIGRP密文验证,密钥位KEY 12,KEY-STRING-QM_CCNA *若在路由表中出现汇总路由,建议在每一台路由器上配置 R1(config-if)#router eigrp 1 R1(config-router)#no auto-summary 四、实验具体操作截图 1.配置IP地址实现直连互通 (1)为R1配置IP地址 (2)为R2配置IP地址

(3)为R3配置IP地址 (4)验证是否直连互通 结果:可以直连互通 2.在所有的路由器上配置EIGRP ,AS号位100

3.查看R2的路由表和邻居表,并分析路由表中EIGRP路由条目的 度量值的计算过程。 (1)查看R2的路由表和邻居表 (2)分析路由表中路由条目的度量值的计算过程 Metric=[10^7/BW+延时总和/10US]*256 在R2的路由表中,根据度量值计算公式: Metric=[10^7/100+(5000+100)/10US]*256=156160 其中f口的最小带宽是100M,总延时为Loopback口的延时5000加上经过路由器F口的延时100之和。 注:对于计算度量值时,才开始总是算不对,将loopback口的延时当做是100,怎么算都不对,百思不得其解,最后上网查找,得知loopback口环路默认延时是5000,最终计算出的度量值与路由表中的度量值相等。

EIGRP 路由协议的配置 一.实验目的 掌握路由器EIGRP 路由协议的配置方法。 二.实验要点 通过对路由器A和路由器B启用EIGRP路由协议,使路由器A可Ping通路由器B所连的各个网络, 反之,亦然。 三.实验设备 路由器Cisco 2621两台,交换机Cisco 2950两台,带有网卡的工作站PC 至少两台。 四.实验环境 S0/0:10.0.0.1/24 S0/0:10.0.0.2/24 F0/0:192.168.0.1/24 F0/0:192.168.1.1/24 Host A Host B IP Address:192.168.0.2/24 IP Address:192.168.1.2/24 Default Gateway:192.168.0.1 Default Gateway:192.168.1.1 图13 EIGRP 路由协议的配置 五.实验步骤 1. 如图对路由器A 及路由器B 的各个接口配置好IP地址 l 在路由器A (假设为DCE 端)上 router>en router#conf t

router(config)#hostname RouterA RouterA(config)#int s0/0 RouterA(config-if)#ip add 10.0.0.1 255.255.255.0 RouterA(config-if)#cl ra 64000 RouterA(config-if)#no sh RouterA(config)#int f0/0 RouterA(config-if)#ip add 192.168.0.1 255.255.255.0 RouterA(config-if)#no sh RouterA(config-if)#exit l 在路由器B (假设为DTE 端)上 router>en router#conf t router(config)#hostname RouterB RouterB(config)#int s0/0 RouterB(config-if)#ip add 10.0.0.2 255.255.255.0 RouterB(config-if)#no sh RouterB(config)#int f0/0 RouterB(config-if)#ip add 192. 168.1.1 255.255.255.0 RouterB(config-if)#no sh RouterB(config-if)#exit 实验结果: a. 在路由器A 上是否能ping 通路由器B 的串口S0/0 (10.0.0.2) b. 在路由器A 上是否能ping 通路由器B 的以太口F0/0 (192.168.1.1) 2. 在路由器A 和路由器B 上分别配置EIGRP 路由协议 在路由器A 上: RouterA (config)#router eigrp 100 RouterA(config-router)# net 10.0.0.0 RouterA(config-router)# net 192.168.0.0 在路由器B 上: RouterB (config)# router eigrp 100 RouterB(config-router)# net 10.0.0.0 RouterB(config-router)# net 192.168.1.0 实验结果: a. 在路由器A 上是否能ping 通路由器B 的串口S0/0 (10.0.0.2) b. 在路由器A 上是否能ping 通路由器B 的以太口F0/0

XXXX负载均衡项目配置手册 杭州华三通信技术有限公司 版权所有侵权必究 All rights reserved

1 组网方案1.1 网络拓扑 1.2 负载均衡资源

注:红色表示该实服务不存在。 1.3 网络设备资源 交换机管理IP地址是:10.4.41.54/255.255.255.192; LB设备的管理IP地址是:10.4.41.34/255.255.255.192; 设备的网关是:10.4.41.62; 2 交换机S75E配置 2.1 创建VLAN及添加端口

F5负载均衡原理 一负载均衡基本概念 1、什么是负载均衡? 负载均衡技术在现有网络结构之上提供了一种廉价、有效、透明的方法,来扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。它有两方面的含义:首先,大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间;其次,单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,返回给用户,系统处理能力得到大幅度提高。 BIG/IP利用定义在其上面的虚拟IP地址来为用户的一个或多个应用服务器提供服务。因此,它能够为大量的基于TCP/IP的网络应用提供服务器负载均衡服务。BIG/IP 连续地对目标服务器进行L4到L7合理性检查,当用户通过VIP请求目标服务器服务时,BIG/IP根椐目标服务器之间性能和网络健康情况,选择性能最佳的服务器响应用户的请求。 下图描述了一个负载平衡发生的流程: 1. 客户发出服务请求到VIP 2. BIGIP接收到请求,将数据包中目的IP地址改为选中的后台服务器IP地址,然后将数据包发出到后台选定的服务器 3. 后台服务器收到后,将应答包按照其路由发回到BIGIP 4. BIGIP收到应答包后将其中的源地址改回成VIP的地址,发回客户端,由此就完成了一个标准的服务器负载平衡的流程。

2.负载平衡典型流程 ●通过VIP来截获合适的需要负载平衡的流量 ●服务器监控和健康检查,随时了解服务器群的可用性状态 ●负载均衡和应用交换功能,通过各种策略导向到合适的服务器 2.1 通过VIP来截获合适的需要负载平衡的流量 在BIGIP上通过设置VIP来截获需要进行负载平衡的流量,这个VIP地址可以是一个独立的主机地址和端口的组合(例如:202.101.112.115:80)也可以是一个网络地址和端口的组合(例如:202.101.112.0:80),当流量经过BIGIP的时候,凡是命中VIP 的流量都将被截获并按照规则进行负载平衡。 2.2 服务器的健康监控和检查 服务器 (Node) - Ping (ICMP) BIGIP可以定期的通过ICMP包对后台服务器的IP地址进行检测,如果在设定的时间内能收到该地址的ICMP的回应,则认为该服务器能提供服务 服务 (Port) – Connect BIGIP可以定期的通过TCP包对后台服务器的服务端口进行检测,如果在设定的时间内能收到该服务器端口的回应,则认为该服务器能提供服务 扩展内容查证(ECV: Extended Content Verification)—ECV ECV是一种非常复杂的服务检查,主要用于确认应用程序能否对请求返回对应的数据。如果一个应用对该服务检查作出响应并返回对应的数据,则BIG/IP控制器将该服务器标识为工作良好。如果服务器不能返回相应的数据,则将该服务器标识为宕机。宕机一旦修复,BIG/IP就会自动查证应用已能对客户请求作出正确响应并恢复向该服务器传送。该功能使BIG/IP可以将保护延伸到后端应用如Web内容及数据库。BIG/ip的ECV 功能允许您向Web服务器、防火墙、缓存服务器、代理服务器和其它透明设备发送查询,然后检查返回的响应。这将有助于确认您为客户提供的内容正是其所需要的。 扩展应用查证(EAV: Extended Application Verification) EAV是另一种服务检查,用于确认运行在某个服务器上的应用能否对客户请求作出响应。为完成这种检查,BIG/IP控制器使用一个被称作外部服务检查者的客户程序,该程序为BIG/IP提供完全客户化的服务检查功能,但它位于BIG/IP控制器的外部。例如,该外部服务检查者可以查证一个Internet或Intranet上的从后台数据库中取出数据并在HTML网页上显示的应用能否正常工作。EAV是BIG/IP提供的非常独特的功能,它提供管理者将BIG/IP客户化后访问各种各样应用的能力,该功能使BIG/IP在提供标准的可用性查证之外能获得服务器、应用及内容可用性等最重要的反馈。

组播实验 一实验目的 1)理解Multicast的一些基本概念。 2)掌握pim dense-mode的基本配置。 3)理解pim dense-mode的flood和prune过程。 4)理解 pim dense-mode 的assert机制 5)掌握cgmp的配置,及其优点。 6)掌握pim sparse-mode的基本配置。 二、实验拓扑和器材 Server 192.168.5.x 拓扑如上所示,需要路由器四台、交换机一台,主机三台(一台能作组播的服务器,需要Server级的windows操作系统)。 三、实验原理 1.组播基本原理 Multicast应用在一点对多点、多点对多点的网络传输中,可以大大的减少网络的负载。因此,Multicast广泛地应用在流媒体的传输、远程教学、视频/音频会议等网络应用方面。 Multicast采用D类IP地址,即224.0.0.0~239.255.255.255。其中224.0.0.0~224.0.0.255是保留地址,239.0.0.0~239.255.255.255是私有地址,类似于unicast的私有地址。 Multicast的IP地址与MAC地址的映射:MAC地址有48位,前面24位规定为01-00-5E,接着一位为0,后面23位是IP地址的后23位。 路由器间要通过组播协议(如DVMRP、MOSPF、PIM)来建立组播树和转发组播数据包。组播树有两类:源树和共享树。 多播时,路由器采用组管理协议IGMP来管理和维护主机参与组播。IGMP协议v1中,主机发送report包来加入组;路由器发送query包来查询主机(地址是224.0.0.1),同一个组的同一个子网的主机只有一台主机成员响应,其它主机成员抑制响应。一般路由器要发送3次query包,如果3次都没响应,才认为组超时(约3分钟)。IGMPv2中,主机可以发送

DNAT负载均衡功能配置案例 DNAT负载均衡功能配置案例(设置内网服务器对互联网提供服务) 拓扑图如附件所示。 需求说明:内网有三台http服务器(192.168.2.2/3/4)要对外提供服务,使用的外网口地址是192.168.0.2,需对外提供负载均衡的功能。后续准备还要增加邮件、ftp等服务器。同时,允许这些服务器能够方便在家休息时的网管人员能管理远程的服务器。 具体配置如下: address "cluster1" range 192.168.2.2 192.168.2.4 host "192.168.2.2" host "192.168.2.3" host "192.168.2.4" exit service "rdp" tcp dst-port 3389 timeout 1800 exit interface vswitchif1 zone "trust" ip address 192.168.2.1 255.255.255.0 manage ssh manage ping

manage http manage https exit interface ethernet0/1 zone "untrust" ip address 192.168.0.21 255.255.255.0 manage ssh manage ping manage https exit ip vrouter trust-vr ip route 0.0.0.0/0 192.168.0.1 exit policy from "trust" to "untrust" rule id 2 action permit src-addr "Any" dst-addr "Any" service "Any" exit exit policy from "untrust" to "trust" rule id 3 action permit src-addr "Any" dst-addr "Any" service "HTTP" service "FTP" service "POP3" service "PING" service "SMTP" service "rdp" service "ICMP" exit policy from "l2-trust" to "l2-trust" rule id 4 action permit src-addr "Any"

负载均衡器部署方式和工作原理 2011/12/16 小柯信息安全 在现阶段企业网中,只要部署WEB应用防火墙,一般能够遇到负载均衡设备,较常见是f5、redware的负载均衡,在负载均衡方面f5、redware的确做得很不错,但是对于我们安全厂家来说,有时候带来了一些小麻烦。昨日的一次割接中,就遇到了国内厂家华夏创新的负载均衡设备,导致昨日割接失败。 在本篇博客中,主要对负载均衡设备做一个介绍,针对其部署方式和工作原理进行总结。 概述 负载均衡(Load Balance) 由于目前现有网络的各个核心部分随着业务量的提高,访问量和数据流量的快速增长,其处理能力和计算强度也相应地增大,使得单一的服务器设备根本无法承担。在此情况下,如果扔掉现有设备去做大量的硬件升级,这样将造成现有资源的浪费,而且如果再面临下一次业务量的提升时,这又将导致再一次硬件升级的高额成本投入,甚至性能再卓越的设备也不能满足当前业务量增长的需求。 负载均衡实现方式分类 1:软件负载均衡技术 该技术适用于一些中小型网站系统,可以满足一般的均衡负载需求。软件负载均衡技术是在一个或多个交互的网络系统中的多台服务器上安装一个或多个相应的负载均衡软件来实现的一种均衡负载技术。软件可以很方便的安装在服务器上,并且实现一定的均衡负载功能。软件负载均衡技术配置简单、操作也方便,最重要的是成本很低。 2:硬件负载均衡技术 由于硬件负载均衡技术需要额外的增加负载均衡器,成本比较高,所以适用于流量高的大型网站系统。不过在现在较有规模的企业网、政府网站,一般来说都会部署有硬件负载均衡设备(原因1.硬件设备更稳定,2.也是合规性达标的目的)硬件负载均衡技术是在多台服务器间安装相应的负载均衡设备,也就是负载均衡器来完成均衡负载技术,与软件负载均衡技术相比,能达到更好的负载均衡效果。 3:本地负载均衡技术

实验 9.6.2:EIGRP 配置技能实验 拓扑图 地址表 设备接口IP 地址子网掩码默认网关Fa0/0 不适用 S0/0/0 不适用HQ S0/0/1 不适用 Lo1 不适用 Fa0/0 不适用BRANCH1 S0/0/0 不适用 S0/0/1 不适用 Fa0/0 不适用BRANCH2 S0/0/0 不适用 S0/0/1 不适用PC1 网卡 PC2 网卡 PC3 网卡

学习目标 完成本实验后,您将能够: ?根据需要创建有效的 VLSM 设计。 ?为接口分配适当的地址并记录地址。 ?根据拓扑图进行网络布线。 ?清除启动配置并将路由器重新加载为默认状态。 ?配置路由器(包括 EIGRP)。 ?配置并传播静态默认路由。 ?检验 EIGRP 的运作。 ?测试并检验网络是否完全连通。 ?思考网络实施并整理成文档。 场景 在本实验练习中,为您指定了一个网络地址,您必须使用 VLSM 对其划分子网,并为拓扑图中显示的网络分配地址。这里需要组合使用 EIGRP 路由和静态路由,以便非直连网络中的主机能够彼此通信。必须配置EIGRP,以便所有 IP 流量使用最短的路径到达目的地址。 任务 1:对地址空间划分子网。 步骤 1:分析网络要求。 该网络的编址要求如下: ?必须对 172.16.0.0/16 网络划分子网,为三个 LAN 提供地址。 ? HQ 的 LAN 需要 500 个地址。 ? BRANCH1 的 LAN 需要 200 个地址。 ? Branch 2 的 LAN 需要 100 个地址。 ?代表 HQ 路由器和 ISP 路由器之间链路的环回地址将使用 209.165.200.224/30 网络。 ?必须对 192.168.1.16/28 地址空间划分子网,得到三台路由器之间的链路的地址。 步骤 2:创建网络设计时,请思考以下问题: 需要通过 172.16.0.0/16 网络创建多少个子网? _______ 总共需要通过 172.16.0.0/16 网络提供多少个 IP 地址? _______ HQ 的 LAN 子网将使用什么子网掩码?______________________ 在该子网中最多可以使用多少个主机地址? _______ BRANCH1 的 LAN 子网将使用什么子网掩码?________________ 在该子网中最多可以使用多少个主机地址? _______ BRANCH2 的 LAN 子网将使用什么子网掩码?______________ 在该子网中最多可以使用多少个主机地址? _______ 三台路由器之间的链路的子网掩码是多少?________ 每个子网最多有多少个主机地址可以使用? _____

前言:最近一直在对比测试F5BIG-IP和CitrixNetScaler负载均衡器的各项性能,于是写下此篇文章,记录F5BIG-IP的常见应用配置方法。 目前,许多厂商推出了专用于平衡服务器负载的负载均衡器,如F5Network公司的BIG-IP,Citrix公司的NetScaler。 F5BIG-IPLTM的官方名称叫做本地流量管理器,可以做4-7层负载均衡,具有负载均衡、应用交换、会话交换、状态监控、智能网络地址转换、通用持续性、响应错误处理、IPv6网关、高级路由、智能端口镜像、SSL加速、智能HTTP压缩、TCP优化、第7层速率整形、内容缓冲、内容转换、连接加速、高速缓存、Cookie加密、选择性内容加密、应用攻击过滤、拒绝服务(DoS)攻击和SYNFlood保护、防火墙—包过滤、包消毒等功能。 以下是F5BIG-IP用作HTTP负载均衡器的主要功能: ①、F5BIG-IP提供12种灵活的算法将所有流量均衡的分配到各个服务器,而面对用户,只是一台虚拟服务器。

②、F5BIG-IP可以确认应用程序能否对请求返回对应的数据。假如F5BIG-IP后面的某一台服务器发生服务停止、死机等故障,F5会检查出来并将该服务器标识为宕机,从而不将用户的访问请求传送到该台发生故障的服务器上。这样,只要其它的服务器正常,用户的访问就不会受到影响。宕机一旦修复,F5BIG-IP就会自动查证应用已能对客户请求作出正确响应并恢复向该服务器传送。 ③、F5BIG-IP具有动态Session的会话保持功能。 ④、F5BIG-IP的iRules功能可以做HTTP内容过滤,根据不同的域名、URL,将访问请求传送到不同的服务器。 下面,结合实例,配置: ①、如图,假设域名被解析到F5的外网/公网虚拟IP:(vs_squid),该虚拟IP下有一个服务器池(pool_squid),该服务器池下包含两台真实的Squid服务器(和)。 ②、如果Squid缓存未命中,则会请求F5的内网虚拟IP:(vs_apache),该虚拟IP下有一个默认服务器池 (pool_apache_default),该服务器池下包含两台真实的Apache服务器(和),当该虚拟IP匹配iRules规则时,则会访问另外一个服务器池(pool_apache_irules),该服务器池下同样包含两台真实的Apache服务器(和)。